Однажды став тем или иным специалистом в сфере IT, каждый из нас начинает окружать себя всевозможными инструментами для работы и отдыха. Далее это перерастает в целый комплекс мероприятий по поддержанию привычек, установленного расписания дня, комфортных условий труда и отдыха. Не претендуя на какую-либо уникальность, все же хотелось поделиться организацией «рабочего» процесса и отдыха ленивого администратора, как результатом знакомства с разными сферами IT, близкими к основной деятельности.

Однажды став тем или иным специалистом в сфере IT, каждый из нас начинает окружать себя всевозможными инструментами для работы и отдыха. Далее это перерастает в целый комплекс мероприятий по поддержанию привычек, установленного расписания дня, комфортных условий труда и отдыха. Не претендуя на какую-либо уникальность, все же хотелось поделиться организацией «рабочего» процесса и отдыха ленивого администратора, как результатом знакомства с разными сферами IT, близкими к основной деятельности.Вспоминая слова одного преподавателя вуза: «Кто такой инженер? Это же лентяй! Вот он лежит на диване, смотрит телевзор. И захотелось ему переключить канал — но вставать то лень! „Ай, ну его, каналы вставать переключать — пойду-ка разработаю пульт дистанционного управления...“. Всегда хотелось сделать что-то интересное и максимально это автоматизировать…

Итак, исходные данные:

0. Работа удаленным инженером-администратором. Поддержка парка серверов/сервисов по части software и hardware.

1. Место дислокации — загородный дом.

2. Гигабитный интернет с резервированием (Просто всегда был рад помочь местным сете-строителям с настройкой и сборкой серверов.)

3. Отностительно надежная инфраструктура — водо-, газо-, электроснабжение.

4. Желание

Задачи:

1. Удобная организация рабочего места с возможностью оперативного мониторинга.

2. Необходимая функциональность в свете безопасности, быстродействия и широкого спектра задач.

3. Энергоэффективность.

4. Изоляция рабочей среды от потенциальных угроз.

Сначала все и вся было уделом одного обычного ПК средней конфигурации — здесь и работа, и развлечения и веб-сервер. Круглосуточная работа, особенно в жилой комнате ну никак не устраивала ни меня, ни домочадцев. Появилось желание сделать все „раз и надолго“. Были испробованы множество вариантов — несколько ПК для разных задач в разных местах, Remote Desktop к рабочему ноутбуку, во избежание всевозможных переустановок, проблем привязки к оборудованию или операционной системе. Но однажды попробовав поиграться с одной из систем виртуализации, понял — это то что решило бы сразу много проблем. Это случилось как раз во время, когда в ESXi было упразднено множество ограничений в бесплатной версии, да так что теперь гипервизор годился прямо в мини-продакшн, для дома это уже была пушка по воробьям Отлично, начнем-с.

Первые грабли не заставили себя ждать. При переносе штатным инструментом (VMware vCenter Converter Standalone Client) ОС Windows 7 из доживающего свое винчестера ноутбука конечно же был словлен блускрин. Решение — загрузочный диск с любым редактором реестра, активация необходимых драйверов путем правки нужных значений (вариант решения).

Как же было приятно потом „лечить“ и украшать медленную 5-летнюю систему! Был произведен перенос всего медиаконтента, „не очень нужных“ программ, система сжата с 500 до 50 гигабайт. Все было чудесно, но, конечно сразу же захотелось „побыстрее“. Здесь начались размышления по поводу, собственно, серверной части. Было решено построить систему с запасом, максимально использовав комплектующие, которые уже были. Основное требование — бесшумность и производительность.

Итак, корпус — был вот такой: INPC DL36 — прочный, просторный корпус, который отлично подходил под все требования — полноценный размер материнской платы, 3U высота для использования полноценных радиаторов и бесшумного блока питания.

Конфигурация оборудования:

- Материнская плата Tyan S7012. 2xLGA1366, 4 сетевых интерфейса, встроенный IPMI, цена на ebay на момент покупки — $130

- Процессор 1 х Intel Xeon L5630. 4x2.13GHz, TDP 40W. Второй пока лежит без дела, хотя, как показали измерения, практически не повлиял на снижение средней потребляемой мощности (-10Вт). Цена 1шт. на момент покупки — $50 (ebay)

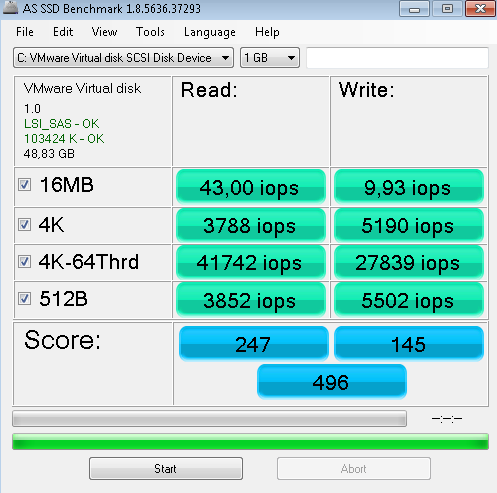

- Контроллер LSI 9261-8i. Минимально необходимый для полноценного использования SSD. Замеры iops внутри виртуальных машин это подтверждают. Цена на момент покупки $150 (ebay).

- Дисковая подсистема Здесь немного понервничал и все же раскошелился. RAID1 на базе 2 x Intel SSD DC S3500 Series (240GB, 2.5in SATA 6Gb/s, 20nm, MLC) + OCZ Deneva 2 480 GB для второстепенных задач, тем не менее требующих быстрой дисковой системы. HDD оказались просто не нужны, к тому же они были бы самым шумным элементом системы! Замер IOPS оказался в „пределах погрешности“ относительно теста производительности RAID при непосредственном подключении, без какой-либо виртуализации.

- Блок питания Chieftec Smart GPS-500C. Он просто бесшумен. Никакого писка дросселей, никаких шумов, абсолютно.

- Оперативная память В текущей конфигурации это 3х8Gb — вполне достаточно для текущих задач и неплохой запас на будущее, чтобы лишний раз не выключать сервер.

- Охлаждение Штатные вентиляторы были выкручены, на продув корпуса установлены Noctua NF-S12A PWM. Основной проблемой конечно же стало охлаждение процессоров. Было решено использовать штатный радиатор Intel STS100C (Cu+Al) вместе с регулируемым вентилятором (штатный даже на минимальных для запуска оборотах был очень шумным). Экспериментальным путем был подобран San Ace 80, регулировка осуществляется с помощью популярного step-down модуля на базе LM2596S. Путем подстройки напряжения получилось добиться скорости 500-700 оборотов, это практически бесшумная работа. Такой режим не допускает перегрева даже жарким летом, все показания датчиков в пределах нормы.

В планах переход на полностью пассивное охлаждение CPU.

Вот как это выглядит на данном этапе:

Вид спереди, диски можно менять не выключая сервер:

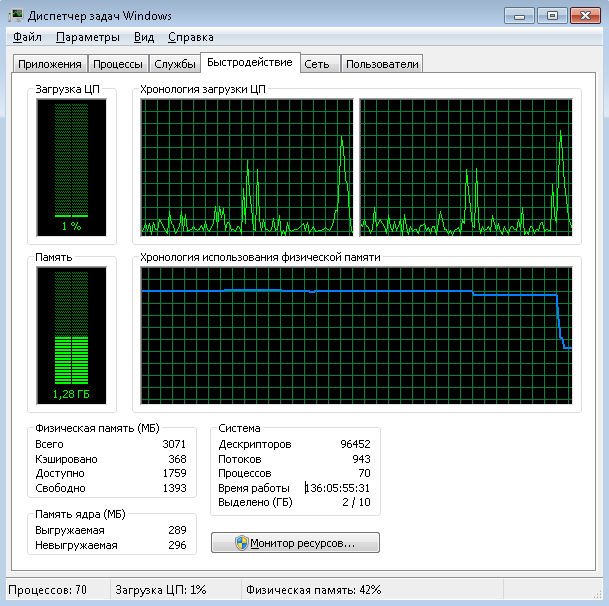

Попутно был развеян миф о потребности регулярной перезагрузки Windows:

Итак, сервер собран, далее приступим к повышению надежности в доступных нам пределах. Мною было продумано множество вариантов бесперебойного электропитания дома в целом, и сервера, в частности. От выделенного ИБП с минимально необходимой мощностью для питания сервера и базовых сетевых устройств до полного резервирования всего дома трехфазным ИБП. В итоге проб и ошибок был выбран все же самый адекватный вариант — ИБП средней мощности с запасом для питания критических устройств в течение хотя-бы 12 часов. Таковыми являются газовый котел, собственно, сервер, коммутатор провайдера, роутер, внутренние коммутаторы, видеокамеры, автоматические ворота, дежурное 12В освещение, аварийные розетки в доме и подсобном помещении. Добавление следующего по важности устройства —

Потребление резервируемых устройств в штатном режиме:

Организация сети. В который раз пришлось на своем опыте убедиться в законе — если по плану необходимо проложить два кабеля — надо закладывать четыре! Даже без систем умного дома. После разнообразных перестановок была применена следующая схема. Для моей реализации сети идеальным роутером оказался, конечно же, MikroTik. Абсолютно все необходимые функции за минимальную стоимость, с минимальным энергопотреблением. Простая настройка локальной сети, безопасности доступа извне, резервирования каналов связи, дополнительных сервисов — устройство класса „один раз разобрался, настроил и забыл“. Функция резервной маломощной точки доступа Wi-Fi, потому как качественная раздача не является основной задачей подобных устройств. В роли главной точки беспроводного доступа был заказан небезызвестный Ruckus — поставил и забыл, проблемы с Wi-Fi прекратились раз и навсегда.

Два аплинка от провайдеров проверяются на доступность по приоритету (distance) — в случае проблем с приоритетным провайдером автоматически происходит переключение на резерв. Решение простое, не самое надежное, но, как правило, достаточное при типичных проблемах сетей в частном секторе — обрывы кабелей/отсутствие электропитания.

Далее хотелось бы рассказать, зачем же это все, собственно, затевалось и какой получился результат. Для каждой группы задач была установлена отдельная виртуальная машина, а именно:

1. Основная рабочая система на базе Windows 7, та самая, с трудом и заботой перенесенная со славно поработавшего ноутбука.

2. Отдельная система для ведения финансового учета и проведения переводов — так же, впрочем, перенесенная с нетбука.

3. ОС с софтом для видеонаблюдения. Хотя полностью независимые системы и имеют свои преимущества — но полугодовой опыт использования виртуальной машины для этих целей показал отличную надежность такого решения. Видеонаблюдение было построено на базе камер Hikvision и бесплатного софт-сервера от этого же производителя.

4. Сетевое хранилище для медиаконтента (FreeNAS) — в основном для удобного обмена файлами между устройствами внутри локальной сети и просмотра на фото/видео на телевизоре.

5. Unix сервер, Debian/Ubuntu, без GUI. Как же без простой, безотказной системы под рукой — собрать статистику и вывести показания датчиков на веб-сервер, перекодировать видео с помощью ffmpeg, протестировать скрипты, и т.д.

6. Бонусы — однажды в экстренной ситуации пришлось даже спасать крупный сайт, вытаскивая контент из проблемного рейда, на лету завернув его в виртуальную машину и переместив на временный сервер.

Для взаимодействия с виртуальной средой установлен ПК с 23'' монитором, на котором есть относительно мощная видеокарта для видео/игр, подключение к машинам происходит по RDP либо SSH. Если уж совсем лениво — то с ноутбука, лежа на диване.

После всех настроек, проб и ошибок, наконец-то можно сказать что все работает, как и было запланировано! Казалось бы, стольким мелочам было уделено внимание — но в сумме это дало очень много выигранного времени и средств, а именно на включения, выключения, замены, контроль всего потенциального парка домашних устройств.Теперь можно больше сконцентрироваться на основной деятельности, не переживая об отключениях электричества, падающих, забытых, украденных ноутбуках, посыпавшихся жестких дисках и прочих сюрпризах. Надеюсь что мой опыт будет интересен и, возможно, кого-то так же мотивирует применить свои профессиональные знания для обустройства рабочего места на дому!

Комментарии (18)

GHostly_FOX

16.09.2015 21:51Лучше бы описал софт с которым работаешь

Iaroslav_Olegovich

17.09.2015 22:28Спасибо за интерес! Акцент в статье хотелось сделать больше на железную часть, о софте расписывать пока особо нечего, все банально — бесплатная лицензия vmware ESXi 5.5, перенесенные с помощью штатного P2V конвертера Windows 7, программный сервер видеонаблюдения Hikvision iVMS-4200, Debian 7 с apache, nginx, ffmpeg — но это, пожалуй, уже больше относится к рабочей деятельности.

novoxudonoser

17.09.2015 01:50+7Статья на манер посмотрите какой у меня большой.

novoxudonoser

17.09.2015 02:50+2Был бы это гайд с теорией и практикой степ бай степ, цены бы не было, а так очередная статейка которая и в памяти не отложится. >если по плану необходимо проложить два кабеля — надо закладывать четыре! Даже без систем умного дома это конечно хорошо при дешёвых ресурсах, но сейчас не об этом, умный дом — кабели ???!!! (а радио или CAN) В статье описан по факту прайс лист типа сервера, а зачем вам он нужен? хоть пару слов а не пару намёков раскиданных в конце, я говорю про расчёт целей, стоимости их достижения и предполагаемово профита. И зачем вам нужна именно мощная машинка? П.С я очень надеюсь что шиндус тут только для игр

TheRaven

17.09.2015 09:52Про конфиг сервера я то же не понял — двухголовая мать, рейд на SSD и 3ГБ памяти. Это как?

Iaroslav_Olegovich

17.09.2015 23:40По ходу написания статьи, но уже после, собственно, построения всего конечно же было много идей как лучше/проще. В реальности приходится решать более конкретные задачи, по мере их поступления. Хотелось, конечно же, сделать что-то похожее на гайд, но очевидно, что он не был бы универсальным — все же требования и условия очень разнятся, я лишь описал одно из возможных решений. Для меня витая пара/оптика все же предпочтительней — PoE, надежность, помехозащищенность. По конфигу, почему я выбрал именно такой — изначально исходил из основных условий:

— самостоятельная сборка, без брендового шасси — неоправданно дорого, мало возможностей кастомизации;

— большой запас для увеличения нагрузки — возможность добавить/убрать процессор и по мере необходимости, постепенно заполнять памятью;

— адекватное соотношение цена-производительность — и на момент покупки, и сейчас 1366 сокет очень привлекателен для решения очень широкого спектра задач — от уже неприлично дешевых процессоров Е5504 в роли «заглушки» до X5690, которые помогут значительно продлить срок актуальности платформы;

— максимально надежное и производительное хранилище — это очень важно в случае с виртуализацией. HDD в RAID0, RAID5, гибридные диски/контроллеры, кеширование контроллером — либо недостаточно, либо уже приближается по цене к описанному решению. Выбранный контроллер уже имеет опции включения кеша дисков, все еще не пугая энтерпрайз-ценой;

— IPMI, минимальное энергопотребление, без особого ущерба для производительности

Профит — время, надежность, безопасность (никогда не держу важные данные на ноутбуке в поездках), энергоэффективность, компактность, незаметность.

P.S. Рабочие задачи и их решения совсем увели бы статью в повествование, в планах попробовать написать отдельно. Windows — хороший клиент RDP, пара-тройка полезных программ, привычка, даже к Mac за 2 года не могу привыкнуть.

Sergey-S-Kovalev

17.09.2015 12:18+4Я прочитал два раза, но не понял чем статья. Стандартный набор geek casual средств.

Необычных технических или программных решений нет. Все обычно, обыденно, стандартно, и еще и без подробностей.

Iaroslav_Olegovich

18.09.2015 00:44Спасибо за отзыв! Согласен, на уникальность решение никак не претендует, скорее описание частного случая, которое, надеюсь, было интересно посмотреть тем, кто «еще не делает backup» и пока не настолько geek.

KorP

17.09.2015 12:59А объясните мне суть это «коробочки»? Я в городе на балконе спокойно разместил стойку серверную, а уж в собственном доме такую поставить вообще проблем не должно быть, особенно по части шума (у меня вот у родителей на даче можно спокойно поставить в техническую комнату стойку — там и прохладно даже летом и на шум пофиг ибо насосы-фигосы).

Ну и как бы живёт у меня там на много больше korphome.ru и прекрасно себя чувствует

А тысяч за 20 можно на авито легко взять двухпроцессорный сервер 1U с парой БП, парой процов и гигов 16 памяти

Iaroslav_Olegovich

18.09.2015 00:25О, балкон тоже был у меня серверной! Сначала в городе на балконе был ПК с выведенными VGA, USB-хабом и на всякий случай RESET-ом чтобы зимой не нарушать «утепление» — личный проект на старте круглосуточно работал на единственном домашнем ПК. На вторую зиму отпала видеокарта, потом материнка, пока накроется винт решил не ждать… Проходил и стойку на балконе, и кондиционер, и закрытые летом наглухо окна, так как солнечная сторона — а винты и материнки все равно не любили такой режим. О шуме и потреблении я уже и не говорю. Проект вырос и переехал в датацентр.

С описанным решением техническая комната была не обязательна — хотя она есть и в ней размещен ИБП и котел/насосы. Я бы с радостью спал хоть в гермозоне датацентра, но другой раз просыпаюсь даже от шороха, а под монотонный гул тем более не заснуть. Знаю как шумят 1-2U сервера — чем круче бренд тем громче — HP, intel потише, Supermicro с турбинами еще тише, но все равно — это самолеты… Посмотрел конфиги по вашей ссылке — у вас все намного серьезней, это уже приличный домашний датацентр, интересно, сколько это все кушает?

KorP

18.09.2015 08:07Ну вот зиму нормально пережили и лето то же ничего

На счёт шума я с вами крайне не соглашусь. Взять тот же 360 г6 — крайне тихий сервер, его и в жилой комнате можно спокойно поставить — шумит не сильнее обычного компа. У меня самое громкое и самое жрущее это блейдовая корзина

Ну и кстати кушает оно не так уж и много, общий счёт за электричество в месяц (без корзины блейдовой) — 3 — 3,5k

midaw1

21.09.2015 16:38Отличная статья. Даже решил написать собственную статью про бэкапы виртуальных машин, чтобы задать один единственный вопрос… Собственно, вопрос. Сколько потребляет, указанная в статье материнская плата, пускай даже вместе с обвесом? Насколько, я смог понять 131W — это далеко не только сервер.

Iaroslav_Olegovich

22.09.2015 23:30Спасибо за интерес! Провел некоторые приблизительные измерения:

Штатное потребление — 75-78W.

Отключение питания SSD — 70W.

Отключение питания дисков, отсутствие контроллера — 55-60W.

Stand-by режим — 8W.

midaw1

23.09.2015 10:3760 Вт совсем скромная цифра для Xeon'а. У меня материнская плата с Core i5 2500 с двумя HDD и с одной SSD без внешнего контроллера кушает 60 Вт. Хотя есть материнская плата с Core2Duo без обвеса, которая кушает больше 100 Вт, что уже существенно для постоянной работы в роли сервера…

Спасибо за полезную информацию!

semlanik

У меня дома сервер сделанный из samsung NC10. Для файлоскладирования и git'а вполне годится, если влить туда 2-3 гига опертивки. Единственная проблема это подключение дополнительных жестких дисков. Но пока мне хватает и того что был в почившем нетбуке. Для работы 24/7 вполне годится и не кушает слишком много электроэнергии. Раньше был собранный из старого десктопа основанный P4, счета за электроэнергию не радовали. Чуть не забыл, вместо бесперебойника родная батарейка :)

kentastik

Тоже пару лет использовал подобное решение. Сейчас хватает ДО на всё про всё :)