На RSA Conference 2021 исследователи продемонстрировали, как можно обманывать автопилоты Tesla и Mobileye с помощью «фантомных» изображений.

Помните эпизод из фильма «О чем говорят мужчины», в котором главный герой попадает с друзьями в кювет из-за того, что ему показалось, будто на дорогу вышла пожилая женщина?

А теперь представьте, что нечто похожее может произойти с автопилотом, которому — нет, не показалось, а показали не очень хорошие люди некое изображение, на которое автопилот запрограммирован реагировать. Показали ненадолго, всего на долю секунды.

Именно о таком виде атак на ИИ автомобильных автопилотов, получившем название «фантомные атаки», рассказали исследователи из университетов Джорджии и Бен-Гуриона в ходе RSA Conference 2021.

Надо сказать, что идея показывать ИИ «опасные картинки» сама по себе не нова. Обычно для этого используют специально модифицированные изображения, которые заставляют ИИ сделать какой-нибудь очень неожиданный вывод. Все без исключения алгоритмы машинного обучения имеют эту ахиллесову пяту: если знать, какие признаки выделяются в качестве ключевых для распознавания картинки, то есть обладать определенным знанием об алгоритме, то можно модифицировать изображение так, чтобы затруднить машине принятие верного решения или вовсе вынудить ее сделать ошибку.

Новизна продемонстрированного на RSA Conference 2021 подхода заключается в том, что автопилоту показывались не модифицированные изображения — то есть атакующим не нужно знать, как работает алгоритм и какие признаки он использует.

Изображения ненадолго проецировались на дорогу, а также на расположенные рядом с ней стационарные объекты, и вот к чему это приводило:

Или другой вариант — изображения появлялись на доли секунды в рекламном ролике на стоящем рядом с дорогой билборде. Результат примерно тот же:

Таким образом, полагают авторы исследования, злоумышленники могут совершить свою пакость, находясь на комфортном расстоянии от жертвы и не подвергаясь опасности оставить лишние следы на месте преступления. Все, что им нужно знать о машине жертвы — это как долго показывать изображение.

Все дело в том, что в целях снижения вероятности ложного срабатывания, например из-за попадания грязи или мусора в объектив камеры или лидаров, разработчики намеренно внедрили порог срабатывания. Ведь мало кому из участников дорожного движения понравится, если ведомая автопилотом машина начнет вдруг случайным образом изменять свою скорость или направление движения.

Разработчикам ИИ приходится чем-то жертвовать, и они, видимо, решили, что раз тормозной путь автомобиля все равно измеряется в десятках метров, дополнительная пара метров из-за задержки на более тщательную оценку ситуации — это не критичная прибавка.

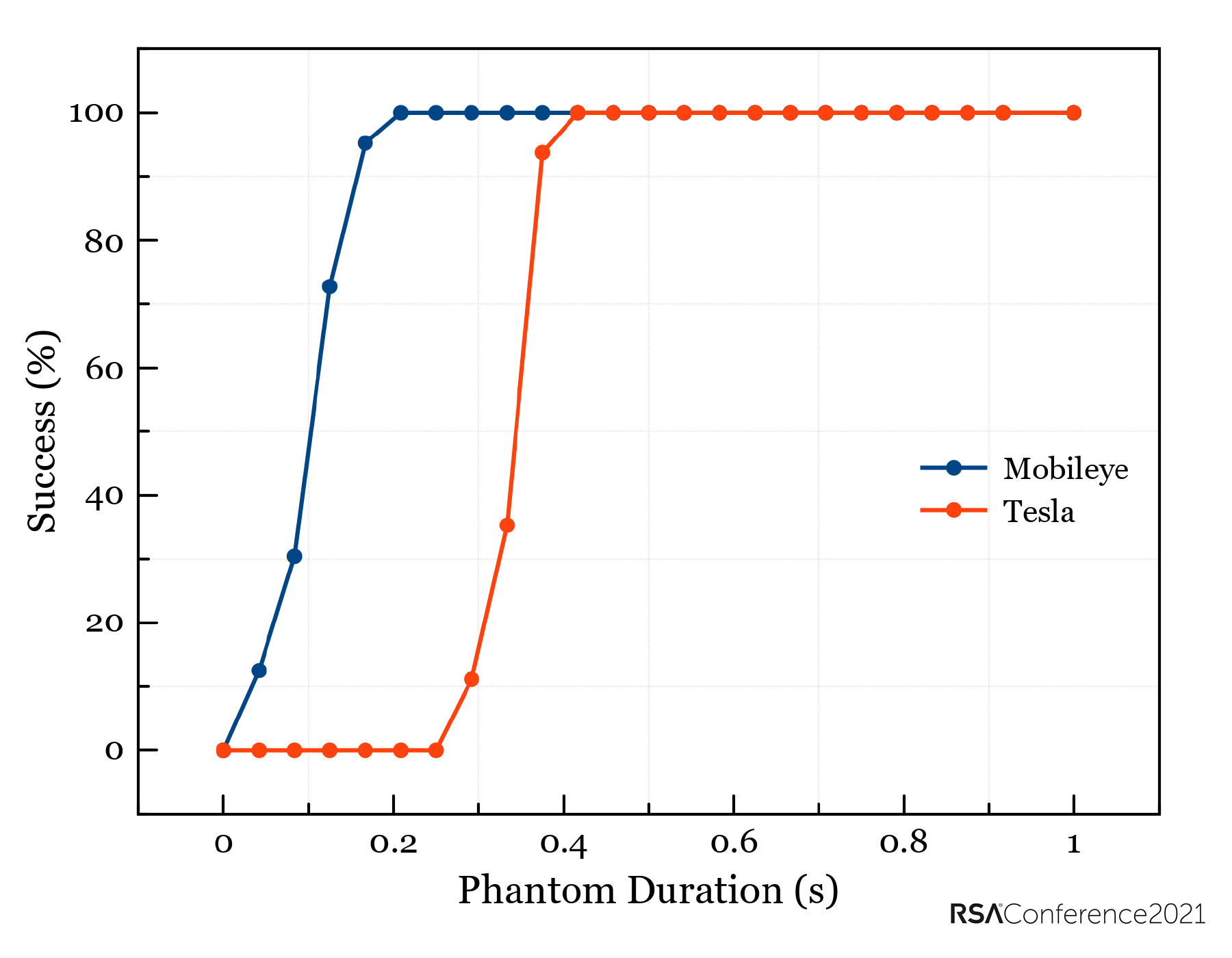

Впрочем, пара метров будет тогда, когда мы говорим о системе искусственного зрения Mobileye и скорости 60 км/ч — время ее реакции составляет около 125 миллисекунд. Экспериментально определенный исследователями порог реагирования автопилота Tesla почти в три раза больше — 400 мс, что на той же скорости прибавит почти семь метров. Так или иначе, это все равно доли секунды. Следовательно, полагают авторы исследования, такая атака может произойти внезапно — и прежде чем вы поймете, что произошло, дрона с проектором уже и след простынет.

Но есть один нюанс, который вселяет надежду на то, что рано или поздно автопилоты удастся обезопасить от данного вида атак. Все-таки внешний вид изображений, спроецированных на неподходящие для просмотра картинок поверхности, сильно отличается от реальности. Человеческий глаз легко отличает фантом от реального объекта по искажению перспективы, неровным краям, неестественным цветам, экстремальному контрасту и другим «странностям».

Таким образом, уязвимость системы автопилота к фантомным атакам — это следствие «разрыва восприятия» (perception gap) между ИИ и человеческим мозгом. Как можно преодолеть этот разрыв? Авторы исследования предлагают внедрять в системах автомобильных автопилотов проверку дополнительных признаков — перспективы, гладкости краев, цвета, контрастности, яркости и так далее — и принимать решение только в том случае, если результаты проверок согласуются друг с другом.

Примерно так же, как принимает решение жюри, только вместо людей на виртуальной скамье будут нейронные сети, оценивающие все те параметры, которые помогают отличить реальный сигнал с камеры или лидара от кратковременного фантома.

Это, конечно, приведет к дополнительной вычислительной нагрузке и, по сути, параллельной работе сразу нескольких нейронных сетей, которые нужно будет еще и предварительно натренировать, а это процесс долгий и энергоемкий. Да и самому автомобилю, который и так представляет собой небольшой кластер компьютеров на колесах, придется превратиться в небольшой кластер суперкомпьютеров.

Есть определенная надежда, что в будущем с распространением нейроморфных процессоров станет реальностью реализация на борту автомобиля сразу нескольких нейронных сетей, работающих параллельно и не убивающих при этом энергетику автомобиля.

Комментарии (11)

AgentRX

20.10.2022 05:02+6Атака с линиями очень нехорошая. Сейчас многие машины оснащены системами, удерживающими машину внутри полосы. Отличить реальную полосу от проекции ночью может быть тяжело, в итоге ТС имеет шанс выехать на встречку или улететь в кювет со всеми последствиями.

BMXer_V

20.10.2022 06:36+11Я кучу раз видел, что такая "атака" остаётся на дороге после ремонта. Когда временную разметку типа закрасили, но в дождь или ночью не понять, какая закрашена, а какая - нет. Так что на самом деле проблема серьёзнее, чем гипотетический дрон с проектором.

Hlad

20.10.2022 08:28+7Так то на такую атаку вполне себе покупаются обычные водители. У себя в городе я знаю пару мест, где криво нанесённая разметка регулярно вводит людей в заблуждение. По сути, автопилот справляется ничуть не хуже среднестатистического водителя, оказавшегося в чужом городе. Единственно, что ему надо добавить — это регулярно обновляемые карты городов, и требование «если происходит что-то непонятное — резко снижать скорость»

SuperTEHb

20.10.2022 09:57+1Во-во. Есть (были) у нас пару мест, где прерывистая линия (та, что между полос одного направления) пересекается с двойной сплошной. Да, вот просто был ряд, да весь резко вышел.

Drayden

20.10.2022 11:19Вообще это прямо классическая цитата: "Любой аварии можно избежать, если просто ехать помедленнее"

BlackMokona

20.10.2022 11:27"Единственно, что ему надо добавить — это регулярно обновляемые карты городов, и требование «если происходит что-то непонятное — резко снижать скорость» "

И то и другое есть. Карты обновляются. А второе называется фантомными торможениями.

Markscheider

20.10.2022 09:17+4Надо сказать, что идея показывать ИИ «опасные картинки» сама по себе не нова.

Ага. У Пелевина об этом было, правда, там военные беспилотники фигурировали

isBlaze

20.10.2022 10:41+5У нас в городе не так давно крупную улицу ремонтировали, частями. Брали метров 100-200, перекрывали, рисовали временную разметку, клали новый асфальт, открывали, двигались дальше. Временную разметку никто не убирал и не закрашивал. В результате вся дорога превратилась в угадайку: едешь по своей полосе, вокруг тебя сплошные, и ВНЕЗАПНО на твоей полосе тоже сплошная поперёк. В итоге все игнорировали любую разметку и ездили там по здравому смыслу. Я боюсь представить, как в такой ситуации будет себя вести автономная машина. И никаких атак не надо, официальные дорожные службы сделают всё качественнее

akakoychenko

20.10.2022 11:05+2Дроны и проекторы выглядят как-то чрезмерно технологичными для такой задачи. Выглядит достаточным просто показать знак, вытянув руку с ним из окна машины. А, если в руке при этом держать куклу, то, наверное, эффект будет ещё круче

RranAmaru

21.10.2022 18:09...проверку дополнительных признаков — перспективы, гладкости краев, цвета, контрастности, яркости...

Ну так атаку можно и наоборот сделать - пририсовать настоящему дорожному знаку лохматые края или спроецировать на него этот же знак в негативе, чтоб контрастность уменьшилась. Но самое веселое начнется, когда ИИ по каким-то признакам начнет принимать реальных пешеходов за фантомных.

dfgwer

Да не только автопилоту. Если мне покажут на четверть секунды пешехода, то я тоже среагирую. Надеюсь.