Всем привет! Делюсь опытом сборки NAS сервера на базе очень интересной (на мой взгляд) материнской платы.

Введение

Гуляя по просторам алиэкспресса наткнулся на специфическую материнскую плату, специализированную под построение NAS сервера. Решено было приобрести и собрать решение на замену старому.

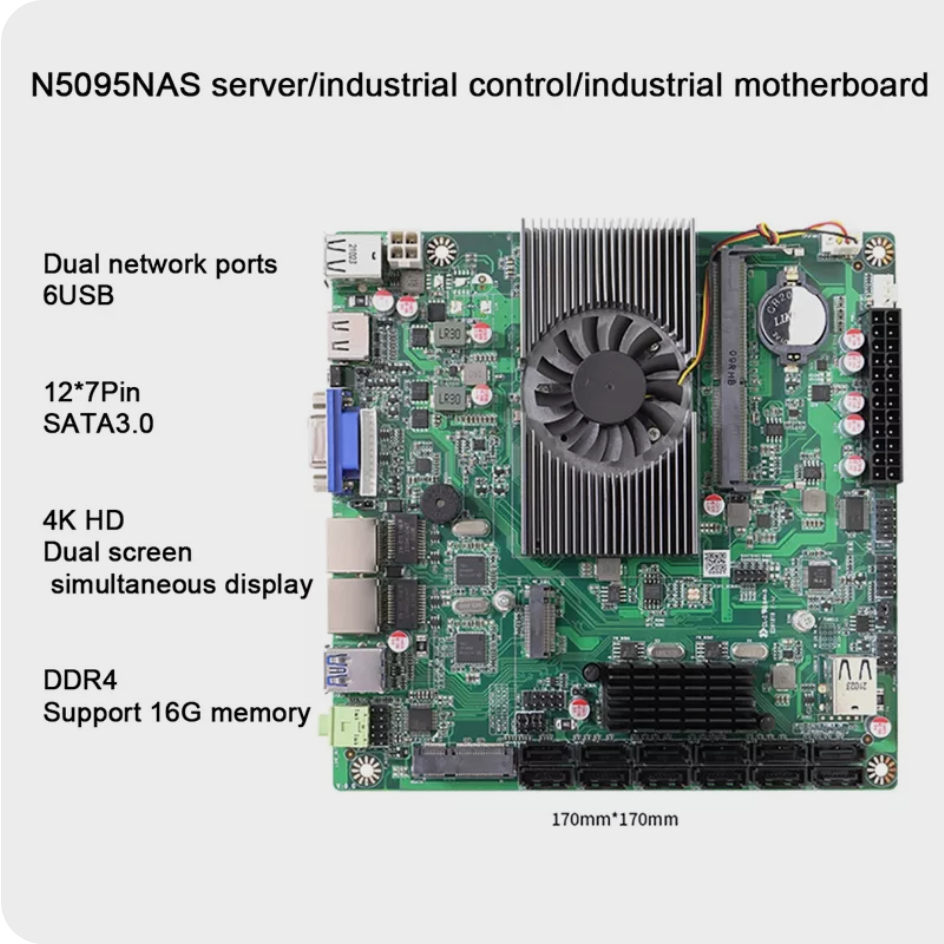

Сама плата зацепила тем, что на ней уже 12(!!!) разъемов SATA3, что более чем покрывает текущие и будущие мои потребности по подключенным дискам. Также на плате уже есть 2 порта Gigabit Ethernet, и встроен процессор Celeron Jasper Lake N5095 (что более чем для нужд чисто файлового сервера). И все это в формате MINI-ITX, что позволит собрать достаточно компактное решение за, примерно, 10 тыс рублей на момент написания статьи. Саму плату можно найти путем поиска на али по слову "N5095 Nas Motherboard". Судя по фото от разных продавцов, есть несколько ревизий. Как минимум, отличаются наличием порта MSATA.

Немного про то, зачем мне 2 сетевых адаптера

Сетевая схема домашней сети такова, что есть основной компьютер-потребитель данных с NAS и он же источник загрузок. И есть остальные клиенты потребители, они получают данные через wifi роутера. Итого NAS должен быть подключен к двум сетям - сети роутера и прямой линк до PC. На PC сетевые шары смонтированы как сетевые диски. Мне так удобнее :)

Обзор платы

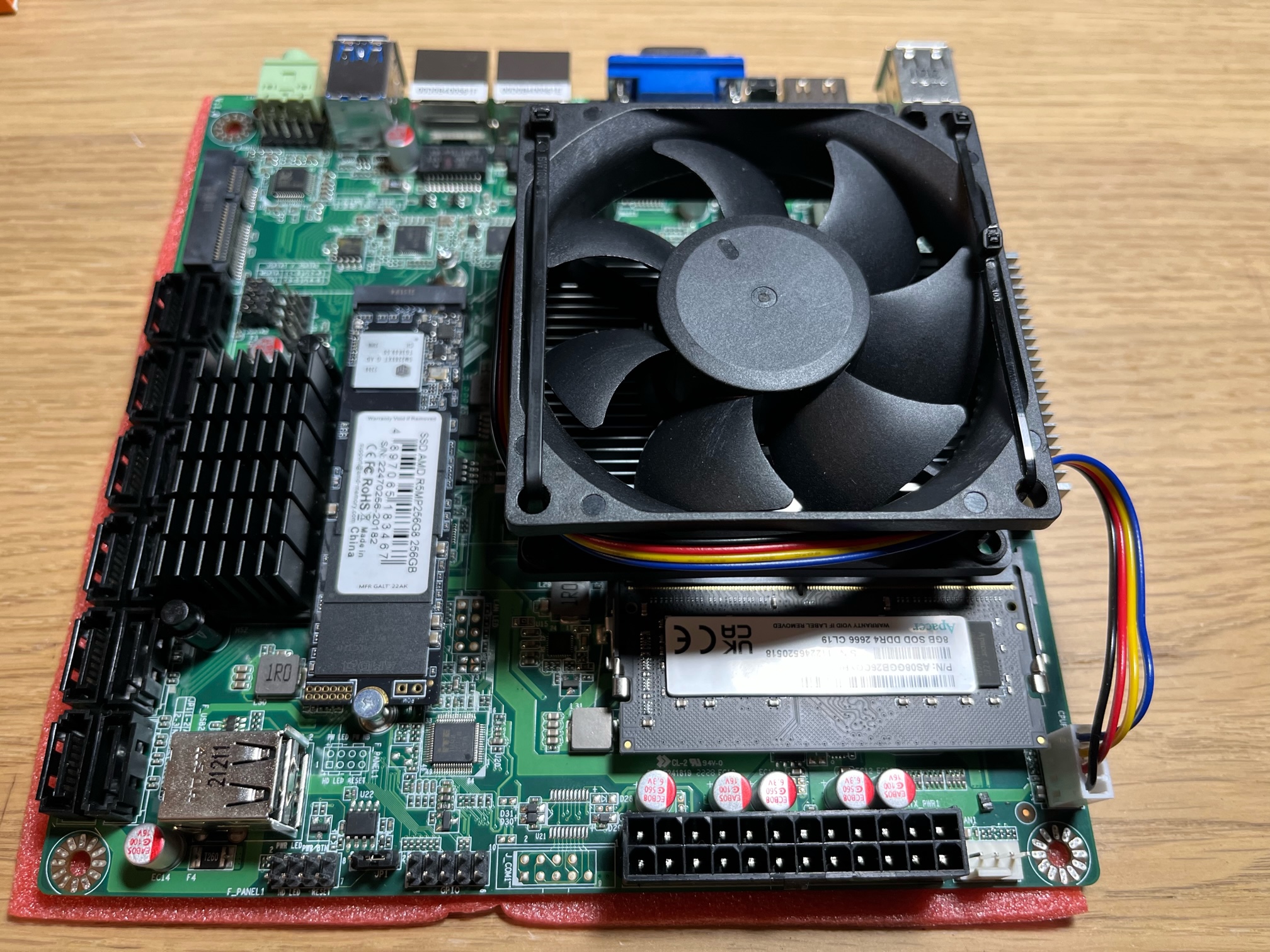

Основные характеристики (взято с али):

12*7 Pin SATA3.0, широко используется в безопасности хранения данных, жесткий диск K машина, NAS сетевое хранилище; Для процессора Celeron Jasper Lake N5095, 2,0 ~ 2,9 ГГц, 4 м кэш TDP15W; 1 * DDR4 2933MHZ SODIMM, до 16G;

2 * для адаптивной сетевой карты WGI211AT 1000M, поддержка пробуждения на LAN, бездисковой загрузки.

1 * MSATA (Выберите один из MSATA и SATA1), максимальная скорость передачи составляет 6 ГБ/сек., 1 * M2 SSD NVME/PCIE3.0 2X; TPM,

GPIO/обеспечивает 8 GPIO контроль, 1 * RS232; Название продукта: материнская плата N5095; ЦП: для Celeron N5095; BIOS: AMI 128MB BIOS, ACPI поддерживается, поддерживает питание при запуске;

Техническая Архитектура: Поддержка одноканального SO-DDR4 s, максимальная поддержка 2933 МГц, SODIMMЕмкость: максимальная поддержка 16G; Слот: 1 * DDR4 SODIMM;

Графический контроллер: поддержка s & HD Graphics; VGA: 1 * VGA, наивысшее разрешение-1920*1080 @ 60 Гц, 1*12 Pin J-VGA расширительный штыревой разъем; HDMI-Совместимость: 1 * HDMI-совместимый интерфейс. Максимальное разрешение 4096*2160 @ 60 ГцПоддержка нескольких дисплеев: Поддержка синхронного или Асинхронного двойного вывода дисплея

MSATA: интерфейс 1 * M-SATA, максимальная скорость передачи составляет 6 ГБ/сек. (выберите MSATA или SATA1)

SATA: 12*7 Pin SATA3.0 интерфейс, максимальная скорость передачи составляет 6 ГБ/сек. (Выберите один из MSATA и SATA1)

M2-SSD: 1 * Интерфейс PCIE3.0 2X M.2, высокоскоростной протокол NVME, характеристики устройства опционально: 2280, 2260

RJ45: 2 * для WGI211AT 10M/100M1000M Адаптивная сетевая карта, поддержка LAN wake-up, бездисковая загрузка

Линейный выход: чип ALC662, поддерживает интерфейс переднего F-AUDIO

USB3.0: внешний 2 * USB3.0

USB2.0: внешний 2 * USB2.0, встроенный 4 * USB2.0

RS232: Встроенный 1 * RS232

GPIO: Поддержка 8 GPIO

TPM: TPM2.0 аппаратное шифрование (опционально)

Сторожевая собака: Поддержка 4 ~ 255 секунд сторожевой таймер

Напряжение: Поддержка + 12V, 3,3 V, 5V, Процессор Vcore, DDR, Мощность Напряжение обнаруженияТемпература: Поддержка определения температуры ЦП

Вентилятор: Поддержка определения скорости вентилятора процессора и интеллектуального управления вентилятором

PWR SW: PWR BTN кнопка (кнопка питания)

ATX: 24Pin + 8 Pin ATX источник питания

Размер изделия: 17х17см

Цвет: зеленый

Материал: PCB + металл

Плата приходит в картонной коробке, обернутой пупыркой с большими ячейками

По комплектации:

Сама плата

Заглушка на заднюю стенку

Иии... Все!

Ни инструкций, ни буклетов, ни наклеек, ни кабелей и болтов! Возможно, кому то это будет критично, но подробного мануала по плате, как я понял по переписке с продавцом, не существует! При запросе скинуть мануал по почте он с радостью отправил файл pdf, внутри которого была та же спецификация, но на китайском:)

Фото мануала

Продолжаем unboxing

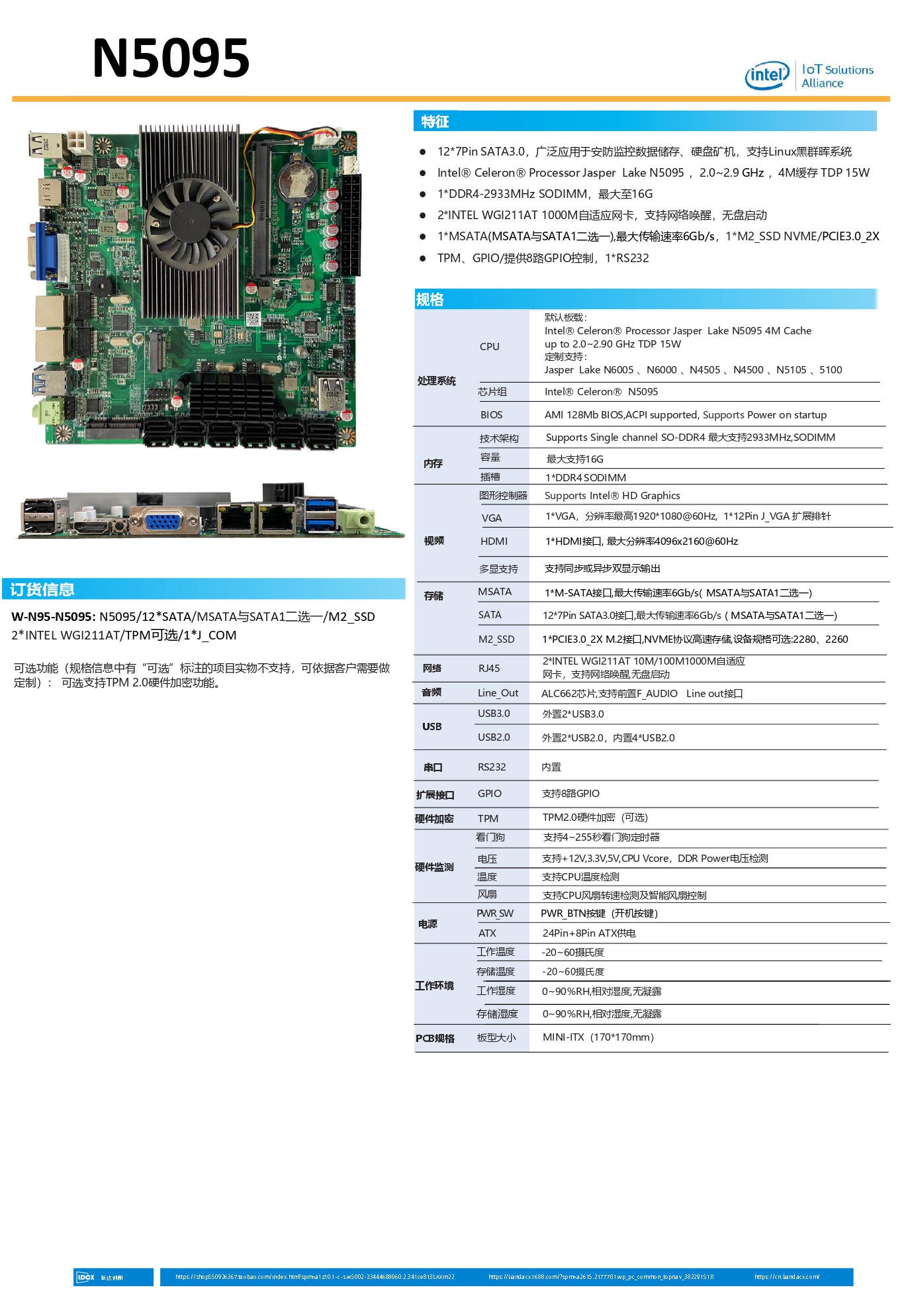

По отзывам и описаниям были комментарии, что на плате вместо контроллеров сети Intel ставят Realtek, но на полученной мной версии вроде как Intel (но, судя по фото, на другом чипе). Возможно, есть несколько ревизий таких плат.

Еще в комментариях указывали на шумность бипера. Да, при включении он издает громкий пик, решено было просто закрыть его заглушкой https://www.thingiverse.com/thing:2943218, напечатанной на 3d-принтере.

Из особенностей платы хотел бы отметить, что внутри самой платы расположены 2 порта USB. Такое я встречал только на материнских платах HP Microserver, что позволяет установить флешку с ОС внутри корпуса (TrueNAS и другие).

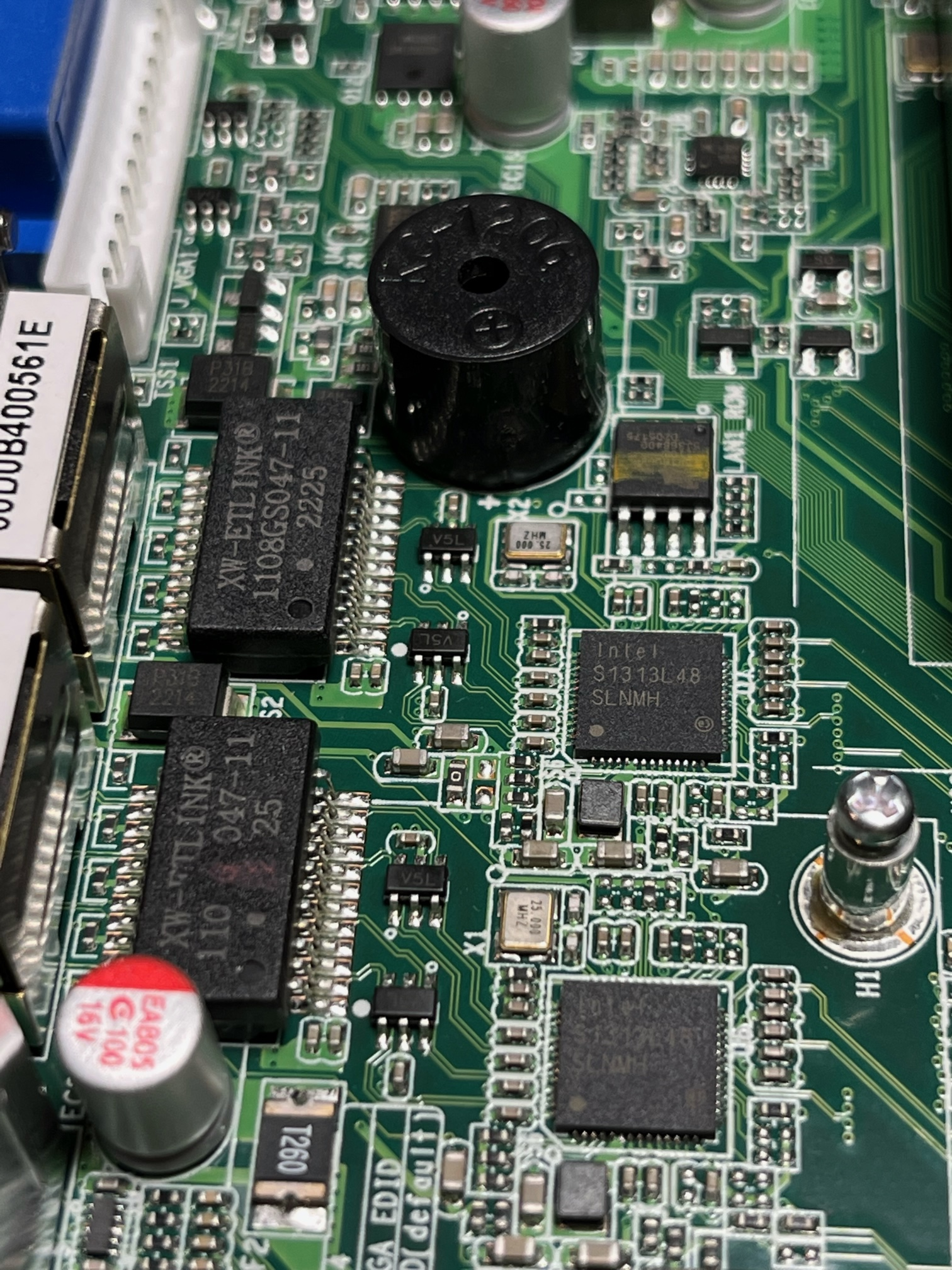

Также в тех же комментариях жаловались на шум стокового вентилятора, я решил заранее заказать большего размера, выбор пал на Gembird 80x80x25 (D8025HM-4), гидродинамический, 4 pin (стоковый 3 pin). После запуска в стоке шум есть, но субъективно, небольшой. Если вам не критично, можно оставить стоковый, но я решил поменять. Возможно, под нагрузкой шум был бы, но я практически сразу заменил вентилятор.

Сначала хотел заморочится с каким-нибудь креплением-переходником, но решил закрепить на существующий корпус радиатора, протянув пластиковые стяжки 2.5/2 мм под радиатором и притянув к нему.

На плате всего один разъем под память, но, опять же, для моих нужд это не было ограничением, и одной планки в 8Гб было бы более чем достаточно. В одном из отзывов указывалась модель Apacer DDR4 2666 Мгц 8 ГБ CL 19, решено было ее же и взять. Стоимость ~1500р на момент написания статьи.

В качестве системного жесткого диска решено было приобрести SSD диск AMD Radeon R5 NVMe Series M.2 PCI-E 3.0 (R5MP256G8). Стоимость ~1600р на момент написания статьи.

Резюмируя по плате (мое субъективное мнение):

Плюсы:

Встроенный процессор, по мощности под простое решение (кому критично ZFS, мощности может недостаточно. Но я не из таких :) )

12 портов SATA

Есть разъем m2 под системный диск (не лишает одного разъема SATA)

2 порта Gigabit Ethernet

Форм фактор mini-itx

Есть встроенный hdmi и VGA (не нужна видеокарта)

Цена

Минусы:

Мощность встроенного процессора может быть недостаточна под нужды более универсального сервера под решение ресурсоемких задач

Нет дополнительных разъемов (PCI-E), расширить платами не получится.

Отсутствие внятного подробного мануала и поддержки

Непонятный китайский бренд

Немного фото BIOS

Кастомизация корпуса

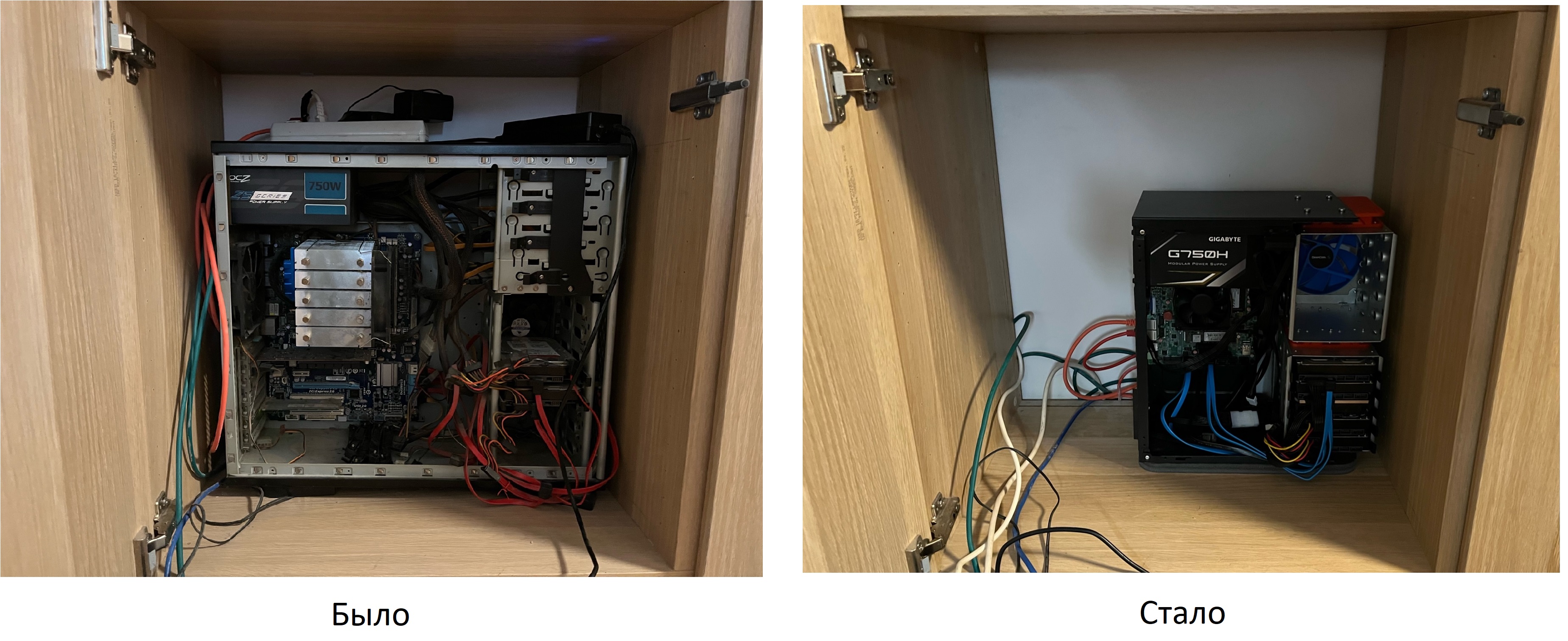

Сам NAS сервер у меня живет в нише/комбинации ikea БЕСТО, новый сервер будет жить там же. Ниша хоть и достаточно большая, но полноценный ATX корпус туда влазит с трудом. Поэтому под новый корпус были сформулированы следующие требования:

Сам внешний вид не важен, сервер будет стоять внутри шкафа

Компактность, желательно корпус microATX (хочу иметь возможность поставить в нишу еще что-то, например ИБП)

Должна быть возможность установки полноразмерного БП (у меня он был)

Возможность простой и быстрой установки 8-10 дисков 3.5

Установка дисков через пластиковые направляющие (в предыдущем корпусе было именно так, очень понравилось, но там было только 6 таких посадочных мест, хотелось бы больше)

Боковая установка дисков (упрощает, как по мне, их обслуживание и улучшает обдув)

Поискав готовые корпуса не нашел ничего компактного под 10 дисков и решено было пойти другим путем.

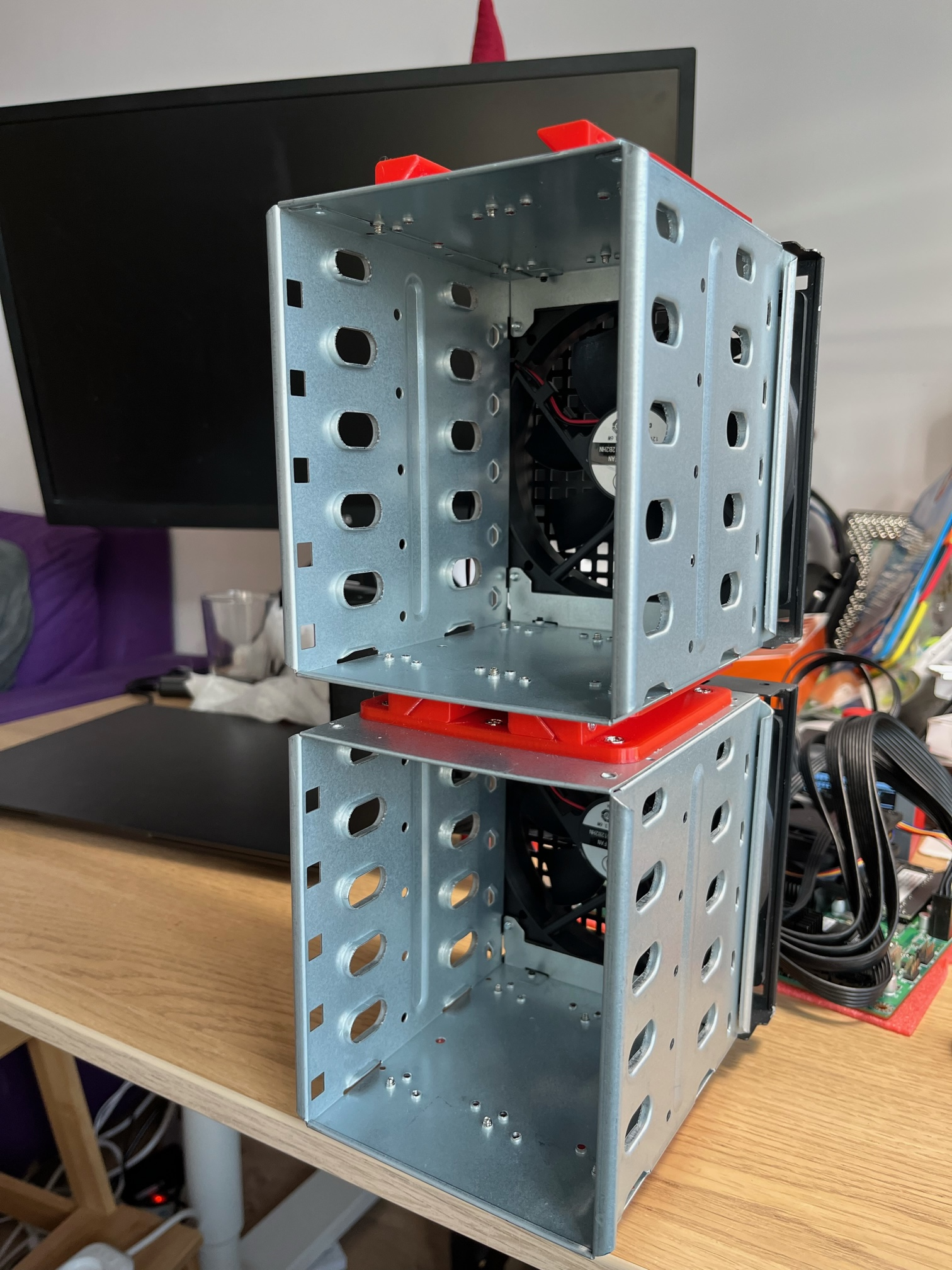

Приобрести на али корзины под диски, как на фото ниже (2 шт). Поиск по ключевым словам "hard drive cage". Я выбрал те корзины, которые рассчитаны на 5 дисков. Цена 3500р за 2 шт с учетом стоимости доставки.

И вставить их в microATX корпус. Забегая вперед, я заказывал комплектацию корзин с вентиляторами, но по шумности они меня не устроили. Даже при подключении к 5в они достаточно сильно шумели, поэтому решено было их заменить на более тихие DeepCool UF 120. Цена 890р за шт. Также, т.к. сервер будет стоять в нише, было решено снять с корзин защитные решетки для упрощения доступа к вентиляторам. В конкретно моей модели сами вентиляторы крепились к корзине, а не к решетке.

Данный формат корзин предполагает их фронтальную установку в нишу 5.25, но я хотел:

Горизонтально расположить диски

Иметь доступ сбоку корпуса для снятия/установки дисков

Такое расположение, как я считаю, оптимизирует конечный размер и сохраняет возможность нормального охлаждения дисков в корзинах. Потокам воздуха для охлаждения дисков ничего не мешает, они перпендикулярны корпусу.

В качестве корпуса был выбран microATX Exegate BAA-106 Без БП чёрный EX283056RUS. Цена 1390р.

Фото из интернета

Т.к. корпуса в формате microATX по длине достаточно короткие, было решено просто срезать переднюю часть и как-то прикрутить корзины.

После снятия фронтальной крышки получаем:

Фронтальная часть корпуса соединена через заклепки, их можно легко снять просто высверлив сверлом 5-6 мм. Также фронтальная часть была загнута и соединена с пластиной под материнскую плату, тут я просто разрезал ее дремелем с абразивным диском.

Получаем такой результат:

Ход размышлений был следующий:

Нужны какие-то проставки для соединения корзин между собой и между корзинами и корпусом

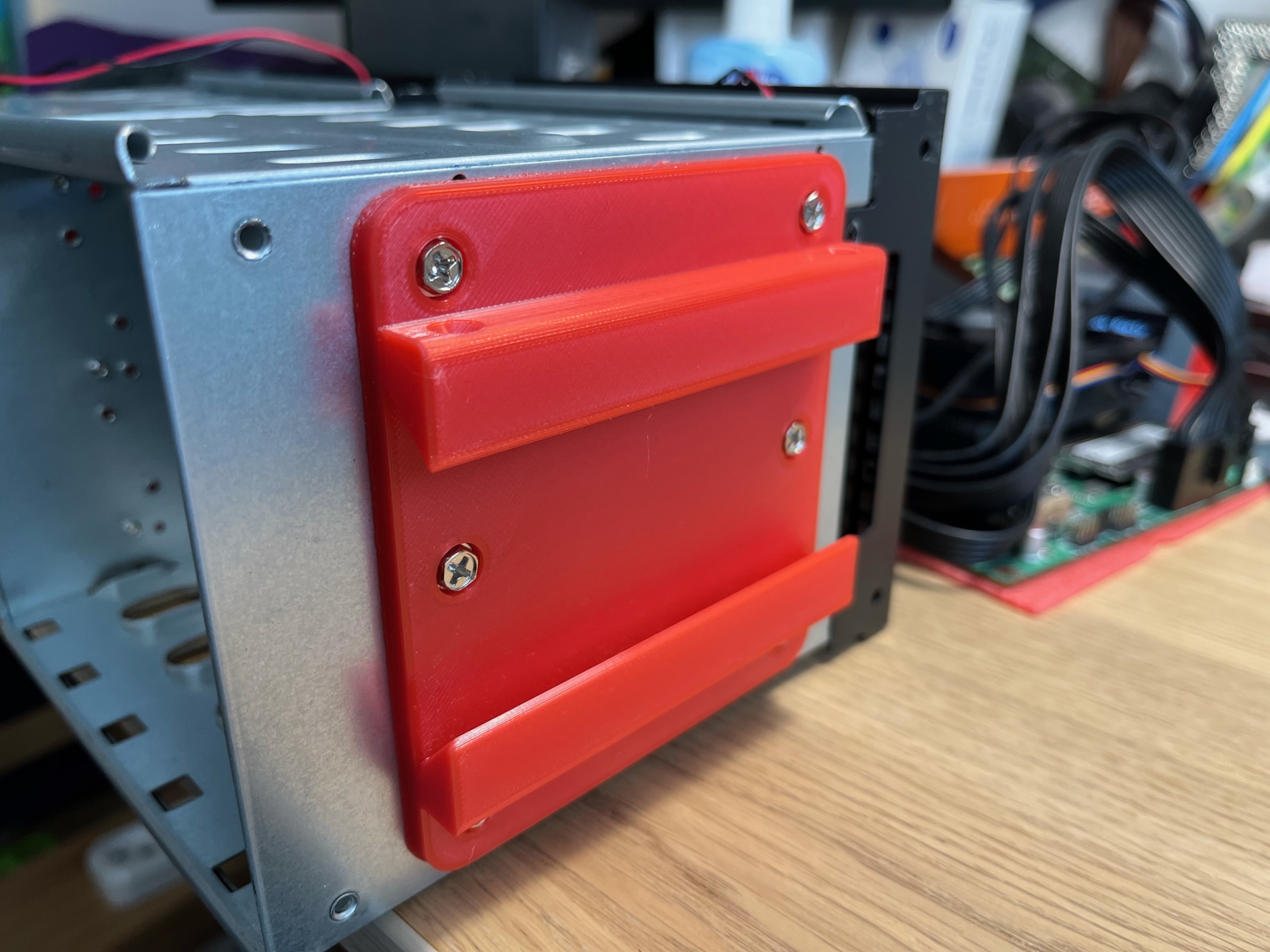

Т.к. на корзинах уже были отверстия с резьбой под стандартные корпусные болты 3.5х6 решено использовать их для крепления проставок

Высота корзины 146 мм, корпуса 350 мм. Проставки 3, и хотел сохранить симметричность, итого высота проставки ~19 мм

Проставка может состоять из двух деталей и скрепляться по соединению ласточкин хвост. Фиксировать положение можно через отдельные болты

У меня есть 3d принтер, поэтому будем проектировать детали под печать

По итогу размышлений и проектирования во Fusion360 родилась такая модель https://www.thingiverse.com/thing:5848585

Печать PETG AbsMaker, температура 240/60, 3 слоя стенки, заполнение 50% сетка, высота слоя 0.16

Крепление к корзине

Между собой закрепляем с помощью болтов 3х20 с потайной головкой (тут еще старая модель, подвинул отверстия для скрепления между собой)

К корпусу деталь крепится болтами с гайками (я решил использовать болты диаметром 5 мм). Сверлим корпус, прикручиваем деталь. Тут есть лайфхак. Можно отметить только одно отверстие и просверлить. Далее деталь закрепляется, выравнивается и затягивается этот один болт гайкой. Сами отверстия в детали можно использовать как направляющие для сверления остальных отверстий (я ограничился 4). Загнутые части на передней части сверху и снизу я предварительно просто спилил дремелем. По расстоянию между корзинами и блоком питания под провода из блока питания заложил примерно 35 мм.

Финальный вид после сборки:

Итоговый размер получился 32 см в длину, 35 см в высоту и 17 в глубину (без учета проводов под диски). Более чем компактно для сервера на 10 дисков, на мой взгляд.

Из дополнений было решено сохранить возможность включения через кнопку и светодиоды состояния. Их решил поставить на сам корпус сверху, между БП и корзинами. Модель данного крепления (под штатные кнопки 8.5х8х5) https://www.thingiverse.com/thing:5848598. К нему в итоге допроектировал крышечку, чтобы можно было закрыть (случайные нажатия, яркий свет светодиодов).

Еще из дополнений для снижения вибрации и шума было решено весь корпус поставить на полиуретановый туристический коврик. Нашел на wilberries идеально подходящий под размеры (нужно было подрезать немного по ширине). Крепил ее просто на двухсторонний скотч. Цена 250р.

Итоговое сравнение после установки в нишу

Установка ОС

Кратко опишу некоторые особенности, с которыми я столкнулся при установке операционной системы для сервера. Я уже использовал в предыдущем сервере openmediavault, сама ос даже в базовом функционале меня более чем устраивала, решил на новый сервер ставить ее же.

От ос мне нужно:

Веб интерфейс

Уметь через него монтировать и форматировать диски

Создавать софтверные массивы

Создавать шары samba

Ну и мониторинг (в который я смотрю очень редко)

Последняя (на момент написания статьи) версия уже готовой ос openmediavault (6.0) при установке не могла определить сетевые адаптеры, поэтому решено было устанавливать omv через установку его пакетов на ванильный debian (подробнее процесс описан тут https://docs.openmediavault.org/en/stable/installation/on_debian.html).

Версия debian-11.6.0-amd64-netinst встала без проблем и сразу при установке определила адаптеры.

Самого пользователя в рамках установки я назвал omv, хотя, наверное, это не столь важно. Сами пакеты openmediavault я ставил под root.

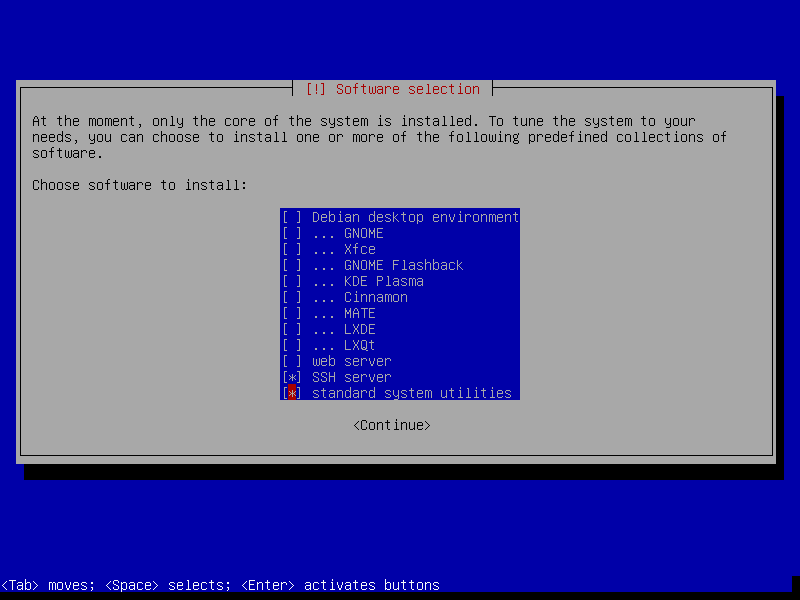

Из важного, на что стоит обратить внимание - это выбор GUI. И в рекомендациях самого openmediavault и логически для сервера gui не нужен, поэтому на шаге Software selection оставляем только ssh и стандартные утилиты.

После установки дополнительно выдал возможность подключения под root через ssh (пример настройки) и далее уже сами пакеты ставил копи-пастой из мануала.

После установки подключаемся через веб интерфейс с указанием логина/пароля admin:openmediavault

Также столкнулся с проблемой, что через соединение через роутер шары samba открывались без проблем, а при соединении напрямую нет. Поставив уровень логирования самбы на максимум с syslog было обнаружена строка smbd[7182]: No protocol supported !

Решение нашлось не сразу и было связано связано с тем, что на машине windows была включена версия протокола SMB1. Подробнее можно почитать про это в статье.

Отключается поддержка командой в PowerShell, запущенной от имени администратора: Disable-WindowsOptionalFeature -Online -FeatureName smb1protocol

Видимо старый сервер (я как-то и не замечал:) ) работал еще на протоколе SMB1, и после отключения на windows машине подключение к новому серверу напрямую по smb заработало. Почему-то при подключении через роутер ошибки не было.

На этом все! Спасибо за внимание!

UPD

Резервное копирование и восстановление системного диска

В комментариях был поднят вопрос про восстановление системного диска, решил этот вопрос (правда, не в автоматическом режиме), делюсь опытом.

Также в комментариях был поднят вопрос о качестве текущего диска и его бренда, поэтому дополнительно был приобретен новый диск m2 ADATA и решено было переехать на него, как раз отработав план резервного копирования и восстановления.

Сами данные на системном диске после первоначальной настройки, в моем случае, достаточно статичны (потерю логов и минорных изменений самого дистрибутива не считаем за потерю). Т.е. защищаемся от сценария: системный диск полностью вышел из строя, на его место нужно поставить новый физический диск с полностью идентичными данными. Можно было бы пойти (как советовали в комментариях) по пути резервного копирования данных, но я решил, что более простым вариантом будет бэкап именно всего диска.

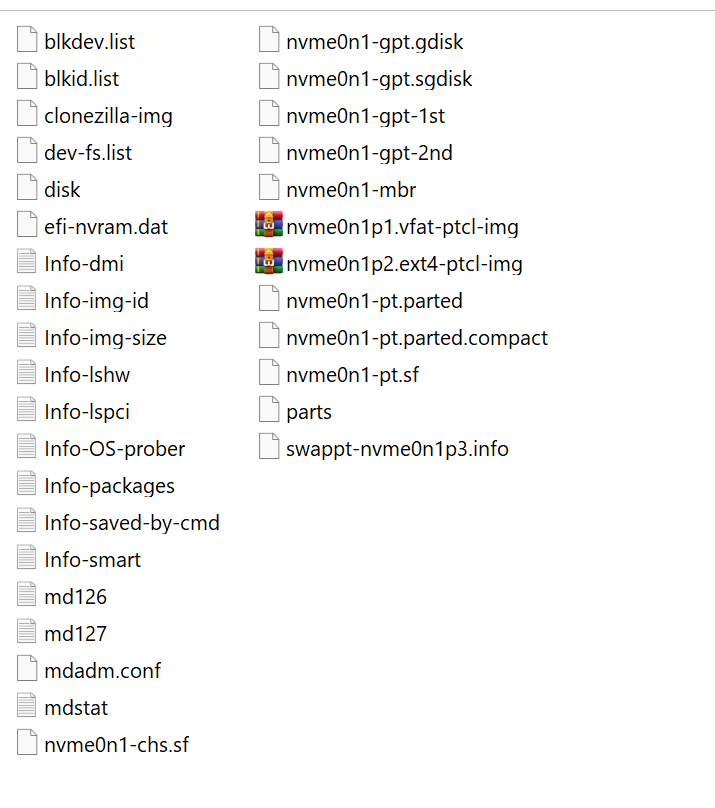

Для таких целей идеально подходит решение Clonezilla. Этот live-дистрибутив позволяет сделать образ диска целиком (включая загрузочные области), и восстановить из образа на голый жесткий диск всю систему. Тк debian и omv как раз установлены на отдельный диск это и будет сценарием восстановления.

В самом openmediavault есть отдельный плагин для установки и работы с Clonezilla (вроде как команда на перезагрузку с загрузкой clonezilla, копирование образа на флешку) , но плагин у меня не установился (возможно, связано с тем, что я ставил не сам omv, а его пакеты поверх debian), поэтому все операции выполнялись вручную с загрузкой с флешки с установленным дистрибутивом Clonezilla. Я брал стабильную версию дистрибутива https://clonezilla.org/downloads/download.php?branch=stable , указав формат iso для последующей записи на флешку. Варианты создания загрузочной флешки можно посмотреть тут.

Немного про запись флешки

В качестве инструмента для записи я выбрал Rufus, с ним не было проблем при записи того же дистрибутива debian или omv, но после записи Clonezilla на новую usb2.0 16Гб флешку Transcent JF V30 почему то загрузка доходила до консоли grub, вместо загрузки clonezilla.

Попробовав unebootin - тот же самый результат.

Поменяв саму флешку на usb3.0 Kingston ошибка исчезла, Clonezilla загрузился.

Я не стал разбираться в причине, но сделал вывод, что не все флешки одинаково полезны и даже если в момент записи образа все хорошо, то не факт, что с нее получится загрузится.

Сам процесс снятия образа и восстановления достаточно подробно со скриншотами описаны в документации Clonezilla:

Другие сценарии использования можно посмотреть в документации.

В общем, сам процесс достаточно прост, в момент определения дисков (в терминах Clonezilla - репозиториев для сохранения образов) дистрибутив сам выкидывает из списка диски, которые содержатся в софтверных raid. Поэтому в качестве репозитория может выступать или диск с файловой системой, которую можно просто смонтировать (диск не в raid), либо отдельная флешка, либо сама флешка live-usb.

В моем NAS как раз был один диск, который был просто смонтирован и не состоял в raid, поэтому решено было образ сохранять на него.

Сам процесс (+архивация образа) занял около 3 минут, итого на диске появилась в выбранной директории папочка с именем2023-02-16-17-img . Имя можно поменять в момент создания образа, но я все оставлял по умолчанию.

Далее установка нового диска m2, повторная загрузка Clonezilla и запись образа на новый диск.

Процесс восстановления прошел на удивление быстро и теперь у меня есть резервный диск, который, в случае сбоя системного диска, достаточно физически поменять в сервере и получить восстановленный NAS.

Сам образ из себя представляет папку с файлами, объем которой в моем случае составил ~1.1 Гб

Еще важный момент: сами файлы образа Clonezilla создает под root, поэтому просто так (в случае использования в качестве репозитория диска NAS) с ними что-то сделать будет нельзя, и пришлось дополнительно заходить по ssh под root и выполнить команду chmod -R 777 2023-02-16-17-img

Комментарии (102)

Vassam

00.00.0000 00:00И почему эту плату, скажите на милость, нельзя запитать только от 12в источника, как у асусовских ИоТ плат? Бп больше, чем все остальные компоненты.

Dkstr Автор

00.00.0000 00:00+5А чем питать 12 3.5 дисков?

madcatdev

00.00.0000 00:00А главное, зачем? Вместо нескольких дисков малого объема лучше купить 1-2 большого.

aik

00.00.0000 00:00+5Вместо нескольких дисков малого объёма лучше купить несколько дисков большого объёма. Это раз.

Если диски уже есть, то купить к ним материнку за 10 тысяч может быть дешевле, чем менять диски. Это два.

aborouhin

00.00.0000 00:00Много дисков относительно малого объёма дают возможность построить из них какой-никакой RAID-5, а лучше RAID-6, потратив на избыточность не половину купленных терабайт, а поменьше.

Причём это будет даже лучше, чем много дисков большого объёма (предположим, на них есть деньги и в них есть потребность), потому что RAID из огромных SATA-дисков на таком железе будет ребилдиться месяц, за который с ненулевой вероятностью ещё один диск вылетит, добитый нагрузкой от ребилда :)

aik

00.00.0000 00:00RAID из огромных SATA-дисков на таком железе будет ребилдиться месяц

Ну это смотря что у вас за рейд. С нынешними дисками и скоростью записи в 150-200 мегабайт даже 16 терабайт у вас должны ребилдится максимум пару суток.

aborouhin

00.00.0000 00:00+4Оно так в лоб не считается, увы. Чтобы ребилдить, скажем, RAID-5 из 12-ти 16 Тб дисков при замене одного из них, надо прочитать 176 Тб, записать 16 Тб, и всё это время загружать CPU (у нас же RAID софтовый будет на этой железке). И это будет не идеально последовательное чтение/запись, позволяющие достичь максимальных скоростей. И не очень понятно, какая на этой материнке суммарная пропускная способность на все эти 12 SATA-портов, т.е. в какой части получится распараллелиться. А если в это время NAS ещё и использоваться будет - вообще грустно.

У меня дома RAID-6 (ZFS RAIDZ2) из 8-ми дисков по 4 Тб, ребилдится почти неделю, при том, что в CPU/RAM там ничего не упирается (2 6-ядерных Xeon'а / 192 Gb), а система установлена на отдельном RAID из SSD-шек. Так что месяц я прикинул исходя из этого опыта :)

P.S. Вот и на serverfault со мной согласны :)

https://serverfault.com/questions/967930/raid-5-6-rebuild-time-calculation

You can calculate the best-case rebuild rate fairly simply: as rebuild is sequential, the needed time is capacity / transfer rate. For example, rebuilding a 10 TB disk with a 200 MB/s transfer rate needs at least 10000000 / 200 = 50000s = ~14h.

Now take this result and trow it away, as it is an overly optimistic scenario: it suppose 100% disk availability for the rebuild operation and totally sequential reads/writes. Toss in the mix some non-rebuild (ie: application) load, cap the rebuild itself to 30% (to not grind other applications to an halt) and you are suddenly in the 10x (eg: a week) rebuild time.

aik

00.00.0000 00:00+2Так пятый raid довольно тупой, там никакой высшей математики нет, в отличие от zfs. На древнем turion'е в gen7 у меня диск на 6ТБ ребилдился меньше суток (4 диска в массиве RAID5).

А вот с zfs я ребилд не пробовал, но там проц просто с записью уже страдал. Гигабит обеспечить мог, но ценой стопроцентной загрузки.не очень понятно, какая на этой материнке суммарная пропускная способность на все эти 12 SATA-портов

По идее, у процессора восемь линий pci-e 3.0, то есть 8 ГБ/сек должен обеспечивать. Думаю, что на 12 винтов этого хватит. Тем более, что они там, похоже, разнесены на три контроллера, а не мультипликатор портов стоит.

aborouhin

00.00.0000 00:00Проц у меня на ZFS нагружен не был вообще сколько бы то ни было значимо. Вероятно, у меня всё упиралось именно в шину PCIe, на которой стоит аппаратный RAID-контроллер (он просто пробрасывает диски как есть, сам никакого RAID не делает, т.к. для этого осознанно выбран ZFS). Т.к. материнка там хоть и нафаршированная по максимуму для своего поколения, но весьма древняя.

P.S. Да, глянул характеристика железа, меня, по ходу, больше всего лимитирует контроллер, который PCIe 1.0x8, т.е. 2 ГБ/с всего (и это в идеальной ситуации, которой не бывает). На материнке при этом три слота PCIe 2.0x8, т.е. если купить ещё один такой контроллер на Авито (а стóят эти раритеты нынче копейки) - можно улучшить ситуацию... а это идея, запишу, если к тому времени, как вернусь физически к этой железке, не решу апгрейдить её кардинально. Спасибо, что заставили про это задуматься!

aik

00.00.0000 00:00Ну так не сравнивайте два шестиядерных ксеона и калькуляторный турион.

Да просто ксеон против целерона — у меня 1610T (2c) при транскодировании видео даже на одном потоке был на 100% загружен, а 1265L (4c/8t) — процентов на десять только.

Так что то, что для ваших ксеонов фоновая нагрузка, то для маленького одинокого двухъядерника может быть делом всей жизни. :)

rPman

00.00.0000 00:00zfs для hdd дисков очень много лишних телодвижений головкой делает (для hdd даже 1% лишних движений может уронить скорость в разы), тестировал на машине с 16гб ram и тестовыми 1тб массивами (по уму должно было хватит памяти без дедупликации), возможно ssd кеширование могло как то помочь, но маловероятно

mdadm при ребилде упирается только в линейную запись/чтение дисков и по ситуации в ширину пропускной способности контроллера, даже на слабом железе (процессор материнки в статье очень даже хорош)

OptimumOption

00.00.0000 00:00+1За такое время ребилда можно в тот же день потерять работу, а вот найти потом новую - может вылиться в многомесячный квест :D

aik

00.00.0000 00:00А за какое время ребилд должен делаться, чтобы работу не потерять? Десять минут?

OptimumOption

00.00.0000 00:00за 2-3 часа. далее идёт уже простой по виде админа/девопса (фиговая конфигурация СХД/ недостаточность ИБП/отсутствие резервируемости) с вполне логичным вопросом насчет компетенции нанятого айтишника... или вы считаете, что раз сервак упал - то пусть весь мир подождет?

aik

00.00.0000 00:00Вообще-то, риски заранее оговариваются. Степень резервирования, допустимое время простоя, скорость реакции и т.п. А не «ребилд идёт сутки — админ непригоден». Это раз.

Ну и когда идёт ребилд, массив доступен. Собственно говоря, raid для этого и нужен — чтобы простоя не было, если один из дисков помрёт. Или несколько — в зависмости от вида массива. Это два.

AlexanderS

00.00.0000 00:00А у вас дедупликация включена? 192 — это всё для zfs отдано?

Я себе сделал два зеркальных пула zfs 2х16Tb и отдал под это дело всего 16 Gb оперативки. Дедупликация естественно даже и не включалось. И оно вполне работает, даже скорости особо не режутся. Скраббинг правда двое суток делается, а вот что будет при замене я не знаю, но о холодных бекапах не забываю пока)

aborouhin

00.00.0000 00:00Дедупликации нет, так никакой памяти не напасёшься :) У меня это не только NAS, но ещё и гипервизор на десяток виртуалок разного назначения, так что RAM есть куда девать. Scrub по расписанию раз в месяц, вроде меньше суток занимает.

AlexanderS

00.00.0000 00:00А NAS как используется — под статичные данные (архивы, бекапы, библиотека) или работает с ним как с рабочим диском и туда активно читается/пишется что-нибудь? Я где-то читал что ZFS для второго использовать не очень хорошо именно из-за механизма CoW, но так и не понял почему — из-за нагрузки при любом изменении? Да и ладно бы с ним, если это, конечно, в разумных пределах)

aborouhin

00.00.0000 00:00RAID из SATA-дисков - в основном относительно статичные данные. Сами образы дисков для виртуалок, где больше интенсивность чтения/записи, на другом RAID, который из SSD-шек. Впрочем, там тоже ZFS :) Каким образом использование CoW в ZFS может препятствовать той или иной нагрузке - я тоже без понятия.

vconst

00.00.0000 00:00+1Дедупликация — это уже совсем энтерпрайз. Дома то такое зачем? Хоть в теории? Для каких задач? Не позволить залить две одинаковые фоточки?

DaemonGloom

00.00.0000 00:00Для хранения резервных копий с компьютеров, например. Ну и да, те же фотографии хранить в nextcloud с дедупликацией удобно — у всех могут быть свои фотографии в альбомах, но для общих событий одинаковые фотографии будут храниться только один раз.

vconst

00.00.0000 00:00+1Дома то?..

Ну отсечет дедупликацая десять, пусть даже сто фоток. Эффективность в домашнем нас — совершенно запредельно низкая

DaemonGloom

00.00.0000 00:00Да, поэтому мне больше нравится идея дедупликации из Windows, когда этот процесс запускается периодически и не требует особых ресурсов.

vconst

00.00.0000 00:00Да не нужен он в домашнем использовании. А этот НАС не на Винде же, там все ручками

AlexanderS

00.00.0000 00:00Ну как зачем… экономить память… только явно не оперативную) Экономия будет, конечно, никакая, но, в конце концов, если человек дома до ZFS дорос, то чего бы ему не хотеть дедупликацию-то чисто по идеологическим соображениям?

vconst

00.00.0000 00:00Чисто поразвлекаться?

AlexanderS

00.00.0000 00:00Было бы интересно получить опыт и вживую посмотреть как оно работает. Но в целом да, поразвлекаться)

AndreyAf

00.00.0000 00:00какой размер dev.raid.speed_limit_min?

```

Dual Core AMD Opteron(tm) Processor 265

cat /proc/mdstat

Personalities : [raid1] [raid6] [raid5] [raid4]

md128 : active raid6 sdd[0] sdm[9] sdg[3] sdk[7] sdf[2] sde[1] sdj[6] sdn[10] sdl[8] sdi[5] sdp[12] sdo[11] sdh[4] sdq13

64464294400 blocks super 1.2 level 6, 512k chunk, algorithm 2 [13/13] [UUUUUUUUUUUUU]

bitmap: 6/44 pages [24KB], 65536KB chunkдиски одинаковые

scsi 6:0:13:0: Direct-Access ATA TOSHIBA MG04ACA6 FS1K PQ: 0 ANSI: 6

```

3-4 дня ребилдился

higin

00.00.0000 00:00У вас не оптимальное количество дисков в рэйде. Для radz2 количество дисков должно быть: 2^n + 2

Dkstr Автор

00.00.0000 00:00Диски у меня уже были (6шт). Но хотелось бы иметь запас под еще дополнительные диски и более простой способ их замены. Теперь всегда будет место поставить еще 1-2 диска и смигрировать данные.

aik

00.00.0000 00:00itx делится на «тонкий» (thin) и «стандартный». Тонкие питаются от «ноутбучного» БП, стандартные — от стандартного. Здесь, не смотря на то, что габариты получаются как у тонкого, вся разводка от стандартного.

Ну и экономия какая-никакая — не надо, к примеру, конвертор питания ставить с 12В на все остальные напряжения, от внешнего БП берёшь сразу готовое.

denisbasmanov

00.00.0000 00:00+3AMD Radeon SSD диски это и не AMD, и не Radeon, а черт знает что такое — я б выбрал что-то более породистое.

Видимо будет настроен также и автобэкап системного диска (кстати вне зависимости от породы системного диска)?

Dkstr Автор

00.00.0000 00:00С диском, видимо, я продешевил) Возможно, приобрету под замену тот же intel.

С автобэкапом пока не думал, хотел после основных настроек один раз вручную загрузиться с live cd clonezilla и сделать бэкап.

Но если у вас есть пример гайда по настройке автобэкапа и последующего восстановления, то с радостью бы изучил.

aik

00.00.0000 00:00Хотя бы просто периодически архивировать содержимое /

Интеловские ссд, кстати, не панацея — тоже дохнут или глючат временами.

Dkstr Автор

00.00.0000 00:00Вот просто это как? Я пока наиболее простой, но ручной процесс планировал , как получу еще один диск, как раз протестировать по описанию https://clonezilla.org/clonezilla-live-doc.php

И не просто забекапить, но и восстановить диск из образа на новый

aik

00.00.0000 00:00Просто архиватором.

Образом оно не развернётся, конечно, придётся поставить чистую систему, а потом сверху распаковать бэкап.

denisbasmanov

00.00.0000 00:00На десктопе Timeshift для автобэкапа, но там GUI. Консольной версией не пользовался для планировки автобэкапов, только для восстановления

Кажется консольная автопланировка в нем есть, но тут мне сложно, я не настоящий линуксоид)

https://dev.to/rahedmir/how-to-use-timeshift-from-command-line-in-linux-1l9bTimeshift использует rsync, на его базе есть куча вариантов, скрипты несложные. Но наверное тогда уж проще rdiff-backup

А на сервере rdiff-backup .sh скрипт, запланировал его в кроне:

nice -n 10 rdiff-backup /home/ubuntu/minecraft/ /home/ubuntu/minebak/rdiff/

nice -n 10 rdiff-backup --force --remove-older-than 4W /home/ubuntu/minebak/rdiff/# ето мой скрипт с путями который по крону срабатывает

rdiff-backup --list-increments /home/ubuntu/minebak/rdiff/

# показать список инкрементов, в них можно подсмотреть даты

rdiff-backup -r 2020-09-08 /home/ubuntu/minebak/rdiff/ /home/ubuntu/minetest

# восстанавливаться через дату

rdiff-backup -r 30D /home/ubuntu/minebak/rdiff/ /home/ubuntu/minetest

# вроде так можно

rdiff-backup -r 2022-12-19 /home/ubuntu/backup/mineserver/ /home/ubuntu/minebak/

# 2022-12-19 вот так норм во временную папку и протестить. но тока дата а как время я пока хз

aik

00.00.0000 00:00внутри самой платы расположены 2 порта USB.

Странно расположены, нижним вообще пользоваться реально?встречал только на материнских платах HP Microserver

На многих серверных материнках такое есть.12 потов SATA

А на каком контроллере?

lspci показать можете?Нет дополнительных разъемов (PCI-E), расширить платами не получится.

Подозреваю, что для извращенцев можно взять переходник с m2 на PCI-E.

Кстати, а в углу там что за разъём, около саташных портов?

Dkstr Автор

00.00.0000 00:00root@omv3:~# lspci

00:00.0 Host bridge: Intel Corporation Device 4e24

00:02.0 VGA compatible controller: Intel Corporation Device 4e55 (rev 01)

00:04.0 Signal processing controller: Intel Corporation Device 4e03

00:08.0 System peripheral: Intel Corporation Device 4e11

00:14.0 USB controller: Intel Corporation Device 4ded (rev 01)

00:14.2 RAM memory: Intel Corporation Device 4def (rev 01)

00:15.0 Serial bus controller [0c80]: Intel Corporation Device 4de8 (rev 01)

00:15.2 Serial bus controller [0c80]: Intel Corporation Device 4dea (rev 01)

00:16.0 Communication controller: Intel Corporation Device 4de0 (rev 01)

00:17.0 SATA controller: Intel Corporation Device 4dd3 (rev 01)

00:19.0 Serial bus controller [0c80]: Intel Corporation Device 4dc5 (rev 01)

00:19.1 Serial bus controller [0c80]: Intel Corporation Device 4dc6 (rev 01)

00:1c.0 PCI bridge: Intel Corporation Device 4db8 (rev 01)

00:1c.1 PCI bridge: Intel Corporation Device 4db9 (rev 01)

00:1c.4 PCI bridge: Intel Corporation Device 4dbc (rev 01)

00:1c.6 PCI bridge: Intel Corporation Device 4dbe (rev 01)

00:1c.7 PCI bridge: Intel Corporation Device 4dbf (rev 01)

00:1e.0 Communication controller: Intel Corporation Device 4da8 (rev 01)

00:1e.3 Serial bus controller [0c80]: Intel Corporation Device 4dab (rev 01)

00:1f.0 ISA bridge: Intel Corporation Device 4d87 (rev 01)

00:1f.3 Audio device: Intel Corporation Device 4dc8 (rev 01)

00:1f.4 SMBus: Intel Corporation Device 4da3 (rev 01)

00:1f.5 Serial bus controller [0c80]: Intel Corporation Device 4da4 (rev 01)

01:00.0 SATA controller: JMicron Technology Corp. JMB58x AHCI SATA controller

02:00.0 SATA controller: JMicron Technology Corp. JMB58x AHCI SATA controller

03:00.0 Non-Volatile memory controller: Silicon Motion, Inc. SM2263EN/SM2263XT SSD Controller (rev 03)

04:00.0 Ethernet controller: Intel Corporation Ethernet Controller I225-V (rev 03)

05:00.0 Ethernet controller: Intel Corporation Ethernet Controller I225-V (rev 03)

aik

00.00.0000 00:00jmicron, да ещё две штуки похоже. Плюс чипсетный. Забавное решение, может быть интересно, если разводить виртуалки — тогда можно отдельные контроллеры туда пробрасывать. Впрочем, проц+память много виртуалок завести не позволят.

Dkstr Автор

00.00.0000 00:00В углу, как я понимаю, это MSATA

the_vitas

00.00.0000 00:00Это miniPCI-E (не m.2) например для wifi карты. А то что вы имели ввиду, это NGFF и он такой же m.2 разъем, только с другим ключем.

Dkstr Автор

00.00.0000 00:00К сожалению, устройств с таким разъемом у меня нет. Мануала, чтобы точно убедиться, также нет. Но по описанию платы путем исключения я предположил, что это msata

AlexanderS

00.00.0000 00:00+2Если собирать NAS то уж поднимать на нём zfs или btrfs. А значит крайне желательно иметь память с ECC. А ECC тут нет, понятное дело — откуда контроллер ECC в селероне? Странное решение для продукта позиционирующегося как NAS, да ещё и Industrial. Для файлопомойки конечно сгодится, но как решение для ответственного хранения как-то сомнительно.

Dkstr Автор

00.00.0000 00:00+1Я в части про материнку постарался это отметить. Под zfs она не подойдет, но мой кейс именно файлопомойка). Софтверный raid0 или просто диски без всяких рейдов. Что то ценное я хранить на таком решении не планировал

aik

00.00.0000 00:00+3откуда контроллер ECC в селероне?

Возможно, будете удивлены, но в некоторых целеронах таки была поддержка ECC. Не в этом, правда.сли собирать NAS то уж поднимать на нём zfs или btrfs.

Всё зависит от потребностей. Миллионы людей хранят данные без ЕСС-памяти на простой ntfs и не особо при этом страдают. Так что NAS и zfs — не синонимы.

AlexanderS

00.00.0000 00:00+1Проблема ещё в том сколько хранить. Если пару сотен гигов — это одно. А если очень много данных, то тут возникает интересный нюанс. С увеличением ёмкости дисков никак не поменялась вероятность ошибок на бит. И получается, что сейчас покупая диск терабайт на 20 (2*10^13 бит) и полностью заполняя его мы уже получаем цифру соразмерную со значениями BER (10^14...10^16). Понятно, что тут смотря что хранить — для большой фильмотеки один вылетевший бит вполне можно допустить. А для каких-то иных данных потери могут быть недопустимы, поэтому в этом случае без RAID или zfs никуда, но даже с ними приходится делать периодические чеки, чтобы данные «не протухли».

aborouhin

00.00.0000 00:00Именно. Когда я первый раз про это прочитал - сразу озадачился тем, что поменял аппаратный RAID на программный средствами ZFS. Потому что у ZFS есть scrub, который можно запускать по крону, и если что - он обнаружит и исправит ошибки на уровне файловой системы.

А на втором сервере вот вообще аппаратный RAID-0 на ext2... потому что он под видеонаблюдение, и утрата архива записей за прошлый месяц не станет катастрофой :)

AlexanderS

00.00.0000 00:00В этом плане ZFS может ошибку при чтении файла исправить и на лету прямо при обращении к этому файлу — поблочное хранение контрольных сумм рядом с файлами вполне себе этому способствует. Но scrub на всякий случай я отключать тоже не стал)

aik

00.00.0000 00:00А если очень много данных,

Хранить «очень много данных» — это обычно не та задача, под которую собирают NAS на целероне. Кстати, btrfs и без ecc замечает, что данные портятся. Я у себя именно с ней и понял, что память битая.даже с ними лучше делать периодические чеки, чтобы данные «не протухли».

С zfs их не «лучше» делать, их там необходимо делать. Не так давно одни ютубовские хипстеры запороли массив на петабайт из-за того, что забыли scrub настроить по расписанию. У них там начали вылетать диски и, если бы всё было нормально, они бы эти диски просто заменили на новые, сделали ребилд и жили дальше. Но не вышло.

AlexanderS

00.00.0000 00:00+1ECC нужно же только для снижения вероятности косяка из-за самой памяти. Потому как если на этапе сброса блока на диск данные попортятся или CRC блока, то ничего с этим уже не поделаешь и вся эта надёжность ФС выглядит блёкло. Так-то у меня и zfs работала год на обычной памяти и ничего страшного вроде не случилось.

А у вас btrfs на чём крутится?

Я когда-то делал выбор между этими двумя ФС и выбор как-то склонился к zfs. А вот прогадал или нет пока непонятно)

aik

00.00.0000 00:00ECC нужно же только для снижения вероятности косяка из-за самой памяти.

Да. Потому лично я не особо упарываюсь в эту сторону. Просто память стал дольше тестировать перед установкой. Впрочем, ЕСС на домашний сервер я в итоге воткнул — но только потому, что недорого попалось 64 гига подходящей.

А так — данные же на сервере только хранятся. А обрабатываются они на других компьютерах, где обычная память, обычные файловые системы — и если они будут испорчены там, то сервер про это и не узнает.А у вас btrfs на чём крутится?

У меня unraid стоит, там базовый массив вообще на xfs, а btrfs они используют под диски кэша, куда активная запись идёт. Там обычно живёт кэш записи массива, рабочие файлы виртуалок и докеров и т.п.

aborouhin

00.00.0000 00:00У меня пару лет был btrfs. Ещё на предыдущей конфигурации сервера, RAID там был аппаратный, железо поскромнее, диски поменьше (8*1 Тб). Я читал, что btrfs не очень стабильна, но решил, что это всё в прошлом. И в один прекрасный день у меня без всяких внешних к тому причин запоролся раздел на 4 Тб. Все магические ритуалы, подсказанные гуглом, для его восстановления, провёл, понял, что если что и вытяну - но небыстро и не всё. Так что снёс я эту btrfs, докупил оперативки, отформатировал в ZFS и вытянул ~2 Тб из облака, благо всё, что было хоть минимально жалко потерять, туда дублировалось.

rPman

00.00.0000 00:00Если собирать NAS

подскажите доступное по цене решение, сравнимой компактности и функционалу?

иметь память с ECC

Судя по всему не желание делать ECC нормой на десктопных машинах (а это становится все актуальнее) имеет исключительно меркантильную цель — искусственное удержание серверных решений в дорогом сегменте. Это легко сделать, если производителей процессоров два с половиной.

AlexanderS

00.00.0000 00:00Я свой NAS построил на б/у E3 1240L V5, выписанном за немного денег из Китая. Правда машина изначально под гипервизор ESXi собиралась, NAS там виртуалкой гостит, но всё равно — суть-то та же. Однако всё остальное кроме проца вылилось в копеечку, так что насчёт компактности и функционала — без проблем, а вот цена подкачает)

Домашние серваки раньше можно было собирать на материнках класса Workstation и 5- летних б/у Xeon, которые совсем за философские цены появлялись на али после очередной волны апгрейдов «больших дядек». От всей этой ситуации у интел видимо знатно подгорело и в новых поколениях чипсетов они начисто выпилили поддержку ксеонов. Получается оригинально — вроде как Workstation само по себе позиционируется под тяжёлые задачи, но ECC теперь в ней нет)

vconst

00.00.0000 00:00Старое серверное железо очень плохо тем, что жрет как не в себя и даже в простое греется, шумя кулерами. У меня был комп на двух старых ксеонах, на 1080 заикался, но грелся и гудел — будто там 4к рендерилось. Валяется в ящике теперь

RuslanHamhoev

00.00.0000 00:00Мой опыт-вибрацию создают кулеры, они же передают её на корпус и винчестеры, если жёстко прикручены к корпусу. Попались как-то резиновые крепления для кулеров, что-то вроде шпильки, котороая продевается в отверстие кулера и вставляется в соответствующее отверстие в корпусе, при этом кулер физически не касается корпуса.

И ещё. Нежелательно ставить корпус в воздухонепроницаемый шкаф, нужна вентиляция, иначе будет сильно греться.

Dkstr Автор

00.00.0000 00:00Как раз приобретенные под замену стоковым кулеры DeepCool UF 120в комплекте идут с резиновыми шпильками. Пока решил прикрутить жестко, там посмотрим.

И ниша не совсем герметична. Она собрана без задней стенки и есть снизу зазор около 1 см, через который поступает воздух снизу. Также пока дверца всегда приоткрыта для выхода теплого воздуха. В будущем планирую в боковой стенке проделать отверстие именно под вентиляцию и установить на минимальных оборотах кулер 200х200 для отвода теплого воздуха. Так вся ниша будет как бы корпусом с принудительной вентиляцией.

RuslanHamhoev

00.00.0000 00:00Попробуйте поставить кулера на шпильки, разница должна быть заметна даже на слух. Важный момент-вибрация корпуса передаётся на винчестеры, в случае HDD там головки, ну вы понимаете. Не знаю почему винчестеры до сих пор кремят жёстко к корпусу, их бы тоже надо крепить на резиновые шпильки.

Принудительная-это хорошо, но можно и без неё обойтись, отверстий должно быть достаточно, конвекция будет работать.

ZlobniyShurik

00.00.0000 00:00В некоторых корпусах и винчестеры через резиновые шайбы-проставки к корзине крепятся (например, Define XL R2).

Другое дело, что не каждому сей корпус подойдёт, как по цене, так и по габаритам. Зато, да, он реально тихий и с кучей посадочных мест под винты.

agathis

00.00.0000 00:00В приличных корпусах диски ставились через резиновые шайбы уже лет 20 назад как минимум

n2dt4qd2wg9b

00.00.0000 00:00Вот бы 2,5Gbps LAN - было бы супер.

aborouhin

00.00.0000 00:00Вообще уже пора бы на 10 Гбит/с переползать, а то у меня уже WiFi (6) не быстрее провода только потому, что точка доступа сама подключена кабелем на скорости 1 Гбит/с. Но 10 Гбит/с как-то не спешат идти в народ, разрыв в ценах с обычным гигабитом пока очень серьёзный.

n2dt4qd2wg9b

00.00.0000 00:00+1Посмотрите connect-x карты для машин. Tp-link 10G свич на Али. Уже ближе к народу, чем кажется.

aborouhin

00.00.0000 00:00+1Карты как раз наименьшая проблема...

Посмотрел на свитчи на Али. Сейчас у меня 28-портовый + 8 портовый + сервера напрямую в роутер подлючены, всё это забито уже под завязку. Прикинем, что мне надо купить на замену. Свитч на 16 портов SFP+ (больше не нашёл) - 53,5 т.₽. С оптимистичным описанием, мол прошивка только на китайском, но с гугл-транслейтом Вы разберётесь :) Плюс 16 собственно модулей SFP+ в него. Плюс ещё один свитч, у которого хотя бы 1 SFP+, а остальные порты 1G, чтобы подключить всякие камеры и пр, чему 10G не надо (или не хватило). Плюс роутер с как минимум 2 портами SFP+ и соответствующей производительностью, т.к. между VLAN'ами трафик пойдёт через него, и чтобы не потерять на этом все прелести 10G, линк между ним и свитчем должен быть хотя бы 20G. Ну это вот всё уже совсем не демократично получается.

А дальше совсем весело, потому что точек доступа, которые подключались бы на 10G, я не знаю вообще. Сейчас купил Unifi U6 Pro, пропускная способность в теории 5,6 Гбит/с, но подключение кабелем на 1G. Т.е. даже в самой идеальной картине два WiFi 6 устройства, расположенные прямо в упор рядом с точкой, будут только между собой резво общаться на скоростях более 1G (и то если им повезёт оказаться в одном VLAN, а домашняя сеть у меня изрядно сегментированная), а при доступе к проводному сегменту сети им достанется по 500M на нос.

Далее ноутбуки. Встроенный Ethernet (да, у меня он есть!) 2,5G. Док-станций, которые имели бы порт 10G, тоже как-то не нашёл (хотя в пропускную способность TB4 укладываемся, но уже конкурируем за неё с мониторами).

Про медиаприставки даже не говорю. Ну им, ладно, в 1G не уложиться надо постараться (даже видео 8k 60fps, вроде, проходит с запасом).

В общем, как-то, во-первых, всё равно дорого. Во-вторых, всю инфраструктуру на 10G не переведёшь, а вложить кучу денег, чтобы всё всё равно упёрлось в "последнюю милю" - так себе идея.

P.S. И это ещё я совсем не уверен, что 10G по меди, разведённые по всему дому, вот так без проблем заведутся и заработают на 10G. Там, насколько я понимаю, к помехозащищённости требования на порядок строже, чем у 1G. А разводить оптику - это надо или покупать сварочник и все прибамбасы к нему (ещё за такие же деньги, как всё перечисленное в начале), или постоянно нанимать сторонних ребят (вероятно, дешевле, но больше мороки).

n2dt4qd2wg9b

00.00.0000 00:00Так сколько реально вам 10G портов то надо? 7 не хватит? Если хватит - то TP-link

Если нужен аплинк с более чем 10G то смотрите старенькие аристы свичи.

С оптоволокном проблем нет - покупаете претерминированные LC-LC патчкорды и растягиваете их по дому. Если супер красиво нужно, то растягиваются до розеток, в которые ставите coupler-ы.

Всё что близко к свичу - не нуждается в оптике - подключайте DAC-кабелями.

Выбор точки не удачен, лучше бы с портом 2,5G. 10G порт легко снабжается медным трансивером 2,5G и будет ок.

Свич с 24портами 1G и 2х10G - CRS326-24G-2S+

10G по меди, если не превышено 30м длины - будет ок, но дороже оптики

aborouhin

00.00.0000 00:007 не хватит, 16 хватит. Но, повторюсь, купить придётся минимум 3 железки: свитч 10G, свитч 10G/1G (и с PoE на 1G портах), роутер с 10G. Дорого :(

Готовые оптические патч-корды я один раз протянул на второй этаж (между свитчами), больше повторять не хочу :) Ну это специфика моих коммуникаций, пропихивание коннекторов в длинную гофру... По этой же причине сомневаюсь в том, что взлетит 10G по меди, много где прямо рядом с силовыми проводами проложено, 1G-то терпит...

Точка доступа с 2.5G - а подскажите модель? Их в целом-то не то, чтобы огромный выбор с WiFi 6, микротики вон не разродились до сих пор.

P.S. Ну и в целом, я перевод своего дома на 10G пока рассматриваю чисто теоретически. Добраться бы для начала до того дома... А разговор-то начался с того, что 10G пока не очень демократично по цене, ну вот я на своём примере (где точно 1G уже кое-где стал узким местом) и прикинул порядок цен... На фоне микрота 3011 и пары длинковских 1G свитчей, которые там стоят сейчас, - это в разы дороже, как ни крути

aik

00.00.0000 00:00Для себя я посматриваю на точка-точка — отдельную сетевушку в сервер, отдельную в свой основной комп и соединить их напрямую.

Остальным же 10 гигабит не нужно, обойдутся и гигабитом.

Ещё бы интернет гигабитный кто провёл… Но более-менее согласны были только МТС, с абоненткой в 25 тысяч в месяц.

n2dt4qd2wg9b

00.00.0000 00:00Тогда, думаю, нужно идти по пути наименьшего сопротивления, и переходить на 2,5G. Если нужно.

DarkTiger

00.00.0000 00:00А разводить оптику - это надо или покупать сварочник и все прибамбасы к нему (ещё за такие же деньги, как всё перечисленное в начале)

Ну, положим, такими же деньгами ограничиться точно не удастся. Дорогое это удовольствие. Не говоря о том, что на этом оборудовании работать надо уметь. А вот пригласить в частном порядке, через Авито, к себе домой монтажника от провайдера на час с оборудованием - это и несложно и недорого.

постоянно нанимать сторонних ребят (вероятно, дешевле, но больше мороки).

Много раз в доме сеть перекладывали? Даже если раз в год - ни о чем.

DarkTiger

00.00.0000 00:00Идея хороша, если надо сделать что-то серьезное, но с ограниченным бюджетом. Скажем, массив на 8-12 дисков. Или очень хочется большой объем, но топовые диски без черепичной записи - очень дорогие. Если же нужно 2-4 диска, хранить фотки и фильмы - проще купить 5-7- летний системный блок с 4 SATA разъемами на Авито, поменять вентиляторы и БП на новые от BeQuiet и проделать все те же манипуляции по снижению вибрации. По деньгам разницы особой не будет, большинство денег тратится на диски.

vconst

00.00.0000 00:00Немного фото BIOS

Это же старый добрый Американ Мегатрнедс. У них и ищите мануалПо итогу размышлений и проектирования во Fusion360 родилась такая модель

По виду, туда можно просто поставить 12см кулер плашмя. Нагрузки нет, свинчивать незачем

aborouhin

Если с сетью не как у Вас делать, а оба сетевых адаптера протянуть каждый своей витой парой к роутеру, от основного компьютера так же, и настроить везде bonding - то получим 2 Гбит/с. Если, конечно, роутер не настолько дохлый, что станет в этой схеме узким местом :)

select26

Даже не 2, а 5!

Intel 211 - это 2,5GBps NIC.

Тоже первая мысль об этом была!

Кроме увеличения полосы пропускания получаем надёжность - можно сетевые кабели по одному переключать на лету и трафик даже не прервется.

А вот корпус мне не понравился: потоки охлаждения в корпусе непредсказуемые, пылевых фильтров нет. Как итог: или пылесосить его раз в месяц, или это будет ящик забитый войлоком без охлаждения.

За обзор - спасибо!

dartraiden

Осталось найти роутер с четырьмя 2.5-гигабитными портами (2 для NAS и 2 для ПК). А если дома есть ещё устройства, которым нужен Ethernet, задача усложняется, т.к. 4 порта уже заняты.

Стало быть, придется смотреть уже в сторону маршрутизаторов не домашнего уровня.

vconst

Микротик же?

TerAnYu

Есть с тремя портами:

https://aliexpress.ru/item/1005004182442458.html

Этого продавца не рекомендую.

Versuz

Не очень понимаю зачем именно роутер. Если связь наружу в 'эти ваши интернеты' не нужна, то возможно остановиться на комутаторе будет заметно экономичнее...

aumi13

учитывая установку в закрытый обьем https://hsto.org/r/w1560/getpro/habr/upload_files/2c9/74f/f19/2c974ff19b0a27d8a173e5635ffda228.jpg

тут больше вопросов про итоговую температуру под нагрузкой

ornic

Давным давно делал в аналогичной икее медиа-сервер с торрентами. Чтобы объем был не замкнутым, во внутренней стенке ставится два вентилятора: снизу на вдув и сверху на выдув. А сам шкаф ставится в угол, чтобы за стенкой был объем воздуха.

rPman

да тут даже щелки у стенки нет, только что если дверь с дырками

Busla

К сожалению так прямолинейно оно не работает: LACP не умеет делить одно соединение на несколько физических линков (для части протоколов это компенсируется multipath'ом), агрегация независимых карт скорее всего окажется несовместима с аппаратной разгрузкой и может заметно сказаться на таком слабом процессоре, плюс накладные расходы по некоторым оценкам выжирают до трети полосы пропускания.

А без протоколов агрегации балансируется только исходящий трафик.

Так что в малых сетях явное деление интерфейсов по назначению/направлению часто оказывается эффективнее.

dimsoft

так балансировать на более высоком уровне, например SMB 3.x умеет мультиченел - проверял на windows server 2019(22) - полностью утилизирует пару каналов

sirota

Для мультиченнел ж надо как раз именно что разные сетевые интерфейсы. Т.е. на источнике и клиента должно быть по 2 сетевки.