Только ленивый не отписался о прелестях ChatGPT, и я, соответственно, как человек не самый ленивый тоже должен что-нибудь сказать по этому поводу. С другой стороны, о волшебных свойствах современных нейронных сетей говорится как-то однобоко - в ключе, что никогда такого не было, и вот опять. У меня не то что бы своя точка зрения на эту тему, и не то что бы свежая, но почему-то мало озвучиваемая.

Историческая

С точки зрения истории попытки собрать нейронную сеть, которая бы как-то поддерживала осмысленный диалог с человеком, делались прямо с самого начала. Можно сказать, что идея сама возникла еще до появления, собственно, нейронных сетей. Идея о машине способной выдавать себя за разумное существо - пройти Тест Тьюринга - является одной из основополагающих для современной информатики и кибернетики концепций - Святым Граалем. То есть к этому стремились столько сколько существуют компьютеры как таковые. И вот, как будто бы, наконец-то, свершилось.

Конкретно же модель GPT (языковая нейросетевая модель основанная на глубоком обучении) была представлена компанией OpenAI еще в далеком, по нынешним меркам, 2018 году. Называть ли эту дату точкой отсчета возникновения чатботов в таком "революционном" смысле дело выбора критериев. Понятно, что GPT не возникла на пустом месте и берет корни от предшествующих моделей, использует ранее известные наработки в области лингвистики, информатики и общих принципов создания ИИ. GPT по сути это такой удачный набор из более общих идей и методов, многие из которых известны аж с 80-х годов прошлого века. А готовый продукт, например ChatGPT, это не более чем результат толкового анализа и кропотливой разметки гигантского количества исходных текстов, которые, к слову, стали доступны как раз только в наши дни.

То есть, с одной стороны, какие-то подобия современных чатботов вполне могли появиться и ранее, будь в распоряжении ученых такое же количество доступной исходной информации. С другой - современные методики обучения и конструирования нейронных сетей очень сильно зависят от новейших разработок в области электроники и использования физических ресурсов новыми способами. Исследования в области нейронных сетей в общем смысле ограничены многими техническими факторами. Существуют более новаторские и смелые подходы к способам повышения эффективности как обучения, так и внутреннего устройства оборудования, но мы их пока не видим в силу отсутствия достаточных технических средств и мощностей.

В общем поставить веху здесь достаточно трудно - это будет лишь неким символическим действием - маркетинговым ходом. Тем не менее нельзя отрицать радикальный скачкообразный прогресс и резкое повышение интереса рядовых потребителей к этим технологиям - его видно невооруженным глазом.

Культурная

Эффект созданный компанией OpenAI открытием общественного доступа к ChatGPT сродни, наверное, прибытию поезда братьев Люмьер или первой общедоступной трансляции телевизионной передачи. Причем и тогда и сейчас большинство узнают о результатах премьеры через третьи руки - благодаря многочисленным восхищенным статьям и отзывам. На деле же как кинотеатры, так и телевидение, были не доступны широким массам напрямую еще достаточно долго. Причем долго не понятно было чем же наполнять новые средства коммуникации. Пройдет еще несколько десятков лет, что бы люди оценили реальный эффект от удобства и пользы.

Так же и здесь - пока не очень понятно как это можно применить. Да, есть уже всякие интересные сценарии, но прямо скажем, это скорее такое хулиганство, а не практическая возможность. Заменять журналистов и поэтов чатботы пока не то что бы готовы. Избавляться от какой-то рутины как, например, у программистов или сценаристов? Возможно. И то уже сейчас хорошо просматриваются границы этих возможностей. Что бы нейросетью пользоваться в качестве помощника надо прежде всего быть самому тем человеком, который может выполнить задачу самостоятельно и объяснить что требуется.

Оптимизм связанный с чатботами лежит скорее в другой плоскости - плоскости маркетинга, рекламы, производства чего-то очень примитивного, но в огромных количествах. Написать рекламное письмо, сделать описание товара, накидать варианты заголовка к статье, подготовить доклад в школе - не более того. Ждать серьезного вклада в жизнь людей от чатботов, мне кажется, преждевременно. Вряд ли мы сможем нынче посадить искусственный интеллект на горячую линию психологической помощи. Не потому что нейросеть легко вычислить - сделать это действительно нынче сложно - а просто потому что нейронной сети нельзя поставить цель. Цель, скажем, отговорить человека от самоубийства. А ведь в связи с этим возникает другой вопрос. А вот не подтолкнет ли чатбот человека с нестабильной психикой к необдуманным действиям?

Этическая

Появление новых массовых явлений, таких как кино или телевидение, всегда сопровождается противоположными тревогами и опасениями. От предсказаний гибели книг и газет, до образования радикальных сект и движений. И тут важен вопрос не столько появления самой технологии, а с применением этой технологии людьми. Причем не только в корыстных капиталистических целях, а в куда более коварных и опасных. Можно ли, например, поставить чатбота на решение каких-то проблем связанных со здоровьем? Можно ли научить чатбота отвечать в выгодном для владельца ключе? Например, натаскать на определенную идеологию или религию.

Мне кажется взволнованность известных и влиятельных людей связанна именно с такими последствиями, а вовсе не из-за веры в восстание машин. Где и как провести черту? Что считать нормой, а что злоупотреблением? Мало ли сумасшедших на земле, которым как-раз не хватало публичного доступа к новым средствам влияния? Если мир журналистики и кинопроизводства в целом эволюционировал сам по себе и нынче поделен более или менее сбалансировано, то как сложится судьба нового вида создания информации предугадать довольно сложно. Теперь люди знают, путем, зачастую, кровавых проб и ошибок, что никакую технологию нельзя пускать на самотек. А лучше всего контролировать её монопольно.

Правовая

Задумываются сильные мира сего наверняка и о правовых коллизиях связанных с применением чатботов. Чьим (не люблю это слов) контентом считать информацию, созданную с применением ИИ? Кто должен отвечать за последствия? Человек сформулировавший запрос, владелец компании, создатель нейросети, группа подготовившая обучающий материал? "Быть или не быть, вот в чем вопрос." - запросит потенциальный самоубийца или террорист. Приложить ли к материалам дела ответ чатбота? На какие вопросы боту лучше не отвечать совсем? В какого бога верить? Какой выбрать пол?

Считать ли использованный корпус текстов общим мнением человечества - среднестатистического человека? Мы с вами хорошо понимаем, что всё-таки ответ будет основан на морально-этических нормах западной культуры. Вряд ли очень много исходных материалов связанных с пониманием то, что хорошо, а что плохо, взятых из регионов Центральной Африки или Средней Азии. Насколько можно научить ИИ специально избегать острые проблемы и отвечать политкорректно и максимально нейтрально? Что такое "нейтрально"? Откуда взять нейтральное мнение?

Масса вопросов на которые нам пока ответов не дают. Да и вряд ли на них можно получить однозначный ответ. А уж тем более сложно всё это регулировать в мировых масштабах. Опять же, кто это будет всё регулировать. Каждое государство по-отдельности, ООН, специальный комитет по ИИ? Исаака Юдовича Азимова, к сожалению, уже с нами нет.

А если бы и был, то что бы он мог сделать? Стали бы к нему прислушиваться в руководствах софтверных гигантов? Да и ведь выводы Исаака Юдовича отнюдь не радужные. Красной линией по всему творчеству проходит мысль о том, что регулировать законами ИИ в общем-то бесполезно. И как бы мы - кожаные мешки - не старались, роботов придется либо контролировать полностью, что у нас уже не особенно получается, либо мы вынуждены будем приравнять их к самим себе. Давать им юридический статус, наделять правами, наказывать, принуждать к труду. Лечить?

Футуристическая

Может ли электрический прибор сойти с ума? По всей видимости, если говорить о сумасшествии как об отклонении от нормы, о сумасшедших ботах говорить уже можно сейчас. Раз их есть несколько вариантов, то существует и математическая норма. А раз есть норма, то есть и отклонение. Что в принципе уже и подтверждается некоторыми эксцессами в работе разных продуктов. Но это техническая формальность. А есть и другой подход к определению нормы.

Можно ли брать за норму человеческий образец и применить его к ИИ? По сути ведь обучающий корпус основывается на относительно нормальных произведениях нормальных в нашем понимании людей. Вряд ли нейросетям скармливают труды Йозефа Геббельса. То есть если отталкиваться от обучающей выборки, то нейросеть не может ничего такого выдумать, что выходило бы сильно за рамки этой выборки. Ожидаем. Это ключевое.

Опять же, это будет сильно зависеть от качества разметки и от множества других субъективных параметров. Может ли один ненормальный человек внедрить нейросети, являющейся плодом труда сотни нормальных людей, "нехорошие мысли", так что бы они проявлялись в её "поведении"?

Более того, мы сейчас находимся на этапе, когда весь доступный обучающий материал всё-таки создан изначально людьми, в большинстве своем нормальными. Но очевидно, что скоро настанет момент, когда в обучающую выборку начнут попадать и материалы созданные с применением ИИ. Во-первых, потому что уже сложно отличить его человеку. Во-вторых, выбор из общей массы информации делается во многом автоматически. Не далек тот день, когда значительная часть материала будет представлять из себя информацию написанную ИИ. А тут о норме уже говорить сложнее.

Не получится ли в итоге так, что нейросети полностью зациклятся на собственных же текстах? И где тогда искать норму? И в какой момент мнение такого чатбота начнет обратно влиять на норму человеческую? Достаточно ведь родится тому поколению, которому будет доступно больше произведений ИИ, чем человеческих. Когда шлейф исходной человеческой мысли и морали растворится в потоке собственных выводов нейронок? А может эту статью написала нейронная сеть?

Юмористическая

Однако не будем пессимистами. Всё-таки до сих пор никакое технологическое новшество не привело к упадку человечества в целом. Да, были трудные моменты, человеку свойственно примерять новое во всех качествах. Как в позитивных, так и в губительных. Будем надеяться что и чатботы нанесут больше пользы чем вреда.

Для меня лично было бы откровением, если бы нейронка научилась шутить. Это то, мне кажется, ради чего вообще стоило развивать это направление. С другой стороны, опять же мне кажется, что это та самая линия за которой начинается настоящий качественный скачок. Всё что придумывают и делают нынче как-то худо-бедно использовать можно, но будет это носить сугубо утилитарный и прагматический характер. По-настоящему страшно станет, когда нейросети научатся отличать конкретных людей, когда контекст станет индивидуальным. Когда ИИ сможет намеренно исказить реальность собеседника таким образом, что человеку станет от этого, например, смешно.

Научится понимать общий культурный и конкретный эмоциональный контекст запроса - а значит сможет направленно влиять на ход мыслей собеседника. Шутить с ним, навязывать эмоцию, видеть границы когнитивных способностей, понимать что человек может счесть сарказмом, а что передергиванием. Мы ведь сами, как существа социальные, основываем общение с людьми на собственном прогнозе умственных способностей собеседников. Мы осознаем и держим в уме контекст, который нам кажется адекватен для другого человека. Получается это не всегда, но чаще всего мы всё-таки угадываем - заканчивается шутка чаще смехом, чем мордобоем.

Юмор как высшее достижение социального взаимодействия имеет на самом деле очень глубокие причины и следствия. Втираться в доверие, лгать, манипулировать, сочувствовать - быть людьми - мы можем благодаря как раз таким тонким материям. И если такого уровня достигнет ИИ вот это уже будет если не точкой, то важной запятой, перед наступлением технологической сингулярности.

А я в данном случае, обращаясь к читателю, рассчитываю, что и он отнесется к написанному с определенной долей юмора и скепсиса.

Запощено под John Murphy - Leaving England

Комментарии (9)

Pastoral

09.04.2023 05:08+1Для меня лично было бы откровением, если бы нейронка научилась шутить.

А почему? Гипотеза: потому, что статья написана не на основе собственно нейронок, а на основе обсуждений нейронок. Сам термин «нейронка» стоит в одном ряду с исторически известными терминами «камень» или «скинь на мыло», это инструменты человека стремящегося избежать понимания того что он понимает что не понимает. Новизна уходит вместе со страхом, понимание приходит вместе с привычкой - специальные термины выходят из обращения.

Что собственно делается «обучением»? Строится аппроксимация. Нейронка не рисует котика, она выдаёт изображение которое, согласно аппроксимации которой её научили, будет воспринято как котик. Ничего не мешает выдавать текст который будет восприниматься как шутка.

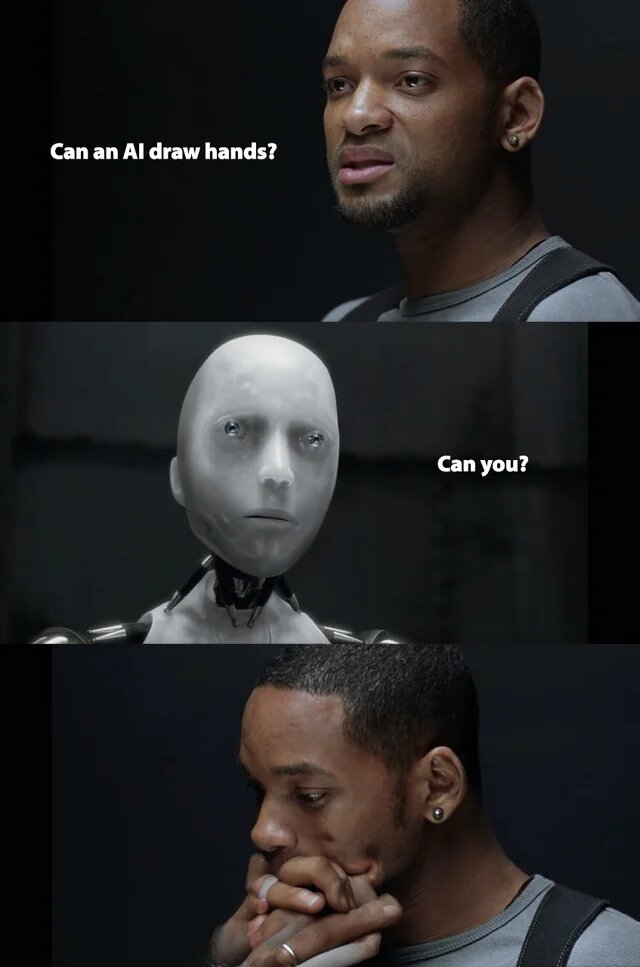

Can an AI draw hands?

У него (были?) проблемы с руками потому, что аппроксимация вообще не знала что рисует руки. Как объяснить - известно хотя бы по переводчику Гугол. Но интереснее дообучить так, чтобы объяснять было не нужно.

Arbeit macht frei

От AI пока видно только три пользы - автоматическое распознование образов (Юлька в бар явилась а ей шестнадцать всего), аппроксимация как таковая (этот пептид перспективный а тот отнюдь) и жёсткое внедрение в массы принципа DRY (творцы уровня подмастерья трепещут и курсы входа в IT гребут последнее как не в себя).

От AI уже видно всего два вреда - помогая разобраться с созданным бардаком (привет второму пилоту) AI содействует созданию ещё большего бардака с которым без AI вообще не управиться и обучение делать хорошо весело и приятно, особенно конкретному человеку, приведёт к тому, что изучают наркологи, снимают в фильмах типа Матрицы, описывают в романах типа Город.

Rembo123 Автор

09.04.2023 05:08+2Ничего не мешает выдавать текст который будет восприниматься как шутка.

Речь не о пересказе анекдотов и добавлении смайлика в конце предложения, а именно об индивидуальном диалоге, когда собеседник понимает, что в данный момент покажется смешным в контексте как самого диалога, так и с оглядкой на возраст, культуру и даже настроение. То что покажется остроумным и смешным одному, другому может показаться оскорблением.

dyadyaSerezha

09.04.2023 05:08никакую технологию нельзя пускать на самотек. А лучше всего контролировать её монопольно.

Да вы, батенька, тоталитарист.

user18383

09.04.2023 05:08+5Мне интересно, автор специально написал в заголовке об или нет?)

perfect_genius

09.04.2023 05:08+1Дивный новый мир, которому было недостаточно фейковых новостей, а теперь сомнения во всём остальном.

whoami

09.04.2023 05:08+1А готовый продукт, например ChatGPT, это не более чем результат толкового анализа и кропотливой разметки гигантского количества исходных текстов, которые, к слову, стали доступны как раз только в наши дни.

Например, GPT в ChatGPT обозначает "Generative pre-trained transformer" - подход в котором не требуются размеченные данные, это и позволяет запихнуть туда гигантские объемы информации без "кропотливой разметки".

Rembo123 Автор

09.04.2023 05:08не требуются размеченные данные

Generative pre-trained в данном случае означает подход смешанного обучения - размеченный начальный датасет предобучает сеть, затем ей скармливаются не размеченные данные на которых идет основное обучение, в ходе которого идет коррекция опять против размеченных данных. То есть без разметки никуда, во-вторых - ручной труд предполагается и при отборе массивов не размеченных датасетов.

SensDj

Военная. Вояки боялись давать право автономным роботам самим определять где враг, а где свои, и стрелять. GPT-4, думаю, справится с этим не хуже человека, а значит можно ожидать полностью автономные танки, самолёты, дроны и т.п.

Alexufo

Перед атакой жертва только должна представиться,иначе чат не поймет.