Итак, SSD Optane 800p построены на той же аппаратной платформе, что и Optane Memory, но при этом имеют в несколько раз больший объем и несколько лучшие характеристики. В целом потребительская линейка Optane теперь выглядит следующим образом.

| Model | Optane SSD 800p | Optane Memory | ||

|---|---|---|---|---|

| Объем | 118 GB | 58 GB | 32 GB | 16 GB |

| Форм фактор | M.2 2280 B+M key | M.2 2280 B+M key | ||

| Интерфейс | PCIe 3.0 x2 | PCIe 3.0 x2 | ||

| Память | 128Gb 20nm Intel 3D XPoint | 128Gb 20nm Intel 3D XPoint | ||

| Посл. чтение | 1450 MB/s | 1350 MB/s | 900 MB/s | |

| Посл. запись | 640 MB/s | 290 MB/s | 145 MB/s | |

| Случ. чтение | 250k IOPS | 240k IOPS | 190k IOPS | |

| Случ. запись | 140k IOPS | 65k IOPS | 35k IOPS | |

| Задержки чтения | 6.75 µs | 7 µs | 8 µs | |

| Задержки записи | 18µs | 18µs | 30 µs | |

| Потр. рабочее | 3.75 W | 3.5 W | 3.5 W | |

| Потр. в простое | 8 mW | 8 mW | 1 W | 1 W |

| Долговечн. | 365 TB | 365 TB | 182.5 TB | 182.5 TB |

| Цена | $199 | $129 | $77 | $44 |

Как видно, из-за маленького объема модуля 3D XPoint даже на 128 Гб удалось получить значительный прирост скорости записи за счет распалаллеливания потоков. Однако в целом характеристики производительности не выглядят выдающимися. Еще одно значительное улучшение — поддержка режима экономии энергии (Idle State). А вот цена за единицу хранения осталась неизменной, и это по-прежнему делает накопители Intel Optane дорогими на фоне прочих SSD.

В распоряжении экспертов Anandtech оказалось несколько модулей Intel Optane 800p, что позволило протестировать не только отдельные накопители, но и RAID-массивы из них, построенные на базе технологии Intel VROC. Приведем результаты основных бенчмарков — с полными результатами тестирования можно ознакомиться на сайте Anandtech.

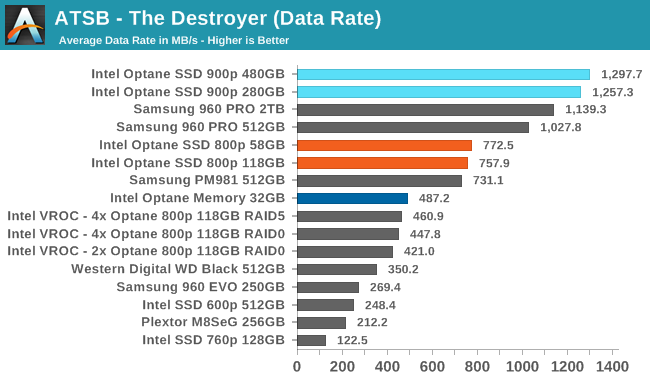

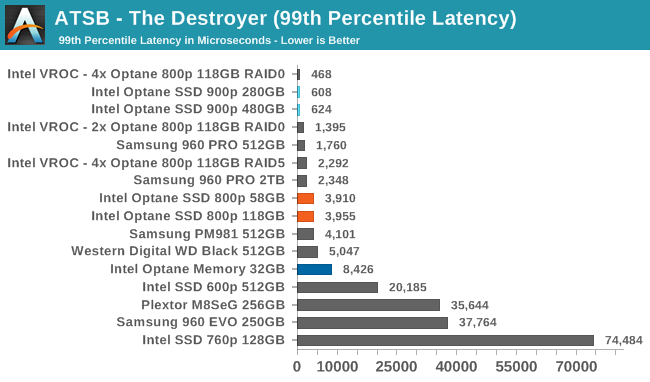

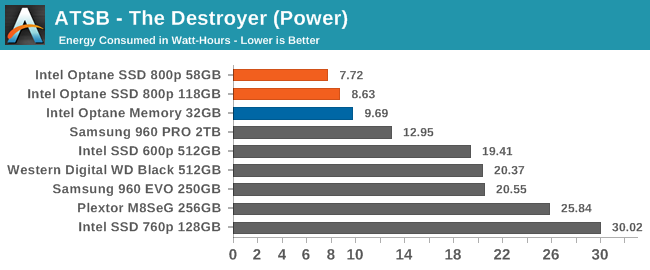

Destroyer — экстремальный тест, эмулирующий длительную активную нагрузку на хранилище.

Скорость обмена данными. Intel Optane 800p быстр, но не превосходит лучших Flash-накопителей. VROC тянет производительность вниз.

Средние задержки — картина та же.

Энергопотребление — отличные показатели, 800р превосходят всех.

Итак, Intel продолжает расширять линейки накопителей Optane. В лице семейства 800р мы видим еще один шаг в направлении потребителей — им предлагается полноценный SSD, который может один использоваться в мобильном компьютере, по характеристикам сравнимый с лучшими Flash SSD, а кое в чем их превосходящий. Если производительность Intel Optane продолжит расти, а стоимость снижаться, это будет интересный вариант для рассмотрения.

Комментарии (49)

Popadanec

15.03.2018 12:09На фоне того же MP500 как то совсем не смотрится. При цене в два раза ниже(того же объёма), скорость работы в два раза выше.

clawham

15.03.2018 12:27Patriot Hellfire m2 даже на 240 гб тихо мирно ржет с него в сторонке. 3200 чтение, 2400 запись, 150 kIOPS и цена 140 уе какбы намекают — оптан гуано… забудь на него смотреть…

amarao

15.03.2018 13:06ой зря. Все эти «ржут в сторонке» обычно быстро заканчиваются, если включить настоящий* бенчмарк.

* настоящий — использующий синхронные записи с fsync или его аналогом.

А ещё ВСЕ ssd (включая ваш любимый hellfire) сосут страшно на пиковых latency. Они ведут себя хуже, чем какой-нибудь WD Green, демонстрируя десятки секунд задержки. И это не производитель плохой, это технология плохая.

Насколько я понимаю, у оптанов такой проблемы нет.

Areso

15.03.2018 13:42А можете написать реальный сценарий, когда можно увидеть такие значения (не 10, хотя бы 1-2с)? При испольховании каких программ? У меня к примеру в основном СУБД...

amarao

15.03.2018 14:13+1Любые критичные операции на файловой системе. Обновления ОС, установка ПО, транзакции в любую базу данных (почтовый клиент, браузер и т.д.). Если в этот момент диск решает, что ВАС ТУТ МНОГО А Я ОДНА, то соответствующее ПО застревает на операции на указанное время. Выглядит это как случайное подлагивание. Если у вас 1 из 10000 запросов так застревает, то это означает, что ваш компьютер ИНОГДА (достаточно иногда, чтобы вы этому никому не могли доказать) замирает без видимых причин в случайном месте.

В серверных же СУБД, это будет кусать постоянно. 99.9% запросов будет обслуживаться за 200мс, а вот оставшиеся 0.05% будут куковать десятками секунд или даже получать таймауты.

Как такое проверять? В линуксах — сделать файловую систему на устройство и запустить вот такой fio:

fio --name `hostname` --blocksize=4k --ioengine=libaio --iodepth=1 --direct=1 --buffered=0 --fsync=1 --rw=randwrite --filename=/mnt/something/bench --size 100G

Тест должен быть достаточно большим (size), чтобы занимать хотя бы 70% устройства, и достаточно долгим, т.к. у многих вендоров толстенные кеши, которые способны пережить первые пол-часа-час теста.

При iodepth=1 никаких разговоров про очередь быть не может, зато может быть вот такое:

Samsung MZ7LM480HCHP-00003: max = 84999 ms

INTEL DC S3610: max= 17922 ms

KINGSTON SEDC1000H800G (nvme): max = 8379 ms

Так что когда герои десктопов, увидевшие гигаиопсы в кеш считают, что ничего слаще нет, у меня есть для них плохая новость.

(более того, оно кусает даже чтение, до 300мс в пике, что вообще смертельный позор, я считаю).

nerudo

15.03.2018 15:35Аж 85 секунд??? Быстрее с дискетой сбегать…

amarao

15.03.2018 15:49По статистике это случается настолько редко, что даже не попадает в максимум для 99.99% персентиля. Т.е. реже, чем 0.01%. Однако, если попался, да, удачи в отладке.

И это (в меньшем масштабе) — общая проблема любых SSD. Так что я от оптанов ожидаю решения именно этой проблемы. Сам их я ещё не щупал, только ожидаю.

nerudo

15.03.2018 15:53Ну это ведь проблема не в интерфейсе, а в контроллере и логике обслуживания flash-памяти, тут принципиально что-то надо менять…

amarao

15.03.2018 16:10Насколько я понимаю проблему, каким бы умным не был контроллер, рано или поздно он обнаруживает, что для записи нужно сбросить блок. А это долго. И дальше вариант: а) ждать б) забить на fsync и сделать writeback в) делать persistent cache (который тоже может забиться).

Ключевая проблема тут — в тормознутости flash-памяти.

Mad__Max

16.03.2018 02:39Это не проблема самого флеша, а контроллеров. Гигантские задержки (в секундах) это обычно тупая реализация алгоритма обслуживания флэша в контроллере. Например очень многие контроллеры грешат тем, что при поступлении команды TRIM зачем-то начинают чистку (стирание освободившихся блоков) в приоритетном режиме просто забивая на обработку всех остальных операций (в т.ч. на общение с хостом).

В результате удалив крупный файл (после чего ОС автоматом пошлет контроллеру диска TRIM со списком освободившихся секторов) многие контроллеры можно почти полностью «повесить» на секунды-десятки секунд прежде чем они обработают следующие стоящие в очереди операции — пока он будет очищать не только очередной блок флэша (реально нужный в данный момент для записи), а вообще весь объем удаленного файла, скажем гигабайт 10-20 за раз.

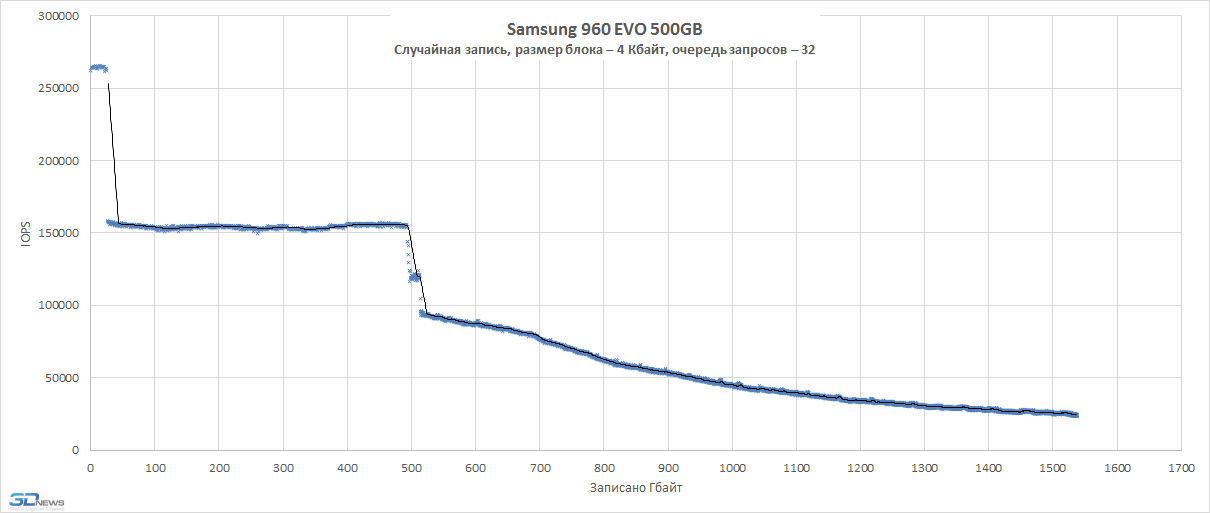

Хорошие контроллеры подобным маразмом не страдают и приоритеты расставляют правильно: в первую очередь — обработка запросов хоста, а все обслуживание идет в фоне, когда есть ресурсы или непосредственно перед записью но в минимально необходимом объеме (а все остальное так же откладывается «на потом» — когда будут свободные ресурсы). И как результат на них подобных аномальных задержек не возникает. Вот для примера непрерывная перезапись нескольких полных объемов диска на хорошем контроллере:

При таком объеме непрерывной записи никаких заранее подготовленных резервов и кэшей не хватает, под конец идет уже запись прямо в неподготовленный флэш с его затиранием «на лету», а не заранее. По ступенькам на графике это хорошо видно — 1 короткая полочка — это отрабатывают DRAM и SLC кэши, 2я длинная полка в объеме примерно равной общему объему накопителя — запись в «свежий» (заранее подготовленный) флэш, а дальше — «работа с колес», без предварительной подготовки, с перемещением данных и затиранием блоков непосредственно перед каждой очередной операцией записи.

arheops

15.03.2018 23:06Впечатления хорошие. Мускл работает в 5-10 раз быстрее nvme в нашем патерне загрузке(практически только запись и сканирование).

mistergrim

15.03.2018 15:59Настоящий бенчмарк — это реальные сценарии работы.

amarao

15.03.2018 16:08apt-get dist-upgrade — реальный сценарий.

ceph, фигачащий fsync на каждое IO — реальный сценарий.

почтовый клиент, транзакционно сохраняющий базу локальных писем — реальный сценарий.

Все они могут в любой момент застрять на секунды или десятки секунд потому что «ну так получилось».

clawham

15.03.2018 17:09Вопервых она есть и у оптанов а во вторых — проблемы начинаются после непрерывной записи 60 гигабайт данных на почти заполненный диск. это для примера у хелфайра. так то я регулярно и в диспетчере задач вижу 2700 3200 1900 чтения или записи при распаковке огромных архивов, проверке антивирусом и т.д. ну а в тестах все просто — есть тесты которые не умеют многопоточность и там что винт что рейд что оптан что любой ссд — покажут чтото типа 200-500 мб/с а есть нормальные и те показывают максимум.

У ссд на нанде проблемы только с записью поверх только что стертых данных. так что если я свой хелик форматну и пару часиков он постоит в компьютере с виндой включенный то я смогу его перепрошить всеми 240 гигами данных без запинки. рим свою черную работу сделает. но если стереть диск удалением виндовым и сразу же попытаться в него писать — естественно вы будете по 100 мсек ждать пока сотрутся 8 чипов nand памяти одновременно т.к. только что свободных чипов с подготовленными стертыми страницами небыло. но это крайне маловероятный сценарий работы обычной домашней станции, средства разработки программ и даже видеомонтажа. я например всем этим занимаюсь на компьютере с 3 тб сигейтом (выдает 300 мб/с чтения) и двумя ссд — один на 512 сата3 а второй системный хелик на 240 гб. там система и часть легковесных временных файлов. ни разу ни сталкивался с проблемой того что мне было некуда писать. занято у меня на хеле примерно 70 гиг. остальное свободно и это его спасительный плот. когда я много хочу писать — у меня есть 120 гиг чистого пространства. отдельный медленный ссд я храню для оперативных временных выходных файлов. стираю я его форматированием. так он делает сразу всем чипам всем страницам трим занимает 20 секунд и у меня снова 512 гиг с записью 480 мб/с есть. если надо больше — есть винт сигейт — пишет он 260 мб/с зато по меркам ссд — безлимитный по ёмкости.

оптан не пробовал у меня увы чипсет z170 а оптан вышел на месяц позже(сволочи) но менять проц мамку память ради оптана с заявленными(заметьте не протестированными в реальных тестах а заявленными) 700 метров в секунду записи — о чем можно ещё говорить? Я лично надеялся что будет лимит перезаписи в районе 10-15 петабайт но нет — все как у обычных nand накопителей… не понятно в чем преимущества.

Раскажите мне пожалуйста о них. и чтоб вы не думали что я мало пишу я покажу вам скрин моего вспомогательного ssd

www.dropbox.com/s/ttp09wwrzuwnsd9/%D0%A1%D0%BD%D0%B8%D0%BC%D0%BE%D0%BA%20%D1%8D%D0%BA%D1%80%D0%B0%D0%BD%D0%B0%20%281%29.png?dl=0

этому накопителю уже третий год пошел. как видите записано на него «рекордные» 40 терабайт. в пересчете на запись в день выходит всего 40 гигов в день. никаких проблем сожрать 40 гиг данных в день ни у одного ссд не будет. хоть единоразово хоть зазбито по кускам на весь день.

хелфайрик то вообще намного проще себя чувствует

www.dropbox.com/s/nrtpm3kvquxkzvq/%D0%A1%D0%BD%D0%B8%D0%BC%D0%BE%D0%BA%20%D1%8D%D0%BA%D1%80%D0%B0%D0%BD%D0%B0%20%281%29.png?dl=0

всего реальных 3 гига за почти год с момента приобретения.

ну и о тестах:

www.dropbox.com/s/ug2nsmricmpwp4g/%D0%A1%D0%BA%D1%80%D0%B8%D0%BD%D1%88%D0%BE%D1%82%202018-03-15%2016.01.46.png?dl=0

amarao

15.03.2018 18:43Evo — консьюмерские железки. При fsync-операциях тормозят, а высокую скорость показывают только в writeback-режиме и на чтение. Я их начинал бенчмаркать под нагрузкой, но где-то в районе обещания закончить бенчмарк через неделю, проект закрыли досрочно.

Во всех этих тестах (на картинках у вас) вы бенчмаркаете write-back кеш устройства. Это быстро и замечательно, и если там кондёр, то с этим можно жить.

Но если говорить про устоявшуюся производительность — нет. Я только что описал как это выглядит. Моменты, когда не должно тормозить, но тормозит.

clawham

15.03.2018 19:03просто поверьте что я лил на этот ссд 200 гиговый файл непрерывным потомок 2.3 гига в секунду и он успевал его жрать. просто примите как данность. Он умеет сжимать данные высвобождая как можно больше страниц под очистку.

кеш работает когда чистых страниц для моментальной записи на флешку уже нет. кэш вообще по другому работает и его мало. не 240 гиг увы. с обычными ссд типа эво там да там печаль после примерно 20 гиг записанного скорость падает до 200 мб/с это да. но это не касается хелфайра

amarao

15.03.2018 20:29Линейная запись — это одна из самых простых задач для SSD. Сложил в write-back буффер, накопилось, записал.

Реальная тяжёлая нагрузка для SSD — непрерывное рандомное IO мелкими блоками с требованием persistent storge (т.е. запретом на использование writeback, а точнее, с требованием FLUSH). Такие операции требуют от SSD постоянно осуществлять переупорядочивание блоков, их чтение и т.д.

Если бы всё, что нужно было бы компьютерам, это линейная запись, то мы бы спокойно жили с жёсткими дисками (которые делают 150-200Мб/с без особых проблем).

Кроме того, я вам говорю про max latency, а вы мне в ответ — про поток данных в секунду.

Ближайшим аналогом будет очередь в супермаркете.

— Клиент А: я на кассе 40 минут ждал.

— Директор Б: У нас пропускная способность 20000 человек в час!

Каким образом клиенту А станет легче от того, что директор Б поднимет пропускную способность до 30000 человек в час, если в очереди надо будет ждать не 40 минут, а 50?

clawham

15.03.2018 20:47ему станет просто намного мегалегче так как дождавшись очереди он прохреначит чек на 100500 товаров за 0.1 секунду а не будет все эти 40 минут хреначить на скорости 1 товар в секунду… так то он вроде и не стоял в очереди но финишный результат то такой же? не?

второе — нахрена такие частые флуши на винт если есть 64-128 гиг озу и отказоустойчивое питание? расскажите как раньше на винтах серверы работали а сичас на ссд даже консюмери внезапно зачали по 80 секунд тормозить? вы о чем? или раньше небыло серверов?

Хотите флушить 100500 раз в секунду все 240 гиг — пажалста купили 128 гиг оперативки ддр4 и вперед.

Я говорю что именно в хелфайре очень много самостоятельных флешек. 64 помоему. и потому у него операции стирания записи хорошо паралелятся… ну а переорганизация блоков рандомами конечно это беда если занято больше половины винта но так извините меня это я и сказал — панацея — взять ссд не в 90% требуемого места а 25% и тогда и с этим не будет никаких проблем. остальное компенсировать кэшем в оперативке. всеравно обьясните мне причем тут оптан если у него все те же проблемы + низкая пиковая пропускная способность шины контроллера? 3200 хелфайровских это ж почти потолок для 4х линий пцие(3900 помоему там теоретический предел) а у оптана всего 600? это что такое? вы о чем? Вы нашли где какое-то конкретное железо тормозит и кричите об этом? нормальные люди ищут сильные стороны железа и эксплуатируют их а слабые места обходят 10-й дорогой… но если цель обосрать нанд и продать оптан то конечно же да так делать можно… но только мы-то понимаем — чушь это все. ничего оптан за свои деньги не дает! ни скорости ни надежности ни долговечности ни ёмкости. так о чем разговор?

amarao

15.03.2018 20:54Флаши нужны каждый раз, когда выполняются критические файловые операции. Базы данных, системы управления конфигурациями, инсталляторы.

Я объяснил как устроена сегодняшняя ситация с SSD — они быстры 99.99% времени, а оставшееся — как получится, включая задержки больше, чем были на HDD. Остальное — ну, уверены, что ничего слаще консьюмерской SSD нет, так всё же замечально!

Я не поддерживаю оптаны, я их ни разу не щупал, но планирую. В этой ветке я описал что я ожидаю от оптанов (снижение max latency), и что очень плохо в текущей ситуации по индустрии с SSD.

arheops

15.03.2018 23:37Вам флаши не нужны пока вы не получили убитую файловую систему, например, на файле с паролями фаерфокса.

Потом резко понадобятся.

arheops

15.03.2018 23:32Если влом искать, то вот www.theregister.co.uk/2017/03/19/optane_ssd_released

и вот www.storagereview.com/intel_optane_800p_nvme_ssd_review

А 850 evo — ну у меня стоит в ноутбуке. хороший дешевый ssd. Но, изивините, 10к операций там не бывает в реальной жизни. Я не в курсе как получить QD64 для ее 300к, даже на тестах серверных так не получается.

я тестировал nvme корпоративного класа и 375gb optane, на softlayer. Разница прыгает от 5 до 10 раз для mysql для моей конкретной нагрузки.

clawham

15.03.2018 23:55эво я привел для примера. он дешевый и тупой и с проблемами. helfire он nvme и на порядок быстрее этого ево

gshamshurin

15.03.2018 12:49Не хватает killing feature.

Автоматическое кэширование данных с HDD (как в Optane Memory) могло бы стать такой фишкой. То есть система и всё что пользователь сам пожелал хранится на быстром SSD, а то, с чем он периодически работает и обычно хранится на HDD (например, вернулся к проекту энной давности) при необходимости «кэшируется» на SSD без участия юзера и апдейтится на HDD при завершениии работы. Таким образом мы имеем и экстремально-быструю загрузку всех приложений (плюс PCI-E SSD) и быструю работу со всей актуальной на данный момент информацией (плюс обычного SSD) и имеем большой объём хранилища занедорого (плюс HDD), и лишний бэкап последних открытых файлов.

При этом HDD при неактивности можно останавливать — раскручивать только перед выключением для бэкапа.

Emily_Watson

15.03.2018 13:14+1Зачем покупать 120гб оптан, если почти за те же деньги можно взять самсунг эво 250гб?

Т.е. есть прирост в производительности, но замечу ли я разницу?

Потому что разницу в 120 гб и 250 гб я точно замечу под систему, т.к. для бекапов места будет мало?

hc4

15.03.2018 13:27Основной профит оптана — на порядок более низкие задержки при чтении.

В основном это даёт существенный выигрыш на операциях с мелкими блоками в 1 поток.

При куче потоков или линейных операциях разницы конечно не заметить.

По моим представлениям — это типичная нагрузка в играх, при подгрузке ресурсов.

Другой вопрос — будет ли заметный эффект, т.к. современный SSD + RAM Cache итак неплохо справляются.

Не зря оптан позиционирют в первую очередь для корпоративного сегмента — различные бигдаты просто тащутся от оптана.

Turbojihad

15.03.2018 13:39Обычному пользователю — незачем. И за те же деньги можно уже купить эво 500Гб.

springimport

15.03.2018 16:54Если предположить что приложение запускается за 20 секунд на 850 evo, то за сколько оно запустится если будет какой-нибудь самый быстрый ssd на m2?

Сам обладаю и хочу понять, надо ли думать на счет более быстрых ssd.Einherjar

15.03.2018 17:18Всегда вот почему то считал что важнее то как приложение работает а не сколько оно запускается, а это уже сильно зависит от того что за приложение и с каким типом данных оно работает. Но в какое обсуждение ssd ни придешь — везде люди только и делают что запускают/закрывают приложения с утра до вечера. Хоть бы кто в них работал.

springimport

15.03.2018 17:37Вот у меня есть PHPStorm с проектом на несколько К файлов. Индексация с нуля занимает около минуты и в это время нельзя нормально работать. Да, нечасто. Да, не критично. Если бы вместо минуты было бы 30 секунд — было бы очень хорошо.

А еще запускать что-то приятно. Как и смотреть на прогрессбар :)

arheops

15.03.2018 23:10Есть вообщето тесты для разных игр. Но если приложение — игра, и данные в ней НЕ упакованные, то гдето за 10 секунд. Если упакованные — то за 18.

creker

15.03.2018 23:48Примерно за столько же за редкими единичными исключениями. Скорости SSD в потребительских задачах давно превысили порог, когда они являются узким местом. Упирается все в других железки — процессор, память — которые не могут быстрее обрабатывать данные, чтобы нагрузить на полную диск. Хоть какой SSD ему поставь или вообще RAM диск. Достаточно посмотреть тесты 960 pro, лучший вариант на рынке, против SATA SSD. Разница практически отсутствует. Узкое местом в виде дисковой системы исчезло еще на SATA. Что собственно и видно с optane — на потребительском рынке ему нечего особо делать даже если они разберутся с мизерными объемами и большой стоимостью.

hc4

15.03.2018 13:14Почему в графе «Память» для всех накопителей указано «128Gb 20nm Intel 3D XPoint»?

Это же не значит, что во всех оптанах стоит один и тот же 128 гиговый чип, программно ограниченный?

arheops

15.03.2018 23:23Кстати, амазон вчера начал продавать меньшую версию, сходу со скидкой до $116-91.

Большей версии пока нету.

n-krd

Очень хотелось видеть в табличках с характеристиками: температурный диапазон. Бытует мнение что на морозе теряются данные.

LuckyLy

А также температуру во время работы.

Поставил упомянутый ниже MP500 в рабочий ноутбук и теперь жалею — ниже 70 температура накопителя не падает практически никогда. Интенсивная запись/чтение почти мгновенно разогревают до 80 и выше.

Хотелось бы знать о таких сюрпризах заранее.

Popadanec

Да, тут согласен, греется он постоянно. Хотя у меня 50-60 градусов не превышает.

Но вот скорость работы, это нечто. Все операции завязанные на него выполняются фактически мгновенно.

Даже после OCZ Trion 150, разница заметна. Если игра с него могла грузится минуту полторы. То с МР500 10-15 секунд.