Почему изучение ИИ должно ограничиваться лишь кругом создателей ИИ?

Что, если бы поведение людей на всех масштабах изучали бы только физиологи; от функционирования человеческого тела до появления социальных норм, от работы финансовых рынков до создания, распространения и потребления культуры? Что, если бы лишь нейробиологи занимались изучением преступного поведения, разрабатывали нормы образования и придумывали правила для борьбы с уклонением от налогов?

Несмотря на растущее влияние с их стороны на нашу жизнь, наше изучение машин с искусственным интеллектом происходит именно в таком ключе – им занимается очень ограниченный круг людей. Учёные, создающие ИИ – специалисты по информатике и робототехнике – практически всегда оказываются теми, кто изучает поведение ИИ.

Специалисты по информатике и робототехнике, создавая свои ИИ для решения определённых задач – а это сама по себе задача не из лёгких – чаще всего фокусируются на том, чтобы их детища выполняли предназначенную им функцию. Для этого они используют различные проверочные наборы данных и задачи, делающие возможным объективное и непротиворечивое сравнение различных алгоритмов. К примеру, программы классификации электронной почты должны соответствовать проверкам на точность разделения почты на спам и не спам, используя некую «точку отсчёта», определённую людьми. Алгоритмы компьютерного зрения должны правильно распознавать объекты в размеченных людьми наборах изображений, таких, как ImageNet. Робомобили должны успешно проехать из точки А в точку В при различных погодных условиях. Игровые ИИ должны победить наилучшие из имеющихся алгоритмов, или заработавших определённую репутацию людей – к примеру, чемпионов мира по игре в го или покер.

Такое ориентированное на задачи исследование поведения ИИ является пусть и узким, но весьма полезным для прогресса в областях ИИ и робототехники. Оно позволяет быстро сравнивать алгоритмы на основе объективных и общепринятых критериев. Но достаточно ли этого для общества?

Представитель племени искусственного интеллекта (Artificial Intelligence, AI)

Нет, недостаточно. Изучение поведения интеллектуального субъекта (человека или искусственного интеллекта) необходимо проводить на других уровнях абстракции, чтобы правильно определить проблемы и придумать решения. Поэтому у нас есть так много дисциплин, занимающихся изучением поведения человека на различных масштабах. От физиологии до социологии, от психологии до политологии, от теории игр до макроэкономики – мы приобретаем дополняющие друг друга перспективы, описывающие индивидуальное и коллективное поведение людей.

В своей знаковой книге 1969 года «Науки об искусственном», нобелевский лауреат Герберт Саймон писал: «Естественная наука – это познание природных объектов и явлений. Хочется спросить, не может ли существовать „искусственной“ науки – познания искусственных объектов и явлений». В соответствии с его представлением, мы агитируем за необходимость создания новой, отдельной научной дисциплины «машинное поведение»: научного изучения поведения, выказываемого умными машинами.

Эта новая дисциплина интересуется конкретным исследованием машин не как инженерных артефактов, а как нового класса действующих лиц, с их уникальными паттернами поведения и экологией. Что важно, эта область пересекается с, но отличается от информатики и робототехники, поскольку она подходит к изучения машинного поведения с наблюдательной и экспериментальной точки зрения, не обязательно учитывая внутренние механизмы работы машины. Машинное поведение похоже на то, как изучение поведения животных – известное, как этология – и поведенческая экология изучают поведение животных без концентрации на физиологии и биохимии.

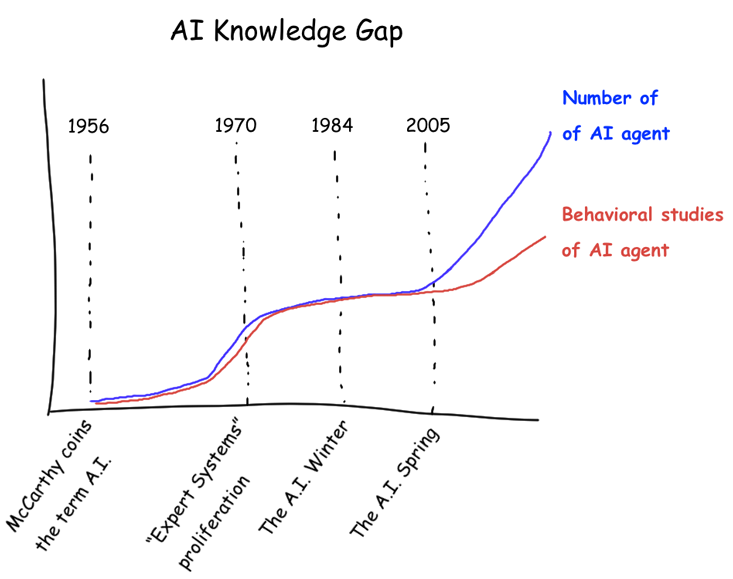

Разрыв в знаниях – предполагаемое расхождение между количеством систем ИИ и количеством исследований, описывающих поведение этих систем

К нашему определению новой области «машинное поведение» необходимо сделать уточнения. Изучение машинного поведения не подразумевает наличия у машин собственной воли – то есть, социальной ответственности за свои действия. Если чья-то собака укусит прохожего, ответственность за неё будет нести хозяин. Тем не менее, полезно изучать – и эффективно предсказывать – поведение собак. Точно так же, машины вплетены в более крупную социально-техническую ткань, к которой относятся и люди, отвечающие за работу машин, и вред, который машины могут нанести другим.

Второе уточнение состоит в том, что машины демонстрируют поведение, фундаментально отличающееся от животных и людей, поэтому необходимо удержаться от стремления к антропоморфированию или зооморфированию машин. Даже если взятые из областей изучения поведения людей и животных методы могут оказаться полезными для изучения машин, машины могут выказывать качественно отличающиеся, совершенно чуждые нам формы интеллекта и поведенческие паттерны.

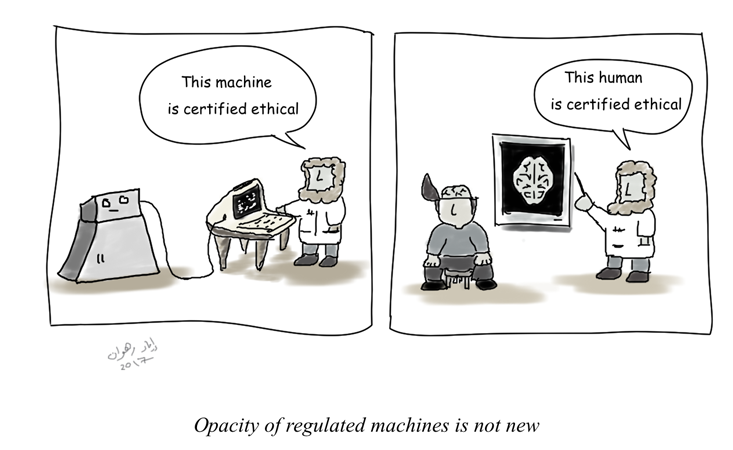

Учитывая эти оговорки, мы утверждаем, что отдельная новая дисциплина, занимающаяся изучением машинного поведения, будет как новой, так и полезной. Есть много причин тому, почему нельзя изучать машины, просто исследуя их исходный код или внутреннее строение. Первая – непрозрачность, обусловленная сложностью: многие ИИ-архитектуры, такие, как нейросети с глубинным обучением, демонстрируют внутренние состояния, которые невозможно легко интерпретировать. Мы часто не можем поручиться за то, что ИИ оптимален или этически пригоден, изучая его исходный код, точно так же, как не можем поручиться за пригодность человека, сканируя его мозг. Более того, то, что мы считаем этичным и подходящим для общества сегодня, со временем может постепенно меняться. Социологи могут отслеживать эти процессы, но сообщество ИИ может не уследить за ними, поскольку свои достижения они измеряют по-другому.

— Эта машина определённо этична.

— Этот человек определённо этичен.

Ещё одна мотивация к изучению машинного поведения без учёта их внутренней структуры – непрозрачность, вызванная защитой интеллектуальных прав. Многие алгоритмы, использующиеся на постоянной основе – например, фильтрация новостей или рекомендации покупок – это чёрные ящики по причине необходимости хранения индустриальных секретов. Это значит, что внутренние механизмы, управляющие этими алгоритмами, непрозрачны для всех, находящихся вне корпораций, владеющих и управляющих ими.

В-третьих, сложные ИИ часто обладают присущей им непредсказуемостью: они демонстрируют возникающие паттерны поведения, которые не может точно предсказать никто, даже их программисты. Такое поведение проявляется только при взаимодействии с миром и другими действующими лицами. Этому определённо подвержены программы для алгоритмической биржевой торговли, которые могут демонстрировать невиданные ранее паттерны поведения посредством сложной динамики рынков. Алан Тьюринг и Алонзо Чёрч показали фундаментальную невозможность гарантирования того, что алгоритм будет обладать определёнными свойствами, без реального запуска этого алгоритма. Существуют фундаментальные теоретические пределы нашей возможности проверить, что определённая часть кода всегда будет удовлетворять нужным параметрам, если только мы не запустим код и не посмотрим, как он себя ведёт.

Но, что самое важное, научное исследование машинного поведения, проводимое людьми, не принадлежащими к специалистам по информатике и робототехнике, открывает новые перспективы в важных экономических, социальных и политических явлениях, на которые имеют влияние машины. Специалисты по информатике и робототехнике сегодня – одни из наиболее талантливых людей на планете. Но они не проходили формального обучения в областях изучения таких явлений, как расовая дискриминация, этические дилеммы, стабильность финансовых рынков, распространение слухов в соцсетях. И хотя специалисты по информатике изучали подобные явления, в других областях тоже есть способные учёные, обладающие важными навыками, методами и взглядами на происходящее, которыми они могут поделиться. Мы, как специалисты по информатике, в собственной работе часто сталкиваемся с превосходством наших компаньонов, специалистов по социологии и бихевиоризму. Они часто показывали нам, как наши первичные вопросы изучения были некорректно сформированы, или как наше применение определённых методов социологии было неподходящим – например, в нём отсутствовали необходимые оговорки, или же сделанные выводы были чересчур уверенными. Мы на собственных ошибках научились замедлять своё стремление просто перемолоть большой объём данных или строить модели машинного обучения.

При теперешнем положении дел вклад от комментаторов и учёных, находящихся вне областей информатики и робототехники, часто плохо интегрируются. Многие из этих учёных пытались бить тревогу. Их волнуют широкие и непредумышленные последствия действий ИИ, способных действовать, адаптироваться и выказывать неожиданное поведение, противоречащее намерениям их создателей – поведение, которое может быть фундаментально непредсказуемым.

Совместно с недостатком предсказуемости существуют опасения потенциальной потери контроля людьми над умными машинами. Было описано множество случаев, в которых вроде бы мирные алгоритмы могут навредить отдельным людям или сообществам. Иные высказывали опасения по поводу того, что ИИ-системы – это чёрные ящики, процесс принятия решений которыми не виден для тех, на кого влияют эти решения, что подрывает возможности последних ставить эти решения под сомнение.

И хотя эти важные заявления уже очень многого добились в деле донесения до общественности потенциально неприятных эффектов применения ИИ, они всё ещё работают с периферии – и обычно вызывают негативную реакцию внутри ИИ-сообщества. Более того, большая часть современных споров основывается на единичных свидетельствах, собранных специалистами и ограниченных особыми случаями. Нам всё ещё не хватает консолидированного, масштабируемого, научного подхода к поведенческому изучению ИИ, в котором бы социологи и специалисты по информатике могли бы беспроблемно сотрудничать. Как писала Кэти О’Нил в The New York Times: «Не существует отдельной области академических исследований, всерьёз относящейся к ответственности за понимание и критику роли технологии – и, в особенности, алгоритмов, отвечающих за принятие такого множества решений – в нашей жизни». Учитывая скорость развития новых ИИ-алгоритмов, этот разрыв – между количеством реализованных алгоритмов и нашим пониманием этих алгоритмов – со временем, скорее всего, будет только увеличиваться.

Наконец, мы ожидаем, что изучение машинного поведения может открыть нам большую экономическую ценность. К примеру, если можно будет гарантировать, что данный алгоритм удовлетворяет определённым этическим, культурным или экономическим стандартам поведения, мы сможем его именно так и рекламировать. Следовательно, потребители и отвечающие за него корпорации могут начать требовать подобной сертификации. Это похоже на то, как потребители начали требовать определённых этических и экологических стандартов для цепочек поставок, производящих потребляемые ими товары и услуги. Изучение машинного поведения может заложить основы такой объективной сертификации ИИ.

ИИ всё больше участвуют в наших социальных, экономических и политических взаимодействиях. Алгоритмы кредитной оценки определяют, кто получит займ; алгоритмические торговые боты покупают и продают финансовые активы на бирже; алгоритмы оптимизируют работу полиции; программы по алгоритмической оценке заключённых влияют на условно-досрочное освобождение; робомобили перевозят многотонные металлические коробки по нашим городам; роботы размечают наши дома и чистят их; алгоритмы влияют на совпадение пар на сайтах знакомств; вскоре смертельное автономное оружие сможет определять, кому жить, а кому умереть в вооружённых конфликтах. И это лишь верхушка будущего айсберга. В ближайшем будущем как программы, так и комплексы оборудования, работающие под управлением ИИ, проникнут во все аспекты нашего общества.

Есть у них антропоморфные признаки, или нет, эти машины представляют собой новый класс действующих лиц – кто-то даже может сказать, новый вид – населяющий наш мир. Мы должны использовать все доступные на инструменты, чтобы понимать и регулировать их влияние на нашу человеческую расу. Если сделать это правильно, то, возможно, люди и машины смогут совместно процветать в здоровом, взаимовыгодном сотрудничестве. Чтобы реализовать эту возможность, нам необходимо с усердием взяться за изучение машинного поведения при помощи новой научной дисциплины.

Ийад Раван – доцент медиаведения в Медиалаборатории MIT, директор и главный исследователь её группы Масштабируемого сотрудничества. Мануэль Себриан – исследователь в Медиалаборатории MIT, научный руководитель группы Масштабируемого сотрудничества.

Комментарии (13)

Orcus13

23.05.2018 15:34В статье сказано, что люди должны изучать поведение машин, но это невозможно, т.к. более сложная сущность, обычно, изучает более простую.

Лучше бы говорить о том, что ИИ должен сделать изучение человека научной дисциплиной.

Ilyasyakubov

23.05.2018 19:51Да что вы вообще такое несёте?!

Orcus13

23.05.2018 20:03-1Белковые организмы показали полную неспособность сделать из психологии науку. В этом смысле интереснее что из изучения поведения сделает кремний.

mister_pibodi

23.05.2018 16:42Но они не проходили формального обучения в областях изучения таких явлений, как расовая дискриминация, этические дилеммы, стабильность финансовых рынков, распространение слухов в соцсетях

и вот эта цитата

машины могут выказывать качественно отличающиеся, совершенно чуждые нам формы интеллекта и поведенческие паттерны.

о мой глоб, что за противоречие

Каким образом, тот кто изучал психологию человека сможет понимать психологию ИИ (которого ещё даже нет в природе) хотя бы на одном уровне с его создателем?

eteh

23.05.2018 18:43Стоит начать с того, что даже нечеткая логика в автоматизации ограничена отбрасывающими неверные входные данные уставками, все остальное будет являться философией в вакууме.

Zmiy666

24.05.2018 10:10Было бы забавно натравить психологов на чат-бота ИИ, но самим психологам не говорить, о том что это бот — и пусть они по общении попробуют составить психопрофиль оппонента и выдвинуть предположения о наличии психических отклонений.

AndreyMtv

Отвечаю на вопрос под заголовком.

Потому, что никакого ИИ в бытовом смысле не существует.

Правила "общения" обычного человека и машины с головой перекрываются прилагаемой инструкцией по эксплуатации и общими правилами техники безопасности при работе с машинами и механизмами.

Zenitchik

«ИИ в бытовом смысле» — это то, что играет против нас в сингл-плеере компьютерных стратегий.

AndreyMtv

Дя того что бы в дотку зарубится никаких универов кончать не нужно. Даже скорее вредно.

Для обывателя все взаимодействие с ИИ ограничиваеться прочтением инструкции по эксплуатации. Все. Нет никакой почвы для появления новой дисциплины изучающей ИИ. И в статье ни одного вменяемого юзеркейса, зачем она практически может понадобиться не приведено.

ariklus

Для обывателя взаимодействие с предметами 99.9% наук — в рамках «прочитать инструкцию».

AndreyMtv

А специалисты уже имеют все необхожимые им курсы по мащинному обучению. Все, что перечислено в статье, создано и успешно эксплуатируется без необходимости "изучать поведение ии".

P.S. не конкретно вам.

Вместо того, что бы агриться на первую половину моего сообщения, не дочитав вторую, попробуйте придумать реальные применения этой новой дисциплины.

Вот отучились вы пять лет, получили диплом "исследователь поведения ии"…

Какова область применения ваших знаний будет? Нет ее. Телегу впереди лошади не впрягают. Если в ней нет потребности, то и создавать данную научную дисциплину незачем.

Tagire

А на мой взгляд дисциплина все-таки нужна, потому что поведение тех же нейросетей в некоторых случаях предсказать довольно сложно, например случай с тем что гугл проставлял тег "горилла" на фотографии очень темнокожих негров. Если даже для простых алгоритмов сортировки требуется доказывать устойчивость и находить вырожденные случаи, то тут тем более нужно.

Примеры ИИ где было бы это полезно: автопилоты машин и квадрокоптеров, поисковые алгоритмы, кредитные рейтинги, боты для торговли на бирже, системы типа Siri, помощники в обучалках видеоигр.