До последнего времени минимальные затраты для такого решения были существенными. Самый маленький коммутатор 10GbE был на 24 порта, а самая простая карта – Intel X520 за 500 долларов. Бюджет на порт составлял около 700-1000 долларов, а входной билет был очень высокий.

Прогресс не стоит на месте, в начале 2015 года появился новый класс устройств 10GbE за приемлемые деньги со склада в Москве и под гарантией.

Так как мы в HOSTKEY регулярно строим на их базе выделенные сервера и частные облака, то хотим поделиться опытом.

Итак, у нашего Клиента 5 машин в кластере и ему нужен 10GbE VLAN – там 2 файлера, одна машина для резервного копирования и несколько нод. На гигабите все медленно и не хочется ставить в машины гигабитные четырехпортовки в тиминге. Надо 10GbE и бюджет ограничен. Звучит знакомо, не правда ли?

Выбор 10GbE контроллеров

Выбираем сетевые платы для серверов – чтобы новые, со склада и гарантией. Есть три варианта, и все они на PCIe x8:

1) Старый проверенный Intel X520-DA2.

2 порта SFP+, уже 5 лет на рынке. Цена около 30 000 рублей (~$450). Обратите внимание, модули надо брать родные по 15.000 рублей или заказывать в НАГе с указанием, чтобы их прошили под эту модель – иначе он их не увидит. Это же касается DAC (медных кабелей прямого подключения с интерфейсами SFP+ — вдруг кто не знает), мы то же думали что любой подходит и были вынуждены заходить на второй круг.

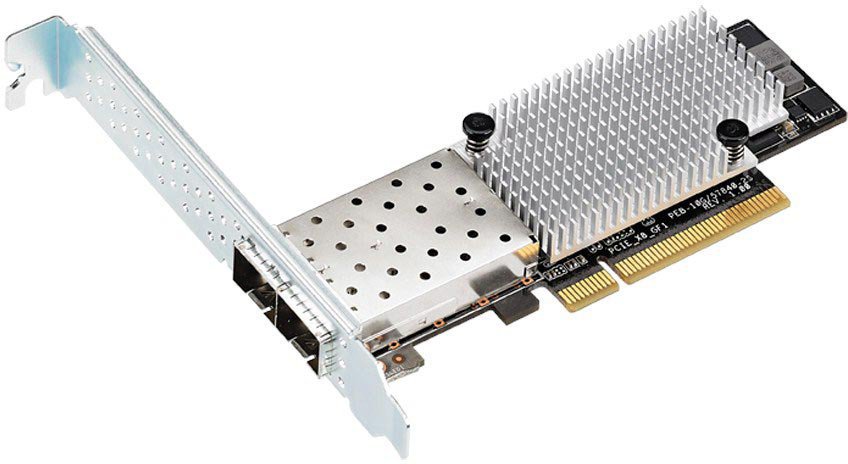

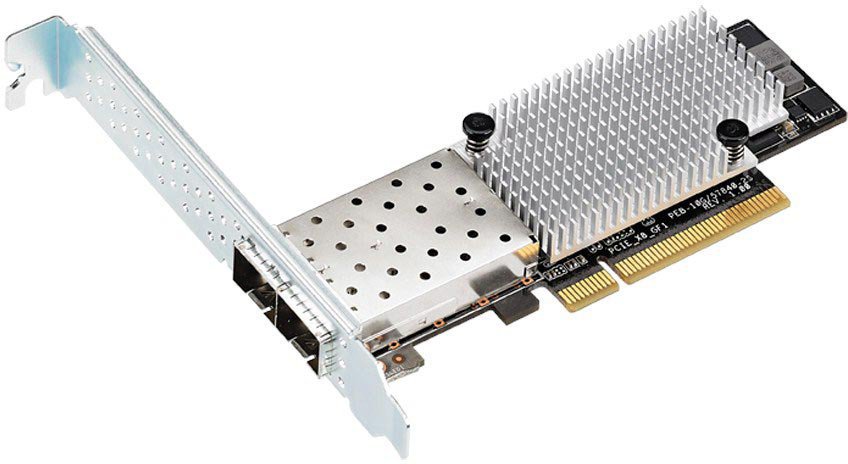

2) Новичок Asus PEB-10G/57811-1S

1 или 2 порта SFP+ на чипсете BCM 57811S.

Впервые мы их заметили в продаже весной. Цена вопроса 10 000 рублей за штуку с одним портом и 16 000 за 2-х портовый PEB-10G/57840-2S. Модули любые, контроллеру не принципиально. Платка на удивление маленькая, чуть больше ладони. Обратите внимание – драйверов под VmWare там нет в коробке (мы попробуем решить эту проблему в одном из следующих постов).

3) Новый Qlogic QLE3440-CU-CK

Один или два порта на SFP+ под DAC, как мы и искали.

Однопортовую версию удалось купить по 16 000 рублей. На Амазоне цена для QLE3440-CU-CK составляет 250 баксов, т.е. это не сток по старой цене — новье. Все драйвера на месте, в том числе и под ESXI. Карточка чуть большего размера. Модули DAC/SFP+ специально шить не надо — он всеядный.

Выбор 10GbE коммутатора

Теперь надо выбрать коммутатор, нам нужно что-то на 8-12 портов с управлением на уровне L2 без особых наворотов. Нексус и Экстрим не рассматриваем, не тот размерчик. Опять же, ищем новое и со склада. Старые Меланоксы с Ebay, Циски на xenpack не рассматриваем, хотя многие так и поступают.

Выбор еще скромнее:

1) Netgear XS708E на 8 медных портов, цена 72 000 рублей в Регарде и других местах. L2 есть, все управляется. У нас медных портов нет на картах, в этом случае придется брать что-то другое.

2) Netgear XS712T-100NES на 12 медных портов, цена 142 000 рублей в Регарде.

3) SNR-S2970-12X– 12 портовый коммутатор от NAG.

У него 12 SFP+ портов, 8 просто гигабитных портов и полный контроль в L2. Цена около 100 000 рублей, т.е. 8333 рублей за 10Г порт и еще 8 гигабитников на халяву – мы еще VLAN управления на нем же соберем. Читаем форум и ветку с обсуждением устройства — нам для кластера это годится, а для опорного коммутатора уровня ЦОД он точно не пойдет.

DAC нам нравятся больше, они имеют задержку в 0,3мкс против 2-3мкс у 10GBase-T. На уровне сетевой агрегации ЦОД это не так важно, а для подключения файлеров ничего нет важнее маленькой задержки.

Спрашиваем коллег про опыт эксплуатации и заказываем в НАГ.ру, через несколько дней коммутатор уже у нас в Москве на столе. Интерфейс коммутатора простой, есть веб-интерфейс, IOS-образный CLI и все управляется по SNMP. Нам не требуется ничего сложнее, чем нарезать VLAN и поставить на мониторинг в CACTI, хотя у него намного больше функций. Он может шейпить, может делать транки, может зажимать MAC на портах, может делать port mirror на 1/10Г, подкрашивать трафик QOS и все остальное, что пристало L2 свитчу в 2015 году.

Снапшоты веб-интерфейса SNR-S2970-12X:

Первый экран:

Управление портами:

МАС-адреса:

Настройка портов:

Настройка шэйпинга и лимитов pps:

Управление зеркалированием портов:

Управление VLAN и транками:

Тестирование

Собираем стенд из двух серверов и коммутатора – две машины на s1366, супермикра и интел. Ставим карточки, ставим на SSD серверам Windows Server 2012 (как надо клиенту) и соединяем все это DAC между собой. Для справки (как тут любят) DAC кабель на 2 метра стоит около 2000 рублей.

Драйвера встают без проблем, все заводится почти с ходу. Никаких ошибок, все работает из коробочки. Qlogic умеет делать из себя виртуальные адаптеры, это удобно для виртуализации интерфейсов в кластере – например один для heartbeat, второй для iscsi, третий для live migration, четвертый для Интернета и пятый для управления всем этим. С Qlogic все можно разобрать еще на уровне виртуальных адаптеров.

IPERF

IPERF во всех режимах показывает 8,5Гбит для Асуса и около 8Гбит для Qlogic. Мы пробовали в разном количестве потоков, включали offload, крутили размер jumbo-frame – разница в пределах статистической погрешности.

ASUS:

Qlogic:

Включаем прямиком сервера друг в друга – те же цифры, коммутатор не вносит задержки. Это проще простого – просто переставляем кабель из коммутатора в сервер и все включается.

10G контроллеры и ширина шины PCIe

Обратите внимание – мы первоначально заметили, что Asus не разгоняется выше 6 Гигабит. Оказалось что в Интеловской матери один из слотов восьмого размера на самом деле на четыре лэйна. Переставили в PCIe с восемью лэйнами – стало сразу 8,5Гбит. На таких скоростях это уже важно, упирается в любое узкое горлышко.

Передача файлов по SMB

Тестируем работу обычной SMB-шары в Windows – без особых заморочек, пост не про это. Сначала получаем скорость около 300Мбайт передачи — SSD через SATA2 больше не тянет. На матери нет SATA3, поэтому ставим RAM Disk и заливаем все туда. Том раздаем по сети и картинка сразу меняется – 609МБ в секунду. 4,7Гб установочный образ копируется за менее чем 8 секунд. Судя по тому, что на графике ровная полка, мы где-то уперлись в ограничение, и это не сеть. Разбираться уже не будем, 600Мб в секунду более чем достаточно – типовая 10Гб виртуальная машина теперь сможет быть мигрирована за 16 секунд с ноды на ноду.

Выводы

Что получается – все работает, быстро и просто. Скорость передачи в таком решении порядка 8,5 Гбит/с — для большинства задач более чем достаточно. Для создания 10Г сетевой инфраструктуры на кластер из 10 машин надо всего 200 000 рублей или 3000 долларов, сумма более чем подъемная. Если комплектовать двухпортовыми платами и двумя коммутаторами для резерва, то цена вопроса 360 000 рублей или около 5500 долларов.

Мы в HOSTKEY специализируемся на аренде для клиентов крупных кастомных выделенных серверов и кластеров на их базе. 10GbE порт для организации VLAN на выделенный сервер обойдется всего в 2100 рублей в месяц. Если коммутация на 10G Ethernet делается без участия коммутатора, например, два сервера смотрят в один файлер с двух-портовой платой – то это добавит всего 1200-1600 рублей на сервер в месяц. Обратите внимание – в однопроцессорный 1U сервер сложно одновременно поставить 10G контроллер и аппаратный RAID-контроллер. В двухпроцессорных машинах обычно есть WIO опция, когда ставится две платы друг над другом через райзер или одна плата ставится спереди, как в HP DL160 или Деллах.

О HOSTKEY

HOSTKEY сдает выделенные сервера в аренду в Москве и Нидерландах с 2008 года. Общий парк собственных серверов сейчас составляет 1300 физических машин на 5 площадках. Мы работаем в сертифицированных по TierIII Московских ЦОД Датапро Авиамоторная, Даталайн Норд и на нескольких площадках попроще. В Нидерландах стойки арендуются в Serverius.nl, сервера там все наши собственные – никого не ресейлим. В этих ЦОД мы размещаем на коло сервера наших клиентов и предоставляем выделенные сервера со всей сетевой инфраструктурой. Цены – разумные, мы делаем все, чтобы снизить свои издержки и предложить клиентам экономически целесообразные условия в это непростое время. Если нужно что-то специальное – обращайтесь, мы всегда поможем.

HOSTKEY сдает выделенные сервера в аренду в Москве и Нидерландах с 2008 года. Общий парк собственных серверов сейчас составляет 1300 физических машин на 5 площадках. Мы работаем в сертифицированных по TierIII Московских ЦОД Датапро Авиамоторная, Даталайн Норд и на нескольких площадках попроще. В Нидерландах стойки арендуются в Serverius.nl, сервера там все наши собственные – никого не ресейлим. В этих ЦОД мы размещаем на коло сервера наших клиентов и предоставляем выделенные сервера со всей сетевой инфраструктурой. Цены – разумные, мы делаем все, чтобы снизить свои издержки и предложить клиентам экономически целесообразные условия в это непростое время. Если нужно что-то специальное – обращайтесь, мы всегда поможем. Промокод на 10% скидки до конца августа 2015 года для читателей — HABR170815

Комментарии (35)

lolipop

17.08.2015 17:53+1Обратите внимание, модули надо брать родные по 15.000 рублей или заказывать в НАГе с указанием, чтобы их прошили под эту модель – иначе он их не увидит

на линуксе проблема решаема

автор метода — amarao

ULP

17.08.2015 18:14+1ага. но мы если заказываем DAC, просто говорим в какие устройства он будет вставлен и модули прошивают верно. Потом у нас выделенные сервера, мы не контролируем ОС клиента — надо что бы все работало из коробочки.

phprus

17.08.2015 20:24+1Зачем так сложно, если в Linux можно включить соответствующую опцию модуля:

options ixgbe allow_unsupported_sfp=1

lolipop

17.08.2015 20:29ixgbe <> e1000

phprus

17.08.2015 20:47А по ссылке что написано:

rmmod ixgbe

modprobe ixgbe

?

Более того, я скачал архив с драйвером по ссылке из блогпоста господина amarao и, что я там увидел? А увидел я там опцию, про которую писал комментарием выше:

IXGBE_PARAM(allow_unsupported_sfp, «Allow unsupported and untested „

“SFP+ modules on 82599 based adapters, default 0 = Disable»);

У адаптера Intel X520-DA2 контроллер как раз таки Intel 82599EN.

Правда, вполне возможно, в 2010 году этой опции не было, и требовалось патчить код ядра.

lolipop

17.08.2015 21:17А по ссылке что написано

недоглядел, да.

Правда, вполне возможно, в 2010 году этой опции не было, и требовалось патчить код ядра.

похоже, что не было, да.

скачал 2.0.84.9 от конца июля 2010-го года(по дате поста), грепнул:

[21:16:05] someuser@somehostname /tmp/ixgbe-2.0.84.9 $ grep -r allow_unsupported_sfp * [21:16:18] someuser@somehostname /tmp/ixgbe-2.0.84.9 $

pavelsh

17.08.2015 18:44+1> Мы наблюдали, как строили кластеры на старых карточках Инфинибэнд и прочих нетрадиционных решениях. По результатам наблюдений мы отказались от этих вариантов и не рекомендуем их использовать нашим клиентам.

А можете рассказать, почему вам не нравятся решения на Инфинибэнд? Спасибо

heathen

17.08.2015 19:36Мне вот тоже любопытно, когда решения на инфинибенд стали нетрадиционными.

ULP

17.08.2015 22:01+1мне очень нравятся решения на ИБ — когда в их составе есть свежий Меланоксовский свитч с купленной лицензией и гарантией 4 часа на сайте. Но боюсь это выйдет за бюджет обычного решения — спрос будет маленький из-за цены вопроса в пересчете на порт.

heathen

17.08.2015 22:18Да, безусловно, согласен с вами — это совершенно небюджетное решение.

Но мы говорим о бюджетном… и, скажем, SNR у меня не вызывает ощущения большей надёжности, нежели новый, но предыдущего поколения коммутатор Mellanox.

phprus

17.08.2015 20:30> на старых карточках Инфинибэнд

Думаю проблема может быть в наличии драйверов для старых карточек в новых Windows.

ULP

17.08.2015 21:56потому что мы не можем дать гарантию что все будет работать как ожидается. Коммутаторы без гарантии, без сервиса, без обслуживания — что-то может пойти не так, мы не готовы брать отвественность и предалагать это как услугу.

На коло нам приносили, делали на ИБ — это пожалуйста.

heathen

17.08.2015 22:13+2Если можно, раскройте подробнее мысль, пожалуйста. Что может работать «не так»? В смысле, я подозреваю, что «что-то может», но вот вы говорите «мы наблюдали и не рекомендуем» — поделитесь, если можно, что именно бывало не так? Чтобы понимать…

Просто с учётом того, что новый (в заводской упаковке запечатанный) 36-портовый коммутатор Mellanox Infiniband IS5025 можно купить баксов за $600-800 уже с доставкой, а карточки — за $20-25, кабель примерно столько же, то гарантийный сервис особо не нужен. Их можно привезти несколько штук. Сгорел один — поставили другой. Более того, ещё и fault tolerance конфигурацию соорудить на 18 нод. Плюс RDMA здесь же — что, скажем, для подсистемы хранения может быть очень полезно. Плюс 32Gbit/s эффективных, а не 10. Плюс изначально меньшие latency.

Я не отрицаю, что для «больших» серьёзных проектов с десятками коммутаторов это, возможно, неправильно, но для начала, или в расчёте на соответствующую аудиторию, или же построив решение с серьёзным резервированием (что получается практически на порядок дешевле, чем если брать современное оборудование на той же технологии) — почему нет? Вот отсюда и вопрос вам, раз у вас есть опыт наблюдения. Поделитесь, пожалуйста, с чем есть риск столкнуться.

fortyseven

17.08.2015 21:15+1Не увидел, как организовано резервирование коммутатора?

ULP

17.08.2015 21:58один запасной стоит в стойке, если случится авария — его быстро включат. Если приложение ответственное, мы можем поставить 2 разных коммутатора и клиент с помощью MPIO или иной технологии поставит трафик. Цена будет x2 по сравнению с одним портом.

Можно делать файловер на гигабите, можно еще как.

ULP

17.08.2015 22:07вообще все можно сделать, если клиент просит 10G циски в стэке — мы сделаем, не проблема. Если задача позволяет взять второй коммутатор или более надежную систему и бюджет позволяет — все реализуется. Но топик про недорогие решения.

Ivan_83

18.08.2015 07:58Надо было опустится совсем на дно и тестить спидтестом, чего уж там, для рекламного материала всё сойдёт.

«Обратите внимание – мы первоначально заметили, что Asus не разгоняется выше 6 Гигабит. Оказалось что в Интеловской матери один из слотов восьмого размера на самом деле на четыре лэйна. Переставили в PCIe с восемью лэйнами – стало сразу 8,5Гбит. На таких скоростях это уже важно, упирается в любое узкое горлышко.» —

А ничего, что PCI-E бывают уже трёх поколений, и скорость между поколениями различается существенно?

Может нужно было почитать доку на чип и на мать, какие там именно PCI-E, и делать выводы.

Кроме того, для венды нужно было бы тюнить tcp, вместо normal ставить experemental для размера окна передачи.

Конкретно про асус пишут что: PCI-E Gen2 x8.

Для х4 на первом поколении полка примерно 8 гигабит.

В D-Link DGS-1510 тоже есть 10G порты, и в продаже они есть, и стоят совсем не дорого.

Ещё у них отдельная новая серия чисто 10G есть, кажется ещё не в продаже.

«1) Старый проверенный Intel X520-DA2.» — Помнится слышал про интел на пару 10Г портов, который больше 16 гигабит выдать не мог, потому что у него PCI-E линии первого поколения или не хватает их. Модель я не запомнил, может как раз оно. :)

«Не родные» SFP модули — это патчится драйвер, особых сложностей там нет: смотрим что пишет, потом грепаем исходник, убираем лишние проверки, собираем и наслаждаемся.

Виндовс юзеры в пролёте: там надо в асме копаться и потом заново подписывать валидным сертификатом.

quartz64

18.08.2015 12:06+1Спасибо за наводку на SNR-S2970-12X. Для маленьких бюджетных кластеров самое то. Приходилось Netgear 8/12 портовые использовать, а они только 10GBASE-T бывают.

erlyvideo

18.08.2015 12:24Если в SNR воткнуть 4 сервера, сервер 1 будет лить на 2 свои 8 гигабит, то сможет ли 3 на 4 пролить столько же?

ULP

18.08.2015 15:39да, у коммуатора 240Гбит матрица переключений — это для него семечки.

igordata

18.08.2015 19:47не могли бы вы ответить и на мой вопрос выше? http://habrahabr.ru/company/hostkey/blog/264931/#comment_8540205

ULP

18.08.2015 20:19мы обычно не продаем 10Г каналов наружу, если для Вашего проекта необходима такая скорость — отпишите запрос на почту с приложением текущего графика потребления, его географии и характера трафика. Тогда мы сможем что-то предложить.

Krey

19.08.2015 21:04Еще можно купить б\у материнку на ебее с 10Гб портами. Буквально недавно видел двухсокетовую за 250$, два порта 10GbE, и два SAS порта.

ULP

21.08.2015 19:30можно. а можно потом обнаружить, что есть некая существенная причина почему ее продали не ебее — причем пока она приедет в РФ, сделку уже нельзя будет откатить. ;)

если системно таришся на ебее и в германии есть человек который будет смотреть все купленное там на работоспособность, то это неплохой вариант. а если это не так, то я бы всегда задавал вопрос — почему это оказалость на ebay? Мой опыт — 30-40% оборудования текущего поколения которое там удавалось взять, имело некоторые особенности эксплутации или было просто мертвым. К тому моменту как это попадало в РФ, можно было только расслабиться по этому поводу.

Krey

21.08.2015 19:45+1Не так все страшно. Я бы сказал почти вообще не страшно :)

Часто (как и в озвученном мной случае) продают партию оказавшейся ненужной после апгрейда. Обычно тут и цену меньше ставят что бы быстрее продать. Там продавали 10-ок 2011v2 плат.

Если статус товара на ебее used but fully worked, то неработоспособные варианты отсылаем обратно. Тут лучше выбирать продавцов с возвратом причем за их счет. И ебей гарантией возврата.

Почта сейчас работает быстро. Я даже получая товар через посредника успеваю получать и проверять.

Если у ебея гарантия кончилась то есть еще пайпал.

Еще смотрим на рейтинг продавцов.

ULP

21.08.2015 20:05э… я там наверно штук 30 зелени года 3 назад потратил на комплектуху, немного разбираюсь в колбасных обрезках.

очень мало желающих отправлять в РФ + стоимость пересылки делает затею бессмысленной. Мы там даже перестали отсматривать, все что надо тут есть на авито и значительно дешевле. например матери на 2011v1 можно взять по 10000-7000р, а на 1366 в районе 5, сразу все проверить и не морочиться.

с 10 крупными платами можно запросто пойти на таможню их декларировать + оплачивать НДС и пошлину, мне вот время дороже.

впрочем пост не про это, давайте не будем развивать тему. 10Г для частных проектов как правило ни к чему, а если контора платит — то на ебее покупать не получится.

ivlad

Скажите, а вы разрешаете запускать tor на своих vps?

ULP

Мы не контролируем что запускают на арендованных серверах клиенты, важно что бы при этом не нарушались законы и не приходили жалобы и запросы из полиции.