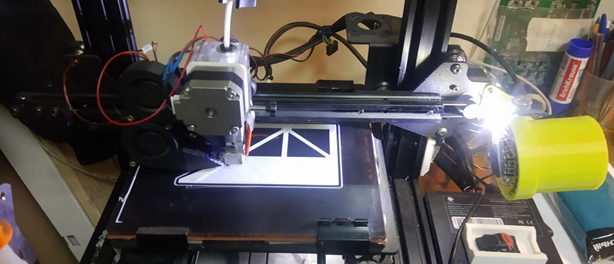

Печатаем адаптеры для SSD с 2,5 на 3,5 дюйма, потому что в продаже их нет

Значит, салазки. Давным-давно мы стояли в ЦОДе на Ярославском шоссе, том самом, что был на месте станции МЦК. Собственно, он в какой-то момент накрылся этой самой станцией, и нам нужно было куда-то уезжать. Тогда у нас была первая партия хуавеевских серверов, 20 штук. И вот у них в поставке идёт сам сервер и отдельно салазки для него за 150 долларов. А у нас стойки с уголками уже, то есть салазки не нужны. Мы просим менеджера их из счёта убрать, он убирает. 3 тысячи долларов экономии, круто, да? На самом деле реально круто, как нам тогда казалось. Деньги для начинающей компании вполне значимые.

В общем, счастливы мы были до переезда. Потому что купили новые стойки. А они не подразумевали уголков в принципе, сразу нужен был нормальный монтаж в салазки. А салазок-то ни у кого нет. Вообще. Даже у вендора нет. Они по какой-то странной причине продают их только вместе с серверами. В общем, уговорили со следующей партией железа каждый сервер укомплектовать двумя комплектами. Причём несколько разных людей пытались нам помочь и сказать, что салазки ломаются редко, и они убрали из заказа лишние…

В момент тотальной замены HDD на SSD снова понадобились новые салазки. На этот раз мы прочёсывали все радиорынки, все склады Савёловской и все объявления на Авито. Но это как с ремешками от дорогих часов: если продаётся, значит, владелец свои часы утопил. Нужно было найти много людей, утопивших свои серверы. В некоторых случаях даже думали покупать совсем старые списанные серверы с салазками в комплекте, потому что там они хотя бы были в сборе.

Давайте расскажу, что потребляет наш ЦОД в Королёве из мелочей.

Теперь патч-корды. Они — самый частый расходник, судя по статистике закупок. На самом деле, конечно, они никакой не расходник, а элемент инфраструктуры. Поскольку рынок VDS растёт, а мы растём быстрее рынка, абсолютная норма для бизнеса — каждый год сильно увеличивать инфраструктуру. Речь про 30% роста примерно каждый год. А каждый раз, когда растёт количество железа, нужны патч-корды. В первом ЦОДе (который как раз на станции большого кольца) половину патч-кордов мы вообще вручную делали, фирменные-то, конечно, уже приезжают заплавленные. По мере роста инфраструктуры доля обжаты вручную становилась всё меньше, но служат они достаточно долго. Хотя вторая статья расхода патч-кордов — это расшатывание гнёзд, после нескольких втыканий-вытыканий их, бывает, нужно менять. Не потому что они как-то плохо проводят, а потому что если чувствуются люфты, лучше поменять дешёвый расходник на всякий случай, чем потом ловить разные плавающие баги.

Патч-корды мы закупаем 6-й категории, почти все типовые по 3 метра. Раньше экспериментировали с тем, чтобы брать разной длины с разницей в 20 сантиметров и использовать по месту, но потом пришли к тому, что лучше сделать петли, чем при вытаскивании-затаскивании сервера пытаться всё отключить и подключить. Петли, конечно, создают не совсем аккуратную картинку, но бардака не вызывают. Для ряда специфических целей сейчас ещё заказываем 10-метровые, они иногда нужны.

Пару раз докупали оптические пигтейлы. Они нужны для объединения свитчей в стек. Кстати, свитчи раз в год выходят из строя, но благодаря резервированию (минимум два устройства на сервер: из своей стоки и из соседней) этого никто не замечает.

Вторые по расходу — диски. Диски прямо ходовой товар. Как я уже рассказывал, мы имеем гарантию next business day от вендора, но диски всегда держим на каждой площадке в запасе, чтобы поменять сразу средствами ЦОДа. Есть мнение, что диски, бывает, летят сразу пачками, потому что если они из одинаковых серий и одинаково эксплуатируются, то карачун им приходит тоже в одинаковое время. На практике было всего два случая за последние лет пять, когда диски умирали не по одному: один раз погибло сразу 3 SAS-диска Seagate (тогда ещё были HDD). Мы считали, что это из-за рассохшегося пластика вентилятора и передающихся на диски вибраций, но было и альтернативное мнение, что там была убита вся партия, и несколько дисков попали в один сервер. Про это история вот здесь в посте про ЦОД в Королёве.

С другой стороны, диски действительно умирают в похожее время. Только эта разница между вылетами ближе к двум-трём неделям. То есть умер один диск, поменяли, RAID отребилдился, через две недели умирает второй диск, RAID опять ребилдится, и дальше остальные в сервере той же серии живут годами.

Контроллеры, как говорят, обычно не умирают, но у нас случаи были. За последние годы помню пару таких случаев. Один просто достали наглухо мёртвый. Что с ним было — так и не поняли. Вообще они постоянно горячие, возможно, если набрать какое-то количество температурных переходов при неравномерной нагрузке, что-то в металлах может устать. Но это не точно )

Оперативка умирает чаще контроллеров, но сильно реже дисков.

Батарейки умирают совсем редко, но мы их держим.

Из совсем экзотики в какой-то момент нам понадобились экспандеры для видеокарт. Это удлинители, которые позволяют установить видеокарту чуть дальше от того места, в которое планировал производитель. Потому что слот в материнской плате сервера может и есть, но современные видеокарты имеют довольно большой геометрический размер, и могут внутрь сервера просто не поместиться. Поскольку корпоративный сервер никто не проектировал как игровой компьютер, видеокарта в нём далеко не главное. В самосборе проще, но мы только на корпоративном железе.

Мы предлагали линейку VDS с нормальным железом для специфических расчётов, и карты были нужны. Дальше оказалось, что отдельно экспандер купить либо нельзя, либо очень дорого, и настолько дорого, что лучше нельзя. Причём это касается и Хуавея, и Леново. Но выход нашёлся: в комплекте с новым сервером экспандер стоит нормальных денег. Чуть потерпели до следующей партии, заказали 8 серверов и 8 экспандеров. Но попросили не ставить их, а положить отдельно. Вендор, конечно, спросил, почему. Потому что загадочная русская душа.

Кабель для внешних коммуникаций с заезда почти не трогали. От серверной до входных лучей и оптики у нас лежит инфраструктура, которая почти не требует каких-то касаний. Из крупного — был обрыв кабеля, там долго думали, где же диагностировать, пока не разобрались. На заводе решили выкопать что-то, и по старой айтишной традиции экскаватор перебил кабель. Проблема была не столько в самом обрыве, сколько в долгом ребилде маршрутов туда и обратно. Но бегали все по территории весело. Второй обрыв был уже в Швейцарии, ещё в старом ЦОДе (откуда мы уехали). Там ремонтировали железную дорогу около небольшого городка. Оптика у них идёт чуть сбоку от шпал и на глубине около метра. В общем, в один из пакетов трафика попала свая. Поскольку диаметр сваи сильно превышал диаметр оптики, а в этой трассе ещё было и всё остальное инфраструктурное для города, у них оторвало даже телефонную связь. Что доставило нам пару часов волнений с поисками проблемы на нашей стороне. Кстати, когда мы обладаем полной информацией о проблеме, то оповещаем клиентов через личный кабинет и IVR, а когда ещё не знаем, что случилось, как тогда, то ставим уведомление, что проблема есть, мы её ищем. Пока не получим полную информацию о сроках, клиентам ничего не обещаем. Предположения не считаются.

Вот примерно так выглядят будни маленького ЦОДа.

Комментарии (21)

czz

09.11.2021 17:20+2А можно ли узнать немного подробнее про среднюю частоту отказов?

Как-то так: «в среднем у нас за год умирает N% свитчей huawei, M% модулей памяти, K% жестких дисков».

ntsaplin Автор

09.11.2021 18:38+3Свитчей — пара известных случаев за всю историю. Оперативка — около 0,3% за год. SSD — 2% за год.

Tangeman

10.11.2021 14:56+3Вы же в статье пишете:

Кстати, свитчи раз в год выходят из строя

а тут уже "пара случаев за всю историю".

Если таки и правда "раз в год" — что за бренд/модель? По своему опыту я столкнулся только с парой "естественных" смертей свитчей — это были D-Link, причём в выборке более 30 штук и все они проработали не менее 15 лет.

TheRaven

09.11.2021 20:23Директ на «дрыгостоле»? Есть смысл?

freddemo

10.11.2021 00:38Да, даже если у вас нет текущей потребности(linear advance, печать мягкими пластиками и т.д.) чуть быстрее печатает за счет меньших откатов, petg чуть меньше соплей. Голова дрыги достаточно медленная что бы не замечать дополнительного веса.

Aslesar2015

12.11.2021 16:29Да, конечно. Это расширяет ассортимент подходящих пластиков и большую точность из-за малого отката. А скорость при этом точно не меньше чем на боудене, так как ограничителем выступает масса стола. А масса головы, пусть даже с директом, всё равно вряд-ли больше массы стола.

AlexanderS

09.11.2021 20:55Контроллеры, как говорят, обычно не умирают, но у нас случаи были.

У меня дома лет 10 назад накрылся контроллер. Очень весело было с восстановлением RAID — данные на дисках лежат-то в «сыром» виде и просто так их не вытащишь, а аналогичный контроллер я так и не нашел. Прямо откровение было в плане надёжности зеркального массива) Теперь либо пара дисков собирается в пул StableBit с дубляжем, либо аппаратный массив, но контроллеры сразу по паре покупаются.

Wesha

10.11.2021 17:38ZFS спасёт отца русской демократии.

AlexanderS

10.11.2021 20:08Это-то понятно. Но вот саму ZFS спасет много оперативки — реально много, всем и дешёвой. И нормальный релиз для винды.

RStarun

09.11.2021 22:39+1Пигтейлы не оптические патч корды. Это половинки патч кордов, для сварки оптики. Не думаю что вы ими соединяли коммутаторы.

Wesha

10.11.2021 17:43+1пришли к тому, что лучше сделать петли, чем при вытаскивании-затаскивании сервера пытаться всё отключить и подключить. Петли, конечно, создают не совсем аккуратную картинку

Человечество давно изобрело решение для этой проблемы

Elmot

11.11.2021 00:39+1Такие кудри хороши на телефонном проводе, c полосой пропускания в несколько кГц. На Cat6 минимальный радиус загиба - дюйм, а завитки вам вообще дадут распрекрасную паразитную индуктивность провода и выдающуюся надежность соединения

Wesha

11.11.2021 00:491) Насколько мне известно, "радиус загиба в дюйм" — это ограничение не сигнальное, а физическое: внутри — витая пара (вернее, четыре) — если их навивать с таким радиусом — где-нибудь жила поломается. Ну ладно, так делайте не точно такие, делайте в дюйм диаметром?

2) Десяток кабелей в одну косу собирают - никто не жужжит, что они друг на друга не влияют; а тут вдруг влиять будет?

3) Вообще-то для того она и "витая пара", чтобы влияние на пути "туда" компенсировалось влиянием на пути "обратно".

GBR-613

12.11.2021 16:29Я не понял в начале - про уголки. Почему нельзя было сделать самим? Это же просто железки на болтиках?

NikolayMT

12.11.2021 16:29Присоединяюсь к вопросы про коммутаторы. Мне всегда казалось, что там нечему ломаться.

echo10

Покажите, пожалуйста, фото укладки серверов и кабель-менеджмент с петлями как выглядит.

LborV

Плюсую, тоже очень интересно