В продолжении темы описания возможностей SiteAnalyzer (бесплатная программа для аудита сайтов - российский аналог Screaming Frog SEO Spider), мы рады сообщить о выпуске новой версии 2.8, в которой мы мы добавили набор из 6 модулей для анализа доменов, реализовали возможность использования и управления файлами cookie для парсинга сайтов, добавили возможность автоматического экспорта отчетов по выбранным проектам в Excel и исправили не всегда удачную регистрацию программы. Расскажем обо всем подробнее.

Основные изменения

1. Анализ доменов

В новой версии SiteAnalyzer мы добавили набор из 6 модулей для анализа доменов, чтобы нашим пользователям было проще проводить анализ сайтов без использования сторонних веб-сервисов. Модули вызываются через контекстное меню списка проектов.

Список модулей:

Проверка WHOIS;

Проверка ответа сервера;

Поиск поддоменов;

CMS-чекер;

Семантический анализ текста;

Анализ релевантности текста.

Почти каждый из модулей дает возможность пакетной работы с доменами, а также возможность экспорта полученных данных в файл формата CSV или буфер обмена.

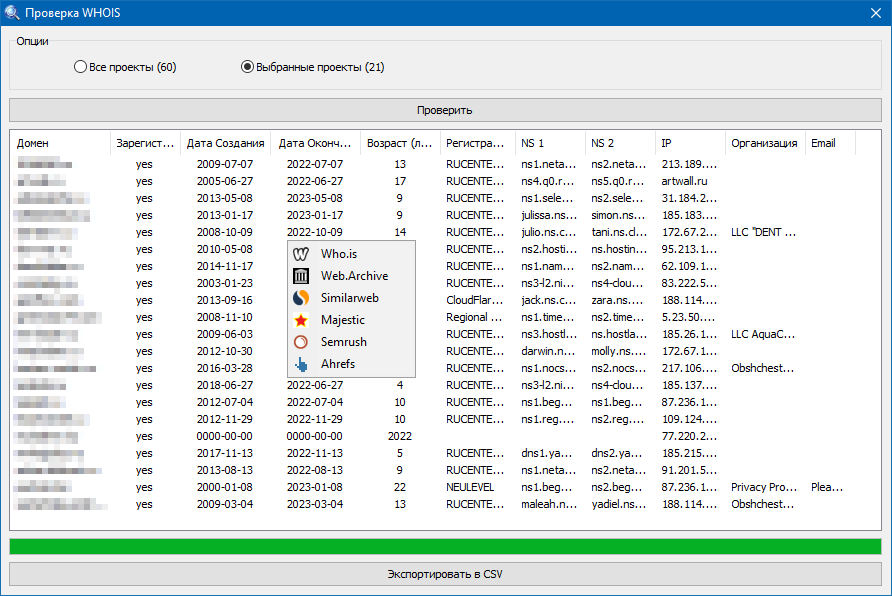

Проверка WHOIS

Инструмент предназначен для массового определения возраста доменов и их основных параметров. Наш WHOIS-чекер поможет массово определить возраст доменов в годах, отобразить WHOIS данные, имя регистратора домена, даты их создания и окончания регистрации, NS-сервера, IP-адрес, название организации владельца домена, а также контактный Email (если указан).

Дополнительно, при помощи контекстного меню, для каждого сайта можно получить информацию по трафику на Similarweb, перейти в сохраненные копии сайта на интернет-ресурсе Archive.org и провести подробный аудит ссылочной массы в Majestic, Semrush, Ahrefs посетив один из интересующих сервисов.

Проверка ответа сервера

С помощью данного модуля можно проверить, какой код ответа возвращает сервер при обращении к одной из его страниц. Для обычных страниц должен возвращаться код HTTP 200 (ОК), для несуществующих страниц этот код должен быть равен значению 404 (Not found). Также существуют и другие коды ответа сервера, такие как: 301, 403, 500, 503 и т.п.

Помимо самого кода ответа, скрипт отображает все заголовки, которые отдает сервер (код ответа, время на сервере, тип сервера и его содержимого, наличие редиректов и т.п.).

Дополнительно, имеется возможность проверки ответа сервера и списка всех редиректов во всплывающей форме используя контекстное меню списка URL сайта.

Поиск поддоменов сайта

Инструмент предназначен для поиска поддоменов определенного сайта. Поиск поддоменов поможет при анализе продвигаемого сайта – для выявления всех его поддоменов, в том числе «забытых» по каким-то причинам, либо технических (тестовых), не закрытых от индексации, а также в целом для анализа крупных интернет-магазинов и порталов в части организации их структуры. Поиск основан на сконструированных определенным образом запросах к различным поисковым системам. Таким образом, поиск ведется только по разрешенным к индексации поддоменам искомого веб-ресурса.

Дополнительно, имеется возможность экспорта найденных поддоменов в список проектов.

CMS-чекер

Модуль предназначен для определения CMS сайта и группы сайтов в автоматическом онлайн режиме. Определение типа и названия CMS идет путем поиска определенных паттернов в исходном коде страниц сайта. Таким образом, данный сервис позволяет в один клик определить CMS, на которой работают десятки интересующих вас сайтов без изучения исходного кода страниц и специфики различных систем управления сайтами.

Если используемая вами система управления сайтом отсутствует в нашей базе, вы можете написать нам через форму обратной связи, и мы добавим вашу CMS в наш список.

Семантический анализ текста (анализ плотности ключей на странице)

Данный семантический анализатор проводит анализ основных SEO-параметров текста, таких как: длина текста, количество слов, анализ плотности ключевых слов (тошнота), «вода» в тексте (водность).

Подобный семантический анализ можно провести для любой страницы сайта используя контекстное меню списка URL данного проекта.

Анализ релевантности текста (анализатор качества оптимизации станиц по запросу)

Данный инструмент предназначен для SEO-специалистов и позволяет провести подробный анализ контента интересующей страницы сайта на предмет ее релевантности произвольному поисковому запросу.

Основные критерии, по которым страницу сайта можно назвать «готовой» к продвижению это: наличие тега h1, количество вхождений ключевого слова в TITLE и BODY, объем текста страницы, число точных вхождений запроса в текст и т.п.

Следуя данным правилам, можно повысить позиции сайта и сделать страницу более дружелюбной не только для поисковой системы, но и к пользователю, что само по себе приведет к улучшению положительной обратной связи с пользователем и повышению конверсии (рост заказов, целевые звонки).

Таким образом, используя данный инструмент, оптимизатор, варьируя количеством вхождений «ключей» на странице, а также редактируя ее содержимое и мета-теги, может добиться оптимального соответствия отношения ключевых фраз к контенту, что положительно повлияет на отношение этому поисковых систем.

2. Использование файлов cookie

По просьбам наших пользователей была добавлена возможность использования в программе файлов cookie, а также экспорт всех сведений о файлах cookie в Excel.

Cookies («куки») – небольшой фрагмент текстовых данных, отправленный веб-сервером и хранимый на компьютере пользователя. В этих файлах обычно хранится информация о посетителе сайта, а также прочие служебные данные (когда и с какого устройства человек заходил на страницу, какими товарами интересовался, IP-адрес пользователя, его сессия, и так далее). Файлы cookie – это своеобразный номерок, который позволяет идентифицировать каждого пользователя на сайте.

Многие сайты имеют средства защиты от парсинга сторонними скриптами и программами, включающие проверку на наличие файлов cookie, поэтому использование файлов cookie во время парсинга является обязательным при сканировании большинство сайтов, иначе на сайте сработает защита и содержимое сайта не будет получено.

В программе SiteAnalyzer имеется 3 варианта использования файлов cookie:

Постоянное – выбирайте этот пункт, если доступ к сайту закрыт для обращений без файлов cookie. Также полезно, чтобы все запросы учитывались в рамках одной сессии, так как при выключенной настройке каждый новый запрос будет создавать новую сессию. Данное разрешение активировано по умолчанию.

Сессионное – в данном случае каждый новый запрос к сайту будет создавать новую сессию.

Игнорировать – запрет использования cookie.

Мы рекомендуем использовать первый пункт, так как он является наиболее распространенным и позволяет более уверенно сканировать большинство сайтов в сети.

Настройка вариантов использования cookie осуществляется в основных настройках программы на вкладке «Сканирование».

Также есть возможность экспорта списка всех файлов cookie активного сайта в текстовый файл при помощи кнопки «Экспорт Cookies» через главное меню программы.

3. Экспорт выбранных проектов в Excel

Данная возможность позволяет производить экспорт отчетов по выбранным проектам в Excel без необходимости ручного экспорта каждого проекта по очереди. Работает данная функция автоматически путем указания конечной папки, если для экспорта выбрано более одного проекта, иначе экспортируется только текущий проект.

Для удобства для каждого сайта автоматически создается отдельный файл с названием проекта.

4. Ввод регистрационного ключа в программу

Исправлена не всегда удачная регистрация программы – теперь регистрационный ключ будет приниматься программой без заминок.

Прочие изменения

Учет правил «Следовать URL» и «Исключить URL» основных настроек программы стал общим для всех проектов.

Исправлен баг в дашборде, возникающий при переключении между проектами, когда основные показатели качества сайта суммировались.

Исправлен баг при экспорте проекта, когда в проекте открыта вкладка с отсутствующими данными. В этом случае экспорт был недоступен.

Оптимизирован алгоритм генерации Sitemap для изображений (теперь изображения генерируются относительно рекомендаций Google).

Исправлен баг, когда при сканировании отдельных страниц в статус баре ошибочно увеличивался счетчик «Обработано проектов».

Исправлен избыточный учет содержимого тегов ALT для файлов типа favicon (игнорирование ALT для файлов в блоке HEAD).

Исправлена ошибка «Access violation», возникающая при клике на правую панель и чарт в режиме Google PageSpeed.

Исправлена проблема не всегда корректной передачи заголовков к серверу при сканировании сайта.

Оптимизирован экспорт в Excel полей, которые видны у пользователя, а не всех имеющихся.

Исправлено некорректное определение внешних редиректов (определялись как внутренние).

Исправлена ошибка соединения с сервером, возникающая при проверке обновлений версии.

Исправлена некорректная работа с доменами, содержащими в названии WWW.

Исправлен не всегда корректный парсинг тегов ALT и TILE для изображений.

Исправлен не всегда корректный учет дубликатов тегов H1 и Description.

Добавлена кнопка, вызывающая меню экспорта данных на панели Инфо.

Добавлена возможность пересканирования 3xx редиректов.

Планы

В ближайших версиях планируется интеграция с системами аналитики Яндекс и Google, добавление возможности сканирования сайтов, созданных по технологии SPA и многое другое.

Будем рады любым замечаниям и предложениям по работе и развитию функционала программы.

ggmlike

Как только появится полноценное выявление дублей, источников URL-адресов с битыми ссылками и редиректами, данным продуктом не имеет смысла пользоваться! Оценка релевантности заменяет поисковый запрос с оператором site:https://site.com "поисковый запрос", некоторый функционал, как семантический анализ без знания тематики сайта вообще бесполезный инструмент, да может быть вы продвинете сайт в топ (при условии, что вам попадется хороший копирайтер), но вас будут материть за то, что выдаете не релевантный контент за релевантный. CMS-чекер для SEO-специалиста вообще бесполезная фигня, что она дает? Ну да знать на какой CMS-ске создан сайт и все? Все хорошие сайта переходят на стек технологий фреймворк + поддержка, т.е. пишут собственное решение под свои задачи!

По моему мнению лучше netpeak-а ничего не придумано, даже лягуша с рядом существенных отличий не перебивает преимущества netpek-а, единственное, что похож это ComparseR, но он медленно работает, и не подойдет для больших проектов! Улучшайте продукт и возможно, возможно им будут пользоваться

Hidadmin Автор

Сложно что-то комментировать - у вас прямо сплошной сумбур в тексте.

Да, нетпик для РФ уже превратился в тыкву.

И по аналогии с вами: улучшайте свою речь - тогда возможно вашим комментариям будут придавать больше значения...

ggmlike

Очень жаль, что вы восприняли здоровую, как критику в сумбур тексте! Очень, жаль, а полезный сервис для вебмастеров так необходим. И да нетпик для РФ не превратился в тыкву, им пользуюсь и я отлично себя чувствую

Hidadmin Автор

Как-нибудь при случае скачайте и протестируйте наш SiteAnalyzer, т.к. вижу что ваши выводы основаны лишь на тексте из новости, но это далеко не весь функционал.

И да, нетпик действительно хороший софт и достойный конкурент, но это не говорит о том что альтернативы никому не нужны и не интересны, да и "на вкус и цвет" как говорится...

ПС. Для справки нашим софтом уже давно и активно пользуются и пока нет предпосылок к обратному.

Katyara12

У Вашего софта есть недостаток, хотя он замечен был ещё у нескольких ресурсов, но вот "Лягушка" не допускает проблемы подобной. Проблема заключается в том, что не всегда видит заголовок h1 на страницах сайта. Для примера можно взять ресурс https://aks.by/ Пишет, что на многих страницах заголовок h1 отсутствует. А на деле, он есть)

Плюс, не все страницы сканируются на сайте, находит лишь часть. При этом, в файле sitemap.xml они все прописаны.

Hidadmin Автор

Да, пока не на 100% отладили все подобные случаи, поэтому такое может встречаться. Пришлите примеры страниц где H1 определяется пустым - протестируем это.

А на счет сканирования страниц - возможно данные страницы закрыты от идексации через robots.txt / meta robots, либо на них может не стоять ссылок, или ссылки на их стоят через nofollow или javascript. Тогда краулер не сможет их увидеть и перейти на них. Вы можете попробовать отключить в настройках учет роботс и nofollow для понимания в чем кроется проблема.

Katyara12

На какую почту прислать пример ссылок?

Нет, то, что в роботсе запрет стоит я знаю, но на сайте перелинковка настроена, ноуфоллоу не используется. Через скрипты не проставлялись ссылки.

Hidadmin Автор

Можно через форму обратной связи https://site-analyzer.ru/contacts/