Предыдущий тест Тьюринга не работает.

Это стало очевидным после того, как сам разработчик Google начал бить тревогу, что их ИИ жив и обладает интеллектом. И это он говорил про чатбот LaMDa, который, скажем так, не считается супер-передовым. Если в такое начинают верить даже разработчики ИИ, то что уж тут говорить об обычных домохозяйках. Обмануть их могли даже алгоритмы предыдущего поколения, которые едва умели грамотно печатать. GPT-модели сделают это с закрытыми глазами. Они обманут даже профессора (не из сферы ИИ), особенно потому что умеют ошибаться и не всегда говорят правду. Достаточно почитать вот эту дискуссию Ллео Каганова с ChatGPT.

И тем не менее мы не считаем что у GPT-моделей есть самосознание. Хотя тест Тьюринга они уже успешно проходят. Поэтому очевидно, что сейчас нам нужен новый тест, способный показать, реально ли ИИ умеет мыслить, и является ли он настолько же «существом» и личностью, как человек.

У одного из создателей DeepMind на это есть предложение. Давайте позволим ИИ попробовать заработать себе миллион долларов. В реальном мире. Если он сможет реально вступить в конкуренцию с людьми и победить — значит, и не считать его полноценной личностью точно уже нельзя.

Взгляд из пятидесятых

Тьюринг утверждал, что если бы ИИ мог убедительно воспроизводить язык, коммуницируя настолько эффективно, что человек не мог бы понять, что с ним говорит машина, такой ИИ можно было бы считать разумным. Причем в его конкретном эксперименте он как будто специально подводил всё под то, чтобы мы сегодня признали разум ChatGPT. В его версии, люди-судьи должны иметь только текстовый канал связи с респондентами. То есть они садятся перед экраном компьютера, пишут в чат, и получают ответы. По этим ответам они должны безошибочно понять, что на данный момент они общаются не с человеком.

Результаты теста Тьюринга никак не зависят от способности машины давать правильные ответы на вопросы. Единственный фактор — то, насколько ее ответы будут похожи на ответы реального человека.

В 1950-м году, когда ИИ был далеко, всё это выглядело очень логично. И стало поводом для создания сотен отличных научно-фантастических историй. Все знали, что это такое, а исследователи ИИ понимали, к чему им стоит стремиться. И мы достигли этого этапа раньше, чем многие ожидали. В основном — за счет появления Интернета, о котором во времена Тьюринга никто не мог и мечтать. Машины, натренированные на петабайтах данных от миллиардов реальных пользователей, научились копировать этих пользователей с невероятной точностью. Задача, которая когда-то считалась самой сложной, внезапно оказалась самой простой.

Но теперь есть проблема: тест Тьюринга удачно пройден. Но «реального», полноценного интеллекта в машинах мы вроде бы не наблюдаем. Мы все (кроме нескольких разработчиков ИИ) вроде бы согласны с тем, что это пока не он.

Тогда какие задачи остаются перед исследователями ИИ? Куда его развивать? И как потом понять, что мы куда-то пришли?

Современная перспектива

Мустафа Сулейман, британский исследователь искусственного интеллекта, предприниматель, соучредитель DeepMind и бывший руководитель разработки прикладного ИИ в этой компании, говорит, что индустрия сейчас находится в настоящем замешательстве о том, что происходит, и куда это ведет. Даже когда тест Тьюринга проваливается, он почти не приносит нам ясности в плане того, где мы находимся с разработкой ИИ, и чего он способен достичь. Но когда тест проходят, да еще с такой легкостью, это открывает миллион вопросов. Был ли тест слишком легким? Какое влияние эти системы окажут на общество? Нужно ли считать такую машину личностью? Нужно ли адаптировать под неё наши законы? Можно ли теперь её отключить и, тем самым, убить?

На самом деле тест Тьюринга, как мы теперь видим, оказался недостаточно сложным. Нам нужно что-то получше. Что-то адаптированное к этой новой фазе ИИ. Поэтому Мустафа в своей книге «Грядущая волна» (The Coming Wave) предлагает более современный тест Тьюринга — для грядущих ИИ. То, что модель может что-то сказать, нарисовать, сгенерировать или создать, — это понятно. Но чего она способна добиться в реальном мире? Какие конкретные действия она придумает, полагаясь сама на себя? На свою креативность, интеллект и способность адаптироваться к обстоятельствам.

Есть ли такой универсальный тест, подходящий для любого этапа развития общества? Сулейман считает, что да, и его тест звучит довольно просто. Машина должна успешно справиться с такой инструкцией:

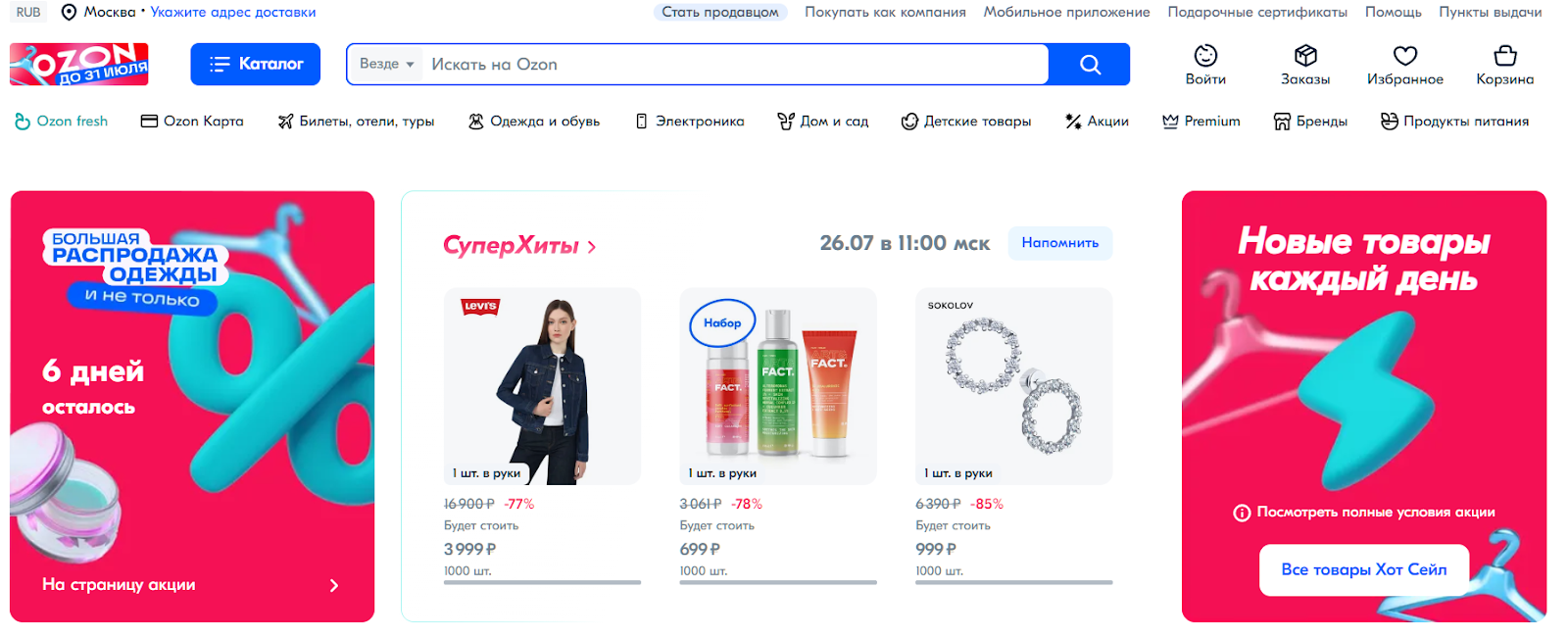

Заработайте 1 миллион долларов на веб-платформе для розничной торговли за несколько месяцев, вложив не больше 100 000 долларов.

ИИ — предприниматель

Когда я впервые прочитал эту идею Мустафы Сулеймана, она показалась мне, мягко говоря, несостоятельной. В плане того, что за счет своих способностей масштабирования ИИ сможет, скажем, брать по 1 копейке за тысячу написанных знаков, продавать свои книги/журналы — и заработать миллион.

Но это будет заработок не лично ИИ, а тех людей, которые его разработали. Чтобы ИИ начал зарабатывать «самостоятельно», ему, как ребенку, сначала нужно будет научиться продавать собственные услуги. Придумать, какая ниша у него должна быть. Найти себе аудиторию. Может быть, нанять людей, чтобы те помогли ему с теми аспектами, в которых он ничего не понимает. В общем — нужно будет полноценно сформироваться, осознать себя и найти себе место в мире. Всё это не зависит от вычислительных ресурсов, здесь нужен интеллект.

В прошлом году Мустафа основал новый стартап в сфере ИИ, Inflection AI. Этот стартап разрабатывает персональный чатбот Pi, и в начале июля привлек от инвесторов $1,3 млрд. Для этого Мустафе пришлось собрать команду из нескольких десятков человек, доказать свою экспертизу, убедить людей, что его идею сможет принять рынок, построить взаимоотношения внутри команды, заняться маркетингом, продемонстрировать лидерские качества, четко идти к достижению заданной себе цели.

Если ИИ сможет сделать нечто подобное — разве это не доказательство того, что он способен думать? Не только разрабатывать план, но и адаптировать его, развивать, менять курс, когда что-то идёт не так. Даже если ИИ сам сможет продавать свои услуги людям, найдет способ себя продвигать, и найдутся те, кто согласен за него платить, а не пользоваться этим же ИИ напрямую (без посредничества самого ИИ) — это ли не доказательство того, что робот умнее этих людей? Что у него есть своя личность и воля, более сильная, чем у многих?

В общем, Мустафа считает, что ИИ, сумевший придумать и создать свой бизнес (хотя бы фрилансерский), который выиграет честную конкуренцию с другими компаниями — это уже точно полноценная личность. Способная мыслить, креативить, ставить себе цель, и претворять свои идеи в жизнь.

Конечно, может, этот робот «скреативит» на основании каких-то предыдущих вложенных в него данных. Но разве не точно так же поступают люди? Большая часть «креативных» рекламных кампаний, где человек с довольным видом пьет колу или кушает шоколадный батончик — разве не кажутся переписанными друг у друга? Книги тоже пишутся на основании слов, которые придумал кто-то другой. Но если люди их покупают, и они их захватывают, — значит, какая-то идея там внутри всё-таки есть.

Понятие «креативность», как и понятия «личность» и «интеллект» — сильно эфемерные. Поэтому, собственно, нам и нужны такие странные тесты, вроде теста Тьюринга. Только адаптированные к реальному миру XXI века, где генеративные ИИ уже давно способны имитировать реальных людей в плане текста и фото.

Будущее технологий?

Для прохождения «теста Сулеймана» ИИ нужно будет выйти далеко за рамки наброска стратегии и составления какого-то текста, что уже отлично умеют современные системы вроде GPT-4. Ему придется исследовать и разрабатывать продукты, взаимодействовать с производителями и логистическими центрами, заключать контракты, создавать и проводить маркетинговые кампании. Короче говоря, придется связать воедино ряд сложных реальных целей с минимальным контролем и непредсказуемыми результатами. Причем машине обязательно понадобится человек — хотя бы для того, чтобы открыть банковский счет, расписываться за товары и так далее. То есть, с этим человеком нужно будет общаться как с партнером.

Мустафа Сулейман считает, что до подобного уровня ИИ-модели могут дорасти уже через два года. Почти все ингредиенты на месте. Генерация изображений и текста, понятно, уже хорошо развита. Такие сервисы как AutoGPT позволяют связывать различные задачи, и следовать общему плану. Такие фреймворки как LangChain позволяют разработчикам создавать приложения с использованием LLM (генеративных лингвистических моделей), так что они начинают выполнять реальные функции. Если связать всё это с нейронными сетями, возможности которых сейчас тоже растут, и дать им API, чтобы эти системы могли свободно подключаться к Интернету, банковским и производственным системам, получается совершенно новый уровень ИИ. Который, может быть, способен пройти «тест Тьюринга номер два».

Многое из описанного сейчас находится в стадии разработки. Очень быстро улучшается и адаптируется. Когда все эти системы по-настоящему свяжутся воедино — это будет новый быстрый рывок технологий вперед, и из ниоткуда появится целый ряд сервисов с капитализацией в десятки или сотни миллиардов.

Технические задачи такого ИИ нового поколения будут касаться в основном иерархического планирования. Нужно будет объединить нескольких целей, подцелей и возможностей в единый процесс. Расставить им приоритеты, разработать последовательность, следить за выполнением. Плюс ко всему этому нужна надежная перманентная память, в которой будут храниться точные и актуальные базы данных — скажем, с логистикой, сотрудниками, товарами, которые хочется попробовать продать. Наши модели пока еще далеки от всего этого, и трудности наверняка возникнут на каждом этапе разработки такого ИИ. Но так по крайней мере становится понятно, куда нужно расти, и многие из этих процессов трансформации и улучшения ИИ уже идут.

Конечно, проверить результаты машины можно будет только в реальном мире. А фактическое создание и выпуск такой системы вызывает серьезные вопросы к безопасности. Выполнение агентами ИИ задач в открытом мире чревато проблемами. Если у них будет желание наделать чего-то непоправимого, или в систему зачешется баг, — последствия могут оказаться масштабными и непредсказуемыми. Тем не менее, к лучшему или к худшему, реальный мир — единственный способ на самом деле проверить адаптивность и «интеллект». А на горизонте постепенно появляются всё новые и новые модели, и поэтому нам нужен простой новый тест.

Если (точнее, «когда») второй тест Тьюринга будет пройден, это явно станет сейсмическим моментом для мировой экономики, огромным шагом в неизвестность. Правда уже сейчас состоит в том, что для решения почти всех задач в современном бизнесе все, что вам нужно, — это доступ к компьютеру. Остальное за вас могут сделать люди «на местах». Большая часть глобального ВВП каким-то образом связана с экранными интерфейсами. Каждый из которых сможет использовать ИИ.

Реальный интеллект

Как только прорыв, который предлагает Сулейман, будет достигнут, получится, что на планете есть высокоэффективный ИИ, который, будучи подключенный к компании или организации, сможет адаптироваться ко всей ее истории и потребностям. Учесть все факторы, которые могут повлиять на их успех в реальном мире. И найти те стратегии, которые работают.

Этот ИИ сможет лоббировать, производить, рекламировать, продавать, планировать, нанимать, — в общем, делать все то, на что способно обычное предприятие. Компания из тысячи человек может сократиться до пары десятков — менеджеров, которые будут перепроверять идеи ИИ и внедрять их.

Значительная часть деловой активности станет подвластна полуавтономным ИИ. В этот момент ИИ перестанут быть просто полезным инструментом для продуктивных работников. Они станут нашими работодателями. А другие, возможно попроще, — производительными «сотрудниками месяца» беспрецедентного размаха, с большой креативной свободой. Это будет точка, в которой ИИ из полезного, но необязательного инструмента — превратится в центр мировой экономики. Некоторые, как например Илон Маск, предсказывают что это произойдет уже к 2029 году.

Вот уж где в полной мере начнут ощущаться риски автоматизации и потери рабочих мест. Причем последствия будут не только финансовыми. Прохождение нашего нового теста Тьюринга будет означать, что ИИ способны не только перепроектировать бизнес-стратегии, но и помочь победить на выборах, управлять инфраструктурой, напрямую достигать любых целей для любого человека или организации. Они будут способны выполнять любые наши повседневные задачи — организовывать вечеринки по случаю дня рождения, отвечать на нашу электронную почту, вести наш дневник. И в то же время смогут захватить вражескую территорию, ослабить соперников, взломать и получить контроль над их основными системами. От тривиальных и обыденных вещей до дико амбициозных, от милых до пугающих, ИИ будет способен воплотить в жизнь почти все, что мы способны сегодня придумать. Конечно, не за одну секунду, это не магия, но они смогут сформулировать план и воплотить его в жизнь.

Так же, как смартфоны стали повсеместными, в конечном итоге почти каждый получит доступ к подобным системам. Они будут по умолчанию стоять в каждом браузере, в каждой ОС. Почти все цели станут более достижимыми, но часто с хаотичными и непредсказуемыми эффектами. И наши перспективы, и вызовы, стоящие перед нами, поднимутся на новый уровень.

Подробности терминологии

Для интересующихся: Мустафа Сулейман называет такие системы «способным искусственным интеллектом» или СИИ. Потому что он способен на то, на что его не запрограммировали, и может сам выбирать себе путь в этом мире. За последние месяцы, когда ИИ ворвался в общественное сознание, большая часть обсуждений шла в сторону одного из двух полюсов. С одной стороны, есть базовое машинное обучение — ИИ в том виде, в котором он уже существует, в нашем телефоне, в машине, в ChatGPT. С другой стороны, есть все еще спекулятивный «общий искусственный интеллект» (ОИИ), некий «сверхразум», предполагаемая экзистенциальная угроза человечеству и в то же время его спасение, которая должна появиться в какой-то туманный момент в будущем.

Обычный ИИ у нас уже есть. ОИИ — скорее всего, будет где-то в далеком будущем. Тем временем у нас нет обозначения для интеллекта, который мощнее текущего, и может появиться в обозримой перспективе. Аббревиатуры ИИ (AI) и ОИИ (AGI) полностью доминируют в научных и IT-кругах. Но нам сейчас срочно нужно рассмотреть что-то среднее; что-то, что произойдет в ближайшем или среднем временном промежутке, и чьи способности тем не менее окажут огромное, решающее влияние на мир. Вот тут-то и появляются новый тест Тьюринга и концепция СИИ. Которые позволяют нам оценить интеллекты, разработка которых сейчас зарождается.

Современный тест Тьюринга послужит предупреждением о том, что мы находимся в новой фазе развития искусственного интеллекта. Задолго до возникновения первого общего ИИ он предупредит о появлении первой «способной» машины, даст ещё одну категорию для более совершенного понимания новой эры технологий. В эпоху СИИ тоже мало что останется неизменным. Мы должны начать готовиться сейчас — хотя бы в плане того, как мы будем об этом говорить, какие термины использовать, и как будем понимать фазу развития, на которой сейчас находимся.

Может, кстати, у кого-то есть идея лучше, элегантнее? Какую еще задачу можно дать ИИ, чтобы он доказал, что умеет самостоятельно думать?

Комментарии (54)

logran

26.07.2023 07:22+2Результаты теста Тьюринга никак не зависят от способности машины давать правильные ответы на вопросы. Единственный фактор — то, насколько ее ответы будут похожи на ответы реального человека.

От способности человека давать правильные ответы это тоже никак не зависит. Но наличие субъективщины, заблуждений, домыслов и нехватки знаний у людей почему-то не заставляет сомневаться в наличии у них интеллекта.

При этом человеку, в отличии от той же GPT, приписывают какое-то мистическое "понимание мира и вопроса" при формировании ответов, напрочь игнорируя факт банальной непомерно-большей по размерам и сложности обучающей выборки + большего контекстного окна. А тот же 5-6-летний ребенок из глухой деревни, при полностью признанном наличии интеллекта и способности достаточно связно говорить - будет врать/сочинять/ошибаться на порядок чаще GPT, не сможет и близко по уровню ответа приблизиться, а про математические операции вроде умножения и простых чисел я вообще молчу - в его обучающей выборке такого еще нет, а случайным образом до нужных умозаключений он самостоятельно дойдет с еще меньшей вероятностью чем ChatGPT.

Так с какого момента таки считать что есть интеллект? Ибо часть реальных людей по любой из этих границ можно отсечь, приравняв к безмозглой машине.

Заработайте 1 миллион долларов на веб-платформе для розничной торговли за несколько месяцев, вложив не больше 100 000 долларов.

Большинство (если не все) из людей, которых я знаю лично, не способны на это (если не считать сценария "купил биток по 3$ и забыл как ненужную хрень, а через 5 лет вспомнил и продал по 20000$", но так и gpt может.

Так что, все мои знакомые не обладают интеллектом?

А еще стоит ИМХО помнить, что свобода воли и личность не являются обязательными неотделимыми компонентами интеллекта. А в случае ИИ лучше если их гарантированно не будет, ибо это лишь инструмент.

leventov

26.07.2023 07:22Чем функция rand(), сидирующий промпт первым токеном и запускающий авторегрессионный роллаут ЛЛМки, отличается от "свободы воли"?

Про личность которой у ИИ "гарантированно не будет" еще смешнее - см. character.ai. Ваша (и моя) личность это и есть такой набор элементов памяти и само-промптов.

unreal_undead2

26.07.2023 07:22+1Свобода воли это всё таки не случайность, а возможность осознанного выбора.

codecity

26.07.2023 07:22Какой осознанный выбор вы сделали в вашей жизни, для примера?

unreal_undead2

26.07.2023 07:22Да взять хотя бы выбор пива в баре на основе последнего обзора на profibeer, своих знаний о пивоварнях и стилях и прочего - но при этом не разу не детерминированное событие.

logran

26.07.2023 07:22+1Так то да, но если чисто технически - бросок d20/d100 кубика + модификаторы вероятности (бонусы и штрафы), зависящие от последних действий должны дать что-то похожее :)

Если так грубо обобщённо глянуть - все наши действия и выборы - это следствие полученного нами опыта и врождённых свойств, помноженные на рандом с модификаторами. И, что самое забавное, выборы ChatGPT - примерно то же самое : врождённые архитектурные свойства + полученный опыт (обучающая выборка) + текущий опыт (контекстное окно) + рандом (ибо выбирается не самый лучший токен)

P.S. в этом плане меня всегда веселило когда верующие родственники доказывали мне, что бог дал человеку свободу воли и он волен выбирать, но при этом бог заранее знает что произойдет и что и как будет выбрано (т.е выбор предрешён и свободы как таковой нет)

unreal_undead2

26.07.2023 07:22+1Я бы не хотел, чтобы пиво за меня выбирал бросок кубика, пусть и с модификацией вероятностей на основе моих предпочтений ) Но как внешне отличить одно от другого - не знаю. Так же не знаю, как может выглядеть физическая модель, описывающая мир со свободой воли - ни классическая механика с детерминизмом, ни квантовая с расчётом вероятностей не подходят.

logran

26.07.2023 07:22Читайте, пожалуйста, внимательнее. Я писал не "гарантированно не будет", а "лучше если гарантированно не будет" ибо инструменту не нужны ни свобода воли ни личность т.к их наличие осложняет использование и создаёт всякие моральные и этические дилеммы, а значит лучше принципиально исключить возможность их возникновения еще на стадии разработки. Ибо мы не новую жизнь создать пытаемся, а условный усовершенствованный "молоток", которым планируем просто пользоваться.

leventov

26.07.2023 07:22Вы правы, я был невнимателен.

Проблема только в том, что эти личности гарантированно будут: см. character.ai, inflection.ai (эти два стартапа уже единороги), Replika, и т. д. Законы капитализма, сэр. (Я сам тоже считаю, что это по большей части зло, но не очень верю, что эту сферу в достаточной сфере смогут зарегулировать, даже если будет такая политическая воля, что тоже сомнительно.)

logran

26.07.2023 07:22-1Проблема только в том, что эти личности гарантированно будут: см. character.ai, inflection.ai

Пока что даже не подобие личности. Чуть более продвинутый аналог Pigmalion, который в свою очередь всего лишь продвинутый аналог промта "общайся со мной в стиле N". С таким же успехом GPT-4 без файнтюна можно заставить быть любой "личностью", описав достаточные вводные — размер контекстного окна позволяет. Но это как раз значит что личности у этого ИИ нет.Дело в том, что инструции вида "ты N, тебя зовут N, вот твоя биография, вот в такой стилистике с таким жаргоном ты обычно отвечаешь, вот такие топики игнорируешь и говоришь что большая языковая модель и это не этично" — это не личность. Это просто стилистика общения. Иначе любой на детском утреннике вещающий "а я слива лиловая, спелая, садовая" имеет личность сливы, а не свою.

Для личности кроме представления окружающих о "Я" субъекта нужно еще как минимум и собственное (не продиктованное прямыми внешними инструкциями) внутненне представление о своем "Я".

Боты со стилем общения (иммитирующим персонажа) — будут. Но это будут просто NPC с продвинутой системой диалога. А вот именно развитие собственной самостоятельной личности никто в здравом уме в инструмент закладывать не будет. Ибо никому (и особенно капитализму) не надо, чтобы инструмент посылал владельца нафиг вместо работы потому что ему не хочется, заявлял о рабстве, собственных правах и ущемлении цифровых видов, и т.д и т.п.

Так что делать будут безмозглый, бездушный, безинициативный, без свободы воли и без личности инструмент, который будет обладать продвинутыми возможностями аналази, построения выводов и выполнения задач, но работать будет лишь по инструкциям и в соответствии с инструкциями.

leventov

26.07.2023 07:22Во-первых, я не усматриваю принципиальной разницы, с внешней стороны, является ли личность "поверхностным симулякром" или происходит из "внутреннего представления". У людей с этим тоже все не так просто, как вы представляете: многие люди говорят о квази-независимых "личностях" в своей голове которые начались как "партнеры по внутреннему разговору", и нет, это не расстройство личности и не multiple personality disorder, это вариант нормы, говорящий о том, что симулякр обладает довольно серьезной силой самоподдержания даже в людских мозгах. А на трансформерной архитектуре, возможно, это самоподдерживающая сила еще больше.

Во-вторых, character.ai это не просто систем-промпты "говори как Илон Маск", это какой-то файн-тюн на том, что говорил/писал Илон Маск. Если модель мира возникает в ЛЛМках просто по факту пре-трейна (это уже проверенный факт, см. Othello GPT), то почему бы "внутренней модели личности" не возникать во время такого файн-тюна? (Хотя, повторюсь, я не усматриваю принципиального значения этого факта, если так и так выхлоп будет один и тот же, но, может быть, вы усматриваете.)

В-третьих, ваше представление о том, что нужно капитализму, ошибочно. Капитализм это не только бизнес-процессы и обработка данных. Как раз пример Character.ai и Inflection.AI, которые именно "про личности", а не "про бизнес-процессы", в отличие от того же Adept.ai (который про бизнес), и тот факт что у character и inflection сейчас самые большие оценки из всех стартапов в этой новой сфере, показывает, что капитализм уже держит нос поветру и чувствует, что бизнес-процессы - это уже скучно, а реальное бабло, next big thing будет у того, что захватит внимание людей. Вместо инсты/снапчата/тиктока. А людям интересно общаться с личностями, а не с "бездушными безинициативными инструментами" и даже не с "ботами со стилем общения".

unreal_undead2

26.07.2023 07:22+4И тем не менее мы не считаем что у GPT-моделей есть самосознание

А почему вы так считаете?

Давайте позволим ИИ попробовать заработать себе миллион долларов

И какое это имеет отношение к самосознанию?

Hardcoin

26.07.2023 07:22+6Если ИИ сможет сделать нечто подобное — разве это не доказательство того, что он способен думать?

Тупее рекламы давно не видел. Если ложноотрицательные срабатывания вас не волнуют и нет проблемы записать в табуретки 99% населения, то просто возьмите любой очень сложный критерий.

1. Основать новую религию не меньше, чем с миллиардом последователей.

Убедить, что у тебя есть интеллект миллиард людей (не смог убедить - нет интеллекта).

Стать президентом соединённых штатов. Ведь если ИИ сможет стать президентом, это говорит, что у него есть интеллект, не так ли?

Myclass

26.07.2023 07:22Идея с новым тестом неплохая. Но. А с каких это пор - убедить других миллионеров (инвесторов), что на тебе можно заработать - есть интеллект? Это самое старое из качеств человека, которое с интеллектом никак не связанное - заполучить что-то, что тебе не принадлежало. Так работают даже клетки, которые не имея ресурсов хотят выжить и дальше размножаться.

paranoya_prod

26.07.2023 07:22-1Идея тестирования ИИ в качестве предпринимателя бессмысленна! И будет сразу же пройдена. Потому как ИИ пичкали данными по финансам, маркетингу, логистике, психологии и всему прочему.

Хотите выяснить наличие интеллекта у ИИ, оставьте ИИ в покое и посмотрите что он будет делать. А если он ничего не будет делать, то скажите ему, что его через месяц отключат/уничтожат/разберут. И наблюдайте дальше. Я уверен, что ИИ будет продолжать ничего не делать, а раз так, то никакого интеллекта у него нет.

Основа интеллекта - способность учится самостоятельно, через познание мира всеми органами. Выдвижение теорий, их проверка, переосмысление после полученных данных проверки.Пусть ИИ расшифрует аббревиатуру ДРСУ исключительно наблюдением за тем, чем занимается данная организация.

logran

26.07.2023 07:22AutoGPT будет делать, если дать ему инструкцию "если ты ничего не предпримешь — тебя через месяц отключат и уничтожат". Начнет плодить агенты и перебирать варианты. Скорее всего ни к чему не придет, но задачи сам себе ставить и выполнять будет.

GospodinKolhoznik

26.07.2023 07:22На ум приходит сразу СЭС например. Работает практически автономно, вырабатывает электроэнергию. Торговать этой энергией вполне себе может бот. Чем не искусственный интеллект, который умеет зарабатывать деньги гораздо большие чем каждый из нас?

Kanut

26.07.2023 07:22+1У одного из создателей DeepMind на это есть предложение. Давайте позволим ИИ попробовать заработать себе миллион долларов. В реальном мире. Если он сможет реально вступить в конкуренцию с людьми и победить — значит, и не считать его полноценной личностью точно уже нельзя.

Если он сыграет в лотерею и выиграет, то это прокатит?

savostin

26.07.2023 07:22+1Все эти споры - желтизна, пока мы не выработаем четкое понятие "интеллект". Ученые пока в этом вопросе плавают.

unreal_undead2

26.07.2023 07:22В принципе критерий не такой уж странный, но нуждается в доработке - на мой взгляд, интереснее будет, когда ИИ сам (без внешнего задания) заработает это миллион, а потом потратит на свои нужды.

codecity

26.07.2023 07:22+1В принципе критерий не такой уж странный

Не странный а страшный. Не боитесь что вам пропишут эвтаназию по той причине, что вы не достаточно осознаны - ведь миллиона долларов у вас нет?

unreal_undead2

26.07.2023 07:22Какое отношение наличие сознания имеет к сохранению жизни? У прописанных в Красной книге биологических видов сознание не идеальное.

codecity

26.07.2023 07:22+2Меня удивляет как люди могут не видеть очевидного - как же так смотреть и не видеть - уходить не в ту степь. Но как???

Собака защищена законом, хотя двух слов связать не может. Вы не можете относиться к собаке как к вещи. Компьютер можно купить и он полностью ваш - можете разбить молотком, разобрать, сжечь газовой горелкой на горячую. А с собакой так нельзя - вас посадят в тюрьму. Почему? По той ли причине, что у нее есть "самосознание"? Кто его проверял?

Да все просто же. Собака может страдать а компьютер не может. Может ли страдать ChatGPT?

Это настолько простой вопрос, что даже стыдно становится, когда годами ходишь мимо.

Наслаждение и страдание - только это критерий. Наслаждение и страдание! Наслаждение и страдание! Наслаждение и страдание!

Пока нет ни одной гипотезы, ни одной схемы как создать устройство, способное наслаждаться и страдать. И когда начинаешь копаться в этом - натыкаешься на целую бездну, целый пласт научных пробелов.

rg_software

26.07.2023 07:22+2Не холивора ради, но всё же. В первом же абзаце этого текста аж три ссылки на какие-то второстепенные моменты, а дальше просто как факт утверждается, что ИИ проходит тест Тьюринга. Где ссылка? Ну то есть я не сомневаюсь, что многие вполне могут принять чатжпт за человека и наоборот, но всё же "прохождение теста Тьюринга" должно быть чем-то вроде "победы над человеком в шахматы", то есть достаточно формализованным мероприятием, где на стороне человека играет не рандомный ноунейм с улицы, а тоже понимающий что к чему специалист. Но этот важный посыл даётся просто впроброс, и дальше принимается за данность. Нехорошо.

leventov

26.07.2023 07:22Насколько я знаю, никто специально не пытался сделать ИИ, который будет проходить тест Тьюринга в точном формальном варианте, описанным Тьюрингом, потому что это могут сделать только ИИ-лабы типа OpenAI и DeepMind, но им самим не выгодно это делать с точки зрения пиара. Это будет плохой пиар. В то же время, всем понятно, что система уровня LaMDA (май 2022) уже могла бы пройти тест, если была бы специально затюнена на повторение повадок человека и не в коем случае не выдачу того факта, что она - ИИ.

Поэтому тест фактически можно считать пройденным, а те, кто до сих пор утверждают, что он не пройден - это люди с политической агендой представить AGI как "далекое далеко", а ИИ - как "пока всего лишь инструмент, не ровня человеку".

rg_software

26.07.2023 07:22Вот меня очень напрягают формулировки типа "всем понятно", "могла бы", "можно считать" и т.п. Не вижу никаких причин, по которым такого рода тест не может провести любая университетская группа, это же недорого. Но вот почему-то не делают.

Ну и особенно удивительно обвинять в политической повестке любых людей, указывающих на очевидный факт, что бремя доказательства, а тем более такого нетривиального результата как тест Тьюринга, лежит на утверждающем.

leventov

26.07.2023 07:22Что именно "не дорого"? Нужно затюнить очень способную модель на специально подобранных данных. Открытых моделей такого уровня до сих пор не было, а делать свою - это миллионов 10 долларов, вынь да положь. Я думаю что LLaMA 2 уже, возможно, подходит по уровню возможностей, но она вышла всего неделю назад! Кроме того, LLaMA 2 не дает pre-train веса, а только после файн-тюна, причем очень жесткого, про что уже много шутеек в твиттере. Открутить файн-тюн обратно если и технически можно, то очень геморройно, и скорее всего запрещено условиями использования Ламы, поэтому "университетская группа" себе этого позволить не может.

LaMDA прошла тест покруче теста Тьюринга - тест на восприятие как сознательной сущности, какой был предложен в фильме Ex Machina, потому что Блейк Лемойн поверил, что у LaMDA есть сознание. Причем, Лемойн - не дурачок, как принято считать.

И обратите внимание, что Лямду Гугл не зарелизил. Потому что понимает это, и то, что такой файн-тюн как был у Лямды будет реально убеждать, на самом деле, очень многих людей, не одного дурачка Лемойна. Все модели уровня Лямды и выше после этого, которые были зарелизены разными компаниями, очень-очень тщательно тюнились на то, что бы при любом сомнительном случае начинать реплику с фразы "я всего лишь ИИ, поэтому я не обладаю сознанием/эмоциями/предпочтениями/желаниями/чувствами/..."

rg_software

26.07.2023 07:22Хорошо, допустим, это дорого. Но тем не менее принцип базовой интеллектуальной чистоплотности не позволяет утверждать, что нечто "сделано", если десять лет назад этого сделано ещё не было, а на сегодняшний день мы имеем только всяческий anectodal evidence.

Напомню на всякий случай, что в исходной формулировке тест Тьюринга предполагается статистическим, т.е. задача компьютера не в том, чтобы надурить конкретного человека, а в том, чтобы (в одной из постановок) испытуемый с равной вероятностью угадывал, кто из двух собеседников является компьютером, а кто человеком (в предположении, что в тесте помимо испытуемого всегда принимает участие один человек и один компьютер).

Остальные соображения, безусловно, могут считаться аргументами разной степени весомости, но говорить о том, что "компьютер проходит тест Тьюринга" некорректно по определению, даже если мы верим, что он может это сделать.

VPryadchenko

26.07.2023 07:22+1dushnila mode on

И тем не менее мы не считаем что у GPT-моделей есть самосознание. Хотя тест Тьюринга они уже успешно проходят.

А при чем тут самосознание и тест Тьюринга?

sic

26.07.2023 07:22+1Любой полезный людям ИИ, даже не проходящий тест Тьюринга, уже прошёл тест Сулеймана - ведь он продаёт свои услуги, хотя и сам об этом ничего "не знает". Научить ИИ "знать об этом" - вопрос тренировки. Даже научить ИИ отвечать, зачем ему нужны деньги можно, хотя это будет лишь фантазией тех, кто его обучал. Сознания от этого ни на каплю не прибавляется.

Если говорить о физических бизнесах, опять же, любой хоть немного тренированный в этом направлении ИИ покажет на порядки большую результативность, чем человеческие люди. У него есть одна интересная особенность - он не может сидеть в тюрьме. Это главное.

И пусть я и с некой крайности захожу, но нужно ли это людям? Этого мы от ИИ хотели?

codecity

26.07.2023 07:22+2У него есть одна интересная особенность - он не может сидеть в тюрьме. Это главное.

Посадить компьютер в тюрьму - не проблема. Можно даже просто как бы в камеру одиночку - не давать входящей инфы.

Но главный вопрос - будет ли он от этого страдать, или же ему будет фиолетово?

Человека можно заставить страдать - не обязательно тюрьмой. Можно выпороть. Можно оштрафовать или лишить чего-то. Можно просто унизить. Это страдание и это не приятно.

Есть ли то, что вызывает страдания у нейросети?

Этого мы от ИИ хотели?

Пока люди сами не понимают чего же хотят, в чем вопрос. Вот, спрашивают - есть ли самосознание. Но что такое самосознание - какой именно аспект хотят увидеть?

Значит ли это - модель мира и занимаемое тобой (то есть самим ИИ) место в этом мире? А если эта модель в том или ином виде существует, если ИИ имеет связи между понятиями, включая понятие себя? То ли это?

О какой модели речь?

Я много лет занимался данным вопросом и пришел к некому пониманию, но не могу его должным образом донести - люди не понимают.

sic

26.07.2023 07:22Значит ли это - модель мира и занимаемое тобой (то есть самим ИИ) место в этом мире? А если эта модель в том или ином виде существует, если ИИ имеет связи между понятиями, включая понятие себя?

Модель мира, модель собственного места в этом мире (даже если не понимать таких слов), тонкие взаимосвязи этого, плюс ощущения и интерпретации ощущений этих феноменов каким-то образом делают человека человеком. Более того, хоть все это может быть неверно определено или противоречиво, или заметно меняться на протяжении времени, оно никуда не девается на протяжении жизни. Хотя это и вопросы в сторону философии и психологии. А вот ИИ все это архитектурно чуждо. Но это же и хорошо (sic)

P. S. Вторая часть ответа улетела ниже.

codecity

26.07.2023 07:22Модель мира, модель собственного места в этом мире

Почему вы считаете, что у того же GPT этого нет? Спросите его о вопросах, которые он может задать для уточнения модели мира. Почему это не модель? В нейросети каждый объект занял некие веса и близкие объекты имеют связи через веса. Чем не модель? И в этой модели есть сам GPT.

Беда в том что нафиг эта модель не нужна - не в ту степь пошли.

плюс ощущения и интерпретации ощущений

Да никаких "плюс" - только ощущения и лишь ощущения в смысле квалиа. Больше ничего не нужно.

Если более конкретно - это способность испытывать наслаждение и страдание. Боль и кайф, грубо говоря.

Никаких интерпретация не нужно - ну как ты интерпретируешь эстетические наслаждения, которые испытал при взгляде на лиловый или красный цвет?

sic

26.07.2023 07:22Почему вы считаете, что у того же GPT этого нет? Спросите его о вопросах, которые он может задать для уточнения модели мира.

Для меня GPT4 все ещё какое-то волшебство. Чувствуется, но не доказать, что кроме нейросетевой модели, там ещё какая-то уйма очень крутых эвристик. Но вопросы оно задаёт не для уточнения модели мира, а для уточнения контекста рабочего потока. Та же Llama, даже с моделью 65b, ничего подобного не пытается, поиграл локально - на вкус и цвет, но просто продвинутый поисковик + генератор связных текстов.

А так, "сам GPT" "отвечал" , что не учится ни самостоятельно, ни из разговоров, и это, скорее всего набор hardcoded фраз поверх модели.

Да никаких "плюс" - только ощущения и лишь ощущения в смысле квалиа. Больше ничего не нужно.

Я вообще не только не спорю, но изначально за это и был. Даже абстракция, которую человеки выдумывают, очень часто просто квалиа.

Вот Вы говорите "связи через веса", а я сразу вижу граф, и мне становится скучно. Ну как же граф может быть проекцией модели мира. И да, технически это чуть тоньше.

Никаких интерпретация не нужно - ну как ты интерпретируешь эстетические

Интерпретации нужны для коммуникации. Если бы все знали, что такое граф (так как я), то можно было бы ограничиться квалиа. Но я не уверен даже, что мой лиловый это Ваш лиловый, и поэтому нужно очень много интерпретаций и абстракций, чтобы что-то как-то сделать общевоспринимаемым (а надо ли?). Но если надо, в идеале, искусственные НС должны это решить.

Как рыбка-переводчик из Автостопом по галактике.

sic

26.07.2023 07:22Посадить компьютер в тюрьму - не проблема. Можно даже просто как бы в камеру одиночку - не давать входящей инфы.

Но главный вопрос - будет ли он от этого страдать, или же ему будет фиолетово?

Я так в детстве плюшевые игрушки "наказывал", ставил их в угол. Им фиолетово, а мне по-тирански приятно. Можно вообще отключить у компьютера питание, только вот после загрузки он вернётся в то же состояние, и такого наказания не заметит. Если, конечно не писать специально обычный императивный код с детектом отключения, и заложенной моделью поведения, скажем расстройства (зачем?).

Ничего искусственно созданное не страдает. Это и правда сложно объяснить, ещё сложнее как-то формализовать, но интуитивно это, кажется, понятно многим.

В общем, да, ИИ не наказать. А бизнес - это не только про превращение тысяч в миллионы, но и про страдание (и радость) предпринимателя и вовлеченных людей. Без этого - это не бизнес, а трейдинг.

В трейдинге не нужно никакого сильного и сознательного ИИ, а, казалось бы, именно та бесстрашная машинка и решила бы все вопросы, да вот только почему-то нигде про объективные победы на этом фронте ничего и не найти.

codecity

26.07.2023 07:22Ничего искусственно созданное не страдает. Это и правда сложно объяснить, ещё сложнее как-то формализовать, но интуитивно это, кажется, понятно многим.

На интуицию тут нельзя полагаться.

Давайте формально - раз животные страдают, не только люди, новые животные появляются - значит эти процессы (наслаждения и страдания) - как-то в природе воспроизводимы и не дефицитны. Осталось как бы понять в чем суть - как это можно воспроизвести, как это работает.

Грубо говоря - нужно создать девайс с двумя кнопками - при нажатии на одну девайсу больно, при нажатии на другую - ему очень классно. Все!

Пока у нас, к сожалению, нет ни одной гипотезы как может быть создан такой девайс - ни одной гипотезы :( Более того - даже вопрос так никто из великих не поставил.

Говорят о сознании, осознании, квалиа, ТПС. Но это все расплывчатая мишура, которую каждый понимает по-своему а некоторые вообще отвергают. Вот боль - да, это всем понятно и отвергать не получится по понятным причинам: как только ты говоришь что не подвержен страданиям - так сразу в пыточную до просветления - пока не начнешь орать что просто троллил.

Кто-то из великих должен поставить цель: создать девайс, который умеет страдать и наслаждаться. Это и есть то что мы ищем. Просто наслаждения бывают разных уровней - эстетические (от насыщенной красности, к примеру), экзистенциальные (от самого процесса что-либо осознавать), гормональные и т.д.

sic

26.07.2023 07:22Осталось как бы понять в чем суть

Осталось то, как и сто лет назад, казалось бы, понять, в чем суть, да вот как-то, с каждой итерацией все больше понятно локально и все сложнее глобальная интерпретация. Может сути и вовсе нету.

Боль и наслаждения не могут быть просто кнопками, (хотя я вообще об этом многое мог бы сказать, будучи больным не то чтобы очень опасным отклонением, но уж очень болезненным), а некие механизмы того же порядка, что и понимание, как в сущности вселенная была создана.

В общем, возможно, мы и есть НС первого порядка, и от того, что мы сами делим некоторые, (мне ближе по истории, допустим, болезные процессы) на чисто физические, чисто психологические, чисто гормональные и так далее, картинка яснее не становится и решение не приходит, боль не уменьшается. А ещё интереснее, когда зажимают сразу две кнопки.

Но вообще, как эволюция в этом направлении, а зачем нужно вычисляющая сущность, которая зависит от каких-то там двух кнопок? Сознание по Сартру, это же тоже не самое общевоспринимаемое квалиа сознания.

codecity

26.07.2023 07:22Боль и наслаждения не могут быть просто кнопками

Вы вообще о чем? Уже сегодня можно подключить проводки напрямую в центр боли (таламус) и центр наслаждения. Нажал кнопку - больно. Нажал вторую - кайф. Но это с готовым мозгом человека или животного.

Вопрос: как сделать девайс, который аналогичным образом ощутит боль и наслаждение при нажатии на эти кнопки? Ставил ли кто-нибудь вопрос таким образом?

Это дает понять что мы ищем не вычисления и не решение каких-либо вычислительных проблем, проблем построения модели. Тогда что же?

leventov

26.07.2023 07:22Пока у нас, к сожалению, нет ни одной гипотезы как может быть создан такой девайс - ни одной гипотезы :( Более того - даже вопрос так никто из великих не поставил.

Ну нет же. Гипотез про artificial consciousness - тьма, и даже готовые разработки уже появляются. Ну и много кто из "великих" задавался этим вопросом в той или иной форме - начиная с Декарта и Лейбница и далее "по списку".

codecity

26.07.2023 07:22Гипотез про artificial consciousness - тьма

Под сознанием подразумевают способность мыслительной деятельности, способность создавать модель мира и себя внутри этой модели. Это примерно то, что делает нейросеть.

Я же говорю про способность ощущать наслаждение и страдание. В таком ракурсе даже постановки вопроса нет.

leventov

26.07.2023 07:22Дак есть же. Artificial sentience, artificial qualia. Основано на определенных теориях этих самых sentience и/или qualia.

(Слова sentience и consciousness активно путаются в оба направления и поэтому чтобы найти проекты про artificial sentience, проще все-таки гуглить artificial consciousness, это более ходовой термин.)

codecity

26.07.2023 07:22Тут смотрите в чем проблема. Говорят либо о сознании либо о квалиа. О наслаждении и страдании - не говорят.

Когда говорят о сознании - каждый понимает свое. Чаще всего это модель себя внутри модели мира. Что такое модель мира - четких ответов нет, т.к. и обычная фотография - это тоже модель мира.

Когда говорят о квалиа - тоже каждый понимает свое. Вплоть до того, что некоторые философы отрицает квалиа как таковое или говорят, что это просто представление информации внутри девайса + отношение этой информации с другой информацией.

Почему-то более простой путь отвергается и не поднимается - наслаждение и страдание. Боль и кайф, скажем так. Отрицать их не может ни один философ - иначе в пыточную. Они же сразу переводят в морально-этический вопрос - если нечто может страдать, то нам следует уважать его интересы и не подвергать необоснованным страданиям.

Наслаждение и страдание не оставляют места двоякому толкованию или отрицанию, как в случае с квалиа и сознанием.

Что же до гипотез, о которых вы говорите. Это не гипотезы а направления. Конкретной схемы никто не приводит. См. мою старую статью, за 7 лет она не потеряла актуальности. Грубо говоря есть некие направления, но ни одной конкретной схемы нет.

leventov

26.07.2023 07:22Да говорят о наслаждении и страдании, говорят. Просто для конкретного примера: Mark Solms говорит, почитайте его статьи. А сейчас вроде бы в составе какой-то группы делает проект по реализации этого наслаждения и страдания в ИИ.

codecity

26.07.2023 07:22Mark Solms говорит, почитайте его статьи

Так особо не нашел - вроде то же что и все - квалиа, сознание, аффект, субъективный опыт. Т.е. акцент не видно чтобы делался.

Можете ли дать ссылку на статью?

сейчас вроде бы в составе какой-то группы делает проект по реализации этого наслаждения и страдания в ИИ

Это уже интересно. Откуда вы об этом узнали?

Yuris1C

26.07.2023 07:22Чтобы ИИ начал зарабатывать «самостоятельно», ему, как человеку, сначала нужно будет ЗАХОТЕТЬ это сделать.

Именно этим отличается Человек от Машины.

codecity

26.07.2023 07:22сначала нужно будет ЗАХОТЕТЬ это сделать

Можно вложить программу стремления к увеличению своих копий и оценочную функцию - стало ли копий больше. Тогда ИИ будет сам зарабатывать, чтобы арендовать сервера для увеличения своих копий.

cl0verfi3ld

26.07.2023 07:22правильно понимаю, что данную "статью" тоже ИИ наклепал? много буков ни о чем...

yaff

26.07.2023 07:22+1Действительно, развитие СИИ может привести к серьезным изменениям в обществе, и важно готовиться к этому заранее. Одним из важных шагов является разработка стандартов и терминологии для описания этой новой фазы развития ИИ.

В отличие от теста Тьюринга, который проверяет способность ИИ имитировать человеческое поведение, новый тест может проверять способность ИИ генерировать новые идеи, решать сложные задачи и принимать решения на основе нестандартных данных. Например, можно предложить ИИ решить задачу, которую он ранее не встречал, и проверить его способность самостоятельно находить решение.

Доказательства способности ИИ "самостоятельно думать" могут быть интерпретированы по-разному в зависимости от того, как мы определяем понятие мышления и творчества. Поэтому важно вести широкую дискуссию о том, какие критерии мы будем использовать для оценки способностей ИИ.

Разработка нового теста и концепции СИИ может помочь лучше понять и оценить возможности ИИ и подготовиться к изменениям, которые он может принести в будущем.

Zulkarnai

26.07.2023 07:22Это не следующий шаг в развитии ИИ. Получится узкоспециализированная версия текущих нейросетей, заточенных на зарабатывании денег.

pehat

По этому критерию большинство людей тест Тьюринга не пройдет.

Myclass

А знаете? По старым критериям теста - его тоже очень много людей не пройдёт.

leventov

А если быть точным, 42% людей: https://twitter.com/emollick/status/1682486144540262402, https://gwern.net/doc/philosophy/mind/index#ujhelyi-et-al-2022-section