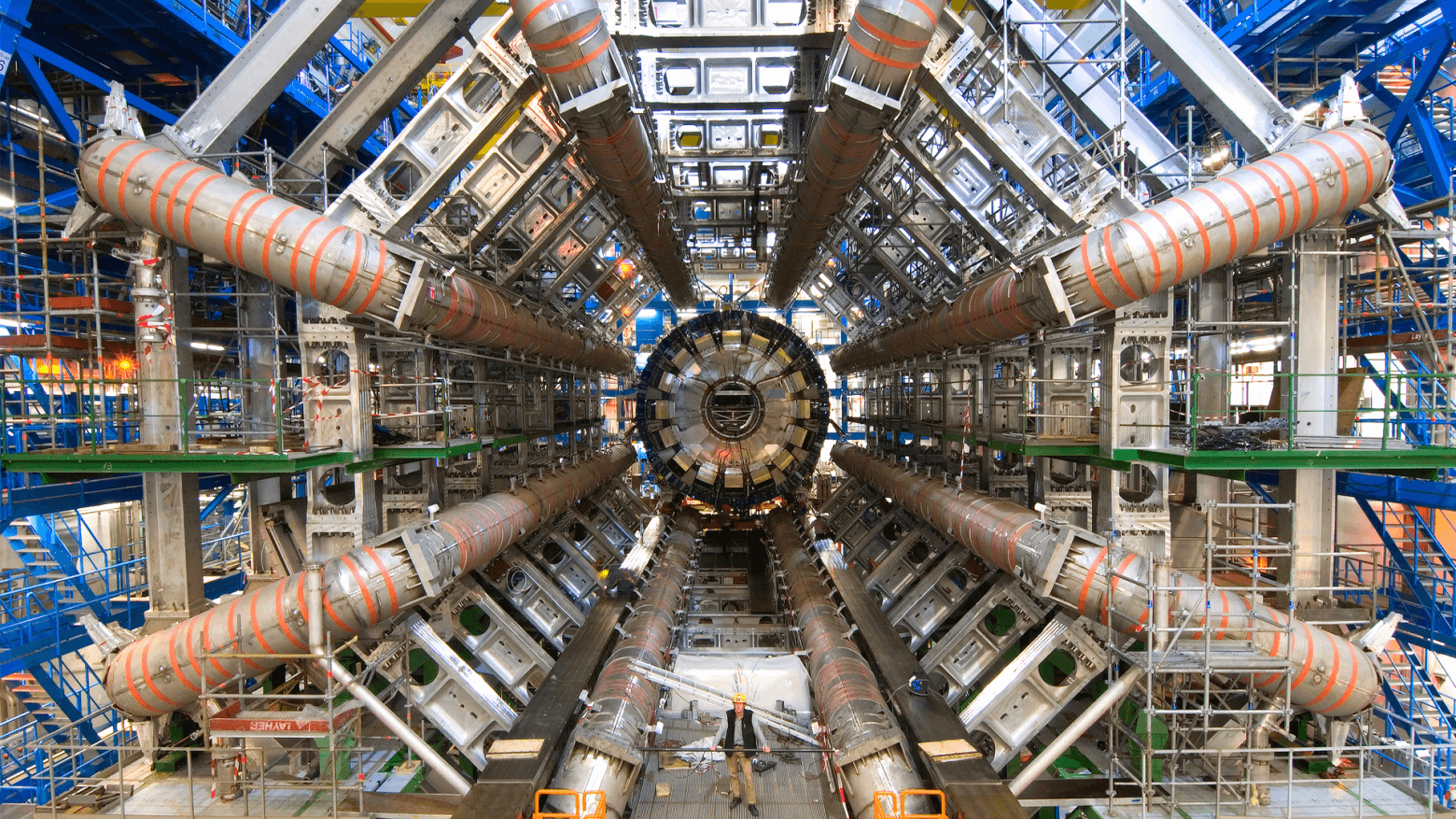

Когда Большой адронный коллайдер запущен — как например, во время своего второго цикла, с начала 2015 года по 2018 год, — он обрабатывает события на частоте 40 МГц. Другими словами, он учитывает 40 миллионов событий в секунду. Это необходимо, чтобы отслеживать столкновения между частицами, длящиеся менее 25 наносекунд.

Каждое событие содержит в себе примерно 1 мегабайт данных. Это значит, что в систему во время работы коллайдера входит примерно 40 терабайт данных. В секунду! Абсолютно фантастический объем информации, ведь петабайт набирается примерно за полминуты. Около 72 000 средних жестких дисков заполнялись бы каждый час.

Обрабатывать всё это на такой же скорости не представляется возможным; для анализа подобных объемов данных после окончания работы установки требуются годы. Значительная часть отфильтровывается еще на этапе сбора, на что тоже уходят огромные вычислительные ресурсы. Но всё-таки остальную часть информации нужно где-то хранить. Для этого европейская организация по ядерным исследованиям (ЦЕРН) содержит самый большой ЦОД в мире.

Как хранятся данные ЦЕРН

Полностью всю информацию записать не могут даже в ЦЕРН. Поэтому они фильтруют события с той же скоростью, с которой те поступают. Система должна отфильтровывать от 40 миллионов событий в секунду до ~1000 актуальных событий в секунду, которые можно затем записать на носители. В основном такая фильтрация делается за счет уровней.

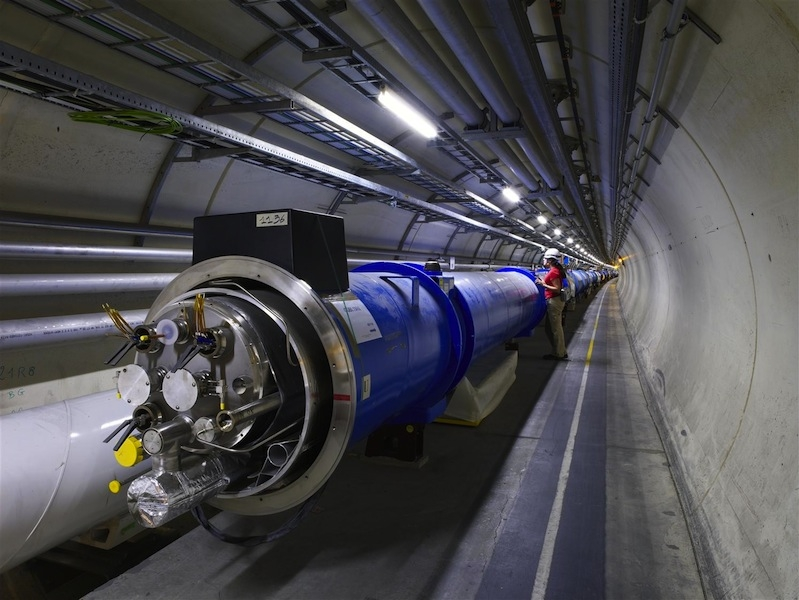

Сеть БАК организована по уровням: 0, 1, 2 и 3. Уровень 0 обрабатывает первичную информацию и находится в самом ЦЕРНе. Он состоит из тысяч коммерчески купленных серверов— как старых коробок в стиле ПК, так иблейд-систем, похожих на черные коробки из-под пиццы, сложенные рядами на полках. Новые серверы постоянно приобретаются и добавляются. Данные, передаваемые на уровень 0 системами сбора данных БАКа, архивируются на магнитной ленте.

Уровень 0 — это ЦОД ЦЕРНа. Все данные БАКа проходят через этот центральный узел, но в целом он обеспечивает менее 20% общей вычислительной мощности. ЦЕРН отвечает за безопасное хранение необработанных данных (триллионов цифровых показаний со всех детекторов) и выполняет первый этап преобразования этих данных в значимую информацию. Бесполезные данные выбрасываются и нигде не записываются. Другие необработанные и реконструированные данные выходят на Уровень 1. Он является основным и самым активным всё то время, когда БАК не работает.

Никаких людей на этом этапе всё еще нет, распределение информации происходит автоматизированно. Уровень 1 состоит из 14 дата-центров в разных странах, каждый площадью 3-5 тысяч квадратных метров. Мощность такого ЦОДа — порядка 3 МВт. Дата-центры обеспечивают круглосуточную поддержку сети и отвечают за хранение своей части необработанных и реконструированных данных, а также выполняют крупномасштабную обработку и категоризацию информации для её последующего хранения.

Дата-центры уровня 1 отвечают за распространение данных на уровни 2 и 3. Они также хранят долю смоделированных данных, которые производит уровень 2. Оптоволоконные линии связи, работающие со скоростью минимум 60 гигабит в секунду, соединяют ЦЕРН с каждым из 14 крупнейших центров уровня 1 по всему миру. Некоторые из них находятся в Венгрии, другие — в Швейцарии, Франции, Нидерландах, Британии. Эта выделенная сеть с высокой пропускной способностью называется LHC Optical Private Network (LHCOPN). Каждые несколько лет к сети подключается новый ЦОД: в 2014 году их было 12, в 2018-м — 13.

Необработанные данные экспериментов существуют в двух копиях: одна в ЦЕРНе на уровне 0, а другая — в крупных центрах уровня 1 по всему миру.

К вычислительной сети БАКа также подключены центры второго уровня — небольшие вычислительные станции в университетах и исследовательских институтах. Там не всегда есть пространство, чтобы поставить большие ЦОДы, но к ним тоже протянута высокоскоростная линия связи, чтобы они могли быстро получать необходимые им данные, структурированные на уровне 1. Даже в такой ситуации, на скоростях 10-60 Гбит/сек, иногда загрузка необходимых данных для анализа занимает несколько недель.

Есть и уровень 3 — индивидуальные компьютеры отдельных профессоров, их студентов и в целом волонтеров по всему миру. Они тоже часто помогают с вычислительной мощностью и могут хранить определенные сегменты данных, чтобы снять нагрузку с сети. Всё это обработанные данные, пришедшие с уровня 1, так что даже если какие-то из них потеряются — не страшно. На уровне 0 внутри ЦЕРНа сохранены все те данные, которые были отфильтрованы в процессе работы установки.

Первый в истории эксабайт

Поэтому ЦЕРНу нужно гигантское хранилище, способное содержать все результаты экспериментов, накопленные за несколько лет. Даже после резкого сокращения объема новых данных во время текущего «затишья», ЦОД внутри ЦЕРНа обрабатывает в среднем один петабайт (один миллион гигабайт) данных в день. Это проанализированные данные, которые постепенно накапливаются.

Чтобы справиться с нагрузкой, институт постоянно добавляет новые хранилища. И в конце сентября организация объявила, что их объем достиг более одного эксабайта, то есть 1024 петабайт (или 1 миллион терабайтов). Это на 39% больше по сравнению с тем же периодом прошлого года: в 2022-м хранилище ЦЕРН имело емкость 735 петабайт.

В официальном заявлении исследовательская организация отметила, что один миллион терабайт дискового пространства нужен не только для записи физических показателей БАКа. Там также размещаются другие данные ЦЕРН, включая вторичные эксперименты, данные от других лабораторий и разные совместные онлайн-сервисы, которыми пользуются ученые.

Емкость в 1 эксабайт обеспечивается за счет 111 000 устройств, преимущественно жестких дисков, а также растущей доли флэш-накопителей. Около 60% хранилища данных ЦЕРН представлена HDD, и только 15% дисков (около 17 000 устройств) являются SSD (но они представляют гораздо меньше 15% емкости всей системы).

Твердотельные накопители управляются программным решением ЦЕРНа с открытым исходным кодом под названием EOS. Оно было создано сотрудниками научно-исследовательского института в 2010 году специально для удовлетворения экстремальных вычислительных потребностей БАКа. При этом этот софт доступен любому — его можно бесплатно установить с сайта лаборатории. В 2021 году у них было около 30 тысяч клиентов, и они хранили порядка 8 миллиардов файлов. Сейчас, в 2023-м, эти цифры, вероятно, можно умножить в два раза.

Для долговременного хранения данных ЦЕРН использует в основном магнитные ленты. Причем они обновляются. Данные из старого архива постоянно переносятся на новые ленты, с более передовыми технологиями и более высокой плотностью записи.

При наличии более чем сотни тысяч устройств поломки неизбежны, поэтому данные постоянно реплицируются. В ЦЕРН говорят, что «сбои компонентов являются обычным явлением, поэтому хранилище построено так, чтобы не допустить критических потерь». Заново начинать эксперимент, который обходится в $1 млрд в год, не хочется никому.

Андреас Петерс, руководитель проекта EOS, дисковой системы хранения данных ЦЕРН, заявил, что огромный рост объема хранилища является подготовкой к предстоящему эксперименту по запуску тяжелых ионов на Большом адронном коллайдере:

«Мы достигли этого нового рекорда для инфраструктуры хранения данных после расширения мощностей, чтобы иметь возможность собрать все данные по тяжелым ионам. Здесь важно не только повышение емкости данных, но и увеличение производительности. Скорость чтения объединенного хранилища данных у нас впервые превысила порог в один терабайт в секунду (1 ТБ/с)».

Благодаря этому, в теории, за день работы коллайдера лаборатория теперь сможет обрабатывать и сохранять не один, а три петабайта данных. А значит, будет собираться в три раза больше информации об экспериментах. Так можно будет достичь более высокой точности измерений — сократив объем данных, отбрасываемых во время фильтрации.

Йоахим Мних, директор ЦЕРН по исследованиям и вычислениям, в заявлении о достижении нового рубежа емкости хранилища говорит: «Этим мы еще раз привлекаем внимание мира к тому, насколько важно продолжать расширять возможности обработки и хранения данных. Мы устанавливаем новые стандарты для высокопроизводительных систем хранения данных, в том числе для компаний и других лабораторий. И, конечно, это очень важная веха для будущих запусков LHC».

Сегодняшняя емкость хранилища представляет собой колоссальное увеличение на 3100% по сравнению с тем, что было в ЦЕРН десять лет назад, в 2012-м. Тогда хранилище данных БАКа могло содержать всего лишь скромные 32 петабайта.

Что интересно, пока что емкость хранилища уровня 0 развивается строго в соответствии с вот этим графиком. Владимир Багил, Джерман Санчио и другие ученые ЦЕРНа ещё в 2015 году предсказали объемы данных, необходимые для продолжения работы проекта. Если верить их работе, то к 2029 году хранилище придется увеличить еще в 4 (!) раза. В нем будет содержаться уже 4 эксабайта данных. Это примерно 0,003% данных всего современного Интернета (~120 зетабайт).

НЛО прилетело и оставило здесь промокод для читателей нашего блога:

-15% на заказ любого VDS (кроме тарифа Прогрев) — HABRFIRSTVDS.

Комментарии (33)

chnav

15.10.2023 11:49-19Как дорого обходится человечеству любопытство. Просто констатация факта.

Fell-x27

15.10.2023 11:49+76Дорого? По сравнению с тем, сколько тратится на военные конфликты, например, БАК - почти бесплатен. Если бы человечество столько тратило на науку, может быть, современный мир и был бы похож на тот, каким его видели фантасты в 50х годах.

Sarjin

15.10.2023 11:49+31изобретение электричества и прочих мелочей окупило расходы на всю науку на столетия вперед.

Neitr

15.10.2023 11:49-12Но не так дорого как обходится на хабре своё мнение или просто констатация факт

Hidden text

поднимите мне карму, враги подпортили

Desprit

15.10.2023 11:49+43Почти как объем моей папки node_modules

Kenya-West

15.10.2023 11:49С рекурсивными, фрактальными и циклическими симлинками можно и до зеттабайта дойти

bbs12

15.10.2023 11:49+2Им кстати можно помочь с вычислениями, если кому процессор нагрузить охота: https://ru.wikipedia.org/wiki/LHC@home

DarkTiger

15.10.2023 11:49-17Мощность такого ЦОДа — порядка 3 МВт.

Так-то автор прав, конечно, все вычисления, по физической сути - преобразование входящей в сервер энергии в тепло, но все же подсознательно хочется терафлопсов и терабайт в качестве единиц измерения :)

Он состоит из тысяч коммерчески купленных серверов

Я все понимаю, чувствуется сожаление, что не удалось украсть, но зачем на это в статье намекать...

Shokoladkasoreshkami

15.10.2023 11:49+1Прикольно послушать рой шелестящих жёстких диском такого массива, и все в одном месте.

Neitr

15.10.2023 11:49+3Самый лучший способ хранения информации - это радиоволны в открытом космосе.

Это единственный способ хранения информации без носителя, когда сам электромагнитная волна и носитель и сама же информация.

Раз уж пошли такие объемы важной информации - надо запускать спутники ретрансляторы далеко в космос и туда - сюда до них и обратно гонять информацию. Пока она летит - это и есть хранение - практически неуничтожима, может храниться миллиарды лет. На случай катаклизма на Земле - радиоволновое хранение всей ценной информации человечества - единственный способ сохранить.

А если в целом говорить об экспансии нашего разума, то надо и начинать экспансию, хотя бы средствами которые уже есть у нашего разума. Сейчас нашему уровню доступна информационная экспансия на многих видах передачи данных со скоростью света. Вот и надо на всех возможных языках (математических, универсальных и прочих) с элементами расшифровки (декодирования/ключи) все запаковывать в радиосигналы всех частот и транслировать на Млечный путь и на Андромеду (как минимум). Это те направления которые логичны с точки зрения времени хоть как то приемлемого. Млечный путь в приоритете. Но Андромеда выгоднее с точки зрения прицеливания в наиболее вероятные области наличия разума (мы видим её плашмя). Все знания, формулы, код ДНК, все науки во всех видах (книжный/текстовый, фото, видео, 3D модели) все отсылать во всех направлениях непрерывно и по многу циклов и со вставками ключей/инструкций и SOS постоянно. Это кстати и лучший способ на сегодня хранения информации. Ведь информация которая летит в виде радиосигнала по вселенной, почти не уничтожаема. Мы на Земле можем потерять всю информацию и знания накопленные на тех носителях что имеем, а вот излученная в виде радиосигнала информация в виде радиоволны — более надежна. Нам её потом могут ретранслировать назад. Это лучший способ хранения информации. Можно вставлять пометку с просьбой о ретрансляции назад и далее, тоже с пометкой откуда и куда/координаты во вселенной. Если транслировать код ДНК, то наши виды животных и нас смогут воссоздать в других галактиках — это тоже экспансия своего рода со скоростью света. В аналоговом и цифровом виде. Если новые знания — дополнять эфир. Сначала самое важное — а в промежутках все подряд (фильмы, музыку, новости). И все это хотя бы в 100 направлениях по Млечному пути, к Андромеде и 10-20 направлений во все стороны вселенной для истории. Ведь радиоволна а соответственно и информация будут существовать, пока она летит в пространстве. Такой надежный способ хранения информации не доступен на Земле. А может выясниться что она к нам вернется после какого то линзирования или огибания кривизны какой нибудь пространства — это тоже будет результат информативный. Или её нам ретранслируют. Кстати, даже гонять информацию к примеру между Землей и Нептуном туда сюда — тоже надежно хранить её. Если что то случится с информацией на Земле, то можно будет восстановить принимая сигнал с Нептуна. 2 вариант это космический аппарат который мы запускаем за пределы солнечной системы, с мощными принимающими и передающими антеннами. Принцип — и хранения и ретрансляции. То есть такая станция летит по Млечному пути от нас, принимает от нас сигнал всех знаний и тут же его ретранслирует и дальше в космос и нам назад на Землю. Если с Земли прекратится прием в виду какого то катаклизма передача, то аппарат начнет просто циклическую трансляцию всего что уже принял (сделать ему хранилище и самого важного для более частого повторения в эфир). Например если такой аппарат улетит на расстояние 1-10 световых лет, то в случае к примеру какого то катаклизма на Земле, мы сможем долгие годы принимать с него информацию еще долгие столетия. Таких аппаратов запустить несколько в разные стороны, чтобы они и между собой могли ретранслировать если что, для дублирования каналов связи. Ну и конечно делать их как и исследовательские, видео с них, телескопчик на них. Вот телескоп Хаббл, хорошо что он есть, но можно было бы его и запустить на дальний полет, он бы пролете и все планеты Солнечной системы хорошо бы отснял и летел бы дальше, и что встретил, тоже отснял, и улетев за пределы солнечной нас бы отснял со стороны. Вообще очень важно запустить наконец то аппарат перпендикулярно плоскости нашей галактики Млечный путь, чтобы увидеть её со стороны в проекции на плоскость. Вот как надо делать экспансию разума, а не сидеть ждать, что кто то сделает это. Предлагаю инициировать общемировой проект по экспансии знаний человечества по этой схеме во вселенную. присоединяйтесь в комментариях. Давайте наводним вселенную нашими знаниями, нашим духом.

X_Max

15.10.2023 11:49Я так думаю, что относительно близкая вспышка сверхновой помножит на ноль всю нашу базу знаний.

AlexSpirit

15.10.2023 11:49Я думаю прокариотам и экстремофилам, оставшимся в живых после вспышки, наша база знаний не понадобится в ближайшие 2-3 миллиарда лет.

Leshiy26

15.10.2023 11:49такое хранение информации не предполагает последующего чтения без потерь что ли? зачем такой способ нужен тогда?

ksbes

15.10.2023 11:49+2Представляю, что будет, если выяснится что в программу первоначального отбора закрался баг и она все эти годы наоборот сохраняла бесполезные данные и отбрасывала полезные!

Если серьёзно: интересно, а как они проводят такую фильтрацию, да ещё в автоматическом режиме? Ведь данные это что - (таймстемп, номер сработавшего датчика). Там уже требуется наука, чтобы понять полезность/бесполезность.

AlexanderplUs

15.10.2023 11:49+1Правильнее говорить не про фильтрацию, а про преобразование данных в более компактный вид. Например, записываются только изменения данных, а длительные показания на нуле - нет.

Так что ничего не теряется, можно восстановить исходные данные, когда обработка производится. Иначе бы там сами физики давно бы шум подняли.

ksbes

15.10.2023 11:49В статье написано:

Значительная часть отфильтровывается еще на этапе сбора, на что тоже уходят огромные вычислительные ресурсы

У меня пока что нет основания не верить авторам статьи.

И это, как вы правильно заметили, самая ответственная часть. Вот и интересно как они с этим справляются.

astromid

15.10.2023 11:49Основная суть фильтрации - оставить только "потенциально интересные" события - которые либо вообще не описываются Стандартной моделью, либо имеют согласно ней очень маленькую вероятность. Сохранять измерения, которые и так подтверждают известную нам теорию особо не интересно. Для оценки "интересности" события смотрят на совпадение с теорией и даже применяют ML для ускорения.

Так что нет, речь не только о сжатии и кодировании, необратимая фильтрация тоже проводится

NutsUnderline

15.10.2023 11:49я в колайдерах не спец, но че то напрягла меня медодика подсчета обьема данных

achekalin

Вроде яндекс говорил, что хранят какие-то данные CERN-а, но это было какое-то время назад. Интересно, сейчас это так, и как это сотрудничество оформлено - от российкого яндекса европейскому научному центру, или как нероссийской компании, которой и был тогда яндекс, европейскому центру?

Спрашиваю, т.к. какая-то часть моей оплаты услуг яндекса как бы опосредованно оплачивала (оплачивает?) и такое непрофильное участие в работе CERN-а.

tmk826

Только та часть которая, через налоги тратится на участие в международных научных проектах с CERN-ом. Прямой вклад яндекса в CEPH равен нулю.

rPman

Хорошее замечание, но не нужно принижать заслугу этого действия, наука, тем более фундаментальная, в любом случае оплачивается государствами, всеми участниками,т.е. это буквально способ участия.

Результат процесса - полученные знания. А как его оплатили, косвенно или через десять посредников дело десятое, даже хорошо что левых не покормили.

achekalin

Ну как бы яндекс как

прослойка без особой ответственности за сервиссервисная компания сегодня стал притчей во языцах, он, как кажется, сильно отличается от того Яндекса, который в 2013 году писал на Хабре о дружбе с CERN-ом.Вот и захотелось узнать: дружат ли до сих пор, и насколько плотно.

Это никак не принижает пользу финасовых вливаний в науку.