Здравствуйте, уважаемые читатели!

В этой статье я хотел бы привести короткий пример использования комбинации из двух нейросетевых инструментов для создания неплохой музыки.

Уверен, на эту тему сказано не мало (общих слов), однако, мне хотелось бы перейти от плоскости

новостей и рассуждений о возможностях к плоскости практической реализации идеи.

Для тех, кто не хочет читать технические подробности - можно сразу перейти к готовому треку.

С ИИ-инструментом Loudly я познакомился благодаря видео с YouTube-канала Мэтта Вулфи (Matt Wolfe), по материалам которого я уже публиковал переводную статью на тему “Программированию конец?”

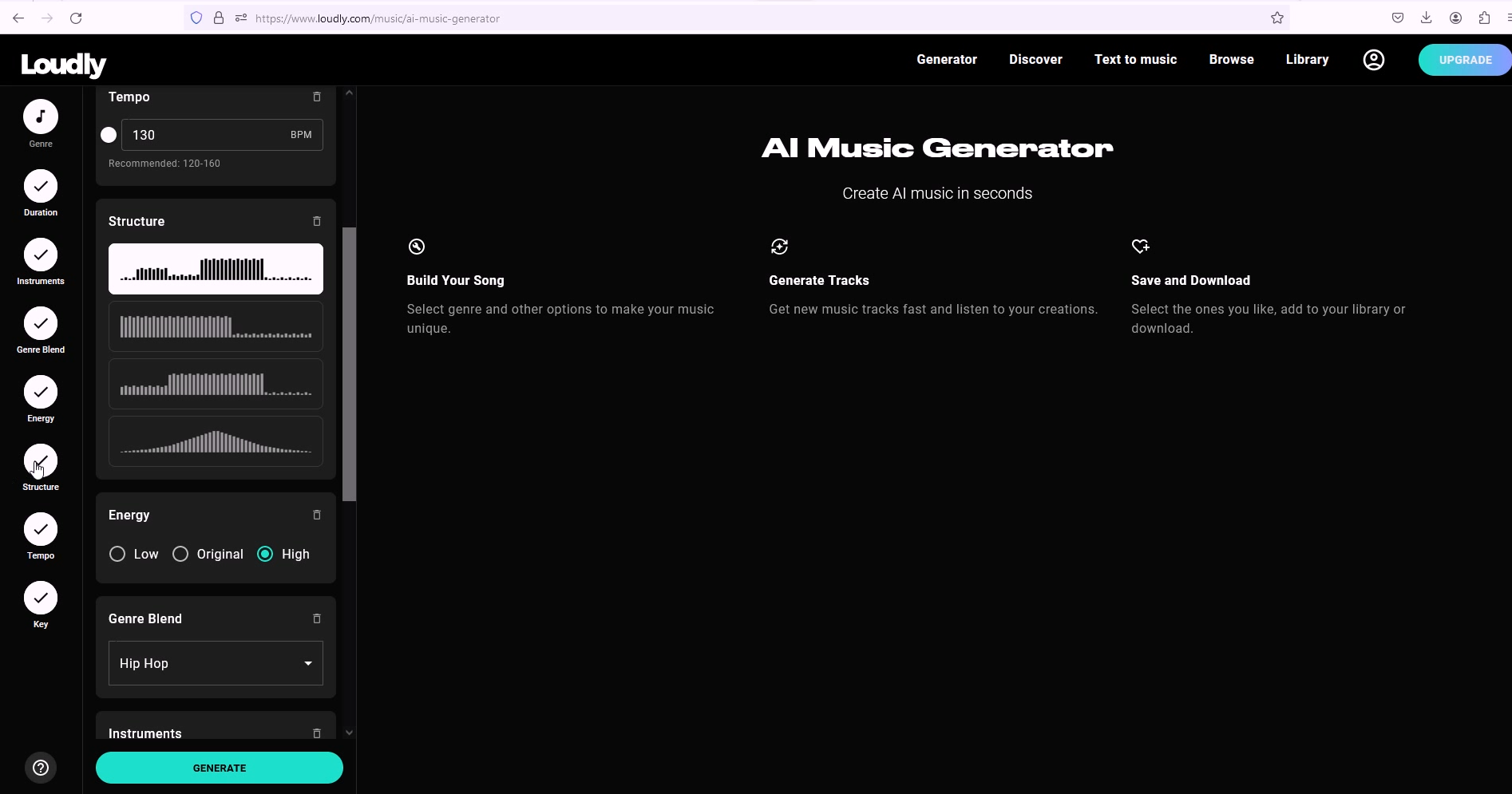

Сам интерфейс ИИ-генератора музыки Loudly достаточно прост и понятен, он включает в себя:

Выбор основного жанра генерируемого трека

Длительность генерата (31 сек для бесплатной версии, 210 и 420 сек в прочих версиях)

Выбор инструментов, используемых для генерации

Возможность смешивания основного жанра генерата с ещё одним жанром на выбор

Выбор уровня музыкальной энергетики генерата (низкий, стандартный, высокий)

Выбор структуры трека

Темп (скорость исполнения музыки, уд/мин)

Тональность генерата (мажор/минор, C, D, E, F, G, A, B)

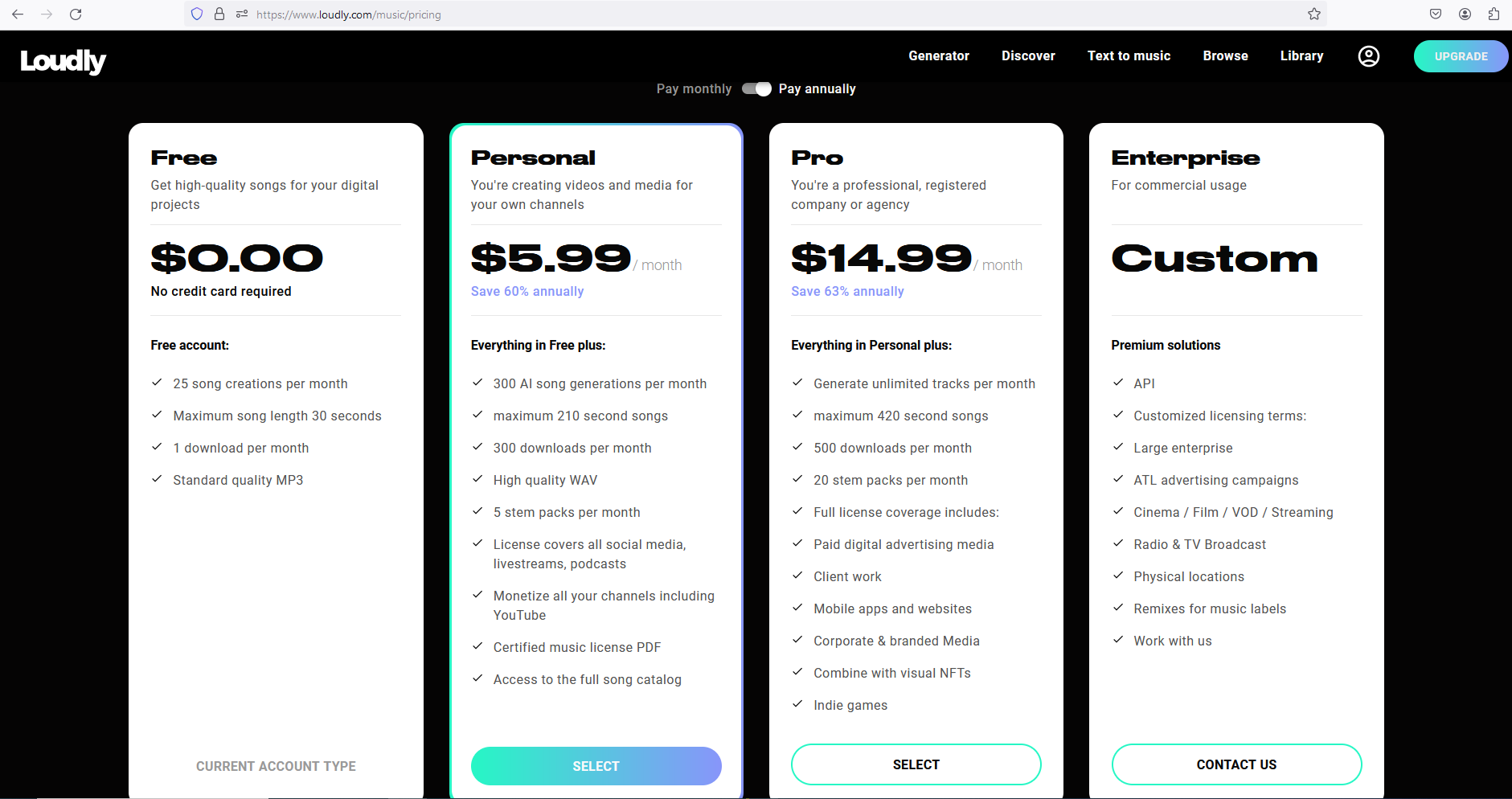

Есть три базовых варианта подписки:

Бесплатный доступ с серьезными ограничениями функционала и возможностью загрузить только 1 трек, сгенерированный ИИ

Доступ за $5,00/месяц

Доступ за $14,99/месяц

Детали представлены на скриншоте ниже.

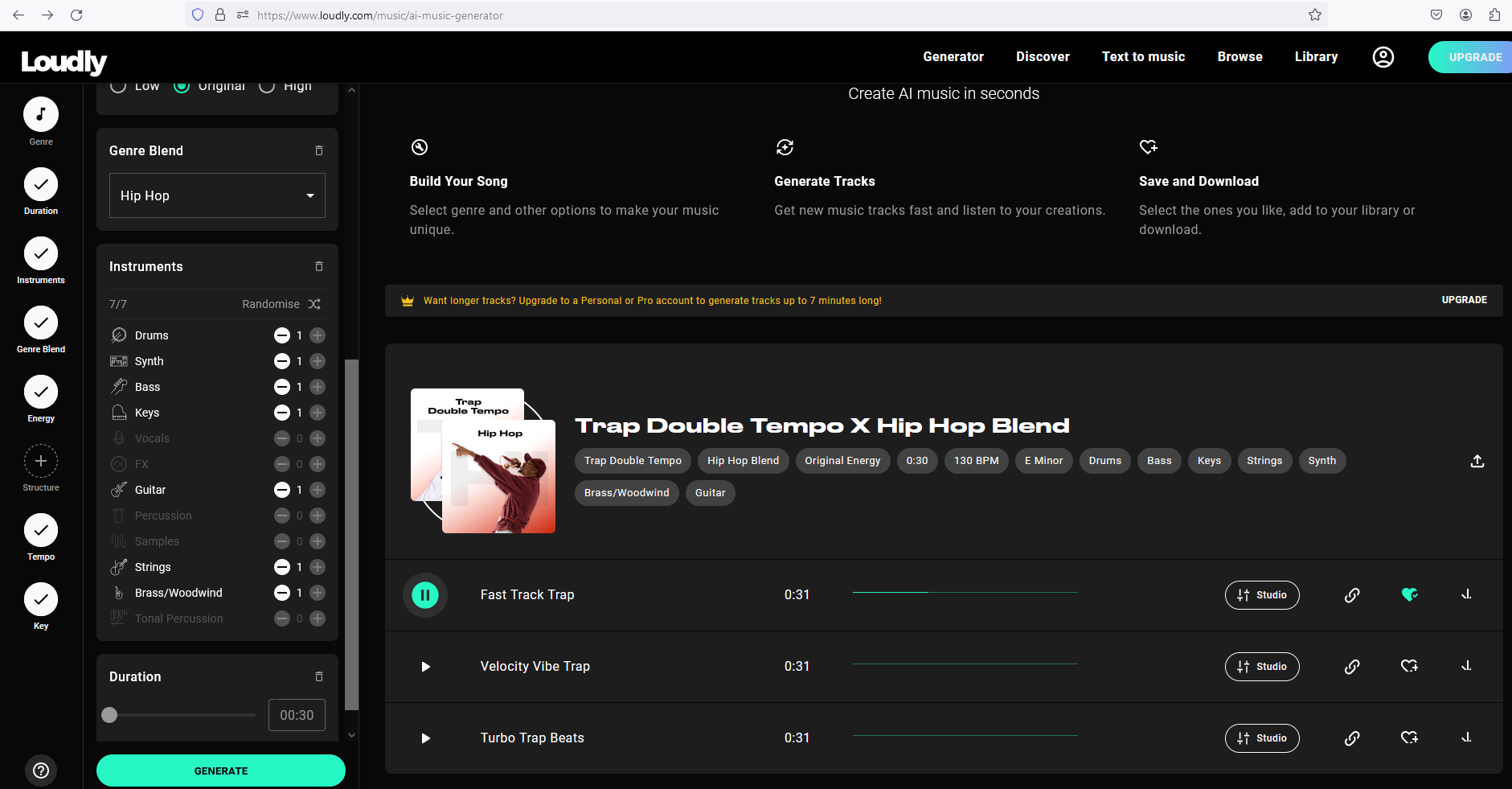

После выбора всех необходимых параметров, пользователю остается лишь нажать кнопку Generate, а далее начинается магия.

Следует отметить, что количество бесплатных генераций ограничено, за одну генерацию создается три варианта трека. На мой взгляд, за 3-5 генераций можно “выловить” один вполне годный вариант.

После прослушивания результатов, тот, который вам понравился, можно сразу загрузить на ваше

устройство или добавить в Библиотеку и скачать уже оттуда.

Несмотря на то, что некоторые результаты генерации довольно неплохие, их нельзя называть законченным музыкальным произведением (в особенности в бесплатной версии на 30 секунд).

Кроме того, следует отметить, что на текущий момент Loudly AI скорее напоминает конструктор, нежели работает как полноценный композитор, поскольку зачастую варианты генерата с одинаковыми настройками звучат достаточно похоже. Таким образом, пока что, Loudly AI не хватает того, что мы, люди, называем вдохновением или музой. Думаю, в даже в краткосрочной перспективе эта нейросеть научится выдавать более качественные результаты.

2. Извлечение отдельных музыкальных дорожек из сырого генерата в FL Studio 21.2

Как я уже сказал выше, для того чтобы создать качественную музыку одного сырого генерата недостаточно. Его необходимо как минимум довести до стандартной длины, и, естественно обработать (добавьте “соль/перец” по вкусу).

В этом поможет второй нейросетевой инструмент, который стал доступен в версии 21.2 Программного Обеспечения FL Studio — цифровой звуковой рабочей станции и секвенсора для написания музыки.

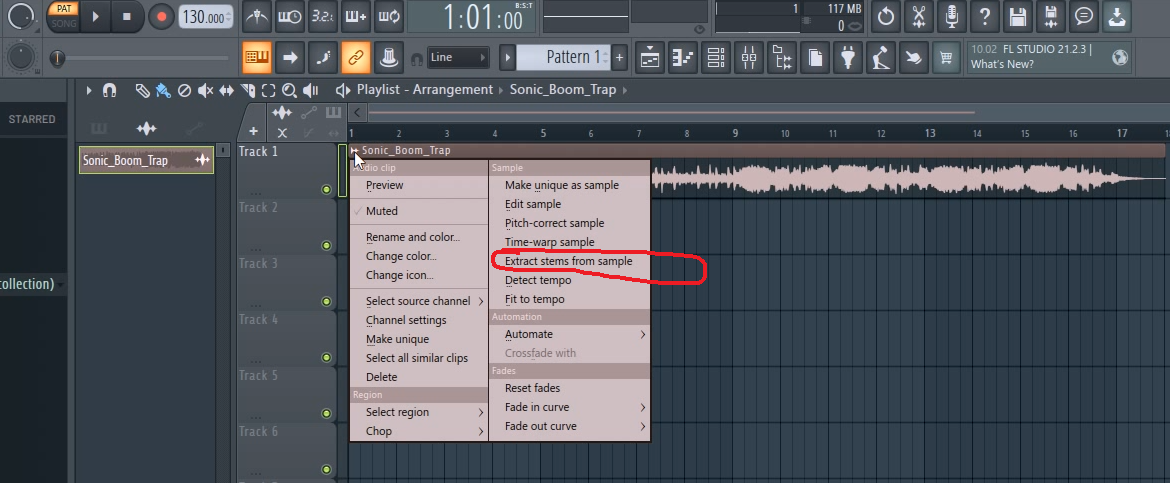

При нажатии на соответствующую область загруженного в FL Studio 21.2 трека-генерата,

полученного с помощью Loudly, открывается меню, в котором необходимо выбрать пункт Extract stems from sample, это и есть ИИ-инструмент извлечения отдельных музыкальных дорожек из

трека.

ИИ-инструмента “Extract stems from sample” в FL Studio 21.2

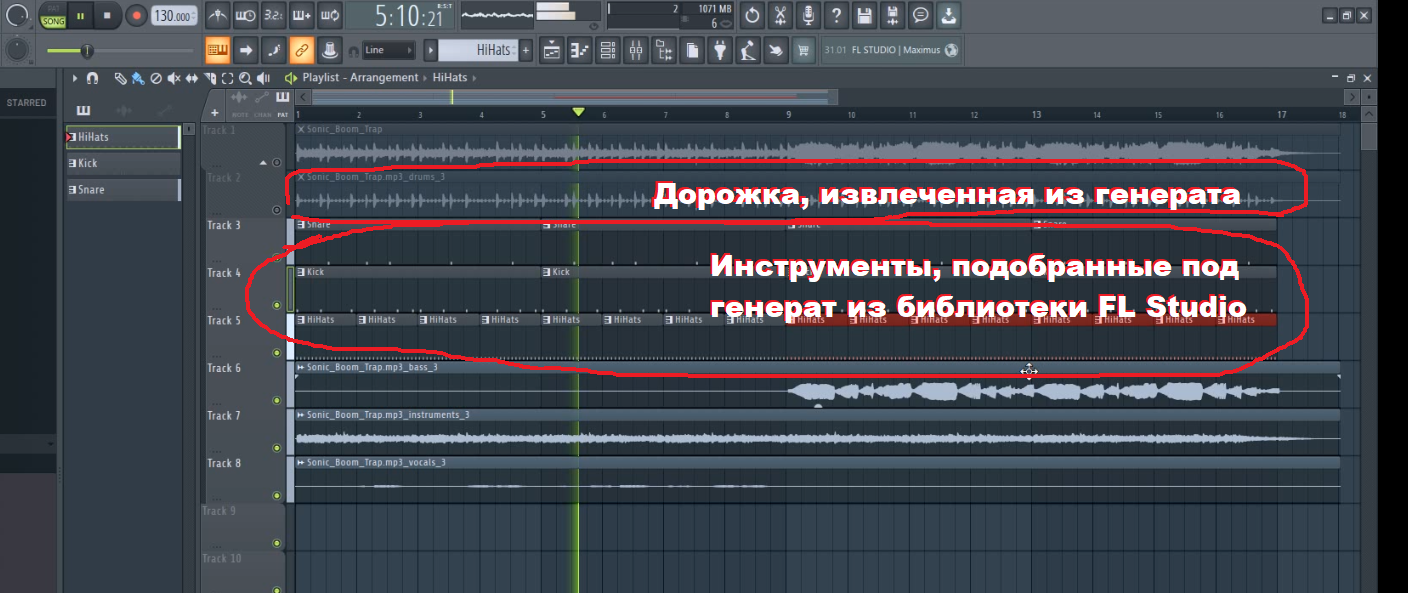

Результат извлечения представлен на скриншоте ниже. Следует отметить, что извлечение происходит не по каждому инструменту в отдельности, а по 4 группам, которые перечислены ниже. При этом, исходный трек автоматически глушится на своей дорожке, его можно снова включить при необходимости. Разбивка на группы выглядит следующим образом:

Группа "Drums" - kick/snare/hi-hats (Ударные/малые ударные/педальные тарелки)

Bass (Бас)

Instruments (Инструменты)

Vocals (Вокал)

ИИ-инструмента “Extract stems from sample” в FL Studio 21.2

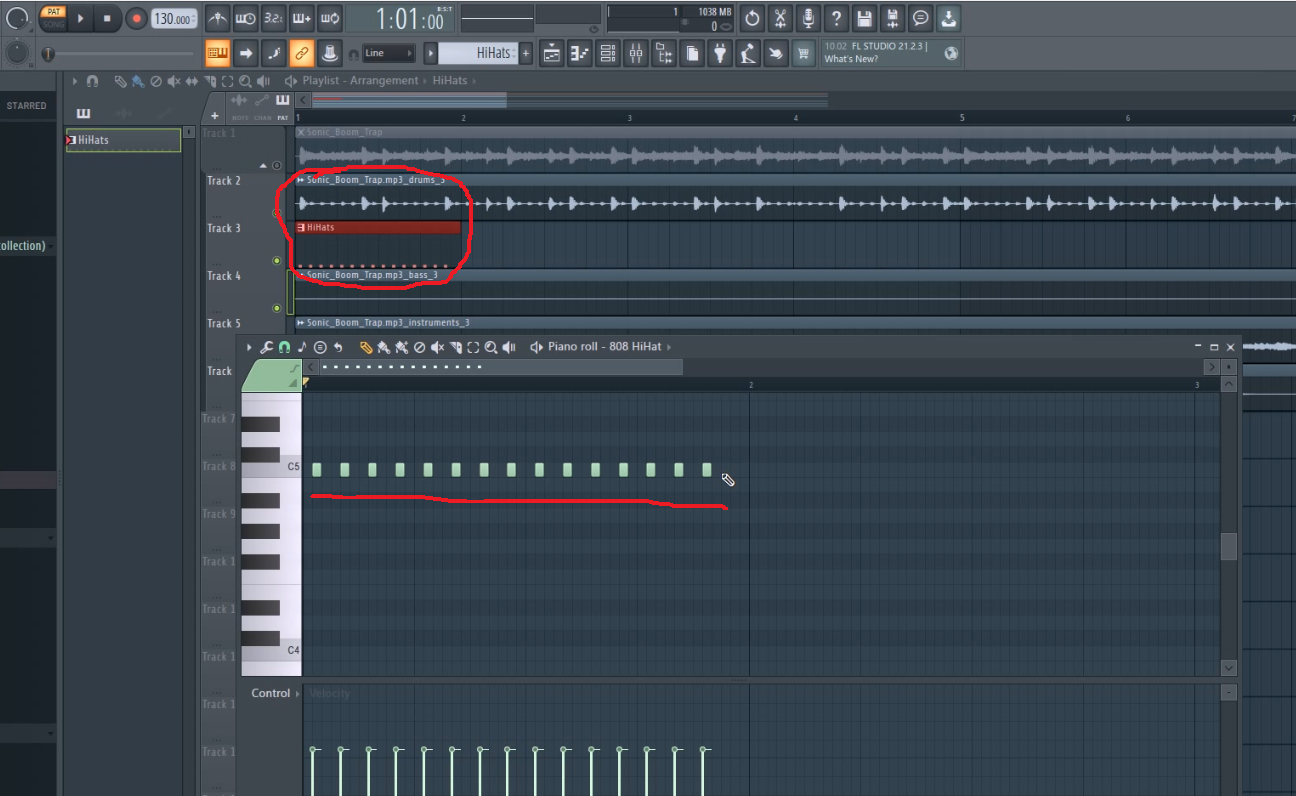

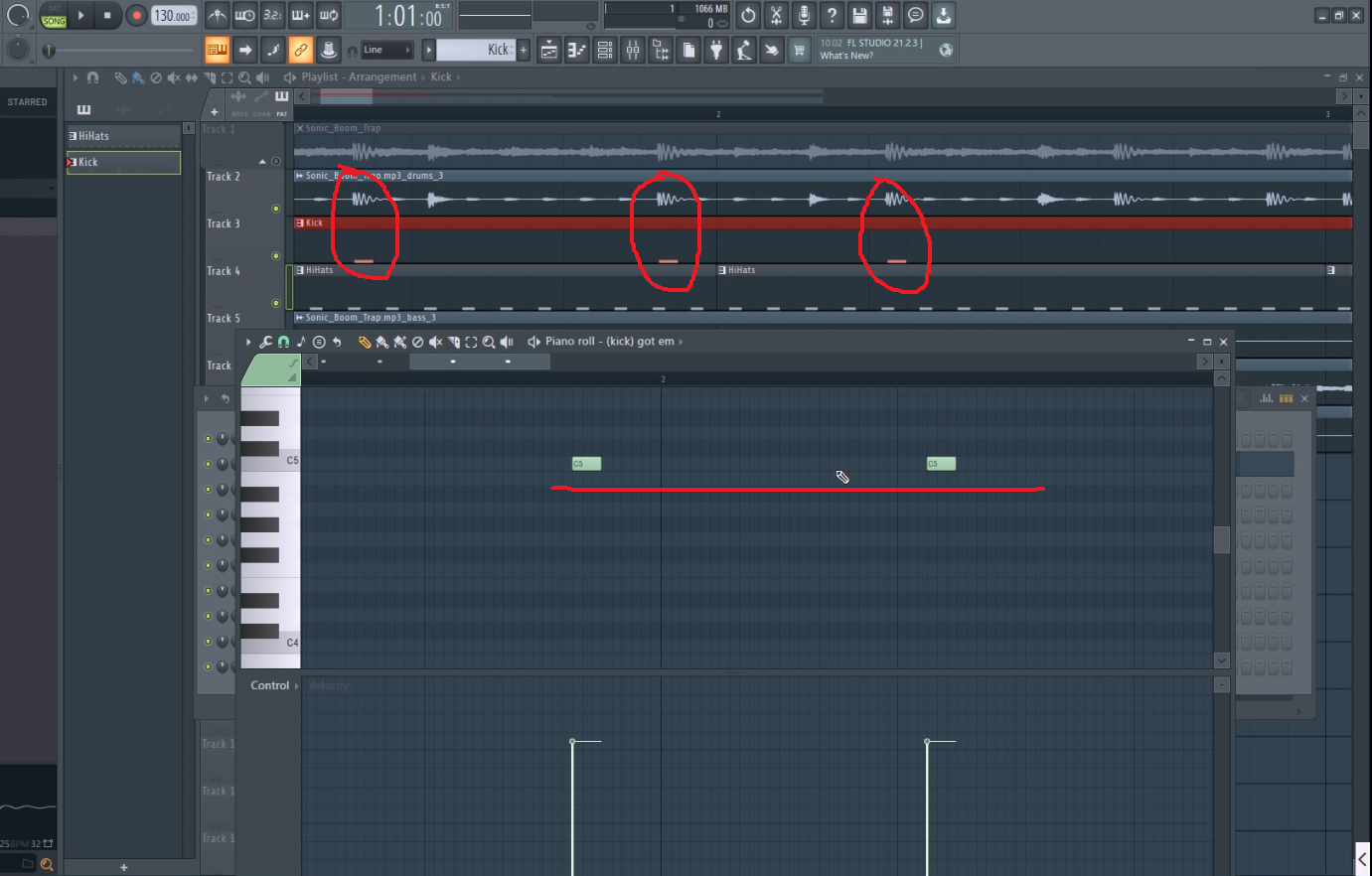

Затем лично я поступаю следующим образом. Для дальнейшей работы над композицией я подбираю соответствующие инструменты (Kick/snare/hi-hats и т.д.) из библиотеки FL Studio и расставляю их в нотной линейке Piano Roll так, чтобы они соответствовали изначальной структуре трека-генерата.

В итоге мы получаем часть трека, в которой вместо сгенерированных нейросетью инструментов расставлены инструменты из библиотеки FL Studio, что позволяет осуществлять их дальнейшую аранжировку, добавить эффекты, нарастить длительность созданного трека и т.д.

(Kick/snare/hi-hats)

Финальный результат после аранжировки представлен ниже. Я намеренно не устал удалять дорожки, оставшиеся после извлечения, только заглушил их.

Итоговый вариант трека можно послушать здесь:

Весь процесс работы, описанный выше в текстовом варианте со скриншотами, на видео можно посмотреть здесь:

Еще один трек, созданный полностью аналогичным способом, лежит здесь:

Что в итоге означает появление подобных возможностей?

Как минимум то, что больше людей смогут создавать ту музыку, которая нравится именно им, при этом, не имея музыкального образования и глубоких познаний в теории музыки.

В глобальном плане я бы сказал, что через 3 года появятся настолько продвинутые технологии, что от всей музыкальной индустрии в том виде, в котором мы ее знаем на текущий момент, не останется камня на камне. На мировую музыкальную арену, возможно, взойдут тысячи новых звезд, а старые кумиры уйдут в небытие.

Затем появятся виртуальные звёзды, которые будут существовать только в сети, при этом, собирая миллионы глаз на своих концертах.

Все вы свидетели новой эры. Узрите!

Также, рекомендую присмотреться к каналу t.me/bitmejkerskaya. Регулярно пользуюсь им: качаю плагины, драмки и вообще все, что нужно саунд продюссеру, битмейкеру или звукорежиссеру

DS28

app.suno.ai вроде как сильно проще позволяет этого добиться...