Мой сайт под фильтром Google? Как узнать под каким? Просел сайт в выдаче, в чём причина? Падают позиции и нет посещаемости, в чём дело?

Именно с таким названием вы увидите темы на большинстве известных SEO-форумах и на Справочном форуме для веб-мастеров Google.

Сразу отметим, что вместо слова «фильтры» в таких ситуациях уместнее употреблять слово «алгоритмы».

На самом деле причина проблем с сайтом может быть не связана с мерами воздействия Google.

Техническая сторона

1. Для начала проверьте нет ли проблем с хостингом.

2. Затем проверьте присутствует ли в исходном коде этот мета-тег.

<meta name='robots' content='noindex,follow' />

Как показал опыт общения с веб-мастерами на Справочном форуме Google, наличие в коде этого мета-тега — типичная ошибка для сайтов на WordPress. Почему именно на WordPress, сложно сказать, но таковы результаты наблюдений. Вероятно, веб-мастера иногда забывают снять указатель в настройках темы, запрещающий сканирование сайта поисковыми системами. Второй вариант — этот мета-тег появился в результате взлома сайта.

3. Проверьте, правильно ли настроен основной домен сайта.

4. Проверьте ваш robots.txt, не закрыли ли вы там чего лишнего.

«Matt Cutts» позвонит?

Если ничего из вышеуказанного не является причиной проблем с сайтом, тогда нужно копать в сторону Google.

Есть только три канала связи по которым можно точно узнать у Google, попал ваш сайт в немилость (под санкции) или нет. Первый и самый простой — проверить обе (все) версии сайта в Google Search Console на предмет наличия мер, принятых вручную (раздел “Поисковый трафик”). Второй — обратиться на Справочный форум для веб-мастеров Google. За каждым справочным форумом закреплён сотрудник Google. В русскоязычном форуме для веб-мастеров это Андрей Липатцев и Екатерина Черткова. При обращении на форум не нужно в названии темы писать что-то наподобие — «Андрей Липатцев, помоги». Дело в том, что сотрудник Google отвечает на форуме при наличии у него для этого времени или если Ведущие участники не могут предложить однозначное решение (уведомляют об этом сотрудника Google). Третий канал — написать в Сообщество Google для веб-мастеров. Там тоже часто отвечает на вопросы пользователей сотрудник Google Андрей Липатцев.

Если в Search Console вы обнаружили сообщение о мерах, внимательно его прочитайте и следуйте описанным инструкциям.

Практика показывает, что в 75 процентах случаев меры применяются за ссылочный и анкорный спам, 10 процентов за неинформативное и бесполезное содержание (обычно как дополнение к абузам за нарушение авторских прав), 10 процентов — за маскировку и скрытую переадресацию — например за вап-клик, и 5 процентов за прочие нарушения Рекомендаций для веб-мастеров.

Если сообщение о мерах в Search Console отсутствует, но трафик и позиции сайта резко падают или, не дай Господь, сайт вовсе исключили из индекса, значит, тут самая вероятная причина — воздействие одного из алгоритмов Google.

Основные алгоритмы Google

Основных алгоритмов, о которых известно вебмастерам и которые влияют на ранжирование, четыре:

Page Layout Algorithm — наказывает сайты за чрезмерное количество рекламы.

Категорически не следует перегружать верхнюю часть веб-страницы рекламными объявлениями. Шквал рекламы не должен обрушиваться на пользователей, приходящих на ваш сайт.[1]

Pirate Algorithm — пессимизирует сайты за нарушение авторских прав (DMCA). У Google есть и специальная форма, через которую правообладатель может подать жалобу. На практике встречались случаи, когда из-за жалобы правообладателя на незаконное использование изображений была удалена из индекса главная страница сайта. Вся информация о таких нарушениях («абузах») в итоге собирается в Lumen (ранее в Chilling Effects).

Google Penguin — Пингвин наверно один из самых известных в среде веб-мастеров алгоритм. Он призван бороться со всеми случаями и видами спама в интернет.

Google Panda — алгоритм, получивший своё название от фамилии одного из инженеров Google — Panda Navneet. Google Panda является алгоритмом изменения результатов ранжирования поиска Google, который впервые был выпущен в феврале 2011 года. Изменения направлены на понижение ранга некачественных сайтов или бесполезного контента, и возврат в верхнюю часть результатов поиска высококачественных сайтов.[2]

Дополнительно рекомендуем изучить:

Амит Сингхал. Дополнительные рекомендации по созданию сайтов с качественным содержанием.

На самом деле таких алгоритмов значительно больше, чем четыре. О многих из них, например о Payday Loan Algorithm, вебмастерам мало что известно или практически ничего не известно.

Способы диагностики воздействия алгоритмов

Информацию о том, воздействует ли на сайт тот или иной алгоритм знают наверняка только сотрудники Google. Естественно, с веб-мастерами они этим не делятся.

Что касается поисковых алгоритмов, здесь мы, обычно, не можем дать какого-либо конкретного совета.

Джон Мюллер (John Mueller)[3]

Таким образом, мы (вебмастера) можем только предполагать пессимизирован ли сайт алгоритмами Google или нет. Есть несколько маркеров по которым можно предположить какой именно алгоритм воздействует на сайт и за что.

Самый лучший показатель качества сайта — это трафик.

Мария Моева[4]

Следовательно первый и основной маркер — резкое падение трафика, позиций в поисковой выдаче. Это говорит о том, что в глазах Google ваш сайт резко потерял в качестве. Вам нужно установить причину.

Если сайт увешан рекламой как новогодняя ёлка — не исключено воздействие алгоритма Page Layout. Тут нужно учесть такой нюанс:

Начиная с сегодняшнего дня [2 нояб. 2015 г. — прим. авт.], страницы с межстраничной рекламой установки приложений, скрывающей существенный объём контента при переходе со страниц результатов поиска, перестанут считаться приспособленными для мобильных устройств. Вместо полностраничных межстраничных объявлений мы рекомендуем веб-мастерам использовать более удобные для пользователей форматы, такие, как баннеры для установки приложений.

Андрей Липатцев

Введите в строку поиска оператор site:domain.com, нажмите клавишу Enter. Добавте в конце ссылки в браузере &start=990 и снова нажмите клавишу Enter. Просмотрите с конца выборочно пять страниц результатов выдачи. Если вы увидите сообщение «В ответ на жалобу, полученную на основании US Digital Millennium Copyright Act (Закона США о защите авторских прав в цифровую эпоху), мы удалили несколько результатов...» — это означает, что правообладатель подал на вас жалобу. Чем больше жалоб, тем выше вероятность попасть под воздействие Pirate Algorithm.

Второй маркер — диагностика спама.

Проанализируйте ваш домен сервисом Ahrefs. Обратите внимание на резкие пиковые скачки прироста dofollow-ссылок.

Даты появления ссылок также могут быть использованы для обнаружения «спама». Обычно, «законопослушный» документ (страница) привлекает обратные ссылки медленно. Большой (пиковый) рост количества обратных ссылок может указывать на то, что страница является источником популярной новости, или сигнализировать о попытке поискового спама.[5]

Несмотря на то что официально Google это не подтверждает, следует прислушаться к мнению основателя Cognitiveseo Развана Гаврилас (Razvan Gavrilas) и Варени Вячеслава о том, что если в структуре ссылочного профиля доля dofollow-ссылок меньше 10 процентов — это может свидетельствовать о его неестественном (спамном) формировании.

Обратите внимание на структуру анкоров ваших обратных ссылок. По нашему мнению, анкоры с долей более 15 процентов в общем количестве могут быть квалифицированы как спам.

Избыточное количество ключевых слов в контенте и в мета-тегах тоже указывает на спам.

Третий маркер — качество контента.

Автоматически сгенерированный текст, текст о том «как налить стакан воды», отсутствие своего полезного и информативного основного контента — может быть причиной пессимизации сайта.

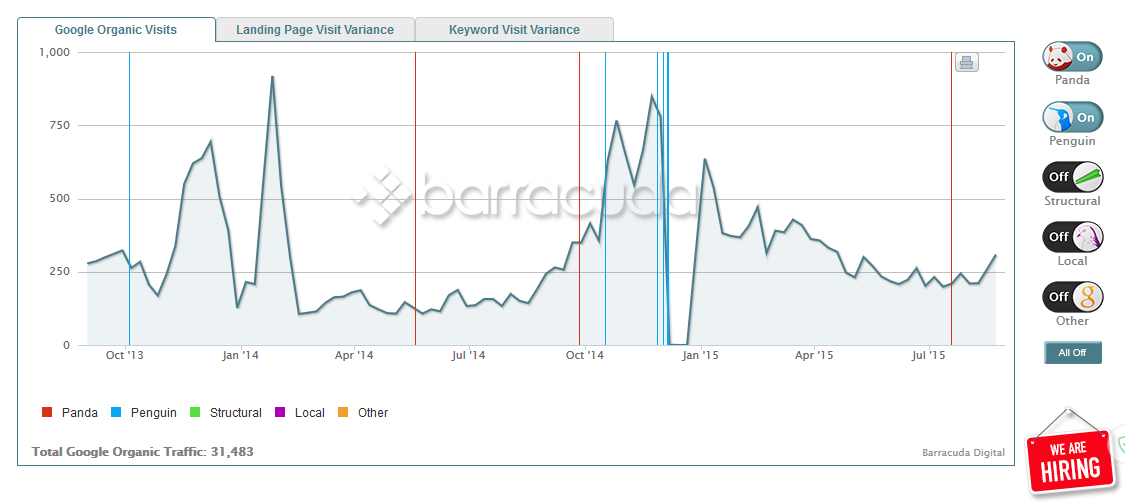

Лучший способ увидеть, избежал ли сайт воздействия алгоритма, — отслеживать органический трафик с помощью аналитики, обращая внимание на большие перепады. Затем следует проверить, подтвердили ли специалисты Google обновления. [6]

Проверить воздействует ли на сайт алгоритм Panda или Penguin можно при помощи онлайн-инструментов или проанализировать самостоятельно.

Google Penguin Checker Tool — показывает динамику органического трафика используя данные SEMrush и апдейты алгоритма Penguin.

Website Penalty Indicator — это более функциональный онлайн-инструмент. Он тоже использует данные SEMrush, но показывает кроме обновлений Пингвина обновления еще нескольких важных алгоритмов, в том числе Google Panda.

Хотелось бы объяснить, как мы собираем свои данные. У нас есть база данных из 106 миллионов самых популярных ключевых слов, распределенных по 26 региональным базам. Когда мы обновляем ключевое слово, мы ищем его в Google и делаем снимок первых двух страниц выдачи.

Таким образом, если в SEMrush нет информации о трафике, это значит, что домен не появлялся в выдаче на первых двух страницах для тех ключевых слов, которые содержатся в нашей базе. Обычно все-таки оценочный трафик согласно SEMrush меньше трафика в Google Analytics.

Elizaveta Lavrienko, SEMrush Customer Support Specialist

Если вы хотите воспользоваться онлайн-инструментом, то лучше выбрать такой, который берет данные из Google Analytics.

Barracuda — бесплатный сервис, использующий данные из Google Analytics и показывает динамику трафика между обновлениями Google Panda и Google Penguin.

Что касается инструмента Диагностика санкций от SEOlib, то к сожалению в нем последнее время не обновляется информация о последних апдейтах алгоритмов Google.

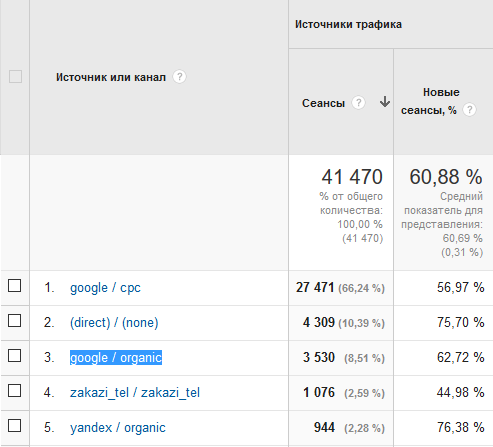

Для самостоятельного анализа войдите в Google Analytics — Источники трафика — Весь трафик — Источник/Канал. Тут нужно обратить внимание какое место в списке занимает «google / organic». Обычно это первая или вторая позиция.

Как мы видим у этого сайта органический трафик с Google лишь третий, а Яндекс и вовсе пятый.

Поставьте отметку напротив «google / organic» и нажмите на кнопку «Показать на диаграмме». Сопоставьте периоды резкого снижения органического трафика с Google с подтвержденными датами обновлений алгоритмов Google.

Надеемся, что эта статья поможет вам быстро разобраться действуют ли в отношении вашего сайта какие-то санкции или нет.

Источники информации

[1]searchengines.ru «Мэтт Каттс на Pubcon Las Vegas 2013: чего ждать вебмастерам от Google в ближайшее время».

[2]Google Panda. Статья из Википедии.

[3]searchengines.ru «Google не даёт советы тем, чьи сайты пострадали от алгоритмических санкций».

[4]Видеовстреча с веб-мастерами — 18.06.15 — Рекомендации по обеспечению качества (50-я минута).

[5]Document scoring based on document inception date. United States Patent Application 20070094254. Kind Code A1. Cutts; Matt; et al. April 26, 2007.

[6]searchengines.ru «Google «Панда» 4.2: вопросы и ответы».

Комментарии (25)

aldous

28.12.2015 23:47+1Практика показывает, что в 75 процентах случаев меры применяются за ссылочный и анкорный спам, 10 процентов за неинформативное и бесполезное содержание (обычно как дополнение к абузам за нарушение авторских прав), 10 процентов — за маскировку и скрытую переадресацию — например за вап-клик, и 5 процентов за прочие нарушения Рекомендаций для веб-мастеров.

Интересно было бы узнать мнение специалистов и команды по борьбе с веб-спамом, но по-моему, сейчас на первое место (после ряда «ссылочных амнистий») вышла борьба со спамом, и самое злободневное — это вап-клик (мобильные редиректы в скриптах для определённых провайдеров в определённое время суток), спам в пуш-уведомлениях и кликандеры всех мастей и калибров (тут пока непахано поле разнообразных спамов). У Яндекса есть хороший список storage.ape.yandex.net/get/browser/antishock/yellow. Если вам что-то знакомо, то надо избавляться от таких безобразий.

blogopoisk

28.12.2015 23:56+1Сейчас для Google мобильная выдача — «священная корова». Любые попытки манипуляций в ней будут жестко пресечены.

Enkin

29.12.2015 00:42у Wordpress есть опция «запретить индексацию», которая реализована именно через этот метатег.

народ ее сначала по ошибке активирует, потом забывает, видимо.

Londoner

29.12.2015 03:32+1Не совсем про поиск, но считаю нужным поделиться. Как я понимаю, Гугл борется со спамом, начихав на «ложные тревоги». Мне «корпорация добра» заблокировала аккаунт с гуглдоками, решив что я злобный спамер (имел неосторожность отправить полсотни автоматических мейлов с запросом цены за интересующую меня услугу), потом две недели бился головой об бетонную стену, называеющуюся техподдержкой, чтоб разблокировали. Хотел даже прийти в утреннее время с плакатиком «Hey Google, talk to me!» к их офису — похоже, это единственный способ быть услышанным. В общем, теперь стараюсь ничего важного у Гугла не держать, хотя это и тяжело.

blogopoisk

29.12.2015 09:45Как таковая техподдержка у Google отсутствует. Если у вас возникли проблемы с каким то продуктом, нужно обратиться на Справочный форум продукта или в Сообщество продукта на G+.

Londoner

29.12.2015 14:58Да? И что, члены справочного форума имеют возможность посмотреть на мейлы, которые я отправил, убедиться, что я не спамер и разблокировать аккаунт? Вы серьёзно?

blogopoisk

29.12.2015 15:34Абсолютно. Если ВУ форума сами не могут найти решение вашей проблемы, информация о ней может быть ими передана сотруднику Google.

Londoner

30.12.2015 23:55+1Ну, давайте пофантазируем, пришли Вы на почту отправить письма, а тётенька в окошке встала сегодня не с той ноги, ей показалось, что писем у вас слишком много, поэтому она позвала охранника, который изъял у вас всё что было — паспорт, водительские права, пропуск на работу, медицинскую страховку, ключи от квартиры и машины, сотовый телефон с записной книжкой и фотографиями жены и детей, авиабилеты на рейс через три часа, кошелёк с наличными и карточками, ну и портфель с важными договорами и бумагами. И всё это по правилам, с которыми Вы автоматически согласились, просто открыв дверь почты. Вы пытались кричать, что эти письма — не спам, но тётке, а тем более охраннику наплевать, у них даже нет ушей. Пообщаться с начальником почта тоже никак нельзя, он очень занят. Но Вам кто-то в очереди прошептал, что есть форум любителей почты, там кто-то вроде может посодействовать, у них вроде как есть связи, так что идите там пообщайтесь, а потом поживите недельки две на улице (ибо ни в офис ни домой, не говоря уже про аэропорт, попасть больше не можете), пока форумчане походатайствуют, а потом несуществующая техподдержка может быть и соизволит разобраться, признать ошибку и вернуть Вам изъятое. Ничего не напоминает?

blogopoisk

31.12.2015 11:57Во-первых: разрешите вас и весь Хабрахабр поздравить с наступающим Новым годом.

Во-вторых: как же в Новый год без подарка — только 1 января любой посетитель Prodvigator сможет использовать сервис бесплатно по тарифу Standard. Это подарок от руководителя нашего информационного партнёра (Prodvigator) Олега Саламахи.

В-третьих: фантазии — это хорошо. Я вам предложил одно из решений вашей проблемы. Воспользуетесь или нет, вам решать.

Всем хороших праздников и заработков в Новом году!Londoner

03.01.2016 16:46Ну что ж, и на том спасибо. Воспользоваться предложенным «решением» не придётся, ибо и двух недель не прошло, как Гугл почесал в затылке и разблокировал аккакунт.

Желаю Вам в новом году объективно смотреть на качество сервисов Вашей любимой компании, а Гуглу — повернуться лицом к каждому пользователю и перестать бороться со спамом головотяпными методами.

dirtyHabrBobr

29.12.2015 06:36Не упомянуты поведенческие факторы;

про Гугл основательно (и, предупреждаю, довольно своебразным языком) пишет Вадим Ласто

blogopoisk

29.12.2015 09:50+3А причём тут поведенческие факторы? Ну если вы так просите, вот мнение Google:

Q: Учитывает ли Google поведенческие факторы для целей ранжирования?

А.: Нет, не учитывает. Смотрите видео ответ Андрея Липатцева.

www.youtube.com/watch?v=wnZKO8n13C8&feature=29m00s

Дополнительно читайте:

John Mueller — I wouldn’t assume it [user behavior] is something that #Google would pick up as a #ranking factor. goo.gl/PrM6nE — @SeoTelegraph

Использование кликов напрямую в ранжировании не будет иметь смысла из-за шума — Gary Illyes. — Блоgгер

«Мы не учитываем данные, предоставляемые через Google Analytics при ранжировании. „Накликивание“ на ссылки в выдаче через псевдо-сервисы, подобные юзератору и иже с ним, – бесполезная трата ресурсов для веб-мастеров, которые могли бы с большей пользой употребить их другим образом». «Мэтт Катс — такие показатели, как CTR и показатель отказов не принимаются во внимание в алгоритме ранжирования».

Андрей Липатцев

Flex25

29.12.2015 21:05> псевдо-сервисы, подобные юзератору и иже с ним, – бесполезная трата ресурсов для веб-мастеров

А что еще мог сказать представитель поисковика? Разве только, что закупка ссылок — это еще одна пустая трата денег и Гугл давно научился определять платные ссылки. Эти сказки мы слышим уже не один год.

blogopoisk

29.12.2015 21:19А что еще мог сказать представитель поисковика?

ОК. Кого, по вашему, в этом случае нужно слушать, если не представителя поисковика, и почему?

Flex25

30.12.2015 10:12+1Слушать надо всех, но окончательные выводы делать самостоятельно. Никому верить на 100% нельзя: ни мне, ни вам, ни инженеру Гугла и т.д. Однако, слушать надо, т.к. даже в самой лживой речи можно уловить скрытые сигналы.

blogopoisk

30.12.2015 11:40Никому верить на 100% нельзя: ни мне, ни вам, ни инженеру Гугла

А самому себе? :)

P.S. Это шутка.

PHmaster

30.12.2015 00:21Автоматически сгенерированный текст, текст о том «как налить стакан воды», отсутствие своего полезного и информативного основного контента — может быть причиной пессимизации сайта.

Интересно, как алгоритмы гугла могут определить, автоматически сгенерен текст, или это автор косноязычен/использует свой авторский стиль изложения? На чем они основываются, когда относят текст «как налить стакан воды» к низкокачественному? Как определяют, какой контент пользователю покажется полезным и информативным, а какой — нет? Или это не алгоритмы, а специально нанятые полчища человеков вычитывают тексты всех ресурсов на всех языках мира перед тем, как отправить их в выдачу?

blogopoisk

30.12.2015 11:35Google получил патент, охраняющий алгоритм оценки качества контента. Следует отметить, что именно этот алгоритм используется лидером поиска для выявления страниц с низкокачественным и искусственно сгенерированным контентом и применения к ним соответствующих санкций.

Подробнее www.searchengines.ru/news/archives/google_zapatent_algo_gibberish.html

PHmaster

31.12.2015 22:27Спасибо за ссылку. Но там новость без всяческих технических подробностей, и в интернете этих самых подробностей я не нашел, а судя по комментарию эксперта из той же новости, сам по себе патент описывает технологию «в самых общих чертах», с уклоном на сам факт ранжирования по оценке качества индексируемого текста, без особого углубления в детали самой оценки. А именно это меня и интересует.

blogopoisk

01.01.2016 15:42Технические подробности знают только сотрудники Google, но они их раскрывать не могут, поскольку подписали NDA.

Что касается поисковых алгоритмов, здесь мы, обычно, не можем дать какого-либо конкретного совета.

Джон Мюллер (John Mueller)

aldous

30.12.2015 11:36+1Интересно, как алгоритмы гугла могут определить, автоматически сгенерен текст, или это автор косноязычен/использует свой авторский стиль изложения?

Ручные меры не подразумевают алгоритмов :-). Есть фидбек, приходит жалоба, что гс с фальшивым текстом в топе. Даже Гугл пока не может обойтись без вмешательства человека.

На чем они основываются, когда относят текст «как налить стакан воды» к низкокачественному?

Текст ранжируется чисто по ключам и неестественному ссылочному. Ответа не даёт, нет комментариев и т.д. Специалист гс распознает в считанные секунды. Что касается алгоритмов кач-ва поиска, то сгенерированные тексты, к счастью, до сих пор убогие и нечитабельные на 98%.

Как определяют, какой контент пользователю покажется полезным и информативным, а какой — нет?

Алгоритмически — по сигналам популярности. Поисковые технологии схожи с музиндустрией. Если люди ищут музыканта, он им нравится, его будут слушать, и ничего с этим не поделать. Если музыканта пропихивает компания методом кошелька, то он два месяца «повисит на слуху» и стухнет.

Не упомянуты поведенческие факторы

У пс сейчас интересные эксперименты. Но к сеошным сказкам они отношения не имеют.

У Яндекса: часто обращаешься к сайту, он будет в поиске выше для тебя. Завязано на аккаунт Яндекса.

У Гугла. На планшете ребёнок искал информацию по игре Скайрим. Теперь Скайрим не только в подсказках, но и в выдаче =). Например, если набрать «как починить», то вылезет сайт с ключом «как починить меч». Тоже завязано на аккаунт и наверное на устройство, потому что с телефоном другая картина на том же аккаунте.

И как гуглеры говорили: если сайт люди ищут, сайт продвинется в поиске. Если сайт людям не нужен, он «сам выкинется» или его выкинут принудительно.

PHmaster

31.12.2015 22:22Ручные меры не подразумевают алгоритмов

Ну в статье речь идет как раз об алгоритмах, в частности, далее по тексту после приведенной цитаты упомянуты «Панда» и «Пингвин».

Что касается алгоритмов кач-ва поиска, то сгенерированные тексты, к счастью, до сих пор убогие и нечитабельные на 98%.

Убогие и нечитабельные для человека, но как это определяет алгоритм? Для меня, например, некоторые статьи и комментарии на хабре тоже нечитабельны: либо использована какая-то узскоспециальная лексика, либо жаргонизмы и обороты, присущие аудитории какого-нибудь небольшого, забытого уже временем интернет-сообщества, мне неизвестного. Либо просто автор так пишет, что поди разбери, что конкретно он имел в виду. И в то же время, находятся люди, которое это читают и комментируют, то есть для них вполне понятно, что имел в виду автор. При всем при этом я встречал сгенерированные тем же «марковым» тексты, в которых можно успешно вчитываться в один-два абзаца, пока поймешь, что что-то здесь не так. Вот мне и непонятно, как алгоритм (а не «ручные меры») понимает, сгенерирован этот текст вручную, или его написал обитатель какой-нибудь «секты» на своем «тайном» языке, или это неформатированный поток сознания какого-нибудь человека, не имеющего склонности и навыков к письменному изложению своих мыслей.

Алгоритмически — по сигналам популярности.

Ну так SEO-тексты как раз и пишутся под эти самые сигналы популярности, насколько я знаю. То есть, если люди часто ищут фразу (условно) «купить новый айфон 29» — то можно быть уверенным, что очень скоро появятся тысячи сайтов, специально оптимизированных под этот поисковый запрос. То есть, эти сайты должны быть популярными априори.

И как гуглеры говорили: если сайт люди ищут, сайт продвинется в поиске.

Оять же, люди ищут (в подавляющем большинстве случаев) не сайт, люди ищут информацию, которая может содержаться на этом сайте, но точно так же может содержаться и на тысячах и миллионах других подобных сайтов. Если миллион сайтов одновременно продвинется в поиске по конкретному запросу — то это будет означать, что фактически не продвинулся ни один из них.

stalkerg

Спасибо, отличный материал!

Правда в жизни оно как то сложнее получается и в странных сочетаниях встречается.

В последний год вообще забил на SEO, просто устал беспокоится.

blogopoisk

Спасибо за отзыв. На счет странных сочетаний тут вы абсолютно правы. Все эти алгоритмы являются частью одного основного алгоритма. Они могут воздействовать как поодиночке, так и одновременно. К этому нужно добавить воздействие мер, принятых вручную. Может быть такое, что меры к сайту отменили, но ситуация не меняется или изменилась незначительно. Это тоже повод проанализировать, не осталась ли на сайте «неведомая зверюшка».