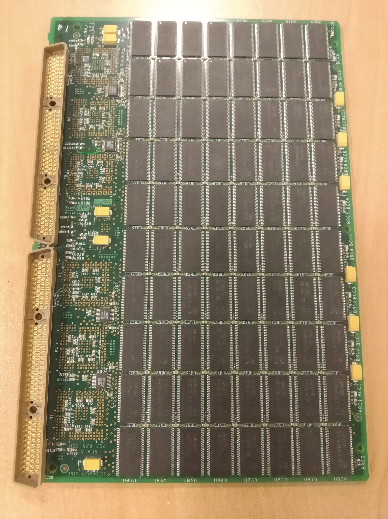

Точнее, это ячейка хайэндового дискового массива, представляющая нечто вроде оперативной памяти, но в центре архитектуры Симметрикса

Еще увидели знакомую старую железяку — VNX1. Она интересна не столько гениальной по тем временам архитектурой, сколько тем, как мы однажды разбирали последствия переезда такого массива с этажа на этаж по офису заказчика. Представьте ситуацию: они там четыре года делали проект по госконтракту, который хранился в виде единственной копии на массиве. И решили перевезти железку, не позвав админа, потому что железяка была старая (на три поколения древнее, чем та древность, от которой кеш-плата на фотографии) и сошла с поддержки. Для упрощения переезда решили вынуть все диски, потому что без них стойка получалась легче. Как вы догадываетесь, вопрос только один: что вообще могло в этой истории пойти ТАК?

Железяка имеет физическую адресацию дисков по номеру слота. Слоты для дисков бывают двух типов: рейд-группы массива (большая часть) и диски горячей замены. Массив при втыкании дисков обратно увидел, что это его диски, но начал ругаться на нарушенную адресацию красными лампочками. Местный админ начал подбирать комбинацию из дисков, надеясь, что если угадать с перестановками, лампочки погаснут и всё заведётся. Потому что про многомиллионный проект уже начали задавать неудобные вопросы.

Подстава заключалась только в том, что при втыкании диска в слот горячей замены массив не ворчал на него, а говорил: «О, новый жёсткий диск» и молча его форматировал, и начинал в него что-то писать.

Всего заказчик успел попробовать около 20 рекомбинаций из 200 дисков, из которых девять пришлось на установку новых дисков с данными в слоты горячей замены.

Массив VNX

Что вообще могло пойти так?

Итак, к 20-й перестановке, к счастью, они поняли, что что-то идёт не так. Позвали нас собирать массив обратно. На тот момент заказчику казалось, что дело просто в том, что нужно правильно расставить диски, коварство массива с очисткой данных они сильно недооценили.

Когда мы чуточку разобрались в ситуации и рассказали, что же именно они сделали, эти лица надо было видеть. Знаете картину «Крик» Мунка? Все думают, что там главный герой кричит, но если присмотреться, можно заметить, что он всеми силами старается выровнять давление в черепе после шокирующего воздействия окружающей среды. То есть крик — это всё вокруг, а он просто жертва. Вот так же выглядели те, кто не сделал бекап.

К счастью, у истории хороший финал — один из немногих в играх на рекомбинацию против бездушных массивов. Как я уже сказал, к моменту нашего приезда они успели грохнуть девять дисков и частично записать на них технические данные. К счастью, по какому-то невероятному для них совпадению, это были диски из разных (!) рейд-групп, то есть каждый раз сохранялась избыточность. Парни несколько раз подряд выиграли в русскую рулетку с пистолетом, а не револьвером.

Мы подготовили и расставили все диски, включили массив, он подцепился (ни один диск в переезде не пострадал) и спокойно начал ребилд. Дальше появился полный доступ к консистентным и полным данным. Заказчики отняли руки от головы.

Мораль истории: массивы могут быть коварны.

А компоненты для таких коварных массивов, используемых в госконтрактах, мы всё ещё храним. Некоторым железякам ЗИПа больше 20 лет, относительно недавно, например, ушёл последний из нашего запаса 486-й процессор в АСУ ТП-компьютер на заводе, управляющий станком. Когда сломается и он, наверное, клиенты сделают апгрейд.

Ещё железо

Но давайте покажу ещё несколько интересных железок у нас на хранении. Склад выглядит вот так вообще:

Вот компаковские сервера:

Когда я приходил на работу в КРОК в 2008 году, они уже были старые — ну, вы можете это понять по тому, как написано название компании HP на их корпусе.

Вот тут видно прогресс, вместо одного Pentium III там стало два или даже четыре процессора. Обратите внимание, эти сервера запирались на замок

Вот обычный сервер IBM. Такие серваки в принципе вообще не изменились внешне. Он примечателен тем, что не примечателен вообще ничем.

Собственно, он как был железкой смутного назначения, так и остался, только теперь на новых написано Lenovo.

А вот это уже штука хитрее, но всё так же смутна:

Это P-серия блейдов HP. Я видел её только в лабораториях и в ЗИПе, но никогда — в проде. Никто из моих знакомых и коллег тоже не видел её в проде. Если вы вдруг знаете, с чем она конкурировала и для чего была незаменима, — скажите, пожалуйста, но вместо неё в проде всегда стояло что-то другое. Но такая штука существовала, вот доказательство.

А это динозавр из эпохи, когда Sun были отдельной компанией. Внутри был один из последних классических RISC-процессоров без довешивания фич. На топовых серверах этой линейки можно было менять оперативную память в онлайн-режиме, а на самых крутых — процессоры. Правда, я обслуживал только младшие сервера линейки и так ни разу не делал. На практике всегда было проще потушить сервер, сделать замены и вернуть его в бой — на этом же сходились все инженеры, которые обслуживали это железо. Железяка связана у меня с большой обидой, потому что я обслуживал похожие (в ЗИПе 440 и 240, я работал с 290) полгода, а дальше должен был ехать на повышение квалификации учиться в ЮАР. Но в солнечную страну я так и не поехал, потому что Sun разорился. Потом съездил в Америку и Германию от EMC и Хитачи, но пингвинов и львов так и не увидел.

А это ленточные библиотеки. Выглядят достаточно старомодно, но современные модели принципиально ничем не отличаются от моделей 20-летней давности. Собственно, вендор это тоже заметил. Наверное, поэтому поменял цвет панелей по бокам, чтобы отличать новые от старых. Отлично работают много где по стране, на них чаще всего хранится бекап Судного дня.

Кстати, про бекап Судного дня. Был у нас потрясающий случай с Симметриксами на заводе. Два массива в синхронизации, но у одного при перепланировании электрики в здании отключили дисковый шкаф. Просто взяли и увели все диски в офлайн. Что характерно, заметили только через полтора года — дело в том, что эти массивы очень коварные и самостоятельные. В случае отказа локальных дисков они присылают админу личное письмо и идут смотреть, что в синхронной реплике. Заказчик купил обновление массива, приезжает инженер ставить обновление. Мы вдвоём заходим в серверную — а серверный шкаф выключен. Полтора года работал без дисков, ни единой ошибки. Данные в порядке. Стали разбираться, почему нет писем — оказалось, при заведении почты вместо .ru указали .ri. Шкаф включили, массив его примерно неделю ребилдил, потом продолжил работать.

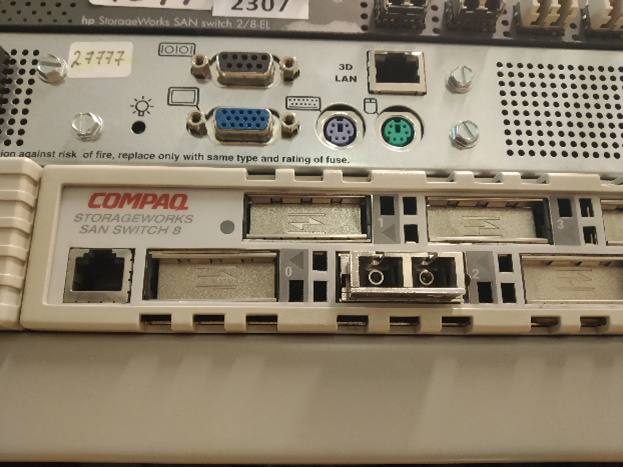

Это древнющий свитч, который вымер, кажется, под тысячу лет назад, но у нас лежит и кого-то ждёт. С учётом, что недавно была перепись предпокойников по стране, это означает, что его прод-коллега всё ещё трудится на заводе где-нибудь в Сибири и радует простых сибирских мужиков нормальными разъёмами. Они там были крупные.

Кстати, про разъёмы со свитчами. В одной крупной серверной один раз админ заказчика увидел свободно висящий из свитча кабель и воткнул его обратно (чем запустил слияние двух фабрик и оторвал все диски от всех фабрик внутри ЦОДа). Или вот другая история произошла пару лет спустя — кабель (уже питания) свисал из сервера, и втыкание его обратно вызвало очень быструю цепочку событий, которые привели к отключению подстанции. Что в обоих случаях заставляло людей так обращаться с железом, мы не знаем. У нас нет админопсихологов.

А это первый лоуэндовый массив HP из известных мне, который смог Fibre Channel. А выше него лежат контроллеры старой-старой EVA — это была суперпродвинутая линейка для своего времени. Делалась она с той архитектурой, которая стала современной существенно позже, по функционалу тоже было круто. HP вообще очень многие интересные проекты закрыл, потому что здесь и сейчас они не приносили денег или чего-то ещё — это были процессоры Альфа (DEC), кластеры VAX, эти вот массивы и так далее.

С массивами самая частая роковая ошибка — выбрать не то направление репликации, я пару раз на такое выезжал. Но один раз было ещё круче. Звонит заказчик, говорит: «Всё плохо, массив недоступен, паника-паника». Я смотрю на интерфейс управления массивом — все LUN’ы в онлайне, всё зелёное. Говорю: «Друзья, давайте соберёмся и проверим пункт 1 таких тикетов: об одном ли мы массиве говорим». Утверждают, что о том. Присылают свои логи — всё офлайн. Я смотрю — снова всё онлайн, в интерфейсе чисто. Говорю: «Друзья, это странно, в такой ситуации надо взять паузу и разобраться». Заказчик же паникует, хочет срочно — и отдаёт команду на перезагрузку массива. А дальше гениальная фраза:

— Ой! А у нас второй массив тоже отвалился!

Вот ещё контроллер от компании, которая теперь называется по-другому:

Кстати, до сих пор ни разу не видел ни одного битого контроллера с 2013 года. Диски летят регулярно, но это расходник. А вот контроллеры делают на века. Как и center plane Симметриксов, к слову, но вот её-то я как раз видел на замену. Напомню, там полутораметровая текстолитовая плата, вокруг которой построена стойка. И чтобы её поменять (что по задумке создателей делать не придётся никогда в жизни), нужно разобрать примерно всё и заодно ещё отогнуть в одном месте заземление. Именно тогда я узнал новые границы русского мата: мой коллега, который выяснил, что именно ему предстоит менять, матерился на всём протяжении процесса, и первые полчаса — без повторов.

А вторая история — почему именно с 2013-го. Дело в том, что тогда было солнечное затмение. Его даже в Москве можно было видеть. Мы в то время обслуживали EMC. Обычно за год бывает один-два случая, когда в RAID 5 вылетает два диска сразу. Это ситуация предсказуемая, и из их массива можно сохранить данные. Но полтора месяца было по три-четыре случая в неделю, причём вылетали сразу и диски, и оперативка. И именно тогда дохли единичные контроллеры. Помню, как мы смеялись ещё раньше над сановскими кодами ошибок про космическое излучение, но вот пригодились же.

Вот здесь модель подставки предлагаю вам определить самостоятельно:

Похожие подставки устанавливались в ещё одну эпичную железяку IBM 306 в 2007 году: у неё материнская плата собиралась из пяти частей с разъёмами. Мы её называли «чёртов конструктор». Другой «чёртов конструктор» — это был Violin, который некоторое время бесил нас в облаке. В теории с массивами всё было хорошо, очень правильная архитектура, современные подходы, отказ от оверхеда жёстких дисков… На практике сейлзы сказали нам, что пара заказчиков не хочет заходить в наше облако, потому что знает, что у нас Виолины, а у них были такие же. В итоге мы вскоре заменили их на делловские системы. Те обычно не преподносят неприятных сюрпризов.

Кстати, один из наших ЦОДов. Мы на нём испытывали защитную капсулу-шлюз, которая должна была пропускать админов по одному. Так вот, из-за неё главный архитектор не мог попасть внутрь. Дело в корейской системе стандартов. Наш архитектор был мужиком под 2 метра ростом и в самом расцвете сил. Корейские инженеры же даже представить себе не могли, что один человек может столько весить. С их точки зрения, в капсулу пыталось пройти два человека, что категорически делать нельзя.

Ещё байки

Поскольку я больше про массивы, расскажу лучший известный случай из практики, где человеческая паника победила. Итак, 31 декабря, банк, тесты генератора перед новым годом, чтобы если что — 3 января не остаться без питания. Команда его погоняла, убедилась, что всё хорошо, но забыла заправить. 2 января в ЦОДе выключили питание, и они штатно перешли на генераторы. Хайэндовый массив очень крутой, он может штатно пережить два выключения питания. При пропадании луча он перешёл на свои внутренние батареи, корректор раскидал кеш, завершил все сессии и лёг спать. Включается генератор, всё поднимается, массив продолжает работать. Через час в генераторе кончается горючка, снова всё отключается. Массив хайэндовый, все дела. Батареи, раскидать кеш, корректное завершение, штатный офлайн. Местные админы паникуют и включают батареи — массив включается. Батареи кончаются через 40 минут. Батареи массива зарядиться не успели. Массив в хламину, никаких целых данных на нём больше нет, заказчик в восторге, а я в особенном, потому что полетел на другой край страны из деревни под Тулой.

Кстати, лететь с кусками массива отдельное удовольствие. Сначала ты объясняешь охране аэропорта, что эти коробки ты открывать не будешь и в сканер не положишь. Потом — на стойке, почему у тебя два билета и на втором полетит микросхема. Потом ещё раз диалог с охраной. Потом объясняешь пассажиру рядом, что вот эту штуку трогать не надо. Потом два бортпитания — мне и контроллеру. К счастью, накладные с суммой 40-60 тысяч долларов за плату действуют достаточно убедительно.

Хотя, конечно, этот случай с генератором — это не так эпично, как когда заказчик узнал на тестировании питания ЦОДа, что на монтаже кто-то перепутал фазу и ноль в одном критичном узле.

А, да, и у нас один раз массив играл в Монте-Кристо. Дисковый шкаф на 16 свинцовых батарей по 22 килограмма и 190 дисков, около 1800 килограмм итого. Его закатили в ЦОД, поставили, а дальше стойка в течение примерно трёх минут плавно уходила под фальшпол, прогибая всё вокруг.

Комментарии (89)

BigBeerman

21.09.2021 10:54+2А чем чреваты перепутанные фаза и ноль? Современным БП вроде пофигу?

Iv38

21.09.2021 11:31+8Скорее всего речь о трёх фазах и о случайном подключении оборудования между двух фаз, а не между фазой и нулём.

beerchaser

21.09.2021 11:33+3На устройство приходит две фазы. но это к вопросу организации подключения - узм это не роскошь, а насущная необходимость.

aMster1

22.09.2021 20:23+1Ха! На заре моей работы на текущем месте, наблюдал ввод ЭПУ в эксплуатацию. Заведено 3 фазы, подключено на разъем, смонтировано все по феншую... Руководитель подрядчиков подходит к распредшкафу, щелкает автоматом, тот моментально отщелкивается, руководитель от неожиданности садится на попу. Быстрое расследование показало что ЭПУ может работать как от одной фазы, так и от трех, но для работы от одной фазы нужно поставить перемычки... Которые на заводе естественно поставили, чтобы на месте не искать.

Зато на следующих объектах перемычки вынимались сразу после вскрытия коробки ;)

AlOvch Автор

21.09.2021 11:47Перепутать фазу и ноль ничем не чревато, если одна фаза в сети. Если в сети три фазы, то будет замыкание.

BigBeerman

21.09.2021 18:03ээээ, как? вы же берете только одну из фаз, как она с остальными пересечется? Вот взять две фазы вместо фазы и нуля да, вариант.

UPD: дошло, как раз вариант с двумя фазами и получается, если потребители 220в распределены по трёхфазной сети

Inskin

22.09.2021 00:01+1Если я не ошибаюсь, то если вдруг электрик решил сделать зануление вместо заземления, то перемена фазы с нулём может быть неприятна. Да и даже без заземления - если ты привык, что выключатель света у тебя выключает именно фазу, то неаккуратное ползание в электросети после такой перемены может нанести неприятности.

drWhy

21.09.2021 12:16К примеру фаза с нулём на выходе онлайнового ИБП могут меняться местами при включении/отключении входного напряжения в случае неправильного подключения входной фазы.

rencom66

21.09.2021 23:58Это как ?

С учётом того что выход от входа отвязан .

drWhy

22.09.2021 09:31Но на выходе же есть фаза? При холодном старте фаза на выходе слева, при восстановлении питания справа — ИБП синхронизирует фазу со входящей сетью, если исходно не выбрать правильный вариант поворотом вилки.

Не знаю, ведут ли себя так все однофазные онлайновые ИБП, но APC SURT2000XLI определённо да.

Частоту с входящей сетью он кстати тоже синхронизирует по умолчанию, хотя можно выбрать стабильные 50/60 Гц.

Am0ralist

22.09.2021 10:12+1А еатоновские упсы работают только в одном положении вилки. Если перевернуть — начинают противно пищать. Если не знать о таком факте, то не сразу соображаешь, в чём проблема)

drWhy

22.09.2021 10:58Спасибо, не знал. Это кажется более правильным подходом. Полагаю, определить положение ноля при подключении в обесточенную розетку должно быть возможно.

DmSting

29.09.2021 01:14+2Мы разок вообще в сервис бесперебойник потащили, ругаться как же так - нулёвый, только из коробки, ИБП отказывается работать!

Он причём так невнятно на экране пишет, типа "проверьте питающий кабель" или как-то так. Ну проверили. В нём 220. не расшатанный :DКак-то до этого у нас все итоны были либо трехфазными, либо однофазными большими, без вилки, и тогда там уже однозначно L и N подписаны.

vesper-bot

21.09.2021 12:19+3А как дела у крысы? (Раз уж ностальгии пост)

AlOvch Автор

21.09.2021 12:35+12ЕЁ РАЗОРВАЛО В ХЛАМ!

Или вы про другую?

vesper-bot

21.09.2021 12:44+2Там вроде одну разорвало, вторая где-то выжила. Мне интересно, была ли в этом посте где-нибудь крыса, в каком-нибудь сервере, например ;)

Squoworode

02.10.2021 15:33+1Эх, хотел перечитать, как её разорвало - а пост закрыт. (Ну, хоть клон кое-как нашёл...)

drWhy

21.09.2021 12:30+4Запас комплектующих на складе производителя на весь срок жизни сервера греет душу. С другой стороны все эти дополнительные процессоры, память, диски, контроллеры, хранящиеся годами — замороженные немалые средства, косвенно учтённые в стоимости сервера. Кажется Dell'у когда-то удалось запрыгнуть в серверный сегмент именно за счёт оптимизации логистики при отсутствии складов.

Спасибо за нарядные истории.

Muzzy0

12.10.2021 18:08+1С другой стороны все эти дополнительные процессоры, память, диски, контроллеры, хранящиеся годами — замороженные немалые средства, косвенно учтённые в стоимости сервера.

А отсутствие ЗиП, когда он срочно нужен — это эпически просранные полимеры и ещё более немалый ущерб. И совершенно непонятно — что делать?

PereslavlFoto

21.09.2021 12:35+5«Мы подготовили и расставили все диски». Вам это удалось, а владельцу не удалось. В чём разница? Почему вам удалось, а штатный сотрудник не сделал?

drWhy

21.09.2021 12:56+1Возможно где-то были записаны серийники дисков в порядке установки. Или была нанесена маркировка на самих дисках. Штатному могло быть не до мелочей, если на него авторитетом давили.

vvzvlad

21.09.2021 13:16+1Если знать про то, какие слоты для дисков горячей замены, проблемы нет: втыкаем любой диск в обычный незанятый слот, смотрит, загорается ли лампочка ошибки. Если нет, то GOTO 1, повторяем операцию со следующим слотом. Если да, вытаскиваем диск и GOTO 1.

Они бы и сами собрали, если бы не разница слотов.

AlOvch Автор

21.09.2021 17:02Изначально всё было просто: если разобрать старые логи массива парсером (а это VNX, там старые логи не удаляются) — можно вытащить правильное расположение. Непросто было убедить диски одной RG, у которых сигнатура, записанная на диск повредилась, что они все впятером из 1 RG, а не из трех разных.

PereslavlFoto

21.09.2021 12:44«Никаких целых данных на нём больше нет». Как же удалось собрать данные в таком массиве?

AlOvch Автор

21.09.2021 15:32+8Непростой вопрос для краткого ответа. Попробую объяснить: основная проблема понять, что повреждено, а что не очень, тут помог вендор, запустили проверку целостности девайсов, но она заняла без малого 12 суток! (мне немного надоело ходить к заказчику утром и вечером на 5 минут, чтобы убедиться, что ещё не всё). Большинство томов собралось более-менее консистентно, а действительно повреждённые были в реплике, ave SRDF. Учитывая дату события, на системе не было активности больше 4-х дней, так что файлы пользователей сохранились. В немалой степени нам повезло.

Caraul

21.09.2021 13:25+3Склад роскошен и напоминает не то пещеру Аладдина, не то археологические раскопки. А голова у заказчика так и осталась в форме лампочки?

ultrazoom

21.09.2021 15:33+1HP вообще очень многие интересные проекты закрыл, потому что здесь и сейчас они не приносили денег или чего-то ещё — это были процессоры Альфа (DEC), кластеры VAX...

Да, это как раз было то время когда царицей HP была Карли Фиорина. В каждом офисе HP должены были висеть её портреты (кто помнит СССР, понимает о чем тут речь...) Потом царицу Фиорину из HP выгнали и она ушла в политику (официально, конечно, она просто перешла на работу, где её таланты были более востребованы). А потом, в 2016, она решила выдвинуть свою кандидатуру на пост царицы всего США... Х̶о̶р̶о̶ш̶о̶ ̶ч̶т̶о̶ ̶е̶ё̶ ̶п̶р̶о̶к̶а̶т̶и̶л̶и̶!̶ Выбрали Трампа...

JerleShannara

21.09.2021 16:30+5Ох, как я люблю «ну мы тут диски потыкали и оно того...»(вернее я таких действительно люблю, т.к. после такого за восстановление данных люди готовы платить, а кушать хочется всегда).

Маленькая хранилка одним прекрасным утром обнаружила, что одному диску стало плохо и выплюнула его, прописав на почту, что «this disk is now ex-disk», спокойно подобрала hotspare и начала на него восстанавливаться (RAID50), одновременно, чтобы было видно, сменив цвет «лампочки» на оранжевый. Что сделали «мудрые» люди, увидев оранжевую лампаду? Прааавильно, начали дёргать диски (на горячую, оно же hotswap да и вообще что-то делать перед физическим отключением диска это не путь джЫдая), мол наверное «контакт отошел», в один прекрасный момент они дёрнули диски от разных пятёрок, и перепутали их местами. Результат немного предсказуем, маленькая хранилка отрапортовала на почту «your array is now ex-array» и сменила цвет лампочки на красный (попутно включив ещё кучку красных лампочек около дисков). Результат — дёргатели остались на белой части зп, дверь в серверную таки подключили к СКУД-у, местный админ очень долго икал, но данные частично удалось восстановить.

drobzik

21.09.2021 18:30+6Прааавильно, начали дёргать диски (на горячую, оно же hotswap да и вообще что-то делать перед физическим отключением диска это не путь джЫдая), мол наверное «контакт отошел»

Пфф, когда-то видел статистику вендора по отказам дисковых систем, так там в тройке лидеров была «когда нужно было поменять сломавшийся диск, не тот диск выдернули».

scruff

22.09.2021 07:34-4RAID50? Это ахтунг! Что только люди не придумают чтобы не сделать всё сразу и по-человечески. Почему нельзя тупо "нарезать" зеркал, а уже на уровне ОС объединять их в бОльшие массивы, или вообще планировать дробное размещение размещение данных? На месте вендоров я бы эти самые RAID5 и все остальные гибридные массивы убрал бы из поддержки совсем и безвозвратно. Абсолютно везде где я встречался с чем-то отличным от RAID1 - везде были проблемы, начинавшиеся с затянувшегося на пару недель ребьюлда, а кончавшиеся выходом из строя остальных дисков с последующей потерей данных. А потом ойой - вы все плохие, ваш сервер сдох.

JerleShannara

22.09.2021 09:32Добро пожаловать в реальность, я и RAID5 на 16 дисках наблюдал (к сожалению того, кто этот массив собрал я лицезреть не смог, а очень хотелось повесить в рамочку «идиёт года»). Лично я очень благодарен вендорам за RAID50 и прочие гибриды, поскольку RADI50 на 10+ дисках вполне себе живёт и даже переносит ребилды, а вот RAID5 — нет.

scruff

22.09.2021 10:29Ради интереса к RAID50 я даже взгуглнул:

(+): высокая скорость передачи данных и обработки запросов.

(+): хорошая скорость восстановления данных и стойкость при отказе.

(-): требуется, как минимум, 6 дисков.

...и ужаснулся - в одном флаконе собраны сразу два костыля - абсолютная ненадёжность RAID0, и ненадёжность (еще одна!) и медлительность RAID5. Всё псевдобыстродействие страйпа улетучивается с использованием тормознутого RAID5. Кем надо быть чтобы :

во-первых придумать такое?

во-вторых - додуматься пользовать "это" в проде.

...и убедился - зеркало и только зеркало!!! - самое простое и надежное. Да, оферхэд, особенно если уже больше 2-х пар дисков. Да, велик соблазн весь этот оверхэд заюзать. Но в итоге надежнее просто докупить пару дисков и сделать еще одно зеркало и фиг с ним с оверхэдом. По крайней мере если разбивается одно из зеркал - страдает от этого только это разбитое зеркало, а не весь массив - с вытекающими последствиями в виде тормозов и рисков потерять еще диски за время ребьюлда.

vesper-bot

22.09.2021 14:21У нас в далеком 2004м собрали RAID5 на 20 дисках +4 hotspare. Массив проработал 4 дня, не выдержав стартового переноса данных с предыдущего хранилища.

PereslavlFoto

22.09.2021 17:03В чём была причина проблемы?

vesper-bot

23.09.2021 07:52+1Под нагрузкой сдох диск — я был тогда ещё эникеем и не был допущен к расследованию, не могу сказать, было что-то не то с дисками как целым или нет. Массив начал ребилдиться на одну из хотспар, помер второй. Собственно нашим был урок от жадности :D

mayorovp

23.09.2021 16:47+1Звучит как бракованная партия дисков, собственно из-за подобных явлений и рекомендуется брать диски из разных партий. Осталось только найти 24 диска из попарно разных партий...

zuek

05.10.2021 16:33"Элементарно, Ватсон!" - видел подобную картину, когда "российский производитель серверов" (надеюсь, уже не являющийся "производителем" - лет 10 не попадается на глаза его реклама) отгрузил "SAS-полку", начинённую SATA-хардами линейки "AS" - заказчик даже смог (с не первой, как потом выяснилось, попытки) на ней собрать RAID 5E, и даже около года на нём проработал... благо, диски были маленького объёма (гигов по 80) и "за мзду малую" я смог софтово пересобрать выпавший в offline массив с минимальными потерями.

horon

21.09.2021 16:32+4Тёплые ламповые истории КРОКа о том как кто то на праздники летел через всю страну - всегда радуют. А как удается договариваться с транспортной безопасностью аэропортов? По работе тоже частенько вожу всякое, но не получается контакт налаживать...

Jef239

25.09.2021 22:27Это просто. Показываешь бумажку с большой надписью «ФСБ РФ» и безопасники сами от тебя бегают. То, что бумажка подписана всего лишь командиром погранчасти — это не важно уже. Её никто и не читал, главное — логотип и печать на месте.

Железка — та, что на фото справа. Там корпус из 5-миллиметровой стали, чтобы пару кубов забортной воды не помяло. Так что обычно просят развинтить, назначение каждой микросхемы объяснить…Фото

slarionoff

06.10.2021 22:04Как-то недобро эта коробка стоит на изломе кабеля (ну, так выглядит)

Jef239

07.10.2021 00:09Могу спросить у конструктора, но скорее всего ничего не будет. На судне кабель питания зачастую тоже примерно так изогнут. Это ж корабельная техника, пару кубов водно-ледовой смеси для неё штатно, а уж кабель забортного питания… Скорее всего эти кабели просто физически нельзя загнуть на тот радиус, который был бы им вреден.

CherryPah

21.09.2021 16:33+4Это P-серия блейдов HP. Я видел её только в лабораториях и в ЗИПе, но никогда — в проде. Никто из моих знакомых и коллег тоже не видел её в проде. Если вы вдруг знаете, с чем она конкурировала и для чего была незаменима, — скажите, пожалуйста, но вместо неё в проде всегда стояло что-то другое. Но такая штука существовала, вот доказательство.

Я никогда не видел ее вживую в проде, но точно знаю компанию которая их так использовала

Это BL20PG2. На Xeon-ах, но судя по свидетельствам там были и BL25P, на оптеронах, что выглядит совсем уж дикой дичью =)

Z80A

21.09.2021 18:09+2Или вот другая история произошла пару лет спустя — кабель (уже питания) свисал из сервера, и втыкание его обратно вызвало очень быструю цепочку событий, которые привели к отключению подстанции.

Любопытно, почему включение сервера в сеть привело к отключению подстанции?

Сервер управлял этой подстанцией или это вопрос какой-то перегрузки?

vesper-bot

22.09.2021 07:14Я понимаю так, что произошло примерно следующее: сервер был отключен от питания, но не от локальной сети или сети управления, после его включения сработал или wake-on-lan или настройка БИОС и он пошел загружаться, вызвал конфликт IP-адресов или конфликт команд управления из-за двух одновременно комплектов работающего управляющего ПО, ну и что-то нехорошее передал на подстанцию, очего она вырубилась.

Dvlbug

22.09.2021 18:22Вы правы, скорее всего. Иначе, сразу было бы понятно, что-то не так, по мгновенно сгоревшему кабелю или автоматам.

marcbook

21.09.2021 19:04+8Расскажу свою "байку" про слабоумие и отвагу. Собираю слаботочный щиток для видеонаблюдения. Раскладываю все по местам: роутер, видеорегистратор с жестким диском, пое-коммутатор, блоки питания. Случайно путаю два штекера, и вставляю тот, что от блока питания пое-коммутатора (53В) в видеорегистратор, рассчитанный на 12В, поскольку они абсолютно одинакового типа и размера. Поскольку все на этапе сборки, ни один прибор к питанию не подключен. Но это меня не спасает, - остаточный заряд, накопленный в конденсаторах блока питания убивает мне и видеорегистратор (4т.р.) и жесткий диск WD Red Plus 4Tb (10т.р.). Причем, диск я взял первый попавшийся под руку, и не собирался его вообще включать, просто хотел прикинуть все по размерам. Как назло, это оказался диск с ценными данными (семейный фото-видео архив), бекап для которого я, конечно же, своевременно не сделал.

Слава богу, в диске пробило по линии питания (12В), а не по линии данных (5В). Ремонт обошелся в 6500р (как сказал мастер, - половина рыночной цены девайса), данные не пострадали.

Регистратор, как мне сказали, проще купить новый.

Вот так цепь случайных действий, каждое из которых вполне "безобидное", привела к неприятностям. Мне еще повезло, - если бы пострадали узлы внутри гермоблока HDD,то для восстановления данных пришлось бы принести в жертву еще пару таких дисков.

Этот жизненный урок стоил мне 10т.р. и нескольких клок выдранных волос ниже спины.

Dmitry_Doshaniy

21.09.2021 19:42+2Спасибо, Саша, знатно поностальгировал. Будет время и свои байки из тех и еще более ранних времен напишу) Была романтика в северном и схдшном железе

PretorDH

21.09.2021 21:20+6Cуперски, по ностальгировал!

P.S. Для знающих: у меня раз на машине с масивом фраза всплыла "One half".

zuek

05.10.2021 16:43Он же DrWeb'ом отлично расшифровывался! Главное не "вылечить" тело в загрузчике, содержащее ключ шифрования до расшифровки... Наши как раз дипломы писали, когда эпидемия пошла...

Вот хуже было с более поздней заразой, "Win95 CIH" или "ВинЧих", из начала нулевых, которая BIOS запарывала и первые несколько мегабайт на харде нулями переписывала, а удобных утилит восстановления тогда ещё не было (была пара утилей, но они кириллицу не любили). Микросхемы BIOS, со всех знакомых, я тогда на работу чуть не пригоршнями носил к нечастому на тот момент прибору - программатору.

mayorovp

05.10.2021 23:21Он же DrWeb'ом отлично расшифровывался!

Только пока он не успел "зашифровать" нулевой сектор, в котором хранится ключ расшифровки. После того как он он это сделал — расшифровка диска перестаёт быть тривиальным занятием и становится статистической угадайкой.

zuek

06.10.2021 13:05Сколько помню, "половинка" шифровала небольшие куски диска при каждом включении - визуально - пара секунд задержки перед появлением загрузочного меню DOS/Win95, у кого оно было (а было оно у многих), а надпись "дис из ванхалф" появлялась, когда зашифрованными становилась половина объёма диска. Ну, по крайней мере мне, из полутора десятков "пациентов" ни одного невосстановимого не попалось. А вот про харды, у которых какой-нибудь "дискинфоскоп" или другой антивирус/ревизор удалил из загрузочной области тело вируса вместе с ключём расшифровки - читать доводилось.

Fodin

21.09.2021 21:52+5Интересно, как можно отказаться открывать коробки в аэропорту? Оборудование ведь вряд ли фоточувствительное едет. Просвечивать - ладно. Ну и что, что 40-60 тыс. зелени в бумажке сопроводительной написано? Самолет и пассажиры всяко дороже стоят в случае бонбы, проехавшей на борт.

Jef239

25.09.2021 22:34Чуть выше описал, как я ехал из бумажкой, на которой написано «ФСБ РФ» Было бы надо — мог бы и не просвечивать. Но нашей железке пофиг.

hw_store

21.09.2021 22:16+1Интересно, а в каком месте сервера или СХД может использоваться контроллер, который на картинке?

(если что, у нас на складе исовые мультипортовки тоже лежат... мы ничего не выбрасываем, но наши всё же моложе 1992 года)

zuek

05.10.2021 16:50+1Скорее всего, это от упомянутой недалеко в тексте "486-й АСУ ТП" - порты управления каким-нибудь "хитрым оборудованием" - чего я только не насмотрелся в котельных и кондиционерных пристройках - от совсем аналоговых панелей до интерактивных мониторов на резистивных матрицах, под управлением "странных железных ящиков", пишущих при загрузке "VIA TM CPU 667 GHz"...

SpiderEkb

22.09.2021 08:53>Собственно, он как был железкой смутного назначения, так и остался, только теперь на новых написано Lenovo.

Да ладно? Сейчас это называется IBM System z - мейнфреймы от IBM. Выпускаются и развиваются активно до сих пор. Наследники System/370 System/390.

Есть еще бывшие eServer iSeries - ныне IBM System i, наследники System/36 System/38 AS/400 Позиционируются как middleware и тоже активно развиваются и выпускаются.

estet

22.09.2021 10:17Отличная статья!

Помню, как мы смеялись ещё раньше над сановскими кодами ошибок про космическое излучение, но вот пригодились же.

А расскажите про это подробнее.

drWhy

22.09.2021 11:05В службу поддержки HP как-то поступил вопрос: «Как можно извлечь картридж из стримера?»

Ответили, что нужно нажать на кнопку на лицевой панели.

Следующим вопросом был: «А что делать, если стример находится на орбите?»

Возможно и у контроллеров упомянутого типа был подобный опыт.

AlOvch Автор

22.09.2021 15:39+1Тут особо не о чем рассказывать, когда-то давно, как уже писалось в посте, я занимался обслуживанием серверов компании Sun. Как-то раз вечером более опытные коллеги обсуждали то-ли ответ вендора по кейсу, то-ли из взятые из документации описания кодов ошибок, где прям дословно говорилось, что причина сбоя чипов — cosmic rays. На детали я тогда внимания не обратил, но само обсуждение запомнил. Тогда же вспоминали забавную инструкцию для топовой ленточной библиотеки, которую продавал через себя Sun microsystems, инструкция называлась в стиле: «Что делать, если вас заперли внутри».

Nichls

22.09.2021 15:38Интересные байки. Благодарю.

Перевозил как-то маршрутизатор плюс IDS из Петербурга в Калининград в салоне самолета.

Цена конечно не 60т.$, но тоже эпично было.

Стойки с массивами так же возили, стену как-то в ЦОДе разбирали - иначе никак не занести, но полы выдерживали.

Yoooriii

27.09.2021 02:17+4У нас, было дело, электрик (профессиональный и с допуском) при разводке силовых кабелей всегда фазу цеплял на желто-зелёный провод. Я как увидел, офигел на месте. А он говорит, типа желто-зелёный провод -- самый яркий, там фазе самое место. Ну было уже поздно, переделывать не стали. И на остальных объектах тоже.

maxwolf

01.10.2021 00:17+2А что вы делаете с оборудованием, которое совсем-совсем вышло из употребления? Неужели выбрасываете на помойку или уничтожаете? Есть у вас какой-нибудь подшефный музей электронной техники?

SoLRoN

26.10.2021 17:08Не помню конкретную модель, но Саны использовались как серверы с ORACLE + ORACLE FORMS в банке. Конкуренция была в том, что тогда ORACLE был SUN. Обеспечивал в общем то легкую разработку и деплоймент по меркам динозавровой эпохи.

ClearAirTurbulence

Тяга к прекрасному. Если в мозге нет правила "не знаешь - не делай", либо мозг загружен другими процессами, и такое правило есть, но игнорируется, многие люди на автомате будут втыкать висящие шнуры, ибо это - непорядок.

Чтобы этого не происходило, нужно:

Помечать такие концы ярко-красным лейблом "не втыкать"

На всякий случай (цветовая слепота, неумение читать, задумчивость+автопилот) желательно ещё исключить возможность втыкания физически. Например, надеть на конец раз'ем, препятствующий втыканию, или чехол какой-нибудь. FGJ, можно и опломбировать, обычно, когда человек видит пломбы, автопилоты выключаются, и он начинает думать.

Keeper1

Я в подобных случаях надеваю на разъём на проводе маленький пакетик и фиксирую его стяжкой.

scruff

не проще ли провод со второго конца отключить и вытащить из стойки? Чтобы не возникало у "молодняка" включать висящие концы обратно?

Keeper1

Так не всегда можно сделать. Например, второй конец провода куда-то припаян. Не отрезать же его.

ClearAirTurbulence

Можно, но тогда когда он будет нужен, его не окажется на месте, куда его положили.

perlestius

Вспомнил давнишний случай. Работал админом в одной небольшой компании. С утра проснулся от звонка коллег. Жаловались, что в одном из офисов жутко глючит интернет на всех машинах (около 50ти штук). Я первым делом, разумеется, стал звонить провайдеру. У тех всё хорошо, пинг до нашего роутера стабильный. Когда приехал в офис, обнаружил, что проблема именно в ЛВС: пакеты ходят с жуткими задержками и большой процент потерь между узлами. Свитчи были неуправляемые, поэтому первое, что пришло на ум - отключать их по одному. Нашел проблемный свитч, далее уже на нем стал отключать кабели от портов. Нашел порт с виновником, а по нему вышел на Ethernet-розетку у рабочего места (благо, розетки были пронумерованы и была схема сети под рукой). Подхожу к этой розетке и вижу, что она закоммутирована с соседней розеткой. Оказывается, кто-то из менеджеров отключил свой ПК и перенес его за другой стол, а утром уборщица, увидев на полу сиротливо лежащий хвост патчкорда, воткнула его в ближайшую розетку. Классика жанра, только обычно уборщицы выдергивают шнуры, а тут был более изощрённый вариант.

Alexeyslav

Может она подумала что случайно выдернула и побыстрее вернула на место "как было"?

scruff

Вывод - если у тебя неуправляемые свитчи - неиспользованные розетки не подключать к свитчам вообще. Хотя тупому юзеру ничего не мешает сделать петлю у себя на свитче под столом. Еще вывод - неуправляемые свитчи с количеством клиентов более чем 5 - зло. Поэтому на всех аццесс портах spanning-tree bpduguard enable - must have!

xsevenbeta

Или перестала работать сеть -> увидели выткнутый кабель -> воткнули. А сеть не работала совсем по другой причине. И если про сетевые петли знает большинство админов, то с кабелем питания не всё так однозначно.