В ноябре 2022 года мы выпустили свою первую диффузионную модель для синтеза изображений по текстовым описаниям Kandinsky 2.0, которая собрала как позитивные, так и отрицательные отклики. Её ключевой особенностью была мультиязычность и использование двойного текстового энкодера на входе сети: XLMR-clip и mT5-small. Рефлексия после релиза подтолкнула нас к перестройке планов по развитию архитектуры и к сильному стремлению получить буст в качестве генераций, чтобы выйти на уровень аналогичных решений, названия которых слишком хорошо известны, чтобы их называть. В то же время мы могли наблюдать за появлением новых генеративных моделей и их файнтюнов, таких как ControlNet, GigaGAN, GLIGEN, Instruct Pix2Pix и др. В этих работах представлены и новые взгляды на генерацию, и новые возможности использования латентного пространства для внесения контролируемых изменений через текстовые запросы, а также для смешивания изображений — возможности использования генеративных моделей расширяются постоянно. Бурное развитие прикладных кейсов привело к интенсивно нарастающему числу различных привлекательных для пользователей реализаций этих функций — визуализация городов, изображения известных личностей в нетипичных ситуациях и многие другие.

Протестировать модель на своих запросах можно несколькими способами:

в Telegram‑боте (есть все доступные 4 режима генерации)

на сайте fusionbrain.ai (доступна генерация по тексту и режимы inpainting/outpainting)

на платформе MLSpace в хабе предобученных моделей и датасетов DataHub

в навыке Салют «Включи художника»

на сайте rudalle.ru

В целях повышения качества генераций будущих пользователей мы также разрабатываем специальный промтбук, который позволит вам выжать из модели максимум :)

Архитектура и детали обучения

Решение о внесении изменений в архитектуру пришло после продолжения обучения версии Kandinsky 2.0 и попыток получить устойчивые текстовые эмбеддинги мультиязычной языковой модели mT5. Закономерным выводом стало то, что использование только текстового эмбеддинга было недостаточно для качественного синтеза изображения. Проанализировав еще раз существующее решение DALL-E 2 от OpenAI было принято решение поэкспериментировать с image prior моделью (позволяет генерировать визуальный эмбеддинг CLIP по текстовому промту или текстовому эмбеддингу CLIP), одновременно оставаясь в парадигме латентного визуального пространства, чтобы не пришлось переобучать диффузионную часть UNet модели Kandinsky 2.0. Теперь чуть больше деталей про процесс обучения Kandinsky 2.1.

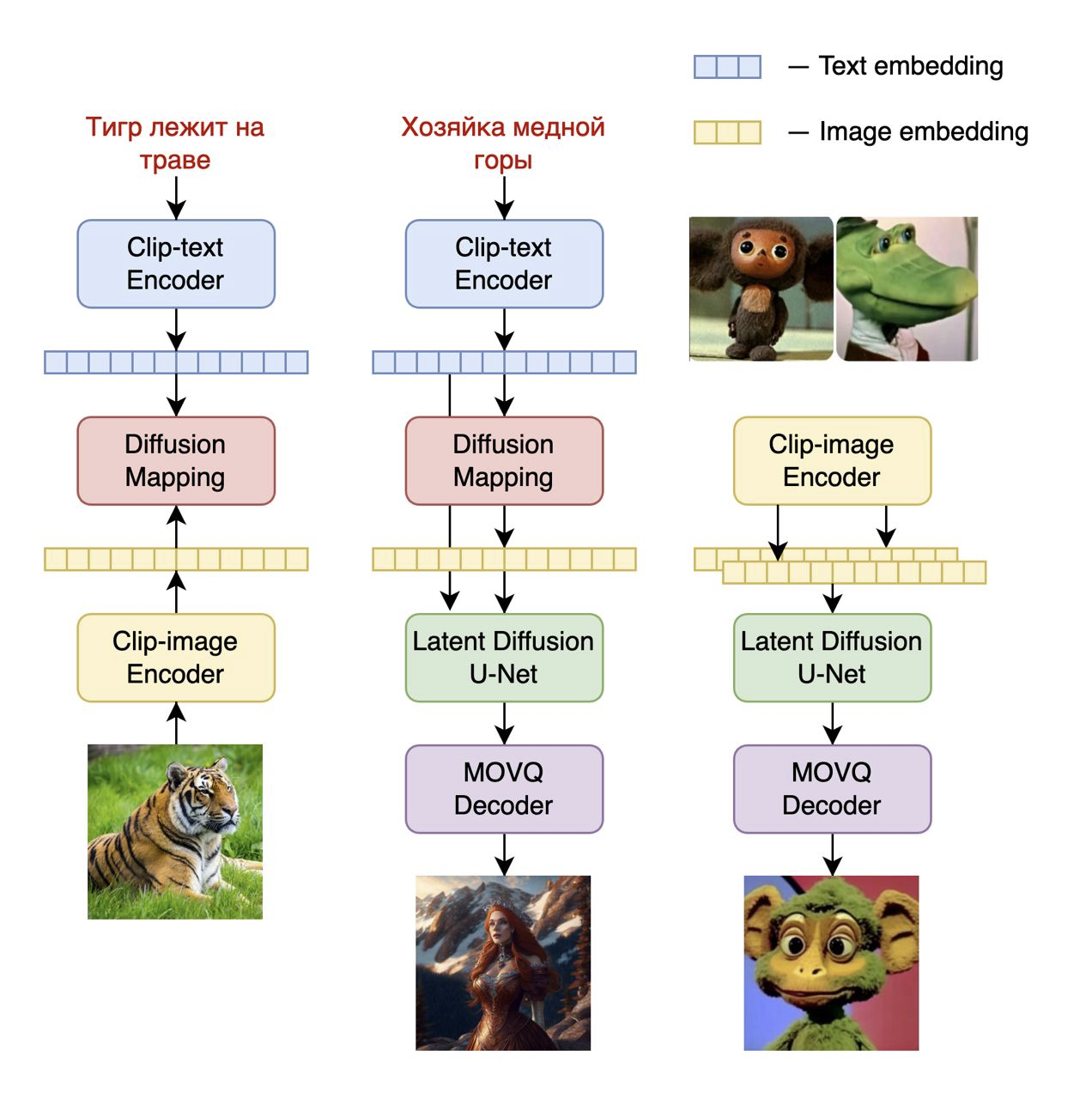

На первом этапе мы начали учить image prior модель для маппинга текстов и изображений, обучив отдельную диффузионную модель DiffusionMapping на текстовых и картиночных эмбеддингах CLIP. В качестве модели CLIP мы использовали предобученные веса mCLIP, а в основе DiffusionMapping лежит трансформерная архитектура с параметрами:

num_layers=20

num_heads=32

hidden_size=2048

Обучив image prior модель (рисунок 1, слева), мы стали учить целевую модель синтеза изображения по текстовому описанию (рисунок 1, в центре). В этой реализации обученный image prior в виде модели DiffusionMapping использовался для синтеза по входному текстовому промту визуального эмбеддинга mCLIP, который далее применялся в процессе обучения диффузионной модели. Таким образом, мы обучали механизм обратной диффузии восстанавливать латентное представление изображения НЕ только из текстового эмбеддинга как в Kandinsky 2.0, а еще и из визуального эмбеддинга CLIP с condition на этот текстовый эмбеддинг. В паре с дополнительными чистыми данными такое архитектурное изменение привело к существенному росту качества генераций (генерации можно наблюдать в конце статьи). В качестве конечного блока модели выступает новый декодер, который из латентного представления позволяет получить финальное синтезированное изображение.

Среди нескольких возможных способов использования генеративной модели мы особое внимание уделили возможности смешивания изображений (рисунок 1, справа). В отсутствии необходимости использовать текстовые эмбеддинги мы просто подаём в обученную диффузионную модель два визуальных эмбеддинга CLIP, и далее декодером восстанавливаем “смешанное” изображение.

В описании выше я умышленно не погрузился в детали нового декодера изображений, потому что этот этап заслуживает отдельного внимания, и даже отдельной статьи, но кратко о том, почему мы ушли от использованного в прошлых версиях генеративных моделей VQGAN и стали использовать специально обученный для наших целей MoVQGAN модель, я расскажу в отдельном блоке ниже.

Архитектура Kandinsky 2.1 содержит 3.3B параметров:

Text encoder (XLM-Roberta-Large-Vit-L-14) — 560M

Image prior — 1B

CLIP image encoder — 427M

Latent Diffusion UNet — 1.22B

MoVQ encoder/decoder — 67M

Для того, чтобы каждый мог оценить качество новой модели Kandinsky 2.1 мы по традиции выкладываем веса в open source на следующих источниках:

Датасеты

Обучение image prior модели выполнялось на датасете LAION Improved Aesthetics, а затем был выполнен файнтюн на данных LAION HighRes.

Обучение основной Text2Image диффузионной модели выполнялось на основе 170M пар “текст-изображение” из датасета LAION HighRes (важным условием было наличие изображений с разрешением не меньше 768x768). Использование 170M пар для претрейна обусловлено тем, что мы сохранили диффузионный блок UNet от версии Kandinsky 2.0, что позволило не обучать его с нуля. Далее на этапе файнтюнинга применяли отдельно собранный из открытых источников датасет из 2М очень качественных изображений в высоком разрешении с описаниями (COYO, anime, landmarks_russia и ряд других).

Визуальный автоэнкодер MoVQGAN

В ранних исследованиях (Kandinsky 1.0 и 2.0) мы использовали VQGAN автоэнкодер, который был специально дообучен под задачи синтеза изображений на таких сложных доменах, как тексты и лица людей. Это позволило добиться определённого успеха в части генераций изображений по сравнению с ванильной моделью VQGAN. Более подробно об экспериментах с VQGAN автоэнкодером мы писали в этой статье.

Очевидно, что весомо в эффектность генераций добавляет именно визуальный декодер, поэтому от его качества зависит очень много. Часто бывает так, что когда долго ищешь решение проблемы, оно приходит не сразу, но стоит немного отпустить мысль, как возникает какой-то новый путь. Получилось так, что на одном из регулярно проводимых в нашей команде ReadingClub мы делали обзор новой модели VQGAN - MoVQ: Modulating Quantized Vectors for High-Fidelity Image Generation [1]. Эта работа дала новую жизнь части модели, отвечающей за представление изображений в пространстве квантованных векторов.

Основное нововведение MoVQ заключается в добавлении слоя spatial conditional нормализации в блоки декодера, что позволило повысить реалистичность восстанавливаемых изображений. Сама идея spatial нормализации не новая и известна со времён StyleGAN и AdaIN слоёв, но авторы MoVQ применили её в пространстве квантованных представлений энкодера, что позволило избежать возникновения типичных повторяющихся артефактов, которые возникают из-за процесса квантования пространственно близких эмбеддингов в одинаковые индексы codebook. Использование spatial нормализации добавляет степеней свободы квантованным представлениям после энкодера и позволяет распространять по слоям декодера более вариативные представления эмбеддингов.

Приведённые в [1] результаты сравнения с известными автоэнкодерами показывают качественное преимущество по всем известным метрикам (PSNR, SSIM, LPIPS и rFID) на двух датасетах: датасет лиц FFHQ и датасет ImageNet (рисунок 2). Отдельно хочется обратить внимание на тот факт, что размер codebook (Num Z) для модели MoVQ самый маленький и составляет всего 1024 вектора. Следует также отметить, что визуально качество MoVQ по изображениям оценить крайне трудно, но далее я приведу примеры декодированных изображений обученной нами модели на самых сложных доменах для автоэнкодеров: лица и текст.

![Рисунок 2. Сравнение MoVQ с другими энкодерами [1] Рисунок 2. Сравнение MoVQ с другими энкодерами [1]](https://habrastorage.org/getpro/habr/upload_files/045/c35/d5f/045c35d5f34db1ed4862dda77d03e00a.png)

Впечатлившись результатами MoVQ, мы реализовали блок spatial нормализации в рамках нашей модели VQGAN, потому что технически эта операция была совершенно понятна и проста. Модель содержит всего 67M параметров, но результаты восстановления действительно не позволяют в большинстве случаев отличить декодированное изображение от исходного (groundtruth). Модель обучалась на 1 GPU в течение двух недель на данных LAION HighRes. Как и обещал, предлагаю оценить качество восстанавливаемых изображений на ярких примерах с декодированием лиц, текста и сложных сцен. В отдельной статье мы представим более подробное сравнение различных автоэнкодеров c нашей реализацией MoVQ.

Сравнение с другими Text2Image моделями

Далеко не все современные решения делятся результатам качественной оценки своих моделей, ведь куда важнее пользовательский отклик - это лучшая оценка работы модели. Тем не менее, мы как исследовательская команда не можем себе позволить обойти стороной вычислительные эксперименты на уже всем известных датасетах для валидации генеративных моделей. С точки зрения метрики мы всё также используем уже ставшую золотым стандартом оценки Frechet Inception Distance (FID), которая позволяет оценить близость двух вероятностных распределений (распределение оригинальных изображений и распределение синтезированных генеративной моделью изображений):

где r - оригинальные, а g - сгенерированные изображения.

Сравнение Kandinsky 2.1 и аналогичных решений мы проводили на датасете COCO_30k, который содержит 30 тыс. изображений с центральным кропом до 256x256 пикселей.. Измерять мы будем в режиме zero-shot, то есть датасет COCO не использовался при обучении модели. Полученные результаты (Таблица 1) позволяют утверждать, что Kandinsky 2.1 сделал большой качественный скачок относительно своих прошлых версий и вышел на уровень зарубежных аналогов, а некоторые из них даже превзошел. Среди известных решений модель Kandinsky 2.1 занимает уверенное третье место.

Таблица 1. Значения метрики FID генеративных моделей на COCO_30k

FID-30K |

|

eDiff-I (2022) |

6,95 |

Imagen (2022) |

7,27 |

Kandinsky 2.1 (2023) |

????8,21 |

Stable Diffusion 2.1 (2022) |

8,59 |

GigaGAN, 512x512 (2023) |

9,09 |

DALL-E 2 (2022) |

10,39 |

GLIDE (2022) |

12,24 |

Kandinsky 1.0 (2022) |

15,40 |

DALL-E (2021) |

17,89 |

Kandinsky 2.0 (2022) |

20,00 |

GLIGEN (2022) |

21,04 |

Генерации

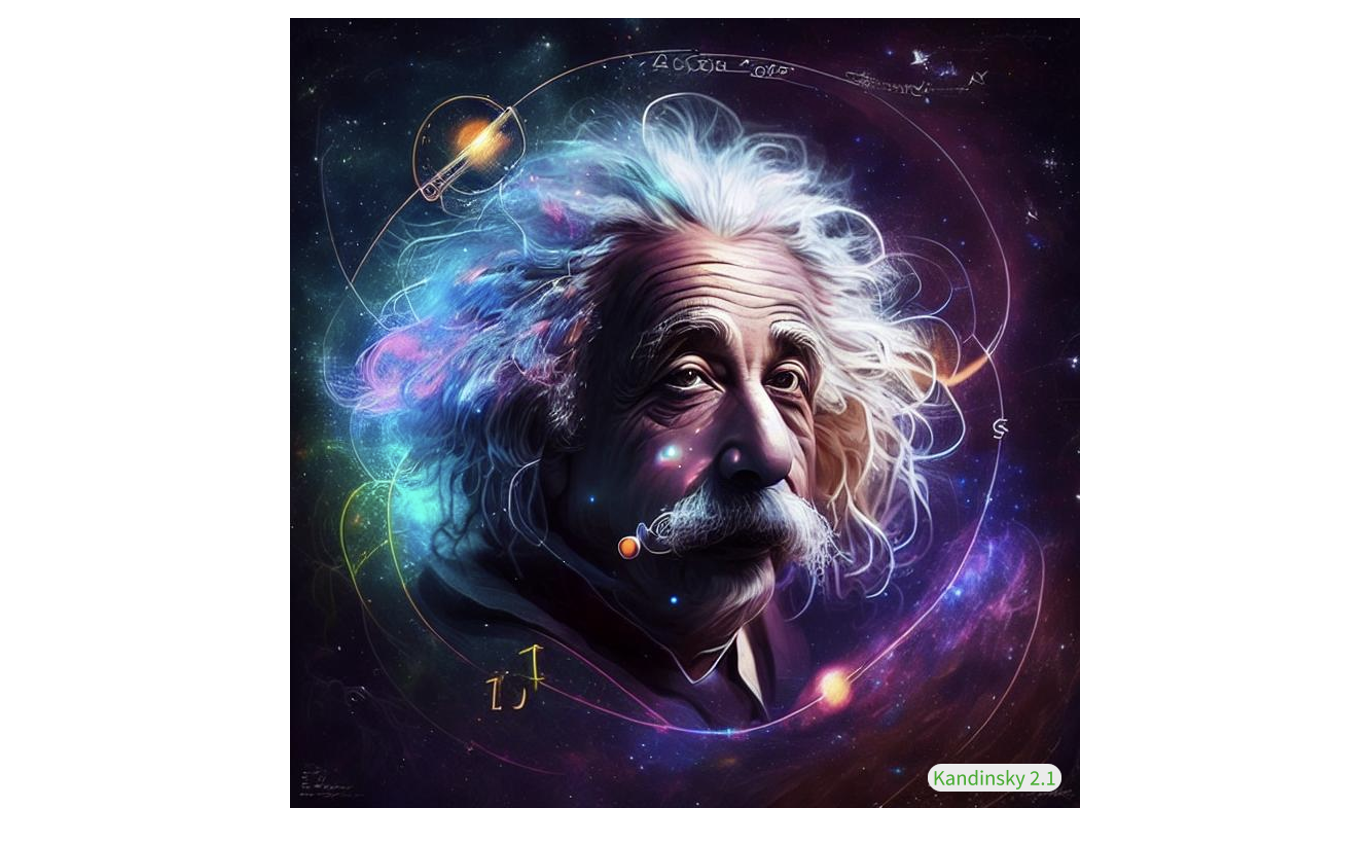

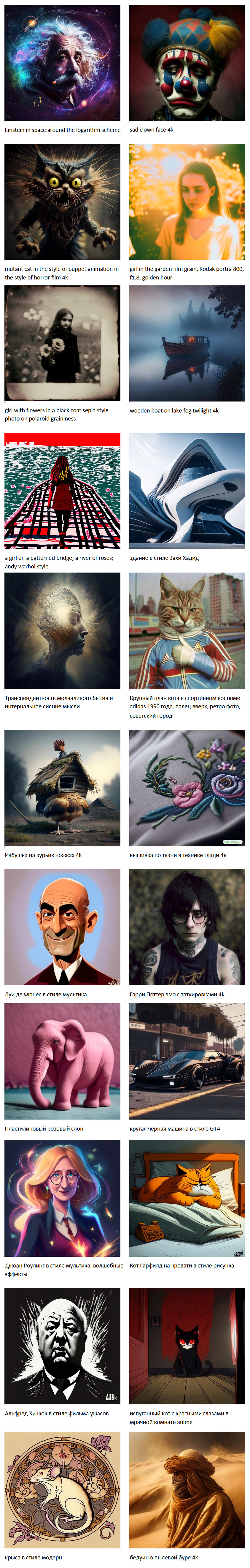

Синтез изображений по тексту

Смешивание изображений

В столбце слева находится изображение “стиля”, которое мы хотим перенести на исходное изображение посредством диффузии.

Синтез изображений, похожих на референсное

В столбце слева находятся оригинальные изображения, а остальные изображения - являются его вариациями, синтезированными с помощью диффузионной модели.

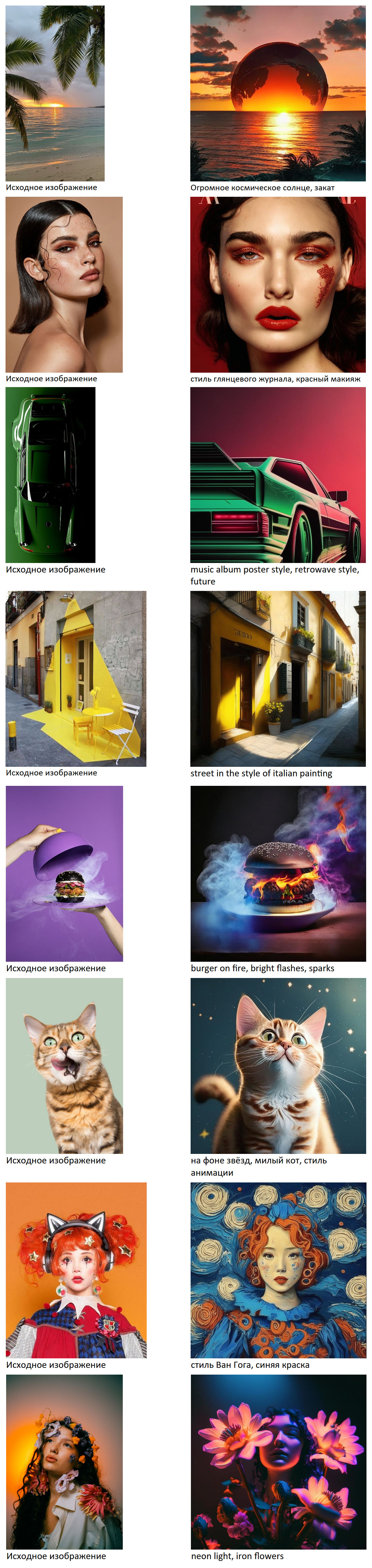

Изменение изображений по тексту

Слева показаны исходные изображения, а справа текстовое описание и результат изменения исходной картинки по этому тексту.

Telegram-бот

Обновленная модель Kandinsky 2.1 доступна для использования в новом Telegram-боте, доступ к которому можно получить по ссылке. В боте доступны 4 режима работы с моделью:

Синтез изображений по тексту

Смешивание изображений

Синтез изображений, похожих на референсное

Изменение изображений по тексту

При генерации изображений доступны 3 стиля:

artstation — сформирован в ходе файнтюна на наборе изображений с сайта artstation.com

4k — сформирован в ходе файнтюна на наборе изображений высокого разрешения

anime — сформирован в ходе файнтюна на наборе аниме‑изображений

Выводы и планы

В итоге: что можно считать ключом к успеху? Вряд ли возможно выделить какое-то одно сделанное изменение из описанных мною выше, именно их совокупность как в рамках архитектуры, так и в части подготовки данных для претрейна/файнтюна позволила получить очень впечатляющий качественный прирост генераций, а также мы успели решить несколько прикладных задач на базе новой модели синтеза:

смешивание изображений;

изменение изображений на основе текстового описания;

генерация изображений, похожих на заданное;

inpainting/outpainting на изображениях.

Что же дальше? Мы продолжим исследовать возможности нового энкодера изображений, общей архитектуры и будем работать над усилением (увеличением) текстового энкодера, а также проведём эксперименты с генерацией изображений в разрешении 1024x1024 и выше. Всё это и многое другое мы имплементируем в следующих версиях модели Kandinsky :)

Следите за новостями в каналах Градиентное погружение, CompleteAI и AbstractDL.

Авторы и контрибьют

Модель Kandinsky 2.1 была разработана и обучена исследователями команды Sber AI при партнёрской поддержке учёных из Института искусственного интеллекта AIRI на объединённом датасете Sber AI и компании SberDevices.

Коллектив авторов: Арсений Шахматов (*), Антон Разжигаев, Владимир Архипкин, Александр Николич, Игорь Павлов, Ангелина Куц, Андрей Кузнецов, Денис Димитров.

(*) - главный контрибьютор

Полезные ссылки

[1] Zheng, Chuanxia, et al. "Movq: Modulating quantized vectors for high-fidelity image generation." Advances in Neural Information Processing Systems 35 (2022): 23412-23425.

Комментарии (97)

Zara6502

04.04.2023 09:37+1Запрос: волна разбивается о прибрежную скалу, закат

Картинку пришлось средствами винды копировать с экрана, в интерфейсе Fusion Brain в буфер копировался белый скрин, а на диск сохранялся черный PNG.

kuznetsoff87 Автор

04.04.2023 09:37Спасибо, приняли. Если ошибка повторится, напишите пожалуйста здесь в треде

Zara6502

04.04.2023 09:37Russian DALL-E, 15 минут висит эта надпись, мне пора домой, так что не дождался )

"До готовности изображения осталось приблизительно: 1 мин. "

Firsto

04.04.2023 09:3715 минут висит эта надпись

осталось приблизительно: 1 мин

Прям как на стиральной машинке.

kuznetsoff87 Автор

04.04.2023 09:37Вчера были проблемы с бэкендом, команда внесла правки - стабильность выросла, скорость генерации снизилась до ожидаемой

recompileme

04.04.2023 09:37+4

ну кстати неплохо для базовой модели.. Единственное что SD комьюнити вытащило на уровень MJ а здесь кто будет тащить?

recompileme

04.04.2023 09:37-4у меня сердце разрывается, когда я думаю что на эти деньги и за это время можно было сделать на базе SD вместо того чтобы сделать свое, отечественное

turbowyrm

04.04.2023 09:37+22Унификация любых решений скорее будет приводить к стагнации, поэтому разнообразные подходы к решению одной и той же задачи помогают сообществу в целом двигаться вперёд - тут так же как с биоразнообразием - большее количество видов приводит к стабильности системы в целом.

Тут опять же можно вспомнить о разработке принципиально новых подходов к построению сетей - если бы все упирались только в одно решение, возможно мы бы никогда и не увидели диффузные модели.

Поэтому я считаю, что вы не справедливы к разработчикам - они своими "велосипедами" дают новые нотки всему ансамлю нейронок.

SinsI

04.04.2023 09:37И что же такое, по-вашему, можно было бы сделать на базе SD?

Там ведь больше проблема не в ресурсах, а в идеях - как сделать руки лучше? Как сделать сходную генерацию img2img для кадров из роликов? Как различать персонажей?

n0isy

04.04.2023 09:37+2А что не так с идеями? Развитие есть и очень большое. Допустим ControlNet на базе SD: можно нарисовать Doll-модель человека и позы, отдельно нарисовать положение рук и каждого пальца. И ты получишь именно то что хочешь.

И так далее. Каждый месяц есть существенное продвижение вперед.

kuznetsoff87 Автор

04.04.2023 09:37+1На самом деле этот проект не такой ресурсозатратный как был ruDALL-E в 2021 году, поэтому так сильно за деньги и время переживать не стоит. Мы сильно переработали архитектуру, сохранив преемственность от 2.0, добавив приор, новый vqgan и чистые данные - имхо, ничто не мешает комьюнити развивать это в условиях того, что модель бесплатная и в опенсурсе

Lucidyan

04.04.2023 09:37Для начала, нужно чтобы это комьюнити появилось. Про инструментарий и тематические ресурсы вроде civit я даже не говорю

recompileme

04.04.2023 09:37-2Забавно. Модели в SD и Кандинский выдают +/- одинаковое лицо на промпт "attractive stunning Ukrainian woman, messy bun"

https://civitai.com/images/393225

Обучение на одном и том же датасете не проходит бесследно.. Такая работа проделана колосальная.. Столько ресурсов вложено.. Для чего? Потому что можем? Ну, здорово, молодцы..

rPman

04.04.2023 09:37+8Возможно тут главный результат не модель, уровня SD, а опыт построения таких моделей. Чтобы сделать лучше, нужно научиться делать хотя бы так же.

logran

04.04.2023 09:37+1Единственное что SD комьюнити вытащило на уровень MJ а здесь кто будет тащить?

Справедливости ради — это скорее MJ вытаскивалась (и вытащилась) на уровень SD, ибо в момент выхода SD была MJ v2, сильно от него отстающая, MJ v3 была на самом деле SD, и лишь к v4 их собственная модель сравнялась с актуальной SD (а niji пожалуй обошла NAI), но скорее не за счет качества модели, а за счет скрытых твиков к промтам (что делает её малопригодной в качестве инструмента, а не игрушки).

v5 да, нынешнюю развитую sd 1.5 обошла. На счет SD 2.1 не уверен — тут скорее причина в том, что 2.х кастрированы и ими мало кто занимается (но даже то что есть — не уступает v5 при применении идентичных трюков к промтам)

BelBES

04.04.2023 09:37А есть какие-то инсайты на тему того, какой постпроцессинг для пользовательских промптов используется в MJ?

diogen4212

04.04.2023 09:37+2Не подскажете, вы обучали на датасете LAION до этой новости или после?

kuznetsoff87 Автор

04.04.2023 09:37-1Мы работали с датасетом LAION с момента его выхода в 2022 году, прикрутив туда много своих фильтров на описания и изображения

volt_amper

04.04.2023 09:37+6Хабраэффект похоже настиг, бот в ТГ глючит, хотя утром работал.

Киберпанк кот играет в шахматы

IgorRJ

04.04.2023 09:37+2Повторил запрос в статье с заменой одной буквы. Первая картинка: "интернальное", вторая: "инфернальное". Особой разницы не ощутил.

koshi

04.04.2023 09:37+3Да, похоже модель воспринимает текст весьма поверхностно, как слабо слышащий, не очень эрудированный человек, которых строит ассоциации по обрывкам слов.

Думаю, логичнее сделать промежуточный этап: запрос пользователя растолковывается продвинутой лингвистической моделью (ChatGPT), а результат уже идёт на вход генератора картинок.

mm3

04.04.2023 09:37+2мне просто интересно, когда случится чудо и для российских ML проектов появятся open source UI интерфейсы для локального запуска уровня stable-diffusion-webui? наличие примеров скриптов и соллаба это конечно хорошо, но требует некоторых специфичных навыков для получения первых результатов.

diogen4212

04.04.2023 09:37хотя бы скрипт командной строки с параметрами, который сохранял бы изображения на диск и очищал память видеокарты после завершения генерации…

И объяснение этих параметров не помешало бы..

Blacknote

04.04.2023 09:37https://gist.github.com/Blucknote/31f792621f4e4cdf0a7d2505ddd6b0a2

У меня получилось только так. В качестве основного venv'a использовал существующий от SD. Качать модель отдельно не нужно, скрипт сделает это сам.На RTX 3060 с 12Гб VRAM максимальный batch_size получился 2, больше -- cuda OOM.

Ширина прокатила 1368

Medeyko

04.04.2023 09:37+2Прогресс чувствуется, молодцы...

А можно ли будет локально запускать? И будет ли по свободной лицензией?

Blacknote

04.04.2023 09:37+1Да, можно запустить локально, для этого достаточно запустить pip install из readme github репозитория и запустить. Веса скачаются автоматически. На RTX 3060 довольно бегло бегает, жаль только какие-то проблемы с очисткой памяти по завершении генерации, накидал скриптик, который её не решает, но хотя бы поиграться

visirok

04.04.2023 09:37Я попробовал вот такое описание на русском и на английском: «Человек лежит на берегу моря, ногами к морю, головой к зрителю. День хороший, солнечный. Его колени согнуты. На коленях находится открытый ноутбук. Небо синее. По нему плывут облака. На облаках написаны математические формулы и куски программного кода.»

Получились такие уроды, что не буду травмировать публику и помещать результаты.

Вариация фото с козлятками тоже превратила их в уродов.

Что-то не так с моделью.

dimitrii_z

04.04.2023 09:37+3с котами может она и справляется, но с оленями и птицами (что выше видно по аистам) не очень. Математических знаков не знает вообще (по запросу "интеграл" рисует бесконечность упорно). База явно ужасная, до MJ как пешком до луны, серьёзно. А с длинным описанием вообще беда. Например:

лесной пожар, в воздухе дым и пепел, и между горящими деревьями бежит олень, и летят птицы спасаясь от огня А получилось нечто реально несусветное. Пробовал раз 20, и видно что картинок пожаров он знает очень мало, как и оленей, всё получается примерно в одном стиле и ни одного "здорового" оленя с нормальным числом ног, рогов и прочего. Один раз вообще создал мне оленя с задней частью из камней и двумя ногами, никаких кошмаров не нужно. А попсу всякую типа девушек и котов он кое-как генерирует, да... И то детали теряет, в отличие от MJ. Ну например:

молодая красивая учительница с указкой AI перевозбудился и до указки не дочитал или как? Но модель ничего такая. Причём она у него одна, 10 попыток и я получил одно и то же лицо в очках и без с немного разными ракурсами, и ни одной (!) с указкой! В общем такое.....

Mad__Max

04.04.2023 09:37А может вы когда смотрели?

Большая указка у нее на плечо (левое — для зрителя получается справа) положена.

Большая часть (как и руки ее держащие) за краем кадра, но в кадре есть ручка (задняя часть) указки прислоненная к плечу.P.S.

Модели у меня разные получаются по запросу такому. Но с руками (и иногда носами еще!) все еще беда больше чем в половине результатов (не считая тех, где они не видны/за кадром).

Denis1121

04.04.2023 09:37Кстати рисунок с горящими и летающими оленями выглядит шикарно. Он не отобржает действительности, однако я его долго рассматривали и смеялся.

ermouth

04.04.2023 09:37+3Улучшено очень существенно. Я месяц назад делал рисёч, сравнивал результаты разных публичных сервисов по не очень удобным запросам. Результаты ruDalle по запросу «Рыцарь с красным плюмажем на фоне заката, в стиле Рембрандта» месяц назад и сейчас отличаются как небо и земля:

Dr_Faksov

04.04.2023 09:37+2

Задано: Компания друзей. 3 надувные лодки.

kuznetsoff87 Автор

04.04.2023 09:37С множественными объектами сейчас как раз работаем - пока генерации не всегда удаются - нужно промт инжинирить

rPman

04.04.2023 09:37как выглядит такая работа, можете запилить статью или серию, как именно нужно менять исходный датасет или как до обучать модель чтобы решать такие проблемы?

Zara6502

04.04.2023 09:37Модель ruDALL-E Kandinsky нарисовала: молодая женщина стоит к нам спиной в белом платье в правой руке держит красный цветок в левой руке держит бокал с водой на фоне много облаков.

Утром таки обнаружил картинку, только вода красного цвета, цветок абстрактный (скорее опрокинутый стакан с молоком) и право и лево перепутано.

snakers4

04.04.2023 09:37Телеграм бот не работает. Отправил запрос на слияние картинок в 4:18, в 4:45 ответа всё ещё нет. Хотя вроде ночь, трафика не должно быть.

snakers4

04.04.2023 09:37+1Вопрос, а сколько ресурсов, например выраженных в видеокарто-днях было потрачено?

Dr_Faksov

04.04.2023 09:37Кандинский ваш, к стати, считать не умеет. Пишу "Великолепная восьмёрка - 4 парня и 4 девушки". Получаю то шестерых, то семерых.

axe_chita

04.04.2023 09:37+7Пока тут ещё сон разума, и он порождает в нейросети

чудовищкрипоту

Запрос: Алиса Селезнёва с миелофоном в руках

Выхлоп:

поперхнувшись воздухом, подправляем запрос: красивая девочка 11 лет Алиса Селезнёва с миелофоном в руках

Выхлоп:

пошел за успокоительным, выпил, выдохнул.

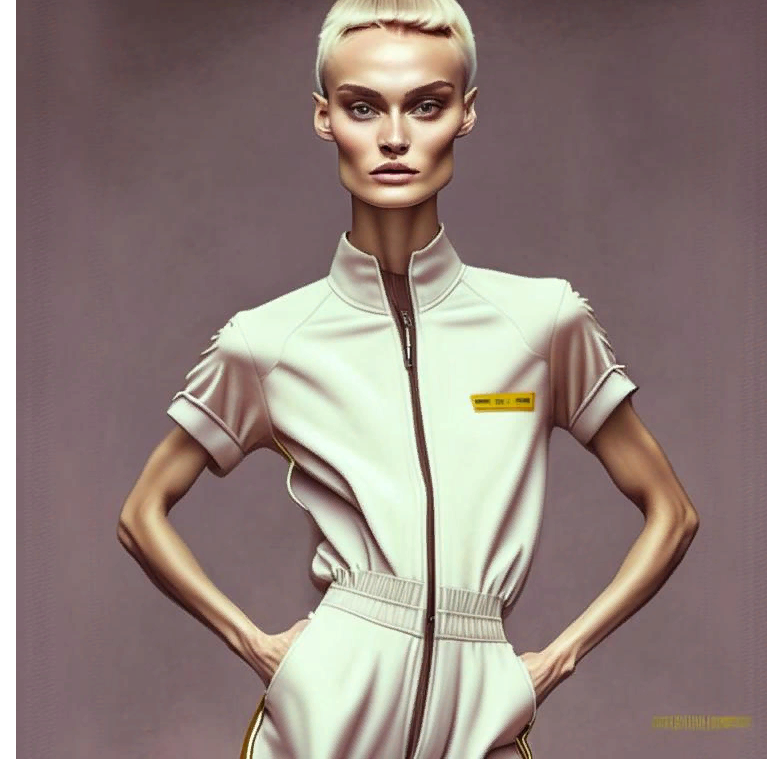

Поправил запрос опираясь на описание из википедии: Алиса Селезнёва, девочка высокого роста со светлыми короткими волосами и спортивного телосложения, одетая в комбинезон

Выхлоп айнц:

Выхлоп цвай:

Выхлоп драй:

И тут меня начали терзать смутные сомнения, что в качестве датасета для обучения нейросети использовались фотографии узников концлагеря.

axe_chita

04.04.2023 09:37+4Подозрительно, но ксеноморфы для нейросети гораздо ближе

Запрос: "ксеноморф собирает ромашки на поляне в лесу"

Выхлоп:

Раз

Два:

в стиле аниме

andy212

04.04.2023 09:37

девочка с красной звездой на папахе, с пулеметом дегтярева в руках в стиле khokhloma.

даже не знаю, в чем именно из запроса сетка попала в точку. и не девочка, а тетки. и папахи со звездой нет. и пулемет нифига не тот. и на хохлому не похоже. и самое худшее - звезды местами, не те, что предполагались.

не получит эта сетка госзаказов, ой не получит...

alisa_famina

04.04.2023 09:37+2На сайте fusionbrain.ai при скачивании картинки появляется рамка, захватывающая область картинки, которая будет скачана. Рамка появляется не в координатах 0,0, а смещённая. Надо понимать, это такая фича, чтобы показать пользователю, что рамка может двигаться и побудить его выбрать облатсть. Простите за прямоту, но решение бестолковое до боли. Двигая рамку мышью выставить её так, чтобы до пикселя захватить изображение полностью - вы сами-то пробовали? А я полагаю, что подавляющему большинству пользователей будет нужна вся картинка, а не фрагменты. Сделайте хотя бы так, чтобы рамка по дефолту появлялась в нулевых координатах. Или так, чтобы липла к краям картинки при перетаскивании. Что в этой стране с юзабилити, проклял её кто-то что ли7

UglukFearless

04.04.2023 09:37Очень крутой прогресс! Хотя, так и не смог понять как из интерфейса fusionbrain.ai работать с загруженными изображениями. Генерация по сравнению с версией 2 сделала огромный скачок вперёд!

okovalevski

04.04.2023 09:37Еще до начала хаброэфекта на сайте Сбера удалось за 20 минут получить картинку, интерфейс там кривой (итоговое изображение с рамочкой для сохранения результата) не совместить так как именно в этот момент блокируется смещение рамки. Сейчас видимо надо ждать уже часами результат.

masterKub

04.04.2023 09:37+2Круто. Неделю назад пытался для поста сгенерировать картинку и ничего подходящего не нашлось, пришлось MJ оплатить. А сегодня махом и в отличном качестве подобрал.

Искал вот идеи для логотипа одного проекта, и первая же картинка неплохо получилась:

andy212

04.04.2023 09:37+2Птичку жалко. Что у нее с одной лапкой случилось?

Mad__Max

04.04.2023 09:37На первый взгляд можно подумать что перелом от сильного удара об ветку. Но взглянув на 2ю лапку можно понять, что там на самом деле гибкие тентакли, поэтому перелом ей не грозит и "ни одна птичка в процессе не пострадала" (с).

avril_rocks

04.04.2023 09:37"аналогичных решений, названия которых слишком хорошо известны, чтобы их называть"

Кто-то видит логику в том, что-бы их не называть? Через года 3 могут быть уже совсем другие решения, а эти будут забыты. Я вижу только страх

AlexanderLifanov

04.04.2023 09:37Я не знаю, кто тренировал это, но за десяток попыток у меня была только одна относительно терпимая картинка. Не эта, правда :)

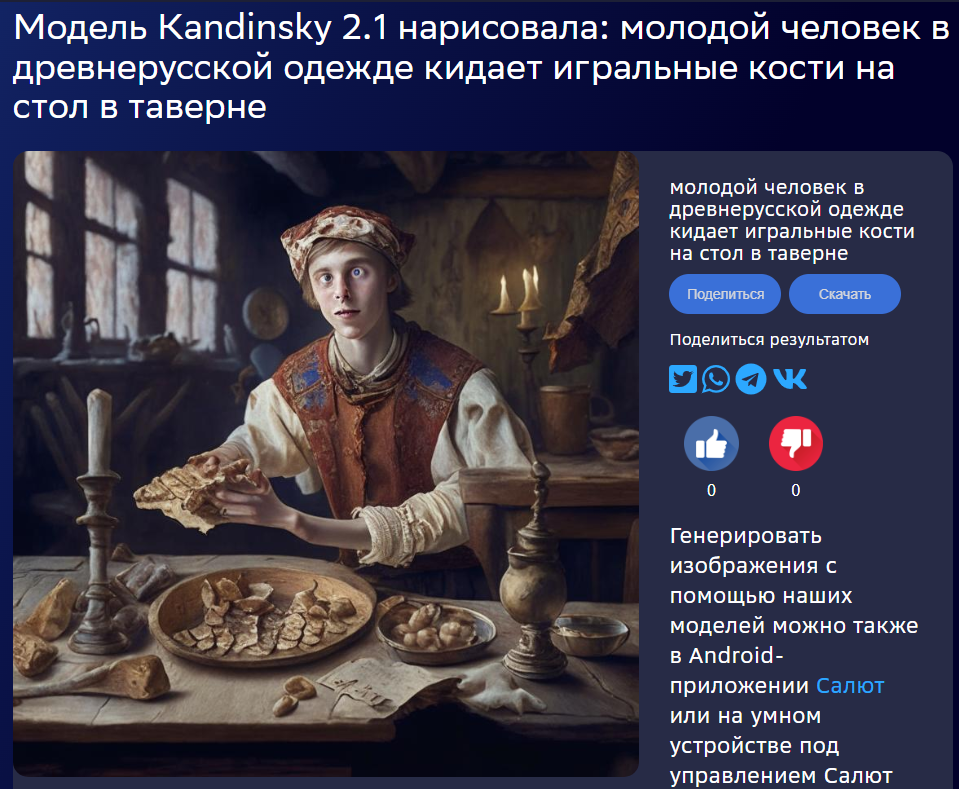

Но кто такой Иван-дурак - модель не знает :)

nellepost5

04.04.2023 09:37А как сделать так , чтобы твое фото в полный рост , дорисовывало например рядом собаку , кошку и .т.п , не изменяя человека с оригинального фото?

kuznetsoff87 Автор

04.04.2023 09:37Надо на FusionBrain.ai загрузить свою фотку и в режиме inpainting попробовать исправить ту область, которую хочется изменить

IvaYan

04.04.2023 09:37А какие стили поддерживаются? В телеге предлагается выбрать "один из поддерживаемых стилей", но какие поддерживаются не понятно. В справке (опять же в телеге) про стили нет ничего.

kuznetsoff87 Автор

04.04.2023 09:37Там если нажать кнопочку справа в клиенте TG, то покажутся несколько стилей - artstation, 4k, anime и без стиля

maxwolf

04.04.2023 09:37Андрей, расскажите, пожалуйста (для людей, понимающих общие принципы, но не погружённых в детали реализаций) про борьбу с "неестественностями" в генерируемых изображениях? Все эти лишние/кривые пальцы, ноги, глаза и т.п…

"Добавление слоя spatial conditional нормализации" — это оно? Если да, до тут spatial — в пространстве изображений, или в пространстве весов модели? Другими словами, вы просто дообучаете модель, чтобы она генерила статистически меньше лишних ног, или пытаетесь найти среди всех весов именно тот/те, что отвечают за количество ног, и работать именно с ним/ними?

kompas_3d

04.04.2023 09:37Как показать что мне нравится или не нравится результат? В прошлой версии были лайк и дизлайк.

Volgarik

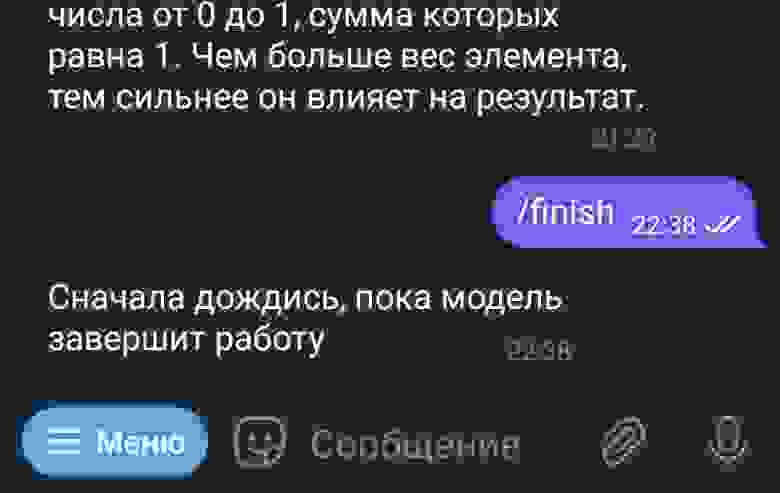

04.04.2023 09:37

Бот завис, уже несколько часов отвечает одно и тоже. У других работает. Как его жёстко остановить/перезапустить?

itmind

04.04.2023 09:37

Увеличил, что бы было лучше видно лицо. Этой сети только для ужастиков придумывать иллюстрации ). Ни одной картинки соответствующей моим запросам сеть не сделала.

axe_chita

04.04.2023 09:37+3Могу предположить, что нейросеть «напугалась» увидев в вашем запросе слова с орфографическими ошибками (басейн — бассейн, тенритории — территории), и начала «фантазировать» что бы значили эти неизвестные слова.

ZillahGiovanni

04.04.2023 09:37А почему у вас отсутствует negative promt, чтобы была возможность исключить уродства и т.д. в генерациях?

Kotokin

04.04.2023 09:37Два дня пытался запустить модель локально что-бы поиграться с русским, в итоге на гитхабе ответили разработки ответили "модель не работает на русском языке".

Что простите? Мультиязычная модель?

dmbozz

04.04.2023 09:37Сохранил с пробной страницы сгенерированные картинки (формат - только png без вариантов), так ни один из файлов не открывается ни в одном браузере (chrome,firefox), ни утилитами просмотра графики, типа XnView. Это бага или фича?

(генерить пробовал в Chrome и firefox, результат один)

dmbozz

04.04.2023 09:37Позднее разобрался. Так получается, если прямо на сгенерированной картинке открыть контекстное меню из него выполнить "Сохранить картинку как..." (зачем вообще это меню, если оно не работает).

А надо, оказывается, в правом верхнем углу нажать кнопку скачивания, натянуть появившуюся рамку на интересующую зону, и потом нажать на сине-фиолетовую кнопку внизу "Скачать"

riqik

04.04.2023 09:37Кто-нибудь разобрался как использовать негатив промпт в данной модели?

Blacknote

04.04.2023 09:37https://habr.com/ru/companies/sberbank/articles/725282/comments/#comment_25415752 но честно я не уверен что он работает

https://gist.github.com/Blucknote/31f792621f4e4cdf0a7d2505ddd6b0a2 накидыла скрипт, в котором можно передать аргументом

fisoon

04.04.2023 09:37На запрос Всадник на лошади:

Произошла ошибка при работе модели:( Попробуй, пожалуйста, еще раз

Zara6502

зашел на сайт rudall-e, написал текст, появилось что-то вроде каптчи, просят переместить слайдер, переместил - ошибка, ну думаю мало ли, переместил снова - ошибка. включил мозг, думаю тут какая-то фигня с подвохом, картинка была повернута на 140 градусов примерно, повернул ее до выравнивания - ок. а можно текстом написать условия успешного перевода слайдера?

kuznetsoff87 Автор

Передам коллегам, кто поддерживает сайт rudalle.ru. Спасибо!

Ox2A

Неплохо, похоже, что банк тренировочных изображений удалось импортозаместить)