В текущей реальности информационных технологий Docker стал неотъемлемым инструментом, переписывающим правила игры в области разработки и развертывания приложений. Docker — это на сегодняшний день самая популярная у айтишников платформа, используемая, чтобы быстро и эффективно создавать, доставлять и запускать всевозможные контейнированные приложения. Но давайте же разберемся, какова истинная роль Docker в современной парадигме разработки, и почему использование в этой разработке контейнеров стало не просто актуальным, но и важнейшим аспектом для разработчиков.

Определение: что вообще такое Docker

Docker — это средство, позволяющее паковать всевозможные приложения прямо вместе со всеми включенными в них зависимостями в стандартизированные контейнеры. Эти самые контейнеры легко и просто могут быть перемещены между разными средами разработки и продакшна, обеспечивая консистентность и надежность выполнения ваших приложений. Docker гарантирует изоляцию отличных процессов и ресурсов, что делает его мощным инструментом для создания, тестирования, а также развертывания всевозможных приложений в разнообразных сценариях.

Роль Docker в современной разработке

Итак, почему Docker стал неотъемлемой частью современного арсенала разработчиков? Первое, что бросается в глаза, — это преодоление проблемы «это у меня работает на моей машине». Docker обеспечивает консистентность сред разработки и продакшна, устраняя конфликты из‑за различий в окружениях. Благодаря этому вы сможете избежать ряда трудностей, которые связаны с переносом приложений и сэкономите время, затрачиваемое на разрешение конфликтов.

Важным аспектом является также масштабируемость. Docker обеспечивает гибкость в управлении ресурсами, автоматическую оркестрацию и возможность масштабирования в зависимости от потребностей проекта. Это сделало Docker незаменимым инструментом для создания микросервисных архитектур, где компоненты приложения могут быть легко масштабированы и обновлены независимо друг от друга.

Введение Docker в современную разработку смогло привнести не только консистентность и переносимость, но и существенно улучшило процессы разработки и последующего беспроблемного развертывания приложений. В следующих разделах мы более подробно рассмотрим, как создавать образы контейнеров и разворачивать приложения с использованием этой инновационной технологии.

Основы Docker

Обзор архитектуры Docker

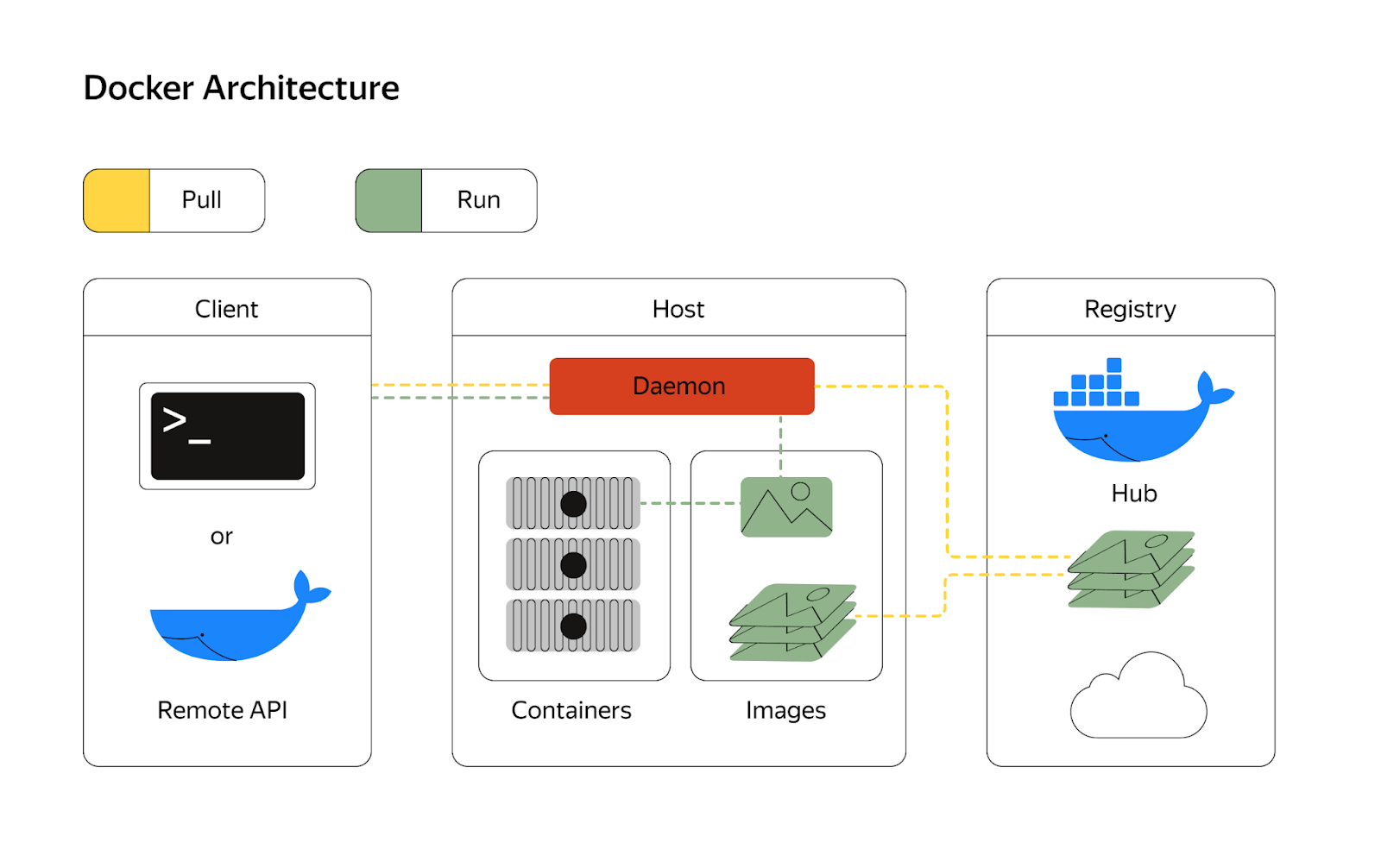

Прежде чем мы погрузимся в детали создания Docker‑образов, важно понять основы архитектуры этой платформы. Docker использует понятную клиент‑серверную архитектуру, где клиент общается с демоном (сервером) через REST API или с помощью командной строки. Демон управляет контейнерами, образами, сетями и другими ресурсами Docker. Эта архитектура обеспечивает модульность и позволяет эффективно управлять контейнерами на хосте.

Основным элементом являются Docker‑образы — это заранее подготовленные шаблоны, которые включают в себя все необходимое для корректной и быстрой работы приложения, включая библиотеки, сам код и все зависимости, а также произведенные настройки. Эти образы используются для создания контейнеров — изолированных исполняемых единиц, в которых запускается приложение.

Контейнеры vs виртуальные машины: различия и преимущества

В отличие от традиционных виртуальных машин, контейнеры представляют собой более компактное и производительное решение. Не в пример виртуальным машинам, которые включают в себя гипервизор, операционную систему и само приложение, контейнеры устроены иначе — они используют ядро операционной системы на хосте, что снижает изоляцию и потребление ресурсов.

Главным и неоспоримым достоинством использования в разработке контейнеров является, конечно, скорость запуска. Контейнеры могут быть запущены за считанные секунды, в то время как виртуальные машины требуют значительного времени на загрузку операционной системы и других компонентов.

Экономия ресурсов также является важным аспектом. Виртуальные машины требуют больше вычислительных ресурсов из‑за дополнительного уровня виртуализации, в то время как контейнеры используют общие ресурсы и изолируют лишь процессы приложения.

Контейнеры также, что немаловажно, обеспечивают более простую оркестрацию и управление масштабированием. Их легко масштабировать, запускать и оркестрировать с использованием самых различных инструментов, таких как Docker Compose и, например, Kubernetes.

Получается, понимание основ Docker и сравнение контейнеров с виртуальными машинами дает возможность разработчикам эффективнее использовать ресурсы, ускорять развертывание и обеспечивать более гибкое управление приложениями.

Создание Docker-образов

Шаг первый: Установка Docker и основные понятия

Начнем с того, что перед тем как приняться за создание ваших Docker‑образов, вам конечно же нужно заиметь Docker на рабочей машине. Процесс установки зависит от операционной системы, используемой на устройстве, и может быть найден на официальном сайте Docker. После успешного завершения установки важно ознакомиться с основными понятиями Docker.

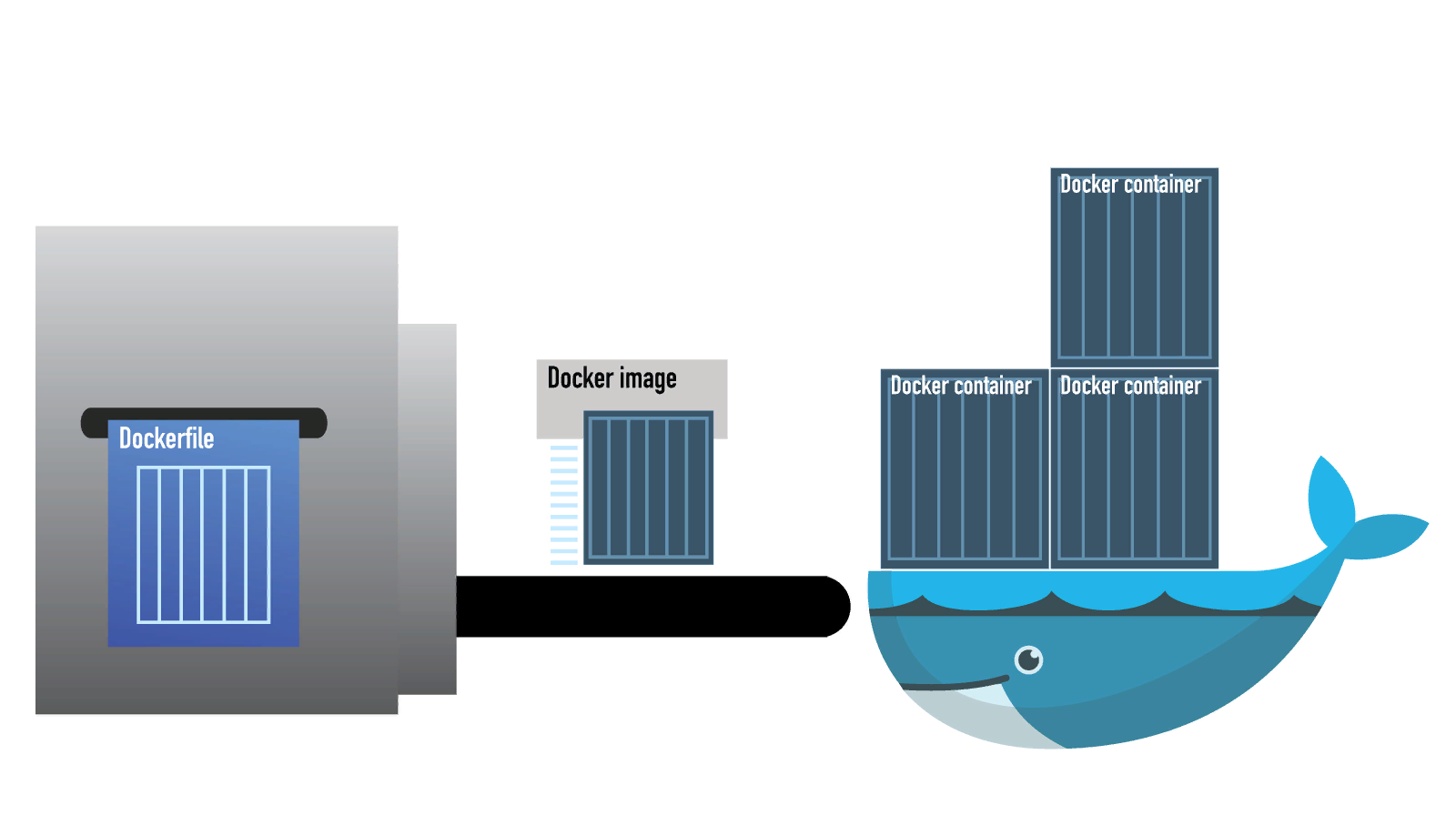

Ключевыми понятиями являются образы (Images) и контейнеры (Containers). Разберемся с точными определениями того и другого. Образ — это шаблон, содержащий все необходимое для запуска приложения. Контейнер — это экземпляр образа, который запущен и работает в изолированной среде. Понимание разницы между образами и контейнерами является фундаментальным для работы с Docker.

Шаг второй: Структура Dockerfile и ее ключевые элементы

Создание Docker-образа начинается с определения его структуры в файле, называемом Dockerfile. Dockerfile — это текстовый файл, содержащий инструкции для построения Docker-образа. Важно знать ключевые элементы структуры Dockerfile:

Базовый образ (Base Image): Указывает базовый образ, на базе которого и будет создаваться новый. Например, FROM ubuntu:latest.

Инструкции по корректной настройке зависимостей: Используйте инструкции, такие как RUN, для установки необходимых пакетов и компонентов в образ.

Копирование файлов: Инструкция COPY используется для копирования файлов из локальной директории в образ.

Установка переменных окружения: Инструкция ENV задает переменные окружения, необходимые для работы приложения в контейнере.

Эффективное использование этих элементов позволяет оптимизировать процесс сборки образа и минимизировать его размер.

Шаг третий: Эффективное использование инструкций Dockerfile

Освоив основы Dockerfile, важно обратить внимание на эффективное использование инструкций для оптимизации процесса создания образа. Инструкции выполняются последовательно, и Docker кеширует промежуточные результаты для ускорения сборки. Однако, при изменении инструкции, кеширование может нарушиться, что влияет на производительность.

Разумное разделение инструкций, установка зависимостей в минимальном количестве слоев и удаление ненужных данных в конце Dockerfile — ключевые моменты для создания эффективных образов.

Работа с образами контейнеров

Загрузка и обмен образами в репозитории Docker

После успешного создания Docker‑образа на локальной машине, встает вопрос его обмена с другими разработчиками или использования в развертывании на удаленных серверах. Для этого используются репозитории Docker, которые предоставляют централизованное хранилище для образов.

Чтобы загрузить образ в репозиторий Docker, используется команда docker push. Перед этим необходимо авторизоваться с учетными данными репозитория. Образ также можно загружать с репозитория на локальную машину с помощью команды docker pull. Это обеспечивает удобный обмен образами между разработчиками и поддерживает прозрачное обновление приложений в продакшене.

Версионирование образов: почему это важно

В мире разработки, где изменения — это норма, версионирование играет ключевую роль. То же самое относится и к Docker‑образам. Версионирование образов позволяет фиксировать состояние приложения в определенный момент времени, что важно для стабильности и воспроизводимости развертывания.

Образ можно пометить версией, используя теги. Например, myapp:1.0 или myapp:latest. Версионирование образов обеспечивает контроль над изменениями и управление разными версиями приложений.

Когда разработчику или системному администратору необходимо обновить приложение, они могут явно указать версию образа, избегая неожиданных изменений, связанных с обновлением до последней версии. Также это упрощает откат к предыдущим версиям в случае необходимости.

Версионирование образов — это практика, которая способствует стабильности и надежности развертывания.

Развертывание приложений с использованием Docker

Подготовка приложения для контейнеризации

Прежде, чем вы приступите к использованию в своей работе Docker для установки ваших приложений, вам следует правильно подготовить само приложение. Применение контейнеров дает преимущество, когда приложение разбито на части, что облегчает управление вложенными в него зависимостями и позволяет выполнять каждую часть изолированно. Каждая составляющая приложения должна быть готова к работе внутри контейнера.

Подготовка включает в себя:

Определение зависимостей: Убедитесь, что все зависимости приложения установлены и указаны в Dockerfile.

Конфигурация окружения: Приложение должно быть настроено для использования переменных окружения, что упрощает настройку в контейнере.

Логика контейнера: Разделите приложение на слои, что обеспечит эффективную работу с Docker‑образами.

Небольшой гайд по работе с Docker Compose: как управлять контейнерными приложениями

Docker Compose — это удобный инструментарий, позволяющий определять и запускать многоконтейнерные приложения. Он использует файл конфигурации YAML для определения сервисов, сетей и других аспектов приложения. Это позволяет определить структуру всего приложения в одном файле.

Процесс использования Docker Compose включает следующие шаги:

Описание сервисов: файл docker‑compose.yml содержит информацию о всех сервисах, которые нужны для функционирования приложения. В их число могут входить веб‑серверы, базы данных, кэш и т. д.

Конфигурирование сервисов: для каждого сервиса устанавливаются параметры, например, образ, порты, переменные среды и зависимость от других сервисов.

Запуск приложения: с помощью команды docker‑compose up Docker Compose создаёт и запускает все контейнеры, которые определены в конфигурационном файле.

Масштабирование и управление: Docker Compose предоставляет простой способ масштабировать приложение и управлять жизненным циклом контейнеров.

Использовать в своей работе инструмент Docker — это значит во много раз упростить для себя и команды процесс управления и развертывания многоконтейнерных приложений, делая процесс более гибким и масштабируемым.

Заключение

В заключение, рассмотрим основные выгоды использования Docker в современной разработке и взглянем на перспективы развития этой технологии в будущем.

Основные выгоды использования Docker

Портативность и консистентность: Docker обеспечивает создание образов, которые легко переносятся между средами разработки и продакшена. Это гарантирует консистентность окружений и устраняет проблему «работает у меня на моей машине».

Эффективность ресурсов: Если сравнивать контейнеры с классическими машинами виртуализации, то они характеризуются более легковесной архитектурой, благодаря чему ресурсы используются грамотно и эффективно, а все процессы развертывания протекают значительно быстрее.

Изолированное выполнение приложений: Контейнеры — это изолированное исполнение приложений, что гарантирует более высокую степень безопасности и предотвращает всевозможные конфликты между вложенными зависимостями.

Гибкость и масштабируемость: Docker поддерживает гибкость в управлении ресурсами, а также обеспечивает легкость в масштабировании и управлении многоконтейнерными приложениями.

Перспективы развития технологии в будущем

С развитием технологий и увеличением потребностей в гибких и масштабируемых решениях, Docker продолжает оставаться ключевым инструментом в арсенале разработчика. Ожидается, что в будущем появятся новые функциональности, улучшения в производительности и инструменты управления контейнерами.

Поддержка оркестрации, такая как Kubernetes, становится все более важной, позволяя эффективно управлять кластерами контейнеров. Безопасность контейнеров также будет акцентироваться, с улучшением инструментов анализа уязвимостей и механизмов изоляции.

В целом, Docker не просто современный инструмент, но и основа для создания инновационных и гибких решений в разработке и развертывании приложений. На фоне быстрого развития облачных технологий и микросервисных архитектур, Docker остается востребованным и будет продолжать влиять на ландшафт разработки в течение многих лет вперед.

Комментарии (20)

sYB-Tyumen

24.11.2023 12:37виртуальным машинам, которые включают в себя гипервизор, операционную систему и само приложение

Это когда в виртуальной машине есть гипервизор? Кроме экзотических случаев вложенной виртуализации, которым обычно не место в проде.

java_prog

Вижу список преимуществ, но не указаны недостатки использования контейнеризированного приложения в сравнении с обычным развертыванием на сервере приложений. Разве их нет?

iig

Оверхед, конечно же. Если один контейнер притащит за собой все свои зависимости, и другой тоже притащит свои, и у них окажутся разные версии - все это будет занимать место.

pavia

В чём здесь оверхед? Ты ставишь два приложения со своими зависимотями не в докере и получаешь тот же самый размер своих зависимостей, да еще конфликтующих друг с другом, вот где будет тебе твой оверхед.

iig

Ставишь не в докере - зависимости решает менеджер пакетов - обычно без конфликтов. Если одно приложение требует libssl, и другое тоже - если их установил пакетный менеджер - libssl будет та что в дистрибутиве, одна. И в память ее загрузят 1 раз.

Если одно приложение в одном контейнере живет с libssl1.1, а другое в другом с libssl3.0 (это же docker, так можно) - будут установлены обе, каждое в своем контейнере. Будут занимать место и на диске, и в памяти.

AlexGluck

Если апп1 требует либссл1, а апп2 требует либссл3, то менеджер пакетов не сможет разрешить конфликт. В вашем кейсе не верно описаны минусы.

Ключевой минус контейнеризации повышение сложности и следовательно повышение требований к квалификации, а большая квалификация требует больших расход на поиск, найм и удержание, а так же ФОТ. Однако в 99% случаев выгоднее более квалифицированные кадры для повышения эффективности, но возможно такие кадры экономически оптимальней было бы делегировать на частичный аутстаф.

iig

Если и app1 и app2 ставятся менеджером пакетов - они либо установятся без конфликтов, либо не установятся никак. Если каждое приложение в своем контейнере - может быть по всякому, в том числе и вот так.

Acidter

"никак" - это как раз одна из тех проблем которая решается с помощью Docker

iig

Эту проблему научились решать в Windows лет 20 назад, когда научились устанавливать .dll не только в c:/windows/system32.

Acidter

Да, для решения двадцатилетней давности это было неплохое решение, хоть имело один плюс и множество минусов.

panteleymonov

А раньше было святое правило: Если ты обновил версию либссл1 до версии либссл3, то работа приложения с либссл1, должна поддерживаться и в либссл3. И никакие докеры не нужны.

AlexGluck

Только приложение апп1 ты купил в рога и копыта, а они закрылись и у тебя нет исходников. Ну или не закрылись, а цену поставили х10 за обновление и уже экономически не выгодно обновлять. А предыдущая версия апп1 не поддерживает либссл3 потому что там ABI изменился.

iig

Оно и сейчас есть. Только его не всегда придерживаются. И что тогда делать, если одно приложение перешло на ssl3, а другое остановилось на ssl1.1? docker позволяет просто запустить каждое приложение в его собственном окружении, без dll hell.

Paulus

Конечно же есть. Кастомизация например

sYB-Tyumen

Например, тут же была статья о том, как контейнеры "подрались" за системный вызов ядра. Одна из библиотек, включенных в контейнеры давала большое количество обращений к системному вызову, который ядро не могло в таких количествах (когда много контейнеров сразу запустили) обработать. И поиск проблемы в таком случае был весьма нетривиален. Ибо нагрузки на CPU нет, а тормозит всё так, будто он под максимальной нагрузкой.

Upd: почему-то умудрился промахнуться мимо ветки с вопросом о недостатках

iig

O_o

top, iotop, etc. Процессы в контейнерах - самые обычные процессы. Только мониторить нужно не изнутри контейнера ;)

AlexGluck

Нет, надо именно с хоста мониторить, а ещё нагрузка на цпу есть и можно увидеть если смотреть потоки ядра или косвенно через wait и\или steel.

sYB-Tyumen

И увидеть, что нагрузки нет, а тормоза есть. Если я правильно помню, то авторы выловили проблему, используя eBPF для сбора статистики использования системных вызовов с хоста, где проблема есть и где нет. Обычные инструменты показывали, что всё хорошо, что на хосте, что внутри контейнера.

Sap_ru

Обновление версий софта весьма интересный процесс. Сложно/невозможно обновлять версии "на лету". Большее время простоя. Возможно запаздывание обновлений, устраняющих критические уязвимости. Некоторый софт и вовсе может не обновлять какие-то библиотеки и существовать с критическими уязвимостями годами.