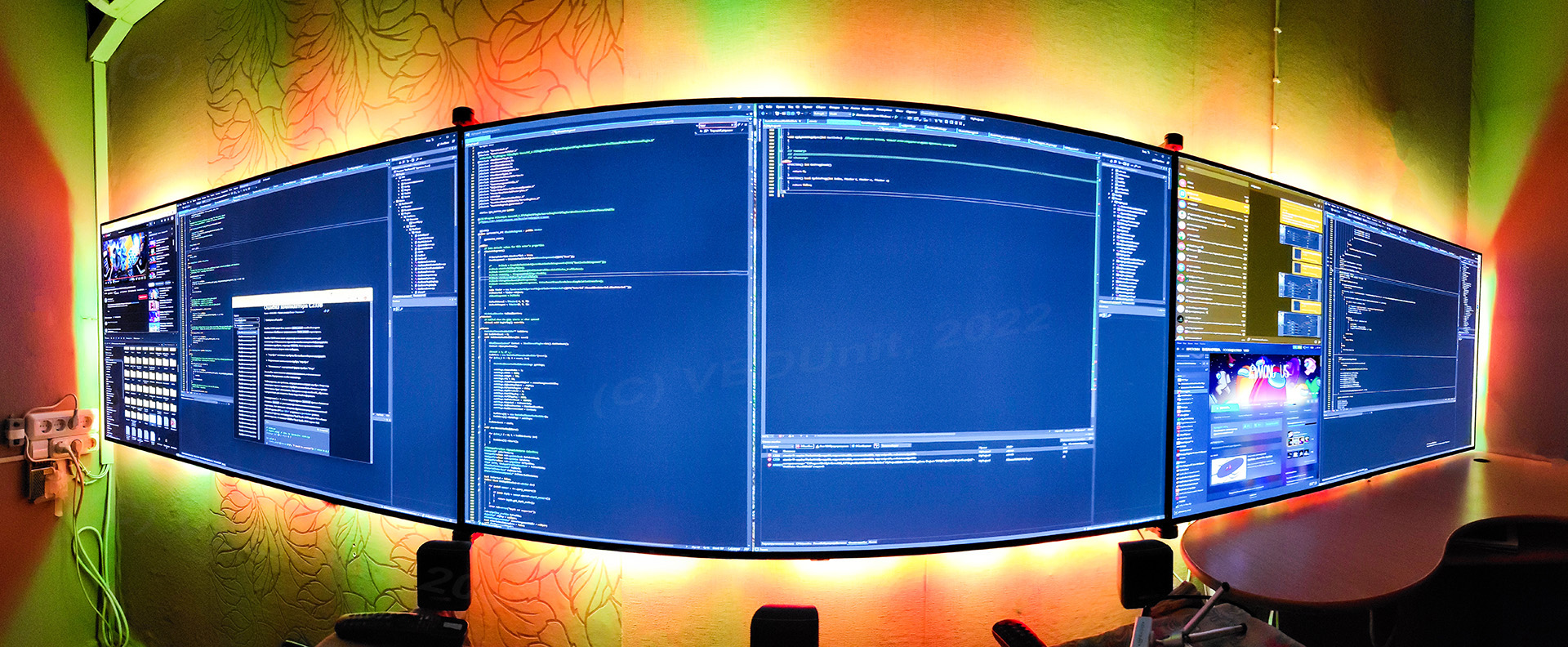

Однажды я подбирал себе новый монитор и немного увлёкся. В итоге, собрал чудище во всю стену из трёх телевизоров с ядерной 2318-зональной подсветкой 40000 люмен на STM32.

Зачем?

Сейчас, в 2022, когда подбираешь экран для максимального погружения, приходится выбирать между мониторами-сосисками 32:9 и телевизорами: производители внезапно и неожиданно заметили, что иногда телевизоры используют для игр, и стали пихать туда игромониторные функции. В первую очередь - это отключение всяческих улучшателей, уплавнялок и других функций: благодаря этому, картинка выводится оригинальная, плюс уменьшается задержка вывода изображения. И если качество картинки у такого телевизора хорошее (привет, OLED/QLED), то чем он тогда не монитор?

Для расширения обзора существует ещё вариант с тремя мониторами, который, из-за появления в продаже экранов 32:9, теряет популярность. В итоге ты выбираешь - либо у тебя экран большой, либо обзор.

Если говорить только о работе за ПК, без каких либо игр - то тут проблем нет, мы можем поставить кучу разных экранов, поворачивать их вертикально и размещать как угодно, расширяя место на рабочем столе столько, сколько нам нужно. В этом плане 4K и 8K телевизоры также хороши - они дают большую площадь рабочего стола без рамок и отличное качество изображения. Мы можем просто взять кучу хороших телевизоров и разместить их, как захочется.

Но вот с играми сложнее - игр, которые сознательно могут использовать несколько экранов, единицы. Исчерпывающее большинство игр работает только с одним монитором. Поэтому, у нас выбор - или один большой телевизор, или мониторососиска.

А есть ещё один вариант - три одинаковых экрана + специальный софт.

В этом случае, обычно, объединяют экраны в один виртуальный, и игра по-прежнему думает, что она запущена на одном мониторе, правда, очень-очень длинном, а драйвер-обманщик раскидывает картинку на три физических экрана. В 3D играх, при этом, картинка будет рендериться с очень большим углом обзора, и края картинки будут растянуты. Это немного непривычно, но не критично - когда играешь на трёх экранах, ты смотришь в центр, а боковые экраны отвечают за периферическое зрение. Хотя, конечно, если приложить усилия, растянутость и другие искажения картинки можно тоже убрать.

Если хочется и панорамности, и размера, и качества - то тут только три телевизора. Потому что мониторососисок с диагоналями 100-200 дюймов в продаже просто нет. Да и они бывают только с соотношением сторон 32:9, шире не выпускаются. А мы хотим 48:9.

Это не первая трёхэкранная конфигурация в моей жизни - до этого я сидел за тремя 24 дюймовыми TN-мониторами, которые умели в стереоскопическое 3D. Как и 120 Гц, три монитора - это хорошо, и отвыкать от этого уже не захочется. Правда, новое железо, к сожалению, не умеет в стереоскопию (есть желание это исправить, правда, занятие обещает быть по сложности и боли сопоставимым с созданием подсветки).

Один из ключевых моментов - нынешние ТВ могут в задержку ~5 мс и честную частоту обновления 120 Гц. Человеческому глазу, конечно, достаточно 24 Гц, но увидеть мы можем и 1000, и даже 10 000 Гц, поэтому 120 Гц - весьма хорошая функция.

Три телевизора дают возможность получить максимум реализма, атмосферности и погружения, который можно получить без VR. Виртуальная реальность, при всех её бесспорных плюсах, на текущем уровне развития, имеет и минусы - ужасный угол обзора и пикселизацию. Плюс на тебе постоянно надеты всякие штуки. То качество, чёткость и углы обзора, который дают три 4K OLED HDR телевизора, даже близко не достижимо современными гарнитурами VR, к сожалению. В будущем, разумеется, эти минусы сойдут на нет, но пока этому препятствуют не только дисплейные технологии (хотя на горизонте маячит MicroLED), но и производительность видеокарт. Иными словами, три телевизора с подсветкой - не хуже и не лучше VR, это как-бы отдельная, параллельная ветка эволюции. VR погружает тебя самого в виртуальный мир, а эта механическая простыня - всё помещение целиком, вместе с содержимым. На мой взгляд, в будущем, VR сможет это всё вытеснить, хотя появление голографических дисплеев этому будет противодействовать.

В общем, у меня получилась механизированная HDR-видеостена на 11520х2160 пикселей с суровой двухконтурной подсветкой на 2318 независимых зон - она очень яркая и светит не только в стену, но и в пол, потолок и боковые стены. Заливает светом всё, до чего дотянется. По совместительству, эта подсветка - мой HelloWorld в мире контроллеров.

Краткие ТТХ

Экраны

3 x LG OLED C1 (4K 120 Hz HDR 10bit RGB HDMI 2.1)

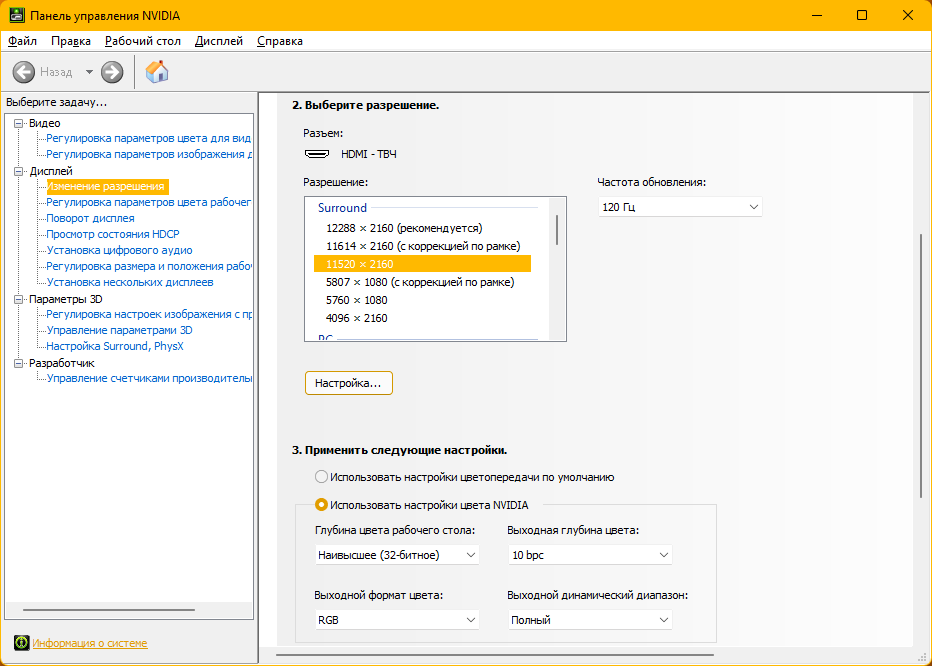

Объединены в цельный виртуальный экран

Суммарное разрешение: 11520x2160

Экраны установлены на специально спроектированных кронштейнах

Время парковки/полного открытия боковых экранов - 12 сек, можно управлять независимо, можно двигать руками. Когда двигаются, громко стрекочут шестернями и бесят. Думаю, как решить проблему.

Подсветка Ambiknight

Ленты RGB (не RGBW) WS2812b, 144 диода на метр, без влагозащиты (охлаждение важнее)

Независимых зон подсветки: 2318

Пиковая яркость: ~40 000 люмен

Максимальное энергопотребление: ~440 Вт

Два контура. Один светит назад, второй в стороны. Подсветка может создавать градиенты от пола до потолка, например, имитировать зарево

Число цветов: 16,7 млн (8 бит/канал, RGB)

Максимальная частота обновления: 40 Гц (производитель говорит до 30, но по факту работает 40)

Число физических сегментов лент: 36

Число отдельно управляемых лент: 17 (некоторые сегменты цепляются друг за друга и работают как 1 лента)

Контроллер: STM32F072RB Discovery (да, я уже в курсе, что надо BlackPill :3 )

Питание: три блока по 5В 40А, каждый отвечает за подсветку на своем экране

Ленты размещены на специально спроектированных рамах

Как работает

Телевизоры подключены по оптическим HDMI кабелям к ПК через специальные переходники, и объединены драйвером видеокарты в единый виртуальный монитор. Игры разворачиваются на все три монитора, окна программ - нет, т.к. драйвер кое-что меняет в поведении Windows + я использую софтину FancyZones/PowerToys чтобы поделить экран на 40 виртуальных областей и раскидывать по ним окна. В итоге и работать, и играть хорошо. Кино разворачивается на весь экран, насколько это для него возможно - есть мысли проработать этот вопрос нейросетями или чем-нибудь в таком духе.

За управление приводами кронштейнов отвечает отдельный выделенный контроллер. С помощью хоткеев, GUI или пультов можно регулировать углы поворота боковых экранов - вместе или по отдельности. При запуске боковые телевизоры сами открываются, при выключении, или когда запускается экранная заставка - паркуются вдоль стены. Пока активна экранная заставка, подсветка плавно приглушается.

Ленты стоят на специально изготовленных рамах из алюминия. Неожиданным оказалось то, что моделил я эти рамы гораздо дольше, чем кронштейны для экранов, хотя рамы, как бы, вообще не шевелятся, и должны быть простыми. Пару железяк даже пришлось печатать - интересный кейс. Подсветка хорошо работает при любом расстоянии до стены, и суммарно заполняет почти половину поверхностей в комнате, остальное покрывает отражённый свет. Контуры - дальний и ближний - работают независимо.

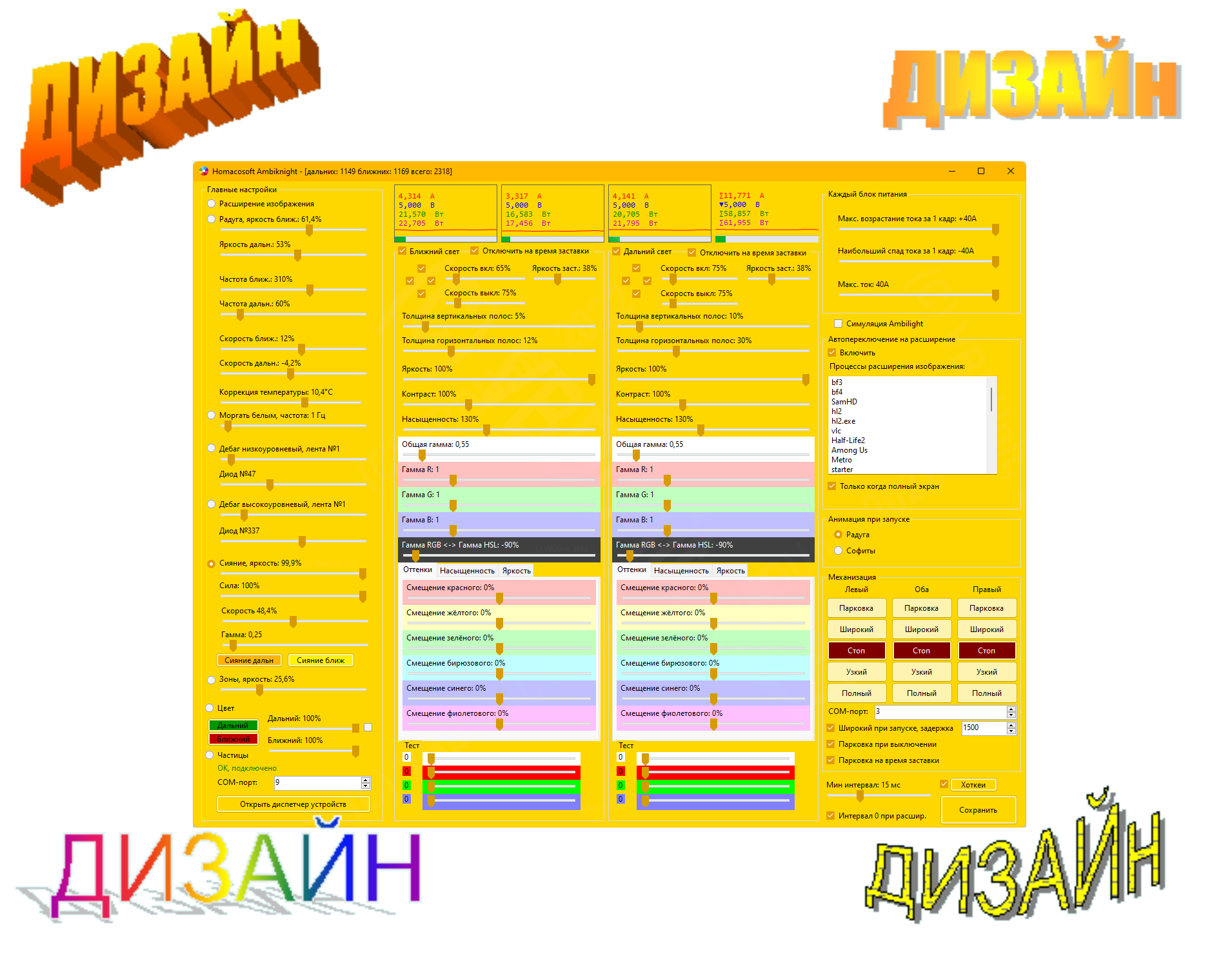

Концептуально, работает подсветка по классической схеме: на компе стоит софт, он анализирует картинку на экране и формирует данные для контроллера - какой цвет должен быть у каждого из 2318 диодов. Эти данные через гальваническую развязку по длинному USB проводу отправляются в STM32, а он уже раскидывает данные на 17 лент параллельно через DMA по коаксиальным проводам - и так 40 раз в секунду. Один контроллер централизованно обслуживает ленты на всех трёх оледах.

Поскольку это мой первый раз с контроллерами, подсветка - это много-много боли. Софт на компе и прошивки контроллеров пришлось делать полностью с нуля: всё, что существует готовое, вплоть до библиотек работы с лентами, не подходит под пару тысяч диодов и разрешение в 25 мегапикселей, не говоря уже о всяких готовых коробочках и приложениях.

Пробовал Arduino, потом Rasberry Pi 4B, писать драйверы под линукс со всякими блокировками прерываний, думал уже ставить RTOS или вообще руками на FPGA расшифровывать HDMI 2.1, или посадить каждую ленту на свой контроллер с WiFi и через отдельный роутер ими управлять. Но всё-таки, у меня не получилось так жестко тупить длительное время, и однажды я решил всё же попробовать STM32. Плюс ещё много проблем по питанию - больше 80 ампер как-никак. Сжёг 5 контроллеров и пару лент, припаял пару сотен проводов и уничтожил тонны канифоли с припоем. В конце концов, оно заработало.

Когда работаешь, подсветка не расширяет изображение, а просто выводит всякие плавные спокойные штуки - градиенты, радуги-переливы, вот это всё, чтобы не отвлекать. Запускаешь игру/кино/шейдер - тогда уже активируется анализ картинки.

В софте, по мере эксплуатации, я наделал кучу настроек для цветокора отдельно дальнего и ближнего цвета, и, разумеется, божественный дизайн, потому что делал для себя и по-быстрому :)

Написано на C#, для захвата используется DirectX OutputDuplication, потом картинка уменьшается в 400 раз через Direct2D, потом переходит в ОЗУ, дальше картинку подхватывает и крошит туча очень оптимизированного и многослойного unsafe кода, по итогу отправляет пакетик в 6954 байт по виртуальному COM-порту на 6 млн бод в STM32, оттуда через DMA всё разлетается по лентам. CPU оно не грузит (поэтому C++ тут нет), а вот видеокарте, всё равно, приходится несладко.

Тут важно понимать - оно не просто должно успевать переваривать более 750 мегапикселей в секунду - оно должно это делать в фоне, чтобы не мешать компу делать основное дело.

Конец 1 части

Заключение

В ходе постройки этого компа пришлось делать много разных штук из разных областей: подбор телевизоров, выгорание OLED, пляски с подключением, проектирование и изготовление рам и кронштейнов, механизация, пайка, мистер Улитка, электроника, программирование, монтаж, высокопрочные куры-гриль, прошивка контроллеров, работа с DirectX и создание драйверов под линукс, 3д печать по металлу и ещё много всего - чем глубже в лес, тем толще партизаны.

Если хабрасообществу данная тема покажется интересной, то могу раскрыть её подробнее в следующих частях.

Комментарии (106)

Dreablin

22.07.2022 00:42+7А глаза не устают от этого всего?

Я всегда думал (лет 10 назад, когда сравнивал вариант телевизор vs монитор), что телевизоры делают чтобы на них издалека смотреть, а мониторы чтобы вплотную. И вот из-за разности в ТЗ там по разным параметрам оптимизация и идет. И поэтому телевизор с расстояния 1-1.5 метра всегда будет хуже монитора...

VBDUnit Автор

22.07.2022 01:16+4Глаза наоборот тут отдыхают.

10 лет назад так и было из-за зернистости картинок, то есть больших пикселей. В современных 4К и 8К телевизорах пиксели достаточно маленькие, чтобы можно было сидеть близко. Ещё плохо глазам может быть потому, что там может быть мерцание, плохой спектр, не совсем честная матрица (pentile бывает и в телевизорах). Конкретно данные телевизоры имеют все нужные характеристики, чтобы глазам было комфортно, плюс специальную функцию, которая отключает все типовые для телевизоров обработки картинки, снижая задержку и выводя почти исходную картинку.

SlFed

22.07.2022 00:55+3Обалдеть сколько труда вложено!

А со звуком как поступил ? Неужели только маленькие колонки на столе ?

VBDUnit Автор

22.07.2022 01:17+3Их на самом деле 5 - там две ещё сзади и сабвуфер на полу. Со звуком тоже есть мысли собрать кастом, но беда в отсутствии достаточного количества многоканального контента.

Ndochp

22.07.2022 09:13+2Вся статья была о качестве погружения в игру и периферийное зрение. Неужели источник картинки для периферийного зрения не дает многоканальный звук?

VBDUnit Автор

22.07.2022 10:02+1Речь не просто о многоканальном звуке, речь о достаточно многоканальном звуке :) Сейчас у меня система 5.1 с неплохой звуковой картой. Если её менять, то менять на что-то современное - а это DolbyAtmos. Это очень-очень хорошая технология, но она только сейчас начинает внедряться в игры. Все старые игры, хоть потенциально и имеют всю необходимую информацию для него, на деле поддерживают максимум 7.1, а часто - всего лишь 5.1.

Ndochp

22.07.2022 10:11Ясно, я думал в плане замены

Неужели только маленькие колонки на столе ?

на что-то большее, но в том же формате аудио, что вы это не делаете, так как все равно в эти каналы источников нет.

VBDUnit Автор

22.07.2022 14:43Хорошая мысль - вероятно, пока контента нет, можно позволить себе остаться на системе 5.1

В плане сохранения числа каналов, но улучшения качества, я думал в сторону какого-нибудь ресивера + набора хороших спикеров. При этом, желательно, чтобы у ресивера как можно больше качества и как можно меньше функций - при работе с ПК они не нужны.

Саундбар тут, к сожалению, ставить нельзя, т.к. для него нужно находиться от стены на расстоянии как минимум полтора-два метра.

kasthack_phoenix

22.07.2022 01:26+5750 мегапикселей в секунду

вот видеокарте, всё равно, приходится несладко.Разница заметна, если подсветка обновляется с меньшим фреймрейтом?

Почему там нагрузка? Я несколько лет назад писал небольшую софтинку для записи таймлэпсов, захватывал изображение похожим образом, просто делая по документации, и на ноутбуке со встроенной интеловской карточкой выходило 100+ fps при двух подключённых 4K мониторах, когда бенчмарки гонял. На полноценной современной карточке вообще заметных эффектов не должно быть от захвата 30fps.

VBDUnit Автор

22.07.2022 01:34+4Очень интересно. У меня работа подсветки сажает фпс где-то на 10-15%, иногда даже 20%. Я делал профайлинг захвата картинки, там больше всего кушает именно функция TryAcquireNextFrame. Полагаю, причина этого может быть не в коде, а в общей конфигурации - версия драйвера, тот факт, что это виртуальный экран, слишком большая ширина картинки. Плюс видеокарта и так испытывает зверскую нагрузку, а ей ещё и экран захватывать. Или, банально, что это Windows 11 - она сама по себе неспешная :)

По фреймрейту - самая главная проблема низкого фремрейта - это то, что он автоматически означает увеличение задержки, а вот она, во всяком случае, в играх - плохо. Дискретное переключение ниже 30 к/с тоже даёт о себе знать на фоне сравнительно плавной картинке на экране.

Coriolis

22.07.2022 15:21+2Не не, тут похоже дело в том что встроенная карточка работает на основной оперативке и перегон из "видеопамяти" в основную - мгновенный. Похожий эффект наблюдал при захвате, на ноуте летало а на большом брате как-то не очень.

VBDUnit Автор

23.07.2022 23:04Хм. А разве TryAcquireNextFrame копирует в оперативку? Я думал оно остаётся в видеопамяти - именно поэтому я уменьшаю картинку при помощи Direct2D, а потом уже копирую в ОЗУ.

Если оно и так само копирует, то тогда уменьшение - это дополнительное копирование обратно в GPU + нагрузка в виде самого уменьшения. В этом случае, надо вообще не уменьшать и алгоритм CPU переработать.

lgorSL

22.07.2022 01:39+2В 3D играх, при этом, картинка будет рендериться с очень большим углом обзора, и края картинки будут растянуты.

Это нормально, для игры монитор как будто один и плоский, боковые мониторы не надо поворачивать и лучше оставить вдоль стены. Тогда "растяжение" края картинки будет компенсироваться перспективным искажением от того, что тот край далеко и видно под углом.

Я только в Euro Track Simulator нашёл честный режим, в котором для каждого монитора отдельная камера - вот там боковые мониторы действительно можно повернуть к себе.

P.S. Советую ещё подключить руль с педалями и в гонки поиграть, на трёх мониторах совсем другие ощущения.

VBDUnit Автор

22.07.2022 10:40+3Это нормально, для игры монитор как будто один и плоский, боковые мониторы не надо поворачивать и лучше оставить вдоль стены. Тогда "растяжение" края картинки будет компенсироваться перспективным искажением от того, что тот край далеко и видно под углом.

Да, если ставить вдоль стены, то искажение почти уходит. Но и погружения тоже становится меньше) Чем сильнее открываешь боковые экраны, тем сильнее искажения, но больше эффект присутствия. Если их ставить почти под 90°, то погружение максимальное, т.к. боковые экраны вообще заканчиваются уже за спиной. Искажения ужасные, но к ним можно привыкнуть.

Я только в Euro Track Simulator нашёл честный режим, в котором для каждого монитора отдельная камера - вот там боковые мониторы действительно можно повернуть к себе.

P.S. Советую ещё подключить руль с педалями и в гонки поиграть, на трёх мониторах совсем другие ощущения.

Всячески поддерживаю. Там на столе переключатель КПП не просто так стоит :)

serge-sb

22.07.2022 13:04Не могли бы вы поделиться инфой про этот честный режим ETS2/ATS? Насколько мне известно, штатно, из интерфейса, это не настраивается.

Lutra90

22.07.2022 05:42+1Проектор не подходит?

VBDUnit Автор

22.07.2022 10:11+2К сожалению, нет. Если говорить про три проектора, то тут плюсы - это отсутствие стыков, возможность делать экраны любой кривизны, даже в двух измерениях, а также возможность реализовать ещё более навороченный вариант подсветки.

Но качество изображения у проекторов очень далека от ТВ, тем более, от OLED. Один проектор тем более хуже - это просто, по сути, дешёвая замена большому ТВ. Низкое разрешение и совсем другая конфигурация картинки - угол обзора не будет настолько широким. Картинка просто будет большая, а не панорамная. Можно получить похожее, если раздобыть 12К проектор и выставить в запредельные углы обзора. Но даже если его найти - возникает ещё ряд серьёзных проблем.

DmitryMurinov

22.07.2022 05:47+5Выглядит впечатляюще.

И напоминает антиутопию с экранами во всю стену, видеокамерами, сценическими костюмами и любительским театром.

VBDUnit Автор

22.07.2022 10:16+2Если речь про Чёрное зеркало - то да, более чем. Я думал ещё сделать, чтобы оно могло работать как будильник, просто в течение пары часов наращивая яркость до максимума. В теории, пробивающийся сквозь веки свет, должен намекнуть организму, что пора убирать гормон сна и сделать пробуждение легким.

Про контроллер в виде тренажёра с педалями ещё не думал :)

Javian

22.07.2022 06:30+4По поводу шума механики. Может попробовать сделать активное шумоподавление. Источник шума и его положение в пространстве известно. Акустика стоит там же. Для начала попробовать программно, а в случае успеха потом попробовать сделать на доступных dsp.

Вариант прототипа за копейки с обработкой звука в реальном времени. Старая мат плата с pci и creative audigy2 по образу и подобию статьи - https://habr.com/ru/amp/post/214755/

VBDUnit Автор

22.07.2022 14:45Отличная идея! Я знал про активное шумоподавление, но не задумывался применить её для этой задачи - меня хватало только на установку кастомных сервоприводов без редукторов.

За статью отдельное спасибо, с таким инструментом тут не только шум от приводов можно будет подавлять.

crazymassa

22.07.2022 06:36+1А посоветуйте пожалуйста видеокарту подключить 4 телевизора в таком же режиме (без Led)

13werwolf13

22.07.2022 06:55для того чтобы подключить много мониторов (читай иметь большое совокупное разрешение) нужно видеокарту с большим аппаратным фреймбуфером (для начала только о фреймбуфере). раньше на сайте гейвидии к каждой видеокарте было написано максимальное разрешение поделив которое на 1920x1080 можно было узнать сколько fhd мониторов ты можешь туда воткнуть, когда я был на этом сайте в последний раз этой инфы уже не положили так что видимо только гуглить. лично мне больше 3ёх мониторов никогда было не надо так что инфа далее больше со слухов:

у красных радеонов обычно фреймбуфер "толше" аналогичных моделей ззелёной гейвидии, но у гейвидии есть не только GeForce но и quadro в которых с этим уже сильно лучше. Ну а если видюха нужна только для вывода изображения а не для каких-то сложных графических операций то есть матроксы, в некоторые модели можно воткнуть более 10 мониторов fhd, правда играть на них уже не получится, максимум видево смотреть (и то декодируя его процессором)

13werwolf13

22.07.2022 14:48до чего дошёл прогресс.. большинство хаброжителей слишком глупы чтобы написать почему поставили минус.. грустно всё это..

Gugic

22.07.2022 22:20+6Предположу что за гейвидию. Здесь так не принято.

13werwolf13

22.07.2022 22:36Да нет, за сленг редко минусуют, и обычно коммент а не карму, тут явно претензия к сути коммента, или что-то личное

Fodin

24.07.2022 20:43Да точно за это. Если б мог, я бы тоже минуснул. Это не слэнг, это какое-то ребячество. Почему радеоны не какие-нибудь "раздевоны"?

VBDUnit Автор

22.07.2022 10:22+1Если речь про нересурсоёмкую работу - подойдет почти любая с 4 разъемами, и у которой драйвер умеет объединять. У AMD и NVIDIA драйверы это делают уже давно.

Но, важно понимать - у ТВ сейчас везде HDMI, а у видеокарт - DisplayPort. Понадобятся переходники.

Если речь про игры младше 8 лет и чтобы не тормозили - то тут только топовые видеокарты, т.к. такая система жрёт очень много. Причем важна не только площадь, но и расположение: расположенные по горизонтали 3 экрана в большинстве случаев будут кушать больше, чем четыре экрана в конфигурации 2х2.

Tarakanator

22.07.2022 12:24Насколько я помню просто переходник это максимум FHD 60гц. Если нужно больше, то это уже умный адаптер.

когда я столкнулся с задачей получить dual-link dvi из DP или HDMI, то "переходник" стоил тысяч 7, и это на али. А видеокарта-затычка 2-3 тысячи. Подозреваю конвертация между DP и HDMI высоких версий породит туже проблему -дорогие адаптеры.

VBDUnit Автор

22.07.2022 14:59Да, разумеется, с определённого момента, адаптер - это уже активное устройство, со всеми вытекающими.

Сейчас в продаже ещё можно найти экземпляры видеокарт с 3 HDMI разъемами, реже - 4 (например, это https://www.ixbt.com/news/2020/04/13/asus-gt710-4h-sl-2gd5-hdmi.html). Как-то встречал RTX 3080Ti с тремя HDMI и тремя DisplayPort.

Есть ещё карты Matrox. В плане производительности они ни о чём, а вот в плане многомониторности - это их стихия. Но я ими никогда не пользовался, точно подсказать не смогу.

Есть ещё один вариант - это USB видеокарты. Современный USB, вроде как, может тянуть картинку 4K на уровне 60 Гц. Поэтому может существовать такая штука, как переходник USB -> HDMI для 4К разрешения. Но тут вопрос цены, а также наличия нужного числа быстрых USB. Впрочем, можно комбинировать: часть экранов в видеокарту, часть по USB. Но это всё если мы говорим об нересурсоёмких вещах.

Tarakanator

22.07.2022 15:09по ссылке HDMI не 2.1 ни 120гц RGB, ни VRR

3080ti... вот есть у меня большое вопрос в каком режиме HDMI порты работают. Я видел видеокарты с HDMI разных версий.

VBDUnit Автор

22.07.2022 15:22По ссылке да, но это очень бюджетный вариант.

по ссылке HDMI не 2.1 ни 120гц RGB, ни VRR3080ti... вот есть у меня большое вопрос в каком режиме HDMI порты работают. Я видел видеокарты с HDMI разных версий.

4K HDMI 2.1 120 Гц RGB с VRR, да ещё и на четыре экрана - это уже точно high-end, тут вряд ли получится взять что-то попроще :) Даже топовые видеокарты тут будут напрягаться. Самый простой подход здесь - это увеличить бюджет и взять активные переходники.

А как предполагается ставить экраны? В панораму, 2х2, 3+1 или как-то ещё? Возможно, Вам вообще требуется профессиональная видеокарта. Либо Matrox, либо Quadro, либо FirePro.

В магазинах комплектующих, обычно пишут, какая версия HDMI стоит. Я видел, например, версии где, только один 2.1, а остальные 2.0. Боюсь, что после того, чтоб было с криптовалютами, дефицитом и перекупщиками, сейчас найти эти редкие экземпляры с более чем одним HDMI портом, очень сложно.

Tarakanator

22.07.2022 15:40скажем так. У меня сейчас 1 экран и в принципе он меня устраивает. второй HDMI 2.1 порт мне может понадобиться в 2-х случаях:

1)наконец-то сделают OLED, выгорания которого я не буду бояться. Вероятно тогда у меня появится 2-х телевизор.

2)VR шлем.(сейчас он не HDMI, но что будет дальше-хз)

Это скорее предупреждение тем, кто захочет делать такую стену для игр. Всё ещё сложнее, чем вы описали.

13werwolf13

22.07.2022 06:51-5Человеческому глазу, конечно, достаточно 24 Гц, но увидеть мы можем и 1000, и даже 10 000 Гц, поэтому 120 Гц - весьма хорошая функция.

Всё это сугубо индивидуально. Я работал с человеком который секунду глядя на экран хоть с другого конца офиса мог сказать разрешение, герцовку и кол-во fps в данный момент, и он реально видел разницу 120-144 герц. А вот у меня ситуация сильно иная, для меня идеально 75гц, всё что выше я не вижу разницы с 75 от слова совсем, а после 75 очень долго привыкаю к 60. И что меня сильно печалит - 75гц сейчас хрен найдёшь (они конечно есть, но выбор не то чтобы очень большой и хороший), в основном продаются или офисные 60гц, или ГЕЙ_мерзкие 100500гц за многоденех.

VBDUnit Автор

22.07.2022 10:26Я довольно глубоко изучал этот вопрос, могу потом отдельно этот вопрос простыми словами расписать - будет очередная попытка расставить все точки над И :)

Всё, на самом деле, сложнее: человеческий глаз не является камерой, и само понятие герцовки, а также других параметров, которыми мы привыкли описывать технику, для него не применимо в полной мере.

perlestius

22.07.2022 09:10+10Почти как у Бредбери:

– Действительно очень забавно. А дальше будет еще забавнее, когда мы позволим себе четвертую телестену. Как ты полагаешь, долго нам придется экономить, чтобы сломать четвертую стену и поставить вместо нее четвертую телевизионную? Она стоит всего две тысячи долларов.

– Это треть моей годовой зарплаты.

– Но ведь всего две тысячи, – возразила Милдред. – Иногда не мешало бы и обо мне подумать. Если бы у нас была четвертая телестена, то эта комната стала бы вроде как вовсе и не нашей. Она превращалась бы в комнаты разных экзотических людей. Мы вполне можем обойтись без чего-нибудь другого…

datacompboy

22.07.2022 09:56+4Сразу видно, когда человек понятия не имеет, за что берётся :) или не обращает внимания. На выходе всегда конфетка!

adante

22.07.2022 10:58+1Я понимаю, что DYI

Но не проще было взять 3 телевизора Philips OLED ambilight (типа 856) и получить такой же (или почти такой же) результат с намного меньшими усилиями?

VBDUnit Автор

22.07.2022 15:32+2Изначально, я так и планировал. Но потом, подробнее изучив филипсы, а также другие телевизоры, сделал выбор в пользу сабжа. А дальше - поскольку подсветку всё равно делать руками - то пусть уж она будет годной :)

adante

22.07.2022 17:45А чем хуже филипсы?

У них же по сути та же матрица, что у LG.

VBDUnit Автор

22.07.2022 18:51+2Вы правы, они закупают матрицы у LG. И тут нюанс - я сильно сомневаюсь, что LG продаёт им матрицы того же уровня, что использует в своих телевизорах. Во всяком случае, на месте LG я бы так не делал :)

Насколько я знаю, эти матрицы немного отстают, на 1 - 2 поколения. Вдобавок, у филипсов появилась поддержка HDMI 2.1 только в 2021 году - то есть, фактически, я бы покупал первую модель с поддержкой данного разъема. Не факт, что он бы работал идеально. Здесь в комментариях у человека как раз возникли проблемы с подключением ТВ на большом разрешении.

Дальше - у филипса существенно больше задержка ввода и нету нормального игрового режима, который полностью выключает все дополнительные обработчики и позволяет телевизору выводить ровно то, что подано ему на вход (я не про G-Sync, а именно про игровой режим).

В остальном они, конечно, особо друг от друга не отличаются.

Gugic

22.07.2022 23:15+1Емнип у них есть своя проприетарная коробка, которая ставится в разрыв HDMI и снимает нагрузку с видеокарты для ambilight. Однако я сильно сомневаюсь что она умеет в HDMI 2.1

VBDUnit Автор

23.07.2022 10:57Есть такая, я её отбраковал именно из-за HDMI 2.1. Были мысли взять разветвители и конвертеры, которые будут из 4К 120 Гц HDR делать 1080p 60 Гц SDR, и вот это уже пихать в подобные коробки (а их довольно много), но так и не смог найти ничего.

Ndochp

23.07.2022 13:54Я на своем филипсе (не олед) так и не смог вырубить адаптивную подсветку, даже в комп режиме, в зависимости от того, что сейчас показывается в пол экрана — белый ворд или черный фон меняется подсветка с ощутимой задержкой. (не игроман, про инпут лаги не скажу)

jaiprakash

22.07.2022 11:24Зачем 3д печать по металлу вместо банальной классической мехобработки?

Dr_Faksov

22.07.2022 13:17А там написано что это печать по металлу? Вам в пластике прототипы никогда не приходилось печатать, подгонять, и лишь за тем - в металл?

jaiprakash

22.07.2022 13:59+1Да, там написано про печать по металлу. Нет, такие штуки как кронштейны, делал сразу и подгонял подрезанием/навариванием. Из стали. Потом — красил.

VBDUnit Автор

22.07.2022 14:48+2Да, там именно печать из алюминия. Позже распишу подробнее, что там было.

Вкратце: большая часть деталей изготовлена механической обработкой, но при изготовлении пары кусочков возникли затруднения из-за необычной формы. Можно было, конечно, как-то обойти проблему через переработку формы, но я решил, что это повод для экспериментов :)

Fodin

22.07.2022 11:50+3Таки отвечу на заданный вопрос. Конечно, конечно же нужно продолжение!!!

Очень интересно про выбор телевизора в качестве монитора. И даже больше не про "почему LG C1", а "почему не более дешевые марки и модели" с разбором конкретных параметров.

Tarakanator

22.07.2022 12:39я не автор, но 2 года назад у LG была САМАЯ дешевая модель 4к, hdr, 120гц, VRR. примерно 44к р.

Самсунги были сильно дороже и цвета мне у них не понравились (VA)

+ некоторые VA дают сильные артефакты при работе VRR, и как это проверить до покупки непонятно.

Fodin

23.07.2022 07:43С цветом проблема решается профилированием. VA вполне себе обеспечивает нужный цветовой охват.

Gugic

22.07.2022 23:17Год назад фактические не было альтернатив — если хотелось OLED, 4k, 120Hz и VRR, ну и чтобы размер не совсем космические — единственной подходящей моделью был LG CX и его наследник C1.

Fodin

23.07.2022 07:28+1Вот и интересно, зачем может хотеться OLED, 120Hz и VRR за 150000 руб. И чем оно кардинально лучше Direct LED, 60Hz за 18000 руб. Цены из ДНС.

Gugic

23.07.2022 09:32+1Странно вы вопросы формулируете. За 150 т.р. наверное и не может (хотя и тут все люди разные), а за 800 долларов (как они прямо сейчас в бестбае стоят) вообще не вижу смысла брать обычный монитор (ну разве что 48" некуда поставить на рабочем месте).

А в остальном - 120Hz лучше 60Hz (хотя бы потому что тот, что 120 все еще может на 60 работать), VRR лучше его отсутсвия, OLED - ну плюсы (глубокий черный, моментальное время отклика, условно бесконечный контраст и условно бесконечное количество зон подсветки) и минусы (выгорание, невысокая яркость), на мой взгляд плюсов больше.

Вот вам side by side хороший олед и очень хороший IPS с одинаковым черным фоном

(в реальности разница не настолько заметна но все равно очень заметна)

VBDUnit Автор

23.07.2022 11:02Всё просто

1) Изображение на OLED отличается от изображения на ЖК-экранах

2) Изображение 120 Гц отличается от 60 Гц

К слову, чем больше диагональ, тем больше герц Вы можете увидеть. А если речь идёт о нескольких метрах - можно увидеть даже 1000 Гц. Я постараюсь потом расписать, что к чему.

Tarakanator

22.07.2022 12:34+3И если качество картинки у такого телевизора хорошее (привет, OLED/QLED), то чем он тогда не монитор?

на примере моего LG49nano886

1)ШИМ. Я при покупке даже не додумался проверить, думал эта гадость давно изжита.

2)глючит если поставить режим ПК и использовать не самую современную видеокарту (RTX 3080ti-ок, а вот RTX2070, gtx1080\1060, rx580 глючит). И это не брак конкретного экземпляра, я поменял телек по гарантии, и новый экземпляр был таким-же.

3)после включения может включиться режим overscan, выключается сам через 0.1-2 мин. Но ИНОГДА может и не выключиться(вроде на последних прошивках пока такого небыло, но может мне пока везёт), надо отключать выключать\включать телек. Лучше из розетки.

P.S. Преимущество такого решения. идеальная для меня плотность пикселей.

теоретически конечно можно было взять 32" 1440p но там тоже есть нюансы. до того было 27" 1440p-мелко.

VBDUnit Автор

22.07.2022 14:53+21) Да, шим это ужасно, и я абсолютно согласен, что брать ТВ с ШИМ как монитор нельзя. Но есть телевизоры и без ШИМ. В частности, большинство ТВ без подсветки (сабж, например), ШИМ не имеет. Там можно, если хочется, включить мерцание отдельной настройкой.

2) Да, эта проблема есть. У меня и на современной видеокарте эта штука глючила, пришлось даже софт писать, который пинает телевизор, чтобы он переключился в нормальный режим.

3) С самопроизвольным включением/выключением параметров не сталкивался, но то, что телевизоры надо включать/выключать - это есть. Это, как и многое другое, лечится руками через контроллеры и вот это всё :)

Tarakanator

22.07.2022 15:051)OLED как монитор я тоже брать не согласен из-за выгорания. Отсутствие ШИМ "пофиксил" диммером освещения. Когда экран слишком яркий, я не яркость экрана снижаю, а диммером фоновое освещение увеличиваю.

2)похоже вы меня не поняли, я про такое

https://www.youtube.com/watch?v=DjCxFoiuMEA&ab_channel=AlexeyBorisov

Или вот, нетепичное проявлиние, но видно что зависит именно от режима

https://www.youtube.com/watch?v=39DMv9ZD0cw&ab_channel=AlexeyBorisovИ да, на OLED тоже есть жалобы на мерцание.

VBDUnit Автор

22.07.2022 15:30И да, на OLED тоже есть жалобы на мерцание.

Есть. Особенно это проявляется в смартфонах, но телевизоры тоже частенько грешат. Тут надо смотреть конкретную модель.

2)похоже вы меня не поняли, я про такоеhttps://www.youtube.com/watch?v=DjCxFoiuMEA&ab_channel=AlexeyBorisovИли вот, нетепичное проявлиние, но видно что зависит именно от режимаhttps://www.youtube.com/watch?v=39DMv9ZD0cw&ab_channel=AlexeyBorisov

Ого, а это точно не кабель? Уж больно это выглядит как хардварная неисправность. Или, возможно, у Вас откуда-нибудь помехи идут сильные? Вроде логично - если разные карты меняли, и телевизоры меняли, и с кабелем всё хорошо, и помех нет - то тогда это несовместимость оборудования, причём очень серьёзная.

Tarakanator

22.07.2022 15:443 кабеля, 2пк(на одном из них 3 разных видяхи пробовал), 1 ноутбук, 2 телевизора.

Заработало хорошо только после установки RTX3080ti, чему я очень удивился. Думал уже судиться придётся.

VBDUnit Автор

22.07.2022 16:43Поправьте меня, если я ошибаюсь: правильно ли я понял, что Вы пытались запустить 4К именно 120 Гц?

Я посмотрел сейчас спецификации RTX 2080Ti - там написано, что HDMI версии 2.0b. Насколько мне известно, его потолок в RGB режиме - это 4K 60 Гц, дальше он, если и может в 120 герц, то, разве что, с цветовой субдискретизацией (непонятно только, 4:2:2 или вообще, 4:2:0). А цветовая субдискретизация - это, как минимум, убитые шрифты.

Иными словами, если я правильно Вас понял, то причина в том, что видеокарты младше 3000 серии, просто напросто, не поддерживают формат 4К@120Гц. И при попытке заставить их это делать, они как-то пытаются сжать сигнал, или отключить RGB (а это проверяется в панели управления Nvidia), а телевизор эти форматы понимает плохо, поэтому глючит. Или - как вариант - вообще не пытаются ничего сделать, и просто пихают данные через разъём и железо, которое на такое не рассчитано. Кстати, последнее, судя по Вашим видео, наиболее вероятно.

Всё просто: чтобы передать 4К 120 Гц RGB 8 бит/канал, нам надо иметь скорость около 24 Гбит/с:

А у HDMI 2.0b пропускная способность - 14.4 Гбит/с.

Tarakanator

22.07.2022 16:54+1Нет, пока у меня небыло RTX3080ti я использовал телевизор в режиме 3840x2160 rgb 60гц.

Ну или YCBCR420 120гц или YCBCR422 100гц (последний почему-то не всегда доступен) для шутеров\гонок.

Нет, проблема наблюдалась в режиме 3840x2160 60гц RGB 8 bit.

VBDUnit Автор

22.07.2022 17:07+1Т.е., исходя из этого, можно сделать вывод, что производители видеокарт системно не соблюдали заявленную ими же спецификацию HDMI 2.0b в серийно выпускаемых продуктах? И массово выпускали видеокарты, не соответствующую заявленным характеристикам?

Тогда это очень серьёзно.

Tarakanator

22.07.2022 17:53+2Я думаю проблема со стороны LG, т. К. Возникает только при определённых настройках телевизора и возникает и на картах нвидиа и амд

Sinergetikus

22.07.2022 14:30Захват картинки самим телевизором не рассматривали?

piccap(hyperion-webos) -> raspbery PI или другой одноплатник

Из плюсов — нет потери фпс, всеядность (HDR,Dolby Vision)

Минусов как таковых нет, если не считать обязательное наличие root на телевизоре.

VBDUnit Автор

22.07.2022 14:55+1Очень интересно, как-то не задумывался влазить в мозги телевизору. Могут быть проблемы, что в режиме оптимизации игр картинка может аппаратно проскочить мимо мозгов ТВ, т.к. там уж больно подозрительно низкая задержка.

А как насчёт гарантии? Производитель разве не расстроится, когда узнает, что я сделал root?

Sinergetikus

22.07.2022 15:38+1Не проскакивает, весь контент с HDMI захватывается. Единственное, что не захватывает — это DRM контент встроенных приложений, например Netflix. Этот же DRM контент с внешних устройств по HDMI успешно захватывает. В теории захват может увеличить задержку, но ни я, ни остальные пользователи ничего такого не наблюдали, а измерить нечем.

Судя по дискорду разработчиков rootmytv, пока никому в гарантии из-за root не отказали. Да и всегда можно сделать сброс до заводских, а если аппарат убит до состояния не включения, то вряд ли кто-то будет ковырять память дохлого телевизора на наличие следов root.

prusak_msk22

22.07.2022 14:35+5Улыбнуло. Давно такие конструкции с 4к мониторами проектировали и массово поставляли по диспетчерским энергетиков. Тут 32-е Dell 4к, отработанная конструкция монтажа на стол. Интересны ли детали и подробности, чят?:)

13werwolf13

22.07.2022 14:51+1я бы почитал с удовольствием, как про конструкцию так и про удобство использования (из фото я не очень понял высоту, но выглядит так словно голова среднестатестического человека будет ниже середины что вроде бы как не очень хорошо)

ну интересно было бы узнать к чему это подключается (аппаратную часть имею ввиду)

holodoz

22.07.2022 14:53+1Единственная инсталляция, где чёрная изолента лучше синей —это видеостена из ЖК-панелей

VBDUnit Автор

22.07.2022 15:01Да, было бы очень интересно узнать подробности, как это подключается, что там за видеосистема, объединяются ли они в виртуальные экраны, и как это вообще всё держится. Оно же весит там, наверное, несколько центнеров.

dragonnur

23.07.2022 15:42Хм. 8 штук 32" деллов это менее 50 кг со всеми причиндалами, наверно и одного центнера в сумме не наберётся (без столов, только рама с основанием и крепежи).

VBDUnit Автор

23.07.2022 22:41Они точно такие лёгкие? По идее каждый должен килограмм 7 - 10 весить + надёжный кронштейн, который тоже весит не мало.

iamkisly

22.07.2022 16:29+1Пожалуй побуду единственным хейтером в треде) Считаю что тема

сисекэкранов не раскрыта. С играми все понятно, смотрится эффектно.. но насколько удобно, и как за этим работать? Человеческая анатомия имеет свои "особенности", а в такой конфигурации особо головой не повертишь, отвалится. Полезность для игр тоже сомнительная, потому что эффект рыбьего глаза дает о себе знать.А еще вы напихали лишних тегов. По моему мнению .NET* и Программирование микроконтроллеров тут лишние, и просто засоряют хаб.

VBDUnit Автор

22.07.2022 17:02+2Судя по экспериментам над моими знакомыми, людям, кто привык работать за ноутбуком, эта штука очень непривычна. Они не выворачивают себе шею только потому, что теряют курсор мышки и не могут его найти :)

Пожалуй побуду единственным хейтером в треде) Считаю что тема

сисекэкранов не раскрыта. С играми все понятно, смотрится эффектно.. но насколько удобно, и как за этим работать? Человеческая анатомия имеет свои "особенности", а в такой конфигурации особо головой не повертишь, отвалится.Это один из ключевых моментов, именно поэтому здесь стоит механика. В зависимости от того, что делаешь, ставишь разные углы. Иначе работать неудобно. Плюс, чем важнее и чаще используешь окно, тем ближе оно к центру, наименее важные окна - на краях боковых экранов.

Человеческое тело изначально предполагает такой кейс использования - люди же как то смотрят в зеркала, когда ездят на машине :) К тому, что нужно активно вертеть головой, привыкаешь, и обратно, на меньшие экраны, уже вернуться не захочешь. Но это дело вкуса.

А еще вы напихали лишних тегов. По моему мнению .NET* и Программирование микроконтроллеров тут лишние, и просто засоряют хаб.

Я исходил из того, что раз тут пришлось кодить STM32, а также писать софт под комп на .NET, значит теги следует поставить + я планировал раскрыть подробности этих аспектов позже. Поправьте, если ошибаюсь.

iamkisly

24.07.2022 21:29Я исходил из того, что раз тут пришлось кодить STM32, а также писать софт под комп на .NET, значит теги следует поставить + я планировал раскрыть подробности этих аспектов позже. Поправьте, если ошибаюсь.

Да какбы видя определенный тег, ожидаешь увидеть там раскрытие темы. А тут из темы только то что вы попробовали несколько микроконтроллеров и у вас получилось реализовать задуманное на stm32.. на мой взгляд этого мало. Я подписан на три тега из четырех указанных, и все равно бы увидел статью.. а представьте человека подписанного, например только на .NET, который зайдет и будет немного разочарован.

Gugic

22.07.2022 23:22+1Сижу за одним 48" «монитором» и очень доволен. На работе 32@4k уже кажется маленьким и некомфортным. Насчет трех не знаю конечно.

mefikru

24.07.2022 20:50У меня уже лет 10 в качестве монитора минимум 48". Начинал ещё с FHD. Сейчас стоит LG 4K 50", не олед правда. Когда садишься за рабочий стол с обычным монитором, возникает ЖУТКОЕ чувство неудобства. Были планы добавить второй моник вертикалкой, места в кабинете не так уж и много, но вот посмотрел как стоят три и сильно задумался...

iamkisly

22.07.2022 16:32+2Говорящая гостиная! Как это верно! Когда бы он ни зашел туда, стены разговаривали с Милдред:

- Надо что-то сделать!

- Да, да, это необходимо!

- Так чего же мы стоим и ничего не делаем?

- Ну давайте делать!

- Я так зла, что готова плеваться!О чем они говорят? Милдред не могла объяснить. Кто на кого зол? Милдред не знала. Что они хотят делать? "Подожди и сам увидишь", - говорила Милдред...

Первая ассоциация, это не кинотеатр, не игровая комната.. а "телестены" из 451 по фаренгейту. Зашел в комнату и забыл зачем )

SiteCenter

22.07.2022 18:10+1Восхитительное творение, спасибо за статью) При 4к и такой большой диагонали учитывая, что мониторы расположены близко к человеку - не видно пикселей? Например скругления в интерфейсе (скажем синяя иконка телеграмма на тёмном фоне) выглядят ровно, или небольшой лесенкой?

VBDUnit Автор

22.07.2022 18:55Смотря с какого расстояния смотреть. Я обычно смотрю с расстояния от 50 см до 1 метра. Если ближе - то да, пиксели. Но, на случай пикселей, можно взять модели по 8К. У них один минус - можно будет только 60 Гц, т.к. 8К 120 Гц, насколько я знаю, пока существуют только в профессиональном сегменте. А у тех мониторов свои заморочки и для подобного использования они довольно неудобны.

jewalky

22.07.2022 18:19+1Пипец. Как же счастливы люди с хорошим зрением :)

Центр управления полётами крутой получился. Один минус — хрен переедешь на другое место жительства, если вдруг захочется. Но это не технологический минус)

VBDUnit Автор

22.07.2022 18:58+1По идее, если со зрением проблемы, можно сюда прикрутить трекер направления взгляда, и включить экранную лупу (она здесь довольно интересно выглядит), например, 2х кратную. И по мере скольжения глазом по экранам изображение на них будет перемещаться, как будто ты смотришь через огромную лупу во всю стену. Правда, не знаю, насколько это будет удобно, но, может быть можно будет привыкнуть.

Что касается переезда - в принципе, если нужно, эту штуку можно сделать перемещаемо-разбираемой, чтобы можно было собрать за час. Просто такая задача изначально не ставилась)

UPD: попробовал включить в полноэкранной экранной лупе следование за курсором (чтобы он всегда оставался по центру), через 30 секунд ушёл за пакетиком. Так что нет, экранная лупа не подходит :)

firs058

22.07.2022 19:22И все это выгорит через полгода под IDE. Нет, если у Вас есть возможность менять эти "мониторы" как перчатки - юзайте, почему нет. Но свистоперделки все-равно дичь и баловство кмк.

Gugic

22.07.2022 23:27Сижу уже год на точно таком телевизоре, работая в основном из дома + просиживая за ним же ночью (т.е. дневное использование по 8-10 часов). Брал для игр, конечно, однако так уже вышло играю очень мало и часто вообще с других экранов. Так что использование это как раз в основном браузер, IDE, терминал.

Могу только сказать перефразируя классика что слухи о быстром выгорании сильно преувеличены.

AiR_WiZArD

23.07.2022 16:28Делал себе подсветку на стандартный 32" 1440p монитор. Штука классная, но учитывая то, что ноутбук постоянно приходится отключать, COM порт как средство связи с МК ужасно неудобен, винда каждый раз меняет его номер. Использую prismatic, хотел использовать STM как HID устройство, с железом проблем нет, а вот опыта разработки под ПК не хватило, в частности под windows. Сейчас думаю, что стоит сделать виртуальный ком порт для prismatic, в который закидывать данные из STM.

VBDUnit Автор

23.07.2022 22:38+1А разве нельзя было сделать автоопределение COM-порта? Если у Вас только одно COM-устройство, сделать это элементарно - просто перебираем порты от 1 до 30 пока не получится подключиться.

mefikru

24.07.2022 20:55Впрочем, уже есть мысли убрать рамки совсем при помощи селенита, оптоволокна и светодиодных лент

А это как?

4reddy

Чума! Сколько денежек ушло на сие творение?

VBDUnit Автор

Много. Но оно того стоило)

AADogov

Боюсь представить сколько бы мне эта идея стоила, с учетом того что под такую инсталляцию следует выделять отдельную комнату, что ведет к покупке новой квартиры.

Donkeyhot_kgd

Не стоило их для начала потратить ну, например, на те же обои и вообще ремонт? На стол? ;)

VBDUnit Автор

Пока не написали, даже не задумывался про ремонт :) Наверное, стоит всё-таки сделать.

А стол, внезапно, новый. Я взял каркас, который может ездить вверх-вниз. Пока не придумал, какой формы должна быть столешница, чтобы была небольшая, но туда влезала куча периферии, поэтому сделал времянку из доски с ветошью. Ветошь очень мягкая, к слову :)

Diamon33

Смотря где покупать (я имею ввиду страну), LG C1 48", 55", 65". Если брать 3х48" по $800 - $2400 (+налоги).

Учитывая, что всякие 27" мониторы с поддержкой "недо-HDR" (HDR400 и далее) стоят под $400 и выше - неплохой вариант.

Цена остального по отношению к цене тв уже не имеет значения.

Этот горизонт далековато, мягко говоря, можно смело брать OLED, если не заморачиваться насчет выгорания (учитывая статичный IDE или рабочий стол).

VBDUnit Автор

Я тоже так в начале думал :)

Согласен, ждать MicroLED, в этом контексте, смысла нет. Однако, эту технологию ещё собираются использовать для VR - можно выпускать очень маленькие дисплеи, но с очень большой плотностью пикселей в тысячи ppi. Я не уверен точно, но могу предположить, что MicroLED, теоретически, позволит выпускать дисплеи с переменной плотностью пикселей - много в центре, мало на переферии. Для очков это не совсем хорошо, ибо глаза умеют в саккады, но для линз VR, где дисплей и глазное яблоко работают как единое целое, самое то.

Gugic

Блин, вот это скидки, я за 1500 брал помнится почти на старте продаж (год назад). Поменять что ли и второй монитор )