Игра навылет

Стадион «Открытие Арена» – нечто среднее между торговым центром, гостиницей и аэропортом. Он рассчитан на 45 тысяч болельщиков. Это сравнимо со средней пропускной способностью аэропорта Пулково в сутки. Чтобы попасть на стадион, эти 45 тысяч человек должны пройти через турникеты, оборудованные билетно-пропускной системой. Билетно-пропускная система работает через ЛВС. Сбои ЛВС или самой билетно-пропускной системы означают давку у турникетов и прочие неприятности.

Гости на стадионе бывают четырех типов: фанаты, более спокойные любители футбола (так называемая категория «Публика»), VIP и СМИ. Журналистам нужен Wi-Fi и проводной доступ в интернет. Им важно как можно быстрее отправить репортаж в редакцию, так что в случае малейших проблем с интернетом они сразу же устраивают скандал.

Места для СМИ

В подтрибунном пространстве есть рестораны и торговые павильоны, работа которых завязана на кассовые терминалы. Еще там висят телевизоры, на которые можно транслировать рекламу или картинку с поля, – это очень удобно, можно стоять в очереди за хот-догом и смотреть футбол. Если телевизор ломается, компания, с которой заключен договор на трансляцию рекламы по этому телевизору, вправе выкатить стадиону неустойку. Кассовые терминалы тоже работают по ЛВС, и хуже всего, если во время матча перестанут проходить банковские транзакции. Страшно представить, что могут устроить 45 тысяч человек в замкнутом пространстве, если их не покормить вовремя.

В VIP-зоне за дополнительную плату можно снять скай-бокс – отдельное помещение с видом на поле, баром, официантами и собственной ложей на трибуне. Там тоже работает Wi-Fi и висят телевизоры. Аренда скай-бокса стоит дорого, поэтому и здесь любые проблемы с Wi-Fi и телевизорами однозначно обернутся претензиями в адрес стадиона.

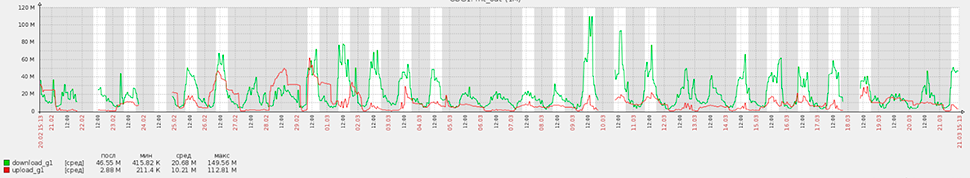

Статистика потребления интернет-трафика на стадионе «Открытие Арена» за месяц. Наиболее активные потребители — СМИ и офис футбольного клуба «Спартак».

Таким образом на каждый матч может прийти 45 тысяч человек, стадион за них отвечает и прилагает титанические усилия, чтобы все прошло гладко. Это огромный стресс и ответственность для всех, кто трудится на стадионе, в том числе для айтишников. Когда в следующий раз будете болеть за любимую команду, подумайте об этом.

Космос как предчувствие

В январе 2012 года стадион пригласил нас поучаствовать в конкурсе на СКС, ЛВС, АТС, серверную инфраструктуру, систему коллективного приема телевидения (СКПТ) и систему видеорекламы (Digital Signage). Туда же входил Wi-Fi, но этой теме мы посвятим отдельный пост. Чтобы победить в конкурсе, надо было выполнить два простых условия: предложить наиболее оптимальное по цене решение и доказать, что оно будет безотказно работать во время мероприятия.

Так выглядел стадион в декабре 2012 года, когда мы начали проектирование

В качестве исходных данных было техническое задание на три листа и куча проектной документации разной степени вменяемости. ЛВС и Wi-Fi были спроектированы на Cisco.

Запомнилось, что коммутатор Cisco Catalyst 6509 шел в спецификации без интерфейсных плат, трансиверов, лицензий, блоков питания и SMARTNETов. Cisco для этого проекта подходил, но не давал преимуществ в цене, так что решили заменить его на аналог от Huawei.

Результат получился дешевле и не уступал Cisco в надежности эксплуатации. Конечно, аналог от Huawei мог немножко покапризничать в ходе пуско-наладки и уступал Cisco в ассортименте доступных руководств по администрированию. Так и получилось, но в угоду оптимизации капитальных затрат с этим пришлось смириться.

Начали думать, как без ущерба для надежности сэкономить на серверах, СХД и оборудовании бесперебойного питания. Нам позвонили из российского представительства Huawei и предложили рассмотреть линейку ИБП UPS2000 с двойным преобразованием, X86-серверы Huawei Tecal и СХД OceanStor. В 2012 году для России это было совершенно незнакомое оборудование, особенно когда речь шла о UPS2000.

Так получилось решение с эксклюзивным железом, в котором ЛВС, Wi-Fi, серверы, СХД и даже ИБП были от одного вендора. В 2012 году ни с каким другим вендором осуществить эту идею было нельзя (сейчас из известных вендоров можно еще на HPE и DELL, но на DELL – вообще экзотика).

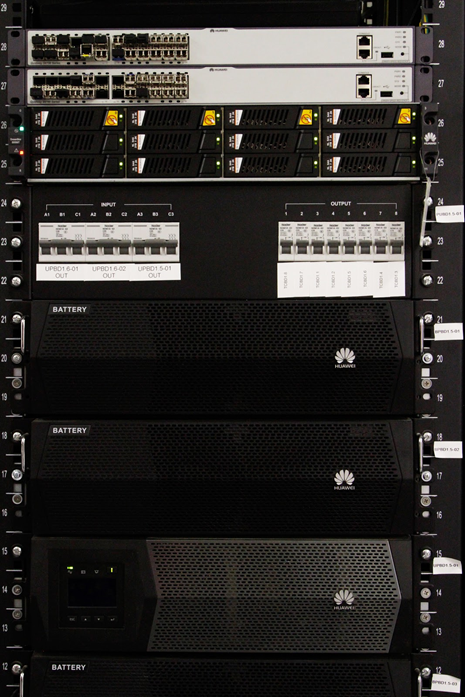

В двух дальних стойках — ИБП Huawei 2000 для серверных помещений. Фактически это три ИБП мощностью 15КВА каждый. Суммарная мощность составляет 45КВА. Oceanstor 5500С — слева.

Вопрос о надежности решили следующим образом. Поскольку опыта эксплуатации предлагаемого оборудования Huawei в России не было, ЛАНИТ пришлось поставить на кон свою 25-летнюю репутацию.

По условиям контракта, если в течение 5 лет с момента ввода в эксплуатацию заказчика не устраивает надежность того, что мы предлагаем, мы забираем оборудование себе, ставим что-то другое и платим за это самостоятельно.

В принципе, с Huawei можно было зайти еще дальше — взять АТС eSpace, Digital Signage vSpace, и сделать на Huawei вообще все, кроме лотков и СКС. Но не сложилось. vSpace не подошло по функционалу (об этом – чуть ниже), а по АТС выбор в итоге пал на Ааstra (бывшая Ericsson, ныне Mitel Networks). Заказчик хотел использовать базовые станции IP DECT по всему стадиону, потому нужно было заложить в проект станцию со встроенной поддержкой этого функционала. Наиболее дешевой из рассматриваемых и соответствующих требованиям оказалась Aastra.

Телевизоры и ревность

Стадион – очень ответственный объект, и если вы думаете, что закладывать туда оборудование без опыта эксплуатации в России – большой риск, вы правы. Но давайте поговорим об IPTV/Digital Signage.

Несмотря на внешнее сходство, это совершенно разные по функционалу системы, и на стадионе «Открытие Арена» у меня от них до сих пор ощущение, как от езды на американских горках. Это потому, что по ходу проекта постоянно менялось и количество ТВ-панелей, и чуть ли ни каждый телевизор хотя бы раз перекочевал из системы IPTV в Digital Signage или обратно. Поэтому решили спроектировать обе системы на одной платформе.

Заказчику идея понравилась. Еще ему хотелось с помощью такой системы управлять всеми телевизорами удаленно, обеспечить возможность наложения на ТВ-поток текстовой бегущей строки, поддержку Adobe Flash, пользовательский портал для контента Video-on-Demand и много чего еще. Таким требованиям из известных нам решений соответствовали: Cisco Stadium Vision (Cisco Systems, США), Tripleplay (Tripleplay Services, Великобритания) и C-nario (YCD Multimedia, США/Израиль). Для всех троих стадион обещал стать первым проектом подобного масштаба в России.

Начали сравнивать архитектуру решений. Первым с дистанции сошел C-nario. У него фантастический функционал, но в качестве приставок Set-top-box, при помощи которой система подключается к телевизору, предлагались x86-неттопы на базе Windows, что вызывало вопросы к надежности. Еще система на C-nario получилась самой дорогой.

Stadium Vision оказался дешевле C-nario, использовал проприетарные приставки set-top-box с логотипом Cisco на лицевой панели, и это было плюсом, так как в теории они более надежны, чем неттопы на Windows. Однако Cisco немножко ревновала нас к Huawei и всячески намекала на то, что если ЛВС будет не на Cisco, то работать должно, но вендор ничего не гарантирует (до сих пор интересно, почему).

У Tripleplay была принципиально другая архитектура. Англичане гарантировали совместимость с ЛВС любого вендора, а в качестве приставок set-top-box использовали изделия производства компании Amino, которые, в принципе, можно было свободно приобрести в России и использовать не только с Tripleplay. При наличии достаточного количества лицензий любую приставку можно было перевести из режима IPTV в Digital Signage парой кликов мышкой в панели администрирования.

Все это настраивало на более позитивный лад и выглядело бы совсем шикарно, если бы не то, как в Tripleplay предлагалось решать задачу удаленного управления ТВ-панелями.

В принципе, Tripleplay мог управлять ТВ-панелями либо через HDMI (но без гарантии совместимости с конкретной моделью телевизора), либо по RS232, но через переходник USB-RS232 из-за отсутствия порта RS232 у приставки Amino. Нам не подходили оба варианта, поскольку переходников не хотелось, а заказчик утвердил спецификацию ТВ-панелей чуть ли не перед самой закупкой. В результате заказчик выбрал Tripleplay и решил организовать удаленное управление ТВ-панелями на отдельном решении в виде контроллера AMX, который взаимодействовал с телевизорами по ЛВС.

Архитектура IPTV/Digital Signage получилась вот такая:

Реакция на мороз

На дворе январь 2013 года. На стадионе четыре сектора, по проекту подтрибунное пространство отапливается только в одном из них – западном. Однако даже оно не отапливалось. В этом пришлось убедиться в ходе прокладки лотков и кабельной инфраструктуры.

Вот так мы ходили к будущему стадиону зимой 2013 года. Коллеги рассказывали, что видели зайцев, которые прибегали с Тушинского поля.

Минус тридцать градусов, люди висят под потолком и тянут лотковую трассу, которая в конце концов упирается в лоток электриков или венткороб. Это потому, что представители смежных монтажных организаций, чтобы согреться, пустились прокладывать свои трассы не по проекту. В результате все стали друг другу мешать. На каждом участке собирался консилиум инженерно-технических работников заказчика и смежных монтажных организаций. Консилиум долго ругался, но потом решал, кто где будет прокладывать коммуникации. На следующем участке все повторялось. Подобная организация работ потребовала от нас проектного офиса на площадке и десанта в виде одного-двух проектировщиков. Каждый день они ходили на эти совещания и отрисовывали фактическую прокладку лотков.

Обстановка нашего проектного офиса на строительной площадке. Фотографировали летом.

С подобной спецификой организации работ приходится сталкиваться очень часто. Со временем ты привыкаешь и перестаешь понимать людей, которые тратят кучу времени на сводные планы прокладки инженерных сетей, BIM-модели, разводку коммуникаций в 3D и прочие вещи, которые совершенно бесполезны на объектах, где постоянно переделываются чертежи, меняются подрядчики, постоянно не хватает времени, и каждую неделю ты делаешь новый план-график.

Кабель мы начали прокладывать, только когда потеплело. Все равно хорошо, что мы заложили в проект кабели, которые рассчитаны на монтаж и эксплуатацию при морозе -40 градусов. Прокладка лотковых трасс по мосткам кровли стадиона оказалась не менее волнительной, так как там очень тесно, скользко и дует сильный ветер с Москвы-реки. Всего за 1 год было проложено 20 километров магистрального кабеля и 300 километров кабеля «витая пара».

Ходовые мостки кровли до начала монтажа слаботочных систем. Монтажники ежедневно проводили на них по 8-10 часов рабочего времени.

Компромисс

Когда закончились строительные работы в серверных помещениях и мы начали монтаж ИБП, всплыла одна пикантная конструктивная особенность UPS2000. В составе изделия шел распределительный щиток с автоматами, который включался между ИБП и блоками распределения питания (PDU) в стойках. Если сравнить номиналы этих автоматов, паспортные токи PDU, и номиналы автоматов вводного распределительного щитка серверного помещения, все это не соответствовало требованиям, прописанным в Правилах устройства электроустановок (они же «библия электриков», или просто ПУЭ). Мы написали об этом в Huawei, они ответили, что хотят посмотреть на все своими глазами. Так у меня состоялись самые странные деловые переговоры за всю мою карьеру.

Вот этот распределительный щиток шел в комплекте с UPS2000.

В серверной появился наш аккаунт-менеджер и три китайца. Мне их не представили, но было видно, что это не инженеры технической поддержки. Самый главный из них носил серый пиджак в клетку и был примерно полтора метра ростом. Два других носили черные пиджаки и были несколько выше главного, чего явно стеснялись. Шумел перфоратор. Воздух был мутным от строительной пыли, и мы стояли возле стоек с ИБП, потому что сесть было некуда. Мой рост – метр восемьдесят. Когда китаец в сером пиджаке говорил со мной, он смотрел на меня снизу вверх и все равно выглядел представительно. Его речь представляла собой смесь китайского и английского языка. Он искренне не понимал, в чем проблема. Я говорил о ПУЭ, принципах селективности автоматов, которые обязаны соблюдать все, кто находится в пределах границ Российской Федерации, но выражение его лица по-прежнему не менялось. Все, что он мне отвечал, тонуло в рокоте перфоратора. Когда перфоратор стих, китаец перешел на русский: «Мы можем поменять решение, но тогда мы за него не отвечаем». «По нашим законам вы и так за него не отвечаете, а отвечаю я как главный инженер проекта», – возразил я. В итоге мы договорились, что вендор приведет решение в соответствие с требованиями ПУЭ.

На самом деле практически все зарубежные вендоры, с которыми мы имеем дело, не всегда посвящены в тонкости российских ГОСТов и СНИПов. В некоторых случаях это грозит полной заменой технического решения. Хорошо, когда вендор это понимает и идет на конструктивный диалог без лишних препирательств и бюрократии.

Ведется монтаж оборудования

Грязные танцы

Чем меньше оставалось времени до окончания проекта, тем ярче становились трудовые подвиги строителей. Бригады маляров и штукатуров все чаще орудовали перфораторами в помещениях с работающими и сосущими пыль коммутаторами. Нависла угроза массового выхода из строя оборудования ЛВС и ЦОД по явно не гарантийной причине. Из положения пытались выйти продувкой «железа» баллонами со сжатым воздухом и даже заклеиванием интерфейсных портов оборудования.

Один из коммутаторов во время пуско-наладки. Порты бесхитростно заклеены малярным скотчем. Если приглядеться, виден слой строительной пыли на верхней панели устройства.

Борьба по SIP

Тем временем заказчик принял решение подключить АТС не по E1, как было в проекте, а по SIP, для чего потребовались пограничные контроллеры сессий. Через месяц после принятия решения на стадион были доставлены два маршрутизатора Huawei AR2240 с платами обработки голоса.

После запуска данные устройства категорически отказались дружить по SIP с Aastra. Смена прошивки не помогла, и мы написали обращение в сервисную поддержку (TAC) Huawei. Сначала инженеры Huawei подключались к AR2240 удаленно, а когда и это не помогло, начались паломничества специалистов вендора непосредственно на объект с целью припадания к консолям маршрутизаторов и тонкой настройки параметров SIP, общее количество которых превышало 100 шт. Все закончилось патчем для ОС AR2240, который был разработан персонально для нашего проекта. После патча SIP заработал, но не так, как хотелось бы. Особенно запомнился баг, из-за которого при звонках с Aastra на номера с автосекретарем (DISA) связь рвалась через 30 секунд. Проблема решилась очередным патчем ПО маршрутизатора.

Про серверы Tecal особо вспомнить нечего – обычные серверы X86. Работали стабильно, к качеству сборки нареканий нет. Заодно познакомились с аналогом iLO у HPE для мониторинга и удаленного администрирования сервера — у Huawei Tecal это называется iMana, и оно вполне неплохо работает.

Две СХД Oceanstor S5500T тоже заработали без особых проблем, в них разве что расстроило тогдашнее отсутствие поддержки кластеризации вроде HP Peer Persistence или NetApp MetroCluster, но нам оно и не пригодилось. В настоящее время Oceanstor кластеризацию поддерживает, технология называется HyperMetro. Про нее есть статья на Хабре вот тут.

Футбол на расстоянии

Под занавес строительства у «Спартака» был запланирован выездной матч. Матч должны были показывать по телевизору в прямом эфире. Заказчик загорелся идеей вывести картинку этой трансляции на видеотабло стадиона, звук – на систему звукоусиления и пригласить на трибуны болельщиков. ТВ-сигнал в прямом эфире предлагалось брать с нашей СКПТ Tripleplay. К этому времени мы почти закончили пуско-наладку.

Видеотабло стадиона «Открытие Арена» во время церемонии открытия. Вполне подходит для просмотра телепередач.

Встала задача интеграции СКПТ, за которую отвечали мы, с системой видеотабло, за которую отвечал один подрядчик, и системой звукоусиления, за которую отвечал другой. Решили интегрировать не напрямую, а через Media Control Room стадиона, за который отвечал еще один подрядчик.

Media Control Room – центральная аппаратная мультимедийных систем стадиона. В ней формируется контент, который выдается на все средства отображения стадиона.

Нужно было как-то снять сигнал с IP-телевидения, подать его на матричный коммутатор Media Control Room’а, отмасштабировать и разделить на видео- и звуковую составляющую. Затем видео отправлялось на контроллеры табло, а звук — на микшерный пульт системы звукоусиления. При этом видео и звук не должны отставать друг от друга.

В итоге мы приобрели еще две приставки Amino A140, зарегистрировали их в системе Tripleplay и вывели на них ТВ-канал, по которому должны были транслировать матч. HDMI-интерфейс приставок через конвертеры HDMI-SDI включили в матричный коммутатор Media Control Room’а. И все заработало.

Было очень здорово сидеть на трибуне стадиона и смотреть матч по видеотабло площадью 172 кв.м.

Настоящее продолженное

Сейчас мы выполняем пуско-наладку оборудования Huawei для одного из наших заказчиков. Представьте себе, заказчику показался неудобным формат вывода одной из команд в консоли межсетевого экрана Huawei NGFW. Мы обратились в Huawei, и вендор выпустил персональный патч для Huawei NGFW заказчика, который меняет формат вывода консольной команды. Это продолжение гибкой политики Huawei, которая помогла нам построить успешный проект на новом для российского рынка оборудовании.

Проект строительства ИТ-инфраструктуры на стадионе «Открытие Арена» занял у нас 2 года. Было проложено 4500 портов СКС, сделана СКПТ на 180 ТВ-панелей, введены в эксплуатацию две СХД на 50ТБ каждая, четыре двухсокетных Rack-mount сервера для платформы виртуализации, 87 точек Wi-Fi, АТС на 250 абонентов и 36 базовых станций DECT.

Стадион стал одним из первых объектов в России, где были применены СХД Huawei Oceanstor, ИБП UPS2000, серверы Tecal и СКПТ/Digital Signage на базе решения Tripleplay. Сегодня ЛАНИТ занимается сервисной поддержкой этих решений. Это опорные решения. За время эксплуатации они успели обрасти другими ИТ-сервисами, в том числе депозитной клубной картой, которую можно использовать как для прохода на стадион, так и для оплаты покупок/дополнительных услуг на территории спорткомплекса.

Ведется активное дооснащение стадиона для приема матчей FIFA в 2018 году. Оно затрагивает и ИТ-инфраструктуру. Причем довольно серьезно, поскольку в 2011 году, когда мы вели проектирование, стадион «Открытие Арена» не планировал участвовать в этом мероприятии.

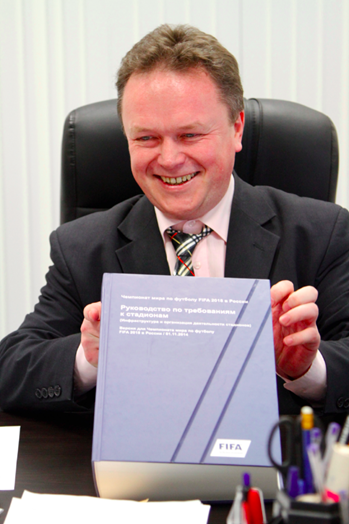

В руках ИТ-директора стадиона «Открытие Арена» Игоря Шестунова талмуд требований FIFA к стадионам (порядка 900 страниц)

Проект получился довольно успешным. В 2014 году компания Huawei обявила его «Проектом года», а написанный ее инженерами патч вошел в состав следующей версии ОС Huawei AR2240. О надежности оборудования Huawei заказчик также отзывается позитивно, в том числе об UPS2000. Нам так и не представилась возможность оценить работу сервисного центра Huawei по доставке нового оборудования взамен того, что мы обеспыливали, так как за все время эксплуатации ни одно устройство Huawei не вышло из строя.

Нет нареканий и к решению IPTV/Digital Signage от Tripleplay. Положительные рекомендации от ИТ-службы стадиона «Открытие Арена» позволили нам предложить похожее решение для реконструкции стадиона «Лужники», которая закончилась в мае 2017 года.

Приятно, что англичане также учли опыт стадиона «Открытие Арена» и за три года значительно улучшили и без того неплохую систему, в том числе в части архитектуры. На «Лужниках» приставки set-top-box уже не нужны, вместо них используются плееры MagicInfo, встроенные в ТВ-панели Samsung. Удаленное управление ТВ-панелями работает по ЛВС без внешнего контроллера и осуществляется через WEB-интерфейс администратора системы. Мы обязательно расскажем о Tripleplay в одном из наших следующих постов.

Этот проект научил нас не бояться предлагать заказчику новые решения, если они ему действительно подходят, и если вендор, который их производит, готов тебя поддерживать. Все, что мы предложили стадиону и внедрили в 2012-2014 годах, в 2017 году востребовано и работает. Пожалуй, это главный показатель успешности и эффективности данного проекта.

Комментарии (29)

Toliyn

09.08.2017 15:50Не знаю чья это зона ответственности, но весной этого года что-то было не так с цветами на одном из экранов.

Звук во время первого полугода после запуска был ужасен. В конце прошлого сезона, со звуком снова были какие-то проблемы.

Raccooon Автор

09.08.2017 16:28+3Видеотабло и систему звукоусиления ЛАНИТ на «Открытие Арене» не делал. Периодически мы действительно что-то слышим про нарекания к работе этих систем, но без конкретики. Там, кстати, причина может быть не в проектных решениях, а в банально не совсем корректной настройке оборудования. Это виднее службе эксплуатации и тому, кто делал проекты по этим системам.

alex1299

10.08.2017 00:56+1Я правильно понимаю, что матчи транслируются на тв панелях по IPTV? Очень любопытно, какая получилась задержка? И с удовольствием почитал бы про ваш опыт с Tripleplay.

Спасибо!

Raccooon Автор

10.08.2017 10:20+2Действительно, задержка — это интересный вопрос. Причем в большей части не из-за самой платформы IPTV, а из-за конвертации сигнала в цепочке SDI-HDMI-IPTV. Дополнительную задержку вносит сам телевизор. В некоторых случаях, когда все это складывается, речь может идти о секундах. Поэтому, например, для ТВ-панелей на комментаторских позициях IPTV в принципе не используется, только коаксиал. Однако в большинстве случаев это совершенно не принципиально, ты заметишь задержку только, если будешь одновременно смотреть на поле и в телевизор. Или если соберешь стенд и будешь специально ее мерить.

В нашем отдельном посте про Tripleplay мы подробно коснемся данного вопроса.

Задержка конкретно между чем и чем интересует?Wan-Derer

15.08.2017 09:54Задержка SDI-HDMI чуть меньше чем ни фига. Основную задержку вносит компрессия перед парковкой в IP.

fgor

10.08.2017 10:17Я был там с референс визитом, когда Вы только запускались(2014 год кажется) на этом стадионе.

Так получилось, что мы попали под санкции и как раз рассматривали «Плохой Путь» в ИТ.

И вот, что для себя усвоил и приметил:

Сотрудники Вашей компании сидели за цисками(коммутатор, ASA) — на вопрос почему — ответили, что китайское сетевое оборудование еще настраивается(При этом уже прошло 2 мероприятия — ну как так о_0).

Персонал стадиона сказал, что на мероприятия(игры) приезжают Китайцы, так как ни кто не понимает, как оно работает.

Данный ЦОД(который весь построен от Китайского вендора) по словам персонала стадиона использовался только(!) для внутреннего офиса и для продажи билетов. Все боевое Фифа запретила ставить от неизвестного на то время китайского производителя.

Вообщем сложилось итоговое впечатление, что кроме содействия(~80%) данный производитель ни чем не мог порадовать

:(

Т.е. это проект скорее не технический, а политический. Так как ставить никем, нигде и ни на чем/ком непроверенное оборудование можно только по политическим причинам(если вы понимаете о чем я).

Raccooon Автор

10.08.2017 10:18+2Ну давайте по порядку.

Сотрудники нашей компании сидели за оборудованием Cisco, которое мы специально привезли с нашего демо-стенда. Оно было нужно для того, чтобы понять на чьей стороне проблема с SIP-транком — SBC или Aastra. Когда на ASA транк заработал, Aastra была исключена из списка подозреваемых. Как только проблема на AR2240 была решена, мы увезли Cisco обратно на демо-стенд. Huawei действительно помогал настраивать оборудование (в основном, SBC), еще приезжал за референсами и пофотографироваться.

Вы правы, ЦОД действительно используется только для внутреннего офиса и для продажи билетов. Это нормально, в райдере FIFA это называется «режим наследие».

ФИФА по последней версии своей концепции из своего боевого оборудования никакие серверы на стадионах вообще не ставит — оно живет во внешних дата-центрах. Даже ЛВС для сервисов FIFA на стадионе делается отдельная, в отдельных стойках, причем Ядро — в отдельном серверном помещении.

На счет политики совершенно не соглашусь, т.к. инвестиции на проекте — частные, у меня сложилось прочное впечатление, что Заказчика совершенно не интересует политика ИТ-рынка.

fgor

10.08.2017 11:49транк на ASA? — научите меня как МСЭ превратить в атс.

ASA использовали Ваши сотрудники для удаленного доступа и выход в интернет, так как МСЭ от Китайских партнеров на то время были бета-версией и не работали от слова — «совсем». Коммутатор Cisco использовали, так как постоянно перенастраивали Китайские коммутаторы — пытаясь добиться их адекватной работы(Ура привет Длинк№2).

А я насчет политики полностью соглашусь, так как откат в 80% сжигает жадные мозги менеджерам на всей пищевой цепочке(Дистрибутор — Интегратор- Начальство ИТ частной компании) и как эти % поделятся как раз зависит от понимания ситуации заказчиком.

И вот Начальство ИТ в частной компании, как раз наиболее заинтересованные люди в таких схемах — их в отличии гос.заказчиков мало кто проверяет на, что они потратили деньги.

Расскажите где с 2013 года Китайский партнер серьезно развернулся? Готов с Вами вести дискуссию на эту тему, так как очень серьезно изучал их.

caban

10.08.2017 13:29транк на ASA? — научите меня как МСЭ превратить в атс.

Вы же явно знаете, что SIP не очень хорошо дружит с NAT, поэтому я допускаю что в одном случае NAT работал в другом нет. А про откаты было интересно услышать, да.

Raccooon Автор

10.08.2017 14:52+2ASA – очепятка, в ходе ПНР для имитации функционала SBC мы использовали Cisco2811. Huawei USG5530 запустился без малейших проблем. Ни ASA, ни коммутаторов Cisco мы на этом проекте вообще не применяли. Так что Вы либо путаете, либо Вы общались не с сотрудниками Ланита. Хуавей нас в этом проекте действительно приятно порадовал, и надежностью оборудования, и работой технической поддержки…

fgor

10.08.2017 15:15Ох, как жаль, что я не фотографировал.

И ASA и коммутатор стояли сзади стоек, т.е. за оборудованием Хуавей. Я не общался с сотрудниками Ланита, но видел как они настраивают в ЦОД-е(кстати там было достаточно тепло).

Раз Вас так порадовал Хуавей(содействеим конечно), то давайте я Вам расскажу как оно работает:

1. Хуавей не создает в Москве(да и в России) службы тех.поддержки;

2. У них в Москве несколько Русских инженеров и они постоянно меняются(текучка);

3. Колл-центр находится в Новосибирске — и это именно колл-центр не более того;

4. При первых же проблемах, вендор шлет к интегратору(Ланит, Джет, Софтлайн итд), если интегратор не справляется то удаленно пытаются сами и в итоге приезжает Китайский десант.

5. О божечки же ты мой, приезжают Китайцы и они тупо делают видеомост по QQ до своих программистов в континентальном Китае.

6. Пишется индивидуальный патч-прошивка под Вас. Всё!

Заметьте в Москве есть несколько постоянно меняющихся инженеров и это только сетевики(роутинг, свитчинг). Все остальные продукты(UC,Wi-Fi,SDN итд) сидят сами китайцы.

Не смотря на то, что они бьют себя в грудь и говорят — да у Нас в Новосибирске полноценная тех.поддержка, на самом деле реальные вопросы переправляются в Китай, а настройка ACL или Etherchannel — это да, в Новосибирске.

Давайте посмотрим, как работает первая линия обороны — инженеры в интеграторах. Увы но нет ни порталов, ни форумов, ни комьюнити по этому чудо оборудованию. И все что могут ребята это задавать вопросы на китайском(!) форуме через гугл транслэйт! И внимание они пишут там на китайском. А теперь представьте эту цепочку(Русский-Английский- Китайский и наоборот).

Вы знаете общая картина такова, что вендору не интересен наш рынок, он не создает рабочие места, нормальную поддержку, а тупо покупают взятками быдло-папуасов. Достаточно вспомнить как США пугнули хуавей санкциями за Крым и они тут же отказались официально поставлять в Крым

И вот самое поразительное — это никак не укладывается в голове по сравнению с бизнесом провайдерского оборудования(в том числе и сотовых операторов), где все выстроено нормально.

Вы так и не ответили — сколько Вы проектов реализовали на этом оборудовании с 2013 года?

Raccooon Автор

11.08.2017 10:20В серверной стадиона стоит не только оборудование, за которое отвечает Ланит. У меня такое подозрение, что Вы видели оборудование Cisco, которое ставил для себя один из арендаторов (банк, если мне не изменяет память).

Так сложилась жизнь, что лично у меня с 2014 года на Хуавее проектов не было. У Ланита были, но я не уполномочен рассказывать о них от лица всего Ланита. Если референсы по Хуавею действительно интересны — можно обратиться к самому Хуавею, или посетить какую-нибудь конференцию, Хуавей периодически приглашает туда своих Заказчиков с презентациями.

fgor

11.08.2017 12:28О том и речь, что нет ни чего у них серьезного, да уже и не интересно.

Оборудование Cisco было от Ланита, ну по крайней мере мне так сказал представитель ИТ стадиона.

Schalker

10.08.2017 10:19+1интерестно. спасибо за статью. особенно понравилась " о китайцах". я тоже намучился с ними на «моем хозяйстве» ( см. аватор ).

А вот о IPTV/Digital Signage от Tripleplay хотелось бы поподробнее.

Raccooon Автор

10.08.2017 14:58+2Всегда пожалуйста :) Trepleplay, действительно, заслуживает отдельного поста. Мы уже над этим работаем

xe_xe

10.08.2017 12:43Даа, знатный зоопарк получился.

Вообще, за годы работы сложилось впечатление, что за все те деньги, которые платятся за AMX, Crestron и Digital-signage решения, команда из нескольких человек в течение нескольких месяцев могла бы написать свой велосипед с любыми функциями, фишками и плюшками на базе Linux\Windows и маленьких ПК.

То, что для управления телеками вместо DS-системы используется отдельный контроллер AMX, показательно…

Кстати, в музее стадиона (где всю мультимедийку делала наша компания), используется Crestron :)

Еще один плюс в копилку зоопарка и головной боли для службы IT :)

Обычно, в таких случаях приводят контр-аргументы в виде глючности, ненадежности и сложности с поддержкой самодельных велосипедов. Но опыт показывает, что решения на базе специализированных контроллеров такие же глючные, не сильно легче в поддержке, и так же требуют программирования, причем, на экзотических языках.

При этом к багам своих разработчиков еще добавляются баги разработчиков Crestron\AMX\whatever, коих тоже предостаточно.

Да и само железо у того же Crestron'а сильно испортилось за последние годы.

А то, что не связались с C-nario, наверное, даже хорошо.

Немного поработал с этим софтом волею судеб. Тех денег, которые за него хотят, он, по-моему не стоит.

А очевидные баги, найденные мной, они даже рассматривать не хотят, потому что «купите сервис контракт, тогда и поговорим».

Raccooon Автор

10.08.2017 12:46+2В целом согласен. Тогдашнее решение по управлению ТВ-панелями от Tripleplay нас не устроило, поэтому мы от него отказались. Модель контроллера выбирал Заказчик. Сейчас TripePlay решение доработал, на БСА «Лужники» внешних контроллеров для управления ТВ-панелями уже не нужно.

extrawelt

10.08.2017 13:11+4Отличный пост, большое спасибо за интересное повествование работы. Хоть и немного не моя сфера, но понравилось.

Полностью соглашусь с вами, ситуация в которой различные технологические сети/вентиляция по факту проходят совершенно не по проекту, это просто бич. Обычная ситуация, когда кто первый зашел на объект, тот и успел и потом смотри и думай, что делать. Очень большой риск вывести из строя оборудование, когда оно ставится в еще строящийся объект и потом пылиться до пнр.

Raccooon Автор

10.08.2017 14:49+2Вам спасибо!

Если оборудование пылится до ПНР — с этим еще можно что-то делать, если оно вынуждено месяцами работать в условиях сильной запыленности, да еще и без (в обход) ИБП — эта ситуация куда хуже

tmax23

11.08.2017 10:00А мне вот интересно, каким образом производился расчет характеристик и количество серверов Tecal?

Raccooon Автор

11.08.2017 10:05+1Мне тоже интересно.

Заказчик в ТЗ написал, что ему нужно 4 сервера такой-то конфигурации.

По-хорошему в таких случаях надо делать сайзинг. На БСА Лужники мы его делали, причем он пригодился не только для защиты перед заказчиком, но и Мосэкспертизе — она затребовала расчеты вычислительных нагрузок серверной фермы, чем приятно удивила.

Не исключено что Заказчик сайзинг и делал, просто нам его не показывал. Единственное, на что пришлось обратить внимание — на стадионе 2 серверных, и все должно должно работать если одна серверная полностью обесточена. Поэтому сайзинг умножается на два.

Wan-Derer

15.08.2017 09:38Какая-то очень менеджерская статья. Всё-то у автора exciting… Из техники в основном перечисление брендов…

При том что проект-то, в общем, обыкновенный. А для лавки с 25-летним стажем, так вообще рядовой-один-из-многих

FreakII

//офтоп

Очень не нравится бездумное калькирование английских конструкций типа Barclaycard Arena. Ну не говорится так по-русски — «Открытие Арена»! Либо Арена «Открытие», либо открытие арены, что, понятное дело, совсем не о том.

«Открытие Зал». «Спартак Манеж». «Зенит Стадион».

Alexeyco

Открытие. Сага. Арена.

misato

К сожалению, этот формат наименования уже вошёл в обиход, и практически все новые стадионы называют подобным образом. Вероятно, так удобнее для рекламодателей, которые покупают наименование.