Привет, хабр! В преддверии старта продвинутого курса «Разработчик iOS», мы традиционно подготовили для вас перевод полезного материала.

Core ML — это библиотека машинного обучения, выпущенная в свет Apple на WWDC 2017.

Она позволяет iOS разработчикам добавлять в свои приложения персонализированный опыт в режиме реального времени с использованием передовых локальных моделей машинного обучения с помощью Neural Engine.

Начинка чипа A11 Bionic

12 сентября 2017 Apple представила миру чип A11 Bionic с Neural Engine. Это нейросетевое аппаратное обеспечение может выполнять до 600 базовых операций в секунду (BOPS) и используется для FaceID, Animoji и других задач машинного обучения. Разработчики могут использовать Neural Engine с помощью Core ML API.

Core ML оптимизирует производительность на устройстве за счет использования ресурсов центрального процессора, графического процессора и Neural Engine, минимизируя объем памяти и энергопотребление.

Core ML является основой для фреймворков и функционала данной предметной области. Core ML поддерживает Vision для анализа изображений, Natural Language для обработки текста, Speech для преобразования звука в текст и Sound Analysis для идентификации звуков в аудио.

Core ML API

Мы можем легко автоматизировать задачу построения моделей машинного обучения, что включают в себя обучение и тестирование модели, используя Playground, и интегрировать полученный файл модели в наш iOS проект.

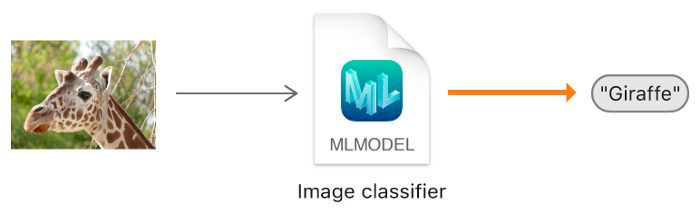

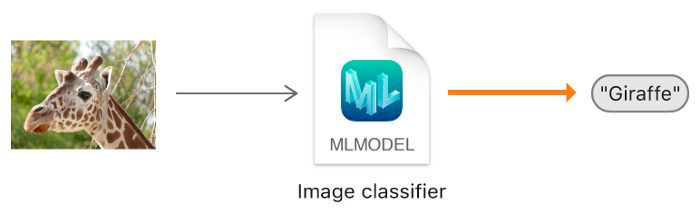

Общая блок-схема Core ML

В этом уроке я покажу вам, как построить модель классификатора изображений с использованием Core ML, который может классифицировать изображения апельсинов (Orange) и клубники (Strawberry), и добавить эту модель в наше iOS приложение.

Модель классификатора изображений.

Прикладные программы:

При сборе данных для классификации изображений следуйте следующим рекомендациям Apple.

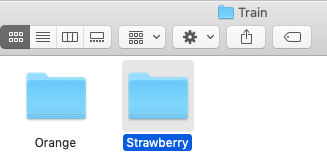

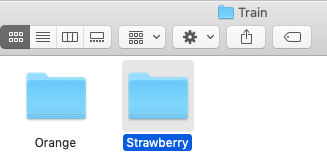

После того как вы собрали ваш набор данных (Data Set), разделите его на обучающий (Train) и проверочный (Test) наборы и поместите их в соответствующие папки

В нашем случае у нас есть две папки, в каждой из которых лежат соответствующие изображения.

Не паникуйте! Apple значительно упростила эту задачу, автоматизировав основные этапы.

С Core ML вы можете использовать уже обученную модель для классификации входных данных или создать свою собственную. Для применения моделей классификации к изображениям и предварительной обработки этих изображений, и чтобы сделать задачи машинного обучения более простыми и надежными, с Core ML уже работает фреймворк Vision.

Просто следуйте этим шагам.

ШАГ 1: Откройте ваш X-code.

ШАГ 2: Создайте чистую Swift Playground.

ШАГ 3: Удалите код сгенерированный по умолчанию, добавьте следующую программу и запустите

Описание:

Здесь мы открываем интерфейс билдера модели по умолчанию предоставленного XCode.

ШАГ 4: Перетащите папку с обучающей выборкой в область обучения.

Поместите папку с обучающей выборкой в область обучения, обозначенную пунктирными линиями.

Шаг 5: Xcode автоматически обработает изображение и начнет процесс обучения. По умолчанию на обучение модели уходит 10 итераций, в зависимости от характеристик вашего Mac и размера набора данных. Вы можете наблюдать за ходом обучения в окне терминала Playground.

Жду пока происходит обучение модели.

ШАГ 6: После завершения обучения вы можете проверить свою модель, перетащив папку Test в область тестирования. Xcode автоматически протестирует вашу модель и отобразит результат.

Как вы можете заметить, наша модель точно классифицировала изображения .

ШАГ 7: Сохраните вашу модель.

Интеграция в iOS приложение:

ШАГ 1: Откройте ваш X-code.

ШАГ 2: Создайте Single Page iOS приложение.

ШАГ 3: Откройте навигатор проекта

Введение

Core ML — это библиотека машинного обучения, выпущенная в свет Apple на WWDC 2017.

Она позволяет iOS разработчикам добавлять в свои приложения персонализированный опыт в режиме реального времени с использованием передовых локальных моделей машинного обучения с помощью Neural Engine.

Обзор чипа A11 Bionic

Начинка чипа A11 Bionic

Количество транзисторов: 4.3 миллиарда

Количество ядер: 6 ядер ARM (64 бита) – 2 высокочастотных (2.4 ГГц) — 4 с низким энергопотреблением

Количество графических процессоров: 3

Neural Engine – 600 базовых операций в секунду

12 сентября 2017 Apple представила миру чип A11 Bionic с Neural Engine. Это нейросетевое аппаратное обеспечение может выполнять до 600 базовых операций в секунду (BOPS) и используется для FaceID, Animoji и других задач машинного обучения. Разработчики могут использовать Neural Engine с помощью Core ML API.

Core ML оптимизирует производительность на устройстве за счет использования ресурсов центрального процессора, графического процессора и Neural Engine, минимизируя объем памяти и энергопотребление.

Запуск модели локально на устройстве пользователя устраняет необходимость в сетевом подключении, что помогает сохранять конфиденциальность данных пользователя и улучшает отклик вашего приложения.

Core ML является основой для фреймворков и функционала данной предметной области. Core ML поддерживает Vision для анализа изображений, Natural Language для обработки текста, Speech для преобразования звука в текст и Sound Analysis для идентификации звуков в аудио.

Core ML API

Мы можем легко автоматизировать задачу построения моделей машинного обучения, что включают в себя обучение и тестирование модели, используя Playground, и интегрировать полученный файл модели в наш iOS проект.

Совет для новичков: Выделяйте отдельные метки для задач классификации.

Общая блок-схема Core ML

Ладно. Что мы будем создавать?

В этом уроке я покажу вам, как построить модель классификатора изображений с использованием Core ML, который может классифицировать изображения апельсинов (Orange) и клубники (Strawberry), и добавить эту модель в наше iOS приложение.

Модель классификатора изображений.

Подсказка для новичков: Классификация изображений относится к задачам обучения с учителем, в которых мы используем помеченные данные (в нашем случае метка (label) — название изображения).

Необходимый минимум:

- Знание языка Swift

- Основы iOS разработки

- Понимание концепций объектно-ориентированного программирования

Прикладные программы:

- X-code 10 или более поздняя версия

- iOS SDK 11.0+

- macOS 10.13+

Сбор данных

При сборе данных для классификации изображений следуйте следующим рекомендациям Apple.

- Используйте минимум 10 изображений на категорию — чем больше, тем лучше.

- Избегайте сильно несбалансированных наборов данных, подготовив примерно равное количество изображений на каждую категорию.

- Сделайте вашу модель более надежной, включив параметры Create ML UI’s Augmentation: Crop, Rotate, Blur, Expose, Noise и Flip.

- Не брезгуйте избыточностью для своих тренировочных наборов: снимайте много изображений под разными углами, с разным фоном и в разных условиях освещения. Имитируйте реальные условия съемки, включая шум и размытость изображения.

- Сфотографируйте образцы объектов в ваших руках, чтобы имитировать реальных пользователей, которые пытаются классифицировать объекты в своих руках.

- Исключайте из поля зрения другие объекты, особенно те, которые вы хотите классифицировать по-другому.

После того как вы собрали ваш набор данных (Data Set), разделите его на обучающий (Train) и проверочный (Test) наборы и поместите их в соответствующие папки

ВАЖНОЕ ПРИМЕЧАНИЕ : Убедитесь что вы распределили изображения по соответствующим папкам внутри папки test. Потому что имя папки служит меткой для наших изображений.

В нашем случае у нас есть две папки, в каждой из которых лежат соответствующие изображения.

Создание модели

Не паникуйте! Apple значительно упростила эту задачу, автоматизировав основные этапы.

С Core ML вы можете использовать уже обученную модель для классификации входных данных или создать свою собственную. Для применения моделей классификации к изображениям и предварительной обработки этих изображений, и чтобы сделать задачи машинного обучения более простыми и надежными, с Core ML уже работает фреймворк Vision.

Просто следуйте этим шагам.

ШАГ 1: Откройте ваш X-code.

ШАГ 2: Создайте чистую Swift Playground.

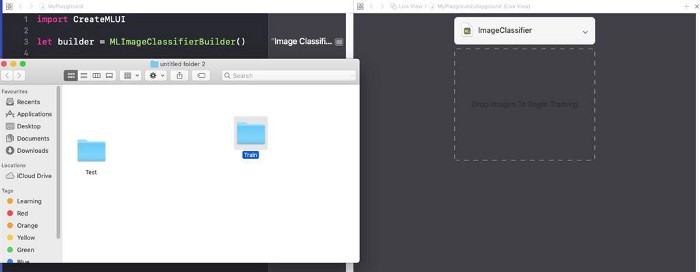

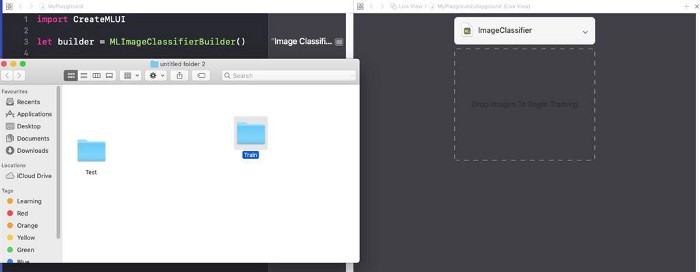

ШАГ 3: Удалите код сгенерированный по умолчанию, добавьте следующую программу и запустите

playground. import CreateMLUI //Импортируем нужный модуль

let builder = MLImageClassifierBuilder()

//Создаем инстанс MLImageClassifierBuilder

builder.showInLiveView()

//Показывает интерфейс редактора Xcode Model builderОписание:

Здесь мы открываем интерфейс билдера модели по умолчанию предоставленного XCode.

ШАГ 4: Перетащите папку с обучающей выборкой в область обучения.

Поместите папку с обучающей выборкой в область обучения, обозначенную пунктирными линиями.

Совет для новичков : Мы также можем указать произвольное имя для нашей модели, щелкнув стрелку вниз в области обучения.

Шаг 5: Xcode автоматически обработает изображение и начнет процесс обучения. По умолчанию на обучение модели уходит 10 итераций, в зависимости от характеристик вашего Mac и размера набора данных. Вы можете наблюдать за ходом обучения в окне терминала Playground.

Жду пока происходит обучение модели.

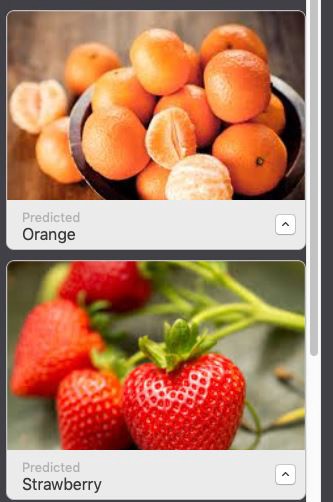

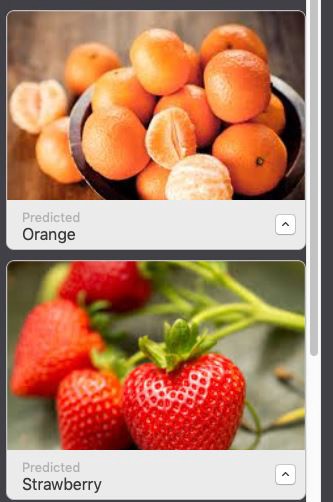

ШАГ 6: После завершения обучения вы можете проверить свою модель, перетащив папку Test в область тестирования. Xcode автоматически протестирует вашу модель и отобразит результат.

Как вы можете заметить, наша модель точно классифицировала изображения .

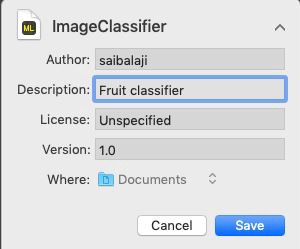

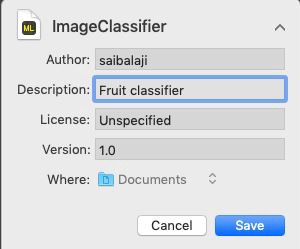

ШАГ 7: Сохраните вашу модель.

Интеграция в iOS приложение:

ШАГ 1: Откройте ваш X-code.

ШАГ 2: Создайте Single Page iOS приложение.

ШАГ 3: Откройте навигатор проекта