Эта статья - авторства Эми Бойд. Подробнее о ней вы можете узнать здесь.

На одном из докоронавирусных мероприятий Microsoft Reactor в Лондоне я посетила действительно интересный семинар Future Recoded, посвященный этике в искусственном интеллекте.

Я знаю, что вы подумали…

"Очередной семинар по этике в ИИ, на котором рассказывают, что все вредоносно, а программисты и специалисты по анализу данных совершают уйму ошибок. И сейчас нам расскажут, как этих ошибок избежать".

Но этот семинар стал исключением… И запомнился мне необычайно свежим подходом.

Безусловно, мы должны обсуждать и анализировать прошлые ошибки, чтобы научиться применять эти мощные технологии для всеобщего блага. Однако этот семинар открыл мне глаза на то, как проверять ИИ-проекты, идеи и даже новый бизнес на здравый смысл.

Здесь нужно отдать должное автору — замечательному докладчику и писателю Майклу Робсону. Майкл, надеюсь мне удастся поделиться твоим пониманием и заставить моих читателей задуматься, как это случилось со мной.

Для начала Майкл задал несколько на первый взгляд простых вопросов. Попробуйте ответить на них сами (потом я поделюсь своими ответами).

Вы бы доверили искусственному интеллекту…

Порекомендовать вам продукт?

Защитить ваши данные в Интернете?

Помогать вам за рулем?

Управлять вашей машиной?

Следить за вашим здоровьем?

Выдавать вам лекарства?

Выбрать няню?

На некоторые из них было легко ответить. Мы привыкли к рекомендациям нашего любимого интернет-магазина или к мониторингу здоровья через приложение. Нам нравится, когда умные часы напоминают больше двигаться.

Однако некоторые вопросы заставили меня задуматься. Например, об автомобиле, который меня везет. Я никогда такого не пробовала, но знаю, что сейчас есть машины, которые ездят сами, так что все должно быть в порядке, правда? Или о выдаче лекарств — это все еще компьютер. Что, если в программе ошибка и она пропишет неправильную дозу (здесь я выражаю свое общее беспокойство ?). Но в здравоохранении часто используются технологии, так что и здесь все в порядке, верно?

Вопрос о выборе няни был неожиданным… ?

Давайте рассмотрим этот сценарий

Скажем, компания А — это служба, которая сканирует действия потенциальных нянь в социальных сетях и выставляет оценку, основанную на том, "насколько они могут быть безопасными" с учетом определенных критериев.

Этот пример основан на реальной компании и реальном сценарии использования.

Вы собеседуете множество разных людей, а эта служба проверяет социальные сети каждого кандидата.

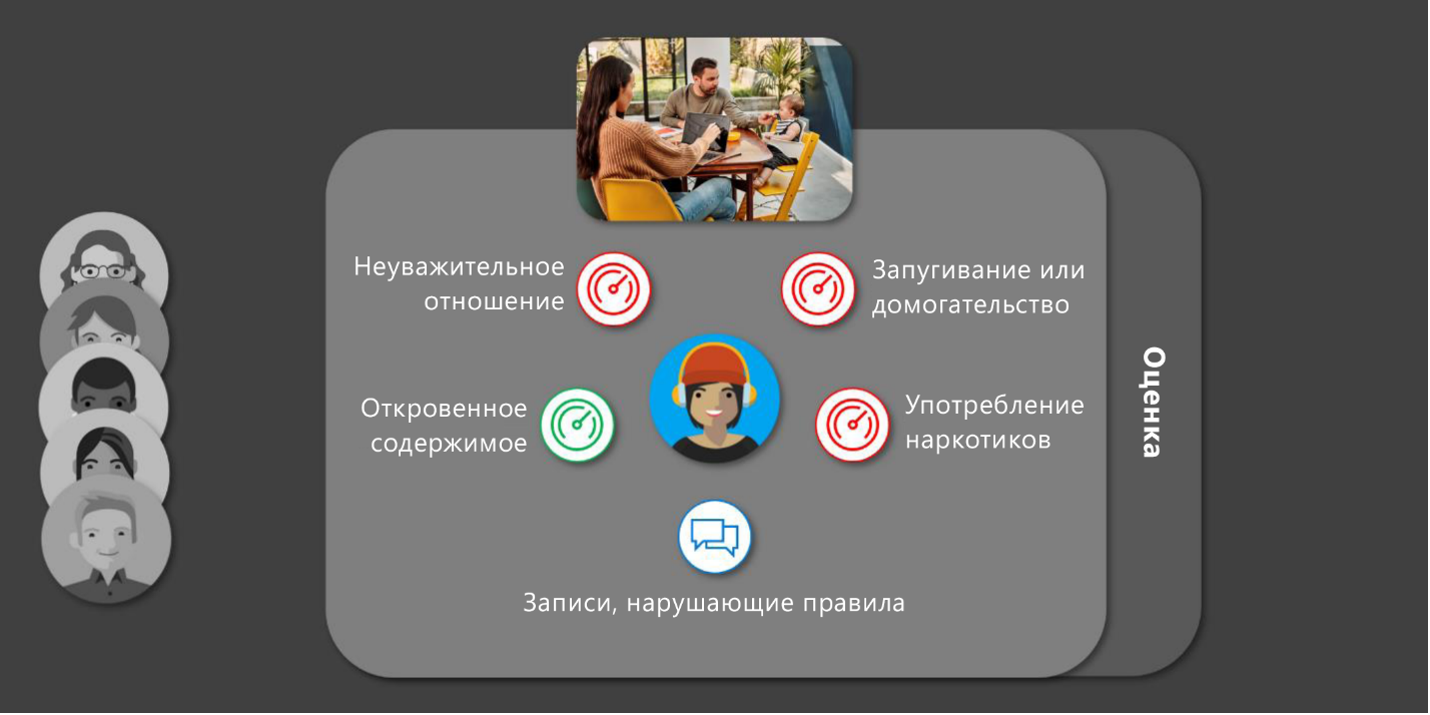

Она оценивает соискателя по определенным критериям, таким как "Неуважительное отношение", "Откровенный контент", "Запугивание или домогательства" и т. п., а затем выставляет оценку (напоминает мне кредитный рейтинг).

На первый взгляд, это служба, которая помогает решить, можно ли доверить конкретному человеку заботу о ребенке. Она также помогает эффективно отсеивать кандидатов, когда их много.

Большой вопрос: этичен ли такой подход?

Чтобы ответить на этот вопрос, мы должны определить для себя понятие этичности? Майкл подробно рассказал о том, как понимать это слово.

Определение в словаре:

Этика — философское учение о морали, ее развитии, принципах, нормах и роли в обществе.

Возможно, лучше начать с размышлений о том, что значит быть этичным человеком. Заботиться о благополучии людей? Теория морали часто строится на какой-то одной ценности. Майкл выделяет пять ценностей.

Итак, если рассматривать этику в целом с точки зрения благополучия людей, то этика данных должна оценивать, как данные влияют на благополучие людей.

Новый подход — FATE

FATE значит fairness (справедливость), accountability (подотчетность), transparency (прозрачность) и ethics (этичность). Миссия одной из исследовательских групп Microsoft:

изучать сложные социальные последствия искусственного интеллекта, машинного обучения, обработки и анализа данных, крупномасштабных экспериментов и возрастающего уровня автоматизации. Их цель — продвигать инновационные и этичные методы вычислений, учитывая более глубокий контекст этих вопросов из социологии, истории, научных и технологических исследований.

Справедливость: искусственный интеллект должен повышать эффективность, не унижая человеческого достоинства, и защищать от предвзятости.

Подотчетность: искусственный интеллект должен иметь алгоритмическую подотчетность, чтобы люди могли устранить непреднамеренный вред.

Прозрачность: искусственный интеллект должен быть прозрачным и интеллектуально обеспечивать конфиденциальность.

Этичность: искусственный интеллект должен поддерживать человечность.

Чтобы лучше понять эти концепции, ознакомьтесь с блогами и вебинарами на веб-сайте FATE.

Когда Майкл разбил эти общие концепции на потенциальные вопросы в каждой категории, у меня появилась интересная идея для практической основы — начальный набор вопросов для оценки планируемых проектов в области ИИ.

Думая о компании А, взгляните на эти вопросы, а затем спросите себя или свой коллектив, вызывает ли что-то опасения (потом я поделюсь соображениями, которые возникли у меня на семинаре).

Ниже перечислены мои первоначальные мысли во время семинара, исходя из информации о компании А.

Будет ли алгоритм относиться к старшему поколению иначе из-за того, что его представители мало или совсем не активны в социальных сетях? Исключит ли он их за это из числа потенциальных кандидатов?

Кто несет ответственность за окончательное решение, связанное с наймом подходящего человека на работу: компания А или родители?

На каких типах данных обучался искусственный интеллект? Есть ли предвзятость по отношению к определенным демографическим категориям, странам и т. п.? Эта информация должна быть опубликована, чтобы пользователи службы понимали ее ограничения.

У меня было еще несколько вопросов о том, как определяется каждая категория и выставляется оценка.

Могут ли плохие кандидаты "переиграть" систему, воздействуя на свои собственные социальные сети до сканирования?

Прежде чем задать себе эти вопросы, я подумала о компании А: "Это немного необычно, но, возможно, все в порядке?" Теперь я могу конкретнее указать причины, по которым я или другие могут беспокоиться об использовании данных или службы.

Теперь я буду использовать этот подход для оценки идей в моих проектах и спрашивать других их мнение по четырем критериям:

справедливость, подотчетность, прозрачность и этичность.

Что читаете вы?

В этой статье я хотела поделиться интересными концепциями, которые услышала на семинаре Майкла: идеями, вопросами и подходами, которые помогут проверить этичность вашего проекта в области искусственного интеллекта.

Это лишь небольшая часть более масштабного процесса — оценки этики данных. Поделитесь в комментариях своими любимыми ресурсами по таким вопросам, как:

оценка предвзятости в наборах данных;

и т. д.