Особо амбициозные разработчики любят заявлять о том, что используемый ими язык программирования или фреймворк будет жить лет сто. Дерзкое заявление, учитывая, что разработке программного обеспечения, как таковой, всего около 65 лет. А фреймворки ещё моложе.

Можно почитать Пола Грэма и его разглагольствования о столетнем языке. Но он имеет в виду немного другое: язык, потомки которого будут с нами и через 100 лет в более или менее узнаваемом виде. То есть, если язык C заменит Algol, это нормально. Пола интересует другое, а именно, какие функции Algol достаточно хороши, чтобы выжить при переходе на новый язык.

А мне интересно, какие языки все ещё будут использоваться через 100 лет.

Есть такое популярное мнение: «чтобы язык можно было использовать и через сто лет, он должен иметь хорошую производительность». Как бы вы оценили подобное заявление? По каким критериям проводили оценку?

Это не риторический вопрос. Приступаем к оценке.

Что могут рассказать нам древнейшие языки?

Раз уж языкам программирования всего 65 лет, у нас попросту нет примеров столетнего языка. Зато есть несколько языков программирования, которым 60 и более лет. Что мы можем о них сказать?

Как только язык становится популярным, он обычно не умирает, но часто мутирует. Версия Fortran 2008 года не совсем похожа на Fortran77 или оригинальный Fortran (1957 год). Но у них много общего. Язык остаётся узнаваемым, у него есть стабильное сообщество программистов. Фортран всегда был популярен в научном и математическом сообществах и остаётся таковым до сих пор. Например, Fortran является основным языком программирования для суперкомпьютеров, для которых в приоритете высокая производительность, а значит, нужен максимально быстрый язык. Fortran значительно быстрее, чем, к примеру, C. Именно потребность в высокой скорости и преданное сообщество разработчиков дают Фортрану дыхание жизни.

Получается, когда мы говорим про столетний язык, мы на самом деле не имеем в виду преемственность синтаксиса или функций. Мы ищем сообщество непрерывного программирования. Интересным примером является Perl: версия Perl 6 (теперь называемая Raku) должна была внести значительные изменения в язык, что и произошло. Но процесс занял много лет. В итоге Perl 5 оформился как отдельное сообщество, а Perl 6 пришлось пробиваться, как новому языку. Если бы изменения Perl 6 случились быстро, мы бы, конечно, до сих пор имели единое Perl-сообщество. Perl 1 и 2 сильно отличались от Perl 5, но никто и не думал считать их разными языками. То есть именно раскол среди разработчиков превратил Perl 6 в другой язык.

Ещё одним старым языком является LISP, у которого множество потомков, включая Guile, Scheme, Clojure и Racket. Они никогда не были особо популярны, но исчезать не собираются. LISP не умер, хотя умерли многие его небольшие диалекты. У более крупных диалектов (например, CommonLISP) есть свой собственный импульс, и они тоже никуда не делись. Итак: речь не всегда идёт именно об одноязычном сообществе программистов. Вы можете возразить, что даже если Clojure разрастётся до огромных размеров, сам LISP останется мёртвым. Но речь идёт об очень конкретном, оригинальном LISP. Как и в случае с Perl 1, его потомки сильно изменились, но в них по-прежнему легко узнаётся один и тот же базовый язык. Что еще более важно, вы можете легко выучить новый диалект LISP, если знаете старый. У них много общего.

Как могут умереть языки?

Я говорю "язык мёртв" в том же смысле, в каком мертва латынь. Существуют небольшие изолированные сообщества академических и религиозных носителей латыни. Но это не повседневный язык для значительного числа людей.

Если вы этого ещё не сделали, советую прочитать статью об истории языков программирования.

Алгол (1958) мёртв. У него есть потомки, но они мало похожи на Алгол. Итак: это один из вариантов того, как может умереть язык. Его могут полностью “съесть” более совершенные потомки, которые заберут всю его пользовательскую базу. «Семейство алголов» включает в себя таких дальних родственников, как Perl, и менее используемые ответвления вроде Delphi. А ещё туда входят C, C++, Visual BASIC и Java. Это чрезвычайно популярные языки, которые давно поглотили всё сообщество разработчиков Алгола. В частности С был молодым и чрезвычайно популярным, поэтому не было никаких причин продолжать использовать Алгол.

Некоторые языки так и не прижились. FLOW-MATIC был первым языком Грейс Хоппер до того, как она написала COBOL. Да, он оказал влияние на COBOL, но сам по себе никогда особо не использовался. И многие ныне мёртвые языки были такими: мало пользователей, маленькие коммюнити.

Сюда также можно включить множество «протоязыков». Это языки, которые по большей части мутировали во что-то другое. FLOW-MATIC превратился в COBOL, поэтому его крошечное сообщество пользователей перетекло в сообщество COBOL. Именно так многие языки умирают: они присоединяются к другому языку, и их сообщество становится частью сообщества этого нового языка.

«Предшественники» и протоязыки не обязательно должны разрабатываться одними и теми же людьми. FACT (1959) сейчас считается предшественником COBOL, поскольку он повлиял на дизайн, и его пользователи стали частью сообщества COBOL. Но FACT не был проектом Грейс Хоппер. Точно так же C был назван в честь BCPL. Пользователи BCPL (их было не так много) стали пользователями C. Но BCPL был написан Мартином Ричардсом, который не входил в число авторов C. Так что дело даже не в том, кто написал язык. Речь идёт о том, куда переходит сообщество его пользователей.

Что значит мёртвый?

Прежде чем идти дальше, остановимся на очевидном и несколько глупом использовании слова «мёртвый» в отношении языков программирования.

Языки программирования пишутся людьми для людей. Это человеческий язык и человеческая культура. Они точно так же создают функциональные компьютерные программы. Они точно так же восприимчивы к тенденциям, как и любой другой человеческий язык или культура.

Когда вы слышите, что «Rails мертв», это вовсе не означает, что «ни одна программа больше не использует Rails», «ни одна компания больше не использует Rails», или «никакие новые проекты не написаны на Rails». Они означает лишь, что «Rails больше не популярен, и вместо него вы должны изучить что-то другое».

Это также может означать, что для программистов на Rails меньше рабочих мест, чем для тех, кто владеет другими языками, меньше фреймворков или технологий. Может означать, что основатели стартапов предпочитают что-то другое. Но совершенно не означает, что Rails в принципе больше не используется или вообще непригоден.

Так что определение “мёртвый” в смысле потери популярности можно спокойно игнорировать для любого языка, которому более 25 лет. Он в любом случае не является новым, популярным или сильно раскрученным. Абсолютное, 100%-е требование к 100-летнему языку — быть, по этому определению, мертвым.

Что ослабляет языки

Языки не умирают сразу. Они медленно угасают, пока последний пользователь не перейдёт на другой язык.

Кое-что серьёзно раскалывает сообщество. Perl 5 и Raku стали намного слабее после разделения. Переход Python от версии 2 к версии 3 был трудным и стоил ему части аудитории. Переход Ruby с 1.8 на 1.9 был схожим, хотя и не таким медленным и драматичным. Когда вы делаете что-то, что раскалывает сообщество, оно естественным образом становится слабее. В крайних случаях, таких как с Perl, сообщество становится настолько маленьким, что может вымереть.

Это одна из причин, по которой языки уничтожаются их собственными потомками. Зачем оставаться с Algol, когда существует C? Зачем оставаться с FLOW-MATIC, если автор перешёл на COBOL? Потомок языка часто более привлекателен для сообщества, чем сам язык.

Что ещё более важно, языковые сообщества, как правило, переходят на тот инструмент, который решает те же проблемы. Разработчики переходят с Perl на Ruby или Python — языки, решающие схожие задачи аналогичным образом. Между Python и R существует постоянное противостояние, потому что оба решают задачи для статистического анализа данных. То есть языком пользуются не ради самого языка, а ради решения вполне конкретных проблем.

Проблема обычно не только в том, что у языка появляется новый конкурент, а в том, что старое решение перестаёт работать. Ruby и Rails имели репутацию феноменально простого стека для разработки веб-приложений по сравнению со старыми средами Java, такими как JBoss. Но в более поздних версиях Rails пришлось всё больше и больше укреплять инфраструктуру из-за угроз безопасности, что усложнило развёртывание. В свою очередь облачная PaaS-платформа Heroku перестала предлагать бесплатный тарифный план, а очевидной замены для неё не оказалось. Следовательно, Rails сейчас сложнее развёртывать, чем раньше. А значит, она хуже решает проблемы пользователей. Это ослабляет фреймворк и сам язык Ruby, который подпитывался от сообщества пользователей Rails.

Итак, языки начинают угасать, если они перестают решать проблему так же хорошо, как раньше, или если появляется конкурент, который решает проблему лучше.

Что укрепляет язык?

Если язык должен решать проблемы пользователей, это означает, что проблема имеет первостепенное значение.

Нишевость укрепляет язык. Язык R отлично подходит для статистического анализа данных и занимает важное место в этом сообществе. Никто не станет писать на нём операционную систему, с этим согласны все участники, но оно и не требуется.

Java — самый популярный в последнее время язык общего назначения. Все последующие являются нишевыми: Python хорош в математике, научном программировании и программировании искусственного интеллекта, а Ruby отлично обрабатывает динамические веб-приложения. JavaScript доминирует в браузерном программировании и нескольких связанных с ним ниш на стороне сервера. Fortran, когда-то универсальный, теперь используется в суперкомпьютерах и некоторых математических приложениях. C отступает в нишу операционных систем и драйверов, поэтому теперь он исключён из общего программирования приложений.

Ниши — это сила.

Я не утверждаю, что «Java — это последний язык общего назначения». Учитывая 65-летнюю историю языков программирования, заявлять такое было бы странно. 27 лет существования Java не означают, что не будет другого популярного языка общего назначения. Но, действительно, скорее всего такие языки будут появляться редко.

Чтобы язык действительно мог претендовать на универсальность, следует избегать нишевости. Даже у Java есть некоторые существенные ограничения на сферы применения, например, большой объем памяти делает его сомнительным для небольших встроенных процессоров. Может быть, «универсальность» вообще сойдёт на нет, размывшись многими и разными нишами.

С другой стороны, ниша означает, что у языка есть фокус и цель. Нишевость сильна, потому что она сообщает своему сообществу, для кого предназначен язык и какие задачи решает.

Нужна ли производительность столетнему языку?

Fortran, один из старейших процветающих языков, который продолжает жить благодаря производительности. Это серьёзный аргумент “за”.

LISP, ещё один из старейших, совершенно не заботится о производительности, но процветает благодаря гибкости и простоте реализации. Это аргумент “против”.

Впрочем, у нас тут не голосование. На деле цель Fortran — производительность, а LISP уделяет основное внимание гибкости и удобству. Так что мы опять возвращаемся к цели использования. Нужна ли производительность? Смотря какие задачи решает язык.

Производительность — это неплохо. Но если вы спросите сообщество Fortran: «Нужно ли вам больше простоты в реализации вашего компилятора?» они скажут «Без разницы». Сообщество LISP не может сказать, что их вообще не волнует производительность, но им интересны и гибкие варианты с низкой производительностью. Вопрос не в том, «хороша ли высокая производительность?» Вопрос в том, «какое место она занимает в вашем списке приоритетов?»

BASH, оболочка командной строки, имеет довольно низкую производительность и всегда была таковой. Но не этим он притягивает пользователей. Сообществу требуется совместимость, стабильность и простота использования. Если бы вы сделали массовую высокопроизводительную версию BASH, её использовало бы всего несколько человек. Точнее его бы использовали, если бы это не было не в ущерб одной из основных целей. Таким образом, наш гипотетический высокопроизводительный BASH уже мертворожденный, потому что «универсальная доступность» и «100% совместимость» слишком важны для его сообщества.

Меняются ли приоритеты?

Если что-то не было приоритетом на заре появления языка, это не означает, что сейчас оно таковым не является. Первые версии Ruby или Python могли быть очень медленными, но часть их нынешних пользователей может заботиться о производительности гораздо больше, чем о выразительности. Возможно, PHP изначально был ориентирован на простоту развертывания, но нынешняя база пользователей фреймворка Laravel может захотеть более чистого, более выразительного основного языка, ради которого готова пожертвовать совместимостью и доступностью.

Тут нет ничего невозможного.

Проблема в преемственности сообщества. Очень сложно отогнать одно сообщество, а потом привлечь другое. Слишком много старой информации о языке теперь неактуально. Неверная информация привлекает людей, которые вам не нужны, и отталкивает тех, которым нужно ваше текущее предложение. Итак: изменение того, что было фишкой приложения, — одна из самых опасных вещей, которые могут произойти с языком. Это может стать причиной раскола сообщества, о котором говорилось ранее.

Вы можете внести небольшие изменения. Немного дополнительной производительности никого не оттолкнет. Но в какой-то момент вам придётся идти на компромисс.

Ruby стал использоваться более крупными компаниями. В целом это хорошо. Но это также было и переломным моментом. Стоит ли снижать выразительность из-за того, что неограниченная выразительность вызывает проблемы с большими командами? Может быть. А если внести это изменение, увеличит ли оно размер сообщества Ruby и продолжительность его жизни? Подобные изменения несут в себе самые большие риски смерти языка.

Между прочим, это одна из причин, по которой проекты по оптимизации Ruby, такие как YJIT и TruffleRuby, не стремятся ограничивать возможности Ruby. Дополнительная производительность — это хорошо, но именно благодаря выразительности Ruby получил своих фанатов. Производительность — это круто, если она не ставит под угрозу выразительность. Да, это касается не всех языков, но для Ruby оно работает именно так.

Быстрее, медленнее

Беспокойство по поводу приоритетов стало причиной того, что переход с Python 2 на Python 3 занял так много времени и мучений. Python делает очень медленные, преднамеренные изменения с отличной обратной совместимостью. В тех редких случаях, когда он нарушает обратную совместимость, пользователи воспринимают это как предательство.

С Ruby было легче, потому что Ruby не обещает такой большой обратной совместимости. Их философия скорее такая: «в основном мы сохраняем некоторую обратную совместимость, но иногда, когда мы хотим сделать язык лучше, что-то ломается, так что вам придётся подстроиться». В результате Python рулит в математическом/научном сообществе, которому нужны программы, способные работать и 20 лет спустя, а Ruby завоевал сообщество веб-программистов, где стандарты меняются каждые 5 лет.

Между прочим, это не означает, что Ruby прав, а Python нет, или наоборот. Это снова к вопросу о нишах. Можно быть настолько крутым в чём-то одном, что вы обойдёте язык общего назначения, который вроде бы подходит для всего, но уступает в конкретных параметрах нишевым языкам.

Язык, завоевавший веб-нишу, быстро меняется, как Ruby. Язык, завоевавший нишу математики/науки, медленно меняется, как Python.

Не исключено, что один язык может быть НАСТОЛЬКО хорош, что завоюет сразу оба сообщества. Но в конце концов ему придётся конкурировать с потомками, которые снова будут превосходить его по тому или иному критерию.

Кстати, именно так и вышло с Perl. Давным-давно Perl был единственным языком сценариев. И он всё ещё неплох для объединения больших кусков текстовых файлов. Но теперь он конкурирует с Ruby, который быстро меняется, и с Python, который меняется медленно. Ruby занял веб-нишу, которую Perl, соответственно, потерял.

Это не ограничивается языками сценариев. C++ меняется намного быстрее, чем C, по разным причинам. C получил преимущество в некоторых областях за счёт медленных изменений. Как часто разработчики драйверов меняют языки? Им нравится стабильность. C++, который меняется быстрее, получил популярность в других областях, таких как программирование приложений. Это далеко не единственная разница между C и C++. Но она важна.

Слон в посудной лавке

Мы ещё не успели толком поговорить про COBOL. Программистов на COBOL немного, и практически все они обслуживают старый код. Многие миллионы строк COBOL поддерживают работу огромного количества банковской инфраструктуры. Он оставался на своём месте, практически без изменений, в течение десятилетий. Там, где от COBOL избавлялись, обычно делали механический перевод с COBOL на другой язык (в основном Java).

С точки зрения количества строк кода, COBOL ещё жив и бодр. Если завтра весь код COBOL испарится, вся международная банковская система мгновенно рухнет.

С точки зрения людей, которые используют его для новых проектов, COBOL почти мертв. На COBOL написано очень, очень мало новых проектов.

Так он жив или мёртв? Скорее мёртв, чем жив.

Не существует большого сообщества разработчиков COBOL. COBOL — это то, что происходит, если вы никогда не вносите изменений в язык, в конечном итоге, ваше сообщество уже не заботится о том, что именно вы предоставляете. Меняться — значит рисковать. Язык может умереть немного или насовсем. Никогда не меняться — значит умереть абсолютно точно.

Может, дело в том, что COBOL устарел? Не совсем. COBOL немного моложе Fortran, а Fortran на удивление здоров и энергичен в своей нише.

Это напоминает нам о том, что фраза «этот язык никуда не исчезнет, его использует компания X» не совсем верна. Google широко использует C++, но это не должно быть единственной причиной его выживания. Ruby используется Shopify, но это только одна из причин его долговечности.

Вам нужны новые пользователи, новые обещания, новая кровь.

Как устаревают обещания?

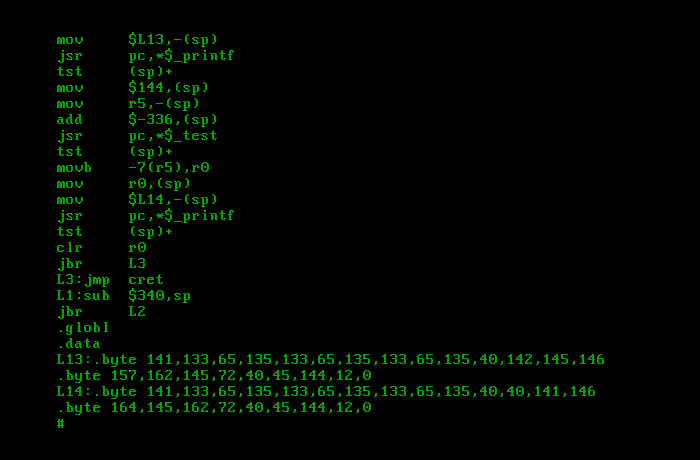

Одним из старых обещаний (особенностей) C было вести себя как компьютер PDP-11. Он по-прежнему делает это, но это больше не является приоритетом. Как ни странно, ранний LISP делал то же самое. Это старые языки. Эти функции можно рассматривать как старые обещания.

Первоначально LISP требовалось совсем немного производительности — ровно столько, чтобы сделать его математическую выразительность работоспособной. Со временем процессоры стали быстрее, и от этого отказались — car и cdr определённо не дают простой доступ к регистрам в современных реализациях LISP, и никого это не волнует. Если производительность приемлемая, остальное не так важно. И планка «приемлемости» на тот момент была довольно низкой. CommonLISP, например, был намного медленнее, чем C, и в основном это считалось нормальным.

Вы можете подумать, что для C такие изменения будут проходить сложнее. Если C обещает быть похожим на процессор, то что он делает, когда процессор меняется? Новые процессоры используют инструкции SIMD, например, инструкции Intel SSE. Они выполняют операции с большими массивами, и это очень важно для быстрого выполнения объёмных задач. C никогда не добавлял для них никакой абстракции. Он по-прежнему выглядит в основном как PDP-11, в котором такого не было.

Но часто мы не понимаем, какие особенности важны для нашего сообщества разработчиков. C не должен быть самым быстрым языком. В противном случае такие проблемы, как перекрытие указателей, заставили бы его первых пользователей обратиться к Фортрану, более быстрому языку без этой проблемы.

C всегда был достаточно быстрым, приятным языком, который обеспечивал хороший баланс между мощностью и производительностью. И, честно говоря, в период расцвета у него было меньше конкурентов, поэтому он мог особо не беспокоиться о своих особенностях и своей нише. Современный C в его современной нише (операционные системы, драйверы устройств, низкоуровневое системное программирование) больше ориентирован на управление, чем на производительность. Его производительность должна быть приемлемой, но, в первую очередь, речь идёт о точных побитовых макетах. Если тут и там сбрасывается несколько циклов процессора, остаётся ещё много свободного времени. Поэтому драйверы устройств всё ещё пишутся не на Фортране.

Особенности меняются с годами. Они должны. Не нужно избегать любых изменений. Нужно правильно управлять ими.

Как сильно меняются обещания языков программирования? Язык C родом из 1972 года, он появился 50 лет назад. Благодаря всем изменениям, которые он претерпел за эти годы, он находится на полпути к тому, чтобы стать столетним языком. Он всё ещё крепок и полон сил. Думаю, у него получится.

Итак, как продержаться 100 лет?

Что, если вы хотите, чтобы ваш язык просуществовал 100 лет? Что, если вы состоите в языковом сообществе, которое вам нравится, или вы языковой дизайнер? Что бы вы сделали, чтобы создать столетний язык?

Вы не можете просто сосредоточиться на особенностях языка и синтаксисе. Чтобы сохранить язык живым, нужно знать, что вы обещаете своему сообществу. Почему они здесь? Это бывает непросто: конкретная новая функция — это хорошо или плохо? Иногда вы попадаете в конфликт с основной причиной, по которой аудитория пользуется языком. В Fortran пользователи не оценят выразительность в ущерб скорости. В Руби наоборот. В Rust безопасность памяти занимает одно из первых мест в списке приоритетов. В C возможность возиться с памятью всякими странными способами ценится больше, чем безопасность.

Ни один из приоритетов не является неправильным. Они определяются нишей.

Это также означает, что нужно быть осторожным, «вырываясь из своей ниши». Ваша ниша — ваша сила. Есть все признаки того, что в будущем языки будут больше ориентированы на ниши, а не меньше.

Это также означает, что следовать различным известным советам Генри Форда стоит очень осторожно. «Если бы я спросил людей, чего они хотят, они бы попросили более быструю лошадь.». «Автомобиль может быть любого цвета, если этот цвет – черный». Иногда вы можете проявить дальновидность и дать своему сообществу то, о чем они и не думали просить. Но если они говорят, что им что-то не нужно, стоит прислушаться. На каждого Генри Форда в мире приходится очень много людей, которые совсем не Генри Форды и угадывают хреново.

Спросите себя: «Каковы ваши обещания и особенности?» Подумайте о том, как они устаревают. Будут ли люди нуждаться в том, что вы предлагаете, через 100 лет? Что им было нужно 100 лет назад?

Да, это сложно. Но стоит понимать, что 100 лет – это на самом деле очень долго.

А как вы считаете, какой язык программирования в ближайшее время умрёт?

Комментарии (338)

MentalBlood

00.00.0000 00:00+24Между Python и R существует постоянное противостояние, потому что оба решают задачи для статистического анализа данных

Python в отличие от R не специализирован для анализа данных. Его особенность — развитая экосистема и низкий порог входа, который хорошо синергировал со скачком популярности ML и DS

P.S. А, там дальше Python уже "нишевый язык". Это как называть компьютеры нишевыми устройствами потому что большинство использует их для просмотра веб-страниц, например

leotsarev

00.00.0000 00:00+8Питон нишевый язык, но не для анализа данных. Он для задач, где требуется с минимум логики склеивать готовые компоненты. Анализ данных — это подмножество этого.

MaratCdek

00.00.0000 00:00+37Fortran значительно быстрее, чем, к примеру, C.

Как это? Как это понимать?

serg_meus

00.00.0000 00:00+45Перефразируя старый анекдот.

Встретились как-то два программиста, один писал на Фортране, другой на Си.

-- Фортран значительно быстрее, чем Си, -- сказал первый.

-- Интересно, чем?

-- Чем Си.

unclejocker

00.00.0000 00:00+15Я по диагонали глянул, судя по всему, дело в том, что там очень много встроенных операций для матриц, например, оптимизацией компиляции которых под разные архитектуры занимались последние 50 лет.

Т.к. и C и Fortran компилируются в машинный код, то наверняка на C можно так же эффективно написать, но это потребует гораздо большего навыка и усилий (а может и вставок на ассемблере), а пользователи фортрана получают все это готовое.

Aldrog

00.00.0000 00:00+2На C вместо них обычно используются различные реализации blas, которые также очень тщательно вылизаны, так что сомнительный аргумент.

IvaYan

00.00.0000 00:00+16И по иронии судьбы, BLAS может оказаться написан на... Fortran. Как например OpenBLAS и ATLAS.

JustMoose

00.00.0000 00:00+2Может быть. А может быть и нет. Я полистал вики. Там действительно упоминается Netlib BLAS - The official reference implementation on Netlib, written in Fortran 77.[39]

Плюс, там же про BLAS пишут, что "It originated as a Fortran library in 1979[1] and its interface was standardized by the BLAS Technical (BLAST) Forum, whose latest BLAS report can be found on the netlib website.[2] This Fortran library is known as the reference implementation (sometimes confusingly referred to as the BLAS library) and is not optimized for speed but is in the public domain.[3][4]"

То есть, эталонная реализация действительно была написана на фортране в 1979.

Однако про ATLAS пишут уже "It provides a mature open source implementation of BLAS APIs for C and Fortran77." - кажется, что ключевое слово здесь "for". То есть, этот самый ATLAS можно использовать ДЛЯ фортрана. Но сам ATLAS написан на вполне себе Си. Я скачал исходники с гитхаба, там внутри от фортрана - только тесты (видимо библиотеке на вход подаются файлики фортрана и проверяется, правильно ли они интерпретируются).

OpenBLAS я тоже скачал, так же как и его прародителя GotoBLAS2. Да, там есть исходники на фортране. В папке test. И в папке lapack. Во всех остальных местах лежит чистый Си.

vadimr

00.00.0000 00:00Но сам ATLAS написан на вполне себе Си.

Вообще-то на ассемблере (собственно вычислительное ядро). На Си это (работу с SSE и другими векторными процессорами) написать невозможно.

JustMoose

00.00.0000 00:00Дело не в Си. Дело в компиляторах. Если верить вот этой статье аж от 2015 года (7 лет прошло!), то обычная студия может генерировать SSE из циклов без какого-либо участия программиста.

Там первой строчкой в статье ссылка на зипарь с результирующим ассемблером. И там действительно внутри SSE!

Ну а вообще, в 21 веке оптимизирующие компиляторы стали вполне умными. Можно открыть Голову Дракона (ниже) и полистать. Там, имхо, половина книжки про оптимизацию.

Ахо, Лам, Сети, Ульман. Компиляторы: принципы, технологии и инструментарий, 2-е изд.

vadimr

00.00.0000 00:00Компиляторы-то умные, но сам язык Си не имеет для этого выразительных средств. Попробуйте на Си написать функцию, перемножающую матрицы, и вы получите сначала проблему с чисто формальным определением параметров, а потом невекторизуемый код.

JustMoose

00.00.0000 00:00Ну так не надо использовать Си. Есть же С++. Можно слепить класс для хранения матрицы с интерфейсом на любой вкус, переопределить оператор умножения и радоваться. Про невекторизуемый код - не верю. Если компилятор из статьи смог заоптимизировать один цикл, то что ему мешает оптимизировать вложенный цикл, который нужен для перемножения матриц?

vadimr

00.00.0000 00:00+1Вопрос в том, как эта матрица будет представлена в оперативной памяти. Если как массив указателей на массивы, то не будет регулярности адресов по второму измерению, что сделает невозможной векторизацию. Если руками намастырить монолитную область памяти и явно прописывать адресную арифметику, то оптимизатору будет непросто в этом разобраться, да и чем это лучше ассемблера.

В Фортране массив A (M, N) представляет собой непрерывную область памяти размером M*N элементов. A (*, 1) – первый столбец, непрерывная область памяти. A (1, *) – первая строка, интервал между адресами всех элементов строго равен M. То же самое с текстовыми строками, которые являются массивами символов фиксированной длины. Ну и т.д. Векторизовать это очень просто.

eptr

00.00.0000 00:00+3Если руками намастырить монолитную область памяти и явно прописывать адресную арифметику, то оптимизатору будет непросто в этом разобраться, да и чем это лучше ассемблера.

А если использовать массив массивов, то правильная адресная арифметика уже будет неявно "встроена", и оптимизатору будет в этом "разобраться" куда проще.

vadimr

00.00.0000 00:00+2В Си массив массивов понимается как массив указателей на массивы, а не как двухмерный массив. Там не будет регулярности адресов элементов, вследствие чего невозможны векторные операции над столбцами. Только над строками.

eptr

00.00.0000 00:00Вы проверять пробовали?

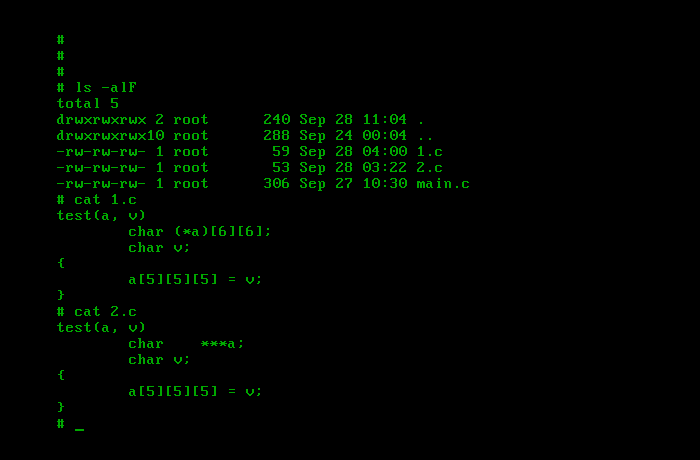

#define M 2 #define N 3 #define ELEMS(a) (sizeof (a) / sizeof *(a)) void fun(void) { char const a[M][N] = {0}; printf("sizeof a: %zu\n", sizeof a); printf("&a: %p\n", (void const *)&a); for (size_t m = 0; m < ELEMS(a); ++ m) { printf("\tsizeof a[%zu]: %zu\n", m, sizeof a[m]); printf("\t&a[%zu]: %p\n", m, (void const *)&a[m]); for (size_t n = 0; n < ELEMS(a[m]); ++ n) { printf("\t\t&a[%zu][%zu]: %p\n", m, n, (void const *)&a[m][n]); } } }Результат будет выглядеть примерно так:

sizeof a: 6 &a: 0x7fffc4b8de7a sizeof a[0]: 3 &a[0]: 0x7fffc4b8de7a &a[0][0]: 0x7fffc4b8de7a &a[0][1]: 0x7fffc4b8de7b &a[0][2]: 0x7fffc4b8de7c sizeof a[1]: 3 &a[1]: 0x7fffc4b8de7d &a[1][0]: 0x7fffc4b8de7d &a[1][1]: 0x7fffc4b8de7e &a[1][2]: 0x7fffc4b8de7fВ C массив массивов понимается как массив массивов.

vadimr

00.00.0000 00:00+3Теперь сделайте M и N переменными.

Попробуйте на Си написать функцию, перемножающую матрицы, и вы получите сначала проблему с чисто формальным определением параметров, а потом невекторизуемый код.

eptr

00.00.0000 00:00+2Теперь сделайте M и N переменными.

Сделал:

#define ELEMS(a) (sizeof (a) / sizeof *(a)) void fun(size_t const M, size_t const N) { char a[M][N]; memset(&a, 0, sizeof a); printf("sizeof a: %zu\n", sizeof a); printf("&a: %p\n", (void const *)&a); for (size_t m = 0; m < ELEMS(a); ++ m) { printf("\tsizeof a[%zu]: %zu\n", m, sizeof a[m]); printf("\t&a[%zu]: %p\n", m, (void const *)&a[m]); for (size_t n = 0; n < ELEMS(a[m]); ++ n) { printf("\t\t&a[%zu][%zu]: %p\n", m, n, (void const *)&a[m][n]); } } } #define M 2 #define N 3 int main(void) { fun(M, N); return EXIT_SUCCESS; }Результат:

sizeof a: 6 &a: 0x7ffc19160190 sizeof a[0]: 3 &a[0]: 0x7ffc19160190 &a[0][0]: 0x7ffc19160190 &a[0][1]: 0x7ffc19160191 &a[0][2]: 0x7ffc19160192 sizeof a[1]: 3 &a[1]: 0x7ffc19160193 &a[1][0]: 0x7ffc19160193 &a[1][1]: 0x7ffc19160194 &a[1][2]: 0x7ffc19160195Предвосхищая возможное дальнейшее предложение поработать в таком же стиле с динамически выделенной памятью, сделаю и это:

#define ELEMS(a) (sizeof (a) / sizeof *(a)) void fun(void const *const p, size_t const M, size_t const N) { char const (*const a)[M][N] = p; printf("sizeof a: %zu\n", sizeof *a); printf("&a: %p\n", (void const *)a); for (size_t m = 0; m < ELEMS(*a); ++ m) { printf("\tsizeof a[%zu]: %zu\n", m, sizeof (*a)[m]); printf("\t&a[%zu]: %p\n", m, (void const *)&(*a)[m]); for (size_t n = 0; n < ELEMS((*a)[m]); ++ n) { printf("\t\t&a[%zu][%zu]: %p\n", m, n, (void const *)&(*a)[m][n]); } } } #define M 2 #define N 3 int main(void) { void *const p = calloc(M, N); if (p) { fun(p, M, N); free(p); } return EXIT_SUCCESS; }Результат:

sizeof a: 6 &a: 0x45e2a0 sizeof a[0]: 3 &a[0]: 0x45e2a0 &a[0][0]: 0x45e2a0 &a[0][1]: 0x45e2a1 &a[0][2]: 0x45e2a2 sizeof a[1]: 3 &a[1]: 0x45e2a3 &a[1][0]: 0x45e2a3 &a[1][1]: 0x45e2a4 &a[1][2]: 0x45e2a5В C массив массивов понимается как массив массивов.

vadimr

00.00.0000 00:00+2Переменными сделайте M и N, а не подставляйте вместо них препроцессором константы 2 и 3.

eptr

00.00.0000 00:00+3Переменными сделайте M и N, а не подставляйте вместо них препроцессором константы 2 и 3.

Да, давайте ещё и константность везде поубираем, чтобы она вас не смущала.

И чтобы компилятор не смог ничего лишнего соптимизировать, запутаем способ получения

MиN, да так, чтобы в выражениях для их вычисления ещё и ни единой константы не было.Вариант с VLA:

#define ELEMS(a) (sizeof (a) / sizeof *(a)) void fun(size_t M, size_t N) { char a[M][N]; memset(&a, 0, sizeof a); printf("sizeof a: %zu\n", sizeof a); printf("&a: %p\n", (void *)&a); for (size_t m = 0; m < ELEMS(a); ++ m) { printf("\tsizeof a[%zu]: %zu\n", m, sizeof a[m]); printf("\t&a[%zu]: %p\n", m, (void *)&a[m]); for (size_t n = 0; n < ELEMS(a[m]); ++ n) { printf("\t\t&a[%zu][%zu]: %p\n", m, n, (void *)&a[m][n]); } } } int main(int argc, char **argv) { (void)argv; size_t M = argc + argc; size_t N = argc * (argc + argc) + argc; fun(M, N); return EXIT_SUCCESS; }Это я знаю, что программа будет запускаться без параметров, и

argcбудет равен1.Но компилятор из этого не может исходить, тем более, что я же могу второй раз ту же уже скомпилированную программу и с параметром запустить.

Результат:

sizeof a: 6 &a: 0x7ffca25fa910 sizeof a[0]: 3 &a[0]: 0x7ffca25fa910 &a[0][0]: 0x7ffca25fa910 &a[0][1]: 0x7ffca25fa911 &a[0][2]: 0x7ffca25fa912 sizeof a[1]: 3 &a[1]: 0x7ffca25fa913 &a[1][0]: 0x7ffca25fa913 &a[1][1]: 0x7ffca25fa914 &a[1][2]: 0x7ffca25fa915Вариант с динамически выделяемой памятью:

#define ELEMS(a) (sizeof (a) / sizeof *(a)) void fun(void *p, size_t M, size_t N) { char (*a)[M][N] = p; printf("sizeof a: %zu\n", sizeof *a); printf("&a: %p\n", (void *)a); for (size_t m = 0; m < ELEMS(*a); ++ m) { printf("\tsizeof a[%zu]: %zu\n", m, sizeof (*a)[m]); printf("\t&a[%zu]: %p\n", m, (void *)&(*a)[m]); for (size_t n = 0; n < ELEMS((*a)[m]); ++ n) { printf("\t\t&a[%zu][%zu]: %p\n", m, n, (void *)&(*a)[m][n]); } } } int main(int argc, char **argv) { (void)argv; size_t M = argc + argc; size_t N = argc * (argc + argc) + argc; void *p = calloc(M, N); if (p) { fun(p, M, N); free(p); } return EXIT_SUCCESS; }Результат:

sizeof a: 6 &a: 0x119f2a0 sizeof a[0]: 3 &a[0]: 0x119f2a0 &a[0][0]: 0x119f2a0 &a[0][1]: 0x119f2a1 &a[0][2]: 0x119f2a2 sizeof a[1]: 3 &a[1]: 0x119f2a3 &a[1][0]: 0x119f2a3 &a[1][1]: 0x119f2a4 &a[1][2]: 0x119f2a5Есть ещё идеи?

В C массив массивов понимается как массив массивов, причём независимо от того, какой это массив, обычный или VLA.

Более того, в этом стиле доступна работа и с динамически выделенной памятью, причём даже в этом случае размерности каждого массива не обязаны быть константами времени компиляции.

В этом смысле Fortran не имеет преимуществ перед C.

vadimr

00.00.0000 00:00+2Видите как, уже пришлось перейти к void*, передаче отдельно от массива его размеров и адресной арифметике полувручную. А когда вы ещё учтёте возможность выравнивания, будет совсем вручную.

Причём компилятор-то не знает, что значение M - это длина строки массива, и не может им воспользоваться при загрузке вектора в векторный процессор.

eptr

00.00.0000 00:00+5Видите как, уже пришлось перейти к void*

Почему вы решили, что именно "пришлось"?

Смотрите, как можно совсем без `void *`:

#define ELEMS(a) (sizeof (a) / sizeof *(a)) void fun(size_t M, size_t N, char (*a)[M][N]) { printf("sizeof a: %zu\n", sizeof *a); printf("&a: %p\n", (void *)a); for (size_t m = 0; m < ELEMS(*a); ++ m) { printf("\tsizeof a[%zu]: %zu\n", m, sizeof (*a)[m]); printf("\t&a[%zu]: %p\n", m, (void *)&(*a)[m]); for (size_t n = 0; n < ELEMS((*a)[m]); ++ n) { printf("\t\t&a[%zu][%zu]: %p\n", m, n, (void *)&(*a)[m][n]); } } } int main(int argc, char **argv) { (void)argv; size_t M = argc + argc; size_t N = argc * (argc + argc) + argc; char (*a)[M][N] = calloc(M, N); if (a) { fun(M, N, a); free(a); } return EXIT_SUCCESS; }Результат:

sizeof a: 6 &a: 0x19fb2a0 sizeof a[0]: 3 &a[0]: 0x19fb2a0 &a[0][0]: 0x19fb2a0 &a[0][1]: 0x19fb2a1 &a[0][2]: 0x19fb2a2 sizeof a[1]: 3 &a[1]: 0x19fb2a3 &a[1][0]: 0x19fb2a3 &a[1][1]: 0x19fb2a4 &a[1][2]: 0x19fb2a5передаче отдельно от массива его размеров

Верно, это же C, и вы сами выбрали случай, когда размерности становятся известны только в run-time'е.

Их в любом случае необходимо передавать, только в других языках это происходит "под капотом", и отменить это нельзя, а здесь, хоть и требуется выполнять явную передачу, но, зато этим можно управлять (передавать или не передавать, если не требуется).

и адресной арифметике полувручную

Где здесь, особенно в последнем варианте, адресная арифметика? (1)

Что значит, "полувручную"? (2)

А когда вы ещё учтёте возможность выравнивания, будет совсем вручную.

Функции

malloc/calloc/reallocвозвращают адрес с выравниванием, достаточным для хранения любого стандартного объекта.Если же передаётся адрес настоящего массива, то он, по определению, выровнен.

Зачем вы пытаетесь найти изъяны там, где их нет?

Причём компилятор-то не знает, что значение M - это длина строки массива, и не может им воспользоваться при загрузке вектора в векторный процессор.

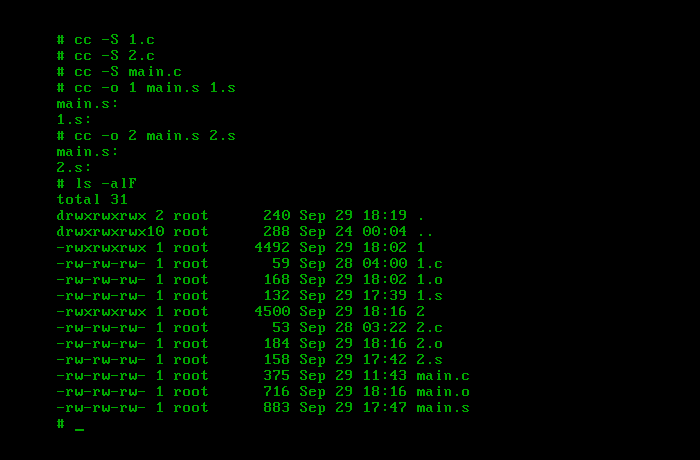

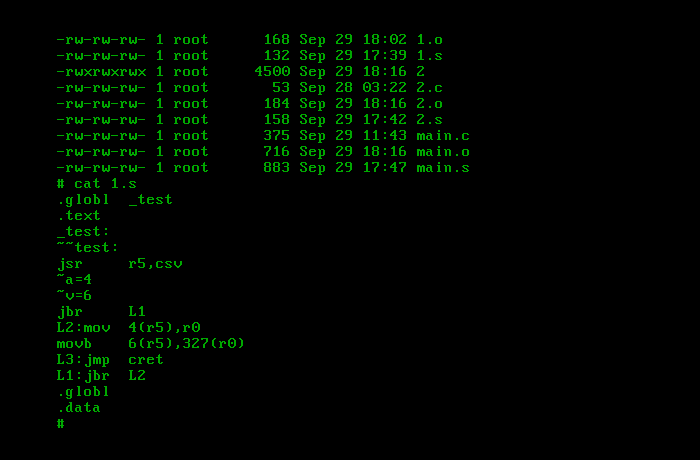

Возьмём следующий код (ссылка на godbolt):

#include <stdlib.h> #include <stdio.h> #include <string.h> #define K 1000 #define ELEMS(a) (sizeof (a) / sizeof *(a)) typedef int type; void add(size_t M, size_t N, type (*a)[M][N], type (*b)[M][N], type (*c)[M][N]) { for (size_t m = 0; m < ELEMS(*a); ++m) { for (size_t n = 0; n < ELEMS((*a)[m]); ++n) { (*a)[m][n] = (*b)[m][n] + (*c)[m][n]; } } } void fill(size_t M, size_t N, type (*x)[M][N], type y) { for (size_t i = 0; i < ELEMS(*x); ++i) { for (size_t j = 0; j < ELEMS((*x)[i]); ++j) { (*x)[i][j] = y; } } } int main(int argc, char **argv) { (void)argv; int m = argc + argc; int n = m + argc * argc; size_t M = m * K; size_t N = n * K; type (*a)[M][N] = malloc(sizeof *a); if (a) { type (*b)[M][N] = malloc(sizeof *b); if (b) { fill(M, N, b, m); type (*c)[M][N] = malloc(sizeof *c); if (c) { fill(M, N, c, n); add(M, N, a, b, c); printf("a[0][0]: %i\n", (*a)[0][0]); free(c); } free(b); } free(a); } return EXIT_SUCCESS; }и посмотрим, векторизуется ли он в функциях

addиfill.Функция

fillзаполняет массив одним и тем же значением.Функция

addскладывает поэлементно два массива и поэлементно же кладёт результат в третий.В данном коде во все элементы массива

bкладётся 2, во все элементы массиваcкладётся 3, затем они суммируются, а результат кладётся в массивa.Первый элемент массива

aраспечатывается, чтобы icc не "думал", что, раз массивaпосле заполнения никак не используется, то можно ничего и не вычислять, и не выбрасывал вызов функцииadd.В функции

addвидим в ассемблерном коде gcc следующее:.L5: vmovdqu ymm1, YMMWORD PTR [r15+rdx] vpaddd ymm0, ymm1, YMMWORD PTR [rax+rdx] vmovdqu YMMWORD PTR [r9+rdx], ymm0 add rdx, 32 cmp rdx, r14 jne .L5Видите векторизацию?

Компилятор смог.В функции

fillвидим в ассемблерном коде gcc следующее:vpbroadcastd ymm0, ebx ... .L36: vmovdqu YMMWORD PTR [rdx], ymm0 add rdx, 32 cmp rcx, rdx jne .L36А здесь видите векторизацию?

Компилятор опять смог.Для clang'а и icc от Intel'а всё аналогично.

Если прогнать perf'ом, то получается следующее (у меня локально установлена другая версия gcc, поэтому используемые регистры в ассемблерном коде слегка другие):

14.99 │118: vmovdqu ymm1,YMMWORD PTR [r14+r12*1] 15.00 │ vpaddd ymm0,ymm1,YMMWORD PTR [rax+r12*1] 65.00 │ vmovdqu YMMWORD PTR [rdx+r12*1],ymm0 │ add r12,0x20 │ cmp r12,rdi 5.00 │ ↑ jne 118Видно, что эти инструкции на самом деле работают, а не просто "валяются в коде рядом".

Это означает, что компилятор смог.

Более того, смогли все опробованные мной компиляторы.Вы можете ответить на вопросы, помеченные мной как (1) и (2)?

Итак:

В C массив массивов понимается как массив массивов, причём независимо от того, какой это массив, обычный или VLA.

В этом стиле доступна работа и с динамически выделенной памятью, причём даже в этом случае размерности каждого массива не обязаны быть константами времени компиляции.

Никакой дополнительной адресной арифметики при этом не требуется.

Никаких прочих накладных расходов, связанных с использованием указателей на

void, нет.Передача размерностей массива в рассматриваемом случае не зависит от языка и будет присутствовать в том или ином виде в любом языке.

Не существует никаких проблем с выравниванием, специфичных для применяемой техники.

При этом все широко используемые современные компиляторы прекрасно векторизуют код.

В этом смысле Fortran не имеет преимуществ перед C.

Если ещё учесть, что strict aliasing'ом можно управлять с помощью ключевого слова

restrict, то станет очевидно, что в этом смысле Fortran вообще не имеет преимуществ перед C.Напоминаю, что первый пункт в списке выше есть прямое возражение на ваше утверждение:

В Си массив массивов понимается как массив указателей на массивы, а не как двухмерный массив.

vadimr

00.00.0000 00:00+2Хорошо, что Вы тратите своё время и пытаетесь доказательно разобраться в вопросе (поставил бы Вам плюсик в карму, да нельзя дальше увеличивать без статей), но плохо, что при этом игнорируете часть смысла сказанного.

Когда вы в своей функции add обходите массив по строкам, то вы никак не используете его двухмерность. Фактически это проход по одномерному массиву, расписанный в два индекса, и компилятор понимает, что происходит обращение к последовательным ячейкам памяти. Если вы заметите, я изначально писал про перемножение матриц, потому что там таким трюком не обойтись. Если вы в своей функции add переставите местами индексы, например, у массива c (т.е. c[n,m] вместо c[m,n]), то компилятор начинает выдавать уже такую хтонь, которую я затрудняюсь проинтерпретировать.

Далее, вы же сами должны хорошо понимать, что ваш макрос ELEMS работает только по совпадению из-за невыровненности элементов массива на границу, большую их длины. Такое поведение не гарантируется языком Си (уже на той же самой PDP-11 нечётные адреса зачастую были запрещены). Конечно, никакого принципиального значения этот макрос не имеет, можно перейти просто к M и N, но это ещё затруднит работу векторизатора. В том числе на некоторых векторных архитектурах размеры самих векторов должны выравниваться на длину векторных регистров.

Что касается массива указателей, то я был неправ, высказав своё утверждение в таком виде, оно неверно. В целом я думал о том, что написано ниже, и неудачно выразил свою мысль.

Теперь, о практике программирования в целом. Думаю, вы согласитесь, что по целому ряду причин мало кто в реальной жизни будет писать функции так, как это сделано в вашем демонстрационном коде. Программист на С и особенно С++ будет выбирать решение, более соответсвующее принципу инкапсуляции и более совместимое со стандартной библиотекой. А это значит, что все эти трюки с массивами в С крайне малоприменимы, на практике там будет другая структура данных. В отличие от Фортрана, где податься некуда, и сложные структуры данных, как правило, представляются в виде набора массивов.

Наконец, как тут уже отмечалось в комментариях выше, не будем забывать, что фортрановскую программу можно простой перекомпиляцией перевести с SSE на CUDA.

eptr

00.00.0000 00:00Хорошо, что Вы тратите своё время и пытаетесь доказательно разобраться в вопросе

А как ещё иначе?

Авторитетов же не существует.К тому же, чтобы навыки не "загнивали", их необходимо тренировать, а на это так и так уходит время.

но плохо, что при этом игнорируете часть смысла сказанного.

Это, видимо, потому, что я возражал по конкретному пункту о необходимости явно прописывать адресную арифметику, а потом по конкретному другому пункту касательно "устройства" массива массивов.

Когда вы в своей функции add обходите массив по строкам, то вы никак не используете его двухмерность. Фактически это проход по одномерному массиву, расписанный в два индекса, и компилятор понимает, что происходит обращение к последовательным ячейкам памяти.

Ну, то есть, не требуется прописывать адресную арифметику, и компилятор может соптимизировать, поскольку "понимает", с чем работает.

Если вы заметите, я изначально писал про перемножение матриц, потому что там таким трюком не обойтись.

Во-первых, это никакой не трюк, а штатная возможность, абсолютно переносимая и обязанная одинаковым образом быть поддержанной всеми компиляторами, претендующими на соблюдение стандарта.

А, во-вторых, основной фоновый контекст у нас здесь – преимущество (или отсутствие такового) Fortran'а перед C в рассматриваемой части.Если вы в своей функции add переставите местами индексы, например, у массива c (т.е. c[n,m] вместо c[m,n]), то компилятор начинает выдавать уже такую хтонь, которую я затрудняюсь проинтерпретировать.

Вы хотите сказать, что компилятор Fortran'а аналогичный код в тех же условиях сумеет векторизовать?

Далее, вы же сами должны хорошо понимать, что ваш макрос ELEMS работает только по совпадению из-за невыровненности элементов массива на границу, большую их длины.

Макрос

ELEMSработает для любых случаев.Элементы массива (и сам массив, а также массив массивов и далее рекурсивно) выровнены согласно требованию к выравниванию для типа элемента массива.

Между элементами массива нет "пропусков", они расположены "вплотную" друг к другу, и sizeof массива строго равен количеству его элементов, умноженному на sizeof его элемента.Такое поведение не гарантируется языком Си (уже на той же самой PDP-11 нечётные адреса зачастую были запрещены).

Расположение элементов массива "влотную", без "пропусков" гарантируется стандартом, и это необходимое условие для того, чтобы адресная арифметика была в принципе работоспособной.

Макрос

ELEMSпрямо опирается на гарантии стандарта и именно поэтому работает для любых случаев.В структурах между полями могут быть пропуски, но там и типы у полей могут быть разными, и, соответственно, у них могут быть разные размеры и требования по выравниванию, что и может приводить к подобным эффектам.

Конечно, никакого принципиального значения этот макрос не имеет, можно перейти просто к M и N, но это ещё затруднит работу векторизатора.

Нет необходимости переходить к

MиN, отказываясь от данного макроса по надуманной причине, поэтому у "векторизатора" затруднений, связанных с этим, не появится.В том числе на некоторых векторных архитектурах размеры самих векторов должны выравниваться на длину векторных регистров.

Язык C предоставляет средства для реализации повышенных требований к выравниванию, поэтому здесь также нет никаких проблем.

Короткий пример (ссылка на godbolt):

#include <stdlib.h> #include <stdio.h> #include <stdalign.h> int main(void) { int a0[16]; alignas(sizeof a0) int a1[16]; printf("&a0: %p, sizeof a0: %zu, alignof a0: %zu\n", (void *)&a0, sizeof a0, alignof a0); printf("&a1: %p, sizeof a1: %zu, alignof a1: %zu\n", (void *)&a1, sizeof a1, alignof a1); return EXIT_SUCCESS; }Результат (взятый у clang'а, потому что у gcc он не интересный):

&a0: 0x7ffe2b64b2b0, sizeof a0: 64, alignof a0: 4 &a1: 0x7ffe2b64b240, sizeof a1: 64, alignof a1: 64По адресу видно, что

a0реально выровнен на границу 16, аa1– уже на границу 64.

Явный код для выравнивания на 64 для массиваa1можно также увидеть в ассемблере у каждого из компиляторов.Что касается массива указателей, то я был неправ, высказав своё утверждение в таком виде, оно неверно. В целом я думал о том, что написано ниже, и неудачно выразил свою мысль.

Но доказательств для этого потребовалось больше, чем, я думал, будет достаточно.

Теперь, о практике программирования в целом. Думаю, вы согласитесь, что по целому ряду причин мало кто в реальной жизни будет писать функции так, как это сделано в вашем демонстрационном коде.

Я не могу судить о реальной жизни в широком смысле, ибо недостаточно информации, поэтому не могу согласиться или не согласиться.

Да, junior'ы не смогут такое написать, и даже, наверное, часть middle'ов не сможет, особенно вариант с VLA, но достаточно им по-настоящему объяснить, как устроены типы в языке, и на чём базируется адресная арифметика, а не как это часто делают современные преподаватели, и, после некоторого времени, потраченного на практику, такое даже junior'ы смогут, здесь нет чего-то заумного.

Программист на С и особенно С++ будет выбирать решение, более соответсвующее принципу инкапсуляции и более совместимое со стандартной библиотекой.

Использование указателя на массив никак не ограничивает инкапсуляцию, а у программиста на C++, кроме указателей, ещё наличествуют в активе и ссылки, он может использовать ссылку на массив.

Поскольку речь идёт об инкапсуляции, то реализация может быть любой.

Если кто-то ничего не знает, кроме как о

std::vector, (как ещё понять "более совместимое со стандартной библиотекой", но при этом не дающее возможности применить указатель на массив?) это не повод огульно обобщать на большинство (как ещё понять "программист на С и особенно С++ будет выбирать"?).К тому же, сейчас активно используется такая процедура как review, что нивелирует огрехи, которые могут допустить не слишком искушённые программисты.

А это значит, что все эти трюки с массивами в С крайне малоприменимы, на практике там будет другая структура данных.

Повторюсь, это никакой не трюк, это совершенно штатная и абсолютно переносимая возможность языка.

Там будет та структура данных, которую выберет программист.

Если программист слабо владеет языком, он легко может выбрать неподходящее решение.

Для этого обычно в компаниях бывают программисты, кототрые хорошо владеют используемым языком, и которые на review укажут, как следует изменить решение, чтобы оно стало эффективным.И уже после этого там будет та структура данных, которую выберет грамотный программист, и которая эффективна для используемого языка.

В отличие от Фортрана, где податься некуда, и сложные структуры данных, как правило, представляются в виде набора массивов.

То есть, получается, что в этом месте C имеет преимущество перед Fortran'ом, поскольку даёт больше возможностей и более гибок.

Наконец, как тут уже отмечалось в комментариях выше, не будем забывать, что фортрановскую программу можно простой перекомпиляцией перевести с SSE на CUDA.

Выходит, это единственное преимущество Fortran'а в данной части.

vadimr

00.00.0000 00:00Между элементами массива нет "пропусков", они расположены "вплотную" друг к другу, и sizeof массива строго равен количеству его элементов, умноженному на sizeof его элемента.

Расположение элементов массива "влотную", без "пропусков" гарантируется стандартом,

Из какого места стандарта вы делаете такой вывод?

и это необходимое условие для того, чтобы адресная арифметика была в принципе работоспособной.

Чтобы была работоспособной адресная арифметика, достаточно того, чтобы инкремент указателя на элемент массива давал следующий элемент.

Как вы вообще представляете себе char [] на машине с невозможностью обращения по нечётному адресу (как, например, некоторые модели PDP, хорошо известные разработчикам Си)?

В близнеце Си Паскале – так там специально даже есть синтаксис packed array.

eptr

00.00.0000 00:00+1Из какого места стандарта вы делаете такой вывод?

6.2.5 Types

...

20 Any number of derived types can be constructed from the object and function types, as follows:

— An array type describes a contiguously allocated nonempty set of objects with a particular member object type, called the element type.

...На всякий случай, ссылка на перевод слова contiguous.

Чтобы была работоспособной адресная арифметика, достаточно того, чтобы инкремент указателя на элемент массива давал следующий элемент.

Тогда все массивы, а также области памяти, интерпретируемые как массивы, будут "дырявыми".

Но в C они не могут быть "дырявыми".

Как вы вообще представляете себе char [] на машине с невозможностью обращения по нечётному адресу (как, например, некоторые модели PDP, хорошо известные разработчикам Си)?

Невозможность обратиться по нечетному адресу характерна лишь для регистров R6 (PC) и R7 (SP).

Для остальных регистров проблемы обратиться к байту, в том числе, по нечётному адресу, нет.Очень просто представляю: байтовые инструкции.

В близнеце Си Паскале – так там специально даже есть синтаксис packed array.

Pascal – очень условный "близнец" C.

vadimr

00.00.0000 00:00Это ваша вольная интерпретация стандарта.

20 Any number of derived types can be constructed from the object and function types, as follows:

— An array type describes a contiguously allocated nonempty set of objects with a particular member object type, called the element type.

Обратите внимание, что contiguously allocated относится к objects, а element type – к member object. Отсюда никак не следует, что тип элемента, т.е. тип объекта-члена – это то же самое, что непрерывно размещённые в памяти объекты. Буквально: размещённый набор объектов с определёнными типами объектов-членов.

Да и по сути, машин с адресацией памяти словами – вагон и маленькая тележка.

В том, что на практике бывают массивы с дырками между элементами, я совершенно уверен, хотя лично с языком Си на таких машинах не работал. Более интересный вопрос другой: бывают ли в Си многомерные массивы с дополнительными дырками между строками? В принципе, это не запрещено, и компилятор мог бы увеличивать длину строк до длины векторного регистра для более эффективной векторизации в какой-нибудь архитектуре, но я о такой автоматической оптимизации нигде не читал, хотя советы вручную увеличивать размеры массивов встречал.

eptr

00.00.0000 00:00Это ваша вольная интерпретация стандарта.

Точно моя?

Обратите внимание, что contiguously allocated относится к objects, а element type – к member object. Отсюда никак не следует, что тип элемента, т.е. тип объекта-члена – это то же самое, что непрерывно размещённые в памяти объекты. Буквально: размещённый набор объектов с определёнными типами объектов-членов.

Здесь имеется ввиду, что тип у всех объектов должен быть одинаковый.

И объекты не просто размещённые, а смежно или непрерывно размещённые.Переводчик №1 (ссылка): "Тип массива описывает смежно выделенный непустой набор объектов с определенным типом объекта-члена, называемым типом элемента".

Переводчик №2 (ссылка): "Тип массива описывает непрерывно выделенный непустой набор объектов с определенным типом объекта-члена, называемым типом элемента".

"Смежно/непрерывно выделенный непустой набор объектов".

В отличие от структур, о которых можно прочесть в следующем предложении стандарта:

— A structure type describes a sequentially allocated nonempty set of member objects (and, in certain ircumstances, an incomplete array), each of which has an optionally specified name and possibly distinct type.

Переводчик №1 (ссылка): "Тип структуры описывает последовательно выделенный непустой набор объектов-членов (и, при определенных обстоятельствах, неполный массив), каждый из которых имеет опционально заданное имя и, возможно, отдельный тип".

Переводчик №2 (ссылка): "Тип структуры описывает последовательно размещенный непустой набор объектов-членов (и, в некоторых случаях, неполный массив), каждый из которых имеет необязательно указанное имя и, возможно, отдельный тип".

Для массивов размещение смежное/непрерывное, а для структур – лишь последовательное (упорядоченное по порядку объявления полей) без требования непрерывности размещения.

И тип элементов – для массивов один и тот же, для структур – нет.

Да и по сути, машин с адресацией памяти словами – вагон и маленькая тележка.

Вы уже приводили пример PDP-11, и выяснилось, что никакой проблемы нет, ибо наличествует и адресация байтами, и в этом случае доступны и нечётные адреса.

В том, что на практике бывают массивы с дырками между элементами, я совершенно уверен, хотя лично с языком Си на таких машинах не работал.

Чья-либо уверенность в данном случае ничего не проясняет.

Тем более, если человек не работал с языком C.Более интересный вопрос другой: бывают ли в Си многомерные массивы с дополнительными дырками между строками?

Нет, не бывают.

В принципе, там и многомерных не бывает, бывают массивы массивов.

vadimr

00.00.0000 00:00К переводам претензий нет, правильные переводы. Претензия к тому, почему вы думаете, что object и member object – это одна и та же сущность. Это же не ведический санскрит, чтобы при каждом упоминании предмет описывать новыми словами. Если б было по-вашему, написали бы “contiguously allocated member objects”.

Здесь структура примерно такая же, как в предложении “ящик доверху заполнен пирожками с ароматными яблоками”. Это не то же самое, что “ящик заполнен яблоками”. Contiguously allocated objects относится к ячейкам памяти (или, говоря наиболее корректно, к единицам размещения в памяти), а member objects – к содержащимся в них элементам массива.

eptr

00.00.0000 00:00К переводам претензий нет, правильные переводы. Претензия к тому, почему вы думаете, что object и member object – это одна и та же сущность. Это же не ведический санскрит, чтобы при каждом упоминании предмет описывать новыми словами. Если б было по-вашему, написали бы “contiguously allocated member objects”.

Рассмотрение набора смежных объектов определённым образом концептуально вводит новую сущность – массив – с новыми терминами.

Если рассматривать этот набор как массив, то теперь это не просто объекты, а элементы массива, но несмотря на то, что с разных точек зрения они называются по-разному, – то объекты, то элементы массива, – от этого они не становятся чем-то другим.

zkutch

00.00.0000 00:00Еще один аргумент в пользу непрерывности расположения элементов массива это (С2011) 6.5.2.1 Array subscripting, где читаем "E1[E2] is identical to (*((E1)+(E2)))". Учитывая однотипность это и есть гарантия непрерывности.

vadimr

00.00.0000 00:00+1Это говорит только о том, что элементы массива находятся друг от друга на расстоянии одного инкремента указателя на массив. Это и есть адресная арифметика. Но она никак не говорит о том, что единичный инкремент строго равен размеру элемента, и, как следствие - не о том, что нет дырок.

Дырки образуются как раз от участков памяти, на которые невозможно (или нежелательно по соображениям эффективности) указать самостоятельным адресом. Нигде в стандарте не указано, что дискретность адреса не может превышать минимальный размер переменной.

eptr

00.00.0000 00:00Дырки образуются как раз от участков памяти, на которые невозможно (или нежелательно по соображениям эффективности) указать самостоятельным адресом. Нигде в стандарте не указано, что дискретность адреса не может превышать минимальный размер переменной.

Однако, сказано, что массив представляет из себя "смежно/непрерывно выделенный непустой набор объектов".

В качестве переменной с нежелательными участками памяти можно привести переменную следующего типа:

struct S { int i; char c; }Если

sizeof(int)есть 4, то размер переменной такого типа можно считать равным 5.В силу невозможности или нежелательности нарушения выравнивания для элементов такого типа в массиве, необходимо добавить ещё 3 байта, и тогда в массиве таких переменных между ними будет 8 байт.

И вот здесь возникает два возможных вИдения происходящего:

Размер переменной данного типа есть 5, адресная арифметика "щёлкает" на 8 байт, и имеет место наличие "дырок" между элементами массива.

Размер переменной данного типа есть 8, то есть, "дырка" входит в состав переменой данного типа, адресная арифметика "щёлкает" на 8 байт, имеет место отсутствие "дырок" между элементами массива.

В силу требования для массивов смежности/непрерывности размещения элементов, в C единственно возможно только второе вИдение.

Зачастую возможно указать компилятору для такой структуры нарушать выравнивание, и тогда размер структуры будет равен 5.

Но и адресная арифметика в массиве с таким типом элемента начнёт "щёлкать" на 5 байт, а не на 8.

Таким образом, даже в тех случаях, когда возникают "дырки", в массиве этих "дырок" все равно нет за счёт вхождения этих "дырок" в состав переменных такого типа (и элементов массива, если они находятся в составе массива) и, как следствие, увеличивающих

sizeofтаких переменных на размер "дырки".

vadimr

00.00.0000 00:00В силу требования для массивов смежности/непрерывности размещения элементов, в C единственно возможно только второе вИдение.

Никто нигде не обещал, что элементом массива является сам тот объект, который хранится в элементе массива. Элемент массива – это адресуемая область памяти, предназначенная для хранения объекта указанного типа, не более того. Поэтому возможны оба варианта.

eptr

00.00.0000 00:00Хорошо, попробуем на этот момент взглянуть ещё с такой стороны.

Вы говорите, что хранящийся в массиве объект может не являться элементом массива, имея ввиду, что у них, вследствие этого, могут быть разные размеры (у элемента массива, очевидно, – больше), из-за чего в массиве между элементами и могут возникнуть "дырки", когда мы рассматриваем элементы массива, верно?

В стандарте сказано, что "тип массива описывает непрерывно выделенный непустой набор объектов с определенным типом объекта-члена, называемым типом элемента".

А именно, что элемент массива имеет тип, и что он совпадает с типом объекта-члена.

Вы же не считаете, что если тип, имеющийся у объекта-члена, назвать типом элемента, то тип у элемента может "в процессе называния" стать другим, отличным от типа объекта-члена?

Для всех типов данных определена операция

sizeof.Результат этой операции зависит исключительно от типа.

Он не зависит от "происхождения" типа, то есть, в результате какой операции у выражения получился такой тип, или в состав какой объемлющей структуры данных входит объект, размер типа которого мы вычисляем.

Соответственно, если типы объектов-членов и элементов массива совпадают, то операция

sizeofдаст для них строго идентичный результат, и, соответственно, выходит, что у объектов-членов и элементов массива строго одинаковый размер.Если объекты-члены выделены смежно/непрерывно (по определению массива), то и элементы массива будут расположены смежно/непрерывно в силу одинаковости размеров объектов-членов и элементов массива.

Или, по-другому: раз у объектов-членов и элементов массива одинаковый размер, то они вынуждены являться друг другом, то есть, быть одной и той же сущностью.

vadimr

00.00.0000 00:00Вы делаете подмену одного понятия другим в самом начале, и дальше уже производите логический вывод из неверной предпосылки.

тип массива описывает непрерывно выделенный непустой набор объектов с определенным типом объекта-члена, называемым типом элемента

не означает, что

элемент массива имеет тип, и что он совпадает с типом объекта-члена

Элементом массива является объект, который представляет собой адресуемую область памяти. Эта область памяти сама по себе не имеет никакого типа, однако содержит объект-член определённого типа. По сути, массив – это контейнер, и когда мы говорим об элементах массива, то имеем в виду ячейки этого контейнера. В которые уложены значения того типа, от которого произведён массив.

Ячейка массива, как таковая, не является частью системы типов языка Си, у неё нет ни типа, ни размера в смысле sizeof. Также как в Си нет типа и размера, например, у функции, хотя мы понимаем, что она в конечном итоге может быть представлена каким-то вполне конкретным набором байтов в машинном коде, имеющим размер с точки зрения машины. Или у оператора присваивания.

Когда мы выясняем тип и размер элемента массива в смысле семантики языка Си, то в действительности получаем тип и размер значения, хранящегося в этом элементе.

eptr

00.00.0000 00:00Элементом массива является объект, который представляет собой адресуемую область памяти. Эта область памяти сама по себе не имеет никакого типа, однако содержит объект-член определённого типа.

Не объект, а объекты, которые "уложены" в этой памяти смежно/непрерывно, и между ними нет промежутков.

То есть, сначала объекты смежно/непрерывно уложены в памяти, а потом это рассматривается как массив.

Если аппаратная архитектура не позволяет смежно/непрерывно уложить значащие биты значения, значит, те незначащие, которые необходимо добавить, чтобы "упереться" в памяти в начало значащих битов следующего значения, и которые мы здесь называем "дыркой", придётся, с точки зрения уже языка C, а не аппаратной архитектуры, "включить" в состав объекта, чтобы получить смежную/непрерывную "укладку".

Без такой "укладки" объектов массива быть не может, ибо это – необходимое условие в его определении.

И выход здесь один – включить незначащие биты в состав объекта.

По сути, массив – это контейнер, и когда мы говорим об элементах массива, то имеем в виду ячейки этого контейнера. В которые уложены значения того типа, от которого произведён массив.

В определении сначала – "плотная" укладка объектов.

Ячейка массива, как таковая, не является частью системы типов языка Си, у неё нет ни типа, ни размера в смысле sizeof. Также как в Си нет типа и размера, например, у функции, хотя мы понимаем, что она в конечном итоге может быть представлена каким-то вполне конкретным набором байтов в машинном коде, имеющим размер с точки зрения машины. Или у оператора присваивания.

Функция не является типом данных, она является "типом исполнения".

Для неё не определена операция

sizeof, поэтому не может быть определено ещё множество операций, включая присваивание и адресную арифметику.Более того, функция может состоять из множества не смежных между собой частей, поэтому принципиально не может быть описана как тип данных с адресом и размером.

Лучше вернуться к типам данных.

Когда мы выясняем тип и размер элемента массива в смысле семантики языка Си, то в действительности получаем тип и размер значения, хранящегося в этом элементе.

Здесь, исходя из определения массива, первично смежное/непрерывное размещение объектов и только потом уже их рассмотрение в качестве массива.

Артефакты аппаратной архитектуры, не позволяющие разместить значения какого-то архитектурного (а не C-шного) типа смежно/непрерывно, решаются включением уже в C-шный тип тех незначащих бит, которые мы называем "дыркой" и которые необходимо добавить, чтобы достигнуть по памяти начала значащих бит следующего значения, лежащего в памяти.

Таким образом, с точки зрения некоторой аппаратной архитектуры, "дырки" есть, но изнутри C их нет, потому что они, с точки зрения C, включены в каждый объект, даже в тех случаях, когда объект является отдельной переменной и не является элементом массива.

Вы смотрите на вещи с точки зрения аппаратной архитектуры, и тогда "дырки", несомненно, есть.

Но изнутри C эта же аппаратная архитектура пропущена сквозь призму абстрактной машины C, которая "обходит" подобные артефакты аппаратной архитектуры путём включения её "дырок" в состав объекта.

Если бы мы "смотрели" на мир из ассемблерного кода, тогда мы бы "сняли с себя очки абстрактной машины C", и "дырки" бы существовали или отсутствовали в зависимости от точки зрения, рассматриваем мы элементы массива в C-шном стиле или в том стиле, в котором их рассматриваете вы.

Но, коль скоро мы смотрим на это изнутри C, "открывающийся вид" становится однозначным, "бездырочным", несмотря на то, что "под капотом" "дырки" есть.

Вот такой получается парадокс, как с тем сусликом:

Видишь изнутри C дырки?

Нет.

И я нет, а они – есть.

zkutch

00.00.0000 00:00Но также не говорится, что единичный инкремент не равен размеру типа. Кстати, как вы сами согласны, если они равны, то и дырок нет.

С другой стороны фразу "set of objects with a particular member object type" (6.2.5, 20) я понимаю как "набор объектов с определенным типом объекта-члена" т.е. декларируемая вами выше разница между object и member object как разница размером ячеек и размером расположенных в них объектах не обязательна. Эта фраза просто и только говорит о том, что у всех членов набора тип один и тот же.

И, как пример, возьмем например массив char-ов т.е. каждый член массива занимает байт. И пусть баит же есть минимальное адресуемое пространство. Думаю да, но все равно спрошу: согласны ли вы с тем, что в этом случае дырок нет?

p.s. я ограничен одним часом на один коментарий, так, что запоздалость ответа не сочтите за невнимательность.

vadimr

00.00.0000 00:00Конечно, эта разница не обязательна. Более того, в подавляющем большинстве случаев её и нет, иначе бы и никаких дискуссий не возникало. Если на машине универсальная байтовая адресация, то дырок не будет.

zkutch

00.00.0000 00:00Ну тогда выход получается очень простым. Стандарт не требует точного размера байта, есть только ограничение снизу, чтобы байт содержал "any member of the basic character set" (3.6). Поэтому достаточно минимальное адресуемое пространство в данной среде объявить байтом. Все остальные основные типы кратны ему, так, что дырок не будет. Зачем делать их различными и заранее обрекать ситуации на дырки? И, не могли бы ли вы привести конкретный пример среды и имплементации массива с дырками для хотя бы одного из основных типов?

p.s. Кстати сам байт тоже "is composed of a contiguous sequence of bits". Следуя вашему предположению можно и бит теперь разделить на два понятия и имет дырки на битовом уровне.

eptr

00.00.0000 00:00;

Так "дырявые" же структуры, а не массив.

А массив состоит из структур, а не из элементов структур.Вот пример (ссылка на godbolt):

#include <stdlib.h> #include <stdio.h> struct S { int i; char c; }; int main(void) { struct S s = {0}; printf("sizeof s: %zu\n", sizeof s); printf("sizeof s.i: %zu\n", sizeof s.i); printf("sizeof s.c: %zu\n", sizeof s.c); struct S a[3] = {0}; puts(""); printf("sizeof a: %zu\n", sizeof a); printf("sizeof a[0]: %zu\n", sizeof a[0]); return EXIT_SUCCESS; }Результат:

sizeof s: 8 sizeof s.i: 4 sizeof s.c: 1 sizeof a: 24 sizeof a[0]: 8Видно, что сумма размеров полей структуры на 3 байта меньше размера структуры.

В структуре – дыра, причём, с краю, а не в середине, но она принадлежит структуре, входит в неё, является её неотъемлемой частью.

Именно поэтому размер структуры равен 8.Массив структур в качестве элементов имеет объекты типа

struct Sразмером 8 байт.

Количество элементов – 3.

Размер массива – 24.Между элементами массива, каждый из которых имеет размер 8 байт, нет никаких дыр.

Они есть внутри каждого элемента, но это – внутреннее свойство типа элемента, а не свойство самого массива.Адресная арифметика "щёлкает" на размер элемента и абстрагируется от его внутренних свойств.

Поэтому ей все равно, есть дыры в каждом из элементов, нет, сколько их и какого они размера.Единственное, что её "заботит" – размер элемента.

vadimr

00.00.0000 00:00Соглашусь с вами в том, что вы убедительно показали, что данный пример ничего не доказывает по сути обсуждения.

Что касается адресной арифметики, то ей наплевать и на размер элемента тоже. Ей важны собственно адреса элементов.

eptr

00.00.0000 00:00+1Соглашусь с вами в том, что вы убедительно показали, что данный пример ничего не доказывает по сути обсуждения.

Это потому, что вы не связываете адресную арифметику с размером элемента.

Что касается адресной арифметики, то ей наплевать и на размер элемента тоже. Ей важны собственно адреса элементов.

Размер элемента является фундаментальнейшей и определяющей сущностью для адресной арифметики, для неё нет ничего важнее.

struct S { int i; char c; }; struct S * fun(struct S *p) { return p + 1; }Если посмотреть, во что транслируется

fun, то мы увидим следующее (ссылка на godbolt):fun: lea rax, [rdi+8] retОткуда компилятор знает, что надо на 8 "шагнуть"?

Он совсем не знает, откуда вообще взялся этот указатель: на элемент массива он изначально указывает, на поле структуры или вообще, на отдельную переменную.Более того, могут быть различные вызовы этой, одной и той же, функции с указателями на различные, в смысле предыдущего абзаца, объекты, а обработка-то должна быть какой-то одной: указатель не несёт в себе информации о том, в составе чего находится объект.

Поэтому на что адресной арифметике точно плевать, так это – на происхождение указателя.

Но ей точно не плевать на размер типа данных, на который указывает указатель.

Именно потому, что размерstruct Sсоставляет 8 байт, и только поэтому, численное значение указателя увеличивается на 8.

В состав чего входит объект, а также то, как он устроен внутри, имеют для адресной арифметики строго нулевое значение.

Для неё важен исключительно размер элемента и только он.Вот пример (ссылка на godbolt):

#include <stdlib.h> #include <stdio.h> struct S; void fun0(struct S *p) { printf("p: %p\n", (void *)p); #if 0 printf("sizeof *p: %zu\n", sizeof *p); p++; #endif printf("p: %p\n", (void *)p); } struct S { int i; char c; }; void fun1(struct S *p) { printf("p: %p\n", (void *)p); printf("sizeof *p: %zu\n", sizeof *p); p++; printf("p: %p\n", (void *)p); } int main(void) { struct S s; fun1(&s); return EXIT_SUCCESS; }Если раскомментировать закомментированный код, то, несмотря на то, что функции

fun0иfun1станут идентичными, сразу же возникнет ошибка:<source>: In function 'fun0': <source>:9:43: error: invalid application of 'sizeof' to incomplete type 'struct S' 9 | printf("sizeof *p: %zu\n", sizeof *p); | ^ <source>:10:10: error: increment of pointer to an incomplete type 'struct S' 10 | p++; | ^~Во время определения функции

fun0структураstruct Sещё не определена, она только объявлена, а это значит, кроме прочего, что неизвестен её размер.Именно потому, что адресная арифметика не существует без размера элемента, ругань относится не только к операции

sizeof, но и к операции инкремента указателя.Но как только структура определена, и становится известен её размер, у компилятора, при компиляции функции

fun1, претензии пропадают не только к операцииsizeof, но и к инкременту указателя.А что изменилось-то?

Стал известен размерstruct S.

И этого оказалось совершенно достаточно.То есть:

Для работы адресной арифметики строго необходим размер типа, на который указывает указатель.

Кроме размера типа, адресной арифметике больше ничего не нужно, будь то происхождение объекта или его внутренняя структура, – это никак не влияет на адресную арифметику.

vadimr

00.00.0000 00:00+2Вы путаете две вещи: размер типа, на который указывает указатель, и размер ячейки памяти, в которой размещено значение этого типа. Они чаще всего совпадают (в x86 всегда), но это не значит, что они одно и то же.

Если вспомнить, например, машину, на которой Вирт реализовывал Паскаль – CDC 6000 – то там память состояла из 60-битовых слов, к частям которых адресоваться было невозможно. Поэтому там отдельно рассматривался тип array of char, где каждый символ записывался по своему адресу, и packed array of char, где несколько символов (видимо, 10 6-битных) упаковывались в одно слово и имели общий адрес памяти. Также там могли целые упихиваться в 30-битные полуслова и 15-битные четвертьслова. А адрес был 18-разрядным, указывая на 60-битовые слова и адресуя таким образом чуть менее 2 мегабайт памяти. Я не думаю, что для CDC 6000 был реализован компилятор Си, но это, тем не менее, пример реальной архитектуры.

Отсюда видно, что инкременты указателей и значения, возвращаемые функцией sizeof, в общем случае не обязаны как-либо соотноситься между собой.

eptr

00.00.0000 00:00+2Вы путаете две вещи: размер типа, на который указывает указатель, и размер ячейки памяти, в которой размещено значение этого типа. Они чаще всего совпадают (в x86 всегда), но это не значит, что они одно и то же.

Речь о языке C, поэтому не путаю.

Программа на языке C исполняется в абстрактной машине.

Чем сильнее свойства железа отличаются от требований к абстрактной машине, тем больше требуется программной поддержки от реализации, чтобы "изнутри языка" всё выглядело так, как будто исполнение происходит в абстрактной машине.Если вспомнить, например, машину, на которой Вирт реализовывал Паскаль – CDC 6000 – то там память состояла из 60-битовых слов, к частям которых адресоваться было невозможно. Поэтому там отдельно рассматривался тип array of char, где каждый символ записывался по своему адресу, и packed array of char, где несколько символов (видимо, 10 6-битных) упаковывались в одно слово и имели общий адрес памяти. Также там могли целые упихиваться в 30-битные полуслова и 15-битные четвертьслова.

Все объекты в программе на C должны иметь уникальные адреса. Элементы массива – тоже объекты, и поэтому тоже должны иметь уникальные адреса. В результате, реализации языка C с таким упакованным массивом невозможны на данном железе.

Я не думаю, что для CDC 6000 был реализован компилятор Си, но это, тем не менее, пример реальной архитектуры.

Это – возможно, но будет выглядеть достаточно уродливо и несколько не эффективно.

Если минимально адресуемая единица – 60 бит, значит,charна этой платформе будет 60-битным, и препроцессорная константаCHAR_BITбудет иметь значение 60.Отсюда видно, что инкременты указателей и значения, возвращаемые функцией sizeof, в общем случае не обязаны как-либо соотноситься между собой.

Из того, что программа на языке C исполняется в абстрактной машине, следует, что любые попытки сослаться на особые свойства железа не состоятельны.

5.1.2.3 Program execution

1 The semantic descriptions in this International Standard describe the behavior of an abstract machine in which issues of optimization are irrelevant.

vadimr

00.00.0000 00:00Если сделать 60-битный char (и остальные типы), то будет невозможно описать упакованную структуру, и расположенные в памяти символы и целые числа вообще будут недоступны программе на Си, за исключением младших частей слов.

eptr

00.00.0000 00:00Если сделать 60-битный char (и остальные типы), то будет невозможно описать упакованную структуру

Видимо, невозможно.

и расположенные в памяти символы и целые числа вообще будут недоступны программе на Си, за исключением младших частей слов.

Половинки и четвертинки могут быть доступны за счёт использования битовых полей струткур.

Для конкретных длин полей (15 и 30) компилятор мог бы задействовать соответствующие инструкции.Но, конечно, эта архитектура – не для C.

vadimr

00.00.0000 00:00Повторюсь, это никакой не трюк

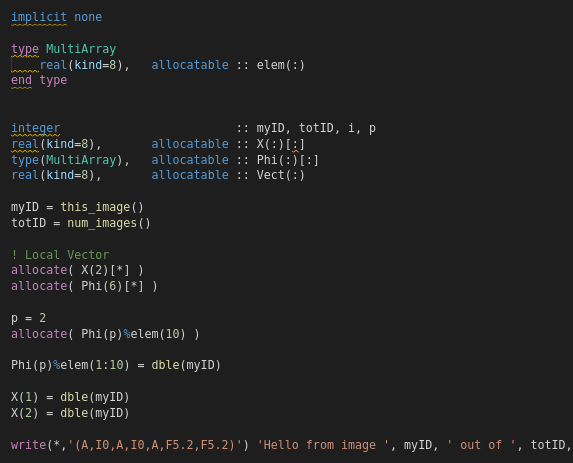

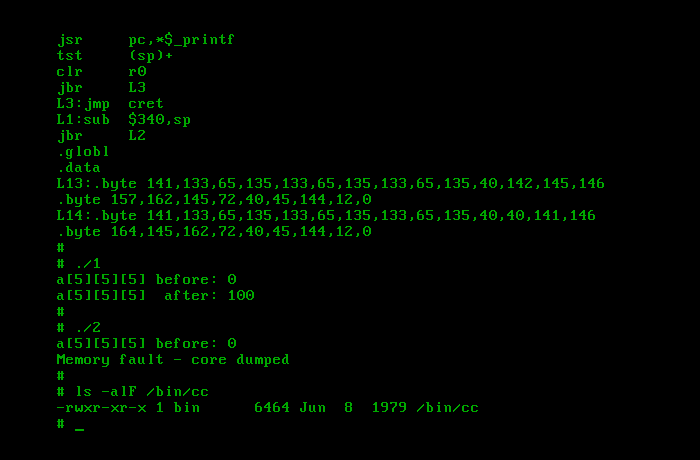

Вы не забывайте, что всеми этими макросами, sizeof'ами, циклами, преобразованиями пойнтеров туда и обратно вы расписываете аналог следующего фортрановского кода:

allocate (a (M, N), b (M, N), c (M, N))b = mmc = nna = b + c

vadimr