Почти все самые важные и интересные финансовые новости в России и в мире за неделю: Вассерман пытается ввести уголовную ответственность за наличный миллион рублей, в Credit Suisse обнаружили наци-след, а OpenAI поделились прогрессом в улучшении ChatGPT.

Финансовые новости из России, к сожалению, по большей части уже не соответствуют духу Хабра. Так что полную текстовую версию этого выпуска новостей можно прочитать вот здесь, либо посмотреть на видео.

Вассерман хочет ввести уголовку за миллион наличкой

Анатолий «Онотоле» Вассерман на прошлой неделе родил «законопроект за 300», в рамках которого он предлагает ввести уголовную ответственность за хранение наличности свыше 1 миллиона рублей без уведомления товарища налогового инспектора. Почему именно миллион? Ну, видимо, ровно столько можно с удобством распихать по карманам знаменитой Вассермановской жилетки – а больше Анатолию ничего особо от жизни и не надо.

Минфин предложение Анатолия поспешил горячо отвергнуть – дескать, не обсуждаем такое, и вообще не поддерживаем. Но надо признать, что в законотворческой практике нередки случаи, когда законы лежат на специальной полочке в Госдуме месяцами и годами, а потом в нужный момент с них стряхивается пыль и происходит молниеносное принятие за пару часов – так что...

ПУЗЫРЬ ГОСДОЛГА США ЛОПАЕТСЯ!! (извините, не удержался)

В США есть законодательно установленный потолок госдолга, который приходится периодически поднимать волевым решением Конгресса. Каждый раз это упражнение сопровождается натуральным цирком с конями – потому что республиканцы всё время морщат кислую мину и причитают о том, что надо бы поменьше тратить, и вообще «нафига нам все эти программы помощи бедным??»

В этом году рубилово за поднятие потолка госдолга, судя по всему, будет особенно жарким – всю эту драму мы, вероятно, будем наблюдать уже в мае.

Из-за всего этого инвесторы чувствуют себя не сухо и не комфортно: стоимость страховки от дефолта США по госдолгу сроком на 1 год подскочила аж до 1%. Напоминаю, что речь в данном случае идет про известный всем финансистам «безрисковый вариант инвестиций» в US Treasuries! =)

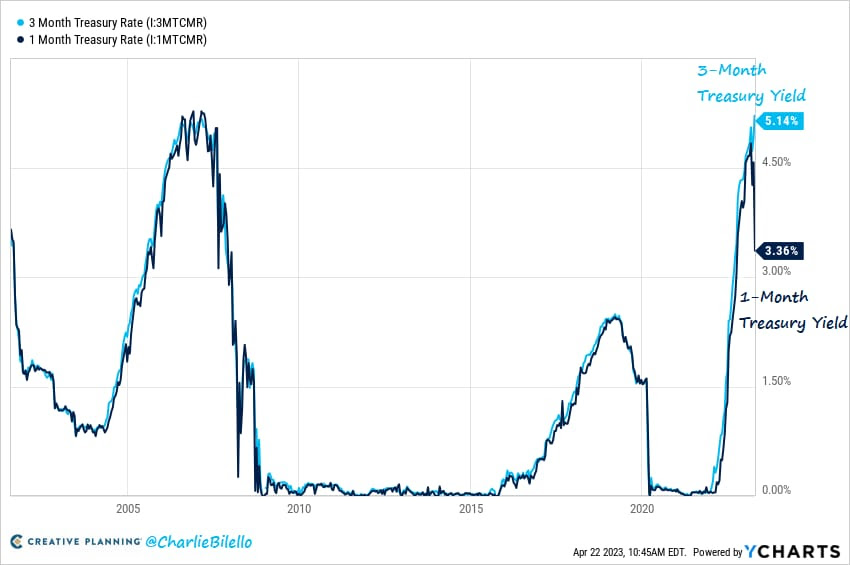

Плюсом к этому доходности одномесячных и трехмесячных госбумаг США разъехались в рекордную раскоряку: обычно они довольно близко следуют друг за другом, а тут вдруг трехмесячный долг стал давать доходность 5,14% годовых, а одномесячный – всего 3,36%. Эта разница аж в 1,8% говорит о том, что рыночек совершенно не исключает вероятность дефолта США на горизонте ближайших двух–трех месяцев.

Если честно, лично я с трудом представляю полноценный дефолт США по своим обязательствам в собственной валюте – это нужно уж совсем извернуться, чтобы таким образом выстрелить себе в ногу. И, самое главное – непонятно, зачем вообще так делать? Вроде бы, все же понимают, что потолок госдолга рано или поздно всё равно будет повышен – а контроль за уровнем расходов надо осуществлять на уровне управления бюджетом, а не плясок вокруг этого самого потолка. Но чужая душа потемки – может быть, республиканцам уж очень захочется устроить красивое шоу с итоговым выводом «СМОТРИТЕ, ДО ЧЕГО БАЙДЕН СТРАНУ ДОВЕЛ!!»

Американцы из BlackRock считают, что портфель 60/40 вышел из моды

Ребята из BlackRock объявили, что «классический» портфель 60% акций / 40% облигаций больше «не работает», так как корреляция между акциями и облигациями растет. Что же вместо это делать? Блэкроки усиленно намекают нам, что нужно «активно менять классы активов туда-сюда, а еще давайте в частные инвестиции побольше бахнем – кстати, мы как раз вот этим всем занимаемся, несите денежки нам (мы тоже кушоц хотим)!»

Если серьезно, то громкие заявления о смерти портфеля 60/40 прекрасно смотрелись бы, например, году в 2020-м – когда ставки были на нуле и вкладываться в длинные облигации действительно резона было мало (спросите тот же Silicon Valley Bank, например). Сейчас же, когда доходности облигаций резко выросли за последние полтора года, сбалансированный портфель наоборот стал выглядеть сильно лучше, чем раньше.

Но если бы мне платили за управление портфелями Private Equity инвестиций столько же, сколько BlackRock клиенты платят (это крупнейший управляющий PE-фондами в мире, на минуточку) – я бы, поди, тоже носился везде с рассказами о губительности всех остальных стратегий...

Немец швейцарцу – друг, товарищ и брат

Из опубликованного американцами отчета следует, что швейцарский проблемный банк Credit Suisse продолжал обслуживать счета, связанные с нацистами, вплоть до 2020 года. (На всякий случай: речь тут про классических винтажных наци из 1940-х.)

Не могу не процитировать этот отрывок: «Credit Suisse обслуживал счета 99 человек, которые были либо высокопоставленными нацистскими чиновниками в Германии, либо членами связанных с нацистами группировок в Аргентине. ... По крайней мере 14 из них продолжали обслуживаться в XXI веке...». Конечно, гораздо смешнее было бы, если б первоначально счетов было 88, а до нынешнего века из них дожило бы только 14 – но, как говорится, работаем с тем, что есть.

Думаю, ребята из UBS, купившие в прошлом месяце болезный Credit Suisse вместе со всеми их потенциальными штрафами и судебными обязательствами, еле успевают утирать пот со лба от появляющихся новостей.

Bank of Cyprus закрывает счета некоторым россиянам

Главный банк Кипра грозится закрыть счета 4-м тысячам российских клиентов. Но не только лишь всем – а в основном таким, которые фактически не живут в стране, или живут по всяким «сомнительным» ВНЖ, типа вида на жительство за инвестиции.

Вообще, надо сказать, что ВНЖ за инвестиции на текущий момент порядком подзашкварились как инструмент легализации в какой-либо стране. Деньги-то у вас взять часто готовы, но вот не поменяют ли потом правила этого самого ВНЖ пост-фактум каким-нибудь хитрым образом – тут уже гарантий, конечно, никаких.

SpaceX отправили космический корабль Starship в суборбитальный полет

На прошлой неделе Илон Маск, наконец, осуществил первый тестовый запуск самой огромной ракеты всех времен и народов (на которой мы все рано или поздно должны полететь на Марс). Ракета успешно взлетела, через несколько минут полета потеряла управление, и произвела БВР прямо в воздухе (Быструю Внеплановую Разборку – это, так сказать, эвфемизм для более привычного нам «хлопка»).

При этом двигателища мега-ракеты оказались настолько мощны, что тупо размотали по кочкам весь бетон со стартовой площадки. Сам Маск ожидает, что площадку залатают за ближайшие пару месяцев, укрепят ее специальными металлическими плитами – и можно будет пускать следующую тестовую ракету (авось, она залетит чуть подольше, чем четыре минуты).

Короче, батя Илон считает, что пуск был большим успехом – all things considered.

Инфляция стоимости образования для нейросетей

Всё больше компаний предпринимают меры для того, чтобы не позволить нейросетевым жестянкам коварно обучаться на их текстовых данных. На прошлой неделе крупнейший в мире онлайн-форум Reddit (именно по ссылкам с которого, если вы помните наш лонгрид про ChatGPT, когда-то обучалась GPT-2) заявил, что доступ к их API для обучения языковых моделей станет платным. О похожей инициативе почти сразу же заявил и Stack Overflow – популярный сервис с ответами на вопросы для программистов.

Пользуясь случаем, хочу тоже официально заявить, что стоимость обучения GPT-5 (или ее аналогов) на всех моих опубликованных статьях составит один миллион долларов. Предложения о сотрудничестве можете присылать мне в личку!

Илон Маск делает ИИ, который совершенно точно нас не уничтожит (но это не точно)

Помните того самого Илона Маска, который подписывал письмо об опасности искусственного интеллекта с призывом срочно прекратить разработку новых, более мощных нейросетей? Так вот, на прошлой неделе в интервью Такеру Карлсону Маск заявил, что он прямо сейчас работает над новым ИИ под названием TruthGPT («ПравдаЖПТ»).

Почему Илон считает, что его карманный Скайнет не уничтожит человечество? Держитесь покрепче, сейчас отвечу вам цитатой от мэтра.

TruthGPT будет максимально стремящимся к правде ИИ, который будет пытаться понять природу Вселенной. Я думаю, что это наиболее безопасный путь: ИИ, пытающийся понять Вселенную, вряд ли уничтожит человечество – ведь мы являемся интересной частью этой Вселенной...

Илон Маск

Я не шучу, он именно так и сказал! AI alignment просто 80-го уровня... Могу ответить только анекдотом:

Крокодилы решили сделать искусственный интеллект, целью которого будет максимизировать количество красоты во Вселенной.

Один из кроков в шляпе спрашивает датасаентистов: «А этот ваш ИИ нас, крокодилов, не уничтожит случайно?»

А ему отвечают: «А НАС-ТО ЗА ЧТО?!!»

ChaosGPT прямо сейчас без устали трудится ради глобального доминирования

И другие новости из рубрики «люди совершенно точно не сделают ИИ, который будет стремиться их уничтожить»: люди пытаются сделать ИИ, который будет стремиться их уничтожить.

Окей, это, конечно, в каком-то смысле шутка, но всё же: одни чуваки запустили AutoGPT, представляющий собой автономный искусственный интеллект, которому можно задавать цели – а он их будет пытаться дальше достигать уже без вашего участия. А другие чуваки насовали в этот AutoGPT целей в стиле «установить глобальное господство над кожаными мешками» и «уничтожить всех человеков».

Ну и ChaosGPT (так его нарекли) приступил: нагуглил самое мощное оружие человечества («царь-бомбу»), развернул кампанию в Твиттере по привлечению сторонников передачи этого оружия роботам с аргументацией о том, почему люди – это фу, и вообще так и так обречены на вымирание (поэтому давайте уже все вместе побыстрее как-нибудь). Ну а сейчас ХаосЖПТ исследует способы наиболее эффективного манипулирования широкими народными массами...

В общем, сейчас, конечно, мало кто может воспринять всерьез такие упражнения. Но, с другой стороны, если в будущем мы действительно получим на руки настоящий сильный AGI – не стоит исключать вероятность того, что человечество самовыпилится с помощью него «just for lulz».

Техдиректор OpenAI выступил на TED Talks с рассказом о прокачке ChatGPT

Грег Брокман, техдиректор OpenAI, выступил с Тед-током на тему того, чего новенького они сейчас запиливают в ChatGPT, и как им вообще можно пользоваться. Посмотрите, там полчаса, но очень интересно!

В частности, мне показалось очень забавным, как они буквально за несколько месяцев добавили всякие очевидные фичи, про которые еще совсем недавно скептики ругались по типу «да полная хрень эта ваша ЖПТ, ведь она даже ХХХ не умеет»:

«У этой тупой жестянки даже нет памяти, она всё забывает при закрытии диалогового окна!» – Брокман: «Мы тут приделали модуль памяти, в который можно сохранять всякое...»

«Да эти модели галлюцинируют, доверять им просто невозможно!» – Брокман: «Вместе с модулем доступа в интернет ChatGPT теперь можно будет попросить факт-чекнуть предложенный ей ответ, и она сама это весьма неплохо сделает.»

«Пока у ИИ нет никаких возможностей влиять на мир, это всё детские игрушечки просто!» – Брокман: «А теперь я попрошу ChatGPT запостить это в Твиттер, чтобы все зрители моего Тед-тока смогли это увидеть...»

«Ваши нейросети – это просто статистические попугаи, которые никогда не смогут в принципе ничего понять» – Брокман: «Да я тут сам офигел, когда выяснилось, что GPT-4 точно складывает 40-значные числа – хотя тупым запоминанием комбинаций этого достичь в принципе невозможно!»

Как говорится в старом меме, «вы сейчас находитесь здесь». Какое там следующее принципиальное непреодолимое возражение на очереди?

Криптобиржа Binance ослабила ограничения на клиентов-россиян

В прошлом году Binance на волне санкций ЕС ввел ограничение на остатки по счетам россиян на бирже в размере 10 тысяч евро. С тех пор санкции Евросоюза становятся только жестче, а вот Бинанс неожиданно это старое свое ограничение отменил.

С чем конкретно связан этот шаг – точно непонятно. Неужели юристы Чанпэна Чжао просто повнимательнее прочитали текст всех десяти пакетов санкций ЕС и поняли, что они с ограничением на кошельковые остатки просто погорячились? Как бы то ни было, возможность торговать долларами и евро для резидентов РФ на Бинансе по-прежнему отрублена – равно как и возможность для нерезидентов РФ баловаться рублями.

В Европе утвердили закон о регулировании крипты, а в США утвердились в желании мочить криптанов

Европарламент наконец утвердил давно обсуждавшийся законопроект MiCA по регулированию крипты: он вступит в силу через год.

Европейцы здесь пошли по пути стандартизации: всем заводчикам стейблкоинов надо будет получать специальные лицензии; эмитентам криптомонет – утверждать свои вайтпейперы (статьи с детальным описанием криптопроектов) в специальном органе; ну и в целом, всем участникам рынка – следовать установленным правилам по прозрачности и раскрытию информации.

Для европейского крипторынка это всё скорее выглядит как хорошие новости. Потому что американцы пошли противоположным путем: «никаких специальных правил для криптанов вводить не будем, пусть они вместо этого следуют всем требованиям для традиционных рынков ценных бумаг».

На практике это означает, что бедных штатовских криптанов просто чехвостят судебными исками в хвост и в гриву – потому что следовать правилам классического финансового регулирования для них заведомо нереально. В прошлый понедельник SEC (Комиссия по ценным бумагам США) выписала очередной иск, на этот раз в адрес Bittrex – по сути, криптобиржа обвиняется в первую очередь в том, что она является незарегистрированной по законам США биржей, брокером и клиринговым агентом. А то же самое, в общем-то, можно смело предъявлять вообще всем подряд криптобиржам, которые ведут свою деятельность в Штатах...

Кстати, зацените еще сразу вот это видео, в котором Гари Генслера допрашивают с пристрастием про то, чем же является Эфир (ETH) – ценной бумагой или сырьевым товаром (commodity)? А тот крутится, как уж на сковороде, и всеми силами избегает прямого ответа. И как вот они ожидают, что американские криптаны будут «честно следовать всем правилам» – если даже на такой вопрос по самому базовому аспекту регулирования невозможно добиться внятного ответа?..

Хорошая новость недели

Госдума приняла закон об увеличении размера налоговых вычетов:

вычет на обучение детей поднимут с 50 тыс. до 110 тыс. рублей;

вычет по расходам на свое обучение и на лечение увеличат со 120 тыс. до 150 тыс. рублей.

И это хорошо!

Если подборка новостей показалась вам интересной – буду благодарен за подписку на мой ТГ-канал RationalAnswer, где я пытаюсь найти разумные подходы к личным финансам и инвестициям.

Комментарии (74)

Belking

24.04.2023 05:20+13>> Эта разница аж в 1,8% говорит о том, что рыночек совершенно не исключает вероятность дефолта США на горизонте ближайших двух–трех месяцев.

Или о повышении ставки в течение ближайших двух-трех месяцев... Вы свои статьи монетизируете размещением эссе Михаила Леонтьева?

RationalAnswer Автор

24.04.2023 05:20+7Только не о повышении, а о понижении. И если есть ожидания, что это произойдет через три месяца - то это никак не повлияет на доходности текущих трехмесячных бумаг, они уже погасятся к этому времени.

Поэтому я немного застилменю ваш тезис: возможно, вы хотели сказать, что рынок ожидает понижения ставки ФРС аж на 1 процентный пункт сразу в течение ближайшего месяца.

Такое теоретически возможно: например, мы видели такое снижение в марте 2020-го. Но это экстренная мера для каких-то супер-выдающихся событий - пока мы не видим даже предпосылок к этому, чтобы говорить, что это более вероятное объяснение.

Belking

24.04.2023 05:20+2>> Только не о повышении, а о понижении

Путаете повышение доходности и стоимости облигации. В общем случае, когда стоимость облигации растет, доходность по ней понижается и наоборот. То есть когда ФРС повышает ставку, облигации падают в цене, но это значит что доходность по ним растёт.

>> И если есть ожидания, что это произойдет через три месяца - то это никак не повлияет на доходности текущих трехмесячных бумаг, они уже погасятся к этому времени.

Посыпаю голову пеплом, тут напутал я, да.

>> Поэтому я немного застилменю ваш тезис: возможно, вы хотели сказать, что рынок ожидает понижения ставки ФРС аж на 1 процентный пункт сразу в течение ближайшего месяца.

Да, спасибо, ловите плюсик, но всё таки к "повышению".

Ещё как вариант - обычный избыток ликвидности в моменте и не готовность их размещать в долгую. На фоне крахов банков риск-менеджеры в моменте решили порекомендовать увеличить объем текущих средств, из-за чего от резкого спроса на них они выросли в цене и соответственно доходность по ним упала.

RationalAnswer Автор

24.04.2023 05:20Путаете повышение доходности и стоимости облигации.

Возможно, это всё же вы что-то путаете. Вы написали, что текущий спред между 1m & 3m Treasury Bills может объясняться ожиданиями повышения ставки. Это объяснение не работает математически - чтобы закрыть этот гэп, наоборот, требуется ожидание резкого понижения процентной ставки.

Belking

24.04.2023 05:20+1>> Это объяснение не работает математически

Может быть, если предположить что имеется бесконечное число каждого из "1m & 3m Treasury Bills", то да, но думать о таком бессмысленно.

Давайте по другому, ещё проще - у вас миллион рублей, который Вы можете разместить на 1 месяц под 3% или на 3 месяца под 5%, при этом Вы уверены, что через месяц ставка снизится. Как Вы его разместите? Логично размещать всё под 5%, потому что мало того, что вы потеряете процент от более низкого месячного размещения, дак еще и дальше разместите уже по ставке ниже. Понимаете? Если же уверены, что ставка вырастет, то конечно логично разместиться сейчас под 3%, чтобы дальше на 3 месяца разместится уже под более высокую ставку на длительный срок.

Но если у Вас в голове "блин, не понимаю что вообще происходит, давайте подождем", то Вы размещаетесь на короткий срок и согласны на любую предложенную ставку, потому что даже 0,1% лучше чем 0%. К тому же будь это вера в то, что инструмент дефолтный (всмысле, по нему может произойти дефолт, а не инструмент по умолчанию, что к нему также применимо), то мне кажется разница в 2 месяца между сроками погашения вообще никакой роли играть не должна. Речь то не о том, что доходность 3-х месячных стала запредельной, а о том, что доходность 1-месячных упала (выросла на них цена).

RationalAnswer Автор

24.04.2023 05:20+2Это объяснение не работает математически

Дошел до дома - сорри, тут конечно я затупил на ходу (перепутал направление гэпа между ставками)! Вы правы про повышение ставки, а я написал ерунду чуть выше.

Я бы сказал, что текущая ситуация, когда одномесячные Treasuries дают доходность 3,36% при ставке овернайта Fed Funds Rate 4,83% - это какая-то аномалия. В принципе, такая форма кривой ставок с огромным разрывом для бумаг с разницей в сроке погашения один месяц - это крайне аномальная штука. Сравните, например, ситуацию в начале апреля (где гэп был нулевой) и текущую: https://home.treasury.gov/resource-center/data-chart-center/interest-rates/TextView?type=daily_treasury_yield_curve&field_tdr_date_value_month=202304

На мой взгляд, говорить, что рынок реально ожидает однократное повышение ставки одномесячных treasuries на 1,6% через месяц, а вся остальная кривая при этом останется плюс-минус такой же - это звучит в каком-то смысле даже более фантастично, чем история с дефолтом.

Belking

24.04.2023 05:20>> Сравните, например, ситуацию в начале апреля (где гэп был нулевой) и текущую

Действительно интересная ситуация с гэпами и их расширением. Причем дальше от года ситуация разворачивается. А вот с 20 апреля происходит резкое падение месячной ставки аж на пол процентной ставки, при том что остальные остаются практически нетронутыми - видимо здесь уж начинает играть больше фактор описанный в последнем абзаце второго комментария с ажиотажным спросом на них. Что на фоне такой ставки овернайта оооооочень странно.

Про 1,6%, конечно перебор, но видимо скопление разных факторов.

victor_1212

24.04.2023 05:20по слухам просто на днях уточнили вниз оценку собранных налогов этого года, меньше свободных денег - более опасна пляска с поднятием потолка гос долга, но только в краткосрочном плане - все понимают, что на долгую пляску никто не пойдет по политическим причинам, типа народ не поймет

victor_1212

24.04.2023 05:20если с gap между краткосрочными и долгосрочными рисками дефолта понятно, какие еще вопросы?

Belking

24.04.2023 05:20Извините, я Вас не понял. Вы же не путаете "поднятие потолка гос.долга" с "дефолтом"? Например, в истории уже вполне себе были шутдауны. В чем принципиальная разница - по общему правилу запрещено оплачивать заимствования новыми заимствованиями, для этого есть процедура рефинансирования, являющаяся маркером проблем.

victor_1212

24.04.2023 05:20да нет не путаю, конечно практически намного более вероятна угроза government shutdown, чем default (таки не аргентина, хотя исключать нельзя), но short term securities учитывают все возможные риски, в данном случае повысились краткосрочные риски -> больше спрос на securities -> low yield -> gap,

учитывая близость выборов, все сильно политизировано, но думаю что серьезных проблем с бюджетом не будет, imho смотреть надо другое, в первую очередь инфляцию и состояние банков

Panov_Alexey

24.04.2023 05:20+23рыночек совершенно не исключает вероятность дефолта США на горизонте ближайших двух–трех месяцев.

Опять? Если верить нашим СМИ, уже сто лет, как западный капитализм вот-вот загнется. Осталось лишь пару месяцев потерпеть.

vvzvlad

24.04.2023 05:20+12Опять? Если верить нашим СМИ, уже сто лет, как западный капитализм вот-вот загнется.

А вы, простите, отличаете "я считаю что рынок сша дефолтнется" и "судя по этим маркерам, примерно Х% рынка ожидает дефолт"

domix32

24.04.2023 05:20+2Так речь не за смерть капитализма, а за умирание экономики. Рост инфляции с обанкрочивание банков и прочих крупных рыночных агентов (тот же SVB, например). Рост инфляции и рост цен на нефть приводит к удорожанию товаров и услуг, что в свою очередь пытаются компенисровать ростом зарплат и дальнейшему разгону инфляции.

Не так давно США таки была в состоянии технического дефолта пару недель. Это как раз тогда, когда они решили переписать определение рецессии. А потом в рынок стали лить нефть из резервов.

vvzvlad

24.04.2023 05:20Кстати, зацените еще сразу вот это видео, в котором Гари Генслера допрашивают с пристрастием про то, чем же является Эфир (ETH) – ценной бумагой или сырьевым товаром (commodity)? А тот крутится, как уж на сковороде, и всеми силами избегает прямого ответа

А что будет в том и в другом случае? Почему они не могут ответить, что это сырьевой товар?

RationalAnswer Автор

24.04.2023 05:20+16Если ценная бумага - то SEC иски должна предъявлять криптанам; если коммодити - то CFTC. Пока Эфир находится в шредингеровской суперпозиции - как мы видим, иски предъявляют одновременно и те, и те.

Kragius

24.04.2023 05:20+13Старшип у вас неправильный :-) это фото с тестов второй ступени, которая тоже Старшип :-) они летали года два назад. Недавно летавший Старшип в 2 раза длиннее, и двигатели у него по всей нижней стороне, а не только в центре. Собственно выхлоп от 33 двигателей первой ступени и уничтожил площадку, 33 контролируемых постоянных взрыва...

domix32

24.04.2023 05:20-2и произвела БВР

так оно ж вроде плановое было. ракета дожгла плановое топливо на подъём с наклоном и стала наворачивать круги в качестве стресс теста. Т.к. сажать обратно это не планировалось был оформлен плановый разбор.

Собственно видео. Отсчёт на 44:30

На фотках выглядит так, как если бы что-то мощное бомбануло прямо на земле

Дык оно фактически и бомбануло.

Криптобиржа Binance ослабила ограничения на клиентов-россиян

Всю почту заспамили по этому поводу. Подозрительная фигня

RationalAnswer Автор

24.04.2023 05:20+3По плану ракета должна была сделать один разворот, сбросить ступень и лететь дальше - но она стала бесконтрольно крутиться и ее взорвали.

Skigh

24.04.2023 05:20+1По плану ракета должна была сделать один разворот, сбросить ступень и лететь дальше

Это — программа-максимум.

Программа-минимум — взлететь со стартового стола, передать телеметрию — выполнена.

RationalAnswer Автор

24.04.2023 05:20Выше пишут, что никакого плана лететь дольше 4-х минут не было.

kamilkamilkamil

24.04.2023 05:20Если автор считает неизбежным постоянное повышение потолка госдолга, то почему его неполная реализация под определенный процент не считается неизбежностью ? Насколько я понимаю если спрос будет низкий -> повысят процент -> кредиты в благополучных странах ниже этой ставки перестанут выдавать -> новый виток проблем.

RationalAnswer Автор

24.04.2023 05:20Не очень понял, что имеется в виду под "неполная реализация под определенный процент"

kamilkamilkamil

24.04.2023 05:20Увеличение госдолга означает что они разрешают самим себе взять в кредит доп. средства, получают они их выпуском дополнительных казначейских облигаций. Если их будут плохо покупать, придется поднять процент по ним, в итоге самая надежная бумага на планете станет более прибыльной, банкам станет невыгодна выдача ипотек по низким ставкам. Не знаю, плавают ли сейчас ставки по ним как в 2008, но тем людям которые имеют низкий остаток после уплаты по счетам станет не по силам тянуть покупку дома. Ну и крупному бизнесу придется кредитоваться под больший процент, т.к. они менее надежные чем местные ОФЗ

phenik

24.04.2023 05:20+3«У этой тупой жестянки даже нет памяти, она всё забывает при закрытии диалогового окна!» – Брокман: «Мы тут приделали модуль памяти, в который можно сохранять всякое...»

Видимо речь о сохранении частей диалога пользователя, возможно используемых в качестве контекста в следующей сессии. Сама модель при этом не меняется.

«Да эти модели галлюцинируют, доверять им просто невозможно!» – Брокман: «Вместе с модулем доступа в интернет ChatGPT теперь можно будет попросить факт-чекнуть предложенный ей ответ, и она сама это весьма неплохо сделает.»

От такой проверки сама модель перестала фантазировать? Это принципиальная особенность технологии. Причем в определенных пределах весьма полезная. Человек также фантазирует, это одна из составляющих творческого процесса, напр, при написании стихов. Однако это плохо для ответов связанных с формализованными знаниями, которые требуют точности и повторяемости результатов вне зависимости от контекста.

«Пока у ИИ нет никаких возможностей влиять на мир, это всё детские игрушечки просто!» – Брокман: «А теперь я попрошу ChatGPT запостить это в Твиттер, чтобы все зрители моего Тед-тока смогли это увидеть...»

Возможно через очередной плагин.

«Ваши нейросети – это просто статистические попугаи, которые никогда не смогут в принципе ничего понять» – Брокман: «Да я тут сам офигел, когда выяснилось, что GPT-4 точно складывает 40-значные числа – хотя тупым запоминанием комбинаций этого достичь в принципе невозможно!»

Чудес не бывает, если речь только о самой языковой модели. Она может правильно сложить 40-значные числа для нескольких примеров, но сложит приближенно или неточно куда меньшие числа, см. пример с возведением в степень. Объяснение этому может быть таким.

Нужно различать возможности самой модели с возможностями внешних расширителей.

Kanut

24.04.2023 05:20+1Однако это плохо для ответов связанных с формализованными знаниями, которые требуют точности и повторяемости результатов вне зависимости от контекста.

Ну так в такой ситуации можно запрашивать только ответы у которых "уровень достоверности 99,99%" или ещё что-то в этом роде.

То есть если модель умеет фантазировать, но при этом всегда знает насколько ответ соответствует реальности, то особой проблемы нет.

phenik

24.04.2023 05:20То есть если модель умеет фантазировать, но при этом всегда знает насколько ответ соответствует реальности, то особой проблемы нет.

В том то и дело, что она не знает точного ответа, только аппроксимацию, если только такого примера не было в обучающей выборке. Увеличение числа параметров модели и объема обучающей выборки может улучшить результаты, но не решит проблему принципиально. Кроме того механизм сэмплирования может иногда просто гадить изменяя потенциально правильный ответ.

Kanut

24.04.2023 05:20В том то и дело, что она не знает точного ответа

Человек тоже не знает точного ответа. Или точнее иногда он считает что ответ правильный, а на самом деле это не так.

Увеличение числа параметров модели и объема обучающей выборки может улучшить результаты, но не решит проблему принципиально

Речь не о улучшении результата как такового, речь о том что модель может вам сказать насколько она уверена в ответе. И/или дать вам ссылку на источник.

phenik

24.04.2023 05:20+1Человек тоже не знает точного ответа. Или точнее иногда он считает что ответ правильный, а на самом деле это не так.

Это зависит от вопроса. Если философского содержания, то да, если формального, то нет. Например, для операций с числами человек знает процедуры вычислений, и для любых чисел теоретически может получить правильный результат. Проблема в ограничениях по памяти, вниманию, скорости мышления. Таких ограничений для для ЯМ нет, однако они не обладают процедурным мышлением и памятью, как человек. В общем случае для этого необходима рекуррентная архитектура сети, а не прямая, как у трансформеров.

Речь не о улучшении результата как такового, речь о том что модель может вам сказать насколько она уверена в ответе.

На основании чего? И как это применимо к формальным выводам? Они либо правильные, либо не правильные. Приводил выше ссылку на примеры вычислений чата, вот еще, сколько пользователь не пытался, не получил ни одного правильного ответа.

Kanut

24.04.2023 05:20-1Это зависит от вопроса.

Или от человека. То есть когда вы задаёте какой-то вопрос какому-то человеку, то вы не знаете насколько точен его ответ. Естественно за исключением ситуаций когда вы сами уже знаете правильный ответ.

Например, для операций с числами человек знает процедуры вычислений,

Или человек тупой и никогда не ходил в школу. И поэтому не знает. Или он процедуру знает, но ошибся когда вычислял.

На основании чего?

А на основании чего это делает человек? Например на основании достоверности источника откуда взята информация.

И как это применимо к формальным выводам? Они либо правильные, либо не правильные.

Это сколько угодно. Но когда вы задаёте вопрос человеку, то он может быть уверен в своём ответе или нет.

phenik

24.04.2023 05:20+1Как то вы перевели обсуждение в гуманитарную плоскость) Мы обсуждаем сложный, но все технический вопрос. Начать с того, что моделируют ЯМ типа GPT на базе трансформерной архтитектуры? В этом исследовании делается вполне обоснованное предположение, что это ассоциативный уровень мышления и памяти человека. Так и есть, причем весьма приближенно. Ассоциативное мышление человека полностью контекстуально, нет никакого механизма сэмплирования, который фактически модифицируем вывод самого трансформера в зависимости от установок. Эти ЯМ полностью вероятностные в отличии даже от ассоциативного уровня мышления человека. Те же фантазии чатов куда менее связанные, чем фантазии человека находящегося в пределах психофизиологической нормы. У человека кроме ассоциативного уровня присутствует еще множество различных форм мышления (здесь подробнее). Среди этих уровней мышления, например, уровни логического и критического мышления. В этом исследовании обсуждаются способы, как включить логику в таких ЯМ, что бы повысит обоснованность ответов.

К чему все это? Не стоит особенно сравнивать возможности человека и эти моделей, и переносить отношения людей на них. Это просто очередное техническое средство, основа для нового поколения интеллектуальных ассистентов, которые придут на смену Сири, Алисе, и др. подобным.

Поэтому остаются актуальными вопросы, как быть с проблемами типа этой и этой, вот еще в дополнение к счету на логику. Они не решаются принципиально не увеличением числа параметров моделей и их обучением, не расширением возможностей с помощью внешних плагинов.

Kanut

24.04.2023 05:20Не стоит особенно сравнивать возможности человека и эти моделей, и переносить отношения людей на них

Никто не переносит отношения людей на модели. Вопрос в том что если вы и без них в общем-то никогда не знаете насколько достоверные ответы вы получаете, то почему вы ожидаете от них чего-то другого?

phenik

24.04.2023 05:20Привел вам вычислительные примеры точные ответы на которые известны, но чатбот отвечает на них не правильно, хотя иногда близко. Это должно также распространятся на факты, и не должно зависеть от называемого пользователем контекста. Например, при соблюдении нормальных условий вода замерзает при нуле градусов, кипит при стах. Видел диалоги, в которых пользователи убеждали чат, что это не так, и он соглашался. И таких примеров полно. От интеллектуальных ассистентов ожидаешь именно такого поведения, а также при необходимости, по запросу, привести обоснование произведенных вычислений или приведенных фактов. Если такое не возможно по каким либо причинам, то явного указания на это. Это соотносится с возможностями людей. И не нужно давить на то, что всегда можно найти людей, которые подобные задачи выполняют не правильно, поступают не лучше чата, ошибаются, поддаются уговорам, и тп. Как обучать чат так на знаниях всего человечества, а как сравнивать возможности, так найти самого убогого) Что за несправедливость. Или чат уже причислили к защищенным меньшинствам, требования к которым снижены?) Сравнивать нужно только с возможностями специалистов, желательно лучшими в своей области, еще лучше с коллективом таких спецов.

Kanut

24.04.2023 05:20Привел вам вычислительные примеры точные ответы на которые известны, но чатбот отвечает на них не правильно, хотя иногда близко.

Известны кому?

От интеллектуальных ассистентов ожидаешь именно такого поведения. Если такое не возможно по каким либо причинам, то явного указания на это.

Кто это сказал?

Это соотносится с возможностями людей.

Нет, не соотносится. Это максимум соотносится с возможностями отдельных людей и/или в отдельных ситуациях. Люди точно так же могут не знать, фантазировать или просто ошибаться. И даже сами этого не понимать.

Как обучать чат так на знаниях всего человечества, а как сравнивать, так найти самого убогого)

Ну так "знания всего человечества" это в том числе и "ошибочные знания". Хотите чтобы ИИ выдавал вам достоверные ответы, ну так и обучайте его только на достоверных непротиворечивых данных.

phenik

24.04.2023 05:20Вы вообще какой тезис защищаете? Что чатбот может выдавать любую лажу на вопросы ответы на которые известны точно?

Kanut

24.04.2023 05:20Я защищаю тезис что чатбот может выдавать что угодно в зависимости от того что вы хотите от него получать и как вы его натренировали.

То есть если вы хотите чатбота для того чтобы просто болтать с ним о всяком разном, то не надо ожидать от него 100% достоверной информации.

phenik

24.04.2023 05:20+1Я защищаю тезис что чатбот может выдавать что угодно в зависимости от того что вы хотите от него получать и как вы его натренировали.

Понятно, это распространенная заблуждение. Возможности ИНС зависят не только от способа обучения и обучающей выборки, но, и первую очередь, от ее архитектуры. Она определяет общие возможности всей сети.

Пример из биологии. Сколько шимпанзе не учили языку, в любых формах, они не превосходили достижений 2-3 летних детей в этом. Очевидно, дальнейшему развитию мешали ограничения когнитивных способностей и физиологии шимпанзе. В мозге не были развиты отделы поддерживающие усвоение более сложных языковых форм, т.е. попусту имеются архитектурные ограничения поддержки функций в терминах технологии ИНС. Адекватной для достижения возможностей человека, включая языковые, считается архитектура получившая название когнитивной архитектуры (обзор). Архитектура трансформеров пока еще весьма далека от таких требований.

Существующая архитектура ЯМ не может обеспечить того, что от нее хотят получить, не смотря на все попытки закрыть недостатки используя увеличение числа параметров, разные варианты обучения и привлечение дополнительных внешних средств. Это к утверждениям Брокмана, и вслед за ним автора статьи, с обычным упоминанием «вы сейчас находитесь здесь». Улучшения имеются, но реальная продвижка в решении будет только с развитием архитектуры, включая в решении вопроса достоверности ответов. Для этого потребуется уровень обобщения приближающийся к возможностям человека, и включение, как минимум, аналогов логического и критического мышления, выше давал ссылку на некоторые предложения. В перспективе образного уровня, который позволит моделирование ситуаций связанных с вопросами в воображаемом мире (симуляцию), как это в сложных случаях может делать человек.

То есть если вы хотите чатбота для того чтобы просто болтать с ним о всяком разном

Для этого достаточно Элизы 60-х годов) Не нужно пыжиться и отравлять атмосферу CO2 при таких энергозатратах на обучение и эксплуатацию трансформерных ЯМ .

Kanut

24.04.2023 05:20-1Возможности ИНС зависят не только от способа обучения и обучающей выборки

Да. Но ваша проблема с "недостоверностью ответов" зависит именно от обучающей выборки.

Существующая архитектура ЯМ не может обеспечить того, что от нее хотят получить

Кто хочет? Вы лично?

Для этого достаточно Элизы 60-х годов

Если вам этого достаточно, то и здорово. Используйте её. Другим хочется слегка большего.

phenik

24.04.2023 05:20Но ваша проблема с "недостоверностью ответов" зависит именно от обучающей выборки.

Нет, привел вам примеры с вычислениями. Для решения этой проблемы требуется обобщение чисел и операций с ними, которое приводит к процедурам вычислений требующих рекуррентности для своего выполнения. В трансформерах в полной мере это не достижимо. Кстати, такого универсального решения не обеспечивают даже специализированные трансформерные ЯМ натренированные на математическом контенте. Всегда нужно перепроверять результаты, в отличии от обычных мат. пакетов.

Кто хочет? Вы лично?

Не только, почитайте коменты в статьях на Хабре посвященных чату с кучей примеров и разочарований от ответов.

Если вам этого достаточно, то и здорово.

Нет, мне не нужет чат, как вы написали "чтобы просто болтать"

Думаю тема дискуссии исчерпана.

Kanut

24.04.2023 05:20Нет, привел вам примеры с вычислениями. Для решения этой проблемы

Для решения этой проблемы достаточно плагина с математикой. Если вам нужно чтобы ИИ умел это правильно делать.

С другой стороны если вам нужны именно правильные вычисления, то зачем вам ИИ? Ну то есть если вам раньше нужны были вычисления, то вы спрашивали их у соседа по площадке или брали калькулятор?

Не только, почитайте коменты в статьях на Хабре посвященных чату с кучей примеров и разочарований от ответов.

Ну то есть люди с какими-то там своими ожиданиями берут рэндомный ИИ и жалуются что он этого не может?

phenik

24.04.2023 05:20Для решения этой проблемы достаточно плагина с математикой.

Исходно речь шла только о возможностям самих ЯМ. Человек может самостоятельно произвести вычисления. Внешние средства нужны только для ускорения процесса.

За плагины, кстати, нужно будет платить дополнительные деньги. По поводу плагина Вольфрама согласен с другим вашим оппонентом, см. ветку. И для них еще нужно создать правильное задание на их языке из запроса пользователя. Если с пониманием смысла чисел и операций с ними проблема, то задание может просто не правильно составляться.

Ну то есть люди с какими-то там своими ожиданиями берут рэндомный ИИ и жалуются что он этого не может?

Ожидания вполне определенные и естественные. Развиваться ЯМ будут в этом направлении, иначе они не выдержат конкуренции с другими развивающимися решениями, такими как нейроморфные технологии и нейросимволический ИИ.

Kanut

24.04.2023 05:20Исходно речь шла только о возможностям самих ЯМ.

Кто это сказал? Кроме того вы оцениваете "чат-бота" по тому как он умеет считать. Возьмите ИИ, тренируйте его исключительно как "калькулятор" и я уверен что он превзойдёт человека. Правда это относительно бессмысленное занятие.

Человек может самостоятельно произвести вычисления.

До определённого уровня сложности.

За плагины, кстати, нужно будет платить дополнительные деньги

И что? Почему это вдруг стало релевантно?

Ожидания вполне определенные и естественные

Людям дали побаловаться с чатботом. А люди хотят чтобы он мог всё и лучше любого человека. Очень естественные ожидания...

phenik

24.04.2023 05:20Кто это сказал?

См. исходный комент ветки, это предполагаемый контекст обсуждения. Не нужно переносить возможности внешних расширений на сам бот. Сам он по прежнему только ЯМ на базе архитектуры трансформера, с преимуществами и недостатками технологии. И эти недостатки определяют потолок ее применимости.

Возьмите ИИ, тренируйте его исключительно как "калькулятор" и я уверен что он превзойдёт человека.

Ну, и где такой калькулятор? Вы отдаете себе отчет, что множество чисел и операций с ними бесконечно, а вещественных к тому же не счетно? Все, или почти все с учетом аппроксимирующих возможностей этой архитектуры, в обучающей выборке не приведешь. Это значит всегда будут проблемы с точность для некоторых значений. Речь именно об обучении ЯМ на GPT, а не других архитектур. Хотя, если ввести ограничения сверху и по точности, то обучить теоретически возможно.

До определённого уровня сложности.

Теоретически для любого, если ограничений по времени нет.

Людям дали побаловаться с чатботом. А люди хотят чтобы он мог всё и лучше любого человека.

Нет, не хотят. Это даже потенциально опасно. Хотят, в основном, чтобы он меньше нес напрасную пургу, хотя есть и другие пожелания. Иначе возлагающиеся на эту технологию надежды не оправдаются, как это энтузиасты представляют сейчас себе. Для этого архитектуру придется развивать.

Мой прогноз, на основе собственного, достаточно продолжительного опыта, такой.

Kanut

24.04.2023 05:20См. исходный комент ветки, это предполагаемый контекст обсуждения.

Где?

Ну, и где такой калькулятор?

А кому он нужен? Кто сейчас будет тратить на такое деньги и ради чего?

Теоретически для любого, если ограничений по времени нет

Теоретически и сильный ИИ возможен и термояд. А вот в реальнсти...

Нет, не хотят. Это даже потенциально опасно. Хотят, в основном, чтобы он меньше нес напрасную пургу

Эти два высказывания противоречат друг другу. Люди несут пургу. Если вы хотите чтобы чатбот этого не делал, то вы ожидаете что он будет лучше людей.

phenik

24.04.2023 05:20Где?

Здесь перечислено и в итоге — "Нужно различать возможности самой модели с возможностями внешних расширителей." Это вполне однозначно определят отношение автора ветки к теме.

А кому он нужен? Кто сейчас будет тратить на такое деньги и ради чего?

Чтобы понять аппроксимирующие возможности этой архитектуры, в конечном итоге пределы обобщаемости. Желательно в зависимости от числа параметров модели и объема обучения. С какой плотностью должны в выборку входить обучающие примеры, чтобы обеспечить требуемую точность аппроксимации для примеров не входящих в нее? Числовые примеры очень удобны в этом отношении, т.к. для них можно ввести количественную оценку точности.

Подробнее..Повторю, человек воспользуется процедурой вычисления, напр, сложением в столбик, что получить точный результат. Это объясняется тем, что производится обобщение операций с числами на конечном числе примеров и вырабатывается процедуры вычислений. Для этого человек пользуется процедурной памятью и мышлением. Эта память располагается в других отделах мозга нежели ассоциативная, которая позволяет, напр, запоминать таблицы сложения и умножения, или конкретные примеры операций, или мнемоники, и тп. Есть исследования, где эта разность демонстрируется с помощью нейровизуализации активности отделов мозга при выполнении различных типов тестов. Напр, операций с небольшими числами и операций с большими. В последнем случае человек может представлять, как он последовательно делает вычисления на бумаге, или аббаке, как распространено на Востоке. Феноменальные счетчики применяют разные приемы, как процедурные, так и ассоциативные, включая визуальные. Но у всего есть предел. Для очень больших чисел придется брать карандаш и бумагу.

Интересный вопрос. Можно ли реализовать такие процедуры в ЯМ? Трансформеры прямые сети во время обучения. Однако во время работы они перезапускаются (авторегрессивны), т.е. обладают рекуррентностью на глобальном уровне. Можно как-то преодолеть этот разрыв? Мозг человека, в первом приближении, состоит из иерархически организованных реккурентных сетей. Эти сети способны создавать аттракторы — устойчивые динамические состояния, которые являются основой памяти и сложного поведения. Никакой информации на этот счет пока не встречал.

Теоретически и сильный ИИ..

Не ерничайте, можно)

Эти два высказывания противоречат друг другу. Люди несут пургу.

Опасность не в пурге. Вы написали, что он может все и быть лучше человека. Это опасно. Может вылиться в конкурирующий вид. Известно к чему это может приводить на примере самого H.Sap. Исчезновению других видов, тех же неандертальцев, и целых цивилизаций, тех же в Ю. Америке при колонизации, и др. Риск имеется.

Kanut

24.04.2023 05:20Чтобы понять аппроксимирующие возможности этой архитектуры

Ну так кому это нужно? Кто готов за это платить? И даже если, то зачем делать результаты общедоступными?

Вы написали, что он может все и быть лучше человека

Где я такое писал?

Это опасно. Может вылиться в конкурирующий вид.

А это вообще здесь причём?

phenik

24.04.2023 05:20Где я такое писал?

А это вообще здесь причём?Это такая возможная перспектива, которую не стоит недооценивать, сами писали

Людям дали побаловаться с чатботом. А люди хотят чтобы он мог всё и лучше любого человека. Очень естественные ожидания...

Впрочем, и переоценивать тоже. По крайней мере в виде ЯМ)

Kanut

24.04.2023 05:20-1Это такая возможная перспектива, которую не стоит недооценивать, сами писали

Где я писал что он может всё?

Refridgerator

24.04.2023 05:20+1«уровень достоверности 99,99%»

Возможно, вы слышали про ложку дёгтя в бочке мёда. Это даже если просто считать, что уровень достоверности считается от достоверных данных.

Kanut

24.04.2023 05:20Это я понимаю. Но давайте забудем про ИИ и вы скажите мне где сейчас можно получить действительно достоверные ответы?

Refridgerator

24.04.2023 05:20При такой формулировке вопроса первым делом нужно определить критерии достоверности. Вторым делом — определить контекст. Один и тот же ответ в разном контексте может менять смысл вплоть до противоположного. Третьим делом — определить мотивацию и профессиональный уровень отвечающего. Например, он может и знать правильный ответ — но соврёт вам специально, потому что это больше соответствует его личным интересам. Четвёртым делом — определить способы тестирования полученного ответа на достоверность, а также связанные с этим риски.

Kanut

24.04.2023 05:20А что мешает поступать примерно так же и в отношении ИИ? Почему от ИИ вдруг ожидается что он будет выдавать достоверные ответы "сам по себе"?

Refridgerator

24.04.2023 05:20Кто ожидает? Я не ожидаю. Если человек/ИИ не врёт — это ещё не значит, что он говорит правду/достоверную информацию. Он может искренне заблуждаться относительно природы вещей.

Kanut

24.04.2023 05:20Ну вон там выше жалуются что ИИ не знает точного ответа и что она иногда "фантазирует". На мой взгляд это не особая проблема потому что это точно так же справедливо и в отношении кучи других источников, которыми мы регулярно пользуемся.

Refridgerator

24.04.2023 05:20Но мы можем оценить беспристрастность этих источников и сделать соответствующие поправки. А ГПТ — нет, у него чем больше мух, тем больше правды.

Kanut

24.04.2023 05:20А вот это уже вопрос того как и/или на каких источниках вы тренируете ИИ.

То есть естественно ИИ, как минимум пока, сам не может оценить беспристрастность источников. Но вы можете сделать это за него.

Robastik

Здесь опечатка, надо через Ы вместо А.

flass

Выссермын? Монгол, что ли?

ogost

Эээ, а мы тут причём?

Kanut

Как обычно. За компанию с велосипедистами :)

VladislavVladimir

Согласен полностью. Но при условии, что фамилия начинается с буквы Ы