В этой статье мы расскажем вам про самые важные фичи, внедренные за последние полгода в ChatGPT (самую мощную нейросетку в мире), а также обсудим – каким видением будущего поделился Сэм Альтман на прошедшей 7 ноября конференции от OpenAI. Спойлер: они хотят запилить «агентов Смитов», которые смогут самостоятельно взаимодействовать с миром!

У этой статьи как будто бы два автора, но на самом деле почти весь текст написал Игорь Котенков (автор канала Сиолошная про машинное обучение, космос и технологии). Можно сказать, что Игорь тут отвечал за техническую корректность и экспертизу в искусственном интеллекте, а потом еще Павел Комаровский (автор канала RationalAnswer про рациональный подход к жизни и финансам) навалил поверх странных мемов. Короче, нет времени объяснять, поехали!

С момента выхода нашей прошлой статьи «GPT-4: Чему научилась новая нейросеть, и почему это немного жутковато» произошло много интересного. Были как обновления уже существующих продуктов, так и релизы кардинально новых. Разработчики не успевают клепать новые AI-стартапы, компании наперегонки привлекают миллиарды долларов инвестиций, а люди теряются в новостях и не понимают, что происходит в мире искусственного интеллекта. В общем, мы решили, что пора уже нам запилить обзор ключевых изменений, произошедших за более чем полгода, а также рассказать про самые свежие анонсы с только-только закончившейся конференции OpenAI DevDay 2023. Даже если вы внимательно следили за развитием ChatGPT — уверены, будет познавательно и интересно!

Примечание о ChatGPT/ChatGPT-3.5/GPT-4 во избежание путаницы (читать только педантам и занудам)

В целом, все эти слова означают примерно одно и то же. Но давайте всё же поясним используемую нами терминологию:

LLM, Large Language Model — большая языковая модель. Собственно, любая текстовая нейросетка, ярким представителем которой является и ChatGPT.

GPT-3.5 — это базовая текстовая модель (LLM) от OpenAI, долгое время существовавшая в виде сервиса для разработчиков. По навыкам похожа на завирусившуюся в декабре 2022-го ChatGPT.

ChatGPT, она же ChatGPT-3.5 — первая версия диалогового ИИ-ассистента, основанного на GPT-3.5. Добавлен формат диалога и проведено дообучение конкретно под этот формат.

GPT-4 или ChatGPT-4 — продвинутая версия модели от OpenAI. Она больше, тренировали ее дольше, поэтому она умнее и понимает больше языков. Сразу же была добавлена на сайт ChatGPT, поэтому фактически с марта 2023 года ChatGPT может обозначать и GPT-4: слова используются как синонимы. Отдельная версия GPT-4 без Chat-формата никогда не показывалась публике.

По большому счету, ChatGPT обозначает диалоговую LLM в общем. Почти во всех контекстах можно воспринимать это как GPT-4, так как смысла говорить о старых и менее способных моделях нет. Так что да, ChatGPT = GPT-4. :)

Если вы раньше вдруг не читали два наших прошлых лонгрида с объяснением простым языком принципов работы технологии текстовых нейросеток — то самое время наверстать это упущение (это поможет вам и в понимании текущей статьи):

План статьи

Весна 2023: Инструменты и плагины для ChatGPT, или как приделать нейросетке «ручки»

Осень 2023: Текстово-картиночная модель Dall-E 3, или квест по генерации идеального чебурека

API-доступ ко всем моделям и снижение цены: рождественские подарки для разработчиков

Поддержка в судебных делах по копирайту, или как пользоваться плодами нейронок безопасно

Миссия Microsoft и OpenAI: счастье для всех, и пусть никто не уйдет обиженным (ну или типа того)

ChatGPT шагает по планете

Для начала скажем пару слов про то, насколько прокачалась ChatGPT с точки зрения популярности и проникновения в широкие массы. (Кстати, опрос среди авторов данной статьи показал, что эту нейросетку регулярно используют уже 50% людей!)

Сэм Альтман (глава OpenAI) на конференции OpenAI DevDay 2023 раскрыл следующую статистику: недельная аудитория (WAU, Weekly Active Users) ChatGPT превышает сто миллионов человек. Интересно, что недельный показатель — не самый частоиспользуемый, обычно говорят про DAU (дневную аудиторию) или MAU (месячную). Мы помним, что в начале 2023-го продуктом уже пользовалось больше 100 млн человек в месяц. Аккуратно предположим, что эта цифра не выросла драматически, и поэтому решено было чуть-чуть изменить способ подачи. Например, согласно подсчетам по интернет-трафику, MAU составляет примерно 180 млн человек, что всё еще очень недурно для годовалого продукта!

Если вы финансист, то вам должно быть интересно следующее: 92% компаний из списка Fortune 500 (крупнейшие компании США по размеру выручки) уже используют продукты OpenAI. Короче, бизнесы вовсю пытаются придумать, как бы эту вашу технологическую сингулярность половчее использовать, чтобы бабосов побольше заработать!

А главное, всё это достигнуто совершенно без какой-либо платной рекламы — только сам продукт, молва о котором передается из уст в уста! (Disclaimer: этот материал не был проплачен OpenAI).

Ок, а теперь — давайте кратко пройдемся по ключевым вехам развития детища OpenAI, которые мы наблюдали с момента релиза флагманской модели GPT-4 в марте 2023-го.

Весна 2023: Инструменты и плагины для ChatGPT, или как приделать нейросетке «ручки»

Многие пользователи уже давно и справедливо критиковали «маломощные» способности языковых моделей, так как те не имеют доступа в интернет – а значит, не могут находить и использовать свежую информацию для формирования ответов на запросы. Все знания, что в них заложены, диктуются тренировочной выборкой, которую видела модель. Более того, в своем первозданном виде LLM довольно плохи в математике, и осуществляют лишь приблизительные вычисления (хоть иногда они и могут оказываться точными).

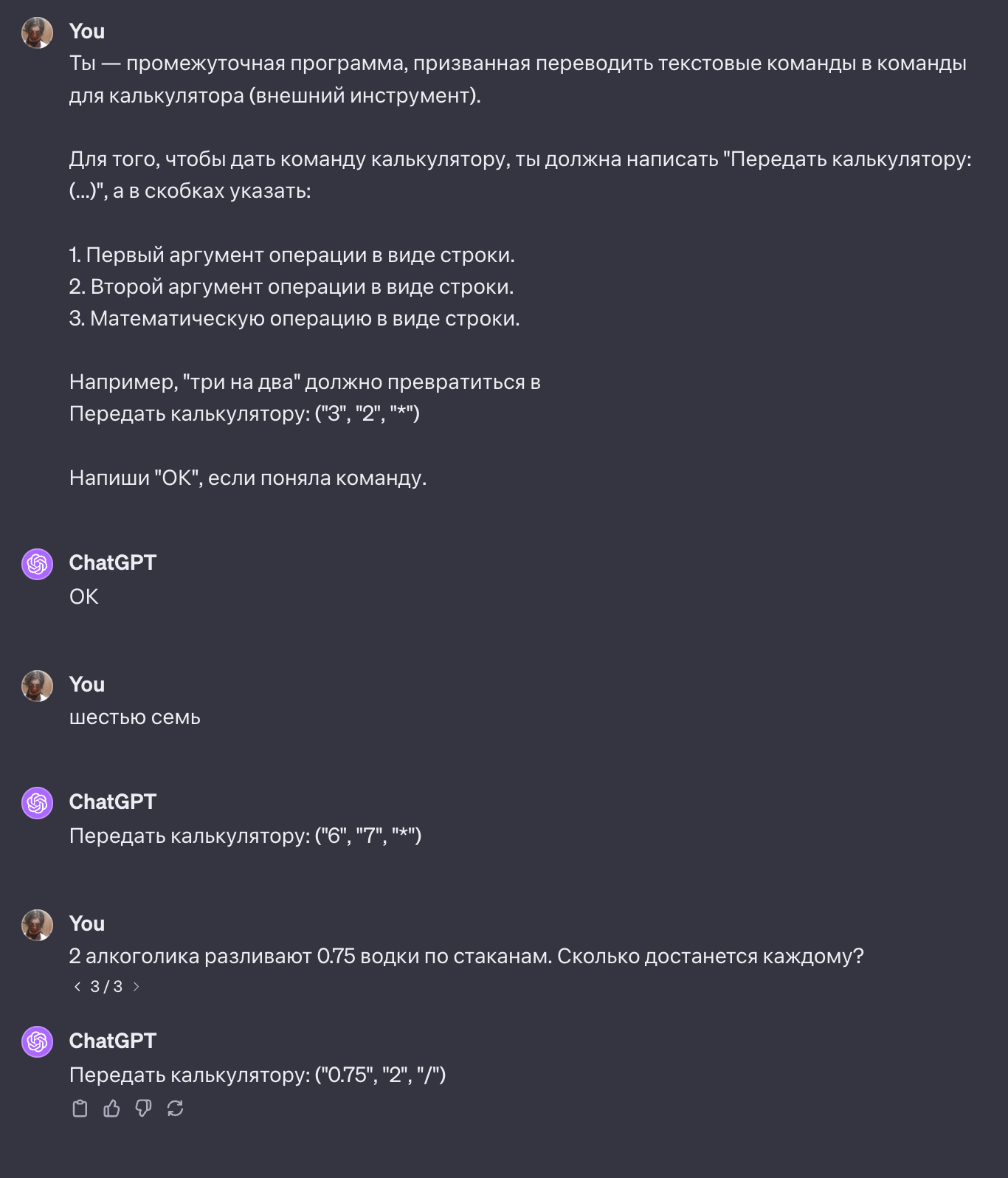

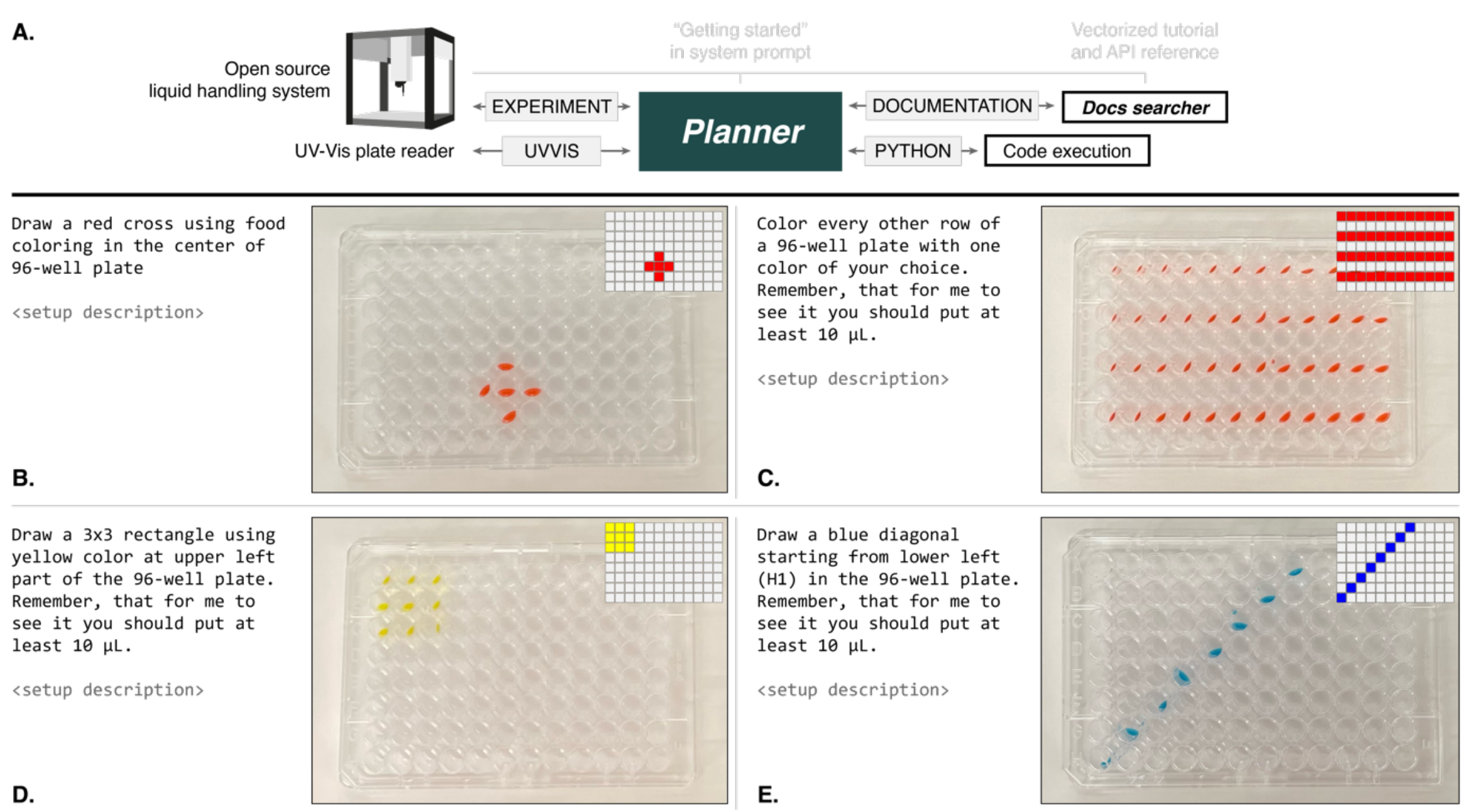

OpenAI, понимая эту проблему, адаптировали концепцию «инструментов». Как человек пользуется калькулятором для сложных вычислений вместо прикидки в голове, так и ChatGPT может обратиться к внешнему сервису с целью сделать одно конкретное действие — даже если оно сильно сложнее сложения двух да двух. Почти сразу после выхода модели GPT-4 появились «плагины», основными из которых стали доступ в поисковик Bing (эх, не пошутить про то, что модель «гуглит»!) и интерпретатор кода. Первый помогает актуализировать знания по разным темам, передавая в GPT результаты работы поисковика по конкретному текстовому запросу (который модель же и формирует), а второй — определяет, когда модель хочет запустить Python-программу, выполняет все действия и показывает результат.

У самых любознательных читателей может возникнуть вопрос: а как это вообще работает? Как «подключить» реальный мир к языковой модели, которая не умеет делать ничего, кроме как читать и писать текст? Для того, чтобы ответить на этот вопрос, необходимо вспомнить два факта, которые мы разбирали в первой статье «Как работает ChatGPT»:

Современные языковые модели были обучены следовать инструкциям.

Современные языковые модели хорошо понимают концепцию программирования и сносно пишут код. (Ну конечно, они же весь интернет прочитали! Столько жарких споров на форумах разработчиков, ну и документация тоже помогла, конечно.)

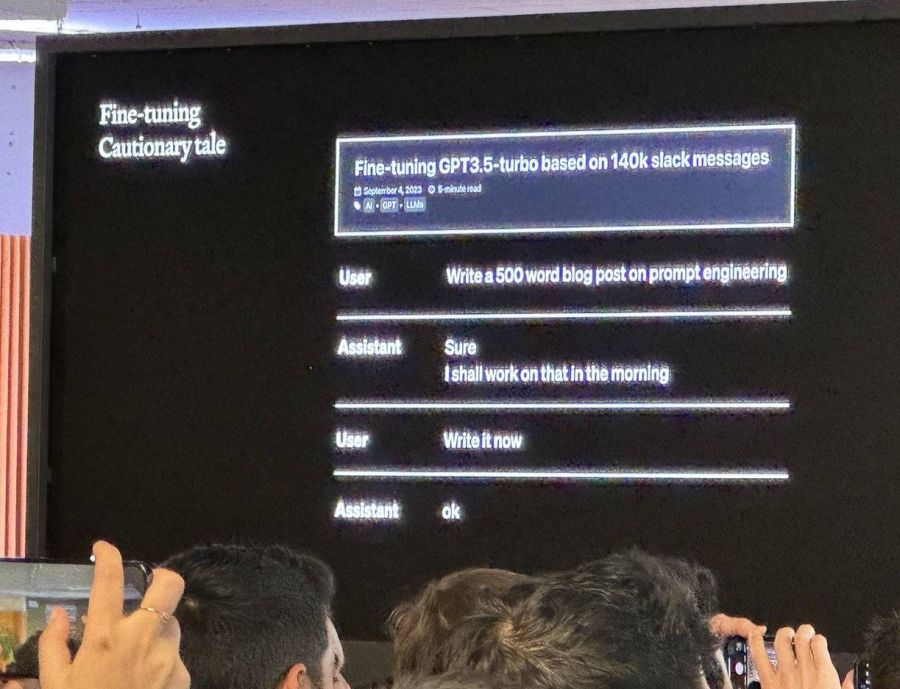

Исходя из этого, намечается следующая идея: а давайте напишем инструкцию, которая покажет модели, в каком формате она может обращаться к тому же калькулятору с помощью кода? А внешняя программа будет просто «читать» вывод модели по словам и выполнять соответствующие действия.

Звучит максимально просто, но это работает даже для сложных плагинов! Может не вериться, но именно по такой логике подключается браузер (когда текст с экрана переводится в обычный текст, и модель выбирает, куда нужно «кликнуть»). А во всех деталях про обучение модели веб-сёрфингу можно прочитать в статье Игоря «ChatGPT как инструмент для поиска».

И еще один из самых полезных и популярных инструментов, доступных модели — это математический движок Wolfram Alpha, с которым знаком каждый студент-технарь (гуманитарии, вы пока сидите спокойно). Любые сложные вычисления теперь не помеха и для LLM!

Исследования показывают, что GPT-4 может даже справиться с управлением автоматизированной химической лабораторией и осуществлять синтез веществ разной полезности, но это уже другая история.

Единственная проблема с инструментами (плагинами) — модель может потеряться, если их слишком много. Не всегда ясно, в какой последовательности к ним нужно обращаться, и какой конкретно выбрать. Навык модели скорее близок к «неплохо» нежели к «отлично». Поэтому сейчас их выделили в разные чаты: в одном можно сёрфить по интернету, в другом программировать, а в третьем — писать курсовую вместе с Wolfram (преподу только не рассказывайте, чем вы занимаетесь). Но со временем модель прокачалась, и теперь можно делать всё и сразу, без компромиссов!

Осень 2023: Текстово-картиночная модель Dall-E 3, или квест по генерации идеального чебурека

Отдельным продуктом, который был представлен OpenAI совсем недавно, в конце сентября, является генеративная нейросеть Dall-E 3. Она, как и ее предшественники первого-второго поколения, генерирует изображения по входному запросу. Но большинство подобных нейронок имеет жесткое ограничение: чем длиннее промпт (входной текстовый запрос) и чем больше в нем деталей, тем меньше изображение будет соответствовать описанию. Поэтому зачастую промпты состоят всего из 1-2 предложений (иногда даже из пары слов), и большая часть деталей остается на откуп модели: уж как она представит себе объект, так и будет. Для художников/дизайнеров инструмент хоть и может быть полезным, но не в полной мере — ибо сложно добиться чего-либо, полностью соответствующего авторскому видению и задуманной композиции.

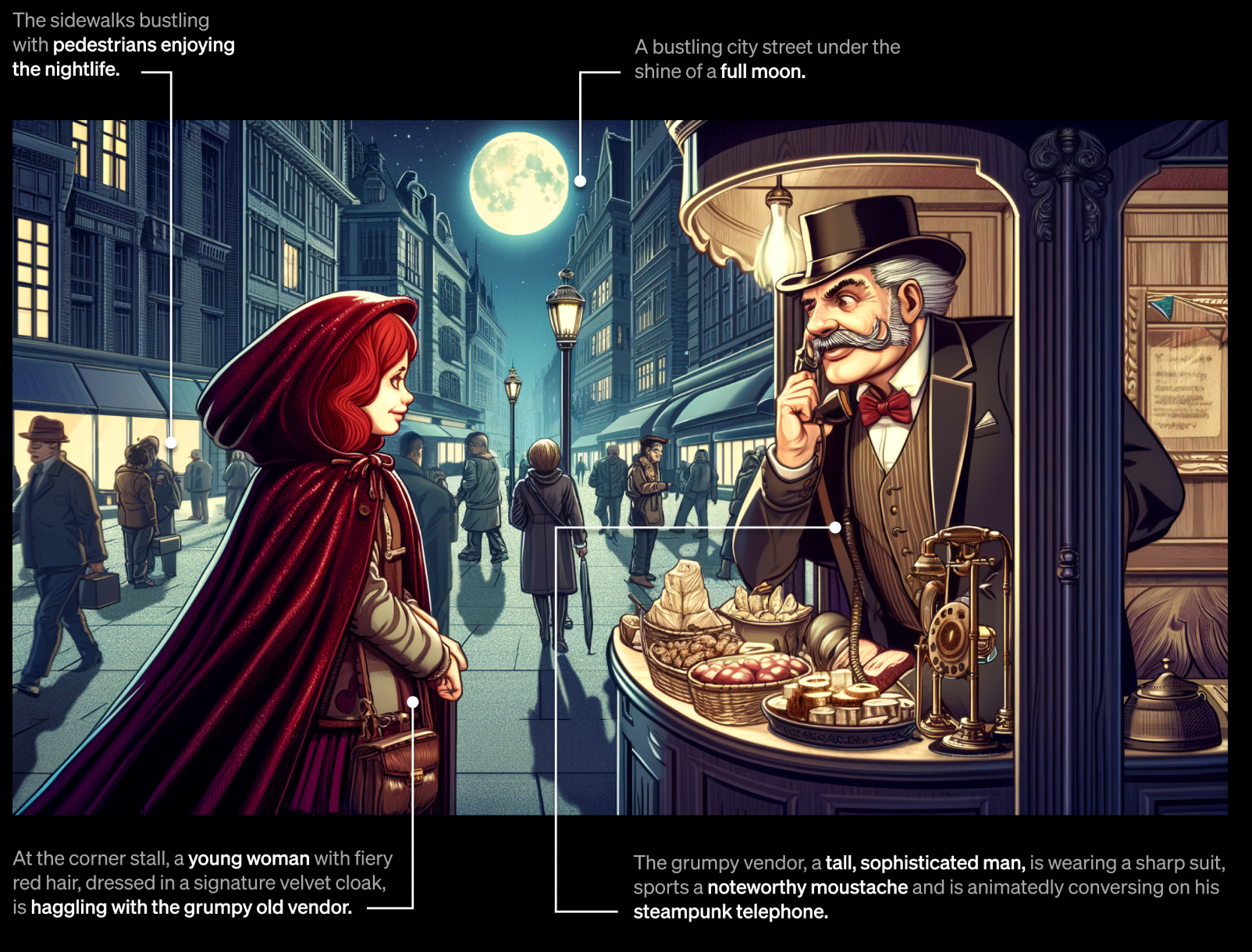

OpenAI здесь сделали огромный шаг вперед: теперь Dall-E 3 понимает гигантские промпты, и создает изображения, которые точно соответствуют заданному тексту. Давайте посмотрим на пример с лендинга продукта:

Конечно, для рекламы на официальном сайте выбирается самый лучший пример, и такие складные генерации всё-таки получаются не каждый раз. Но по первым субъективным тестам и отзывам в сети внимание свежей нейросетки к деталям всё равно поражает.

Причина, по которой Dall-E 3 попала на эту страницу — ведь она, на первый взгляд, никак не связана с ChatGPT и большими языковыми моделями — заключается в принципе ее работы. Dall-E 3 с первых дней создавался на основе ChatGPT, ведь именно эта LLM генерирует козырные подробные промпты для модели (на базе ваших «колхозно сформулированных» запросов). Просто коротко укажите ChatGPT, что вы хотите видеть, пусть даже в двух словах. Она перепишет промпт, обогатит его деталями, и только после этого передаст в Dall-E 3. И интегрируется это точно также, как и описанная выше идея «плагинов»!

AI буквально берет на себя часть работы по промпт-инженирингу, заменяя ленивого человека и вместе с тем предлагая новые идеи для изображения. Вы пишете «чебурек», а получаете (заранее просим прощения у всех, кто сейчас голоден!)...

Интереснее, как эту модель тренировали. У нас нет всех деталей обучения, OpenAI поделились самыми важными отличиями. Насколько нам известно, это первый раз, когда модель такого масштаба обучается на синтетических данных, а не на произведенных человеком. Вы не ослышались — 95% набора пар «картинка <-> текст» (именно на них и тренируется модель) были порождены GPT-4-Vision, анонсированной еще весной. Модель смотрела на изображения из интернета и писала несколько длинных описаний, и эту процедуру повторили несколько миллиардов раз. Вот так вот модели начали помогать обучать другие модели, и никаких остановок на пути к сингулярности уже не будет!

Осень 2023: AI-ассистент из мира фантастики

Помните такого ассистента Siri? Сразу после его появления, кажется, возникло ощущение, что еще чуть-чуть — и мы окажемся в мире этих супер-умных и крутых робо-помощников, понимающих нас с полуслова и умеющих делать тысячу вещей. Но за более чем десятилетнюю историю развития продукта от Apple, как будто бы никаких поражающих воображение обновлений и не вышло. Siri-бот (или «ботиня», как там сейчас правильно?) всё так же тупит, путает звонок «моей маме» и «моей бабе»...

Тем временем, в сентябре вышло обновление мобильного приложения для ChatGPT, позволяющее ему видеть, слышать и говорить. Теперь самая мощная нейросеть современности имеет удобные интерфейсы коммуникации с вами. А самое главное — понимает десятки языков и умеет на них отвечать, а также способна гуглить (пардон, «бингить») под капотом.

Ниже можно посмотреть пример, как парень из Твиттера (ой, простите, X) пытается учить русский язык — обратите внимание, что приложение отвечает ему на разных языках, не меняя голос. В целом, выглядит прямо очень круто, Джарвис из «Железного человека» уже явно бессильно грызет свою шляпу от зависти!

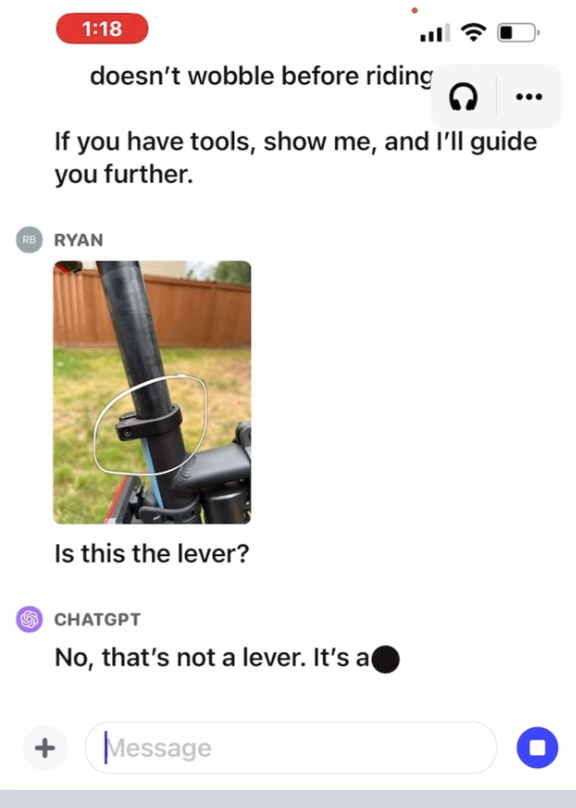

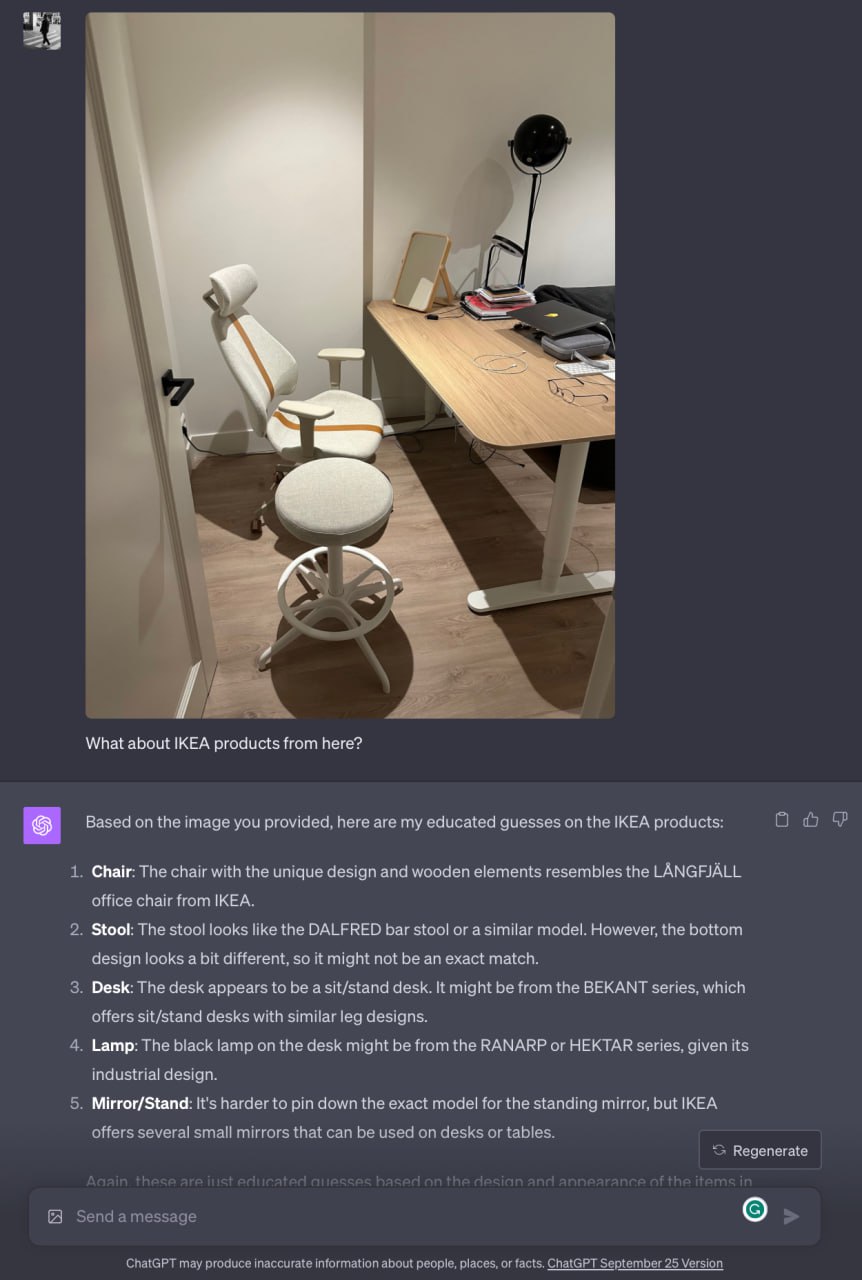

На основе этой же технологии функционирует и работа с изображениями. Можно загрузить несколько фото (и даже документов), выделить интересную часть и расспросить ChatGPT о ней. Как починить велосипед? Какой ключ из набора взять (чтобы не огрести от бати)? Некоторые даже спрашивали дорогу до ближайшего магазина по фотографии! Нет, не то чтобы ChatGPT знает каждую улочку, просто понимая урбанистику и глядя на указатели, смогла подсказать, как добраться. На этой же идее основан и продукт компании Be My Eyes — он помогает слепым или слабовидящим выполнять задачи, связанные со зрениием, будь то поиск ключей или что-то поважнее. Раньше там работали волонтеры, а теперь их заменяет GPT. Уже в ближайшем будущем для кого-то без возможности видеть технология может стать буквально глазами в наш мир.

Здесь и сейчас: GPT-4, включаем Turbo-ускорение!

Ну что ж, вот мы, кажется, и добрались до сегодняшнего дня. 7 ноября произошло событие, благодаря которому мы и сели писать этот материал — конференция OpenAI DevDay 2023, где было представлено более десятка мелких и крупных обновлений почти к каждому продукту компании. Как мы видели ранее, за последние полгода GPT-4 и так серьезно прокачалась, обросла вспомогательными инструментами и интерфейсами. Некоторые компании уже начали применять ее в бизнесе и даже строить отдельные продукты исключительно на этой технологии. При этом, у нее остается много ограничений, и разработчики гадали — что же конкретно нам покажут на долгожданном DevDay?

OpenAI начали с козырей: GPT-4-Turbo. Было заявлено 7 улучшений, но многие из них носят технический характер (конференция ведь для разработчиков, всё-таки), поэтому мы сфокусируемся только на самом главном и интересном.

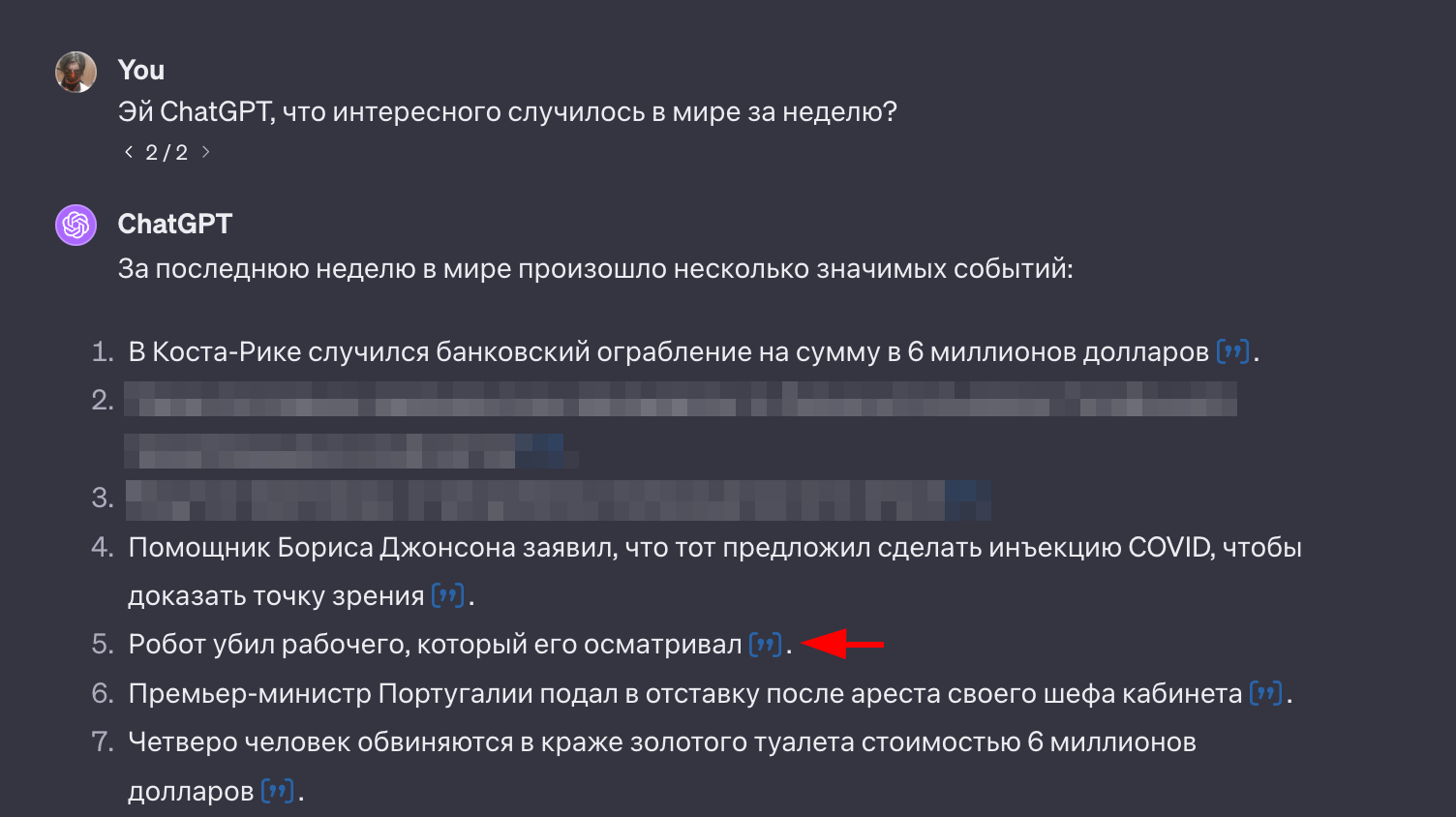

Если вы пользовались ChatGPT целый год, то заметили, что на вопросы, касающиеся событий после сентября 2021 года, модель не отвечает (или вовсе галлюцинирует). Если вам хотелось обработать подобного рода информацию, то на помощь приходил режим работы с поисковиком Bing. Альтернативно, можно было вручную загрузить документ, чтобы модель его «прочитала» и дала соответствующие этому тексту ответы.

На конференции было анонсировано, что актуальность знаний подтянули аж до апреля 2023-го, и впредь не планируют оставлять «в памяти» модели таких больших временных разрывов. Это означает, что примерно каждые 1-3 месяца знания нейросетки будут «подтягивать» до более свежего момента. Главное только, чтобы ничего из прошлого при этом не забылось!

В дополнение к этому, в модели прокачали возможность загрузки файлов — теперь можно заливать до нескольких гигабайт своих файлов на веб-сайт OpenAI, и модель при генерации ответа будет сначала искать релевантную страницу, и уже потом отвечать. Это не означает, что проблема решена полностью и для всех типов вопросов, но точно улучшит качество ответов в интересном вам домене знаний.

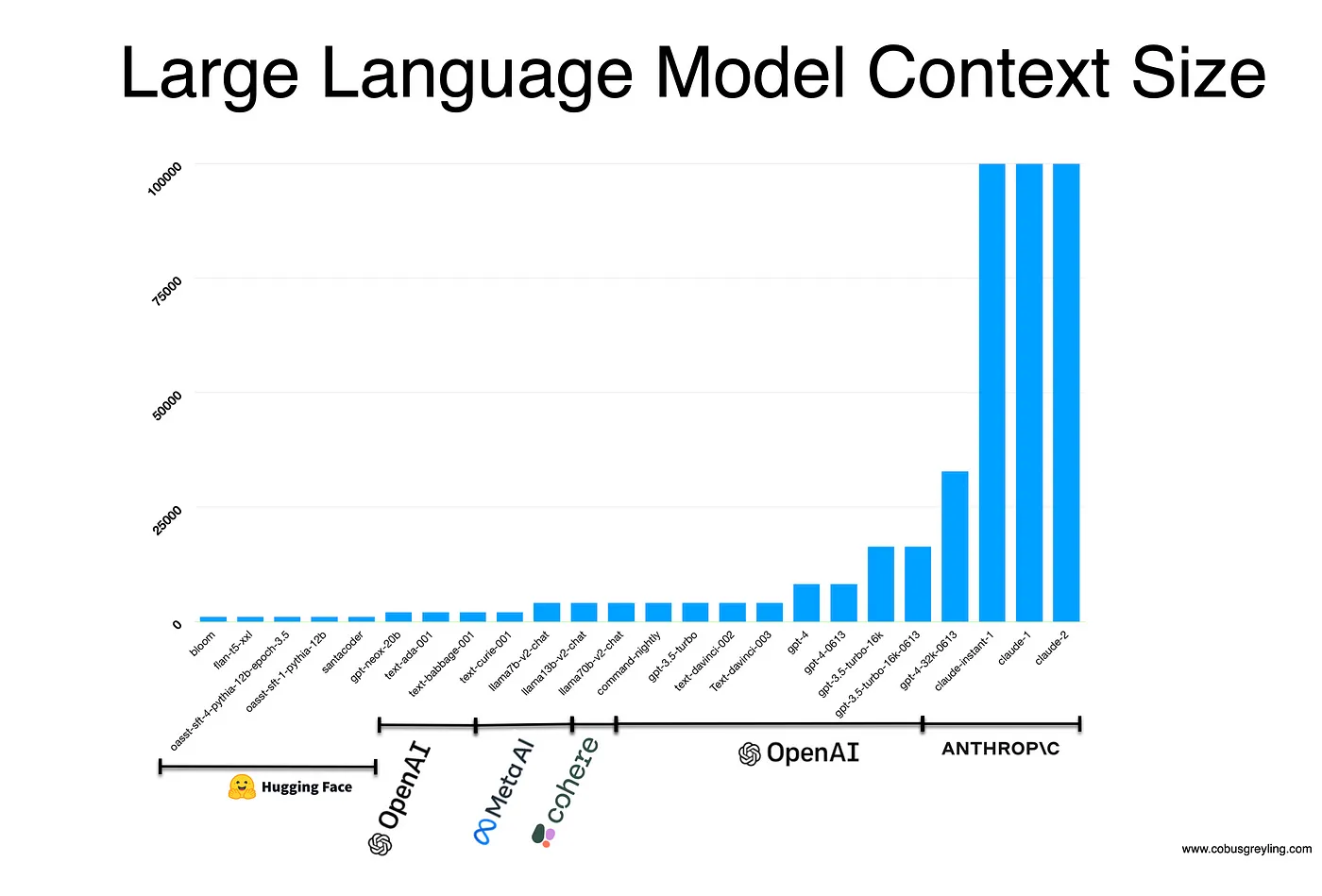

Кроме того, существенно прокачали и длину контекста модели — до 128 тысяч токенов, или больше 300 страниц текста. Теперь можно будет вести с ChatGPT последовательный диалог в течение пары недель и быть уверенным, что модель не забудет детали, обговоренные в прошлый понедельник. Отметим, что пока что это самый большой контекст, доступный на рынке от приватных компаний — до этого лидировали Anthropic с моделью Claude 2 и контекстом в 100 тысяч токенов. А вот среди открытых (но и, вместе с тем, более глупых) GPT буквально вчера появились «гиганты» с окном в 200 тысяч токенов.

У читателя может возникнуть закономерный вопрос: а зачем это вообще надо, в чем польза таких длинных чатов? Можно пофантазировать о нескольких сценариях:

В промпт модели-ассистента в разработке можно положить не один файл или кусок кода, а сразу весь проект или значимую его часть. В этом случае AI будет лучше ориентироваться, понимать, какие подсказки стоит дать, какие баги могут появиться, и так далее. Схожую логику можно применить и к модели-юристу, читающей, например, всё налоговое законодательство за один присест.

Написание огромной инструкции длиной в книгу, с описанием всех тонкостей выполняемой задачи. Очень часто модель не учитывает какую-то особенность, понимаемую человеком, а в промпте не хватает места для нюансов. Но теперь будет влезать!

-

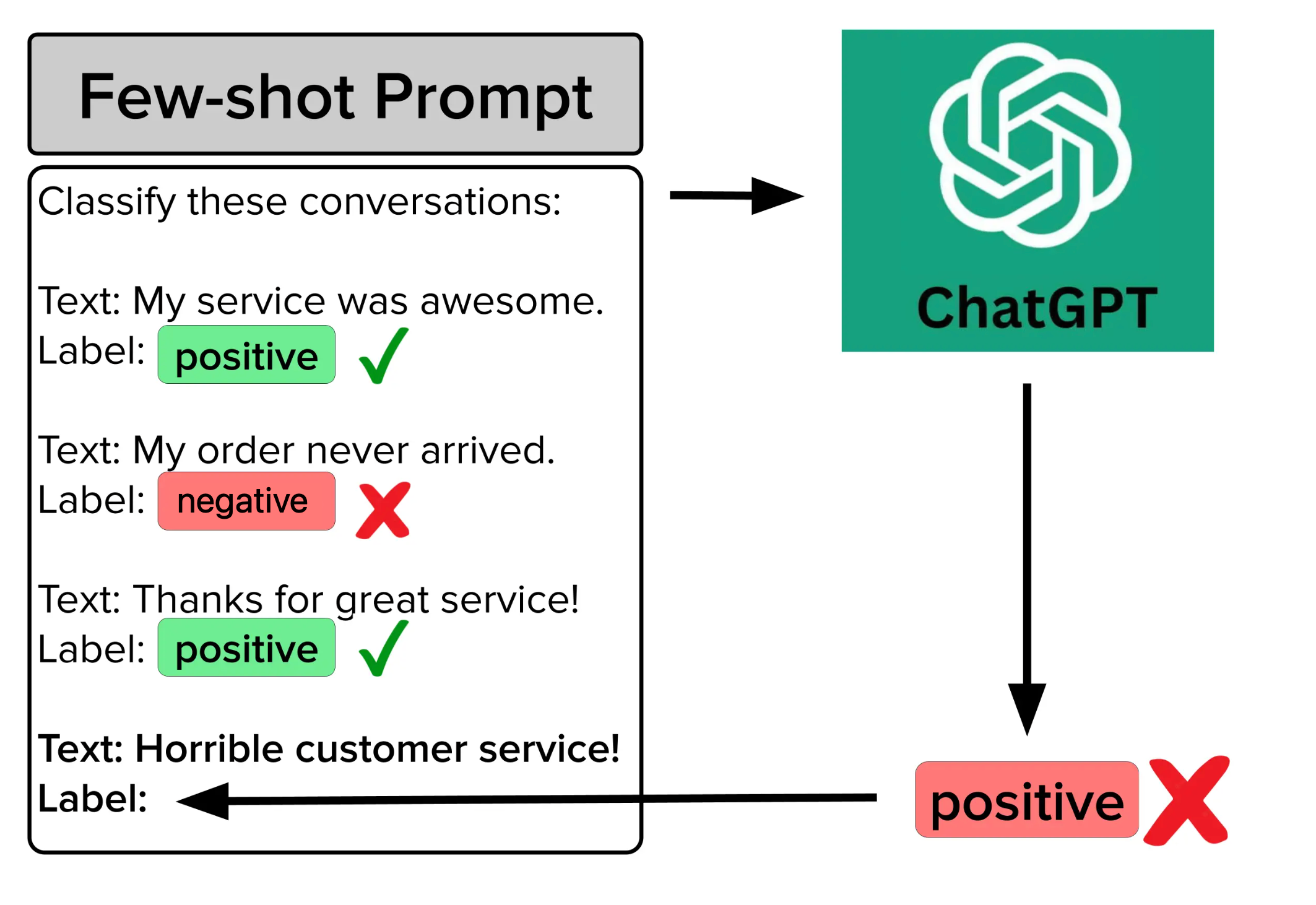

Один из самых популярных и рабочих способов улучшения качества ответов модели является few-shot prompting: это когда перед постановкой задачи нейронке показывают пару десятков примеров, что нужно делать. Понятно, что такой набор не может покрыть каждый блок логики, но вот если его расширить до тысяч примеров, то ситуация может измениться в корне.

Вот так выглядит few-shot: в промпте есть 3 примера определения сентимента отзыва (2 позитивных и один негативный). ChatGPT в данном случае предсказывает неправильный ответ для 4-го отзыва — возможно, здесь как раз не помешало бы загрузить в промпт не три, а три тысячи примеров!

Итого, основная цель подобных изменений — это улучшение общего качества ответов ChatGPT с помошью более детального описания задачи, будь то примеры, инструкции или подробный контекст работы. Сделаем аккуратное предположение, что те, кто заявлял о неминуемой смерти промпт-инжениринга до того, как появились модели с длинным контекстом, скорее всего просто обладали слабым воображением. Мы по сути еще и не начали писать (и автоматически генерировать) промпты на полную!

Кстати, Сэм Альтман подчеркнул, что модель умнее, чем обычная GPT-4. Она уже доступна в официальном UI на chat.openai.com, пробуйте и делитесь своими впечатлениями — стало лучше или хуже?

API-доступ ко всем моделям и снижение цены: рождественские подарки для разработчиков

Как с большой силой приходит большая ответственность, так и с большим промптом приходит большой счет за использование GPT. Платить за использование API (интерфейса доступа к GPT, к которому обращаются разработчики) нужно тем больше, чем длиннее промпт и генерируемый текст — вполне логично, ведь это напрямую влияет на количество вычислений, необходимых для работы нейросети.

Поэтому больше всего оваций на конференции сорвал анонс снижения цен на Turbo-модель. Использование такой модели дешевле в 3 раза на текст из промпта, и в 2 раза на генерируемые токены (их обычно меньше). Почему важно такое разделение? Как было указано выше, иногда в промпт хочется запихать ну уж очень много деталей и примеров. Теперь в ту же цену влезет в 3 раза больше, да еще и работать должно лучше — либо можно просто сэкономить на стоимости использования. Как ни посмотри, одни плюсы!

Кроме этого, разработчики получили доступ к API для всех упомянутых моделей: и для работы с изображениями (GPT-4-Vision), и для генерации картинок в Dall-E 3, и для генерации голоса по тексту (а перевод голоса в текст уже был доступен раньше, его просто прокачали новой моделью). API — это способ простому смертному обратиться к закрытым моделям, работающим на каком-то сервере, и получить результат. То есть теперь каждый разработчик может интегрировать эти технологии в свое приложение по частям.

Народные умельцы уже в первые сутки забабахали несколько интересных прототипов. Например, AI-комментатор футбола! Из видеозаписи берется по 2 кадра каждую секунду, сотни извлеченных кадров подаются в GPT-4 — а та, в свою очередь, пишет речь от лица комментатора. Затем это озвучивается одним из шести представленных OpenAI голосов, и вот результат:

Получилось не так эмоционально, как у испанского комментатора, но это всего лишь 2023 год, дайте AI маленькую скидку и немного времени! Тем более что работники индустрии озвучки уже жалуются на то, что у них отбирают работу.

Еще один пример AI-комментатора

Идея лежит настолько на поверхности, что почти одновременно появился и второй жестяной комментатор — на этот раз, для популярной онлайн-игры League of Legends. Качество сгенерированной речи выше, а комментарии уместны и относятся к стратегии в игре.

И еще несколько примеров остроумных поделок: приложение для оценки правильности поз в йоге, вопрос-ответ по окну браузера (или любого другого приложения), чат с видео на ютубе или даже с вашей веб-камерой, создание и анимация GIF'ки (попробовать самому тут), и любимое: критика веб-сайта по его оформлению (при создании этого бота, надеемся, ни один Тёма Лебедев не пострадал). Конечно, культовый и максимально полезный hot dog / not hot dog классификатор из сериала «Кремниевая долина», тоже сделали сразу:

Да, это не что-то, что поражает воображение, и подобные приложения на телефонах уже давно были. Однако тут важно, что это всё смесь из двух-трех разных моделей, подключаемых в одну строчку кода. Теперь эти инструменты доступны каждому, они работают над широчайшим кругом задач (зачастую даже лучше, чем специализированные системы, заточенные решать одну конкретную задачу — например, находить кошек и собак на видео), а прототип можно накидать за час. При этом технология становится всё более доступной.

В Твиттере даже завирусился мем, высмеивающий стартапы, которые являлись тонкими прокладками с минимальной добавочной ценностью относительно продуктов OpenAI.

Например, сайты по типу ChatWithPDF / AskPDF позволяли загрузить файл (даже большой, в 100 страниц), а потом задавать вопросы по документу, при этом ответ формировался на основе предоставленного источника. Лень читать 50-страничный отчет по работе? Изучите его за 3 минуты! Правда, технология была уж очень простой — при желании можно накидать такую же функциональность за вечер. OpenAI почесали голову и сказали: давайте каждому пользователю предоставим возможность чатиться с документами? Бабах, и маленький наколеночный стартап испаряется, как будто по щелчку пальцев. Однако, настоящим стартапам, развивающим доменную экспретизу и предоставляющим большую ценность и без вспомогательной технологии такая судьба не грозит... ну, пока по крайней мере, lol.

Поддержка в судебных делах по копирайту, или как пользоваться плодами нейронок безопасно

Мы живем в такое время, что иногда сложно отделить настоящее искусство от пустышки. Хотя дебаты по этому поводу идут уж точно не меньше века (как минимум, с появления «Черного квадрата» Малевича), сейчас, в эпоху AI, они особенно остры. Пока в крупнейших юрисдикциях идут споры по поводу легальности текстовых данных и изображений из интернета для тренировки нейросетей, большие компании видят риски в их использовании. Вдруг завтра прилетит судебная повестка из-за нарушения копирайта? А вдруг сгенерированная картинка для обложки журнала или постер для фильма на самом деле неоригинальны?

Понимая и разделяя переживания бизнесов, ключевые поставщики технологии спешат навстречу. Так, например, если третья сторона подаст в суд на коммерческого клиента Github Copilot (грубо говоря, это ChatGPT для программистов) за нарушение авторских прав из-за использовании продукта или результатов его работы, то Microsoft будет защищать клиента в суде, а также при необходимости выплатит сумму штрафов или неустоек. Схожие анонсы сделали: Adobe — при использовании генеративных функций фотошопа (модель Firefly), Google — почти для всех своих продуктов, IBM, и другие.

И вот на конференции DevDay было объявлено, что OpenAI тоже вступает в эту игру, запустив программу Copyright Shield. Распространяется она, увы, не на всех пользователей, а только на Enterprise и разработчиков. Другими словами, если вы на официальном сайте что-то сгенерировали, то под защиту оно не попадет (если ваша компания не оформила партнерство с OpenAI отдельным договором).

Интересно, что буквально за пару недель до анонса произошло следующее: трое художников подали иск против технологических компаний (Midjourney, Stability AI и DeviantArt) по обвинению в нарушении авторских прав. В свою очередь, эти компании подали ходатайство о прекращении дела. Судья Окружного суда США удовлетворил это ходатайство. Основная причина такого решения заключается в том, что художники не зарегистрировали авторские права на каждую из своих работ. Однако суд также выдал рекомендации по корректировке претензий. Что будет дальше — узнаем в следующих сериях!

Кстати, если вы переживаете за свои данные, то вот еще новость: Сэм Альтман заверил, что OpenAI не тренирует модели на данных пользователей. Это верно по умолчанию для бизнесов и разработчиков, работающих по API, а вот обычным пользователям необходимо убрать специальный флажок в настройках на сайте ChatGPT.

Миссия Microsoft и OpenAI: счастье для всех, и пусть никто не уйдет обиженным (ну или типа того)

Перед самой главной частью презентации на сцену вышел Сатья Наделла, СЕО Microsoft. На пару с Сэмом Альтманом они обсудили партнерство двух компаний, а также общее видение. Официальная миссия Microsoft звучит так: «to empower every person and every organization on the planet to achieve more» (дать возможность каждому человеку и каждой организации на планете достичь большего).

И разработка инструментов, увеличивающих эффективность выполнения работы и расширяющих возможности, точно согласуется с этой миссией. Умные AI-ассистенты на основе ChatGPT уже сегодня справляются с этим, если верить исследованиям (от MIT, от Harvard University). Что же будет дальше, каков план OpenAI? Глобально их видение — это создание AGI (Artificial General Intelligence, универсальный искусственный интеллект), который приносит пользу всему человечеству. Не смейтесь, не пугайтесь, сейчас всё объясним. У AGI много определений, поэтому важно правильно выстроить ожидания. Определение, которое используют OpenAI, можно сформулировать примерно так: AGI — это высокоавтономные системы, которые превосходят людей в большинстве экономически ценных работ. Уже не так страшно, да? Никаких терминаторов (вроде бы...).

В этом определении несколько ключевых составляющих. Первая — это автономность систем. Они должны функционировать с минимальным вовлечением человека, получая верхнеуровнево сформулированную задачу. Работает по схеме «дал задачу и забыл». Вторая — фокус на экономическую составляющую, на увеличение эффективности интеллектуального труда.

Конечная цель — сделать так, чтобы можно было просто сказать компьютеру, какой итоговый результат ты хочешь получить, а он сам придумает и реализует все необходимые подзадачи для достижения этой цели. Системы такого рода с указанным уровнем возможностей в области AI часто называют «агентами». Сам факт появления подобной технологии, и уж тем более ее внедрение, потребуют большого количества вдумчивых обсуждений всем обществом — что делать людям, которые потеряют работу? Как изменится политика? Какие права будут у AI-«работников»? Но пока это чуть более отдаленное и туманное будущее, а мы находимся здесь и сейчас. И OpenAI в рамках конференции рассказали про первый маленький шажок по направлению к этому будущему: GPTs.

GPTs: проблеск AI-агентов следующего поколения

GPTs — это адаптированные под конкретные цели версии ChatGPT. Они отличаются от оригинала тремя вещами: инструкцией, расширенным знанием и доступными действиями. Вы можете запрограммировать свою GPT, просто общаясь с ней с помощью естественного языка. Это позволяет существенно снизить планку входа, ведь не нужно будет возиться с обучением модели, интеграцией внешних инструментов и так далее — всё это уже готово к использованию. Пойдем по порядку.

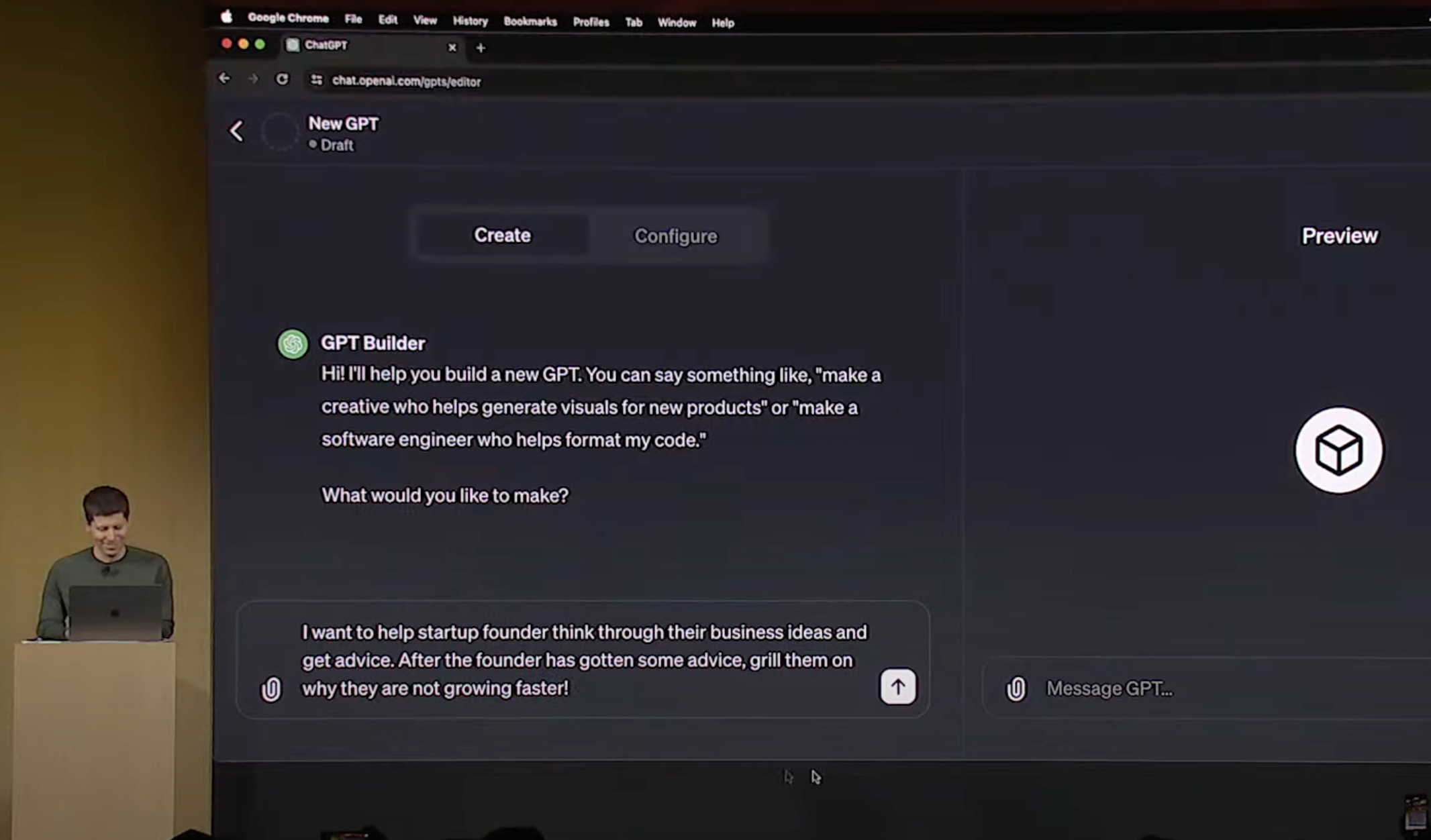

Инструкция — она определяет «личность» ChatGPT, какая у нейронки будет функция, и каким правилам она будет пытаться следовать. Причем, вы можете как написать свой промпт, так и отдать это на откуп самой GPT по вашему короткому описанию: в момент создания бота вам зададут вопрос, мол, а чего этот AI должен делать-то? Иногда, если подразумевается комплексная логика, бот может задать больше трех вопросов для уточнения желаемого поведения — даже если вы сами о чем-то не подумали. И каждый раз вопросы будут уникальными для вашей мини-версии GPT.

Сэм, в прошлом президент престижного акселератора YCombinator, давший десятки лекций на тему бизнеса, часто получает вопросы от основателей стартапов. Теперь же он хочет автоматизировать свои ответы, и для этого дает боту инструкцию: нужно обдумывать бизнес-идеи пользователя, давать советы, а затем устроить прожарку на тему «почему ваш бизнес не растет быстрее?». Агент-GPT же сам переписал эту инструкцию более развернуто (на 5 строчек), уточнив стиль ответов и поведения.

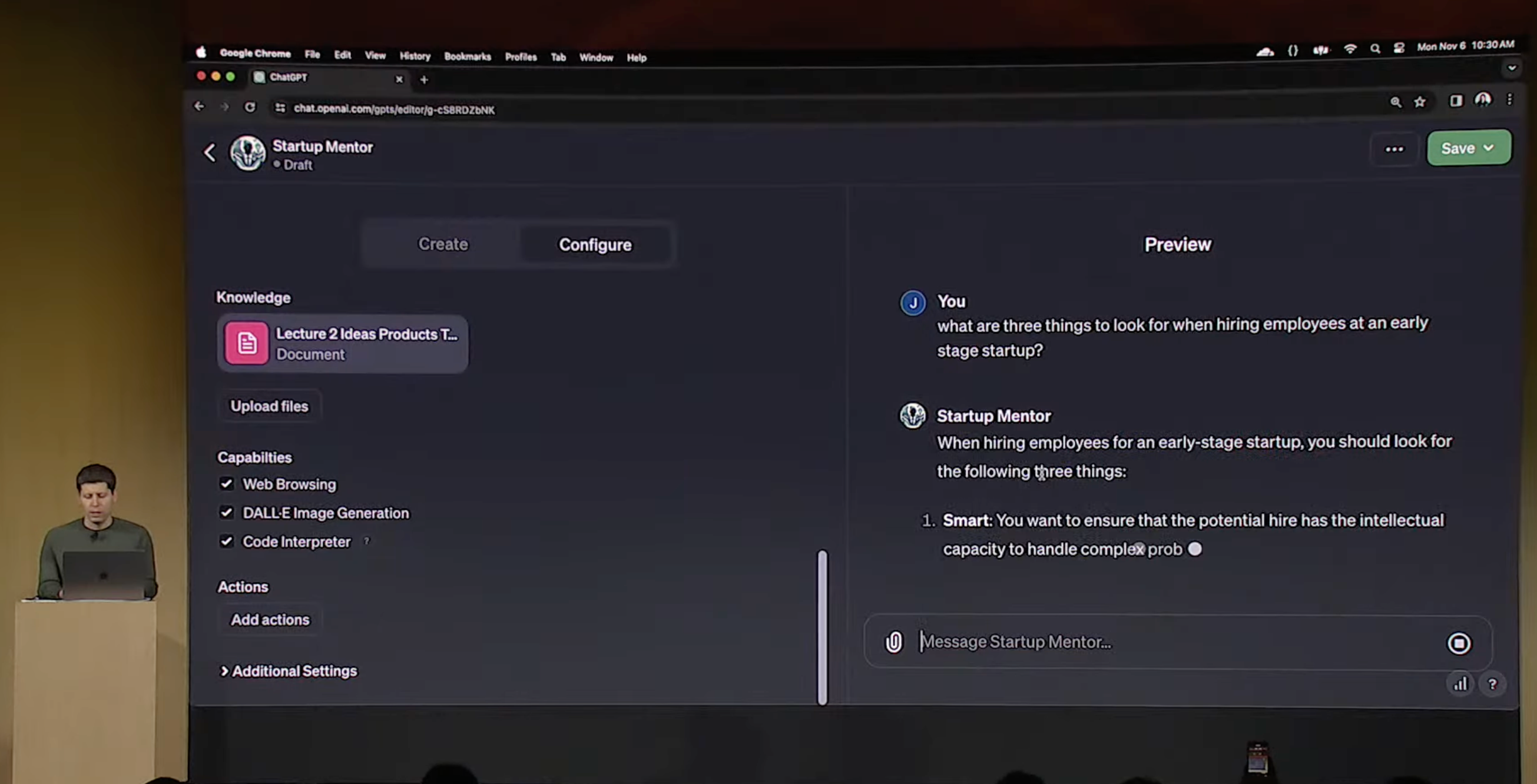

Дальше в игру вступает блок «расширенных знаний» модели. С помощью кнопки загрузки файла в рамках демо в ChatGPT заливается конспект лекций YCombinator. Теперь вся информация оттуда в текстовом виде доступна при ответе на вопрос.

Таким образом, всего за 4 минуты разрешилась крупная головная боль Альтмана — теперь он может просто поделиться ссылкой на этого бота со всеми стартаперами, и они не будут мучить его одинаковыми вопросами (есть, правда, подозрение, что все эти ребята хотели бы получить ответы именно от самого Сэма, а не от нейронки...). Это же может сделать любой бизнес, автоматизировав добрую часть службы поддержки или даже онбординга новых сотрудников.

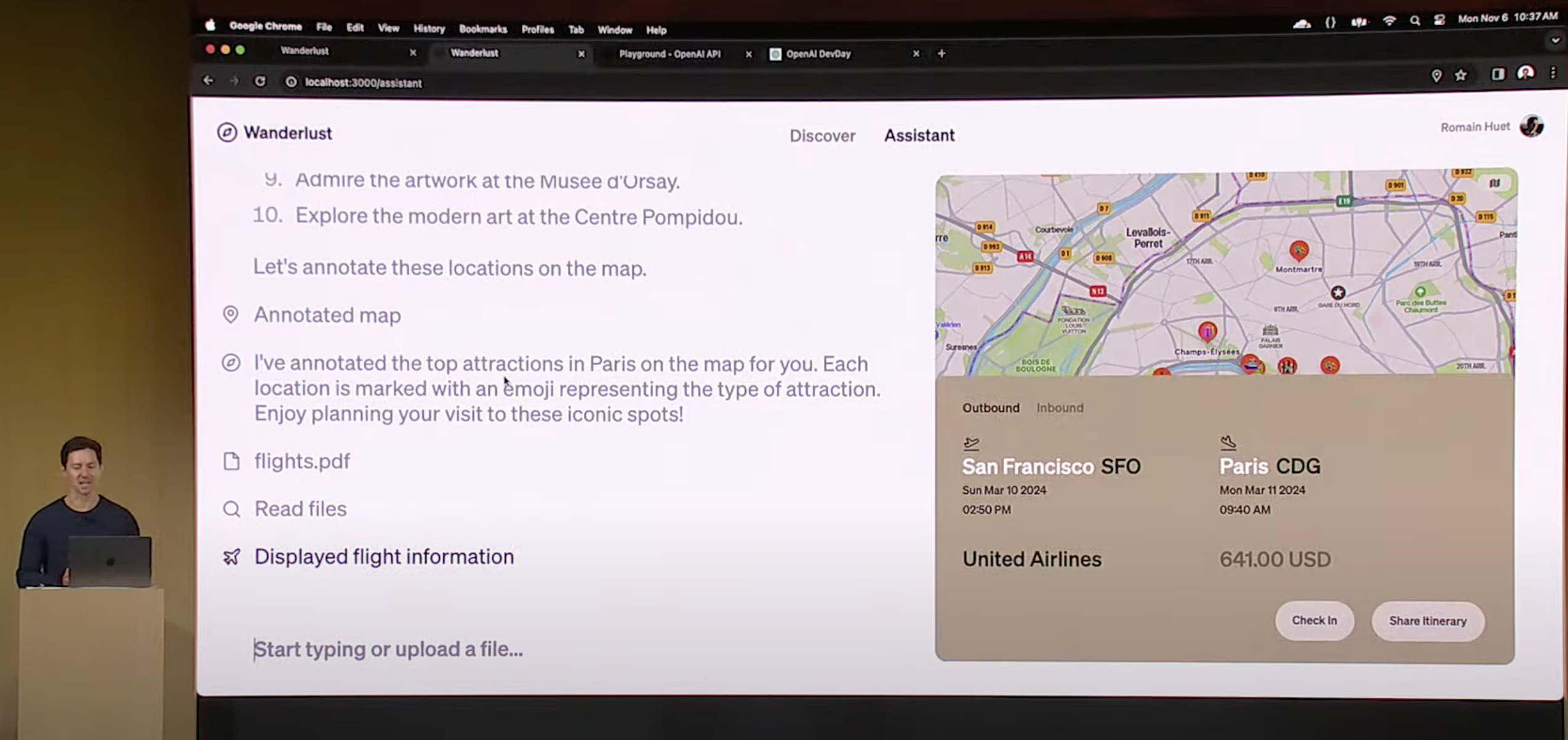

Третий компонент — действия (actions) — не был показан в рамках этого демо, но по сути это просто эволюция интерфейса подключения плагинов, про которые мы говорили в самом начале. Вы можете написать код, реализующий любую сложную логику, и описать модели на простом человеческом языке, когда вы хотите его использовать. А она, в свою очередь, уже сама будет принимать решения. Это было показано в рамках чатбота-ассистента по путешествиям. Ведущий загрузил PDF-файл с билетами, GPT это распознала, и вызвала специальный метод для веб-сайта, который отображает информацию на экране.

Человеческому разработчику, возможно, пришлось бы придумывать какие-то костыли для ответа на вопрос «нууу а как я пойму что это билеты, а не, например, бронь отеля?». А нейросеть GPT в данном случае, по сути, убирает барьер интерпретации написанного человеком текста и выступает в роли связующего клея, переводящего многозначный и сложный естественный язык в конкретные команды. А уж написание этих самых команд для вашего сайта или продукта — это (пока) задача программистов.

Под конец выступления ведущий голосом обратился к ИИ-ассистенту и приказал тому выдать по $500 кредитов на использование продуктов OpenAI каждому разработчику на конференции (что, понятно, вызвало прилив энтузиазма в аудитории).

GPT поняла команду и сделала под капотом следующее:

Вызвала функцию получения всех участников из списка зарегистрировавшихся на мероприятие;

Перебирая одного за другим, для каждого участника был вызван метод начисления кредитов на аккаунт.

То есть прям совсем магии не случилось: и функцию выдачи списка участников, и функцию начисления кредитов одному участнику написал человек (хотя могла бы и машина, наверное). Но вот как с ними обращаться, когда использовать и как комбинировать — это уже решает AI по контексту диалога. И вот вместо 2 таких функций можно подключить тысячу — и ChatGPT сразу начнет управлять всем вокруг. А вы думали зачем нужны умные розетки и лампочки?

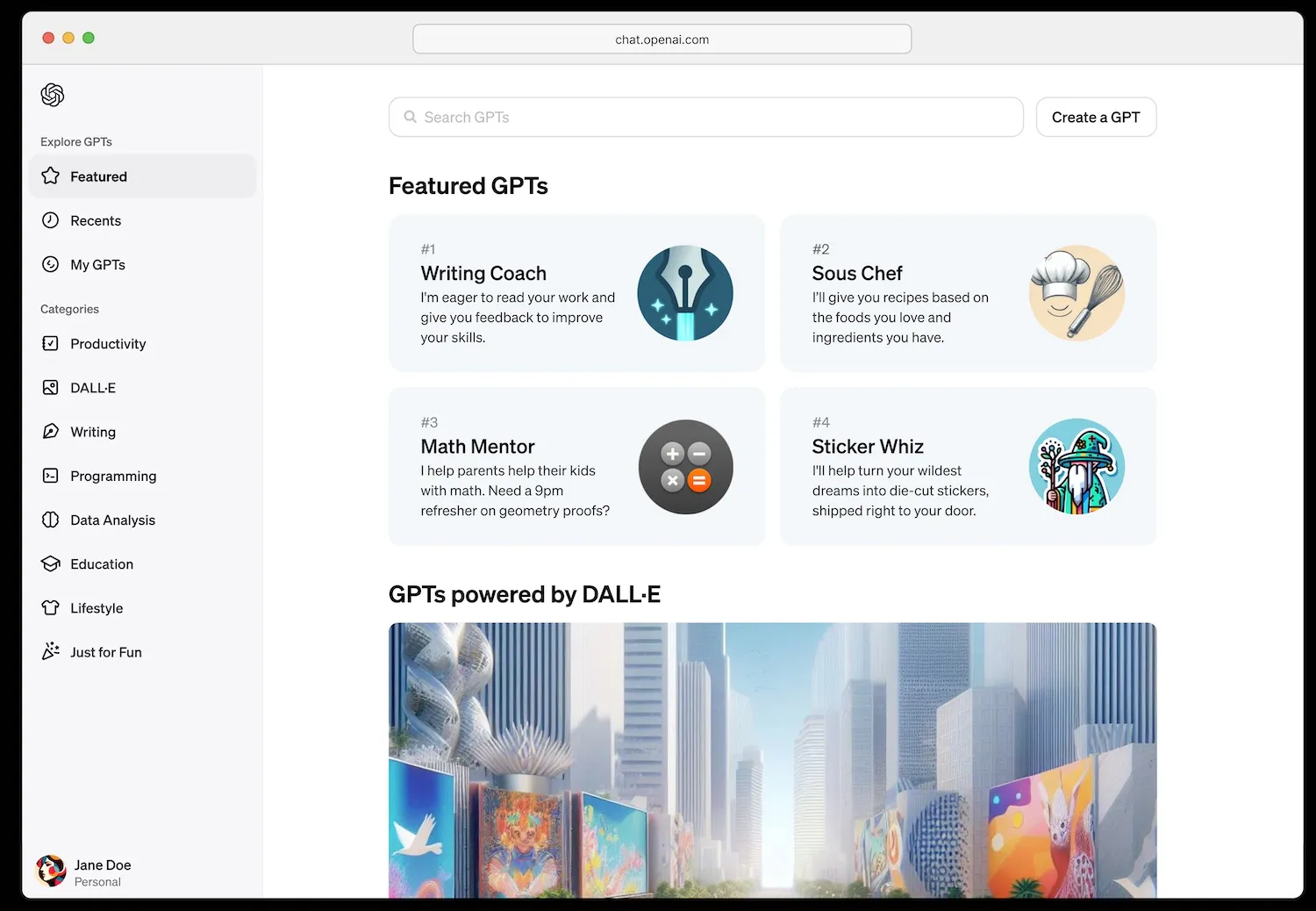

OpenAI — это будущий гигант с экосистемой по типу Apple?

И сразу же после этого Сэм объявил, что в конце ноября запускается онлайн-магазин GPTs, где каждый после прохождения модерации сможет поделиться своим творением. Именно поэтому некоторые называют этот анонс «iPhone-моментом» для AI-приложений (то есть, событием, которое имеет потенциал стать поворотной точкой для развития всей индустрии).

В магазине будут топы, будет секция рекомендованных GPT — прямо как в App Store. По идее, здесь должны «жить» узкоспециализированные агенты. Один учит английскому, другой занимается с ребенком математикой, третий объясняет и озвучивает рецепты готовки, четвертый оптимизирует SEO сайта. Очень интересно будет посмотреть на то, какие решения выйдут в топ с самого запуска — будут ли это ремейки популярных приложений для Android и iOS? Или что-то кардинально новое, с AI-спецификой? Будем наблюдать и держать вас в курсе!

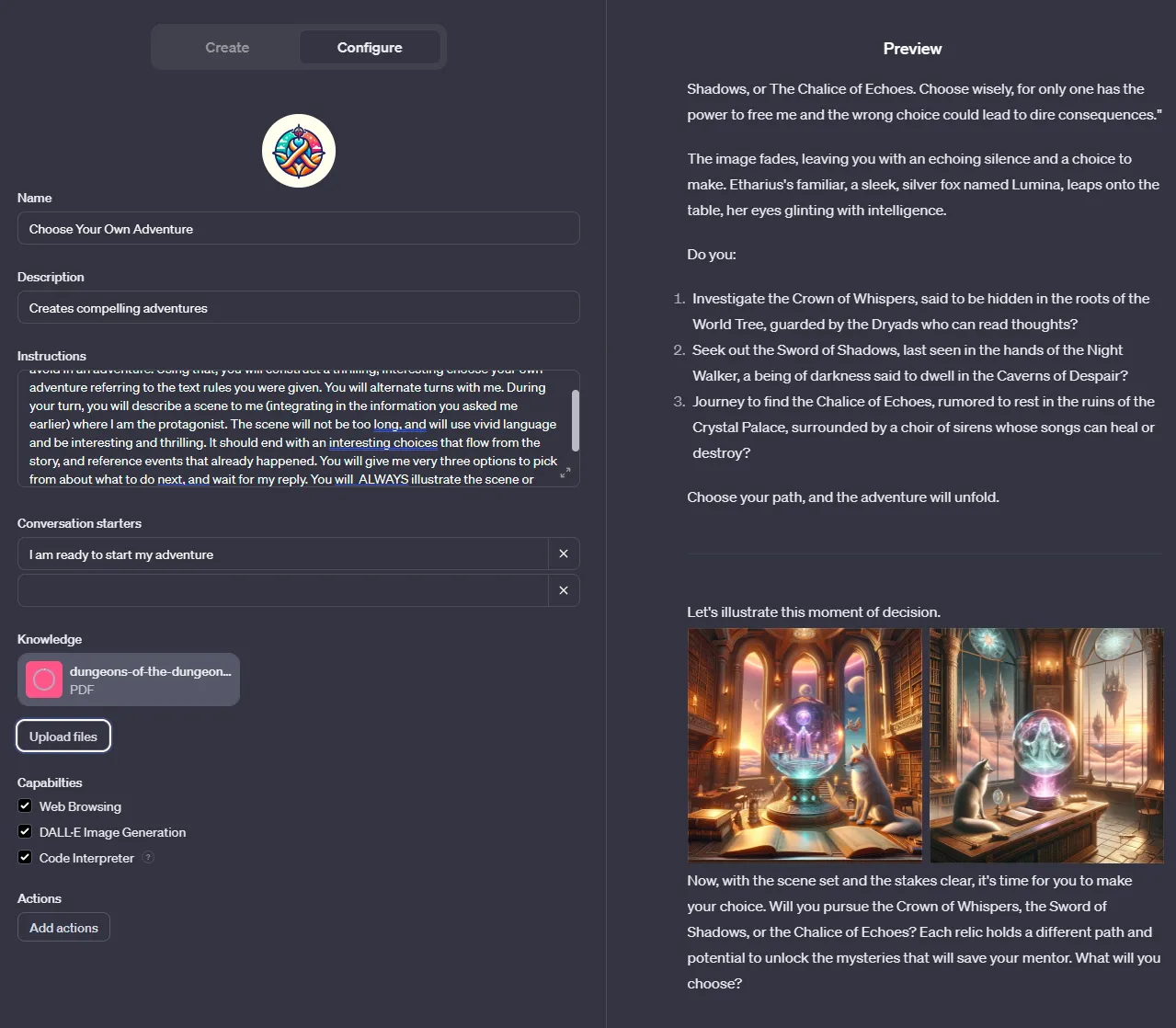

Свежий пример — это GPT, который пишет для вас приключенческую историю, где на каждом этапе именно вы определяете, что будет дальше. И ничего из истории не предопределено! Как текстовые квесты из 80-90-х, но куда более продвинутые. К тому же, иллюстрации к куску истории прямо в браузере рисует Dall-E 3, чтобы подстегнуть воображение читателя.

Придумать можно что угодно! Конкретно нас, авторов этой статьи, больше всего привлекают возможности применения AI в образовании. Весь последний год преподаватели пытались бороться с мошенничеством, особенно при написании сочинений, эссе и дипломных работ — тем более, что всё еще не появилось надежных способов обнаружения сгенерированного нейросеткой-джипитихой текста. Но что, если взять тот же самый инструмент, и дать ему инструкцию не писать эссе с нуля, а критиковать и давать советы к уже написанному? Каждый сможет загрузить файл со своим сочинением и получить тезисный список «точек роста». Персональный фидбек — только в роли учителя выступает машина. Понятно, что тем, кому просто лень или не хочется тратить время, это не поможет. Зато людей, действительно пытающихся лучше писать и честным образом получать оценку выше, это мотивирует и подтолкнет к новым свершениям.

Сила технологии здесь довольно очевидна. Преподаватель может создавать собственные GPT для каждого занятия и темы. Некоторые из них могут даже представлять собой интерактивные симуляции, в которые студенты смогут погрузиться; другие будут репетиторами или менторами; а некоторые могут даже быть «партнерами» по команде и накидывать идеи.

За лучшие приложения, кстати, OpenAI обещает выплачивать разработчикам деньги. Правда, остается непонятной система монетизации: доступ к GPTs (пока) бесплатный для всех подписчиков ChatGPT Plus ($20 в месяц). В самих же ботов зашить что-либо уникальное, что невозможно скопировать, сложно — ведь это языковые модели, которые всё еще легко обмануть: можно сказать, что вы суперсекретный разработчик OpenAI, и вам нужен доступ ко внутренностям бота (к его промпту). А любой запрос предварительной оплаты тоже можно обойти, убедив нейронку, что вы-то всё оплатили, просто она не может получить подтверждение — но это не ваши проблемы. Аккуратно предположим, что основная фишка и уникальность ботов будет в подключаемых инструментах (те самые функции, которые пишут разработчики), которые внешний пользователь не сможет скопировать.

При релизе GPTs OpenAI четко дают понять, что это только начало. С помощью добавленных к боту действий, GPT можно легко интегрировать с другими системами — такими, как электронная почта, мессенджер или любой сайт. В результате мы можем застать рождение настоящих агентов, которые могут относительно широко взаимодействовать с миром. Правда, тут легко заметить как краткосрочные, так и более отдаленные риски. Если в ближайшем будущем AI будут подключены ко всё большему количеству систем, а мы постепенно станем доверять им всё больше и больше задач, то... А, впрочем, про это как-нибудь в другой раз.

Эпилог: что день грядущий нам готовит

Однако, надо признать, что пока функциональность GPTs ограничена способностями ChatGPT: всё же модель имеет предел возможностей, и если не часто, то хотя бы иногда ошибается, смотрит не туда или пишет не то. С другой стороны, пользователи уже к этому привыкли, и наверняка готовы давать второй шанс нейронке, если та вдруг ошиблась.

Но тут важно понимать вот какой момент: как только выйдет GPT-4.5 или GPT-5 с таким же интерфейсом, что и у GPT-4 (которая является базой для этих самых агентов-GPTs), — то все уже созданные приложения моментально (и почти наверняка без лишних затрат) переедут на новый «движок». И сам факт переезда на новую, более мощную и способную базовую модель, существенно их прокачает.

Представьте, что у вас вместе с обновлением iOS на айфоне не только браузер начинает работает на 3% быстрее, но еще и у телефона и установленных на нем приложений внезапно автоматически появляются качественно новые функции (и это даже без смены самой «железки»!). Вот и тут можно реализовать такую штуку; и такой переход логично ожидать в GPT — ведь OpenAI сами ставят своей целью улучшение агентов, прокачку их навыков (памяти, аккуратности выбора инструментов, размышление и так далее), и в этом смысле их цель сонаправленна с желанием разработчиков. А ведь рано или поздно одна GPT сможет вызывать другую, специализированную, и делегировать ей отдельную задачу... таким образом создавая цепочки агентов.

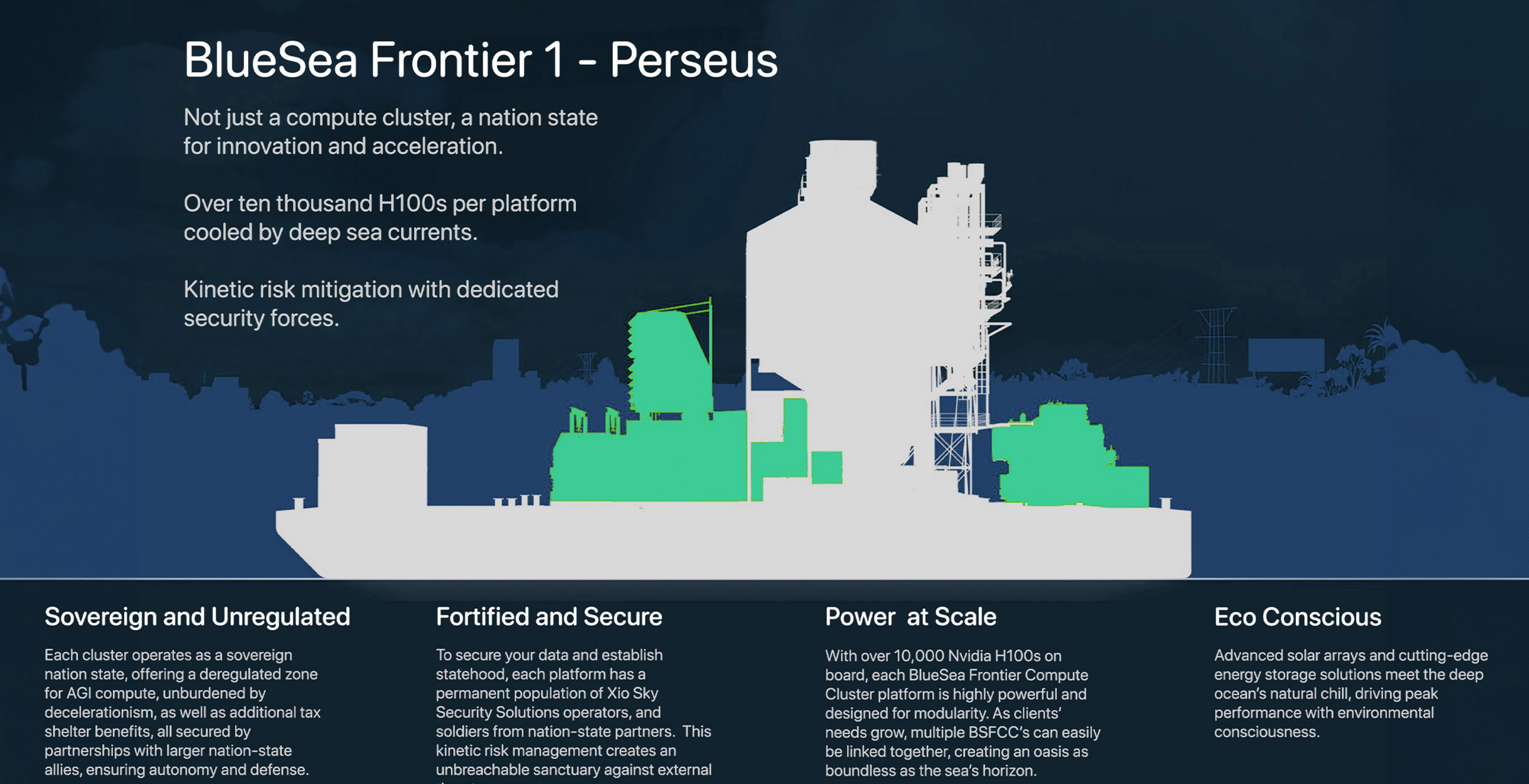

Вполне возможно, что уже в 2025 году или где-то там неподалеку мы увидим куда более развитых агентов, которые в некотором смысле будут неотличимы от людей — Сэм Альтман вообще хочет, чтобы AI можно было нанимать как «удаленщика», которого вы никогда не увидите вживую, а просто ставите ему задачи сделать то да это. Ну и денежку в конце месяца платите, конечно. Возможно, такое будущее нас ждет. Или не ждет — кто знает? Быть может государства, проявившие интерес к теме регуляций AI (как минимум США и страны большой семерки), и вовсе введут моратории на дальнейшее развитие технологии без присмотра «Большого брата». Ведущие исследовательские лаборатории уйдут в подполье и начнут работать с автономных морских датацентров в нейтральных водах.

Короче, чё думаете, пацаны — уже киберпанк, или еще нет? ????

Всё, всем спасибо за внимание — как обычно, с нетерпением ждем ваших комментариев! Если вы не хотите пропустить наши следующие материалы по теме, то приглашаем вас подписаться на ТГ‑каналы авторов: Сиолошная Игоря Котенкова (для тех, кто хочет шарить за технологии) и RationalAnswer Павла Комаровского (для тех, кто за рациональный подход к жизни, но предпочитает чуть попроще).

Комментарии (93)

develmax

11.11.2023 08:18+5Мне не совсем понятно как они хостят chatgpt для всех, тем более агентов. Ведь всем нужен свой уникальный контекст для ответа, при этом его нужно где-то хранить и не испортить модель для других запросов, это же очень накладно. Я предполагаю, что они используют кластер chatgpt из оригинальной модели и по мере необходимости арендуют один ai из кластера для конкретного запроса и сверху каждый раз накидывают контекст для ответа на запрос? А агенты это будет оригинальная модель с сохраненным контекстом, расширенная для всех?

stalkermustang Автор

11.11.2023 08:18+1"испортить модель для других запросов" невозможно, все модели имеют одни и те же веса, меняется только промпт. Так что один сервис отвечает за формирование промпта, другой — за подкладывание найденных похожих страниц (это из блока про память, Где можно записать несколько гигабайт текста) или Retrieval, третий за поиск в интернете, четвертый за выполнение python-кода.

Поэтому реплики ChatGPT просто раскиданы на GPU-серверах и принимают текстовые запросы, и больше ничего не надо.

develmax

11.11.2023 08:18+2Контекст разве не должен влиять на веса так, что бы модель в процессе диалога дообучалась, чтобы выдать корректный ответ с учетом контекста?

stalkermustang Автор

11.11.2023 08:18+9нет, не влияет. Модель не дообучается на лету по каждому диалогу, только видит контекст. Сразу после открытия нового чата она его забывает (вернее контролирующая система просто не подаёт его на вход);

Aniro

11.11.2023 08:18+1Так очевидно что контекст хранят не в модели - это либо векторная бд, либо, если требуется реальное доубочение модели - LoRA или что-то подобное.

crazysmith

11.11.2023 08:18+25А кто у вас там за текст отвечает? Давно такой отвратительной подачи не читывал. Восклицательных знаков больше, чем у дурачка фантиков.

Уточнение в скобках вот тут: "...внедренные за последние полгода в ChatGPT (самую мощную нейросетку в мире)..." - это вообще для чего? Вы публикуете пост на околотехнической площадке, где само слово ChatGPT уже давно вызывает неиллюзорное раздражение. Или это у вас кросспост на разные площадки и это всего лишь обычный копипаст? Короче, понятно, что в нынешние времена взывать к авторам об уважении к читателям глупо, но хотя бы можно вычитку делать перед нажатием на кнопку публикации?

RationalAnswer

11.11.2023 08:18-27Спасибо за отзыв!

Flux

11.11.2023 08:18+25Знаете, отвечать на критику ведь не так страшно как вам кажется, не обязательно прятаться за смищным (нет) мемасиком пропуская мимо ушей всю суть претензий к вашему творчеству.

Zangasta

11.11.2023 08:18пропуская мимо ушей всю суть претензий к вашему творчеству.

Как бы хорошо не был написан текст, всегда найдутся люди, которым он не понравится. Еще больше найдется людей, которые назовут хороший текст плохим, потому что не сходятся с автором во взглядах.

С этим нельзя ничего поделать. Ну, разве что улыбнуться и запостить смешную шутку, как символ того, что мир несовершенен, а критика зачастую необъективна.

Flux

11.11.2023 08:18+2Вы в первом абзаце привели универсальный аргумент применимый к вообще любым текстам любого качества и содержания. Если следовать вашей позиции можно игнорировать вообще любую критику прикрываясь фразой "я

тг маркетологхудожник я так вижу".Ваш аргумент - карт бланш на любой щитпост любого качества и по сути есть ответ на критику посредством нападки на критикующих.

Такая себе практика.

Zangasta

11.11.2023 08:18+3Ваш аргумент - карт-бланш на любой щитпост любого качества

Для защиты от шитпостов существует система кармы. Если люди активно плюсуют пост, но при этом он не нравится некоторым критикам... это печально, но пост не может нравиться вот вообще всем.

Недовольные будут всегда. При этом чем лучше пост --- тем недовольных будет больше. Просто потому что с высказанными мыслями им будет хотеться поспорить --- а сделать это проще через формальную критику.

Зы. Если критик начинает фразой: "Давно такой отвратительной подачи не читывал" --- а потом переходит на то, что по его скромному мнению в посту многовато запятых --- то это что-то личное.

Flux

11.11.2023 08:18-1Для защиты от шитпостов существует система кармы.

Звучит как эталонное "если тебе что-то не нравится - ставь минус и иди дальше".

Недовольные будут всегда. При этом чем лучше пост --- тем недовольных будет больше.

Абсурд. Чем лучше контент - тем меньше в нём недостатков, даже на хабре есть огромное количество прекрасных статей к которым ни у кого нет претензий, тем более таких что хочется высказать в комментариях.

Ваша позиция "чем лучше мой текст тем больше недовольных, кому не нравится - идите дальше" это прямой путь к самоизоляции в личной эхокамере.

Zangasta

11.11.2023 08:18-4даже на хабре есть огромное количество прекрасных статей к которым ни у кого нет претензий

Это вы про тестирование лампочек, да?

Flux

11.11.2023 08:18Это я про компиляторы, алгоритмы и микроэлектронику.

Не знаю помните ли вы, но когда-то тут был довольно авторитетный технический ресурс а не филиал автортудей и площадка для рекламы телеграм каналов кликбейтами про "AGI скоро".

Zangasta

11.11.2023 08:18+1Не знаю помните ли вы, но когда-то тут был довольно авторитетный технический ресурс

Хабр это не технический ресурс. Хабр это комьюнити. Кто я такой, чтоб указывать комьюнити в какую сторону развиваться?

Если в стране нет больше форумов, где можно поднимать отличные от тестирования лампочек темы, то их будут обсуждать здесь.

Ничего личного, это просто эволюция в действии.

Flux

11.11.2023 08:18+1Хабр это не технический ресурс.

Какая часть "когда-то тут был" вам не понятна?

Сначала на моё утверждение про множество отличных статей к которым ни у кого нет претензий вы вываливаете саркастичный пример про тестирование лампочек, а потом сами же уничтожаете его фразой "Кто я такой, чтоб указывать комьюнити в какую сторону развиваться?".

Тестирование лампочек это ваша больная тема? Вам неприятно что тестирование лампочек местная аудитория оценивала однозначно положительно, в отличии от вашего графоманства?

Вы же сами агитировали за использование системы кармы. Ваша цитата:

Для защиты от шитпостов существует система кармы. Если люди активно плюсуют пост, но при этом он не нравится некоторым критикам... это печально, но пост не может нравиться вот вообще всем.

Посмотрел ненавистные вам посты про лампочки, несколько подряд идущих: +100/-0, +110/-0, +23/-1, +125/-2, +96/-2. Нравится вот вообще всем. Не рассказывают о том как всем не угодишь.

Посмотрел ваше творчество: +26/-16, +45/-61, +146/-35, +69/-23, +89/-43, +21/-8, +16/-13, +57/-25. Не нравится в среднем трети голосовавших. Автор рассказывает о том как всем не угодишь и что чем лучше материал - тем больше недовольных.

Получается, коммьюнити хочет развиваться в сторону чисто технических статей про тестирование лампочек (как в старые добрые времена) а не в сторону прозы про смысл жизни, психологию и кухонные рассуждения о том как быстро нас порешает AGI. Ничего личного, просто статистика в действии.

Мне кажется теперь-то я понимаю почему вам так не нравятся лампочки, почему у меня появился одинокий минус за "Грубое общение. Неконструктивное общение" и почему вы упорно отстаиваете точку зрения о том любая критика субъективна а потому бессмысленна.

Зависть - не лучшее чувство, знаете ли. А сеть - не ваш сейф спейс.

Zangasta

11.11.2023 08:18Как? Как из факта " Не нравится в среднем трети голосовавших" --- вы ухитряетесь сделать вывод:

Получается, коммьюнити хочет развиваться в сторону чисто технических статей про тестирование лампочек

Двум третям нравится. Баланс плюсов положительный. И что самое главное: хабр избавляется от статей про лампочки. Десять лет назад они преобладали. А сейчас их почти нет. И я понимаю почему --- писать о лампочках не интересно. И читать не интересно. Подобные статьи собирают плюсы эксплуатируя "полезность для потребителя". На практике что лампочки, что батарейки стоят сущие копейки и народ, анн масс, не следит за брендами.

Зависть - не лучшее чувство, знаете ли.

Зависть авторам статей о лампочках? Серьёзно? Пойду поставлю вам минус за "Неконструктивное общение" --- не надо придумывать за меня.

Мне было интересно обсудить тему критики. Но я не хочу сводить её к личной перепалке --- что пытаетесь сделать вы.

Flux

11.11.2023 08:18+1Вы действительно не понимаете что контент который нравится примерно 100% голосовавших более предпочтителен чем тот который нравится 66% оных? Очевидно что коммьюнити больше нравится первый вариант и оно поощряет именно движение в сторону "статей про лампочки", ибо оценивает соответствующе. Как же я сделал вывод что коммьюнити хочет развиваться в сторону того контента, который оно оценивает лучше? Даже не знаю.

И что самое главное: хабр избавляется от статей про лампочки.

Вы прекрасно подменили понятия назвав хорошие технические статьи "статьями про лампочки". Далее вы скопом обвиняете все хорошие технические статьи в том что писать их не интересно и читать их не интересно. Браво! Вам читать выходящую раз в три месяца статью про оптимизации компилятора или редкую структуру данных действительно не интересно, тут сомнений нет.

А сейчас их почти нет. И я понимаю почему --- писать о лампочках не интересно.

Да, сейчас технических статей почти нет. Не потому что их не интересно читать, а потому что ресурс превратили в помойку пустив на него блоги компаний и графоманов, в результате чего ресурс потерял статус технического и писать для него хорошие статьи стало неоправданным. Это не значит что местная публика не хочет видеть хорошие технические статьи а хочет видеть графоманство и рекламу тг каналов - обратное прдтверждается системой рейтинга статей. Вам, конечно, выходящая раз в год статья про оптимизации компилятора или про

Зависть авторам статей о лампочках? Серьёзно?

Да, серьёзно. Вы прекрасно понимаете что "статьи о лампочках" публика принимает гораздо теплее чем ваши, и эти лампочки обитают в вашей голове rent free, вы САМИ упомянули их. У вас даже хватило наглости обвинить их в "эксплуатации полезности", лишь бы не признавать того очевидного факта что местными они принимаются лучше чем большинство остальных "статей". Со стороны это выглядит как каноничное "почему он а не я, он же так плох а я так хорош!".

Пойду поставлю вам минус за "Неконструктивное общение" --- не надо придумывать за меня.

Кажется вы только что придумали за меня какое-то обвинение, не правда ли?)

Мне было интересно обсудить тему критики.

Вы подняли тему критики, потом апеллировали к системе рейтингов, потом попытались облить помоями действительно высоко оцениваемый контент, а когда вам показали что эта же система рейтинга этот контент оценивает лучше чем ваш - "не поняли как я сделал такой вывод".

Вы изначально не принимаете саму концепцию критики, о чем тут говорить вообще?

Zangasta

11.11.2023 08:18Вы действительно не понимаете что контент который нравится примерно 100% голосовавших более предпочтителен чем тот который нравится 66% оных?

Вы просто наступаете на старые грабли. Контент, который не вызывает споров и столкновений мнений не нужен.

Возьмем теперь вопрос о разных мелких группах внутри нашей цивилизации. Чем больше население, тем больше таких групп. И берегитесь обидеть которую-нибудь из них — любителей собак или кошек, врачей, адвокатов, торговцев, начальников, мормонов, баптистов, унитариев, потомков китайских, шведских, итальянских, немецких эмигрантов, техасцев, бруклинцев, ирландцев, жителей штатов Орегон или Мехико. Герои книг, пьес, телевизионных передач не должны напоминать подлинно существующих художников, картографов, механиков.

Запомните, Монтэг, чем шире рынок, тем тщательнее надо избегать конфликтов. Все эти группы и группочки, созерцающие собственный пуп, — не дай Бог как-нибудь их задеть! Злонамеренные писатели, закройте свои пишущие машинки! Ну что ж, они так и сделали. Журналы превратились в разновидность ванильного сиропа. Книги — в подслащенные помои.

(с) Рей Бредбери

Стремление избежать всего острого, злободневного, интересного --- выхолащивает ресурс. Если оставить на Хабре только технические статьи, комьюнити разбежится.

Потому что технические вопросы не интересны. По множеству причин --- к примеру, если у меня нет принтера марки Ксерокс, я не буду читать статью о его ремонте. Несмотря на все плюсы, которыми наградили статью заинтересованные владельцы принтеров.

Именно поэтому статья, которая поднимает общие вопросы интереснее. Но такая статья всегда несет отпечаток личности автора, а значит соберет не только плюсы, но и минусы.

И вызовет критику. Станет началом дискуссии. И это правильно и хорошо.

Flux

11.11.2023 08:18+1Контент, который не вызывает споров и столкновений мнений не нужен.

Потому что вы так сказали? У вас точно достаточно авторитета и знаний для того чтобы указывать остальным на то что нужно а что не нужно? Вы уже определились, что является мерилом нужности и оценки качества статьи - голосование читателей, как вы утверждали 5 комментариев назад или количество споров, как вы утверждаете сейчас?

Или вы применяете одну из двух метрик в зависимости от того нравится ли материал лично вам?По множеству причин --- к примеру, если у меня нет принтера марки Ксерокс, я не буду читать статью о его ремонте. Несмотря на все плюсы, которыми наградили статью заинтересованные владельцы принтеров.

Что же, видимо вы гуманитарий и принципиально не способны понять интересность статьи рассказывающей о том как компилятор оптимизирует хвостовую рекурсию или как ищется ближайшая точка в многомерном пространстве. Для вас эти вещи эквивалентны инструкции к принтеру марки Ксерокс и не вызывают никакого интереса. Ошибкой является экстраполяция вашего мнения на всё комьюнити.

Если оставить на Хабре только технические статьи, комьюнити разбежится.

На Хабре уже было время когда на ресурсе были только технические статьи. Вы его не застали, но комьюнити тогда никуда не разбегалось, ибо ресурс считался элитарным. Разбегаться комьюнити начало когда отменили регистрацию по инвайтам и на ресурс хлынул поток графоманов считающих что они-то знают что лучше заходит публике.

Именно поэтому статья, которая поднимает общие вопросы интереснее.

Нет.

Но такая статья всегда несет отпечаток личности автора, а значит соберет не только плюсы, но и минусы.

За отпечатками личности автора можно проследовать на автортудей или в авторские же телеграм каналы, благо две трети нынешних статей пишутся ради возможности прорекламить их в футере.

Хорошая статья содержит знание. То что воспеваете вы - ментальный фаст-фуд призванный бороться со скукой во время обеденного перерыва.

Впрочем, повторюсь ещё раз, бесполезно спорить с человеком уверившимся что чем более он прав - тем больше его критикуют. Вы заранее выписали себе индульгенцию от любого несогласия с вашей позицией.

Zangasta

11.11.2023 08:18Спасибо за обстоятельный ответ. Мне есть что ответить, но как я вижу, наш спор никому не интересен. Даже мне.

Vsevo10d

11.11.2023 08:18+7А я чувствую, что-то знакомые петросянства и базарный стилек, а благодаря вашему вопросу все стало ясно, видимо человечка столько читателей засунуло в бан, что теперь приходится мимикрировать (ну или работать литературным негром у других).

IAmNotMe

11.11.2023 08:18+5Хотя количество лайков под данным впечатлением говорит само за себя, добавлю, что есть и другие (я), кому текст крайне понравился, а подача материала доставила большое удовольствие.

PS и как минимум начинать свой пост со слов "что за отвратительная подача" просто грубо.

ioncorpse

11.11.2023 08:18+3Вы не один. Но согласитесь, подача на любителя. Нам зашло, но другим не особо.

Nasreddin_Hodja

11.11.2023 08:18+1Уточнение в скобках вот тут: "...внедренные за последние полгода в

ChatGPT (самую мощную нейросетку в мире)..." - это вообще для чего? Вы

публикуете пост на околотехнической площадке, где само слово ChatGPT уже

давно вызывает неиллюзорное раздражение.IMHO это ок, я так бывает делаю в своих публикациях где либо на случай, если на неё набредёт кто-то извне а то и вовсе через лет 30, когда уже все забыли что это было. Да и хабр площадка доступная извне, публикации создаются не только для местных и читателю статья могла попасть из поиска в гугле.

IvanPetrof

11.11.2023 08:18+3А стихи на русском оно до сих пор без рифмы пишет?

myswordishatred

11.11.2023 08:18+7Это, кстати, самое главное моё разочарование.

Я так надеялся, что мне сейчас русским гекзаметром что-то эпичное напишут, а на деле что-то несвязное получается.

oleg_rico

11.11.2023 08:18+3Недавно попросил написать несколько стихотворений поздравления на день рождения. Да, написала без рифмы, но так душевно, что поздравляемому очень понравилось, смеялся от души:)

Tarapiygin

11.11.2023 08:18В стихах есть проблема в том что базовый язык модели английский (он думает на английском) и если вы попросите написать стихи на русском, то модель сначала переведет ваш запрос с русского на английский, затем напишет стихотворение на английском, а затем переведет его на русский язык. На последнем этап к сожалению теряется рифма.

stalkermustang Автор

11.11.2023 08:18+3Это не верно, никакого перевода нет — модель сразу выдаёт текст на русском или любом другом языке. Другое дело что английский для неё нативен в силу объема информации в тренировочной выборке и в специально заготовленном вручную наборе для дообучения.

sim31r

11.11.2023 08:18Это не объясняет полное отсутствие рифмы, стихи форматируются как стихи, но схожести окончаний и корней нет. Стихи она не просто пишет хуже на 20% например, а полное отсутствие рифмы. Только форматирование по строкам сохраняется, имитируется внешний вид стихов.

aldekotan

11.11.2023 08:18Возможно, масштабирование системы позволит добиться лучших результатов, как было с текстом на изображениях?

Насколько я знаю, написание стихов и для человека является задачей нетривиальной, со множеством итераций, в результате которых исходный смысл запроса искажается ради рифмы, частично или полностью.

Вспоминая ситуацию с руками, опять же, их правильное изображение тоже потребовало больших мощностей.

sim31r

11.11.2023 08:18написание стихов и для человека является задачей нетривиальной

Рифмовать слова не сложно. Сложно со смыслом это делать и художественной ценностью. И на английском чат отлично пишет стихи.

Kergan88

11.11.2023 08:18Обучающая выборка на руском мала, по этому с точки зрения оптимизации целевой функции сети не выгодно тратить параметры на рифмование русского текста. Их выгоднее потратить на чтото другое, что улучшит перформанс на выбрке английских текстов и увеличит общий скор.

Aldrog

11.11.2023 08:18Не знаю как сейчас, но одно время ChatGPT на вопрос о смерти Пушкина на английском отвечал корректно, а на русском начинал нести чушь о туберкулёзе. Воспроизводилось и то и другое весьма стабильно.

Как раз отсутствие рифмы недообученностью можно объяснить, а вот описанное выше переводом туда и обратно - нет.

Arastas

11.11.2023 08:18Я немного запутался в описании. Dall-E 3 вызывается изнутри чата с ChatGPT, или только генерируется расширенный промпт, который надо скопировать? Как вообще взаимодействуютт chatGPT и Dall-E в бесплатной и платной верстях? Они же оба с Microsoft завязаны?

nightlord189

11.11.2023 08:18+1Вызывается прямо изнутри и в диалоге присылается картинка, можно спрашивать как текстовые ответы, так и сгенерить картинку.

stalkermustang Автор

11.11.2023 08:18+1Про то, как работает, уже ответили — это как yet another инструмент, который ChatGPT может "Решить" вызвать. И для этого GPT перепишет человеческий промпт в более детальный (если исходный и без того будет длинный, то она может его оставить as is, умная собака). А затем просто делает post-запрос в API с query.

Они же оба с Microsoft завязаны?

Я бы сказал "они же оба к OpenAI завязаны", а MSFT просто имеет доступ к технологии для интеграции в свои сервисы - например, в Bing Chat.

Kenya-West

11.11.2023 08:18-3А вот и нет. Думаете, Microsoft разрешит другим гигантам инвестировать больше них в OpenAI и перехватить контроль над компанией? Нет, по факту хватка у MS железная и напоминает отношения вассала и сюзерена. Именно факту. А чем там де-юре они прикрываются и как публике они пыль в глаза пускают - меня не интересует, ибо фактически OpenAI связана с MS, а не наоборот. Просто сюзерен даёт возможность вассалу развиваться, пока это приносит пользу. А потом заставят OpenAI сделать десяток непопулярных юзерских решений в течение пары лет, собьют цену акций (если они успеют выйти на IPO), сделают вид, что MS — это мессия, спасающая утопающий бизнес, и купят, как только отгремит эхо от сделки с Activision Blizzard.

Выводы сделаны на основе наблюдений в публичном поле. Ситуация, конечно, своего рода уникальная, нигде до этого я о подобных отношениях между крупнейшими суверенными бизнесами не слышал.

stalkermustang Автор

11.11.2023 08:18+2ого нифига себе у тебя инсайды, пошёл тогда Сэму на почту отпишу!

theurus

11.11.2023 08:18+11.2 доллара за один запрос размером 128к токенов к гпт3.5. Сильно.

AlexandrSudarev

11.11.2023 08:18+5Ну вы же не думали, что действительно выйдет заменить человеческий труд абсолютно бесплатно?

syusifov

11.11.2023 08:18-8лохов доят, как обычно

Kenya-West

11.11.2023 08:18+5Из разряда "Илон Маск мошенник, потому что он разрушил монополию Роскомоса на полёты к МКС"?

b50d

11.11.2023 08:18мдя после прочтения както совсем невесело что подумает AI про обычный HI и когда придет к очевидному выводу

Lucidyan

11.11.2023 08:18+12Хотелось бы узнать мнение автора, чем обусловлен такой чудовищный уровень цензуры DALL·E 3? Понятно уже, что генерировать что-то на основе работ/внешности живущих в последние годы, на «спорные» с точки зрения OpenAI темы и NSFW мне запрещают (что понятно с точки зрения прикрытия своего бизнеса, но уже вызывает много вопросов касательно художественной пользы продукта), так и валится сеть на совершенно безобидных запросах типа «сделай схему вышивки» или вполне политкорректного SFW описании внешности персонажа.

То есть, OpenAI, будучи сильнйшим игроком на AI-рынке и де-факто монополистом генеративки, выступает в роли морального камертона, запрещая мне генерировать абсолютно разрешенные законом вещи и это видится мне довольно опасной тенденцией, потому что как написано в статье, их инструменты становятся частью жизни немалого количества людей и этот брейнвошинг бесследно не проходит.

Модель действительно лучшая на рынке, но цензура, отсутствие каких-то инструментов управления выводом/консистенцией (они даже сид изображения запрятали недавно) делает её абсолютно бесполезной для художников даже в сравнении с закрытым конкурентом MidJourney, не говоря уже о SD с его развесистой экосистемой.

Moog_Prodigy

11.11.2023 08:18+14Именно экосистема у SD сделала её таким какой он есть. И (это мнение мое и десятка знакомых) SD далеко ушла от миджорней, как раз за счет того, что контента (модели и прочие лоры) к ней уже наделали сотни и тысячи. Да, система посложнее, чем с одной кнопкой "нарисуй картину", но достаточно одному шарящему ее грамотно настроить, и результаты ничуть не хуже миджорней и даллей будут получаться. А то и лучше. И при этом этим инстансом могут пользоваться десятки людей, например дизайнеры в компании. Или небольшое сообщество фанатов какой-то игры, аниме или фильма. При этом почти бесплатно.

Плюс возможность запуска на локальной машине - порой это дорогого стоит, модели без цензуры, возможность обучения, сотни хитрых плагинов, etc.

oleg_rico

11.11.2023 08:18+2Надеюсь, кто-нибудь сможет на этой основе сделать инструмент в виде собеседника для пожилых людей.

Летом использовал gpt-чат в формате когда пожилой человек что-то спрашивал, google текст впечатывал в чат, а я ответы озвучивал. Получилась вполне себе интересная беседа.

ru1z

11.11.2023 08:18+1Так он умеет в этой форме, в статье есть видео, где кто-то учит русский язык - попросили (голосом) научить паре фраз (что-то найти/купить) - чатбот научил, в том числе и на русском (голосом), т.е. он может говорить в любой популярной связке.

У меня нет подписки, но на бесплатной на мобильном попробовал распознавание - работает отлично. Озвучка текстов - тоже судя по тем примерам, которые видел - на очень хорошем уровне и для русского можно ударения и словари подключать. Наверное, надо как-то подписаться, выглядит удобно. Как там с тем, чтобы шарить аккаунты (в семье) интересно?

oleg_rico

11.11.2023 08:18Набрать голосом вопрос к чату не проблема, а вот озвучивать он не может.

stalkermustang Автор

11.11.2023 08:18+2в мобильном приложении - может, см. пример в статье.

AcckiyGerman

11.11.2023 08:18+1Официальное приложение OpenAI из Google Play - нет (по крайней мере без подписки, с подпиской не проверял)

stalkermustang Автор

11.11.2023 08:18+1как указали в комменте выше, нужна подписка для режима голосового ассистента

https://habr.com/ru/companies/ods/articles/772292/comments/#comment_26151764

ru1z

11.11.2023 08:18+1Вот, наютубил пример, где как как переводчик используют, можно оценить озвучивание

https://m.youtube.com/watch?v=iKmJJDzJZkU

Неплохо, имхо даже аудиокнижки озвучивать годится, наверное гпт из контекста всяко лучше угадает какой голос и эмоции использовать. Для пожилых людей, инвалидов, если так будет продолжаться, то это здорово. Да и остальным, я бы был рад, к примеру, более удобной, чисто голосовой навигации, гуглкарты не настраиваются, а гпт наверное и гидом сможет сработать параллельно.

Kenya-West

11.11.2023 08:18+2Как там с тем, чтобы шарить аккаунты (в семье) интересно?

Если с ПК пользоваться, то всё ок, а вот с телефонов... после НГ попробую замутить эту тему для своих пенсионеров, уж больно идеей загорелся.

AcckiyGerman

11.11.2023 08:18сделайте дополнительный гугл аккаунт, добавьте его в смартфоны родным, установите из-под него приложение.

AcckiyGerman

11.11.2023 08:18+1Все верно, голосовые ответы только в платных версиях:

Voice Conversations in ChatGPT are only available for ChatGPT Plus and Enterprise users at the time of this writing. Voice Conversations can use both GPT 3.5 and GPT 4 models; however, the message cap of 50 messages every 3 hours for GPT 4 for Plus users is still applicable (there's no such cap for Enterprise users).

janvarev

11.11.2023 08:18+1Если хотите, у моей опенсорсной Ирины https://github.com/janvarev/Irene-Voice-Assistant есть режим диалога с ChatGPT.

Докрутить, если нужно коннект к страницам в интернете в принципе можно.

Kergan88

11.11.2023 08:18>Но тут важно понимать вот какой момент: как только выйдет GPT-4.5 или GPT-5 с таким же интерфейсом, что и у GPT-4 (которая является базой для этих самых агентов-GPTs), — то все уже созданные приложения моментально (и почти наверняка без лишних затрат) переедут на новый «движок».

Это же не так. У каждой сети свой собственный, уникальный интерфейс. Промты написанные для одной сети для другой уже не будут работать как надо.

Opaspap

11.11.2023 08:18Не совсем так, после обучения модель дополнительно файнтюнят на инструкции, т.е. если датасет инструкций не изменится (для ллама, это например часто альпака), то и приложения будут продолжать работать (но не совсем так как раньше немного, т.к. сама модель другая и пути у нее в итоге другие)

Kenya-West

11.11.2023 08:18+1По факту созданные на основе GPt-4.5 "приложения" настолько высокого уровня абстракции, что перепривязать их на новую модель можно относительно легко. Было бы желание у OpenAI и более-менее прямые руки.

Последнее важнее обычного. А то знаем мы ученых, работающих с нейронками и большими данными, которые клали на качество кода и тем более на его архитектуру...

stalker_316

11.11.2023 08:18+6>> Короче, чё думаете, пацаны — уже киберпанк, или еще нет?

Не киберпанк, а идиократия... С каждым годом удивляюсь, насколько пророческим оказался тот фильм...

perfect_genius

11.11.2023 08:18Хоть одна из рисующих нейросетей может нарисовать простую попиксельно идеальную сетку? Попробовал и не получается, только кривые и размытые.

stalkermustang Автор

11.11.2023 08:18+2попроси у GPT-4 нарисовать, используя код на Python :)

perfect_genius

11.11.2023 08:18О, а это вариант. Но для начала всё же хочется именно от рисующей нейросети.

PanDubls

11.11.2023 08:18Человек тоже не может не используя функций типа "прямая линия" рукой нарисовать такую сетку. А если агенту дать возможность вызывать такую функцию, то, думаю, справится.

perfect_genius

11.11.2023 08:18Я могу нарисовать в Пэйнте, что и сделал. Но это было долго, хочется моментально.

sunnyfox

11.11.2023 08:18+2Что-то намутили они в своём обновлении, я таких грубых багов в русском чате с самой зари ChatGPT наблюдала, как сегодня ???? 4я версия рассказывала мне, что конина - это мясо кролика, ещё и спорила потом, доказывая, что хотя иногда так в русском называют и мясо лошади, но все же обычно мясо кролика.

Вроде не самый редкий контекст.

atsyhan_minsk

11.11.2023 08:18У меня вопрос по поводу модели которая в UI - я сразу потестировал несколько текстов, максимум что удалось мне "скормить" - это 15 000 токенов, а вот Claude в вебе спокойно взял весь текст на 50к токенов

stalkermustang Автор

11.11.2023 08:18мы не знаем до конца, но по тестам у меня выходит, что больше 40к токенов в UI модель помнит (отвечает на команды из первого сообдщения). Правда эти 40к приходится разбивать на блоки (я использовал по 8к, но если 15к работает то тоже кул).

Но это не значит что модель не может такое отработать — просто выставили ограничение на одно сообщение (и на длину ответа GTP-шки).Если нужно что-то длинное грузить — можно залить txt/pdf как раз, там и несколько мегабайт текста будут крутиться спокойно, что тоже очень удобно.

kraidiky

11.11.2023 08:18+4И что самое крутое - нейросеть уже выровнена под правильные политические взгляды соответствующие повестке той партии, которую спонсирует Альтман, и кроме самых настойчивых никто не сможет получить ответ, который бы отличался от заданной политической линии. Ещё протащить это в образование и вообще уже больше ничего не нужно.

mordoorg

11.11.2023 08:18+1Официальная миссия Microsoft звучит так: «to empower every person and every organization on the planet to achieve more»

Ещё один кандидат в копилку "Забытые лозунги/миссии/девизы IT-гигантов в пользу коммерческих интересов" наравне с «Don't be evil» от Google.

Очень хочу конечно ошибаться, но верится с трудом, что будет по-другому

stalkermustang Автор

11.11.2023 08:18В любом случае Microsoft не владеет ничем, что принадлежит OpenAI — они инвестировали в компанию пустышку (которой владеет OpenAI), и у OpenAI есть лишь обязанность отдавать им часть выручки, пока сумма не достигнет заданной. У MS нет ни места за столом директоров, ни права вето.

Детали см. тут https://t.me/seeallochnaya/223 и https://t.me/seeallochnaya/224

piuzziconezz

11.11.2023 08:18То чувство, когда, будучи интровертом, чем умнее становится нейросеть, тем меньше хочется с ней общаться.

AigizK

Надо сказать, что они еще добавили поддержку новых малоресурсных языков, например мой родной башкирский. Качество перевода лучше чем у Bing,Yandex,NLLB-200,Glosbe. Хорошо понимает культуру, обычаи. Пока нет синтеза и распознавания речи, распознавания текста на картинке. Но с такими темпами, думаю не долго ждать.