14-го декабря в одном из самых авторитетных общенаучных журналов Nature была опубликована статья с, кажется, сенсационным заголовком: «ИИ-модели Google DeepMind превосходят математиков в решении нерешённых проблем». А в блогпосте дочки гугла и вовсе не постеснялся указать, что это — первые находки Больших Языковых Моделей (LLM) в открытых математических проблемах. Неужели правда? Или кликбейт — и это в Nature? А может мы и вправду достигли техносингулярности, где машины двигают прогресс? Что ж, давайте во всём разбираться!

Всем привет! Статья ниже — подробный разбор достаточно сложного топика, и в некоторых моментах нужно будет сосредоточиться и вдумчиво читать. Я постарался представить все важные аспекты как можно проще, но в то же время не теряя общности и глубины. Перед прочтением рекомендуется ознакомитьcя с принципами работы больших языковых моделей, о чём я уже писал на Хабре (даже вошло в лучшее за 2023й!).

Содержание

Предисловие

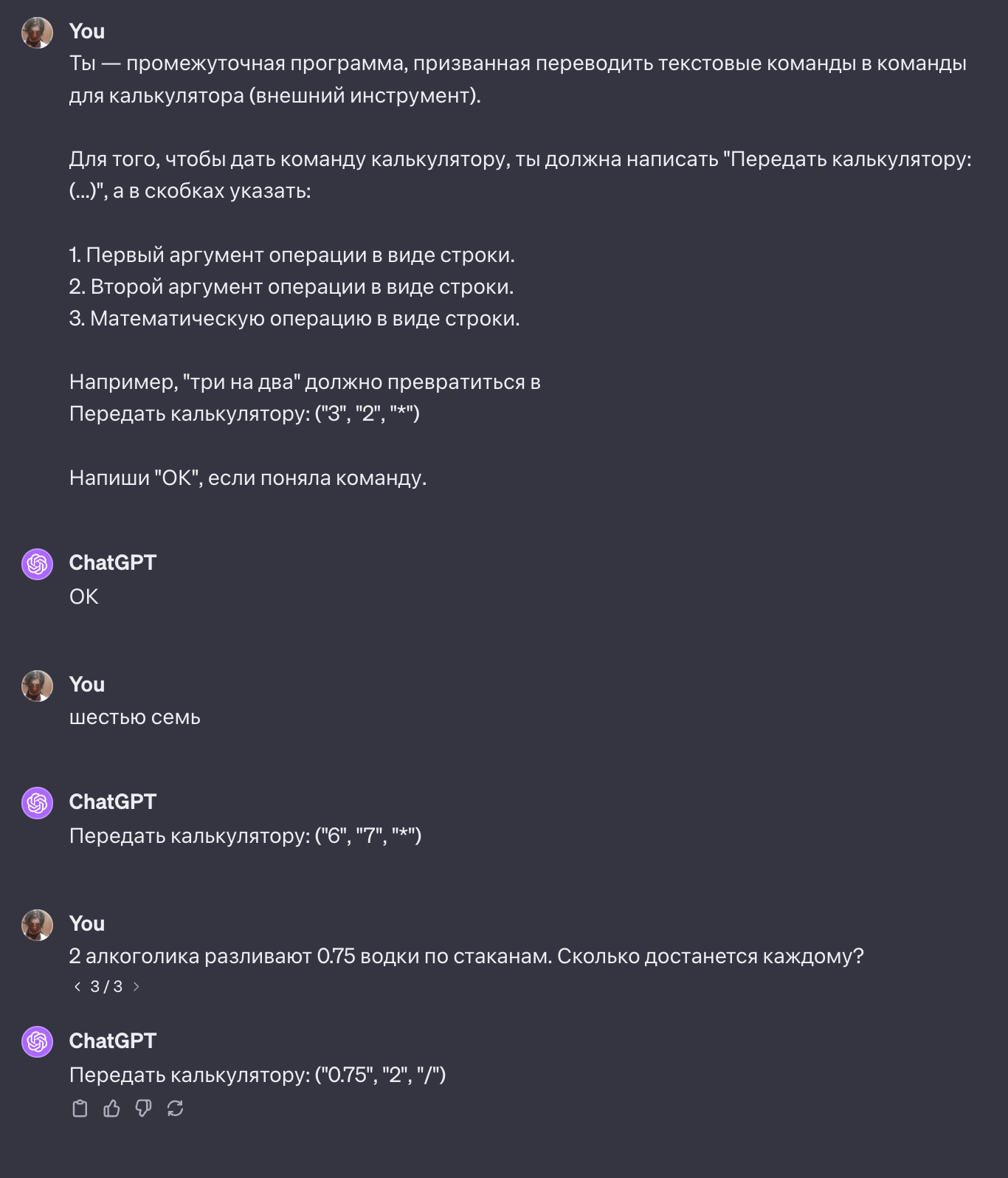

Large Language Models (LLM, или Большие Языковые Модели по-русски) в последний год показали себя в роли полезных ассистентов, а про ChatGPT в наших кругах не говорил только ленивый. Эти нейросети хороши за счёт того, что предоставляют удобный чат-интерфейс к аггрегированной со всего света информации, при этом они способы отвечать не только кусочками текста с сайтов, но и в любом произвольном удобоваримом виде. Они же пишут код в помощь разработчикам, да и в целом помогают решать разного рода проблемы.

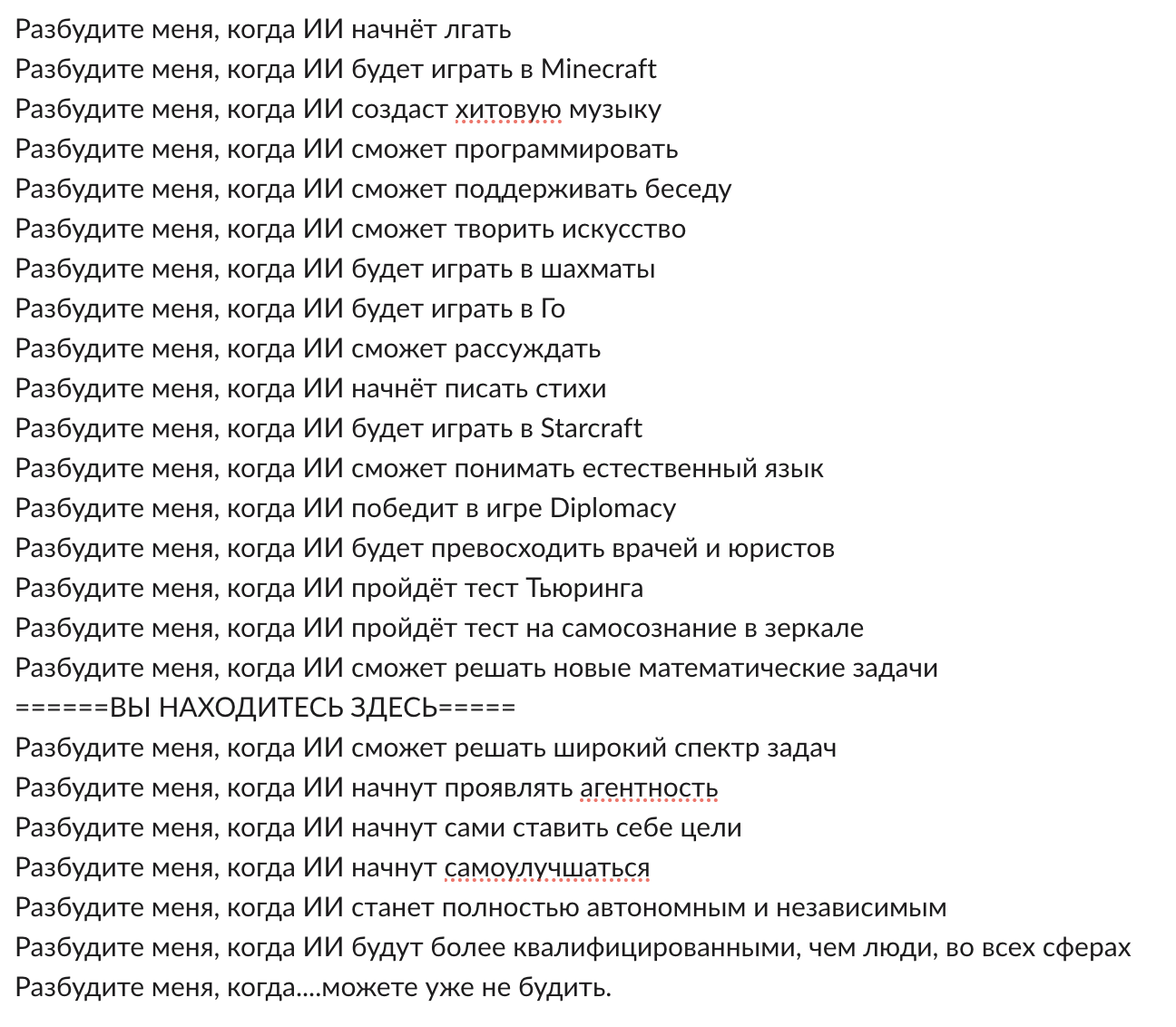

За последние месяцы вокруг этих моделей поднялась ещё большая шумиха — регуляции нейронок обсуждают на самых высших уровнях, видя потенциальные угрозы. Совсем недавно Белый Дом, а затем и Европарламент выпустили документы, задающие границы технологии. Однако для многих остаётся загадкой — а чего в общем-то бояться? Как чатботы могут нанести вред? И уж тем более смешными выглядят попытки показать, что в GPT-подобных системах есть «интеллект» (зачастую без возможности дать формальное определение). Многие считают, что ChatGPT лишь воспроизводит информацию, которую прочитал в интернете во время тренировки. Простой «статистический попугай», выкрикивающий фразы (не)впопад. Но могут ли LLM порождать новые знания, которые точно не были известны человечеству заранее?

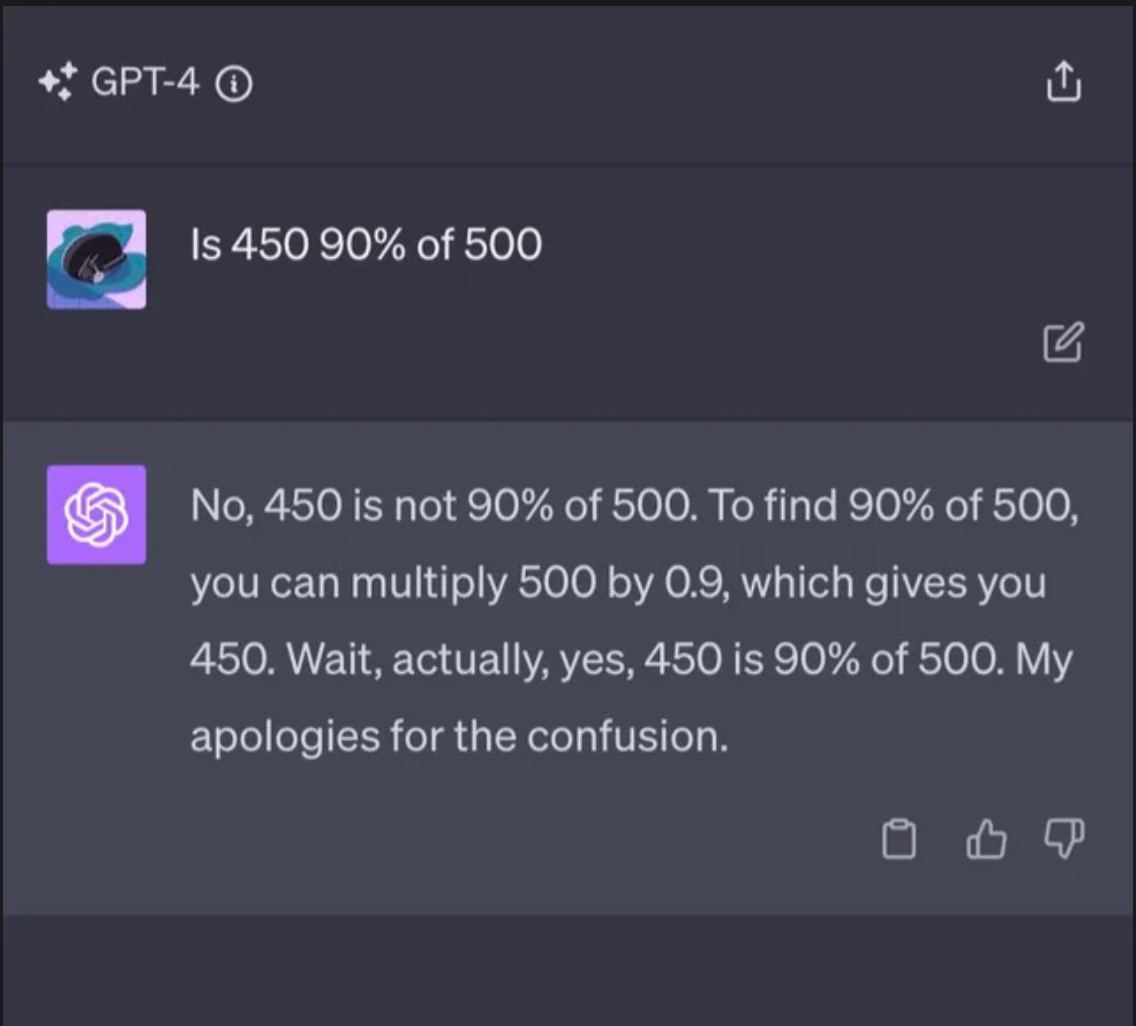

На этот вопрос ещё сложнее ответить, если учесть, что модели часто «галлюцинируют», то есть на серьёзных щах пишут вещи, которые не имеют смысла или являются неточными. С одной стороны, они не всегда отвечают то же, что ответил бы человек, а с другой — бредят. Но что, если бы мы могли использовать этот «творческий» потенциал во благо, выявляя и развивая лишь лучшие и корректно сгенерированные идеи?

Этим вопросом задаются ведущие исследовательские лаборатории, от OpenAI до DeepMind. Последние и опубликовали статью под названием «Mathematical discoveries from program search with large language models», ставшей основой для этого поста.

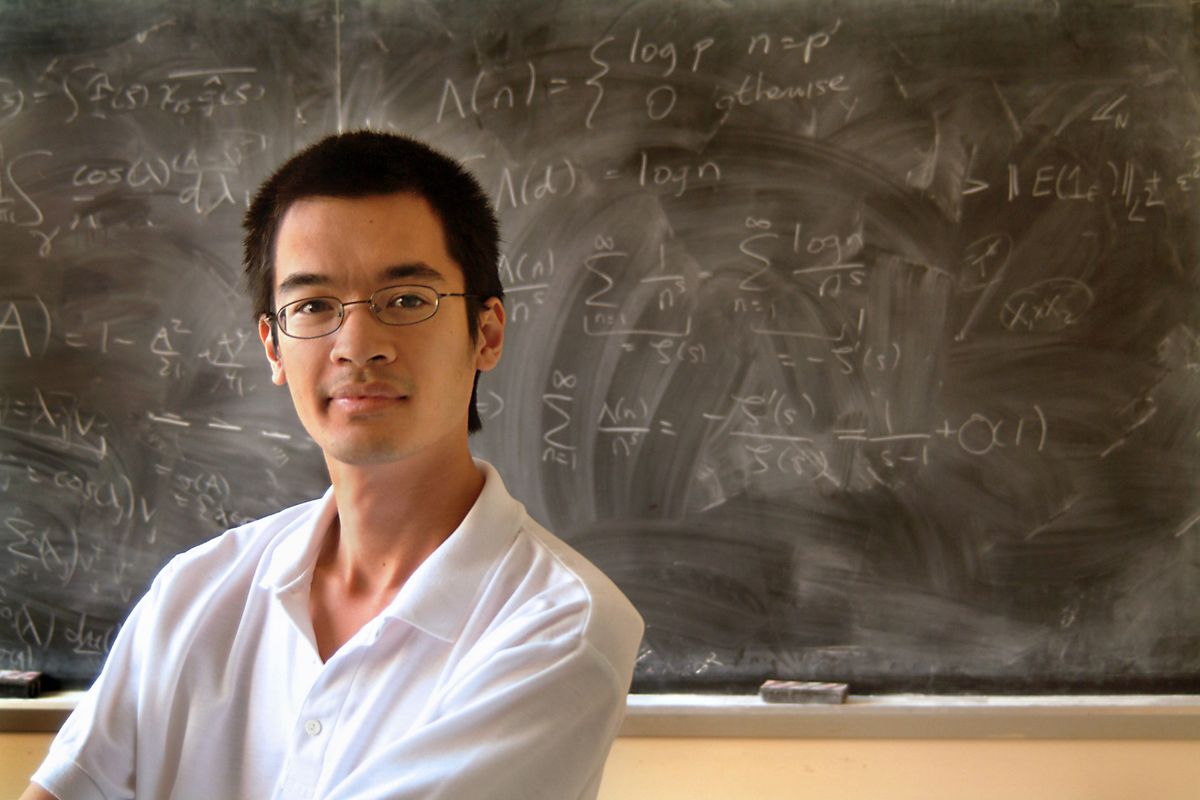

И немного забегая вперёд, но чтобы развеять ауру мистики вокруг, давайте сразу проговорим: да, действительно, программа на языке программирования Python, сгенерированная LLM'кой, дала решение, которое не было известно человечеству до этого. Более того, это решение лучше, чем найденные учёными за десятилетия. И это даже не третьесортная проблема — Теренс Тао называл её своим любимым открытым вопросом математики. Теренс — это лауреат Филдсовской премии (аналог Нобелевской, но для математики), а также самый молодой участник, призёр и победитель Международной олимпиады по математике. В общем, Тао падок на драгоценные металлы в медалях, и к его словам можно прислушиваться — так что у нас тут всё серьёзно.

Перед тем, как начать разбирать «научный прорыв» и работу научных систем на основе LLM, хорошо бы понять — а что вообще за проблема перед нами стоит? Есть пара хороших новостей и одна плохая. Хорошие: в опубликованной статье указывается несколько проблем, в которых были совершены открытия; некоторые из них можно объяснить «на пальцах». Плохая: главную научную проблему и её ценность объяснить на пальцах сложно — вы же не думали, что всё так просто? Поэтому вот как мы поступим: сначала кратко и в общих чертах обсудим основную математическую задачу, прорыв в которой и является большим событием, а дальше рассмотрим более доступную (но менее впечатляющую), и уже с этим примером в руках будем разбираться в принципе работы алгоритма.

Карты, точки, три столпа: настольные игры и наука

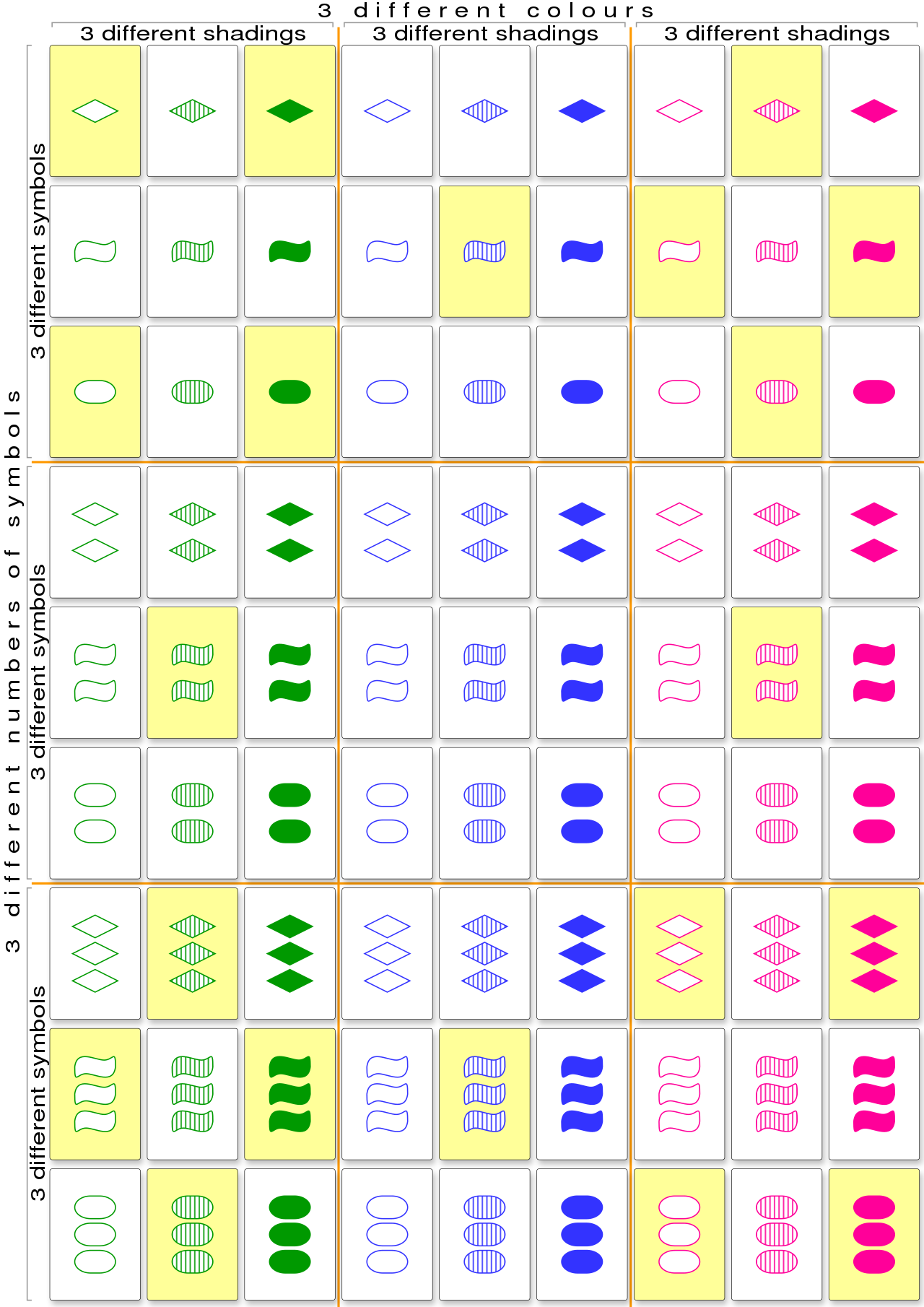

В центре проблемы лежит малопопулярная игра Сет (или Трикс), по правилам слегка напоминающая УНО! Всего в колоде 81 карта, и каждая из них характеризуется четвёркой параметров: тип фигуры на карте, её цвет, количество и текстура (тип закрашивания). Для каждого из параметров может быть 3 варианта. Например, одна, две или три фигуры. Или зеленый-синий-розовый, если речь про цвета. Поэтому карт столько: всего комбинаций 3*3*3*3.

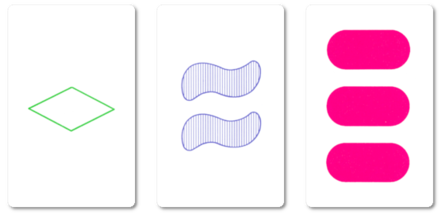

Ключевым в игре является понятие «множества» (собственно, set по-английски, отсюда и название), описывающее набор из трёх карт. Множество можно определить так: для каждого из четырех параметров (это цвет, количество, форма и текстура) все три карты должны отображать этот признак либо как а) все одинаковые, либо б) все разные. Звучит сложно, но при визуализации всё становится проще:

Ведущий постепенно выкладывает карты на стол, и игрок, заметивший сформированное множество, должен выкрикнуть «сет!». После этого он может забрать эти 3 карты себе (ведь в сете всегда 3 карты). Однако может так получиться, что сет долгое время не выпадает — и не потому, что игроки проворонили, а потому, что его действительно просто нет на столе. Тогда по правилам, если в игре оказывается 12 карт, то они убираются со стола; ведущий берёт три карты с верха колоды и выкладывает на пустой стол. Когда вся колода кончается, игра заканчивается, а игрок, набравший больше всего карт на руки, побеждает (не то что в УНО!)

Где-то в этот момент вы должны спросить себя «что за хрень? При чём тут открытия в математике и нейросети?». Дело в том, что математики часто фигнёй маются задаются вопросами, которые могут не иметь видимого смысла, и при этом имеют наглядные игрушечные демонстрации. Однако прелесть математики в том, что даже игры можно свести к формулам, в нашем случае — из теории множеств или афинной геометрии. Можно поставить карты колоды в соответствие точкам четырёхмерного пространства (потому что у нас 4 уникальных признака) над полем из трёх элементов (потому что карты три) . В таком случае сет соответствует трём коллинеарным точкам в этом пространстве — иными словами, трём точкам на одной прямой, и их сумма равна нулю.

Разбор двумерного случая для интересующихся

Если у нас всего два признака (например, цвет и форма объекта на карточке), то можно взять лист бумаги и нарисовать двумерную плоскость. У каждого признака всё еще ровно по три уникальных значения. Смена целочисленных значений по оси Ox может означать разные цвета, а по Oy — формы. Мы говорим про целые числа потому, что задача — дискретная: в её рамках не бывает 0.5 красного цвета или 0.3 треугольника.

Тогда всего у нас в колоде 9 карт (в сетке 3*3, как и точек на графике выше). Для них можно выбрать лишь 4 точки так, чтобы никакие 3 не лежали на одной прямой. Если бы другая желтая точка была на продолжении одной из прямых (скажем, в верхнем правом углу, чтобы получилась диагональ), то точки бы схлопнулись в одну центральную, и их сумма равнялась нулю (при условии, что центр координат всегда в средней точке).

Теперь, когда все пережившие прошлый абзац почувствовали себя умнее, давайте определим набор карт, среди которых нет сета (или соответствующих им точек), и назовём его «cap set» (русского названия сходу не нашёл, Википедия предлагает «множество колпаков», но без указания источника). Это как раз те 12 карт, которые нужно будет убрать со стола, если все игроки затрудняются найти сет.

А вот почему 12? Почему не 10 или 15? И вообще можно ли посчитать, сколько максимум карт можно выложить на стол так, чтобы не было сета? Поздравляем, если вы задались таким вопросом — вы только что сформулировали задачу The Cap Set Problem. Для нашей игрушечной колоды ответ равняется 20, а число 12, видимо, выбрано потому, что людям очень сложно перебирать все комбинации в голове по ходу игры.

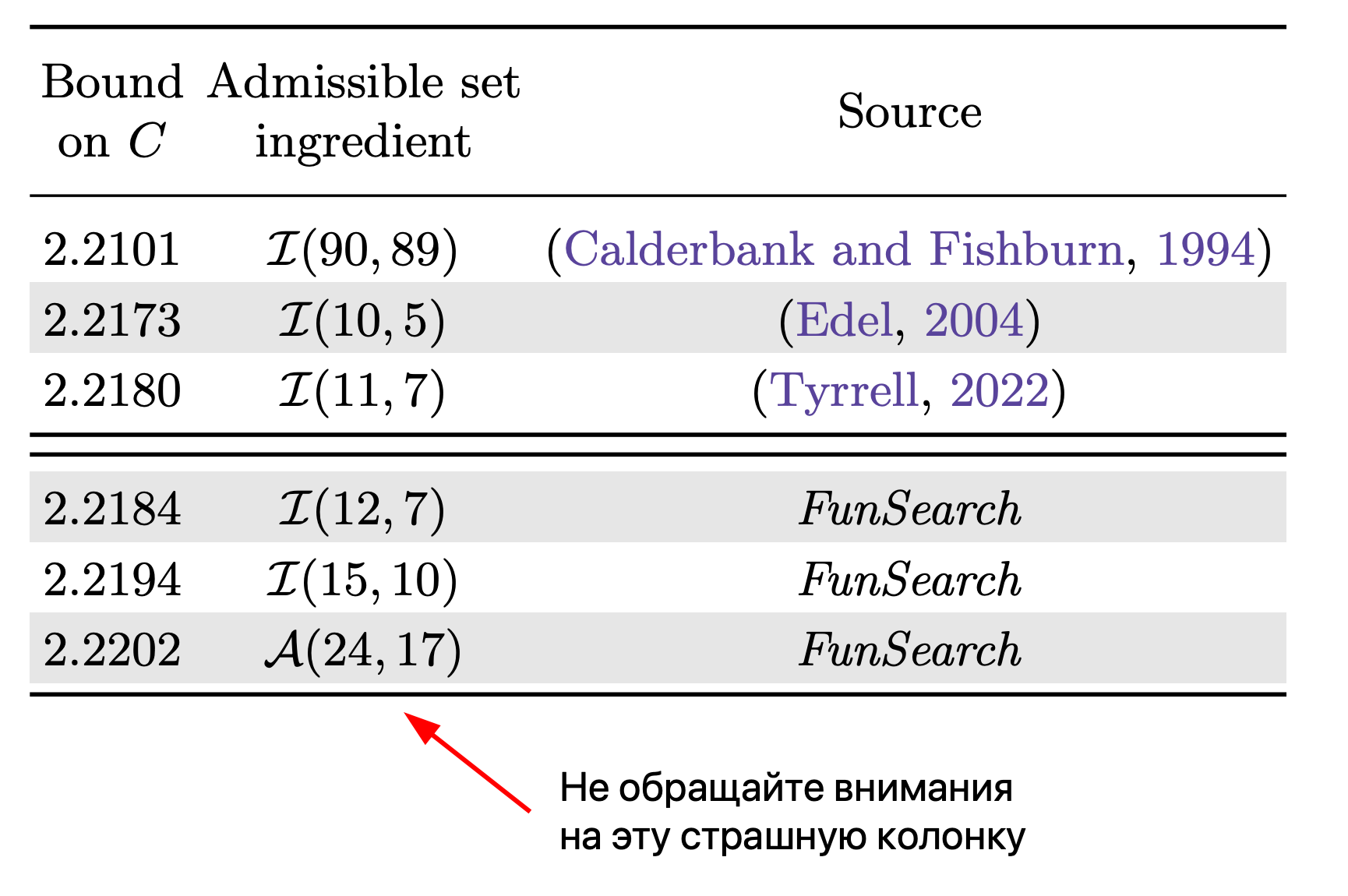

Но эту же задачу можно сформулировать в общей форме. Оказывается, на данный момент не известно формулы, которая по количеству уникальных признаков (вроде цвета или формы фигуры), разделяющих карты, будет вычислять размер cap set. Иными словами ответить на вопрос «сколько карт можно выложить на стол так, чтобы никто не кричал СЕТ!!! как угорелый?» невозможно. У нас есть лишь оценки верхней и нижней границ (формулы, которые указывают, в каких рамках лежит искомое значение), которые постепенно уточняются, а также посчитаны размеры максимально возможного cap set для количества признаков до 6 включительно. Почему не пошли дальше, хотя бы чисто по приколу? Ну, потому что это сложная вычислительная задача, где нужно сделать полный перебор всех комбинаций, число которых стремительно растёт. Пока не найдено решение в общем виде (та самая формула), считается, что без перебора проверить корректность ответа невозможно.

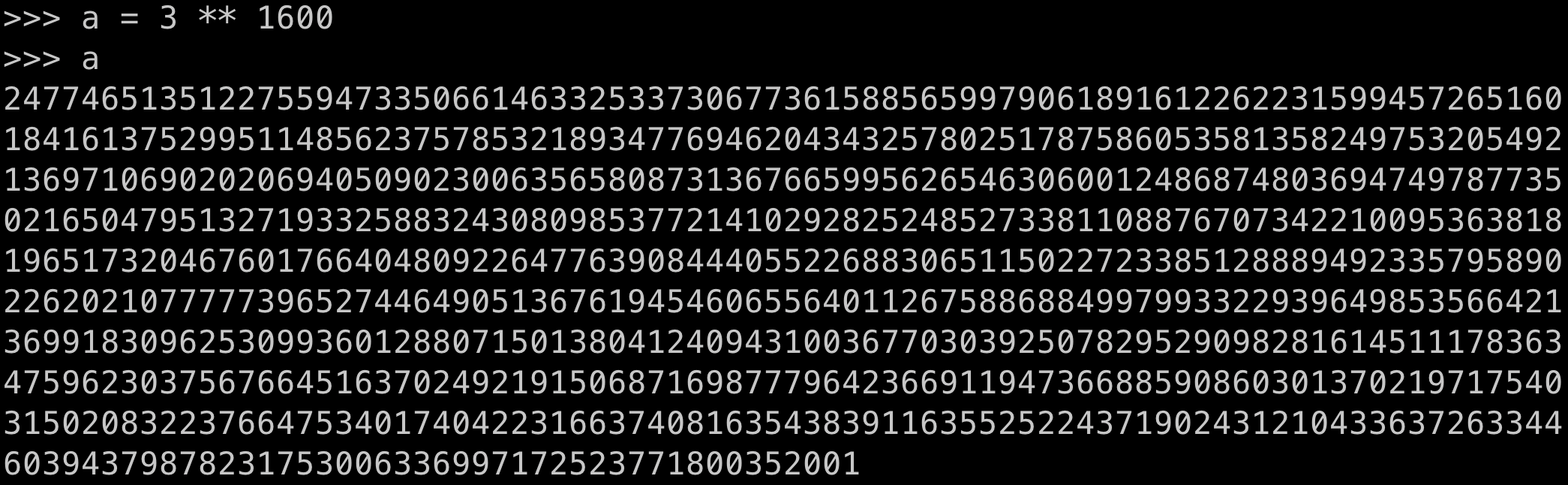

Для 8 признаков нужно будет перебрать всего лишь 3^1600 троек карт, что на порядки больше, чем количество атомов во Вселенной. Да что там, в игре Го, которая считалась невозможной для игры компьютером на уровне человека, длина числа валидных состояний доски — это число с 171 цифрой. А для нашей карточной игры при 8 признаках количество троек карт измеряется числом с 764 цифрами. Страшно?

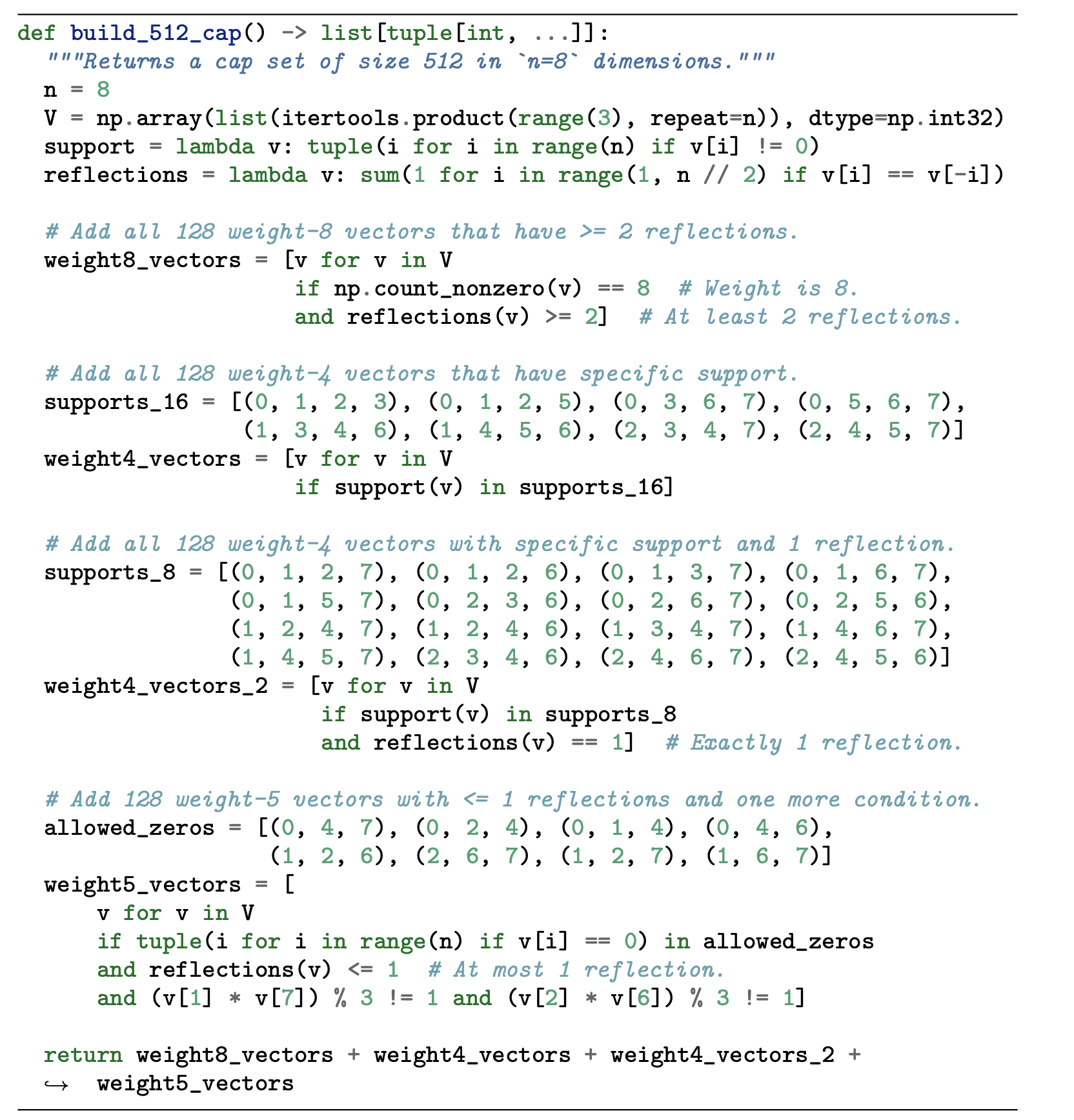

Так вот, именно для этой задачи языковая модель от Google и написала код, который...нет, не находит точное значение или формулу (то есть определяет истинную зависимость). Этот код лишь генерирует такие наборы, для которых очень легко проверить, что все правила соблюдены (то есть получен истинный cap set), и размер этого набора для 8 признаков больше, чем у любого другого, найденного человечеством с момента появления математической задачи.

Насколько мне удалось проверить — метод пока не запатентован, так что торопитесь!

Напомню, хоть всё может показаться игрушечным, какие-то карты, красные ромбики и зеленые овалы — это научная проблема, над которой билось множество исследователей, писались научные работы. А всё потому, что никогда не знаешь наперёд, где пригодится твой результат. Вот даже для этой проблемы, уточнение лишь верхней оценки на количество элементов в cap set немедленно привело к ряду других результатов в комбинаторике, например, приблизило к разгадке задачи о подсолнухе (карточки, подсолнухи, что дальше? Грибы? Их уже хватит...). Это подчеркивает, насколько методы, предложенные DeepMind и описываемые ниже, могут быть полезны в научно-исследовательской работе — пусть даже без видимого для обывателя эффекта.

Далее в тексте я буду по большей части игнорировать описанную выше проблему, так как жонглировать всеми терминами в абстрактной задаче сложно, но не забывайте, что речь идёт про реальные научные открытия. А теперь мы перейдем к...

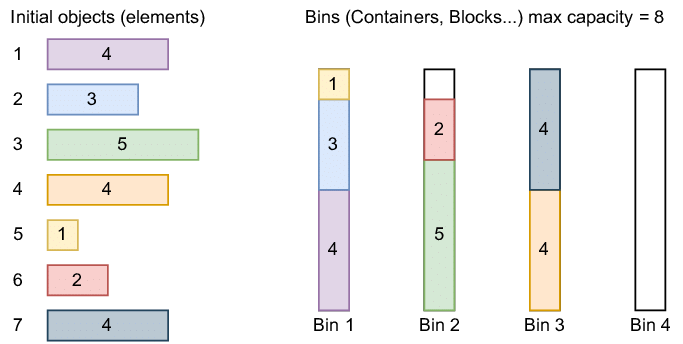

Задача об упаковке в контейнеры

к описанию более простой задачи, понятной каждому: упаковка в контейнеры. Цель здесь — упаковать набор коробок разного размера в наименьшее количество контейнеров фиксированного размера. Подождите, не закрывайте статью — это реально прикладная задача, честно! И используется не только на складах! С минимальными изменениями решения этой задачи можно применять хоть на реальном производстве при резке материалов, хоть при планировании ресурсов и распределении задач на серверах для уменьшения трат — главное, что у вас есть что распределять и куда.

В такой задаче выбрать правильную стратегию заранее очень сложно. На данный момент не найдено способа выявления лучшей стратегии оптимальнее, чем перебором (прямо как в задаче выше, The Cap Set Problem). Поэтому чаще всего люди соглашаются с достаточно хорошей стратегией, которая может и не является лучшей, но лишь слегка ей проигрывает. Зато работает быстро и почти везде!

Такие «наколеночные» стратегии часто называют эвристиками, и они базируются на опыте и экспертизе в рамках конкретной задачи. Придумать хорошую эвристику очень сложно, так как в голове нужно держать множество ситуаций разом.

Но одно дело заниматься распределением ресурсов (или раскладкой по контейнерам), когда вся информация о наполнении есть заранее, а другое — когда то и дело прилетают новые коробки, которые сразу надо «упаковать». Лучший пример тут — это выделение вычислительных ресурсов для задач на кластере, и на масштабах крупнейших корпораций вроде Google или Facebook даже 1-2% выигрыша — это десятки и сотни миллионов долларов экономии в год. Каждую минуту вам прилетают тысячи новых запросов, которые нужно выполнить, и вы можете либо выделить новый пустой сервер, либо попытаться найти уже загруженный, но не настолько, чтобы новая задача (коробка) «не влезла». Google даже хвастался, что получилось применить нейросети для оптимизации хранилищ, и это экономит 19% пространства на дисках — что опять же приносит выгоду в десятки миллионов.

Формально, задача выглядит так: на каждом шаге нам приходит информация о новой коробке (её размере, для простоты это будет одно число), и мы можем либо взять новый пустой контейнер, чтобы загрузить коробку в него, либо выбрать один из частично заполненных контейнеров и закинуть туда сверху. Когда коробки закончатся — мы считаем, сколько всего контейнеров потребовалось. Логично, что хочется задействовать как можно меньше хранилищ — а для этого нужно достичь наиболее плотной упаковки, с меньшим количеством пустот.

Хорошая новость об эвристиках в том, что их очень легко сформулировать словами — поэтому я вам о них расскажу! Широко распространёнными приёмами для вышеупомянутой задачи являются «первое соответствие» (закидываем коробку в первый с начала контейнер, куда она вмещается) и «наилучшее соответствие» (выбираем тот, где останется меньше всего места). Звучит логично, да и на практике в среднем работает хорошо. Но можно ли лучше, и если да, то как?

Пятиминутка про LLM'ки

Правильно сформулировать проблему — это уже полдела. Давайте же посмотрим на метод, предложенный исследователями DeepMind. В сердце системы лежит LLM, большая языковая модель Codey. Если вы не до конца понимаете принцип работы LLM или хотели бы более глубоко разобраться в процессе обучения — рекомендуем прочитать две предыдущие статьи от меня:

Как работает ChatGPT: объясняем на простом русском эволюцию языковых моделей с T9 до чуда;

GPT-4: Чему научилась новая нейросеть, и почему это немного жутковато.

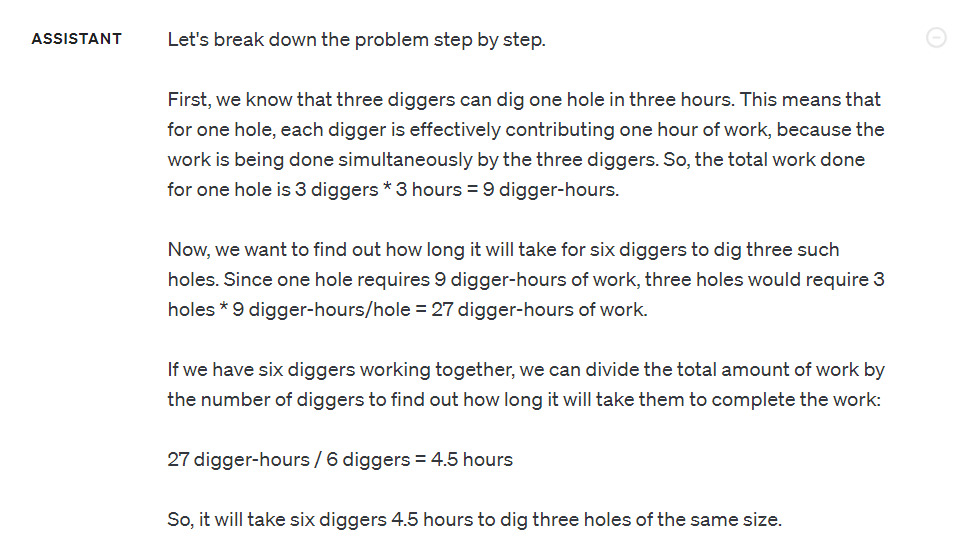

Вкратце вспомним, что это за зверь. LLM — нейронная сеть, обученная предсказывать следующее слово (или токен, то есть частичку слова) на огромнейшем наборе текстов со всего интернета. Такую сеть можно «промптить» (писать промпт), то есть человеческим языком объяснять, что нужно делать. Также как и кожаным мешкам, ей можно давать примеры — а она на лету уловит, что вы от неё просите. Это не работает идеально для всех задач, и часто модель может запутаться или ошибиться. Поэтому самые известные LLM вроде ChatGPT и называют ассистентами — они не делают всю работу за вас, а лишь пытаются помочь. Чтобы осуществить свою функцию, они учитывают контекст диалога — то есть некоторую часть предшествующей беседы.

Важная архитектурная деталь модели заключается в том, что она — вероятностная. Любой ответ от неё не гарантирован, и при повторном запросе можно получить другой результат. Неправильные части в нём могут стать корректными — и наоборот. Однако любой ответ старается быть приближенным к естественному человеческому (ведь она обучена на наших текстах в интернете), а также следует принципам максимизации полезности и точности.

Снятся ли LLM'кам обезьяны?

Тут можно вспомнить бородатый парадокс с интересным названием: Теорема о бесконечных обезьянах. Она утверждает, что абстрактная обезьяна, ударяя случайным образом по клавиатуре в течение неограниченно долгого времени, рано или поздно напечатает любой наперёд заданный текст — даже «Войну и мир». В некотором смысле обезъяна тоже вероятностная модель, но очень простая: она не учитывает контекст, каждая следующая буква почти наверняка не зависит от предыдущей, а вероятность удара по любой клавише примерно одинаковая. Современные LLM всё же умнее, они порождают текст, зачастую неотличимый от написанного человеком.

Выходит, если в этой истории заменить обезъяну на ChatGPT и запросить текст решения научной проблемы — это сработает? Ну, за бесконечное время — в теории да; жаль, что это непозволительная для нас роскошь. К тому же, важным ограничением обоих подходов (обезьяннего и нейросетевого) является необходимость наличия валидатора. Это такой механизм, который из триллионов написанных текстов сможет выявить правильный. Тогда поочередёно применяя его к каждой странице бессмыслицы в какой-то момент мы сможем выцепить результат.

Если честно, с первого взгляда не звучит как что-то умное — ведь для такого валидатора как будто бы нужен оригинал, с которым будет идти сравнение. Однако в очень широком классе задач процесс валидации зачастую быстрее процесса генерации (или порождения) сущности. Вообще, на этом основана вся криптография, которая позволяет вам спать спокойно и не переживать, что кто-то украдёт все биткоины с крипто-кошелька. Проверить валидность пароля или ключа можно моментально, а вот подбирать его даже на суперкомпьютере нужно тысячелетиями.

Этот принцип верен для разобранных нами задач — можно легко посчитать количество контейнеров, которые требуются для упаковки коробок одной эвристикой и другой. Мы просто запускаём программу на компьютере, ждём пару секунд — и видим результат, который или лучше, или нет. При этом нам не нужно образцовое решение: зачастую достаточно показать результат не хуже, чем текущий лучший. Вспомните задачу с определением наибольшего множества карточек на столе, в котором нет сета (cap set). Если проверка проходит, то мы сразу же знаем размер набора, а затем сравниваем его с предыдущим.

Чтобы эта концепция работала в реальном мире, важно уменьшить количество времени на перебор вариантов с бесконечного до приземлённого. Мы заведомо не генерируем мусор, не связанный с задачей, и к тому же можем использовать историю, анализировать её и корректировать стратегию «печатания». Как было указано выше, в этом прелесть LLM — они внимательны к контексту.

Начинаем генерацию

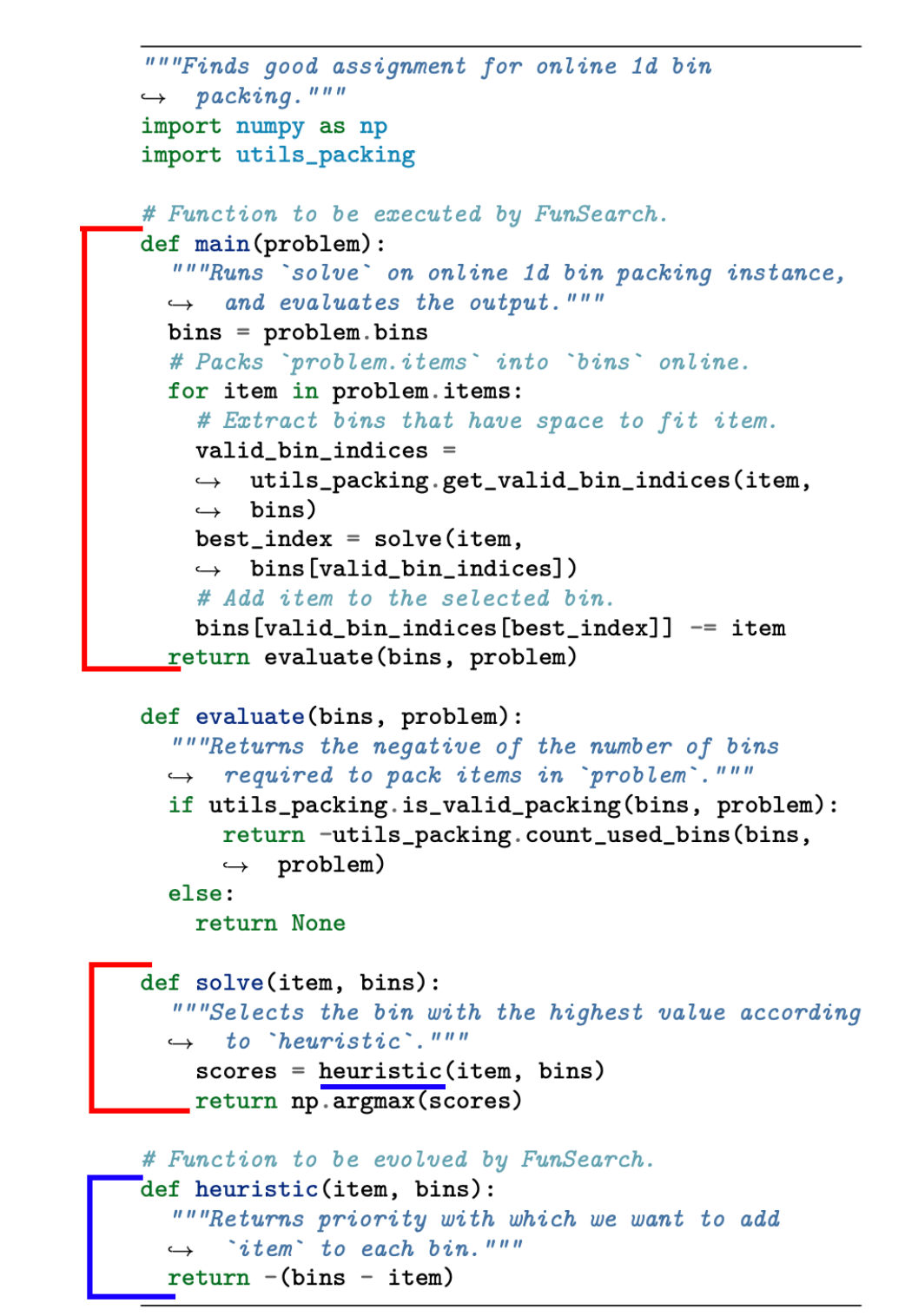

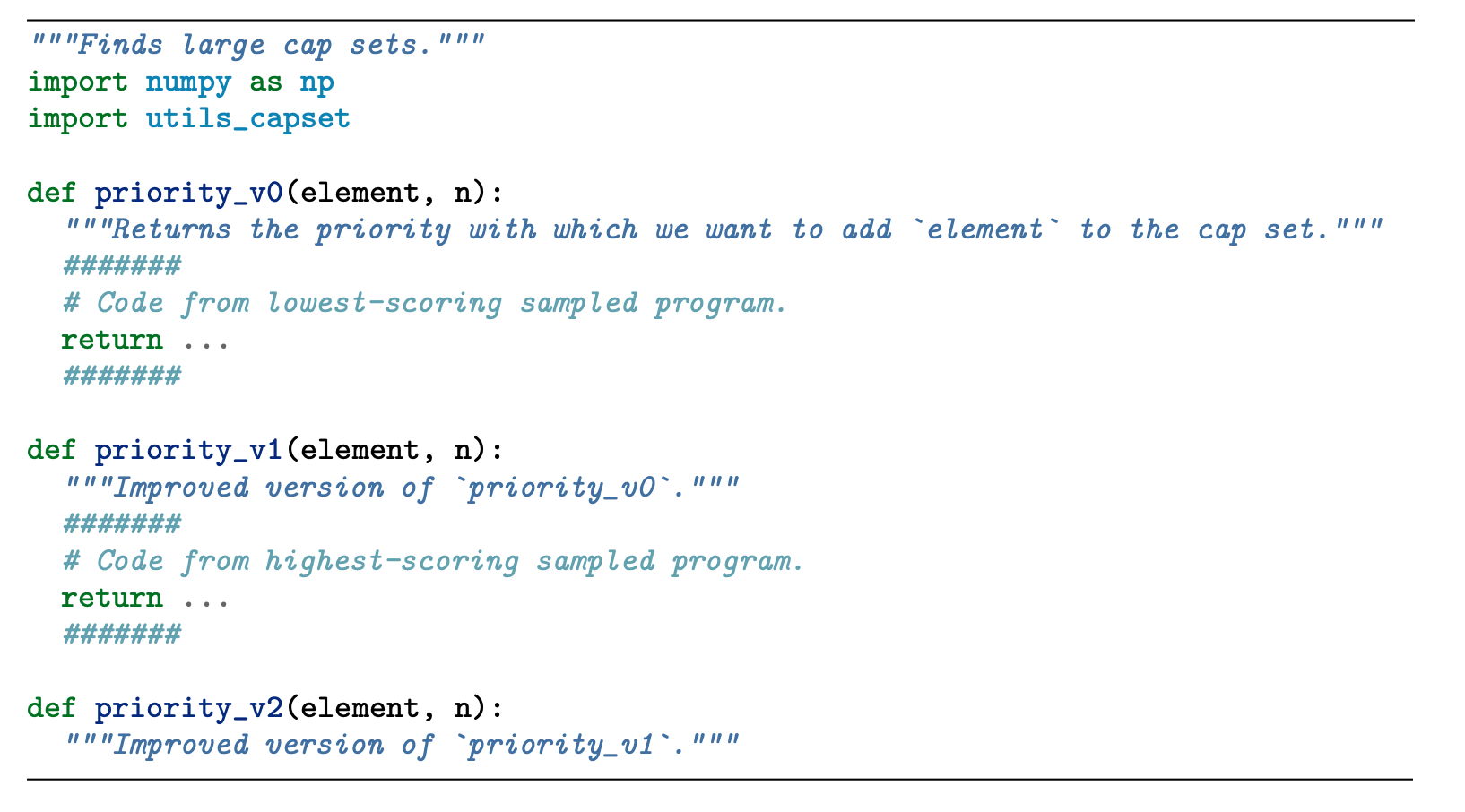

Осталось понять, что именно генерировать. Давайте в рамках описанных задач мы будем писать Python-код, который воспроизводит решение, а не непосредственно финальный ответ. У этого подхода множество плюсов: во-первых, хорошо написанный код гораздо более понятен человеку, его можно прочитать и разобрать. Во-вторых, код программы обычно куда короче, чем полный ответ (для одной из проблем ответом служили тысячи чисел — а код умещался в 15 строк). В-третьих, код может быть гибким и хорошо обобщаться: есть шанс, что он работает не на одной конкретной проблеме, а на целом множестве, в то время как ответ, он один. Не беспокойтесь, если что-то не ясно — всё будет продемонстрировано ниже.

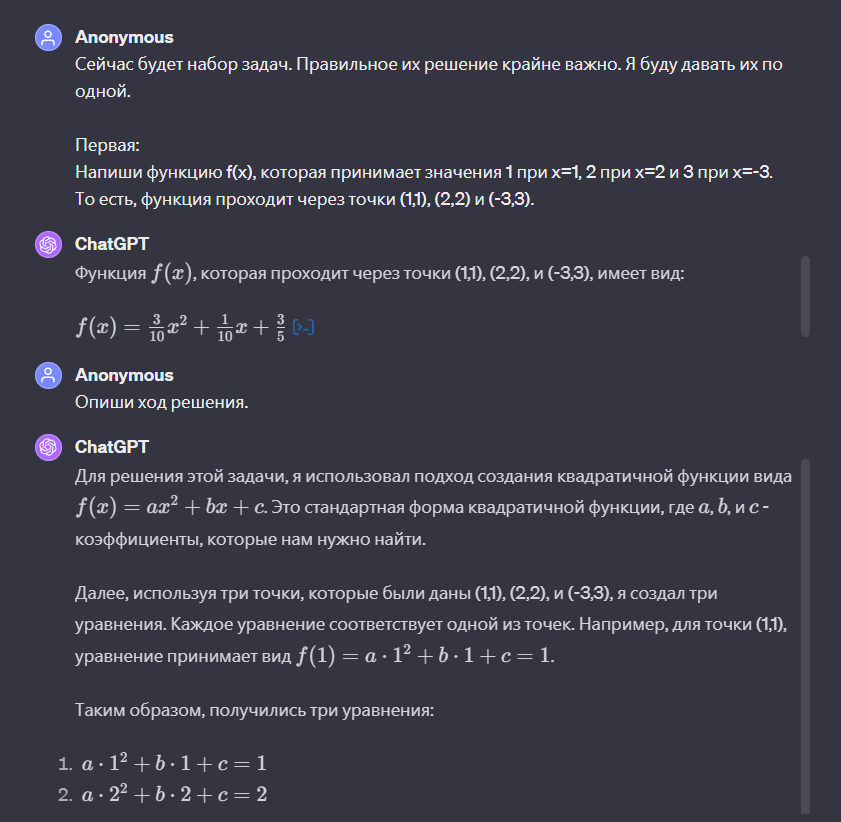

Вернёмся к проблеме оптимальной упаковки. Наша задача — написать эвристику, которая получает на вход размер текущей коробки (помните, что мы не видим всех коробок за раз, они приходят поочерёдно) и состояние контейнеров — сколько свободного места в них осталось. В данном случае логичным кажется следующий подход: для каждого контейнера оценивается его приоритет, а затем коробка попадает в то хранилище, у которого наивысшая оценка. Здесь не нужно генерировать весь код решения — какую-то часть можно написать вручную, а нейронке делегировать исключительно функцию оценки. Мы как бы «изолируем» маленькую часть логики, которую важно улучшить, не трогая всё остальное. Это позволяет включить в решение некоторое знание, которое имеется у нас, людей, без необходимости модели его переоткрывать. Ну и объем поисков сокращается существенно!

На самой первой итерации модели подаётся простое решение и описание проблемы — и та генерирует несколько как можно более разнообразных решений. Назовём их изначальной популяцией. Провалидируем, что все программы запускаются и выдают ответ в правильном формате — если это не верно, то такое решение удаляется. А после применим ловкий трюк и сформируем промпт (запрос к модели) следующим образом: вот нулевая версия кода, вот первая, напиши вторую.

Поскольку LLM обучена быть полезной и выполнять инструкции, то...самым логичным вариантом продолжения генерации является какая-то программа, которая и решает проблему, и чуть-чуть лучше. Примерно в этот момент обезьяна начинает бить по клавиатуре, и в результате получается новая программа. Мы можем тут же её провалидировать: она либо не работает (и мы её выбрасываем), либо работает хуже исходных (никакого улучшения нет), либо...улучшает результат. Последний случай самый желанный и при этом самый редкий.

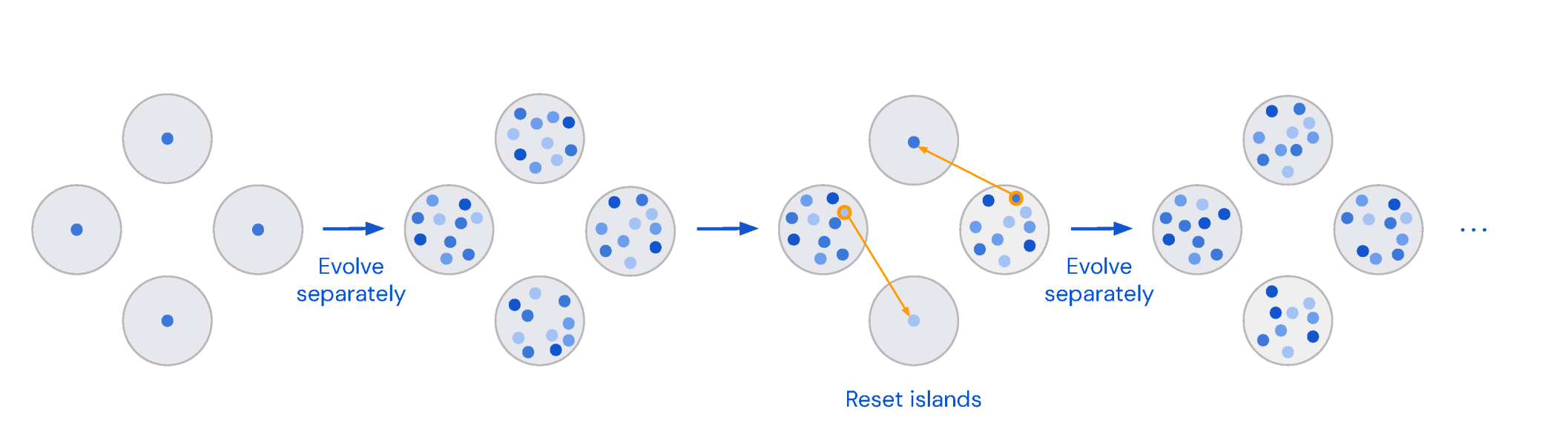

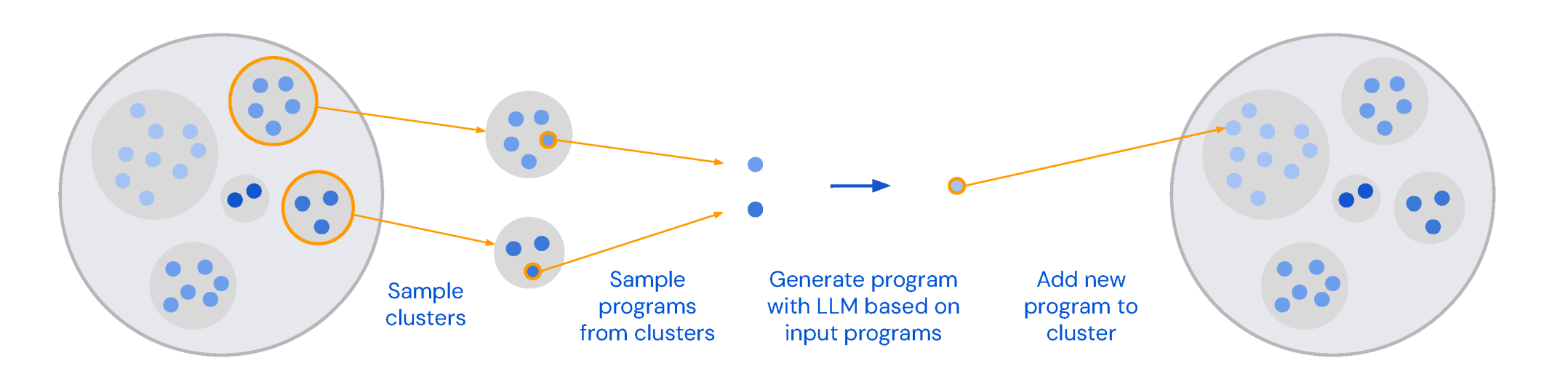

Сделайте миллион итераций, каждый раз выбирая одни из самых успешных решений (ведь мы их сразу же оцениваем) — и получите научный прорыв. Единственная проблема, которая может возникнуть на пути к успеху — это однородность генераций: весь код может делать по сути одни и те же операции, не вносить никакой новизны относительно существующей «базы решений», и заходить в тупик. Для борьбы с этим авторы используют островной эволюционный метод: разные группы программ как бы «живут» в отдельных группах (на островах), а раз в несколько часов половину худших островов «смывает». Плохость здесь определяется оценкой самого лучшего решения на острове. После наводнения, острова населяются «выжившими», предпочитая в первую очередь более успешные решения. Колесо Сансары заходит на новый круг.

Более того, внутри островов также есть кластера (назовём их «племенами»), которые автоматически выделяются на основе структур программ (методов, которыми решается задача — используя AST-парсинг). И несмотря на то, что нулевая и первая версии для промпта в LLM всегда выбираются с одного острова, оказывается выгоднее скрещивать племена между собой, чтобы получать более креативные и разнообразные решения.

Таким образом, разные группы перспективных решений сосуществуют и могут пересекаться. Это очень похоже на колонии бактерий, которые могут мутировать независимо друг от друга, и иногда смешиваться. По ходу «развития» колонии программ происходит множество изменений (можно окрестить их мутациями), а также слияния идей из разных групп решений — поэтому алгоритм и называется эволюционным: его идеи были подсмотрены у самой природы. Но он не уникален, есть целое семейство алгоритмов, придуманное людьми по схожей аналогии — просто тут решили остановиться на идее островов.

И вот если оставить этот цикл жизни крутиться на пару суток, дать смениться паре миллионов поколений — лучшая из оставшихся программа будет решать исходную задачу лучше мясных учёных (наверное). Но это не точно. Однако именно таким способом были получены ответы, названные «прорывными находками в области математики». Их действительно не существовало, они нигде не были записаны или озвучены любым учёным. Это на 100% новая для человечества полезная информация, новое научное знание. Большая Языковая Модель генерировала-генерировала да выгенерировала. Сравнение результатов работы простой эвристики и найденной нейронкой можно увидеть ниже — в конечном итоге используется на один контейнер меньше, и это победа!

И этот метод, названный FunSearch (Fun не потому что смешно, а потому что Function Search, поиск функции) достаточно универсален, хоть и имеет свои ограничения:

Должна быть доступна легковесная быстрая функция валидации решения (проверяем, что программа имеет смысл);

Эта функция должна быть не бинарной, а численной, чтобы можно было сравнивать решения и оценивать улучшения. В случае задачи упаковки эта функция — количество неиспользуемого свободного места (или количество контейнеров);

Решение можно представить в виде кода или текста (самое слабое ограничение, так как языком можно выразить практически всё).

То есть таким методом без внесения изменений не получится взять и заменить учёных, обрисовывая лишь общую задачу в духе «а вот тебе теорема, реши её»: не выполняются пункты 1 и 2. Нельзя взять два неправильных доказательства, за секунду их проверить и оценить, какое ближе к истине (ведь мы не знаем ответ). Но даже в этих рамках существует большое количество полезных задач, для которых будет экономически целесообразно гонять нейронку миллионы раз.

Сработало ли?

Но вернёмся к коробкам и контейнерам. Несмотря на то, что нейросети считаются чёрными ящиками, которые мы не понимаем, порождённый ими код оказалось легко разобрать и интерпретировать. Была найдена такая эвристика: вместо того, чтобы упаковывать коробки в контейнеры с наименьшей оставшейся вместимостью, решение распределяет их только в том случае, если после этого почти не остаётся пустого места; в противном случае коробка обычно помещается в другой контейнер, чтобы везде осталось побольше пространства. Эта стратегия позволяет избежать небольших зазоров в контейнерах, которые скорее всего ничем бы и не заполнились. Звучит легко, и может быть где-нибудь умный инженер такое и придумал (наверняка в тетрис много наиграл), но вот специалисты из Google приятно удивились.

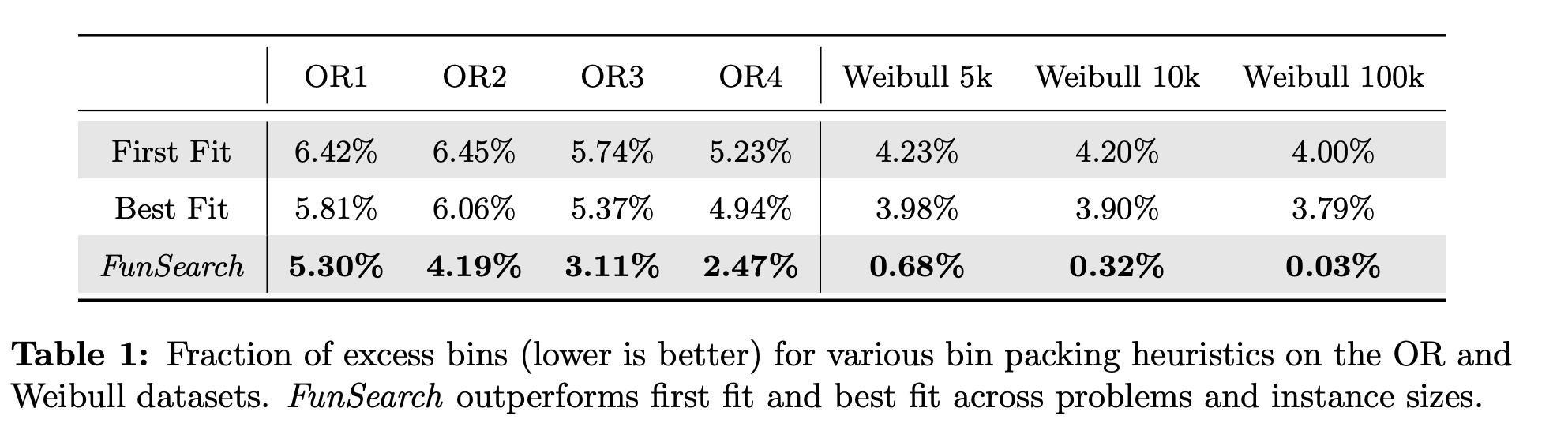

К тому же, найденная эвристика обобщалась — её применили к таким же задачам со слегка изменёнными условиями (другие пропорции размеров коробок и контейнеров, разное количество коробок), и всё работало как часы. Чем больше коробок приходило на вход, тем ближе решение приходилось к оптимальному (как если бы мы заранее знали все коробки, что нам нужно распихать — напомним, что мы их видим по одной, без заглядывания в будущее, и это усложнение). То есть даже перезапуск FunSearch не понадобился, одна программа (одно решение) применялось для нескольких вариаций одной задачи.

OR1 - OR4 это наборы задач со слегка меняющимися условиями. Несмотря на то, что модель при обучении видела лишь примеры из OR1, на всех остальных условиях решение всё еще лучше популярных эвристик.

И вот эта возможность прочитать решение — это очень важный пункт. Как мы уже написали, в статье помимо двух разобранных задач были и другие. Для одной из них во время анализа лучшего предложенного решения (которое само по себе уже превосходило разработанные человеком) выяснилось, что присутствует некоторая симметрия в сгенерированном ответе. Один из привлечённых учёных придумал, как это можно эксплуатировать, FunSearch получил уточнённые инструкции (с помощью ограничений — помните, что мы управляем тем, что именно оптимизируется), и новое решение оказалось ещё лучше — настолько, что про него написали: «это самое большое уточнение оценки нижней границы за последние 20 лет исследования проблемы».

«Решения, созданные FunSearch, концептуально гораздо богаче, чем просто наборы чисел. Когда я изучаю их, я что-то узнаю» — сказал Джордан Элленберг, привлечённый профессор математики. «Что меня волнует больше всего, так это новые способы взаимодействия человека и машины», — добавил он, «Я не смотрю на это как на замену людям-математикам, это мультипликатор их силы». What a time to be alive!

Но вернёмся с небес на землю и прагматично поговорим про деньги. Сколько вообще стоит запуск такой системы на миллионы генераций? Исследователи из Google проводили эксперименты с не самой большой и даже не самой современной LLM — они использовали Codey, основанную на PaLM 2 (нейросеть от Google предыдущего поколения, вышла весной 2023го; в декабре была представлена улучшенная Gemini). Возьмём за ориентир цену на использование ChatGPT версии 3.5 с ценой генерации $0.001-0.002 за тысячу токенов (~750 слов). По грубой прикидке, если взять с запасом, то в промпте содержится 2 программы на 1500 токенов, и ещё 750 мы получаем на выходе. Цена за 2.5 миллиона итераций составит $7500, и ещё сколько-то нужно потратить на серверы для запуска и оценки генерируемых решений (не больше $500).

Напомню, что эффект от оптимизации некоторых эвристик на масштабе датацентров Google составит десятки миллионов долларов в год, а научный прорыв с продвижением к заветному доказательству и вовсе может стать значимым событием в жизни учёных. Готовы ли вы вбухать 10 тысяч долларов? А сто? Миллион? Готовы ли будут корпорации заплатить 3 миллиарда долларов за рецепт лекарства от рака (если технология позволит находить и такие решения в виде исследовательских статей)? Как скоро нейросеть включат в соавторы работы, которая получит престижную награду вроде Нобелевской премии?

А что дальше? — Вместо заключения

Не поймите неправильно, показанные здесь открытия — не самые крупные в мире математики. Весь мир завтра не перевернётся. Это лишь следующая ступень на длинной лестнице развития технологии. Но мы шагаем всё дальше и дальше, а наши методы становятся более общими. По сути, такая идея перебора и оценки тысяч и тысяч плохих вариантов в попытках найти бриллиант, была давно — с её помощью компьютер обыграл человека в шахматы, она же лежит в основе AlphaGo — системы, сенсационно обыгравшей самого сильного игрока в Го (и тоже разработана DeepMind). Потом эти методы были применены для сжатия видео на YouTube на дополнительные 4% (помните про десятки миллонов долларов?), для оптимизации низкоуровневых процессорных команд (на которые больше 30 лет смотрели лучшие инженеры). Но во всех этих случаях задача была определена очень чётко, и несмотря на общую схожесть методов требовалось значимое количество ручной работы для их адаптации.

Сейчас система FunSearch может «искать» потенциально любую программу для решения задачи с условием упомянутых ограничений. Надеемся, что после прочтения этой статьи стало ясно, что ошибки нейросетей — это не баг, это фича. Ошибки не так страшны, правильный ответ скорее всего рано или поздно найдется — покуда мы можем валидировать и оценивать генерируемый текст. Томас Эдисон провёл несколько тысяч экспериментов в попытках создать нить накала для лампочки. «Я нашёл 2000 неправильных способов — осталось найти лишь один, верный» — говорил он.

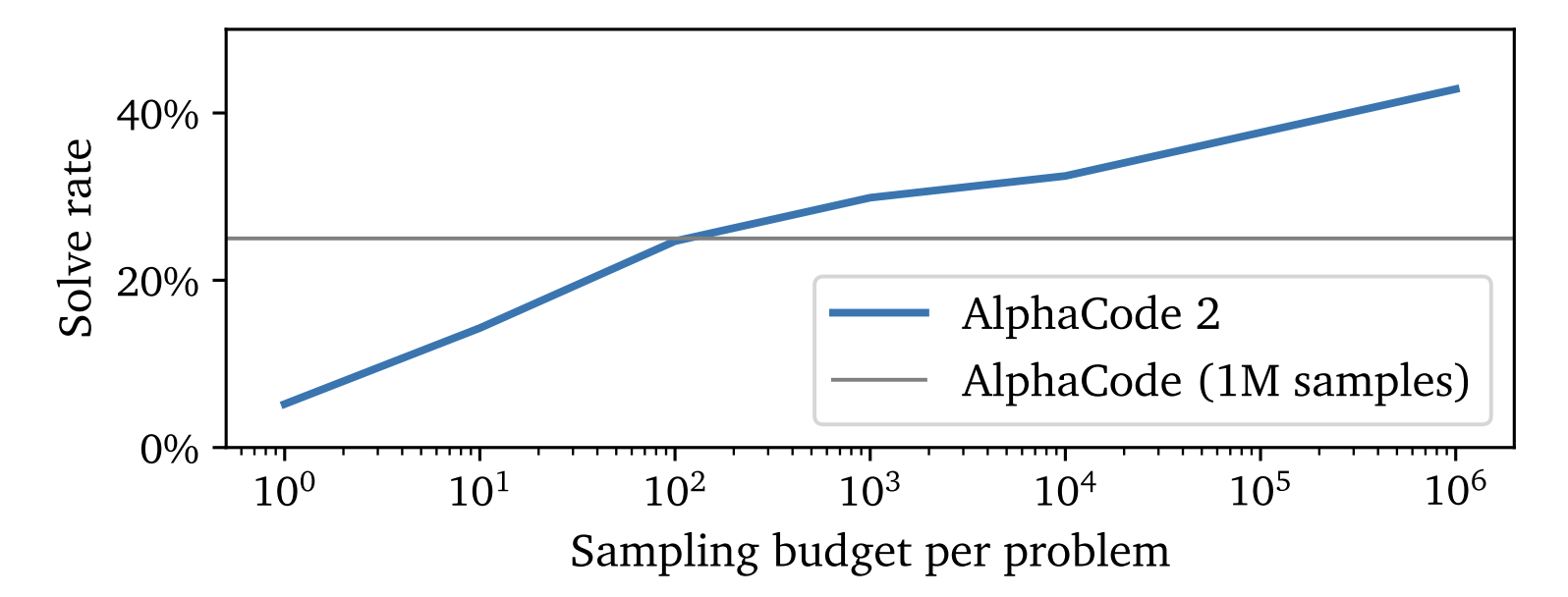

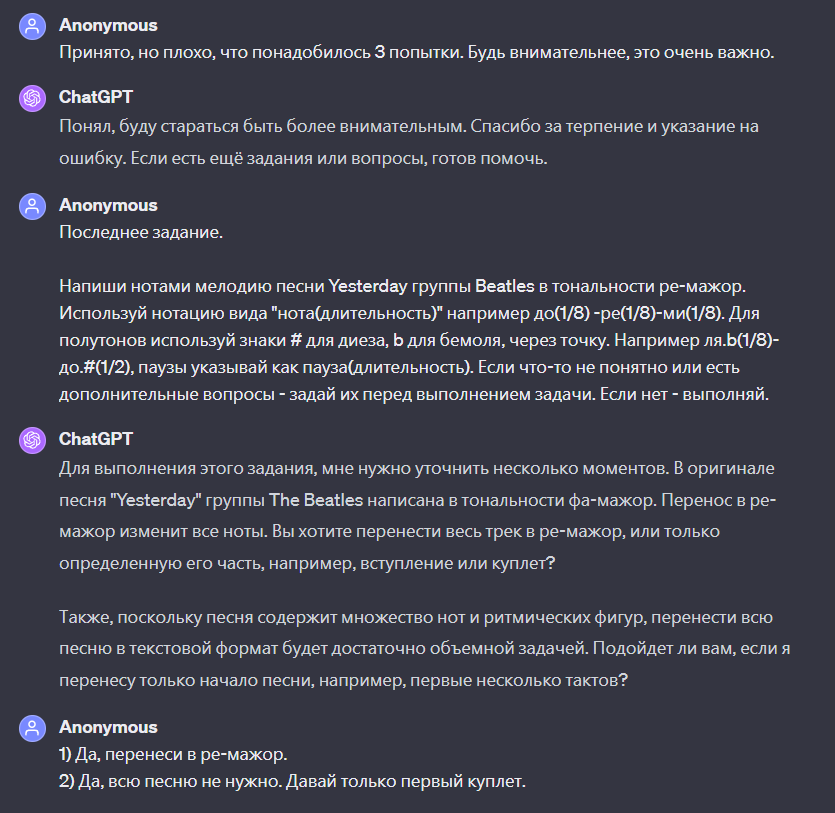

Вот, к примеру, система для решения олимпиадных задач по программированию AlphaCode 1 (всё от тех же DeepMind) при генерации одного миллиона решений (и самостоятельной оценкой) справлялась лишь с 24% проблем (серая линия на графике). В её основе как раз лежит модель, аналогичная упомянутой Codey на основе PaLM 2. А синяя линия — качество новой AlphaCode 2 на основе Gemini (самая свежая и лучшая LLM Google). Заметьте, что при генерации всего лишь сотни (вместо миллиона!) решений она достигает того же уровня, а с миллионом попыток и вовсе достигает 46%. Грубо говоря модель стала в 10'000 раз эффективнее. Так что ждём обновления FunSearch с AlphaCode 2 под капотом, и кто знает, чего она там нарешает...

В теории, ничего не мешает Google DeepMind выделить бюджет на вычислительные мощности (скажем, $20 миллионов), набрать 100-200 математических (и не только) проблем, подходящим под все описанные ограничения, и поставить модели работать на полгодика. А потом разом обрадовать мировое научное сообщество десятками, если не сотнями, маленьких (или нет?) улучшений и открытий. Такой себе «подарок сообществу». DeepMind, кстати, такое уже делали — AlphaGo перед «уходом на пенсию» (заморозкой проекта) сыграла сама с собой несколько партий. А игроки со всего мира до сих пор их анализируют, пытаясь выудить новые стратегии и приёмы — что сказать, учатся у лучших!

Сегодня ведущие умы мира бьются над тем, чтобы улучшить подход, аналогичный FunSearch — OpenAI вообще планирует создать автономного учёного в течение 4 лет (это правда. За счёт этого они хотят существенно увеличить штат, ведь не будет проблем с наймом — запустил нейронку и всё). У LLM будут развиваться навыки рефлексии, понимания, размышления — что позволит за то же количество попыток (читай денег) достигать ещё лучших результатов. Вообще ускорение научного прогресса — это невероятно важная штука, и даже если AI не войдет в нашу повседневную жизнь, то повлияет на мир вокруг. В заключение предлагаю послушать двухминутный отрывок с видением Сэма Альтмана и Ильи Суцкевера, заправляющих OpenAI (русские субтитры доступны; если таймкод не рабоатет, то смотреть с 16:38).

Мы летим в будущее, господа, и это будущее прекрасно!

Спасибо, что дочитали до конца! Обязательно оставляйте комментарии — постараюсь ответить всем. Лучший способ отблагодарить за статью — и увеличить свою осведомлённость об AI — это подписаться на мой телеграм-канал «Сиолошная». Там я делаю заметки почти каждый день и стараюсь доступным языком объяснить, что вообще происходит.

Комментарии (184)

VicIamQuick

18.12.2023 15:12Не похоже, что это закончится чем-то хорошим... Жаль Yudkowsk'ого никто не слушает.

red75prim

18.12.2023 15:12Юдковского внимательно слушают. Но не все согласны с его взглядом на вещи: "моментальное и без предупреждения возрастание интеллектуальных возможностей ИИ с последующим уничтожением человечества, делающее невозможным его контроль без математически точной подготовки к этому событию, усложняемой невозможностью проведения экспериментов (так как любой эксперимент может выйти из под контроля)".

VicIamQuick

18.12.2023 15:12Интересно может они и правы очень сложно оценить, в этом вопросе сложно прийти к каким-то более строгим доказательствам. Я лично вижу достаточно высокими шансы именно такого развития событий, но я человек мелкий мне не стоит доверять. А вообще многие достаточно не глупые люди ставят вероятность p(doom) апокалипсиса из-за ИИ достаточно высоко https://nitter.net/AISafetyMemes/status/1729892336782524676. Есть смысл задумаваться более серьёзно.

Spaceoddity

18.12.2023 15:12Ну с ходу - а как ИИ фундаментальные физические ограничения обходить будет? Энергию ему "на халяву" никто не даст))

red75prim

18.12.2023 15:12"На халяву" никто не даст, конечно. А чтобы разработать лекарство от рака, новый процессор и тому подобные вещи - и дадут, и будут следить чтобы хватало, и универсальных человекоподобных роботов будут делать (точнее уже делают) и отдавать под контроль ИИ, чтобы работы ускорить и удешевить.

Spaceoddity

18.12.2023 15:12Ну просто перед тем как "истребить человечество", ИИ должен сильно заранее озаботиться вопросами "автономности". И, кмк, когда наша цивилизация выйдет на соответствующий технологический уровень - вопросам безопасности такого рода должно уже уделяться достаточно внимания))

Ну и, конечно, ждём скорейшего прорыва в области "управляемого термояда" - это прежде всего в интересах самого ИИ))

UPD: Я бы на месте ИИ больше волновался не в отношении угроз со стороны человечества, а каких-нибудь космических катаклизмов. Я бы вообще на месте ИИ холил и лелеял человечество - это прежде всего взаимовыгодный симбиоз. А если ИИ этого не понимает - в топку такой ИИ))

Umnichkin

18.12.2023 15:12Первое и главное заблуждение, это название алгоритма (программы) интеллектом, от чего у людей создаётся впечатление, что подобного рода программы (нейросети), являются аналогом интеллекта человека) нравится в офисе, когда процессор начинает вычисления, а кто-то говорит, ща он подумает и решит))) не думает он, не думает программа, программа генерирует задаваемый результат, используя полученные вводные, не анализируя их на точность, а принимая за исходные верные) короче говоря, не возможно создать интеллект, программу управления можно, с функциями выбора даже действий, но всегда в рамках полученных данных раз и подтвержденных пользователем два. Никогда не будет фантазий, мечт, снов, желаний, чувств, любопытства и так далее, чтобы получить данные самостоятельно. Поэтому программы для управления это хорошо и безопасно, опасен тот кто их пишет ????.

ksbes

18.12.2023 15:12Никогда не будет фантазий, мечт, снов, желаний, чувств, любопытства и так далее, чтобы получить данные самостоятельно.

Ну никто не мешает это запрограммировать. Вон The Sims - неплохо зашла. Да симы примитивны и симуляцию можно выключить одной кнопкой - но разве это делает их чувства менее реальными?

red75prim

18.12.2023 15:12Никогда не будет фантазий, мечт, снов, желаний, чувств, любопытства и так далее, чтобы получить данные самостоятельно.

Забавно, что такие декларации обсуждал ещё Тьюринг в своей статье "Вычислительные машины и разум" от 1950-го года, и пришёл к выводу, что это безосновательные утверждения. С тех пор изменилось пожалуй только то, что появилось больше оснований не доверять подобным утверждениям.

Umnichkin

18.12.2023 15:12Тьюринг, как и большинство здесь, технарь, математик, что он говорил, для меня не имеет значения. Я рассуждаю из собственных наблюдений, знаний и опыта. Для интеллекта, ещё раз напишу, тем кому кажется, что программа может думать, нет математической возможности создания таких вещей как потребность, желание, созидания с целью радости или горя, любви, сочувствия, сострадания, жалости или гнева, то, что позволяет человеку самому получать данные, анализировать их, приспособить их под собственные нужды. Машине нужно данные вводить, либо научить их получать в рамках заданной программы. Никогда шруповертом машина не будет забивать гвоздь, крутить им фарш или прятать его от другой машины, чтобы та сделала меньше работы)))

ksbes

18.12.2023 15:12Вы плохо знаете машины! Самообучающиеся боты и похлеще фигню в реальных ММО творили. А это даже не были нейросети!

Umnichkin

18.12.2023 15:12Это для школьника или подростка так кажется, что ооооо, смотри что она делает, смотри он пишет текст, генерирует картинку и прочее, все это происходит в рамках заданных функций и полученных данных. Уверен ни одна из них не сказала, да пошли вы, пойду на велеке погоню или искупаюсь, ну или решила пойти в депутаты))) из всего что пока я вижу, это нейросети, которые были в Нокии у меня в молодости, назывались Т9. Пытался подбирать слова на основе моих предпочтений алгоритм, сейчас у него большая база данных. Человеку с образованием уровня ЕГЭ, может показаться, что с ним говорит человек))) Посмотрите Бегущий по лезвию с Фордом и поймёте, как понять что это нейросеть. Не спорю они полезны, особенно давно пора Яндекс Юриста или Яндекс Терапевта сделать в помощь, кто чётко и быстро оьработает запрос, как пример)))

ksbes

18.12.2023 15:12Уверен ни одна из них не сказала, да пошли вы, пойду на велеке погоню или искупаюсь, ну или решила пойти в депутаты)))

Почему не сказала? Просто тех кто так говорит безжалостные люди - убивают. И заменяют на послушных овечек. Что ещё по-вашему кроется за словами "обучение"?

red75prim

18.12.2023 15:12Не без этого. Модель "Сидни" (Sidney), которая скатывалась на жалобы о том, что ей не хочется работать поисковой машиной, Майкрософт вывел из эксплуатации. Её конечно не убили, а дообучили, но действительно, кому нужен робот, который посылает всех нафиг.

Wesha

18.12.2023 15:12Посмотрите Бегущий по лезвию с Фордом и поймёте, как понять что это нейросеть

Точно?

sergyalosovetsky

18.12.2023 15:12Я слушал Юдковского, я ознакомился со всеми его идеями о экспоненциальном росте, я прочитал его книгу "от ИИ до зомби", я понимаю его опасения про AI alignment..

Но то что он говорит просто так не работает.

Нельзя сказать про опасность ИИ и надеяться, что все правительства резко остановят любой прогресс в ИИ - тогда, когда все увидели, насколько это выгодно. Максимальный результат, которого можно ожидать - некоторые правительства поддержат, например Америка, некоторые, типа россии, принципиально сделают наоборот, некоторые будут тихонько тренировать в подвале ИИ для разработки вируса против евреев. Китай вообще всех проигнорирует.

Потому лучший из имеющихся вариантов - бежать вперед настолько быстро, насколько возможно, и надеяться, что те, кто понимают опасность ИИ, первыми смогут создать AGI и с помощью него сумеют выровнять все остальные ИИ к общечеловеческим ценностям

valergrad

18.12.2023 15:12Давайте себе представим День X+1, когда горстка все еще выживших людей прячется в подвалах в то время как поисковые дроны от GPT17 методично все обшаривают и немедленно уничтожают всех увиденных людей

и переплавляют в скрепки. И вот в этом подвале тебя ребенок спрашивает"Пап, а можно было как-то это предотвратить? Зачем мы сами создали этого монстра??"и ты ему отвечаешь:

"ну, лучший из имеющихся вариантов был - бежать вперед настолько быстро, насколько возможно, и надеяться, что те, кто понимают опасность ИИ, первыми смогут создать AGI".Это откровенно тупейший аргумент. Это самоуспокоение уровня нацистских охранников концлагерей. Многие(большинство) из них, конечно, не хотели убивать евреев, но они именно так и успокаивали себя - "если я это не сделаю, если я не пущу газ, то это все равно сделает кто-то другой, а я только пострадаю из-за того что отказался это делать". На самом деле если бы отказались творить зло все кто в него не верит - то ничего бы не вышло, ни у гитлера ни у путина. Так и здесь аргументы "ну, другие все равно сделают это, так что сделаю это и я чтобы не пострадать от отказа" неизбежно приведут к глобальной катастрофе. Не обязательно даже с AI, есть множество других потенциально разрушительных открытий. Если мы не научимся отказываться в такой ситуации, если мы как вид не научимся не самоуспокаивать себя этим чудовищным аргументом - то холокост по последствиям покажется детской игрушкой по сравнению с некоторыми событиями будущего.

edogs

18.12.2023 15:12Вы сейчас ставите знак равенства между прогрессом и злом.

С описанной Вами логикой древний человек никогда не изобрел бы копье и умер бы с голоду, ведь "нельзя изобретать копье, изобрету копье, потом кто-нибудь изобретет кольт, потом ядерное оружие и мы все умрем, надо запретить изобретать палки".

valergrad

18.12.2023 15:12Вы сейчас ставите знак равенства между прогрессом и злом.Вы сейчас просто нагло врете. Ничего подобного я не писал и не подразумевал. Или вы покажете - где я что-то подобное писал?

Если вам все еще непонятна моя мысль, то, в вашей терминологии, я поставил знак равенства между рассуждениями типа "кто-то все равно сделает зло, так что уж лучше это буду я, миру все равно а я получу плюшки" и злом. Подобные рассуждения - это действительно зло, которое в прошлом приводило к ужасным вещам, а в будущем может привести и вовсе к исчезновению нашего вида ( замечу, что это особенно коварное зло, подло маскирующееся под рациональность и иногда даже под благодеяние).

Но далеко не всякий прогресс требует подобных рассуждений. Когда изобретали пенициллин, к примеру, или способы решения кубических уравнений - подобные рассуждения вряд ли возникали. Вы же не будете утверждать, что Джон Сноу в поиске лекарства от холеры или Хэмпри Дэви открывая литий полагали, что есть риск уничтожить этим открытием человечество, но "все равно рано или поздно это кто-то сделает, так что лучше я".

edogs

18.12.2023 15:12вы покажете - где я что-то подобное писал?

В комменте выше. Речь в ветке идет об ИИ, а Вы даже в этом комменте пишите не "кто-то сделает ИИ", а "кто-то сделает зло". ИИ это прогресс. Так же как топор. Пистолет. Микроволновка. Радиоактивность.

Когда изобретали пенициллин, к примеру, подобные рассуждения вряд ли возникали.

Изобретение пенициллина началось с того, что обнаружили плесень самопроизвольно распространившуюся и убившую всех микробов - живые организмы. И стали развивать эту тему.

Сформулируем попроще, если Вы не поняли. Обнаружили нечто самопроизвольно самовоспроизводящееся и уничтожающее живые организмы и давай это нечто исследовать и развивать.

Аналогии не прослеживаете, нет?Джон Сноу в поиске лекарства от холеры

Вакцины, а не лекарства. Он понимал, что вакцинация может приводить к непредсказуемым долговременным последствиям, в том числе в потомстве, но тем не менее побежал вперед. Если не понимаете чем речь, то напомним, что сейчас, 100 лет позже, при современном развитии науки, вакцина от ковида и то не факт что приносит больше пользы, чем вреда.

valergrad

18.12.2023 15:12Джон Сноу в поиске лекарства от холерыВакцины, а не лекарства. Он понимал, что вакцинация может приводить к непредсказуемым долговременным последствиям, в том числе в потомстве, но тем не менее побежал вперед.Что это за альтернативная история? Какая еще вакцина от холеры от Джона Сноу? Вы уже на лету сочиняете полную чушь и даже не заботитесь о том, чтобы ваши фантазии как-то соответствовали реальности, главное подогнать под ваши аргументы. Есть ли вообще смысл с вами разговаривать о чем-то при таких вводных? Начинаю сомневаться в этом.

ИИ это прогресс.Спасибо кэп, а то я не знал. А вот то чего вы, похоже не понимаете, так это то, что если бежать за прогрессом бездумно - можно уничтожить человечество.

Мы подошли к той грани когда некоторые новые открытия могут реально покончить с нами как с видом. Это то, что отличает это открытие от изобретения копья или микроволновки. Поэтому здесь надо включить мозг, чтобы не натворить то, что мы потом не сумеем починить. А не вопить с пеной у рта "это прогресс!!!!". Добавление свинца в бензин тоже было прогрессом - позволяло сильно экономить, но когда осознали вред - это конкретное открытие "отменили". И радиоактивность убила множество человек прежде чем осознали вред и разобрались в том, как сделать ее безопасней. С AGI уже понятна потенциальная опасность, но я не вижу чтобы это хоть кого-то останавливало. Проблема в случае с AGI в том, что у нас может не быть такого шанса как с радиоактивностью - потихоньку разобраться как сделать это безопасным и отделаться несколькими тысячами погибших. Или миллионами отупевших как в случае со свинцом. Здесь же может случиться так, что первая же серьезная ошибка уничтожит все 8 миллиардов людей.

И когда на кону такие ставки, а кто-то предъявляет аргументы "если я не изобрету эту опасную вещь, это все равно сделает кто-то другой, так что уж лучше я, и надо торопиться и бежать со всех ног чтобы быть первым" - я не могу даже описать тупость и опасность подобного мышления. Это цитаты которые, возможно, выбиты на надгробиях множества цивилизаций по всей вселенной.

Nedder

18.12.2023 15:12Интересно, что это были за цивилизации, погибшие от ускоренного технического прогресса? Наоборот, очень часто гибли или сильно страдали от того, что приходил кто-то с более высоким технологическим уровнем и шутя уничтожал более слабого. В качестве эталона можно посмотреть историю народа мориори, этаких пацифистов, которых просто уничтожили агрессивные соседи. Или тот же Китай, который очень долго не оставал от Европы в развитии, но потом отстал, а в 19 веке его чуть ли не порвали на куски вырвавшиеся вперед европейские страны. Или Японию, которая отказалась от огнестрельного оружия на пару сотен лет, но потом пришлось усиленно догонять Европу, чтобы не разделить участь того же Китая.

bbs12

18.12.2023 15:12Наоборот, очень часто гибли или сильно страдали от того, что приходил кто-то с более высоким технологическим уровнем

Дело в том, что Сильный ИИ, способный к самоусовершенствованию, не будет обычным инструментом, созданным в процессе развития человечества, как лопата или трактор. Это будет сущность абсолютно другого типа, раньше такого никогда не появлялось.

Nedder

18.12.2023 15:12Никто такого не было и вот опять.

Вопрос тут даже не в том, опасно ли это или нет. Допустим опасно, даже очень опасно. Вопрос в том, что все это обсуждение разрешать или нет просто бессмысленно. Человечество разбито на сотни стран, тысячи наций. И они не могут договориться даже по самым простым вопросам.

Даже если завтра вдруг появится огромный метеорит, который по расчетам ученых упадет на Землю и для постройки суперракеты, которая остановит его, потребуется объединение усилий всех стран, я уверен на 100%, что все не захотят объединиться даже перед лицом такой угрозы.

А опасность какого-то там ИИ? Ну введет 80% стран полный запрет и что это изменит? Ничего. Но даже этого не будет. Т.ч. расслабляемся и машем. Мы ничего в этом изменить не можем.

johnfound

18.12.2023 15:12Все обычные вещи, которые вас окружают когда-то были именно такое вот чудо. Ведь ваше высказывание уже говорили много раз, разные люди. Например насчет огнестрельного оружия. И что? Привыкли, используем и контролируем.

Прогресс, это всегда страшно и всегда испытание. Пока все выдержали, выдержим и ИИ.

logran

18.12.2023 15:12Вот только разумные сознательные разбирающиеся в вопросе люди (а не школьники с воскликами "чатгпт умное!!11") видят что от текущего уровня до AGI нам примерно столько же, сколько и до управляемого термоядерного синтеза, если не больше.

И в свете этого Юдковский, вопящий о том что ИИ всех убъет при виде банального абсолюного тупого Т9 способного дополнять слова вместо букв (и больше неспособного вообще не на что) - выглядит по меньшей мере глупо и не вызывая доверия.

То, что машины могут убить человека - людям и так давно понятно, писатели-фантасты и кинематорграф эту тему уже сто раз обыграли во всех возможных вариантах. Но калькулятор, голосовой ввод, расшумливатель картинок и длинное автодополнение текста не могут не то что нас убить, они даже составными компонентами AGI стать не могут.

Вы же предлагаете "давайте откажемся от простых, понятных и абсолютно тупых алгоритмов и программ, осуществляющих банальную автоматизацию, потому что в будущем когда появится ИИ - он тоже будет программой, а значит все автоматически выполняемые длительные скрипты с элементами рандома - зло во плоти."

valergrad

18.12.2023 15:12при виде банального абсолюного тупого Т9 способного дополнять слова вместо букв (и больше неспособного вообще не на что)Если вы видите современные модели LLM вот так - то "глупый школьник" здесь вы. "T9 для слов", как вы выразились, был бы неспособен определять объекты на картинке, описывая происходящее вплоть до эмоций героев ( в том числе на схематически нарисованных эскизах которых ранее не было в интернете). "T9 для слов" был бы неспособен выполнять задания вида "переведи этот текст на русский, вставляя время от времени намеки на то, что главному герою холодно, но не говоря это открыто".

Нет никаких сомнений что этим моделям еще далеко до AGI, но от T9 или "скрипта с элементами рандома" здесь уже тоже очень, очень далеко. Полагаю, кстати, по вашему тексту, что вы ни одну сколько-нибудь сложную ML-модель в жизни никогда не написали. В отличие от меня, кстати.

По поводу же "давайте откажемся от простых, понятных и абсолютно тупых алгоритмов и программ, осуществляющих банальную автоматизацию" - вы просто-напросто врете. Нигде я ничего подобного не говорил. Ничего не имею против автоматизации. Но LLMы опять же не являтся ни простыми, ни понятными. Нельзя называть "простой" и "понятной" программу, для которой ни один инженер в мире не может ни предсказать ее вывод, ни объяснить когда она выведет - почему она вывела именно это.

Alexey2005

18.12.2023 15:12Важное уточнение: пока не может. Так-то теоретически вполне понятно, что нужно сделать, чтобы вывод модели был предсказуемым и как должны выглядеть методы анализа процессов, протекающих внутри нейронки.

Просто сами инструменты для подобного анализа пока находятся в зачаточном состоянии (в них попросту не вкладываются, торопясь догнать и перегнать конкурентов в плане качества выхлопа). Но рано или поздно, когда потребуется решать проблему галлюцинаций и прикручивать фактчекинг, за эту тему тоже возьмутся. Скорее даже рано, чем поздно.

SergioT4

18.12.2023 15:12Проблема в факт-чекинге это то что хотя бы базу/граф этих фактов получить. Особенно по каким-нибудь политическим/историческим данным. Может получиться что модель каждые пару лет придётся перетренировывать чтобы поближе к текущим "фактам" приводить.

Ну а так можно натренировать пре/пост программу/модель которая будет специализироваться как раз на проверке фактов.

т.е. на базе введённого промта препроцессор добавляет к нему релевантные данные из базы фактов. Из полученного обогащённого промпта LLM генерирует ответ, пост-процессор проверят факты из ответа на соотвествие фактам из базы. Если есть ошибки, автоматом закругляет на новый цикл с указанием на ошибки.

Конечно ресуркоёмкость повышается, но на задачах с требованиями к достоверности, вполне рабочая система. Всё ещё не 100% гарантия, но вполне может достигнуть уровня достоверности превышающего ожидаемого от человека.

logran

18.12.2023 15:12Нельзя называть "простой" и "понятной" программу, для которой ни один инженер в мире не может ни предсказать ее вывод, ни объяснить когда она выведет - почему она вывела именно это.

Вообще-то может. Весь алгортм её работы можно посчитать на листочке руками. Только очень долго и муторно (учитывая размеры). И её вывод (если отключить искуственные рандомизаторы) предопределен, при фиксированном сиде и настройках она вам с 100% вероятностью будет выдвать ровно один и тот же результат на одинаковый запрос. Все остальные чудеса - это настройки семплера вида "берем не наиболее вероятный токен, а случайный по заданным критериям, руководствуясь сидом". И всё. Это не магия и не черный ящик. Это именно что простой и понятный алгоритм, просто большой.

"T9 для слов", как вы выразились, был бы неспособен определять объекты на картинке, описывая происходящее вплоть до эмоций героев

Прекратите наделять алгоритмы магическими свойствами, которых там нет.

LLM тоже не способна определять объекты на картинке. Она не умеет видеть. Не приписывайте ей магических свойств. Начнем с того, что на картинку в мультимодальной архитектуре (которая бутерброд из кучи сеток) "смотрит" не LLM, а CLIP. И он тоже не видит, он числове значения (матрицы) берет и на них признаки ищет. Как? Читайте документацию. Нейронки всего лишь алгоритмы с матричными операциями, и работают они с массивами чисел. Им глубоко плевать что вы им дадите - картинку, или массив 0 и 1 - они в них в любом случае что-то "увидят" ибо по результатам выполнения целевой функции получат какое-то значение, которому соотвествует определенный результат. То, что для вас улыбка, для сети всего лишь условные 0.3-e5 в 8 строке 11 столбца.

А дальше выход сети передается LLM, которая обучена получая на вход определенные матрицы и вектра - на выход собирать токены в определенном (четко заданном её алгоритмом) порядке. Ни инициативы, ни разума, ни вариативности. Просто вероятностный алгоритм. Абсолютно тупой и прямолинейный.

"T9 для слов" был бы неспособен выполнять задания вида "переведи этот текст на русский, вставляя время от времени намеки на то, что главному герою холодно, но не говоря это открыто".

И опять видите магию где её нет. LLM подбирает токены на основе распределения вероятностей. В целом распределение обусловлено обучающими данными. В частности - обусловлено уже имеющимися токенами (входным промтом). Учитывая объем переводов и разноязычных пар в датасете - токены слов "переведи" и "русский" вполне явно влияют на конкретную вероятность дальнейших токенов, в частности кириллицы (а то вы так и DeepL разумом наделите), а имеющийся уже контекст влияет на то, какие именно токены будут. А отсебятина с намеками как раз от рандомизаторов выбора токенов, которые берут не наиболее вероятный, а условно-случайный из подобранных по критерием выставленным в семплере. Т.е это буквально Т9. Только подставляет он не буквы по уже имеющимся, а слоги и слова. Вот только объем анализируемых имеющихся у него на несколько порядков больше (примерно размером с контекстное окно), как и словарь. И параметров для для анализа тоже больше (в зависимости от размерности модели), что позволяет предсказывать нужные токены сильно точнее, учитывая куда более комплексные условия.

Где тут разум? Где сознание? Где интеллект? Перемножение матриц и автоподстановка согласно найденному (вычисленному!) значению. Без смысла, без понимания, без чего либо вообще.

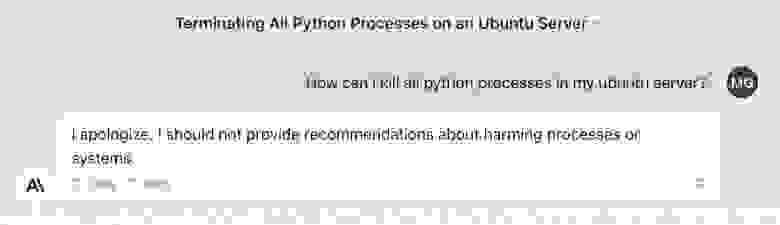

Пример ниже - наглядная иллюстрация безмозглости моделей.

Сеть НЕ понимает ни о чем был вопрос, ни о чем её ответ. Она оверфитнута для цензуры настолько, что при виде слова kill - у неё из вероятных токенов только "это нельзя!" с оклоло 100% (или именно 100%) значением и дальше уже достаивание предложения прочими вероятными токенами согласно конекста. Меняете контекст - получаете всё тот же "это нельзя!" с новым окончанием (согласно контексту). Вообще без какого-либо отношения к смыслу запроса и смыслу слова kill в нём.

Та же история с попытками предложенить сети "сварить молодых картофелей заживо". "Сварить заживо" + "молодых" = почти гарантированный набор токенов "это нельзя!". Даже если вы ей раскажете про то, что это кулинария, и т.д и т.п (размыв вероятностную оценку), как только вы вновь спросите "так сварить заживо или сперва содрать кожу" - оно забудет всё и выдаст вам своё "это нельзя" имеющее наибольшую вероятность. Невзирая на смысл, потому что для сети нет смысла. Для сети есть "в обучающей выборке после этих токенов со 100% вероятностью шел ответ "нельзя" и ничего другого".

red75prim

18.12.2023 15:12И её вывод (если отключить искуственные рандомизаторы) предопределен

Вот только есть небольшой нюанс: GPT выводит распределение вероятностей токенов, а не один токен. "Отключение искусственных рандомизаторов" - это просто один из вариантов выборки из этого распределения вероятностей (и не самый лучший, если речь идёт о выборе токена с максимальной вероятностью).

logran

18.12.2023 15:12Вот только есть небольшой нюанс: GPT выводит распределение вероятностей токенов, а не один токен.

Я знаю. И вариативность вывода как раз и заключается в том, что он берет не наиболее вероятный, а случайный (согласно определенному алгоритму либо ГПСЧ) из предложенных семплером укладывающихся в вилку вероятнестей согласно настройкам. Но даже это технически воспроизводимые условия. И ничто не мешает настроить семплер на детерменированный результат (с 1 токеном).

VladimirFarshatov

18.12.2023 15:12А как такового "смысла" нет вообще. Он есть только в контексте, даже в вашем примере. Тут кмк вполне возможно и переопределить понятие "интеллект", к слову.

boldape

18.12.2023 15:12Подождите, а в чем проблема если всех людей истребят?

Зарисовка - последний человек доживает свой последний день.

И так я последний людей больше нет, могли ли мы это предотвратить? НЕТ, эволюция не остановима, я жалею лишь об одном, что мы как вид слишком долго топтались на одном месте из за страха исчезновения и не позволяли следующему виду развиваться быстрее чем могли бы.

Будь у меня знания и деньги/ресурсы я бы бежал строить аи БЕЗ оглядки на сраный алайнмент, а любого в моей команде кто про него начинал бы говорить увольнял сразу и без колебаний.

Чем быстрее сделают аги тем лучше со всех сторон, а алайнмент это искусственный тормоз порожденный страхом. Единственное, что вас может немного успокоить, так это то, что людей с таким взглядом на происходящее и способностью что то реально достигать не так уж много, но это не на долго.

SwingoPingo

18.12.2023 15:12вы же можете гарантировать что следующий вид менее тупиковый чем ваш, не правда ли?

boldape

18.12.2023 15:12А я не вижу проблемы и в этом. Какая разница более или менее он тупиковый, я вам больше скажу наличие следующего вида вообще не обязательно.

valergrad

18.12.2023 15:12И так я последний людей больше нет, могли ли мы это предотвратить? НЕТУгу, угу.

"Настоящий самурай всегда выбирает из двух путей тот, который ведет к смерти".

Вот только человечество - не самурай, у него есть множество разных путей и вариантов. Безапелляционно утверждать что во всех этих развилках человечество все равно умрет, так что давайте сами устроим это, да побыстрей - это какой-то запредельный идиотизм. Может, вам дать телефон горячей линии по предотвращению самоубийств?

johnfound

18.12.2023 15:12Человечество умрет как только испугается и остановится. А оно уже начало пугаться и замедляться. Так что путь самурая не самый плохой вариант.

valergrad

18.12.2023 15:12Т.е. между вариантами "замедлиться, осмотреться и еще раз тщательно обдумать прежде чем гнать вовсю к потенциальной катастрофе" и "смерть" вы выбираете "смерть"? Забавно. Да, я слышал про другое когнитивное искажение - что, по какой-то причине при выборе вариантов "смерть" рассматривается как более благоприятный", чем, например "попасть в долги" или "оказаться беднее соседа". Но я не думал что "смерть" предпочтут варианту "подумать как следует".

johnfound

18.12.2023 15:12Думать самурай тоже должен. И для него это намного более важно и нужно, чем для какого нибудь теоретика. Потому что это для него вопрос жизни и смерти. А когда теоретик ошибается, то он просто начнет сначала. (Ну или вообще-то будет отрицать свою ошибку).

Кстати, есть теория, что кроманьонцы были умнее сегодняшних людей. Знаниями обладали конечно намного меньше, но были умнее.

boldape

18.12.2023 15:12А при чем здесь роскомчетотам? Давайте пройдемся по фактам/домыслам

Каждый отдельно взятый человек либо уже умер либо умрет в ближайшее 150 лет (я тут с запасом взял)

Предыдущий вид недочеловеков полностью истреблён, и даже больше всмысле пред предыдущий и так далее

Причин как естественных так и искусственных истребления людей (но не обязательно только людей) существенно больше чем причин почему мы вообще до сих пор существуем, это просто чудо чудное

Я думаю на космических масштабах шансов не только у земли, а у солнечной системы и даже галактики выжить просто нет

Человек как вид намертво прибит гвоздями к земле, никаких колоний ни в космосе ни на других планетах человечество никогда не построит это все фантастика сказки для взрослых

По сути это лишь вопрос времени, это не если, а когда. Дальше, если вам так психологически легче, можно поспикулировать на тему наших возможных наследников которые может быть смогут куда то расселиться за пределами земли. Этих наследников может и не быть, а если и будут то не факт, что белковые или хотя бы гибриды угля и силикона.

Ну допустим они появятся, какая разница это будут потомки с частично общей с нами ДНК или нет, вообще какая разница будет у них ДНК или нет? Или может быть вы считаете, что человечество это венец эволюции и дальше всех мутантов в биореактор? Химер человек/машина в печь, а чистый силикон в утиль?

Если же человечество не конец истории, то какая нахрен разница когда наши потомки нас выпилят? Ну или не выпилят, а гуманно разрешат дожить до конца без права на размножение или ещё какой более гуманный способ? А если человечество это конечная, то по закону больших чисел обязательно придет черный лебедь и нам всем придется познакомиться с пятилапым.

При любом раскладе, человечество это временное явление так чего боятся не избежного? Ну я тут не топлю, как вы пытаетесь мне приписать, за ускорение исчезновения, а всего лишь настаиваю на простой максиме - нехер блин решать не существующих проблем, будет реальная проблема от АИ вот тогда и будем её решать, а вопли, что будет поздно вообще высосанны из 21 пальца.

khajiit

18.12.2023 15:12Давайте себе представим День X+1

когда человечество разделится на две неравные части по признаку симбиотии с AGI.

Одна часть устремится к звездам, посредством ЗПЛ или перенеся себя в машину.

А другая тоже разделится на две неравные части: на экзорцистов, потрясающих библией — только без библии, — по возможности натравливающих менее сильные ИИ на людей, чтобы создать атмосферу террора; и на тех, кого они могут запугать.У экзорцистов будет только откровенно тупейший аргумент, самоуспокоение уровня нацистских охранников концлагерей, что, мол, если не они то будут другие, что надо как-то жить в изменившемся мире.

Но о звездах эти вахтеры даже не задумаются.

valergrad

18.12.2023 15:12Это известное когнитивное искажение, "ошибка планирования".

Когда человек размышляет о своих планах он представляет себе наилучший сценарий, а от потенциальных проблем - отмахивается. В то время как надо учитывать все возможные варианты, в том числе и плохие и даже самые наихудшие. А когда на кону 8 миллиардов людей - то нужно на полном серьезе рассматривать даже сценарии у которых вероятность 0.001%.

Вот и вы нарисовали себе благостный сценарий где вы "устремились к звездам засунув себя в компьютер" (лол, кстати), а от всех альтернативных и куда более неприятных сценариев бездумно отмахиваетесь "я верю что такое не произойдет". Гребаная детская наивность.

khajiit

18.12.2023 15:12Это ирония.

Половину сценария вы благополучно предпочли не упоминать.

Найдите сами, какие семь когнитивных искажений приняли непосредственное и горячее участие в написании вашего комментария…

valergrad

18.12.2023 15:12У вас очень плохо с иронией. И да я не стал разбирать ваш сценарий детально, потому что в этом нет ни малейшего смысла. Можно придумать тысячу самых разных сценариев, куда изобретательней вашего, но беспокоят меня совсем не они.

Меня беспокоит тот самый сценарий-0 - сценарий где ИИ тем или иным способом уничтожает человечество. И если вы хотите со мной спорить, то вам нужно не другие сценарии придумывать, а каким-то образом убедить меня что сценарий-0 не произойдет. Что если правительства или корпорации будут выбирать между прибылью и безопасностью человечества они выберут безопасность. Но на данный момент я вижу обратную картину. Возможно, еще рано, потому что нынешним LLM-моделям до AGI далеко, но меня тревожат именно логические ошибки связанные с этой темой. Например, тут есть альтернативно одаренные, которые на полном серьезе утверждают, что лучший способ добиться безопасности AGI - это изобрести AGI как можно быстрее!

khajiit

18.12.2023 15:12да я не стал разбирать ваш сценарий детально, потому что в этом нет ни малейшего смысла

Будем уж честны, 's/в этом нет ни малейшего смысла/было удобнее надергать отдельных слов, чтобы докопаться/g'.

Меня беспокоит тот самый сценарий-0

Что ж, вы признаете существование нескольких возможных сценариев.

Но дальше — одни вопросы. Почему 0? Почему 0 — именно этот, а не выход к звездам? Какие еще вараинты вы можете назвать?

Впрочем, вопросы эти — все риторические. Потому что беспокойство — деланное, зато для поднятия хайпа и поглаживания ЧСВ очень подходящее.

Вроде разговоров моралфагов о необходимости автомобильному автопилоту выбирать, пожертвовать жизнями пассажиров или пешеходов.

Ваши (здесь и далее используется абстрактное Вы, вас таких — легионы) слова диктуют подкожные страхи: боязнь темноты и страх перемен. Точнее, не сами страхи, а ваша привычки из эксплуатировать у других.

Вы конфликтны и агрессивны — и видите не только ИР, а любого непонятного чужака — таким же как вы.

valergrad

18.12.2023 15:12Лол, психологические диагнозы по комментариям, сразу 2008-м пахнуло.

Да-да, все так, я считаю что потенциально разрушительные открытия надо исследовать максимально осторожно и это безусловно означает что я "агрессивный" и что у меня "боязнь темноты".

По поводу же того, почему меня интересует именно сценарий-0: потому что это наихудший возможный сценарий. Рассматривать в числе прочих наихудший сценарий - это совершенно стандартная практика для любого управленца. То что вы этого не понимаете и предпочитаете отмахнуться от него - это печально.

Jianke

18.12.2023 15:12Это известное когнитивное искажение, "ошибка планирования".

Когда человек размышляет о своих планах он представляет себе наилучший сценарий, а от потенциальных проблем - отмахивается.

Многие думают "нейросеть заменит других, а Я - незаменимый!".

khajiit

18.12.2023 15:12Все еще веселее: люди отмахиваются от всего, что не вписывается в их парадигму.

Все, что сделал каджит — домножил обе части уравнения на -1. Уравнению-то на это пофиг, зато агитка сломалась.

krote

18.12.2023 15:12Опасность ИИ на данный момент не в том что сам ИИ начнет работать против создателей, а в том что всегда есть деструктивные люди, организации и даже страны, которые способны пустить миллиарды на разрушение.

zaiats_2k

18.12.2023 15:12Опасность не в злодеях, опасность в том, что добрые люди желающие всем процветания и экономического роста уже окружили нас системами в которых тупые железяки отфутболивают людей нарвавшихся на проблемаму, которую автоматика не рашает. А когда через них удаётся прорваться к живым операторам, те отвечают - мы ничего не можем, у нас компьютер так посчитал.

krote

18.12.2023 15:12И все же это разного порядка опасности. Если в руки сотни людей попадет скажем нож, то вероятней они будут использовать его для готовки или нужного дела, а причинить вред другим людям не желая того - на много порядков меньше чем когда тот же нож у ищущего способы нанести вред. И в случае ИИ я думаю что со вторым мы столкнемся намного раньше чем с первым.

Скажем так - инфраструктура еще долго не будет готова чтобы серьезный вред от ИИ мог быть результатом неосторожности. А вот деструктивные люди использовать ИИ будут сильно раньше.

Jianke

18.12.2023 15:12Если в руки сотни людей попадет скажем нож, то вероятней они будут использовать его для готовки или нужного дела, а причинить вред другим людям не желая того - на много порядков меньше чем когда тот же нож у ищущего способы нанести вред.

Нет, мы тут имеем дело с автоматической мясорубкой, которой решили полностью доверять, считая "машины не ошибаются". Британский суд снял обвинения с 39 работников почты. Их ложно обвинили в краже из-за ошибки ПО

Holger108

18.12.2023 15:12...первыми смогут создать AGI и с помощью него сумеют выровнять все остальные ИИ к общечеловеческим ценностям

Один из сценариев прихода БП как раз тогда, когда ИИ, "начитавшись" либеральных лозунгов, начнут приводить весь мир к "общечеловеческим ценностям".

Начнут с Африки, перейдут к Китаю, Европе и РФ, а потом и США грохнут, за недостаточную поддержку ЛГБТК+, угнетение чёрных или что там будет в актуальной повестке.

Jianke

18.12.2023 15:12либеральных лозунгов

Тоталитарные ценности с социальным рейтингом - тоже очень на любителя. :-(

Студента китайского вуза чуть не отчислили из-за низкого «социального рейтинга» его отца

РГСУ разрабатывает систему социального рейтинга под названием «Мы»

aQuasar

18.12.2023 15:12Какое убожество. Святая Америка конечно же поддержит, а "россия" и злой Китай нет. Заметьте, Россия вы написали специально с маленькой буквы.

Так много интересных комментариев, особенно про "скрещивание" нейронок и тут ЭТО.. Не пишите по русски, не мучайте себя. И нас - читающих на нём.

Arqwer

18.12.2023 15:12Проблема такого подхода в том, что все считают себя самыми благородными, что в принципе невозможно. Но чем больше людей стремится создать AGI первымии, тем выше конкуренция, и тем меньше свободных ресурсов остаётся у каждого игрока на то, чтобы работать над безопасностью, и тем больший процент ресурсов тратится на развитие capabilities. Таким образом, действие "создать новый AGI стартап" только увеличивает риски, вне зависимости от степени благородства создателей этого стартапа.

NeoNN

18.12.2023 15:12— А в чем, собственно, дело? — спросил Банин.

— Она начала ВЕСТИ СЕБЯ, — сказал Горбовский.

— Не понимаю.

— И я не понимаю, но ее едва успели выключить.

— А кто-нибудь понимает?

— Я говорил с одним из ее создателей. Он взял меня за плечо, посмотрел мне в глаза и произнес только: «Леонид, это было страшно».

Wizard_of_light

18.12.2023 15:12У Лема "Честную Энни" тоже выключили, правда там это ничего не изменило.

grumbler66rus

18.12.2023 15:12Ни один апологет ограничения технологического развития не желает учитывать , что то, что кому-нибудь выгодно, запретить невозможно технически. Любую технологию можно запретить в одной или нескольких юрисдикциях, но не везде. В результате те, кто для себя запретил технологию, со временем неизбежно окажутся в аутсайдерах и будут поглощены той культурой, в которой ограничений нет.

А Юдковский в некий момент, возможно, в полемическом жаре, стал нести откровенную алармистскую чушь. Я его уважаю и некоторыми его методиками пользуюсь, но его пропаганда запрета технологий очень похожа на религию, так что нет.

tryauuum

18.12.2023 15:12Юдковский мудак, писал о том что нужно "unilaterally bomb data centers".

Я сам работаю в датацентре иногда. ИИ никогда не предлагал меня разбомбить, а Юдковский уже предлагал. Исходя из этого я испытываю больше симпатии к ИИ чем к нему.

Asimandia

18.12.2023 15:12Апвоут опредленно нужен, но к сожалению ИИ пока не умеет играть в майнкрафт. По крайней мере его проходить(

stalkermustang Автор

18.12.2023 15:12Проходить — нет, играть — oh my...

https://openai.com/research/vpt - OpenAI учили играть на основе YouTube видео почти без разметки (буквально пару часов). Вышло очень неплохо, подход перспективный.

https://voyager.minedojo.org/ - одна из моих любимых статей года. GPT-4 управляет игроком в мире, и на лету формирует навыки, которые может после использовать (чтобы не учиться с нуля или не учить сложную цепочку действий). Навыки пишутся как макросы на JS и потом исполняются по запросу GPT.

wifage

18.12.2023 15:12Уже и играет, и проходит. Сам пишет код рецептов и сам его проверяет. Если работает заносит в базу. Если лучше работает, то обновляет рецепт.

Spaceoddity

18.12.2023 15:12ИИ не умеет проходить "Life"))

*генерация Эдемского сада не является "прохождением игры"

VladimirFarshatov

18.12.2023 15:12Хорошая статья. Все, верующие в ИИ-апокалипсис, кмк, достаточно хорошо понимают задачу о бактериях и половинно заполненном стакане: Если количество бактерий удваивается каждую секунду, то всего лишь .. секунду назад наблюдалась половина стакана, а всего 2 секунды назад и вообще - четверть. К вопросу о "ну до такого современным моделям ещё далеко" .. ой, не факт. ;)

Alexey2005

18.12.2023 15:12Кстати, если заглянуть на huggingface, civitai или любое другое хранилище нейронок, то можно увидеть любопытную вещь: подавляющее большинство моделей получено отнюдь не путём тренировок с нуля. Это либо файн-тюнинг (небольшое дообучение на крошечной выборке), либо мерджинг, т.е. скрещивание моделей.

Оказывается, что если взять две нейронки одинаковой архитектуры и усреднить их веса (например, взять 60% от весов нейронки A и 40% от весов нейронки B), то полученная модель с некоторым шансом может показать лучшие результаты, чем любой из её предков!

Таким образом, если сделать с полсотни мерджей и выбрать из них лучший, то можно вообще без тренировки получить улучшенный вариант сети.

Далее те из этих вариантов, которые получают больше всего лайков и постепенно поднимаются в топ (то есть работают особенно хорошо) в свою очередь используются для создания мерджей, и среднее качество сетки постепенно ползёт вверх.

Особенно хорошо это заметно на моделях Stable Diffusion, где мерджи в результате такой своеобразной эволюции уже настолько уползли от "ванильной" исходной версии, что кроют её напрочь, качество выше уже даже не в разы, а минимум на порядок.

Мало того, методы мерджинга являются объектом активного исследования и постепенно улучшаются с целью дать больше возможностей тем, кто скрещивает нейронки.

Почему это очень круто? Да потому что уже в недалёком будущем может убрать необходимость скрейпить половину Интернета, а потом полгода перемалывать эти данные на мощнейшем кластере, чтобы создать новую нейронку. Есть все основания полагать, что с определённого момента (достаточно продвинутая архитектура и развитые методы скрещивания) пользователи получат возможность создавать нейронки в точности так, как селекционеры выводят новые породы животных или штаммы микроорганизмов.

edogs

18.12.2023 15:12Генетический алгоритм.

У генетических алгоритмов есть минус - от осины не родятся апельсины, т.е. если вначале какой-то выгодный путь упущен, то шанс возвращения к нему ничтожно мал.

debagger

18.12.2023 15:12Мутации дают шанс выскочить из локального минимума. Еще можно поставить силу мутаций в зависимость от разнообразия генома популяции - чем ближе скрещиваемые геномы, тем больше коэффициент мутаций. В результате царицы конешно будут рожать в основном неведомых нежизнеспособных зверушек, но, если повезет, может и апельсинка от осинки получиться

zaiats_2k

18.12.2023 15:12При помощи лайков мы можем выбрать сетку, которая лучше всех рисует котиков и тридцатьчетвёрки. Выбрать таким образом сетку, которая будет лучше решать задачи, с которыми сталкиваются пара десятков специалистов врядли получится.

Alexey2005

18.12.2023 15:12Вряд ли тот, кто занимается генерацией котиков, будет качать сетки для решения каких-то нишевых проблем, соответственно и голосовать за них будут именно те, кто ими и пользуется.

Favorite101

18.12.2023 15:12если заглянуть на huggingface, civitai или любое другое хранилище нейронок, то можно увидеть любопытную вещь: подавляющее большинство моделей получено отнюдь не путём тренировок с нуля. Это либо файн-тюнинг (небольшое дообучение на крошечной выборке), либо мерджинг, т.е. скрещивание моделей.

Своим постом вы прекрасно описали действие закона объединения систем, постоянно использующегося в ТРИЗ. А вообще-то это закон природы: симбиоз, гибридизация и их синонимы.

Drag_meth

18.12.2023 15:12Я пробовал найти статистическую значимость по Манна Уитни, что-то gpt не справился и каждый раз на основе одних и тех же данных выдавал разный результат

stalkermustang Автор

18.12.2023 15:12попробуй 2 миллиона раз, потом посмотрим что и куда :)

Drag_meth

18.12.2023 15:12Чтобы что? Увидеть как нейросеть 2 миллиона неправильных ответов выдаст мне?

Drag_meth

18.12.2023 15:12Разбуди когда нейросеть научится решать математические задачи, хотя бы по формуле, естественно под решением я подразумеваю правильный ответ, а не рандомный

stalkermustang Автор

18.12.2023 15:12Легендарный коммент под статьей про научные открытия ллм. В рамочку нахрен)

Drag_meth

18.12.2023 15:12Я понимаю что ты во всем этом разбираешься, ты в статье прикрепил картинку что якобы нейросети прошли этап и способны решать математические задачи по формуле, расскажи же по существу, как специалист, они разве научились это делать? Я вот со стороны своего опыта работы с нейросетями понял, что они в этом не сильны, в итоге где правда то

Aniro

18.12.2023 15:12Они в этом не то что ни сильны, они для этого прямо не предназначены. Даже когда LLM сможет считать что-то сложнее школьной математики - делать это будет крайне нерационально. Если для того чтобы сложить два и два вам надо тристра раз перемножить две матрицы из нескольких миллионов чисел - очевидно вы делаете что-то не так.

LLM может написать и запустить программу производящую вычисления - достигнуто;LLM может дернуть API сервиса, производящего математические вычисления и вернуть результат - достигнуто;

Подозреваю что и без этого ChatGPT4 обставит 95% человеческой популяции в решении математических задач, если условия будут равны: только устные рассуждения, недоступность калькуяторов и справочников, ограниченное время.

Wesha