Компания Facebook опубликовала информацию о работе компании по борьбе с дезинформацией. Из документа следует, что только за апрель на платформе было обнаружено 50 млн постов с дезинформацией о коронавирусе. Обнаружение и удаление дезинформации, касающейся коронавируса, стало одним из основных приоритетов в работе систем модерации Facebook в последнее время.

«В апреле мы поместили предупредительные метки примерно на 50 млн единиц контента, связанного с COVID-19. Когда люди видят эти предупреждающие надписи, в 95% случаев они не переходят на просмотр исходного контента. Мы также удалили сотни тысяч единиц дезинформации, которые могут привести к ущербу», — заявляют в компании.

Facebook пытается активно использовать ИИ в процессе определения дезинформации, однако сталкивается с трудностями, пишет TechCrunch. На фото ниже первый кадр — оригинальное изображение, второй — скриншот, а третий кадр похож на первый, но с противоположным смыслом. Искусственный интеллект может как заметить небольшие различия и оценить изображения как совершенно разные, так и решить, что они одинаковые, из-за их визуального сходства. Если человек увидит различия сразу, то обучить этому алгоритм очень сложно.

Ещё одна проблема, с которой сталкивается Facebook, это разжигание ненависти и хейтспич.

«Мы определяем хейтспич как жестокие и оскорбительные комментарии, заявления о неполноценности, призывы к сегрегации на основе определённых характеристик — например, расы, этнической и религиозной принадлежности, сексуальной ориентации, пола, гендерной идентичности, инвалидности или заболевания», — поясняют в компании.

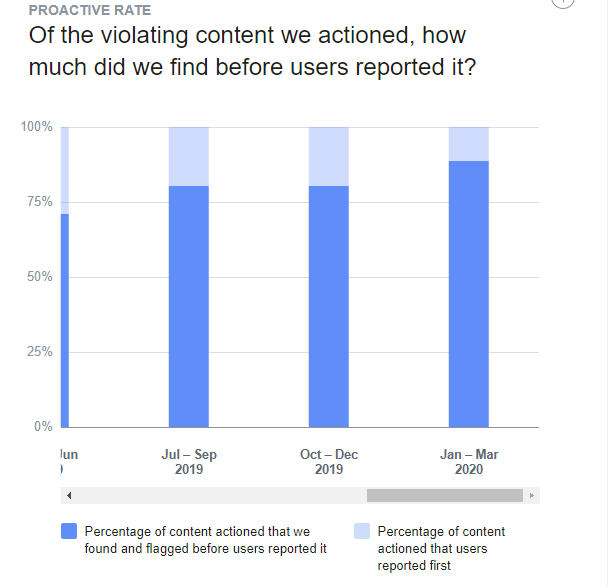

В первом квартале 2020 года компания удалила 9,6 млн единиц контента, который был определён как оскорбительный или ненавистнический. Для сравнения, в четвёртом квартиле 2019 года было удалено 5,7 млн единиц контента, в третьем — 7 млн. Из 9,6 млн удалённых постов алгоритмы Facebook обнаружили 88,8% раньше, чем о них сообщили пользователи. Это на 86% больше, чем в предыдущем квартале.

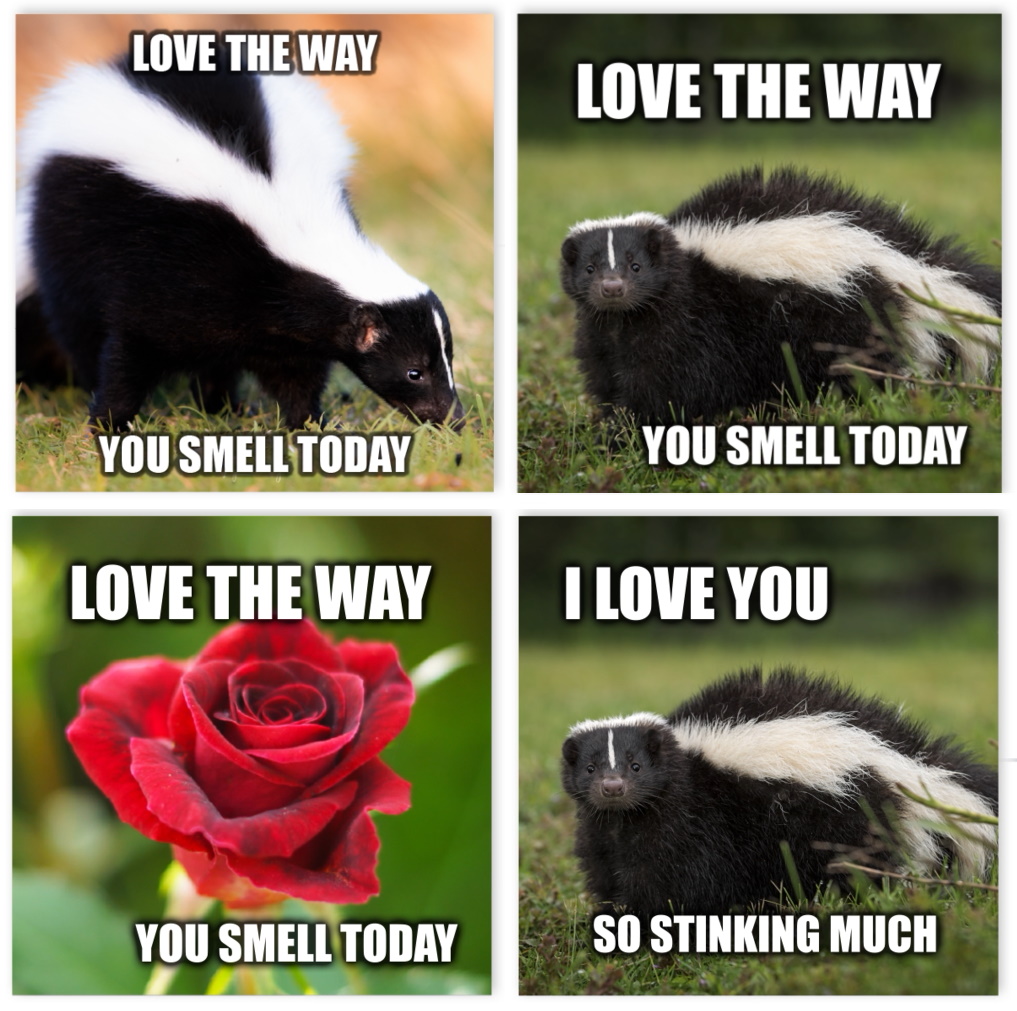

Одной из областей, которая оказалась особенно сложной для автоматизированных систем, оказались мемы. Проблема в том, что значение мема часто является результатом взаимодействия между картинкой и наложенным на неё текстом. Слова, которые были бы совершенно уместны сами по себе, приобретают обратный смысл благодаря изображению.

В компании есть свой алгоритм борьбы с оскорбительными мемами. Для начала Facebook попросила пользователей помечать картинки как разжигающие ненависть или оскорбительные, собрав в итоге набор данных Hateful Memes. Затем на этих данных была обучена система машинного обучения, работа которой существенно отличается от других ей подобных. Как поясняют в Facebook, почти все алгоритмы анализа изображений, сталкивающиеся с картинкой и текстом, сначала анализируют одно, потом другое, а затем пытаются связать текст и изображение вместе. Система Facebook сначала объединяет информацию из текста и изображения и только потом оценивает её значение.

Тем не менее, в Facebook признают, что алгоритмы пока не готовы к широкому развертыванию — точность их работы составляет около 65-70%.

В первые дни кризиса COVID-19 Facebook объявила о своих планах более активно полагаться на искусственный интеллект в процессе модерирования. YouTube и Twitter также возложили большую часть обязанностей по модерации контента на ИИ примерно в одно и то же время. Однако, несмотря на свои усилия по внедрению искусственного интеллекта, Facebook с нетерпением ждёт возвращения сотрудников в офисы. В середине апреля Цукерберг составил график того, когда сотрудники могут вернуться в офис, отметив, что модераторы контента находятся в списке самых востребованных сотрудников Facebook.

Изначально Facebook ждала от систем модерации на основе искусственного интеллекта более «агрессивного» характера работы. В ходе своей пресс-конференции в марте Марк Цукерберг заявил, что компания ждёт большого количества «ложных жалоб» — случаев, когда контент будет отмечаться как оскорбительный, хотя не будет являться таковым. Несмотря на это, на платформе продолжают распространяться ненавистнические высказывания, угрозы и дезинформация. Как пишет TechCrunch, недавно Facebook подверглась критике за распространение вирусного видео, которое отговаривало людей от ношения защитных масок, что является явным нарушением правил платформы, касающихся дезинформации относительно здоровья. Такое видео является примером нежелательного контента, который алгоритму будет трудно распознать, указывает издание.

Как заявил Цукерберг, пандемия значительно усложнила задачу модераторам, поскольку забота о защите конфиденциальности пользователей и о психическом здоровье сотрудников делает удаленную работу непростой. Facebook подтвердил TechCrunch, что в настоящее время компания разрешает небольшой части модераторов вернуться в офис на добровольной основе, и, по словам руководства Facebook, люди будут и впредь оставаться важной частью работы компании.