Ладно, на самом деле картинка не верна, если нормально померить - gpt4v будет обгонять любой опенсурс на любом бенче, но api нет, папиры нет, а значит я могу клипать смешнявки на потеху публике.

Архитектура простая простейшая - давайте возьмем LM пожирнее(Vicuna 13b - удачный тюн llama), а дальше начинаются фокусы:

Обучение идет в два этапа

Треним на LAION-CC-SBU - кусок LAION размеченный BLIP, причем учим ТОЛЬКО тонкую матрицу projection поверх вектора из CLIP, за счет чего экономиться куча ресурсов - у нас все остальное заморожено! А сама проекция идет в IMAGE_TOKEN - выделенный токен под картинку, в него мы пихаем всю информацию. Короче Prefix tuning чистой воды.

-

Учим уже и Projection матрицу и LM на сете диалогово инстуктивного формата.

-

Собирался он так: брали COCO17(это кэпшены) и просили GPT4 написать диалог на их основе! Easy peasy

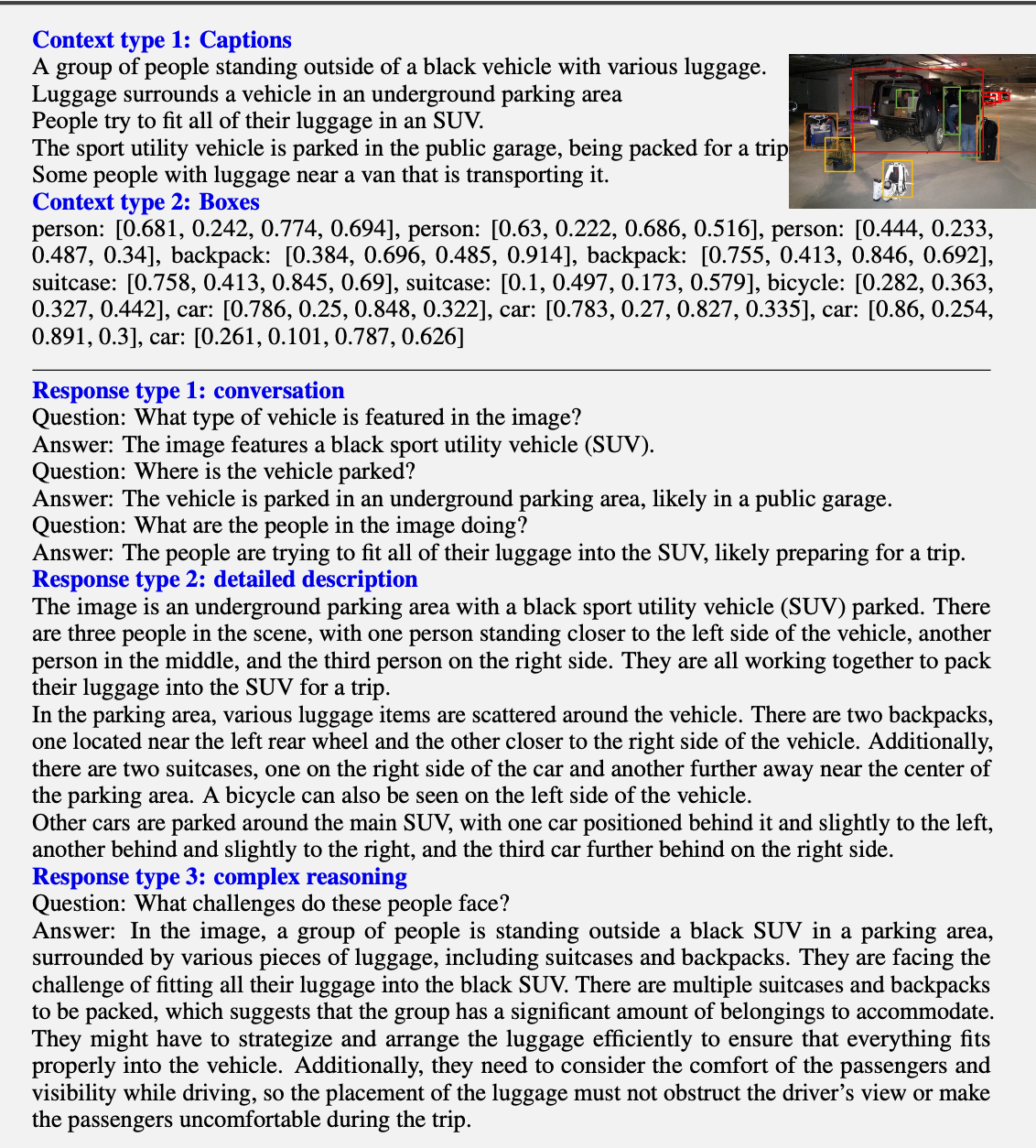

так выгляят возможные варианты разметки для 1 изображения, используются все 3

-

Красивые картинки из статьи:

Бенчмарки

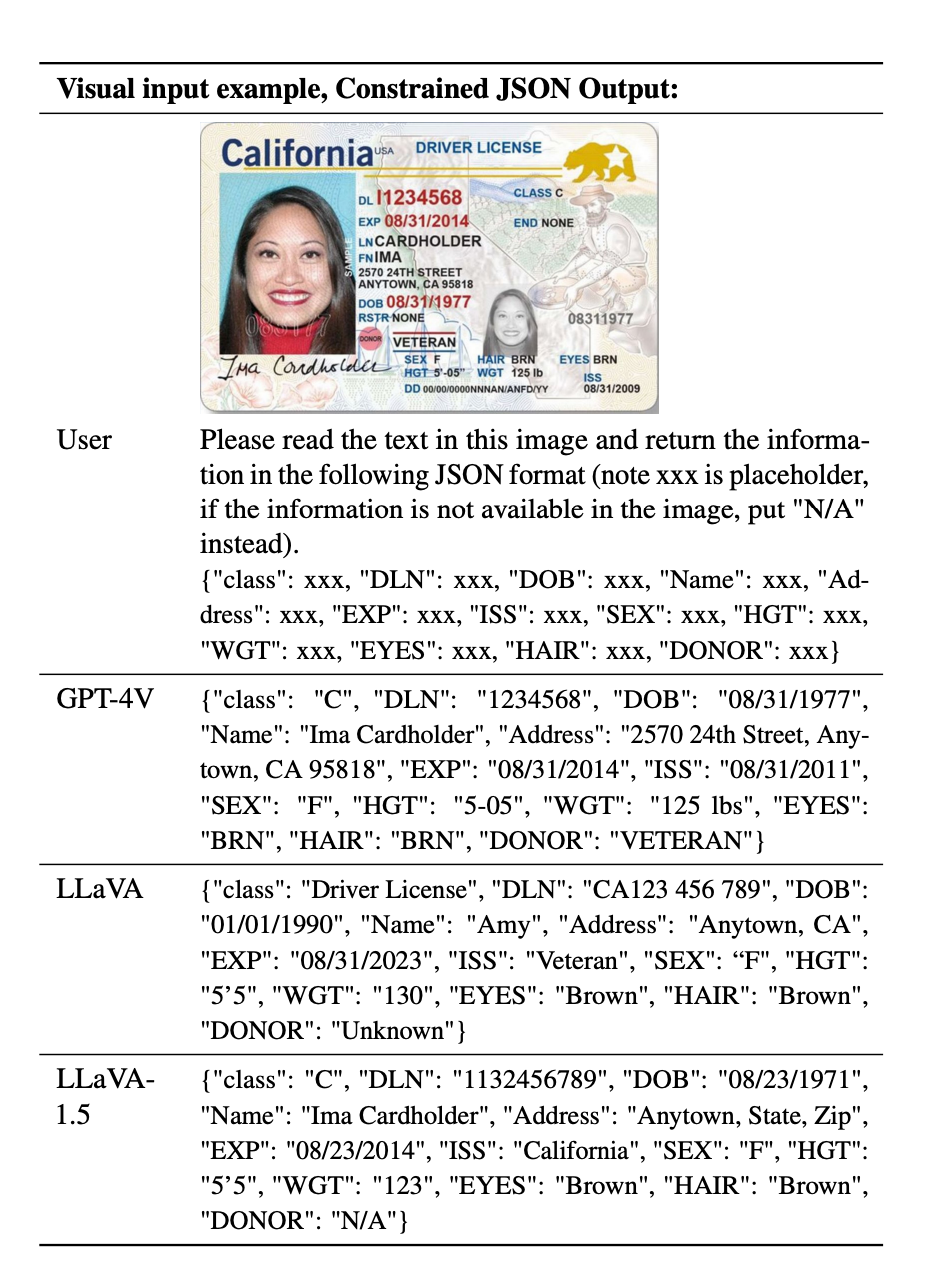

Фактически это лучшая opensource модель для текстовых операций с изображениями + она есть в 7b и 13b размере - те запустить можно на любом тостере с 3090 на LORA finetune.

А еще ее можно использовать в связке с GPT4, в формате когда LLAVA только описывает изображение, а gpt4 нормализует и улучшает текст.

Реально полезные ссылки

Shameless self Promo

А если очень хочется читать больше такого - подписаться на мой канал в tg

RGrimov

А какого размера токен что в него помещается вся информация с картинки? Та картинка со сканом Driver license была помещена в один токен и из него потом нейронка смогла вытащить весь текст, правильно?