Соблазн выдать текст, написанный ИИ, за оригинальный собственный стал особенно велик в последние годы, когда нейросети сделали огромный шаг вперёд. Вместе с этим, конечно же, появилась потребность определять тексты, написанные ИИ, а не человеком. Дошло до того, что некоторые учителя не засчитывают сочинения всему классу, хотя большинство работ действительно было написано учениками. Их тексты просто вызвали ошибочное срабатывание системы — ложноположительное (false positive). В этой статье мы разберём, почему инструменты определения сгенерированных текстов так неточны и можно ли с этим что-нибудь сделать.

Системы определения текстов, написанных ИИ, очень далеки от совершенства, настолько, что иногда от них вовсе отказываются. Такой продукт, AI Classifier, сделала даже OpenAI, создатель ChatGPT, но его довольно быстро закрыли, поскольку точность определения составляла менее 26 %. Забавно, что даже конституция США, по мнению AI Classifier, с большой вероятностью тоже была написана искусственным интеллектом. Это породило много шуток о том, что отцы-основатели США — роботы, присланные из будущего.

Инструменты, подобные ChatGPT, опираются на LLM, большие языковые модели. И если разобрать LLM подробней, становится понятно, почему такие тексты сложно отличить с помощью автоматических инструментов.

Если по-простому, то нейросеть — это попытка с помощью компьютера обработать информацию так, как это делает человеческий мозг. Нейросеть состоит из искусственных нейронов, своего рода узлов сети. Эти нейроны объединяются в слои, которые имеют сложные связи как между собой, так и внутри. Можно представить это так, что в верхний слой вы даёте какие-то данные, а нужный результат после множества взаимодействий между нейронами получаете из нижнего слоя. Иногда ответ верный, а иногда нет. Если нет, то вы пытаетесь сделать так, чтобы нейросеть дала лучший результат.

Входные данные воспринимаются нейросетями по-разному. Некоторым из них даётся приоритет, сравнительной больший вес, который в итоге влияет на то, какое решение принимает нейросеть. Если бы данные не имели веса для нейросети, она никогда не смогла бы выдать нам решение по запросу. Изменяя вес данных, вы можете повлиять на решения, которые выдаёт нейросеть.

Представим, что вы создаёте нейросеть, которая определяет фото кошек. И оказывается, что за фото кошек она принимает фото собак. Вы видите, что нейросеть работает неправильно, что данным присваивается некорректный вес. Подстраиваете параметры много раз и таким образом постепенно обучаете модель, пока она не начнёт абсолютно точно определять, изображена ли кошка на любой картинке, поступившей на вход. Так на базовом уровне и строится работа с нейросетями.

Свёрточные нейронные сети обрабатывают каждый запрос как абсолютно новый. Рекуррентные нейросети устроены чуть сложнее: при обработке новых они могут использовать данные прошлых запросов. Но проблема таких сетей в том, что им нужен полный набор данных, прежде чем они обработают информацию. В случае с текстом это значит, что для понимания контекста нейросети нужно прочесть весь текст. Иногда такой подход приводит к проблемам, поскольку к концу текста модель забывала то, что узнала в начале текста.

Но всё изменилось в 2017 году, когда группа ИИ-исследователей Google опубликовали статью Attention is all you need, где предложила отойти от рекуррентных нейросетей в работе с текстами и подобной информацией. Они предложили новую модель Transformer: в отличие от рекуррентных моделей она анализирует текст не посимвольно, а целыми предложениями или даже отрывками. Это позволило моделям понимать контекст, не ошибаясь, например, с многозначными словами, и, соответственно, корректно выполнять задачи по работе с текстами.

Модели-трансформеры произвели революцию в ИИ-приложениях, особенно в сфере обработки естественного языка и генеративного ИИ. Стало возможно развитие LLM — больших языковых моделей, на которые мы полагаемся сегодня. По сути, это и есть очень большие модели-трансформеры.

Для обучения LLM нужно очень много текста. OpenAI обучала ChatGPT на миллионах документов, найденных в интернете — на той же информации, на которой мы и сами учимся писать. Здесь у ИИ нет ни собственного первоисточника, ни уникального набора правил, по которому мы могли бы как-нибудь отличать тексты, написанные нейросетью. Поэтому тексты, созданные LLM и человеком, так похожи.

Определить текст, написанный человеком, можно только вручную, если проверяющий хорошо знаком с его письменной речью. Например, если учитель ведёт один класс, то через некоторое время он вполне может запомнить, как пишет каждый из его учеников. Но если тот же учитель ведёт множество классов в разных параллелях — как обычно бывает в школе, — то шансы совсем невелики. Разве что неосторожный ученик забудет удалить промпты из своего произведения :)

Ориентироваться здесь можно лишь по косвенным признакам. Например, насколько оригинален выбор слов в тексте. Неожиданные лексические ходы говорят в пользу человека. Большие языковые модели при выборе следующего слова выбирают из наиболее популярных вариантов — точно так же, как телефон подсказывает нам вероятное следующее слово при наборе сообщения. Но если нарочно писать так чудно́, чтобы точно пройти «проверку на робота», это может навредить тексту. Зато perplexity, то есть новизна вашего текста для языковой модели, будет велика.

Другое свойство, на которое ориентируются инструменты определения ИИ-текста, — это burstiness. Ближайший русский эквивалент — неравномерность. Тексты, написанные нейросетями, довольно последовательны по структуре предложений, их состав и длина практически не меняются. Людям свойственна более динамичная манера письменной речи. Длинные предложения мы чередуем с короткими. Одни предметы и явления описываем пространно, а для других и вовсе не подбираем определений. Меняем порядок слов для создания художественного эффекта или лучшей расстановки акцентов.

Этот подход к определению текста, написанного нейросетью, имеет и свои слабые стороны. Текст, созданный человеком, не всегда будет демонстрировать неравномерность. Многое здесь зависит от стиля повествования: чем менее художественным он должен быть, тем меньше простора у автора. Научная статья поймает «false positive» с гораздо большей вероятностью, чем школьное эссе. А если модель определения AI-текстов успели обучить, например, на сообщениях из Twitter, но никакой неравномерностью её не удивишь. Большие языковые модели вбирают в себя всё больше текстов, созданных человеком, поэтому со временем полагаться на неравномерность будет всё сложнее.

Получается, что инструменты, определяющие ИИ-происхождение контента, с текстами работают гораздо хуже, чем с фото и видео. Потому что все эти модели тоже обучались на человеческих текстах! По сути, это ещё один случай «уловки-22».

Неверное срабатывание таких проверок несёт дополнительный риск, например, в школах. Если ребенок написал сочинение сам и получил двойку из-за автоматической проверки, это может привести к неприятным последствиям — от недоверия к учителю до потери веры в людей. Поэтому отказ от таких инструментов в школах вполне оправдан. Пусть лучше это будет «false negative», рано или поздно ученик проявит неаккуратность и сам выдаст очевидные доказательства того, что балуется ChatGPT :)

А теперь пойдём по стопам хороших технических презентаций и организуем небольшую демонстрацию: прогоним эту статью в бесплатных вариантах «теста Войта-Кампфа». Сразу оговорюсь: весь текст был написан человеком, при его создании использовались разные англоязычные источники, информация из которых прошла множество изменений под руками автора.

«Антиплагиат», наиболее известная в России система подобных проверок, весной получила функцию определения сгенерированных текстов. Мы добавили весь текст до предыдущего абзаца включительно и получили оригинальность в 100 %. Но потом обнаружили, что проверка на «человечность» входит только в платную версию. Что ж, об этом инструменте можно подробней почитать в Т—Ж. Не дал бесплатно попробовать себя и аналог Text.ru.

AI Detector Sapling без регистрации принял примерно 2000 символов и оценил показатель fake в 0,1 %.

GPTZero утверждал, что из первых 44 предложений половина, вероятно, сгенерирована ИИ.

AI Detector Content at Scale радостно ответил «Passes as human!» на первые 2000 символов, но всё же предложил переписать несколько предложений для надежности.

AI Content Detector Crossplag отчитался «This text was written by a human».

А есть ли у вас опыт работы с подобными инструментами? Что можете посоветовать?

Комментарии (8)

Kergan88

21.11.2023 16:48+4Задача нейросети сгенерировать текст, который статистически не отличается от обучающей выборки. Если сеть делает это достаточно хорошо - то совершенно очевидно, что статистическии методами отличить одно от другого будет нельзя - ну просто by design.

Ведь точность "проверяльщика" в этом случае должна оказаться строго выше точности самой сети.

>Но всё изменилось в 2017 году, когда группа ИИ-исследователей Google опубликовали статью Attention is all you need, где предложила отойти от рекуррентных нейросетей в работе с текстами и подобной информацией.

Вообще, это распространенное заблуждение. Трансформеры с формально математической точки зрения являются рекуррентными сетями, если учитывать больше одного шага генерации. Идея ребят из гугла состояла как раз в том, чтобы обойти наличие рекурсии и позволить применять для обучения стандартные методы.

adeshere

21.11.2023 16:48+3А есть ли у вас опыт работы с подобными инструментами? Что можете посоветовать?

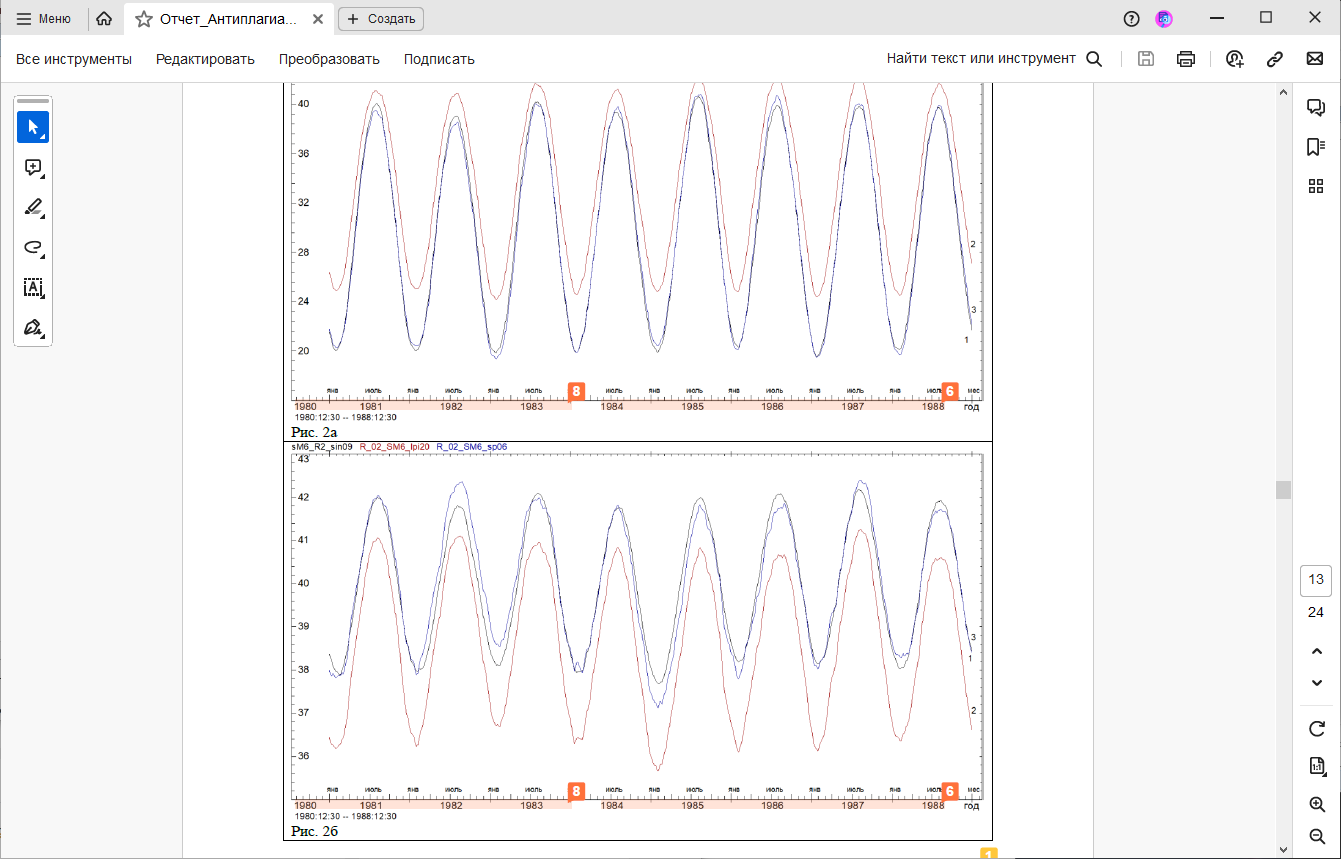

Как научный сотрудник, я иногда сталкиваюсь с проверкой на антиплагиат. И вот на днях нас впервые обвинили в скрытом самоцитировании изображения: мы воспроизвели существенную часть рисунка, но не привели ссылку на работу, откуда она заимствована. Для сохранения интриги, спрячу заимствование

под спойлер

Но сначала поясню, что мы много лет проводили наблюдения в сейсмоактивном районе, и у нас почти в каждой публикации есть картинки с временными рядами, чаще всего за 1979-1992гг. А теперь собственно претензия:

Плагиат выделен розовым фоном. Судя по отчету, мы неправомерно заимствовали сразу девять номеров лет!!! Интересно, что система выделила два фрагмента оси, как отдельные цитирования. Похоже, она сначала обработала нашу публикацию с картинкой за 1984-1988г (цитирование номер 6), а потом уже анализировала только остаток временной шкалы слева (1980-1983г) и нашла его совпадение с другой публикацией. Хотя в публикации (8) у нас вроде ось на картинке 12-летняя, а не 4 года.

Кстати, про публикации-источники

Это вообще отдельная тема. Формально для каждого заимствования в отчете приводится его источник. Но там сплошь им рядом стоит что-то вроде "Перефразированные заимствования по коллекции Интернет в английском сегменте". И как я должен отсюда понять, что именно ей не понравилось? Надпись "год" или число "42"?

В общем, вывод такой: алгоритмы развиваются быстро, но "дыры", подобные приведенной под спойлером, в них вылезают направо и налево пока что. Хорошо, если в редакции сидят адекватные люди и им можно объяснить, что надпись "январь" - это "необходимое самоцитирование", вполне уместное в научной работе. Но ведь журнал-то не сферический и не в вакууме. Ему надо выполнять формальные метрики, а как они получились - разбираться никто не будет. Если сверху спущено требование: "процент совпадений не выше ХХХХ", то хоть убейся, а выполняй. Иначе система снизит рейтинг журнала.

Так что на данный момент ИИ очень хорош в качестве помощника, но только если все его результаты потом интерпретируются кожаными мешками. Если представить себе условную "редакцию на ИИ", то как бы мы ей объясняли проблему с нашей картинкой?

Конечно, поживем-увидим, но пока что я опасаюсь, что до полного искоренения таких глюков намного дальше, чем от Т9 до ChatGPT. И что если доверить "творческие процессы" системам на основе ИИ чуть раньше, чем они будут к этому готовы (например, по причине массового нежелания кожаных заниматься этим самостоятельно), то вместо прогресса мы получим быструю деградацию как науки, так и всего человечества в целом.

P.S. Мы тут частенько размышляем про парадокс Ферми (я там тоже, кстати отметился, пытаясь все свести к понижению среднего уровня интеллекта "всемирного разума" по мере интернетизации человечества). Но вот такое объяснение парадокса Ферми - через самозацикливание глюков ИИ - кажется, может добавить в это обсуждение новую тему...

Deosis

21.11.2023 16:48+3То есть нейросеть тренировали, чтобы она выдавала текст неотличимый от написанного человеком, а теперь жалуются, что не могут эти тексты отличить?

MonteDegro

21.11.2023 16:48+2но его довольно быстро закрыли, поскольку точность определения составляла менее 26 %

Хм, а они не пробовали пррсто инвертировать ответ? Тогда точность будет больше 74 %)

MAXH0

Из корпоративной солидарности? Чтобы не дать шансов кожаным мешкам дискриминировать творчество братьев!

Хотя вот в случае школьных сочинений все более менее понятно. Как мне кажется, имея пул сочинений данного ученика, тексты написанные другими людьми или роботами все равно должны определяться статистически. Тут и нейросетей не нужно.

Вот вопрос о том, что написан текст неизвестным человеком или нейросетью - дискуссионный. Можно же стилизовать тексты под определенного автора. И любой фильтр это одновременно и набор правил для стилизации текста на его прохождение.

welga

ИИ должен иметь право подписи своих текстов, чтобы можно было различить свой текст или чужой.

Jeshua

Причем подпись должна быть стеганографической, а проверка должна идти не по точному соответствию, а по лингвистической дистанции, чтобы замена нескольких слов не уничтожила подпись.

MAXH0

Забудьте! ИИ не субъект права. И вообще ИИ не субъект. Это инструмент.

А идея про "подпись" напомнило идею администрации Байдена по регулированию ИИ.