Они случайно встретились, увлеклись одной идеей и написали работу «Трансформеры» — самый значительный технологический прорыв в новейшей истории.

[Перевод статьи из журнала Wired. Историю компании Near из первых рук можно почитать в статье на Хабре / прим. перев.]

Восемь имён указаны в качестве авторов научной работы «Всё, что вам нужно – это внимание», написанной весной 2017 года. Все они были исследователями из Google, хотя к тому времени один из них уже покинул компанию. Когда ветеран исследования, Ноам Шазир, увидел ранний вариант работы, он был удивлён, что его имя стоит первым, что говорит о том, что его вклад был первостепенным. «Я не думал об этом», — говорит он.

Перечисление имён — это всегда тонкий баланс: кому достанется желанное место лидера, а кого отодвинут на задний план. Особенно в таком случае, как рассматриваемый нами, где каждый участник оставил свой след в по-настоящему групповой работе. Торопясь закончить работу, исследователи в конце концов решили «саботировать» традицию ранжирования участников. Они добавили звёздочку к каждому имени и сноску: «Равноценный вкладчик, — гласила надпись. — Порядок перечисления случайный». Авторы отправили статью на престижную конференцию по искусственному интеллекту, когда сроки уже почти истекли, и положили начало революции.

Приближается седьмая годовщина публикации статьи «Внимание», которая приобрела легендарный статус. Авторы начали с процветающей и совершенствующейся технологии — разновидности ИИ под названием нейронные сети — и превратили её в нечто иное: цифровую систему, настолько мощную, что её результат может показаться продуктом работы инопланетного разума. Эта архитектура, «трансформер», и есть тот самый секретный соус, под которым создаются все эти умопомрачительные ИИ-продукты, включая ChatGPT и графические генераторы, такие как Dall-E и Midjourney. Шазир сейчас шутит, что если бы он знал, насколько известной станет его статья, то «возможно, больше беспокоился бы о порядке авторов». Все восемь подписантов теперь стали микрознаменитостями. «Люди просят сделать со мной селфи, потому что я упомянут в работе!» — говорит Ллион Джонс, который (случайно, конечно же) стал пятым.

«Не думаю, что без трансформеров мы бы сейчас были здесь», — говорит Джеффри Хинтон, который не входит в число авторов, но является, пожалуй, самым известным в мире учёным в области ИИ. Он имеет в виду время, в которое мы живём, поскольку OpenAI и другие компании создают системы, которые соперничают, а в некоторых случаях и превосходят человеческие достижения.

Все восемь авторов с тех пор покинули Google. Как и миллионы других, они сейчас так или иначе работают с системами, работающими на основе того, что они создали в 2017 году. Я поговорил с «трансформерной восьмёркой», чтобы собрать воедино анатомию прорыва, объединения человеческих умов для создания машины, которая вполне может оставить последнее слово за собой.

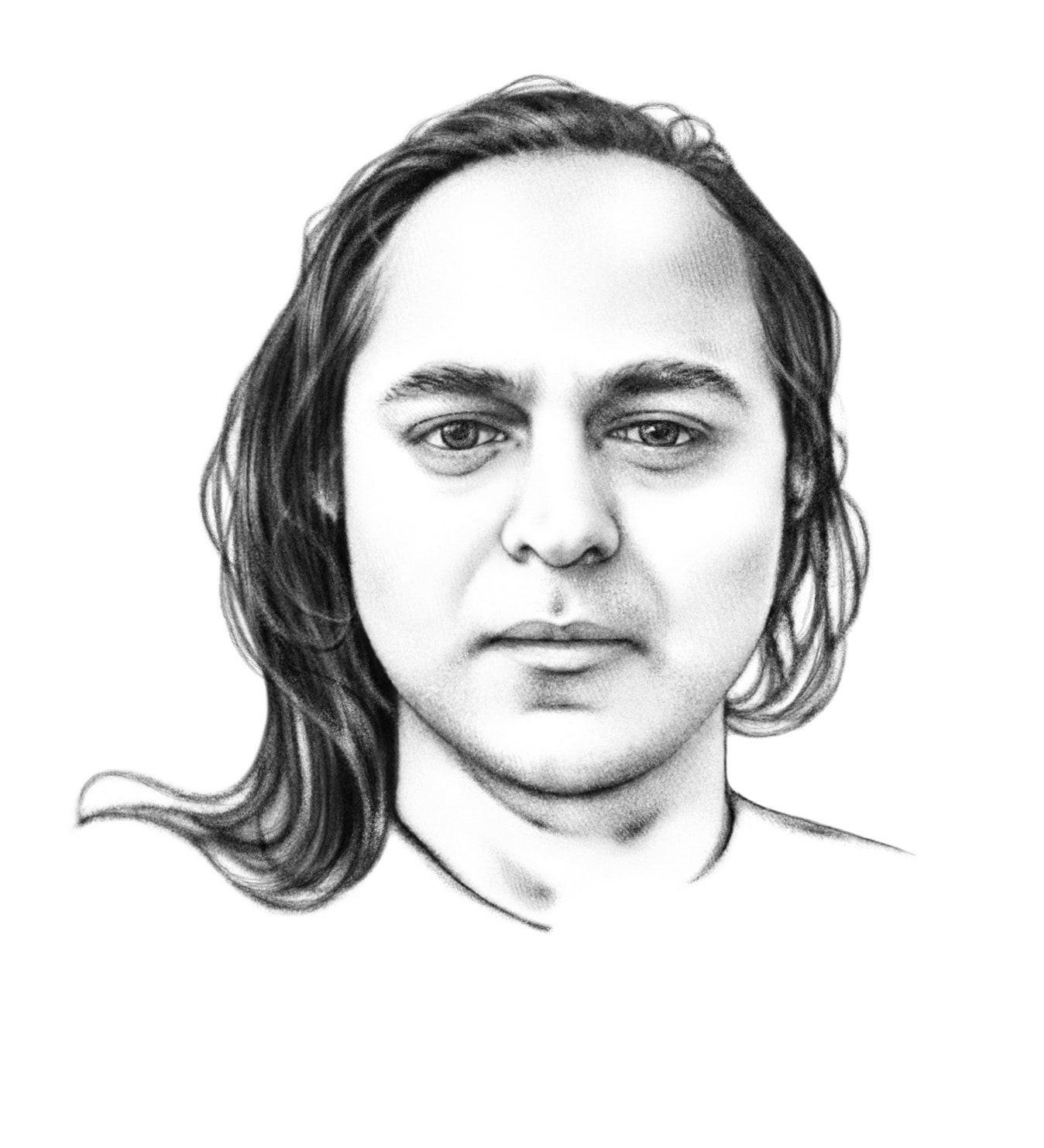

История трансформеров начинается с четвёртого из восьми имён: Якоб Ушкорейт.

Ушкорейт — сын Ганса Ушкорейта, известного специалиста по вычислительной лингвистике. Будучи школьником в конце 1960-х годов, Ганс попал в тюрьму на 15 месяцев в своей родной Восточной Германии за протест против советского вторжения в Чехословакию. После освобождения он бежал в Западную Германию и изучал компьютеры и лингвистику в Берлине. После рождения Якоба он перебрался в США и работал в лаборатории искусственного интеллекта в SRI, исследовательском институте в Менло-Парк, штат Калифорния. В конце концов семья вернулась в Германию, где Якоб поступил в университет. Он не собирался заниматься языками, но, поступив в аспирантуру, прошёл стажировку в Google в его офисе в Маунтин-Вью, где попал в группу переводов компании.

Он занимался семейным бизнесом. Он отказался от планов получить докторскую степень и в 2012 году решил присоединиться к команде Google, работавшей над системой, которая могла бы отвечать на вопросы пользователей на самой странице поиска, не отвлекая их на другие сайты. Apple только что анонсировала Siri, виртуального помощника, который обещал давать простые ответы в непринуждённой беседе, и руководство Google почуяло огромную конкурентную угрозу: Siri могла съесть их поисковый трафик. Они стали уделять гораздо больше внимания новой группе Ушкорейта.

«Это была ложная паника, — говорит Ушкорейт. — Siri никогда по-настоящему не угрожала Google». Но он приветствовал возможность погрузиться в системы, в которых компьютеры могли бы вести с нами своеобразный диалог. В то время рекуррентные нейронные сети — некогда академическое захолустье — внезапно начали обгонять другие методы разработки ИИ. Такие сети состоят из множества слоёв, и информация проходит через эти слои, чтобы определить наилучшие ответы. Нейросети одерживали огромные победы в таких областях, как распознавание изображений, и внезапно наступил ренессанс ИИ. Google лихорадочно перестраивала свой персонал, чтобы внедрить эти методы. Компании нужны были системы, способные выдавать человекоподобные ответы — автозаполнение предложений в электронных письмах или создание относительно простых чат-ботов для обслуживания клиентов.

Но область столкнулась с ограничениями. Рекуррентные нейронные сети с трудом справлялись с разбором длинных фрагментов текста. Возьмём, к примеру, такой отрывок: «Джо — бейсболист, после плотного завтрака он пошёл в парк и сделал два удара». Чтобы понять смысл слов «два удара», языковая модель должна запомнить часть про бейсбол. Говоря человеческим языком, она должна быть внимательной. Принято было исправлять ситуацию с помощью так называемой «долгой кратковременной памяти» (LSTM) — инновации, которая позволяла языковым моделям обрабатывать большие и более сложные последовательности текста. Но компьютер по-прежнему обрабатывал эти последовательности строго последовательно — слово за словом — и упускал контекстные подсказки, которые могли появиться позже в отрывке. «Методы, которые мы применяли, были, по сути, заплатками, — говорит Ушкорейт. — Мы не могли добиться того, чтобы система была масштабируемой».

Примерно в 2014 году он начал разрабатывать другой подход, который он назвал «самовнимание». Такая сеть может переводить слово, обращаясь к любой другой части отрывка. Эти другие части могут прояснить смысл слова и помочь системе сделать хороший перевод. «Она учитывает всё и даёт вам эффективный способ рассматривать множество входных данных одновременно, а затем отбирать что-то довольно избирательно», — говорит он. Хотя учёные в области ИИ стараются не сравнивать работу нейронных сетей с тем, как на самом деле работает биологический мозг, Ушкорейт, похоже, считает, что самовнимание в какой-то степени похоже на то, как человек обрабатывает язык.

Ушкорейт считал, что модель самовнимания может быть быстрее и эффективнее рекуррентных нейронных сетей. Кроме того, способ обработки информации идеально подходил для мощных чипов параллельной обработки, которые массово производились для поддержки бума машинного обучения. Вместо того чтобы использовать последовательный подход (просматривать каждое слово по порядку), он использует более параллельный (просматривать их вместе). Если всё сделать правильно, подозревает Ушкорейт, то можно использовать исключительно самовнимание для получения лучших результатов.

Не все соглашались с тем, что эта идея потрясёт мир, в том числе и отец Ушкорейта, который получил две награды за исследования на факультете Google, пока его сын работал в компании. «Люди относились к этому с подозрением, потому что это отвергало все существующие нейронные архитектуры», — говорит Якоб Ушкорейт. Попрощаться с рекуррентными нейронными сетями? Ересь! «Из разговоров за столом, которые я вёл с отцом, следует, что мы не всегда понимали друг друга».

Ушкорейт убедил нескольких коллег провести эксперименты по изучению самовнимания. Их работа оказалась многообещающей, и в 2016 году они опубликовали статью об этом. Ушкорейт хотел продвинуть их исследования дальше — в экспериментах использовались лишь крошечные кусочки текста, — но никто из его коллег не был заинтересован в этом. Вместо этого, подобно азартным игрокам, которые покидают казино со скромным выигрышем, они отправились применять полученные уроки. «Всё получилось, — говорит он. — Люди, написавшие этот документ, с воодушевлением принялись за извлечение выгоды и внедрение его в различных областях Google, включая поиск и, в конечном счёте, рекламу. Это был потрясающий успех во многих отношениях, но я не хотел оставлять его без развития».

Ушкорейт почувствовал, что самовнимание может взять на себя гораздо более серьёзные задачи. Есть другой способ сделать это, доказывал он всем, кто слушал его, и тем, кто не слушал, излагая свои идеи на досках в здании 1945, названном так по адресу на Чарльстон-роуд на северной окраине кампуса Google.

Однажды в 2016 году Ушкорейт обедал в кафе Google с учёным по имени Илья Полосухин. Уроженец Украины, Полосухин работал в Google уже около трёх лет. Его назначили в команду, обеспечивавшую выдачу ответов на прямые вопросы, задаваемые в поисковой строке. Дела шли не очень хорошо. «Чтобы отвечать на вопросы в Google.com, нужно что-то очень дешёвое и высокопроизводительное, — говорит Полосухин. — Потому что на ответ у вас есть миллисекунды». Когда Полосухин высказал свои претензии, Ушкорейт без труда придумал решение. Он предложил: «Почему бы не использовать самовнимание?» — говорит Полосухин.

Иногда Полосухин сотрудничал с коллегой по имени Ашиш Васвани. Он родился в Индии и вырос в основном на Ближнем Востоке, а затем поступил в Университет Южной Калифорнии, чтобы получить докторскую степень в элитной группе машинного перевода этого учебного заведения. После этого он переехал в Маунтин-Вью, чтобы присоединиться к компании Google — в частности, к новой организации под названием Google Brain. Он описывает Brain как «радикальную группу», которая верила, что «нейронные сети будут способствовать развитию человеческого понимания». Но он всё ещё искал большой проект, над которым можно было бы поработать. Его команда работала в здании 1965 по соседству с языковой группой Полосухина в 1945, и он услышал об идее самовнимания. Может быть, это тот самый проект, который был ему нужен? Он согласился работать над ним.

Вместе три исследователя составили проектную документацию под названием «Трансформеры: Итеративное самовнимание и обработка для различных задач». По словам Ушкорейта, название «трансформеры» они выбрали с самого начала. Идея заключалась в том, что этот механизм будет преобразовывать получаемую информацию, позволяя системе извлекать столько же понимания, сколько и человек, — по крайней мере, создавая иллюзию этого. К тому же у Ушкорейта были приятные детские воспоминания о том, как он играл с фигурками Hasbro. «У меня были две маленькие игрушки-трансформеры, когда я был совсем маленьким ребёнком», — говорит он. Документ заканчивался мультяшным изображением шести трансформеров в гористой местности, стреляющих друг в друга из лазеров.

В предложении, которым начинался документ, также присутствовала некоторая развязность: «Мы крутые».

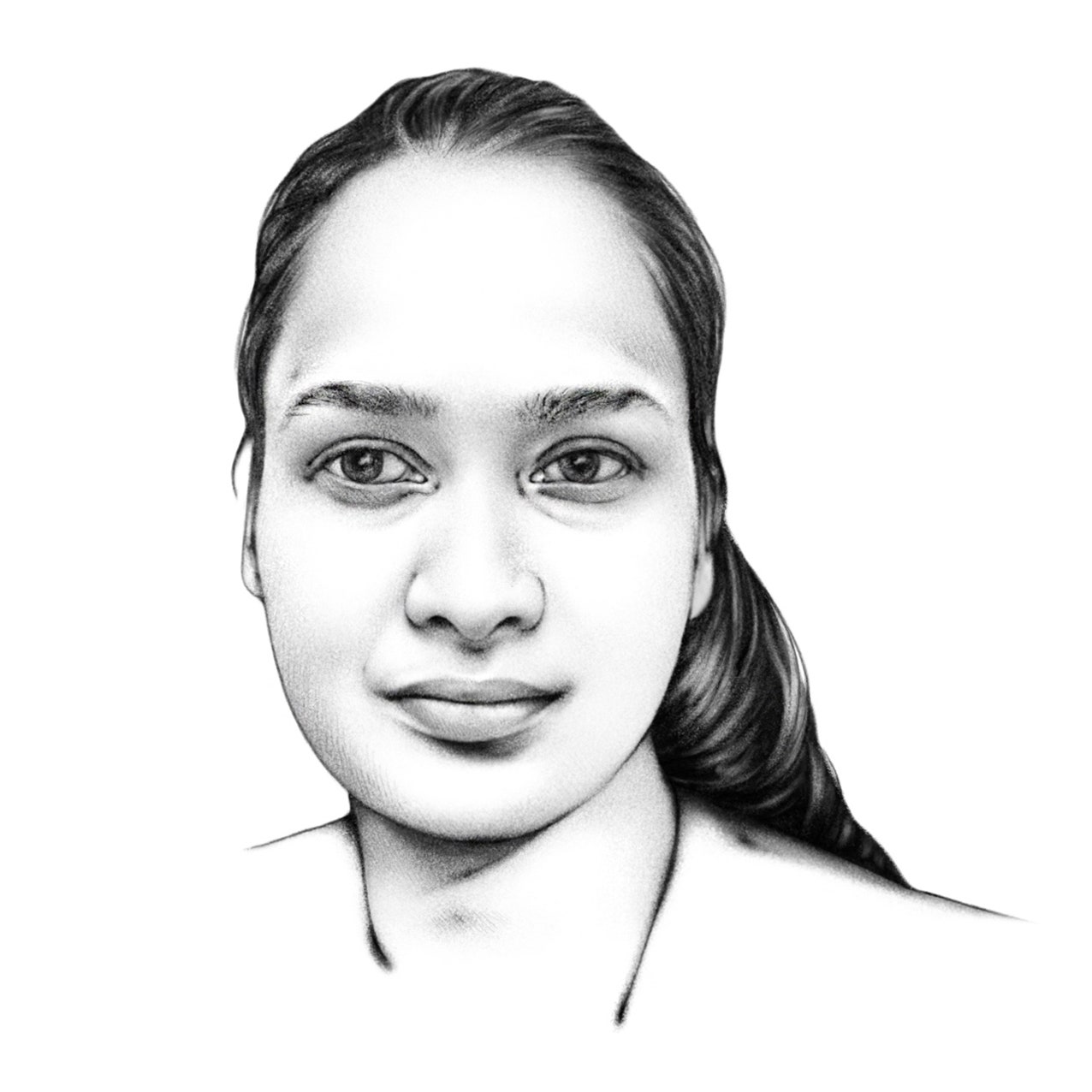

В начале 2017 года Полосухин покинул Google, чтобы основать собственную компанию. К тому времени к работе подключились новые соавторы. Индийский инженер по имени Ники Пармар работала в американской компании по разработке программного обеспечения в Индии, когда переехала в США. В 2015 году она получила степень магистра в Университете Южной Калифорнии и была принята на работу во все крупные технологические компании. Она выбрала Google. Когда она начала работать, то присоединилась к Ушкорейту и работала над вариантами моделей для улучшения поиска Google.

Ещё одним новым участником стал Ллион Джонс. Он родился и вырос в Уэльсе и полюбил компьютеры, «потому что это не было нормальным». В Бирмингемском университете он прослушал курс по искусственному интеллекту и заинтересовался нейронными сетями — на курсе их описывали как исторический курьёз. Он получил степень магистра в июле 2009 года и, не найдя работы во время экономического спада, несколько месяцев жил на пособие. Он нашёл работу в местной компании, а затем в качестве последнего шанса отправил резюме в Google. Он получил работу и в итоге попал в отдел исследований Google, где его руководителем был Полосухин. Однажды Джонс услышал о концепции самовнимания от своего коллеги по имени Мэт Келси, и впоследствии он присоединился к команде «Трансформеры». (Позже Джонс встретил Келси и рассказал ему о проекте трансформеров. Келси не поверил. Я сказал ему: «Я не уверен, что это сработает». «Это, по сути, стало самым серьёзным неверным предсказанием в моей жизни», — говорит Келси сейчас).

Работа над трансформерами привлекла других исследователей Google Brain, которые также пытались улучшить большие языковые модели. В эту третью волну вошли Лукаш Кайзер, компьютерщик-теоретик польского происхождения, и его стажёр Эйдан Гомес. Гомес вырос в небольшой фермерской деревне в канадской провинции Онтарио, где его семья каждую весну собирала кленовый сироп. На первом курсе Университета Торонто он «влюбился» в искусственный интеллект и присоединился к группе машинного обучения — лаборатории Джеффри Хинтона. Он начал связываться с людьми в Google, которые написали интересные статьи, и предлагать им идеи по расширению их работ. Кайзер попался на удочку и пригласил его на стажировку. Только спустя несколько месяцев Гомес узнал, что эти стажировки предназначены для докторантов, а не для простых студентов, как он.

Кайзер и Гомес быстро поняли, что самовнимание выглядит перспективным и более радикальным решением задачи, стоявшей перед ними. «У нас состоялся серьёзный разговор о том, хотим ли мы объединить эти два проекта», — говорит Гомес. Ответ был положительным.

Трансформерная команда занялась созданием модели самовнимания для перевода текста с одного языка на другой. Они измерили её производительность с помощью эталона BLEU, который сравнивает результат работы машины с работой человека-переводчика. С самого начала новая модель показала хорошие результаты. «К тому времени мы прошли путь от отсутствия работоспособной концепции до создания чего-то, что, по крайней мере, не уступало лучшим альтернативным подходам к LSTM», — говорит Ушкорейт. Но по сравнению с долгой кратковременной памятью «наша модель была не лучше».

Они на какое-то время застряли, пока однажды в 2017 году об их проекте случайно не услышал Ноам Шазир. Шазир был ветераном Google — он пришёл в компанию в 2000 году — и легендой компании, поскольку начинал с работы над ранней рекламной системой компании. Шазир работал над глубоким обучением в течение пяти лет и недавно заинтересовался большими языковыми моделями. Но эти модели и близко не подходили для создания плавных диалогов, которые, по его мнению, были возможны.

Как вспоминает Шазир, он шёл по коридору в здании 1965 и проходил мимо рабочего места Кайзера. Он обнаружил, что слушает оживлённую беседу. «Помню, Ашиш рассказывал об идее использования самовнимания, и Ники была очень взволнована этим. Я подумал: вау, это звучит как отличная идея. Похоже, это весёлая, умная группа людей, которая делает что-то многообещающее». Шазир нашёл существующие рекуррентные нейронные сети «раздражающими» и подумал: «Давайте заменим их!»

Присоединение Шазира к группе имело решающее значение. «Такие теоретические или интуитивные механизмы, как самовнимание, всегда требуют очень тщательной реализации, часто небольшим числом опытных "магов", чтобы проявить хоть какие-то признаки жизни», — говорит Ушкорейт. Шазир сразу же приступил к колдовству. Он решил написать собственную версию кода трансформерной команды. «Я взял основную идею и додумал остальное сам», — говорит он.

Время от времени он задавал Кайзеру вопросы, но в основном, по его словам, он «просто действовал некоторое время, возвращался и говорил: "Смотрите, это работает"». Используя то, что члены команды позже описывали такими словами, как «магия», «алхимия» и «прибамбасы», он вывел систему на новый уровень.

«Это положило начало спринту», — говорит Гомес. Они были мотивированы, а также хотели успеть до 19 мая — даты подачи документов на крупнейшее событие года в области ИИ, конференцию Neural Information Processing Systems в декабре. Когда зима в Кремниевой долине сменилась весной, темп экспериментов ускорился. Они протестировали две модели трансформеров: одну, которая была создана с помощью 12 часов обучения, и более мощную версию под названием Big, которая обучалась в течение трёх с половиной дней. Они поставили их на работу по переводу с английского на немецкий.

Базовая модель превзошла всех конкурентов, а Big получила такую оценку BLEU, которая решительно побила предыдущие рекорды; при этом модель оказалась более эффективной с точки зрения вычислений. «Мы сделали это за меньшее время, чем кто-либо другой, — говорит Пармар. — И это было только начало, потому что оценка продолжала расти». Услышав это, Ушкорейт достал старую бутылку шампанского, которая валялась у него в грузовике для горных экспедиций.

Последние две недели перед дедлайном прошли в суматохе. Хотя официально некоторые члены команды всё ещё работали в здании 1945, в основном они работали в 1965, потому что тамошняя кофемашина, готовившая эспрессо на микрокухне, была получше. «Люди почти не спали», — говорит Гомес, который, будучи стажёром, жил в постоянном бешеном ритме отладки, а также создал несколько диаграмм для статьи. Обычно в таких проектах проводится абляция — вынимаются элементы, чтобы понять, достаточно ли того, что осталось, для выполнения работы.

«Там были все возможные комбинации трюков и модулей — какие помогают, какие не помогают. Давайте вырежем это. Давайте заменим это вот этим, — говорит Гомес. — Почему модель ведёт себя таким неинтуитивным образом? О, это потому, что мы не забыли сделать правильную маскировку. Это уже работает? Хорошо, переходим к следующему этапу. Все компоненты того, что мы теперь называем трансформером, стали результатом чрезвычайно быстрых, итеративных проб и ошибок». По словам Джонса, в результате всех этих манипуляций за авторством Шазира получилось «нечто минималистичное». «Ноам — волшебник».

Васвани вспоминает, как однажды ночью, пока команда писала статью, он прилёг на диван в офисе. Когда он смотрел на шторы, отделявшие диван от остальной части комнаты, его поразил рисунок на ткани, который показался ему похожим на синапсы и нейроны. Там был Гомес, и Васвани рассказал ему, что то, над чем они работают, выходит за рамки машинного перевода. «В конечном итоге, как и в случае с человеческим мозгом, вам нужно объединить все эти модальности — речь, звук, зрение — в единую архитектуру, — говорит он. — У меня было сильное предчувствие, что мы пришли к чему-то всеобъемлющему».

Однако в высших эшелонах Google эта работа рассматривалась просто как очередной интересный проект в области ИИ. Я спросил нескольких сотрудников «Трансформеров», вызывали ли их начальники для уточнения информации о проекте. Не особенно. Но «мы понимали, что это потенциально очень большое дело, — говорит Ушкорейт. — И это заставило нас задуматься над одним из предложений в конце статьи, где мы комментируем будущую работу».

Это предложение предвосхитило то, что может произойти дальше — применение трансформерных моделей практически ко всем формам человеческого самовыражения. «Мы с нетерпением ждём будущего моделей, основанных на внимании, — пишут они. — Мы планируем расширить трансформер на проблемы, связанные с модальностями ввода и вывода, отличными от текста, и исследовать изображения, аудио и видео».

За пару ночей до дедлайна Ушкорейт понял, что им нужно название. Джонс отметил, что команда остановилась на радикальном отказе от общепринятых лучших практик, в первую очередь LSTM, ради одной техники: внимания. Джонс напомнил, что группа The Beatles назвала свою песню "All You Need Is Love" [Всё, что вам нужно – это любовь]. Почему бы не назвать работу «Всё, что вам нужно – это внимание»?

Beatles?

«Я британец, — говорит Джонс. — На это ушло буквально пять секунд размышлений. Я не думал, что ребята решат это использовать».

Они продолжали собирать результаты своих экспериментов до самого крайнего срока. «Цифры по переводу с английского на французский появились примерно за пять минут до того, как мы подали статью, — говорит Пармар. — Я сидел на микрокухне в здании 1965 и набирал последние цифры». Они отправили работу, когда до конца срока едва ли оставалась пара минут.

Google, как это делают почти все технологические компании, быстро оформила предварительные патенты на работу. Это было сделано не для того, чтобы помешать другим использовать идеи, а для того, чтобы пополнить свой патентный портфель в оборонительных целях. (Компания придерживается философии «если технологии развиваются, Google получит выгоду»).

Когда трансформерная команда получила ответы от рецензентов с конференции, они были смешанными. Один был положительным, один — крайне положительным, а один — «ну, нормально», — говорит Пармар. Доклад был принят для одной из вечерних постерных сессий.

К декабрю работа вызвала большой резонанс. Четырёхчасовая сессия 6 декабря была забита учёными, желающими узнать больше. Авторы говорили до хрипоты. К 10:30 вечера, когда сессия закрылась, там всё ещё было полно народу. «Охране пришлось попросить нас уйти», — говорит Ушкорейт. Пожалуй, самым приятным моментом для него было, когда к нему подошёл компьютерщик Сепп Хохрайтер и похвалил работу — весьма комплиментарно, учитывая, что Хохрайтер был соавтором изобретения долговременной кратковременной памяти, которую трансформеры только что вытеснили из набора инструментов ИИ.

Трансформеры не мгновенно захватили мир или даже Google. Кайзер вспоминает, что примерно во время публикации статьи Шейзер предложил руководству Google отказаться от всего поискового индекса и обучить огромную сеть из трансформеров — по сути, изменить способ организации информации в Google. В тот момент даже Кайзер счёл эту идею нелепой. Теперь же принято считать, что такой переход — лишь вопрос времени.

Стартап под названием OpenAI сработал гораздо быстрее. Вскоре после публикации статьи главный исследователь OpenAI Илья Суцкевер, который был знаком с трансформерной командой ещё по работе в Google, предложил одному из своих учёных, Алеку Рэдфорду, поработать над этой идеей. Результатом стали первые продукты GPT. Как сказал мне в прошлом году генеральный директор OpenAI Сэм Альтман, «когда вышла статья о трансформерах, я не думаю, что кто-то в Google понял, что она означает».

Внутри компании картина была более сложной. «Для нас было совершенно очевидно, что трансформеры могут делать действительно волшебные вещи, — говорит Ушкорейт. — Теперь вы можете задать вопрос, почему в 2018 году Google не создал ChatGPT? Реально, мы могли бы получить GPT-3 или даже 3.5, возможно, в 2019, может быть, в 2020 году. Главный вопрос не в том, видели ли они это? Вопрос в том, почему мы ничего не сделали с тем, что увидели? Ответить сложно».

Многие технологические критики указывают на то, что Google превратилась из площадки, ориентированной на инновации, в бюрократическую структуру, ориентированную на конечный результат. Как сказал Гомес в интервью Financial Times, «они не модернизировались. Они не внедряли эти технологии». Но для гигантской компании, чьи технологии лидировали в отрасли и приносили огромные прибыли на протяжении десятилетий, это было бы очень смело. В 2018 году Google всё же начала внедрять трансформеры в свои продукты, начиная с переводчика. В том же году компания представила новую языковую модель на основе трансформеров под названием BERT, которую она начала применять в поиске годом позже.

Но эти внутренние изменения кажутся робкими по сравнению с квантовым скачком OpenAI и смелой интеграцией систем на основе трансформеров в линейку продуктов Microsoft. Когда в прошлом году я спросил генерального директора Сундара Пичаи, почему его компания не запустила первой такую крупную языковую модель, как ChatGPT, он ответил, что в данном случае Google считает выгодным позволить другим быть лидерами. «Мне не совсем понятно, что могло бы получиться. Дело в том, что мы можем сделать больше после того, как люди увидят, как это работает», — сказал он.

Неоспоримой истиной является то, что все восемь авторов статьи покинули Google. Компания Полосухина, Near, создала блокчейн, рыночная капитализация токенов которого составляет около 4 миллиардов долларов. В 2021 году Пармар и Васвани объединились как бизнес-партнёры, чтобы основать компанию Adept (оценка — 1 миллиард долларов), а сейчас занимаются второй компанией под названием Essential AI (финансирование — 8 миллионов долларов). Токийская компания Ллиона Джонса Sakana AI оценивается в 200 миллионов долларов. Шазир, который ушёл в октябре 2021 года, стал соучредителем компании Character AI (оценка — 5 миллиардов долларов). Эйдан Гомес, стажёр в группе, стал соучредителем компании Cohere в Торонто в 2019 году (оценка $2,2 млрд). Биотехнологическая компания Якоба Ушкорейта Inceptive оценивается в 300 миллионов долларов. Все эти компании (кроме Near) основаны на трансформерной технологии.

Кайзер — единственный, кто не основал компанию. Он присоединился к OpenAI и является одним из изобретателей новой технологии под названием Q*, которая, как сказал Альтман в прошлом году, «отодвинет завесу невежества назад, а границы открытий — вперёд». (Когда я попытался расспросить Кайзера об этом в нашем интервью, пиарщик OpenAI чуть ли не прыгнул через стол, чтобы заставить его замолчать).

Скучает ли Google по этим беглецам? Конечно, помимо тех, кто перешёл из компании в новые ИИ-стартапы. (Пичаи напомнил мне, когда я спросил его об уходе авторов трансформеров, что любимица индустрии OpenAI тоже не осталась в стороне: «Область ИИ очень, очень динамична», — сказал он.) Но Google может похвастаться тем, что создала среду, которая поддерживает стремление к нестандартным идеям. «Во многих отношениях Google была далеко впереди — она инвестировала в нужные умы и создала среду, в которой мы могли исследовать и расширять границы, — говорит Пармар. — Нет ничего удивительного в том, что потребовалось время, чтобы принять это. У Google на кону было гораздо больше».

Без такой среды трансформера не получилось бы. Мало того, что все авторы были сотрудниками Google, они ещё и работали в одних и тех же офисах. Встречи в коридорах и подслушанные разговоры за обедом привели к важным моментам. Группа также отличается культурным разнообразием. Шесть из восьми авторов родились за пределами США; двое других — дети двух немцев, получивших грин-карту и временно проживавших в Калифорнии, и американца в первом поколении, чья семья бежала от преследований, соответственно.

Ушкорейт, выступая из своего офиса в Берлине, говорит, что для инноваций нужны правильные условия. «Это привлечение людей, которым что-то очень нравится, и которые находятся на правильном этапе своей жизни, — говорит он. — Если у вас это есть, и вы получаете удовольствие от работы, и вы работаете над правильными задачами, и вам везёт — происходит волшебство».

Нечто волшебное произошло и между Ушкорейтом и его знаменитым отцом. После всех этих дебатов за обеденным столом Ханс Ушкорейт, как сообщает его сын, стал соучредителем компании, которая занимается созданием больших языковых моделей. Разумеется, с помощью трансформеров.

Комментарии (5)

ITMatika

23.04.2024 04:33+7Его команда работала в здании 1965 по соседству с языковой группой Полосухина в 1945 году.

Переводил ChatGpt? Сочинял тоже ChatGpt? )

da-nie

23.04.2024 04:33Когда ветеран исследования, Ноам Шазир, увидел ранний вариант работы, он

был удивлён, что его имя стоит первым, что говорит о том, что его вклад

был первостепенным.А мне часто публикующиеся рассказывали, что настоящий автор либо на первом, либо на последнем месте (чаще всего). Потому что на первое место часто ставят всякое нахрен не нужное начальство, которое страшно хочет быть в публикации, но делать ничего не делало для исследования.

psitronic

23.04.2024 04:33+1А мне часто публикующиеся рассказывали, что настоящий автор либо на первом, либо на последнем месте (чаще всего). Потому что на первое место часто ставят всякое нахрен не нужное начальство, которое страшно хочет быть в публикации, но делать ничего не делало для исследования.

Все "зависит", как обычно, от разных факторов. Обычно в западном научном мире принято на первые места в списке со-авторов ставить основных "вкладчиков" в работу. Типа, кто сделал больше всех - это могут быть и аспиранты и постдоки. На последнем месте обычно стоит руководитель группы или "начальник" (тот, кто платит деньги, грубо говоря, и ставит задачи, определяет направление и тд). Эта практика, имхо, достаточно сомнительная. Если человек в списке со-авторов, значит там есть его вклад и кто знает - не решающий ли он? А если считатете, что вклад его несущественный, то зачем тогда брать в со-авторы?

cmcspec

Все самое интересное происходит часто неожиданно:)