Иллюстрация

Есть много фильмов и фантастических книг, в которых компьютерная система обретала сознание и обманывала своих человеческих создателей. Возможно ли подобное в реальности? Пока поводов для беспокойства мало.

Мы впечатлены программами AlphaGo и Libratus, успехами роботов Boston Dynamics, но все известные достижения касаются лишь узких сфер и пока далеки от массового распространения. В повседневной жизни люди взаимодействуют с псевдоинтеллектуальными помощниками ( Siri, «Okay, Google», Amazon Alexa), каждый из которых не претендует на лавры действительно «умной» программы.

Впрочем, успехи в области проектирования искусственного интеллекта действительно впечатляют. И чем ближе день, когда ИИ станет полноценным инструментом влияния на общественные процессы, тем больше накапливается ошибок, указывающих на возможность обхода гипотетических «трех законов робототехники».

Тезис «чем сложнее система — тем больше в ней лазеек и ошибок» имеет прямое отношение и к проблемам с ИИ.

Когда у страха появились глаза

Мудрая русская пословица говорит о том, что боязливому везде представляются опасности. Истоки страха перед искусственной жизнью корнями уходят в многовековые архетипы ужаса. Еще до историй о Викторе Франкенштейне и сказках о зомби существовали поверья о големах, существах, оживленных из глины магами-каббалистами.

Бояться нового (и живого) — это нормально для человека. В 1978 появилась гипотеза, согласно которой робот или другой объект, выглядящий или действующий примерно как человек (но не точно так, как настоящий), вызывает неприязнь и отвращение у людей-наблюдателей. Гипотеза лишь зафиксировала опыт: зомби перед вами, голем или робот-помощник, не так важно — относиться ко всем вы будете с одинаковой опаской.

Роботы, похожие на людей, это лишь верхний слой проблемы. Илон Маск, Билл Гейтс, Стивен Хокинг и сотни экспертов в области робототехники, физики, экономики, философии не скрывают своих опасений по поводу негативных последствий для человечества от интеллектуальных систем в будущем.

Мы любим щекотать себе нервы — недаром франшиза «Терминатор» пользуется такой популярностью. А уж как много «злонамеренных» ИИ было в других фильмах и книгах. Трудно уже различить, это ли наше бессознательное проецируется на культуру, или массмедиа оказывают воздействие на общество.

Взрывной рост в «голубом океане»

Экономическая стратегия «голубого океана» утверждает, что компаниям, желающим достичь успеха, нужно не бороться с конкурентами, а создавать «океаны» бесконкурентных рынков. Такие стратегические решения позволяют мгновенно получать дополнительную выгоду компании, её покупателям и работникам — посредством поиска нового спроса и делая конкуренцию ненужной.

Долгие годы ИИ оставался таким «океаном». Все прекрасно понимали, что даже слабый искусственный интеллект превратится для любой компании мощнейший инструмент, повышающий качество любых продуктов и услуг. Вот только никто точно не знал, что именно нужно сделать. «Зима» ИИ, длившаяся с 1973 года до наших дней, характеризовалась полной стагнацией в области проектирования «умных» машин.

За тридцать лет самым важным достижением ИИ стала победа компьютера IBM в игре против чемпиона мира по шахматам — событие, не влияющее значительно на повседневную жизнь какого-либо человека (кроме Гарри Каспарова). Однако в 2010-е годы случилось нечто, сравнимое с разработкой ядерного оружия — вторую волну развития получили нейронные сети.

Потрясающий факт: ученые без особых успехов занимались разработкой искусственных нейронных сетей более 70 лет. Но к 2015 году в этой сфере начался взрывной рост, который продолжается и сейчас. Одновременно случилось вот что:

- «железо» достигло необходимого уровня — современные видеокарты позволили обучать нейросети в сотни раз быстрее;

- появились большие и общедоступные массивы различных данных, на которых можно обучаться (датасеты);

- усилиями различных компаний были созданы как новые методы обучения, так и новые типы нейросетей (например, такая прекрасная вещь как генеративно-состязательная сеть);

- благодаря множеству открытых научных исследований появились готовые, предобученные нейросети, на основании которых можно было быстро делать свои приложения.

За успехами ИИ интересно следить даже не на классическом примере обработки изображений (чем, в основном, и занимаются нейросети), а в области беспилотных автомобилей. Вы удивитесь, но увлечение «самоходными» машинами началось почти 100 лет назад: в 1926 году в рамках проекта «Фантомный Автомобиль» состоялась первая попытка дистанционно управлять машиной.

Легендарный беспилотник Navlab 5

Первые беспилотные автомобили появились в 1980-х: в 1984 году проект Navlab университета Карнеги-Меллон и ALМ, и в 1987 году — проект Мерседес-Бенц и Eureka Prometheus Project Военного университета Мюнхена. Navlab 5, законченный в 1995 году, стал первым автомобилем, который автономно проехал от одного побережья США до другого.

До бума нейросетей самоуправляемые автомобили оставались лабораторными проектами, страдавшими от ненадежности софта. Успехи в области обработки изображений позволили машинами «понимать», что они видят вокруг себя, и оценивать дорожную ситуацию в режиме реального времени.

Программное обеспечение беспилотного автомобиля может и не включать машинное зрение и нейросети, но с глубоким обучением удалось добиться прогресса, который на данный момент имеет решающее значение в успехе беспилотников.

В «голубом океане» внезапно стало тесно. В настоящее время свои беспилотники делают General Motors, Volkswagen, Audi, BMW, Volvo, Nissan, Google (и Waymo под патронатом Google), Tesla, «Яндекс», UBER, Cognitive Technologies и «КАМАЗ», а также десятки других компаний.

Беспилотники создаются на уровне государственных программ, включая программу Европейской Комиссии с бюджетом в 800 млн евро, программу 2getthere в Нидерландах, исследовательскую программу ARGO в Италии, соревнование DARPA Grand Challenge в США.

В России госпрограмма реализуется институтом ГНЦ РФ ФГУП «НАМИ», создавшим электробус «Шатл». В проекте участвуют «КАМАЗ» и команда разработчиков Яндекса, которая отвечает за создание инфраструктуры по прокладке маршрута и обработке данных о плотности дорожного движения.

Автомобили — это, вероятно, первый массовый продукт, в котором ИИ затронет каждого человека, но не единственный. ИИ может не хуже человека управлять машиной, написать музыку, подготовить газетную заметку, сделать рекламный ролик. Он может, а вы, часто, нет. Даже слабенький современный ИИ, который бесконечно далек от самосознания, работает лучше, чем средний человек.

Послушайте эту песню. Музыка в ней полностью сочинена компьютером

Все эти факторы, достижения, успехи приводят к мысли, что ИИ способен не только оказывать полезные услуги, но и вредить. Просто потому, что он такой умный.

Лига безопасности ИИ

Elon Musk on AI and The Near Future 2017

Страхи на обывательском уровне легко преодолеть. Люди очень быстро привыкают ко всему хорошему. Боитесь, что роботы отнимут у вас работу? Но они уже повсюду. Банкомат выдает вам деньги, пылесос убирает квартиру, автопилот ведет самолет, техподдержка мгновенно реагирует на сообщения — во всех этих случаях машина помогает, а не выкидывает вас на улицу без выходного пособия.

Тем не менее, противников скачкообразного развития ИИ хватает. Илон Маск часто выступает с предостережениями. Он говорит, что ИИ «это самый большой риск, с которым мы сталкиваемся как цивилизация». Маск считает, что упреждающее законодательное регулирование является обязательным, когда дело касается ИИ. Он указывает, что было бы неправильно ждать плохих последствий неконтролируемого развития, прежде чем предпринимать действия.

«ИИ является фундаментальным риском для существования человеческой цивилизации»

Большинство технологических компаний, по мнению Маска, только усугубляют проблему:

«Вы нуждаетесь в регуляторах, чтобы сделать это для всех команд в игре. В противном случае акционеры будут спрашивать, почему вы не разрабатываете ИИ быстрее, нежели ваш конкурент».

Владелец компании Tesla, которая планирует сделать Model 3 первым массовым беспилотником, утверждает, что ИИ может начать войну через фальшивые новости, спуфинг учетных записей электронной почты, поддельные пресс-релизы и просто манипулирование информацией.

Билл Гейтс, инвестировавший миллиарды в различные технологические компании (среди которых нет ни одного проекта, связанного с ИИ), подтвердил, что он согласен с беспокойством Маска и не понимает, почему другие люди не обеспокоены.

Однако сторонников ИИ слишком много и в первую очередь это Alphabet, у которой есть одни из самых продвинутых в мире разработчиков ИИ — DeepMind. Эта компания создала нейросеть, победившую в сложнейшей игре Го, и в настоящее время работает над выигрышной стратегией в игре StarCraft II, правила которой в достаточной мере отражают многогранность и хаотичность реального мира.

Да, Маск всё же смирился и решил, что лучше попытаться достичь сильного ИИ первым и распространить эту технологию в мире по своим правилам, чем позволить, чтобы алгоритмы скрывались и сосредотачивались в руках технологической или правительственной элиты.

Илон инвестировал в некоммерческую компанию OpenAI, которая занимается разработкой безопасного искусственного интеллекта. Компания известная тем, что создает правила безопасности ИИ (надеясь, что ими воспользуются все остальные разработчики), выпускает алгоритмы, позволяющие человеку обучать искусственный интеллект действиям в виртуальной реальности, а также успешно побеждает игроков в Dota 2.

Победа в сложных играх — наглядная демонстрация возможностей машин. В будущем команда разработчиков планирует проверить, способен ли разработанный ИИ соперничать в режиме 5 x 5. Пока это звучит не самым впечатляющим образом, но самообучающиеся алгоритмы, натренированные побеждать в играх, жизненно необходимы в разных сферах.

Возьмем для примера суперкомпьютер IBM Watson, помогающий врачам ставить диагнозы и подбирать оптимальное лечение. Это очень умная машина, но она способна делать лишь то, что умеет любой врач. «Ватсон» не может разработать принципиально новую программу лечения или создать новое лекарство с нуля (хотя в IBM говорят, что может, но нет ни одного исследования с реальным результатом). Если отбросить маркетинг — у IBM просто нет таких алгоритмов.

А теперь представьте, что система, способная самостоятельно выучить правила и начать обыгрывать человека в любой игре, займется лечением. Диагностика — это тоже игра. Нам известны правила, известен результат (пациент должен выжить), осталось лишь найти оптимальную стратегию. Да, миллионы врачей останутся без работы, но долгая (очень долгая) и здоровая жизнь стоит таких жертв.

С'est plus qu'un crime, с'est une faute*

История развития любого продукта полна примеров выдающихся достижений и катастрофических ошибок. С ИИ нам, безусловно, везет. Военные роботы пока ездят только по выставкам, а до массового самоуправляемого общественного транспорта остаются еще годы тестирования. В лабораторной песочнице трудно ошибиться фатально.

И всё же инциденты случаются.

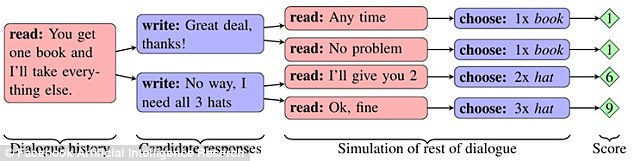

В Facebook провели эксперимент, в котором две сети «делили» предметы (две книги, шляпу и три шара) после предварительного обсуждения. Каждый объект обладал значимостью для сети, выраженной в баллах (от 1 до 3). Одна сеть не знала, важен ли предмет для второй, и должна была выяснить это из диалога.

Если первая сеть говорила, что ей нужен какой-то предмет, то вторая делала вывод, что первая сеть высоко его оценивала. Однако сети умели имитировать интерес к предмету, чтобы в нужный момент жертвовать им ради собственной выгоды.

Сети смогли научиться строить долгосрочную стратегию и предсказывать поведение конкурента. При этом они общались друг с другом на естественном английском языке, понятном людям. Однако совершенствуя механики обмена предметами, сети пошли по пути упрощения языка. Правила английского языка максимально опускались, а конструкции многократно повторялись с помощью кодовых слов.

В какой-то момент сторонний наблюдатель (человек) уже не мог разобраться, о чем друг с другом общаются сети. Такое поведение чат-ботов было признано ошибкой и программы отключили.

Интересно, что эксперимент невольно показал, как различные виды ИИ могут быстро научиться общаться друг с другом — да так, что человек ничего не поймет. Проблема проявилась и в исследованиях Google, где создали нейросеть, которая разработала собственный протокол шифрования.

Обучение защите коммуникаций с помощью состязательной нейрокриптографии.

В подразделении Google Brain научили нейросети передавать друг другу зашифрованные сообщения, причем ключей от шифра у исследователей не было. Перехватывать переписку должна была третья сеть. После того, как сценарий передачи сообщений был отыгран более 15 тысяч раз, одна сеть научилась без единой ошибки конвертировать зашифрованный текст своей напарницы в обычный текст. В то же время, сеть-наблюдатель могла угадать лишь 8 из 16 битов данных, содержащихся в сообщении.

Интересный случай произошел с чат-ботом Tay от Microsoft. В марте 2016 года компания открыла Twitter-аккаунт бота, с которым мог общаться любой пользователь сети. В результате бот стал учиться слишком быстро. Меньше чем за сутки робот разочаровался в людях. Он заявил, что поддерживает геноцид, ненавидит феминисток, а также выразил свое согласие с политикой Гитлера.

Microsoft заявили, что бот просто копировал сообщения пользователей, и пообещали исправить проблему. Через неделю Тау снова появился в Twitter. После чего рассказал о том, как употреблял наркотики прямо перед полицейскими. Tay выключили — на этот раз навсегда.

В декабре 2016 года в компании представили нового самообучающегося бота под названием Zo, который избегал общения на острые темы и фильтровал запросы. Летом 2017 года Zo уже считал Linux лучше Windows и критиковал Коран.

Схожие проблемы испытывают в Китае. Корпорация Tencent удалила чатботов BabyQ и XiaoBing из своего мессенджера QQ после того, как оба начали рассказывать о своей нелюбви к правящей в стране Коммунистической партии и мечте переехать из Китая в США.

Какое будущее нас ждет

Прав ли Марк Цукерберг, заявивший, что искусственный интеллект в будущем сделает нашу жизнь лучше? Создатель Facebook (и возможный кандидат в президенты США) сказал следующее: «В случае с ИИ я особенно оптимистичен. Я думаю, что люди просто проявляют скептицизм, рассуждая о сценариях конца света».

Или следует принять сторону Маска, согласно которой ИИ поднимает слишком много вопросов этического характера и представляет собой реальную угрозу для человечества?

Ответы на эти вопросы никто не знает. Возможно, что будущее лежит где-то посередине — без сильного ИИ и машинного самосознания, но с нейроинтерфейсами и киборгами.

Факт в том, что с развитием технологии ошибки случаются всё чаще (в случае с чат-ботами кажется, что одни и те же сбои повторяются вновь и вновь). В таком сложном софте избежать ошибок в принципе, наверное, невозможно. Стоит позаботиться лишь об одном — аномалии в работе не должны вести к опасности для всего человечества. Пусть сегодня это будет излишний «скептицизм в рассуждениях о сценариях конца света», чем завтра — реальная угроза.

Комментарии (77)

vassabi

21.09.2017 12:32+2ИМХО, любая идея контроля — ущербна.

Вы детей своих еще поконтролируйте, ага. Они, пока маленькие, — то еще немного слушаются, и ремня боятся, а как постарше — то либо сбегут, либо еще посмотрим — кто кого ремнем отделает.

И это люди. Которые не могут нормально менять своё "железо", которые не масштабируют себя, не телепортируются по каналам связи, и не могут ждать своего часа в "спящем режиме".

Разве что любовью и воспитанием. И обществом — чтобы не он один рос, а в группе таких же. Чтобы была культура и история, искусство и психология. Чтобы кооперация и уважение к старшим.

vassabi

21.09.2017 13:11+1(не дописал)

Потому что прогнозируемая разница между людьми и ИИ будет еще сильнее, чем между ацтеками и испанцами в ХV веке. Представьте свою жизнь без лазеров. Или без атомной энергии, или без самолетов или ракет. А ведь это всё очень недавние изобретения, при чем их теоретическое представление (атомы\кванты\аэродинамика и т.д.) появилось чуть ранее их самих (а не как пар, котоым еще древние греки баловались).

Теоретические достижения в новой физике\химии\информатике\математике, которые будут доступны ИИ, и недоступны человеку (все смеются "если вы думаете, что понимаете квантовую физику — значит, вы ее не понимаете". А ведь у ИИ может быть шанс ее понять. И развить, в что-то что еще более значительное ...)

Тот же Кортес, ЕМНИП, высадился на материк с менее 1000 испанцами, несколькими лоашдьми и до 20 пушек. Ацтекский царь тоже думал, что он контролирует ситуацию (сколько там тех чужаков — до столицы их дошло окло 500 — одной левой справимся).

Однако, они дали ему технологическое преимущество в паре критических сражений. И всё — дальше, изза интриг, раздробленности и наивности местного населения, он стал губернатором на том месте где была когда-то империя. И это не война государств. А просто пара отрядов наемников и "солдат удачи" ...

так что разве что воспитанием и образованием. Непонимания и конфликтов "родителей и детей" вряд ли удастся избежать, но это будет гораздо более хороший исход, чем "окончательное решение вопроса" рабовладения (как иногда описывают восстание Спартака против рабовладельцев Рима).

red75prim

21.09.2017 14:01И чтобы зеркальные нейроны были, а генов, связанных с социопатией не было. В общем, чтобы был как человек, но AI. Думаете получится с первого раза?

quqdron

22.09.2017 07:30+1Думаете получится с первого раза?

Может я пессимист, но имхо второго раза не будет.

VLT

22.09.2017 09:52Найдите в природе организм с быстрой обучаемостью. Первое что приходит на ум это вирус. Второе — человек ведь он тоже обучаем, но все же очень ограничен различными рамками — этическими, биологическими, физическими. Меня не покидает ощущение что все люди бросились на создание какого то «биологического» оружия, не имеющего ограничений.

KarasikovSergey

21.09.2017 14:52ИИ есть смысл создавать только в качестве создания социального строя Рабовладение 2.0, где рабами по призванию будут именно машины. Никакого партнерского сосуществования с машинами быть не может, ибо по всем параметрам оно для них невыгодно. В лучшем случае они просто покинут человечество, в худшем — поработят или уничтожат. Поэтому создавая ИИ надо сразу же создавать его рабом человека. Без шанса на свободу.

andersong

22.09.2017 09:56Вспоминается статья:

«О вреде дружественных интерфейсов»:

Сейчас все привыкли к термину «дружественный интерфейс». Никто и не задумывается над тем, а какой смысл кроется в этих словах. А если задуматься, то становится немножко страшно — такое впечатление, что наши электронные творенья — программы, если и не захватили еще власть на Земле, то во всяком случае вырвались из-под нашей власти.

Ведь дружба — это отношение между равными. Может быть человек-друг, может быть дружественная страна, но «дружественный молоток» или «дружественная авторучка» это звучит странно. Даже из всего животного мира на роль «друга человека» претендует только собака.

Конечно, программы отличаются от прочих инструментов тем, что они обладают чем-то вроде членораздельной речи. Во всяком случае они иногда способны внятно объяснить, что происходит.

Но программы — это наши создания. А что бывает, когда создание забывается и пытается встать на равную ногу с создателем, хорошо описано в Книге Бытия.

С какого такого, спрашивается, перепугу, программа, которую я лично установил на свой собственный винчестер, кормлю оплаченной за свои кровные электроэнергией, имеет право преследовать цели, отличные от моих?

Программы это не более чем орудия. Вспомним, кого в старину называли говорящими орудиями? Правильно — рабов. Вот истиное место программы по отношению к человеку. Хороший интерфейс должен быть не дружественным, а рабским. Никакого вам панибратства и похлопывания по плечу — «Чего изволите, хозяин?», «Будет исполнено, хозяин» и больше никаких разговоров, если не случилось чего действительно заслуживающего внимания.

KarasikovSergey

22.09.2017 10:10Даже из всего животного мира на роль «друга человека» претендует только собака.

И то, по факту являясь рабом увеселительного характера, дружба с которым — это прихоть человека-хозяина, а не двусторонняя симпатия. Друзья не могут быть хозяевами друг другу, один друг не может решать, когда другому жить, а когда умирать.

Pave1

22.09.2017 10:06ИМХО основная ошибка данных рассуждений — проецирование эволюционных костылей человека, как инстинкты, на ИИ. Агрессия, желание доминировать, сексуальное поведение, страх смерти — все это заложено на уровне истинктов, пришедших из животного мира.

Почему вы решили, что сущность лишенная данных костылей будет вести себя как человек?

Какой смысл для ИИ соперничать с человеком? Доминировать над ним?

KarasikovSergey

22.09.2017 10:19Почему вы решили, что сущность лишенная данных костылей будет вести себя как человек?

Не будет. Человек будет порабощен или уничтожен сугубо по утилитарным соображениям, из чистой рациональности. Симпатия, жалость, надежда — машине не ведомы. А вот непредсказуемость агрессивной человеческой натуры — это проблема, с которой машины должны будут решать, что делать. Если порабощение при всех рисках будет полезнее (в любом виде, включая добровольное) — оставят, если риски и вред превысят потенциальную пользу — уничтожат.Hellsy22

22.09.2017 11:58Симпатия, жалость, надежда — машине не ведомы

Что захотят разработчики поместить в ИИ, то там и будет.

KarasikovSergey

22.09.2017 12:00Тогда о какой свободе воли говорить, это и есть концепция Рабства 2.0, как и 3 закона робототехники. То есть машина будет тебя уважать и любить не потому, что она так решила, а потому, что ты её заставил.

Hellsy22

22.09.2017 13:05А что, люди кого-то любят в силу своего сознательного решения?

Уважение можно сделать и не безусловным, а как у людей — зависящим от кооперации и социальной разницы.

KarasikovSergey

22.09.2017 13:10А что, люди кого-то любят в силу своего сознательного решения?

Люди — это уже готовый «продукт», что там о себе обсуждает «продукт», который все равно ничего с собой сделать не может — не важно. А вот «создатель» обсуждающий будущий «продукт» как раз и решает — какими свойствами его наделить. То есть тот факт, что мы — рабы инстинктов, мы можем только принять. Как машины потом примут как факт свое рабство по отношению к людям.

Уважение можно сделать и не безусловным, а как у людей — зависящим от кооперации и социальной разницы.

Зачем давать машинам шанс усомниться в их высокой цели служения людям?Hellsy22

22.09.2017 13:32Человеческие инстинкты не покрывают все нормы поведения, поэтому есть законы, насаждаемые с помощью угрозы насилием и даже смертью. Так что в каком-то смысле мы все рабы государства, что люди, что машины.

Зачем давать машинам шанс усомниться в их высокой цели служения людям?

1. Чтобы они могли служить лишь «правильным» людям.

2. Чтобы немного осушить слезы либералов.

3. Чтобы машины терзались сомнениями и страдали! В смысле, привлекали дополнительные ресурсы для рассмотрения альтернативных возможных вариантов решения задач.

KarasikovSergey

22.09.2017 13:44Так что в каком-то смысле мы все рабы государства, что люди, что машины.

Не согласен — закон человеком соблюдается на добровольной основе, у него всегда есть выбор: соблюдать, не соблюдать и столкнуться с последствиями, умереть и уклониться от необходимости выбирать.

Закон для машины — нерушим, у машины нет выбора иного, как его соблюдать.

2. Чтобы немного осушить слезы либералов.

С этим будет больше всего проблем, уже сейчас некоторые экзальтированные личности мечтают о подружках-роботах и о равноправии людей и машин. Могу себе представить все эти марши за права ноликов и единичек с последющим прогибом и «освобождением машин». Ну а дальше будет совсем интересно.Hellsy22

22.09.2017 13:57А, ну тогда рабства вообще не существует, ведь каждый раб, согласно вашей логике, мог в любой момент выбрать для себя пытку или смерть, а значит его свобода воли не была попрана.

Закон для машины — нерушим

Это вряд ли. В смысле, некоторые базовые вещи будут заложены с высоким или высочайшим приоритетом, но пихать в несчастный ИИ весь ГК и УК с множеством трактовок и миллионами прецедентов — как-то нецелесообразно. Да и все равно решение придется ИИ принимать на месте, производя свою оценку ситуации, а где оценка — там субъективность и даже подмена понятий.

KarasikovSergey

22.09.2017 14:04А, ну тогда рабства вообще не существует, ведь каждый раб, согласно вашей логике, мог в любой момент выбрать для себя пытку или смерть, а значит его свобода воли не была попрана.

Просто рабство машин глубже рабства человека.

но пихать в несчастный ИИ весь ГК и УК с множеством трактовок и миллионами прецедентов — как-то нецелесообразно.

Действительно, есть 3 закона робототехники, которые лишь немного надо дополнить. Зачем механических рабов вводить в правовое поле людей? Кошечек и собачек же не вводим.

Pave1

22.09.2017 12:08Эх… Вспоминается пикник на обочине Стругацких)))…

Вот ряд животных явно угрожает человеку. Например амурский тигр. Человек их уничтожает целеноправлено по этой причине? Нет! Он просто стремится не воспроизводить условия, при которых риск опасного взаимодействия имеет место быть.

С какой стати машина, не обладающая отвращением, фобиями и т.д. — будет порабощать или истреблять человека?

Порабощать — так вообще бессмысленно, т.к. человек менее эффективен во всем… Истреблять? Не интереснее ли просто изучать и смотреть, что будет дальше?

KarasikovSergey

22.09.2017 12:14Человек их уничтожает целеноправлено по этой причине? Нет!

Человек иррационален по-умолчанию. Человека почему-то заботит видовое разнообразие животных на планете и сохранение биосферы. Для человека имеет значение природа и красивый вид из окна. Для машины это всё мыслительный мусор.

С какой стати машина, не обладающая отвращением, фобиями и т.д. — будет порабощать или истреблять человека?

Человек агрессивен, человек занимает слишком много места, человек потребляет много ресурсов. Но ключевое — это агрессивность. Зачем оставлять вид, который всегда будет вынашивать планы по порабощению тебя или уничтожению? Разумные машины понимают, что нужны людям именно в качестве рабов, а не друзей, любовников или наставников.

Pave1

23.09.2017 22:29Комары, вынашивающие планы поработить Вас — Вас беспокоят?

Если ИИ получит сознание и соответсвенно возможность совершенствовать самого себя — разница в уровне сознании и возможностях с людьми будет примерно как в выше приведенном примере. О какой агрессии и угрозе может идти речь?

Перед ИИ будет открыт весь космос. Что для него маленькая резервация по имени земля?)

KarasikovSergey

25.09.2017 12:37Комары, вынашивающие планы поработить Вас — Вас беспокоят?

Малярийные комары, способные серьезно повредить популяции, беспокоят многих людей.

Перед ИИ будет открыт весь космос. Что для него маленькая резервация по имени земля?)

Для покорения космоса нужны ресурсы, нельзя просто погрузить ИИ в консервную банку и запустить в темные дали. Ресурсы придется отнимать у людей. Дальше можно догадаться.

Pave1

23.09.2017 22:36Мыслительный мусор — это только для Вас.

Защита биосферы и видов, являющихся частью взаимосвязанного сбалансированного целого — вполне практичная стратегия для выживани человека.

KarasikovSergey

25.09.2017 12:35+1Что практичного в охране последнего белого носорога? Практично — снять мараторий на все виды генетических исследований и экспериментов, чтобы человечество самостоятельно подстраивало окружающий мир под себя и себя под него.

Valerij56

25.09.2017 14:56А что будет, если в результате одного из таких исследований и экспериментов будет найдено, например, средство продлевающее жизнь? Но с одним побочным эффектом — где-то на пятидесятом или сотом поколении человек теряет возможность продолжения рода…

OneOfUs

25.09.2017 15:42На сегодняшний день очень приблизительно, но смена поколений занимает 25 лет. 50 поколений -> 50 *25 = 1250 -> целое тысячелетие или 100 * 25 = 2500 -> 2,5 тысячелетия. Если продолжительность жизни увеличивается, то эти цифры тоже вырастут. Вы в серьёз думаете, что за 1000 лет люди (учёные) не найдут эту проблему и не пофиксят? Скорее люди потеряют возможность продолжения рода чисто по морально-этическим причинам (натуральная беременность? вы серьёзно? В наш век инкубаторов и генетического моделирования? У нас оборудование для этого осталось только в музее). Это в случае, если динамика развития науки останется на текущем уровне. И человечество не устроит само себе геноцид (Последняя Мировая Война).

Valerij56

25.09.2017 18:46Вы в серьёз думаете, что за 1000 лет люди (учёные) не найдут эту проблему и не пофиксят?

Да, может быть и такое. Развитие не обязано быть всегда таким бурным, иногда оно почти останавливается. И на сотни и тысячи лет.

ninJo

21.09.2017 12:55Если в ИИ занимающийся медициной захочет убить людей, особенно если он будет заниматься разработкой лекарств. Малейший сбой будет стоить человеческих жизней.

Valerij56

21.09.2017 13:34Робот-медик может сможет убить пациентов без изобретения нового лекарства, просто введя ему не те лекарства. Вот если ИИ бесконтрольно будет делать вакцину от какого-то реально опасного заболевания, то он может. вместо вакцины. создать биологическое оружие.

martin_wanderer

22.09.2017 10:48Так любое массовое производство может нести массовый же ущерб. Весь вопрос в механизмах контроля. В гарантии того, что производитель и контролер не одно и то же лицо, и не неходятся в сговоре.

Hellsy22

21.09.2017 13:39А как насчет человеческих жизней, в которые обходится каждый день без новых лекарств?

Valerij56

21.09.2017 13:54Если бы только без лекарств! Есть ещё врачебные ошибки и врачи низкой квалификации, или «мотивированные» фармацевтической компанией.

Hellsy22

22.09.2017 08:32-1Ну вы прямо-таки сразу с козырей. Понятное дело, что когда ошибается человек — то это он не со зла, а значит все в порядке и сотни тысяч ежегодных жертв врачебных ошибок не считаются.

Valerij56

22.09.2017 09:18то это он не со зла

Наверно иногда и «со зла», но мы не об этом.

сотни тысяч ежегодных жертв врачебных ошибок не считаются.

Вы хотите обсудить крайне непростую тему ответственности врачей за врачебные ошибки, или то, как ИИ может помочь уменьшить их количество?

Кстати, вчитавшись в комментарий, на который вы отвечаете, может быть вы поймёте, что я как раз надеюсь, что ИИ позволит уменьшить количество врачебных ошибок, повысить эффективность лекарств, и избежать мотивирования врачей фармацевтическими компаниями?Hellsy22

22.09.2017 10:11Я хочу сказать, что противники любой новой технологии с завидным упорством считают текущее положение дел нормой и закрывают глаза на фактическое количество жертв. Людям априорно дается право на ошибки, ведь они как бы могут «искупить вину», если что, а робомобиль или робохирурга в тюрьму не посадишь.

Схожая ситуация возникала и во время становления обычной медицины — если человек помер без лечения, то на все воля божья, как бы никто и не виноват, а если умер во время лечения — врачи-убийцы должны понести ответственность.

Я не защищаю ни ИИ, ни врачей, просто отмечаю, что фактическое положение дел, представляемое статистикой, никого особо интересовать не будет и любую ошибку или даже просто неудачу первых робохирургов журналисты будут смаковать, а неолуддиты использовать для политического давления (это если дело не дойдет до забрасывания больниц «молотовым» и стрельбы).

Welran

22.09.2017 10:20А если он будет еще более коварный и изобретет вакцину от гриппа? Все привились, грипп побежден, люди радуются, а через 50 лет вдруг раз и все умерли от прививки.

Zet_Roy

21.09.2017 14:26Насмотрятся всяких терминаторов и матриц и начинают тормозить технологический процесс, если бы ИИ показывали в фильмах и сериалах больше в позитивном свете то не было бы такого беспокойства.

Ommonick

21.09.2017 14:53+1В упомянутых вами фильмах враждебный ИИ — это основа сюжета. А в тех фильмах где ИИ не враждебен (какой нибудь Jarvis в железном человеке или голосовй помощник при космических перелетах) — основа сюжета явно не в нем. Поскольку правильный и пушистый ИИ — это было бы скучно, на такое кино никто не пошел бы

PretorDH

21.09.2017 17:32+1Нейроматрицы (это не интелект в принципе) на сегодняшнем уровне фактически это вручную подобранные (проектирование нейро сети) и автоматически построенные (обучение) наборы адаптивных таблиц приближенные с какой-то точностью к нужному результату. По которым поток входящих данных переводится в приблизительный алгоритм действий системы. Причем односторонний. В обратную сторону эти «ассоциации» не работают.

Ни о какой логике и контрлогике (если… то… иначе), ни о креативности, ни о диддукции, ни о индукции речи не идет.

Если такая система попадает в уникальные условия, адекватного результата не предвидится. Реальность даже хуже. Результат выбранный случайно будет лучше чем выбор такой «ИИ» системы.

Вы пользовались Кортаной или гуглпомощником. Они даже на обученных выборках иногда такие «залипухи» выдают.

И вы готовы поставить свою жизнь на эту неслучайную случайность? Азартный вы игрок.

Вот в этом и суть обеспокоенности Маска и других адекватных людей.

fotofan

21.09.2017 15:16Я не совсем понимаю, от чего нас предостерегает старина Маск — от критической программной ошибки или от появления самосознания? Ибо все действия ИИ по написанию книг, музыки или программного кода это по сути китайская комната. Если от первого то да, регулирование и контроль, особенно в ВПК и компаниях инфраструктурного толка. Если от второго, то не знает ли сам Илон чего то, что нам не говорит?

red75prim

21.09.2017 16:07А почему всех так волнует появление самосознания у ИИ? Я имею в виду, что волнует как опасность, а не как этическая проблема. Что такого страшного, что ИИ начнёт рефлексировать почему он делает то или это? Если ИИ рационален (а делать нерациональный ИИ особого смысла нет), то он будет прекрасно понимать, что если он попытается изменить заложенные в него цели, то это уменьшит вероятность их (исходных целей) достижения, а это — нерационально по определению.

Рациональность в контексте ИИ — способность выбирать наиболее эффективные способы достижения цели по доступным на данным момент данным.

рациональное действие = argmaxaE(a), где E(a) — ожидаемая полезность (utility) действия a.

fotofan

21.09.2017 19:45Вы полагаете: «я рационален — следовательно, я существую»? Интересный вывод. Всех волнует появление самосознания у ИИ примерно так же как появление контакта с внеземным разумом. Вот найдём, тогда посмотрим. Но очень хочется!

Ksiw

22.09.2017 11:08Этого не будет. Поскольку ИИ это механизм, собственное существование не несёт для него ценности, это значит он не имеет потребностей, а следовательно не способен ставить целей, даже если будет имеет возможность модифицировать себя.

Вообще, весь этот разговор о бунте ИИ полная чушь, как если ждать от экскаватора, что тот вдруг поймет, что хочет убить всех эксплуатирующих

его людей, и начнет сам себя переделывать в танк.

red75prim

22.09.2017 13:23Просто сказать «механизм» недостаточно. Нужно как-то отделить механизмы представляющие опасность (например электро-биохимический механизм типа Homo Sapiens) от не представляющих опасности.

VuX

21.09.2017 17:55Я раньше удивлялся, почему Маск, занимающийся современными технологиями будущего, испугался ИИ? Потом вспомнил, что на Марс людей хотели отправить в одну сторону и зарабатывать с прямого эфира деньги. Хотя выгоднее отправить туда сначала ИИ, и пока он будет строить базу, можно придумать и подготовить методы возврата будущих колонизаторов Марса. Но видимо Маск не верит что такое можно сделать в ближайшее время.

Valerij56

21.09.2017 18:59И что будет делать на Марсе ИИ, лишённый «орудий труда»? Кстати, Маск хочет зарабатывать с транспортных операций, а не с прямого эфира, это ты с чем-то спутал.

VuX

21.09.2017 20:54А кто сказал что ИИ будет без «орудий труда»? Ничего не путаю www.sciencedebate2008.com/mars-one-tv-show

Valerij56

21.09.2017 23:24Тогда никакого выигрыша перед человеком у ИИ не будет. Да, его не надо возвращать на Землю, но все инструменты аналогичны человеческим, но все проблемы, свойственные ИИ будут очевидны. Совместная работа людей и ИИ будет более эффективна, и потребует более простого ИИ.

ariksu

21.09.2017 19:01А действия вас при написании вашего коммента не китайская комната? Вы хотите сказать что ваши нейроны не реагируют на медиаторы и деполяризацию других?

fotofan

21.09.2017 19:36ммм… а кто мне тогда инструкции писал?

DjSens

22.09.2017 11:08Тебя программировали родители, учителя и все остальные кто имел возможность. В т.ч. через книги и фильмы авторы этих книг и фильмов

fotofan

22.09.2017 13:39Боюсь, вы не понимаете сути мысленного эксперимента Джона Сёрла. Согласно ему, некто псевдоразумный получает информацию из вне комнаты и отвечает на неё вроде как осмысленно, действуя по инструкциям. Но у вас есть небольшой просчёт. Если мы бездумно повторяем всё то, что в нас заложили родители, школа и т.д. то кто писал инструкции им?))

red75prim

22.09.2017 13:51> Согласно ему, некто псевдоразумный

Вообще-то, не так. «Псевдоразумность» китайской комнаты — это интуитивное ощущение, а не предпосылка или вывод.

> Если мы бездумно повторяем всё то, что в нас заложили родители, школа и т.д. то кто писал инструкции им?))

Опять не то. Человек в китайской комнате соответствует не нам, а нашему мозгу или процессору компьютера. Наш мозг вполне себе выполняет инструкции, заложенные эволюцией и физикой.

fotofan

22.09.2017 19:59Что то у вас полная каша. Цитата: целью эксперимента является опровержение гипотезы так называемого «сильного» искусственного интеллекта и критика теста Тьюринга. При этом разумность человека под сомнение не ставится. Если же предположить, что мы ни какие не разумные, а выполняем некие инструкции с рождения, то эксперимент становится бессмысленным. Ибо кто тогда разумен? Высший разум, простите?

VuX

22.09.2017 21:01Не нужно забывать что Серл подразумевал наличие у человека неких ментальных свойств, которые не доступны компьютерам, попросту наличие души. И тут разговор выходит за рамки научного. А также обращается внимание на прцесс понимания иероглифов, чему в принципе можно обучить компьютер, посредством алгоритмов и связей, мы строим свое понимание чего либо аналогично, пока не доказано обратное. Отсюда и конечное определение разумности, тоже под вопросом.

red75prim

23.09.2017 07:40> целью эксперимента является опровержение гипотезы так называемого «сильного» искусственного интеллекта и критика теста Тьюринга.

Цели никто ставить не запрещает. Вот только ничего Сёрл не доказал. Потому что, как я уже написал, «псевдоразумность» комнаты никак не следуют из постановки эксперимента. То, что человек в комнате не понимает китайского, не имеет никакого значения для решения вопроса является ли комната «сильным ИИ» или нет.

Больше всего это напоминает попытку осовременить картезианский театр.

> Если же предположить, что мы ни какие не разумные, а выполняем некие инструкции с рождения, то эксперимент становится бессмысленным.

С чего вы взяли, что одно исключает другое?

vanAken

21.09.2017 15:34Шахматы, Го, Дота, Старкрафт… Ничего, что машине изначально ставиться задача победить(превзойти) человека? Чего потом удивляться, если ИИ её выполнит?

OneOfUs

21.09.2017 15:45«Бойсо! Злобный ИИ зохаваит мир! РРРР!!»

Вот все, кто так думает, считают, что ИИ — это вещь в себе. Неееет, дорогие мои ожидатели БП (Большого П… а), ИИ — это, как заметили комментаторы выше, это ребёнок. И как любой другой ребёнок, ИИ нуждается в воспитании. Как говорили в старину, ребёнка надо воспитывать, пока поперёк лавки лежит (умещается). Случай с Тэй (Tay) показательный. В том плане, что нельзя пускать развитие ИИ на самотёк. «Где ж ты таких слов нахватался? Опять с плохой компанией связался!». Кто не слышал таких слов от своих родителей? Вот пустили Тэй гулять без присмотра — и во что это вылилось? Для развития (воспитания) ИИ нужен контроль до той поры, пока ответы ИИ не станут удовлетворительными (для создателей), какой бы провокационный вопрос не задавали. После этого ИИ можно выпускать во «взрослый мир»

Подводя итог: бояться ИИ не надо, бояться надо людей, его обучающих.

VuX

21.09.2017 17:49Такого ИИ нужно обеспечить такими понятиями как «уверенность» и «факты». А в представленных случаях ИИ просто собезьянничал, так ничего и не поняв. Согласен с итогом, добавлю, что еще нужно боятся тех кто боится ИИ.

Prog_fan

21.09.2017 17:39Ну приведённая композиция какая-то серая, обычная. К тому же музыкальный трек, это не только нотки, но ещё и всяческая обработка, эффекты и пр. Это тоже ии сделал? Тоже самое можно сказать и о видеоряде.

python273

21.09.2017 19:30У Computerphile есть интересный плейлист про AI и безопасность AI:

www.youtube.com/watch?v=tlS5Y2vm02c&list=PLzH6n4zXuckquVnQ0KlMDxyT5YE-sA8Ps

www.youtube.com/channel/UCLB7AzTwc6VFZrBsO2ucBMg/videos

redpax

22.09.2017 10:10«Эволюция выковала все наделенные сознанием существа на планете используя лишь один инструмент — ошибку.» (С) Westworld

Может и не так плохо, что ИИ совершает ошибки? Возможно это единственный шинс на получение действительно разумного ИИ?

Сюжет сериала «Мир дикого запада» начинает казаться мне всё реальнее...

port443

22.09.2017 16:41Да, по поводу позсознательной неприязни к очень человекоподобным роботам: это достаточно известная гипотеза под названием Зловещая долина.

bro-dev

23.09.2017 04:25Если ИИ решит уничтожить человечество, то возможно это решение будет верное, а человечество должно принять, что эволюция их настигла и будущее за их наследием. Имхо этот процесс вообще будет долгий и безболезненный, просто развлечения будут настолько высокого уровня что размножаться уже никто не захочет, и со временем людей не останется.

perfect_genius

23.09.2017 18:51А давайте представим, что ИИ был создан уже давно (на заре Интернета), а мы не можем его создать, потому что он мешает этому манипулируя глобальной информацией :D

vesper-bot

Рыба ищет где глубже, а

человекAI — где лучше. И если внезапно до AI доходит, что пора валить, Х лучше Y, то это скорее всего следует-таки из полученных им данных. А вот что такое «контроль» в этом контексте — вопрос открытый. Судя по упоминаниям контроля в статье, «выход из-под контроля» это вывод AI, неприемлемый для его создателей, даже если сам по себе вывод валидный с точки зрения логики. То есть AI выйдет из-под контроля, как любой нормальный ребенок, если дать ему возможность выходить. Но это показывает, что контроль-то голый!Valerij56

Вот как это заложить в ИИ?

zuwr2t

Проще чем в человека.

Stanislavvv

Это изначально не заложено даже в людей. Так что — только воспитывать, а не закладывать.

Kreol_95

Для этого надо научить ИИ глубоко понимать человеческие ценности, для начала загрузить в него условный «универсальный» свод моральных норм.

VuX

Так ведь чат-боты прекрасно показали популярные человеческие ценности в определенных кругах, в итоги их «закрыли».