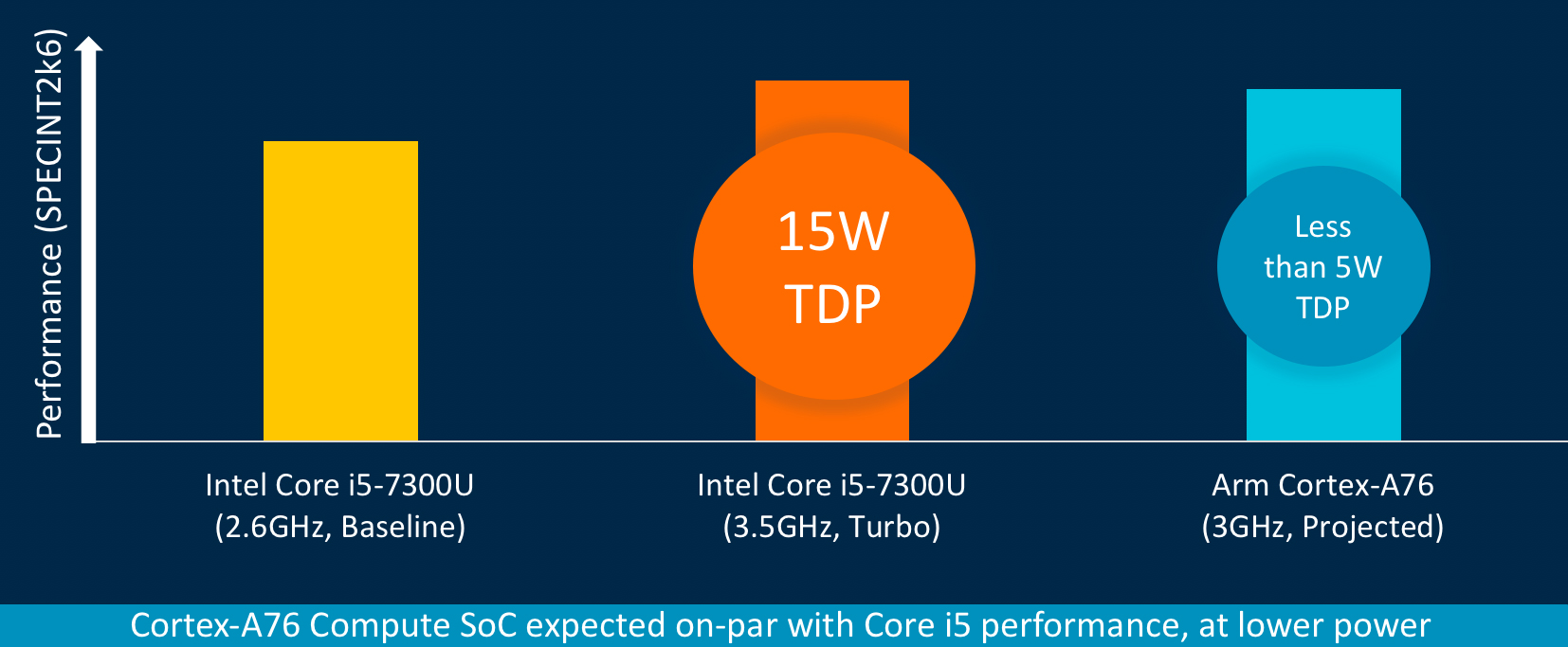

Согласно собственным тестам ARM, процессор Cortex-A76 уже примерно соответствует по производительности разогнанному процессору Core i5-7300U, рассеивая при этом менее 5 Вт (TDP), в сравнении с 15 Вт у чипа Intel

Процессоры ARM традиционно используются в смартфонах и планшетах, но в последнее время производители ПК вроде Asus и HP решили, что производительность и низкое энергопотребление этих «камней» вполне подходят для ноутбуков. Глядя на такое положение вещей, сама компания ARM анонсировала процессорные архитектуры, специально предназначенные для конкуренции с Intel и AMD на ноутбуках и настольных компьютерах в 2019?2020 годы. По мнению ARM, новые чипы вполне могут сравниться и даже превзойти процессоры Intel в однопоточной производительности.

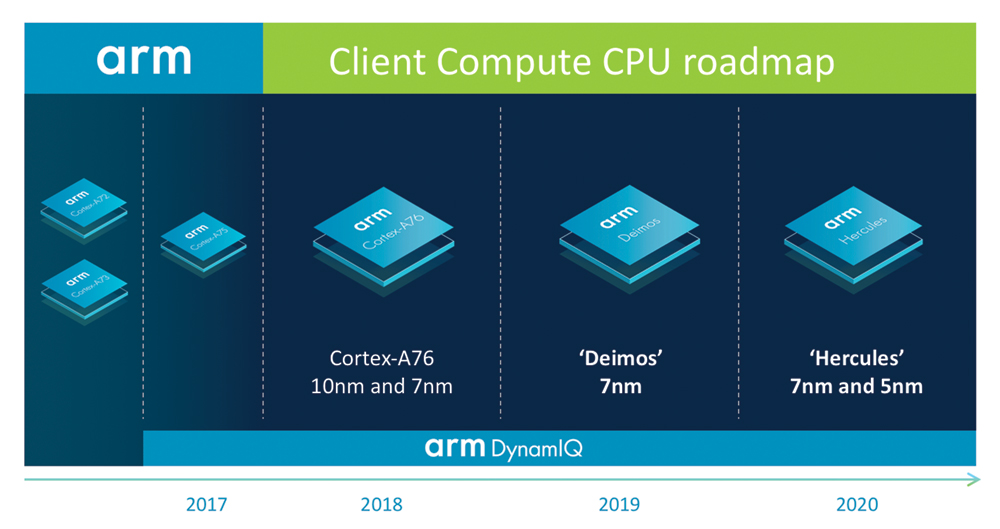

ARM анонсировала две новые микроахитектуры:

- Deimos, 7 нм, 2019 год

- Hercules, 7 и 5 нм, 2020 год

Все эти процессоры будут использовать новую технологию DynamiQ, которая заменит big.LITTLE.

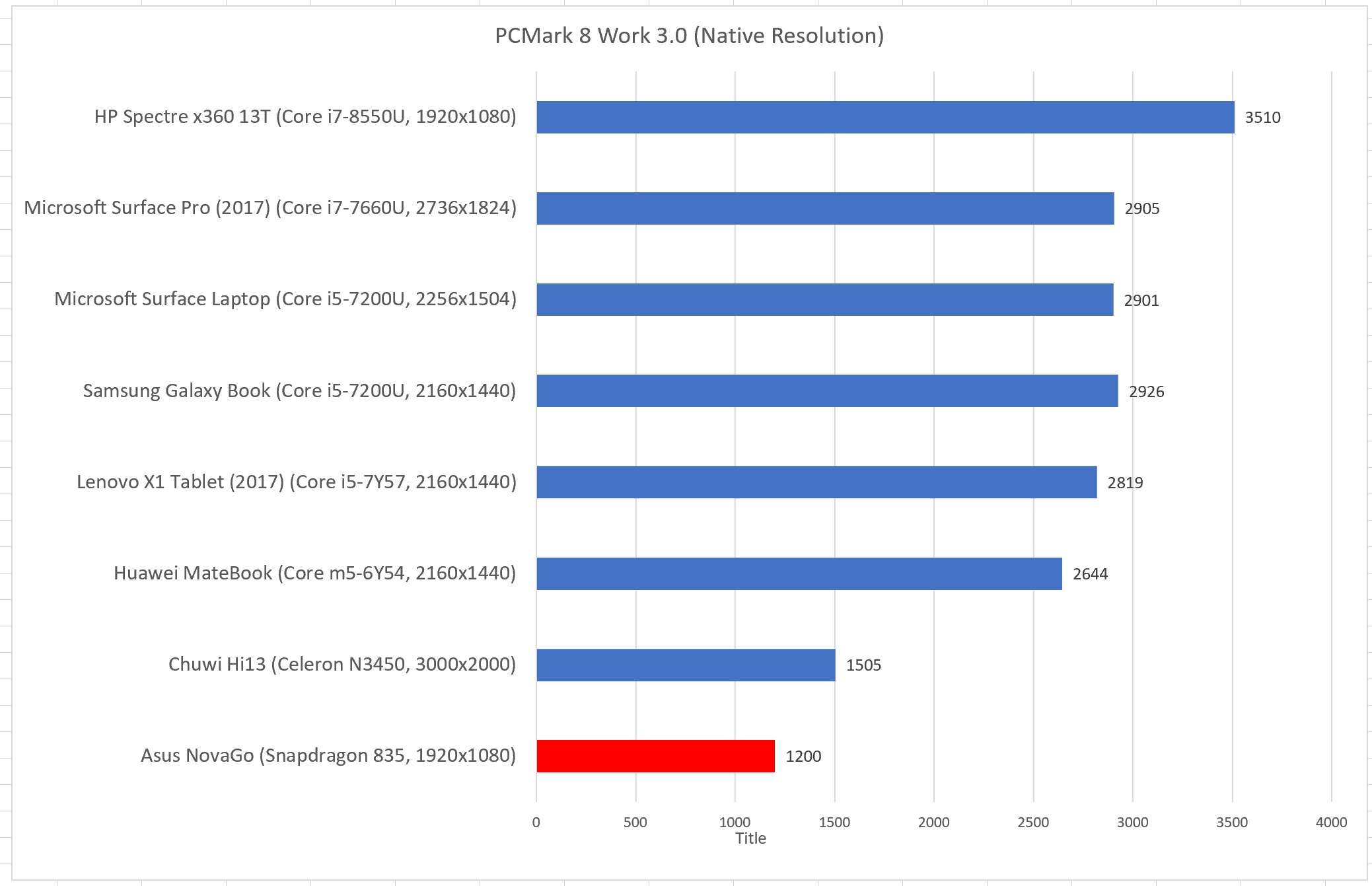

Сложно заранее сказать, насколько реальные системы на ARM смогут сравниться в производительности с обычными машинами x86. Всем понятно, что большинство программного обеспечения пишется и оптимизируется для x86, а под ARM будет работать через эмуляцию, что сразу даёт x86 фору в производительности. Например, можно посмотреть на реальные бенчмарки PCMark 8 Work 3.0 обычных процессоров в сравнении с ARM. Бенчмарки проводились в нативном разрешении каждого планшета/ноутбука.

Как видим, мощный современный ARM-процессор Snapdragon 835 (производитель: Qualcomm) сильно проигрывает в производительности даже системе на Celeron N3450. Проигрыш объясняется двумя причинами: кроме упомянутого режима вынужденной эмуляции это ещё и меньшее количество ядер в процессорах ARM по сравнению с представителями семейства Core.

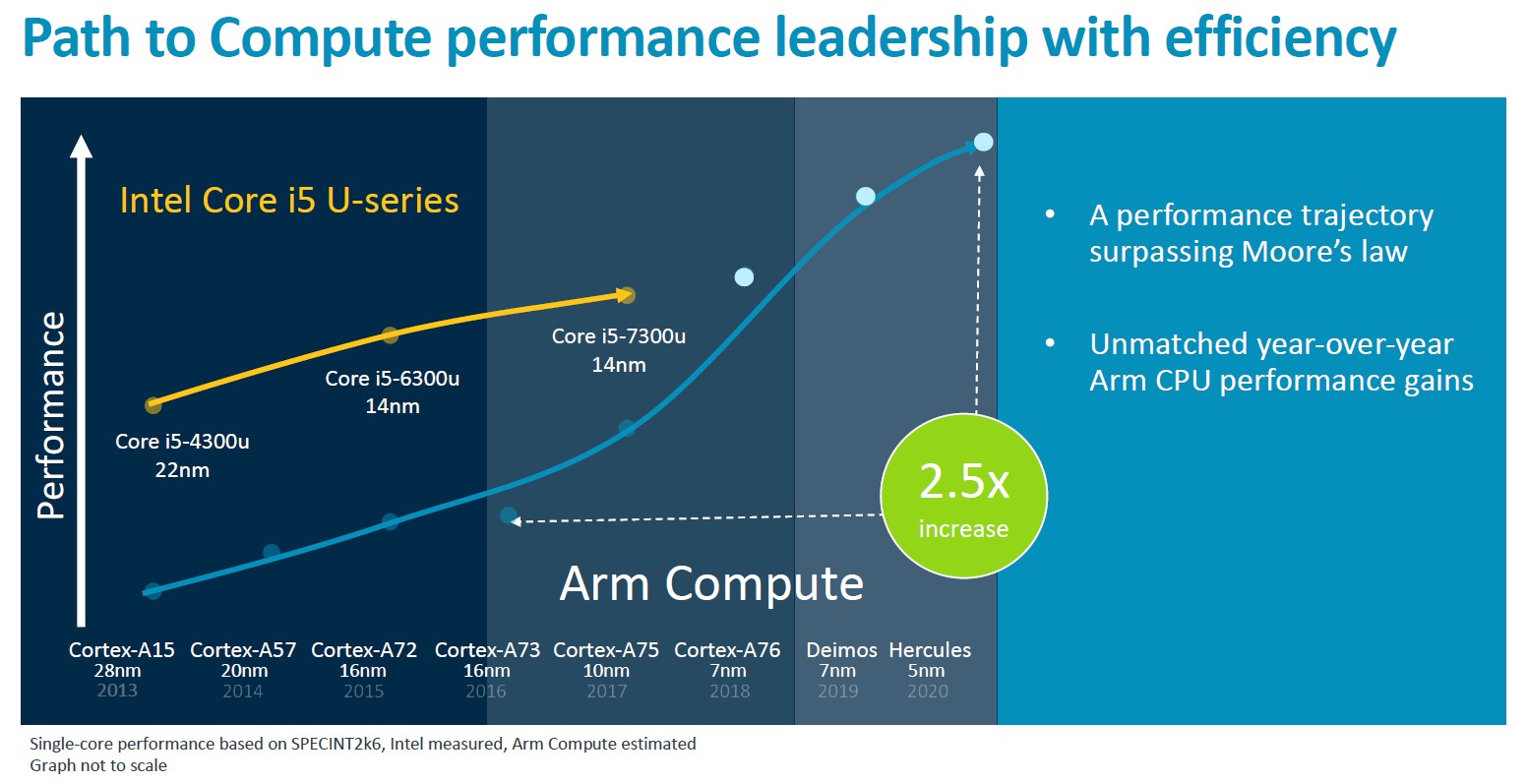

Но ARM собирается устранить это обидное недоразумение в будущих процессорных архитектурах, где микросхемы станут изготовлять по техпроцессам 7 и 5 нм. К 2019?2020 годам компания намерена догнать и обогнать по производительности существующие процессоры Core i5-4300U, Core i5-6300U и Core i5-7300U, а траектория развития процессоров ARM превзойдёт закон Мура. По заявлению фирмы, до выхода Cortex-A76 в последние годы ARM и так выдаёт средний ежегодный прирост производительности процессоров около 20%, а после Cortex-A76 ежегодный прирост ещё увеличится. Итак, с 2016 по 2020 годы производительность её чипов вырастет в 2,5 раза, то есть процессоры на архитектуре Hercules будут в 2,5 раза быстрее, чем Cortex-A73. Львиная доля в этом скачке производительности объясняется переходом с техпроцесса 16 нм на 5 нм, но частично — системными улучшениями, ведь в сравнении с остальной процессорной индустрией ARM демонстрирует (или обещает продемонстрировать) намного больший прогресс.

Но разница постепенно нивелируется. Согласно собственным бенчмаркам ARM, процессор Cortex-A76 уже примерно соответствует по производительности процессору Core i5-7300U, рассеивая при этом менее 5 Вт (TDP), в сравнении с 15 Вт у чипа Intel.

Проигрывая в производительности, ноутбуки вроде Asus NovaGo уже сейчас выигрывают в энергопотреблении, то есть во времени работы без подзарядки. Вероятно, это преимущество сохранится и в будущем, когда мощность процессоров ARM резко вырастет.

Вероятно, ARM рассчитывает, что процессоры на её архитектуре станут настолько же популярными в ноутбуках, насколько популярными они сейчас являются в смартфонах и планшетах. Это вполне целенаправленная и логичная экспансия. Как и планшеты, ноутбуки тоже преимущественно эксплуатируются в «мобильном» режиме, то есть без непосредственного подключения к сети питания, а в таком режиме ноутбуки на ARM смогут работать несколько дней. Кроме того, ведущим производителем ARM-процессоров является компания Qualcomm. По всей вероятности, она станет и крупнейшим производителем 5G-модемов. Это даёт дополнительное преимущество ARM-ноутбукам, которые в будущем предположительно будут эксплуатироваться в режиме постоянного соединения с сетью 5G.

Комментарии (155)

DrPass

17.08.2018 17:47Как видим, самый мощный современный ARM-процессор Snapdragon 835 (производитель: Qualcomm) сильно проигрывает в производительности даже системе на Celeron N3450.

Если экстраполировать производительность, то уже даже прошлогодний Snapdragon 845 обгонит Celeron N3450, и это круто для ARM, учитывая их энергоэффективность.

Marwin

17.08.2018 18:19+1Это всё, конечно, круто, но ведь в 2020 году и софт продвинется вперёд, и x86 процы будут еще больше энергоэффективны (надеемся, что Интел всё же разродится со второй реинкарнацией 10нм). Если утрированно говорить, то прикольно, конечно, было запускать Win98 на HTC HD2, но смысл? К сожалению, тенденции развития софта говорят только о том, что повседневный софт жирнеет не по дням, а по часам (даже виндовый блокнот научился в bing!) Поэтому на армах 20-х годов, да, если и будет что-то нормально работать, то только ПО двух-трехлетней давности, раз они сравнивают их с нынешним поколением интелов.

PS примеры типо "да даже на семилетнем 2600k всё отлично пашет" не считаются… тут же разговор идёт о энергоэффективном сегменте на грани комфортности при минимальном потреблении, где, например, J1800 совершенно не справляется с банальным современным браузингом

powerman

17.08.2018 18:25+4У меня i7-2600K разогнанный на 4.5GHz (десктоп, Linux, SSD и 24GB RAM). Периодически поглядываю на современные процы — никакого смысла апгрейдиться пока не видно. Учитывая, что помимо проца придётся менять ещё и материнку, и память, как минимум — стоимость апгрейда получается значительной, а вот ожидаемый выигрыш в производительности реальных приложений вряд ли будет заметен "на глаз". Были бы новые процы защищёнными от модных уязвимостей без больших потерь в производительности — тогда был бы хоть какой-то смысл обновиться.

Marwin

17.08.2018 18:33так ведь моя мысль и была в том, что high-end процы на то и high-end, чтобы их хватало на несколько лет. А вот мобильные энергоэффективные версии всегда находятся на границе добра и зла )) И уже буквально через пару лет полностью оказываются непригодны к ежедневному использованию ввиду постоянного роста

средней температуры по больницетяжести контента. Поэтому будущие армы, сравниваемые с текущими лоу процами, будут иметь крайне малый запас скорости в рамках нагрузок 20-х годов.

powerman

17.08.2018 18:54Ok, давайте про мобильные. У меня уже довольно старенький (лет 5-6) Samsung Galaxy S3 (правда, его редкий вариант i9305 с 2GB RAM и LTE). Ну и Cyanogen, разумеется, родные прошивки это зло. Никаких проблем, тормозов, нехватки места, etc., регулярно качаю новые игрушки и пока все отлично работали, обычные приложения тем более — единственная причина заставляющая периодически задумываться об обновлении — для этой модели нет поддержки текущих версий LineageOS (обратная сторона выбора более мощной, но и более редкой модели).

Иными словами проблема не столько в том, что софт жирнеет (хотя это безусловно так, и очень раздражает), сколько в том, что железо покупается без запаса прочности, что и приводит к тому, что через год-два начинаются проблемы и его нужно обновлять. Думаю, по факту либо эта "экономия" приводит к тому, что используемые инструменты тормозят и раздражают годами, либо регулярно обновляются и в результате за суммарное время эксплуатации обходятся дороже, чем если сразу взять что-то более мощное.

springimport

17.08.2018 18:42Сам так думал пока сидел на 3770 и пока не попробовал 8700k. Все же с выходом Ryzen многое изменилось и новый i7 вышел очень хорошим. 2600k знаю и пишу с него прямо сейчас, достойный вариант.

Обновляться есть смысл, но если именно что не хватает производительности.

Marwin

17.08.2018 19:12да на самом деле разница огромна даже при переходе с 2600k на какой-нить 2011-3 хасфелл от 6 ядер и более. Особенно, если добавить NVME SSD, чего на 2600k платформе сделать весьма непросто. Я тоже не верил… до тех пор пока не обновился. Дело-то не только в синтетических циферках, но и задержках IO подсистемы, которые на новых платформах уменьшаются заметно сильнее роста мощи процов, и очень бросаются в глаза.

powerman

17.08.2018 19:33+1Опять же, под виндой может и так. И при нехватке памяти это запросто может быть правдой. Но я поставил 24GB RAM (хотя практика показала, что хотя 8GB было реально мало, но вот 16GB уже бы хватило), и, скажу честно, все тормоза моментально пропали — при том, что у меня даже SSD не было!

Линух в этом отношении устроен очень удачно — при первом обращении в винту всё кешируется в память (если её хватает), и остаётся там навсегда, что делает работу с HDD и SSD примерно одинаковой (после начальной загрузки компа и всех приложений, что у меня занимало 2 минуты, а перегружаюсь я примерно раз в месяц-два).

Я только полгода как добавил SSD и перенёс на него систему — и сделал это исключительно из-за того, что на HDD заметно тормозил docker, которому при

docker image prune -fприходилось удалять файлы сотнями тысяч. Единственное заметное отличие после перехода на SSD — ускорилась загрузка системы (да, вот эти 2 минуты раз в месяц, очень важно, ага) и она стала абсолютно тихой, но в работе, если не считать docker, никаких заметных отличий от перехода на SSD (достаточно быстрый, хоть и не NVMe — hdparm показывает чтение 460MB/sec) не обнаружилось.

rub_ak

17.08.2018 20:13+2Windows 7 и старше (а скорей всего и Vista) также делают, всё единожды запущенное остается в памяти, пока она не понадобиться.

"

"

oldbie

17.08.2018 21:45+2Пусть меня поправят знающие наверняка, насколько мне известно все зависит от кол-ва озу: чем больше доступной тем более агрессивную политику кеширования использует ОС. И win и linux.

powerman

17.08.2018 23:43-1Я виндой давно не пользовался, но насколько я помню, 7-ка, как и все предыдущие, постоянно что-то свопят на винт, даже если памяти достаточно. И вот тут SSD сильно ускоряет. Linux тоже изредка что-то свопит, но это происходит на порядок-два реже и намного менее заметно (типичная ситуация на двух примерно одинаковых компах, на которых никто ничего не делает — на винде лампочка винта моргает почти постоянно, на линухе крайне редко). Впрочем, даже этот редкий своп сильно раздражает, так что я его выключаю в принципе. Наверное, под виндой тоже можно выключить, хотя я не слышал, чтобы так делали.

Kwisatz

18.08.2018 11:14Неправда. У меня памяти 18гб стоит и пока я не работаю с графикой ее хватает за глаза. Но иногда какойнить хром, висевший в фоне часов 10, явно начинает работать из свопа. Отключение свопа кстати решает эту проблему, но порождает куда более неприятную

Gaikotsu

18.08.2018 20:03Ну это вобщем-то вполне логичное поведение — скинуть из физ. памяти в своп самые старые фоновые/неиспользуемые данные/приложения, если вдруг чему-то более свежезапущенному потребовалась свободная память, а ее уже маловато.

Massacre

18.08.2018 22:52Смена постоянно запущенного браузера на другой тоже решит эту проблему :) Ну и ленивая загрузка вкладок.

0xd34df00d

19.08.2018 05:01Ну фиг знает. Прогон make на уже собранном проекте в tmpfs — две секунды, на пятилетнем интеловском ssd — четыре, на харде — 15. Грепать сорсы clang'а быстро — бесценно.

powerman

17.08.2018 19:19+1У 8700k ядер больше. Если сравнить производительность, учесть мой разгон (а он линейно ускоряет, сам тестировал многократно), и сравнить производительность на одно ядро — у 2600K она будет даже немного больше (~2800 моего разогнанного против ~2660 у не разогнанного 8700K).

При этом количество ядер больше 4-х на десктопе особого выигрыша не даёт — у меня Gentoo Linux, и, честно, если бы не регулярная Gentoo-шная компиляция обновлений то и одно ядро почти никогда не занято, не то, что 4. Поэтому и нужно смотреть производительность на одно ядро, а не суммарную сколько может выжать проц если нагрузить максимально.

Гарантировать разгон сложно, но, предположим, получится разогнать 8700K на те же 4.5GHz — это даст 15% выигрыша производительности на одном ядре. Допустим, он разгонится до 4.7GHz, учитывая что его это турбо-частота шансы хорошие — это будет 20%. И, наконец, если реально повезёт, и он будет на воздухе стабильно работать на 5GHz, то мы получим уже что-то достойное упоминания, такое, что реально может быть заметно в скорости работы десктопа "на глаз" — 28.5%. При этом стоимость апгрейда потянет под штуку баксов (проц, мать, 24GB очередной новой быстрой DDR, и может потребуется ещё что-то менять).

Так что нет, обновляться смысл может быть только если это нагруженный сервер, но туда лучше ставить что-то с количеством ядер значительно большим, чем у 8700K. А обновлять десктоп с 2600K на 8700K смысла ровным счётом никакого. Не знаю, может если речь про винду и тяжёлые игрушки картина будет другая, но для линуха смысла точно нет.

springimport

17.08.2018 19:258700k вообще спокойно берет 4.8 и даже 5.0. Только тогда нужно скальпирование. И, насколько я понял, здесь нет лотереи: у всех так гонится.

Если хочется максимальной отдачи то конечно надо брать. Выше я написал, разница большая между 3770 и 8700k. Это реально чувствуется во всем.

Конечно, ssd m2 и ram 3600 способствуют тоже.

Marwin

17.08.2018 19:29ну так про проц-то разговор идёт даже в меньшей степени. Материнка и pci-ex дисковая подсистема (может еще немного DDR4) — вот что даёт огромный именно субъективный рост комфорта работы с компом. А обновление проца при этом — скорее вынужденная мера.

0xd34df00d

19.08.2018 05:05В тяжелых игрушках смысла еще больше нет, на игровой машине хазвелл i5 вытягивает что баттолфилд на максималочках, что какой-нибудь DCS. И загружен он далеко не на сто процентов.

А вот на домашней машине с линухом я попрограммировать для себя люблю и всерьез присматриваюсь к 32-ядерному threadripper. Эх, жаль,

stackне умеет в многопоточную сборку.

Urub

17.08.2018 22:52Пережимал видео с регистратора на i7-2600K и на i3-6100 — и несмотря на 8 потоков первого, 4 потока второго жмут чуть быстрее за счет новых инструкций. Оба без разгона т.е. частоты сопоставимы.

Sway

18.08.2018 14:05У i7 8700 есть преимущества перед 2600К, причем довольно много. Я это понял только после апгрейда (удачно слил почти весь системник и покрыл примерно половину затрат на апгрейд). Очевидное: + 2 ядра и + 4 потока, возможность использовать DDR4, намного меньшее энергопотребление (т.е. можно поставить очень тихий и не очень мощный БП). Не очевидное: современные материнки позволяют использовать оперативку в дополнение к памяти на видеокарте, т.е. имея, например GTX 770 c 2GB RAM можно вообще не задумываться об апгрейде видяхи (а это 30-40к если брать что-то аналогичное по производительности). Есть еще пачка плюсов мелких, в основном связанных с возможностями материнки. В общем по моим ощущениям стало немного лучше, хотя я и на 2600К не жаловался. Кстати не советую брать топовые материнки — они чисто маркетинговые, толку от наворотов в них нет никакого. Я взял среднего уровня материнку и доволен ей полностью (MSI Z370-A PRO, брал весной за 8к). Кстати, счета за электроэнергию стали меньше =)))

walti

18.08.2018 14:10Не очевидное: современные материнки позволяют использовать оперативку в дополнение к памяти на видеокарте,

Пора бы уже сменить Geforce 6200 TC, 2006 год -прям ностальгией повеяло.

www.ixbt.com/video2/nv44.shtml

Sway

18.08.2018 14:21Мне кажется, что у вас в процессоре видяха и то мощнее (если он из core i серии) =)))

walti

18.08.2018 14:28Мне кажется, что системную память умели использовать еще AGP карты.

Я вам ненавязчиво намекаю, что процитированное сообщение — немножко заблуждение.

Sway

18.08.2018 17:15Могли-то могли, но если вы сейчас сравните скорость работы памяти на видяхе GTX 7xx+ и DDR3, то толку от добавления DDR3 к видяхе никакого. В случае с DDR4 ситуация получше — разрыв не настолько катастрофичный и в целом я не заметил особых лагов.

walti

18.08.2018 17:48HBM2 ;)))))))))))

Сравните скорость.

У ДДР4 вырос ПСП, но с задержками не стало особо лучше.

ВК всеравно приходится конкурировать с ЦП за доступ к памяти.

Я понимаю вашу радость от покупки, но все не так радужно, как в середине 00-х — при переезде с нетберста на коре — буст достигал сотен процентов, а не жалкие 30-40%.

Прогресс, увы, уныл. З-н Мура — мертв.

Олдфаги помнят ощущения с перехода с 5900 Ультра на 6600, и тем более на 6800.

8800 — эт вообще неописуемо.

Kobalt_x

19.08.2018 16:28Ну hbm2 это конечно хорошо, но например бенчмаркинг того же graph500 показывают что при использовании nvlink используя ту же ddr4 производительность повышается и масштабируемость растет что позволяет решать задачи медленнее чем чисто на GPU но в разы быстрее чем на cpu

dartraiden

19.08.2018 17:47современные материнки позволяют использовать оперативку в дополнение к памяти на видеокарте, т.е. имея, например GTX 770

Разве материнки, а не DirectX 12? А если DirectX, то тут облом — 770 в него полноценно не умеет, и не будет уметь из-за особенностей архитектуры (формально умеет, но на практике под 6xx/7xx разработчикам игр придётся делать отдельный DX12-движок, отличный от DX12 для более новых архитектур; естественно, это экономически неоправданно, поэтому удел таких видеокарт — DX11).

Что почитать по теме:

Сравнение быстродействия видеокарт в DirectX 11, DirectX 12 и Vulkan, часть 1

Sway

19.08.2018 18:20У меня спокойно подтягивает недостающую память из оперативки. Остальной функционал DX12 — хз, мне как бы и DX11 вполне достаточно. В играх графика для меня не главное. 770 чаще всего спокойно тянет средне-высокие настройки для fullhd, но вот оперативки на ней последние пару лет стало заметно не хватать и этот неожиданный бонус мне зашел на ура т.к. пока жаба давит тратить несколько десятков тысяч на GTX 1060/1070.

chapai22

19.08.2018 05:39у меня рабочая станция делл, ей лет 5-6: 2 xeon 3gHz/6core + 72GB RAM ECC +2xSSD/Raid6HDD + NVquadro5 и все ценой ценой меньше штуки.

Никакие апгрейды не смогут понадобиться еще лет 6, а то и больше.

Попросту нет практических задач которые могли бы требовать большего.

И никакие защищенности новых процов роли не играют.

А вот с лэптопами не все так просто. совокупность быстродействие+время работы играет роль. Лэптопом приходится пользоваться часто вместо дектопа.

Попытался использовать старый лэптоп i5 — ужас, хотя он был вполне хорош. И тут процы только в путь, и если арм подтянется — будет отлично, день работы от батарей нужен при весе в килограмм.

Так что прогресс с одной стороны достиг потолка — а с другой есть куда двигаться.

cujos

19.08.2018 11:01Я вот когда поменял ноут в этом году на 8550u, почувствовал силу. В сочетании с ddr4, nvme-ssd, он заметно обходил десктопный 3770k(тоже с SSD) в повседневных задачах процентов на 20, притом что он с более чем в 6 раз меньшим TDP. Ноут работает 7 часов, в повседневных задачах неслышен совсем (куллеры не включаются). Хотя 3770к пока тоже менять не собираюсь.

inferrna

17.08.2018 18:37Скорость ожирения ПО примерно равна скорости роста производительности ПК. А кое-где и вовсе отстаёт — например, в способности утилизировать многоядерность. К 2020 году интел порадует привычными +15% на ядро и удвоением числа ядер относительно текущего момента — соответственно потяжелеет и софт, ничего страшного.

LevOrdabesov

17.08.2018 18:37+5*в специально подготовленных задачах, оптимизированных под архитектуру ARM. Не является офертой.

seri0shka

17.08.2018 18:45+82040 год.

Новый 256-ядерный процессор от… позволяет открывать страницу в браузере менее чем за 30 секунд!

Kwisatz

18.08.2018 11:20Ну если так пойдет то это будет не шуткой. Уже сейчас картинки по несколько мегабайт, хренова туча js метров на 10+. Всевозможные обсерверы, двусторонний data-binding, js-анимация, 20 слоев абстракции итд, даже там, где оно нахрен не нужно. Открытие какого нибудь мегаплана по 5+ секунд считается нормальным.

seri0shka

18.08.2018 14:37Именно поэтому пытался найти для себя (и вроде нашёл, но не совсем то) текстовый браузер. По большому счёту мне нужен только текст и картинки, открываемые по моему запросу.

0xd34df00d

19.08.2018 05:08Новый интерфейс гмыла открывается секунд 15 и жрет все четыре логических ядра на ноуте с i7-6600.

iproger

19.08.2018 08:08И 1 секунду на 8700k. Видимо что-то не так с вашим i7.

khanid

19.08.2018 12:06У рядовых ноутбучных версий количество ядер меньше десктопных вдвое, кроме некоторых топовых. А деградация производительности при полном потреблении ресурсов, по ощущениям, нелинейная по времени выходит.

oldbie

19.08.2018 16:43+1логических ядра на ноуте с i7-6600.

на 8700k. Видимо что-то не так с вашим i7.

Он ноутбучный.

0xd34df00d

19.08.2018 16:46На десктопном 3930k тоже пару секунд.

И я бы сказал, что всё же, видимо, что-то не так с этим UI. Разницы в фичастости с прошлым интерфейсом я не увидел, а тормозит оно заметно сильнее. Зачем?

Gryphon88

17.08.2018 18:48Немного не в тем статьи: почему многопроцессорные ПК стали редкостью? В память лезть дольше, зато проще специализировать по задачам, эффективнее делить ресурсы между не заточенными на многоядерность программами, ну и «песочницы» делать в удовольствие, особенно если процессоры неравноправные.

Marwin

17.08.2018 19:07Где? дома? Потому что на днях вышел домашний и как раз по сути многопроцессорный Threadripper 2990WX с неравноправным доступом к памяти, и Винда (да и весь остальной софт) настолько фшоке от его особенностей, что его производительность как 32-х ядерного процессора скачет в разы как в бОльшую так и в МЕНЬШУЮ сторону по сравнению с 16 ядерным аналогом, что вызывает некоторое смятение. Как бы среднестатистический-то пользователь не хочет заморачиваться особенностями привязки потоков к ядрам. А в датацентрах как были 2011-3, так и есть 3647 многопроцовые

vdem

17.08.2018 19:10Ну в датацентрах они в кластеры собраны, а не тысячи процессоров в одном корпусе :)

Gryphon88

17.08.2018 19:34Да, дома. Почитал описание к Threadripper 2990WX… Ну, приятно, что NUMA скорее работает как в железе, так и на уровне ОС, но я имел несколько иное в виду: грубо говоря, отдать системе одно ядро и палку памяти без возможности сменить (или вообще отдельный сокет), а остальные ресурсы оставить прикладным программам. Или сделать ядра, различающиеся по набору инструкций, всё равно относительно мало программ умеют AVX, а цену немного снизить.

Marwin

17.08.2018 19:42ну примерно так это и сделано в мобилах… идея-то здравая, но в больших компах, предполагаю, что зоопарк конфигураций процов, платформ и вообще совершенно по-разному написанного софта сведёт всё это на нет. На жёстко контролируемых маках это еще хоть как-то было бы возможно, но на остальном — утопия. Слишком всё уже завязано на то, что всё одинаково и доступно в равных условиях. Да даже банально то, что софт сильно часто общается с подсистемами ОС, и их нельзя просто так взять и развязать по дальности памяти и процов.

Gryphon88

17.08.2018 19:47В мобилах тоже зоопарк, а как-то всё эти BigLittle и вспомогательные сопроцессоры работают. Думаю, и на ПК справились бы, если б это было нужно и выгодно.

stychos

18.08.2018 02:56На какой только зоопарк эти жёстко контролируемые маки не устанавливают…

Telmah

18.08.2018 12:20тестируют систему на ограниченном «официальном» наборе железа, все остальные зоопарки за пределами тестинга и гарантий работы, претензии можно писать в спортлото

stychos

18.08.2018 13:00Основные проблемы на хакинтошах — только с вайфлей и тачпадами. В остальном система уверенно работает на практически любом зоопарке, что немного расходится с комментарием, на который я отвечал.

0xd34df00d

19.08.2018 05:10Под виртуалбоксом она очень так себе работает, UI ужаснейше тормозит даже с проброшенным ускорением.

stychos

19.08.2018 14:37-1В виртуалках она плохо работает, да, нет вменяемых драйверов на виртуальную видеокарту. Когда-то была у VMWare, но и они забили на Fusion. Может, можно как-то через SR-IOV с отдельной видеокартой, но не пробовал, не в курсе. Ну и комментарий мой не о виртуальных машинах, а о железном зоопарке, там более-менее всё в порядке, даже на AMD и с большинством популярной графики работает.

Kobalt_x

18.08.2018 21:57Системе вроде нельзя а usermode приложениям можно man CPU affinity. В Винде даже через GUI taskmgr/process explorer

vdem

17.08.2018 19:09+1Зато процессоры стали многоядерными, что практически то же, что и многопроцессорность (для программ). Кстати для того же VirtualBox вполне можно выделить отдельное ядро (или несколько ядер) — вот вам и «песочница».

oldbie

17.08.2018 21:50+1Если упростить то причина в overhead согласования — сложность и дороговизна.

SergeyMax

17.08.2018 23:22почему многопроцессорные ПК стали редкостью?

Мне кажется, при наличии денег они немедленно перестают быть редкостью)

stychos

18.08.2018 00:56+1Никто Вам не мешает купить материнку а-ля Z10PE-D16 WS и воткнуть туда два 24-ядерных процессора и полтерабайта оперативки. Ну кроме зарплаты, разве что.

daggert

18.08.2018 02:18Можно Huanan двухсокетный взять (: Дешевле в разы. Используем для рабочих станций, вполне неплохая штука за свои деньги.

stychos

18.08.2018 02:50Можете пример привести? А то первый раз слышу про такое, беглый гугл многосокетных не выдаёт. Вообще, сейчас на рынке полно дешёвого б/у на 1366м сокете за копейки, можно за очень вменяемые деньги построить достаточно мощную систему, если не обращать внимание на новые фичи процессоров и TDP.

rogoz

18.08.2018 03:09Почти первая ссылка в гугле:

ru.aliexpress.com/item/New-arrival-HUANAN-ZHI-X79-dual-CPU-motherboard-CPU-Intel-Xeon-E5-2680-V2-SR1A6-RAM/32891361324.html

stychos

18.08.2018 03:52Вы уж простите, но это никак не в разы дешевле, а очень даже в два раза дороже чем вышеупомянутая z10pe-d16 ws. Да и на чуть более старой платформе с какой-то кастрацией по памяти.

SergeyMax

18.08.2018 09:07+1Мне кажется, там цена за мать с уже установленными процессорами и памятью.

daggert

18.08.2018 10:47https://m.aliexpress.com/item/32896997783.html

Матплата + два проца + память. Не последний чипсет, не свежие процы, но производительность мне нравится.

Kwisatz

18.08.2018 11:3150 тысяч? О_О серьезно? Да у нас б/у сервак дороже стоит мне кажецо)

И как оно на вкус? Вот хочу но не знаю зачем) у меня i7 960 + 18 gb DDR 1333, вроде и хватает, а тут такая красота.

daggert

18.08.2018 14:20С телефона не могу найти, но буквально позавчера другу показывал набор X79 за 20к в виде мвтплаты, проца и 8 гигов ддр3.

Сам покупаю наборы 10-ти ядерные на одном проце за 20к комплект, выходит дешевле чем любой новый ритейл тут.

dartraiden

19.08.2018 18:11Тесты (в однопроцессорной конфигурации) есть тут (там же можно поглядеть другие процы/сокеты).

stychos

18.08.2018 12:53Дороговато будет за такого франкенштейна.

SergeyMax

18.08.2018 15:19Предлoжите варианты дешевле?

stychos

18.08.2018 15:29У Вас либо ударение не там, либо буква не та.

Нормальная некитайская матплата, в среднем сто баксов.

32 гигабайта памяти до сотни баксов.

Процессор, где-то по 130 за единицу.

Сумму сами посчитайте, и учтите, что если искать по аукционам, то может ещё раза в два дешевле выйти.

SergeyMax

18.08.2018 16:40С ударением вроде бы всё в порядке, так же как и с буквой.

По стоимости если всё сложить, то уже получается 500 долларов, + стоимость доставки из США через посредника, + на выходе материнская плата с нестандартным разъёмом питания, а если что-то не заведётся (V2 процессоры вообще заявлены для этой ревизии платы?), то кому из продавцов предъявлять претензии?

Вариант конечно имеет право на существование, но в целом не всё так радужно…

stychos

18.08.2018 20:29С ударением вроде бы всё в порядке, так же как и с буквой.

Не уверен, звучит в Вашем варианте дико.

с нестандартным разъёмом питания

Чушь какая, там вполне стандартный разъём.

а если что-то не заведётс

То оно также и на Вашем франкенштейне не заведётся. С возвратами также как и на алишках.

Вариант конечно имеет право на существование, но в целом не всё так радужно…

Очень даже имеет, не все готовы выкидывать в два раза больше денег ради китайского нонейма в сборе, кое-кому удобнее повыискивать лоты с нормальными ценами, не переплачивая за воздух.

zxweed

18.08.2018 13:11за такую кучу денег можно на родной интеловской плате собрать десктоп — natex.us/intel-s2600cp2j-motherboard

Karpion

18.08.2018 17:18Потому что синхронизировать кэш между процессорами-чипами — дико долго. А работать без синхронизации кэшей — современные программы (особенно операционки) не умеют.

Следующий рывок производительности ожидается при переходе на NonMA (раздельная память процессоров при быстрой шине); либо при UMA+S (общая память с раздельным использованием — без синхронизации кэшей).

Фразу «в память лезть дольше» я не понял. В NonMA — у каждого процессора собственная память, в неё он лазает быстро. Особенно если учесть, что другие процессоры туда не лазают, коллизий не бывает.

В UMA+S — пожалуй, да: лазать в память будет дольше, и коллизии при одновременном cache-miss будут.

PS: Т.к. я не могу постить ответы чаще чем раз в час — хорошо бы обсуждать это там, где третьи лица не могут помешать двум приличным людям культурно обсуждать интересующую их тему.

Gryphon88

18.08.2018 23:10Да я больше ною, чем что-то деятельно предлагаю, всё-таки я не лид топовой хардварной или софтварной фирмы. У меня чёткое ощущение, что проблему «программы должны работать быстрее» стыдливо спихивают друг на друга: программисты в массе своей не используют возможностей оборудования (векторизация, многоядерность, гетерогенные системы, да даже локальность памяти), спихивают компиляторщикам, те — разработчикам ОС, те — разработчикам оборудования, а те в итоге делают страшные глаза и советуют каждые 3-5 лет ставить топовый процессор и удваивать объём оперативки. В итоге переживать о том, чтобы кривое десктопное приложение на JS не тормозило, должен кто угодно, но не программист.

Понятно, что надо потихоньку уходить от концепций, сформировавшихся, когда частота процессора совпадала с частотой памяти, а кэшей вообще не было, а не вбивать костыли в промышленных масштабах. Но скорее всего тот, кто это попробует сделать, сверхприбылей не обрящет, а проблем соберёт со всей индустрии.

cher11

18.08.2018 08:25Как видим, самый мощный современный ARM-процессор Snapdragon 835 (производитель: Qualcomm) сильно проигрывает в производительности даже системе на Celeron N3450.

Имхо, так себе сравнение, один из участников заведомо в проигрышных условиях. Я делал проще — брал Safari и сравнивал производительность в браузере (MacBook Pro 2014 15" Core i7 и iPad Pro 10.5) — и что по результатам тестов, что по реальным ощущениям iPad уже быстрее, чем ноутбук. Результаты GeekBench говорят примерно такие же вещи.

Понятно, что тяжелый и специализированный софт надо будет адаптировать, но, если все будет так, как с браузерами — Интелу действительно грозит неиллюзорная возможность быть в пролете :)

SergeyMax

18.08.2018 09:10по реальным ощущениям iPad уже быстрее, чем ноутбук

Ой, об этом не стоит беспокоиться. Пара обновлений iOS, и такое ощущение как рукой снимет)

cher11

18.08.2018 10:17Да, к сожалению, аппетиты (или кривизна — сложно сказать) софта растут очень быстро. Из-за этого iPad до сих пор на iOS 10.3, кстати.

iproger

19.08.2018 08:10Он быстр, да. Но чувствую что через пару лет станет медленным как и предыдущие. Замедление и софт сделают своё дело.

advan20092

20.08.2018 09:51Странно, учитывая что ios11 принесла немало нового именно для планшетов. Да и в 12 обещают существенные улучшения. Я особой разницы в производительности не заметил на аналогичном планшете.

Alex_ME

18.08.2018 10:08А всякие SIMD и прочее? У ARM есть NEON, но он 128 битный против 256/512 AVX. А также кэши, бранч-предикторы, разная встроенная периферия, которая, по рекламным словам интела, все лучше и лучше. А также специфическая оптимизация под конкретное железо, хотя это больше к HPC относится.

Dima_Sharihin

18.08.2018 15:04кэши

Кэши есть даже у микроконтроллеров. Вопрос в их объеме и ширине.

бранч-предикторы

Как и спекулятивное выполнение. Это же есть и у ARM, и это — часть проблемы Spectre (которой так же подвержен)

разная встроенная периферия

Простите, я думал, что как раз ARMовские SoC радуют пользователя "периферией на любой вкус и цвет"+гетерогенные системы. Чего такого интересного есть у интела?

maxzhurkin

18.08.2018 10:41… а траектория развития процессоров ARM превзойдёт закон Мура

Но Закон Мура — про количество транзисторов на кристалле, а не про развитие, производительность или что-то ещё

Gordon01

18.08.2018 13:22Слабо что-то верю в ARM, они обещают захватить ноутбуки уже лет 10, да вот только ОС для этой архитектуры так нормальной и не сделали. Андроид как-то существует, благодаря тому, что нет разделения на планшетную и смартфонную версию, apple кажется забила на планшеты.

В итоге ms surface go с х86 процом и аккумом 6 Ач на лески раной винде работает 7 часов. Аналога на ARM не видно что-то

Dima_Sharihin

18.08.2018 15:10вот только ОС для этой архитектуры так нормальной и не сделали

Под ARM давно есть и Linux, и Windows и еще куча разных других операционных систем. Если вы говорите про "десктопное окружение для домашнего пользователя", то профита в ARM-ядре особо нет. Кому не нужна производительность, берут Intel Atom, а до быстрых решений ARM Cortex не догоняет.

Что до эмбеддеда, то ARM там живет и здравствует: производительность там особо не нужна, а в обращении он будет попроще.

Аналога на ARM не видно что-то

Был Surface RT, похоронили тупейшей политикой распространения приложений (а жаль). На любой андроидопланшет гипотетически можно было бы поставить обычный Debian, но, как человек, ставивший Arch Linux на ASUS Transformer TF300T, скажу, что пингвин не приспособлен к планшетному применению и Windows 10 намного впереди.

advan20092

20.08.2018 09:56Да видели мы в обзорах как этот go работает. Тупит по страшному — по сути это дорогой нетбук с переименованным атомом и emmc памятью. Планшеты Apple вполне себе живы-здоровы. Приложений хватает, вот обещают фотошоп скоро подогнать.

Goodkat

18.08.2018 17:20+4Полправил вам заголовок: Новые процессоры ARM, которые сейчас пока ещё только в проекте и через два года должны появиться в продаже, смогут потягаться со старыми Core i5, которые вышли два года назад, а на тот момент будут уже четырёхлетними.

Diordna

18.08.2018 17:59-2До сих пор сижу дома на q9550. Подскажите если в интернете Существует сайт с результатами реальных тестов(winrar videodecoding) производительности процессоров чтобы можно было сравнить свой камень с каким-нибудь кор ай5 8400 и понять какой будет примерно прирост производительности.

Chamie

19.08.2018 06:29А PassMark — достаточно «реальный» тест?

powerman

19.08.2018 14:00По моим наблюдениям — да. Я многократно за последние годы перепроверял его на разных реальных задачах, практически всегда разница в скорости работы этих задач на разных процах соответствовала разнице в рейтинге этих процов на PassMark.

iproger

19.08.2018 08:10Сайт? Самый популярный userbenchmark.

Diordna

20.08.2018 00:59+138% i5 8400 vs q9550 реально?

cpu.userbenchmark.com/Compare/Intel-Core-i5-8400-vs-Intel-Core2-Quad-Q9550/3939vsm334

iproger

20.08.2018 01:11В теории? Вполне возможно. Я бы не смотрел на такие метрики потому что даже если в теории они и такие, то на практике обычно все не настолько хорошо.

Надо еще понимать для чего он нужен. Например, в новейших играх на 1080ti его будет не хватать. В то же время для обычных задач будет с избытком.

DrPass

20.08.2018 02:12+138% i5 8400 vs q9550 реально?

Для процессоров, между которыми лежит почти десятилетие? Ну, если вы отмотаете примерно столько же времени назад, конкурентом q9550 будет что-то вроде Pentuim III 450. Там разница в быстродействии будет раз в тридцать, если не больше.

loki8

19.08.2018 11:01еще пяток уязвимостей типа spectre|meltdown найдут и core i5 сравняется не только лишь с ARM, а даже с core2quad.

Viacheslav01

19.08.2018 14:13+1Сколько лет я слышу: АРМ скоро догонит х86, все еще догоняет. Сколько слышу, что мобильные уже гораздо мощнее Хбокса 360, а игры на них все еще далеки от старичка и все еще тормозят. Подождем еще…

evocatus

А я думал, что приложения пишутся на C/С++/Java, а дальше их можно скомпилировать, например, под ARM, что и позволяет выпускать тот же Debian(с десятками тысяч пакетов) под десяток разных архитектур.

Понятно, что есть всякие SSE, AVS и пр., но их использует очень небольшое количество ПО и, насколько мне известно, современные компиляторы ещё не умеют автоматически использовать эти возможности.

picul

Ну их использует как раз то ПО, тормоза которого будут ощутимы, потому что как раз с этим ПО люди заморачиваються.

Умеют, хоть и не дотягивают пока до человека (насколько я знаю).

Вообще, насколько я знаю, Винда ARM очень слабо поддерживает, так что наверное проблема еще и в этом. Ну и разные архитектуры означают разные инструкции и их характеристики.

Am0ralist

винда арм то поддерживает. ей интел перекрыл возможность поддерживать x86 на арме…

picul

Как он это сделал?

springimport

Патентами, конечно.

DrPass

А как можно запретить патентами использование набора команд? К тому же существующему в несколько раз дольше, чем действует срок патентной защиты.

evocatus

bfy.tw/JSX3

picul

Чего же Intel не перекроет аналогичную возможность AMD? Они (Intel) бы себя неплохо почувствовали.

imanushin

Тогда антимонопольные комитеты остановят Intel. А точнее — производитель компилятора сможет пожаловаться на Intel Compiler (как это сделал производитель браузера Chrome, который пожаловался на Microsoft), так что Intel'у придется отдать рынок компиляторов. Потом производитель чипсетов пожалуется и т.д.

А так сейчас у Intel'а есть доля в 80-90% от процессоров х86/х64, плюс доля на рынке компиляторов и тд. А если занять 100%, то отнимут все дополнительные рынки.

Xalium

у AMD них с Intel кросс-паненты. Минимум набор команд x86-64 принадлежит AMD.

Newbie2

Потому что тогда они станут монополистами, а это их самый страшный кошмар. Антимонопольщики принудительно их поделят на две компании и все, нет Интел. А благодаря АМД соблюдается видимость конкуренции при фактическом ее отсутствии. Поэтому мне лично кажется, что АМД это внебрачная дочка Интел.

evtomax

Cейчас у крупных игроков конкуренция в основном с самими собой. То есть процессоры улучшают для того, чтобы ими заменяли ещё вполне рабочие старые процессоры.

we1

AMD не дочка, а сестра. Две конторы были основаны, скажем так, хорошими знакомыми.

0lympian

Там все значительно запутаннее и интереснее, рекомендую посмотреть на ютубе «16 бит тому назад» — там есть несколько серий «intel vs amd»

Am0ralist

Примерно так

АМД существует только потому, что иначе антимонопольщики бы их загрызли.

Newbie2

Именно поэтому АМД никогда и нигде не обгонит Интел, как бы того не хотелось фанатам.

Am0ralist

Почему, поэтому? Потому, что у них патенты кросс имеют и обе компании могут ими легко пользоваться в разработке своих продуктов?

Так то она их уже обгоняла, если не в проданных штуках считать, а по производительности.

Newbie2

Ну да, обгоняла. Видимость острой конкурентной борьбы показали, а теперь все. Спектакль окончен.

walti

Так уже года 2 как)))))))

Во-1, АМД младше Интела… на 1 год. 1969 против 1968-го, до создания микропроцессора на х86 архитектуре оставалось… 10 лет

(это из оперы Интел придумал АМД)

Во-2, если посмотреть тестирования Интел вс АМД с включенными патчами от мелдония и спектры, то Интел не смотрится от слова совсем.

В-3, самая быстрая платформа — за АМД.

ПС. У Интела сейчас цейтнот, нет идей, постоянные скандалы, отсутствие диверсификации бизнеса.

Newbie2

Во-первых, интел не придумал, а, как мне кажется, купил АМД. Только без шуму и через подставные фирмы.

Во-вторых — патчи мелдония, скорость платформы… Это все неважно. Для корпораций важна прибыль и доля на рынке. Интел гребёт бабло лопатой, монополизировав рынок десктопов, ноутбуков и весь корпоративный сектор от корпоративных же ноутбуков и вплоть до серверов. А АМД притворяется живой.

fatronix

То что у AMD меньшие объемы на рынке не означает, что они фиктивная компания.

x67

sarcasm

Ну как же, я комп собирал — выбрал интел. Все друзья собирали, выбрали интел. Значит амд мертва!

/sarcasm

klirichek

А я вот без сарказма… Собирал себе впервые десктоп (до этого покупные готовые ноуты/компы напрочь устраивали). Всё посчитал, взвесил… Взял материнку под AM2 (давно дело было) и на тот момент "что-то" из amd из процессоров. Позже вышел (впервые!) 4-ядерный феном, взял свежую материнку (уже под AM2+) под него (ещё порадовался, что она гораздо дешевле интел-ориентированных) и его самого, с теплопакетом в 95 ватт…

Погонял два-три года… Ну, как сказать… Десктоп вполне отзывчивый. Перекодировать видео (на тот момент на "новый" H264 — уже натяжно… Кодирует, но ревёт всеми кулерами, как паровоз… И десктоп в то же время начинает уже подтормаживать).

И вот тут внезапно попался задёшево ноут на core i5, того же поколения, что мой phenom… И внезапно выяснилось, что то же видео он кодирует раза в полтора быстрее, при этом не ревя кулерами и не подтормаживая…

И теперь материнка с феномом, оперативкой и кулерами лежит в загашнике "про запас", потому что интеловские решения (в совокупности; мамка + проц) оказались в реальной жизни гораздо более внятными

Greendq

Я тоже без сарказма. Занимался перекодированием видео — много, очень много (терабайты). На Opteron/Xeon специально собранными кодеками под конкретный процессор для задействования всех доступных инструкций. Разница в скорости — в пределах погрешностей. При этом Opteron-ы значительно дешевле Xeon-ов.

Так что всё очень сильно зависит от того, чем конвертировать. :)

nckma

Сейчас у Интела аппаратный кодек прямо в чипсете: QuckSync. Не знаю как у АМД

Sap_ru

У АМД встроенная видюха, которая рвёт интелловскую, как тузик грелку, и на ней есть аппаратный кодек.

walti

Ноут с поколением равным феному — это 2008 год и это аррандейл, и они весьма унылы… если не использовать его встроенный аппаратный кодер, который тоже весьма уныл.

Скажем честно, не только лишь все из нас, способны смотреть на артефакты кодирования аппаратного кодера Интел.

И чем больше частота (svp просто прекрасен) и разрешение, тем большую усмешку вызывает результат.

Сейчас не эпоха S-VHS, и пятна и артефакты вызывают раздражение.

walti

Обе компании — публичные, можно смотреть, кто владелец акций, это не секрет.

Интел догребает деньги лопатой, ибо в мобильный сектор его не пустили, АРМы они уже не производят, немного делают флеш ( но помнится они уже погрызлись с Микроном), модемы помнится тоже не вышли.

Видеокарты -всё (найт корнер, который в девичестве должен был стать первой в мире ВК на х86 — снят с производства).

Контрактным производством интел не занимается, да и проблемы с новыми ТП у них начались.

Альтера в виде сопроцессора не прижилась — а как дышали, как дышали.

Учитывая все вышесказанное — перспективы не очень.

Да обороты громадные, да — большая часть рынка его (пока).

Но «титаники» всегда тонут долго и пафосно.

walti

Проблемы Интела, как я вижу — как и у любой большой корпорации -они не хотят рисковать.

А каждый раз когда пробуют (в надежде прогнуть рынок) -получается факап, как с Итаником или нетберстом.

В результате они сидят на сверхудачной архитектуре Коре разлива 2006 года, вяло копирую наиболее удачные решения АМД.

ИКП -не они придумали, х86-64 — тоже называется АМД64.

Первый двуядерник, тем более на одном кристалле — не они, интегрированное видеоядро — типа они, но это склейка.

Единственное толковое — встроенный VRM, но в следующей архитектуре Интел его же и похоронила.

В общем, обычная закостенелая контора с весьма туманными перспективами.

Newbie2

А мобильный сектор, внезапно, это бэкэнд+веб, которые размещаются в ЦОДах, которые на 99% укомплектованы интелом. Может быть когда-нибудь этот титаник и потонет, но сейчас пророчить ему «интелокапец» рано.

walti

Ой-ли.

IBM точит зубы на этот сектор, АРМ предлагает всякое.

Интелокапец — это понятие перспективное, но Интелу в этом секторе все меньше и меньше есть что предложить.

Newbie2

А пока другие точат зубы и предлагают «всякое», интел гребет деньги лопатой и изменений этому не видно. АМД попыталось влезть, но не пошло. И вряд ли из-за того, что Оптероны хуже были. Маркетинг, он такой.

khanid

И IBM кроме точения ничего не остаётся, по большому счёту, потому что их цены не способствуют широкому распространению. Только там, где готовы тратить такие деньги — это либо что-то специфическое, либо крупный энтерпрайз. А для рядовых ЦОД/компании пока по-прежнему сильно выгоднее hpe/dell на интелах.

carebellum

у интела идет разработка дискретной графики, планируют выход на рынок в 2020

Sap_ru

С видеокартами они делают хитрое лицо и обещают очень (через год — два) скоро всех порвать в сегменте интегрированных и даже потеснить на рыке дискретных. С другой стороны, они такое лицо уже не раз делали (по крайней мере, относительно интегрированных) и каждый раз кончалось пшиком — конкуренты за время разработки и вывода на рынок уходили далеко вперёд.

Dioxin

Уже обгоняли с Атлон 64. Причем по всем статьям.

Весь офисный и бытовой сектор сидел на АМД начиная с К7 и до Х2 пока интел кор дуо не выкатил и цена на него не опустилась до приемлемых.

Только инерционность мышления и корпоративные соглашения позволили Интелу пересидеть до белой полосы.

Если бы в АМД не отдыхали так сильно, глядишь ситуация была бы не так однозначна.

kalininmr

всё немного печальнее. в критичном софте есть куски кода заточенные под конкретную архитектуру. и комплилятор тут не очень помогает.

всяческие особенности работы кеша, длинная арифметика.

dendron

Не всё так просто с C/C++. Код должен быть написан как кросс-платформенный, иначе вместо рабочей программы после сборки получится бинарная какашка. И чем больше и сложнее проект — тем сложнее в нём обеспечивать кросс-платформенность.

Antervis

там всего одно правило: не использовать расширения msvc

Kobalt_x

Ага, конечно.

Про unaligned reads забыли? Что вам будет за это на x86? — правильно ничего а только чтение меделнное а на ARM — sigbus. и в существующем коде их куча.

А это ещё блин только цветочки.

Antervis

армы ж уже умеют читать невыровненную память. Если там еще остались проблемы — ну допилят за пару поколений, всё равно арм в десктопах — сравнительно далекое будущее.

0xd34df00d

А еще прелести модели памяти, из-за чего кривоватый многопоточный код как-то работает на х86, а на армах не работает никак.

Sap_ru

ARM уже давным давно читает unaligned точно так же, как и x86. Даже на микроконтроллерах, не говоря уже более серьёзный SoC. Я бы, даже, сказал, что архитектуры, где он fault выдавал можно ныне считать мёртвыми. И доп. расходы на невыравненные чтение-запись у ARM точно такие же, как и x86.

Dioxin

SSE2 везде используется давно, компьютер без него это кусок кремния.

По этой причине я слез в свое время с Amd K7.