Из предыдущего поста вы узнали, что в ML существует дискриминация. Отлично! Таким образом вы уже разбираетесь в Этике машинного обучения лучше, чем многие инженеры МL. Благодаря примерам (из медицины, анализа твиттов, распознавания лиц) вы наверняка уже сделали вывод, что существуют разные виды предвзятости.

Алгоритмы машинного обучения строят стереотипы на основе каких-либо черт и особенностей, так же как это делаем и мы с вами.

Три кита дискриминации

Есть три характеристики людей, на которых основываются большинство предвзятостей в real-world алгоритмах:

Гендер

Раса

Возраст

Дискриминация может быть против многих характеристик (доход, образование, и т.д.), вытекающих из указанных выше. В алгоритмах, которые работают с людскими данными, ими в основном являются доход, место проживания, образование и т.д.

Одним словом: практически всё, к чему обычный человек может проявить дискриминацию. Эти характеристики называют чувствительными атрибутами (sensitive attributes) — особенности, по отношению которых проявляется дискриминация.

Набор данных, по которым обучается модель машинного обучения, имеет конкретные признаки (features). Признаки (или атрибуты) являются одной из основных причин, почему существует предвзятость в алгоритмах машинного обучения.

Важно будет отметить, что самой модели машинного все равно на то, против чего дискриминировать. Это может быть цвет стебля у растения, глубина глазниц, город рождения кота и так далее. Современные модели не обладают возможностями к мышлению, а являются просто продвинутым инструментом анализа данных.

Если задуматься, то всё кажется вполне очевидным: модель, которая фактически работает за счёт запоминания закономерностей из данного набора данных (а эти данные отражают стереотипы людей), будет наверняка помнить эти не всегда справедливые (или стереотипичные) закономерности и начнёт использовать их для прогнозов.

Примеры дискриминации по половому признаку из алгоритмов машинного обучения:

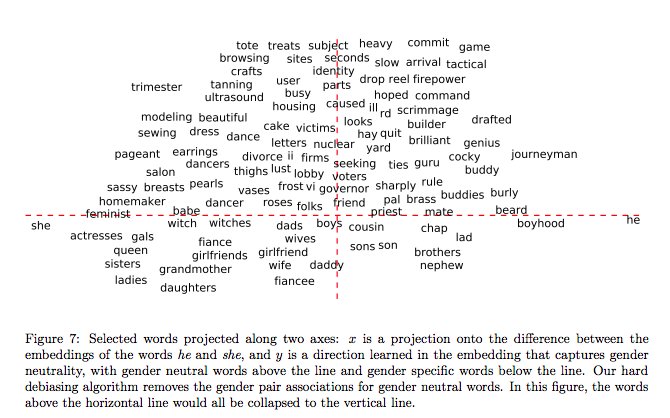

Word embeddings, полученные из статьей с Google News (где материал довольно строго курируется), отражают большое количество гендерных стереотипов («Man is to Computer Programmer as Woman is to Homemaker»)

Точность алгоритмов распознавания лица «IBM’s» и «Face++» значительно ниже для женщин по сравнению с мужчинами («Gender Shades»)

Некоторые алгоритмы допускают серьёзные погрешности во время перевода женского голоса в текст ( «Where is Female Synthetic Speech»).

Предвзятость, связанная с расой, очень удручает многих специалистов в области технологий. Пару лет назад некоторые американские клиники предоставляли темнокожим пациентам почти в два раза меньше средств для специальной медицинской помощи. Используемый алгоритм предсказывал, что темнокожие меньше нуждались в особом наблюдении (https://science.sciencemag.org/content/366/6464/447.abstract) Другой алгоритм, COMPAS, который использовали в американских судах, выдавал в два раза больше ложноположительных (false positive) прогнозов о рецидивизме по отношению к темнокожим, нежели к светлокожим. (https://www.propublica.org/article/how-we-analyzed-the-compas-recidivism-algorithm) Есть еще масса примеров bias’а, который основывается на расе.

Так почему это происходит?

Потому что используются реальные данные о людях и их исходах. Если многие чернокожие на самом деле оказались рецидивистами, эта закономерность запоминается («Чёрные люди с большей вероятностью снова совершат преступление»). Алгоритм не берёт во внимание какие-либо особые обстоятельства, предысторию и прочие элементы трагической жизни индивидуума. А должен ли он? При этом в случаях, в которых алгоритм ущемляет определенные группа из-за социальных стереотипов (как в примере с корпусом слов), он по прежнему является объективным в рамках предоставленных ему данных.

Большинство алгоритмов машинного обучения делают то, что им “говорят” данные и статистические методы. Проще говоря, учатся на прошлом опыте: на объективных данных.

Поэтому возникает вопрос: так разве можно утверждать, что результаты, полученные с помощью такого (объективного) подхода, несправедливы?

Это и есть дилемма этики в ИИ: по мере того, как мы пытаемся стереть грань между человеческим мозгом и «мозгом» искусственного интеллекта, необходимо также определить грань между этическими и нравственными их составляющими.

gleb_l

Дилемма этики в ИИ очень наглядно показывает, что основа политкорректности — ханжество государственного уровня.

ИИ априори не может иметь гендерных, расовых или еще каких-либо предрассудков, поскольку он искусственный — ему не рассказывали про то, кто виноват, если «в кране нет воды», он не воспитывался в домострое с синяками у мамы, не читал новости про убер-таксистов, размазывающих по асфальту выходящих из трамвая пешеходов, не впитывал лексику и повадки беззубых жителей 101 километра. ИИ оперирует лишь полуразмеченным корпусом данных, в которых он находит закономерности, не зная, в отличие от человека, политкорректно или нет называется тот или иной столбец данных, и политкорректен ли будет вероятностный вывод класса из набора свойств.

Но, поскольку ИИ делает выводы, подобные нынешним выводам сообщества людей (частным до сих пор, или публичным, не запрещенным еще в недавнем прошлом) — это означает, что эти выводы — более объективны, чем скоррректированные современной моралью. То есть, сходство выводов беспристрастного ИИ и внутреннего классификатора человека (даже искаженного воспитанием и средой) доказывает то, что статистическая разница все-таки существует. Независимо от того, запрещено или разрешено ее признавать публично.

В современной политкорректности есть подмена фундаментальных понятий и перекладывание ответственности с общества/среды на конкретного индивидуума-декларатора. Почему нельзя сказать, что средний уровень зарплаты афроамериканцев меньше, чем белых? Или женщин, чем мужчин? Почему мы не можем вывести собирательный портрет типичного преступника, если он мигрант, хотя и то, и другое, и третье подтверждается статистически, но в то же время можем сказать, что типичный француз — прижимист, немец — расчетлив, грузин — гостеприимен, японец — сдержан, а русский — хмур?

Потому, что за зарплаты, образование и преступность отвечает само государство — своей текущей и прошлой социальной политикой, а за национальные особенности — что-то гораздо более древнее, что к текущей власти отношения не имеет. И вместо того, чтобы обеспечить людям из разных кластеров равные возможности (сработает не сразу — нужно несколько поколений !) — просто запрещают вслух признавать очевидные даже ИИ различия — поскольку такое признание на самом деле не столько оскорбляет принадлежащего к кластеру человека, сколько ставит вопрос о *причинах* этой принадлежности. А постановка этого вопроса вызывает exception в современной системе команд, как недопустимое значение указателя — так как указывает он на тех, на кого указывать нельзя.

Politura

Угу, этот самый ИИ делает свои выводы на основе тех данных, что ему подсунули для обучения. И вот эти данные могут быть сильно неоднородными, в этом случае модель обученная на таких данных с одними объектами будует работать хорошо, а с другими плохо. Например, если вы попытаетесь обучить какую-то систему определения лиц на фотке отдав в ей в качестве обучающей выборки исключительно фотографии белых, то после обучения на фотографиях чернокожих она будет ошибаться намного чаще, чем на фотографиях белокожих.

Но разумеется в самом машинном обучении накакой дескриминации, или там расизма нет. Есть только человеческие ошибки в подготовке данных для этого самого обучения, которые могут приводить в том числе и к дискриминациями. Например, в статье дана ссылка www.propublica.org/article/how-we-analyzed-the-compas-recidivism-algorithm по ней некие исследователи изучали какую-то систему, которая оценивала преступников давая им 3 параметра: риск рецидива, риск опасности и еще чего-то там. Эти исследователи якобы нашли, что система ошибочно давала чернокожим высокий риск рецидива гораздо чаще, чем белым: 45% ошибочно высокий риск рецидива чернокожим и 23% ошибочно высокий риск рецидива белым. Я не знаю, так ли это (впервые слышу о propublica.org), но если они правы, то значит обучающая выборка была кривая.

Dair_Targ

Так а в чём проблема? Допустим есть система, описываемая функцией f(x). На выходе получаются какие-то результаты — ну там американские негры преступники или там русские водку литрами пьют, а хохлы сало едят как не в себя.

И дальше есть выводы, которые должны получиться: распределение преступлений по оттенку кожи — константа, русские пьют на равне с арабами из Мекки, а хохлы употребляют сала столько же на человека, сколько и евреи на Хануку. Опишем разницу между результатом f и тем, что должно получиться, как g(y).

Ну и давайте на выходе скрестим эти системы — получим g(f(x)). Подозреваю, что при должной проработке функции g от функции f вообще можно будет отказаться за ненадобностью.

SinsI

evadesad

ИИ учится на данных, которые ему предлагаются. Вот и Амазон пытался сделать идеальный ИИ хайринговый инструмент, научив их «хорошим кандидатам» и «плохим кандидатам».

ИИ научился на выданных ему данных, и отсеял всех кандидатов, которые ходили в женские школы или колледжи, были капитанами женских спортивных команд и вообще имели косвенные указания на женский пол в резюме.

slate.com/business/2018/10/amazon-artificial-intelligence-hiring-discrimination-women.html

Значит ли это, что женщинам объективно не место в Амазоне, если только не подключить современную мораль?

А ещё вот про непредвзятость, объективность, мораль и здравый смысл:

«he program also decided that basic tech skills, like the ability to write code, which popped up on all sorts of resumes, weren’t all that important, but grew to like candidates who littered their resumes with macho verbs such as “executed” and “captured.»

Можно ли считать, что объективно программисту не важно умение писать код, а гораздо важнее быть executed или там captured?