Привет всем! Сегодня состоялся релиз InvokeAI 2.0: A Stable Diffusion Toolkit, проекта, цель которого — предоставить энтузиастам и профессионалам набор надежных инструментов для создания и редактирования изображений с помощью нейросети. InvokeAI требует всего ~3,5 Гб видеопамяти для создания изображений 512x768 пикселей (и еще меньше для 512х512), и совместим с Windows/Linux/Mac с M1 и M2.

Что такое InvokeAI

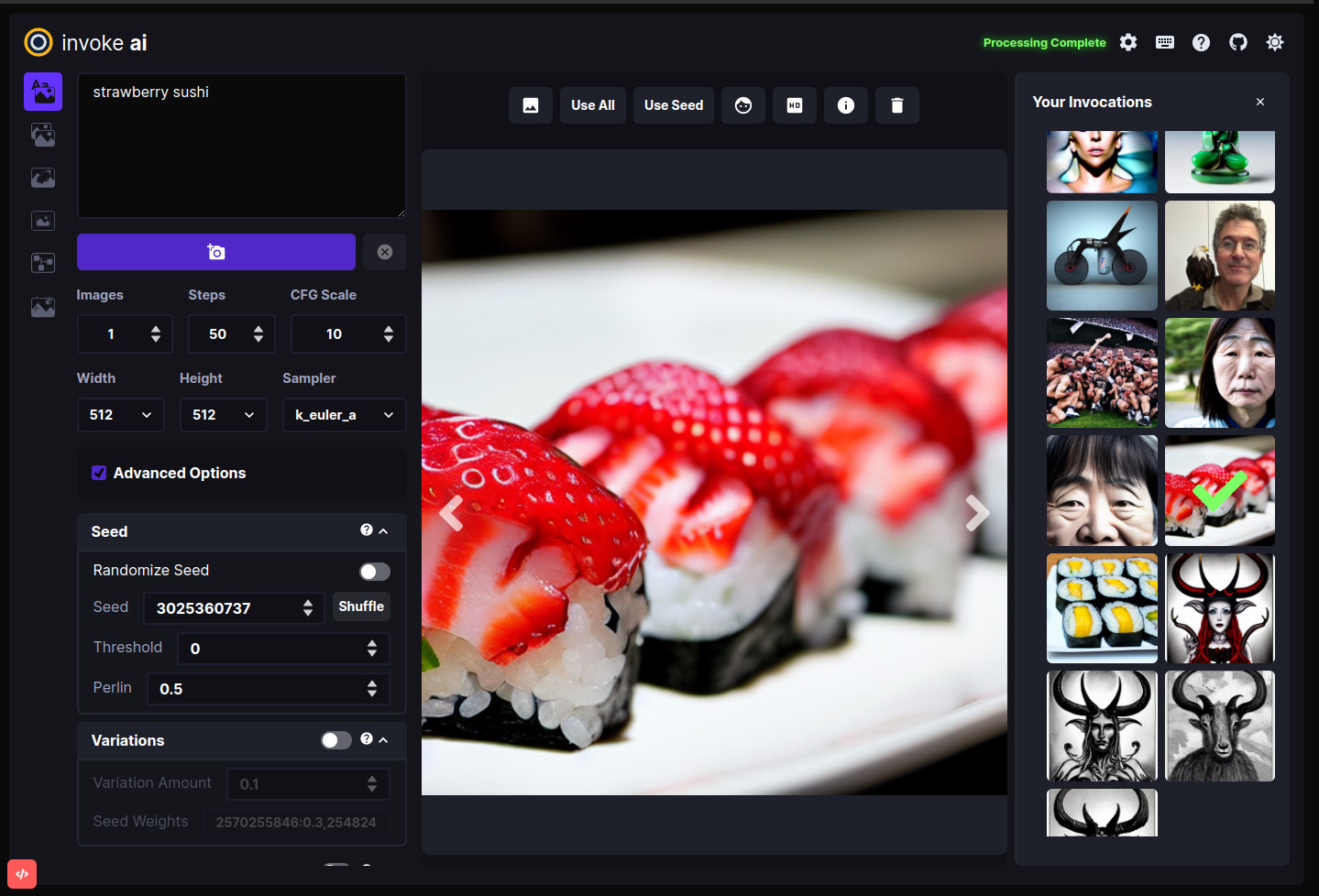

InvokeAI (ранее lstein/stable-diffusion) был одним из самых ранних форков основного репозитория CompVis, а теперь превратился в полноценный инструментарий Stable Diffusion с открытым исходным кодом под названием InvokeAI. В новой версии у нас появился совершенно новый графический интерфейс с возможностью запуска в отдельном от браузера окне в режиме desktop и оптимизированный back-end сервер, с которым можно взаимодействовать через командную строку или расширять с помощью собственных форков.

Эта версия приложения упрощает работу с изображениями, используя gfpgan и Codeformer для восстановления лиц, а также Realesrgan для увеличения картинок в 2 и 4 раза. Кроме этого, командная строка также поддерживает большое количество функций:

Inpainting — изменение отдельных частей изображений по маске.

Outpainting — дорисовывание изображений вокруг оригинала.

Prompt Unconditioning — удаление ненужных вам объектов из генерации.

Textual Inversion — обучение нейросети вашим стилям на ваших изображениях и встраивание ваших объектов в сгенерированные картинки.

Embiggen — генерация изображений с большей детализацией средствами нейросети

Улучшенное качество изображений с высоким разрешением — без повторяющихся паттернов-артефактов (которые бывают и Embiggen, Gobig, img2imghd и др.).

И многое другое :-)

Дальнейшая разработка

В ближайшем будущем планируется значительное обновление интерфейса для outpainting/inpainting, поддержка Cross Attention (позволяет заменять части изображения без потери его основы), а также новый интерфейс с нодами (например, как в блендере) для более гибкой работы, автоматизации рабочего процесса и обмена готовыми шаблонами с сообществом.

Мы очень рады этому релизу и большим возможностям для творчества в будущем. Загляните в репозиторий (https://github.com/invoke-ai/InvokeAI) , чтобы начать работу, и присоединяйтесь к нам в Discord (https://discord.gg/ZmtBAhwWhy — на английском)!

От себя: Меня зовут Артур Нецветаев, я менеджер продуктов, предприниматель и дизайнер интерфейсов. Я помогаю с разработкой интерфейса InvokeAI и пользуюсь им сам с момента создания.

Комментарии (10)

Araki_Satoshi

15.10.2022 17:13+1Как обычно только для Nvidia-бояр?

netsvetaev Автор

15.10.2022 20:33+3а вот и нет! Это кроссплатформенный форк и оптимизированный для маков. Работает и на нвидии, и на амд, и на м1, и даже немного на интелах (но ооочень медленно!) :-)

Araki_Satoshi

15.10.2022 20:57+1Странно, на гитхабе глянул, в requirements просят либо нвидиа, либо м1. Надо попробовать самому, я буду рад даже если она 10 минут (вместо 30 секунд на колабе) генерировать картинку будет на моей амд карточке

netsvetaev Автор

15.10.2022 21:07+1Я поторопился и неточно выразился. Юзеры с амд есть, генератор работает, но с виндой+амд, похоже, проблемы. https://github.com/invoke-ai/InvokeAI/issues/1019. Там есть ссылка на статю про работу на амд https://www.travelneil.com/stable-diffusion-windows-amd.html

foxairman

16.10.2022 14:23А там встроенные модели уже и ничего скачивать не нужно? Я пробовал ставить нейронку с веб-интерфейсом по гайду, там нужно было модель отдельно качать. А запуск нейронки сделан через bat файл и потом через браузер заходишь по локальному IP.

Soren

16.10.2022 20:14+1Нужно. Почитайте инструкцию по установке InvokeAI на GitHub по ссылке в статье, там всё есть.

netsvetaev Автор

16.10.2022 20:31+1Сейчас вам нужно просто скачать общую модель на 4.3гб. Авторизация не нужна, где вы найдете этот файл (sd-v1-4.ckpt) — не важно. В мануале есть прямая ссылка https://huggingface.co/CompVis/stable-diffusion-v-1-4-original/blob/main/sd-v1-4.ckpt. Тут вот есть какой-то торрент и гуглдрайв https://cyberes.github.io/stable-diffusion-models/#standard-model.

Потом перетащите в указанную в мануале папку (или создадите симлинк) и инициализируете — и все будет работать.

Но мы уже тестируем установку все-в-одном, скоро будет.

yar3333

О, outpainting завезли! Вроде ещё неделю-две назад его не было, приходилось сначала натравливать lama-cleaner для дорисовки, а затем уже делать inpainting для перерисовки на нечто более подходящее. Спасибо за статью!

netsvetaev Автор

Пожалуйста. На самом деле, там еще очень много работы с outpainting, хочется сделать его в графическом интерфейсе, как и все остальное. Получится такой мини-фотошоп, встроенный в SD. Но меня поражает, как быстро идет разработка.