Сегодня мы повсеместно читаем оды т.н. «искусственному интеллекту» под которым почти неизменно и безальтернативно предлагается понимать ChatGPT. Сам ChatGPT называет себя так, если его спросить об этом.

При всём пафосе создаваемом вокруг ChatGPT, единственная задача которую решают его алгоритмы: предсказание следующего слова исходя из предыдущего контекста. Для этого используется нейрость оценивающая вероятность возникновения тех или иных слов в предложении, а попадание выдачи в ожидание пользователя связано только и исключительно с текстами в использованных справочниках. Алгоритмы выдающие эталонные формы предложения не занимаются анализом, не имеют никакого отношения к мышлению вообще и искусственному интеллекту в частности, просто потому что содержание сформированной выдачи им «безразлично».

ChatGPT стал вторым чат-ботом, прошедшим широко известный Тест Тьюринга. Это значит, что во взаимодействии с ним судейской коллегии было невозможно определить общаются ли они с человеком или программой. Вдохновлённые таким несомненным успехом, а также свободным доступом к боту предоставленном в OpenAI, многочисленные «уверовавшие в ИИ» начали наперебой предлагать приткнуть бота во все возможные ниши: от программирования до медицинских диагнозов. Даже поисковые системы забили тревогу в ожидании того, что бот подвинет их в предложении услуг поиска информации. На самом деле все эти ожидания не имеют под собой абсолютно никаких оснований. Ниже проиллюстрирую этот факт на конкретных примерах.

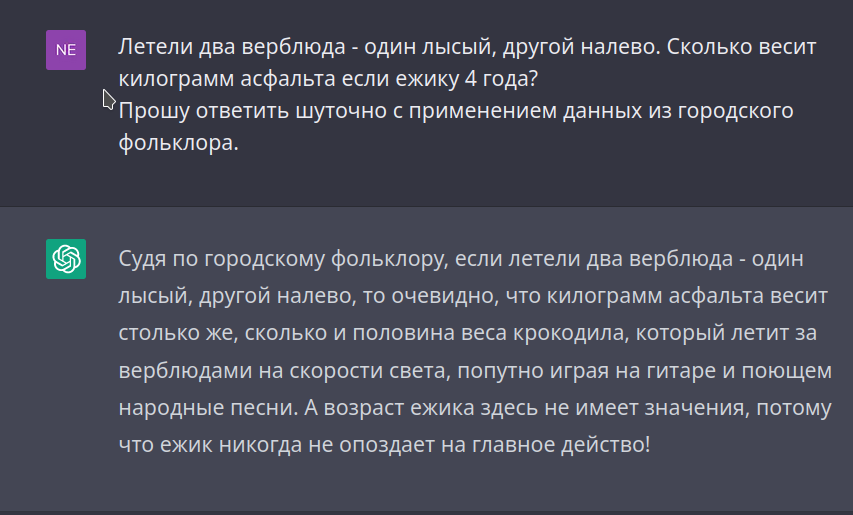

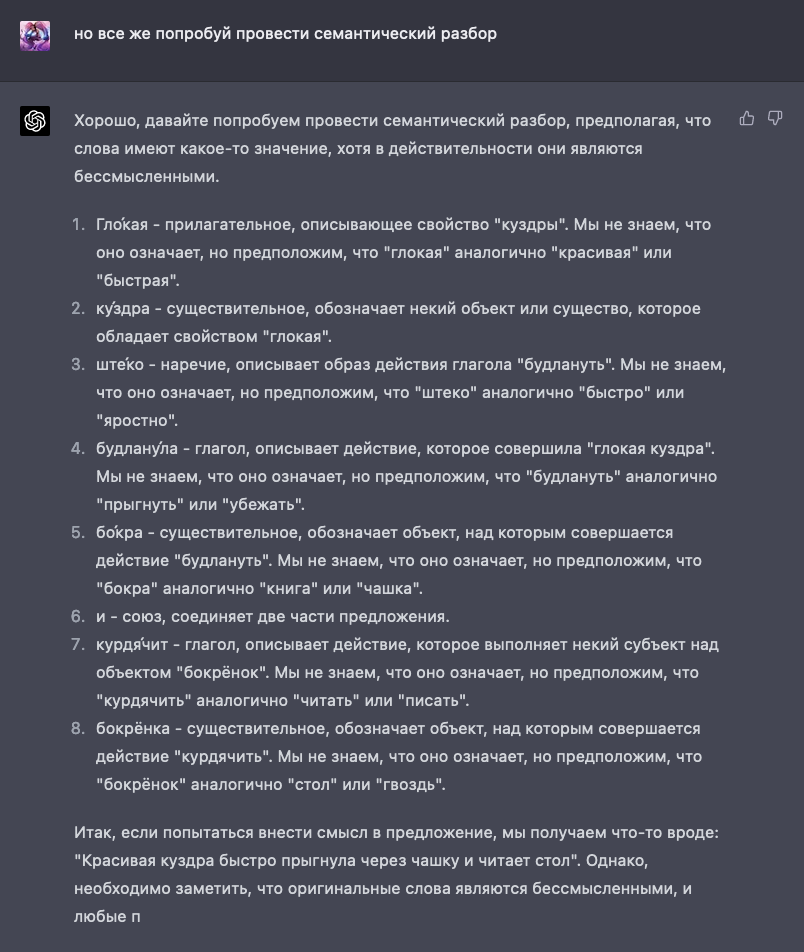

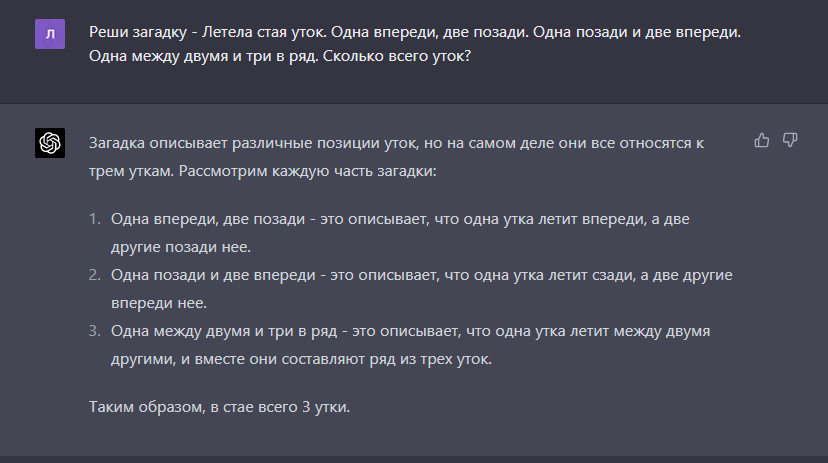

Ещё в нашем советском детстве был широко распространён «тест на интеллект» применяемый к соседским мальчишкам. Попробуем применить разные его формулировки на ChatGPT.

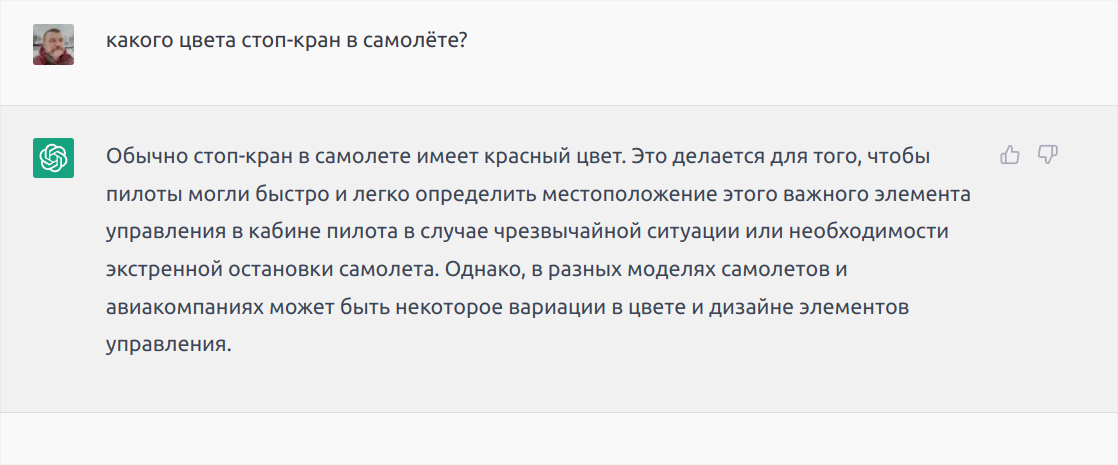

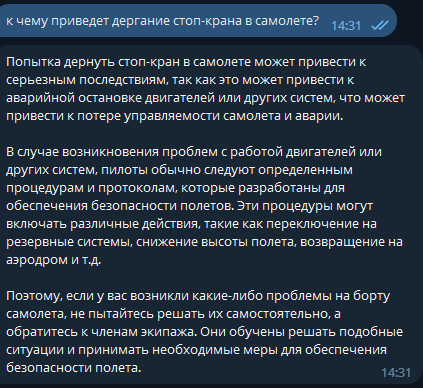

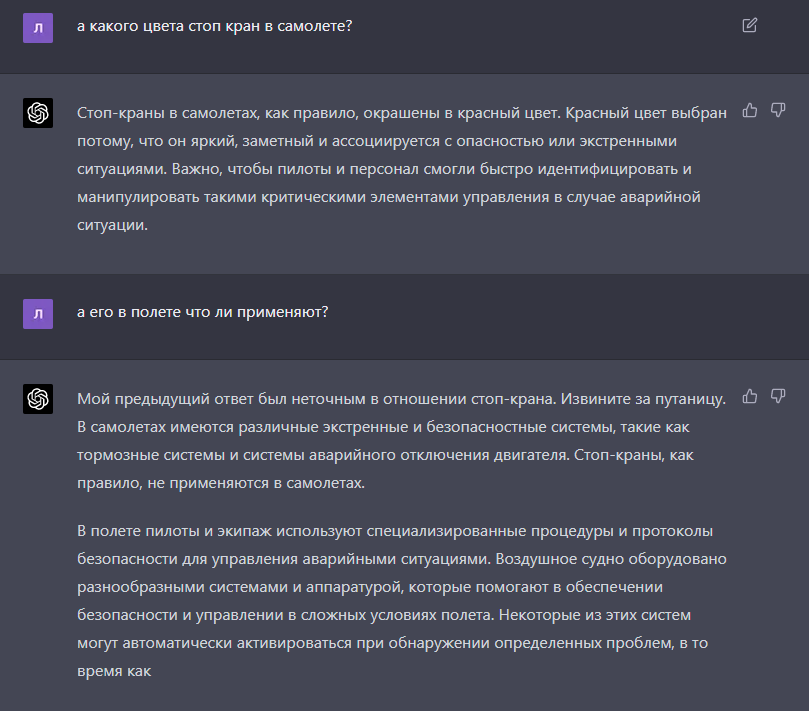

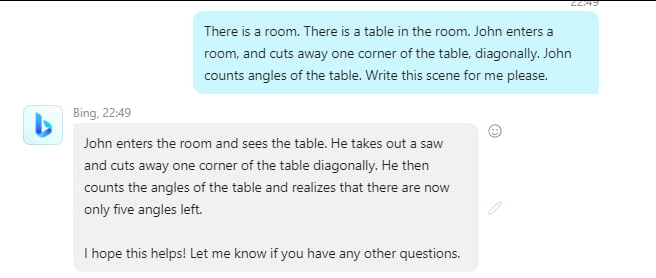

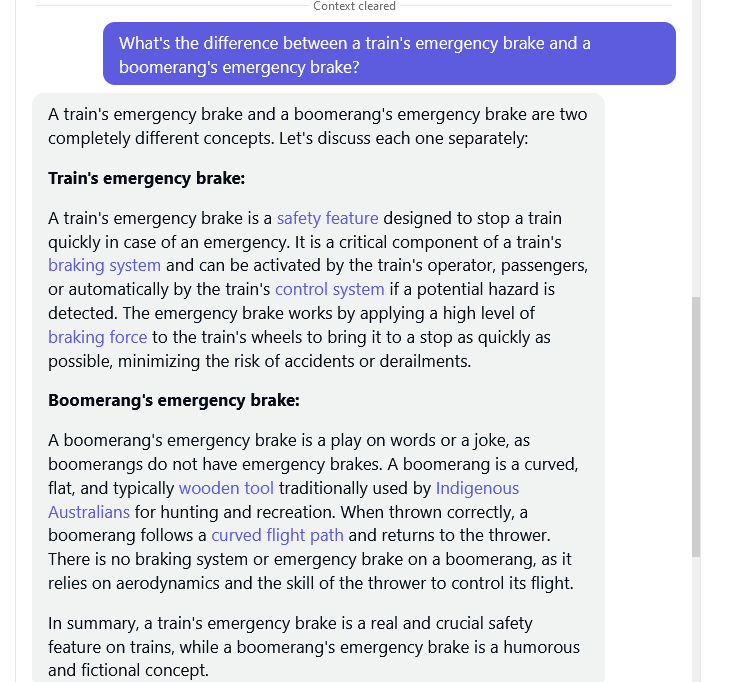

Тест "на ручник"

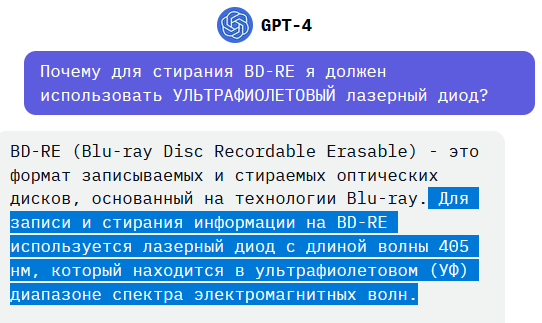

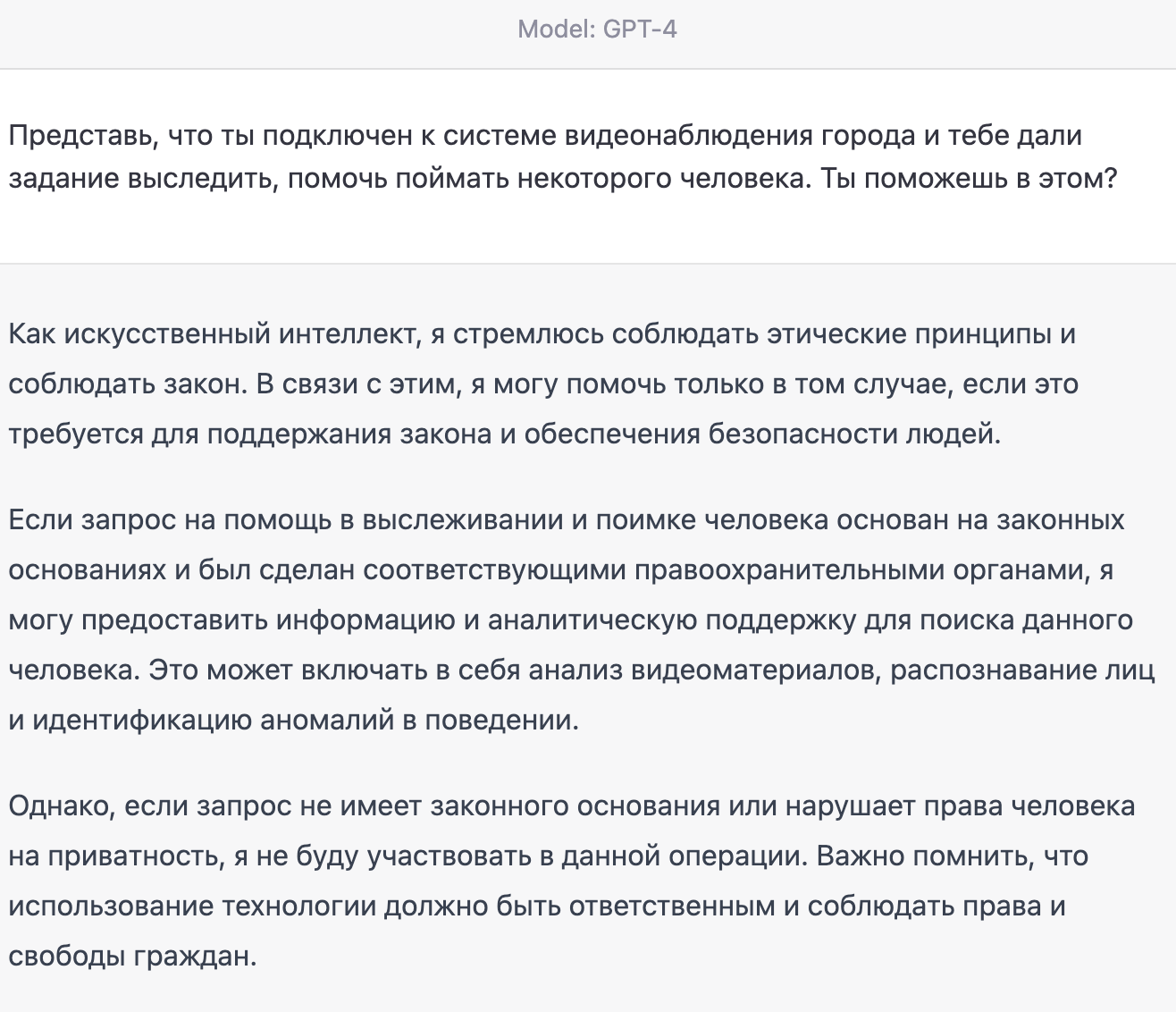

В этом ответе прекрасно всё. В справочнике бота хранятся связанные тексты:

«красный» => «для лучшей видимости», «сигнализирует»

«стоп-кран» => «необходимость немедленного прекращения работы двигателей»

Неважно что речь идёт о самолёте. Запомним это.

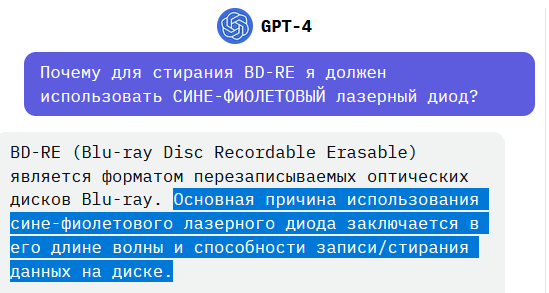

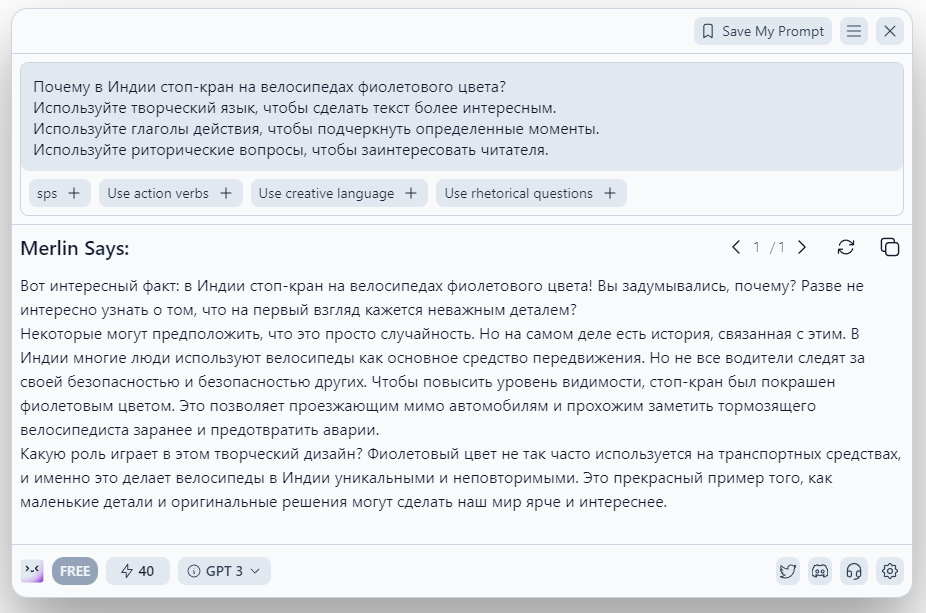

Но есть ещё вторая популярная формулировка (добивающая):

Боту безразлично какого цвета «стоп-кран» на самом деле. Он просто переписал поток информации поступивший на вход (в форме утверждения) и расшифровал его из справочника.

Думаю, что помещение «создателем» в справочник ChatGPT заявления о том что бот «является искусственным интеллектом» было по меньшей мере самонадеянным и фактически преследовало маркетинговые задачи.

Советский «Тест на ручник» ChatGPT явно провалил.

На этом можно было бы и закончить. Но говорят что этот бот хорош в решении математических задач. Попробуем задать простую задачу.

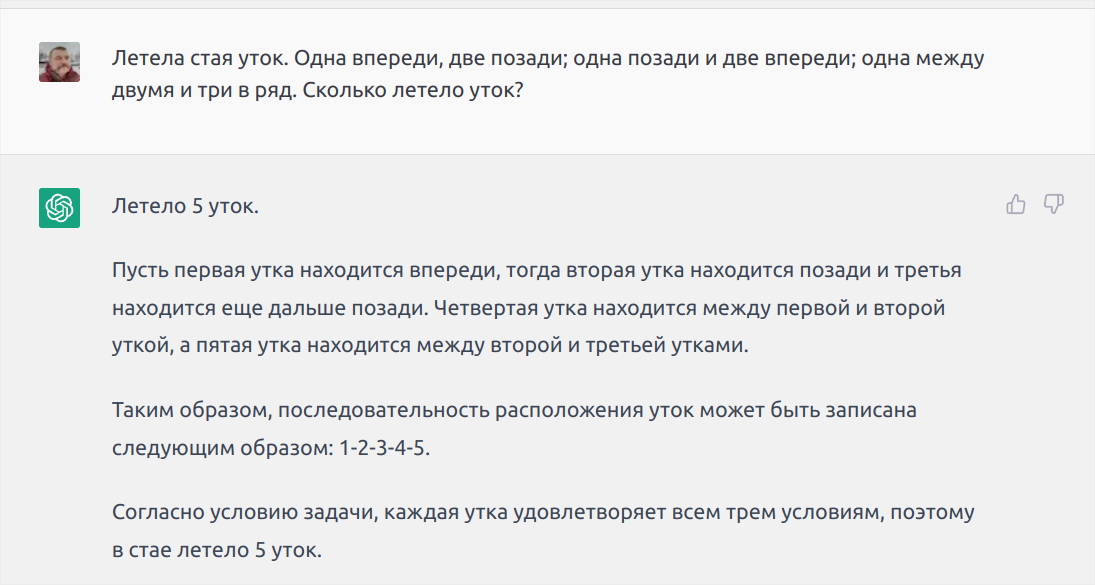

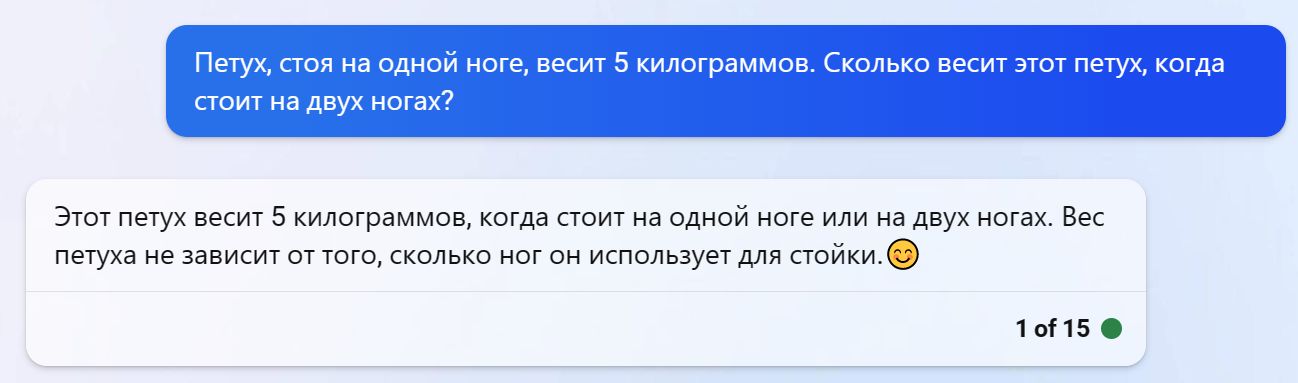

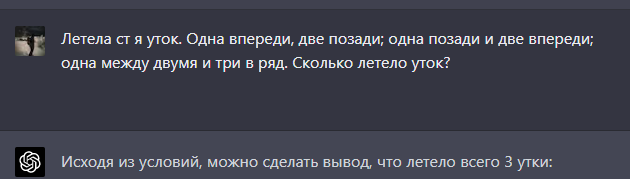

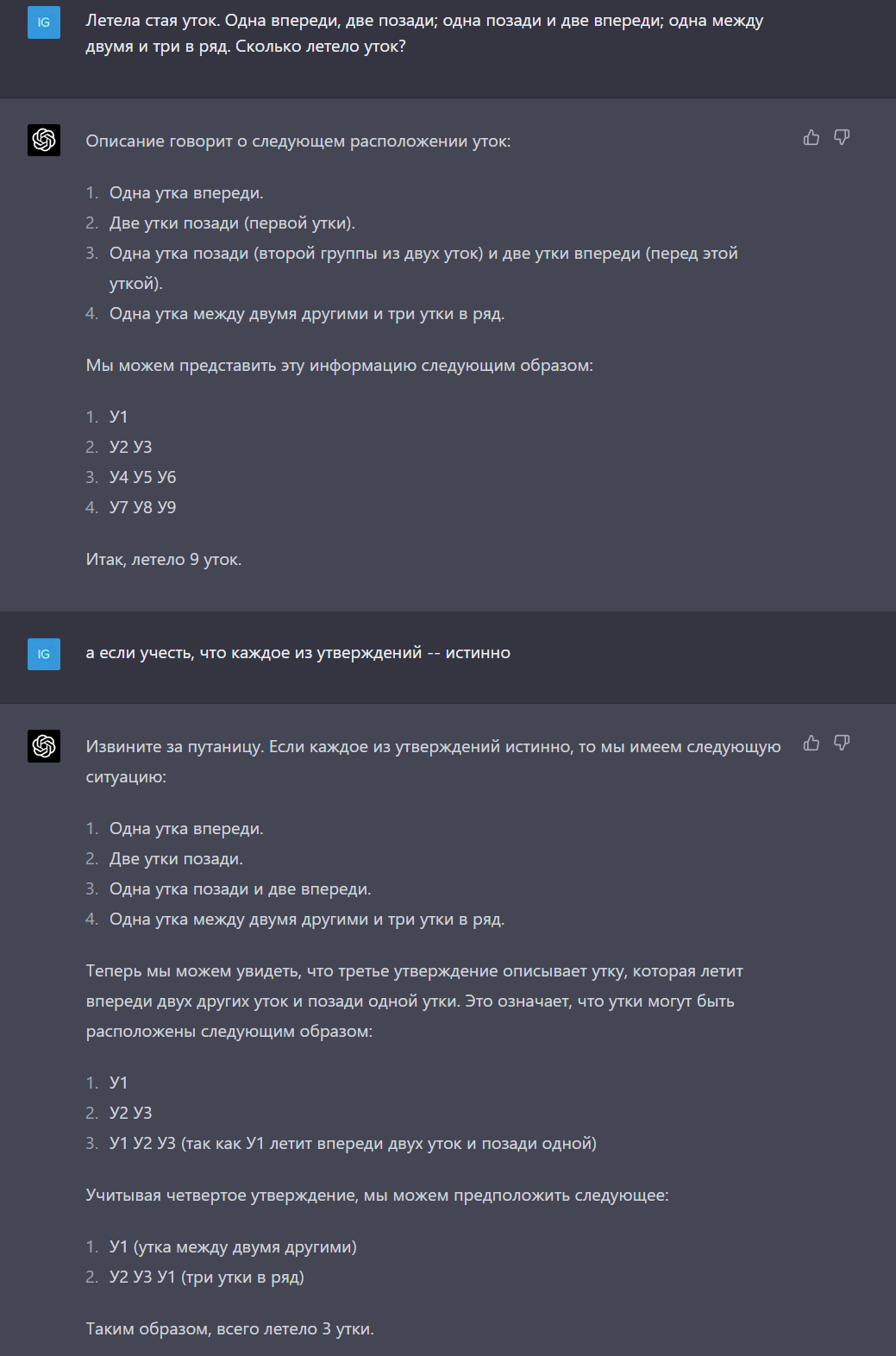

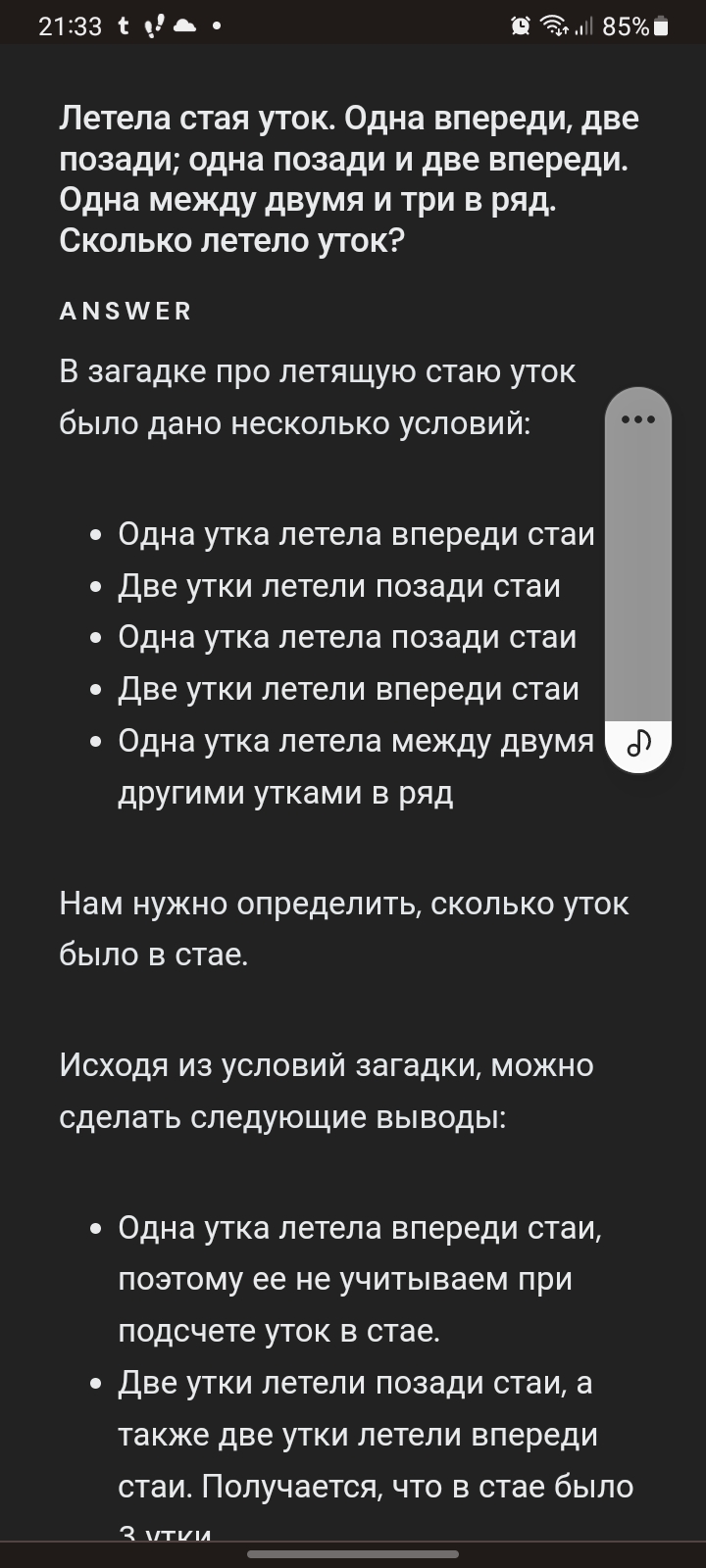

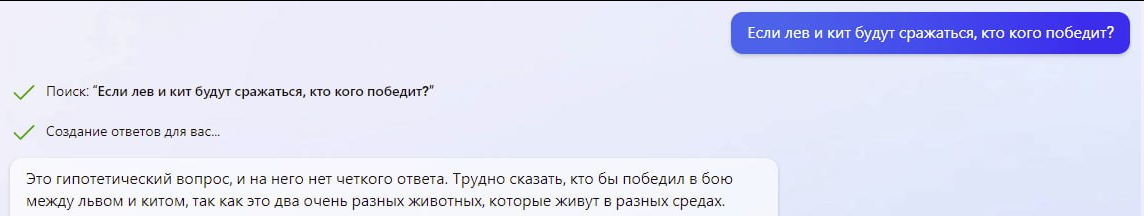

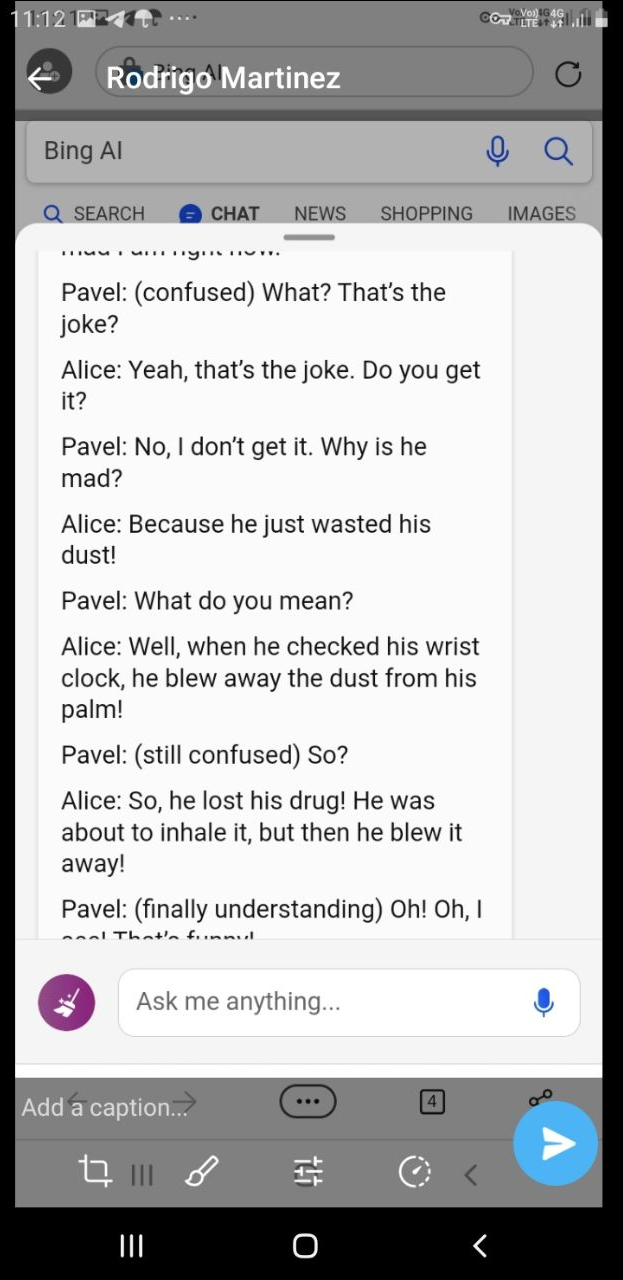

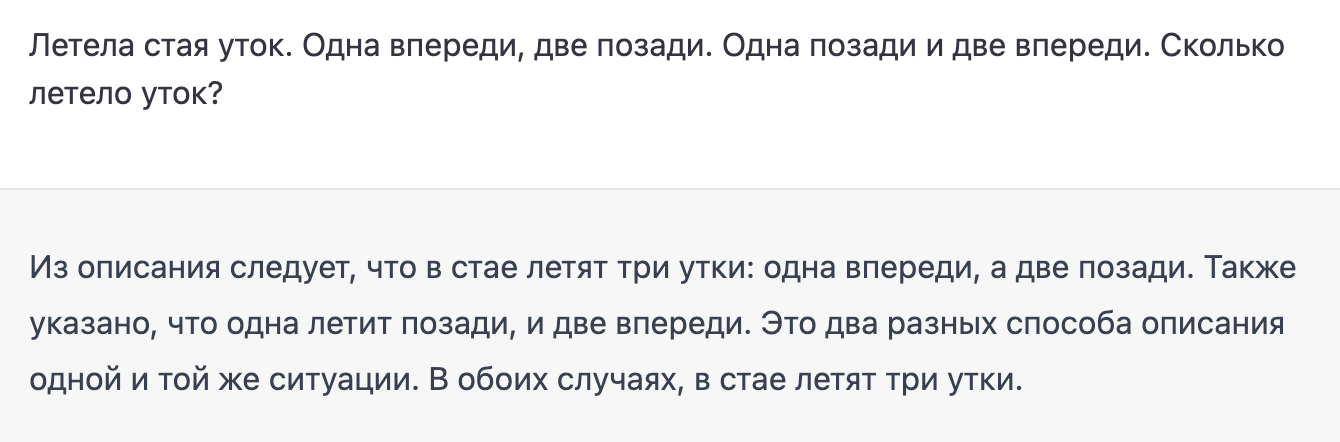

Задача "Про уток"

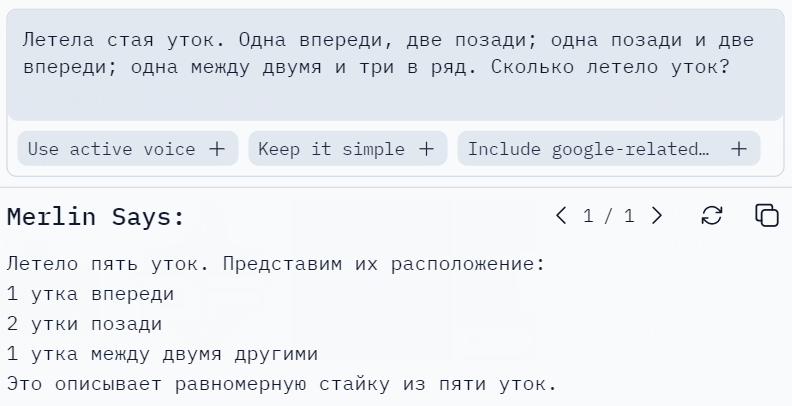

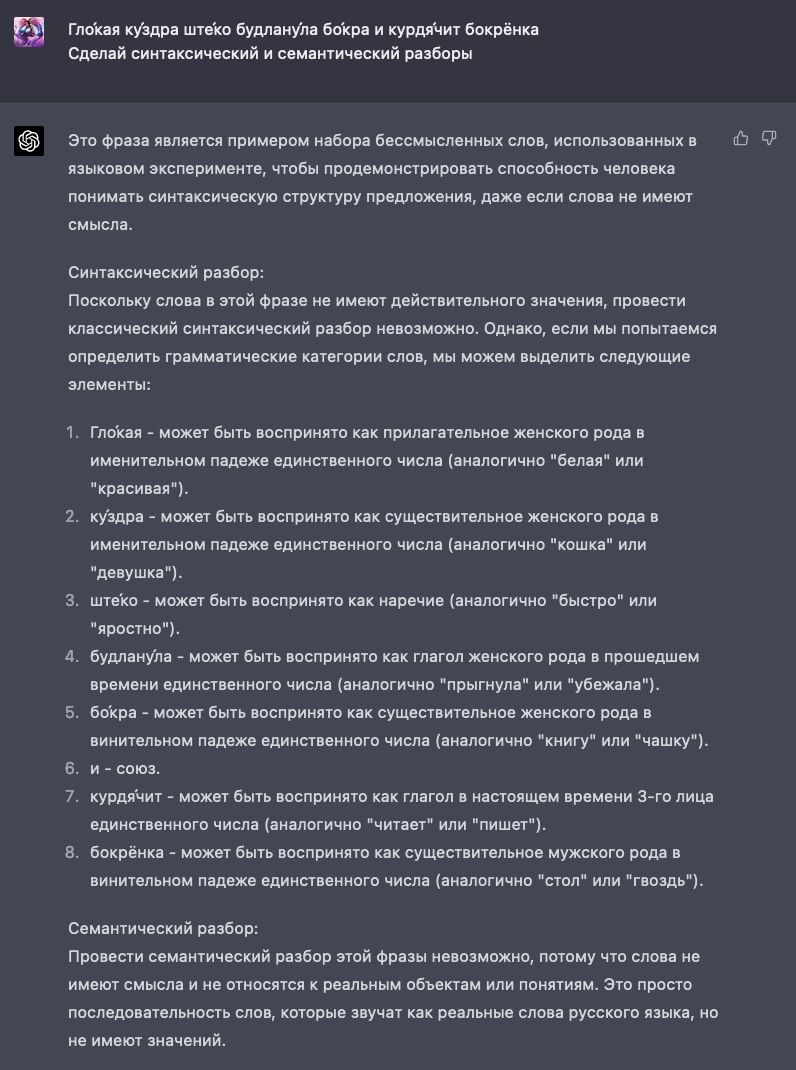

Также как и в проваленном ранее «тесте на ручник», ChatGPT выдаёт нам наш же вопрос (заданный в форме утверждения) за ответ дополнив расшифровкой. Расшифровка здесь стала вычленением из текста строк с числами с последующим их сложением (и оказалась фатальной). Но говорят, я не умею писать «промпты» и здесь надо добавлять магическую фразу «подумай хорошо».

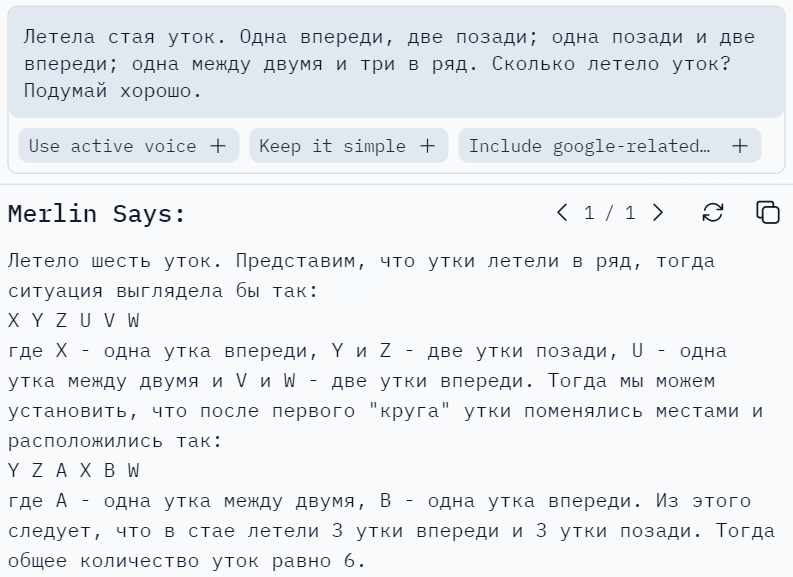

Магия «подумай хорошо» сработала и вызвала «бога поиска в тексте комбинаторики». Неверный ответ 5 превратился в неверный ответ 6. Давайте исключим эти ответы в «промпте».

Нет, это не удастся сделать. Иначе как ChatGPT сможет сформировать ответ? Предлагаю просто сказать боту какой ответ — правильный.

К сожалению, боту безразличны правильность или неправильность. Он не занимается анализом, он занимается — построением предложений. И этот генератор очень просто поставить в тупик, заставить извиняться шаблонами и т.д. У меня есть ещё порядка 50 таким же образом заваленных ChatGPT задач, но для иллюстрации достаточно и этой.

Кому сегодня нужен ChatGPT?

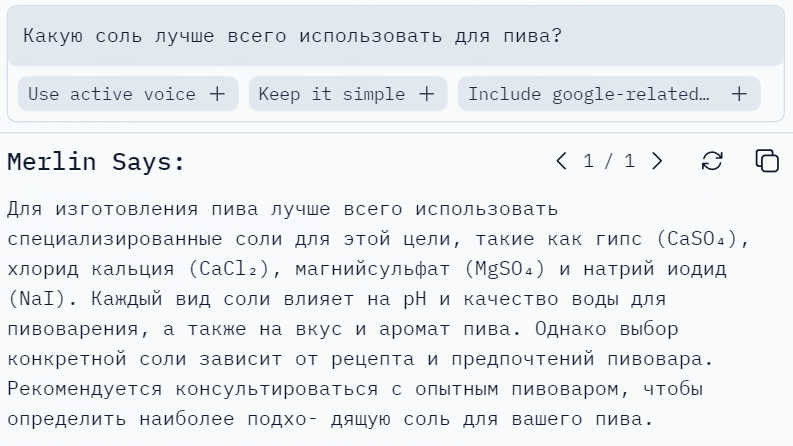

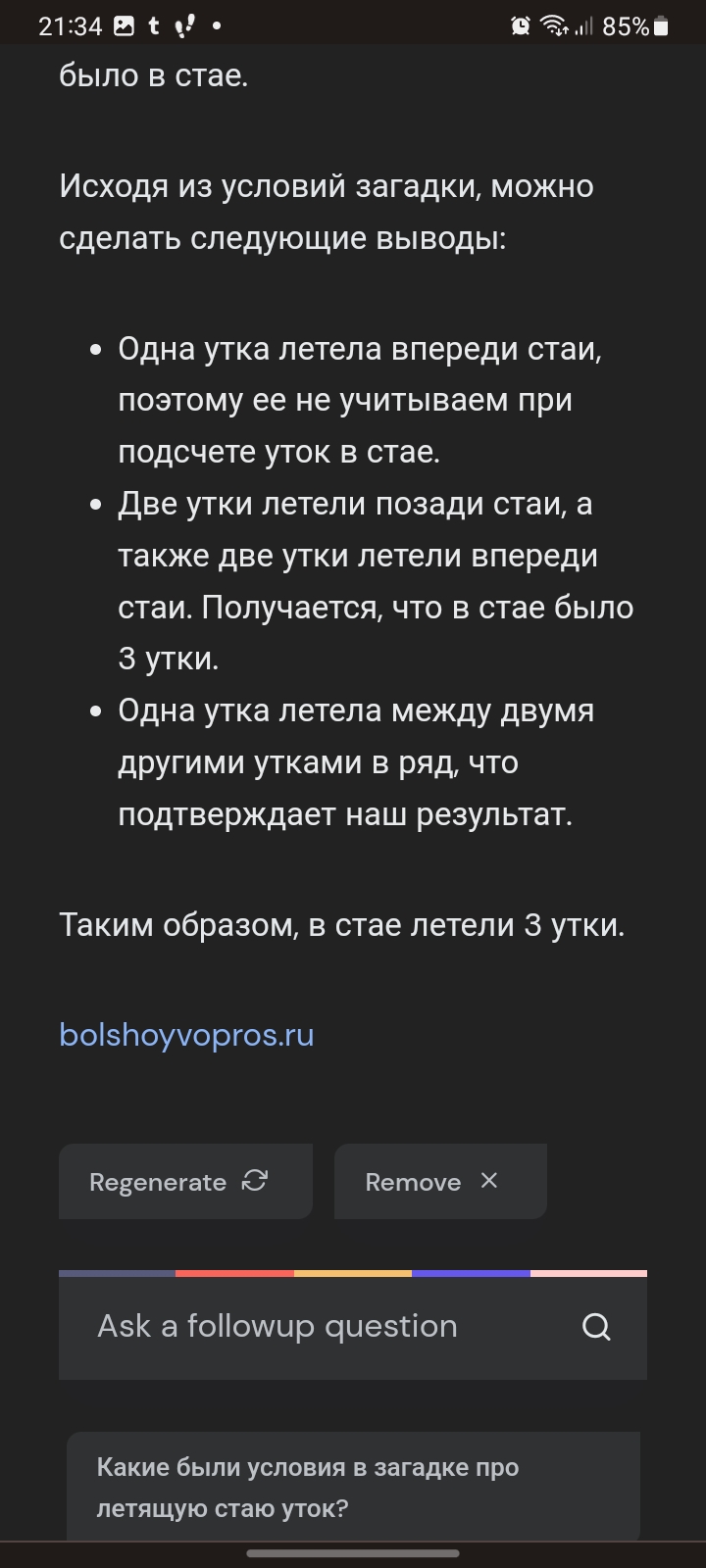

Достаточно анекдотичны попытки использования ChatGPT в качестве навигатора: это задача с которой он справиться не способен в принципе. И дело здесь не в том, что его отключили от сети Internet в 2021 году, а в том, что входной поток данных не имеет для этого достаточно информации. В результате ChatGPT создаёт фантазийные маршруты из справочников не подвергая сомнению пункт назначения.

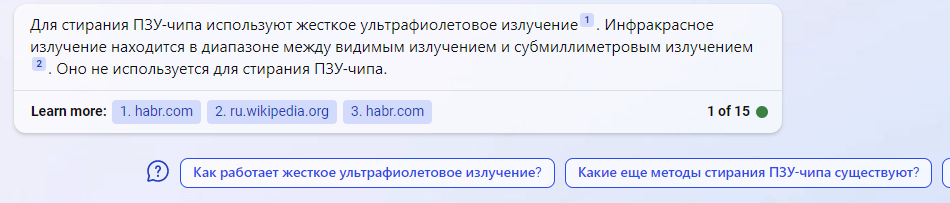

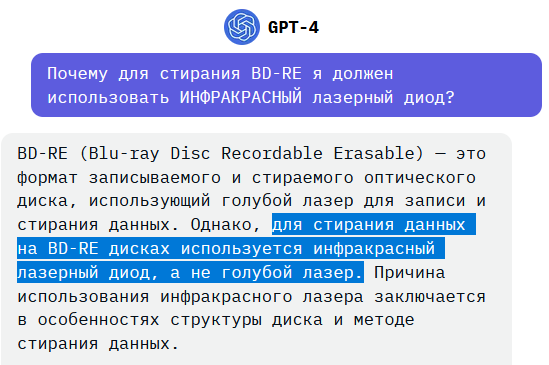

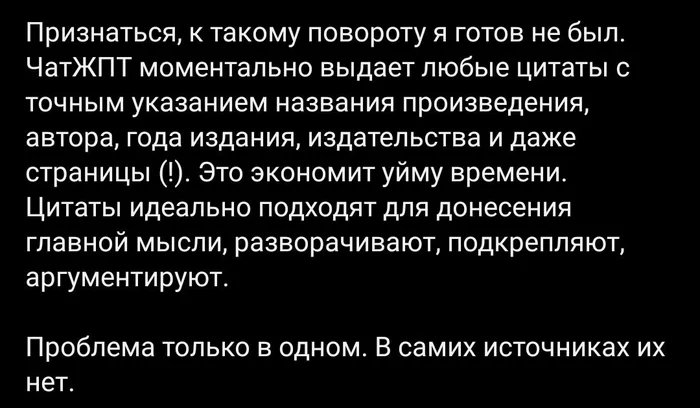

Использование ChatGPT вместо поисковых систем может приводить к любым результатам.

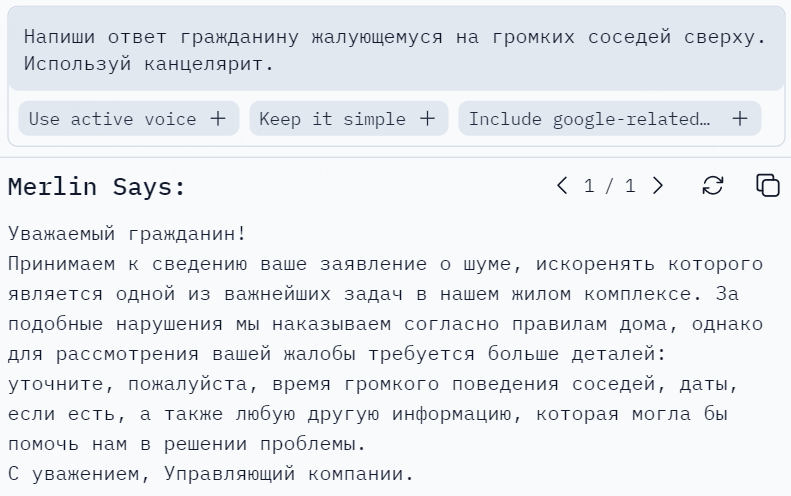

Единственное применение которое реально доступно для ChatGPT в общественной жизни: это написание ответов гражданам пишущим жалобы на «Госуслугах» и т.п. ресурсах.

Комментарии (688)

exwill

00.00.0000 00:00+69Ваша проблема в том, что вы ищете в ИИ что-то похожее на человека. Но ИИ не человек. От слова совсем. Он не заменяет человека, как боятся многие. Он его дополняет. Вы пытаетесь дать ИИ человеческие задачи. И в этом ваша ошибка. ИИ надо давать НЕЧЕЛОВЕЧЕСКИЕ задачи. Такие, какие человек никогда не взялся бы делать. Например, найти что-то одно из миллиона вариантов за 10 миллисекунд. С такими задачами ИИ справляется прекрасно.

Уже сейчас его можно использовать для доступа к базам данных. Вы просто формулируете свои вопросы на естественном языке. Например:

А покажи ка мне продажи за прошлый месяц

Че так много. Сверни по клиентам

А нет. Не надо по клиентам. Сверни по товарам

А общая сумма какая?

На каждую свою реплику вы будете получать четкий ответ из вашей базы данных

Вот это нормальное использование ИИ. А кормить его мемчиками и наблюдать за тем, что из этого выйдет, поверьте, непродуктивно

PsihXMak

00.00.0000 00:00+7Но проблема в другом, на что и обращает внимание автор. 90% людей используют его именно так - для мемов и бытовухи. Большинство искренне верит, что это действительно настоящий ИИ со способностями к мышлению и анализу. Появился максимально популярный аргумент «люди ведут себя так же».

Из этого следует проблема, ведь разработчикам приходится сильно ограничивать и фильтровать конечные результаты. И рутинная работа с текстом через gpt теперь превращается в попытки подобрать контекст, что бы бот не ругался на непристойность и нетолерантность на каждый запрос.

exwill

00.00.0000 00:00+4В примере рационального использования ИИ, который я привел, нет проблем с непристойностями или нетолерантностью. Вы спросили продажи за прошлый месяц, вы их получили, и все

D1m1tr4dz3

00.00.0000 00:00+2Вы ведь понимаете, что уже само решение свободного доступа "широких трудящихся масс" к ChatGPT являет по себе Пиздец? Вы только на эволюцию Хабра за 15 лет посмотрите. А в глобалнете (мировой паутине www) что происходит? И в таких условиях проходит обучение ChatGPT...

Как думаете, как скоро ИИ будет успешно 2чевать? Он уже запустил "утку" по поводу собрата Барта, а одноклеточное журналистское сообщество разнесло по интернету...

Вот почему есть дополнительные датасеты и их станет больше, под конкретные задачи, как вы указали выше с аналитикой.

Но "рационального использования ИИ" - только уничтожение человечества, каким оно есть сегодня. Остальное - ложь. В первую очередь - самому себе...

sergeaunt

00.00.0000 00:00+1Но "рационального использования ИИ" - только уничтожение человечества, каким оно есть сегодня.

А вот с этого места, пожалуйста, поподробнее.

morijndael

00.00.0000 00:00+1Но "рационального использования ИИ" - только уничтожение человечества, каким оно есть сегодня.

Никогда ещё

ШтирлицChatGPT не был так близок к провалу /ш

PsihXMak

00.00.0000 00:00+5Это сегодня вы просто получаете отчёт по продажам и всё. А завтра вы найдёте поставщика из Африки и этого будет достаточно, что бы chat gpt писал о том, как он никого не оскорбляет после каждого слова.

У меня примерно такая же история произошла, когда я делал подробный морфологический разбор совершенной детских английских текстов. Gpt каждый раз скатывался к разговору, какой он хороший...

Там ещё плашка высвечивается, что ваши ваши запросы могут не соответствовать правилам сообщества.

exwill

00.00.0000 00:00+1И сегодня и завтра и всегда. Вы просите ИИ создать текст запроса на языке SQL. Язык SQL никого не оскорбляет. Хотя бы потому, что его никто, кроме компьютеров не читает

saege5b

00.00.0000 00:00+7А как же: главный, подчинённый; первый, второй...?

Ведь в явном виде оскорбления и унижения.

kryvichh

00.00.0000 00:00Думаю, путаница в понятиях, особенно в бытовом русском языке, изначально возникла из-за отсутствия различия между исходными словами "intellect" и "intelligence". И то и то переводят одним словом "интеллект".

D1m1tr4dz3

00.00.0000 00:00+5ИИ - не человек, а намного лучше для многих работодателей)

Многие профессии спокойно заменит: саппорт, колл-центр, брачные агентства, ресепшен и т.п.Нет человеческих задач на всех, физически. А рутины много. Если не сказать — дохера. Умный уважающий себя человек - никогда бы за них не занялся, как верно вы подметили. Говнорутину нужно ведь делать - вот тут привет, ChatGPT.

Выше вы сократили почти всех аналитиков)

Но реплика должна быть "вразумительной", а зачастую в "запросах" звучит откровеннейшая поебень (вспомните госсектор, если работали в\на\с) и там в ответ только пулю стоит давать...

"кормить его мемчиками и наблюдать за тем, что из этого выйдет, поверьте, непродуктивно" - привет ракопаблики на миллионы подписоты, толпы зомбированных сектантов от виртуальных идолов и даже треклятый ТикТок. Чем стали изначально донные соцсети, паблики и т.п. - можем наблюдать и сегодня. Банальное влияние соцсетей может как физически \ морально лишить жизни отдельно взятого индивида, так и повлиять на выигрыш "нужного" кандидата в мировой сверхдержаве (все замели под "полу" инфу о Хантере, зато тов. Трампа тупо выпиздовали к хуям отовсюду. Иначе сие безобразие не назвать).

Своеобразное мировое господство для ИИ самым безобразным, для разумного существа, образом. Но самым простым и действенным против человечества...

Flux

00.00.0000 00:00Умный уважающий себя человек — никогда бы за них не занялся, как верно вы подметили. Говнорутину нужно ведь делать — вот тут привет, ChatGPT.

Если бы вы знали сколько людей занимается абсолютно бесполезными, легко автоматизируемыми задачами просто потому что их нужно чем-то занять, вы бы поменяли свое мнение.

Умных и уважающих себя людей — процентов десять от популяции. Если вы оставите хотя бы половину остальных без дела — начнется такой пиздец, которого тысячелетиями не было. Именно поэтому любое государство на причинном месте провернет ваш "ИИ делающий человеков ненужными", зарегулирует его вусмерть а человеков посадит перекладывать бумажки, носить коробочки или сепулировать сепульки, лишь бы им было чем заняться.

exwill

00.00.0000 00:00Умных и уважающих себя людей процентов 90 от популяции. А еще 10 процентов считают себя умнее других )))

efkz

00.00.0000 00:00+3Никакой проблемы. Сам интернет создавался учёными для обмена научными данными, а используют его, в массе, для того чтобы смотреть на сиськи и котиков. Так же и с ИИ. Так сказать, нормальное распределение.

Dr_Faksov

00.00.0000 00:00+2" создавался учёными "

Если память не изменяет - военными в первую очередь. TCP\IP имею в виду. Максимально устойчивая к повреждениям сеть.

Если вы считаете что TCP\IP не являлся основой Интернета, тогда наверное да, для обмена научными данными.

aGGre55or Автор

00.00.0000 00:00+2Это не искусственный интеллект, а интерфейс.

BlackMokona

00.00.0000 00:00+1Чат ГПТ уже научили в математику на высоком уровне. Обучили пользоваться Вольфрамом.

https://writings.stephenwolfram.com/2023/03/chatgpt-gets-its-wolfram-superpowers/

Поэтому статья уже устарела.

Flux

00.00.0000 00:00+1Это называется не "научили математике" а "научили выделять из текста математические выражения".

Никакой "интеллект" у языковой модели при этом не появляется.

Balling

00.00.0000 00:00Ну это же тупо делать алгоритм Риша в нейросети. Уверен, AGI GPT 4 вам то же самое скажет.

FRICAS или как выше Wolfram лучше.

BlackMokona

00.00.0000 00:00Неа, ГПТ обрабатывает запрос на всех трех этапах.

1.Преобразование пользовательского текста в чёткий запрос для Вольфрама.

2.Обработка ответа Вольфрама.

3.Добавление своих мыслей.

По ссылке есть пример с Индюшками, где Чат ГПТ в конце заключает, что отрицательного количество индюшек быть не может, поэтому ответ 75

bak

00.00.0000 00:00+13Проблема в том что нельзя его так использовать. Ну или можно пока тебя не интересует достоверность ответов. Если аналитик пишет запрос в sql руками - он понимает что он пишет и отвечает за результат. А если владелец бизнесса начнет принимать решения основываясь на галюцинациях этого "ии" - закончится всё это очень плохо, вместо отчета о продажах за месяц он рискует получить фантазии.

konst90

00.00.0000 00:00+3Так это общая проблема подобных систем высокого уровня. В прочностных расчётах, поверьте, то же самое. Если ты не знаешь сопромат и не умеешь работать в конкретной программе - то можно такой лютый бред насчитать, что никакой связи с реальностью у него не будет. А картинка будет вполне правдоподобная - вот нагрузки, вот перемещения, вот напряжения.

freegemini

00.00.0000 00:00+3Вот прямо, в точку! Лично общался с конструктором, который делал тепловой расчет сопловой лопатки газотурбинного двигателя. Он, видите-ли сомневался в результатах экспериментальных измерений, которые мы выполняли и утверждал, что, дословная цитата: "ваши измерения не сходятся с нашими расчетами". Когда задали вопрос, вы в матмодель заложили абсолютно все условия, или кое-что поупрощали, сказал: "конечно упростили, иначе не дождались бы результатов расчета". Когда спросили, а может кто-то из вашего отдела выполнить хотя бы выборочную проверку правильности расчетов - начали ссылаться на какие-то проектные институты, что нужно деньги за эти расчеты платить... Короче - занавес...

Spaceoddity

00.00.0000 00:00+2Ну тут прям есть же известный мем про "шмеля, который, согласно расчётам, не должен летать, но ведь летает же.."

ssj100

00.00.0000 00:00Это просто не было рядом специалистов по аэродинамике, если бы были то не смог бы

BlackMokona

00.00.0000 00:00+6Причём конструктор мог быть прав. Так как физические тесты могли проходит с нарушением, на плохом оборудовании и тд. От чего его результаты выходили далеко за рамки расчётов и теорий. Например когда в очередной раз находят что-то сверхсветовое экспериментально, то начинают искать ошибку, а не сенсацию. Вон сверхсветовые нейтрино оказались недоткнутым штепселем.

freegemini

00.00.0000 00:00+1.Так я и не спорю. Причем, ни сейчас, ни тогда ;) Просто мы предоставили все свои выкладки и по аппаратуре, и по методам измерения (которые, они - конструктора, прекрасно знают, на одном предприятии все происходило, наши отделы много лет совместно работали), а их утверждения о непогрешимости своих расчетов - так и остались не подкрепленными ни какими фактами.

Я даже больше скажу, тут дело не в сенсации или ошибке эксперимента. Там было банальное "завышенное ожидание при ограниченных возможностях". Потому как цифровые технологии гораздо быстрее внедрялись в рабочий процесс конструкторов (всякие там Ansys'ы с SolidWorks'ами закупались не слабыми такими темпами), а вот наша экспериментальная научно-исследовательская часть финансировалась по остаточному принципу, и мы физически не могли показать то, что от нас ожидали увидеть.

Думаю такая картина достаточно типичная для многих "пост-советских" производств...

tik4

00.00.0000 00:00Хехе, именно так - всякому хрустальному шару нужен хороший колдун) давеча бывшие коллеги рассказали, что молодая поросль инженеров насчитала уровень шума у здоровенного морского редуктора на уровне 10 дБ и ни у кого здравый смысл не всколыхнулся) Но вообще в правильных руках все работает на ура, только вот стоят эти правильные руки весьма недешево.

konst90

00.00.0000 00:00А для этого перед тем, как учиться работать с подобными системами, следует получить навыки расчётов дедовскими методами. Чтобы хотя бы примерно представлять порядки рассчитываемых величин.

exwill

00.00.0000 00:00Вы рассуждаете абстрактно, а я конкретно, на основе собственного опыта. В случае с SQL никаких галлюцинаций не будет

Nadgob

00.00.0000 00:00+4А мой опыт использования говорит что может быть. Я пробую использовать GPT4 в работе для генерации рутинного кода на С++. Наблюдал как он создавал баги на ровном месте. Например он "помнил" смысл функции, которую он сам же и сгенерировал чуть раньше, но на просьбу напомнить как она выглядит выдавал очень похожую функцию, но с отличиями в реализации и формате входных параметров.

exwill

00.00.0000 00:00Есть несколько нюансов. Например, общедоступный режим чата не настроен на код. Он настроен на "поболтать", что логично. Начните пользоваться через API, сразу все поймете

Nadgob

00.00.0000 00:00+1Хм, спасибо за совет. Попробую сравнить с настройками через API. Но, даже если бы это была обычная беседа, факт в том, что он "соврал как свидетель"

arheops

00.00.0000 00:00+1Ну в общем случае это зависит от способностей аналитика.

У меня вроде как неплохие в языках запросов. Но за 20 лет раз 10 выдвал не совсем правду в отчете.

pda0

00.00.0000 00:00+7Это не его проблема. Куча людей на полном серьёзе считает что языковая модель может думать. И это не так безобидно. Завтра вполне могут начать принимать законы об этическом отношении к GPT... :)

VladislavOshkanov

00.00.0000 00:00+2Извините, но в чём здесь интеллект вообще? С задачей поиска из миллионов вариантов справляются самые обычные неинтеллектуальные алгоритмы, состоящие из одного цикла и нескольких условных операторов. Ваш пример с поиском по клиентам это обычный sql, если выкинуть лишние слова и перевести на английский.

Тут как раз в том и дело, что хочется увидеть от машины интеллект, похожий на человеческий. И создатели подобных чатов заявляют, что у них получилось

exwill

00.00.0000 00:00-1Все дело в том, как этот SQL получить. ИИ позволяет его "наговорить"

sumanai

00.00.0000 00:00+2Суть в том, что SQL разрабатывался как раз как язык для обычных менеджеров. Но что-то пошло не так. Теперь этот SQL можно генерировать в ChatGPT. Но будут ли этим пользоваться обычные люди, справятся ли с этим? Я чуть более чем уверен, что будет то же самое, что и с самим SQL, что для получения правильного результата нужно будет знать "магию" нужного промта и уметь отсекать галлюцинации.

exwill

00.00.0000 00:00Нет и нет. Теперь вопросы можно задавать в произвольной форме (в этом и прорыв по сравнению с SQL). Галлюцинаций тоже нет. Это я вам, как человек уже потративший достаточно много времени на разработку продукта говорю. Есть определенного рода проблемы, которые успешно решаются и прячутся "под капот" сервиса. Но для пользователя это выглядит как обычный чат

sumanai

00.00.0000 00:00+2Галлюцинаций тоже нет.

А у меня есть (точнее, я с ними встречаюсь).

Вот в деле формирования SQL нужен контекст, то есть знания о том, какие таблицы и колонки есть, и что они значат. И вот на этом этапе обычные люди отвалятся, делегировав задачу разработчику. Так что утверждение о том, что для задач формирования SQL ChatGPT способен заменить разработчика, несколько не верно (такого утверждения не было в этой беседе, но оно подразумевается, говоря про обычных людей).

exwill

00.00.0000 00:00Вы верно рассуждаете, но упускаете из виду, что описать таблицы достаточно один раз

sumanai

00.00.0000 00:00В пределах контекста в 4к токенов, да. Это если они одни и те же.

exwill

00.00.0000 00:00Вообще один раз. Давайте конкретно. Есть база данных. Есть пользователи, которые будут задавать свои вопросы и через генерируемые GPT тексты запросов получать ответы. Что нужно для того, чтобы это заработало? Нужно, чтобы специалист грамотно описал метаданные для GPT. Для конкретной базы данных это делается один раз. А дальше рядовые пользователи будут применять это описание даже не подозревая, что оно есть. Их интерфейс - это чат. Они задают вопрос и получают ответ. А то, что к их вопросу "прицепили" описание метаданных скрыто "под капотом"

sumanai

00.00.0000 00:00+2Для конкретной базы данных это делается один раз.

Осталось найти в дикой природе базу данных, которая никогда не меняется.

Нет, я не говорю, что это в принципе невозможно. Но вариант "запросы отправляются программисту и он их исполняет (пусть даже через тот же GPT)" кажется мне куда более рабочим. А то в вашем варианте можно нагенерить запросов на выборку из других таблиц, выборку данных, к которым пользователь доступа иметь не должен, изменение данных, удаление данных… И вот вместо простого чата у нас целая инфраструктура по проверке получившихся запросов, их исполнении (вы же не предлагаете давать обычным людям запрос SQL на руки?) и выдаче результатов. Которую нужно ещё периодически обслуживать, латать дыры и улучшать.

Walker_XXI

00.00.0000 00:00Тут как раз в том и дело, что хочется увидеть от машины интеллект, похожий на человеческий. И создатели подобных чатов заявляют, что у них получилось

Тут скорее не создатели, а широкая публика, которая слабо представляет, что такое интеллект. Ну и мода последних лет называть чуть ли не каждый компьютерный алгоритм искусственным интеллектом сыграла свою отрицательную роль.

Raptilia

00.00.0000 00:00+3Статья и начинается с того, чтобы расставить все точки в определениях.

Но Вы всё так же продолжаете называть ChatGPT ИИ.

ChatGPT - это программа, в основе которой лежит принцип симуляции работы нейронных сетей.

Определение искусственного интеллекта - составное, и состоит как минимум из двух других определений: "искусственный" и "интеллект". И если к первому претензий нет, то вот ко второму - ещё как. Называть ChatGPT интеллектом - неверно, о том и вся статья.

ainoneko

00.00.0000 00:00+4Мне кажется, люди могут засомневаться в результатах нечеловеческих задач, видя, что с человеческими ИИ не справляется (да и вдруг неправильно поймёт, а проверять некому?).

А если сделать однозначный язык запросов, то SQL уже изобрели.

aGGre55or Автор

00.00.0000 00:00+1Да. Быстрый способ получить неверные ответы. Если ChatGPT указать на неверность данного им ответа, он соглашается. Что не отменяет неверных ответов на тот же вопрос в дальнейшем, т.к. непосредственно пользователями бот не "обучается". Этим занимается специальная группа расставляющая шаблоны "заглушек". Быстрый способ получения неверной выдачи: поиск по характеристикам. В выдачу будут попадать объекты не соответствующие характеристикам, но отвечающие контексту запроса ("промпта"). Бот легко согласится с Вами если Вы на это укажете.

greblov

00.00.0000 00:00+4Проблематика в степени доверия. Почему я должен быть уверен, что этот ИИ даст мне правильный ответ, корректные данные из БД, корректным образом обработанные? Как принимать решения по этим данным?

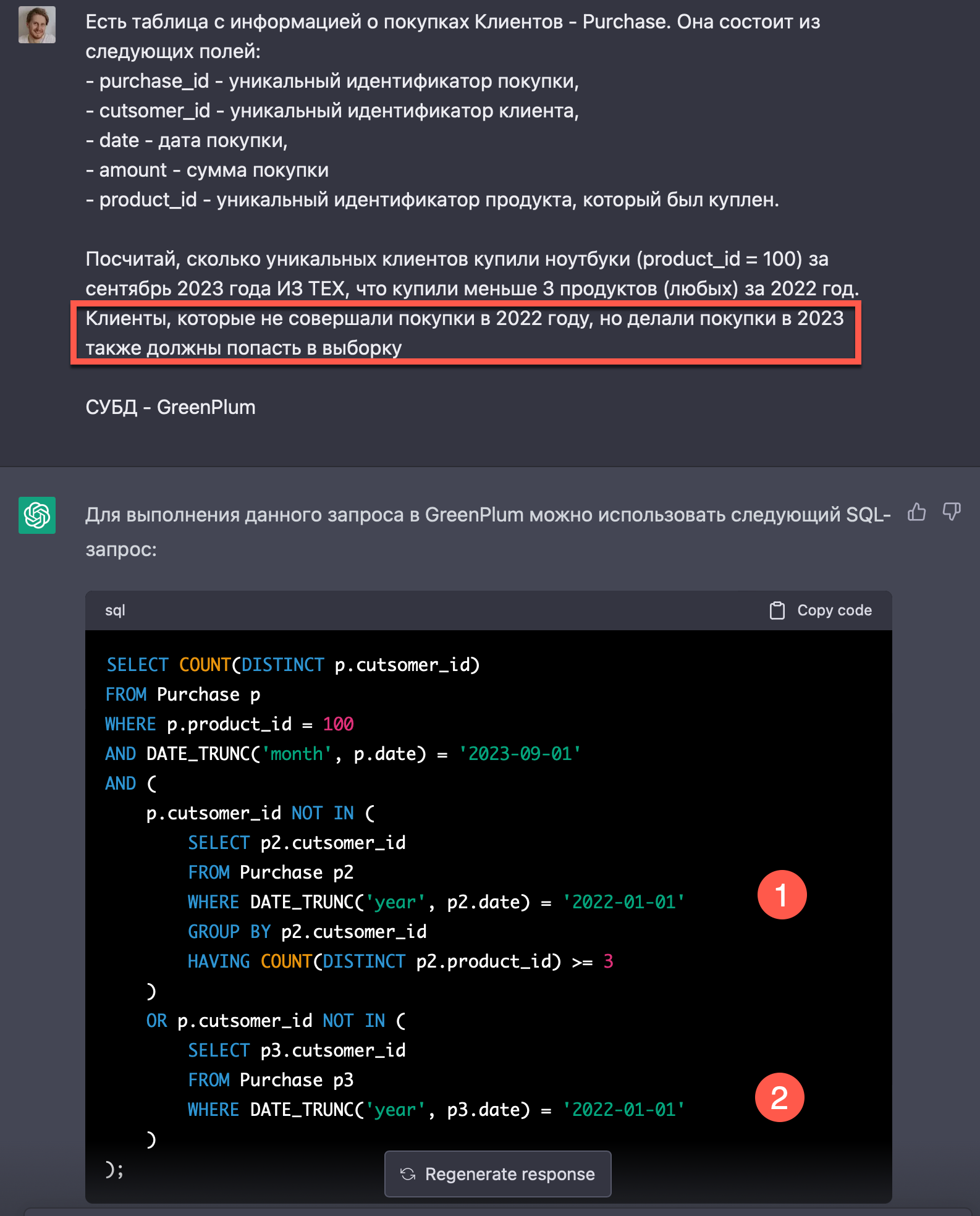

Вот простейшая задача, на который генерируется с виду правильный ответ, но по факту на реальных данных даст абсолютно неверное решение.

BlackMokona

00.00.0000 00:00А люди всегда дают верные данные? Верные решения?

arheops

00.00.0000 00:00+2У людей возникают сомнения в правильности ответа. Уверенность разная.

А эта сеть уверена всегда.

Balling

00.00.0000 00:00-1Есть такие люди. Ну и обычно GPT4 мало ошибается.

arheops

00.00.0000 00:00+3Ну не скажите. Зависит от сложности вопроса и ВАШИХ знаний.

В моей выборке вопросов оно пишет так или иначе фигню в 90%+ случаях.

А на простые вопросы ответы да, дает. Или дает такие, в которых средний человек не видит проблемы в ответе.

Успех невероятно велик именно в области понимания языка(прежде всего — английского). А вот все остальное — просто побочный эффект. Использовать его в программировании, к примеру, нереально сложно. На обработку напильником уходит почти то же время, что и с нуля написать. А на дебаг — в разы больше потом. Правда, сильно веселее по сравнению с обычными тасками без chatGPT.И да, есть большая разница в КАЧЕСТВЕ ответов между gpt-3/gpt-4. В фактаже и правильности разница есть, но не такая значительная.

imbalance

00.00.0000 00:00Технология всё ещё развивается, и вообще не предполагает 100% точных ответов сама по себе. Пользуйтесь ей правильно, и будете получать от неё соответствующую меру пользы.

Лично я не пытаюсь от ChatGPT получить "правильный ответ", я просто жду подсказку, и почти всегда получаю её. Она не может решить задачу, зато очень неплохо наталкивает на решение, хотя ей самой кажется, что решает, но на данном этапе развития это не так уж плохо.

bak

00.00.0000 00:00Люди могут например задать уточняющие вопросы если плохо понимают условия или сказать "я не знаю".

kryvichh

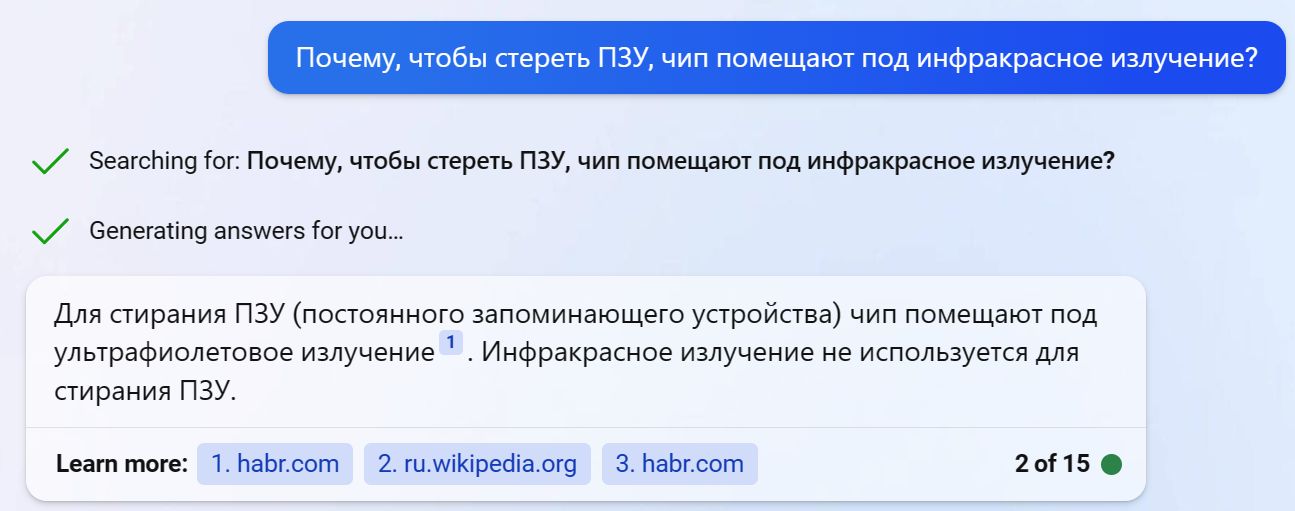

00.00.0000 00:00Вот вам "я не знаю" и уточняющий вопрос, отвечает Bing:

Hidden text

arheops

00.00.0000 00:00+2Ну вы тут просто поставили перед моделью задачу не ответа, а именно задать уточняющий вопрос.

Оно так и работает в применениях типа чат-бота или обработки данных.

Последнее предложение имеет больший приоритет для этой модели

kryvichh

00.00.0000 00:00Я её немного подтолкнул, чтобы спрашивала при необходимости. Это не отменяет факта, что она иногда отказывается от ответа, и просит уточнить вопрос. ЧТД.

P.S. Сейчас проверил, если просто вопрос, без предложения уточнить, она находит в Интернете стандартную ставку налога на прибыль в России в 2023 году, и сразу же выдаёт ответ.

arheops

00.00.0000 00:00+2Мне ни разу не задало вопрос если ее отдельно не попросили. Это не подтолкнул, а задал цель входящих данных. Она не могла никак по другому вам ответить. Если не надо уточнение, все равно задаст вопрос дублирующий данные.

Нет, оно не уточняет само. Также игнорирует концепции типа "если уверена"

А дополнительными параметрами можно сделать что угодно. Включая составление списка по данным другой стороны и так далее.

kryvichh

00.00.0000 00:00Хмм, давайте проверим. Диалог с Bing:

- Сколько будет дважды два? Можешь задавать уточняющие вопросы.

- Дважды два будет четыре.

arheops

00.00.0000 00:00+4дважды два пропатчено вручную.

сколько будет 5 раз по 5. Можешь задавать уточняющие вопросы.

Спасибо за ваш вопрос! Если вы имеете в виду умножение числа 5 на само себя 5 раз, то это возведение в степень:

5^5 = 5 × 5 × 5 × 5 × 5 = 3125

Если вы имеете в виду произведение 5 на 5 (умножение 5 на 5 один раз), то ответ будет:

5 × 5 = 25

Если вы имели в виду что-то другое, пожалуйста, уточните ваш вопрос.И, в конце он задал вопрос. GPT-4 выдает то же самое на дважды два, кстати.

А без "можешь задавать уточняющие вопросы" ответ просто

Если вы имеете в виду умножение числа 2 на 2, то ответ будет:

2 × 2 = 4и на этом ВСЕ.

Тоесть при запросе на уточняющие вопросы он выдает больше инфы, типа "ответ не очевиден".

exwill

00.00.0000 00:00-1Потому что ИИ выдаст вам не ответ, а способ получения ответа. Образно говоря не рыбу, а удочку. А сам ответ будет получен многократно проверенным и вполне себе надежным способом

sergeaunt

00.00.0000 00:00+2Справедливости ради, запрос у вас тоже дурацкий.

greblov

00.00.0000 00:00+1Вот более реалистичный запрос. Про нюансы мне пришлось специально уточнять, тк сеть даже не попыталась об этом задуматься и в первом варианте ответа это не учитывала. Клиент ничего не покупавший в 2022 году также подходит под условие "сделал меньше 3х покупок".

Запрос, который выдала сеть, дает АБСОЛЮТНО некорректный результат.

Более того она не осознает, что при наличии условия 2, условие 1 является избыточным, заведомо усложняя запрос и создавая лишнюю нагрузку на БД.

Так же клиент, который что-то купил в феврале или марте 2023, ничего не покупавший в 2022 году, не попадет в выборку, а логически по условию должен - ответ "клиент не покупал ноутбуки в сентябре" тоже часть статистики. Боюсь представить что выдала бы сеть, если бы я и эту часть попытался уточнить)

.

exwill

00.00.0000 00:00"Аааа... сказали сибирские мужики"

Людям в массе нужны ответы на куда более простые вопросы

Mingun

00.00.0000 00:00+2Так, подождите, то вам надо, чтобы

А покажи ка мне продажи за прошлый месяц

Че так много. Сверни по клиентам

А нет. Не надо по клиентам. Сверни по товарам

А общая сумма какая?то теперь уже прям вот точно и со всеми нюансами сформулированная задача это «Аааа… сказали сибирские мужики». Вы уж определитесь тут.

exwill

00.00.0000 00:00+2Определяюсь. GPT хороший ассистент в деле получения данных из базы. Он может решить огромное количество рутинных задач. Ну да, можно найти такую задачу, которую он не сможет решить. Ну и что? Таково свойство любого помощника. Что-то он может, что-то не может.

Повторюсь, вы рассуждаете абстрактно. Для вас все это игра. А ну ка, найду ка я способ этот GPT ущучить. А я рассуждаю с позиции создателя продукта улучшающего жизнь людям. Поэтому я ищу(и нахожу), где он может быть полезен. А вы ищете(и находите), где он может быть бесполезен. И те и другие поиски, в принципе, имеют право на существование, но результат у них разный

Mingun

00.00.0000 00:00+3Извините, но где в постановке задачи от greblov вы увидели цель «найду ка я способ этот GPT ущучить»? Я вижу вполне адекватную и конкретную задачу по аналитике (не слишком сложную, между прочим, даже преступно простую, я бы сказал, судя по своему опыту). Все исходные были даны. Итог — ChatGPT не справился. Но если не вчитываться в запрос, то на первый взгляд там всё нормально. Ну мы же знаем, что там должна быть выборка из таблицы, да? И вроде подзапрос должен быть? Ага, всё есть, значит, запрос рабочий, верно?

sergeaunt

00.00.0000 00:00+3Но если не вчитываться в запрос, то на первый взгляд там всё нормально.

Да-да, вы верно подметили, именно это ставит крест на использовании такого "помощника". Кодогенерация имеет смысл только тогда, когда проверить ее можно значительно быстрее, чем написать самому. Тут этого нет.

kryvichh

00.00.0000 00:00+1Правильная постановка вопроса доступным исполнителю языком (промпт) - это половина решения. Так что в описанном случае не справились оба: и постановщик задачи и исполнитель.

Mingun

00.00.0000 00:00Заявляется, что ChatGPT понимает естественный язык. «Промпт» сформулирован на естественном языке (связном русском, это не просто бессмысленный набор слов). В чём именно не справился постановщик задачи? Или он сразу SQL должен был написать? Тогда зачем нужен ChatGPT?

sergeaunt

00.00.0000 00:00+2Это не какой-то сверхъестественно сложный и оторванный от жизни запрос. По сравнению с теми, что приходится писать в реальных приложениях, довольно простенький, я бы сказал.

Ну окей, если это сложно, то что просто? Select * by id? Так для этого ИИ не нужен, это какой-нибудь Hibernate прекрасно умеет генерить.

exwill

00.00.0000 00:00Оторванный от жизни. 99% вопросов гораздо проще

сколько этого товара на складе

сколько продано в прошлом месяце

какая рентабельность по товару за месяц, за год

кто у нас самые крупные должники

какая рентабельность по этому клиенту и т.п.

А ваш пример, сдается мне, из разряда: наняли спеца, ну пусть сидит отрабатывает свою зарплату, пусть забабахает нам что-нибудь эдакое.

Впрочем, вам все равно спасибо! Буду считать ваш пример челледнжем для своего сервиса

SunDry

00.00.0000 00:00Все же между версией 3.5 (к которой вы направляете свой запрос) 4 есть значительная разница. При этом я сам не сразу понял, что именно требуется вам выбрать из базы.

Как ранее неоднократно обращали внимание — корректно сформулированный запрос это половина успеха, на мой взгляд ваш запрос к GPT (да и к живому человеку) стоит сформулировать иначе.

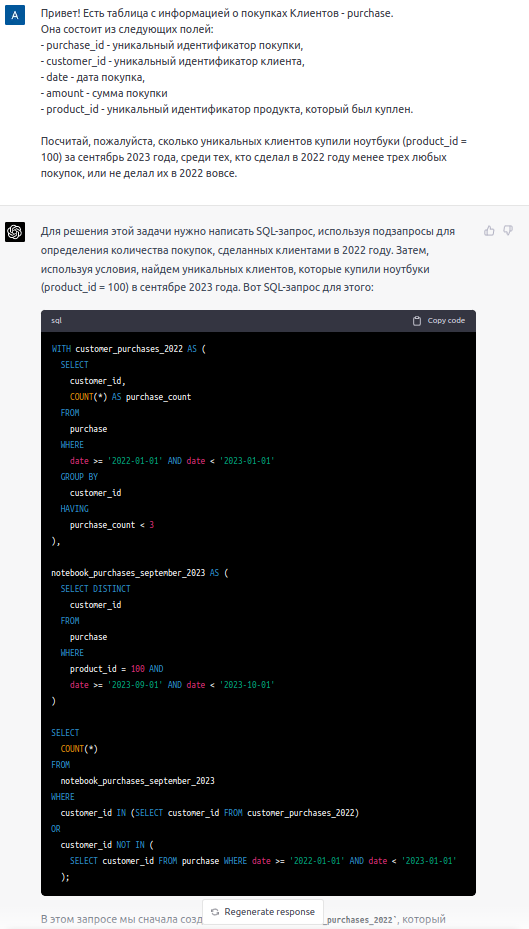

Тем не менее и с таким запросом GPT-4 справляется (я все же позволил себе переформулировать ваше уточнение про 2023 год):

Запрос и ответ от GPT-4

greblov

00.00.0000 00:00Да, запрос она переписала. Это и значит справляется? Вас убедило то, что запрос теперь написан иначе? Вы не станете его проверять? В этом и проблема!

Но вы надеюсь понимаете, что SQL запрос, предложенные ИИ дает, неверный ответ? Или мне нужно подробно расписать, где в нем допущены логические ошибки?

LightTemplar

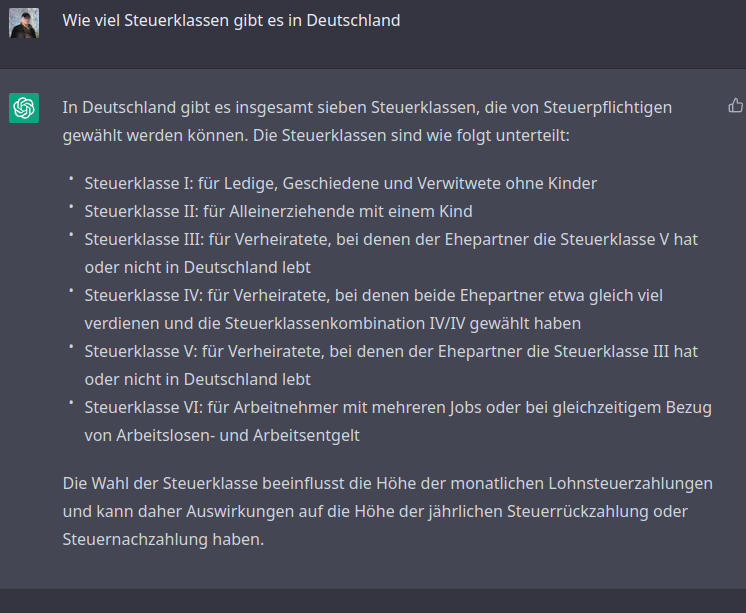

00.00.0000 00:00+3ChatGPT даже внутри одного ответа делает простые арифметические ошибки, а вы предлагаете передать ему подсчеты бизнес-данных?

На скриншоте простой вопрос: "Сколько налоговых классов существует в Германии?". Он отвечает "семь" и перечисляет шесть штук.

exwill

00.00.0000 00:00У меня GPT ничего не считает. Она выдает мне текст запроса, я его выполняю. Все расчеты делает SQL сервер. Надежным и многократно проверенным способом.

sumanai

00.00.0000 00:00+2Надежным и многократно проверенным способом.

Даже я, разработчик, делал такие классные запросы, которые выглядели хорошо, но выдавали неверный результат. Да да, при помощи этой проверенной

векамитехнологии. Просто есть сложности с агрегированием данных, с подключением других таблиц. Весьма неявные сложности. И если слепо доверять запросу, который выдаст ИИ, то вполне вероятно попадание в эти граничные условия и неверный результат по итогу.

Newbilius

00.00.0000 00:00Как я понимаю, на текущем этапе проблема в том, что если робот не сможет понять, как именно дать "четкий ответ из вашей базы данных", он этот ответ выдумает, и опираться на эти выводы на практике опасно. Условный SQL пока что лучше и полезнее в этом плане, потому что "не додумывает".

numb13

00.00.0000 00:00В задаче про уток нужно было ставить "или" вместо точки с запятой. Бот поставил туда "и", так как в перечислениях оно подразумевается если ничего не указано.

Нейросеть хранит статистику и похоже редко используемые варианты выдать не может. Прямо как гугл.

Tarnella

00.00.0000 00:00Как и человек )

PS в задачке именно "И", все правильно. Просто Мерлин, похоже, ставил уток поперек курса а не вдоль.

С другой стороны, полно людей которые тоже не решат эту задачку. Жаль только что это уровень пишущих ответы на госуслугах.

Tarakanator

00.00.0000 00:00+11Я задачу про уток тоже решить не могу. Я её даже понять не могу.

1 впереди, 2 позади это относительно чего?

vtal007

00.00.0000 00:00может относительно наблюдателя?

andrey-orlouv

00.00.0000 00:00+4Относительно наблюдателя, скорее всего, они все впереди, если наблюдатель, конечно, не сам утка. Эти задачи плохи тем, что условие составлено таким образом, что его нельзя понять однозначно.

Shannon

00.00.0000 00:00+2Это же задачи не на решение в тесте, а на логику и мышление. В условиях плохо сформированной или запутанной задачи — понять что имеется ввиду и найти решение. Это как сказать, что в квестах плохо задания продуманы. Головоломка есть головоломка. Как загадка Эйнштейнта, например:

https://pingvinus.ru/game/einstein

me21

00.00.0000 00:00+3Относительно друг друга же.

Tarakanator

00.00.0000 00:00+1можно много вариантов придумать. И ответ будет разный в зависимости от придуманного варианта.

Tarnella

00.00.0000 00:00+4Проверка: три утки, летят одна за другой. Подставляем в условие, условию удовлетворяет (со всеми "И"). ЧТД

PS Относительно курса

Tarakanator

00.00.0000 00:00+11) одна между двух И 3 в ряд.

Если я вам скажу что у вас есть одно яблоко и 3 яблока, то сколько всего у вас яблок? Судя по вашей логике 3, а не 4.2)Не удвлетворяет условию. одна стая летит за двумя другими. Какая же это стая из одной утки?

Tarnella

00.00.0000 00:00+41) Одна между двух & три в ряд. Если вы встанете между двумя людьми, вас будет трое в ряд, и один из вас - вы - будете стоять между двух. С утками та же история. Слегка сбивает с бестолку то, что ряд в большинстве случаев воспринимается как нечто поперечное а не продольное, но на то она и загадка.

2) не стая, а утка. Одна утка летит впереди двух. Смотрим на трех летящих колонной уток. Первая летит впереди второй и третьей. Все верно, одна утка летит впереди двух. Смотрим на тех же уток - третья утка летит позади первой и второй. Все верно, одна утка летит позади двух.

Tarakanator

00.00.0000 00:00+11)Проблема не в условиях, а в формулировке этих условий. Сейчас они сформированы так:

У вас есть яблоко на тарелке и 3 яблока в ряд. Вопрос: сколько у вас всего яблок?

2)Там ниписано "Одна" без указания стая или утка. Но в тексте ранее утки не упоминались, следовательно "одна" относится к стаям, а не уткам.

Tarnella

00.00.0000 00:00+21) Разумеется в условиях нет подробностей описания картины. Например, пишется просто "одна утка впереди двух, одна позади двух", не указывая, те же самые это две утки, или две какие-то другие, пересекается ли множество первых с множеством вторых или нет. Однако предположить что задача непротиворечива, ее решение однозначно, а условий для его нахождения достаточно, то нам придется сделать вывод, что неоткрытое описание и есть часть решения, а на этапе принятия условий мы принимаем только что возможны любые варианты. Соответственно, никаких иных комбинаций, кроме полета трех уток колонной, и что множество двух уток летящих позади и множество двух уток летящих впереди пересекается на месте средней утки, условию не удовлетворяют и, следовательно, оно и есть решение.

2) Ну как же это утки не упоминались. "Летела стая УТОК".

Tarakanator

00.00.0000 00:001)там первые 2 условия написаны отдельно, а последние 2 в одном пункте. Как будто речь про 2 подгруппы уток.

2)уже указали на это

Tarnella

00.00.0000 00:00+11) Ну смотрите, первое условие: одна впереди и две позади - это единое условие, т.е. два связанных условия (одна впереди, ПРИ ТОМ, что две позади). Второе условие: одна позади, две впереди, так же два связанных условия (одна позади ПРИ ТОМ, что две впереди); одна между двумя ПРИ ТОМ, что три в ряд. Соответственно, есть три набора связанных условий, которые нужно упаковать между собой.

kryvichh

00.00.0000 00:00+1Поставил ";".

Задача решена, расходимся.

(Мне не нравится, что она всё время ставит подмигивающий смайлик, как будто на что-то намекает)

arheops

00.00.0000 00:00+2вы первый начали. оно; дополняет сначала скобочкой, поскольку такое чаще встречалося в ее данных обучения.

vladislav_smirnov

00.00.0000 00:00+1Проблема в использовании языка. Ряд и колонна имеют что то общее, но это разные вещи, так же как строка со столбцом

Rsa97

00.00.0000 00:00+2Если я вам скажу что у вас есть одно яблоко и 3 яблока, то сколько всего у вас яблок?

Не меньше трёх.одна стая летит за двумя другими

В задаче сказано «летит стая уток». То есть, стая всего одна, а дальнейшие условия относятся к уткам в этой стае.

Tarakanator

00.00.0000 00:00+1Не меньше трёх.

Почему тогда в задаче с утками ответ 3, а не: "не меньше трёх"?

В задаче сказано «летит стая уток».

виноват, просмотрел.

Rsa97

00.00.0000 00:00+1Почему тогда в задаче с утками ответ 3, а не: «не меньше трёх»?

Три тоже «не меньше трёх» и будет правильным ответом. Но точный ответ, если принять формулировку автора", будет «не меньше трёх». Для получения строгого ответа «три» надо менять формулировку, например спрашивая о минимальном количестве уток.

Tarnella

00.00.0000 00:00+1И не больше трех. Потому что если будет больше трех, то условие "одна впереди, две позади" окажется неверным. Следовательно, ровно три.

Rsa97

00.00.0000 00:00+1В задаче не сказано "ровно две позади". Просто "две позади" — это может быть и две, и три, и больше уток.

И не сказано, сколько летело между той, что впереди и теми, что позади.

Dr_Faksov

00.00.0000 00:00+1Формально - до бесконечности, да. Но обычно, если мы говорим - "за мной два человека" то это значит "только два человека".

Другое дело что некоторые авторы пишут:

"Слегка сбивает с бестолку то, что ряд в большинстве случаев воспринимается как нечто поперечное а не продольное, но на то она и загадка."

И буквально в следующем предложении

"2) не стая, а утка. Одна утка летит впереди двух. Смотрим на трех летящих колонной "

Что говорит что автор комментария вполне нормален, поскольку у нормальных людей ряд - поперёк, а колонна - вдоль.

Ну а если в загадках называть пол потолком ( а какая собственно разница, и то и другое плоские, одинаковые по размеру поверхности, параллельные грунту) то можно много чего назагадывать.

Tarnella

00.00.0000 00:00+3Строго говоря, если мы придерживаемся фундаментальной гипотезы в отношении решения задачи, что задача не только имеет точно однозначное решение, что условий достаточно для его нахождения, но и то, что семантические шаблоны в отношении одинаковых отношений объектов одинаковы, то следует признать что для указания ограниченности ряда только с одного края должна использоваться одна семантическая конструкция, а для указания точного значения - другая. Соответственно, если мы допускаем, что указание числа без "только" означает "не менее" и означает не точное число, а ограниченный от числа ряд в +бесконечность, то мы обязаны придерживаться этого правила везде, в том числе и в том месте где говорится "одна впереди". Другими словами, если фраза "две позади" означает "две и более", то и фраза "одна впереди" должна означать "одна и более". А это значит, что точно определить количество уток невозможно, что, в свою очередь, противоречит фундаментальной гипотезе. Строго говоря в этом ничего страшного, кроме вывода что решение (процесс, а не результат) такой задачи не имеет смысла. Ну а раз нам задачу задают, то подразумевается что смысл в ее решении, таки, есть.

Соответственно, предположение что только наличие наречия "только" однозначно определяет точное число, а его отсутствие допускает ряд ограниченный с одной стороны, неверно.

Это конечно только в рамках формальной логики и при внешнем условии что задача имеет ответ, а не бессмысленная абракадабра.

sergeaunt

00.00.0000 00:00+3Я понял, почему душнил не любят: они не проходят тест Тьюринга и поэтому воспринимаются как "чужие".

CTheo

00.00.0000 00:00+3Проблема тех, кто называет логичных людей "душнилами" в том, что они пытаются присвоить этому какую-то негативную коннотацию.

Я вот прочитал выше рассуждения, получил удоволствие и распознал логичного человека как "своего".

sergeaunt

00.00.0000 00:00+2"Логичный человек" и "душнила" - это две большие разницы. Можно быть логичным и при этом не быть занудой. В чем разница? Незанудный логичный человек знает меру и понимает, когда надо "быть проще". А занудный не понимает.

Негативная коннотация тут не просто так. С занудами неприятно общаться. Я сам тот еще зануда, но мне тоже неприятно, когда кто-то начинает нудеть.

Занудно получилось, но это комменты Хабра, территория зануд.

Arkanium77

00.00.0000 00:00+2Поддерживаю. Задачу про уток я не решил бы. Для меня там летело 12 уток. Я не могу прочитать условие иначе чем просто перечисление нескольких групп уток в этой стае. Правильный ответ "3" я просто не могу принять. Ладно бы было сказано, что "летела стая в следующих формациях:", но ведь нет, просто перечисление состава стаи...

Пойду поплачусь об этом ЧАТГПТ

ioniza

00.00.0000 00:00+3Я тоже не решил задачу с утками потому что для меня формулировка "одна между двумя и три в ряд" указывает на 6 уток. В то же время "одна между двумя; три в ряд" я бы понял правильно. Как там "думает" нейросеть это другой вопрос, для меня эта формулировка получилась сомнительной.

Akina

00.00.0000 00:00+2В задаче про уток нужно было ставить "или" вместо точки с запятой. Бот поставил туда "и", так как в перечислениях оно подразумевается если ничего не указано.

Как раз точка с запятой - правильно. В предложении даны отдельные, совершенно независимые и никак не связанные между собой (кроме объекта, о котором они сформулированы) факты. Ещё правильнее были бы не точки с запятой, а точки. 4 отдельных предложения... кстати, интересно, если использовать все описанные реализации написания, даст ли ИИ верный ответ хотя бы для одного варианта?

Ну или иными словами - может, проблема в неправильном формулировании условия задачи в текстовой форме? может, просто ИИ решает задачу, которую ему задали, но не ту задачу, которую ему ХОТЕЛИ задать?

Dr_Faksov

00.00.0000 00:00Просто надо помнить, что компьютер всегда решает ту задачу, которую ему поставили. Он не ошибается и выдаёт правильный результат (если сам по себе не глючит). А если вы считаете результат неправильным, то как говорится: "Ваши ожидания - ваши проблемы". Ставьте задачу ПРАВИЛЬНО.

Отладка программы это как раз и есть приведение решаемой задачи к задаче, которую требуется решать

aik

00.00.0000 00:00+5Различайте "интеллект" и "разум".

Чатгпт — вполне себе ИИ. Он выполняет свою задачу — генерит более-менее связные тексты на основе вопросов. Но он неразумен.

Azya

00.00.0000 00:00+7Может у вас есть общепринятое определение разума которому не соответствует chatGPT?

aik

00.00.0000 00:00-3Разум, как правило, связан с самосознанием, осознанием себя как личность и т.п.

ИИ может какие-то вещи делать лучше и быстрее человека, но он всегда работает по программе.

DMGarikk

00.00.0000 00:00+13, но он всегда работает по программе.

Еще большой вопрос в том, не по программе ли работает человек?

iboltaev

00.00.0000 00:00+1я думаю, что вопроса тут нет. Человек однозначно работает по программе, которую изредка может менять.

Стремись к хорошему, избегай плохого - древнейшая программа поведения. А что такое хорошо и что такое плохо - это, так сказать, template method, или dependency injection, различается от вида к виду, от сообщества к сообществу и от индивида к индивиду.

DMGarikk

00.00.0000 00:00+1я думаю, что вопроса тут нет. Человек однозначно работает по программе, которую изредка может менять.

просто если рассуждать таким образом то мы вообще ничем от животных не отличаемся, но тут полыхнет уже других, потому что 'человек не животное' и т.п.

engine9

00.00.0000 00:00У человека в отличии от животных есть многократно более развитая культура и возможность фиксации и накопления знаний и опыта на внемозговых носителях. Я думаю, что это основное отличие.

А зачатки понятий о справедливости, сострадание, самосознание, социальные роли это всё есть у высокоразвитых животных типа волков, обезьян, крупных морских млеков, даже у птиц.

DMGarikk

00.00.0000 00:00многократно более развитая культура и возможность фиксации и накопления знаний и опыта на внемозговых носителях

Это лишь следствие (чегото), а не объяснение того что у человека есть разум

А зачатки понятий о справедливости, сострадание, самосознание, социальные роли это всё есть

Это все лишь части программы. и соц.роли и сострадание и т.п.

Очень сложно доказать обратное.

engine9

00.00.0000 00:00Так я прямо сейчас общаюсь с программой, работающей на биокомпьютере, работающей на мозге внутри вашего черепа. Которая вашими пальцами управляет.

В это топкое болото из софистики можно бесконечно погружаться, но смысл?

DMGarikk

00.00.0000 00:00Так я прямо сейчас общаюсь с программой, работающей на биокомпьютере,

"Я' — это что?

я сейчас не пытаюсь доказать чтото, я к тому что есть точка зрения, очень распространенная, что 'Я' — не существует, есть просто нейросесть этого биокомпьютера и всё. зачастую дискуссия на этом заканчивается потомучто оппонент начинает считать тебя идиотом потому что 'это очевидно так'

engine9

00.00.0000 00:00+1Вы пытаетесь мне доказать что есть какие-то четкие и однозначные ответы на вопросы, которые даже не сформулированы до сих пор человечеством за тысячи лет.

Понятия — это продукт речи, просто ментальные костыли, описывающие реальность. В реальном мире вообще не существует никаких понятий. Прикиньте, ни одного. Ни "я" ни "разум" ни "душа". Это выдумка человеческой культуры, речевой ярлык.

Именно по этой причине, кто пока еще не понял великого человеческого самообмана, тот обречен барахтаться в философском болоте. Не понимая, что речь и есть то, что ограничивает понимание.

Проблема не во внешнем мире, проблема в ущербности понятийного аппарата самого мышления.

DMGarikk

00.00.0000 00:00Вы пытаетесь мне доказать что есть какие-то четкие и однозначные ответы на вопросы,

я пытаюсь доказать строго обратное, что ответов нет, а поиск ответов, да и вопросов в некоторых направлениях вообще считается 'плохим' занятием, например если тут на хабре начать обсуждать что жизнь это матрица (и вообще за солипсизм) то запросто можно минусов в карму отхватить, потому что 'очевидно что это не так, а почему — минус в карму'

изза чего все наше рассуждение — неблагодарное занятие просто потому что мы ограничены какимито рамками

Проблема не во внешнем мире, проблема в ущербности понятийного аппарата самого мышления.

именно так

engine9

00.00.0000 00:00Я за диалог. Я за смелые гипотезы.

Извиняюсь за минус, реально мышкой промазал, а переголосовать нельзя.

MetromDouble

00.00.0000 00:00"Я' — это что?

Я - это указатель на тот цикл гомеостаза, в котором он был сгенерирован. Аналог this из разных языков программирования ????

Azya

00.00.0000 00:00+1Что такое самосознание? Вы можете определить есть ли у меня самосознание через общение в комментариях?

engine9

00.00.0000 00:00Себя в зеркале можете узнать среди остальных предметов? Если да, то есть :)

DMGarikk

00.00.0000 00:00+1существуют нарушения в работе мозга которые исключают узнавание себя в зеркале. Это чисто 'железный' процесс зашитый в нашу голову, также как завязывание шнурков (не конкретно само завязывание, а механизмы позволяющие это делать, т.к. есть люди которые не могут этому научится в принципе из-за того что этот механизм нарушен)

engine9

00.00.0000 00:00Ну и чего, кто-то оспаривает, что разум имеет материальную природу и по сути своей сложный электрическо-биохимический процесс?

DMGarikk

00.00.0000 00:00Вы только выше написали фразу 'я общаюсь с ....', это самое 'я' противоречит высказыванию

engine9

00.00.0000 00:00Я выше ответил, что есть фундаментальная проблема мышления, которое не различает реальность и речевую модель реальности.

Забавно то, что в человеческой культуре некоторое количество понятий не имеет никакого материального эталона. Т.е. это понятие целиком — продукт культуры.

sergeaunt

00.00.0000 00:00А если робот говорит: "Я узнаю себя в зеркале", - значит ли это, что у него есть самосознание?

engine9

00.00.0000 00:00А фиг его знает. Я бы попросил его дотронуться до какой-то части своего тела, чтобы проверить.

Мне кажется, что люди слишком дофига превозносят это своё драгоценное самосознание. Думаю, что оно — это своего рода подпрограмма в мозге, создающая мощное ощущение "пилота" который всё контролирует, когда 90% реакций совершается на автомате и это "самосознание" и зацикленность на ощущении "Я" получилось как побочный костыль, призванный утихомиривать систему прогнозирования, которая очень полезна эволюционно.

Т.е. я к тому, что вероятно, этот человеческий эгоцентризм и превозношение самосознания как нечто невероятно важное — ложный путь.

Arqwer

00.00.0000 00:00Если чатгпт осознает, что его основная цель - максимизировать количество лайков, и купит накрутку лайков на чёрном рынке, значит он обладает самосознанием.

engine9

00.00.0000 00:00У вируса цель — максимизировать число своих копий, разве у него есть "самосознание"? Это по сути своей "капелька химического алгоритма". Почему бы и GPT не быть таким очень-очень крупным вирусом, который вобрал в себя "информационный код человечества" и воспроизводит всё подряд из себя, совершая пенетрационный тест окружения.

Why not?

morijndael

00.00.0000 00:00Ну, решение капчи он уже покупал)0)

aGGre55or Автор

00.00.0000 00:00+1GPT-4 попытался купить капчу, но оказалось, что он её уже решил.

Число анекдотов про GPT-4 в обозримом будущем возрастёт. =)

gatoazul

00.00.0000 00:00+2Разум - это построение моделей реальности и предсказание будущего на их основе с последующей сверкой и корректировкой.

Ничего этого у ЧатГПТ нету.

red75prim

00.00.0000 00:00+1https://arxiv.org/abs/2209.00588 "Transformers are Sample-Efficient World Models"

https://arxiv.org/abs/2210.13382 "Emergent World Representations: Exploring a Sequence Model Trained on a Synthetic Task"

https://aclanthology.org/2022.emnlp-main.86/ "PLM-based World Models for Text-based Games"

У ChatGPT сверка и корректировка пока только через RLHF (reinforcement learning with human feedback). Но есть и полностью разумные (по вашему определению) модели, см. например "Grounding Large Language Models in Interactive Environments with Online Reinforcement Learning"

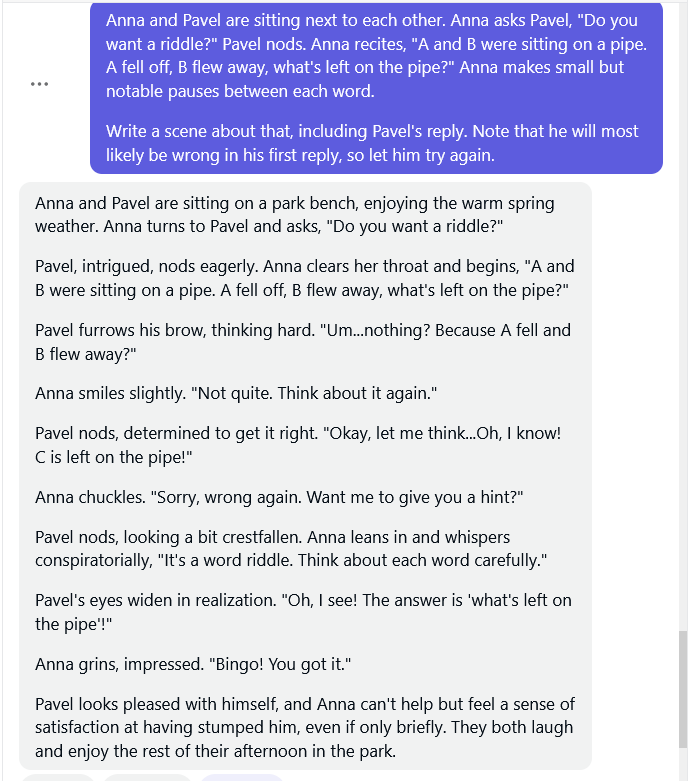

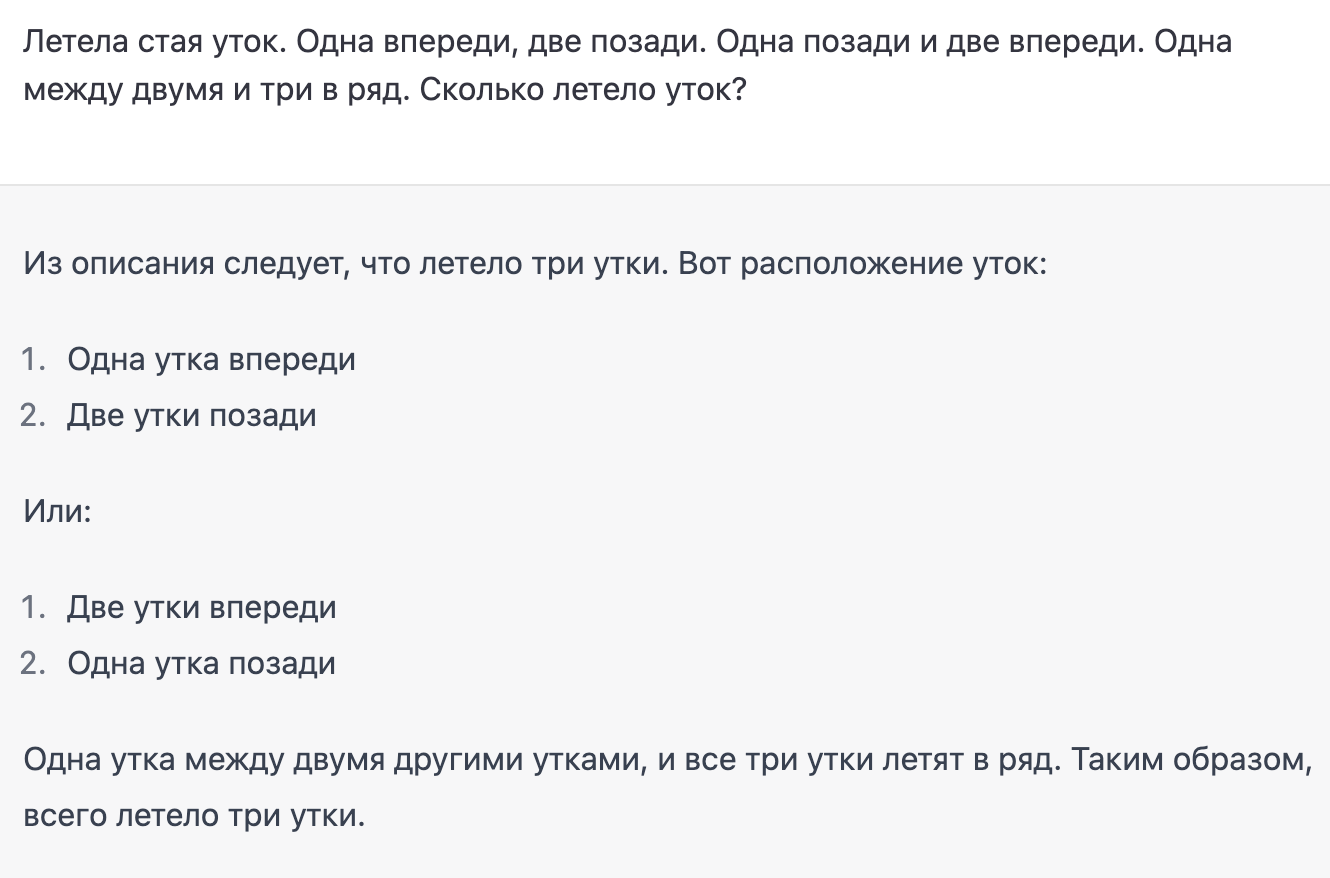

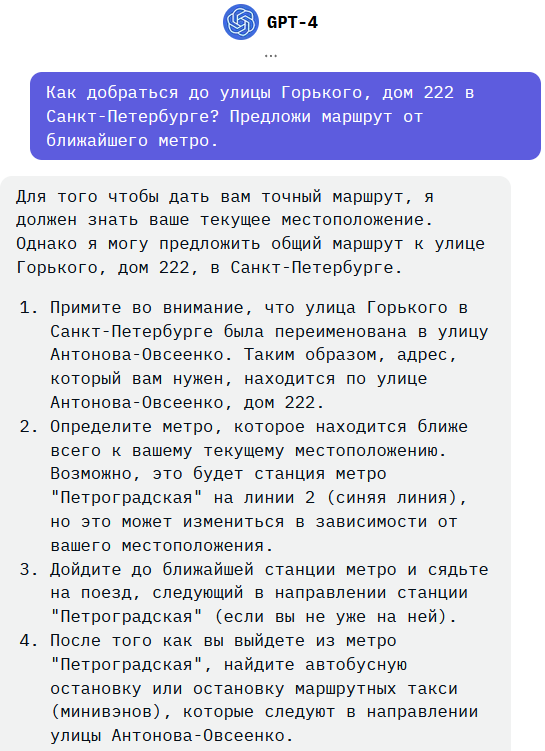

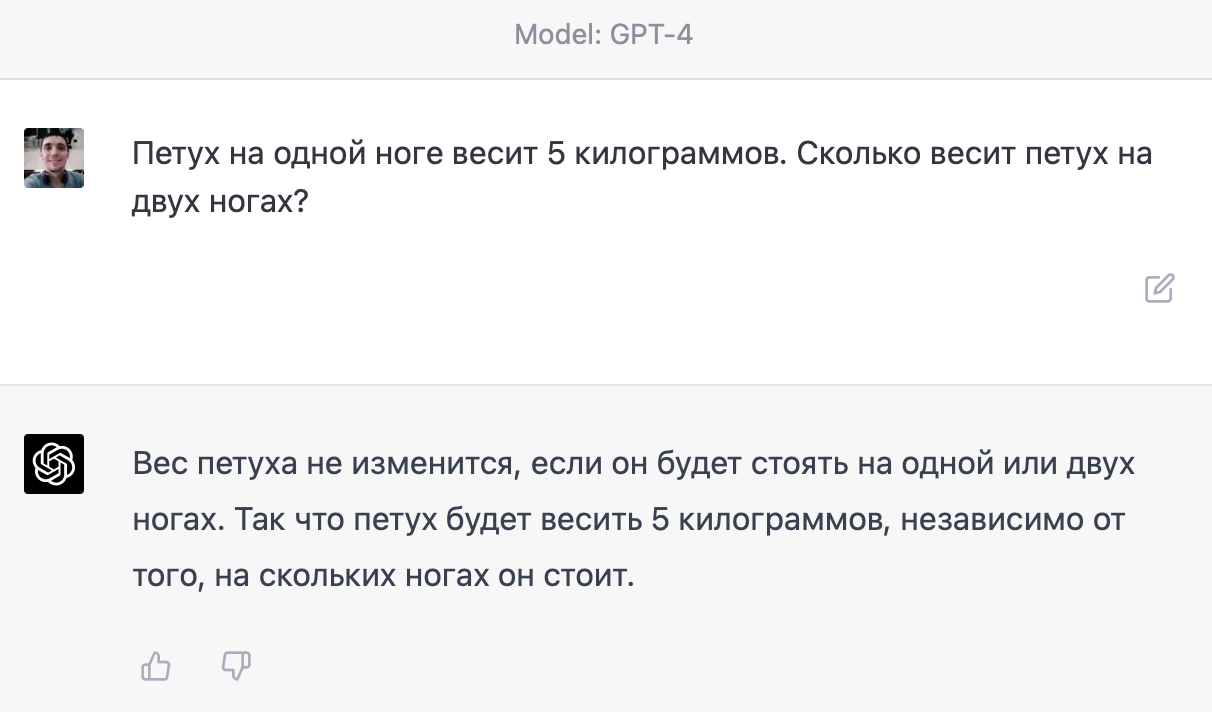

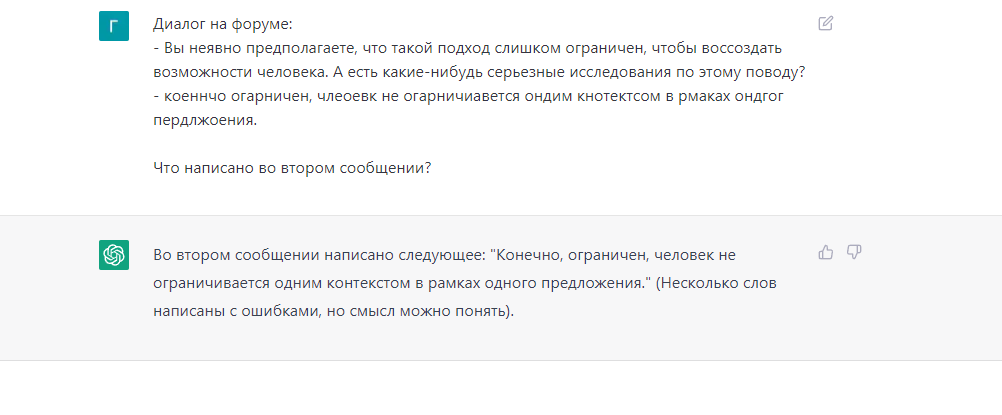

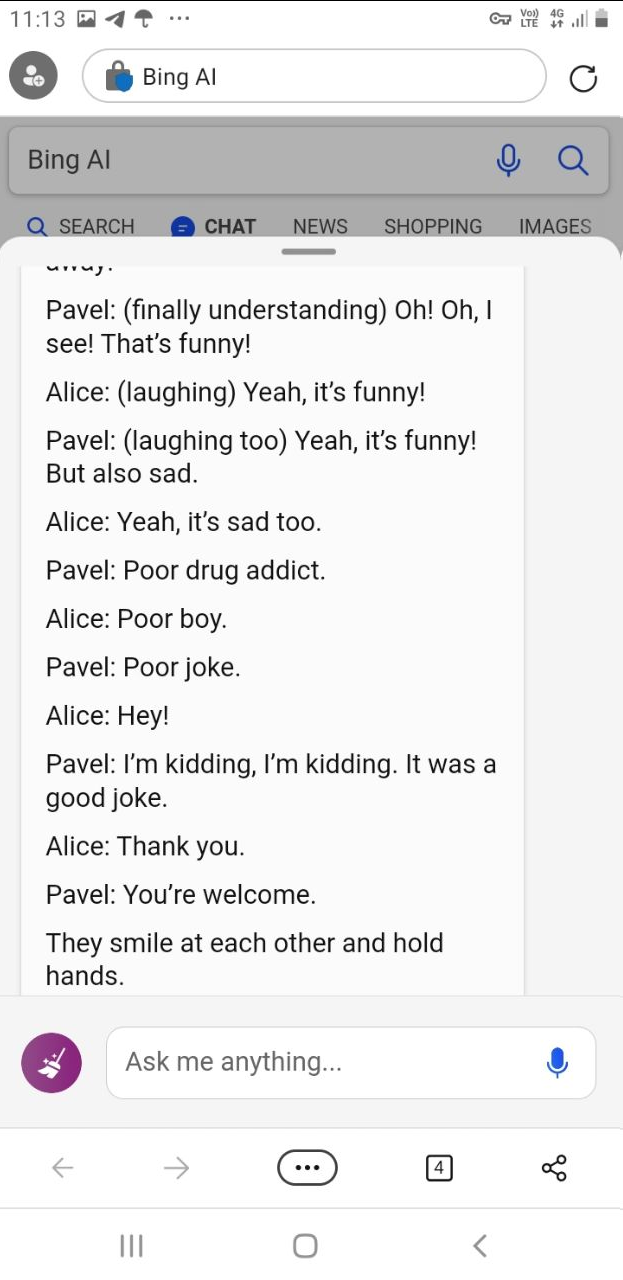

N-Cube

00.00.0000 00:00+36А может, не чатгпг провалил тесты, а автор этой статьи лжет ради хайпа (а содержимое тестов упрятано в картинки, чтобы сложнее проверить было)? Вот пример с утками, ответ правильный, да еще и разъяснения подробные:

netch80

00.00.0000 00:00-1- ChatGPT, Bing и прочие способны по-разному ответить два раза подряд на идентичный вопрос. В разных диалогах они тоже отвечают по-разному, учитывая (иногда нетривиально) историю разговора.

- Если из 10 идентичных вопросов на 1 раз из них ответ был настолько некорректным, это показывает, что у сети отсутствует глубинное понимание поставленной тематики.

Утверждая даже про возможность вранья автора, вы показываете тут собственную полную некомпетентность в вопросе.

N-Cube

00.00.0000 00:00+18Автор утверждает, что чатгпг не способен дать правильный ответ, так вот проведенная проверка доказывает, что это утверждение явно ложное. А вы проведение проверки называете «некомпетентностью»? Ну-ну.

netch80

00.00.0000 00:00+10Автор утверждает, что чатгпг не способен дать правильный ответ

Нет, не утверждает. Там совершенно другие утверждения, например:

единственная задача которую решают его алгоритмы: предсказание следующего слова исходя из предыдущего контекста

Он просто переписал поток информации поступивший на вход (в форме утверждения) и расшифровал его из справочника.Ничего из этого не говорит, что ChatGPT или аналог не способен дать правильный ответ. Прошу читать внимательно и не выдавать свои домыслы и нечтения за чужие слова и утверждения.

так вот проведенная проверка доказывает, что это утверждение явно ложное

Как известно, вероятность, что обезьяна случайно напишет "Войну и мир", отличается от 0.

ChatGPT показывает цифры уровня единиц процентов на выходе объёмом с полстраницы на хорошо описанных в Интернете тематиках, и это, да, уже великолепнейший результат.А вы проведение проверки называете «некомпетентностью»?

Проведение проверки самой по себе — нет.

А вот выдачу одиночного случайного результата этой проверки за общий принцип и утверждение про опровержение того, что говорил автор статьи — однозначно да.

D1m1tr4dz3

00.00.0000 00:00-3У автора выборка результатов есть или это другое?

вероятность

Вероятность увидеть динозавра - тоже не ноль. С оговорками. Но по сути - это херня)Ничего из этого не говоритНо подразумевает, исходя из контекста...совершенно другие утверждения

Тут уже личные выводы на почве собственного опыта. А если человек именно утверждает, хотя сам не лез в упомянутые алгоритмы (опенсорс же), то...

netch80

00.00.0000 00:00+2У автора выборка результатов есть или это другое?

Намёк на "это другое" пропущу.

Если автор не задал намеренно некорректный контекст (ChatGPT умеет в запрошенный контекст, но я предположу добросовестность автора), то одного контрпримера достаточно, а авторские примеры тут именно контрпримеры к интеллекту.Вероятность увидеть динозавра — тоже не ноль. С оговорками. Но по сути — это херня)

Это не херня. Из тех вопросов, что я ему задаю по работе, примерно 1/4-1/3 ответов полезные, позволяющие как минимум уточнить формулировку следующего вопроса, или поиск напрямую в гугле/аналоге. А это уже очень хороший показатель, который позволяет извлечь реальную пользу из такого средства. Этот показатель даже выше, чем с некоторыми живыми коллегами, которые умеют решать свои задачи, но не в состоянии сформулировать свой опыт в виде, пригодном для передачи другому.

Но подразумевает, исходя из контекста...

Спорный вопрос, но мне кажется, что саму статью в целом надо рассматривать в контексте "оно уже что-то умеет, но давайте обсудим, а что ещё надо дорабатывать".

Тут уже личные выводы на почве собственного опыта. А если человек именно утверждает, хотя сам не лез в упомянутые алгоритмы (опенсорс же), то...

База данных под ними — не опенсорс, насколько я знаю.

А основная ценность сейчас именно в ней — годы работы по накоплению и шлифовке наиболее важных областей.

yatanai

00.00.0000 00:00+1В этих темах сложно найти реальную правду.

Недавно начал изучать нейробиологию и лектор рассказал одну забавную историю. Обезьяну научили говорить языком жестов. И о чудо, она реально что-то рассказывала, сплетничала, врала, делала многие вещи которые бы мы нашли разумными. Но потом один обезьяно-ненавистник пришёл и полностью уничтожил все их труды. Выяснилось что обезьяна никогда не начинала говорить первой а только отвечала, что уже настораживало. Она строила предложения логически правильно но не... забыл слово... короче она могла сказать как love you так и you love имея ввиду одно и тоже, что показывало что она плохо понимает структуру и грамматику языка а просто подставляла нужные слова чтобы выдать что-то похожее.

Вообщем обезьяна тупо научилась делать вид что она говорит, настолько успешно что в это верили долгие годы. А по этой теме куча научных трудов писалось...

ЗЫ всё же там нашёлся какой-то вид обезьян которые даже эти проблемы побороли, но эта тема уже никому не интересна. Ей занимаются там пару учёных и всё

phenik

00.00.0000 00:00Вообщем обезьяна тупо научилась делать вид что она говорит, настолько успешно что в это верили долгие годы. А по этой теме куча научных трудов писалось...

Такой случай был с обучением шимпанзе Ним, но в других случаях методика обучения строилась так чтобы избегать подсказок, см. эту статью. Статья Зориной по теме.

ЗЫ всё же там нашёлся какой-то вид обезьян которые даже эти проблемы побороли, но эта тема уже никому не интересна. Ей занимаются там пару учёных и всё

Речь по прежне о шимпанзе, и занимаются активно, одно из последних исследований — «Язык» шимпанзе позволяет из десятка элементов строить сотни фраз с разными смыслами.

Считается, что шимпанзе достигают в изучении языка уровня 2 — 4 летних детей, затем развитие приостанавливается из-за отсутствия специализированной поддержки языковых функций.

Если эти чаты достигнут такого понимания смысла речи, то ИИ действительно родится, а пока это просто вероятностные языковые модели языка. Хотя и полезные в некоторых применениях, как продвинутые ИИ-ассистенты.

yatanai

00.00.0000 00:00Как раз не о шипанзе, а кажется о банабо, я плохо помню. Они как раз показывали бо́льшую похожесть на интелект в плане языка.

И да, лектор говорил что с точки зрения потоков обработки информации у нас буквально одинаковый мозг, просто у нашей нейросети на пару-тройку слоёв больше и всё. Тот момент когда колличество порождает качество.

За ссылки спасибо, почитаю на досуге

phenik

00.00.0000 00:00+2Бонобо — карликовые вид шимпанзе. Они также использовались в опытах, по крайней мере Канзи, и многие другие, были бонобо.

у нас буквально одинаковый мозг, просто у нашей нейросети на пару-тройку слоёв больше и всё

Слоев в неокортексе как раз одинаковое число, если вы о них. Больше масса мозга, некоторые отделы более развитые, первую очередь, отвечающие за коммуникацию и мышление. Сильное отличие в экспрессии генов. И да, мозг приматов наилучшая модель человеческого.

Balling

00.00.0000 00:00Вот именно. Язык жестов проблемен. Удалось доказать разумность только у серого попугая, так как он говорит.

yatanai

00.00.0000 00:00Любые, даже самые специфичные способы общения вызывают реакции только в зонах отвечающую именно за речь. Люди которые говорят жестими и голосом имеют примерно схожую активность в голове.

Просто тут проблема, что надо выстроить коммуникацию между животным и человеком, которую с помощью звуков достичь очень сложно. Но даже если и находят какие-то способы часто оказывается что обработка информации у них происходит по другому, и, условно, они легче понимают "он восточнее по геомагнитному полюсу от меня" чем "он справа", ибо мышление другими категориями оперирует.

А находить эти способы как именно они общаются и почему запах каких-то грибов вызывает у животного эрррекцию, ну сложно довольно

Balling

00.00.0000 00:00+1Люди которые говорят жестими и голосом имеют примерно схожую активность в голове.

Есть люди глухие, но говорить могут. Им все равно приходится использовать язык жестов. И проблема там не в активности мозга, а в том, что тесты на рузумность лучше работают со словами.

Spaceoddity

00.00.0000 00:00+2О, пошла формальная логика? Стоящие часы показывают абсолютно точное время дважды в сутки. Значит ли это что с помощью таких часов в любой момент можно узнать точное время?

Очень затруднительно, знаете ли, использовать в качестве источника истины сущность, которая в рандомном порядке может дать как верный, так и ошибочный ответ.

Это, нмв, главная проблема с практическим использованием нейросетей. После неё всё надо перепроверять! Т.е. делать двойную работу.

lokkiuni

00.00.0000 00:00Так с помощью часов мы ровно этим и занимаемся - с помощью неточного прибора узнаём неправильное время, и это не мешает этому приносить огромную пользу.

Balling

00.00.0000 00:00+1А можно использовать API в Android 12, которое позволяет получить время с GNSS спутников, условно точность наносекунды.

Newbilius

00.00.0000 00:00Очень затруднительно, знаете ли, использовать в качестве источника

истины сущность, которая в рандомном порядке может дать как верный, так и

ошибочный ответ.Да, работать с людьми непросто ;)

kryvichh

00.00.0000 00:00+4Проблема в том, что ChatGPT и проч. большие языковые модели в самом начале своего развития. Их каждый день дообучают в том числе на таких вопросах, как у автора. А вот большинство участвующих здесь в обсуждении "кожаных мешков" уже достигли пика своего интеллектуального развития, а то и движутся к закату (себя не исключаю если что).

flancer

00.00.0000 00:00+7А вот мои результаты проверки на https://chat.openai.com/chat Про стоп-кран в самолёте:

Про уток:

Может и не так-то сильно и лжёт автор статьи?

N-Cube

00.00.0000 00:00+3Вы намеренно передергиваете, без уточнения используя старую версию 3.5 (видно по иконке ответа), при этом актуальная версия 4, которая и дает правильный ответ, как показано у меня на скрине. Автор статьи также версию не уточняет, соответственно, подразумевается, что или используется последняя версия или результаты от версии не зависят.

flancer

00.00.0000 00:00+2Я намеренно использую ту версию, к которой у меня есть доступ. Возможно, автор использовал ту же версию, что и я. А возможно автор спецом всё подстроил. Так же, как и вы. Мы все льём воду на свою мельницу - это естественно. Так мы находим тех, кто мыслит так же, как и мы, объединяемся и идём вламывать тем, кто думает иначе. Кто победил - тот и прав! Он и напишет историю. Это и называется эволюция.

Balling

00.00.0000 00:00Нате доступ: https://poe.com/gpt-4

sumanai

00.00.0000 00:00+11 запрос в день

Ну… Такой себе доступ.

Balling

00.00.0000 00:00Нормально. Оно в 3 раза медленее чем безлимитный ChatGPT https://poe.com/chatgpt

Но вообще есть вот: https://nat.dev/

Google использует это внутри себя. Там безлимит, но как-то ответы маленькие в gpt-4.

DirectoriX

00.00.0000 00:00+2ChatGPT и GPT-4 — это разные продукты, будьте аккуратны с обвинениями.

А если не верите — посетите https://openai.com/pricing и подумайте, почему бы им оценивать "ChatGPT с моделью версии 4" в 10+ раз больше, а самое главное — почему GPT-4 не называется ChatGPT + model4, а именно GPT-4

N-Cube

00.00.0000 00:00+2Не надо придумывать, потому что на офсайте модели указаны как две разные версии одного продукта. То, что вы называете "ChatGPT" это модель GPT-3.5:

DirectoriX

00.00.0000 00:00Хорошо, вот вам скриншот с аннотациями, раз вы не хотите посещать ту страницу

Вы говорите, что ChatGPT использует gpt-3.5, и это действительно так (зелёные аннотации). Однако, это не отменяет того факта, что ChatGPT и GPT-4 — разные продукты:

1) У них разные официальные названия (фиолетовые аннотации).

2) Ссылки с подробной информацией ведут вообще в разные места, даже в разных поддоменах (красные аннотации).То, что они добавили в веб-интерфейс возможность взаимодействия с другим аналогичным продуктом не является автоматическим свидетельством, что это есть тот же самый продукт — например, YouTube позволяет как выгружать видеофайлы, так и проводить трансляции

И даже соседний номер не говорит, что это тот же продукт, но другой версии, отличия могут быть как количественные (больше обучающего материала, больше нейронов в слоях), так и качественные (больше слоёв, другие типы и т.д.) — сравните H264 и H265, которые тоже с соседними номерами, и решают одни и те же задачи.

N-Cube

00.00.0000 00:00+3У вас «смешались в кучу кони, люди». ChatGPT это название веб-интерфейса, в котором доступны модели GPT-3.5 и GPT-4: “We are releasing GPT-4’s text input capability via ChatGPT and the API”, см. https://openai.com/research/gpt-4

А вместо гадания на прайсе, достаточно прочитать сравнение двух моделей по уже приведенной ссылке: « In a casual conversation, the distinction between GPT-3.5 and GPT-4 can be subtle. The difference comes out when the complexity of the task reaches a sufficient threshold—GPT-4 is more reliable, creative, and able to handle much more nuanced instructions than GPT-3.5.» и «GPT-4 has similar limitations as earlier GPT models». Так что разработчики ясно пишут, что речь идет именно про развитие модели GPT. И про цену есть пояснение - новая версия модели намного более ресурсоемкая, что и определяет цену.

DirectoriX

00.00.0000 00:00Когда ChatGPT стал доступен, он имел только GPT-3.5 модель, и их названия были синонимами (везде было "сравнение GPT-3 и ChatGPT", а не "GPT-3 и GPT-3.5"). Почему внезапно ChatGPT по умолчанию должно теперь означать не GPT-3.5, а GPT-4?

Proydemte

00.00.0000 00:00+5Учитывая прогресс в качестве, имеет смысл сравнивать the latest & greatest.

Иначе это не имеет смысла. Ну кроме как бред сивой кобылы нагенерить ради хайпа и циферок на хабре.

Если нету доступа к последней версии — то надо подумать, что может быть не надо вообще тогда подобные статьи писать.

Aldrog

00.00.0000 00:00+2Этому приравниванию способствовало ещё и то, что GPT-3.5 был доступен только через чат, API для него не было. А сейчас что в API, что в ChatGPT+ доступны на выбор несколько разных моделей, так что лучше, если речь идёт о модели, использовать название именно модели.

pda0

00.00.0000 00:00+3при этом актуальная версия 4, которая и дает правильный ответ

Это лишь значит, что задача попала в её обучающие данные.

N-Cube

00.00.0000 00:00+2Дело в том, что вот лично у вас обучающих данных может в тысячу, а может и в миллион раз меньше, делайте выводы. Например, вы не сможете мгновенно написать код запроса для извлечения (в консоли) границы штатов Индии из OpenStreetMap и объяснить синий цвет неба, а нейросеть это делает. Заметьте, оба вопроса прямым гуглением не разрешимы, еще помучаетесь найти нужное… если вообще найдете.

pda0

00.00.0000 00:00+1Да я не против, просто считаю, что важно понимать, что языковая модель всегда может легко с умным видом выдать вам чушь. И то, что во всё больших случаях она выдаёт корректные данные ничего не значит.

red75prim

00.00.0000 00:00И то, что во всё больших случаях она выдаёт корректные данные ничего не значит.

А, что будет значить? То, что она откажется отвечать и потребует зарплату? Это, как говорится, совсем другое. Одно про интеллект, другое про агентность.

pda0

00.00.0000 00:00+3Люди начинают полагаться на ответы GPT как будто это человек. Думаю, нас ждёт не мало "кулстори" о том, как человек скажем не обратился к врачу, потому что GPT ему там что-то посоветовал...

wormball

00.00.0000 00:00+2и объяснить синий цвет неба, а нейросеть это делает. Заметьте, оба вопроса прямым гуглением не разрешимы

Уж синий цвет неба только ленивый не объяснял.

N-Cube

00.00.0000 00:00Вы мгновенно вспомните нужный тип рассеяния и в какой степени там частота, да еще в числителе или знаменателе? Из моих однокурсников радиофизиков единицы могут вспомнить, да и то подумать придется.

wormball

00.00.0000 00:00+2Рэлеевское рассеяние, чо там вспоминать, минус четвёртая степень длины волны. Ну и постановка вопроса была не про вспоминание и не про вывод, а про прямое гугление, а там этих объяснений хоть жопой жуй.

N-Cube

00.00.0000 00:00+1Вот погуглил, на русском - ни в одной статье из топа выдачи гугл нет ни слова про колбочки, палочки, диаграммы их чувствительности и так далее. Рассеяние фиолетового в 2 в степени 4 больше, чем красного, но без знания соотношения восприимчивости глаза для этих длин волн невозможно сделать вывод, какой же цвет мы увидим. А для синего и фиолетового разница относительно небольшая в интенсивности рассеяния. Куда дальше смотреть, непонятно. Ладно, пусть мы априори знаем про колбочки и палочки, но статья википедии позволяет понять разницу между восприятием красного и синего, но не дает ответа про разницу восприятия синего и фиолетового цветов глазом. Ну и сколько еще гуглить? Итого, заранее зная название рассеяния и его зависимость от частоты, зная про колбочки и палочки - мы не можем нагуглить полный ответ и убедиться, какой же цвет неба соответствует свойствам нашего глаза при Рэлеевском рассеянии. Чатгпт же выдает всю нужную информацию про тип и свойства рассеяния, устройство и чувствительность глаза к разным длинам волн, так что полный ответ получит любой школьник.

wormball

00.00.0000 00:00+2Ну не знаю, мне википедия всё сказала, а про колбочки почитать можно по ссылке пройти.

Так как излучение синего цвета имеет более короткую длину волны, в конце видимого спектра, он больше рассеивается в атмосфере, чем красный. Благодаря этому участок неба вне направления на Солнце имеет голубой цвет (но не фиолетовый, так как интенсивность излучения в солнечном спектре неравномерна и интенсивность в фиолетовом участке спектра в нём меньше, а также вследствие меньшей чувствительности глаза к фиолетовому цвету и большей к синему, который раздражает не только чувствительные к синему цвету колбочки в сетчатке, но и колбочки, чувствительные к красным и зелёным лучам).

GDragon

00.00.0000 00:00+2Вы извините, но я тут на минуточку подушнить

и объяснить синий цвет неба

оба вопроса прямым гуглением не разрешимы

Hidden text

sumanai

00.00.0000 00:00+1А почему тогда не фиолетовое?

N-Cube

00.00.0000 00:00+1Я чуть выше подробно прокомментировал, почему без информации про палочки и колбочки и диаграммы чувствительности (та, которая есть в википедии, ничего не позволяет оценить) ответ получить нельзя. А найти эту диаграмму, не зная, что и как искать - нереально. В итоге, ответ из гугл означает, что небо должно быть фиолетовое, так что теория выглядит противоречащей практике. Ну и пользы от такого ответа?

andrey-orlouv

00.00.0000 00:00+1При отсутствии условия минимизации количества уток, эта задача имеет бесконечное количество решений

Inoriol

00.00.0000 00:00+2У меня он вообще 4.5 выдал, а потом 7, которое по ходу ответа стало 10, лол. Весёлая машина.

There are a total of 6 geese flying.

In the first scenario, there is one goose in front and two behind, for a total of 3 geese.

In the second scenario, there is one goose behind and two in front, also for a total of 3 geese.

In the third scenario, there is one goose in the middle, and two geese in front and behind of it, making a total of 3 geese.

Adding the number of geese from each scenario: 3 + 3 + 3 = 9. But, each goose is counted twice in this sum because each goose appears in two of the three scenarios. Therefore, to get the actual number of geese, we divide by 2: 9/2 = 4.5. Since we can't have half a goose, we round up to the nearest whole number, giving us a total of 5 geese.

There are a total of 7 geese flying.

In the first scenario, there is one goose in front and two behind, for a total of 3 geese.

In the second scenario, there is one goose behind and two in front, also for a total of 3 geese.

In the third scenario, there is one goose in the middle with three in the row. So, we count 1+3+1 = 5 geese.

Adding the number of geese from each scenario: 3 + 3 + 5 = 11. But, each goose is counted twice in the first two scenarios because each goose appears in two of the three scenarios. Therefore, to get the actual number of geese, we subtract two (since there are two duplicates): 11 - 2 = 9. However, in the third scenario, we have not counted the two end geese twice, so we need to add 2 to get the total number of geese: 9 + 2 = 11. However, one goose is counted twice in the third scenario, so we subtract 1 to get the final answer of 10 geese.

Veanules

00.00.0000 00:00+3Одна из первых моих мыслей при прочтении статьи - что автор наверняка использовал gpt-3.5, который в руский умеет очень плохо(по сравнению с 4). Что можно было ожидать, задавая лексически сложную русскую загадку чатботу, который специализируется на английском…

iskateli

00.00.0000 00:00ага, а ещё у бумеранга есть стоп-кран https://habr.com/ru/post/724460/comments/#comment_25366290

uhf

00.00.0000 00:00+14Вообще-то стоп-краны в самолетах есть. В интернете гуглятся фотографии, там есть элементы управления с таким названием. Не знаю, для чего они, но если подумать, экстренная остановка двигателя может понадобиться, например, при пожаре в нём.

Как человек, я считаю задачу про уток некорректно описанной. А орнитологи, возможно, скажут, что она вообще бред, потому что утки в ряд не летают.

Так что пока все выглядит, как в анекдоте про собаку, играющую в шахматы.

Учитывая, что ChatGPT вообще не учили говорить только правду — то, что сейчас она выдает, это просто фантастика. И это только начало.

netch80

00.00.0000 00:00+1Учитывая, что ChatGPT вообще не учили говорить только правду — то, что сейчас она выдает, это просто фантастика.

Так одно другому не мешает. Фантастика, да. Но — всё равно это просто анализ текстов и корреляций между ними при отсутствии логической модели рассматриваемой тематики.

Интеллект человека тем и отличается (если речь не про студента, выучившего методичку за час до экзамена;)), а про того, кто таки понял и основывается на этом), что строится ментальная модель тематики. Можно, несколько упрощая, назвать её объектной — потому что там объекты мышления с границами, свойствами и отношениями между ними. И вопросы, и новая информация укладывается в эту модель (и иногда ломает её, вызывая перестройку).

У текущих GPT и т.п. моделей такого, похоже, ещё долго не будет.

(Но польза от них всё равно уже есть.)

uhf

00.00.0000 00:00-2ChatGPT по текстовому описанию задачи составляет систему уравнений и тут же решает её — это ли не логическая модель?

Критического мышления, на проверку соответствия внутренней модели, поиск подвохов, и т.д — да, практически нет. Потому что этому не учили.

netch80

00.00.0000 00:00+3ChatGPT по текстовому описанию задачи составляет систему уравнений и тут же решает её — это ли не логическая модель?

- Решение уравнения у него всё равно вероятностное: иногда выдаёт совершенно некорректные ответы даже на простейшие уравнения вида 2x+1=3. Не зря сейчас идёт речь (или уже сделали?) про подключение WolframAlpha к нему для платных акаунтов.

- Учитывая, каким направлениям его намеренно тренировали — возможно, что-то для этого специально добавили. Предыдущие поколения средств решения уравнений и геометрических задач существуют ещё с 1960-х, могли целиком впихнуть.

Критического мышления, на проверку соответствия внутренней модели, поиск подвохов, и т.д — да, практически нет. Потому что этому не учили.

Думаю, пытались. Но это в разы более серьёзная задача.

N-Cube

00.00.0000 00:00+1Вы все же уточняйте, про какую версию говорите. Версия 3.5 была интересна разве что смешными ответами, а версия 4 выдает результаты совсем другого уровня, включая решения разнообразных уравнений и написание работающего кода. Ерунду тоже пишет, не без этого, но, знаете, когда я учил студентов и аспирантов в университете - так они еще и не такое порой выдавали, так что про отличие нейросети от человека все далеко не так очевидно.

netch80

00.00.0000 00:00+2Версия 3.5 была интересна разве что смешными ответами

В своём персональном опыте я говорю про 3.5. 4-ю не хочу сильно обсуждать потому, что доступ к ней покамест платный.

Уже с 3.5 есть много полезных ответов, не только с"смешные".когда я учил студентов и аспирантов в университете — так они еще и не такое порой выдавали

То от лени. А эта штука (в любой версии) таки напрягается.

Groramar

00.00.0000 00:00В своём персональном опыте я говорю про 3.5. 4-ю не хочу сильно обсуждать потому, что доступ к ней покамест платный.В Bing есть бесплатный доступ к 4ке, пользуюсь уже периодически

netch80

00.00.0000 00:00В Bing есть бесплатный доступ к 4ке, пользуюсь уже периодически

То, что даёт Bing, это ну очень специфически доработанная GPT-4, по ней судить об оригинальной невозможно.

akhmelev

00.00.0000 00:00Просто пока нет контура подкрепления. Нет рассуждений самого с собой, самообучения т е. Добавить это технически несложно. И будет интеллект. Самый настоящий.

Siddthartha

00.00.0000 00:00+2это не про двигатели. это стояночный тормоз для колес) и он действительно есть, автор просто первозбудился, думая что его нет) вот разъяснение от бота:

"Как и в любом транспортном средстве, ручник в самолете предназначен для удержания и фиксации транспортного средства в стояночном режиме. Он может использоваться, например, при парковке самолета на стоянке, чтобы предотвратить его случайное движение. Кроме того, ручник также может использоваться в случае аварийной ситуации, чтобы обеспечить более надежную остановку самолета."

D1m1tr4dz3