О чём статья?

Одна из проблем, с которой могут столкнуться сайты с очень большим количеством страниц (порядок: несколько десятков миллионов страниц), — одинаковые мета-теги title и description на всех этих страницах. В этой статье разберём способы, как можно частично улучшить SEO ситуацию в таком случае.

А что такое вообще мета‑теги и зачем они нужны?↓

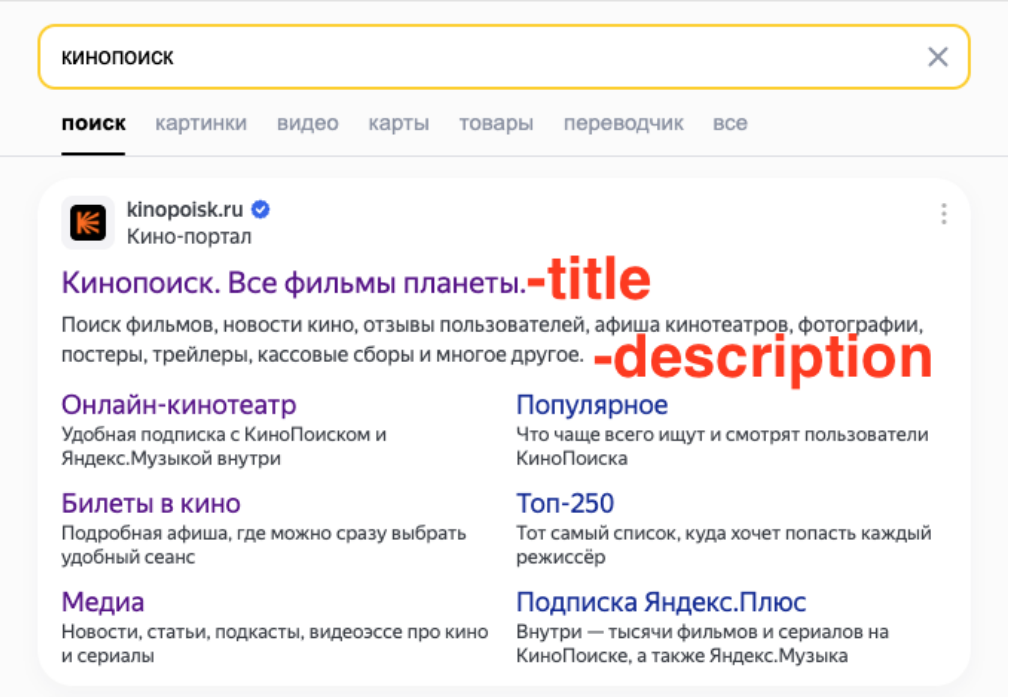

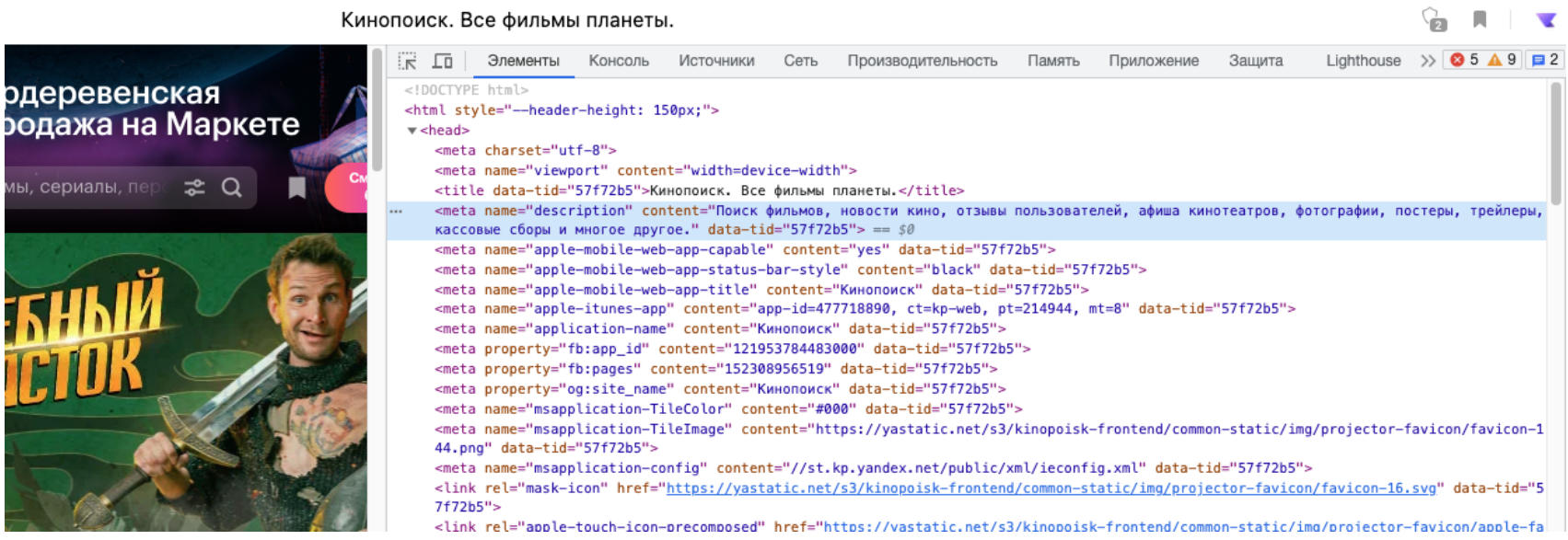

Если говорить простым языком, то мета‑теги — это специальная разметка на странице, которая на самой странице не видна пользователю, но нужна для поисковых систем, чтобы те понимали, как озаглавить сайт в поисковой выдаче и какое краткое описание ему дать. Чем информативнее и привлекательнее meta‑title и meta‑description, тем привлекательнее сайт для пользователя в поисковой выдаче. Это повышает количество кликов на него и, соответственно, органический трафик на сайте — одна из главных задач SEO. Пример — на скриншотах ниже.

Оглавление

Способ 1: Уникализировать title и description (капитан-очевидность)

Способ 2: 301 редирект (если есть неактуальные страницы)

Способ 3: Директива clean-param в robots.txt (только для поисковых роботов Яндекса)

Способ 4: Закрыть страницу от индексирования мета-тегом robots (не действует, если директива запрещена в robots.txt)

Способ 5: Добавить мета-тег canonical (для поисковых роботов он носит рекомендательный характер)

Уникализировать title и description

Самое первое, что приходит на ум, когда вебмастер жалуется на большое количество одинаковых мета-заголовков и метаописаний страниц, — уникализировать их. Это прекрасная мысль, однако что делать, когда таких страниц не 5 или 10 штук, а 5 или 10 миллионов?

Основная хитрость заключается в том, что необязательно редактировать все мета-теги title и description вручную. Как правило, на любой веб-странице есть та или иная ключевая уникальная информация (а иначе какой смысл в веб-странице?), которую можно «подтащить» в meta-title и meta-description. Например, у каждой статьи есть заголовок и краткое описание (они идеально подходят для использования в meta-title и meta-description, если, конечно, на вашем сайте статьи имеют различные названия и различны по содержанию). У каждого товара есть своё уникальное название и описание и так далее. Достаточно лишь настроить «подтягивание» этих полей информации в соотвествующие мета-теги. Кстати, если описание статьи содержит >250 символов, то нет ничего страшного подтягивать текст до последней точки, которая укладывается в заданный лимит. Как правило, первые 200 — 250 символов содержат достаточно ключевой информации и ключевых слов.

А можно пример «на пальцах»?↓

Конечно!

Допустим, у вас интернет-магазин «КупиВсё» по продаже бытовой техники. Сейчас на странице каждого товара метаназвание и мета-описание просто дублируются с главной страницы, то есть:

meta-title as is: Купить товары в «КупиВсё» — крупном интернет-магазине по продаже бытовой техники.

meta-description as is: В крупном интернет-магазине «КупиВсё» есть много разной бытовой техники! Чайники, утюги, мультиварки и другая бытовая техника — купить онлайн.

То есть на странице чайника «Суперчайник ХХХ» сейчас такие же описанные выше тайтл и дескрипшн, как и на главной странице интернет-магазина. А теперь на странице каждого товара добавим в эти мета-теги название товара и получим:

meta-title to be: Купить Суперчайник ХХХ в «КупиВсё» — крупном интернет-магазине по продаже бытовой техники.

meta-description to be: В крупном интернет-магазине «КупиВсё» есть Суперчайник ХХХ и много разной бытовой техники! Чайники, утюги, мультиварки и другая бытовая техника — купить онлайн.

Бинго! Настроив автоматическое заполнение title и description таким образом на всех карточках товаров, вы избавитесь от очень большого количества дублей. Разве что не стоит забывать, что в великом и могучем русском языке есть много склонений и спряжений, поэтому, учитывая несклоняемость и неспрягаемость подтягиваемого текста, нужно грамотно построить под него шаблон мета-заголовка и мета-описания.

301 редирект

Если у вас есть страницы, которые по каким-то причинам более не являются актуальными (например, вы сделали новый дизайн какой-то части сайта и получилось, что на двух разных урлах лежат страницы с идентичным контентом, но разным оформлением и вёрсткой), то с них можно настроить 301-ый редирект на актуальные страницы. Подробнее о том, какие виды редиректов бывают, для чего они нужны и как их настроить можно прочитать в этой статье или в этой. Если кратко, то 301-ый редирект — это принудительная переадресация с одного урла на другой, которая помогает скрыть от индексирования ненужные урлы.

На примере чайников для чайников↓

Рассмотрим всё тот же интернет магазин «КупиВсё» и карточку чайника «Суперчайник ХХХ». Допустим, вы решили сделать редизайн карточки товара, то есть у вас есть две страницы на разных урлах с одинаковым контентом (и, соответственно, с одинаковыми мета-тегами). И таких товаров у вас миллион, то есть миллион дублей. Настроив 301-ый редирект с урла, ведущего на старую карточку, на урл, ведущий на новую, вы закроете от индексации все страницы старых карточек.

Директива clean-param в robots.txt

Если по той или иной причине у вас при переходе на ту или иную страницу есть GET-параметры (например, вы трекаете поисковую систему, с которой был совершён переход, или иные параметры), то необходимо закрыть их от индексации, чтобы поисковые роботы не считали эти страницы за разные. Для этого в файл robots.txt (подробнее о нем можно прочитать здесь) необходимо добавить директиву clean-param (подробнее о ней здесь) и внести в неё соотвествующие параметры.

Важно отметить, что эту директиву «выполняют» только роботы Яндекса, тогда как роботы Гугла — нет.

Снова к чайникам↓

Допустим, у вас по дефолту карточка чайника «Суперчайник ХХХ» лежит по следующему урлу: www.kupivse.ru/bitovayatehnika/chayniki/123123. Однако вам важно трекать, из какой поисковой системы к вам переходят на эту карточку, для чего вы добавляете UTM-метку.

Итого при переходе из Гугла урл выглядит как

www.kupivse.ru/bitovaya-tehnika/chayniki/123123?utm_source=google а из Яндекса

www.kupivse.ru/bitovaya-tehnika/chayniki/123123?utm_source=yandexДля избегания дублирования в данном случае необходимо в файл robots.txt добавить строчку

Clean-param: utm_source Бинго! Вы побороли дублирование, вызванное get-параметрами (только для роботов Яндекса).

Закрыть страницу от индексирования мета-тегом robots

Чтобы скрыть от индексирования страницы, можно добавить следующий мета-тег в заголовок Header:

<meta name="robots" content="noindex, nofollow">Важно учесть, что если страница запрещена в файле robots.txt, то директива метатега или заголовка не действует

Без чайников, но подробнее об этом мета-теге↓

Добавить мета-тег canonical

К практически всем описанным выше способам не помешает добавить лаконичный атрибут rel="canonical". Он носит рекомендательный характер и помогает поисковым роботам понять, какую страницу считать за каноническую и, следовательно, снижает число дублей.

Без чайников, но подробнее об этом мета-теге↓

Комментарии (4)

sasmoney

17.11.2023 16:05Просто генерировать несколько случайных слов в начало и конец title и description если это возможно, и перестанет жаловаться

И canonical не влияет на это, жаловаться всеравно будет если найден клона

Balerka92

Закрывать страницу от роботов не имеет смысла, они все равно проиндексируют и ещё будут жаловаться, что "Страница проиндексирована, не смотря на запрет"

setishin Автор

Хорошо, как считаешь, что тогда имеет смысл сделать?

Balerka92

Если страница является копией другой, то rel canonical. Если немного отличается, например: пагинация - номер страницы добавлять и в тайтл и в дескрипшн.