Любое решение мы в Lamoda Tech подтверждаем мнением пользователей. Но прежде чем фича или продукт отправятся в A/B-тест, они проходят долгий путь. Все начинается с выяснения желаний, проблем и привычек юзеров, и без общения с клиентами здесь не обойтись.

Я руковожу командой исследований в Lamoda Tech, и мы постоянно проводим интервью с людьми. Такие задачи требуют глубокой эмпатии к людям, понимания их психологии и мотивации. Поэтому мне было любопытно, получится ли встроить в нашу работу AI, не потеряв ее ценность и смысл: например, подключить ChatGPT на этапе анализа интервью и синтеза результатов.

Скажу сразу — далеко не все получилось с первого раза. Но в итоге эксперимента я собрал сценарий исследования и обработал 24 интервью по фреймворку Jobs to be Done, сэкономив целых 6 дней работы.

В общем, я дерзнул и вот что понял.

Дисклеймер

В этой статье не будет четкой инструкции, как сделать идеальное исследование силами ChatGPT4. Вряд ли такая инструкция вообще возможна. Я расскажу про свой опыт — местами удачный, местами не очень. Покажу, где ошибался и какие выводы сделал.

Напомню очевидное: GPT не заменяет исследователя, это лишь инструмент. Если вы плохо разбираетесь в методологии исследований, то использовать его нужно еще осторожнее и постоянно проверять. Хотя бот сокращает время работы, он не сводит ее к нулю: справиться с задачами средней и высокой сложности без помощи человека AI пока не может.

В чем поможет ChatGPT4

В моих планах было исследовать категорию «Красота» на Lamoda. Это косметика, товары для здоровья и ухода за телом. Раньше мы не уделяли этому разделу особого внимания и почти ничего не знали про поведение людей при покупке. Чтобы составить стратегию развития «Красоты», было важно исследовать пользовательский опыт.

Мы хотели провести глубинные интервью и выяснить, как люди выбирают и покупают парфюмерию, декоративную и уходовую косметику. Задачи были следующими:

Понять, какие сложности есть у пользователей в каталоге, поиске и на карточке товара.

Изучить опыт покупок.

Определить, как пользователи принимают решение перейти на карточку товара в категории «Красота».

Определить, какую информацию пользователи хотели бы видеть на карточке товара.

Сформулировать «работы» по фреймворку Jobs to be done, которые помогут лучше понять аудиторию продукта (подробнее о фреймворке можно прочитать в статье Tilda Education).

Подключать ChatGPT4 я планировал на трех этапах: составлении портрета респондентов, подготовке сценария интервью и анализе его результатов. И на первом же шаге понял важный момент: даже если ты знаешь все принципы промпт-инжиниринга, этого недостаточно для решения задачи.

С ChatGPT нужно общаться, чтобы получить результат

Перед началом исследования мне нужно было выбрать респондентов для интервью. Решить, сколько человек приглашать, сколько из них должны быть клиентами Lamoda, на какие категории и по каким признакам разбивать людей и так далее.

Критерии для выбора я доверил ChatGPT. Первый промпт составил по всем канонам промпт-инжиниринга:

Задал роль, чтобы бот действовал в рамках определенной области знаний — исследований.

Добавил контекст: сказал, что он проводит исследование по такой-то теме, прояснил цели бизнеса и цель исследования.

Сформулировал задачу, используя глагол действия (действуй, определи, проанализируй). И четко формулировал конечную цель.

Показал пример. Так бот лучше понимает, чего от него ждут.

Объяснил формат ответа: как должен выглядеть результат. Если формат не указать, бот скопирует формат из примера.

Я сделал все по рекомендациям. Но ChatGPT ответил очень поверхностно, а потом и вовсе отказался работать, так как информации было слишком много.

После нескольких неудачных попыток я изменил подход. Решил действовать поэтапно и не закидывать все в одно сообщение:

Сократил количество контекста. Вначале загрузил только исследовательские вопросы и попросил их запомнить.

Затем загрузил и попросил запомнить оставшуюся информацию по задаче.

После этого попросил сформулировать требования к респондентам.

В этот раз ChatGPT ответил. Но ответ был неполным: например, он не указал точное количество человек для интервью, не назвал магазины, которыми они должны пользоваться.

Я не сдавался и пытался вместе с ботом докопаться до истины, задавая уточняющие вопросы.

В итоге получил вполне приемлемый список критериев. И сделал первые важные выводы о работе GPT:

-

Не жди, что с первого же запроса получишь правильный ответ. С ботом нужно вести разговор, чтобы добиться результата. Совсем как с человеком:

задавать уточняющие вопросы,

спрашивать мнение,

сомневаться в ответах.

Если материалов много, знакомь ChatGPT с ними поэтапно.

Если результат не устраивает, задавай уточняющие вопросы и делись с ботом своими сомнениями.

Проверяй работу — или пусть это делает сам ChatGPT

Работу важно проверять. Поэтому следующей задачей для ChatGPT стала проверка качества критериев.

Я попросил бот запомнить получившийся список. А после загрузил критерии, которые использовали мои коллеги из команды Custom Research для количественного исследования по этой же теме. Попросил сравнить две выборки и сказать, какая из них лучше.

Выборку моих коллег он оценил более высоко — на 5, а свою на четверку. Я попросил объяснить, почему так. Бот подробно рассказал, в чем плюсы выборки от коллег и в чем недостатки его собственной работы.

Тогда я попросил его доработать выборку. И он это сделал: конечно, без странностей не обошлось, и мы с ними немного поспорили. Но когда я обсудил результат с продактом, коллегами из коммерции и команды Custom Research, у них не было вопросов: все было отлично.

В результате я понял несколько вещей:

-

Обязательно проси ChatGPT оценить свою работу. Есть несколько вариантов, как это сделать. Я использовал такие:

находил более качественный пример и просил сравнить два результата;

давал ему роль преподавателя или эксперта в нужной теме и просил поставить оценку работе.

Если бот ставит невысокую оценку, проси исправить работу и сделать ее лучше. Он хорошо с этим справляется.

Действуй поэтапно

У меня были на руках проверенные критерии для выбора респондентов. Дальше нужно было составить сценарий исследования — документ, в котором собраны гипотезы, цели и задачи исследования и исследовательские вопросы от бизнеса. На их основе мы составляем вопросы, которые будем задавать респондентам на интервью.

Я загрузил в бота все материалы: тему исследования, вопросы, гипотезы, выборку. Попросил написать сценарий исследования. Но результат был очень плох: ChatGPT предложил поверхностные вопросы, которые совсем не копали вглубь.

Кажется, я опять перегрузил бот контекстом. Поэтому пошел поэтапно:

«Запомни, что у нас есть респонденты с определенными критериями». Добавил их в разговор.

«У нас есть список исследовательских вопросов. Я пронумеровал их, загрузил, и теперь мы пойдем с тобой шаг за шагом по списку. Какие вопросы ты задашь пользователю для того, чтобы проверить первый исследовательский вопрос?»

Проходя по каждому вопросу отдельно, ChatGPT выдал неплохой результат. Я просил его больше углубиться в тему, и результат стал еще лучше.

То же самое я проделал с гипотезами: загружал их по одной штуке и спрашивал, как он будет проверять каждую.

После я попросил объединить все в один ответ: вопросы по гипотезам и вопросы по исследовательским вопросам. Он меня не понял и создал кашу-малашу. Пришлось опять идти поэтапно: загружать в него сценарий, просить запомнить его как «сценарий 1». Затем загружать «сценарий 2» и просить их объединить.

Бот справился с задачей с небольшими помарками: несколько вопросов потерял, несколько — дублировал. Я попросил исправиться. Теперь у меня на руках был хороший сценарий — и понимание еще нескольких особенностей работы с ChatGPT:

В случаях, где контекста слишком много, лучше действовать поэтапно.

Отдавай в ChatGPT максимум задач. Даже объединение результатов в один ответ — это то, с чем бот может справиться, если правильно сформулировать задачу и проверить результат.

Переводи с языка GPT на человеческий

По готовому сценарию мы с коллегами провели 24 интервью. А после автоматически расшифровали аудиозаписи с помощью сервиса Riverside.

Время на редактуру я не тратил. Просто загрузил одну из расшифровок в ChatGPT и спросил про пару моментов, которые неявно упоминаются в тексте. Бот отвечал адекватно: он хорошо понимал и интерпретировал расшифровку.

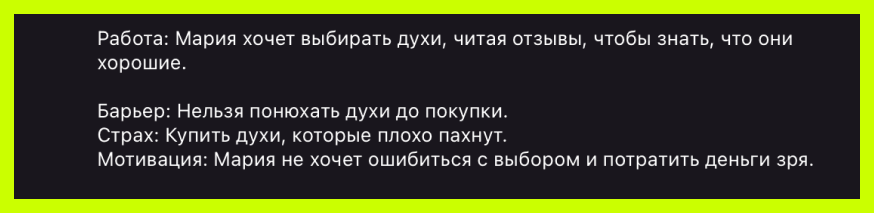

Следующая задача — обработать интервью по методологии Jobs to Be Done: найти, какие задачи и потребности есть у респондентов в связи с товарами из раздела «Красота». В этой методологии они называются «работами», и для выполнения этих работ пользователи могут «нанять» наш продукт. Выглядит каждая «работа» примерно так:

Шаблон: Как [тип пользователя], я хочу [действие], чтобы [результат].

Пример: Как водитель, я хочу пользоваться надежным GPS-навигатором, чтобы не заблудиться в незнакомом городе.

Я показал боту статью о методологии JTBD, задал роль исследователя и попросил вычленить из интервью работы, которые он там найдет.

Бот нашел 7 или 8 неплохих работ. Но когда я на радостях пошел хвастаться коллегам, сразу столкнулся с проблемой: GPT пишет нечеловеческим языком. Работы по сути своей были правильные, но сформулированы на языке GPT.

Я очень люблю книгу «Вы, должно быть, шутите, мистер Фейнман». Фейнман — физик, лауреат Нобелевской премии. Он утверждал, что если вы можете объяснить что-то пятилетнему ребенку, значит, вы в этом разбираетесь.

Я вернулся к ChatGPT и сказал: «Представь, что ты разговариваешь с пятилетним ребенком. И тебе нужно для него переформулировать эти работы».

Вероятно, я изначально выбрал неудачные описание фреймворка и примеры работ. Начал искать другой пример, но потом подумал: а зачем мне что-то искать, если я могу спросить у самого бота?

В новой ветке я написал: «Что ты знаешь про фреймворк JTBD?» Бот рассказал всю теорию: что есть эмоциональные работы, есть функциональные, есть социальные и так далее. Функциональных и эмоциональных мне было достаточно, и я попросил его привести примеры. Его формулировки мне понравились.

Снова загрузил текст интервью, напомнил, кто мы и что делаем. Привел пример, который он сам сформулировал, и попросил вычленить в расшифровке работы. И в этот раз он справился намного лучше!

Теперь нужно было все проверить. Я дал ему роль преподавателя в вузе, попросил оценить каждую работу и объяснить, почему он поставил такую оценку. А также написать, как ее улучшить.

После я еще раз загрузил список работ и рекомендации по улучшению — и попросил исправить. И он все сделал! Транскрипт первого интервью был полностью обработан.

Дальше я просто создавал новый чат, загружал транскрипт следующего респондента и повторял все этапы: сформулировать работу, потом определить барьер для совершения этой работы, потом определить мотивацию для этой работы, опционально добавить цитату.

Какие выводы я сделал:

С GPT работает эффект стажера: он очень хочет ответить и не разочаровать тебя. Поэтому когда он не может найти нужную информацию, он начинает ее придумывать. Действовать здесь тоже нужно как со стажером: не ругать за ошибки, а уточнять, почему он выбрал такой ответ. Он проверяет себя и признает, что был неправ.

Устанавливай свои правила в процессе общения. Когда ChatGPT выдумывал ответы, я обращал его внимание на это. Например, просил в следующий раз, когда он не найдет информацию, отвечать честно, что информации нет. Это работает.

Следи за тем, чтобы ответы GPT были понятны не только тебе. Показывай результаты коллегам или просто другим людям, чтобы это проверить. Если результат непонятен, возможно, проблема не только в формулировке: также влияет неудачная постановка задачи, неудачный пример или шаблон работы.

Результат

Финальный список состоял из 65 функциональных и 50 эмоциональных работ, многие из которых были близки по смыслу. С моей помощью бот объединил их в 4 функциональные и 4 эмоциональные работы.

По тому же принципу я проанализировал расшифровки интервью, чтобы найти ответы на исследовательские вопросы и подтвердить или опровергнуть гипотезы о продукте. Результаты добавил в свой отчет и представил его команде.

Какие выводы я сделал?

Хочу интегрировать ChatGPT4 в исследования как рутину. Бот может стать полноценным инструментом анализа глубинных интервью. На момент исследования (октябрь 2023 года) еще не было возможности использовать ChatGPT4 в UX-исследованиях, но с тех пор технология сделала несколько шагов вперед, и я хочу попробовать и этот вариант.

Правильные отношения с ChatGPT4 — не ждать сразу готового результата, а настраиваться на диалог. Поиск решения строится как беседа: «А что если делать вот так?», «А если мы вот это попробуем?», «Как ты думаешь, ты прав или нет?». В ходе такого разговора GPT приходит к хорошим результатам.

ChatGPT повышает твою ценность на рынке, потому что ты становишься более эффективным специалистом. Сроки работы над исследованием с ботом у меня сильно сократились. Анализ шел 1,5 дня вместо обычных 6-7. Написание дизайн-сценария заняло около 2-3 часов, хотя обычно я трачу целый день. У меня как будто появился личный, очень талантливый и смышленый помощник. Сейчас я не ограничиваюсь ChatGPT, использую Сlaude AI и Gemini (работаю с ними в Poe.com).

Интересно экспериментировать и решать задачи по-разному. Например, пробовать задавать разные роли для бота. Я просил его действовать в роли ведущего исследователя из компании Usability Lab, в роли Дона Нормана — человека, который популяризовал термин User Experience. С Доном Норманом, кстати, получилось очень плохо. Возможно, на английском сработало бы лучше.

ChatGPT действительно очень хочет тебе помочь. Это подкупает и усыпляет бдительность. Помните эффект IKEA? Когда делаешь что-то своими руками, то намного трепетнее к этому относишься. Я попал в эту ловушку: восхищался способностями GPT и не подвергал результат серьезному критическому анализу. Важно проверять работу и обязательно показывать результаты кому-нибудь еще.