1. Artificial Narrow Intelligence (ANI) — это ИИ, созданный для одной конкретной задачи (например, победить чемпиона мира по шахматам)

2. Artificial General Intelligence (AGI) — это ИИ, способный выполнять множество задач (сопоставимо с возможностями человека)

3. Artificial Superintelligence (ASI) — это ИИ, способный выполнять множество задач на высочайшем уровне (превосходя возможности человека)

Когда мы говорим о RankBrain Google, и других алгоритмах машинного обучения, которые в настоящее время работают в Google, мы, очевидно, говорим об ANI.

Аналогично RankBrain Google, ANI — это и те самые спам-фильтры в нашей почте, и мой любимый Google Translate и IBM’s Watson, и фича Amazon, которая рекомендует нам покупки, и беспилотные автомобили.

Внутри ANI существует масса различных подходов.Педро Домингос в своей книге Верховный алгоритм разделил всех ученых, занятых проблемой совершенствования ИИ, на несколько групп:

- символисты (Symbolists)

- коммуникаторы (Connectionists)

- эволюционеры (Evolutionaries)

- баэзианцы (Bayesians)

- анализаторы (Analogizers)

RankBrain сделан в лагере коммуникаторов. Они считают, что все наше знание закодировано в связях нейронов нашего мозга.

Особая стратегия RankBrain заключается в том, что специалисты называют методом обратного распространения ошибки, а после ребрендинга стали называть «глубинное обучение”

Коммуникаторы утверждают, эта стратегия способна научиться всему из необработанных данных, и, в конечном счете, автоматизировать поиск новых знаний. Google, по-видимому, считает также: еше 26 января 2014 года, компания Google объявила о приобретении DeepMind Technologies, которая была, по сути, построена на методе обратного распространения ошибки.

Резюмируя можем сказать, что RankBrain — это искусственный интеллект, созданный для узкой задачи на базе технологии “глубинного обучения”. Разобравшись с этим, давайте разберемся насколько далеко они зашли и, что более важно, как это изменит бизнес SEO?

Экспотенциальный рост технологий (и ИИ)

Мы склонны недооценивать будущее — все потому, что в своих оценках мы полаемся на прошлый исторический опыт. Тем не менее, реальность такова, что прогресс ускоряется со временем. Рэй Курцвейл называет это Законом более быстрой отдачи. Научное обоснование его теории состоит в том, что более развитые общества имеют возможность прогрессировать более быстрыми темпами, чем менее развитые — потому что они более продвинутые. Конечно, те же выводы можно применить к области искусственного интеллекта.

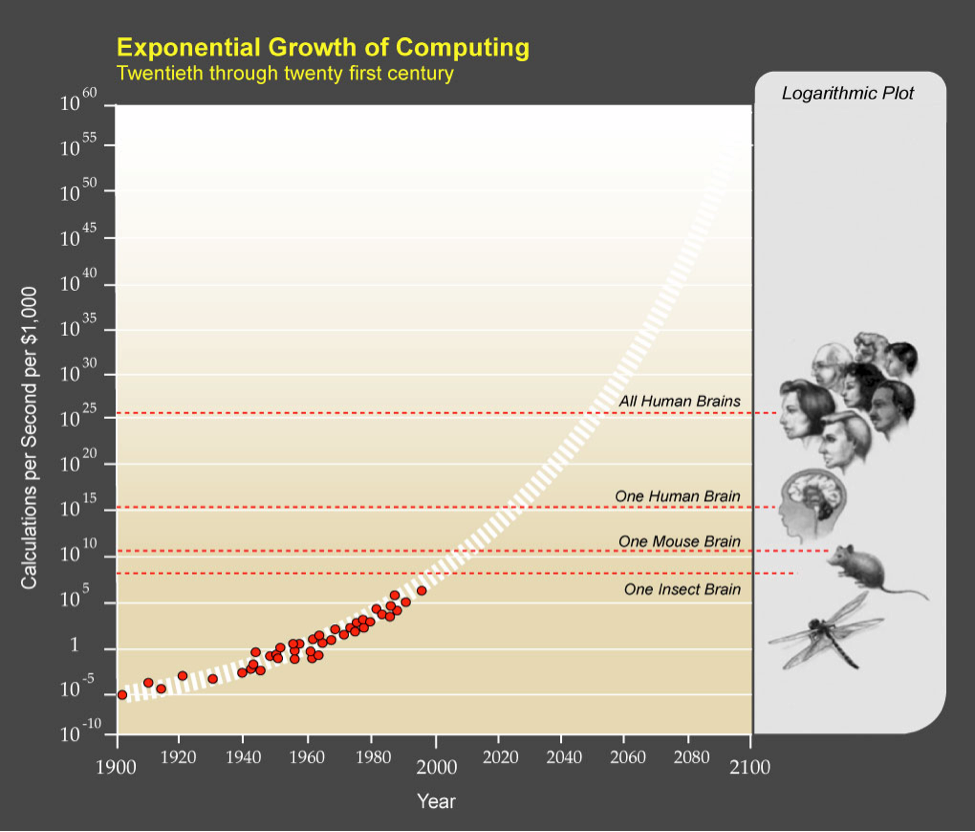

Вот визуализация Закона более быстрой отдачи:

Как можно заметить, да и интуитивно почувствовать, усовершенствование методов глубинной обработки и компьютеров следует из Закона более быстрой отдачи. Вот еще одно шокирующее откровение: в какой-то момент, мощность процессора превзойдет, не только одного человека, но и всех людей вместе взятых.

На самом деле, теперь кажется, что мы сможем создать многозадачный искусственный интеллект (AGI) к 2025. Технологии явно растут быстрыми темпами, и, по многим свидетельствам, большинство из нас будут застигнуты врасплох.

Рост суперинтеллекта

Как я уже объяснял выше, RankBrain — лишь одна из форм ANI, что означает, что он может выполнять лучше чем человек задачи в одной конкретной области, а значит это относительно слабая форма искусственного интеллекта.

Но вскоре мы можем быть ошеломлены тем, насколько быстро этот „слабый” искусственный интеллект может легко превратиться в нечто, с чем мы не имеем ни малейшего представления, как иметь дело.

Здесь вы можете ясно видеть, что RankBrain Google, будучи супер умным в одной конкретной задаче, по-прежнему в общем контексте вещей, довольно слаб в общем смысле интеллекта.

Но что происходит, когда мы применяем тот же Закон более быстрой отдачи к области искусственного интеллекта? Вот выводы такого мысленного эксперимента Тима Урбана:

“… Так, наблюдая развитие ИИ, мы вскоре увидим, как просто ему стать умнее животного. Затем, когда он достигнет минимального уровня человеческого интеллекта — скажем так 'деревенского дурачка’ — мы будем восклицать: „О, ничего себе, это какой глупенький. Миленько”. Только вот не так уж велик диапазон недостающего интеллекта между дурачком и Эйнштейном — так что очень скоро после “дурачка” мы услышим о создании AGI, который еще умнее Эйнштейна “.

SEO изменился навсегда

До того как начать заниматься предсказаниями давайте посмотрим как уже изменился рынок SEO. В этом мне помог мой друг, выпускник Университета Карнеги-Меллон (США) Scott Stouffer — технический директор и сооснователь Market Brew, занимающийся поисковыми моделями для SEO команды Fortune 500. Вот некоторые из его советов для SEO индустрии, в контексте акцента компании Google на искусственном интеллекте.

Сегодняшний регрессионный анализ имеет серьезные недостатки

Внутри Google, существует целый ряд алгоритмов. Работа RankBrain состоит в том, чтобы решать, какой комплекс этих алгоритмов лучше всего применять к каждому типу результатов поиска. Например, в некоторых результатах поиска, RankBrain может решить, что наиболее важным является META Title. Но в другом результате поиска, этот же сигнал может иметь ужасную корреляцию с хорошей поисковой выдачей.

Отсюда становится очевидным, что больше не имеет смысла делать делать регрессионный анализ сайта, не имея контекст результата поиска.

По этим причинам, сегодня регрессионный анализ должен быть сделан для каждого конкретного результата поиска. При этом алгоритмические сдвиги Google могут быть измерены. Во-первых, вы можете зафиксировать текущую ситуацию, а также каждую калибровку по ключевым словам. Затем повторно калибровать каждый раз после обнаружения сдвига в рейтинге, выявить дельту между двумя параметрами. Используя этот подход, вы можете обнаружить, какой конкретный алгоритм приоритезирует RankBrain для каждого отдельно взятого контекста, повышая или понижая его значение в каждой выдаче поисковых результатов. Понимая это, мы можем сосредоточиться на улучшении этих конкретных частях SEO для сайтов для этих уникальных результатов поиска.

Четко фокусируйтесь на своей нише, чтобы избежать неправильной классификации

Кроме этого Google понял, что они могли бы научить RankBrain отличать “хорошие” и “плохие” сайты. Подобно тому, как он определяет веса существующих поисковых алгоритмов по-разному для каждого результата поиска, они также поняли, что в каждой такой вертикали разные примеры „хороших“ и „плохих“ сайтов. Это, несомненно, потому что разные вертикали имеют разные CRM, различные шаблоны и различные структуры данных в целом. Оценка сайтов проходит путем их сравнения с лучшими и худшими сайтами. Простой пример: если вы работаете в здравоохранении и ваш сайт похож на авторитетный WebMD.com — то вы будете признаны “хорошим” сайтом, если он заметит у вас что-то общее с сайтами-спамерами — вы получите клеймо “плохой”.

Теперь подумайте, каковы ваши шансы на успех, если вашей задачей будет объяснить RankBrain что сайт, который, например, посвящен многим различным отраслям промышленности одновременно — “хороший”?

Так что же происходит с сайтами, которые имеют много различных категорий? Хорошим примером этих типов сайтов являются сайты How-To. В этих случаях, алгоритм ломается. И что же делает Google? Ответ: Выбирает случайным образом одну или другую категорию из всех представленных для ранжирования. Для хорошо известных сайтов, как Wikipedia, Google делает исключения, чтобы гарантировать, что новый алгоритм не уничтожил существующий опыт поиска (но это только для тех, кто “слишком велик, чтобы рухнуть»).

Но что будет происходить для менее известных сайтов? Кто знает? По-видимому, алгоритм имеет автоматизированный способ классификации каждого сайта, прежде чем пытаться сравнить его с другими сайтами в той же категории.

Вывод простой: для сайтов типа How-To имеет смысл завести отдельные домены, для каждого направления и это поможет ему улучшить свои позиции в каждой категории из этой отрасли. Фокусируйтесь на одной нише.

Обратные ссылки (backlinks) дурно попахивают

Давайте посмотрим, как новый алгоритм влияет на обратные ссылки. Сейчас больше чем когда бы то ни было важно заниматься перелинковкой. Это объясняется тем, что RankBrain для определения результата в выдаче будет сравнивать обратные ссылки вашего сайта с обратными ссылками “хороших” и “плохих” сайтов — то есть это один из параметров сравнения наравне со структурой и пр. Перелинковка с дружественными, но нерелевантными ресурсами грозит вам той же проблемой, что и излишнее количество категорий на сайте — случайным выбором алгоритма ранжирования, сравнивания с сайтами чужих категорий.

Будущее SEO и ИИ

Никто не знает точно как будет совершенствоваться ИИ и куда это нас приведет, но кое-что все же можно утверждать наверняка уже сегодня:

- Конкурентную среду каждого ключевого слова необходимо изучать по-отдельности;

- Большинство сайтов нужно будет сделать нишевыми, чтобы избежать неправильной классификации;

- Каждый сайт должен имитировать структуру и содержание лидеров поисковой выдачи в этой нише.

С одной стороны, методика глубинного обучения упростила работу оптимизаторов. Теперь, зная, что есть RankBrain и подобные технологии, работающие практически на одном уровне с человеком, ясно одно: лазеек больше нет.

С другой стороны, все немного сложнее. Поле SEO будет продолжит становиться исключительно техническим. Аналитика и большие данные на повестке дня, и любым SEO-специалистам, которые не знакомы с этим, придется наверстывать. Зато, те из вас, у кого есть эти навыки могут рассчитывать на большие зарплаты.

Комментарии (9)

pda0

05.06.2016 23:17+1Взяли старую шапку статьи про страхи перед ИИ (которая вроде даже на хабре была) и приклеили абзацы про страхи SEO'шников. В реальности вместо экспоненты, увы, похоже мы идём к вершине S-образной кривой. Если петафлопс получился сам собой, то экзафлопс уже вымучивают, да ещё рассчитывая уложиться по энергии. («В Японии институт RIKEN (Advanced Institute for Computational Science) планировал создание эксафлопсной системы в 2020 с энергопотреблением не выше 30 МВт.»)

gene4000

06.06.2016 09:58+1Сложно что-то сказать о только появившихся технологиях. Но тенденция последних пяти-семи лет: все улучшения алгоритмов приводят к ухудшению результатов. Стало проще найти фотографию, но это из-за распространения фототехники. Поиск какого-то нужного текста стал очень сложным. Есть подозрение, что алгоритмы улучшуют для продажи рекламы, а не качественного поиска.

armancho7777777

06.06.2016 11:25+1Тоже мысль посетила про:

>>> алгоритмы улучшуют для продажи рекламы

Shamov

06.06.2016 12:19Только подозрение? С чего бы вдруг поисковому гиганту заниматься улучшением качества поиска, если деньги он получает не за поиск, а за рекламу?

VioletGiraffe

06.06.2016 13:20+1C того, что если пользователи у него не находят то, что ищут, то они будут пользоваться другими поисковиками.

Shamov

06.06.2016 13:34Не будут. В наши дни поисковик — это точка входа в интернет. Если что-то не нашлось в поисковике, то считается, что этого нет в интернете.

gene4000

06.06.2016 17:11+1Правильно написал VioletGiraffe. Нельзя полностью убить главный сервис. Сейчас многие уже не ищут в гугле (я про это первый раз услышал лет десять назад). Пользуются основными тремя-четырьмя сайтами, и ничего им больше не нужно. При ухудшении поиска тенденция может заметно ускорится. Тем более, что периодически выходят статьи на тему манипуляции общественным мнение с помощью изменения выдачи. Достаточно небольшого слуха, что гугл это делает, и последствия могут оказаться очень серьезными.

Shamov

06.06.2016 17:31Уже были не то что небольшие слухи, а громкие скандалы на ту тему, что гугл точно это делает. И ничего. Через неделю все всё забыли. Как будто и не было ничего. У современных пользователей память как у куриц. Новая информация поступает к ним с такой скоростью, что старая вытесняется очень быстро, если она напрямую их не касается.

exelens

не CRM а CMS

В целом же на мой взгляд статья очень даже годная. Хотя про то, что анализировать выдачу по каждому основному ключу нужно отдельно =) это понятно уже давным давно.