В процессе подготовки задачи для вступительного испытания на летнюю школу GoTo, мы обнаружили, что на русском языке практически отсутствует качественное описание основных метрик ранжирования (задача касалась частного случая задачи ранжирования — построения рекомендательного алгоритма). Мы в E-Contenta активно используем различные метрики ранжирования, поэтому решили исправить это недоразуменее, написав эту статью.

Задача ранжирования сейчас возникает повсюду: сортировка веб-страниц согласно заданному поисковому запросу, персонализация новостной ленты, рекомендации видео, товаров, музыки… Одним словом, тема горячая. Есть даже специальное направление в машинном обучении, которое занимается изучением алгоритмов ранжирования способных самообучаться — обучение ранжированию (learning to rank). Чтобы выбрать из всего многообразия алгоритмов и подходов наилучший, необходимо уметь оценивать их качество количественно. О наиболее распространенных метриках качества ранжирования и пойдет речь далее.

Ранжирование — задача сортировки набора элементов из соображения их релевантности. Чаще всего релевантность понимается по отношению к некому объекту. Например, в задаче информационного поиска объект — это запрос, элементы — всевозможные документы (ссылки на них), а релевантность — соответствие документа запросу, в задаче рекомендаций же объект — это пользователь, элементы — тот или иной рекомендуемый контент (товары, видео, музыка), а релевантность — вероятность того, что пользователь воспользуется (купит/лайкнет/просмотрит) данным контентом.

Формально, рассмотрим N объектов и M элементов

и M элементов  . Реузальтат работы алгоритма ранжирования элементов

. Реузальтат работы алгоритма ранжирования элементов  для объекта

для объекта  — это отображение

— это отображение  , которое сопоставляет каждому элементу

, которое сопоставляет каждому элементу  вес

вес  , характеризующей степень релевантности элемента объекту (чем больше вес, тем релевантнее объект). При этом, набор весов

, характеризующей степень релевантности элемента объекту (чем больше вес, тем релевантнее объект). При этом, набор весов  задает перестановку

задает перестановку  на наборе элементов элементов

на наборе элементов элементов  (считаем, что множество элементов упорядоченное) исходя из их сортировки по убыванию веса

(считаем, что множество элементов упорядоченное) исходя из их сортировки по убыванию веса  .

.

Чтобы оценить качество ранжирования, необходимо иметь некоторый «эталон», с которым можно было бы сравнить результаты алгоритма. Рассмотрим — эталонную функцию релевантности, характеризующую «настоящую» релевантность элементов для данного объекта (

— эталонную функцию релевантности, характеризующую «настоящую» релевантность элементов для данного объекта ( — элемент идеально подходит,

— элемент идеально подходит,  — полностью нерелевантен), а так же соответствующую ей перестановку

— полностью нерелевантен), а так же соответствующую ей перестановку  (по убыванию

(по убыванию  ).

).

Существует два основных способа получения :

:

1. На основе исторических данных. Например, в случае рекомендаций контента, можно взять просмотры (лайки, покупки) пользователя и присвоить просмотренным весам соответствующих элементов 1 ( ), а всем остальным — 0.

), а всем остальным — 0.

2. На основе экспертной оценки. Например, в задаче поиска, для каждого запроса можно привлечь команду асессоров, которые вручную оценят релевантности документов запросу.

Стоит отметить, что когда принимает только экстремальные значения: 0 и 1, то престановку

принимает только экстремальные значения: 0 и 1, то престановку  обычно не рассматривют и учитывают лишь множество релевантных элементов, для которых

обычно не рассматривют и учитывают лишь множество релевантных элементов, для которых  .

.

Цель метрики качества ранжирования — определить, насколько полученные алгоритмом оценки релевантности и соответствующая им перестановка

и соответствующая им перестановка  соответствуют истинным значениям релевантности

соответствуют истинным значениям релевантности  . Рассмотрим основные метрики.

. Рассмотрим основные метрики.

Mean average precision at K (map@K) — одна из наиболее часто используемых метрик качества ранжирования. Чтобы разобраться в том, как она работает начнем с «основ».

Замечание: "*precision" метрики используется в бинарных задачах, где принимает только два значения: 0 и 1.

принимает только два значения: 0 и 1.

Precision at K (p@K) — точность на K элементах — базовая метрика качества ранжирования для одного объекта. Допустим, наш алгоритм ранжирования выдал оценки релевантности для каждого элемента . Отобрав среди них первые

. Отобрав среди них первые  элементов с наибольшим

элементов с наибольшим  можно посчитать долю релевантных. Именно это и делает precision at K:

можно посчитать долю релевантных. Именно это и делает precision at K:

Замечание: под понимается элемент

понимается элемент  , который в результате перестановки

, который в результате перестановки  оказался на

оказался на  -ой позиции. Так,

-ой позиции. Так,  — элемент с наибольшим

— элемент с наибольшим  ,

,  — элемент со вторым по величине

— элемент со вторым по величине  и так далее.

и так далее.

Precision at K — метрика простая для понимания и реализации, но имеет важный недостаток — она не учитывает порядок элементов в «топе». Так, если из десяти элементов мы угадали только один, то не важно на каком месте он был: на первом, или на последнем, — в любом случае . При этом очевидно, что первый вариант гораздо лучше.

. При этом очевидно, что первый вариант гораздо лучше.

Этот недостаток нивелирует метрика ранжирования average precision at K (ap@K), которая равна сумме p@k по индексам k от 1 до K только для релевантных элементов, деленому на K:

Так, если из трех элементов мы релевантным оказался только находящийся на последнем месте, то , если угадали лишь тот, что был на первом месте, то

, если угадали лишь тот, что был на первом месте, то  , а если угаданы были все, то

, а если угаданы были все, то  .

.

Теперь и map@K нам по зубами.

Mean average precision at K (map@K) — одна из наиболее часто используемых метрик качества ранжирования. В p@K и ap@K качество ранжирования оценивается для отдельно взятого объекта (пользователя, поискового запроса). На практике объектов множество: мы имеем дело с сотнями тысяч пользователей, миллионами поисковых запросов и т.д. Идея map@K заключается в том, чтобы посчитать ap@K для каждого объекта и усреднить:

Замечание: идея эта вполне логична, если предположить, что все пользователи одинаково нужны и одинаково важны. Если же это не так, то вместо простого усреднения можно использовать взвешенное, домножив ap@K каждого объекта на соответствующий его «важности» вес.

Normalized discounted cumulative gain (nDCG) — еще одна распространенная метрика качества ранжирования. Как и в случае с map@K, начнем с основ.

Вновь рассмотрим один объект и элементов с наибольшим

элементов с наибольшим  . Cumulative gain at K (CG@K) — базовая метрика ранжирования, которая использует простую идею: чем релевантные элементы в этом топе, тем лучше:

. Cumulative gain at K (CG@K) — базовая метрика ранжирования, которая использует простую идею: чем релевантные элементы в этом топе, тем лучше:

Эта метрика обладает очевидными недостатками: она не нормализована и не учитывает позицию релевантных элементов.

Заметим, что в отличии от p@K, CG@K может использоваться и в случае небинарных значений эталонной релевантности .

.

Discounted cumulative gain at K (DCG@K) — модификация cumulative gain at K, учитывающая порядок элементов в списке путем домножения релевантности элемента на вес равный обратному логарифму номера позиции:

Замечание: если принимает только значения 0 и 1, то

принимает только значения 0 и 1, то  , и формула принимает более простой вид:

, и формула принимает более простой вид:

Использование логарифма как функции дисконтирования можно объяснить следующими интуитивными соображениями: с точки зрения ранжирования позиции в начале списка отличаются гораздо сильнее, чем позиции в его конце. Так, в случае поискового движка между позициями 1 и 11 целая пропасть (лишь в нескольких случаях из ста пользователь заходит дальшей первой страницы поисковой выдачи), а между позициями 101 и 111 особой разницы нет — до них мало кто доходит. Эти субъективные соображения прекрасно выражаются с помощью логарифма:

Discounted cumulative gain решает проблему учета позиции релевантных элементов, но лишь усугубляет проблему с отсутствием нормировки: если варьируется в пределах

варьируется в пределах  , то

, то  уже принимает значения на не совсем понятно отрезке. Решить эту проблему призвана следующая метрика

уже принимает значения на не совсем понятно отрезке. Решить эту проблему призвана следующая метрика

Как можно догадаться из названия, normalized discounted cumulative gain at K (nDCG@K) — не что иное, как нормализованная версия DCG@K:

где — это максимальное (I — ideal) значение

— это максимальное (I — ideal) значение  . Так как мы договорились, что

. Так как мы договорились, что  принимает значения в

принимает значения в  , то

, то  .

.

Таким образом, наследует от

наследует от  учет позиции элементов в списке и, при этом принимает значения в диапазоне от 0 до 1.

учет позиции элементов в списке и, при этом принимает значения в диапазоне от 0 до 1.

Замечание: по аналогии с map@K можно посчитать , усредненный по всем объектам.

, усредненный по всем объектам.

Mean reciprocal rank (MRR) — еще одна часто используемая метрика качества ранжирования. Задается она следующей формулой:

где — reciproсal rank для

— reciproсal rank для  -го объекта — очень простая по своей сути величина, равная обратному ранку первого правильно угаданного элемента.

-го объекта — очень простая по своей сути величина, равная обратному ранку первого правильно угаданного элемента.

Mean reciprocal rank изменяется в диапазоне [0,1] и учитывает позицию элементов. К сожалению он делает это только для одного элемента — 1-го верно предсказанного, не обращая внимания на все последующие.

Отдельно стоит выделить метрики качества ранжирования, основанные на одном из коэффициентов ранговой корреляции. В статистике, ранговый коэффициент корреляции — это коэффициент корреляции, который учитывает не сами значения, а лишь их ранг (порядок). Рассмотрим два наиболее распространенных ранговых коэффициента корреляции: коэффициенты Спирмена и Кендэлла.

Первый из них — коэффициент корреляции Кендэлла, который основан на подсчете согласованных

(и несогласованных) пар у перестановок — пар элементов, котором перестановки присвоили одинаковый (разный) порядок:

Второй — ранговый коэффициент корреляции Спирмена — по сути является ни чем иным как корреляции Пирсона, посчитанной на значениях рангов. Есть достаточно удобная формула, выражающая его из рангов напрямую:

где — коэффициент корреляции Пирсона.

— коэффициент корреляции Пирсона.

Метрики на основе ранговой корреляции обладают уже известными нам недостатком: они не учитывают позицию элементов (еще хуже чем p@K, т.к. корреляция считается по всем элементам, а не по K элементам с наибольшим рангом). Поэтому на практике используются крайне редко.

До этого момента мы не углублялись в то, как пользователь (далее мы рассмотрим частный случай объекта — пользователь) изучает предложенные ему элементы. На самом деле, неявно нами было сделано предположение, что просмотр каждого элемента независим от просмотров других элементов — своего рода «наивность». На практике же, элементы зачастую просматриваются пользователем поочередно, и то, просмотрит ли пользователь следующий элемент, зависит от его удовлетворенности предыдущими. Рассмотрим пример: в ответ на поисковый запрос алгоритм ранжирования предложил пользователю несколько документов. Если документы на позиции 1 и 2 оказались крайне релевантны, то вероятность того, что пользователь просмотрит документ на позиции 3 мала, т.к. он будет вполне удовлетворен первыми двумя.

Подобные модели поведения пользователя, где изучение предложенных ему элементов происходит последовательно и вероятность просмотра элемента зависит от релевантности предыдущих называются каскадными.

Expected reciprocal rank (ERR) — пример метрики качества ранжирования, основанной на каскадной модели. Задается она следующей формулой:

где ранг понимается по порядку убывания . Самое интересное в этой метрике — вероятности. При их расчете используются предположения каскадной модели:

. Самое интересное в этой метрике — вероятности. При их расчете используются предположения каскадной модели:

где — вероятность того, что пользователь будет удовлетворен объектом с рангом

— вероятность того, что пользователь будет удовлетворен объектом с рангом  . Эти вероятности считаются на основе значений

. Эти вероятности считаются на основе значений  . Так как в нашем случае

. Так как в нашем случае  , то можем рассмотреть простой вариант:

, то можем рассмотреть простой вариант:

который можно прочесть, как: истинная релевантность элемента оказавшегося на позиции после сортировки по убыванию

после сортировки по убыванию  .

.

В общем же случае чаще всего используют следующую формулу:

PFound — метрика качества ранжирования, предложенная нашими соотечественниками и использующая похожую на каскадную модель:

где

В заключении приведем несколько полезных ссылок по теме:

— Статьи на википедии по: обучению ранжированию, MRR, MAP и nDCG.

— Официальный список метрик используемых на РОМИП 2010.

— Описание метрик MAP и nDCG на kaggle.com.

— Оригинальные статьи по каскадной модели, ERR и PFound.

Задача ранжирования сейчас возникает повсюду: сортировка веб-страниц согласно заданному поисковому запросу, персонализация новостной ленты, рекомендации видео, товаров, музыки… Одним словом, тема горячая. Есть даже специальное направление в машинном обучении, которое занимается изучением алгоритмов ранжирования способных самообучаться — обучение ранжированию (learning to rank). Чтобы выбрать из всего многообразия алгоритмов и подходов наилучший, необходимо уметь оценивать их качество количественно. О наиболее распространенных метриках качества ранжирования и пойдет речь далее.

Кратко о задаче ранжирования

Ранжирование — задача сортировки набора элементов из соображения их релевантности. Чаще всего релевантность понимается по отношению к некому объекту. Например, в задаче информационного поиска объект — это запрос, элементы — всевозможные документы (ссылки на них), а релевантность — соответствие документа запросу, в задаче рекомендаций же объект — это пользователь, элементы — тот или иной рекомендуемый контент (товары, видео, музыка), а релевантность — вероятность того, что пользователь воспользуется (купит/лайкнет/просмотрит) данным контентом.

Формально, рассмотрим N объектов

Чтобы оценить качество ранжирования, необходимо иметь некоторый «эталон», с которым можно было бы сравнить результаты алгоритма. Рассмотрим

Существует два основных способа получения

1. На основе исторических данных. Например, в случае рекомендаций контента, можно взять просмотры (лайки, покупки) пользователя и присвоить просмотренным весам соответствующих элементов 1 (

2. На основе экспертной оценки. Например, в задаче поиска, для каждого запроса можно привлечь команду асессоров, которые вручную оценят релевантности документов запросу.

Стоит отметить, что когда

Цель метрики качества ранжирования — определить, насколько полученные алгоритмом оценки релевантности

Mean average precision

Mean average precision at K (map@K) — одна из наиболее часто используемых метрик качества ранжирования. Чтобы разобраться в том, как она работает начнем с «основ».

Замечание: "*precision" метрики используется в бинарных задачах, где

Precision at K

Precision at K (p@K) — точность на K элементах — базовая метрика качества ранжирования для одного объекта. Допустим, наш алгоритм ранжирования выдал оценки релевантности для каждого элемента

Замечание: под

Average precision at K

Precision at K — метрика простая для понимания и реализации, но имеет важный недостаток — она не учитывает порядок элементов в «топе». Так, если из десяти элементов мы угадали только один, то не важно на каком месте он был: на первом, или на последнем, — в любом случае

Этот недостаток нивелирует метрика ранжирования average precision at K (ap@K), которая равна сумме p@k по индексам k от 1 до K только для релевантных элементов, деленому на K:

Так, если из трех элементов мы релевантным оказался только находящийся на последнем месте, то

Теперь и map@K нам по зубами.

Mean average precision at K

Mean average precision at K (map@K) — одна из наиболее часто используемых метрик качества ранжирования. В p@K и ap@K качество ранжирования оценивается для отдельно взятого объекта (пользователя, поискового запроса). На практике объектов множество: мы имеем дело с сотнями тысяч пользователей, миллионами поисковых запросов и т.д. Идея map@K заключается в том, чтобы посчитать ap@K для каждого объекта и усреднить:

Замечание: идея эта вполне логична, если предположить, что все пользователи одинаково нужны и одинаково важны. Если же это не так, то вместо простого усреднения можно использовать взвешенное, домножив ap@K каждого объекта на соответствующий его «важности» вес.

Normalized Discounted Cumulative Gain

Normalized discounted cumulative gain (nDCG) — еще одна распространенная метрика качества ранжирования. Как и в случае с map@K, начнем с основ.

Cumulative Gain at K

Вновь рассмотрим один объект и

Эта метрика обладает очевидными недостатками: она не нормализована и не учитывает позицию релевантных элементов.

Заметим, что в отличии от p@K, CG@K может использоваться и в случае небинарных значений эталонной релевантности

Discounted Cumulative Gain at K

Discounted cumulative gain at K (DCG@K) — модификация cumulative gain at K, учитывающая порядок элементов в списке путем домножения релевантности элемента на вес равный обратному логарифму номера позиции:

Замечание: если

Использование логарифма как функции дисконтирования можно объяснить следующими интуитивными соображениями: с точки зрения ранжирования позиции в начале списка отличаются гораздо сильнее, чем позиции в его конце. Так, в случае поискового движка между позициями 1 и 11 целая пропасть (лишь в нескольких случаях из ста пользователь заходит дальшей первой страницы поисковой выдачи), а между позициями 101 и 111 особой разницы нет — до них мало кто доходит. Эти субъективные соображения прекрасно выражаются с помощью логарифма:

Discounted cumulative gain решает проблему учета позиции релевантных элементов, но лишь усугубляет проблему с отсутствием нормировки: если

Normalized Discounted Cumulative Gain at K

Как можно догадаться из названия, normalized discounted cumulative gain at K (nDCG@K) — не что иное, как нормализованная версия DCG@K:

где

Таким образом,

Замечание: по аналогии с map@K можно посчитать

Mean reciprocal rank

Mean reciprocal rank (MRR) — еще одна часто используемая метрика качества ранжирования. Задается она следующей формулой:

где

Mean reciprocal rank изменяется в диапазоне [0,1] и учитывает позицию элементов. К сожалению он делает это только для одного элемента — 1-го верно предсказанного, не обращая внимания на все последующие.

Метрики на основе ранговой корреляции

Отдельно стоит выделить метрики качества ранжирования, основанные на одном из коэффициентов ранговой корреляции. В статистике, ранговый коэффициент корреляции — это коэффициент корреляции, который учитывает не сами значения, а лишь их ранг (порядок). Рассмотрим два наиболее распространенных ранговых коэффициента корреляции: коэффициенты Спирмена и Кендэлла.

Ранговый коэффициент корреляции Кендэлла

Первый из них — коэффициент корреляции Кендэлла, который основан на подсчете согласованных

(и несогласованных) пар у перестановок — пар элементов, котором перестановки присвоили одинаковый (разный) порядок:

Ранговый коэффициент корреляции Спирмена

Второй — ранговый коэффициент корреляции Спирмена — по сути является ни чем иным как корреляции Пирсона, посчитанной на значениях рангов. Есть достаточно удобная формула, выражающая его из рангов напрямую:

где

Метрики на основе ранговой корреляции обладают уже известными нам недостатком: они не учитывают позицию элементов (еще хуже чем p@K, т.к. корреляция считается по всем элементам, а не по K элементам с наибольшим рангом). Поэтому на практике используются крайне редко.

Метрики на основе каскадной модели поведения

До этого момента мы не углублялись в то, как пользователь (далее мы рассмотрим частный случай объекта — пользователь) изучает предложенные ему элементы. На самом деле, неявно нами было сделано предположение, что просмотр каждого элемента независим от просмотров других элементов — своего рода «наивность». На практике же, элементы зачастую просматриваются пользователем поочередно, и то, просмотрит ли пользователь следующий элемент, зависит от его удовлетворенности предыдущими. Рассмотрим пример: в ответ на поисковый запрос алгоритм ранжирования предложил пользователю несколько документов. Если документы на позиции 1 и 2 оказались крайне релевантны, то вероятность того, что пользователь просмотрит документ на позиции 3 мала, т.к. он будет вполне удовлетворен первыми двумя.

Подобные модели поведения пользователя, где изучение предложенных ему элементов происходит последовательно и вероятность просмотра элемента зависит от релевантности предыдущих называются каскадными.

Expected reciprocal rank

Expected reciprocal rank (ERR) — пример метрики качества ранжирования, основанной на каскадной модели. Задается она следующей формулой:

где ранг понимается по порядку убывания

где

который можно прочесть, как: истинная релевантность элемента оказавшегося на позиции

В общем же случае чаще всего используют следующую формулу:

PFound

PFound — метрика качества ранжирования, предложенная нашими соотечественниками и использующая похожую на каскадную модель:

где

,

, если

и 0 иначе,

— вероятность того, что пользователь прекратит просмотр по внешним причинам.

В заключении приведем несколько полезных ссылок по теме:

— Статьи на википедии по: обучению ранжированию, MRR, MAP и nDCG.

— Официальный список метрик используемых на РОМИП 2010.

— Описание метрик MAP и nDCG на kaggle.com.

— Оригинальные статьи по каскадной модели, ERR и PFound.

Написано с использованием StackEdit.

Большое спасибо пользователю SeptiM за восхитительный habratex.

Поделиться с друзьями

tumbler

А наши пользователи вводят "конкретная имевшаяся ввиду рыба", потом пролистывают выдачу, на первом месте которой эта самая "конкретная имевшаяся ввиду рыба", эдак, страницы до пятой, и смотрят один ролик. Как объяснить это поведение, кроме как эффектом от подстановки автокомплита (которую пользователь не заметил), мы не придумали.

obus

Логика есть, главное ее найти. Может дело в многозначности значений?

А так, во всех метриках в этой статье подразумевается их усреднение по пользователям, за счет чего влияние небольшого числа «нелогичных» пользователей мало заметно.

P.S. Сервис — tumblr? :)

tumbler

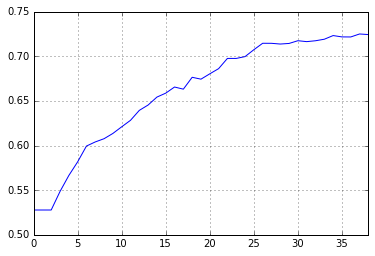

Возможно, Вы правы. Мы только начали собирать метрики с поиска, так что "усреднение" пока не работает — зато как раз этих "сумасшедших" заметили. Зато, судя по MAP20, качество выдачи тем больше, чем популярнее конкретный запрос. 10% запросов у нас в логах пришли больше чем от 20 уников, и по ним метрика максимальная, а к "уникальным" запросам качество заметно просаживается.

X — минимальное число уников, спросивших одно и то же; Y — MAP20

Отсюда встает еще один поведенческий вопрос: а не будет ли определение качества по кликам/покупкам просто следствием того, что переход с 1 на 2 страницу имеет вероятность 50%, с первой на третью — 25%, и т.д? Кстати, а это нормировать как-то можно?

PS. Нет, не tumblr.