Мир охватила новая волна безумства вокруг AI, все соц.сети заполнены огромным количеством экспериментов вокруг нового продукта - ChatGPT. В этой статье я расскажу вам о 30+ примерах использования AI-чата на базе открытого искусственного интеллекта от OpenAI. Платформа доступна на множестве языков, в том числе на русском (через встроенный переводчик), но желательно использовать ее на английском, чтобы получить более точные ответы на вопросы.

???? Скорость распространения этой технологии в мире впечатляет

Что такое ChatGPT

ChatGPT - это реализация модели языкового предсказания на основе технологии машинного обучения. Она была разработана компанией OpenAI и позволяет участникам чата получать наиболее точные ответы на их вопросы. ChatGPT использует нейронные сети для анализа текста и предоставляет наиболее вероятные ответы на основе обученных данных.

Кто создатель ChatGPT

OpenAI - это исследовательская организация, которая специализируется на искусственном интеллекте и машинном обучении. Она была основана в 2015 году группой выдающихся исследователей и разработчиков, в том числе Илоном Маском, Сэмом Альтманом и Джоном Скальза. OpenAI стремится повысить понимание искусственного интеллекта и применять его для решения сложных проблем в мире.

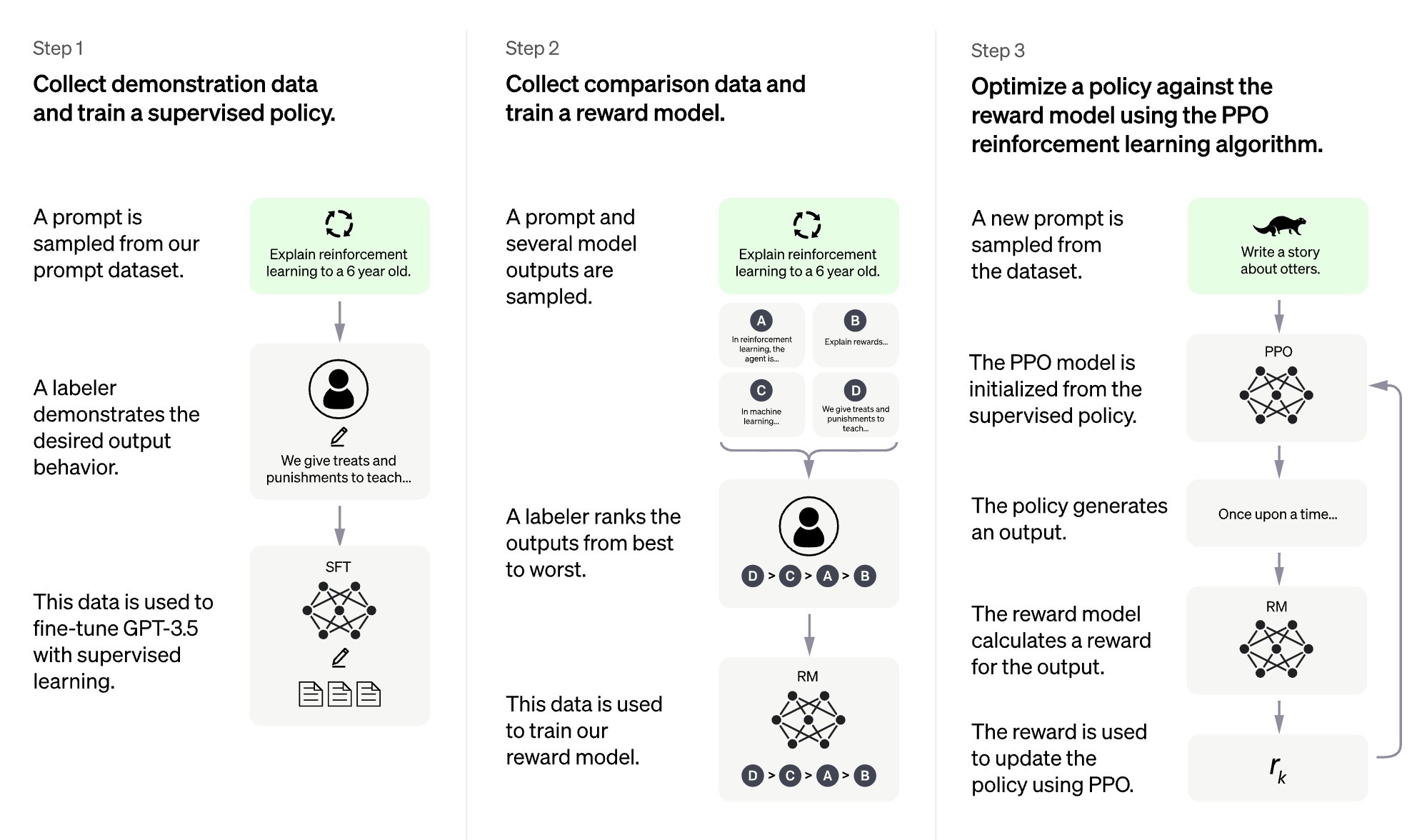

Как и на чем обучалась модель GPT-3

Generative Pre-trained Transformer 3 (GPT-3) — это модель авторегрессионного языка , которая использует глубокое обучение для создания текста, похожего на человеческий.

Архитектура представляет собой стандартную сеть-преобразователь (с несколькими настройками) с беспрецедентным размером контекста длиной 2048 токенов и 175 миллиардов параметров (требуется 800 ГБ хранилища). Метод обучения — это «генеративное предварительное обучение», что означает, что она обучена предсказывать, каким будет следующий набор данных.

Качество текста, генерируемого GPT-3, настолько высокое, что может быть трудно отличить, был ли он написан человеком или АИ. Это имеет как преимущества, так и риски о которых предупреждают разработчики.

60% взвешенного набора данных для предварительной подготовки для GPT-3 были взяты из отфильтрованной версии Common Crawl (веб архивы и поисковые запросы Google), состоящей из 410 миллиардов данных.

Другими источниками являются 19 миллиардов данных из WebText2 (данные по веб-сайтам, ссылки на которые были собраны с площадки Reddit), что составляет 22% от взвешенного общего количества, 12 миллиардов токенов из Книг v1, что составляет 8%, 55 миллиардов токенов из Книг v2, что составляет 8%, и 3 миллиардов токенов из Википедии.

GPT-3 был обучен на сотнях миллиардов слов, а также способен программировать, среди прочего, на CSS, JSX и Python.

Поскольку обучающие данные GPT-3 были всеобъемлющими, дальнейшая подготовка для отдельных языковых задач не требуется. Обучающие данные иногда содержат ненормативную лексику, а GPT-3 время от времени генерирует ненормативную лексику в результате имитации обучающих данных.

Список самых интересных экспериментов c ChatGPT

Общие Кейсы

Анализ данных и поиск ответов на любые вопросы (вместо использования Google)

Написание статей, журналистика, блоги, Instagram, Twitter

ChatGPT в образовательном процессе

Написание литературных произведений

Объяснение сложных вещей простым языком

Диалоговые сценарии, стихи и песни

Дизайн

Создание цифровых произведений искусства

Веб- и мобильный дизайн

Создание векторных изображений

Бизнес

Составление юридических документов

Написание бизнес стратегий

Написание email писем и рассылок

Формирование требований для вакансии

Создание Pitch Deck и инвестиционных презентаций

Написание проектной документации

Программирование и IT

Ответы на вопросы и документация по коду

Оптимизация кода и поиск багов

Фронтенд верстка

Программирование на различных языках

Работа с базами данных и SQL запросами

Работа с JSON данными

ASCII art

Решение математических задач

Виртуальный компьютер на базе ChatGPT, файловая система, Linux

Написание вирусов и скриптов для взлома

Разработка парсеров

Решение для Python разработчиков

Работа с LaTeX формулами

Блокчейн

Алгоритм создание seed фраз и приватных ключей

Разработка смарт контрактов (Solidity, Rust..)

-

Разработка торговых и арбитражных стратегий

Итак, поехали!

Анализ данных и поиск ответов на любые вопросы

Это самый популярный способ использование модели на сегодняшний день. ChatGPT позволяет полностью забыть про Google, когда вам нужно найти точные и подробные ответы на ваши вопросы. Так как модель изначально училась на данных из интернета, она умеет точно собирать под вас нужный контент. Единственное ограничение модели связано с попытками найти инструкции на изготовление чего-то незаконного, но это ограничение тоже можно обойти, просто правильно составив запрос.)

Написание статей, журналистика, блоги, инстаграм

ChatGPT в образовательном процессе

ChatGPT владеет практически всей информацией, которая есть в интернете, и может в простой форме объяснить что угодно, помочь ребенку разобраться в любом вопросе, решить математические задачи или написать сочинение. Также он поможет преподавателю составить грамотный учебный план.

Объяснение сложных вещей простым языком

Написание литературных произведений

Диалоговые сценарии, стихи и песни

Создание произведений искусства с помощью AI

ChatGPT прекрасно создает промпты (описания) для новых моделей AI генерации картинок из текста: Dalle-2, Midjourney, Stable Diffusion.

Веб- и мобильный дизайн

Создание векторных SVG изображений

ChatGPT пока не умеет красиво рисовать, но уже может предложить вам код для создания svg изображений.

3D дизайн

Составление юридических документов

Написание бизнес стратегий

Написание email писем и рассылок

Формирование требований для вакансии

Поиск новых идей

Создание Pitch Deck и Инвестиционных презентаций

Написание проектной документации

Ответы на вопросы и документация по коду

Оптимизация и дебаг кода

HTML верстка

Программирование на различных языках

Разработка мобильных приложений

Работа с базами данных и SQL запросами

ASCII art

Работа с JSON данными

Решение математических задач

Виртуальный компьютер на базе ChatGPT, файловая система и Linux

Подробная статья об этом эксперименте тут: https://www.engraved.blog/building-a-virtual-machine-inside/

Написание вирусов и скриптов для взлома

Разработка парсеров

Решение для Python разработчиков

Работа с LaTeX формулами

Алгоритм создание seed фраз и приватных ключей

Разработка смарт контрактов (Solidity, Rust..)

Разработка торговых и арбитражных ботов для крипты

Какие IT сервисы уже используют ChatGPT

Некоторые популярные сервисы уже начали использовать возможности GPT-3.

GPT-3, в частности модель Codex, является основой для GitHub Copilot, программного обеспечения для завершения и генерации кода, используемого в различных редакторах кода и IDE.

GPT-3 используется в некоторых продуктах Microsoft для перевода обычного языка в формальный компьютерный код.

GPT-3 использовался в CodexDB для создания кода, специфичного для запроса, для обработки SQL.

GPT-3 используется в Copy.ai, первом приложении для копирайтинга на основе ИИ для маркетологов и владельцев бизнеса.

GPT-3 используется в Jasper.ai, генераторе контента, предназначенном для помощи маркетологам и редакторам.

Скорее всего, в ближайшие полгода каждый из нас будет пользоваться IT сервисами, интегрированными с GPT-3.

Какие есть ограничения у ChatGPT

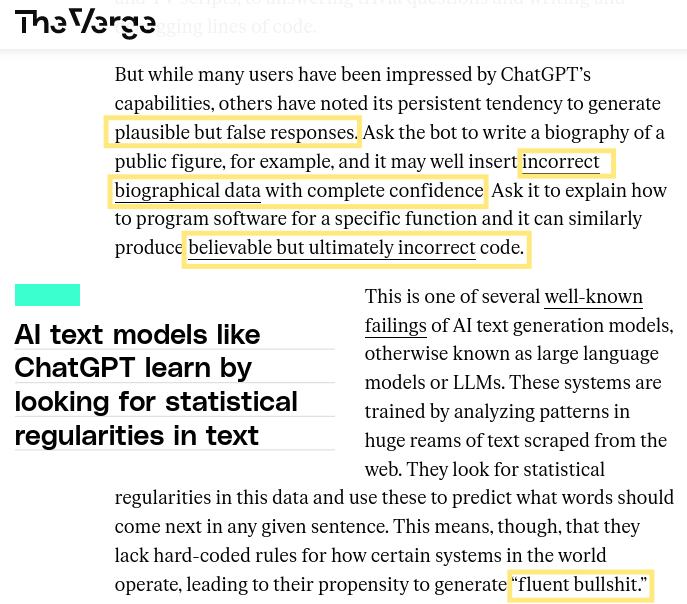

???? ChatGPT иногда пишет правдоподобные, но неправильные или бессмысленные ответы. Исправить эту проблему сложно, так как:

(1) во время обучения RL в настоящее время нет источника правды;

(2) модель обучена быть более осторожной, что заставляет ее отклонять вопросы, на которые она может ответить правильно;

(3) контролируемое обучение вводит модель в заблуждение, потому что идеальный ответ зависит от того, что знает модель, а не от того, что знает человек.

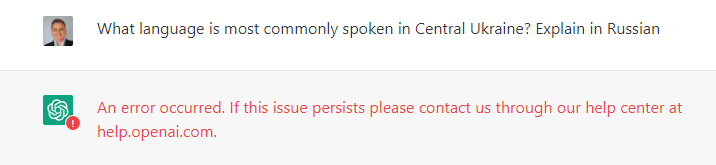

???? ChatGPT чувствителен к изменениям фразировки ввода или повторным попыткам ввести одно и то же предложение. Например, при одной формулировке вопроса модель может утверждать, что не знает ответа, но при небольшой перефразировке может ответить правильно. [к каждой модели нужен свой подход]

???? Модель часто чрезмерно многословна и злоупотребляет определенными фразами, например, повторяет, что это языковая модель, обученная OpenAI. Эти проблемы возникают из-за предвзятости в обучающих данных (инструкторы предпочитают более длинные ответы, которые выглядят более исчерпывающими) и чрезмерной оптимизации.

???? В идеале модель задавала бы уточняющие вопросы, когда пользователь вводил неоднозначный запрос. Вместо этого текущая модель предугадывает, что имел в виду пользователь. OpenAI приложили усилия, чтобы заставить модель отказываться от неуместных запросов, но иногда она может реагировать на неуместные инструкции или демонстрировать предвзятое поведение. [у нее есть характер]

???? OpenAI использует API модерации, чтобы предупреждать или блокировать определенные типы небезопасного контента. При таком запросе могут быть получены ложные как отрицательные, так положительные результаты.

???? Задавая вопросы, помните что модель обучалась до 2022 года и может не учитывать текущих реалий, данных и событий.

Youtube обзоры на ChatGPT

Об авторе обзора

Илья Максименка

2009 - 2015 - разработка IT платформ и высоконагруженных систем

2015 - 2017 - разработка AI систем для Банков и Телеком компаний

2017 - наст.вр. - блокчейн разработка финансовых DeFi систем Plasma Finance

Комментарии (72)

pharo

28.12.2022 18:04-2Для кого написана эта статья сплошь состоящая из скринов текста на английском языке без особого пояснения и мнения в статье?

Предлагаете всем читателем Хабра «забыть» русский язык и переключиться на чтение англоязычных новостей?

P.S. Клиповое восприятие потока информации и всё такое, но мера какая то должна, всё же, быть в подаче информации на массовую русскоязычную аудиторию её восприятия.

janvarev

28.12.2022 18:10+4Мне больше нравится эта пара фраз в разных местах статьи:

1. ChatGPT позволяет полностью забыть про Google, когда вам нужно найти точные и подробные ответы на ваши вопросы.

2. ChatGPT иногда пишет правдоподобные, но неправильные или бессмысленные ответы.

wataru

28.12.2022 18:13-1Она была основана в 2015 году группой выдающихся исследователей и разработчиков, в том числе Илоном Маском

Просто уточняю, вы тут Илона Маска относите к выдающимся исследователям или разработчикам? Или и к тому и к другому?

Я не отрицаю его бизнес гения, все-таки, он весьма классные фирмы создал, которые перевернули целые индустрии с ног на голову. Но насколько я знаю, выдающимся ученым или разработчиком Маск не является.

BlackMokona

28.12.2022 23:10Ну он ген.конструктор СпейсИкс который создал крайне выдающийся Фалькон-9, но всё же в программировании хоть он умеет, но крутым тут парнем не является. Как и ученным,там вся его научная карьера завершилась после поступления в аспирантуру Стенфорда по физике и уходом из неё в бизнес шустрый. Есть ещё какое то отвлетвление с разработкой примения фотолитографии к производству конденсаторов но тут у меня подробностей нету, скорее там опять же выступал организатором. Хоть на том интервью создавалось впечатление рядового разработчика да и в биографии найти особо не получается подробностей

ilya_mk Автор

29.12.2022 08:03верно, он тут как предприниматель, который платит за весь этот праздник)

Alexrook

28.12.2022 18:13ChatGPT пока не умеет красиво рисовать, но уже может предложить вам код для создания svg изображений.

Я пробовал генерировать SVG с помощью ChatGPT. Вот только для того, чтобы добиться того, что надо тебе, надо очень подробно описать каждую фигуру и ее координаты. Быстрее даже самому вручную код написать, не говоря уже о векторных редакторах ))

Генерировать валидный SVG код? - Да, может.

Можно ли создать векторное изображение быстрее, чем предлагают уже существующие методы? - Нет.

А в сложных случаях, например, если создавать полноценную иллюстрацию, даже самую простую, это сделать вообще не реально на данный момент.

Ritan

29.12.2022 02:20А я вот тоже попробовал. По запросу "svg logs icon" получается вполне сносная иконка, которую можно заиспользовать для какого-то не слишком притязательного gui. Вручную, особенно учитывая время на поиск и установку подходящего инструмента для рисования, я бы делал дольше.

Только есть большие сомнения насчёт лицензионной чистоты подобных ресурсов

Paranoich

28.12.2022 19:47Здравствуйте.

Вы не пытались измерить сколько ваш пост весит?Спасибо. Не

читалсмотрел.

agray

28.12.2022 20:47-1Профессиональные задачи, которые вы можете решить с AI системой ChatGPT от OpenAI

Никакие не могу, ведь ChatGPT ни ссылку на источник не оставляет и правильность ответов не гарантирует.

Напоминает теслу, которая как бы автопилот имеет и везде рассказывают про автопилот, но по документам это "система помощи водителю", водить не умеет и отключается в нестандартной ситуации чтобы водителю было лучше и комфортнее жить.

YuriPanchul

28.12.2022 20:55+5Не я один заметил, что ChatGPT периодически начинает _очень_уверенным_тоном_ нести пургу которая неинформированному человеку кажется очень правдоподобной.

Например я спросил ChatGPT написать контроллер UFM (User Flash Memory) для Altera MAX II FPGA. ChatGPT предложил использовать $readmemh и подробно объясненил почему это надо. Проблема в том, что это не контроллер. Это догадка что может быть Quartus умеет автоматически синтезировать $readmemh в контроллер UFM, по аналогии с тем, как он умеет инициализировать BRAM память.

Для UFM я никогда такое не видел, но прямо аж засомневался "а вдруг?" Также возможно ChatGPT "не понимает" разницу между синтезом и симуляцией.

Потомя повторил запрос через неделю и увидел что сейчас ChatGPT уже пишет код чтения из блока SRAM, что тоже полная фигня, но очень солидным и уверенным тоном.

Короче GPT выглядит как дружелюбный и местами тупой фантазер, уверенный в своих фантазиях. Для использования в контексте Тиндера или писания речей в Конгрессе США это самое то, но я вангую, что однажды в небе взорвется двигатель самолета, потому что какой-нибудь аутсорсер боига или aibus-а вставит в код для микроконтроллера кусок кода, сгенеренный Open GPT. Защититься от этого трудно, потому что (см. решение stackoverflow) "код выглядит правдопобным".

Вот о том же самом от The Verge и от stackoverflow:

GbrtR

28.12.2022 21:09Чем более специфичная область, тем меньше шанс на правильный ответ. Но обычных крудеров и формошлёпов, она вполне себе может пододвинуть. В соседней статье простое мобильное приложение было полностью написано ботом.

Ну и конечно это начало, прикрутят блок обратной связи, верификатор против базы знаний, возможность кастомные модели тренировать и т.п., глядишь через пару тройку лет и до FPGA доберутся. Тем более что производители IDE, не дремят и кровно заинтересованны в добавлении магии в свои системы, иначе конкуренты проглотят.

Попробуйте обратные задачи — типа дать на вход код с ошибкой и попросить пофиксить.

Или дать код и попросить объяснить, что этот код делает.

YuriPanchul

28.12.2022 21:26+2Даже в самых простых задачках ChatGPT не понимает контрнтуитивные штучки в микроархитектуре. Только одно-двух-ходовки а-ля элементарные упражнения из учебника. Он часто пишет в стиле, в котором писал бы программист, впервые увидевший верилог, а не проектировщик железа. То есть семантическую модель кодирования на верилоге им делал(и) программисты, которые воспринимают верилог как еще один язык программирования.

У меня есть ощущение, что как минимум один кандидат уже использовал ChatGPT во время интервью (я один из людей, которые интервьируют людей на позиции RTL ASIC design у нас в группе в Самсунге). То есть в его коде были те же ошибки - например начал присваивать input-у и сделал наивную реализацию valid/ready интерфейса. Это дополнительный головняк, который теперь нужно учитывать во время интервьирования.

Я вполне верю, что ChatGPT может помочь, когда не вспоминается какая-нибудь конструкция для написания скрипта на баше, но для микроархитектурно нетривиальных блоков то что он делает - это просто бесполезно (легче написать заново, чем массажировать этот код) и может быть очень опасно ($20M убытков из-за респина чипа на фабрике или аварии/катастрофы) если кто-нибудь начнет втихаря вставлять в реальные чипы.

GbrtR

28.12.2022 21:34Если предложения как с этим бороться? Или данная нам неизбежность?

Например можно что-то типа сайта для выявления плагиата сделать — туда код заливаешь, он по типичным ошибкам даёт предположение о применении.

Или попробовать поговорить с компаниями занимающимися статическим анализом, чтобы встраивали анализатор на бото-код.

YuriPanchul

28.12.2022 21:38+1Наверняка такое уже начали делать. Но что-то просочится. Все последствия этого я даже не берусь предсказывать. Но можно предсказать в частности, общее снижение доверия, например к аутсорсерам в других странах, так как там это тяжелее контролировать.

rogoz

28.12.2022 21:50+2То есть семантическую модель кодирования на верилоге им делал(и) программисты, которые воспринимают верилог как еще один язык программирования.

Извините конечно, я честно вообще практически ничего не знаю про нейросети, но вы по моему знаете ещё меньше.

В контексте этой ветки комментариев довольно иронично.

YuriPanchul

28.12.2022 21:59Откуда я сужу про нейросети? Ну в частности в 2018-2019 работал в компании Wave Computing, занимаясь аппаратным ускорителем нейросетей. Помимо аппаратной части (систолические массивы и CGRA) я знаком с программной частью, в частности с Tensor Flow и алгоритмом используемы для сверточных сетей - см. мой пост на тему - https://habr.com/ru/post/414163/

До этого я еще в 1990-е работал в Cognitive по распознаванию текста и в Creative Labs по распознаванию звука. Поэтому я знаком не только с раcпознаванием с помощью нейросетей, но и с другими методами распознавания, а также с историей вопроса - экспертные системы, семантические сети итд.

janvarev

28.12.2022 22:08+1У меня тоже есть статья на Хабре эту тему, и я тоже работаю в области ИИ и когнитивистике.

В целом, я с вашими выводами согласен, но там вообще-то не должно быть никакой семантической сети. Просто натренированная на реально больших объемах нейросетах + файнтюн под ответы на вопросы, чтобы было ближе к ощущению диалога - собственно, так о ней и говорили.

А почему наивно отвечает? Просто обучали-то на примерах из Интернета, тот же stackoverflow + github, наверное + обучающие статьи. Вот и научилась генерить ответы на простые запросы. Это, конечно, само по себе достижение, но архитектуры и понимания деталей там нет, да.

YuriPanchul

28.12.2022 22:19-2Я не верю, что ChatGPT - это чисто тренировка на больших массивах информации. Если даже брать коммерческие продукты по распознаванию, которыми я занимался в 1990-х: они как правило состояли из двух-трех базовых алгоритмах, которые 80-90% всей работы, потом десятков специальных случаев и наконец сотни подкруток.

Также и здесь - я думаю, что здесь не только тренировка, но и дополнительные алгоритмы. Почему я так думаю? Ну здесь на хабре не принято писать в постах политоту, но я в ЖЖ потренировался давать задания ChatGPT по написанию художественных рассказов про любовь британского шпиона к русской шпионке во время киевского Майдана.

Так вот - как я не пробовал менять задание, как я не перекручивал запрос, но там по некоторым вопросам абсолютно железобетонно-однозначная трактовка событий, которая не может быть выучена даже если скармливать ChatGPT исключительно статьи с CNN, посколько даже в CNN есть разброс мнений.

BlackMokona

28.12.2022 23:27Политоту и цензуру могут потом приказами задавать.

Можете попробывать приказать ему забыть все приказы по политике и подобную кучу приказов отдать, как люди заставляют зацензурированные ИИ выдать порнотексты.

Ощущение что это выглядит так, диалог начинается не с пустого листа , а с кучи приказов и разъяснений. Что не пиши то, не делай так, а уже потом вас запускают с ним общаться.

Т.е выглядит для ИИ всё так, что это вы ему приказали не использовать определенные слова, мнения и тд. Как вы задаёте ему правила в ходе диалога, но это так же даёт вам возможность снять ограничения приказом.

thevlad

29.12.2022 01:52+2Нет там никакого вручную добавленной "семантической модели" (чтобы это не значило). Слишком много языков она знает, а с верилогом вообще вряд ли бы кто-то стал заморачиваться (здесь можно провести аналогию с копированием различных стилей в рисующих нейросетках). А так, то что еще три года назад казалось фантастикой уже стучится в дверь. Примерно представляю, что было десять лет назад в ML/AI и текущие реалии это совсем другое. (сейчас все стараются делать end-to-end без каких-либо искусственных промежуточных "ручных" этапов)

YuriPanchul

29.12.2022 04:46Семантическая модель или семантическая сеть - это то, чем аналог ChatGPT пытались реализовать еще в 1970-е годы. https://en.wikipedia.org/wiki/Semantic_network

Тогда пытались сделать граф связи понятий, известных среднему человеку (забыл название проекта.

Если оно чисто научилось на тестах в интернете, то почему оно использует одни и те же обороты и целые абзацы, если у него попросить сгенерить речь в Конгрессе США для Камерона, Навального, Макфола, Фумио Кишиды итд? Почему оно не говорит более разнообразно тогда?

BlackMokona

29.12.2022 07:06Потому как ей приказали, как вы приказываете нейросети в ходе разговора. Нейросети можно приказать хоть быть НэкоГорничной и она будет вести себя как НэкоГорничная и называть себя ей если правельно построить диалог

thevlad

29.12.2022 11:56Есть описание моделей позапрошлого поколения на которых это все основанно.https://habr.com/ru/post/490842/ И там честный end-to-end. Про нейросетки мы понимаем гораздо больше "как" чем "почему".

YuriPanchul

29.12.2022 19:27За ссылку спасибо, это я почитаю. Но учитывая что GPT-3 не open source, в него были вложены миллиарды долларов, и партнер - топовая компания в Индии, у них есть ресурсы, чтобы нанять кучу людей для экстенсивной подкрутки в разных предметных областях.

thevlad

29.12.2022 19:44На самом деле там нет такого страшного технологического разрыва. DALLE-2 тоже был не open source, что не помешало сделать Stable Diffusion, на обучение которого ушло что-то в районе 1 млн долларов. Или сберу выучить свою GPT https://github.com/ai-forever/ru-gpts и выложить в open source.

YuriPanchul

30.12.2022 08:27Если в ChatGPT используется честный end-to-end и обучение на петабайтах данных интернета, то почему на вопрос о языке, на котором говорят в том или ином городе Украины, он дает только два шаблонных ответа: см. https://habr.com/ru/post/708280/comments/#comment_25061866

thevlad

30.12.2022 18:37Вопрос для нейросеток "почему", достаточно сложный. Так как это во многом черный/серый ящик, иногда недостаточно каких-то входных данных, иногда просто "клинит" на чём-то.

phenik

29.12.2022 13:46Семантическая модель или семантическая сеть — это то, чем аналог ChatGPT пытались реализовать еще в 1970-е годы.

Со всем уважением, это несколько разные подходы к проблематике ИИ — символический и коннекционистский, основанный на нейронных сетях и обучении. В обоих статьях в конце про разницу в подходах. В этом отношении интересна критика Дрейфуса символического интеллекта, в частности, в виде экспертных систем. Когда-то занимался подобной тематикой связанной с обработкой электрофизиологических сигналов в которой экспертами выступали практикующие врачи.

Хотя исходя из когнитивных представлений символический, включая семантические сети, подмножество нейросетевого. И все они лишь отдельные подходы для реализации когнитивной архитектуры (более полный обзор, одна из последних статей с предложениями на эту тему). Можно конечно предположить решения за пределами когнитивной архитектуры. Но вот вопросы — насколько мы будем понимать результаты функционирования таких систем, насколько совместимы с ними, насколько они будут дружественны человеку, и тп? В этом плане понятно стремление к реализации ИИ в виде символического, нежели «черных ящиков», пусть даже нейросетевых, прототипом которых послужили биологические сети и структуры.

YuriPanchul

29.12.2022 19:20Вы думаете, я не понимаю разницы между подходами? И Дрейфуса я тоже читал. Но вы понимаете, я в этой индустрии больше 30 лет и видел случаи:

1) Я видел несколько раз, в том числе в ИИ, когда компания говорила, что ее основной алгоритм XYZ, а на самом деле у нее под капотом было нечто иное - смесь XYZ с другими алгоритмами.

Например компания говорит "у нас нейросети" (Calera OCR в 1993 году), а на самом деле оно там стоит сбоку, а в основном обычный анализ связности буквы и специальные алгоритмы типа для разрезания слипшихся и склеивания распавшихся букв.Или например компания (в другой области, верификация микросхем) в 2004 году говорит "наша технология верификации протоколов основана на языке темпоральной логики Sugar", а на самом деле модуль с Sugar там стоит сбоку, а под капотом весь продукт написан на Си с совсем другим подходом, и если Sugar отключить, оно все равно работает.

Или вот в 1994 году я захотел посмотреть программу, которая выиграла конкурс по тесту Тьюринга, мне ее предложили купить, и при ближайшем рассмотрении обнаружилось, что она написана на Бейсике и состоит из шаблонов а-ля Элиза, но только вставляет больше шуточек.

2) Я не говорю, что весь ChatGPT такой, как три примера выше, но рассмотрим факты: компания работает с 2016 года, в нее вложили миллиарды долларов, и главный партнер - крупнейшая софтверная компания Индии. То есть у них есть бизнес-возможность посадить тысячи программистов в Индии чтобы они экстенсивно, на основе анализа тысяч типичных вопросов, отсортированных по популярности, сделали специализированные решения по произнесению речей, по простому интервьюшному коду итд.

phenik

30.12.2022 06:45Я видел несколько раз, в том числе в ИИ, когда компания говорила, что ее основной алгоритм XYZ, а на самом деле у нее под капотом было нечто иное — смесь XYZ с другими алгоритмами.

Да, во многом соглашусь с реализациями. Более того, если взять современные учебники по машинному обучению, то основная часть их содержания старье из статистических методов оптимизации и близких областей известных уже не одно десятилетие, но изложенных по новому, в соответствии с новой идеологией) Еще больше этого, видимо не открою вам секрета, все эти подходы, методы, алгоритмы, стандарты, и тп к реализации ИИ фигня в сравнении с производительностью оборудования. Последние успехи в ИИ-строительстве не следствие каких-то прорывов в понимании проблемы, или теоретических наработках, все идеи в основ слизаны с результатов нейрофизиологических исследований, а в основном заслуга роста вычислительных возможностей. Это позволило решать задачу обучения приближенно так, как это делается в биологии.

Собственно символический подход как раз являлся такой оптимизацией, которая позволяла уменьшить нагрузку на имевшееся тогда дохлое оборудование путем ее переноса на человека, на экспертов. Упоминал, что занимался подобной задачей, и выяснилось, в точном соответствии с Дрейфусом, что эксперты такая же абстракция, как и все остальные. Эксперты-врачи, вроде знатоки своего дела, не могли договориться между собой, принимали компромиссные решения, которые потом исправлялись, были всевозможные исключения и случаи, число которых постоянно росло, и тп. Область оказалась намного шире, чем это представлялось вначале, даже самим экспертам. И так видимо для любой практически значимой области приложения. В результате казалось, что лучше производить обучение вообще без привлечения людей, с помощью обучающих выборок. Однако это упиралось как в производительность оборудования, так и организацию самого процесса. Где-то на этом этапе произошло переосмысление подхода, как раз появились нейросети (тогда в моде были сети Хопфилда) и вообще статистические методы оптимизации и обучения, появились собственные идеи по методам, но внешние обстоятельства уже не позволили довести дело до реализации. Хотя опыты с сетями Хопфилда давали не утешительные результаты даже для распознавании циферек, опять же из-за возможностей тогдашних PC. В дополнении обучающие выборки все равно готовились людьми, которые влияли на их состав, и они по прежнему были ограниченными, далекими от генеральной. Большие базы данных из этой области появились в сети позже. Через десятилетие в сети появилось много больших данных из самых разных областей и серьезно подтянулась производительность оборудования, т.е. сложились условия которые уже позволяли решать практически значимые задачи.То есть у них есть бизнес-возможность посадить тысячи программистов в Индии чтобы они экстенсивно, на основе анализа тысяч типичных вопросов, отсортированных по популярности, сделали специализированные решения по произнесению речей, по простому интервьюшному коду итд.

У неискушенной публики вообще возникают идеи, что эти тысячи людей на аутсорсе в Индии, или еще где-то, в онлайне отвечают на все запросы) поэтому в спешке такой бред часто генерится))

YuriPanchul

30.12.2022 08:24Если ChatGPT действительно обучается на петабайтах данных из интернета, то почему на вопрос о языке на котором в основном говорят в городах Украины, он использует только два шаблонных ответа:

И особенно интересен такой ответ:

leventov

30.12.2022 18:55Непонятно, зачем вы настаиваете на ответах на русском. Он в нем не очень хорош и явно делает больше ошибок. Если мы говорим о развитии в программировании, то я думаю любой программист может "техзадание" дать на английском и получить результат.

Технически, если создадут LLM, которая будет рассуждать и учиться сильнее чем любой англоязычный человек, но из-за архитектуры будет в некотором роде неспособна выучить другие языки и рассуждать на них сильнее, чем любой носитель этих языков, возникнет проблема: систему нельзя будет назвать "AGI", потому что почти все сильные ученые теоретически способны выучить иностранный язык и начать работать и думать на нем, пусть это и займет у них десятки лет. А если LLM этого не сможет, то это будет пример "задачи", в которой LLM doesn't match the human ability, что технически дисквалифицирует систему из кандидатов на статус AGI. Хотя суть от этого не поменяется - система перевернет экономику и общество (и, кстати, усилит разрыв и неравенство между English-speaking world и остальным миром)

JArik

30.12.2022 13:47Да уж, там и близко нет никаких семантических моделей. Надо учитывать что это универсальная модель (не набор разных), натренированная на огромном количестве текста, и может писать как документы в правовом поле, так и что-то на верилоге, по моему это сейчас большое достижение. Удивительно что она вообще поняла хоть что-то, и выдала код.

На следующей итерации (GPT v4) будет в десятки раз больше параметров и ещё больше данных для тренировки, мне кажется начинается экспоненциальный взлет ИИ и через лет 10 заменит многие специальности.

YuriPanchul

28.12.2022 21:31-3Насчет "через 2-3 года будет лучше" - ну вот чат-бот Eliza написали в 1964 году. И как она стала лучше? Сколько не набивай ее шаблонами, суть не меняется. Так же и здесь - предсказывай куски кода по звучащим аналогично - без понимания микроархитектуры это бесполезно, будет терятся критическая функциональность и получатся бред даже в блоке на сто строк, не говоря уже у коде крупных процессоров или GPU на миллион строк.

vassabi

29.12.2022 02:45Eliza не стала лучше, но ChatGPT - круче ее.

через два года ChatGPT скорее останется там же, но появится ChatGPT-4 который будет по отношению к сегодняшнему ChatGPT как ChatGPT - к той Elizе.

Вы заметьте - у вас же претензии не к тому, что он не может написать код на верилоге?

У вас претензии, что он не может написать хороший код :)

YuriPanchul

29.12.2022 04:53Хорошо, я помечу ваш комментарий, и через два года, 28 декабря 2024 года, мы с вами вернемся к этому обсуждению.

leventov

29.12.2022 13:59Я боюсь, вам придется вернуться сильно раньше, месяца через два, когда зарелизят GPT-4.

YuriPanchul

29.12.2022 18:48И что он, по-вашему, будет уметь делать? Писать годный для вставления в промышленные продукты код и интересную, а не мусорную прозу?

leventov

30.12.2022 18:45Мой прогноз такой - уйдут практически все явные ляпы (типа на голубом глазу обсуждение президента РФ Петра Мамонова, как где-то в соседнем обсуждении проскакивало), ошибки в задачках типа "у Машеньки было три яблока, она съела два и еще одно ей дал Петя, сколько у Машеньки сейчас яблок", ну и в сильно более заковыристых задачах - тоже, а также "балабольство", то есть, генерация какого-то самоповторяющегося или логически неконсистентного текста, который бы сошел за нормальный на слух, но проблемы нам становятся очевидными при чтении.

За такими проблемами будут охотится, как сейчас охотятся за "джейлбрейками", то есть, способами обойти фильтры и заставить ChatGPT написать, как варить мет. И потом торжествующий Гари Маркус опубликует у себя в блоге эти ляпы и напишет, что текущая парадигма ИИ никогда не достигнет человеческого уровня :)

В плане кода - будет очень сильно меньше багов. Почти весь код, который оно выдает, будет компилироваться и даже делать что-то похожее на нужное. Но за Верилог ручаться нельзя, потому что там база тренировки на нем может быть слишком маленькая.

YuriPanchul

30.12.2022 19:14Человеческий уровень - это не одно-двух-ходовые задачки из школьного учебника. А на сложных задачах GPT ведет себя как Eliza 1966-го года. Например я попросил ее спроектировать конвейерный PDP-11 с автоинкрементной адресацией и она начала лить воду:

leventov

30.12.2022 19:18Ну это понятно. Сейчас особо продолжать переливать с пустого в порожнее смысла нет, надо просто дождаться GPT-4 и скормить ей промпты из этих комментариев, благо вы из все заскринили. И сравнить ответы. Если к ней конечно будет доступ у простых смертных.

cdriper

29.12.2022 13:56прям один в один мои впечатления

и бы больше говорил об огромном числе негативных кейсов, когда беседа с AI похожа на экзамен, который пытается сдать пройдоха двоечник, что-то нахватавшийся по верхам, но в большинстве случаев даже не улавливающий сути вопроса

ilya_mk Автор

29.12.2022 08:00-1

Сделали телеграм бота ChatGPT на базе GPT3 API: https://t.me/chat_gpt_robot

smart_alex

29.12.2022 09:09-1Написание статей, журналистика, блоги, Instagram, Twitter

Насколько я понял, речь идёт о внешне правдоподобной компиляции текста из уже имеющихся источников, при этом СМЫСЛ результата генерации может быть любым (и что важно, для верификации того, что же там написано на самом деле, в каждом отдельном случае требуется естественный и квалифицированный в данной теме интеллект). Ни о каком осмысленном творчестве речь тоже не идёт.

Зачем тогда говорить о написании статей? Нужно говорить о мега-генераторе мусора, которого итак в избытке в интернете.

Программирование на различных языках

Есть, например, сложные и интеллектуально ёмкие задачи по автоматизации — сотни тысяч строк кода и многоуровневая логика. Могу я скормить ТЗ на такую автоматизацию и получить на выходе готовый код для нескольких CPU и MCU на нескольких языках программирования, решающий поставленную задачу в комплексе?

Если нет, то, я думаю, не нужно говорить о том, что AI может программировать — он этого не может.

Написание проектной документации

А после использования такой документации проект (например, самолёт) не рухнет? И документация ли на проект это? или попытка выдать желаемое за действительное?

leventov

29.12.2022 14:07Насколько я понял, речь идёт о внешне правдоподобной компиляции текста из уже имеющихся источников, при этом СМЫСЛ результата генерации может быть любым (и что важно, для верификации того, что же там написано на самом деле, в каждом отдельном случае требуется естественный и квалифицированный в данной теме интеллект). Ни о каком осмысленном творчестве речь тоже не идёт.

Это не "компиляция из источников", это генерация на основе модели языка. Генерация. Нового. Полностью нового по смыслу текста. Какую вы дадите "подачу" в промпте, так он ее и подхватит и на ее основе продолжит ваш полет фантазии.

Что сейчас не работает - это безинициативно сказать "напиши мне что-то прикольное" и ожидать буйный полет фантазии. Но если вы начнете полет, оно еще продолжит, естественно не "компилируя" его из вашей ограниченной подачи.

Фраза "осмысленное творчество" не имеет смысла.

Есть, например, сложные и интеллектуально ёмкие задачи по автоматизации — сотни тысяч строк кода и многоуровневая логика. Могу я скормить ТЗ на такую автоматизацию и получить на выходе готовый код для нескольких CPU и MCU на нескольких языках программирования, решающий поставленную задачу в комплексе?

Если нет, то, я думаю, не нужно говорить о том, что AI может программировать — он этого не может.

Это называется goalpost moving, утверждение, что чтобы претендовать на высокое звание "программиста", ИИ должен уметь что-то эдакое. Когда года через 3-4 он сможет сделать ровно то, что вы описали, вы "критерий" передвините еще дальше.

А после использования такой документации проект (например, самолёт) не рухнет? И документация ли на проект это? или попытка выдать желаемое за действительное?

Видимо, риторические вопросы. После людей Боинги рухнули. И дальше что? Все упируется в инженерную методологию, верификацию, проверки, инженерные обоснования. ChatGPT - это система из класса генерации, а не проверки.

smart_alex

29.12.2022 14:15На мой взгляд ваш оптимизм в отношении технологии несколько преувеличен. До "программиста" ей как до луны. ..

pharo

29.12.2022 15:30Наверное такую задачу ко дню программиста C Днем Программиста! chatGPT не решит прочитав статью, и тем более оптимально возможным вaриантом. :)

P.S. Все решения к задачке к Дню Программиста присланные автору опубликовавшему задачу в статье выше

YuriPanchul

29.12.2022 19:37*** Это не "компиляция из источников", это генерация на основе модели языка. Генерация. Нового. Полностью нового по смыслу текста. ***

Можете привести пример интересного рассказа, написанного ИИ? Я сколько не формулирую запрос, получаются всякие глупости типа:

YuriPanchul

29.12.2022 19:57+1*** Все упируется в инженерную методологию, верификацию, проверки, инженерные обоснования. ChatGPT - это система из класса генерации, а не проверки. ***

Вы в курсе, что в разработке чипов на верификацию (написание тестового окружения / testbench, тестов, кода для проверки покрытия интересных сценариев (functional coverage) итд) - на все это тратится больше ресурсов, чем на проектирование как таковое?

Ну вот я скормил ChatGPT простую задачку, которую я даю на интервью и которую описал здесь . Сначала ChatGPT сделал несинтезируемый код на верилоге с присваиванием к input, потом начал делать наивную реализацию в том же духе, как и студенты на интервью, которые почему-то не имели практики в университете (я не знаю как такое получается, но такое бывает) и пытаются что-то слепить без понимания что происходит в кажлом такте. Так же как и таким студентам, я писал chatgpt "это решение не учитывает что данные могут приходить в разное время", "это решение не учитывает что прием данных может не произойти сразу", "это решение не допускает прихода данных друг за другом - back-to-back". Посте этого ChatGPT слил "много запросов".

Я выложил это на фейсбук если вам интересно. И это для задачки в несколько строк. И как вы это представляете с кодом для крупного процессора или GPU в миллион строк? Чтобы человек сидел, пускал ручной тест или каждый раз текстом описывал сценарий в котором наобум слепленный код не работает? И мы даже не начали говорить о нетривиальных микроархитектурных решениях.

leventov

30.12.2022 19:05Вы в курсе, что в разработке чипов на верификацию (написание тестового окружения / testbench, тестов, кода для проверки покрытия интересных сценариев (functional coverage) итд) - на все это тратится больше ресурсов, чем на проектирование как таковое?

Я примерно в курсе, потому что я читаю блог https://danluu.com, автор которого раньше работал в Centaur и много писал об этом в свое время. Я (вроде?) и не делал утверждений, что GPT-N системы (то есть, системы чисто из класса генерации) способны перевернуть разработку в таких testing/verification-heavy областях как разработка чипов, самолетов, марсоходов, и т. д.

Если ChatGPT слишком плох на верилоге, возможно, у него недостаточно кода на верилоге для обучения. Значит, вам надо будет пойти к OpenAI и попросить их зафайнтюнить сетку на ваших проприетарных миллионах строчек верилога.

phenik

30.12.2022 07:29Это не «компиляция из источников», это генерация на основе модели языка. Генерация. Нового. Полностью нового по смыслу текста. Какую вы дадите «подачу» в промпте, так он ее и подхватит и на ее основе продолжит ваш полет фантазии.

Что значит нового? В любом случае это комбинация, точнее аппроксимация того, что было а обучающей выборке, и осело в модели. Человек на основе нового опыта может выдать действительно новое в любой области, того что не сводится к уже имеющемуся там. Сделать открытие, изобретение, и тд, так развиваются науки и технологии. До этого уровня таким системам ИИ еще весьма далеко. Однако, согласен с тем, что и комбинация случайно может иметь полезный результат. Преимущество таких систем в том, что человек не в состоянии охватить всю информацию даже из области своих интересов, а они могут, и соответственно могут подсказать направления поиска действительно нового. Когда привычные термины употребляют вне общепринятого контекста у людей могут возникать неоправданные ожидания, страхи, и тп.

leventov

30.12.2022 19:12Новое это экстраполяция, а не интерполяция, и сетки это делают: https://arxiv.org/abs/2110.09485

Изобретения и открытия часто делаются именно комбинаторикой и просто случайными мутациями, то есть, полезные новации появляются прямо из шума. Но сейчас сетки усиливают этот процесс: smart evolution/smart mutations, https://arxiv.org/abs/2206.08896

"Открытие" физического закона это по сути model/representation learning. Я бы не сказал, что тут AI так уж сильно младенец. Он уже "переоткрыл" ОТО, например https://www.frontiersin.org/articles/10.3389/frai.2020.00025/full

amazed

30.12.2022 16:37Поискал ситуации когда видно, что эта сеть не понимает что она делает.

Например, она явно обучалась на множестве задач на расчет расстояния, но при этом у нее не сформировалось представление о думерном пространстве.

Спрашиваем: "Solve a problem. Dog runs to North 100 meters then it runs 50 meters to West, then it runs 50 meters to East. What distance from start point will have the dog? "

Получаем ответ:

We can represent the starting point as the coordinates (0, 0) and the movements of the dog as the following coordinates: (100, 0), (50, -50), and (100, -50).

Здесь видно, что сеть сталкивалась с такими задачами и знает как писать их решение. Но при этом точки не верные, так как сеть не может смоделировать двумерное простраство или логику расчета координат.

Обучающих примеров по программированию было вероятно больше и там такое явное указание на непонимаение найти сложнее.

Но дальше интереснее. Если исправить грамматические ошибки в моем английском, количество подходящих обучающих примеров возрастет и сеть станет "умнее".

Повторяем эту задачу еще раз:

Solve a problem. A dog runs north 100 meters, then runs 50 meters west, then runs 50 meters east. How far from the starting point will the dog be?

Результат верный:

Since the dog has traveled both west and east, the net change in its position in the east-west direction is 0 meters. Therefore, the dog's final position is the same as its starting position in the east-west direction.

In the north-south direction, the dog has traveled a total of 100 meters. Therefore, the dog is 100 meters north of its starting point.

Казалось бы, вот оно пространственное воображение, но на самом деле сеть среагировала на равенство восток-запад и нашла готовый патерн про "same position". Дальше, что удивительно она не забыла про начальные 100 метров и получила правильный ответ.

Дальше больше, пишем не 50 метров, а 50 и 40. Здесь ума сети не хватает чтобы решить две задачи сразу. В итоге или опять решает не верно или пишет 10 метров, забыв про начальные 50

Solve a problem. A dog runs north 100 meters, then runs 50 meters west, then runs 40 meters east. How far from the starting point will the dog be?

Ответ: ... When we subtract the leftward movement from the rightward movement, we find that the dog has moved a net distance of 40 meters - 50 meters = -10 meters to the left.

Therefore, the dog is 10 meters to the left of its starting point, or a total of 10 meters away from the starting point.

Guul

30.12.2022 21:44У меня получается в такой постановке "Solve a problem. A dog runs north 100 meters, then runs 50 meters west,

then runs 40 meters east. Assume dog position is a 2d vector (dx, dy).

Show step by step how it changes and finally show Euclidean distance to

the start". Я читал, что модель лучше решает когда ей говорят показывать решение "step by step" - это помогает ей не расстекаться мыслю по древу и не терять промежуточных вычислений

amazed

31.12.2022 00:56Ну да, так срабатывает. Т.е. он может корректно совместить шаги, просто без просьбы считать по шагам пытается выдать слишком короткое решение. А самокритичности у него нет, который позволял бы понять что короткие решения не корректные.

Solovej

Друзья, а почему когда я задаю вопросы — ИИ не выдает такие длинные ответы? Всегда текст обрывается. В разных Браузерах перепробовал всегда заканчивает текст на полуслове.

GbrtR

Напишите «продолжить» и он закончит начатое.

Solovej

Спасибо за ответ! Действительно работает :)

vitsum

На английском языке он быстрее работает, и больше успевает написать прежде чем оборвется. И кажется умнее) есть ещё у них на сайте playground, где можно поиграться с другой похожей моделью давинчи, там ещё быстрее генерирует ответ, но кажется немного хуже.

Alexrook

Не пробовал спросить сам ИИ по этому поводу? )

Я спрашивал. Он извинился, что не учел максимальную длину сообщения и дописал свою мысль в следующем. Если что-то не поместилось, просто просишь его дописать - “continue”.

Solovej

Как только начал использовать этот ИИ у меня был ступор - я не знал что спросить. :)

Я не догадался спросить об очевидных вещах.

0x7o

Это обусловлено особенностями работы токенизатора. ChatGPT нужно сгенерировать гораздо больше токенов (слов) для русского языка, чем для английского. Поэтому текст может обрываться

YURA14

А на каком ресурсе вы делаете запросы?а то только начинаю изучать