Доступность продвинутых технологий на базе искусственного интеллекта растёт поразительными темпами. Еще вчера создание изображений с помощью ИИ было уделом исключительно технически подготовленных специалистов. Сегодня такие бесплатные генеративные сервисы, как Midjourney и Stable Diffusion, дали возможность миллионам обычных пользователей раскрыть свой «диджитал‑творческий» потенциал буквально в пару кликов.

Взрывное распространение ИИ‑генеративных технологий затронуло и создание видеоконтента. Главным двигателем здесь стали дипфейки (DeepFake). В общем доступе появились десятки инструментов, вроде DeepFaceLab, Deepfakes Web или FaceSwap, которые позволяют изменять лица людей на видео, добиваясь пугающей натуралистичности.

Стоит ли удивляться, что открывшейся перспективой незамедлительно воспользовались разного рода киберхулиганы и откровенные мошенники. Неслучайно Лаборатория кибербезопасности «Сбера» в своем аналитическом отчёте «Прогноз влияния перспективных технологий на ландшафт угроз кибербезопасности» (Hypervector 2022) поставила дипфейки в ряд главных киберугроз ближайшего будущего. А компания VMware в своем ежегодном ревью Global Incident Response Threat Report 2022 включила их в тройку наиболее актуальных новых вызовов для глобальной информационной безопасности.

Ранее мы уже разбирали, что представляет собой технология deepfake, какие потенциальные опасности несет, а также тестировали популярные инструменты для распознавания дипфейк‑изображений. Этим материалом мы продолжим интересную тематику и раскроем больше технологических деталей вывода «глубоких подделок» на чистую воду. На сей раз речь пойдет о real‑time или live‑дипфейках, способных в реальном времени подменять участников видеозвонков образами других людей. Также расскажем о критических уязвимостях «живых» дипфейков, которые можно эффективно использовать для их распознавания.

Дипфейки криминализируются

В 2022 году live‑дипфейки в видеоконференциях, создаваемые в режиме реального времени, стали общепризнанной угрозой безопасности. В июне ФБР выпустило официальное предупреждение о расширении использования дипфейков при устройстве на удаленную работу. В июле крупнейшая американская СРО в отрасли бизнес‑регулирования Better Business Bureau (BBB) также предупредила об использовании дипфейк‑инструментов для организации новых, крайне опасных разновидностей фишинговых атак и атак социальной инженерии.

Первое известное крупное мошенничество с дипфейками было раскрыто в 2021 году. Тогда были обнародованы подробности аудиозвонка с дипфейками, который позволил злоумышленникам побудить банковского служащего из ОАЭ перевести 35 миллионов долларов на неизвестный счет. Другой громкий случай криминального применения дипфейков связан с кражей 20 миллионов долларов из американских государственных фондов пособий по борьбе с Covid, которую совершила китайская кибергруппировка APT41 в декабре 2022 года.

Само существование видео‑ и аудиодипфейков, создаваемых в реальном времени, оказывается своего рода «террористической атакой» на реальность. Подобные прецеденты способны поставить под вопрос судебное рассмотрение многих спорных случаев, даже тех, где данная технология не использовалась.

В поисках решения

В последние годы мировое сообщество исследователей безопасности активизировало свои усилия по созданию более эффективных систем обнаружения дипфейков, уделяя особое внимание проблеме распознавания live‑дипфейков.

В конце 2022 года было объявлено о начале работ над анти‑дипфейк сервисом Expert. Новый инструмент, который создают эксперты научно‑технического центра ФГУП «Главный радиочастотный центр» (подчиняется Роскомнадзору) совместно с НИУ ИТМО, задействует искусственный интеллект, чтобы выявлять видеозаписи с дипфейками, а также потенциально опасные материалы, содержащие скрытую агрессию и ложь.

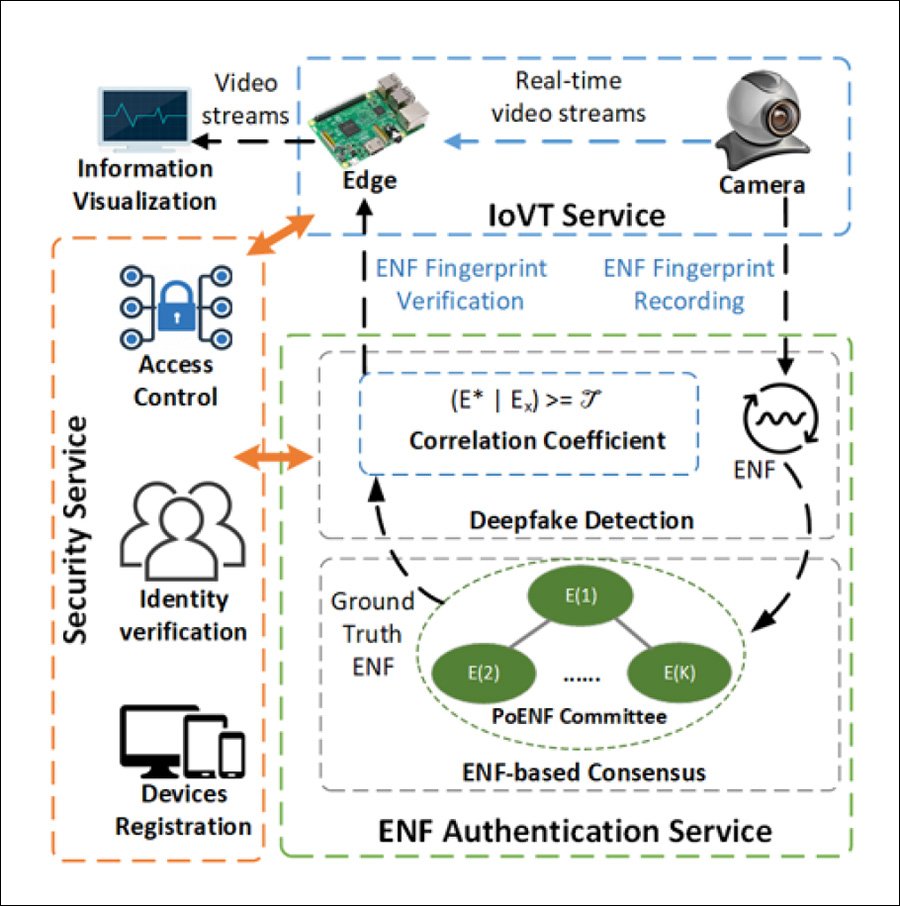

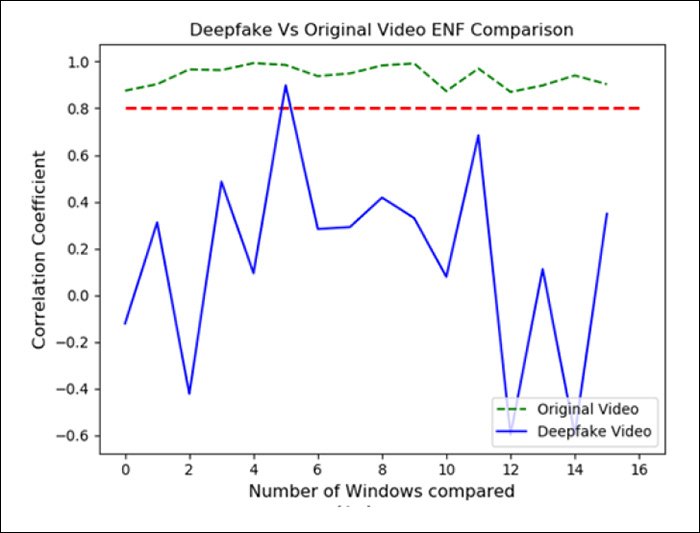

Одной из практических реализаций таких инициатив стал совместный проект Исследовательской лаборатории ВВС США и Бингемтонского университета в Нью‑Йорке. Созданный ими метод DeFakePro использует уникальную частоту электрической сети или ENF (Electrical Network Frequency), встроенную в любую аудио‑ или видеозапись в качестве «неподдающегося подделке» сигнала. ENF позволяет отличать реальные видео‑ и аудиосигналы от поддельных во время видеоконференции в режиме реального времени.

Мониторинг электрических колебаний — ключ к разоблачению

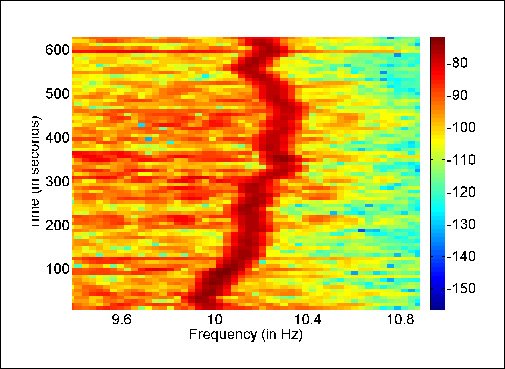

ENF — частота в сетях распределения электроэнергии, которая возникает из‑за колебаний в управлении нагрузкой и различается в зависимости от региона и внешней среды. Если видео не создается на улице, ENF надежно встраивается в мультимедийную запись, придавая всему контенту уникальную сигнатуру, которая нарушится при попытке «дипфейкового» вмешательства.

В аудиоконтенте сигнатура ENF возникает из‑за двух основных причин:

электромагнитной индукции — для подключенного к сети оборудования;

фонового шума — для устройств с питанием от батареек.

В видеоконтент ENF встраивается из‑за колебаний яркости света в источниках, питаемых от электрической сети.

Колебания освещенности на частоте 120 Гц при средней частоте 60 Гц могут быть зарегистрированы с выхода веб‑камер или других устройств захвата, участвующих в видеоконференции. Наиболее распространенным типом датчиков изображений является аналоговый сенсор CMOS (КМОП), построенный на основе кристаллов кремния. В CMOS‑датчике кадры захватываются с помощью механизма скользящего затвора, что увеличивает количество доступных метрик ENF, по сравнению со вторым по популярности датчиком типа CCD (ПЗС).

В методике DeFakePro, использующей ENF‑метрики контента, каждый участник видеоконференции регистрируется в автоматизированном общем консенсусе с помощью децентрализованного механизма аутентификации, обычно используемого в популярных технологиях на основе блокчейна. При этом доступ к механизму консенсуса системы под названием PoENF (Proof‑of‑ENF) предоставляется только ограниченной группой участников.

DeFakePro против DeepFaceLive

Мы проверили работоспособность системы DeFakePro в тестовой среде для видеоконференций, где основную роль «создателя подделок» взяло на себя популярное ПО для потоковой передачи в реальном времени DeepFaceLive.

DeepFaceLive — версия популярного опенсорсного ПО для прямой трансляции DeepFaceLab, которая способна создавать альтернативные видеоидентификации в режиме реального времени. Подробнее о достоинствах DeepFaceLab, а также о других актуальных технологиях на основе искусственного интеллекта и машинного обучения мы уже ранее рассказывали в отдельном обзоре.

Аудио‑сопровождение фейковых участников было создано с помощью платформы Descript, способной использовать предварительно обученные голосовые модели для синтеза «на лету».

Тестовая среда была настроена на Python с модулями Raspberry Pi-4 (RPi), что позволило установить разумные ограничения на мощность системы, которая должна работать в live‑режиме с минимальными автономными вычислениями, а также на компьютере Dell OptiPlex-7010 (Intel Core i5 3470, 3.2 ГГц, 4 ГБ DDR3).

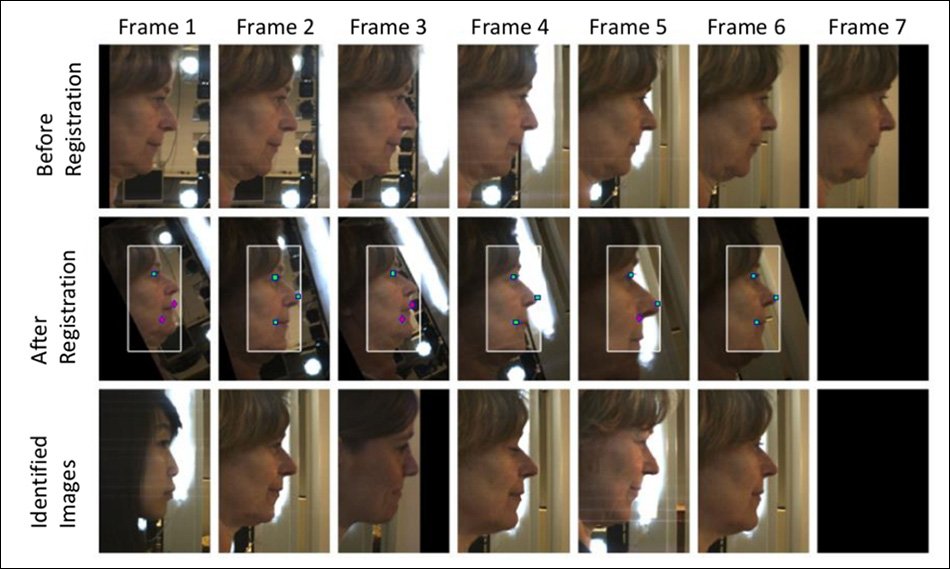

Основная сложность эксперимента — получить из потокового видео конференции с изменяющимся числом участников достаточно буферизованного материала, чтобы иметь возможность правильно оценить характеристики ENF.

На изображении выше мы видим, что задержка увеличивается по мере роста числа участников («валидаторов»), поскольку каждый из них должен зарегистрироваться и участвовать в механизме консенсуса. Когда число участников <10, система фактически работает в режиме реального времени.

Результаты тестирования

Оказалось, что даже при высоких нагрузках DeFakePro может идентифицировать поддельный контент в разумные сроки. В самом экстремальном варианте, когда Raspberry Pi должен справляться с 500 участниками (что маловероятно), система по‑прежнему обеспечивает эффективную идентификацию поддельного контента менее чем за минуту.

В ситуации критических ограничений по времени, такой как видеоконференция, важно быстро оценить вероятность замены реального изображения дипфейком. А, поскольку переменные относительно ограничены, исследователи использовали площадь под кривой (AUC), которая обеспечивает эффективное обнаружение.

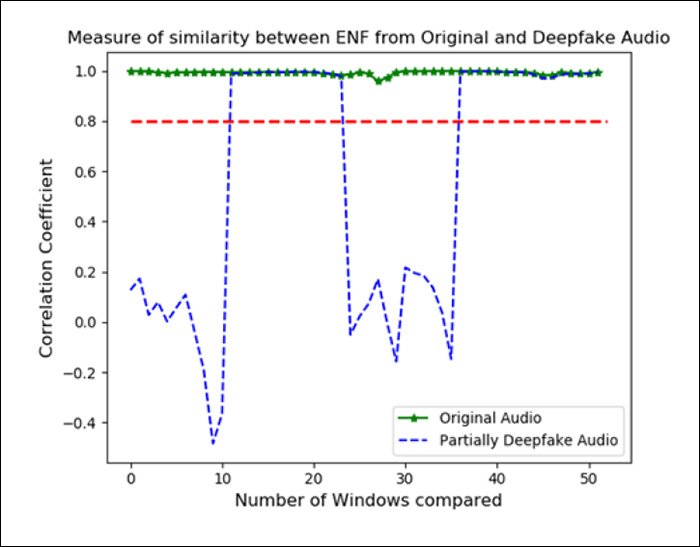

В ходе испытаний DeFakePro смог четко отличить настоящий звук от дипфейкового звука Descript в ряде возможных операционных сред:

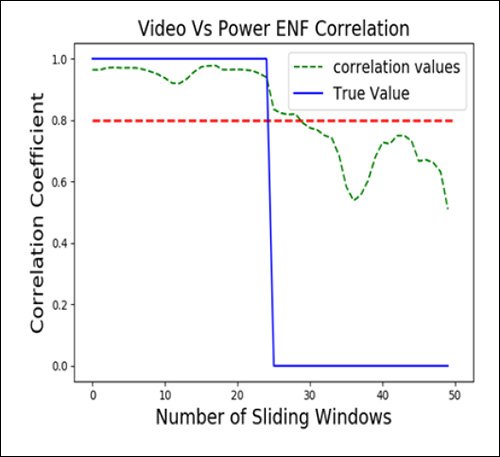

Аналогичный результат был получен для вывода DeepFaceLive, представленного в тестах:

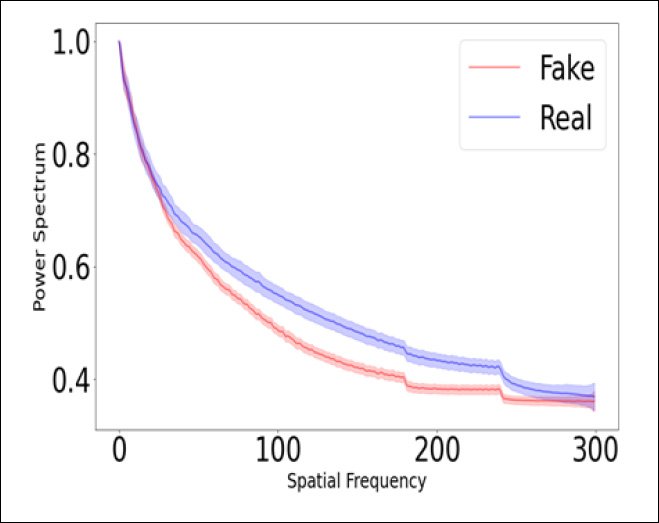

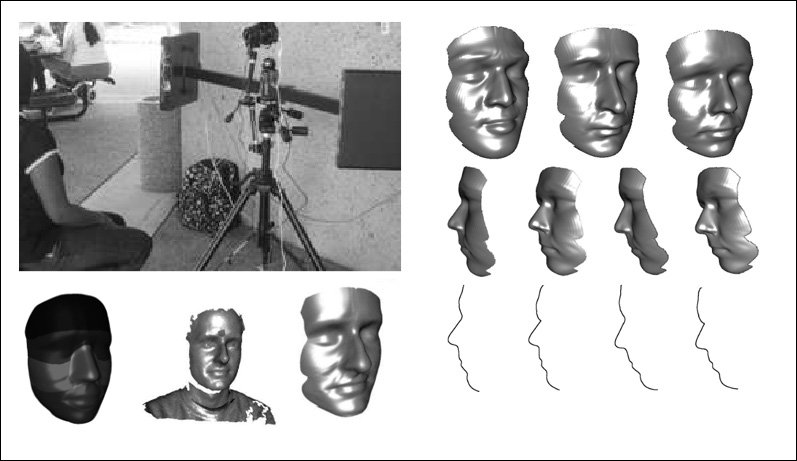

Автоэнкодерные дипфейковые модели не просто «закрашивают» лицо реального участника с наложенной идентичностью, но также должны модифицировать фон — например, в тех случаях, когда профиль или внешние очертания фальшивой «личности» менее выпуклы, чем лицо оригинального человека.

Подобное «закрашивание» означает, что алгоритм должен воссоздать любые участки фона, которые соответствуют наложенной «личности». Поэтому в фоновом материале потока дипфейкового контента также могут быть обнаружены дополнительные спектральные несоответствия.

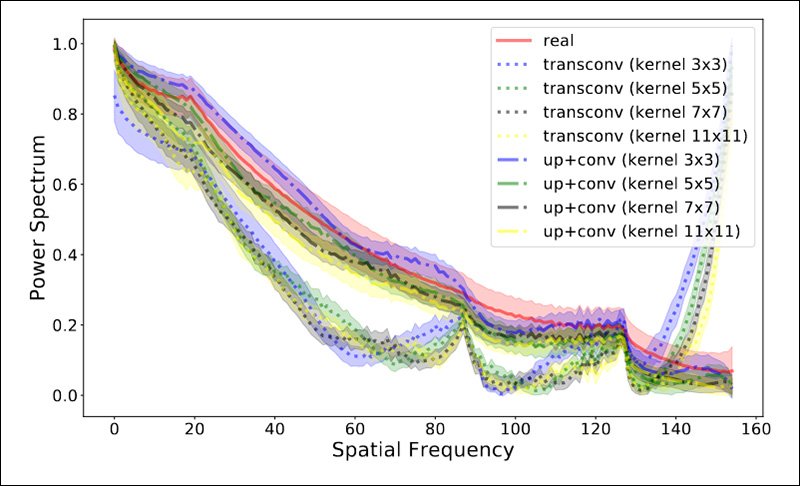

Несоответствия пространственной частоты, которые DeFakePro способен выявить, являются прямым результатом практических ограничений дипфейков с точки зрения их способности производить выходные данные с высоким разрешением. Во время реальной видеосвязи с разрешением до 4K это, вероятно, будет означать, что дипфейковое изображение лица будет занимать минимум 50% площади экрана.

Это намного превышает то, что такие системы автоматического кодирования, как DeepFaceLive, могут эффективно обрабатывать на современном техническом уровне. Сегодня у «производителей» дипфейков есть четкие пределы повышения дискретизации, что гарантирует спектральное несоответствие между оригинальным и поддельным видеоконтентом.

В настоящее время DeepFaceLive и подобные флагманские технологии создания дипфейков работают на пределе технологических возможностей. Успешность «обмана» сторонних наблюдателей при создании live‑видео еще сильно зависит от контекста — элемента неожиданности и относительно низкой осведомленности о возможности реального дипфейк‑контента.

По самым скромным оценкам, real‑time дипфейки с высоким разрешением, устойчивые и правильно передающие черты целевой «личности», появятся через несколько лет. Однако сигналы ENF настолько чувствительны к любым искажениям электрических сигналов, что этот метод разоблачения может успешно пережить даже заметное изменение эффективности дипфейков.

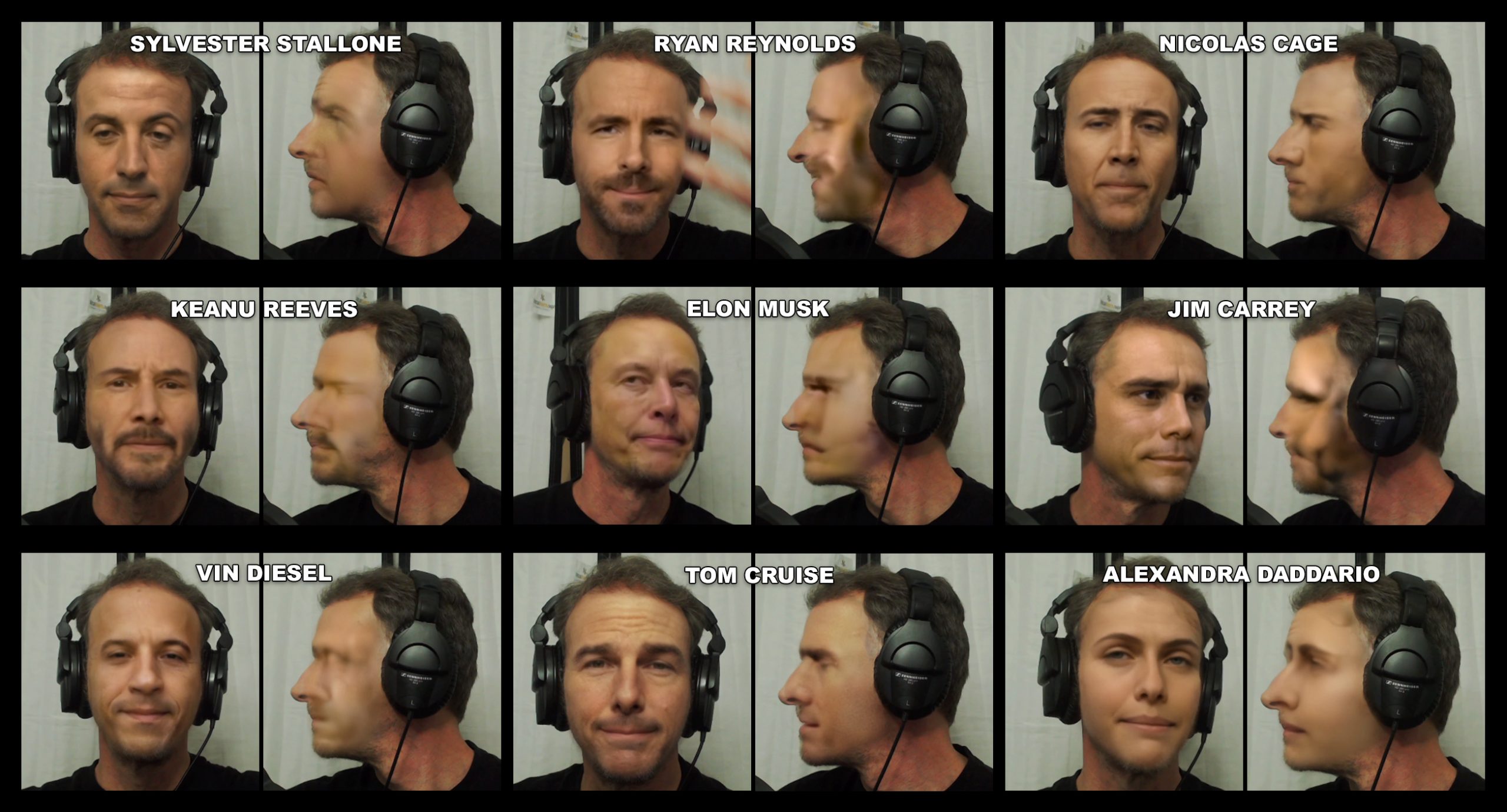

А можно проще? Конечно — попросите звонящего повернуться в профиль

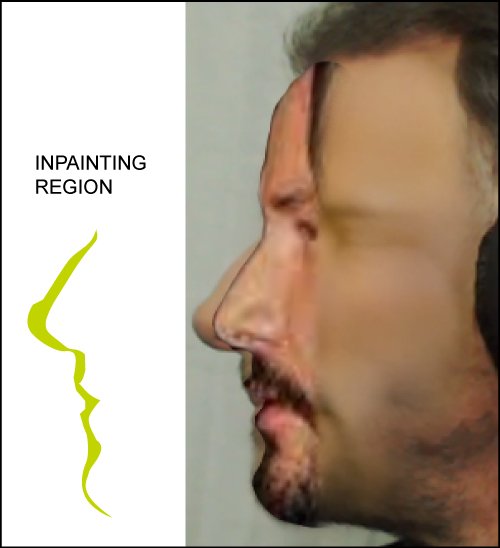

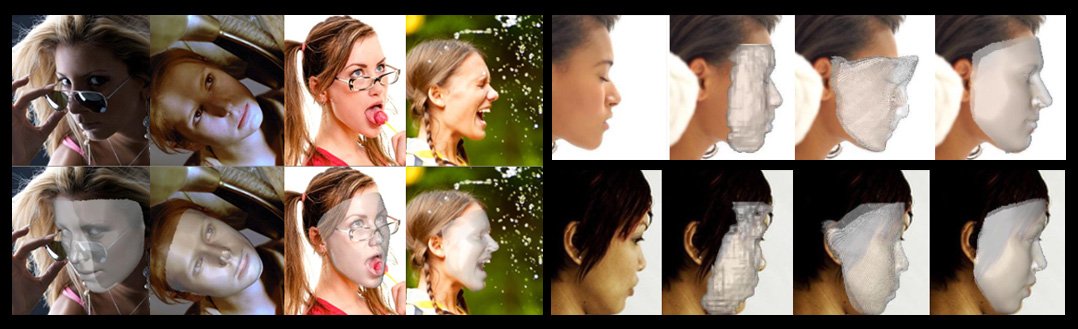

Хотя рассмотренный выше метод, основанный на анализе сигналов ENF, показал высокую эффективность, существует и более простой способ распознать в собеседнике видео‑дипфейк. Он основан на одной простой уязвимости данной технологии — дипфейки обычно не очень хорошо воссоздают в реальном времени профили лиц при повороте головы на 90°.

Если во время видеозвонка «лицо», созданное дипфейк‑генератором, будет смотреть прямо на зрителя, в большинстве случаев наложенное изображение будет выглядеть весьма реалистично. Звонящий даже может поворачивать голову, но лишь до тех пор, пока угол поворота лица не достигает полных 90°.

Почему же стандартное программное обеспечение (Facial Alignment Network), которое отвечает за оценку лиц на дипфейк‑изображениях, работает ненадежно под острыми углами? И могут ли создатели дипфейков исправить это?

Причины «боковых» ограничений в дипфейках

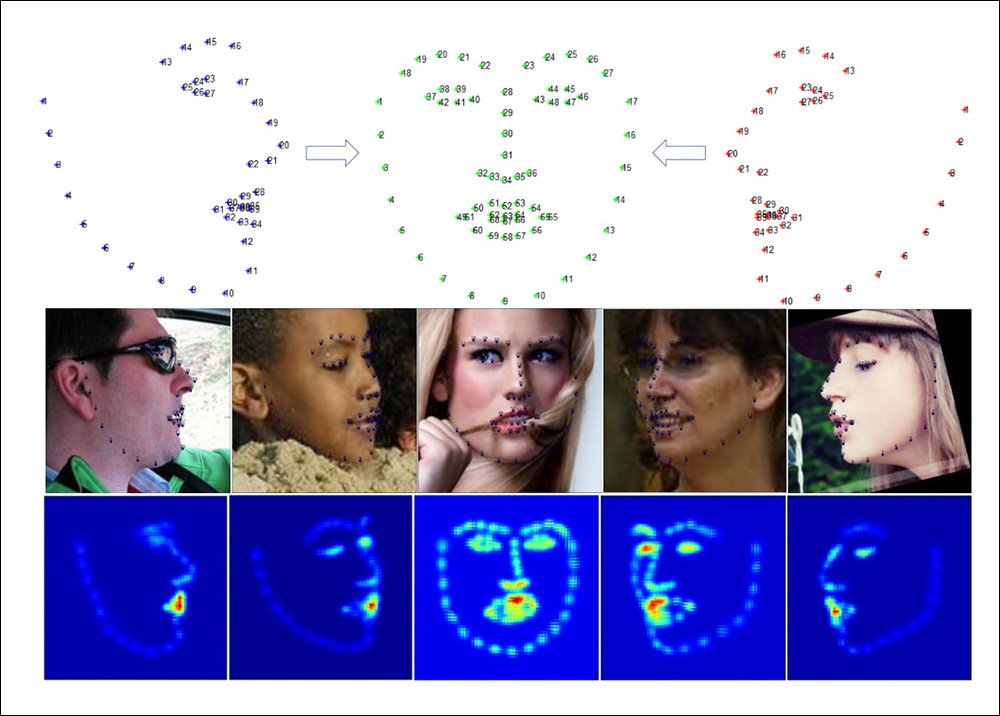

Дело в том, что большинство алгоритмов выравнивания лиц на основе 2D используют для вида «в профиль» только 50–60% от общего числа ориентиров, применяемых при отображении лица в «анфас». Это затрудняет распознавание, точное обучение и последующий синтез лица.

Поэтому, несмотря на возможность ручных правок и очистки изображения, кадры с лицами в профиль дадут обучающейся дипфейк‑модели гораздо меньше фактических данных, что плохо отразится и на качестве последующей «реконструкции».

«Профильная» пустыня за пределами Голливуда

Понимая эту технологическую слабость дипфейков, большинство создателей вирусных дипфейк‑роликов стараются избегать использования кадров, требующих хорошо подготовленного, точного и согласованного по времени отображения персон в профиль.

Сегодня подобного точного соответствия можно ожидать лишь при профилировании известных голливудских теле‑ и киноактеров, данные о внешности которых легкодоступны в миллионах отснятых кадров. Например, для того, чтобы добавить в киносагу о Бетмене Мэтта Деймона, создателю дипфейка Batdamon потребовалось изучить фильмографию актера общей продолжительностью 144 часа. При этом большая часть видеоматериалов была доступна в высоком разрешении.

А теперь задумаемся — сколько четких фотографий в профиль у вас есть?

Если речь не идет о знаменитостях, постоянно мелькающих на телеэкране, или о профессиональных моделях, дело, скорее всего, ограничится несколькими изображениями в социальных сетях и в личных архивах. Такие снимки можно найти в основном в рабочих материалах медиков, VFX‑художников, судмедэкспертов и полицейских, но не в общем доступе.

Критическая слабость «живых» дипфейков

Неужели для того, чтобы определить, не является ли ваш собеседник live‑дипфейком, достаточно просто попросить его повернуть лицо на пару секунд в профиль?

Джорджио Патрини (Giorgio Patrini), генеральный директор компании Sensity, создавшей один из самых популярных дипфейк‑инструментов — нейросеть DeepFaceLive, подтверждает это предположение:

«Виды лиц сбоку, используемые в качестве формы проверки личности, могут обеспечить некоторую дополнительную защиту от дипфейков. Большинство современных программ для создания дипфейков просто не работают, если их применять для замены или воспроизведения лиц, полностью повернутых в профиль. Это связано с тем, что программное обеспечение для дипфейков должно точно определять лица и их ориентиры на целевом видео, а вид в профиль усложняет задачу, так как детектор должен работать только с половиной ключевых точек лица.

Действительно, сегодня это один из лучших советов по обнаружению дипфейков «на глаз»».

С мнением Джорджио согласен еще один эксперт по дипфейкам — профессор компьютерных наук и инженерии в Университете штата Нью‑Йорк в Буффало Сивэй Лю (Siwei Lyu):

«Изображение в профиль — большая проблема для современных технологий дипфейка. Нейросеть FAN (Face Alignment Network) очень хорошо работает для фронтальных граней лица, но не очень хорошо справляется с боковыми.

На это влияет не только отсутствие общедоступных данных, но и такое фундаментальное ограничение алгоритмов, как ухудшение работы механизма выравнивания при отсутствии части ориентиров на ключевые точки лица. В таком случае оценка вида в профиль становится своего рода «догадкой», даже при наличии информации о глубине изображения, которую могут предоставить датчики в некоторых моделях современных смартфонов».

Системы распознавания по лицу в профиль

В 2017 году исследователи из Нидерландов разработали систему безопасности на основе лица, которая при распознавании считывает ключевые точки лица с профиля. Технология учитывает обструкцию ушей и другие проблемы, делающие сбор данных с лица в профиль столь трудным.

Хотя этот случай не имеет прямого отношения к потенциальным изготовителям дипфейков, он демонстрирует яркий пример курируемой базы данных, которая потенциально может решить проблему ограниченного числа ориентиров, доступных при съемке лица сбоку.

В конце 2010-х Хьюстонский университет также разрабатывал собственную систему распознавания лиц на основе профиля. Принцип ее действия был основан на 3D‑модели лица пользователя, создаваемой при регистрации. В дальнейшем 3D‑модель использовалась в качестве эталона для сравнения и поиска субъектов по профилям лиц, фиксируемым сбоку во время вождения.

Новое поколение моделей выравнивания, таких как 3DDFA, использует параметрические шаблоны CGI, для более точной оценки изображений лиц, включая вид в профиль. Однако пока эти сложные модели не применяются в ПО для дипфейков.

Матирование Matter

Есть и другие способы определить наличие потенциального дипфейка во время видеозвонка. Причем этот способ проверки подлинности не требует сложной обработки данных и (на данный момент) не может быть в ближайшее время так же технологически решен, как проверка по лицу в профиль.

Все дипфейк‑видео в реальном времени имеют общую проблему с дополненной реальностью — необходимость наложения оригинальных деталей (например, рук, пальцев и других видов объектов, появляющихся перед лицом) на нереальное изображение. В мире визуальных эффектов эти наложения известны как «матирование» (mattes), ротоскопирование (фотоперекладка) или «удаление фона» (background removal).

В отрендеренных дипфейк‑видео (например, вирусных роликах с YouTube и TikTok) их создатели имеют возможность тщательно ротоскопировать вручную любые объекты перед лицом, которые оказались слишком сложными для автоматизированного матирования с помощью XSeg (DeepFaceLab/Machine Video Editor) или обученных весов BiseNet (FaceSwap).

Когда речь идет о live‑дипфейке, то для сохранения правдоподобности картинки модель должна быть обучена автоматически обрабатывать подобные объекты на приемлемом уровне. Но какой бы полный набор данных не использовался для обучения, полностью подготовить генеративный механизм дипфейка к обработке внезапно появляющихся объектов и затемнений перед лицом практически невозможно.

Достаточно попросить собеседника помахать руками перед лицом в процессе видеозвонка, чтобы такие огрехи дипфейка, как плохая задержка и низкое качество наложения, моментально вылезли наружу. Потенциально эти технологические недостатки могут быть «пропатчены» создателями дипфек‑инструментов, но на сегодня они могут так же хорошо служить для быстрой идентификации видео‑фальшивок, как и боковые ракурсы лиц.

Заключение

Исследовательское сообщество активно занимается разработкой технологий обнаружения «фальшивых» видео с момента возникновения этого явления. Ежегодно появляется все больше решений, которые можно применять в качестве мер анти‑дипфейк безопасности при видеозвонках, включая:

измерение уровня освещенности монитора;

оценку несоответствий в различных областях лица;

распознавание паттернов известных моделей дипфейков;

каталогизацию и обнаружение последовательных дипфейк‑артефактов в видео;

использование детекторов на основе анализа высокоуровневых аудиовизуальных биометрических характеристик.

Во время общения по видео в реальном времени есть также несколько относительно надежных способов обнаружения дипфейков, например, просьба к собеседнику повернуть лицо на 90° или помахать руками перед головой. Однако стоит помнить, что основная угроза дипфек‑видео — в эффекте неожиданности, поэтому главной защитой от нее становится наша осведомленность и способность критически оценивать ситуацию.

Комментарии (3)

familiarny

00.00.0000 00:00+2Пока загружалась страница, я уже понял как отличить настоящего Том Круза от мошенника - спросить у него, нужны ли ему данные моей карты (причём на русском). Да - мошенник. Нет - привет, Том!

Tarson

Мэтта Деймона ....

Если честно, зрелище жуткое, полный эффект "зловещей долины"... Вроде Мэтт, но не он, а монстр в его обличье...

b0sun

Это потому, что мимика и артикуляция Деймона хорошо знакомы по крупным планам множества фильмов. Если отбросить редкие артефакты дипфейка и проблемы типа оригинальной линии скул при съёмке сзади - качество хорошее. Но изменения лица человека, движение бровей, губ и прочего - остаются от оригинала, и они сильно отличны от мимики человека, чья маска натянута. И вот это как раз и порождает тот самый дискомфорт - человек на видео (не на статичном кадре!) вроде тот, да не тот.

Так что незнакомое лицо на дипфейках воспринималось бы гораздо комфортнее. Хотя практическая польза в этом - разве что, сокрытие оригинала,