Пока только в мечтах

Один из основателей проекта Oculus, Палмер Лаки, заявил, что проект будет поддерживать Mac, только «если Apple создаст нормальный компьютер». Это высказывание можно сравнить со звонкой пощечиной всем, кто ратовал за поддержку работы нового VR-шлема на яблочной продукции.

Стоит отметить, что слова Палмера не лишены смысла: все VR-технологии весьма прожорливы как в плане оперативной и видеопамяти (в особенности видео), так и в плане нагрузки на центральный процессор. Сейчас, для стабильной работы VR-шлема Oculus или шлема Vive от тандема Valve и HTC, необходима конфигурация, которую смело можно назвать «топовой». Продукция же Apple вычислительными мощностями геймерских машин никогда не блистала, а выходила вперед исключительно за счет оптимизации ПО, маркетинга и пиара.

«Проблема в том, что для Apple производительность GPU никогда не была приоритетом. Вы можете купить Mac Pro за шесть тысяч долларов, но в нем будет стоять AMD FirePro D700, который не подходит под рекомендованные требования», приводит слова Палмера The Verge.

Продукция Apple сильно ориентированна на профессиональную сферу и работу с ПО, в то время как производительность «маков» в играх оставляет желать лучшего. Технологии VR же, в первую очередь, ориентированны на геймерскую аудиторию и шлемы создавались с учетом того, что у конечного потребителя будет мощная «игровая» конфигурация оборудования последнего или предпоследнего поколения. И это касается не только Oculus, но и всех VR-проектов: рекомендуемый перечень видеокарт для работы VR-шлемов начинается, примерно, с Nvidia GeForce 970, а от этой карты до топового и премиального геймерских сегментов «рукой подать».

С другой стороны Пламер говорит о том, что и оптимизация Oculus на уровне ПО также невозможна. Даже если он и его команда начнут работу по «допиливанию» софта своего шлема под Mac, со стороны Apple поддержки они не получат.

Shtucer

«а выходила вперед исключительно за счет оптимизации ПО, маркетинга и пиара»

Плохая какая Эппл… ПО она оптимизирует, и вперёд за счёт этого выходит, вы только посмотрите на неё!

Rampages

В последнее время у Apple оптимизацией и не пахнет… с новыми релизами Xcode всё больше глючит, также как новая iOS… ?(????)

Shtucer

При чём здесь iOS? Речь идёт о компьютерах Apple. В любом случае, пункт об оптимизации ПО звучит крайне странно в качестве претензии. Разве нет? Или это действительно уже считается дурным тоном, наряду с "маркетингом и пиаром"?

ragequit

Претензия? Что?

Shtucer

Ну а зачем ещё было упоминать оптимизацию ПО в статье со столь претенциозным заголовком?

Khayrullin

"Оптимизация" в одном ряду с маркетингом и пиаром, действительно читается, как нечто негативное. Вроде — "Пока мы тут говнокодим, для того, что бы подтолкнуть развитие видеокарт, проклятая Эппл занимается оптимизацией! Они против прогресса!".

ragequit

Ну, видите скорее, что хотите видеть. Оптимизация как таковая — это прекрасно. Но Apple занимается ею, чтобы использовать не самое мощное железо, а не потому что они такие крутые. Т.е. делается это ради экономии, а продукция пропихивается дальше маркетологами, а не цифрами ТТХ оборудования. Вот такая политика партии, ничего более.

Firz

Я бы добавил что оптимизация ПО для них это критически важный аспект, потому что 90%(если не больше) продукции Apple в обычном режиме рассчитано на работу от аккумулятора. (Думаю, доля Mac Pro, Mac Mini и iMac как раз на уровне 10% от всей их продукции, включая телефоны, планшеты).

Shtucer

Ндэ… а я помню ещё те времена, когда покупка "цифр ТТХ оборудования" считалось победой чёрных маркетологов...

Nepherhotep

Любая оптимизация делается для этого, и поэтому они крутые. Мне, как программисту, оптимизация импонирует больше, чем рост производительности. Сплошь и рядом мы видим просто бессмысленное растрачивание ресурсов на всякую чепуху, и вместо того, чтобы сделать вменяемую архитектуру, просто увеличивают производительность.

Есть клинические примеры, когда jquery или zepto пакуют в титаниум, и потом в мобильном приложение ненужная анимация отрисовывается яваскриптом. Но есть и другие примеры — графическая система Андроида, где отрисовка UI делается без приоритета над остальными потоками, и как следствие — даже на нынешних смартфонах с дикими характеристиками, заикания интерфейса по-прежнему проскакивают.

Или же мобильные игры, написанные на движках без поддержки вертикальной синхронизации, превращают телефон в утюг и при этом дико тормозя.

Есть, правда, другие аспекты, из-за которых я никогда не куплю себе айфон, а мой макбук никогда не станет основной платформой разработки, но оптимизация и используемое ими железо — точно не в списке этих причин.

6opoDuJIo

Акцент на оптимизации ПО сделан, вероятно, потому-что от оптимизации эппловского ПО окулусу ни холодно, ни жарко — маловероятно что код драйверов вносит значимый оверхед, а вот тощая видяха может стать тем самым бутылочным горлышком.

Lain_13

Не может, а становится им. У VR очков есть жесткое требование на то, чтоб карточка рисовала картинку 3840x1080 (2x1920) не менее чем 90 раз в секунду. Будет меньше — нормального VR не будет. Без хорошего железа это условие просто недостижимо.

Faer

Да если бы было так! Они же по факту «заставляют» оптимизировать приложения самих разработчиков. Это отлично видно, когда делаешь мультиплатформенное приложение, а оптимизируешь именно под Apple, т.к. именно там падает fps. И если разницу в производительности самого процессора можно списать на «мультиплатформенность», то вот нехватку памяти на модели и текстуры уже не получится.

dzzh

Хотелось бы посмотреть, как именно мерзкие маркетологи Эппл пиарят свои "геймерские машины".

4dmonster

Возможно, имелась в виду оптимизация бенчмарков. Ещё в древние времена Apple могла в своём тесте в тихую вместо Double использовать Single.

Kain_Haart

Про "плохая" и "посмотрите на нее" — это исключительно ваши домыслы.

Просто производителям Oculus нужно не оптимизированное по apple, а производительная графика, которой там нет.

BelBES

И тут вообще говоря возникает вопрос к создателям окулусов: чего они такого напихали в свой шлем, что ему нужно топовое GPU, или может там просто программисты криворукие и код понаписали по принципу "и так сойдет". Или может быть где-то прсчитались при проектировании и могли бы часть вычислений переложить на какие-нибудь ASIC'и запихнуть прямо в шлем, как например в свое время поступили ребята из PrimeSense, запихнув самые прожорливые вычисления внутрь Kinect'а и загружая ПК не больше, чем веб-камера.

Ну и не совсем понятно, что означают заявленные системные требования окулусов… если 970 карта нужна только для того, чтобы картинка на очки рендерилась, то надо полагать, что под прожорливую игру надо будет уже вкорячивать второе GPU устройство в ПК.

dydyman

Могу ошибаться, но разве не придется в 3D приложениях рендерить сцену дважды за кадр (для каждого глаза под своим углом)? Из-за этого и повышенные требования. Чтобы обеспечить картинку в 60fps, система должна выдавать 120, пусть и для вдвое меньшего разрешения.

BelBES

Я не то имел в виду… я говорю о том, что:

1) Пока не известно то, сколько свободных ресурсов оставляет Oculus для всего остального. Грубо говоря, если заявленный требования нужны только для того, чтобы видяху рендерить, то для игр класса ААА у топового ПК тупо не останется ресурсов и они либо не будут запускаться, либо будут тормозить. И мне, как пользователю, пофиг сколько там FPS нужно окулусам… я потратил кучу денег на крутой комп, потом еще кучу денег на очки и хочу с комфортом играть, а не "понять и простить" криворукость программистов окулуса, которые сделали ставку на железо и не стали заморачиваться с оптимизацией своего гаджета.

2) Для специфических задач можно было бы часть рендеринга реализовать в железе в виде DSP/ASIC/etc. что могло бы значительно облегчить нагрузку на ПК.

OnYourLips

> чего они такого напихали в свой шлем, что ему нужно топовое GPU

Для обычных игр нужно не более 60FPS. Для игр в VR нужно 2 раза по 120FPS.

Видеокарта должна выдавать в 4 раза больше FPS.

Areso

Почему два раза по 120? 1 раз по 60 для одного глаза, 2 раз по 60 для другого… Можно еще черезстрочку сделать для экономии ресурсов, но это нынче не модно, да и активная область по высоте уменьшается вдвое.

OnYourLips

Нельзя по 60 FPS в каждый глаз — будет заметно торможение.

Именно по 90-120 в каждый нужно.

Volutar

Хорошему танцору как говорится.

В PlayStationVR специальная коробочка занимается перепроекцией и увеличения фреймрейта до 120Гц (hardware async warp + framerate multiplication), а Окулус не осилили подобного подхода. Возложили всё на ПК. Остались на уровне шлема-монитора. Гоняют видео и сигналы по двум USB3, вместо того чтобы всю эту кухню делать в устройстве. Понятно дело, что очень ограниченные конфигурации такое потянут.

Xenotester

Только вот создание промежуточных кадров ведёт к артефактам и увеличению лага — и поэтому окулус решили идти путём честного рендеринга, а вот сони деваться некуда — в PS4 новое железо не запихнёшь

Volutar

Я не думаю что создание промежуточных кадров вообще не отключается (по-идее должно).

Просто есть дилемма — либо 1) небольшие лаги и небольшие артефакты, но с потенциально любым железом, либо 2) небольшие лаги (будем считать, что интерактивность ощущается главным образом по моменту доварпа), отсутствие артефактов, и с очень дорогим железом с особо заточенной под это драйверами.

Лаки решил пойти по второму пути. Лично я не думаю, что его апломб в отношении Маков будет в результате оправдан. Технически ничто не мешает делать доварп в самом устройстве, для этого нужен довольно простой 3D чип, и потянет даже самый недорогой на adreno, не говоря уж про tegra, который стоит долларов 20. И вопрос с совместимостью и требовательностью к ПК был бы убран с повестки вообще. Очевидно что популярность и аудитория охвата была бы в разы больше.

SpaceEngineer

Этот самый "доварп" при недостатке fps — не более чем хак. Плавности он вроде бы добавляет, но изображение выглядит двоящимся. Всё-такие движок должен уметь выдавать честные 90 fps при разрешении 2160 x 1200 (реально надо раз в 1.2-1.3 больше из-за нелинейного искажения перед выводом на шлем). Много вы видели таких движков? Нет, конечно демка вроде комнаты с разноцветными мячиками выдаст 200 fps и на Intel HD, но всех ведь интересует нормальная графика.

Volutar

А скажите — действительно ли нужны эти честные 90fps? На глаз 75 от 90 уже не отличишь. И 60 — уже достаточно. Вся игровая индустрия ориентируется на 60fps (ТВ/монитор). Эти пресловутые 90-120fps если и нужны, то только из-за минимального лага. А лаг явно не сократится, если доварп делать в ПК. Доварп и нелинейное искажение (с учётом формы/модели/параметров линз) должны производиться в самом шлеме. И в идеале это должно выполняться параллельно, без прерывания rendering pipeline и создания пауз. Чтобы можно было швырять картинку в шлем с максимально возможной скоростью, сопровождая векторной информацией (чтобы сделать возможным прогнозирование поворотов — пространственная инфа из шлема в ПК не обязательно должна использоваться 1 в 1). Не будет необходимости в сложных многопоточных API типа DX12/Vulcan — даже слабое железо потянет. Не нужно движку знать о том какие сейчас линзы вставлены, какое фокусное расстояние (чтобы регулировать подушкообразность).

Кроме того, fps можно делать не фиксированным, и презентацию делать с минимальной задержкой после получения нового кадра, чтобы доварп был "косметическим", и даже почти не нужным. Если движок и видюха смогут обеспечивать честные 90fps — отлично. А не смогут — это не будет трагедией. Ну а в Окулусе это пока трагедия. Ну, может через итерацию додумаются, у Фейсбука денег много.

TheSpyMonkey

90fps действительно нужны. Да и серьезные геймеры с дисплеем 120гц не согласятся, что разницу между 60fps и выше невозможно различить. В VR все воспринимается иначе, чем на обычном дисплее с 60fps. Задержка и лаг ощущаются намного сильнее, начинает укачивать и вообще ощущения не из приятных при быстром движении. Не зря и Sony для своего PSVR поставили планку либо в 60fps с принудительной дорисовкой до 120, либо твердые 90. HTC Vive требует те же честные 90fps. Дорисовка кадров не более, чем костыль, призванный на помощь слабой PS4.

К тому же, думаю Oculus потянут карточки и слабее 970-ой. В принципе, любая карта, способная выдавать изображение 90 fps при разрешении 2160 x 1200 потянет Oculus. Вопрос только в том, что она сможет запустить на этом разрешении. Всякие 360-градусные видео и игры на средних настройках вполне потянет и какая-нибудь gtx 950 — 960.

Volutar

Да нет же, не нужны 90fps. Нужен минимальный лаг. Почему-то считается, что чем больше fps, тем меньше лаг, но это заблуждение. ПК может выдавать плавные 120fps бурстом с задержкой в 50мс (рисование, vsync, hdmi), и это будет из рук вон плохо для гейминга (будет так называемый render ahead lag). Геймерам нужна реакция, а не fps. В идеале, для геймеров необходимо чтобы вместе "кликом" сразу начался рендеринг кадра, и сразу же вывод на экран. Без ожидания очередного V-sync'а. Именно поэтому для геймеров freesync/g-sync предпочтительнее и важнее чем большой fps. Именно поэтому чем больше детализация кадра, тем дольше он будет пересылаться в шлем (это помимо скорости рендеринга).

Ключевое слово — отзывчивость. Именно из-за плохой отзывчивости при резких движениях возникает ощущение укачивания (точнее, создаётся ощущение "пьяности" — т.к. эффект воздействия на восприятие аналогичный). И хардварный доварп (вместе с хардварными линзовыми и хромическими предкомпенсациями) очень сильно этому поможет. А технология вроде freesync/gsync (только для шлема) сможет ещё больше минимизировать эти задержки.

Насчёт дорисовки кадров. Штука в том, что дорисовка кадров ещё больше увеличивает "игровой лаг", т.к. для просчёта промежуточных нужно, чтобы следующий уже был сделан (т.е., при приставочном рендере в 30fps, это дополнительные ~50мс). При доварпе это будет не так заметно в плане "тошнотиков", но реакция на действие будет с задержкой. Возможно, в Sony провели тесты того и другого варианта, и поняли, что с учётом наличия хардварного доварпа плавность оказалась важнее больших "игровых" лагов.

TheSpyMonkey

Все же самая крутая комбинация — 90fps и низкая задержка. Все разработчики стремятся к этому. Разве нет? При быстрых поворотах, чем больше кадров с минимальной задержкой тебе покажут, тем изображение будет плавнее. Трекинг движения тоже синхронизируется с изображением так или иначе. То есть, при 60fps видишь изменение своего положения в пространстве всего 60 раз. Для вестибулярного аппарата это маловато и это сильно чувствуется, хотя и не осознанно. Получается некая дискретность восприятия — ты можешь чувствовать гораздо больше изменений положения головы в секунду, а тебе выдают только 60.

Наверное такая частота отрисовки связана еще и с частотой обновления дисплеев, установленных в Oculus и Vive. Например, на моем Gear VR при быстрых поворотах видны небольшие темные шлейфы от предметов в кадре. 90fps и 90 Гц обновлением дисплея там и не пахнет конечно же. Что интересно, при обычном использовании Galaxy s6 такого эффекта на экране не наблюдается.

Volutar

Зачем выдумывать про не осознанное ощущение вестибулярным аппаратом? Он тут вообще не причём. Все "тошнотики" — сугубо от моторно-визуального лага. Лаг великолепно можно убрать за счёт хардварного процессинга этой проекционной и доварпной рутины, и за счёт свободной синхронизации кадра.

"Молчащий" вестибулярный аппарат тут просто диссонанс вносит в сенсорную систему, но не создаёт эффекта тошноты.

В Окулусе всё возложено на GPU компа, который в итоге должен регулярно прерываться и делать всю эту рутину, расходуя драгоценное время, которое мог бы потратить на полезный рендеринг.

Шлем:

Даже если рендеринг будет с безумно огромным FPS, перед глазами кадр возникнет только после того как ПК получит от шлема обновлённые параметры, доварпает копию старого кадра, сделает все манипуляции, перешлёт этот кадр по HDMI, и подождёт vsync. То есть "доварпнутый" кадр в любом случае будет отображаться с лагом, размером в HDMI transfer latency + Vsync wait, что составляет оценочно ~10-15ms.

В случае хардварного процессинга:

Со стороны шлема:

2a. Если тайминг нормальный то: берутся текущие параметры шлема, и производится доварп и предкомпенсации в соответствии с физическими характеристиками линз.

2b. Если кадр не пришел вовремя — берётся предыдущий буфер, и далее 2a.

2c. Если скорость слишком большая (выше способности матрицы выводить), то кадр просто запоминается в буфере и 3й шаг пропускается.

Xenotester

Нет, нужны — важен не только минимальный лаг, но и плавное изображение — "скачки и рывки" картинки вызовают тошноту не меньше, чем задержка

Volutar

Ошибаетесь. Небольшие внутриигровые (физические) рывки, при сохранении плавности и минимального лага при шевелении головой, тошноту не вызывают. Они некомфортны и снижают эффект реалистичности, но не более того. И у PlaystationVR такого нет, т.к. используется framerate multiplication, несмотря на 30fps в графическом движке.

Xenotester

Это в каких проектах для PS VR используется 30 фпс +fm? Говорили же о 60 и framerate multiplication до 120, неужели не вытянули ?!

Volutar

Да, вы правы. Я, видимо, вспомнил про нечто из ранних "заметок" (что 60 / 90 / 120 как 30x2 / 30x3 / 30x4, и четверное уплавление тестировалось). И ещё, оказывается, что framerate multiplication, вероятно, подразумевает не рендеринг промежуточных кадров по типу ТВ "уплавнителя", а просто перепроекцию с бoльшей частотой. Sony рассчитывает на нативные 90/120Гц, но в худшем случае будет делать 60x2, и сообщает, что визуально от нативных 120 отличить почти невозможно. Я на себе знаю, что плавности картинки в 60fps более чем достаточно для сильного ощущения присутствия. Вся основная гонка происходит за уменьшение лага (они хвастаются <18ms, но это не похоже на тайминги при хардварном доварпе). Короче — надо дождаться и посмотреть технический обзор.

Xenotester

При рендеринге промежуточных кадров меня беспокоят двойные контуры и прочие артефакты — я их и на тв иногда замечаю и совсем не хочу видеть что-то подобное в VR шлеме

А вообще немного спешат они с VR шлемами (особенно при таких ценах)

trilodi

Боже, что вы делаете с телевизором что наблюдаете такие артефакты?

Xenotester

Смотрю. Смотрю с включённым режимом создания промежуточных кадров — увы, алгоритмы неидеальны, но это куда лучше чем смотреть при 30фпс.

Почему остальные не замечают? Нужно знать куда смотреть. Более того, многие не используют режимы увеличения fps, а большинство людей смотрят видео на жк панелях без строба подсветки — там в динамике изображение размывается, там основные контуры разглядеть не просто, не то что фантомные

trilodi

Ну я так не заморачиваюсь. Обычно когда уже сожусь посмотреть телевизор то что бы разгрузить мозг, а не вглядываться в контуры. Изображение четкое, и все мне например этого хватает. Вы не поверите, я даже не знал про режимы увеличения fps на телевизорах, более того я даже не мог допустить мысли что они нужны на телевизоре.

trilodi

Прогресс по определению должен приносить в нашу жизнь радость и облегчение, но нет же, мы и из простых вещей умудряемся выделить для СЕБЯ проблему. Зачем? Почему мы разучились наслаждаться прогрессом?

Xenotester

Прогресс в этом отношении ещё не достаточен — алгоритмы не могут сотворить чудо, а контента изначально снятого в 60 фпс мало

Прогресс "должен приносить в нашу жизнь радость и облегчение" и решать проблемы — но проблема есть (и есть она не только для меня, она действительно существует) — и назвать её решённой нельзя.

Разве? Нет противоречия в том что бы наслаждаться прогрессом и сокрушаться тем, что в некоторых областях он недалеко ушёл или просто заторможен.

SpaceEngineer

Доварп в окулусе не требует следующего кадра. Он испольщует последний выданный движком кадр, и так искажает его по данным с сенсоров положения и ориентации, чтобы создать иллюзию движения. Точнее наоборот, кажется что изображение неподвижно, хотя был отрисован всего один кадр. Этот доварп быстрый и выдаёт честные 90 fps. Он конечно фейковый (это же не полноценный рендер нового кадра), но здорово увеличивает плавность, если движок не успевает рендерить. В Oculus SDK 08 это просто пост-эффект над выданным движком кадром, но они вроде планируют использовать ещё и z-буффер, чтобы искажение было перспективно-корректным. Если есть окулус, можно в их демке посмотреть, как это работает (там есть опция freeze renderer или типа того).

Xenotester

Нет — он не был бы убран.

DK1-2 вполне работает и с Intel HD, только вот пользовательский опыт совершенно другой: в лучшем случае низкое качество графики, а в худшем головные боли. Хотите качества — покупайте хорошее железо, ничего тут не поделать.

Популярность и аудитория охвата в разы больше? Представьте количество недовольных с проблемами из-за железа — а подобные требования сразу отводят от разработчиков все претензии с качеством и производительностью

netslavehq

Sony признала технологическую отсталость PlayStation VR от Oculus Rift

netslavehq

_

Magistrico

Для начала еще было бы неплохо все таки начать выпускать свою продукцию а не продаватся и кормить бэкеров обещаниями и жаловатся на чужое железо

PupkinVasia

Так они и выпускают. Называют это Developer Kit и продают дороже чем заявленная цена на «обычный» Consumer Kit потому что кому не терпится — купят. А так и затрат на производство меньше, меньше продаж, а деньги те же.

RuddyRudeman

ЕМНИП, $350 за devkit и $599 за consumer

AllegroMod

Если мне не изменяет память, когда они собирали деньги на Kickstarter, то пели совсем другие песни. Там и версии для линукса были и макось и все, что душе угодно. А потом кампания закончилась и оказалось, что у Apple компы не подходят.

zelcam

"So if they prioritize higher-end GPUs like they used to for a while back in the day, we’d love to support Mac. But right now, there’s just not a single machine out there that supports it," he added. "Even if we can support on the software side, there's just no audience that could run the vast majority of software on it."

Trosp

Справедливости ради, для начала, не мешало бы Oculus выпустить нормальный vr-шлем.

firya

Да хотя бы просто выпустить

iBat

Все-таки правильнее было бы "когда Apple создаст игровой компьютер".

sanabek

Мне кажется что Apple в ответ выпустить свою консоль с VR шлемом.

PupkinVasia

На которой нельзя будет играть. А чтобы посмотреть видео на полный экран надо будет купить Pro версию плеера.

sanabek

Наверно в след. Apple TV будет VR и игры ему.

sevikl

через 2-3 версии может быть и будет. А в презентации именно следующей версии эппл должны сказать "ВР — не для людей и Эппол не будет этого делать"

Gorthauer87

А ещё OpenGL драйвер от Apple на интелах (на радеонах не видел тестов) сливает opensource драйверу для Linux. По ходу их любовь самостоятельно писать драйвера на видео не дает хороших результатов. Проще уж было реально брать linuxовые тогда.

vlreshet

Не факт что лицензия линуксовских дров позволила бы использовать их в Mac OS

Gorthauer87

Так ядро то открытое, в *BSD же их используют спокойно, а у клиентской mesa лицензия вообще MIT.

stanlee

Не соглашусь с автором насчет термина «нормальный компьютер»

Apple делает компьютеры направленные в первую очередь на бизнес среду, а не на игровую.

Для бизнес среды все идеально.

TheRaven

Не сказал бы что "идеально". Лично столкнулся с непредсказуемой работой прокси на маках: часть трафика от стандартных приложений (айтюнс, мейл, клауд и т.д.) шла вообще как ему вздумается, часть запросов падала с 407 при уже прошедшей авторизации и т.д.

CodeRush

Идеальный компьютер для бизнеса без TPM, без SecureBoot, без защиты от вредоносных OROMов и с прошивкой стандарта EFI 1.10 выпуска 2007 года. Энтерпрайз во все поля.

Kasatich

Идеальный для бизнеса по пунктам "дорогой и стильный на вид"?) А если бизнес связан с работой в 3д — выходит что уже не идеальны маковские машины.

ionovAG

Как раз идеальные, потому как используют профессиональные видеокарты, а не обрубки для геймеров.

EvilGenius18

Сразу видно, что никогда не занимались серьезной разработкой в 3D софте.

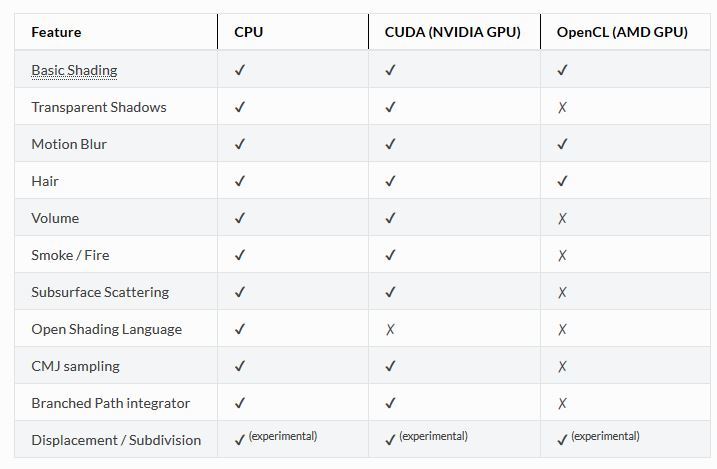

Что по-вашему, я должен делать с этим OpenCL, который не поддерживается для рэйтрейс рендеринга в реальном времени? — ждать по минуте каждый раз, чтобы увидеть незначительное изменение? Или что мне по вашему делать с 2 гб встроенной в эту AMD FirePro D700, которые забьются за пару секунд?

AMD GPU — бесполезный хлам, для работы с серьезным 3D софтом (в основном)

За те же деньги можно купить 2 Nvidia Titan X и получить в 24 гб видео памяти, и мгновенный рэйтрейс рендеринг на 6000 ядрах CUDA и никаких проблем с совместимостью.

К тому же, изучите сначала вопрос о том, что такое "профессиональные видеокарты", потом делайте подобные заявления, а то диванных экспертов, что-то слишком много

Chamie

EvilGenius18

Приложения для разработки в 3D не поддерживают OpenCL GPU рендеринг на должном уровне, используемый GPU от AMD, в отличии от CUDA, которые имеют прекрасную совместимость в любом 3D софте

Chamie

Так какие именно? V-Ray поддерживает, например:

EvilGenius18

Конечно, же vray поддерживает OpenCl, он стоит 30.000р. Но увеличив сложность моделей от него выгоды по сравнению с процессором не видно, в некоторых случаях. Дело даже не в этом, Cycles, к примеру, практически совсем не поддерживает OpenCl.

Речь была о том, что GPU используемый в Mac PRO, не только не подходит для VR, но и работать на нем без костылей не везде получиться, товарищ сверху говорил про 3D, я просто подтвердил его слова опытом, AMD это не каким образом не предел мечтаний, к тому же если это стоит нереальных денег, купив Titan X вы сможете не только забыть про апгрейд на 10 лет, но и спокойно пользоваться VR, играть при желании в игры, рендерить и создавать симуляции сложных моделей и частиц в любых движках и любых 3D программах, не думая о несовместимости OpenCL. в отличии от 2гб — 4гб AMD, которая ни на что не способна и стоит при этом дороже

Chamie

Что значит «практически совсем не»?

Причём, для CUDA возможностей не сильно больше — для OpenCL нет HDR-текстур, а для CUDA float-текстур вообще может быть не больше 5, к тому же, у OpenCL нет ограничения по количеству восьмибитных текстур.© https://www.blender.org/manual/ru/render/cycles/gpu_rendering.htmlEvilGenius18

В Cycles только недавно появилась поддержка OpenCl, и «практически совсем не» значит, что скорость в отличии от CUDA примерно в 2 раза меньше и поддерживаются всего лишь несколько моделей AMD.

2-4гб FirePro D700, котоаря в Mac Pro для 3D не годиться, об этом и была речь — самый топовый пк от apple не годиться для VR, а для 3D софта придется идти на уступки в некоторых случаях, так зачем тогда нужна эта "профессиональная карта". У нее только 1 плюс- это коррекция ошибок, но это ситуацию не меняет

Chamie

Так и с CUDA придётся — не более 145 текстур в Cycles, в отличие от.

EvilGenius18

Я понимаю что вы имеете ввиду. Но я иммел ввиду, что у OpenCL больше проблем и выглядит совместимость примерно вот так

https://www.blender.org/manual/ru/render/cycles/features.html

К тому же придется смириться, с тем, что ни VR от Oculus, ни производительности в 3D не получишь, заплатив намного больше за "профессиональную" FirePro D700 (т.к 2-4гб, OpenCL и в целом характеристики GPU на много хуже обычной "игровой" Titan X)

Поэтому нету смысла покупать macPro и "смиряться" со всеми минусами за большие деньги

ionovAG

Спасибо поржал.

Блендер нефига не промышленный стандарт.

EvilGenius18

Спасибо, я знаю. Именно, поэтому, я упоминал, что в другом софте, типа premiere, vray и тд, тоже есть ограничения OpenCl, в отличии от CUDA

ionovAG

повторю ваш пост, вы видно никогда не занимались профессиональным монтажем.

Во первых в премьере были ограничения в прошлых версиях, года 2 назад.

Во вторых премьер нифига не промышленный стандарт.

Все монтируют в авид и в файнале. На премьерщиков смотрят как на свадебников без образования.

Так что вы диванный критик, фапующий под кудовский совфт, который даже не преподают в ВУЗах.

EvilGenius18

.

Xenotester

Купив Titan X вы сможете забыть о FP64 — а апгрейд… главное случайно дрова не обновить, а то может в тыкву превратиться

beeruser

>> Или что мне по вашему делать с 2 гб встроенной в эту AMD FirePro D700, которые забьются за пару секунд?

12GB

4096 «ядер»

>> AMD GPU — бесполезный хлам, для работы с серьезным 3D софтом (в основном)

Я понял, вы «нефанат». Как раз таки архитектура GCN куда лучше работает с вычислениями.

>> За те же деньги можно купить 2 Nvidia Titan X и получить в 24 гб видео памяти

TitanX это геймерская карта.

Сравните цену с какой-нить Quadro M6000.

EvilGenius18

Что значит вот это ?:

Сайт Apple показывает совсем другое

Не смотря, что конфигурация $2.999 уже будет дороже конфигурации c Titan X. Так зачем вам 2 AMD 2гб каждая, которая уже в 6 — 12 раз хуже Titan X только по памяти? (CUDA SLI в некоторых случаях позволит использовать 24гб, AMD — нет, поэтому в 6 — 12, а не в 6)

>>>архитектура GCN куда лучше работает с вычислениями.

не всегда (смотрите выше в комментах о чем была речь)

>>>TitanX это геймерская карта. Сравните цену с какой-нить Quadro M6000.

Опять же, смотрите выше в комментах о чем была речь.

Зачем вам бесполезная дорогущая "профессиональная карта" если "геймерская" намного лучше в плане VR, игр, некоторых типов симуляций частиц, и рендеринга моделей большей плотности и тд и тп, к тому же не нужно париться на счет несовместимости в некоторых случаях. так зачем вам "профессиональная карта", если она ни на что не способна (относительно тех пунктов описанных выше). Об этом и разговор

Mad__Max

Быстро вы однако с AMD FirePro D700(которую изначально обгадили) на AMD FirePro D300 перескочили ;)

beeruser

Почему вы не обвели D300 таким же кружком?

Mac Pro ориентирован не под игры, поэтому наличие неигровой карты вполне логично :-)

С чего вы взяли что она не способна работать с VR?

Железо весьма мощное. У той же PS4 GPU раза в 3 слабее.

И ничего, может выдавать неплохого качества графику в 3D.

Проблема у Apple в дровах.

BelBES

Вот только почему-то под числодробилки покупают именно TitanX а не Quadro… ну либо уже K40/K80)

doobrik

Палмер> Вы можете купить Mac Pro за шесть тысяч долларов, но в нем будет стоять AMD FirePro D700, который не подходит под рекомендованные требования.

Также вы можете купить Audi R8 за больше чем сто пядесят тысяч долларов, но в ней будет стоять Nvidia Tegra, которая не подходит под рекомендованные требования.

970-й жираф всего на 40% быстрее 395Х-радеона в маках. Через пол года Яблоки выпустят новый мак, тогда уже будут новые 14/16-нм видяхи, которые, я уверен, будут быстрее 970-й. А значит пол года ждать до выхода окулуса на маки?

maxpsyhos

Ну да, самая топовая модель всего в полтора раза отстаёт от минимальных требований по видеокарте. И чего это они всю линейку забраковали, ума не приложу...

EvilGenius18

Тут ничего нового, все в традициях Apple — только избранные, купившие mac PRO версию смогут насладиться VR… хотя не… даже они не смогут ?_(?)_/?

doobrik

Я уже приводил выше аналогию. При чём тут Мак про. Это как купить Ауди и сетовать на то что деньжищи уплачены а на её Тегре ничего не идёт.

EvilGenius18

Я видел ваш пример. И до сих пор так и не смог понять его сути

Тут говорят "oculus VR не будут работать с mac т.к. даже самый мощный Mac компьютер, который максимум имеют 0.1% всех mac пользователей, не годится для этого" — поэтому oculus VR не будет работать с apple компьютерами.

При чем здесь машина Ауди, приятель?

doobrik

Они говорят что самый дорогой мак не подходит для игрушек с Окулусом. Но этот мак предназначен не для игор. Поэтому он и дорогой.

Точно так же для игор не подходит Ауди, которая значительно дороже. И хотя в ней есть дисплей и Тегра (видеопроцессор), и, в теории, даже можно играться, но она предназначена не для игор. Поэтому она и дорогая.

Теперь-то видно связь и логику?

0xd34df00d

А для чего он предназначен?

doobrik

AMD FirePro is AMD's brand of graphics cards intended for use in workstations running professional Computer-aided design (CAD), Computer-generated imagery (CGI), Digital content creation (DCC) applications.

0xd34df00d

Интересно, кстати, что при всём этом из трёх софтин, которые я видел в реальной CAD-работе — SolidWorks, Pro/ENGINEER и AutoCAD, под маком, судя по вики, работает только последняя. Притом, что всяких симуляций и прочего счастья там нет, в отличие от того же SW.

trilodi

Не хочу развивать снова халивар, но Mac PRO не только для CAD работ берут, их очень любя дизайнеры, обработчики фото и всякого свадебного видео. Это по моим наблюдениям. Я бы тоже от него не отказался, но пока жаба душит

doobrik

Если посмотреть статистику по Стиме за декабрь (за январь-ферваль там фигня какая-то а не статистика) то самой топовой видеокартой среди списка на есть как раз 970 с долей 4,9%. Более мощных карточек в списке нет, они все имеют очень малую долю и находятся в категории "другие".

Окулусы просят для своего девайса самую топовую карточку (карточки мощнее 970-й погоды не делают, их даже на Стиме нет). Почему вас удивляет что я сравниваю её с топовой карточкой на Маке?

И второе, современные 28 нм это техпроцесс карточек начала 2012-го года. Этой весной выходят карточки на 14/16 нм, осенью, а то и летом будут маки на этих карточках, которые, очевидно, будут быстрее 970-й. Странно жаловаться что карточки, техпроцессу которых четыре года не тянут окулус, в то времья когда через несколько месяцев выйдут которые спокойно впишутся в минимальные требования. Ва смущает несколько месяцев? дык Окулуса-то ещё и тоже нет.

Gexogenn

Когда (и если) VR крепко войдет в нашу жизнь, Oculus сами буду ж*пу рвать что бы сделать свое железо Mac-совместимым. Как ни крути, а аудитория пользователей продуктов Apple значительно больше, чем аудитория Oculus.

zelcam

тут как раз наоборот — когда vr крепко войдет в нашу жизнь, эппл порвет жопу, чтобы впихнуть в маки ГПУ получше, потому что нынешнее железо в маках ниже минималки для VR. окулусы и рады бы поддержать мак, но поддерживать нечего пока что.

такие дела.

Gexogenn

Я, вероятно, немного неверно выразился, раз Вы меня так поняли. Я пытался сказать, что у Apple есть своя ярко выраженная аудитория, есть брэнд. Oculus молодая компания, как и сама технология которую они используют. Если их продукт будет доступен широкой массе людей, то они автоматически потеряют ту часть покупателей, что используют продукцию Apple. Не думаю что это разумно. Потому им придется задаться вопросом как все же "подружить" эти два девайса.

ffs

Вы, возможно, не так поняли zelcam. Окулусу для обеспечения приемлемой картинки (90 фпс на каждый глаз) требуется оборудование определенного уровня производительности (geforce 970+), которого в маках попросту нет.

pOmelchenko

Обеспечить мак картой типа geforce 970+ можно и внешней видеокартой. Это не повод для добавления поддержки?

trilodi

Да это лишь отговорки у них. Просто среди пользователей маков очень мало игроманов, и игр очень и очень мало, вот и не хотят заморачиваться двигаться в этом направлении

igorkozinov

«Мальчики, таки не сорьтесь!»

Предлагаю такую формулировку: «Когда VR крепко войдёт в нашу жизнь, %1 порвёт жопу...»

Virviil

Как ни крути, но на сегодняшний день VR для работы не очень пригоден. А среди геймеров «яблочная» продукция не котируется.

А в тот момент, когда VR «крепко войдёт в нашу жизнь» в плане пользы, Эппл выпустит свой iOculus, который будет продавать за +$один нолик в конце по сравнению с остальными VR, с самым закрытым протоколом и совместимым только со своей продукцией, так же как сейчас продаёт свои мышки и клавиатуры для маков.

isden

А разве ихние мышки/клавы/трекпады нельзя использовать, скажем, под виндой или линуксом? Я вроде у коллег видел.

Virviil

Да, можно. "так же" относилось непосредственно к факту продажи собственного оборудования, а не всех перечисленных характеристик, но видимо я запутался в причастных или каких-то там оборотах. Что касается VR — может быть тоже будет совместим. А может вообще его не будет. Это просто фантазии, которые, как мне кажется, похожи на правду.

daggert

Пользуюсь уже лет пять эпловской клавой и мышкой под обычным PC.

Или вы вспомнили 90-е?

Zeliret

Аудитория VR = аудитория игроманов. А у эпла с этим всегда было все плохо.

Ra-Jah

А к Маку разве нельзя внешнюю видеокарту приколхозить?

reji

Можно, но вам не кажется это странным? По цене этой внешней видеокарты можно собрать не топовый, но ещё один компьютер.

extempl

Ну если это будет вполне прилично выглядеть (не внешне, а в принципе), то таки универсальность решает. Принёс домой, подключил к внешнему мону, к видеокарте и вроде как игровой десктоп. Надо уйти — отключил и унёс (а нафига избыточная видеокарта в таком случае?)

Zeliret

Игроделы очень не любят писать игры под мак. ААА проекты делаются редко и не сразу.

navion

Нормальное решение появится только в этом году.

xZARx

VR всё же направлен в первую очередь на геймеров. Много геймеров на маках? Много ААА проектов за последний год вышло на маки?

Так что скорее наоборот: Apple начнёт ставить железо, достаточно мощное для VR, а уже потом VR и игровая индустрия должны будут дружно повернуться в сторону маков.

Да и вообще по моим личным ощущениям целевая аудитория VR геймеров и пользователей маков не сильно-то пересекается.

Argutator

Если мне память не изменяет, facebook, который купил Oculus rift, надеется внедрить VR на более широком уровне. Повторить успех мобильных телефонов, которые сейчас есть чуть ли не у всех. Получится или нет (и, главное, как именно) — посмотрим

xZARx

если радикально снизят требования к железу, то быть может и взлетит. сейчас это очень дорогая игрушка, с которой в общем-то делать особо нечего (пока что). и дорогая не только сама по себе, но ещё и требует почти топового железа.

holomen

>>сейчас это очень дорогая игрушка

Это только сейчас. Сотовые тоже не так давно были

>>это очень дорогая игрушка, с которой в общем-то делать особо нечего

famiak

С сотовых понятно, что было делать. Звонить. А для бедных выпускали сотовые, умеющие только СМС.

Шлемы виртуальной реальности пилят уже лет 20 и особого успеха не было ни разу. Железо, которое нужно для 8к стоит как самолет и позволяет играть в некоторые игры без нативного управления или смотреть пару специальных роликов. Это в случае, если у вас не кружится голова и вас не тошнит.

kafalk

А почему профессиональные видеокарты не подходят для VR? Если Apple впаяет, например какуюнибуть tesla, тоже толку мало?

BelBES

Потому, что у Tesla нет видеовыхода?:-)

kafalk

К сожалению ваш комментарий не дает ответ на мой вопрос, понятно что выхода нет но делать расчеты то можно, а выводить уже другим способом хоть бы тем же wifi

BelBES

Нуу… с ходу видится только проблема того, а хавтит ли скорости PCI-E для того, чтобы гонять по шине картинку для очков в реальном времени в обе стороны… как числодробилка какая-нибудь K40/K80 уделывает и титанов.

Ca5per

Нет не одной игры для Oculus Rift, но при этом они утверждают, что необходима производительность NVIDIA GTX 970 в связке Intel i5-4590. Игры могут быть совершенно разными по требованиям к производительности, например, дальность отрисовки будет небольшой или текстуры и полигональность будут не такими высокими.

Для комфортной работы с Oculus Rift нужно 90 кадров в секунду и всё. И играми виртуальная реальность не заканчивается, есть youtube, кино, творческие приложения и так далее.

Благо есть конкуренты, которые выпустят поддержку в том числе и на Mac, при этом не будут вкладывать всякую ерунду в комплект, типа геймпадов, наушников и так далее.

Tribe

Ну, это ж не просто 2 монитора, это еще и изменение начальной картинки под оба глаза, плюс трекинг положения в пространстве.

Если добавить еще требования к движку, то неудивительно, что требуется топовый на данный момент конфиг. Ведь любые лаги сразу же убьют эффект присутствия. Так что надо просто подождать год-полтора, чтоб рекомендуемый конфиг стал приемлемым по цене.

Кто знает, мб Apple к тому времени решит сделать конфиг с хорошей видеокартой.

TipTop

Эффект присутствия убивает отсутствие обратной физической связи. После пары минут гонок в окулусе меня тошнило несколько часов, потому что не было эффекта инерции ни на разгонах, ни на поворотах, ни на торможении. Заодно я обнаружил, что нужную силу торможения определяю только по вестибулярному аппарату. Стоит отметить, что графа там реально барахло. Меня, игравшего в свое время в игры 320х240 таким не напугать, но друзья помоложе ждут от окулуса большего.

ffs

Пока, к сожалению, все конкуренты делают и дороже и со всякой гадостью в комплекте. Ждём хода китайцев.

Jamato

Ну, про "ни одной игры" — это категорично. Есть игры, которые поддерживают Oculus в экспериментальном режиме. Например Alien. Или просто поддерживают, не являясь эксклюзивами для него. Но рассчитать необходимую производительность достаточно легко не имея игры. Обычная игра умножить на 120 герц умножить на три картинки с определённым разрешением.

silverjoe

Elite: Dangerous

Fen1kz

Или дело в отношении Apple к разработчикам. Пару раз сталкивался с разработкой под iPhone, такое ощущение, что я им платить должен за привелегию дебажить айфон. Предполагаю такое же и с VR-Mac

mobimaks

Так и есть. Раньше, чтоб запустить свой апп, на своем же iPhone нужно было иметь dev-аккаунт (100$/год). Но с выходом Xcode 7 можно дебажить на своем iPhone бесплатно.

vanyatwo

Да, но ведь для публикации всё также надо иметь dev-аккаунт. И ладно бы они просто верифицировали людей по документам. Деньги-то зачем берут?

dmitrienkop

Это не какая-то уникальная особенность Apple. Берут как Google, как Microsoft. Microsoft и побольше брал, как я помню.

vanyatwo

Только что загуглил — для Google Play через Google Developer Group — бесплатно.

Chamie

Верификация по деньгам проще и надёжнее, и точно так же отбивает охоту регистрировать миллион фейковых аккаунтов. Притом, миллион фейковых аккаунтов, которые все нужно проверить — это нагрузка на техподдержку, а миллион платежей — это капля в море транзакций платёжной системы.

vanyatwo

Зачем тогда ежегодная оплата? Им жалко записи "active" в бд?

Chamie

Чтобы не держать «мёртвые» аккаунты, зарегистрированные и заброшенные. Которые, кстати, могут потом скупать по дешёвке те же скамеры.

VBKesha

Интересно как они от линукса отмажутся?

DenimTornado

Там будут ругать как раз таки ПО) Типа вот железо можно любое поставить, а софт тупит и крэшится. А потом их купят Мелкомягкие.

Goodkat

Разве их не купил уже Фэйсбук?

TheLonerD

Уже как давно их купили.

https://www.facebook.com/zuck/posts/10101319050523971

Упс, отвечал DenimTornado, комменты здесь удалять нельзя.

valexey

Думаю легко — скажут что сделают поддержку линукса как только линуксоиды осилят сделать нормальную версию для десктопа, которой люди будут пользоваться.

AlexeyS

Для Steam Machines наверное поддержка будет

fear86

Steam Machines есть с железом хуже яблочного, надо будет еще фильтровать по характеристикам.

lybin

Nvidia обматерят снова чё :)

lizarge

Не удивлюсь если apple выпустит рабочее VR решение раньше чем Oculus, и потом они начнуть говорить что apple снова украла все.

p.s. А если я на mac поставлю windows, то как быть?

6opoDuJIo

Претензии не к макоси, претензии к железу.

Windows не превратит Radeon 6700m во что-то, что сможет рендерить тот-же Star Citizen хотя-бы в 120 фпс (по 60 в каждый глаз)

lizarge

>Претензии не к макоси, претензии к железу.

Это понятно, вот только в статье это слабо раскрыто, да и мак про не отменяли, имхо им бы стоило сделать софт, а железо подтянется. Да Oculus разве только к играм применим? Просто ищут отмазки что бы оправдать то что не успевают сделать нормально кроссплатформеную версию.

6opoDuJIo

По-моему, тут даже ткнули носом в суть проблемы:

>>Проблема в том, что для Apple производительность GPU никогда не была приоритетом. Вы можете купить Mac Pro за шесть тысяч долларов, но в нем будет стоять AMD FirePro D700, который не подходит под рекомендованные требования

Так что всё описано довольно чётко.

По поводу «для игр-не для игр» тут ситуация такая: эппл не нацелен на аудиторию окулуса, так что они не имеют мотивации поддерживать платформу, не предназначенную для их ЦА.

tartarelin

p.s. А если я на mac поставлю windows, то как быть?

то останется только поменять видеокарту

roller

Ну поменяйте, паяльную станцию вам в руки

Darth_Biomech

НАСТОЯЩИЙ™ компьютерщик должен паять компьютер самостоятельно, а не покупать готовые комплектующие?

Xenotester

Ну купите Вы видеокарту — как её в мак вставить? Thunderbolt переходник городить ?

extempl

Нет, действительно интересно, тема установки винды на мак не раскрыта. Будет ли окулус отказываться работать на железе (определяя что это мак) или будет пытаться вытянуть на низких настройках? Если второе — причина не выхода на мак как бы непонятна, вполне могли бы и на низших настройках запустить, а железо таки подтянется. Если первое — тогда речь не в маке вообще, а в ограничении железа на чём угодно.

6opoDuJIo

Чисто теоретически, окулус должен работать по принципу «проблемы негров шерифа не касаются» — если ты включаешь окулус на железе, которое не может вытянуть картинку, это твои проблемы.

Никто не возмущается от того, что окулус не собираются портировать под Android, верно? Верно, ибо андроид крутится, как правило, на слабом железе. Так-же и с макосью.

Goodkat

Безотносительно именно этой железки, я согласен с претензиями к Эплу — игровую графику не поставишь даже за большие деньги.

Ёлы-палы — iMac, один из лучших на рынке экранов, а графику можно выбрать только мобильную и лишь увеличить количество видеопамяти за немалые деньги.

Ну сделайте вы цену в два раза выше рынка, но дайте возможность опционально ставить десктопную видеокарту.

isden

Mac Pro же? Там, вроде, все прилично. В том числе и цена.

BelBES

А у iMac экран не прожжется от топовой графики? Всякие титаны греются как утюги под нагрузкой...

n1nj4p0w3r

Покупается thunderbolt->PCI-E и втыкаем дискретную графику, цена в результате как-раз конская получается, как заказывали.

Много ли моноблоков у которых стоит десктопная графика? Как её охлаждать? Особенно если речь о топовых печках которых еще и прокормить надо.

6opoDuJIo

Лучший коммент во всём треде.

Goodkat

Старая сказка — внешние видеокарты нам обещали с выходом Thunderbolt 1, но приемлемых решений пока нет, говорят, что это из-за лицензионной политики Интела. Ждём Thunderbolt 3 и верим в лучшее.

n1nj4p0w3r

А что такое "приемлемые решения"? Даже известные в узких кругах "бизон" запилили thunderbolt->pcie и прежде всего утверждают, что это для дискретной графики.

Goodkat

Бизон работает с экраном iMac-а или нужно дополнительный 27-дюмовый 4К-монитор к нему покупать, чтобы поиграть?

n1nj4p0w3r

А к окулусам приклеивается уже присутствующий экран или у него свои есть?

Почем я знаю, но вроде-как расчет на одной графике, а вывод через другую в нынешнее время проблемой не является, смотреть про гибридную графику.

Goodkat

Вы совершенно правы — мы же рассуждаем в контексте Oculus Rift, и если играть только в очках, то внешняя видеокарта подходит.

Когда я смотрел существующие решения полгода назад, я не думал об очках.

На тот момент внешние видеокарты работали со встроенными экранами только на макбуках и аймаках без дискретной видеокарты. Вторая проблема — производительность упиралась в пропускную способность Thunderbolt.

Идеальный вариант, конечно — это если Intel и Apple добровольно будут поддерживать внешние видеокарты.

Потому и надеемся на Thunderbolt 3.

navion

Только в третьей версии добились пропускной способности на уровне PCI-E x4 и Razer уже анонсировал свою коробку:

http://www.razerzone.com/gaming-systems/razer-blade-stealth

Goodkat

Сколько это в валюте?

navion

Пока не сказали, но бренд не из дешевых и цену могут заломить на уровне топой видеокарты. Alienware за свою просит $300, а она подходит только к родным ноутбукам.

Sleepwalker_ua

Было бы желание, в моноблок можно много чего запихнуть. Чай, это не ультрабук, можно сделать корпус толщиной в 6-10см, оставить стоковый охлад дискретной двухслотовой видухи (поставленной вертикально), и подключить к материнке ее через шлейф. + пара корпусных вентиляторов снизу на нагнетание, сверху на выдув. И всё. Чисто инженерная небольшая заморочка. Топовую конечно так не впихнуть, всякие титаны не светят, но хотя бы 960гтх вполне реально уместить. За те деньги, что просят эпплы за топовые маки можно было бы и поднапрячься.

n1nj4p0w3r

Не выйдет, нормальный температурный режим топовой графики 80+ по цельсию, мощность печки 230+ ватт, ни какая матрица этого терпеть не будет.

Sleepwalker_ua

можно сделать теплоизоляцию матрицы, причем даже двойную. Можно сделать канал-воздуховод, чтобы воздух от видухи не растекался по корпусу, а уходил сразу наружу. Добавить турбинку. Сейчас уже их научились делать относительно тихими, 30-34дб пережить можно, тем более, что им необязательно работать постоянно на всю катушку, а в играх на шум особо не обращаешь внимания, проверено собственным системником, довольно шумным.

Опять же, та же 960 GTX имеет тдп в 120 Вт. 970 — 145Вт. 980 — 165 Вт. Цифры конечно великоваты, но далеко не смертельные, чтоб эту проблему нельзя было решить. Да, будет безусловно дороже, чем обычный ПКшник, где-то на уровне хорошего игрового ноута, но своя ниша нашлась бы, хотя и не слишком большая. Вот с теми же очками виртуальной реальности, например.

Xenotester

Цифры занижены — 970 и 980 и по 230-260 ватт сожрать могут.

Охлаждать то можно, но вопрос и блоке питания: MSI сделала БП внешними + на видеокарту БП отдельный.

В общем — всё сводится к соотношению между габаритами и производительностью

Goodkat

Для моноблоков и ноутбуков подойдёт вариант с внешней коробкой под видеокарту, с собственным питанием и охлаждением.

Дело только за поддержкой от производителя этих самых моноблоков и ноутбуков.

trilodi

Я бы сказал больше, вся идея VR и всего подобного должна строится вокруг того что бы уходить от больших монитором в сторону VR. Открыл ноут подключил устройство и вот ты уже в кинотеатре, или мочишь монстров. В маках как раз таки уже есть порт thunderbolt который впринципе должен позволить подключить подобное устройство. Вот это был бы шаг в перед.

В этом случае очень шикарный заголовок был бы "Мы не стали ждать пока Apple сделает нормальный компьютер, а сделали нормальную приставку для всех ПК"

Xenotester

Выйдет. И выходит.

Но приходится жертвовать габаритами

AxisPod

Пацаны ваще ребята. По началу с девкитами было норм, потом решили вспомнить СССР и продавать в нагрузку всякое ненужное, вместо того чтобы продавать отдельно, это я про геймпад. Теперь решили пропиариться на обкладывании другой компании. Что дальше?

PapaDen

Отгороженность Apple приводит к таким плодам. Они строят свою экосистему и просто рискуют остаться в свей нише и все. Большая, неповоротливая корпорация.

trilodi

Тут много возгласов про глючность ios, osx и все продукции Apple. До 2012 года сам их ненавидел, но потом пересел на MacBook и iMac. С тех пор слова программирование и osx для меня не разделимы. На Windows очень часто приходилось перезагружать компьютер с очень даже нехилыми параметрами (i7, 16гб оперы, 8гб видео и ссд диски). На том же MacBook с намного хилыми параметрами я месяцами не перезагружаюсь если того обновления не требуют. Возможно для графики это не тот продукт, но для программирования, учебы, и всего подобного это наилучший вариант на мой взгляд. Недавно вообще с андроида пересел на iPhone, и понял что врятли в ближайшее время вернусь на андроид. Перебрал много андроид фонов до перехода на iPhone. Все по началу шикарны, но потом начинается тихий ужас. Самсунг делает аппараты на вычислительных возможностях которого можно наверное в космос улететь, но с выходом нового аппарата старые ПОЧЕМУ то начинают тихо глючить даже без игр и лишнего софта. Дома валяется iPhone 4 который даже сегодня работает быстрее чем мой Galaxy S5, про iPhone 6s я вообще промолчу

Возможно это мне так не повезло с железом, не исключено!

trilodi

А уж чего стоит инфраструктура Apple я уже молчу, все из коробки.

yadobr

Поддерживаю. На Виндовс10 ужасные стандартные приложения. Почтой вообще невозможно пользоваться. Выход — качать что-то другое.

В макос стандартные приложения очень удобные. Шрифт читается лучше и как результат глаза меньше устают.

Т.е. поставил систему и все — работай.

Сейчас я делаю дизайн сайта(я программист, просто пришлось)), так вот в макос есть Sketch — современный инструмент. В винде — древний FireWorks.

Плюс, удобный просмотрщик шрифтов.

В общем все, что нужно уже есть.

А если нет, то есть Аппстор, с качественными приложениями. А не мусором как в гугл плей или виндовс стор

0xd34df00d

Как вы добились удобных шрифтов? Мне не удалось получить на маке что-то, по удобству чтения приближающееся к fontconfig-infinality + liberation.

yadobr

Вам нравятся тонкие шрифты? Уверен, что и на мак найдется программа для этого.

Рендер шрифтов в макос делает их более «жирными». По моим наблюдениям, глаза стали значительно меньше уставать

0xd34df00d

Да, тонкие и плотные. Вроде таких: http://dump.bitcheese.net/images/ikepewi/screenshot.png

Читать с мака мне было приятнее до тех пор, пока я пару лет назад не настроил рендеринг тут под себя. Как искать соответствующие программы под ма, стати, я не представляю.

Mad__Max

Шрифты на скришоте довольно приятные на глаз. Но где же они тонкие? Тонкие для обычных мониторов это с толщиной всех основных линий = 1 пикселю.

А то что выше может изначально они такими и были, но там явно активно используется какая-то агрессивная технология сглаживания — многие линии оказываются даже не 2 а 3 пикселя в толщину (один основной и 2 цветные полутени), включая обычно вообще не сглаживаемые чисто вертикальные линии (т.к. на них не образуются "ступеньки" из пикселей, то в большинстве алгоритмов сглаживания их оставляют как есть, а тут они так же "сглажены" = визуально утолщены).

На мой взгляд это и есть как раз жирные шрифты.

elmm

Давеча сегодня Xcode несколько раз заглючил. Например тупо пропал курсор. Текст вводится, а вот где он будет сейчас вводится — не понятно. Что-то я последнее время глюки ловлю на маке чаще чем на винд.

trilodi

Сейчас открыт Xcode и около 40 вкладок хрома, а так же другой софт работает на MacBook Air 2012. Никаких глюков не наблюдаю. Я не отрицаю, бывают глюки, но они крайне редки. По крайней мере я не бегаю в год по несколько раз за более совершенными процессорами, оперативками и всем таким в магазин потому что выход новой среды разработки принес за собой глюки системы. А что говорить про постаянные переустановки винды, это были целые ритуалы, вспоминаю с ужасом

EvilGenius18

Не стоит сравнивать XP с Win10. Я ни одного глюка за полгода не заметил на Win10, хоть и были ситуации с рандомным отключением питания — никаких проблем. Управление OS кэшированием памяти работает просто прекрасно, 5-8 гигов в оперативе, используемые разными приложениями ни разу не вызывали никаких конфликтов, вылетов и глюков.

Это все равно что сравнивать первую версию андроида на слабом noname железе с android 6.0 на топовом железе. Если использовать win10 на core i7 и SSD от самсунга с коррекцией ошибок и всяческого рода системами защиты от перегрева и сбоев, то конечно вы не будете замечать ошибок, так же как и на OSX

trilodi

ну так я с XP и не сравнивал, последняя винда на которой я работал это была 8+, а самая оптимальная по мне так это 7 была.

Ничего про 10 версию сказать не могу потому что переходить назад нет никакого желания, так как опять начнется гонка за железом. Да и в стабильность 10 версии мне слабо верится в свете всех статей как на хабре так и на просторах интернета.

Ну и у винды напроч отсутствует инфраструктура из коробки

Ну и очевидный для меня плюс в отсутствии нормальной графики в маках это то, что я слез с игр и посветил больше времени работе и самообразованию. А системник с указаными вами параметрами (только ssd kingstone) стоит и пылится, включается только для того что бы провести транзакцию по вебмани 5 раз в год

Но все вышесказанное это сугубо мое мнение. На вкус и цвет как говорится. Кто то влюблен в osx, кто то линуксы, кто то без ума от винды

EvilGenius18

Ну единственное, что я имел ввиду, это то, что люди обычно сравнивают win10 и OSX, но не учитывают железо, Вот у вас в Mac стоит m.2 PCI-e жесткий диск с коррекцией ошибок и скоростью ~800 мб\с, и если сравнивать его с win10 на обычном HDD со скоростью 110 мб\с, который очень медленно работает с оперативкой, то конечно же у всех появляются негативные мысли по поводу win10. Так если поставить топовый диск m.2 PCI-e ~800 мб\с \ ~1500 мб\с, с коррекцией ошибок и защитой от перегрева и тп, то глюков и ошибок, приводящих к BSOD не будет возникать, и окажется, что в некоторых случаях управление памятью даже лучше "Великой оптимизации OSX". Это единственное, что я имел ввиду. Если сравнивать ОС с на одинаковом железе, то все выглядит совсем иначе. Никаких притензий к вам лично

trilodi

Полностью с вами солидарен.

И вообще считаю что на вкус и цвет в этом плане нет товарищей.

Я первый комментарий постарался изложить так что это сугубо мое мнение, которое возможно разделяю только я.

Просто добавлю к вашим словам о железе в целом в пк и маках. Просто в маках железо подобрано уже под ОС, и работают они в замечательном тандеме как я считаю, а готовых ПК для тандемной связки с другими ОС я так и не видел. Все приходится вручную собирать, делать расчеты, проводить сравнительный анализ железа и все подобное

trilodi

Но при этом конечно становится сложным расширяемость и модернизация, но у меня пока до этого не доходило

ad1Dima

У меня тут макмини сам перезагрузился. С чего — хз, системник с виндой из той же розетки норм работал…

trilodi

Ну вы сейчас сравнили 2 разных устройства с разными ОС и общее у них только 1 разетка. А сколько раз у вас сама перезагружается винда? Или по другому спрошу, сколько раз вас винда заставляет перезагрузиться?

ad1Dima

Я не сравнил, я всего лишь предупредил аргумент про скачек напряжения.

А винду я не перезагружаю очень редко. А заставляла она меня последний раз на win8, то есть месяцев 7 назад. После этого все добровольно.

trilodi

Не буду спорить, вполне возможно что новые версии винды более стабильные в этом плане.

Я писал выше в другой ветке, что я коментарий строил не как навязывание или утверждение, а как свою точку зрения, через что сам прошел и к чему пришел

trilodi

У меня бывало что мак сам перезагружался, причину я так и не выяснил, было пару раз всего. Но даже при таком экстренном рестарте у меня все сохранялось, даже текст который я вводил в этот момент

ad1Dima

>даже текст который я вводил в этот момент

ну круто. У меня на том же маке парралелс не перезапустился, ещё пару приложений тоже не восстановили свои состояния.

Тот же офис на винде тоже регулярно сохраняет документ.

Это я к тому, что везде глюки есть.

trilodi

я не про офис веду речь, например на тот момент в последний экстренный рестарт сохранился текст который в хроме набирал, это к авто сохранению не имеет никакого отношения.

Вы очень правильно заметили, спорить про достоинства и недостатки нет никакого смысла, у всех ОС есть как свои плюсы так и недостатки.

Кому где удобнее работать

Alex_ME

Не могу ничего сказать о производительности и стабильности мака (но и не могу ничего сказать плохо про винду у себя), но вот позволите высказать ИМХО про юзабилити MacOS (довелось поработать пару дней за iMac):

1) Нет возможности развернуть окно на пол экрана перетащив его к краю (как в виндах и современных окружения раб. стола и линуксов) (нет, серьезно, 2016 год на дворе, монитор вроде 27", а я окна мышкой ресайзю)

2) Разворачивание окна на весь экран — только двойной клик по заголовку окна, разворачивает не всегда. Если развернуть на весь экран — скрывается меню и док, при подведении курсора они появляются весьма неспешно. Просто открыть какое-то другое окно поверх того, которое на весь экран — неет, весь экран плавно сдвинется в сторону, к другим, не полноэкранным окнам

3) Несколько экземпляров приложения по клике на иконку в доке переключаются последовательно, как выбрать нужный сразу? Аналогично в "Alt+tab"

4) Баг(?): зачастую не хотел переключать раскладку на клавиатуре. У человека за соседнем iMac все было хорошо

EvilGenius18

На маке все это делается немного по другому, на сколько я знаю

1) Чтобы перетащить окно на одну из частей экрана надо зажать кнопку окна "развернуть" и перетащить в нужную часть окна

3) Переключение между окнами активного приложения Command+’

4) Кнопка заедает м?

trilodi

Скорее всего кнопка. Что касается разворачивания окна в пол экрана то это присутствует в последней версии OSx и прекрасно работает.

По поводу альт таб, это все прекрасно реализовано на тачпаде простым взмахом пальцев, можно как переключится между окнами там и между приложениями, даже между окнами других приложений (к сожалению к iMac он не идет в базе, но мне достался)

Если вы всего пару дней работали за маком, то врятли ваше мнение может быть объективным, потому что к каждой ОС нужно привыкнуть.

Это тоже самое что я сейчас скажу что в винде проблема с юзабилити в том что кнопки окон находятся справа а не слева, или язык переключается менее удобнее чем в маке, или меню пуск отвратительное в котором нужно напрягать зрение и искать нужную программу, а про вирусы я вообще молчу, но это будет не верно с моей стороны, хотя когда приходится работать с виндой это очень раздражает.

ramntry

А вы Linux пробовали?

trilodi

Пробовал. Но он мне вообще не подошел. Много телодвижений что бы добиться более менее приемлемого окружения для работы, ну и полное отсутствие инфраструктуры, даже винда в этом плане по лучше будет

0xd34df00d

Что вы называете инфраструктурой?

trilodi

Инфраструктурой я называю совокупность сервисов Apple. сел на один мак, поработал, то же самое можно открыть уже на другом маке без каких либо искажений или подтягивания библиотек или артефактов. все устройсва в рамках одного Apple ID работают в отличном тандеме. К примеру можно набрать текст, документ в Pages или таблицы в Numbers и потом их же открыть и отредактировать на iPad или iPhone, и все это без искажений и практически из коробки.

0xd34df00d

А, не понимаю, зачем это всё нужно, когда есть свободный и открытый git без привязки к конкретной платформе, непонятным TOS и непонятным лицензионным условиям.

trilodi

Я сейчас говорю про средства из коробки. git он для разработки хорош, а я использую Apple устройства как для разработки так и в повседневой жизни. Например медиатека мака без каких либо телодвижений у меня и на телефоне и на планшете. iTunes работает замечательно, это помоему единственный медиа магазин который активно развивается и регулярно пополняется, за Google Play я не замечал такого пополнения хотя до недавнего времени был активным пользователем плея

0xd34df00d

git вообще для текстовых документов хорош. Правда, тут, вероятно, специфика моих занятий сказывается: не припомню, когда мне последний раз нужно было редактировать документ в Pages/OO Writer/MS Word или таблицу в Numbers/OO Calc/MS Excel. А резюме отлично пишется в TeX и хранится в таком виде на том же гитхабе.

Как организовать медиатеку в моих условиях, я плохо представляю, когда музыка из разных источников и во флаке, для проигрывания музыки с собой у меня не мобильное устройство, а Sansa Clip с ?SD-карточкой на 128 гигабайт и прошивкой Rockbox, и так далее.

0xd34df00d

А, вы с Windows пересели?

Я попытался с Linux пересесть, не получилось. Неудобно, неюзабельно, XCode для написания кода на C++ не очень, KDevelop на мак впендюривать — то ещё извращение, да и зачем, когда есть нормальный удобный Linux?

trilodi

Я параллельно windows работал и в Linux (Ubuntu и Kali) многий софт работает крайне нестабильно, часто крэшится. OSx это тоже никсы, и большенство пакетов Linux очень прекрасно поднимаются на маке. По крайней мере я не сталкивался с тем чтобы у меня что то не встало. Согласен иногда приходится извратиться, но это больше применимо было к неповседневным инструментам а к разовым (в моем случае).

Пересел на мак потому что нужна была разработка под iOS, первое время плевался, недели 2, но потом забыл о существовании других ОС.

Основное предназначение XCode это разработка под OSx и iOS, поэтому под другие он не особо пригоден, для С++ наверняка есть более удобные инструменты, с С++ уже лет 10 не приходилось работать. А вот под Android (Java) и iOS (objective-c, swift) мак просто идеален.

Я в этом посте в коментариях уже не раз подчеркивал, что не в коем случае не навязываю никому свою точку зрения, лишь привожу свое мнение и свои впечатления. Выбор ОС это вообще сугубо личное дело и под нужды пользования, и пересаживаться с ОС на ОС очень и очень трудно с точки зрения привычки

0xd34df00d

Какой это софт нестабильный? Ну, просто из интереса.

Я на Gentoo сижу лет, наверное, двенадцать, если уже не тринадцать, и крешится толко то, что должно крешиться — версии программ прямо из их VCS, например. И то, KDevelop из их git master у меня работал стабильнее, быстрее и адекватнее, чем XCode под маком.

Собственно, про невставший у меня кусок Linux-пакетов я уже сказал — стабильно и надёжно завести KDevelop (и вообще KDE-окружение) под маком мне не удалось.

trilodi

-и крешится толко то, что должно крешиться

Вы считаете что в стабильной ОС что то должно крэшится по дефолту?

Я говорю лишь то, что было со мной. Когда пользовался никсами основной проблемой для меня были поиск драйверов для новейших или нестандартных устройств. Не знаю где вы увидели нестабильную работу XCode (у меня он даже на хакинтоше идеально работал).

Я лишь обращу ваше внимание на один момент, попробуйте опубликовать кривое приложение в аппсторе, или нестабильное, вы замучаетесь. Я например когда начал программировать под iOS и OSx научился соблюдению правил, и более детально начал относится к мелочам в коде, и считаю что их дотошность хоть и излишняя, но приучает к дисциплине

0xd34df00d

Да, и я даже указал пример — программы, собранные прям из их VCS, а не релизные срезы. Если вы такое экспериментальное счастье поставите в свою макось, у вас же не макось будет виновата?

Он упорно зависал на этапе разбора моего C++-проекта. Эклипс, впрочем, тоже зависать любит. И тот же CLion ещё годик назад зависал, сейчас вот уже прожёвывает.

Аналогично при попытке опубликовать пакет в Debian или подобных дистрибутивах.

trilodi

Просто все познается в сравнении, я познал свое счатье в OSx, вы в Генту. У каждого свои нужды и ОС выбирается именно под эти нужды, а дальше уже возобладает привычка, вы начинаете развивать эту ОС, писать софт для нее, и все больше погружаетесь в нее. Если мне сейчас придется писать специфичный софт под Виндовс то естественно я заведу свой системник и загружу Visual Studio и не исключено что на долго погружусь туда

0xd34df00d

Ну, в принципе, да. И вы поделились тем, что слова «программирование» и «os x» для вас неразделимы, я поделился тем, что они для меня вообще не могут стоять в одной фразе без какого-нибудь отрицания рядом.

Я вообще стараюсь софт под ОС не писать. Просто даже всякие ОС-независимые вещи, вроде вычислительного эксперимента для научной работы, оказывается удобнее делать мне в Gentoo. Да и статьи потом по этим экспериментам почему-то писать проще в той же Gentoo. Отчасти потому, что я так и не понял, из какого пакетного менеджера в OS X мне поставить TeX :(

trilodi

-Я вообще стараюсь софт под ОС не писать

Ну мне по факту работы может понадобится написать подобный софт, старые заказчики иногда дают заказы подобные, и не хотят чтобы этот софт был сделан кросплатформенным на Java. Новых таких заказчиков я уже не набираю, а от старых не этично отворачиваться

0xd34df00d

Лишний раз порадовался своей работе. Там вообще особо не важно, какая ось, я в некотором смысле одни числодробилки пишу, вся работа с ОС у которых сводится к чтению файлов.

trilodi

По крайней мере за 4 года активного использования OSx мне ниразу не пришлось переустанавливать систему, в то время как на виндовсе это приходилось делать минимум 2 раза в год в то время, как тут упоминали сейчас ситуацию лучше, но привычка уже сидеть на одной ОС. На линуксе тоже какой то эксперемент, или неверно установленный критичный пакет приводили к краху системы не редко (возможно это больше зависело от плохого знания самой системы мною)

0xd34df00d

Я переустанавливал OS X на своём макбуке, которым я почти не пользуюсь, уже дважды за три года. В один прекрасный день она почему-то просто отказывается загружаться.

Давным-давно, когда я первый раз поставил себе линукс и по глупости сидел под рутом, он за неделю тоже как-то так сломался, что проще было переустановить. С тех пор я

переустанавливаю ОС только тогда, когда покупаю новое железо, да и то,переустановка сводится к копированию /etc, доводке конфигурации под новое железо, да и всё.trilodi

Возможно это мне так повезло, но 3 MacBook Air и 1 iMac у меня активно работают и используются уже 4 года, пока (тьфу тьфу тьфу) дело не доходило до полного умирания системы хотя тоже работаю под рутом. Кстати да, неосторожные движения убивавшие мои Линуксы были именно под рутом

0xd34df00d

Видимо, я невезуч. Мои жалкие попытки дебажить эти проблемы дали понять, что дело где-то в районе SSD или шлейфа к нему, но и то, и другое было в порядке по независимым тестам на других машинах, и после переустановки всё отлично работало. До поры до времени.

Под рутом, вероятно, и на OS X работать не стоит :)

trilodi

Ну вот и добились общей точки зрения))) А то не особо люблю эти баталии какая ОС лучше. Это как девушка, моя всегда лучше))))

konchok

К слову, на самсунге 4-летней(!) давности каждая следующая версия CyanogenMod работает всё быстрее и быстрее.

trilodi

Ну я не про цианоген говорил же, я про штатную прошивку, к цианогену нет никаких притензий абсолютно, он у меня и на HP TouchPad работает изумительно. Не использую кастомные прошивки на боевых аппаратах, нынче рут может спустить у вас баланс вашей карты на раз два

lybin

Палмер, похоже, норм чел :)

d_olex

Все правильно сказал, новые мак про (которые в форме ведра) — это одноразовое неапгрейдабельное говно для фанбоев Apple.

trilodi

Откиним вопрос VR или жесткой графики. А теперь факты в студию? Сколько вы проработаете на максимальной комплектации этого неапгредного *гавна без нужды его апгрейдить? Факты только факты пожалуйсто

d_olex

Вообще-то это пост именно про VR и жесткую графику, и для подобных сценариев использования отсутствие возможности воткнуть в комп видеокарту последнего поколения в момент ее выхода на рынок — это шоу стоппер.

trilodi

Постойте, мы сейчас не про пост а про ваш комментарий говорим:

-новые мак про (которые в форме ведра) — это одноразовое неапгрейдабельное говно для фанбоев Apple.

Вы не упомянули что для графики это гавно! Именно по этому я попросил факты.

d_olex

> Постойте, мы сейчас не про пост а про ваш комментарий говорим

Не мы, а вы.

> Вы не упомянули что для графики это гавно!

Это подразумевалось исходя из тематики поста.

trilodi

Изумительные аргументы! 5+

0xd34df00d

Сколько будет стоить мак с шестиядерным процессором, 64 гигами оперативной памяти, SSD на 480 гигабайт и двумя хардами по 3 терабайта? И чтобы с nVidia-карточкой. И чтобы в него сегодня можно было поставить 980-ую нвидию. И чтобы это всё счастье не шумело как самолёт даже под нагрузкой, у меня студия и я рядом с машиной сплю.

В 2013-м году я подобную машину где-то за пару тысяч долларов купил. У меня сейчас в эппломагазине получилось 5.5 тысяч долларов. Да я за такие деньги новую машину раз в три года могу себе покупать и покрыть все свои потребности на протяжении девяти лет!

И, кстати, учитывая, что три года уже прошло, а нужды апгрейдить что-либо кроме видеокарты я не испытываю, получается ещё забавнее.

BelBES

Описаная вами конфигурация под нагрузкой в любом случае будет шуметь. Одна только 980-я карта как взлетающий самолет воет при высокой нагрузке(

0xd34df00d

Ну, в моей рабочей машине сейчас вместо 980-й 660-ая, и какой-то башенный кулер Noctua на процессоре, не помню точную модель — оно не шумит вообще. Притом, что там i7-3930K, поэтому он, считайте, всё время в турбобусте на 3.8 ГГц, пока позволяет температурный режим, а он позволяет — вот, последним летом температура выше 50 градусов под нагрузкой и этим самым турбобустом не поднималась.

А 980-ую в игровой машине я не слышу даже в баттлфилде на максималочках.

BelBES

У меня 980Ti под нагрузкой (обучение нейронных сетей) воет так, что на всю комнату слышно… титаны также себя ведут.

0xd34df00d

О, ну то Ti, у меня-то обычная. Плюс, у меня не референсный дизайн, а какое-то вычурное счастье от MSI.

Хотя не знаю, что буду покупать в свою рабочую машину, когда созрею переписать штуковину, над которой сейчас работаю, на CUDA. Авось, к тому моменту что-то ещё выйдет.

d_olex

[del]

ImMetatron

Так и хорошо что оптимизируют ПО, сейчас этим такое ощущение вообще мало кто занимается.

Что мешает им оптимизировать своё ПО? У меня нет Эпла и никогда не было, и я не сторонник или противник. Просто я за оптимизацию ПО всегда ратовал, говнокодить может каждый.

sumanai

Физические ограничения.

Oculus последней версии для разработчиков требует рендеринг картинки с двух точек с разрешением FullHD и частотой в 75 Гц.

В потребительской версии разрешение обещают сделать ещё выше.

ImMetatron

Так у эпла тоже софт запускается на слабом железе, тот же видеомонтаж тогда как для PC нужно под этот софт железо топовое нужно брать, но они же оптимизируют. Что Окулусу мешает? Какие физические ограничения?

Mad__Max

То что игры (и 3d движки в общем) от которых зависит эта скорость рендеринга пишет совсем не Окулус — а разработчики соответствующих игр/движков.

ImMetatron

Ага теперь прояснилось. Я то думал что окулус им дает какой-то кит свой чтобы те оптимизировали под них. Оказывается нет. Тогда всё понятно. Говнокод и ноль оптимизации в играх вот и результат. Эпл тут не при чем.

6opoDuJIo

Говнокодят ровно настолько, насколько это нужно. Если оптимизация под слабые видяхи съест больше бюджета, чем принесёт потенциального профита — такая оптимизация будет никому не нужна. Тем не менее, индустрия живёт, не особо замечая того, что обладатели слабых компов не могут пользовать часть продуктов.

…

Хотите гарантии того, что игра запустится и будет хорошо работать? Покупайте консоль.

Может быть, VR придёт и туда.

ImMetatron

Говнокодят этим всё сказано. Не все деньгами меряется :-) Остальное и без вас очевидно.

6opoDuJIo

… в свою очередь, чисто рендер, зачастую, самая оптимизированная часть, в плане конкретно кода. От контента тоже много зависит (и конкретно контент тоже может вносить оверхед).

trilodi

Вы меня извините уже не сдержался.

Вы хоть представляете к каким финансовым потерям ведет гавнокод?

В компаниях гигантах занимающихся разработкой игру штат большой, и большая текучка, в итоге этой текучки если не следить за качеством кода и его документации не избежна гибель проекта, потому что если каждый по капле гавна капнет в эту кучу кода, то это будет уже не проект а сливная яма!

Вы вообще понимаете разницу между гавнокодом, и неотлаженым кодом или не оптимизированным кодом?

6opoDuJIo

Ок. Проведём опрос. Что, в вашем понимании, представляет из себя говнокод?

trilodi

Говнокод может быть прекрасно отлаженым, и работать на много четче даже чем красивый но неотлаженый код.

Определение гавнокода появилось от того что многие пишут код таким, что его сложно разобрать другим разработчикам, сложно даже порою самому разработчику в дальнейшем поддерживать его через какое то время, но в то же время он может быть прекрасно отлажен изначально, но в конце концов эта путаница может его испаганить.

А красивый и вылизаный код может быть не отлаженным, могут быть утечки памяти и все такое.

Но код еще может быть и красивым и чистым, и при этом хорошо отлаженным. Это очень большая редкость

Поясню почему. В больших конторах код пишет большое колличество разрабов, и есть критерии к коду, которые на 99% обычно соблюдаются, что бы другие разрабы могли его поддерживать, но при большой текучки кадров, когда разрабов срывают с проектов перекидывают на другие, а старым проектом занимается другая команда, то очень редко когда вторая команда изучает код от начала до конца, а лишь движется дальше по плану. А уже реализация может быть немного иной у другой команды, тут то и вылазиют всякие косяки в драйверах, ошибки в играх/программах/ОС который конечно оперативно стараются залатать.