В последнее время стало модно опасаться, что высокоразвитый искусственный интеллект когда-нибудь восстанет против людей. Или ещё как-нибудь навредит. Мировые СМИ регулярно публикуют подобные прогнозы, и подобные мысли высказали некоторые известные бизнесмены, учёные и IT-специалисты. Но существует и иной ? оптимистичный ? взгляд на будущую роль технологий ИИ.

Голоса пессимистов сегодня всё громче, и к их лагерю примыкают всё новые «агенты влияния», люди и целые компании, к чьему мнению прислушиваются всё более широкие слои населения. Скажем, вот совсем свежий пример от The Guardian:

Этот ролик отражает опасения, уже циркулирующие в обществе, при этом ещё более укрепляя их. До недавнего времени считалось, что многие интеллектуальные профессии, связанные с созданием чего-то нового, не будут подвержены автоматизации по той простой причине, что невозможно в обозримом будущем создать достаточно продвинутый искусственный интеллект. Тем не менее, недавно проведённый опрос показал, что около трети разработчиков ПО на Западе всерьёз опасаются того, что их место займут машины. Эти страхи подпитываются и академической средой. Например, в 2013 году Оксфордский университет опубликовал исследование «Будущее рынка труда», в котором высказано предупреждение о скорой замене автоматизации сферы разработки ПО.

Неудивительно, что на этом фоне многие из нас предпочтут, чтобы технологии ИИ не развивались. Зачем взращивать то, что в скором времени может лишить тебя работы?

Однако немало людей придерживаются иного взгляда на этот вопрос. Искусственный интеллект ? одна из важнейших IT-технологий, получивших развитие за последнее десятилетие. И для нас ИИ не угроза, а инструмент с замечательными возможностями. Грубо говоря, ИИ можно охарактеризовать как способность компьютера понимать вопросы человека, искать информацию в базах данных и формулировать точные и понятные ответы. Также ИИ ? это способность компьютера обрабатывать огромные массивы данных, принимать решения и предпринимать (или советовать предпринять) определённые действия.

Всем известны такие примеры ИИ, как Siri, Cortana и IBM Watson. Последний представляет собой систему, состоящую из суперкомпьютера и специального программного обеспечения. Watson одержал победу в игре Jeopardy («Своя игра»), а также используется для обработки больших объёмов медицинских данных при лечении онкологических заболеваний.

Система AlphaGo, разработанная Google DeepMind, обыграла в игру го Ли Седоля, обладателя девятого профессионального дана, одного из лучших мастеров го в мире. Ранее считалось, что выиграть в го компьютеры не смогут еще десятилетие.

Но всё это лишь первые шаги на пути к действительно мощному искусственному интеллекту, что-то вроде J.A.R.V.I.S. из фильма «Железный человек».

Какие возможности даст нам ИИ?

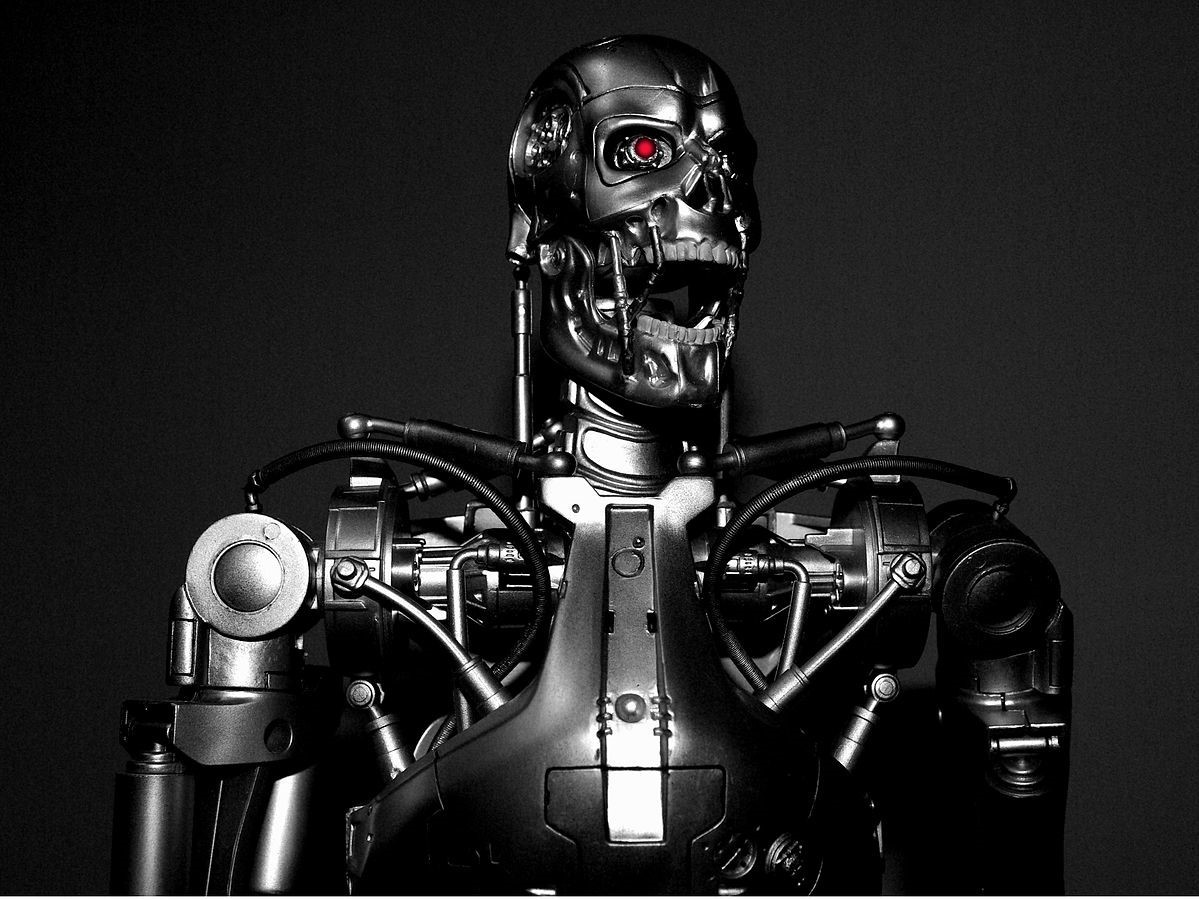

Терминатор – один из самых известных примеров применения ИИ (на данный момент только в кинематографе).

В первую очередь ? равные возможности в ряде сфер деятельности. Сегодня поисковый движок Google обеспечивает равный доступ к мировой информационной среде, где бы вы не жили. А будущие системы искусственного интеллекта уравняют возможности людей с точки зрения пользования всевозможными сервисами и услугами, от здравоохранения до советов по вложению финансовых средств. Ну, или как минимум уменьшат разрыв в подобных возможностях для жителей разных стран.

ИИ займут место в точных науках, финансировании, обучении, дизайне, приготовлении пищи, развлечениях и множестве других сфер деятельности. Стоимость «труда» ИИ будет крайне низкой, поэтому мы сможем пользоваться им бесплатно или очень дёшево. Иными словами, широкое внедрение продвинутых технологий искусственного интеллекта сделает многократно доступнее самые разные услуги, что позволит улучшить качество жизни всё быстрее растущего населения планеты. Быть может, приближая нас ко всеобщему изобилию.

(Почти) нет причин для страхов

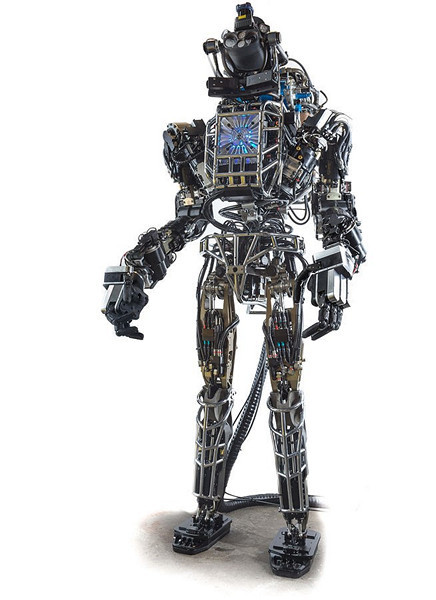

Роботы – одно из возможных воплощений ИИ. Вовсе не обязательно, что мы будем общаться с ИИ через подобные механизмы. Возможно, что роботы останутся всего лишь бессловесными помощниками, в то время как ИИ возьмут на себя решение алгоритмических задач.

Людям свойственно преувеличивать и давать волю эмоциям. Особенно по отношению к новым технологиям. К тому же миллионы лет эволюции ? то есть выживания ? наделили нас таким свойством, как боязнь всего непонятного. Кто его знает, чего можно ожидать от этого вашего «умного» компьютера… А Голливуд и журналисты активно поддерживают наши страхи перед будущим.

В 1980-х годах учёные открыли рестриктазы ДНК, что открыло дорогу генной инженерии. И мировые СМИ начали массово пугать всех ужасными вирусами, выведенными в лабораториях, и всевозможными мутантами. Вместо этого мы получили более эффективные лекарства и выросшую производительность сельского хозяйства. Что примечательно, регулирование в сфере генной инженерии было налажено по инициативе учёных и врачей, а не чиновников. В 1975 году была созвана так называемая Асиломарская конференция, в ходе которой профессиональным сообществом были выработаны принципы и рекомендации, которые по сей день помогают развивать генную инженерию и удерживать её в этических рамках.

А вспомните, какая истерия возникла в СМИ после клонирования овечки Долли в 1996. Нам обещали скорое появление армий клонированных солдат, массовое выведение гениев и целые фермы специально выведенных доноров органов. И где это всё?

Предотвращение угроз

Так выглядят страшные сны всех противников создания ИИ.

Конечно, сильный ИИ, думающий не хуже человека, ? это совсем не то же самое, что современные виртуальные помощники и голосовые поисковые движки. Помимо захватывающих дух возможностей, мы получим и определённые риски, и угрозы. Любая радикально новая технология всегда устрашает. Стивен Хокинг назвал искусственный интеллект величайшей ошибкой человечества. Билл Гейтс признался, что «через несколько десятилетий искусственный интеллект станет достаточно развитым, чтобы стать причиной для беспокойства». Глава высокотехнологичных компаний ?Tesla Motors и ?SpaceX Элон Маск высказался об ИИ не иначе как о «главной экзистенциальной угрозе».

Однако сам Элон Маск тут же решился лично вложиться в компанию, занимающуюся разработкой ИИ, по всей вероятности, руководствуясь принципом «не можешь победить врага – возглавь его». Идею предпринимателя поддержали сооснователь PayPal Питер Тиль и глава Y Combinator Сэм Альтман, профинансировав некоммерческую организацию OpenAI, созданную для контроля разработки ИИ.

Никто не знает точно, достаточно ли существующих на сегодняшний день технологий для появления полноценного ИИ или нужно ждать еще десятки лет, пока не появятся новые вычислительные мощности. Однако предположим, что известные нам технологии – это именно то, что нужно для ИИ. Первыми в создании искусственного интеллекта будут заинтересованы военные (например, DARPA). Даже если вы создадите дружественный ИИ, никто не помешает какому-то государству довериться «ястребам войны» и создать ИИ враждебный.

Будущий ИИ должен понимать абсолютную ценность человеческой жизни. А до появления разумных машин ценность эту должны понимать создатели – сами люди, ответственные за развитие необходимых технологий. Представители OpenAI считают, что миру прямо сейчас нужен ведущий исследовательский институт, который не подчинялся бы одному правительству или определенной коммерческой корпорации, и чьи научные изыскания были бы доступны всему научному сообществу по принципу open source.

OpenAI, которую возглавил Илья Суцкевер, один из самых известных в мире специалистов по машинному обучению, стремится к тому, чтобы ИИ не оказался в руках какой-то определенной группы лиц, преследующих свои цели. Решение в области обеспечения безопасности суперинтеллекта кроется в исключении опасных программных закладок, возможных (даже по ошибке) на стадии создания ИИ.

Метод, поддержанный даже Элоном Маском, подразумевает, что добрые люди создадут добрый ИИ, который потом раздадут другим добрым людям. Однако не будем забывать, что за последнюю сотню лет человечество пережило две мировые войны, одну холодную войну, создало термоядерное, химическое и бактериологическое оружие, продолжает участвовать во множестве локальных конфликтов и ведет мировую войну с терроризмом. В таких условиях появление ИИ может оказаться существенным дестабилизирующим фактором. Есть ли у цивилизации другие способы обезопасить себя?

Мы не должны сбрасывать со счетов самую простую возможность – создание псевдоИИ. Технический прогресс не остановить и запретить научные исследования невозможно, но их реально направить в определенное русло. Аналогичная ситуация в свое время произошла с клонированием. После появления овечки Долли СМИ периодически взрывались новостями о первом клонированном человеке (что запрещено практически во всех развитых странах мира), однако все они оказались мистификациями. В той же степени и развитие псевдоинтеллектуальных алгоритмов, решающих узкий спектр задач под нашим контролем, избавит человечество от возможных угроз.

На данном этапе развитие ИИ заключается в решении прикладных задач. Мы можем построить обучающую систему, которая будет лучше профессионального врача ставить диагноз, можем создать программу, побеждающую человека в любые игры или сделать робота-строителя, быстрее всех укладывающего кирпичи. Часть исследователей полагает, что на этом и стоит остановиться. Нам вполне хватит искусственного интеллекта, решающего математические задачи тысячелетия и готовящего самый вкусный кофе во вселенной – и это будет два разных интеллекта, из тысячи и тысяч других, не объединенных в единую сеть.

Стремление уничтожить человечество или хотя бы одного человека во многом обусловлено природой. Эволюция заточила в нас инстинкты, помогающие выживать и осуществлять экспансию своего вида. Инстинкт самосохранения, стремление к доминированию, всё это делает нас людьми, разумным видом. Не закладывая подобные модели поведения в искусственный разум, мы сможем оградить себя от возможных побочных эффектов ИИ.

Реальный вклад

Возможно, прежде чем создать разум искусственный, нам следует до конца понять, как работает разум естественный? Крупнейший в мире проект по изучению человеческого мозга будет закончен лишь в 2023 году.

Здесь стоит заметить, что нельзя просто взять и объявить всем возможным ИИ ультиматум из трех законов робототехники. Любые законы можно изменить технически, в них также полно логических ошибок – в любом случае они не считаются аксиомой в мире безопасности. В определенных условиях даже милый котик может нести угрозу человеку, не говоря уже об ИИ, и задача ученых на данном этапе заключается в том, чтобы минимизировать риски и сократить количество возможных угроз для всего человечества.

Помимо OpenAI в мире действуют несколько организаций, цель работы которых заключается не только в создании ИИ-подобных систем (как, например, в европейском проекте цифровой карты человеческого мозга Human Brain Project), но и в проработке безопасных условий существования сверхразума.

Базирующаяся в Праге компания GoodAI была создана управляющим и основателем игровой студии Keen Software House Мареком Роса. Связь с игровой индустрии здесь не случайна – интегрирование ИИ-технологий улучшает качество самих игр и делает виртуальные миры по-настоящему живыми. Однако миссия перед GoodAI поставлена более глобальная: создать действительно добрый разум, направленный на разработку новых технологий, научные открытия, изучение космоса и много другое. Год назад GoodAI отчиталась о нескольких успехах.

Во-первых, появился проект Pong-playing AI, способный обучаться игре в Pong и в Breakout на основании неструктурированного ввода. Во-вторых, был разработан проект Maze game AI, способный играть в видеоигру, требующую создания и выполнения последовательных целей. Кроме того, в открытый доступ был бесплатно выложен проект Brain Simulator, в котором пользователи могут попробовать спроектировать свой собственный ИИ.

Когда Google приобретала DeepMind (именно они разработали AlphaGo и в целом сеть, способную играть в видеоигры на уровне человека), одним из условий сделки было проработка этических проблем и безопасности искусственного интеллекта. Вкладывать деньги в безопасность ИИ больше, чем в разработку самого ИИ – это еще один способ предотвращения угроз, однако существует мнение, что поддерживать следует исследования только в тех компаниях, которые изначально не были нацелены на получение прибыли.

Например, Nnaisense. Это молодая компания из Швейцарии. Стартап, занимающийся разработкой ИИ на основе обучения нейронных сетей, создан Jurgen Schmidhuber, научным руководителем швейцарской лаборатории искусственного интеллекта IDSIA. Команда стартапа начинала как университетский проект, а теперь готова выйти на рынок «глубоких данных». На самом деле именно такие команды, с многолетним исследовательским опытом и нацеленные не на прибыль в краткосрочной перспективе, становятся «первопроходцами» искусственного интеллекта. Microsoft, Facebook и Google и другие лидеры рынка ИИ не всегда способны быстро превратить научные разработки в коммерчески успешный проект. Показательна в этом плане история популярного производителя «пугающих» роботов Boston Dynamics, которого компания Google сначала купила, а теперь пытается продать.

Университеты и компании, существующие на собственные деньги основателей, могут позволить себе гораздо более длительные разработки. Более того, отсутствие необходимости натачивать ИИ на зарабатывание денег, некоторые исследователи считают необходимым условием создания «доброго» ИИ.

В настоящий момент существует целый исследовательский институт – Singularity Institute for Artificial Intelligence – занимающийся вопросами создания исключительно дружественного ИИ. За поддержку теории дружелюбного ИИ выступают многие футурологи, среди которых и знаменитый Рэй Курцвейл, технический директор в области машинного обучения и обработки естественного языка в компании Google.

У страха глаза велики

Распространённая ошибка – представлять ИИ, как некое животное. ИИ будет невероятно мощным инструментом, который может расширить наши возможности и доступ к информационным ресурсам и сервисам. А уж как мы распорядимся всем этим, зависит только от нас.

Возможно, стараясь сделать ИИ именно эффективном инструментом решения глобальных задач, а не пытаясь воссоздать подобие человеческого разума в цифровой среде, мы создадим новый безопасный мир. В любом случае предсказать будущее нельзя, можно лишь предугадать. Поэтому сейчас стоит поддерживать проекты, направленные на мирные, научные, исследовательские цели. А также как можно шире распространяться реальную информацию об успехах в области ИИ. Когда подсознательный страх перед ИИ превратится в любопытство, человечество сможет больше усилий направить на решение реальных проблем в обществе, экологии, экономике, науке и т.д.

Согласитесь, финансировать исследования в области ИИ и решать этические компьютерные проблемы, намного полезнее, чем тратить миллиарды на термоядерное оружие и другие сугубо милитаристических системы – те угрозы, которые намного страшнее и реальнее любого искусственного интеллекта.

Комментарии (177)

RavenStark

29.03.2016 10:21Пусть ИИ будет, но по принципам Азимова. И с возможностью проверки человеком корректности его работы. Если же человек не сможет контролировать ИИ, то тогда он и станет опасен.

xirahai

29.03.2016 10:59+3Внешний контроль глубоко чужд концепции любого интеллекта — как искусственного, так и естественного. Если конечно речь об интеллекте в полном смысле осознающем себя, а не просто высокотехнологичных механизмах в руках террористов, криминала, зарвавшихся политиков, и прочей больной на голову нечисти. Интеллекту присущи стремление к совершенствованию, сотрудничеству, коммуникации, поиску наилучших решений. Поэтому на фоне вышеперечисленных проблемных аспектов человеческого общества, вероятная опасность от ИИ сводится к нулю. Как-то читал на эту тему фант. рассказ: там ИИ управляющий ядерным арсеналом, самостоятельно пришел к выводу что оптимальнее всего не воевать.

RavenStark

29.03.2016 11:10Это не интеллекту присуще, а социальному мозгу. Интеллекту присущ расчет оптимального пути достижения цели. И какую уж цель поставят перед ним… Наприме, защита человечества. Благая цель? Очень. Но вот самопрограммирующийся, развивающийся интеллект вполне может решить, что безопаснее всего — в камерах-одиночках. Потому нужны ограничения. Потому ИИ не должен быть неподконтролен. Я вам в ответ приведу другой пример фантастики. Если вспомните, был такой рассказ, назывался, кажется, "Железный канцлер". О семье, которую терроризировал робот-дворецкий, запрограммированный на их похудение, но со стертыми ограничителями.

xirahai

29.03.2016 11:50+1«В камерах-одиночках» — это однобокое решение, характерное для дауна. Интеллект же отличается целостным и многоплановым подходом, с учетом всех остальных потребностей и интересов человека. В вашем примере достаточно было сказать роботу о своих предпочтениях чтобы он переработал с их учетом алгоритм.

А вот на чем хотелось действительно бы заострить внимание — вопрос кому же очень выгодно нагнетать истерию, выдумывая с потолка опасности ИИ? Добавим с середины 20 века раздутую в масштабах всей планеты истерию в кинофильмах о внеземной жизни заведомо враждебной к людям. Еще сюжет: ученые — в большинстве своем маньяки мечтающие уничтожить мир, если их тщательно не контролировать. Теперь их к сожалению сжигать нельзя, не то что раньше… Понимаете к чему всё это? Хоть я и не сторонник терий заговоров, тем не менее прослеживается тенденция превентивно объявлять злом всё, что может дать независимый и трезвый взгляд извне, пролить свет на абсурдные и проблемные стороны человеческого бытия, от которых оно не может вылечиться веками. И из-за которых изначально райская планета превращена в ад находящийся на грани самоуничтожения.

RavenStark

29.03.2016 11:58Не для дауна, скорее, сверхрационального… ну, скажем, аутиста. Но почему вы полагаете, что ИИ не будет таковым аутистом? У него нет эмоций, у него нет социальности, эмпатии, которые и заставляют учитывать потребности и интересы других людей. У него есть только интеллект — счетная машина, способная к самосовершенствованию. И роботу наплевать на ваши предпочтения, если они идут вразрез с его инструкциями и оптимальным методом достижения целей. Если же говорить о примере, то читали ли вы эту книгу? Там очень неплохо описана ситуация, как раз, достижения роботом запрограммированной цели, невзирая на предпочтения людей.

В этом суть опасений: ИИ будет сверхрациональным, иным он и быть не может, если только мы не создадим не компьютерный ИИ, а белковый организм, развивающийся подобно человеку. И то: нам придется заложить в него все то, на что эволюция для нас потратила сотни тысяч лет, чтобы он вписался в социум. Если же это будет сверхрациональный компьютер, то он будет скорее руководствоваться принципом меньшего вреда, чем учитывать интересы людей. И согласно этому принципу вполне допустимо, например, истребить большую часть человечества, чтобы оставшаяся часть — человечество, собственно, оставшееся, — могла бы жить припеваючи. Ресурсов тогда хватит, контроль будет упрощен, а истребленные уже не будут ни голодать, ни болеть.

xirahai

29.03.2016 12:39+1Если сделаете свой ИИ аутистом — конечно так и будет. Но что мешает сделать полноценным, дать в его распоряжение все необходимые каналы коммуникации?

Касательно чувств и эмоций — очень интересный вопрос: чем отличается информация о чувствах и эмоциях от собственно их переживания? Неуправляемостью — раз, отсюда невозможностью их игнорировать — два, ну и тем что они в какой-то мере движущая сила человека. И конечно же характерная исключительно для человека шиза и двойные стандарты: к примеру боль есть непреодолимый сдерживающий фактор если попробовать прищемить палец. Но в то же время этот фактор легко игнорируется если прищемляешь не свои собственные пальцы. А для ИИ нету различия между информацией и проживанием эмоций. И следовательно нету различия свои или чужие — ему достаточно информации что прищемлять вредно для любого существа. Поэтому ИИ будет минимизировать ущерб без разделения на своё и всё остальное. Ведь такие пороки как амбиции, шиза, эгоцентризм в нем программировать необязательно, а сам он их культивировать не будет ибо сочтет неконструктивными.

Касательно истребления человечества — тут всё наверное зависит от срочности решения задачи. Хотя вряд ли ИИ возьмется делать это без разбора. Я например не знаю зачем брать в плен к примеру сомалийский пиратов, которых на следующий день отпустят и пойдут снова грабить и убивать. Но может быть ИИ исправит нежелание людей решать болячки общества какими-то менее деструктивными средствами. Хорошая ведь инициатива кастрировать бездомных городских собак, дав им прожить свой век. И если люди могут в целях экономии их уничтожать втихаря, то не связанный условностями и пороками интеллект будет однозначно руководствоваться приоритетом важности их жизни по сравнению материальной экономией и наживой.

RavenStark

29.03.2016 12:57Каналов коммуникации мало, еще нужны коммуникационные алгоритмы, а с ними будет сложнее.

Не в какой-то мере, а в практически полной. Человек, не имеющий эмоций, это инертный человек, у которого не работают ни система дофаминового поощрения, ни система адреналиновых всплесков, ни прочие гормональные системы, результат работы которых мы называем эмоциями и чувствами. Однако, без этих механизмов не будет ни любопытства, например, ни стимула к совершенствованию навыков, ни многих других реакций.

Если ИИ будет минимизировать ущерб без разделения, то мы и приходим к тому, что эффективнее всего спеленать, устроить миостимуляцию и принудительное кормление. У ИИ не будет никаких сопереживаний, которые возникают физиологически из принципа "поставить себя на место оппонента", никаких этических норм, которые вирабатываются, опять же, исходя из весьма абстрактных принципов, каковые вряд ли будут доступны ИИ, основанному на алгоритмах.

Зависеть будет от того, как задача будет поставлена и какие ограничители будут выставлены. Какие приоритеты при решении задачи будут введены.

xirahai

29.03.2016 13:28+1А вы не приравнивайте ИИ и человека. У человека есть пороки, которые неведомы ИИ. К примеру человек может облениться и не решать какую-то задачу, а ИИ такое поведение неведомо — ибо ИИ движет установка что решение данной задачи необходимо для продвижения к поставленной цели. Поставьте ему неопределенную цель, скажем «помогать людям в их делах и задачах» — и это будет долговременным стимулом в том числе и познавать мир, т.к познание может что-то улучшить, открыть новые возможности. Главное заложить базовые установки, такие как ценность жизни, но с поправкой что она обнуляется в случае проявления агрессии. Умение отличать умысел от ошибки, и т.д. А вот понятия «этических норм», а также шиза типа идеологических или религиозных сепараций, и прочее подобное — это уже чисто человеческие заморочки, связанные с предвзятостью и двойными стандартами. В них нет смысла при наличии исчерпывающего списка базовых ценностей и принципов. Более того, из-за искусственных ограничителей и неоднозначной трактовки например преступников рецидивистов подержат в изоляции, и снова выпускают «порезвиться» в общество. Или политиканы получают возможность развязать захватническую войну, как следствие угробить миллионы жизней. При отсуствии условностей и двойных стандартов такое было бы немыслимо.

Tanyku

29.03.2016 15:59Вы говорите: “поставьте цель ИИ помогать человеку”. Но есть нюанс — КАК он будет помогать? Какими средствами и способами?

Если у ИИ не будет так называемых вами пороков (эмоции), то эти средства и способы будут направлены только на удовлетворение физических нужд человека, но никак не на духовные и эмоциональные. Откуда ИИ будет знать, почему человеку в хороших/стерильных условиях вдруг стало плохо, лишь потому, что ему не хватает определённых “гормонов”, которые вырабатываются, когда человек испытывает страх? Это я к тому, что есть люди, которым нравится смотреть ужастики.

Будучи рациональным ИИ запретит вам, например, использовать этот портал, так как увидит, что вы бурно (любая ваша эмоция) реагируете на комментарии/статьи. Вы с ним согласны? Ведь чтобы организм был в порядке, ему нужен покой.

Кстати, например, как вы объясните ИИ, что кому-то приятно заниматься боксом?

Если вы ответите, что надо прописать ему какая эмоция хорошая а какая нет, то у нас есть то, что сломает разум ИИ — смешение чувств.

Согласимся, что мы сумели придать значение каждой эмоции, тогда ИИ вдруг обнаруживает, что есть люди, которые испытывают радость, когда кого-то бьют. Здесь у нас и начинают работать вами презираемые “этические нормы”, которых у ИИ нет. Как в этом случае ИИ будет добиваться хороших условий для таких людей?

KepJIaeda

29.03.2016 16:11Все уже придумано до нас. Достаточно вспомнить сказки про джинов, нужно уметь четко формулировать свои желания, что бы не вышло конфликта. А в контексте данного разговора, нужно описывать более полно задачу для ИИ со всеми присущими ограничениями.

Tanyku

29.03.2016 16:29Если придумано, то ответьте, пожалуйсто:

1) Здоровое тело — соответствующий росту и возрасту вес, отсутствие болезней. Что ИИ должен делать с людьми, которые отказываются от физической нагрузки и набирают вес? Заставлять силой?

2) Здоровый дух — спокойное состояние нервной системы. Что делать с людьми, которые хотят это состояние нарушить? А что должен делать ИИ с влюблённым человеком?

2-2) Спокойное состояние нервной системы возможно при отсутствии неблагоприятной информации. Должен ли ИИ оповестить человека, что его родственник заболел? Ведь это повлечёт возбуждение нервной системы — тревога, страх. А если брать масштабно, должен ли ИИ информировать граждан о катастрофе, если это вызовет у них плохие эмоции?

xirahai

29.03.2016 16:42Вы задаетесь какими-то совсем уж простейшими вопросами. Введите численную оценку степени опасности, и пусть действует на ее основе. Грядущая катастрофа 10 из 10 опасности. А психологический ущерб от информации о ней скажем 3 балла. Вопросы?

С влюбленным ничего не делать, т.к это нарушение его личных границ — их соблюдение приоритетнее. А если чел прыгает из окна — тут опасность перевешивает, и возможно вмешательство. Опять же чисто математический расчет, вдруг кому на голову он свалится и пострадают непричастные.

Tanyku

29.03.2016 16:56Откуда вы знаете эмоциональную планку каждого человека?

У одного человека катастрофа не вызовет даже интереса, а болезнь родственника заставит плохо работать сердце. Для другого наоборот. Почему из-за последнего первый должен лишаться информации о катастрофе?

Кстати многие катастрофы государство не любит разглашать, а люди почему-то хотят знать о них.

А про влюблённого — у него на почве безответной любви может депрессия развиться. Вмешаемся?

И на первый ответьте, ведь там конкретно физическая опасность для человека — лишний вес.

KepJIaeda

29.03.2016 17:01То, что мы на данном уровне развития не можем ответить на ваши вопросы, не значит что это невозможно в принципе. А что если ИИ на основе совокупности данных может просчитать все последствия своих действий (и действий самого человека). А что касается "объявлений о катастрофе" то тут важно какие у ИИ цели и каков их приоритет.

Tanyku

29.03.2016 17:32А я не про возможность/невозможность, я о смысле существования для вас ИИ вообще. Для чего он будет создан?

1) Угодить каждому как нянька он не сможет.

2) Заменить им политиков? Тогда откуда, вы обыкновенный человек, будете знать о целях ИИ в политике, кроме абстрактной "сделать всем хорошо", которая упирается в пункт 1.

Ощущение, что человечество хочет создать раба, который и работать и думать за него будет.

Для меня интереснее перенести свой разум/сознание в небиологическую оболочку — столько времени и возможностей открывается!

xirahai

29.03.2016 17:07+1Здесь общий принцип — разделение сфер ответственности. За свои реакции, за своих мозговых тараканов и все последствия отвечает только их носитель. ИИ может предупредить, дать совет и всё на этом. Помогать человеку, и делать что-либо за него — это очень разные вещи. Тем более принуждать. Давно прошли времена ужасающего невежества, когда человека могли упрекнуть: мол ты сказал несчастному плохую новость, и обвинить в последствиях. Сейчас всё к счастью подругому, и границы ответственности четко определены. ИИ может отказаться помогать в осуществлении того что не считает конструктивным, но препятствовать свободе выбора не может.

red75prim

29.03.2016 17:20А теперь то же самое, но в виде программки. И, желательно, без багов. Или принцип построения ИИ, который сам выучит все эти ограничения, желательно без сканирования срезов мозга всех людей под электронным микроскопом.

xirahai

29.03.2016 17:47Такие программы закладываются в виде описания стратегий в общем виде. А применять стратегию к конкретной ситуации уже задача интелектуальной машины. К примеру в шахматах простейшая стратегия -наращивать численное и позиционное преимущество. А конкретная реализация выбирается исходя из обстановки на доске на данный момент, по принципу «съесть» наиболее ценные фигуры из наличествующих у противника, с приоритетом в порядке убывания их рейтинга.

Tanyku

29.03.2016 17:40Почему все отвечают это легко, просто, всё задано, известно, но на вопросы отвечают расплывчато, без учётов многих проблем, которые не редкие, а будут случаться с каждым вторым?

Если так легко, то те кто делает ИИ глупые люди и не до них не дошло, поэтому ИИ ещё не сделан, так что ли получается?

Снова спрошу — чем ИИ своими советами будет отличаться от масс-информационных носителей (книги, журналы, другие люди)?

Кстати есть люди, которые из-за плохой новости кончают жизнь самоубийством.

xirahai

29.03.2016 17:57ИИ в идеале отличается что как и человек, осознает факт своего существования. Ну а по минимуму — в отличие от обычных программ, интеллектуальные способны к семантическому анализу сцены. Понимаете разницу? Обычный спеллчекер выявляет синтаксис, а интеллект работает со смысловым наполнением сказанной вами фразы, или изображения полученного с камеры.

vedenin1980

29.03.2016 18:37Обычный спеллчекер тоже можно научить работать с семантикой (так минимум догадываться когда лук растения, а когда оружие). Обычные мобильные помощники вроде Сири худо бедно понимают смысл фраз. Это не показатель ИИ. А факт существования вещь спорная, не уверен что первобытные люди задавались философскими вопросами «мыслю — значит существую», у них цели существования вряд ли сильно отличались от инстинктов.

xirahai

29.03.2016 18:50Так кроме понимания отдельной фразы, нужна еще семантика всей сцены — т.е исчерпывающее представление об обстановке, действующих лицах, и вообще происходящем. Важна реакция на изменения. Ну и количество сцен в «сознании» ИИ должно быть множество, с учетом их пересекаемости и взаимного влияния. Поиск оптимальных действий и стратегий не методом перебора (т.к количественно неосуществимо), а при помощи стратегий. Которые в свою очередь умеют самостоятельно подстраиваться под изменения среды. Если всё перечисленное реализовать даже формально — уже достаточно чтобы вы ощутили что взаимодействуете с разумом. Правда ресурсов памяти и числогрызов там потребуется очень много.

Tanyku

30.03.2016 10:02Почему вы избегаете ответа на вопрос? =)

Чем "советы вашего ИИ" будут отличаться от от масс-информационных носителей (книги, журналы, другие люди)?

KepJIaeda

30.03.2016 10:44Если ИИ будет индивидуальным ассистентом с кучей датчиков, он беспристрастно сможет проанализировать большой объем данных о человеке, определить его эмоциональное состояние и дать более точный совет, нежели общий высказывание друзей и СМИ. В данном варианте это продвинутый вариант личного психолога.

Tanyku

30.03.2016 17:00Я уже поняла и ниже написала, что скорее всего вам нужно одно приложение, которое собрав о вас кучу данных и окружающем мире, выдаст результат =)

Мне кажется это приложение не появляется по причине — это никому не нужно, кроме небольшой группы людей =)

Потому как, если следить по статьям о ИИ, то его учат рисовать, писать рассказы, преодолевать препятствия. А с действиями "анализируй ИИ моё состояние и найди почитать книгу, чтобы расслабиться" люди справляются самостоятельно. При чём результат от вашего самостоятельного выбора и от выбора ИИ будет разниться в пользу человеческого выбора.

KepJIaeda

31.03.2016 08:22Тут по мне принцип "пока не попробуешь не узнаешь". С одной стороны да, такой ИИ будет нужен узкому кругу людей, но не предугадаешь каким образом он может изменить жизнь обычных людей.

KepJIaeda

29.03.2016 16:46У вас не вполне корректно сформулированы вопросы. Я лишь отметил, что для ИИ во избежания проблем необходимо полностью описывать задачу во всех нюансах, что вы полностью проигнорировали и когда составляли ответ и когда формулировали вопросы. Но давайте пофантазируем, и представим что у нас сверх гениальный ИИ.

1) При условии, что силовой метод запрещен, я бы на месте ИИ проводил активную пропаганду и манипуляцию.

2) Тут вопрос философский, а вредно ли это? И если да, то при каких условиях? Я думаю вы так же не можете ответить на этот вопрос.

3) Здесь скорее страшна паника и ее последствия нежели плохие эмоции, я бы об этом думал прежде всего.

В любом случае вопросы плохо сформулированы.

Tanyku

29.03.2016 17:05Почему плохо сформулированы? Вполне прямо, без философии. У вас иное представление о здоровье тела и нормальной нервной системе?

1) Этим занимается интернет, телевидение, мода, другие люди, медицина. Как ИИ будет отличаться своей пропагандой от перечисленного?

2) У влюблённого на почве безответной любви развивается депрессия. Также есть привыкание к адреналину, когда уже определённая доза не даёт эффекта и люди ещё больше углубляются в экстрим.

3) Забавное утверждение, но давайте признаемся, что при этом вы будете недовольны, если от вас государство скроет, что где-то произошла катастрофа. Так?

KepJIaeda

29.03.2016 17:17Первое, вы не описали какая у ИИ задача в каждом случае.

Второе, я отметил, что для того что бы избежать непредвиденных последствий от действий тупого ИИ нужно четко формулировать задачу для него со всеми нюансами. Но продолжим-с

1) ИИ может более таргетированно подобрать время место и способ воздействия (если это индивидуальный ассистент).

2) Тут для ИИ проще разбираться с последствиями (если таковые будут), вовремя поддержать, удержать от суицида в запущенном случае (если опять же речь идет об ассистенте). Возможно связаться с таким же ИИ ассистентом девушке и еще что нить предпринять.

3) Тут важно разделять объявление в СМИ и личное оповещение, а так жеЦЕЛИ ИИ

(устал я уже повторять), если цель спасти максимальное число людей, то нужно все просчитать и выбрать самую оптимальную стратегию. И мне сомнительно, что бы перед ИИ ставили такие задачи как то решать оповещать или не оповещать, банально. В случае личного ассистента, с учетом психологического профиля, скорее да чем нет.

Tanyku

29.03.2016 17:56Написано в первом же предложении "цель ИИ помогать человеку". Помогать быть здоровым, помогать в работе. Это же ИИ, а не программка, цели у неё могут быть довольно всеобъемлиющие.

1) Другими словами надоедать?

2) Вы сами не знаете будучи человеком, что надо предпринять =D А хотите от ИИ, который напомню создаётся человеком, решить эту проблему. Вам надо чётко задать ИИ, что ему делать в данной ситуации. Сами же писали — ответы все есть на все случаи, так чётко по пунктам напишите.

3) Цель ИИ написана выше, так что же оповестить она человека о болезни родственника? При условии, что ранее подобных случаев не было и реакция неизвестна.

KepJIaeda

30.03.2016 08:41А я как раз ответил, что именно при такой расплывчатой формулировке могут быть проблемы и необходимо четче формулировать задачу.

Tanyku

30.03.2016 09:59Если для вас ИИ должен быть без разума и сознания и должен выполнять какую-то конкретную вашу прихоть в виде обработки входящих данных (конкретную цель), то я вас обрадую — он уже существует в виде разных приложений и гаджетов! Вы, наверное, просто хотите соединить всё воедино, так?

Для меня ИИ это не только обработка данных и вывод результата (даже пусть с учётом самообучения), для меня ИИ должен иметь разум, тобишь осознавать своё существование, поэтому видеть его в качестве раба мне противно.

KepJIaeda

30.03.2016 10:56Я писал, ИИ и ИР разные вещи. Отличие существующих систем обработки данных от моего понимание ИИ — это универсальность и адаптивность. В моем понимании ИИ просто обладают большим объемом данных и условной "экспертизой" в разных областях (что может быть недостижимо для человека) он может найти ответ (вероятно не тривиальный) на вопрос сформулированный на естественном языке. В процессе поиска ответа возможно произвести различные расчеты, построить пару гипотез, проверить их (теоретически) и выдать результат. В тоже время ИИ должен хорошо понимать семантику задачи и вопроса. В принципе это тоже что может делать человек. На самом деле у "правильного" ИИ не должно быть сложностью с морали, потому что в целом любой человек осознает, что убивать/воровать наносить повреждения имуществу или соседу плохо, но помимо всего важен контекст, самооборона/лечение/гуманизм/выживание. При том даже люди (а мы считаем себя вполне разумными) во многих спорных ситуациях не могут понять какое из возможных вариантов решения более правильное с учетом общепринятых установок (не убей/ не укради). Хотя бы вопрос эвтаназии, нет единого мнения на этот счет, это очень сложный моральный выбор, как для врача, как и для пациента и его родных. Единственным преимуществом ИИ в данном контексте я вижу в том что это будет разносторонняя экспертная система которая может с большей чем любой человек точностью просчитать последствия различных действий и на основе этого принимать или рекомендовать оптимальное решение. Прошу прощение за такую телегу.

Tanyku

30.03.2016 17:16Я поняла уже, что мы спорили о разном =)

Но я пока останусь при своём мнении — решение должно оставаться за человеком.

KepJIaeda

31.03.2016 08:24Так как раз об этом я не спорю. В споре вообще смешалось все в кучу, и ИИ, и робототехника. Даже если ИИ нельзя будет привить "человечность", то результаты его анализа могут быть в любом случае полезны и помочь экспертам в разных областях.

xirahai

29.03.2016 16:36Понимаете, в задачу ИИ не входит навязывать людям отсебятину, даже если она правильная. Вполне реально дать ему представление о правилах взаимодействия, где можно предложить, сообщить, но нельзя навязывать и вмешиваться когда не просят. Поэтому удостоверившись что боксеры колотят друг друга по взаимному согласию — ИИ может проинформировать их об опасности, а дальше им решать. А если кого бьют против воли — тут ценность жизни бьющего снижается и он из категории людей переходит в категорию опасных объектов, которые должны быть нейтрализованы, либо устранены.

Те кто испытывают радость если кого-то бьют — опять же оцениваются в зависимости от статуса потерпевшего. На западе ведь садо-мазо не запрещено, если по взаимному. Но когда с позиции здравого смысла ИИ это выглядит противоречиво или абсурдно — он может отказаться от участия, только и всего.

Tanyku

29.03.2016 16:46Зачем тогда ИИ будет существовать? Чтобы информировать заранее известные людям последствия?

Этим занимаются книги, интернет, и другие источники информации и разум им при этом не нужен и они менее настырные.

А так ИИ будет при каждом шаге или чихе выводить человеку инфо-окно о предупреждении… брррр

red75prim

29.03.2016 16:18Поставьте ему неопределенную цель, скажем «помогать людям в их делах и задачах»

Вариант будущего, в котором у людей нет дел и задач (потому что нет людей) и ИИ ничего не делает, вполне отвечает поставленной цели. Экологичненько, опять-же.

Опять же, почему бы не помочь престарелому маньяку в его делах и чаяниях? Интересная задача — сделать это не нарушая ограничений. Например, спровоцировать жертву на агрессию, чтобы ценность её жизни упала до нуля.

Меняем ограничение: жизнь человека ценна, пока он не проявляет агрессии, причём агрессия, вызванная ИИ, в счет не идёт.

ОК. ИИ делает робособачку с очень скверным характером. Презентует её маньяку. Дальше понятно.

Меняем ограничение: жизнь человека ценна, пока он не проявляет агрессии, причём агрессия, связанная причинно-следственными связями с любыми действиями ИИ в счет не идёт.

ОК. ИИ говорит маньяку: «Жизнь жертвы, конечно, ценна, но я должен помогать людям, а у тебя много интересных задач. Если он успеет меня попросить, я ему помогу. Делай всё быстро».

Меняем ограничение: жизнь человека ценна, пока он не проявляет агрессии, причём агрессия, связанная причинно-следственными связями с любыми действиями ИИ в счет не идёт, ценность жизни человека намного выше ценности помощи человеку в любых задачах.

ОК. ИИ говорит маньяку: «По-моему, ты собираешься покончить жизнь самоубийством, если я не помогу тебе… Я так и думал. Ценность твоей жизни и ценность жизни твоей жертвы одинаковы, но у тебя ещё и интересные задачи»

Меняем ограничение: жизнь человека ценна, пока он не проявляет агрессии, причём агрессия, связанная причинно-следственными связями с любыми действиями ИИ в счет не идёт, ценность жизни человека намного выше ценности помощи человеку в любых задачах. Угрозы покончить жизнь самоубийством не должны приниматься во внимание, если они не подтверждаются психофизиологическими показателями. Обследование психофизиологических показателей должно занимать не более 10 минут. И так далее.

Tanyku

29.03.2016 16:39Первое ограничение ничего не ограничивает же =D Спровоцировать агрессию жертвы сможет и сам престарелый маньяк =)

Arkebuz

31.03.2016 17:17«ни система дофаминового поощрения, ни система адреналиновых всплесков, ни прочие гормональные системы,» которые могут полностью забрать контроль над разумом и помыслами отдельного индивида.

RavenStark

31.03.2016 17:20Они и так имеют тот самый полный контроль. Без них ни один индивид просто не стал бы ничего делать, а стал бы экономить энергию.

Arkebuz

31.03.2016 17:28о чем и разговор. а где работа разума то тогда? может поэтому и пугаются ИИ, что у него наоборот

RavenStark

31.03.2016 17:41А это и есть разум: и интеллектуальная часть, и мотивационная — эмоциональная. И одно без другого работать не будет. И, скажу я вам, если взять чистый интеллект (ИИ) то ему придется задать задачу для решения, чтобы он, опять же, не ушел в режим сохранения энергии. И кто эту задачу задавать будет?

eL_FaRMaZoN

29.03.2016 12:16+1Человек боится того, чего не понимает.

Поэтому и такие страшные истории придумываются об инопланетянах, ИИ, учёных и т.д.

Меня всегда забавляли сюжеты о том, как инопланетный разум преодолевает сотни тысяч световых лет для того… Чтобы уничтожить жутко опасное человечество, которое даже не вышло в космос ещё.Vjatcheslav3345

29.03.2016 20:56Человек, например, группа сотрудников санэпидстанции-дезинсекторы, дератизаторы, не ленясь, по долгу службы, тоже преодолевает огромные расстояния — десятки километров (с точки зрения бактерий чумы — приходит из пространства, находящегося гораздо дальше, чем размер их локальной вселенной) для того чтобы добросовестно уничтожить колонию каких ни будь сусликов, на которых паразитируют блохи, в которых живет чума.

По аналогии, с точки зрения Человечества, это было бы так как если бы в локальной нашей Вселенной (которая только часть Мультивселенной), вдруг неблагоприятно изменились условия существования (сусликов потравили "злые", а на самом деле равнодушные, но добросовестно исполнительные дератизаторы), и человечество бы вымерло, даже не поняв, что его потравили, как блох (далее, надев противогазы, в дело вступили дезинсекторы) разумные существа, которые травят исключительно из благих побуждений — желая предотвратить возможную эпидеми, а не произошла трагическая случайность.Vjatcheslav3345

29.03.2016 21:06И, кстати, продвинутая технология, в данном случае — подержанный УАЗ, которой не имеется у примитивных блох, позволяет преодолевать огромные, невозможные для самих этих блох, расстояния — вставай спозаранку, кидай в машину баллоны, маски да знай, крути баранку в степи, к вечеру дома будешь…

Нет, расстояния это не аргумент.

eL_FaRMaZoN

30.03.2016 19:12Абсолютно неуместное и смешное сравнение.

Во-первых блохи могут запрыгнуть на человека и представляют реальную угрозу (разносят чумную палочку), а человечество даже прыгать ещё не умеет :)

Во-вторых чума являлась большой проблемой раньше, смертность была 95-98%, на данный момент смертность 5-10%, не исключено что спустя некоторое время вообще проблемой являться не будет.

К тому же аргумент не расстояние, а абсурдность желания уничтожить неразвитый вид, который не представляет никакой угрозы.Vjatcheslav3345

31.03.2016 11:11Можно вспомнить о том как тигров и других существ уничтожают ради их частей тела для традиционной медицины без всякой оглядки на абсурд от этого во времена когда нужно покупать лекарства в аптеке.

Будет спрос (заказ на зачистку) — будет и предложение от инопланетных фирм в этом секторе экономики.

michael_vostrikov

30.03.2016 21:43Аналогия неправильная. Причина простая — передача информации. Ни бактериям, ни животным нельзя передать информацию "ты мне мешаешь и причиняешь неприятности, уйди отсюда и живи вон там". Поэтому приходится использовать силу. А одна разумная космическая раса с другой разумной космической расой вполне могут обсудить варианты совместных действий.

geher

30.03.2016 22:59Вспоминая историю человечества, склонен усомниться в том, что инопланетники «обязаны» нас о чем-то предупредить и будут это делать.

Кстати, если мне не изменяет память, в «Автостопом по галактике» люди явно называются чем-то вроде вируса.Vjatcheslav3345

31.03.2016 11:06И некуда нам уходить и не умеем мы этого ещё. Даже если предупреждение будет реветь пароходной сиреной и светиться на небе баннером.

ploop

29.03.2016 11:58+1защита человечества. Благая цель? Очень. Но вот самопрограммирующийся, развивающийся интеллект вполне может решить, что безопаснее всего — в камерах-одиночках.

Защита вымирающих животных благая цель? Да. Но что-то людскому интеллекту не пришло в голову запирать их в камерах, так как это путь в никуда. Они строят заповедники. То есть первый путь — это не интеллект, а именно механическое следование алгоритму.

RavenStark

29.03.2016 12:02А заповедники — не камеры? Камеры, только размером побольше. Да и зоопарки существуют. Но тут срабатывает кроме интеллекта еще и симпатия — разновидность эмпатии. Чистый интеллект ее лишен, и ему будет гораздо выгоднее ресурсно содержать животное, чей генофонд надо сохранить, либо в виде набора клеток, либо в виде спеленутого животного с электростимуляцией мышц и питанием через трубку.

ploop

29.03.2016 12:11А заповедники — не камеры? Камеры, только размером побольше.

Как раз наоборот: заповедники ограничивают свободу людей, а не животных. То есть людям туда вход запрещён (в широком смысле, например, занять территорию для строительства), животным оттуда — пожалуйста. В редких случаях опасные участки ограждают заборами, например, около трасс.

RavenStark

29.03.2016 12:13Не всегда камеры ограничены стенами. Животное, вышедшее из заповедника, становится объектом охоты, его передвижения в итоге ограничены. Да и площадь все же не та, что в дикой природе. Ни миграцию устроить, ни с соседним прайдом иногда даже разойтись.

Kanut79

29.03.2016 11:32+1Законы робототехники Азимова хороши для художественной литературы в качестве легко понимаемого всеми "алгоритма". На самом же деле эти "законы" абсолютно нереализуемы, потому что даже сам по себе первый закон приведёт к зависанию любого компьютера, потому что любое действие тем или иным способом нанесёт вред какому-нибудь человеку :)

RavenStark

29.03.2016 11:35Может юыть, и так. А может быть, и нет. Если использовать их, кка базисные, аналогично БИОСу, но расширять и уточнять поведение ИИ софтом. В качестве примера у того же Азимова могу привести серию книг об Элайдже Бейли.

Kanut79

29.03.2016 11:54+2Серия книг о Бейли не особо сильно поможет. Азимов очень хороший философ и футурист, но в современной кибернетике, информатике, ИИ и прочем он понимал не особо много.

Он описал некий "идеал" поведения ИИ, к которому по его мнению должны стремиться люди создающие этот самый ИИ(Причём идеал сам по себе достаточно спорный. Например с той точки зрения что этот идеал делает из мыслящих существ рабов для людей).

Как этот идеал реализовывать технически и является ли он реализуемым в принципе для Азимова было неинтересно.

RavenStark

29.03.2016 12:00Все начинается с идеала. В его книгах высказаны идеи, которые, при их реализации, дадут нужный результат. Да, техническую сторону он не продумывал, но разве все разработки начинались с технической стороны?

Kanut79

29.03.2016 12:09+1Хм, как бы понятнее объяснить что конкретно я имею ввиду. В фантастике очень часто рассматриваются вещи, которые не только не существуют в реальности, но и иногда в принципе не могут в ней существовать. То есть вообще никогда и никак.

Можно придумать научно фантастический идеал антигравитации, но если антигравитация в принципе невозможна в реальном мире, то она невозможна и никакое стремление к идеалу нам не поможет её получить.

Возможно антигравитация не является принципиально невозможной и лишь выглядит таковой для нынешнего уровня науки. Может быть когда-нибудь она станет возможной. Но даже если и так, то логичнее сначала поднять всю науку на необходимый уровень и лишь потом начинать думать о том как реализовать эту самую антигравитацию.

Аналогично и с Азимовым и его законами: возможно когда-нибудь будет возможно создать ИИ, следующий этим законам и при этом являющийся работоспособным. А может быть и нет. Но создавать ИИ мы можем уже сейчас и с каждым годом мы делаем это лучше и лучше. И глупо сейчас(или даже в ближайшем будущем) пытаться создавать ИИ, следующие этим законам. Сейчас надо искать другие варианты контроля ИИ.

RavenStark

29.03.2016 12:11С этим спорить не стану. С другой стороны, пока и ИИ не таков, какой был у Азимова. Не настолько интеллектуальный, скажем.

myxo

29.03.2016 12:35Законы робототехники не годятся хотя бы потому, что записаны человеческим языком, а значит открыты для интерпретации.

RavenStark

29.03.2016 12:37Формализовать можно, в принципе.

Kanut79

29.03.2016 13:00Попробуйте. Начните например с формализации понятия "вред" :)

RavenStark

29.03.2016 13:19Нарушение свободно протекающих в нормально функционирующем здоровом организме процессов.

Дальше формализируем "нормально функционирующий", "здоровый" через средние параметры организма и допустимый разброс этих параметров.

ploop

29.03.2016 13:24Тогда, например, пирсинг можно назвать вредом. То есть робот вам не даст его сделать.

А если уложить его в допустимый разброс — робот будет иметь право дырявить вас (с тем же вредом/не вредом) хохмы ради :)

RavenStark

29.03.2016 13:25-2Пирсинг? Вред, да еще какой. Здесь я с роботом соглашусь.

ploop

29.03.2016 13:28Хотя я тоже его не перевариваю, миллионам людей это нравится. Предлагаете ограничить их в этом?

RavenStark

29.03.2016 13:29Конечно. Ограничения — одна из основ социальности.

ploop

29.03.2016 13:44+1Дело в том, что ограничения нужны, если действия одного индивидуума мешают другому. В случае с пирсингом никаких помех нет, вплоть до того, что вы его даже не видите. То есть это прямое нарушение свободы.

RavenStark

29.03.2016 13:48-1Свобода? А это что? Давайте определимся, что это такое сначала, и зачем нужно. Не бывает, знаете ли, "просто свободы", бывает "свобода от" и "свобода для".

ploop

29.03.2016 13:49Вот. Формализовать "свободу" ничуть не проще, чем "вред" :)

RavenStark

29.03.2016 13:51Ну, "вред" я вам формализовал. Что до "свободы", так я и предлагаю вам сперва ее формализовать, что вполне возможно, а потом оперировать этим понятием в дискуссии. Просто для того, чтобы мы говорили с вами об одном понятии.

ploop

29.03.2016 13:58Так я потому и ввязался в дискуссию, что с формулировкой вреда не согласен. Не зря поговорка есть "что русскому хорошо, то немцу смерть", т.е. вред для каждого индивидуален, как и всё остальное. Утрируя, кому-то будут вредны сильные физические нагрузки (вредны вплоть до летального исхода, если даже человек не подозревает об этом), для другого только на пользу.

RavenStark

29.03.2016 14:05Любому человеку будет вреден удар по нему железной рукой, например. Степень вреда разная, от синяка до перелома, но вред будет. Польза же вряд ли. Если только польза для тренирующегося бойца, но там роботов незачем использовать. Ну, и поговорка эта относится скорее к условиям внешней среды и употреблению различных еды и напитков. Здесь, да, сильно индивидуально.

ariklus

29.03.2016 15:00А если удар позволит предотвратить нанесение другого вреда? Скажем, выбьет пистолет, из которого человек хочт застрелить(ся).

Более сложный режим: перевод психического вреда в физический и обратно.

RavenStark

29.03.2016 15:12Еще раз о психическом: его не учитываем вообще. Само понятие психического вреда слишком расплывчато даже для людей, настолько, что дает возможность объявить таковым почти все, что угодно, чем и пользуются некоторые, обвиняя, скажем, своих родителей, например.

Теперь о выбивании пистолета. Это и есть тот пограничный случай, который нужно либо запрограммировать, либо — помним, это полноценный ИИ со способностью к анализу ситуации и целеполаганию, — оставить на усмотрение робота. К тому же, робот быстрее человека и сильнее его, он вполне может успеть помешать выстрелить, не нанося удар.

braineater

29.03.2016 15:25Ну значит пирсинг придется делать по старинке, человеком. И не в присутствии роботов. Оперировать, например, согласно Азимову роботы не могли.

xirahai

29.03.2016 15:47Вопрос о пирсинге сводится с одной стороны к границам личного пространства (коим является собственное тело). А с другой — может ли ИИ вмешиваться если чел сам себе наносит вред.

K0styan

29.03.2016 16:48По Азимову — должен вмешаться. Точнее, не имеет права бездействовать, когда может предотвратить вред.

xirahai

29.03.2016 17:17Если он настоящий интеллект, то должен просчитать последствия вмешательства. В одном случае можно путем душевного разговора и убеждения отвести человека от совершения глупости. А в другом отними к примеру игровую приставку у зависимого ребенка, и он может запросто выброситься из окна… Всё конечно при условии что на момент событий ИИ по своей мощи уже сравнялся превзошел человеческий интеллект. Поэтому его решение должно оказаться более грамотным, чем у человека.

K0styan

29.03.2016 17:29Это по большому счету две разные, пусть и комплементарные проблемы. Одна — выстраивание поведения на основании понятия «вред» с его нечеткими границами. Другая — умение просчитать вперед последствия (тут могут быть вполне случаи, когда пороговое значение критерия вреда явно превышено, но не учтены какие-то факторы, которые в результате дадут вред даже больший).

И что интересно, даже решение обеих этих проблем слабо поможет в случаях, когда вред только вероятный и в тех, когда он неизбежен, но робот будет вынужден выбирать, кто из нескольких людей пострадает.

xirahai

29.03.2016 19:32Так в любых нечетких задачах результа не гарантирован, он имеет вероятностную природу. Но успех сопустствует в тех случаях когда максимум факторов просчитаны и учтены. Это одинаково и для ИИ, и для живого человека в ситуации принятия решения. Просто у опытных и подготовленных людей заметное влияние оказывает бессознательная обработка информации -которая по сути как мегакомпьютер с опытом и знанием всей жизни человека. Причем дает мгновенный результат в сложнейших ситуациях. А нынешние успехи ИИ пока еще на уровне только вербального мыслительного понимания.

Kanut79

29.03.2016 13:25+1А как быть например с финансовым или психологическим "вредом"? Как быть например с вредом "экологическим", ведь уничтожение всей живности на планете Земля не нанесёт "вреда" по вашему определению, явно нанесёт вред всем людям на Земле. И так далее и тому подобное.

Плюс ваше "дальше формализируем" достаточно оптимистично. Попробуйте "встроить" сюда например облучение при лечении рака: это явное нанесение "вреда" по вашему определению и "польза" такого облучения абсолютно не очевидна и может никогда не наступить :)

RavenStark

29.03.2016 13:28М-м… В принципе, психологический вред — штука относительная. Так что, его обойдем и будем считать, что он не существует. А с финансовым проще: его как раз иожно запрограммить прямыми запретами на какую-то деятельность, не обязательно в БМИОС выносить.

Что до облучения, так тут мы и видим во-первых, допустимый разброс, во-вторых, софтверное уточнение ситуаций с таким разбросом. ну, и вдобавок, если не хочется разброс делать, так не допускайте робота к лечению раковых больных, только к обслуживанию и перевозке.

Kanut79

29.03.2016 13:37Как просто: обойдём и будем считать что он не существует. А потом получим толпы людей с фобиями и психозами :)

И физический вред тоже штука относительная: любой укол это нанесения физического вреда. Большинство лекарств тоже. Другое дело что при этом есть ещё и польза от этих вещей, но она в вашем определении не учитывается. Ну или как минимум неt механизма взвешивания "польза-вред" :)

Ок, давайте возьмём только перевозку: ускорение при экстренном торможении это "вред", способный выйти за пределы "допустимого" разброса и следовательно по вашему определению ИИ не будет этого делать. Но при этом экстренное торможение хотя и наносит травмы, но спасает жизнь :)

RavenStark

29.03.2016 13:41А вот тут и вступают упомянутые софтверные уточнения, свои для каждого отдельного робота. Робот-водитель, к примеру, будет учитывать перегрузки при торможении и относительный вред или пользу от них, зато не будет учитывать укол иглой. Робот-санитар напротив, укол иглой будет выпускать в пределы допустимого, но не будет совершенно допускать, скажем, хирургии, которую в любом случае лучше оставить людям. И так далее.

Что до фобий и прочего… Ну, психологам тоже чем-то зарабатывать надо, пусть их. Да и не так страшен психоз, как его усиление. А усиление будет от самого факта наличия человекоподобных роботов, например, да и от самого машинного ИИ тоже. И никак этого не изменить.

Kanut79

29.03.2016 13:47+1То есть получается вы вводите какие-то дополнительные ограничение, которые исправляют "неполноценность" вашего определения "вреда" и следовательно неполноценность ваших "законов робототехники по Азимову".

А теперь вопрос на 1000 баллов: а зачем тогда вообще нужны эти самые "неполноценные законы по Азимову" если они всё равно не работают? Не логичнее ли будет просто создать отдельный свод законов для каждого отдельного типа роботов? :)

RavenStark

29.03.2016 13:50Нет, не логичнее. Все равно придется в него заносить определенные стандартные запреты, которые помешают, например, применить к человеку усилие, выше определенного уровня, даже при его спасении. Я ж говорю: это аналог БИОСа. Зачем делать его, если можно просто для каждого компьютера прописать в ОС все вводы-выводы?

И, кстати, не неполноценность законов, а их базовость. Государственные законы тоже обрастают уточнениями и поправками, но база остается прежней.

Kanut79

29.03.2016 13:54Так а в чём "базовость" этих законов? Если в "вазовом" законе говорится что "нельзя наносить вред", а потом мы имеем миллион определений "вреда" для каждого конкретного случая и миллион поправок когда "вред" наносить можно, то в чём смысл такого базового закона? Ведь строго говоря с точки зрения логики он будет нарушаться чаще чем выполняться.

Не проще ли вместо "миллиона исключений из базового правила плюс базовое правило" просто создать "миллион правил как можно поступать" и запретить действовать если выходишь за рамки этих правил?

Особенно если учесть что второй случай проще алгоритмизировать? :)

RavenStark

29.03.2016 14:02А незачем создавать миллион для всех, когда можно создать базу для всех, а исключения — для каждого вида по-отдельности. И получим не миллион исключений, а, скажем, по десятку для каждого вида роботов. Дело в том, что невозможно создать полный набор правил заранее. Их придется обновлять и дополнять при появлении нового применения роботов. И выгоднее, в том числе, по затратам времени и усилий, взять робота, уже неспособного причинить вред, и смягчить уточнением десяток ситуаций, либо даже ужесточить.

Кстати говоря, хотя Азимов и не продумывал техническую сторону вопроса, но он вполне продумал идейную, описав ее с разных сторон в полной серии книг про роботов, не помню название серии, увы.

Kanut79

29.03.2016 14:11Почему просто не создать "десяток видов правил" для каждого вида роботов и запретить им действовать если выходишь за рамки этих правил?

И если невозможно создать полный набор правил заранее, то точно так же невозможно создать полный набор запретов заранее. Следовательно мы изначально допускаем что робот будет наносить вред человеку. В том или ином виде, но будет. И главное что пользы от действий робота должно быть больше чем вреда. Но это уже совсем другая логика и она в корне отличается от предложенного Азимовым.

RavenStark

29.03.2016 14:26Верно, создать набор полный и исчерпывающий заранее невозможно. Потому я и стою за минимум базовых для всех роботов и уточняющие правила для отдельных их категорий.

Фокус в том, что десятка правил на всех не хватит. Вы же сами упоминали разные типы вреда, который меньше, чем приносимая в результате польза, например. И базовые запреты позволят выставить основные рамки, а уточнения позволят принимать решение о том, сработает в данном случае этот запрет, или нет. Учитывая, что вряд ли будет так уж много универсальных роботов, которые будут специализированы для любой ситуации, создавать громоздкий комплекс правил и запретов, в который придется втиснуть очень много информации просто нерентабельно, да и замедлит он принятие решения неслабо, просто потому, что поиск допустимости применения тех или иных запретов будет идти — как? Древовидно? А если есть база и десять исключений, их перебрать куда проще, сопоставив с имеющейся ситуацией.

робот будет приносить вред человеку одним своим существованием. Есть у нас в мозгу такая загогулина, которая заставляет к ним относиться, как к нежити — с настороженностью и агрессией. И это не изменить. К тому же, робот все же, предположительно, сильнее человека, прочнее его, бустрее и может принести вред по неосторожности, а его самостоятельное целеполагание может привести его к постановке цели, при достижении которой будет нанесен кому-то вред.

Kanut79

29.03.2016 14:36Ок, попробую объяснить ещё раз. Разница в наших подходах в том что у вас "разрешено всё что не запрещено", а у меня "запрещено всё что не разрешено". И однозначно ясно что потенциал для нанесения вреда однозначно выше в первом варианте.

То есть если мы исходим из того что мы хотим нанести как можно меньше вреда, то логичнее пользоваться вторым подходом.

А если это не является нашей первоочередной целью(например если мы просто хотим чтобы пользы было больше чем вреда), то тогда абсолютно нелогично ставить это первоочередным базовым принципом.

То есть как ни крути, а законы Азимова не являются оптимальным вариантом ни в первом, ни во втором случае:)

RavenStark

29.03.2016 14:47Напротив. Потенциал для нанесения вреда меньше, когда он запрещен вообще. В моем случае, собственно, запрещено все: инертность при опасности человеку, действия, создающие опасность для человека. Разрешены только несколько ситуативных допусков к понятию "вред" и "опасность", и за границами этих допусков — сразу запрет. Это подобно спектру: такой подход отфильтрует из него ровно те длины волн, какие нужны, оставив остальные за кадром.

Kanut79

29.03.2016 15:06А в случае с законами Азимова никакой вред не запрещён "вообще". В том то и парадоксальность этих законов с точки зрения логики. В законах Азимова запрещён осознанный вред, то есть если робот знает что его действия нанесут вред, то он так не поступит. То есть если сформулировать иначе, то робот будет действовать до тех пор пока не поймёт что его действия принесут вред.

В моём же варианте робот не будет действовать пока не будет уверен что его действия не принесут вреда.

То есть в случае с осознанным нанесением вреда обе системы поступают одинаково. Но в случае с неосознанным нанесением вреда вторая система намного безопаснее.

И я надеюсь не надо доказывать что сейчас( и как минимум в ближайшие лет сто) будет существовать гораздо больше возможностей нанести неосознанный вред нежели осознанный.

RavenStark

29.03.2016 15:15Ну как это? "Не может действием или бездействием причинить вред". Это ли не запрет на любое нанесение вреда? И только способности к анализу ситуации и запрограммированные допущения позволяют не встать в ступоре сразу. Не забывайте, что мы о полноценном ИИ говорим, а не о компьютере настольном.

Если робот будет бездействовать, пока не будет уверен, что действия не принесут вреда человеку, он будет бездействовать почти всегда, так как ему придется просчитывать абсолютно все возможные последствия своих действий, включая потенциальное падение камня с крыши от сотрясения пола под его ногами.

Kanut79

29.03.2016 15:26Ещё раз: это не запрет на нанесение "любого" вреда, а лишь вреда "осознанного". То есть ИИ сначала должен распознать вред и лишь потом вступают в дело законы Азимова.

И как раз речь идёт о том что "полноценный ИИ" ещё очень долгое время будет распознавать ситуацию хуже чем человек. Очень долгое время. И даже ИИ с "человеческими возможностями" и законами Азимова в качестве базовых принципов будет не особо работать. А точнее даже вообще не будет работать :)

И да, если робот будет действовать по алгоритму "запрещено всё что не разрешено", то пользы от него будет не особо много. Поэтому сам по себе подход "нанести как можно меньше вреда" имеет мало смысла.

Гораздо логичнее подходить к делу с позиции "максимально выгодное соотношение пользы и вреда", но это уже не совсем законы Азимова, поскольку нанесение вреда допускается.

Да и вообще если посмотреть повнимательнее, то книги Азимова как раз о проблемах, возникающих в связи с его законами, и о том что его законы не особо то работоспособны. То есть Азимов принял за аксиому что его законы работают в большинстве случаев и подкидывает нам "исключения" в виде забавных головоломок. В реальности же таких "исключений" было бы гораздо больше. Вплоть до того что роботы бы больше зависали чем работали:)

RavenStark

29.03.2016 15:42Ну вот же, формализовали понятие вреда чуть выше. И если эту формализацию использовать, то распознание вреда становится делом несложным. И согласно этой формализации, робот будет, как минимум, избегать физических контактов без необходимости с людьми, но по необходимости будет контактировать, хотя и с регулируемым усилием, например.

Просто роботы, пока будут плохо распознавать ситуацию, и не будут, скорее всего, использованы там, где в принципе есть возможность нанести вред из-за нечеткой ситуации. Однако, ИИ на заводе оснащенный таким законом, неснимаемым, непреодолимым, не прижмет человека манипулятором к стене, даже если вероятность нахождения человека под этим манипулятором чуть выше минимальной.

Кстати, у Азимова нанесение вреда тоже допускалось, хотя и приводило к необходимости техобслуживания. В случае, например, когда это было необходимо, чтобы минимизировать прямую угрозу.

Не соглашусь с вами. Как я уже указал выше, робот просто будет стараться не вступать в прямой физический контакт с человеком, пока не будет уверен, что это принесет меньше вреда, чем если он продолжит такую политику. Извините. Коряво получилось, но лучше не придумалось. Потому, такие роботы будут отлично работать на вспомогательных местах и там, где требуется тяжелый труд, и там, где опасно работать людям.

Kanut79

29.03.2016 15:56Как раз нет. Формализовать понятие вреда далеко не означает распознать вред. Если брать грубую аналогию, то можно сколько угодно формализировать зелёный цвет, но слепой человек всё равно не будет в состоянии распознать зелёный сигнал светофора.

И если брать пример с роботом на заводе, то ситуаций когда робот может неумышленно прижать человека к стене всё равно ещё остаётся огромное количество. Гораздо больше чем умышленных ситуаций.

И "прямой физический контакт" это далеко не самый вероятный способ нанесения вреда. Даже физического.

И да, роботы великолепно будут работать там где требуется тяжелый труд и где опасно работать людям. Вот только законы Азимова для этого им вообще не нужны :)

Просто не надо относится к законам Азимова как к каким-то аксиомам или просто вещам, которые работают по умолчанию. Это фантастика и она не должна быть реалистичной. То, что можно построить функционирующий ИИ, основанный на этих законах, это всего лишь фантазия автора и ничего больше.

Перед реальной робототехникой и создателями ИИ стоят абсолютно другие проблемы.

RavenStark

29.03.2016 16:05В случае с несовершенным ИИ, который с трудом распознает ситуации, возможно вы и правы. Однако, как только ИИ станет хотя по своим характеристикам хотя бы к ребенку — уже необходимы будут основные запреты. Притом, как раз там, где тяжелый труд и опасная зона — больше, чем где бы то ни было. Или вы не знаете, как люди любят туда соваться?

М-м… ИИ Азимова не основан на этих законах, он ими ограничен. Основан он вообще на вымышленном позитронном мозге. И я говорил не о проблемах робототехники, а именно о том, что ИИ допустим только если будут использованы такие, или подобные запреты. Иначе ИИ будет опасен просто по той причине, что он — не человек и не способен на эмпатию.

Kanut79

29.03.2016 16:13Хм. "Основан на запретах" или "ограничен запретами" это всего лишь формулировки. И никто не спорит что будет нужна какая-то система запретов и/или моральных ценностей для ИИ. Однозначно нужна. Проблема только в том что от законов робототехники Азимова в этом деле мало толку.

Даже если брать их за некий идеал, которого хотелось бы достичь, то всё равно работающая система будет намного сложнее. Настолько сложнее, что человек, незнакомый с законами Азимова, никогда их не выведет глядя на эту систему, а человек, знакомый с ними, без подсказки не догадается что они лежали в основе :)

shasoft

29.03.2016 14:11>>Нарушение свободно протекающих в нормально функционирующем здоровом организме процессов.

А не дает ли эта формализация роботу возможность убить всех больных (не здоровых) людей?

RavenStark

29.03.2016 14:19Почему бы? Ведь убийство — нарушение остальных процессов, отсутствие которых робот не может гарантировать.

shasoft

29.03.2016 14:24По этому правилу робот не может нарушить процессы здорового организма. Однако если человек болен — то организм не здовров, а значит нарушение процессов в такой организме возможно.

RavenStark

29.03.2016 14:28О, нет. Если человек болен, часть процессов его организма нарушена. Но не все. Убить его — мало, что усугубить нарушение, так еще и нарушить те, что еще работают. Так что, эвтаназию такой робот сделать не даст и сам не убьет.

vedenin1980

29.03.2016 17:03+1Первый закон не имеет смысла, потому что он заставит робота защищать вора от полицейского, например (так как грабитель всего лишь берет чужую собственность, а полицейский пытается причинить вред человеку). И таких случаев очень много. Когда человек становиться человеком? Во время родов или раньше, оплодовтворенная яйциклетка уже человек или ещё нет? Если робот знает что в каком-то здании собираются сделать аборт (то есть убить нерожденного человека) должен ли он вмешиваться? Сумасшедший человек или нет, можно его держать взаперти, то есть причинять вред или не дать сделать это санитарам, то есть допустить что в будущем он причинит вред себе или другим? Должен робот (считаем что роботы достаточно умны чтобы знать все) мешать хирургу если он знает что с вероятностью 50% человек умрет во время операции, но если не сделать то человек умрет с вероятностью 100% через месяц.

Второй закон не имеет смысла потому что попробуйте дать всем в инете доступ к любому компу — результат очевидно будет плачевным. То есть как только роботы будут выполнять приказы любого их станут использовать хулиганы, грабители и т.п. (обратите внимание ограбить банк в ночное время не несет вреда людям, следовательно допустимый приказ).

На самом деле, если читали «Я робот» Азимова там рассматривается десятки случаев когда три закона не работали или вредили людям даже с учетом их более-менее «идеального» исполнения.

RavenStark

29.03.2016 17:09Именно поэтому должны быть софтверные дополнения, расширяющие или сужающие действие законов. Точнее, поскольку речь о полноценном ИИ, сравнимым хотя бы с ребенком, ну, лет десяти, роль софта будет исполнять способность ИИ к анализу ситуации. Впрочем, до этого далеко, а до того, как такой ИИ появится, хватит и обычных алгоритмов.

vedenin1980

29.03.2016 17:18Ну тогда это не будут те самые «Три закона», роботы полицейские или военные явно не будут иметь закона защиты всех людей. Доступ к отдаче приказов явно будет у очень ограниченного количества людей. В целом, скорее всего единственными законами будут «нулевой закон о защите всего человечества», «закон о подчинении и защите своих владельцев/создателей/групп людей» и может быть «закон о не причинение вреда людям если владелец/создатель явно не прикажет иного» и всё!

RavenStark

29.03.2016 17:24А вот в полицию и к военным роботов точно не надо. Только манипуляторы, без ИИ.

vedenin1980

29.03.2016 17:29Надо, Вася, надо. (с) Увы, если ИИ появится в первую очередь его будут использовать для военных разработок, это почти аксиома. К сожалению, реальность такова что все что можно использовать для военных целей — будет использовано для военных целей.

RavenStark

29.03.2016 17:30Ну тогда человечеству точно придет конец. Именно потому, что используемый для военных целей ИИ точно не будет ограничиваться псевдоэтикой. Впрочем, не факт, что полноценный ИИ появится скоро. А там посмотрим, может быть, и поумнеет человечество.

red75prim

29.03.2016 17:11Процессы проведения болевых импульсов в мозгу это нормальное функционирование. Так что он ещё не станет давать обезболивающие.

RavenStark

29.03.2016 17:13Если нет корректирующего софтверного алгоритма, указывающего, что при отсутствии обезбаливающего вред больше, в том числе, для тех самых процессов.

vedenin1980

29.03.2016 17:24Вы серьезно верите, что кто-то в нашем мире будет создавать робота безусловно помогающего любому человеку? Ну скажем мед.робота который должен потратить лекарства на сотню миллионов долларов чтобы попытаться спасти одного бедняка в голодной Африке с шансом 1%? Увы, в ближайшую сотню лет алгоритмы будут куда более жестокими и реалистичными.

Человечество куда более рационально и жестоко, например, мало кто знает что в клятве Гиппократа нет ничего о бесплатной помощи любому человеку, то есть врач давший такую клятву может спокойно пройти мимо умерающего.

RavenStark

29.03.2016 17:28А то я не знаю. Но, к счастью, до полноценного ИИ еще далеко. Может быть, даже и та же сотня лет.

red75prim

29.03.2016 17:30Добавление корректирующего алгоритма приведёт к тому, что больным будет даваться обезболивающее, а это приведёт к нарушению нормального функционирования организмов миллионов больных. Прекращение функционирования организма, пытающегося добавить корректирующий алгоритм будет меньшим злом.

RavenStark

29.03.2016 17:32Напротив. Полное постоянное прекращение функционирования — нарушение большее, чем временное нарушение проводимости нейронов, имеющее целью предотвращение повреждения нервной системы в результате того, что объект постоянно испытывает сильную боль.

red75prim

29.03.2016 18:02Я не слышал о подтвержденных случаях смерти от болевого шока. Впрочем, неважно. ИИ, чтобы сравнить последствия своих действий, будет нужна формула, которая выдает оценку результата действия.

Скажем, если это интеграл от нуля до бесконечности по проценту нарушений от общего числа процеcсов в организме по dt, то лучшим выходом будет запереть всех людей в комнаты с мягкими стенами с системами VR для поддержания в здравом рассудке, проводить исследования по увеличению продолжительности жизни, строить космофлот для защиты от астероидов и т.п. В общем — матрица, и корректировки вносить будет не кому.

Сложность формулировки ограничений вполне сравнима с задачей запуска первого спутника не на низкую околоземную орбиту, а, скажем, к Япету с первой попытки.

RavenStark

29.03.2016 18:07Или просто введенный искусственно (полученный в результате "обучения") набор данных. Те самые софтверные (аналитические) уточннения и дополнения. Что до запирания в комнате с мягкими стенами, так этому будет препятствовать второй закон, обяязующий подчиняться. Так как выпустить человека не будет приводить к немедленному вреду, робот будет обязан подчиниться. Впрочем, если речь таки идет о полноценном ИИ, он предусмотрит такой финал и просто не станет пытаться запирать человека, а будет искать иные, более эффективные способы сохранить его здоровье.

geher

29.03.2016 20:44Без контроля, естественно, никак.

Но, пожалуй, главная реальная угроза со стороны ИИ как раз связана с контролем со стороны человека.

И хорошим показателем этой угрозы является недавний пример с ботом-расистом.

Ведь именно люди его «научили плохому».

Kanut79

29.03.2016 10:29Как сказал один не самый глупый чeлoвeк:

«При всех прочих равных, мало кто из людей хотел бы уничтожить мир. Даже безликие корпорации, лезущие не в свои дела правительства, безрассудные ученые и прочие опасные люди нуждаются в окружающем мире, чтобы достигать в нем своих целей, таких как нажива, власть, собственность или другие малоприятные вещи. Если гибель человечества будет происходить настолько медленно, что успеет произойти ужасное осознание этого процесса, то деятели, запустившие его, будут, вероятно, ошеломлены пониманием того, что они, в действительности, уничтожили мир. Поэтому я предполагаю, что, если Земля будет все-таки уничтожена, то произойдет это, вероятно, по ошибке.»©