Как построить дата-центр?

ЦОД (центр хранения и обработки данных, он же дата-центр) — это совокупность нескольких инфраструктурных систем, которые обеспечивают надёжность и отказоустойчивость работы серверного и сетевого оборудования.

Нельзя просто поставить кучу серверов и коммутаторов. Нужно создать и поддерживать оптимальные условия для их работы. Если Вы хотите построить свой ЦОД, Вам потребуются:

- Система электроснабжения. Тут всё ясно — серверы работают на электричестве, и их много. Стало быть, обычной розетки на 220В, скорее всего, будет маловато.

- Система охлаждения. Даже игровая видеокарта в продвинутом компьютере требует мощного кулера. Что уж говорить о сотнях и тысячах высокопроизводительных устройств.

- Структурированная кабельная система (СКС). Что-то должно соединять все элементы в единое целое. Вам потребуется очень много кабелей и пылкая любовь к процессу их педантичной укладки.

Это основные системы «жизнеобеспечения», самый минимум, который нужен, чтобы просто запустить оборудование. Но для настоящего полноценного дата-центра нужно кое-что ещё. А именно:

- Система пожаротушения. Важно позаботиться о том, чтобы случайная искра не превратила Ваш новенький ЦОД в руины.

- Система контроля и управления доступом (СКУД). Не стоит оставлять двери открытыми для всех желающих.

- Система мониторинга. Вы должны вовремя узнать, если что-то пошло не так.

- Охранная сигнализация. На случай, если вместо пропуска кто-то решит использовать лом.

- Система видеонаблюдения.

Мы верим, что у Вас получится отличный дата-центр. А пока посмотрим, как выглядит наш.

Добро пожаловать в ИЦВА

Почему ИЦВА, что за название такое? ИЦВА — это исследовательский центр высоковольтного аппаратостроения, который раньше находился в здании дата-центра и работал на благо энергетической промышленности. В наследство нам достались антиутопического вида ангары с потолками на уровне пятого этажа и загадочные помещения со стенами толщиной в метр.

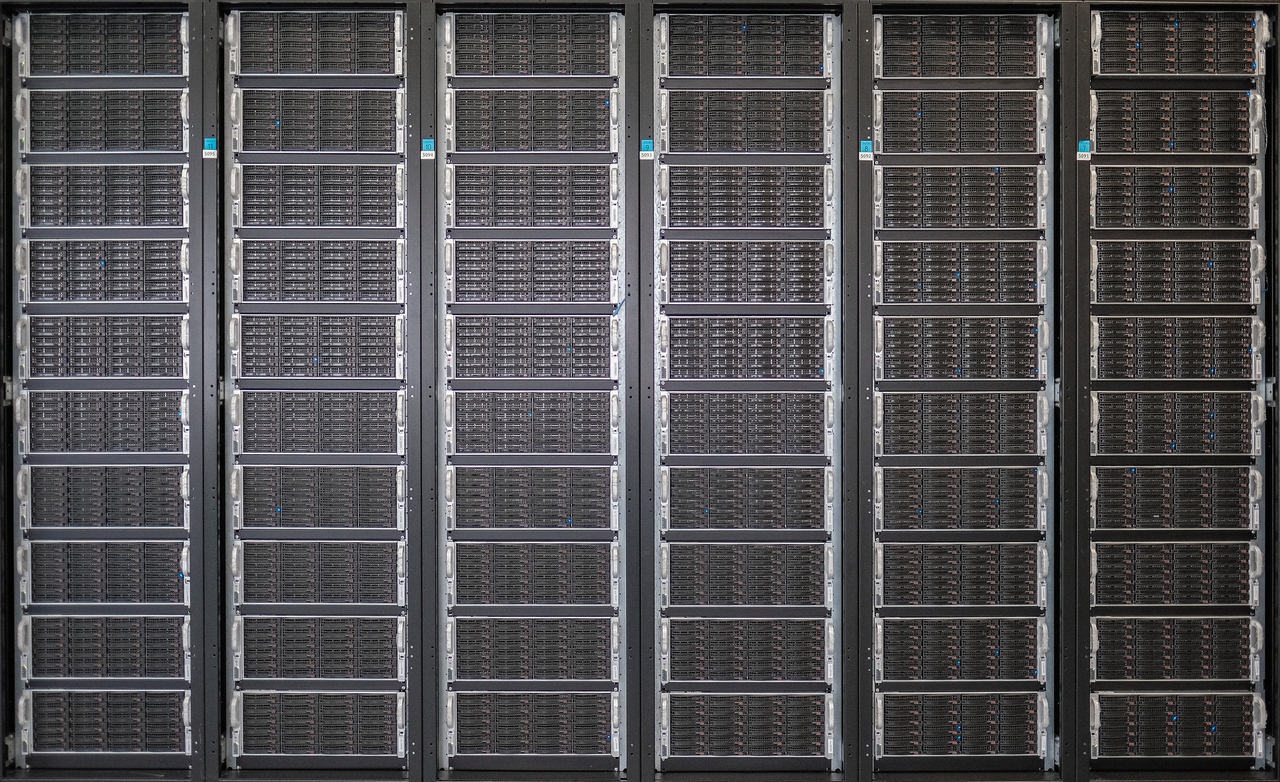

В четырёх машинных залах размещены 640 стоек — это более 20000 серверов и более 200 коммутаторов, роутеры и DWDM-системы ёмкостью свыше 4 Тб/c. Здесь установлен роутер ASR9000 с серийным номером 1 — в своё время это была первая коммерческая установка такого устройства во всём мире.

В пике дата-центр генерирует более 1 Тб/c внешнего трафика. К нашим DWDM-системам подключены более 10 крупнейших международных провайдеров и международных центров обмена трафиком, а также около 40 крупных операторов РФ.

Первый машинный зал. Возможно, именно здесь лежит Ваше любимое видео.

Электроснабжение

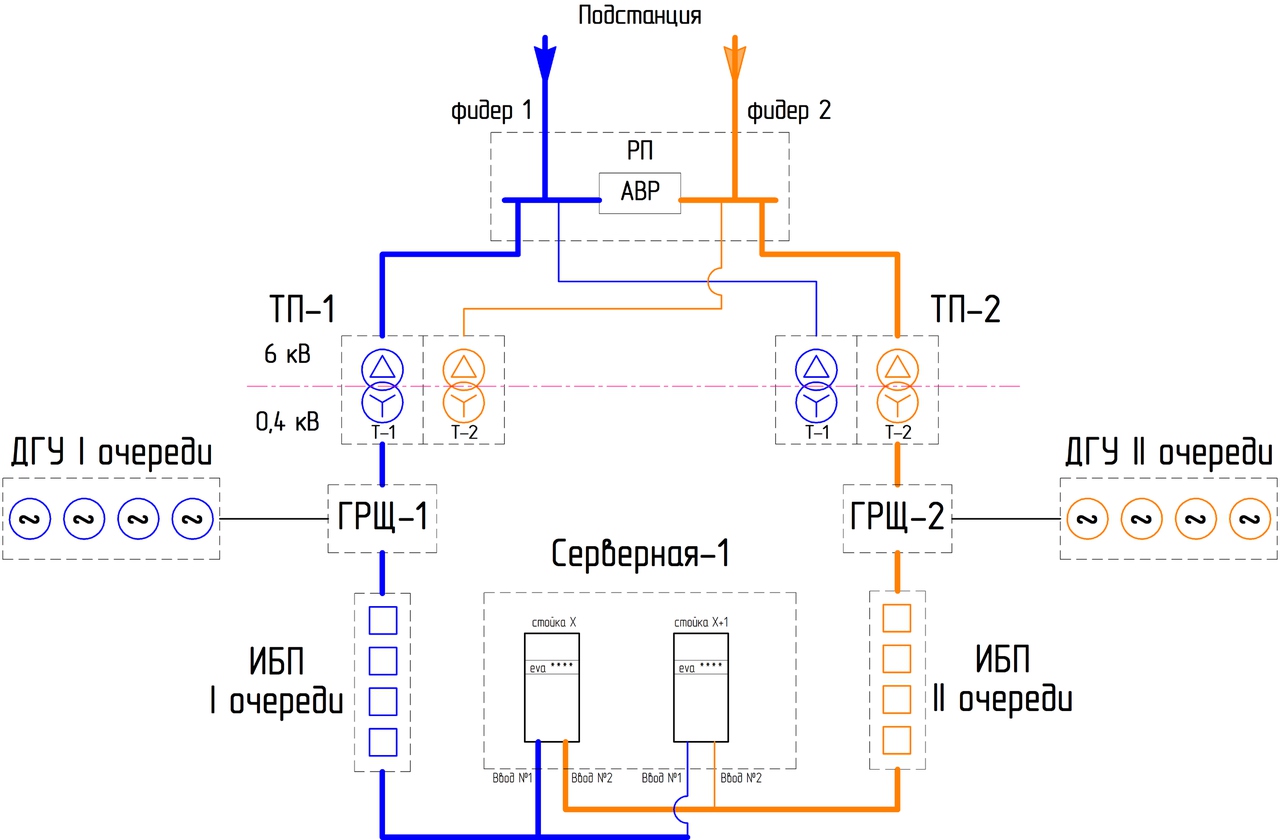

Все элементы системы электроснабжения резервируются как минимум N+1. Буквально напротив здания дата-центра находится подстанция «Восточная», от которой питание подаётся в ЦОД по двум вводам 6кВ. Далее через распределительную подстанцию и автоматический ввод резерва питание подаётся по двум независимым вводам. Вот как это выглядит на схеме (для простоты — с одним машинным залом из четырёх):

Схема электропитания в штатном режиме

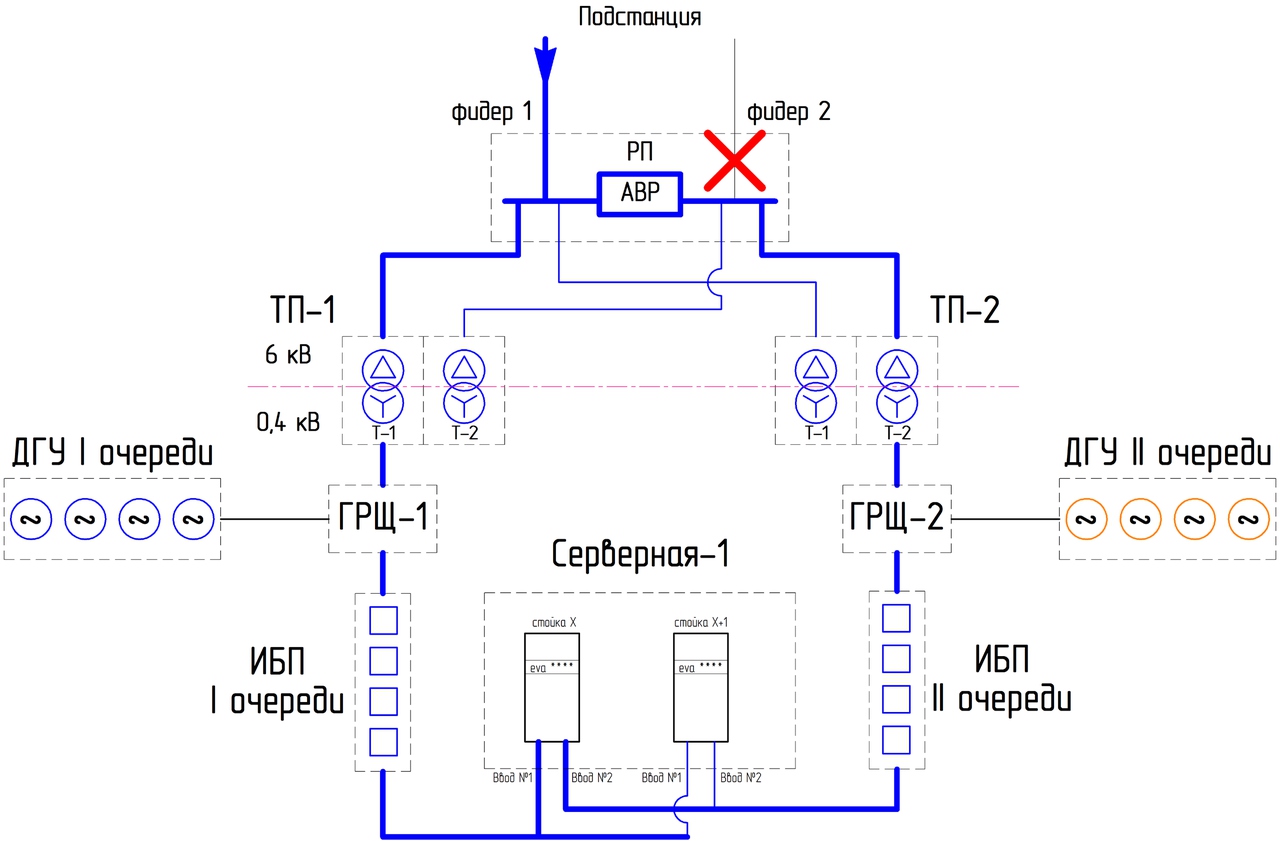

Каждый узел дублируется и в норме работает под половинной нагрузкой. В случае аварии питание дойдёт до машинного зала в обход вышедшего из строя участка. Например, мы потеряли один 6кВ ввод:

Схема электропитания при аварии на вводе

Если всё совсем плохо, и на вводы от магистральной сети рассчитывать не приходится, в дело вступают источники бесперебойного питания. Их задача — обеспечить питание машинных залов на то недолгое время, пока запускаются дизель-генераторные установки.

Источники бесперебойного питания

А это аккумуляторы для них — внешне очень похожи на автомобильные…

… только занимают несколько больших помещений

Дизель-генераторные установки (ДГУ) поддерживают жизнь в дата-центре в случае затяжной аварии или плановых работ в системе электроснабжения. Кроме топливных баков в самих ДГУ установлена автоматическая контейнерная заправочная станция большой ёмкости. Топливо из резервуара подаётся автоматически во все ДГУ, запас рассчитан минимум на сутки. В случае необходимости бензовоз с дизельным топливом прибудет в течение двух часов.

Дизель-генераторные установки

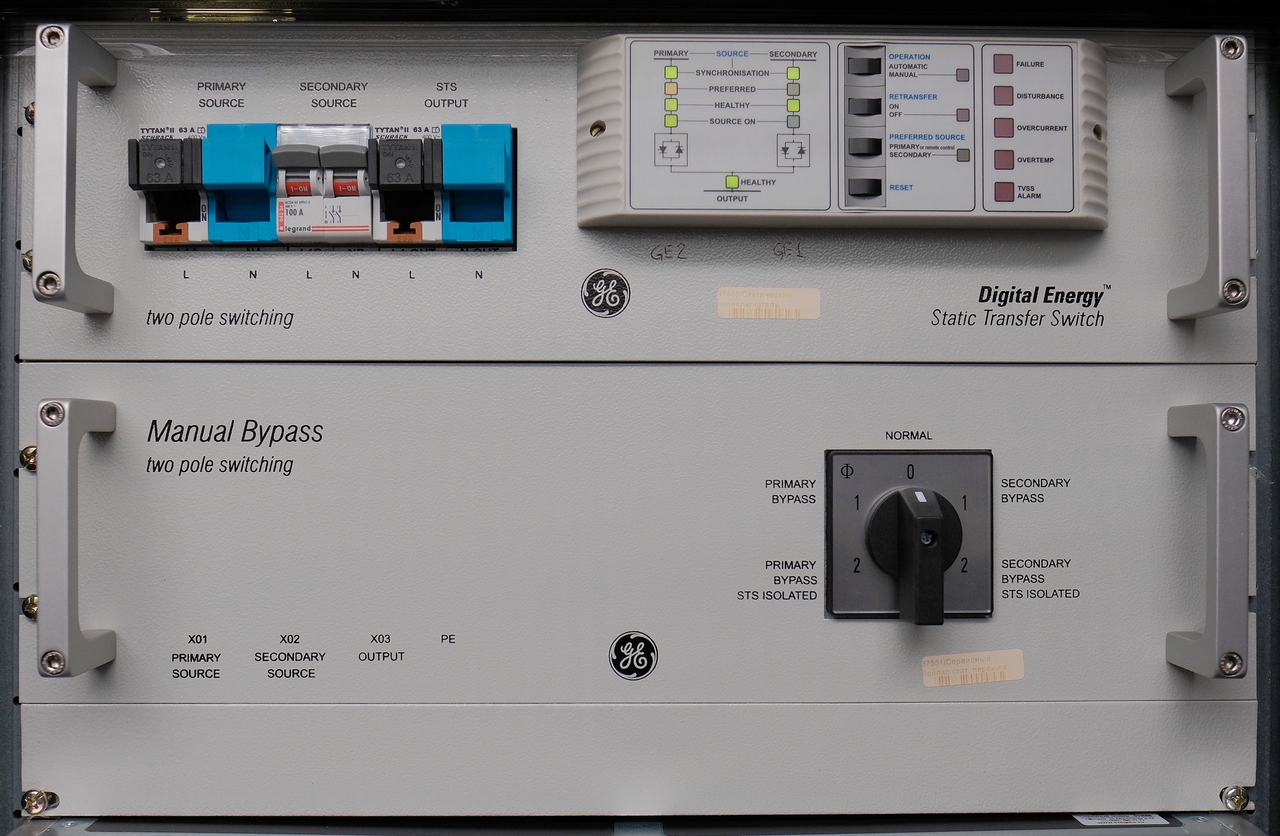

Каждый сервер и каждый коммутатор подключены к двум вводам питания. Как правило, в современном оборудовании такая возможность предусмотрена производителем. Для серверов с одним вводом питание дублируется с помощью вот такого устройства:

Статический переключатель нагрузки + ручной байпас Digital Energy

Система охлаждения

Для комфортной жизни оборудования в машинных залах нужно поддерживать определенный температурный диапазон. Вот почему компании по всему миру всё чаще строят свои ЦОДы где-нибудь неподалеку от полярного круга — в таких условиях можно использовать наружный воздух для охлаждения серверов. Это называется «фрикулинг», и такой подход по праву считается самым энергоэффективным (зачем тратить энергию на охлаждение тёплого воздуха, если можно сразу взять холодный?).

У нас фрикулинг тоже используется, правда, с некоторыми оговорками. Несмотря на легендарную питерскую прохладу, летом температура воздуха всё-таки иногда поднимается выше заветных 20-25°, и его приходится дополнительно охлаждать. В зимний период, напротив, воздух слишком холодный, чтобы его можно было сразу использовать. Кроме того, что серверы могут просто переохладиться, изменение температуры приведёт к сдвигу точки росы — а конденсат такому оборудованию противопоказан. Вдобавок, воздух при такой схеме попадает с улицы, а значит, его нужно дополнительно очищать.

Фрикулинг используется в одном машинном зале из четырёх, в остальных система охлаждения работает по классической схеме с использованием прецизионных кондиционеров.

Внутренние блоки прецизионных кондиционеров

Внешние блоки прецизионных кондиционеров

Холодный воздух из камеры смешения или кондиционера через фальшпол или воздуховод подаётся в так называемый «холодный коридор». Это изолированное пространство между лицевыми сторонами двух рядов стоек. Вот такое:

Холодный коридор машинного зала

С обратной стороны отработанный нагретый воздух попадает в «горячий коридор» — а оттуда отправляется обратно на охлаждение фреоном во внутренние блоки кондиционеров. Так достигается циркуляция чистого (без пыли) воздуха в машинном зале.

Горячий коридор машинного зала

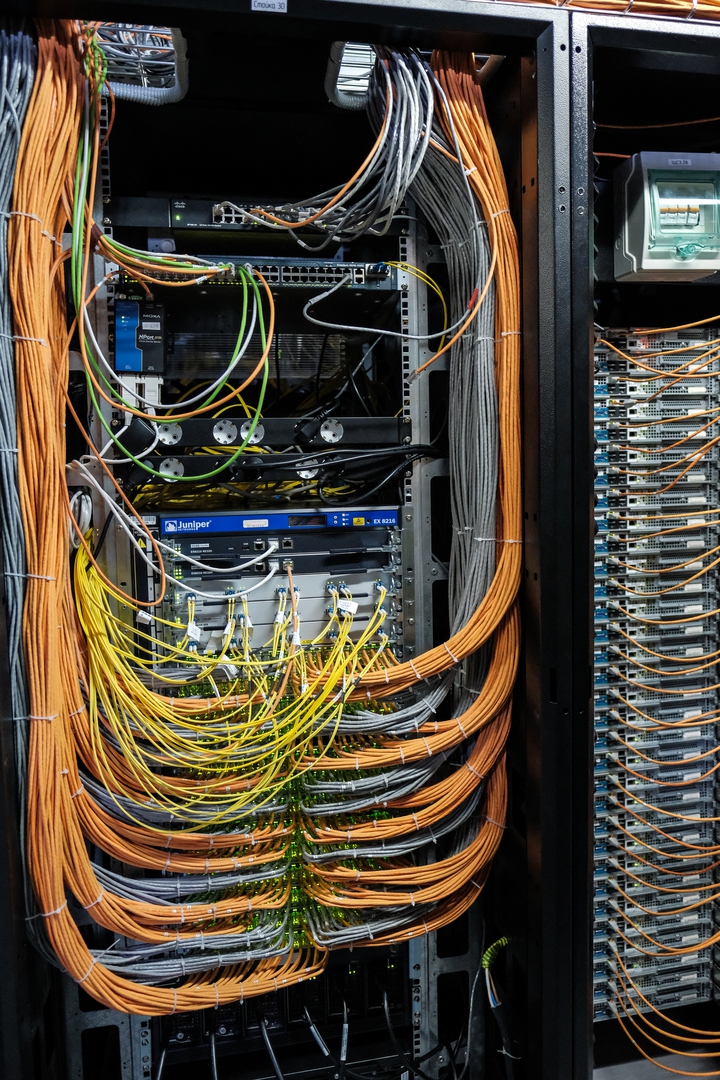

Структурированная кабельная система

Километры бережно уложенных проводов. Здесь не нужны слова.

Система пожаротушения

В нашем ЦОДе предусмотрена система газового пожаротушения. Собственно газ (хладон) хранится под давлением в баллонах. В случае пожара по сигналу с датчика в машинном зале клапан будет приведён в действие, и газ по трубам устремится к источнику возгорания.

Баллоны с хладоном

Манометр

Мониторинг

Все показатели здоровья дата-центра отслеживаются в режиме реального времени. Это температура (с датчиков оборудования и внутри помещений), электроснабжение, нагрузка на сетевое оборудование — данные выводятся на дисплеи дежурных и контролируются автоматикой. Если что-то пошло не так, система мониторинга сама пришлёт инженерам сообщение о проблеме (ВКонтакте и по СМС).

Мониторинг электроснабжения

Мониторинг системы охлаждения

Система контроля доступа и охрана

На территорию могут попасть только сотрудники, любая дверь снабжена электронным замком со считывателем карты доступа. ИЦВА охраняется в режиме 24/7, в каждом помещении ведётся видеонаблюдение.

Подведём итоги

ИЦВА имеет очень удачное расположение: всего в нескольких километрах от родного города ВКонтакте и рядом с надёжным источником электроэнергии.

Здесь непрерывно продолжается процесс модернизации оборудования и повышения энергоэффективности. PUE (Power Usage Effectiveness), или коэффициент эффективности использования электроэнергии — ключевой показатель оценки ЦОД. Он считается как соотношение всей энергии, потребляемой дата-центром, и фактического потребления серверов и сетевого оборудования. Как ясно из этого определения, PUE идеального дата-центра в вакууме равен 1.0. ИЦВА — не идеальный дата-центр в вакууме, но мы планомерно работаем над снижением этого показателя.

Команда сотрудников ИЦВА и сетевых инженеров ВКонтакте делает всё, чтобы Вы каждый день могли наслаждаться своими любимыми роликами, смотреть новые фотографии друзей и не задумываться о том, какая сложная инфраструктура при этом используется.

Если Вы — первоклассный специалист, у Вас есть шанс познакомиться с нашим дата-центром поближе, став частью команды. Мы приглашаем на работу руководителя тестовой лаборатории ЦОД и системных администраторов.

P.S. Статьи о технической стороне ВКонтакте также можно читать в нашем блоге на русском и английском языках. Задать вопрос автору можно в официальном сообществе.

Комментарии (34)

0x5cef

05.07.2017 18:29Вот это мощь! А как все начиналось…

bondbig

06.07.2017 10:20как?

DarthVictor

06.07.2017 15:37+3Известно как

Adward

07.07.2017 05:13+1Но ведь до этого была уже проведена какая то работа?

Вячеслав?и Михаил?Мирилашвили, Лев Левиев уже принесли немножко денег для первых серваков и программистов ;)

Alaniyatm

05.07.2017 22:48+3Добрый вечер!

Можете подсказать чем осуществляете мониторинг? Если это конечно не секрет.

Очень любопытно )))

greediness

06.07.2017 17:04Мониторинг сделали сами. Работает по SNMP. Либо в железо ставятся интерфейсные карты, либо ставятся контроллеры а-ля сухой/мокрый контакт <-> SNMP.

Коллектор собирает данные, далее можем отображать для мониторов больших и маленьких, телефонов и т.п.

Alaniyatm

08.07.2017 13:22Механика понятна. Вопрос был именно к программной части, тк выглядит очень прилично.

TimsTims

06.07.2017 01:46-1А если умирает подстанция, то оба канала электричества пропадают?

А что если во всём городе выключается свет? Допустим, ваш ЦОД работает, но ведь множество соседних узлов оставшиеся без электричества просто не смогут передавать сигналы до абонентов, и всё-равно, вконтакте будет недоступен…

Tobishua

06.07.2017 05:39Вы пишете глупости. Каждый серьёзный оператор имеет такие же схемы резервирования электропитания + многие оптические линии могут быть протяжённостью много километров и приходить в точки обмена, которых не коснулось отключение.

TimsTims

06.07.2017 08:56+4Почему же глупости… Москва, 2005 год, веерное отключение электричества. Некоторые ЦОДы хоть и работали, но ближайшие узлы операторов в тех или иных мечтах — нет. В итоге, 20% интернета не работало.

greediness

06.07.2017 17:11Дизель-генераторные установки (ДГУ) поддерживают жизнь в дата-центре в случае затяжной аварии или плановых работ в системе электроснабжения. Кроме топливных баков в самих ДГУ установлена автоматическая контейнерная заправочная станция большой ёмкости. Топливо из резервуара подаётся автоматически во все ДГУ, запас рассчитан минимум на сутки. В случае необходимости бензовоз с дизельным топливом прибудет в течение двух часов.

slavabars

06.07.2017 13:06Я предполагаю, что если умрут все последующие точки связи (маршрутизаторы), то связи с дц не будет. НО т.к. используется много магистралей, то подобную ситуацию, наверное, можно исключить.

kirillaristov

06.07.2017 02:02-2Понятно — статья "приходите к нам работать" :)

"Ввод 6кВ" — а в мощности сколько?

Pave1

06.07.2017 09:35+1Вот интересно — а зачем так запариваться с запитыванием серверов без резервного блока питания через отдельный балансировщик и т.д.? Это же лишние юниты, лишняя сложность.

Ведь, как я понимаю — предполагается полное резервирование на уровне софта, и выход из строя одной ноды — не должны влиять на сервис?

Ну и укладку кабеля я бы бережной точно не назвал)) Скажем так, она адекватна и функциональна. Но не более)))

И да, спасибо за статью. Интересно.

quantum

06.07.2017 10:53Как мне кажется из за того, что при внезапном отключении электричества может многое сломаться, от ОС до железа

Tramantor

06.07.2017 13:06Вы может быть не читали статью от Нага? На их фоне это ваще! очень бережная и аккуратная укладка.

NAI

06.07.2017 13:06А я правильно понимаю, что если навернется ИБП1, вы получите только одно плечо питания от ДГУ2? Не захлебнется?

Как рассчитываете потребление серверов (и соответственно время работы ИБП)?

karibskii_koks

06.07.2017 13:06Никогда не был знаком с большими объемами серверов.

Но полагаю, что это очень грамотно построенный проект.

Судя по материалу и вакансии Системного администратора ВК, работы там Ого-го сколько.

freeseacher

06.07.2017 13:06+1А расскажите, пожалуйста, как используются qr коды на оборудовании? Куда ведут? Как используются ?

KorDen32

06.07.2017 23:45А почему все сетевое оборудование сведено в отдельные стойки, в которые сходятся огромные пучки? Не проще ли ставить условно по паре коммутаторов на каждые две стойки, но рядом с оконечными серверами? Есть же вроде уменьшение энергопотребления для коротких кабелей витой пары и т.п.

В случае с текущим расположением — если коммутаторы соединены между собой (стекирование, etc) — не эффективнее ли с точки зрения нагрева, энергопотребления,… использовать dirrect-attach медные кабели вместо оптических патчкордов? Или же на больших скоростях все совсем наоборот?

Arrest

Теперь мы знаем, что сетевое оборудование у вас называется A9922-E-5 и A9922-E-7.

K0Y0T

И ещё мы знаем, что используется WDM железки Ciena (Nortel).

Только что нам это даст?