Предприниматель Илон Маск, возглавляющий многие известные технологические компании, известен своей точкой зрения об опасности искусственного интеллекта. Конечно, он знаменит далеко не только благодаря этому мнению. Тем не менее, он выступает против создания сильной формы ИИ с 2014-го года. Тогда он в первый раз публично заявил о том, что искусственный разум может быть опасен. С ним согласен Стивен Хокинг и многие другие ученые, футурологи, специалисты по ИТ. Есть мнение о том, что все человечество может пасть жертвой технологической сингулярности.

Самой опасной, по мнению Маска, является тенденция создания автономного «умного» оружия. По словам предпринимателя, риск появления «роботов-убийц» очень высок, так что необходимо отнестись к этому вопросу со всем возможным тщанием. «Третья революция в вооружениях» уже близка, убеждены специалисты, а автономные «роботы-убийцы» — это своеобразный ящик Пандоры. Времени для решения проблемы остается очень мало.

Примерно неделю назад Маск вместе с 115 видными специалистами, представляющих различные сферы науки и техники подписал открытое письмо, авторы которого просят ООН заняться указанной проблему, причем как можно быстрее.

Письмо было подписано на мероприятии International Joint Conference on Artificial Intelligence (IJCAI 2017), которое проходило в Мельбурне. Кстати, в числе подписавшихся — и основатель DeepMind Мустафа Сулейман, а также Джером Монсе, глава компании Aldebaran Robotics, разработавшей робота Pepper. Если уж руководители компаний, стоящих во главе технологического прогресса, подписывают это письмо, то наверное, над проблемой действительно стоит задуматься.

В письме, в частности, говорится о том, что ИИ и робототехника развиваются такими быстрыми темпами, что возможность ведения войны при помощи автономного оружия, включая роботов, становится все более вероятной. Причем это вопрос ближайших лет, а вовсе не десятилетий, как считалось ранее. Так что уже сейчас необходимо задуматься над тем, каким образом технологии могут повлиять на судьбу человечества. И думать об этом должны, в первую очередь, руководители государств, где технологии развиваются максимально активно.

Сюда можно еще добавить угрозу попадания технологий такого рода в руки террористов и автократов, которые без всяких угрызений совести будут направлять смертоносные инструменты против обычных людей. Даже, если этого удастся избежать, остается еще угроза взлома систем, причем вовсе ненулевая. Хакеры неоднократно доказывали то, что взломать можно практически все, как бы хорошо это «все» ни было бы защищено.

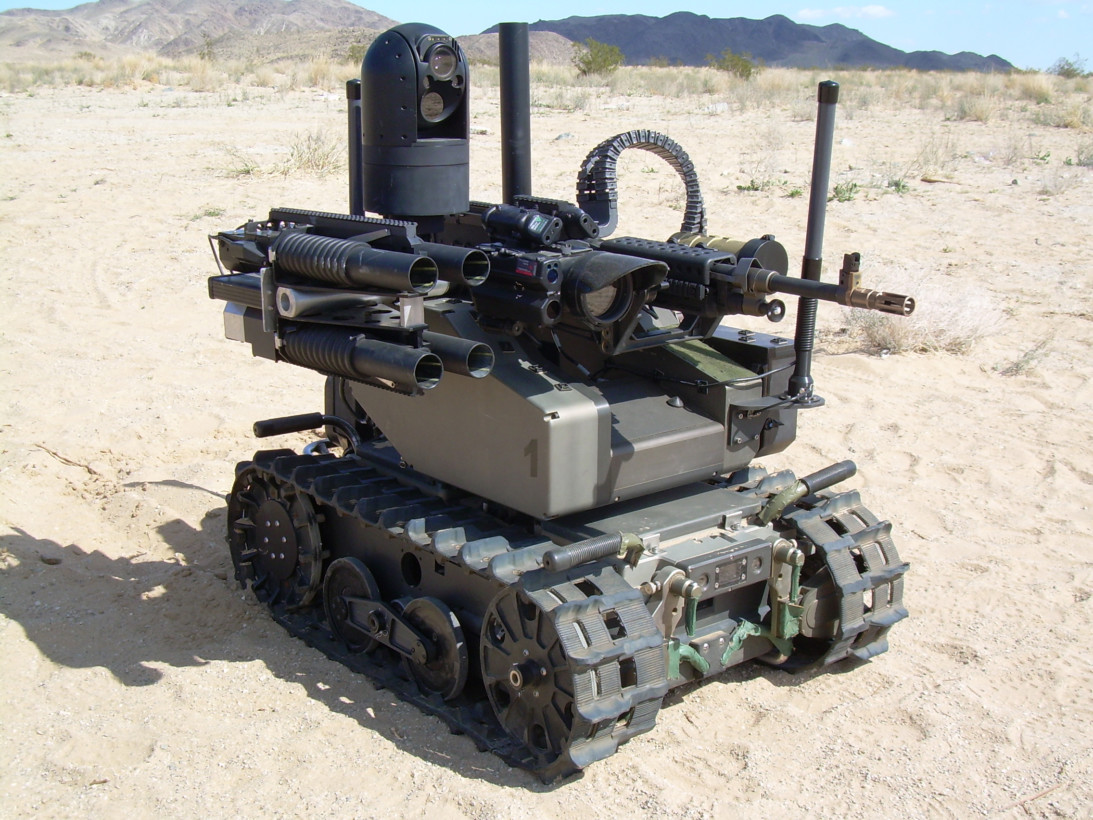

Уже сейчас существуют разработки смертоносного оружия, работающего в автономном или полуавтономном режиме. В числе прочих это вот такой аппарат.

Фото приведено просто для демонстрации того, каким оружием могут быть оснащены роботы на войнах будущего. А ведь уже сейчас в небе летают дроны, способные работать в автоматическом режиме. А корабли оснащаются автоматическими пушками, которые самостоятельно отслеживают возможную угрозу.

Правительства различных стран не согласны с точкой зрения ученых и технологов по разным причинам. Основная — для государств автономное вооружение — это выгодно. Оно способно увеличить эффективность защиты границ или снизить число смертей солдат в случае возникновения локальных или региональных конфликтов. Так, в 2015 году правительство Великобритании выступило против запрещения автономного летального оружия. Более того, разработки вооружения такого типа ведутся здесь очень активно.

Ну а точка зрения ученых, выступающих против автономных «роботов-убийц» хорошо иллюстрируется заявлением основателя Element AI Йошуа Бенджио: «Я подписал открытое письмо, поскольку использование ИИ в автономных системах вооружения противоречит моему пониманию этики, все это может привести к очень опасной эскалации, затронуть всю сферу разработки ИИ. Ситуация должна быть взята под контроль международным сообщества, подобно тому, как это сделано с другими типами вооружений (биологического, химического, ядерного)».

«Создание смертоносного автономного оружия позволяет увеличить масштабы войн до небывалых масштабов, которые даже сложно представить», — говорится в письме. И, вероятно, авторы письма действительно правы.

Комментарии (105)

Ommonick

29.08.2017 15:25+3Статья про опасное автономное оружие. В конце промо код

на скидку к опасному автономному оружию.Ням

ariklus

29.08.2017 15:39+1Короче, боятся что менее антимилитаристским компаниям выделят гранты военного размера на разработку ИИ.

Singrana

29.08.2017 15:57Странные эти все запреты. Давайте запретим на уровне ООН, страны и т.д. и т.п. Как по мне — все эти запреты нужны, только что бы у честных и небольших стран этого не было, всех остальных это не остановит. Это как закон о запрете огнестрела, и как итог, законопослушные граждане в заведомо проигрышной позиции, ибо преступникам все равно на сии законы, у них все есть

Valerij56

29.08.2017 17:52+2Ну, почему? Договор о нераспространении ядерного оружия вполне себе действует, в основном действует запрет на распространение ракетных технологий, довольно эффективен контроль над биологическим и химическим оружием. Такова реальность.

Singrana

29.08.2017 18:11+3Это работает в силу труднодоступности (специфичности( части составляющих, либо сложности технологии. В случае автономных роботов, мы прекрасно понимаем, что тут ограничить весьма проблематично. Тут ближе к огнестрелу. Де юре — запрещено, де-факто — его нет только у законопослушных граждан.

Valerij56

29.08.2017 19:16Вы считаете, что, например, биологическое оружие труднодоступно? Уверяю — ошибаетесь.

Singrana

29.08.2017 19:38+1Вполне возможно. Я в химии не компетентен. Но, мои бытовые познания говорят о том, что не все реактивы есть в свободной продаже и/или легкодоступны. Возможно, не все так просто. Ибо какой не был бы надзор, изготовить можно все, что позволяют ресурсы и возможности, и применить, особенно терористам, которые, вполне могут все изготавливать прямо на месте, раз это не сложно. Возможно есть еще какие-либо причины. Но не отнюдь не то, что кто-то где-то договорился, и страну не спросил. Яркий пример — КНДР. Все вокруг скулят — а воз и ныне там. Так же Иран. По этому я и утверждал, что ООН и прочие — это не панацея. А если взять в учет именно терористов, то там становится все еще проще. Их запреты ООН или государства априори не волнуют

BlackMokona

29.08.2017 19:59Хлор продаётся даже мирным жителям.

Хлор был одним из первых химических отравляющих веществ, использованных Германией в Первую мировую войну, впервые применен в 1915 году во время битвы при Ипре.

wildlion

30.08.2017 11:48+1Тут в деревню ездил к приятелю, в деревенском магазине аммиачную селитру продают, прям вот на полу лежат мешки по 10 кило. Бери — не хочу.

OneOfUs

30.08.2017 11:56ВУ можно собрать из стеклянной баночки от детского питания и спичек. Правда спичек понадобится вагон, чтобы серных головок наковырять на баночку. Или флэша из петард. Тут главное проявить смекалку. А что можно сделать из перекиси водорода, серной кислоты и ацетона я уже молчу

mat300

30.08.2017 01:57-1Вот, как и эти опасные реактивы, так же и все достаточно мощные и специализированные процы запретят для свободной продажи, а в то что разрешено встроят рубильник, чтоб если что, то бац и приехали. И это, я думаю, простейший путь обуздать автономное оружие, его несанкционированное производство и прочее неведомое нечто.

mat300

30.08.2017 02:03-1И в самом деле, нужен международный договор по вопросам производства и использования автономного оружия и применения ИИ технологий в военной технике. И это может и звучит как-то убого все, но намного лучше, чем оказаться на поле боя между разными формами ИИ. Я полагаю, тут все хотят жить долго и счастливо.

И дело каждого коллеги по ИТ не допустить скатывания известного нам мира в хаос. Лучше пока притормозить.

Singrana

30.08.2017 09:28в случае с ИИ это практически неосуществимо, при условии что мы не откатываемся в каменный век. Любой минимально производительный смартфон может обсчитывать сеть. Ограничение в поставках специализированных или высокопроизводительных решений — так сделают кластеры на менее производительных. Спецрешение — fpga. Имхо, сложнее тут проконтролировать.

Valerij56

30.08.2017 12:18Тогда действует принцип коллективной безопасности — нарушителя режима давят всем миром.

Valerij56

30.08.2017 12:14Но, мои бытовые познания говорят о том, что не все реактивы есть в свободной продаже и/или легкодоступны.

На уровне государства или достаточно крупной корпорации вполне доступны, поэтому и есть уверенность, что режим ограничения биологического и химического оружия действует.

Сложнее на уровне террористов, но в Японии крупная секта смогла изготовить вполне современные V-газы.

Ещё сложнее с биологическим оружием. Достаточно квалифицированный врач-эпидемиолог сможет его создать, так как практически везде есть захоронения, оставшиеся после какой либо эпидемии, и вовсе не все они нормально обеззаражены, а многие бактерии сохраняют вирулентность в могильниках сотни и тысячи лет. И вот для этого не нужны какие-то крутые ресурсы.

При первой же попытке КНДР применить ОМП её сотрут в порошок. Другое дело, что КНДР (как и Россия в последнее время) ведёт себя как гопник, который понимает, что окружающие, в отличии от его, будут думать о рисках и последствиях. Тем не менее стоит чуть-чуть слишком нажать — и всё будет.

MTyrz

01.09.2017 01:06Я в химии не компетентен. Но, мои бытовые познания говорят о том, что не все реактивы есть в свободной продаже и/или легкодоступны. Возможно, не все так просто.

Ваши бытовые познания ошибаются.

Просто террористы — унылые неучи, неспособные даже к воспроизведению примитивных химических технологий. В общем-то, оно явно к лучшему.

Eklykti

29.08.2017 19:25Да, биологическое оружие, несомненно, находится под контролем, вот только под чьим?

Valerij56

30.08.2017 12:23С этим согласен. Споры сибирской язвы — пример того, что могут в своё распоряжение получить даже индивидуальные террористы.

Falstaff

29.08.2017 21:47Сложно сказать, насколько эффективен контроль над биологическим. То, что оно ещё не было пущено в ход — ещё не свидетельствует о том, что его никто не исследует и не производит. Инспекции ООН в своё время мало нашли в Ираке, и только после того как Хусейн Камель переметнулся, они сами внезапно признали, что вовсю производили антракс и ботулотоксин аж с восьмидесятых годов. Причём даже сами штаммы они получили от американского центра по контролю заболеваний — просто взяли и заказали. Для медицинских исследований.

Valerij56

30.08.2017 12:20Это, всё же, скорее химическое оружие, производимое методами микробиологии.

Falstaff

30.08.2017 19:56Ботулотоксин, да, пожалуй. Антракс — сибирская язва — это всё-таки биологическое. Причём это только то, что они в промышленных масштабах производили под носом у всех, а исследовали ещё кучу вещей — энтеровирус 17, camelpox, возбудителей газовой гангрены. Образцы штаммов вообще всем доступны, их CDC официально послала, согласно рекомендациям ВОЗ по свободному обмене образцами между исследователями.

Valerij56

30.08.2017 20:15Образцы штаммов вообще всем Доступны

Сертифицированным лабораториям, что в масштабах страны не сложно. Хотя на это есть и ограничения.

Falstaff

30.08.2017 20:24Я не имел в виду кому-то с улицы, конечно. Ирак попросил, ему дали — скажем так, это, думается, гораздо легче чем контрабандой тащить урановую руду.

Valerij56

30.08.2017 20:53Я понимаю, как понимаю и то, что добыть вирулентную бактерию язвы в состоянии практически любой. Правда, не любой после этого выживет. но для устройства теракта с сибирской язвой не нужна большая террористическая организация.

black_semargl

31.08.2017 01:36У любого теракта есть его вдохновители, которые совсем не собираются гибнуть после его совершения, а очень даже наоборот.

И при каком-то уровне угрозы их просто убьют невзирая на сложившиеся международные законы

Valerij56

31.08.2017 11:06Я и говорю — достаточно иметь совсем небольшую организацию, чтобы получить возможность совершить теракт биологическим оружием. Вычислить и убить их всех в принципе невозможно. Всегда останется риск, что кто-то уцелел.

black_semargl

03.09.2017 15:19Теракты не совершают просто так.

Поэтому достаточно выявить и зачистить выгодополучателей, остальные члены организации неважны.

Valerij56

03.09.2017 16:34Такими действиями, с учётом специфики менталитета восточных народов, вы скорее будете раз за разом получать через некоторое время поколение, в котором террористов будет всё больше и больше. «Вычищенный» вами террорист в их представлениях будет в раю рядом с богом вкушать явства с окружении сотни девственниц.

Заставьте его убирать за свиньями и есть свинину. Пусть живёт, но разрушьте его дом, чтобы семья была вынуждена просить милостыню, а у сына не было денег выкупить невесту. Пусть знает, что семья отвечает за его.

chieftain_yu

30.08.2017 14:17Ну, даже по имеющимся штаммам работы явно должны идти.

Та же сибирская язва, полагаю, должна как минимум активно изучаться в специализированных институтах (и быть там в активной форме, естественно) с попыткой выработки лечения, попыток сделать вакцины и так далее.

А забабахать биологическую «руку мертвеца» — вполне заманчиво.

bak

30.08.2017 00:24+1Сильный ИИ — следующая ступень эволюции, нет никакого смысла противиться его созданию. Лучше наоборот ускорить.

Kardy

30.08.2017 00:44"Лучше наоборот ускорить."

Зачем? То что кто-то "следующая ступень" — не делает его лучше или нужнее — это человеческие термины, существующие только в рамках человеческой системы ценностей. Эволюция сама по себе это просто процесс, вроде дрейфа континентов.

" нет никакого смысла противиться"

С эволюционной точки зрения если противится хочется и можется, то "следующая ступень" — не "следующая ступень", а "тупиковая ветвь". Если нет — то нет.

dron_k

30.08.2017 01:14+1«Создание смертоносного автономного оружия позволяет увеличить масштабы войн до небывалых масштабов, которые даже сложно представить»

1) И кто первый достигнет бОльших масштабов тот и в лучшей военной позиции.

И сможет всем рассказывать что нужно делать а что нет.

2) Выйдет ли ИИ из под контроля человека зависит от очень многих факторов, но то что он появится это точно тк см.п.№1.

3) Ну а тк имеет место конкурентность (см.п.№1) то качество очередного решения может таки быть не совершенным, что может быть одним из факторов п.№2.

Valerij56

30.08.2017 12:29И кто первый достигнет бОльших масштабов тот и в лучшей военной позиции.

На первых порах превосходство не будет слишком большим — можно будет задавить массой. Даже искусственный интеллект всё равно в качестве оружия вынужден будет использовать те же пули снаряды, ракеты.

И сможет всем рассказывать что нужно делать а что нет.

Silvatis

30.08.2017 02:34+2не знаю, в моей философии создание ии, который будет умнее человека и в последствии к человеку будет относиться как человек к муравью\кошке\корове\вредителям? — обычный эволюционный, нужный и очень важный вопрос.

Просто надо смириться, дать

более лучшеенеорганическое но превосходящее по когнитивным возможностям потомство иосесть в человеческих заповедникахсгинуть в небытие.

Kardy

30.08.2017 13:30Нужный кому? Вселенной — безразлично. Людям, при таком раскладе — вред. А заботится об интересах несуществующих железяк — просто глупость какая-то.

Silvatis

30.08.2017 16:04Ну на счет вселенной я бы не был так уверен. Она любит тратить энергию и упорядочивать. Планеты там на орбиты сажать, тела в состояния покоя засовывать. Вполне может оказаться, что вселенной выгоднее в этом плане ИИ будет, нежели белковые процессоры. Но это я так, языком почесать.

А вообще для меня это процесс ради процесса: Продолжение эволюционного развития жизни на качественно новом уровне. Один фиг все в нашем биологическом мире направленно на этот процесс, хоть сразу и не скажешь.

Denkenmacht

30.08.2017 04:38Люди долго привыкали убивать друг друга не лицом к лицу, а на расстоянии, не видя противника. И автономное роботизированное оружие — это еще один шаг по этому пути, как бы страшно это не было, но те страны, кто будет обладать этой технологией, будут победителями на полях боя будущего. Нам надо не сопли распускать, а работать над созданием такого оружия, потому что оно гарантирует нам мир, как гарантирует ядерное оружие и технологии автоматического ответа, типа "мертвой руки". Пока американцы пишут такие письма в ООН, они с одной стороны ведут работу над ИИ (тот же Маск), а с другой дискредитируют саму роль ООН как международной организации — считай вешают всему миру лапшу про пацифизм, при этом готовя оружие будущего и снижая роль мирового регулятора, который хоть как-то способен их ограничить.

Valerij56

30.08.2017 12:33+1Люди долго привыкали убивать друг друга не лицом к лицу, а на расстоянии, не видя противника. И автономное роботизированное оружие — это еще один шаг по этому пути, как бы страшно это не было, но те страны, кто будет обладать этой технологией, будут победителями на полях боя будущего.

Не обязательно. Вполне возможен вариант, когда победителей не останется, или уровень цивилизации будет снижен лет на пятьсот. Второй индустриализации не будет — все легко извлекаемые ресурсы уже истрачены.

lavmax

30.08.2017 07:10Создание смертоносного автономного оружия позволяет увеличить масштабы войн до небывалых масштабов, которые даже сложно представить

Так когда то говорили про пулемёт.

red75prim

30.08.2017 08:52И получили первую мировую войну. Там, конечно, повлияли в основном не пулемёты, а поезда, то есть увеличение логистических возможностей.

BaLaMuTt

30.08.2017 08:30То что люди рано или поздно создадут «скайнет» глупо отрицать. Вопрос лишь в том как он будет называться на самом деле — Google, Яндекс или Baidu)))

andrey_aksamentov

30.08.2017 10:26Не совсем понятно в чем опасность.

Если, например, залить в танк ИИ, и у этого ИИ будут внедрены нужные постулаты (в момент обучения), То чем он может быть опасен владельцу?, ИИ не сможет просто так взять и вырезать себе восприятие окружающего и вставить другое.

Как из сети машин с ИИ может получиться подобие скайнета?

Чем, танки, самолеты, машины, мелкие гусеничные роботы, приделают себе руки и ноги, чтобы строить заводы по производству себе подобных…

Хорошо, даже если они будут управляться центральным дата центром, который вдруг захочет уничтожить всех, что помешает его отключить?

red75prim

30.08.2017 12:04Скайнет — это совсем маловероятный сценарий. Тут речь о другом. Понижение планки для начала военных действий из-за отсутствия человеческих потерь и сопутствующих этому политических проблем у инициатора. Упрощение контроля за населением в диктатурах. Увеличение потенциальных потерь от кибертерроризма и кибердиверсий. Потеря командованием контроля над ситуацией из-за слишком быстрого темпа боевых действий. И т.п.

andrey_aksamentov

30.08.2017 13:50Имхо исторически боевые действия, теми кто их затевает, оцениваются прежде всего с финансовой стороны, людские ресурсы, как и ресурсы материальные есть расходный материал. Люди относительно недорогой ресурс — сами размножаются, сами кормятся, работают. Роботы с ИИ на этом фоне выглядят намного дороже.

black_semargl

31.08.2017 01:38Нет никакой гарантии, что постулаты будут введены правильно

geektimes.ru/post/291847andrey_aksamentov

31.08.2017 09:24На то они и специалисты, а оно и тестирование.

Саботировать машину с ИИ картинками, очень сомнительная затея.

Для этого потребуется в боевых условиях захватить машину с актуальным для всех остальных машин ИИ состоянием, избежать самоуничтожения машины или ее мозгов, подобрать что то визуальное, что повлияет на работу этой машины и как то суметь передать изображение на камеры остальным машинам. Но ведь каждая машина будет в своей уникальной среде и воспринимать эту среду по своему, если машина способна еще и обучаться, то каждое состояние будет уникальным.

black_semargl

03.09.2017 15:22Сознательно саботировать — оно да, сложно. Но данный пример показывает, как легко заставить машину неверно распознать символ.

Т.е. ввести правило что надо убивать исключительно солдат противника не получится, нейросеть может внезапно для всех отнести к ним покупателей очередной модной сумочки.andrey_aksamentov

03.09.2017 15:33Но мы имеем ввиду достаточно разумный ИИ, способный в реальном времени оценивать объект.

Как обычный солдат оценивает врага?, — по иной одежде, оружию, расположению и реакции.

Покупатели модной сумочки в зоне боевых действий? Мы же не говорим об ИИ у роботов — полицейских в мирное время.

andrey_aksamentov

03.09.2017 15:38Если вы имеете ввиду подделку противником своих юнитов визуально под союзных юнитов противника, то есть старая проверенная система свою-чужой.

sets

30.08.2017 13:20+1Упущен вариант ответа «автономное оружие приведет к понижению уровня истерии и повышению гуманизации общества».

alix_ginger

30.08.2017 15:43+1Воевать люди все равно будут. Но в случае с автономными боевыми

человекоподобнымироботами, жертв будет меньше. А в случае боя между роботами и роботами — количество жертв будет в пределах погрешности. Что в этом плохого?

chieftain_yu

30.08.2017 15:57Кто мешал и мешает выставлять в войнах по одному бойцу от страны? Или вообще решать все боксом/греко-римской борьбой в рамках олимпиад? Жертв минимально. Сравнительно недорого и все такое…

Да только на экономику (причину войн) сражения «робот против робота» влияют очень слабо. А вот «робот против людей» («бомбардировщик против людей», «артобстрел против людей» и так далее) — намного сильнее.

black_semargl

31.08.2017 01:40Мешает отсутствие желания у некоторых соблюдать соглашение после проигрыша…

alix_ginger

31.08.2017 09:06Да только на экономику (причину войн) сражения «робот против робота» влияют очень слабо. А вот «робот против людей» («бомбардировщик против людей», «артобстрел против людей» и так далее) — намного сильнее.

Можете объяснить подробнее? Я не очень понял.

chieftain_yu

31.08.2017 09:22Если сражения делать вида «вышел робот в чисто поле и уничтожил робота противника», то у противника экономика не падает, он потерял по сути только стоимость робота, что — копейки.

Если вместо этого с помощью беспилотника или классического самолета скинуть бомбу на требуемый завод (обитаемый, то есть люди тоже пострадают), железнодорожный узел, узел связи, центр снабжения — подрыв экономики выйдет намного больше.

Если устроить несколько террактов (то есть акций, принципиально ориентирующихся на поражение людей), то перевозбудившиеся власти начнут ставить рамки и охранников. Чем опять же ухудшат состояние экономики — здоровые лбы вместо осмысленной работы будут гонять население через рамочки. А население — терять человековека.

speakingfish

30.08.2017 18:55Всё это хорошо, только для начала надо запретить уже существующие doomsday-системы типа «Периметр», так как они также как и прочие автономные системы не защищены от ложного срабатывания. Только кто от них сейчас откажется-то? Как-никак вторая холодная война на дворе :(

Wesha

31.08.2017 03:06Вы статью-то вообще читали?

Она была разработана так, чтобы находиться в дремлющем состоянии, пока высокопоставленное официальное лицо не активирует её в кризисной ситуации. Тогда она начала бы мониторить сеть датчиков — сейсмических, радиационных, атмосферного давления — на признаки ядерных взрывов. Прежде чем запустить ответный удар, система должна была бы проверить четыре «если»: если система была активирована, сперва она попыталась бы определить, имело ли место применение ядерного оружия на советской территории. Если бы это оказалось похожим на правду, система проверила бы наличие связи c Генеральным штабом. Если связь имелась, система бы автоматически отключилась по прошествии некоторого времени — от 15 минут до часа — прошедшего без дальнейших признаков атаки, в предположении, что официальные лица, способные отдать приказ о контратаке, по-прежнему живы. Но если бы связи не было, «Периметр» решил бы, что Судный день настал, и незамедлительно передал право принятия решения о запуске любому, кто в этот момент находился бы глубоко в защищённом бункере, в обход обычных многочисленных инстанций.

"Периметр" не запускает ракеты, он всего лишь даёт право запуска ракет человеку, который в нормальной ситуации этого права не имеет.

chieftain_yu

31.08.2017 07:09Чуть выше: «Другой предполагаемый вариант работы системы — при получении информации о первых признаках ракетного нападения Верховный главнокомандующий переводит систему в боевой режим. После этого, если в течение определённого времени командный пункт системы не получает сигнал на остановку боевого алгоритма, то происходит пуск командных ракет.»

А то, что вы цитировали, это из интервью одного из создателей.

Создатели подобных систем всегда в интервью говорят чистую правду, да и система совсем не секретная, как и алгоритм работы, конечно же.Igor_34_rus

31.08.2017 10:48В любом случае у ракеты есть «дежурный» который должен нажать на кнопку запуска.

И если этот «дежурный» не получил приказ об отмене запуска то по регламенту должен совершить запуск.

Всякие чемоданчики и периметры всего лишь дают доступ «дежурному» к кнопке пуска.

chieftain_yu

31.08.2017 11:44Вы достоверно знаете или, как и я, предполагаете?

Система, зависимая от человека или нескольких, не может всерьез считаться «рукой мертвеца».

Если бы я делал именно «руку мертвеца», я бы предусмотрел и сценарий, когда дежурный (дежурные) на пульте должен подтверждать свое существование системе с некой периодичностью по аналогии с УКБМ. И в случае, если ни один из людей, могущих дать команду на пуск, недоступен (при доступности их терминалов управления), а система находится на боевом взводе, давать команду на запуск.Igor_34_rus

31.08.2017 11:58Точно знаю. По крайней на подлодках и шахтах так.

Если дежурный, а это человек физически находящийся рядом и может дотронуться рукой до ракет(в смысле при желании добраться до неё), не может подтвердить своё существование значит либо само место базирования разрушено/уничтожено/захвачено и запуск будет не возможен.

Приказ на запуск будет задолго до того как оружие противника ударит по объекту(лететь далеко) да и запас по ударной мощи хороший и заранее предусматривает, что часть ракет не выйдет из шахт, часть собьют ПРО/ПВО и т.д…

По этому я уверен, что аналог с УКБМ, тут просто не нужен.

chieftain_yu

31.08.2017 12:13Полагаю, в системах, отдающих команду не на запуск конкретной ракеты/пачки ракет в непосредственной близости от пусковой, а глобально для устраивания атомного армагедца алгоритмы и процедуры могут быть совсем другими.

Смотрите, на пусковой это, может, и требуется. Чтобы ответственнный за пусковую дежурный подтвердил пуск.

Но в случае «ядерного чемоданчика» нельзя завязываться, что главковерх всегда возле чемоданчика. Должна быть и возможность инициации удара в случае определенных ситуаций (например, борт №1 уничтожен вместе с чемоданчиком).Igor_34_rus

31.08.2017 13:31Нет команды на запуск пачки ракет, есть команда на включение доступа дежурного у пуску ракет(ы).

Чемоданчик это переносной пульт, этих пультов несколько, в том числе и стационарный, в Чехове, в убежище генштаба.

В «штатной» ситуации, команда на запуск будет идти от генштаба( в армии всё построено на иерархии).

Для случая когда полный ахтунг и есть система «периметр». Она отдаст команду, что можно пускать ракеты. (по моему периметр = чемоданцик)

black_semargl

03.09.2017 15:29Прохождение команды по всем уровням иерархии дело слишком долгое и приемлемо только если ты стреляешь первым.

Чемоданчик как раз для того и придуман, чтобы передать команду от Главнокомандующего сразу дежурящим за пультами запусков.

ну а если и чемоданчик накрылся — тогда «периметр»

Hellsy22

На фото MAARS, которому около десяти лет. И он не автономен.

kraidiky

И вообще, кто-нибудь объясните этому кретину, что мина это тоже автономное летальное оружие, и он со своими заявлениями опоздал. :\

hungry_ewok

Нет ничего нового в этом мире — где-то в начале прошлого тысячелетия один римский папа запрещал арбалеты…

Vemaster

Дистанционное != автономное. Маск говорит за оружие под контролем ИИ, которое само одновременно решает кого убивать, а кого нет — и производит убийство. Мина же просто мина — ей пофиг кто на неё наступил, и сама наступать ни на кого не может, и тем более в избирательной форме.

Hellsy22

Есть мины с системой опознания «свой-чужой».

Vemaster

Примитивные нули и единицы, мимо. Речь шла, очевидно, про оружие под управлением нейросетей, что при определённом этапе развития нейросетей в полноценные ИИ может быть чревато, и не обязательно надо совать именно что полноценный в применяемое оружие — просто сам факт наличия такого функционала в нём, и получи доступ к серверу с апдейтами условный злой ИИ, не важно через подкуп/шантаж человека с флешкой, или прямой хак — этого всё очень плохо кончится.

Так что сам факт автономного, пусть и не развитого по своему интеллекту оружия — просто из-за факта того, что ИИ рано или поздно будет создан, и ситуация может выйти из под контроля — несёт потенциальную угрозу масштабного факапа, так что г-н Маск тут чертовски прав.

Hellsy22

Что значит «ситуация может выйти из под контроля»? Мины убивают и гражданских. С ними ситуация давно уже «вышла из под контроля», но ни к каким глобальным проблемам это не привело. Как не приведет и в случае потери контроля над беспилотным дроном или каким-нибудь штурмовым роботом.

Чтобы случилась неприятность планетарного масштаба эти самые дроны должны уметь размножаться или хотя бы ремонтироваться, заправляться и пополнять боезапас.

Маск, как мне кажется, озабочен не тем, что неприятность может случиться с человечеством вообще, а тем, что неприятность может случиться с кем-то из золотого миллиарда.

Valerij56

Маск, мне кажется, озабочен тем, что автономное оружие может вбомбить нас в каменный век. Но это в перспективе. А сейчас мы имеем снижение порога начала войны, который сейчас и так уже низок. А дальше мы вполне можем угодить в т.н. «воронку», когда события как бы сами по себе приводят к эскалации военных действий. Война может стать слишком скоротечной, чтобы ею могли управлять штабы, а тем более политическое руководство.

Помните, во время карибского кризиса кубинцы сбили американского лётчика? По действовавшей тогда военной доктрине американцы вполне могли начать военные действия.

Hellsy22

Вы, видимо, тоже говорите о золотом миллиарде. Ведь войны постоянно идут и в них активно принимают участие страны первого мира, просто не друг с другом. Или не напрямую друг с другом, по крайней мере.

Valerij56

Вне «золотого миллиарда» нет такого разрушительного оружия, которое могло бы угрожать существованию цивилизации.

А риск действительно большой, если развитие будет откинуто на 500 лет назад, то второй индустриализации не будет. Все легкодоступные ресурсы растрачены.

red75prim

Уголь пока ещё есть, паровыми буровыми вышками наверное смогут и до остатков нефти добраться. Информация о разведанных месторождениях возможно сохранится. Металла будет полно. Длительный коллапс пока ещё не гарантирован. Но ничего приятного, конечно.

Valerij56

Зависит от того, как глубоко оппоненты вбомбят друг друга. И вот здесь сильный ИИ вполне может помочь вбомбить оппонента в каменный век.

black_semargl

Ну да, уголь тут, руда там — а между ними десяток враждующих полевых командиров — феодалов.

И нагнуть их без железного оружия никак.

Замкнутый круг.

Или до угля шахту в сотню метров копать — а чтобы сделать инструмент для этого уголь нужен.

Hellsy22

Если вы говорите о ЯО, то оно есть у Северной Кореи, Индии, Пакистана и даже у ЮАР. Это если верить, что страны СНГ действительно уничтожили свои запасы ЯО, а не припрятали их или того хуже — продали кому-нибудь.

Но проблема ЯО никак не связана с проблемой ИИ, ну, кроме сюжета фильма «Терминатор». Речь-то же вроде как шла об автономных боевых единицах с обычным вооружением. Даже если они зачем-то разнесут ракетами производственные комплексы и электростанции, убытков будет на десятки миллиардов (да пусть хоть на сотни), но и только.

Вы это к чему?

Valerij56

Надо немного подумать, и станет ясно.

Hellsy22

Я вас не тороплю.

Valerij56

А вы сами так подумать и не пробовали? Печально.

Hellsy22

Мне очень не хочется верить, что вы имели в виду сюжет типа «роботы уничтожают цивилизацию и сами разрушаются, утерявшие знания люди пытаются на обломках мира начать все заново». Ведь дело даже не в том, что этот сюжет заезжен до дыр, хотя Каганов написал отличный рассказ на эту тему, что характерно — без ИИ. И не в морально-этической составляющей — странно переживать о будущих проблемах с металлами у 1% человечества, если погибнет 99%. А в том, что это все не имеет отношения к рассматриваемому оружию, основанному на ИИ.

Valerij56

Даже не обязательно уничтожают цивилизацию. Просто один нехороший человек может попытаться диктовать свою волю другим, и то чревато миллионами и десятками миллионов жизней.

Hellsy22

Это население одного мегаполиса. Или количество погибших от плохой медицины и соц. условий в России за пять лет по сравнению с развитыми странами.

Я согласен, что государства — зло. И создавая все более и более мощные инструменты, мы как бы строим себе собственным руками тюрьму и виселицу. Но и это не имеет отношения к краху технократической цивилизации во всем мире.

Valerij56

Десятки миллионов может быть в несколько раз больше населения всех российских мегаполисов.

Eklykti

И у великой и Могучей Америки начнут то тут, то там отжимать вкусные кусочки от всяких островных баз и подконтрольных территорий. Вот и кричат спешно «запретить!». При том, что реальной власти что-либо запретить у ООН ни фига нет, и запретят они таким образом только самим себе. Зато будет повод поорать «отняли пустой атолл без единого человека бесчеловечным автономным оружием».

Valerij56

Так не терпится повоевать, и «отжать кусочек» у великой и Могучей Америки? А потом посмотреть на родные просторы с высоты, пролетая радиоактивным облачком?

kraidiky

Потрясающе как много казалось бы носителей интеллекта и кругозора не в курсе о существовании прыгающих мин, реагирующих на звук шагов и ракет самостоятельно выбирающих себе цель, с использованием системы свой-чужой и библиотеки типичных инфракрасных изображений целей. А ведь всё это технологии прошлого века.

Люди берутся обсуждать искусственный интеллект, а сами рассуждают на уровне мин растяжек, сделанных из гранаты и разбитой бутылки.

red75prim

Эти минные поля самостоятельно перемещаются в сторону противника? Они осуществляют обмен сведениями о текущей обстановке и этот обмен можно перехватить и заставить их атаковать что-то ещё? Срабатывание одной мины может вызвать автоматическую эскалацию до уровня крупномасштабной войны?

Нет? Тогда при чём тут это?

Valerij56

Кроме того, представьте себе, что в распоряжении ГКЧП четверть века назад у вас была бы в Москве, скажем, сотня танкеток, с фотографии в статье, и что управляются они ИИ, и имеют секретные базы снабжения и замены аккумуляторов по всему городу.

dron_k

А кстати прекрасное сравнение,

сидит ждет пока на неё ктото наступит и бах

сидит ждет пока мимопроходил ниточку зацепил и бах

сидит ждет пока мимопроходил будет похож на человека и бах

ездит на рельсах вдоль забора, видит похож на человека и бах

ездит по маршруту, видит похож на человека и бах

ездит по маршруту, видит похож на полковника вражеской армии и бах

где грань автономной летальности между тупой миной и сильным ИИ?

black_semargl

Всё что действует по неизвестному человеку алгоритму.

red75prim

Нейросети действуют по известному алгоритму, но заодно являются универсальными аппроксиматорами. Обученная сеть реализует неизвестную нам функцию, выполняющую, скажем, отличение кошки от собаки. Это уже неизвестный алгоритм?

black_semargl

Нет, алгоритм как раз неизвестен — хрен знает, по какому именно признаку нейросеть научилась отличать одно от другого? Тут было несколько статей про глюки распознавания образов, вот совсем недавно geektimes.ru/post/291847

А уж как она «распознает» ранее неизвестный образ — вообще непредсказуемо. Распознает своё мирное население как армию противника, например…

Hellsy22

А сам-то человек действует по известному человеку алгоритму?

black_semargl

Человек как нейросеть тоже по неизвестному. Но тут в большинстве случаев можно просто самому попробовать подумать, чтобы получить аналогичный результат.

red75prim

То, что убивает без прямого контроля человеком, даже если не ходить по территории огороженной табличками "осторожно мины"?

Oberon812

Противовоздушная мина? Автономна, плюс ни разу не видел территорию, огороженную воздушными шариками с «Achtung! Minen!».

lavmax

То, что нет четкой границы, не означает, что нет разницы.