Фото: micron.com

Фото: micron.comНа днях Micron объявила о том, что стартовало производство тестовых образцов регистровых модулей оперативной памяти DDR5 для использования в серверах. Они будут построены на микросхемах 10-нм класса (1Znm) и, как заявили в компании, обеспечат прирост производительности подсистемы памяти более чем на 85% по сравнению с существующими DDR4.

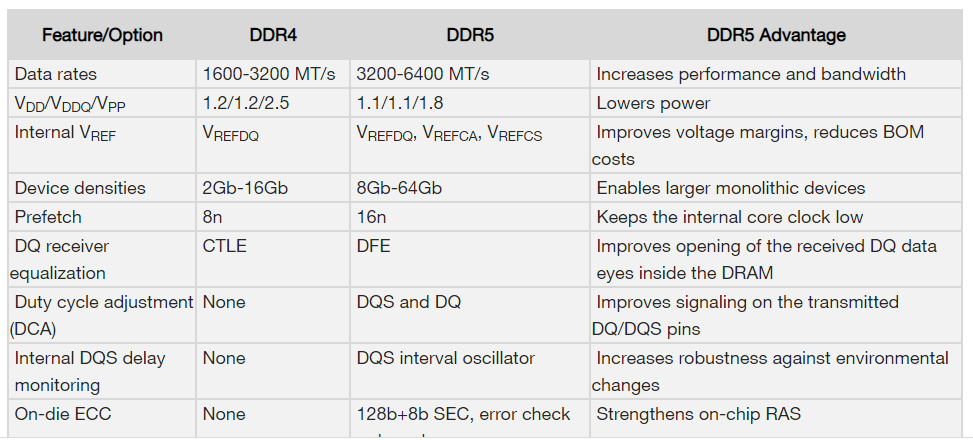

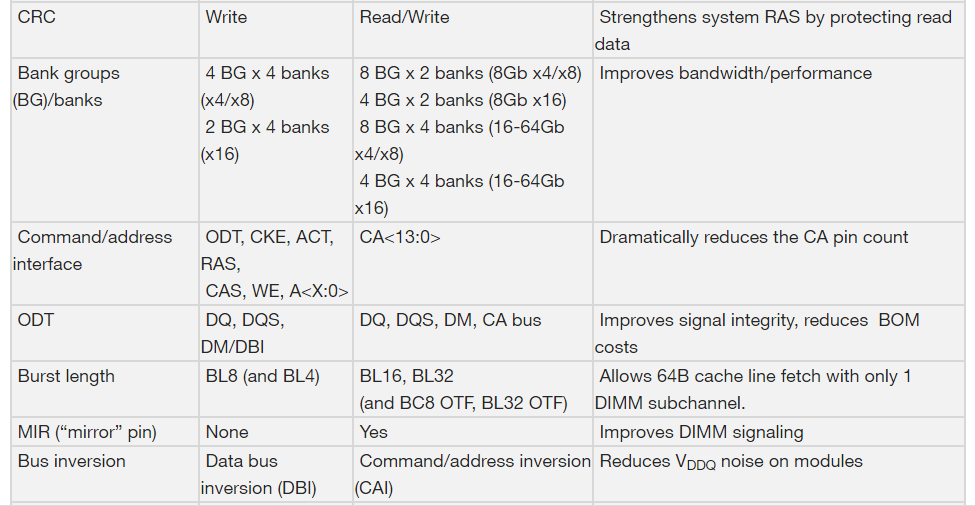

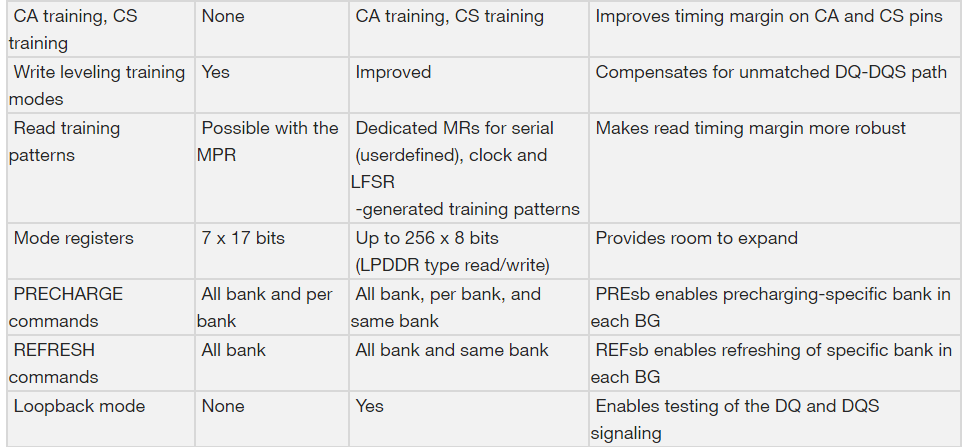

Ожидается, что DDR5 будут требовать меньше энергии, так как рабочее напряжение уменьшат с 1,2 до 1,1 В. При этом они обеспечат больший объем вследствие увеличения емкости самих микросхем. Из спецификации JEDEC следует, что память DDR4 обеспечивает скорость 1600–3200 МТ/с, а для памяти DDR5 этот показатель составляет 3200–6400 МТ/с. То есть, процессоры будут быстрее получать данные из памяти.

Первыми новые модули получат ключевые партнеры Micron. О начале массового производства DDR5 информации пока нет. Предположительно, оно начнется к 2021 году ко времени появления первых процессоров с поддержкой DDR5. Intel и китайская Zhaoxin уже заявляли о таких планах.

«DDR5 RDIMM представляет собой значительную веху, приближающую отрасль на шаг ближе к раскрытию ценности ориентированных на данные приложениях следующего поколения», —заявил Том Эби, старший вице-президент и генеральный менеджер подразделения Compute&Networking Business Unit в Micron.

См. также: «На рынке появится отечественный SSD. Чипы для него будут производить в России»

DeboshiR

Мне кажется ещё текущие машины не все перешли на DDR4 а они уже DDR5 собираются выпускать.

DrunkBear

Это планы на 2021 год, а объявили вовремя: вон уже DDR4 4866@CL18 на рынке.

Sayaka

Так это скорее норма, вспомните как быстро в своё время менялись поколения памяти.

mig126

Ну так это пока не для домашнего рынка. Для домашнего ПК возможностей DDR4 еще на лет десять хватит.

Sayaka

Ой зря вы загадываете на такой долгий срок. У меня VR шлем и могу уверить, шустрая память ему нужна и много. Если VR действительно взлетит, то это ОЧЕНЬ сильно задерёт планку по требованиям к железу.

mig126

За VR я внимательно слежу ещё с появления Окулус. Проблема там в том что отсутствует оптимизация. Создатели игр идут по непроторенной дорожке. Готовых решений фактически нет.

На глаза идёт фактически одинаковая картинка, нет единой/универсальной технологии отслеживания глаз(несколько компаний пытаются протолкнуть свои, но поддержка в играх фактически отсутствует), нет поддержки в directX/Vulcan.

Да и на мой взгляд проблема больше упирается в видеокарты. Возможностей ЦП вполне хватает. SLI VR нет, но вроде планируется. Так что посмотрим.

Temtaime

Она из без VR задирается — 4K, 8K на подходе.

mig126

А какой смысл игры на 8к мониторе? 4к ещё оправдано, но и то при хорошо оптимизированной игре практически не заметно, а 8к мониторы как и 8к телевизоры не дадут никакого прироста качества(если не сидеть в метре перед диагональю от 30").

6opoDuJIo

Моё имхо — с появлением 4к/8к мониторов отпадёт надобность в изощрённых техниках антиалиасинга — он будет просто не нужен, ибо физические пиксели уже слишком малы, чтобы алиасинг был проблемой.

DistortNeo

Да, в играх я это тоже заметил. Если в FullHD приходится для комфортной игры ставить антиалиасинг на максимум, то в 4K я его вообще отключаю и не вижу разницы.

Mad__Max

Ну как бы самый первый (и наименее эффективный, но зато качественный) метод антиалиасинга был это просто считаем всю картинку в 2х или 4х кратном разрешении, а потом уменьшаем полученную картинку до реального разрешения монитора.

DrunkBear

Для 4к это будет уже слишком дорого, особенно с новомодными лучами и прочим.

DmitriyDev

Ну не знаю. Может если сравнивать картинки от игр без какого-то чёткого контура, то разницы и нет, а вот на примере текстов разница обычно хорошо видна. Особенно если текст мелкий. И да, я не имею в виду что мелкий текст это единственное преимущество 8К мониторов. Для проверки можете сделать однопиксельную сетку из черных и белых пикселей, если вы не увидите линии на вашей диагонали при комфортном расстоянии — то да, значит 8К это однозначно переплата.

6opoDuJIo

Э, а зачем тогда 100500 видов антиалиасинга придумали, если алиасинга «не видно»?)

Kolyagrozamorey

ну и запросы сейчас пошли. Я когда то второй квейк и контру 1.6 играл на моніторе Samsung 765MB и вполне хватало, а сейчас мониторов с 4к недостаточно

Fenzales

Во втором квейке и контре не на что было особо смотреть в таком разрешении, уровень детализации сейчас на совершенно другом уровне.

alex6999

Задайте этот вопрос производителям телефонов, они туда гораздо быстрее 8к впендюрят.

Gugic

У телефонов оправдывают наращивание разрешений VR'ом (экран очень близко к глазам + разрешение «пополамится»). Монитор к голове примотать гораздо сложнее.

Mad__Max

Только много ли используют телефоны для VR через кто-то типа гугл cardbox и приспособлений? Вроде тема уже заглохла, «наигрались».

А без оптики снижающей фокусное расстояние все эти мегапиксели на экране бесполезны, как близко к глазам маленький экран не подноси — без помощи оптики глаз просто не способен сфокусироваться на достаточно близком расстоянии, чтобы их рассмотреть.

ClearAirTurbulence

640кб хватит всем?

Кроме того, для игры весьма неплохо идут мультимон-конфиги (особенно для авиасимов) и широкие мониторы с AR 21:9. Пока у последних разрешение не очень. Но рано или поздно оно тоже подтянется, и вот вам, >4k для сопоставимого качества картинки.

Temtaime

Плюс, активно продвигают 144 гц, например. Это уже требование более двух раз в производительности.

DrunkBear

А зачем?

В видеокартах и так уже под 16ГГц частоты памяти, а разгон памяти на i9900k с 3 до 3.6 ГГц даёт прирост в пределах 10%.

x67

Интересно, это реальные 16 ггц или маркетинговые 4х4Ггц, например

Mad__Max

Настолько же реальные как те 6.4 «ГГц» (6.4 GT/s) что будут тут в DDR5-6400 еще только года через 3 когда она появится на практике (по началу как обычно первое поколение на практике будет даже медленней чем хорошая DDR-4 имеющаяся уже сейчас), при работе самой памяти на реальной частоте чипов памяти всего в 0.4 Ггц.

В видеокартах примерно аналогично, только и частоты уже сейчас намного выше и ширина шины «ширше».

iproger

Любой прирост необходим. Сейчас остро не хватает однопоточной производмтельности.

Пример из игр: недавно анонсировали 360гц монитор. В теории он будет полезен уже сейчас, на практике процессоры не вытягивают столько кадров.

Mad__Max

А процессор ли не вытягивает?

Попробуйте ради интереса снизить разрешение и чисто графические эффекты загружающие только видеокарту (типа разных сглаживания и анизотропной фильтрации) и посмотреть сколько кадров интересующая игра выдаст.

DrunkBear

Анонсировали, ога.

1920*1080, 24", зато 360 герц!

Не, их реально видят люди без 1000fps камеры, которая на замедленном повторе покаже, чем монитор А отличается от монитора Б?

А если двойной слепой тест? /irony

Osnovjansky

С десяток лет назад играл в совсем старый 3д шутер (Renegade) — мой комп воспроизводил все 60 кадров в сек. с включенным VSYNC. При резком развороте в «глазах» оставался отпечаток от 5-6 кадров, которые накладывались друг на дружку и вместо наблюдения поворота получалась легкая дезориентация (в фильмах для исключения такого эффекта делают «моушен блюр»).

Подобный эффект наблюдаю в ванной комнате, где поставил дешевые, мерцающие 100 Гц, светодиодные лампочки.

Так что, сказать что 360Гц монитор нужен всем — нельзя, но про игрокам в шутеры он может оказаться полезен.

DrunkBear

мм… вы уверены, что играли на мониторе с хорошей быстрой матрицей?

Такой эффект можно получить на матрице с достаточно большим временем переключения.

Osnovjansky

На компе — действительно был монитор с медленной матрицей, но в ванной комнате скорость перерисовки картинки — просто отличная ))

Я хотел сказать, что 360 Гц монитор, возможно, не является необходимостью, но может давать чуть-чуть дополнительного комфорта просто потому что техника стала это позволять (подозреваю, что ценой некоторого ухудшения цветопередачи).

Mad__Max

По сравнению с 60 Гц монитором — да конечно, вполне заметно при большой динамике. Для этого сейчас специально для геймеров и выпускают модели 120 и 144 Гц.

А вот даст ли что-то 360 Гц относительно 144 Гц — сильно сомневаюсь.

А в ванной это «эффект стробоскопа», на нем и 300-500 Гц в принципе заметить можно если достаточно быстро головой успевать крутить (или наоборот очень быстро и резко размахивать источником света перед глазами). Но он проявляется не при быстрой смене картинки, а при резких импульсах яркости.

DistortNeo

Так это типичный сценарий для шутеров.

mig126

Мозг сложная штука. Он не работает тактами и в тоже время у глаз очень ограниченная пропускная способность(порядка 1Мп разрешение, частоту сложно подсчитать, т.к. нет среднего значения как и среднего человека).

Но достоверно установлено что в VR шлеме минимально комфортная частота выше чем при игре с монитора(90 против 60).

Вероятно это из за того что в шлеме экран занимает большую часть обзора, тогда как при игре с монитора часть изображения фон который за счет алгоритмов требует меньшее количество ресурсов.

DistortNeo

Можно вообще считать, что глаз воспринимает действительность непрерывно, а не дискретно, и передаёт данные в мозг асинхронно — при накоплении определённого количества фотонов в светочувствительной клетке. Поэтому человек будет видеть вспышку, даже если ещё выдержка будет очень короткой.

Mad__Max

Так в полноценном VR шлеме же нужно считать 2 раздельные (отличающиеся) картинки для каждого глаза. Поэтому 90 fps в VR примерно соответствуют ~45 fps на обычном мониторе, на который смотрим обоими глазами одновременно, а не каждый глаз на свой отдельный экранчик.

Хотя зависит от схемы реализации, но для VR нужно либо удвоение горизонтального разрешения (при этом каждый кадр это на самом деле 2 слепленных вместе кадра), либо удвоение частоты кадров, чтобы получить примерно ту же плавность движений.

mig126

Нет, насколько я знаю на каждый глаз идёт 90фпс.

45 и на обычном мониторе плохо смотрятся, в VR шлеме такой фпс быстро вызывает головокружение.

Mad__Max

Чтобы каждый кадр резко отличался по яркости от предыдущего и последующего? Что-то на реальные игры не похоже, если конечно в кадре не какая нибудь штука так же имитирующая (уже виртуально) быстро моргающий источник света.

DistortNeo

Не кадр целиком, а его фрагменты при движении объектов в кадре.

Mad__Max

Так это соответствует движению источника света, а не его морганию.

Если яркий источник света движется в поле зрения, но при этом не моргает, а имеет примерно постоянную яркость, то эффекта «стробоскопа» вообще не возникает.

Эффект возникает только если он одновременно и быстро движется (или движется глаз относительно него) и одновременно моргает.

Хотя какое-то подобие этого эффекта может быть если яркий источник света в игре движется по экрану с очень большой скоростью. На настолько большой, что его перемещение за время отрисовки 1 кадра существенно превышает его размеры — скажем за 1/10 сек проскакивает весь экран от края до края, а размер объекта при этом небольшой. Тогда глаз может успеть зафиксировать прерывистую траекторию движения состоящую из отдельных, не пресекающихся изображений яркого объекта, вместо непрывного «светового шлейфа» который наблюдался бы если смотреть на аналогичный быстрй яркий объект в реальности не дробящейся на отдельные кадры.

DistortNeo

Именно. И подобное движение — это быстрый поворот камеры.

Gugic

Тут вот товарищи попытались разобраться дает ли преимущество высокая частота обновления монитора и какое и довольно сильно заморочились:

Mad__Max

Вы в VR на встройке что-ли гонять собрались скорость работы которай сильно от системной памяти зависит? Очень сомнительная затея.

А с полноценной видеокартой нужны выч. мощь и ПСП видеокарты, а не системной памяти.

alexdevyatov

Если под домашним ПК вы подразумеваете печатную машинку, до для нее и DDR 2 хватает. А все новые игры будут оптимизированы под DDR 5.

hexploy

DrunkBear

Вово, скорее, посмотрят статистику стима / продаж и скажут «оптимизируем на 12 потоков, большинство покупает от 12 до… потоковые процессоры и от 16 Гб памяти»

PS видимо, так и оптимизировался хром, который прямо сейчас нагло жрёт 24 гб оперативки всего с 50 вкладками. /sarcasm

Am0ralist

Поговаривают про DDR5 и PCI-E 5.0 в Ryzen на zen 4 (и смена сокета под это дело). С учетом, что zen4 это еще и тредриперы, и новые эпики, то вряд ли они будут два контроллера памяти пилить.

mig126

Обычно в переходные периоды пилят материнки/ЦП с поддержкой и старой и новой технологии, а то и обе одновременно. Почему вы думаете что AMD будет упускать часть рынка? Они и так регулярно отстают.

Am0ralist

А что они упустят? ам4 — так же был новым сокетом лишь под ddr4, представлен в 16 году и под zen2 дожить обещает. С выходом am5 ещё какое-то время продаваться явно будет.

Ам5 будет под новые системы на ddr5, всё логично, вполне вероятно, что изначально там только топовый сегмент будет. На данный момент они уже не отстают и наоборот, наращивают себя именно в высшем сегменте. А вот обратную совместимость ещё и по памяти тянуть после am2/2+/3/3+ подозреваю у них желания не будет

Mad__Max

И Тредриперы и Эпики же на своих собственных отдельных сокетах и своих чипсетах живут.

А контроллеры памяти начиная с Zen2 уехали в отдельный чип и от архитектуры самих ядер теперь не зависят.

Так сейчас получаются «настольные» Райзен с 2х канальной памятью, 4х канальные тредрипепы и 8 канальные Эпики.

При том что чипы с ядрами и кэшем у них одинаковые — меняется только I/O чип ну и количество кристаллов с ядрами.

В принципе можно даже будет тот же Zen2 выпустить с DDR5. Или наоборот Zen4 на DDR4 если зачем-то такая нужда будет.

Am0ralist

Но только такой момент, чтоб в одном сокете держать два типа памяти — контроллер должен оба поддерживать! Либо делать зачем-то две линейки процессоров под разные сокета.

Поддержка ам4 обещана только в процессорах с началом выпуска до 2021 года включительно была, то есть ещё в рамках zen3 и всё. Так что делать zen4 универсальным под два типа памяти AMD вряд ли будет. Более того, мне почему-то поставили минус в указание, что AM4 изначально так же вышел на DDR4-only и никого это не смущает. Итого, шансов, что после выхода zen4 и сокета am5 останется поддержка ddr4 — минимальная. Нет, понятно, что zen3 будет ещё года 2-3 в продаже, но скорее уже в среднем и нижнем сегменте, тогда как am5 будет больше на топовые показатели изначально заточена.

Mad__Max

Да, надо. Но ведь такое уже было во времена феномов/атлонов (с одновременной поддержкой DDR2 и DDR3 ) — их можно было как в платы с AM2+ (c DDR2) ставить, так и в AM3/AM3+(c DDR3), даже когда для этого приходилось именно универсальный контроллер делать работающий одновременно и с такой и с такой памятью. Т.к. тогда он был полностью интегрирован в кристалл. И у Intel вроде тоже какое-то из поколений могло с 2мя разными типами памяти работать.

А сейчас это еще намного проще сделать — достаточно просто разные I/O чипы использовать в каждым из которых контроллер только с одним конкретным типом памяти работает, а не городить универсальный контроллер усложняя его.

Зачем такое может понадобиться? Ну например новые I/O чипы под DDR5 и PCI-E 5.0 будет для AMD уже делать TSMC на 7нм производственном процессе.

А I/O чипы для работы с DDR4 и PCI-E 4.0 будет продолжать выпускать GlobalFoundries на 12нм.

Тем более у AMD c ними долгосрочные контракты с обязательствами заказывать и выкупать не меньше какого-то объема пп пластин в месяц/год, а более тонкие (ниже 12нм) они освоить все-никак не могут. И вроде уже даже официально отказались от таких планов остановившись на 12нм.

Чем их загружать? На одних чипсетах для материнских плат много не загрузишь. Сейчас эти мощности еще дополнительно хорошо загружены производством процессоров на предыдущем Zen+ и вроде бы GPU семейства Polaris тоже у них делаются.

Но все это скоро будет сниматься с производства из-за морального устаревания, а производственные мощности (в т.ч. зарезервированные под AMD) останутся.

Или например поначалу возникнет дефицит и завышенные цены на DDR5 из-за каких-то просчетов у производителей памяти (или опять пожар/наводнение/землятресение). И тогда имеет смысл младшие линейки под DDR4 выпустить в качестве временного решения.

Далеко не факт конечно, что так будет делаться на практике. Просто возможный вариант действий, который теперь в текущей многочиповой компоновке процессоров намного проще реализовать.

Am0ralist

Но процессор должен в любом случае оба их содержать, при этом усложняя комутацию. Зачем?

Вы объясняете как, но не объясняете «зачем?»

И этим себе костыль на следующие лет 6 поставить? Или потом выпускать несовместимые с старыми сокетами процессоры? Так тогда им придётся с каждым поколением сокеты тасовать, оно им надо?

У них будет zen3 на ddr3 ещё какое-то время. Делать am5 с двумя типами памяти — это вновь по старым граблям. am4 показал, что им это не очень нравится.

V1tol

Я бы так не сказал. Да, в момент выхода памяти DDR4 хватало на всё что угодно и, казалось, ещё на 10 лет хватит. А потом пошёл бум количества ядер и сегодня в «домашнем» сегменте у нас есть процессоры с 8 и даже 16 ядрами, которые толкаются попами в 2 каналах памяти.

Конечно всегда можно купить память с частотой типа 4200, но она стоит уже далеко не бюджетных денег. Я считаю, что при росте ядер нужно было увеличивать и количество каналов памяти в пользовательском сегменте — тогда можно было бы поставить 4 относительно низкочастотных планки по 8 гигабайт и получить хорошую скорость и нормальный объём.

mig126

Назовёте игры которые забивают на 100% оба канала ОЗУ?

Обычно они тупо забивают весь доступный объём и начинают спотыкаться.

По поводу задач где понадобятся такие скорости, это уже не домашний сегмент, а работа/бизнес.

DistortNeo

Бенчмарки показывают некоторую зависимость производительности игр и от частоты памяти и таймингов (правда больше — от таймингов). А для современных игр даже 15% FPS за счёт значительно более быстрой памяти могут оказаться уже значительными.

mig126

Тут неоднократно приводили результаты тестирования копеечной ОЗУ и дорогих высокочастотных модулей.

В играх разница составляла 1-2 кадра в секунду на 60-70.

DrunkBear

Нашёл тест i9900 c разной памятью.

TL;DR: кодирование и распаковка — память сильно влияет, рабочие приложения — разброс в пределах погрешности, игры в невысоком разрешении (до fullhd) — изрядно влияет, в разрешении выше 2k — можно пренебречь.

C AMD — немного другая ситуация: с памятью разгоняется и infinity fabric, поэтому 10-15% среднего и до 20% минимального ФПС можно выиграть с памятью в 3600-3733Mhz (по сравнению с 3000) практически во всех приложениях.

Mad__Max

infinity fabric вместе с памятью разгоняется только на Zen/Zen+.

Начиная с Zen2 (настольный Ryzen 3xxx и мобильные 4ххх) частота IF выставляется отдельно и от частоты памяти уже не зависит. Заодно и ее ширину в 2 раза увеличили, так что в случае с высокочастотной памятью разница в скорости шины примерно 2 раза, а с низкочастотной и все 3 набирается.

DistortNeo

Не совсем так. До частоты памяти 1866 МГц (DDR4-3733) частота IF совпадает с частотой памяти, процесс работы с памятью синхронный. При дальнейшем повышении частоты памяти частота IF отвязывается от памяти и становится равной 1800 МГц. Работа с памятью становится асинхронной, что приводит к ощутимому росту задержек.

Mad__Max

Вы путаете частоту IF с частой работы контроллера памяти.

Это 3 разных частоты. IF, контроллеров памяти и собственно самой памяти (точнее шины связывающей контроллеры с модулем памяти, т.к. сами чипы на намного меньшей частоте работают).

Всего есть 3 частоты:

FCLK = Fabric Clock (частота работы IF)

UCLK = Unified Memory Controller clock (частота работы контроллера памяти)

MEMCLK = memory clock (частота шины памяти от контроллера до модулей DIMM)

Или на картинке наглядно (вообще там еще и 4я частота есть — lclk но она сейчас нас не интересует):

DistortNeo

Именно об этом и речь. В асинхронном режиме задержки становятся выше. И, кстати, именно это вы ссылкой и подтверждаете, где 4000 оказывается медленнее, чем 3600. Слюни и сопли, конечно, но сам факт имеет место быть.

Mad__Max

Выше речь была о привязке в том смысле, что низкочастотная память снижает не только собственно скорость работы с памятью, но и замедляет работу IF и следовательно обмен данными между ядрами и работу с кэшем.

В Zen/Zen+ это было действительно так — IF работала всегда на частоте памяти, поэтому прибавка реальной скорости работы от частоты памяти была очень существенной, т.к. одновременно ускорялись и сама память и L3 кэш и пересылка данных между ядрами и например работа с GPU по PCI-E (до которого данные сначала тоже нужно передать по IF).

У Zen2 это уже не так, от частоты памяти ускоряется только память и соответственно только ПО сильно зависящее от работы с памятью. Которого кстати стало заметно меньше, т.к. размеры кэшей выросли в 2 раза и доля обращений к памяти («промахов» кэша) в Zen2 стала меньше.

А выше 3600 МГц память для Zen2 действительно особого смысла не имеет(лучше снизить тайминги если память позволяет). Не только собственно из-за появление 2го асинхронного режима (деления частоты работы контроллеров памяти в 2 раза) ведущего к росту задержек. Но и из-за того, что даже ПСП почти не растет дальше с ростом частоты.

Обычно тут обращают внимание на задержки (становящиеся хуже после 3600 / 3733), но если протестировать ПСП то видно что и она не растет практически:

V1tol

Пока я такие не встречал, да и игр, которые могут забить все 8 ядер процессора до 100% тоже. А скоро выйдут консоли нового поколения (по слухам, у 5 плойки будет 20 гигов GDDR6 со скоростью 880GB/S) и посыпятся кривые порты — вот тогда уж наверняка придётся выкидывать свой 9700К.

iproger

Такая игра есть, хоть забивает и не полностью — wd2.

mig126

Кривое убожество кое как переведённое на рельсы виндовс.

Таких игр много которые или писали или переносили пьяные обезьяны.

Есть и такие что при довольно ущербной графике полностью загружают топовую видеокарту.

DistortNeo

Игры, которые забивают 4 ядра процессора на 100%, уже существуют.

mig126

А как вы это определили? Системный монитор в окнах нагрузку на ЦП считает довольно криво.

DistortNeo

Почему? Обоснуйте.

Ну и это подтверждается бенчмарками, где производительность игры на 6 и 8-ядерниках выше, чем на 4-ядерниках.

mig126

Мне встречались игры где ЦП якобы на 100% заняты все 4 ядра/потока(судя по диспетчеру). Вот только игры были однопоточными(я в курсе что современные ЦП умеют перераспределять нагрузку). И другие методы измерения давали правильный результат. Плюс разница в температуре ядер.

DistortNeo

Это оптимизация работы с видеокартой на уровне библиотек и драйверов. То, что раньше делалось в главном потоке, теперь буферизуется и выполянется в фоне. Ну а разница в температуре объясняется busy wait — задержки при общении с GPU насколько малы, что нет смысла переключать потоки.

DistortNeo

Intel в X-серии использует четырёхканальную память. И даже более того, процессоры 10-го поколения обещают быть даже доступными по ценам.

Сложно сказать. Во многих задачах больше решает скорость доступа (тайминги), чем пропускная способность.

V1tol

Только материнские платы на них тоже не бюджетные, домашний компьютер золотой получится.

На низкочастотных планках тайминги как раз относительно невелики из коробки. На планку за 2000р с частотой 2400 вижу CL16-CL17. Примерно те же СL16 на моих недорогих Crucialах с частотой 3000 (за эту цену тот же кингстон предлагает 2933 CL19). А количество каналов компенсирует низкую частоту планок.

Понятно, что можно взять какой-нибудь кит на 4000, но комплект из 2 таких планок по 16 гигабайт встаёт в 30 тысяч — это даже дороже 9700К получается.

DistortNeo

Потому что тайминги относительные — они указываются в тактах, а не в наносекундах. По факту их надо переводить в наносекунды, чтобы оценить реальную задержку. Далее стоить учесть, что процессор читает/пишет данные не побайтно, а целыми кэш-линиями, поэтому выполяет команды в burst mode, то есть полная задержка включает в себя ещё и такты на передачу данных.

Ну и ещё тут есть AMD с привязкой частоты памяти к частоте внутренней шины, что заставляет использовать высокочастотную память.

amarao

Новый DDR5, с улучшенной поддержкой rowhammer.

dimsog

Эм, ну вот сейчас я обновил платформу и перешел с DDR3 на DDR4 и пшик. Разницы не особо увидел.

Sayaka

А была уверенность что именно память узкое место? Условно, ставить ддр4 на машину без ссд и ожидать прироста производительности эээ, странно.

dimsog

Да. SSD стоит конечно же.

Osnovjansky

Вспоминая статьи 10-ти — 15-ти летней давности, чтобы при апгрейде компа заметить улучшение «глазами» (без запуска бенчмарков) нужно чтобы производительность улучшилась на порядка 30 %

VADemon

On-Die ECC — это отличные новости! С нынешними объемами памяти пора бы.

AMD Zen4 нацеливаются либо на середину или вторую половину 2021 года, я думал раньше будут принимать DDR5. Intel Sapphire Rapids технологически тоже будут оснащены DDR5 и PCIe5, интересно будут ли у них в 2020г. платформы на PCIe4?

DrunkBear

А что, у Intel уже есть хоть где-то PICE4?

Они ещё летом рассказывали, что 4 версия не нужна и PICE3 хватит всем?

Или это ещё один из приступов Not Invented Here от маркетологов Интел?

PS Всем хватит скоростей 3 версии стандарта, поэтому мы не выпускаем 4, но анонсируем сразу 5, правда, не сейчас, а потом, на 7нм процессорах.

Ну да, к тому времени или ишак помрёт, или патишах /irony

VADemon

В этом вся и хохма. Хотя сейчас посмотрел, в 2020 наконец будет новая микроархитектура введена: Sunny Cove, с PCIe4.

Недавно их, правда, ударило иронией реальности: ищут среди разработчиков тестировщиков новых PCIe4.0 SSD… да только своей платформы нет: https://www.techspot.com/news/83402-intel-prototyping-pcie-40-ssds-but-needs-amd.html

Am0ralist

Zen2 был к концу 2 началу 3 квартала, Zen3 — по роадмапам это граница 3/4 квартала. Я подозреваю, что Zen4 будет к 2022 ближе, раньше — не сильно логично сокращать время между поколениями (особенно, если как на Zen2 будут ещё в течении полугода анонсировать новинки, но при этом до настольных APU ещё даже не добрались...)

VADemon

Сэмплинг Zen2 (серверных) начался ещё зимой прошлого года, а десктопы только зарелизили в середине лета. Я-то прикинул по roadmap +5-6 кварталов после Zen3 — да, поздний 2021 вероятнее. Хм, а раз так, то десктопы может быть сдвинут до презентации CES2022? Хотя тогда рождественские закупки отпадают...

Am0ralist

Побуду вангой пальцем в небо)

Ради рождества им топовые камушки надо где-то в ноябре выкатить, тогда куш на рождество они сорвут неплохой. То есть условные r7-9 только представить, благо сейчас у них достаточно плотная обойма по производительности за счёт снижения цены на старые поколения. Всё равно у них в материнками тоже проблемы по сути вечные, так что анонс на новом сокете может быть урезанный.

Mad__Max

Серверные где-то в середине 21 года года ожидаются, а настольные да, вполне и до конца 21 или начала 22 года могут задержаться.

yarston

Шину адреса уменьшили до 13 бит O_o, там адрес ячейки по 3 частям теперь передаваться будет?

mOlind

Паковать будут как-то. Чтобы при последовательном чтении только младшие биты пересылать.

Osnovjansky

А какой сейчас минимальный размер фрагмента, который грузится из памяти в кэш? Давно не читал, как сейчас работает кэш в процессорах.

OleksiyT

Не знаю как для дома, но для серверов быстрая память даёт много.

Там производительность никогда лишней не бывает, но надо смотреть на цену.

mjr27

На 85% быстрее — это почти в 6 раз или почти в 2 раза?

Mad__Max

На 85% быстрее это почти в 2 раза, т.к. в качестве базы меньшее значение.

Теоретическая пропускная способность увеличивается ровно в 2 раза, но как обычно попутно вырастут задержки и реальная скорость увеличится несколько меньше чем в 2 раза.