Мой самый первый пост, который я три года назад написал на Хабр, был посвящен 10G Ethernet и 10G сетевым картам Intel, что, в принципе, не случайно, ведь сетевые технологии – это моя профессия. Далее посты на данную тему почти не появлялись в блоге Intel – как говорится, не было повода. И вот теперь он появился, и вполне весомый. Ведь выход нового поколения сетевых карт Intel на контроллере X/XL710 принес с собой не только улучшение характеристик и новые возможности, но и появление принципиально нового для компании продукта – 40G Ethernet сетевых карт для серверов. Самое время поговорить о текущей ситуации в области 40-гигабитности.

«в 4 раза лучше 10G»

Стандарт IEEE 802.3ba, описывающий 40/100G Ethernet, был опубликован более 5 лет назад. Перспективы тогда рисовались самые радужные: прогнозировалось, что к 2015 году (то есть уже сейчас) порты 40/100G будут составлять не менее четверти всех портов Ethernet. На правах живущих в означенное время мы можем утверждать определенно: этого не произошло. Почему? Собственно, за три прошедших года принципиально ничего не изменилось; позволю себя процитировать: «… главная причина, на мой взгляд, заключается в том, что такие скорости в большинстве случаев просто не нужны; за исключением сверх больших ЦОД или гигантских облачных площадок одна или несколько линий 10G прекрасно справляются с передачей возложенного на них трафика».

Однажды в оное оптимистическое время довелось мне присутствовать на презентации известного вендора. На вопрос: «почему вы продвигаете 40G?» докладчик ответил лаконично: «потому что он в 4 раза лучше 10G». Однако рынок в очередной раз продемонстрировал свою прагматичность. Навряд ли оператор поведет своих партнеров в автозал, чтобы гордо показать: а вот у нас модуль 40G в маршрутизаторе! Конечному пользователю нужно получить необходимые показатели производительности за оптимальную стоимость. Пусть даже с использованием устаревших технологий.

По моим наблюдениям, ситуация стала потихоньку меняться где-то около двух лет назад, при этом, что характерно, порты до сих пор 40G имеют тенденцию «разваливаться» на 4х10G (благо по своей природе они это делают легко), что еще раз подтверждает вышеозначенный тезис. В целом процесс идет очень медленно, операторы связи, даже самые крупные, по-прежнему предпочитают обходиться агрегацией n x 10G каналов, а в ЦОД Ethernet приходится конкурировать с Infiniband QDR/HDR, экономнее тратящим пропускную способность канала и обеспечивающим меньшие задержки. Кому интересны цифры, вот здесь приводится отчет от тестировании Ethernet vs Infiniband с помощью бенчмарка Intel MPI Benchmark.

| 40G Ethernet | InfiniBand QDR | InfiniBand FDR | |

|---|---|---|---|

| Задержки, мсек | 7.8 | 1.5 | 0.86-1.4 |

| Скорость, МБ/с | 1126 | 3400 | 5300-6000 |

40G изнутри

Стандарт IEEE 802.3ba предложил несколько вариантов сред передачи данных на скорости 40 Гбит/с.

| Спецификация | Среда | Макс. расстояние |

|---|---|---|

| 40GBase-KR4 | Бекплейн | 1 м |

| 40GBase-CR4 | Медный твинаксиальный кабель | 7 м |

| 40GBase-SR4 | Оптика многомод, 850 нм | 150 м (ОМ4) |

| 40GBase-LR4 | Оптика одномод, 1310 нм | 10 км |

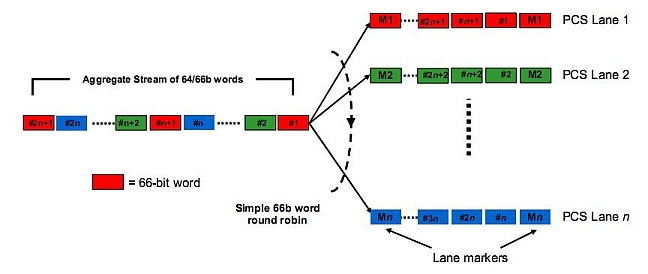

Все спецификации 40G с цифрой 4 на конце объединяет один общий момент: для передачи данных используется не одна, а одновременно 4 линии. Распределением данных по линиям занимается модуль, названный в стандарте MLD (Multilane Distribution, распределение по множественным линиям). На вход модуля поступает поток данных, закодированных по алгоритму 64b/66b, MLD по очереди (round-robin) раздает 66-битные блоки в каждую из параллельных линий, которые могут быть как физически различными волокнами (40GBase-SR4), так и различными ?-частотами в рамках структуры WDM (Wave Division Multiplexing), как в спецификации 40GBase-LR4.

Дабы избежать ошибок при обратной сборке трафика на этапе мультиплексирования в поток 66-битных слов вставляются служебные маркеры.

Технологии частотного мультиплексирования, давно прописавшиеся в Ethernet, оказались тут как нельзя кстати, однако возникала некоторая натяжка: устройства WDM и без того давно используются в магистральных линиях MAN/WAN, зачем нам еще один CWDM под другим именем? А вот у многоволоконного варианта перспективы, определенно, есть.

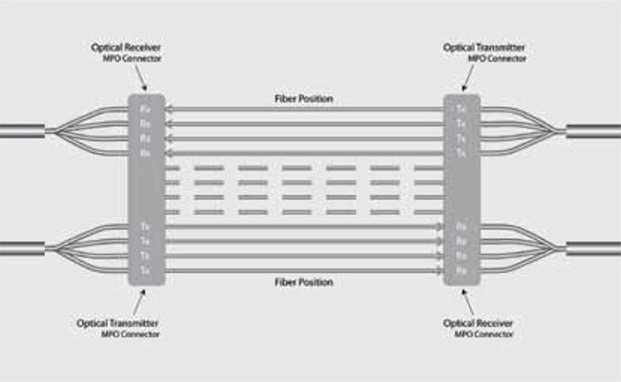

Перспективность спецификации 40GBase-SR4 (а речь именно о ней) – в ее экономичности. В настоящее время это самое доступное решение 40G для LAN-расстояний и фактически единственное активное используемое среди всей линейки 40G спецификаций. В качестве конструктива присоединения для 40GBase-SR4 используется 12-контактный разъем MPO (Multi-fiber push-on).

Оптические выходы в 12-контактном MPO расположены в один ряд между направляющими, для 40GBase-SR4 применяется 4 пары линий. В 100G Ethernet МРО-разъем 24-контактный, выходы идут в два ряда.

«Ответной частью» оптического порта 40GBase-SR4 в оборудовании служит разъем QSFP+ (аналогично SFP для 1G и SFP+ для 10G), таким образом, трансивер 40GBase-SR4 имеет с одной стороны МРО, с другой – QSFP+.

Что дает нам Intel 710?

Перейдем теперь к сетевым продуктам Intel. Сначала немного истории. Сетевые карты – устройства, не имеющие маркетинговой нагрузки, поэтому смены их поколений обусловлены исключительно техническими причинами и происходят нечасто – об этом мы уже говорили во введении.

Прорывом в высокоскоростной Ethernet стал для Intel сетевой чип Intel 82598EB, созданный 10 лет назад и ставший де-факто эталоном 10G Ethernet на многие годы. Через несколько лет в линейку добавился чип Intel 82599EN, принесший ряд улучшений: уменьшился техпроцесс, увеличилась скорость передачи данных по шине… Кстати, мало кто знает, но у сетевых чипов Intel также есть кодовые имена, как у процессоров: скажем, у первого – Bellefontaine, у второго – Spring Fountain. При выходе очередного обновления линейки сетевых контроллеров в Intel решили, что негоже ломать мозг об длинные индексы и назвали его короче и понятнее – Х540; то же наименование получили и карты на его основе. Вот с таким багажом мы подошли к выходу нового поколения чипов Х/XL710. Если кому интересно, то кодовое имя нового чипа – Fortville. В настоящее время доступны 4 варианта карт, навряд ли их станет больше.

| Карта | Скорость | Порты | Варианты модулей |

|---|---|---|---|

| Intel X710-DA2 | 10G | 2 x SFP+ | 10GBase-LR, 10GBase-SR, DA |

| Intel X710-DA4 | 10G | 4 x SFP+ | 10GBase-LR, 10GBase-SR, DA |

| Intel XL710-QDA1 | 40G | 1 x QSFP+ | 40GBase-SR4, 40GBase-LR4, DA |

| Intel XL710-QDA2 | 40G | 2 x QSFP+ | 40GBase-SR4, 40GBase-LR4, DA |

Партномера оптических модулей и медных кабелей Intel можно найти по ссылкам на страницах карт.

Почему появление новых сетевых карт встречено такими громкими словами? Дело в том, что новизна Х/XL710 поистине всеобъемлюща, как технологически, так и идеологически. Начнем с идеологии. Раньше Intel предпочитала выпускать 10G карты с фиксированными портами, опасаясь (и подчас справедливо), что некачественный трансивер, установленный в карту и, как следствие, некорректная работа всей системы – это подрыв и ее репутации. Однако такой подход доставлял определенное неудобство, был негибким по отношению к конечному пользователю. И вот Intel решилась: все семейство Х710 идет исключительно с разъемами SFP+ (QSFP у 40G карт на чипе XL710).

Теперь о технологии. Серия 710 стала первой, получившей поддержку PCIe 3.0 со скоростью на линию 8 ГT/с. Таким образом, восемь линий обеспечивают достаточный запас для размещения на карте 4 портов 10G или одного порта 40G (два порта 40G с переподпиской) – естественно, такая конфигурация появилась тоже впервые. Ну и, в добавок, очередное уменьшение техпроцесса – теперь это 28 нм.

Итак, теперь оконечное устройство (сервер) получило в свое распоряжение 40G интерфейс в виде одного порта или четырех на одной карте. В свете главы второй этого поста возникает вопрос: а так ли оно ему надо? На мой взгляд, настал такой момент, когда появление такого адаптера оправдано. Вот мои аргументы.

- Сервера с несколькими 10G интерфейсами – уже давно не редкость, причин тому может быть несколько: топология сети, особенности маршрутизации, требования приложений и т.д. 4-портовая карта сэкономит вам место в сервере, что в условиях хронической нехватки места только приветствуется. Кроме того, 4 порта на одной карте обойдутся вам существенно дешевле отдельных.

- Увеличение плотности портов на серверах позволит пытливым оч. умелым ручкам реализовать интересные аппаратно-программные решения для жонглирования трафиком. Список вариантов очень широк: мониторинг, фильтрация на любом уровне, агрегация, балансировка и так далее, как говорится, DPDK вам в руки.

- Мощные платформы виртуализации – тоже вполне реальная тема, и им также хочется быть потоньше. Для некоторых серверов приложений 40G тоже будет, думается не лишним.

Исходя из динамики процесса, мой следующий пост будет о 100G карте Intel. Что ж, это тоже непременно произойдет. А может, и до того что-то интересное случится.

Комментарии (25)

MaxxxZ

08.09.2015 12:24И ещё один вопрос — мультимодные линии обладают очень маленькой дальностью связи и требуют большого количества жил. Их использование не позволяет говорить ни о какой «сохранности инвестиций».

Но почему все крупные вендоры, например, Cisco, считают что именно из ММ надо делать внутриобъектовые линии?

gotch

08.09.2015 12:30400 метров это мало? Более чем достаточно для одного здания, не говоря уж о серверной.

Большое количество жил? Одна на RX, вторая на TX. Куда уж меньше?

MaxxxZ

08.09.2015 12:41Здесь же в статье указано 150 м максимум и по одной жиле на каждые 10G — 1 MPO разъём требует нескольких линий. Каждые лишние 10G — +1 линия в каждую сторону. В то время, как одно волокно SM 10 лет назад работало на 100 Мбит/с, так и сегодня оно же 100 Гбит/с может потянуть, если было правильно уложено и разделано.

Это в каком стандарте одна жила на 40G и 400 м?

gotch

08.09.2015 12:58+1Cisco QSFP-40G-CSR4 (http://www.cisco.com/c/en/us/products/collateral/switches/nexus-9000-series-switches/datasheet-c78-730160.html)

400м.

Да и 150 метров это очень серьезное расстояние. В СКС на меди ограничиваются 90 метрами, и вроде всем хватает, а здесь в 1.5 раза больше расстояние.

По жилам я промахнулся, перепутал по инерции с 10G, извините.

Хотя Cisco может помочь вам сэкономить жилы с трансивером Cisco QSFP-40G-SR-BD

www.cisco.com/c/en/us/products/collateral/switches/nexus-9000-series-switches/white-paper-c11-729493.html

The Cisco QSFP BiDi transceiver, shown in Figure 2, transmits full-duplex 40-Gbps traffic over one dual-fiber LC-connector OM3 or OM4 MMF cable. It provides the capability to reuse 10-Gbps fiber infrastructure. In other words, it enables data center operators to upgrade to 40-Gbps connectivity without making any changes to the previous 10-Gbps fiber cable plant.

MaxxxZ

08.09.2015 13:07+2Угу, Cisco-то поможет и 400 м. и жилы сэкономить.

Но у них очень грамотный маркетинг: указанные вами трансиверы стоят дороже. И применительно к мультимодной линии встанет вопрос: на проще ли эти 150-400 м полностью поменять, чем покупать такие трансиверы.

И, кстати, я имел ввиду восновном перспективы. Скажем 10 лет. Вполне возможно, что скорости придётся увеличивать. И вряд ли захочется менять СКС.

Так вот, зачем эти все навороты и усложнения, если можно тупо строить на SM? Дороговизна лазеров SM в фирменных прайсах мягко говоря преувеличена именно желанием продавать MM-комплектующие.

gotch

08.09.2015 12:06Подскажите пожалуйста, у вас на картинке DAC кабель. Можно ли им подключить сервер напрямую к коммутатору Cisco?

saul

09.09.2015 09:32У меня на картинке так называемый breakout кабель 40G — 4x10G. Если же говорить про DA, скажем 10G, то да, подключить можно, но небольшой процент несовместимости все-таки существует.

amarao

09.09.2015 04:02+1Что-то вы не то говорите на тему «раньше интел выпускала карточки только с фиксированными портами». Я ещё в 2010ом писал патч на ixgbe, чтобы она жрала те SFP, какие дали, а не по белому листу. Потом этот параметр в модули добавили.

Я вообще не помню ни одной ixgbe-based сетевухи интела без SFP.

saul

09.09.2015 09:36В каждой линейке 10G карт Intel были модели с дырками под SFP, но они позиционировались исключительно как DA медные карты. Типа, вот вам оптика, пользуйтесь, а вот DA для интерлинков. А кто в DA будет что непотребное совать — тот сам себе злобный буратино.

amarao

09.09.2015 19:12Вы мне какие-то сказки рассказываете.

первая попавшаяся сетевуха: Ethernet controller: Intel Corporation Ethernet Controller 10-Gigabit X540-AT2

С SFP.

saul

10.09.2015 09:36Вот этот вот?

ark.intel.com/RU/products/60020/Intel-Ethernet-Controller-X540-AT2

Он медный, 10GBASE-T. Но это, в принципе не важно, есть там и с разъемами под SFP, но только для Direct Attach кабелей.

Это называется маркетинг. Ну или позиция компании, кому как больше нравится.

amarao

10.09.2015 15:18Просто для меня эта позиция очень внезапная и я первый раз такое слышу. Ссылки вижу, да, но как-то эта позиция очень вяло озвучена.

С другой стороны, нареканий на них никаких (кроме тех, что без кулеров — те могут перегреваться).

MnogoByte

09.09.2015 16:33У нас есть две карты разных вендоров на Intel XL710, в том числе и Intel XL710-QDA2 с родным DA кабелем. И у обеих карт проблема: через какое-то время работы карта просто сбрасывает все коннекты на пару минут. И потом их возвращает. Пробовали 2 версии драйверов i40e — результат один и тот же. Проблема возникает не только у нас, но и у других крупных трафикогенераторов. Прокомментируйте, пожалуйста, как Intel собирается решать эту проблему?

saul

11.09.2015 13:44К сожалению, подразделение сетевых карт далеко от нас во всех смыслах. Так что вы быстрее получите фидбек если обратитесь как клиент (тем более крупный) в службу поддержки.

gotch

19.09.2015 19:15А с SFP+? Просто интересно, DAC это

— для экстремалов и «экономных» облачных провайдеров. Ну подумаешь моргнуло, при таких-то ценах клиент переживет.

— для стоящих двухузловой кластер с однотипным железом

— это мейнстрим, у каждого второго половина серверной DA завешана.

MaxxxZ

Есть вопрос про WDM: а сколько всего таких каналов в одном волокне? Речь идёт о CWDM, DWDM или HDWDM?

Если сказать проще — используя существующие технологии — сколько можно засунуть одно волокно с той же модуляцией и шириной полосы, что и в 40/100G?

leon_ti

40G LR4 использует стандартную сетку частот, и добавить к одному 40G LR4 другой канал 40G LR4 простым пассивным мультиплексором не получится.

А с помощью относительно недорогих транспондеров — там обычные потоки 10G прямой модуляции, до 96 каналов шириной 50ГГц в одном волокне — то есть 9.6Тбит/с :)

MaxxxZ

Наверное всё-таки 10Gx96=0,96 Тбит/с?

leon_ti

Тьфу ты, конечно :)