Привет, Хабр! Меня зовут Ярослав, я стажер инженерно-технического отдела в Selectel. И несколько лет назад у меня была мечта — сделать домашний дата-центр. Я ее исполнил и хочу предупредить: не повторяйте моих ошибок, сохраните психику.

В статье делюсь опытом проектирования и сборки домашнего дата-центра. А также рассказываю, как случайно не сжечь серверный шкаф и за что провайдеры могут подать в суд. Подробности под катом.

Дисклеймер: Я называю свой пет-проект дата-центром, потому что, помимо нескольких серверов, у меня целая инфраструктурная обвязка в виде сетевого оборудования, систем отказоустойчивой работы и даже СКУД. Естественно, он очень далек от того, что представляют собой настоящие дата-центры, но я все равно буду называть его в тексте именно так. Живите с этим! ????

Зачем мне дата-центр

Просто так идея о возведении дата-центра не возникает. Если вспомнить историю Selectel, то первый дата-центр появился для хостинга «Вконтакте». Почти то же самое случилось с моим пет-проектом. Только заказчиком был не «Вконтакте», а я не был крупным инвестором.

У меня было желание — изучить профессиональное сетевое оборудование, чтобы перейти на него со своего домашнего роутера. Изначально цель была построить проводной интернет в квартире. Но потом я задался вопросом: могу ли я самостоятельно сделать серверную с корпоративным качеством сервиса?

Цель превратилась в челлендж по развертыванию собственной серверной инфраструктуры с минимизацией влияния различных провайдеров.

Закупка сетевого оборудования

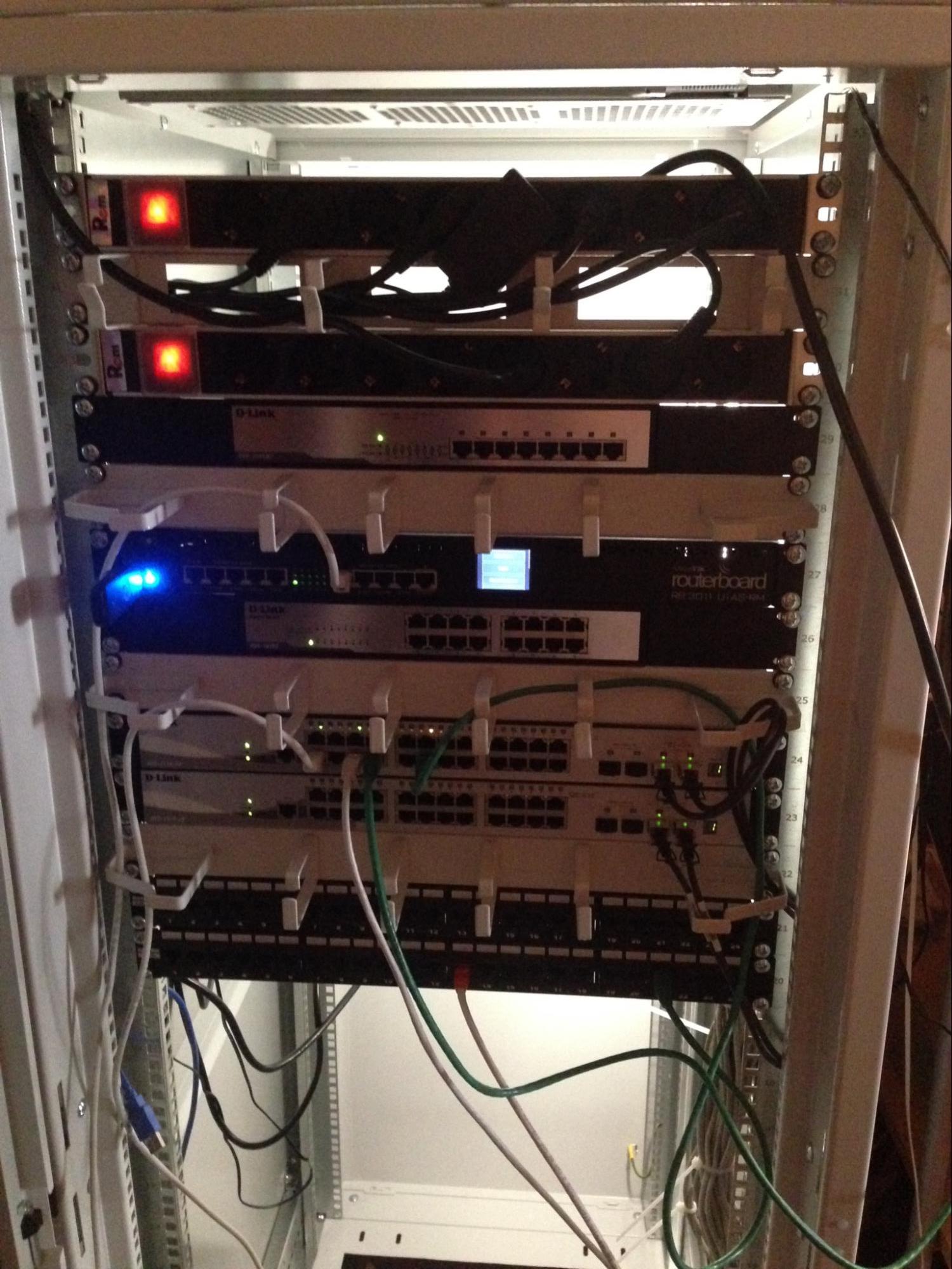

Коммутаторы

Бюджет в 70 000 рублей меня ограничивал: я не мог себе позволить коммутаторы от Cisco, Juniper, Huawei, H3C или Brocade. Наиболее оптимальным вариантом в 2017 году — именно тогда я начал «строительство» дата-центра — казалась связка из двух управляемых L3-стекируемых коммутаторов D-link DGS-1510-28. Стоимость одной шутки — 16 000.

Можно ли было найти модель дешевле? Да, но у DGS-1510-28 были аплинк-порты на 10G, которые, как я думал, понадобятся. Но оказалось, что трафик внутри сети не превышает даже 1 Гбит/с.

DGS-1510-28. Источник

Зачем нужно было два коммутатора?

Сначала я хотел проложить по квартире витую пару и установить rj45-розетки в каждой комнате. Задумка была в том, чтобы все стационарные устройства подключались по кабелю, а смартфоны — по беспроводной сети.

rj45. Источник

У идеи был недостаток: нужно более 24 портов на коммутаторе, чтобы подключить все устройства, розетки и резервы. Поэтому пришлось докупать второй коммутатор. В итоге я объединил два коммутатора в одно логическое устройство — получился Stack. Но позже я отказался от этой идеи.

Роутер

В качестве роутера я использовал Mikrotik RB3011. Тогда, в 2017 году, я его взял за 15 000.

Mikrotik RB3011. Источник

Серверное помещение

Отчасти идею удалось реализовать: стационарные устройства получили проводное подключение, а в некоторые комнаты были проведены дополнительные линии с розетками. Но большую часть розеток я так и не использовал. Неправильный расчет кабельной системы — мой первый факап.

Первая площадка

Унывать было некогда, и я продолжил работу над первой версией серверной.

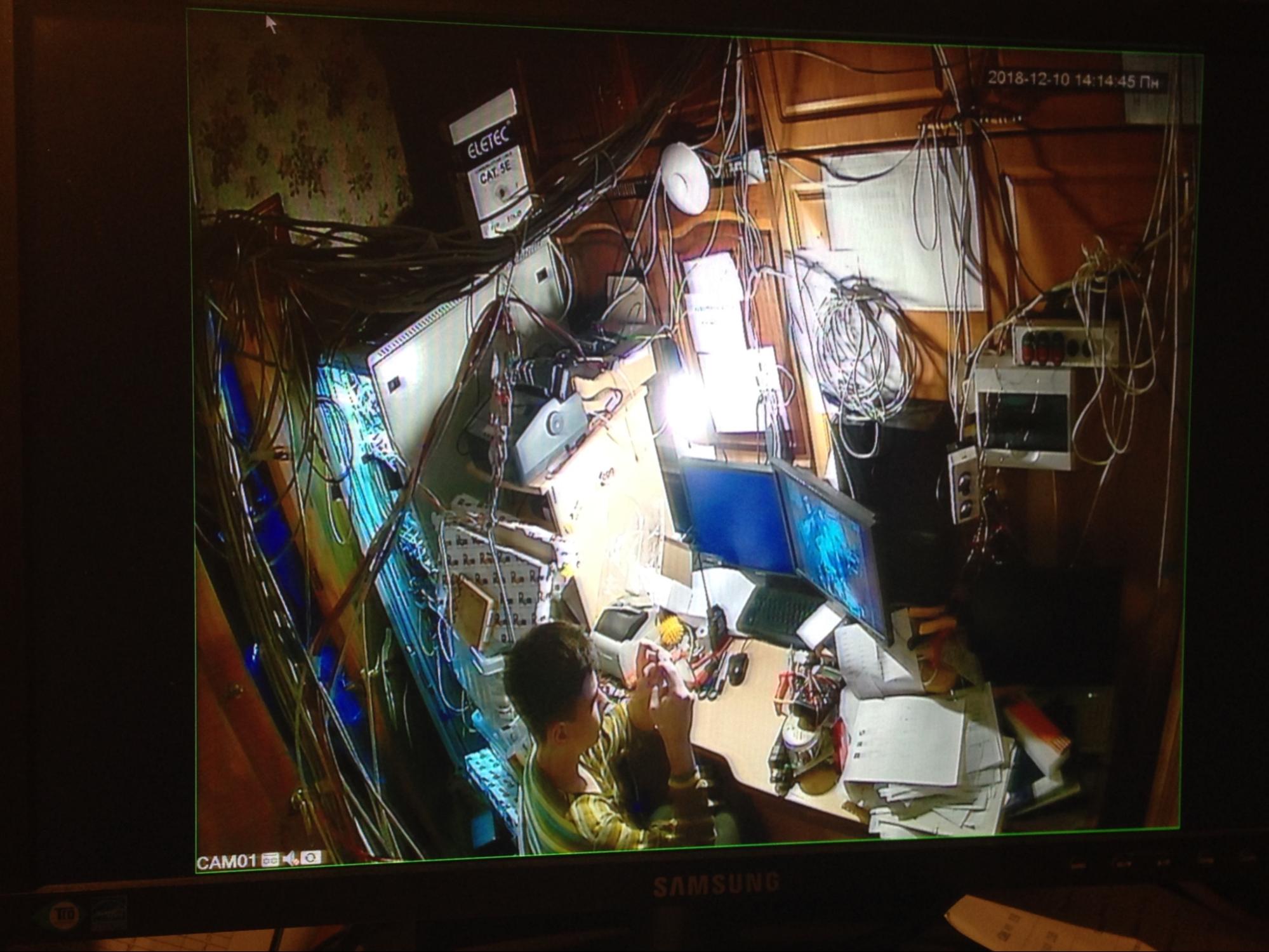

Рекурсия. Фотографирую сам себя через камеру видеонаблюдения. На фото — первое помещение

Тогда о стойках не было и речи, но получилась вполне гиковская сборка из оборудования. Она была до неприличия колхозной: кабель-менеджмент напрочь отсутствовал, коммутаторы были скреплены деревянным бруском. А в качестве сервера я использовал свой компьютер.

Первый сервер и шкаф

Когда пришло осознание, что пора бы перестать мучить компьютер, я купил сервер — HPE ProLiant DL360p Gen8. Для него докупил подержанный шкаф на 32 юнита.

Переезд на вторую площадку

Водяное охлаждение в серверных платформах вот уже несколько лет набирает популярность. Но это решение не для простых обывателей. Поэтому я использовал воздушное охлаждение в своих серверах.

Была проблема — сильный шум от вентиляторов. Не хотел, чтобы меня проклинали соседи по квартире, и понял, что серверу нужно переехать.

Я перенес сервера на нежилую площадку. Только так я мог повысить шансы бесперебойной работы оборудования, поскольку не было соседей, которые могли случайно отключить электричество.

Площадка внушительная — целых 4 квадратных метра. Пожалуйста, не спрашивайте, что это за помещение. Оно нежилое — и это главное.

Возможно, эти тексты тоже вас заинтересуют:

→ Залогиниться из России через Турцию — без VPN. Обновление геолокаций IP с помощью Geofeed

→ Объединяй коммутаторы и властвуй — сравниваем Stack и MLAG

→ Сетевое резервирование в дата-центрах: решаем задачку про двух велосипедистов

Шумоизоляция

Я все равно решил избавиться от «серверного воя» и обклеил уже новый серверный шкаф автомобильной шумоизоляцией.

Через несколько дней я понял, что мое решение не самое разумное. У него есть пара недостатков:

- Ноль эффекта. Лопасти вентиляторов не умолкали. Возможно, это из-за вентиляционных отверстий или плохих шумоизоляционных свойств материала.

- У материала высокая горючесть. Шумоизоляция неплохо так горит. В условиях серверного помещения это недопустимо.

Шумоизоляцию нужно было снять, притом как можно быстрее. Но и с этим возникли проблемы: материал намертво приклеился к серверному шкафу. До сих пор не могу снять «камуфляж», который остался после зачистки. Вот бы это было единственной заботой при проектировании…

Резервное питание

Для бесперебойного электроснабжения можно использовать источники бесперебойного питания (ИБП) трех типов — резервные, линейно-интерактивные и онлайн-ИБП.

Когда серверов у меня еще не было, я использовал офисные ИБП со встроенными аккумуляторными батареями (АКБ). Для питания сетевого оборудования, которое потребляет минимум электричества, они вполне подходили.

Когда же я установил серверы, к ИБП появились дополнительные требования:

- Нужно регулировать входное напряжение и фильтровать его от помех.

- Емкости АКБ должно быть достаточно для питания серверов.

Решение

Я выбрал недорогой линейно-интерактивный ИБП Ippon Smart Winner 1500 мощностью 1500 ВА и тремя встроенными АКБ по 9 А/ч на 12В. К нему можно было подключить дополнительные блоки АКБ.

Увеличение емкости ИБП

Мощности выбранного ИБП хватило для электропитания двух серверов HPE ProLiant. Но возникли проблемы с емкостью и продолжительностью работы АКБ.

Я попробовал решить проблему за счет приобретения дополнительного блока АКБ. И это помогло: емкости ИБП хватает на 2 часа работы сервера. Так как на серверах не хостятся коммерческие сервисы, этого достаточно.

Планы

В будущем планирую перейти на онлайн-ИБП. Они используют двойное преобразование электроэнергии: из переменного тока в постоянный и обратно. Оборудование получает «чистую электроэнергию» — ток, который стремится к правильной синусоидальной форме. На мой взгляд, это лучший способ организации электропитания серверного оборудования. Но и самый дорогой. Кстати, именно его мы используем в Selectel.

Возможно, когда-нибудь я внедрю онлайн-ИБП в свой дата-центр. Если у вас есть опыт использования такого оборудования — напишите в комментариях.

Пример онлайн-ИБП с подключенными АКБ

Физическое резервирование аплинков

Для стабильной связи дата-центра с интернетом нужно резервировать аплинки — соединения от роутеров во «внешний мир». Есть ряд особенностей, которые нужно учитывать.

Юридическая ответственность

В качестве аплинков нужно использовать каналы с широкополосной передачей данных. Но есть нюанс: интернет-провайдеры не разрешают использовать аплинки для коммерческих целей.

Не рекомендую сдавать в аренду домашние серверы: можно нарваться на судебный иск.

Отказоустойчивые аплинки

Почти в каждом многоквартирном доме есть несколько интернет-провайдеров. Это хорошо: можно выбрать два независимых провайдера и организовать отказоустойчивый выход в интернет.

Но важно, чтобы провайдеры были независимыми, с разным оборудованием и линиями связи. Обратное бывает, когда один интернет-провайдер поглощает другого: тогда, если у одного провайдера сломается оборудование, велика вероятность, что у второго провайдера тоже будут сбои. Толку от такого резервирования нет.

Как узнать, какие провайдеры независимы друг от друга — открытый вопрос. Напишите в комментариях, если есть идеи.

Резервный оптический аплинк

Иногда провайдеры падают из-за электропитания коммутаторов, которые подключены к общедомовой электросети: отключили в доме электричество — бах — аплинки не работают.

Чтобы это не отразилось на дата-центре, я использую один PON-аплинк от провайдера.

PON (Passive Optical Network) — технология деления и передачи сигнала от потребителя по оптическому волокну.

У PON-аплинков есть преимущество: активное оборудование, к которому протянуто оптоволокно, зарезервировано провайдерами по питанию от другой сети, которая не зависит от электроснабжения дома. Если в доме погаснет свет, соединение дата-центра с интернетом будет работать как минимум 2 часа, пока не разрядится ИБП. Или пока кто-то не сломает резервный PON-аплинк.

Переключения между IP-адресами

На следующем этапе нужно было настроить доступ к серверам через интернет.

Но и здесь было препятствие: каждый провайдер выдал по одному «белому» IP, а пакеты можно отправлять только через конкретный адрес. То есть нужно было научиться балансировать трафик и переключаться между IP-адресами. Я нашел два пути решения этой задачи.

DNS с минимальным TTL

Изначально планировал передавать через одну запись DNS сразу несколько IP-адресов. Но тогда, если пользователь отправит запрос к DNS-серверу, в ответ он может получить «пачку адресов». А дальше неизвестно, что с ней сделает ОС клиента: она может постучаться по произвольному адресу и, например, получить ответ «Ресурс недоступен».

Чтобы избежать таких ошибок, я загрузил на роутер скрипт. За его основу взял код из github-проекта. Но есть отличие: я запускаю скрипт не по расписанию, а через утилиту netwatch — она отправляет эхо-запросы (ping) через аплинки и при падении одного из них запускает скрипт. Так Mikrotik отслеживает состояние каналов и через API DNS-сервис меняет IP-адрес на актуальный.

Минимальное время жизни записи (TTL) нужно для того, чтобы после переключения на резервный канал запись со старым IP долго не жила в кешах устройств — это может привести к ошибкам вроде 404 — и удалялась. Из минусов:

- долгое время переключения на резерв, равное значению TTL,

- необходимость поддержки API DNS-сервисом.

В качестве DNS провайдера я использую сервис Cloudflare, так как он поддерживает API и есть возможность указать минимальный TTL, равный 1 минуте.

Но есть и другие варианты.

Промежуточный хост-сервер

Для балансировки трафика между двумя IP-адресами можно использовать хост-сервер: пользователь отправляет трафик на надежный хост, который определяет, на какой IP его перенаправить. Есть два способа организации такого сценария.

VPN-туннель

Идея в том, чтобы пользователи обращались хосту, от которого поднят VPN-туннель до моего дата-центра. Данный хост перенаправляет пакеты из интернета на сервер дата-центра через туннель. Для преобразования адресов на частные используется DST-NAT. Но есть минус — большая нагрузка на хост-сервер из-за шифрования во время передачи через VPN-туннель.

Обратный прокси-сервер

Чтобы снизить нагрузку, можно использовать обратный прокси-сервер вместо VPN-туннеля.

Обратный прокси-сервер — это балансировщик, который перенаправляет весь HTTP-трафик на web-серверы внутри сети, учитывая доступность и загруженность каждого из серверов.

Я пробовал организовать обратный прокси-сервер. Он анализировал доступность внешних адресов с помощью специальных запросов на каждый из внешних IP и «смотрел», какой из них актуален на данный момент.

Резервирование аплинков хост-сервера

У вас мог появиться вопрос: «Разве для хост-сервера не нужно тоже резервировать аплинки и плодить IP-адреса?»

Самостоятельно — не нужно. Хост-сервер можно реализовать на виртуальной машине, bare metal-сервере или роутере. В случае с виртуальной машиной за резервирование ответственен облачный провайдер. А для резервирования физического сервера достаточно заказать услугу MC-LAG.

Сетевая инфраструктура

Со всеми резервными и не резервными аплинками получилась такая топология сети дата-центра:

Откуда второй роутер?

На схеме видно, что в сети работают два роутера: основной и резервный. Когда я переезжал на вторую площадку, я купил второй роутер — Mikrotik hEX. Он слабее, чем Mikrotik RB3011. Но это не просто так: скорость канала от резервного провайдера меньше, чем от основного, — всего 100 Мбит/с. С такой скоростью hEX справляется без проблем.

Для резервирования шлюза на роутерах настроен протокол VRRP. О том, как он работает, можно прочитать в статье.

Резервное подключение серверов

Чтобы не резервировать коммутаторы, я решил включить серверы напрямую в роутеры и настроить MC-LAG (MLAG). Портов на роутерах хватило для включения двух серверов. Сами же коммутаторы использовал для включения в сеть остальной периферии дата-центра: видеокамеры, контроллера и прочего оборудования.

Мониторинг

На площадке я нахожусь не всегда, поэтому нужно было собрать систему для удаленного мониторинга оборудования.

Электроэнергия

Для учета электричества я использую электросчетчик с последовательным интерфейсом, который подключен к Ethernet-преобразователю RS-485.

Преобразователь нужен для передачи данных со счетчика на виртуальную машину — в систему мониторинга Zabbix. Это open source-программа для отслеживания статусов оборудования.

Охранно-пожарная сигнализация

В помещении я разместил контроллер SNR ERD-4s-GSM. К нему я подключил магнито-контактные датчики и дымовой извещатель.

Контроллер можно мониторить по локальной сети и через SMS-оповещения: если в серверной что-то загорелось, на телефон придет сообщение. В дополнение к охранной сигнализации я использую видеонаблюдение.

Распределение питания

Для управления питанием серверов собрал «аналог» PDU из трех управляемых розеток со встроенными реле, которые я подключил к выходам контроллера. Через них можно управлять электропитанием блока вентиляторов и некоторыми сетевыми устройствами: коммутаторами и вентиляторами.

Можно ли назвать домашний дата-центр полноценным

Я доволен тем, что получилось. В будущем планирую перевезти серверы на дачный участок. Представляю, как буду летом отдыхать в холодном коридоре, а зимой — в горячем.

Но для коммерческих проектов и дачный вариант дата-центра использовать нельзя. Я уже говорил о юридической ответственности. Но есть и вторая причина — технические ограничения. Вот некоторые из них:

— Для охлаждения большого количества серверов нужны мощные кондиционеры.

— Нельзя превышать лимит по потребляемой электроэнергии.

— В домашнем дата-центре нет дежурного персонала.

Для серьезных проектов рекомендую обращаться за услугами к настоящим дата-центрам — это надежней и выгодней, чем строить свою инфраструктуру на коленке.

Не знаю, во что превратится мой проект через несколько лет. Если он разрастется настолько, что его выкупит Selectel, вы узнаете об этом здесь, в блоге на Хабре.

Комментарии (119)

rsashka

15.09.2022 11:21+17И несколько лет назад у меня была мечта — сделать домашний дата-центр. Я

ее исполнил и хочу предупредить: не повторяйте моих ошибок, сохраните

психику.Сохранить психику не удается, так как вопрос "зачем домашний дата-центр" так и остался не раскрытым.

screwer

15.09.2022 11:48+11Я построил свою стойку год назад. В ней 3000ква ИБП, который я полностью перебрал - заменил все конденсаторы (кроме самых громадных силовых, они были в отличном состоянии), все реле и, разумеется, батареи. Получил по-сути новенький ИБП за копейки.

Три дисковые полки SAS, по 25 хдд 600гб в каждой.

Ленточная библиотека LTO-6 FC на 24 картриджа.

Два сервера, 48 и 72 CPU, в каждом по 256гб памяти, суммарный объем дисков (без полок) около 200 Тб. В одном из серверов стоит лто5 стример..

Третий серверный корпус, также на салазках, пустой (только БП) установлен "на вырост". Не смог не купить - слишком хороша была цена.

КВМ, монитор, клаваомышь, складная полочка на защелках - чтобы не печатать "на весу"

yabovbel Автор

15.09.2022 12:00+3Здравствуйте, звучит очень круто. Надеюсь, ваш проект будет развиваться)

Я пока что не успел накопить столько оборудованию у себя, поэтому ограничиваюсь двумя серверами и сетевым оборудованием.

vanxant

17.09.2022 21:14Но зачем?.. Локальная копия пронхаба?

screwer

18.09.2022 00:36Неоригинально. Все сразу о проне вспоминают, когда мои цифры озвучиваются.

Два гитлаба. Один на 10тб, другой на 40тб. Заполнены примерно на 70% Билд сервер. Обработка массивов данных ~30тб размером, промежуточный результат примерно такой же. Все распихано по виртуалкам. Плюс горячий бекап, который уже пишется на ленты в холодный. Плюс свободное место, забито не все "под завязку".

nutz

15.09.2022 12:05А что с энерго потреблением? на сколько счет вырос?

screwer

15.09.2022 12:10+1Могу ответить за себя. Зимой поставил счётчик на вход стойки. Среднее потребление получается 12квт-ч/сутки. Пиковое, и у всего зоопарка - сложно сказать, больше киловатта точно. По крайней мере только от двух 18 ядерников с анлоком и в стресс-тесте обычный БП на 500 "китайских" ватт сказал "пщщщ" и испустил волшебный дымок. Корсар на 850вт держит прекрасно, равно как и серверные фирменные БП.

yabovbel Автор

15.09.2022 12:24+1Сейчас серверы работают далеко не на полную мощность)

Среднее потребление составляет всего около 400 Вт. Это около 10кВт в сутки. Один киловатт мне обходится, примерно, 5 рублей. И, конечно, сэкономить помогает двухтарифный счетчик электроэнергии

Taus

15.09.2022 12:57+1Пересчитайте аккуратно затраты на электроэнергию по однотарифному и двухтарифному плану ;)

Оборудование работает почти постоянно, то для простоты сразу посчитаю средний тариф за 1 день. Например, в СПб разница между однотарифным и двухтарифным планом около 0.1 руб. Теперь докидываем всю остальную технику в квартире к постоянному потреблению 400Вт. Пользуемся остальной техникой обычно не в ночные 8 часов, за месяц набегает 100-150кВт ч (или даже больше). Из-за того, что потребление приходится на дневное время с более дорогим тарифом, вся прелесть от двухтарифа исчезает, и мы только переплачиваем.

screwer

15.09.2022 13:20Например, в СПб разница между однотарифным и двухтарифным планом

У меня двухтарифный, 4.51/2.44 (из ЛК петроэоектросбыта)

Однотарифный план стоит 3,92Пользуемся остальной техникой обычно не в ночные 8 часов

Стиралка и посудомойка - обычно всегда ночью. Они далеко, их не слышно. А днём всё на работе/в школе/садике. Поэтому вечером перед сном закинул, утром вытащил.

witcherj

17.09.2022 17:05Я как-то вещи закинул, включил стиральную машину и через час обнаружил полную ванну комнату воды

PavelBelyaev

15.09.2022 13:25Я тоже недавно такое считал, у нас вообще на 50 копеек (15%) дороже дневной двухтарифный чем однотарифный. получается если ночью спать и днем работают стиралка, электроплита, посудомойка, утюг, телик, комп с игровой видяхой, а ночью обычно только роутер, то выходит даже дороже.

Kotsusamu

15.09.2022 12:14+8Да уж. Весь мой ЦОД - это ноутбук и стационарный ПК (и то он не часто используется). Совсем непонятно, для каких задач строить дома серверную и какие задачи она решает.

elve

15.09.2022 15:01+2Все зависит от потребностей. Для самообучения 4 сервера может еще и мало будет.

Например, захотелось пошатать дома OpenStack или хотя K8s полноценный (а не k0s) - надо минимум 3 ноды. Ворох учебных виртуалок тоже может легко вылезти за пределы стационарного ПК и ноутбука.

usego

15.09.2022 15:32+1Не проще ли и дешевле нынче в облаках под такое дело наноинстансы поднимать? Да и более релятивно к дооперационным реалиям инфраструктур.

Areso

15.09.2022 15:49Не проще ли

Проще

дешевле

Depends. По моим подсчётам 2-3 месяца непрерывной эксплуатации сопоставимы с покупкой собственной железки (бу). Опять же:

наноинстансы

далеко не нано для таких вещей.

С другой стороны, что некоторое время назад мне нужно было сделать лабу на виртуалке с 2C/8G, потратил я на это 40 часов, отдал 2 доллара (в России было бы раз в 5-10 дороже) :)

usego

15.09.2022 16:23+1Таки не фулл тайм такое надо. Ну и опять же облачные скилы прокачивать сейчас не менее важно, даже в новых условиях.

Areso

15.09.2022 17:53облачные скилы

не очень переносимы между вендорами.

Видел фотку AWS Solution Architect'a с надписью на картонке, что готов работать за еду. И хотя это была шутка, в но в ней есть только доля шутки.

sin0nim

16.09.2022 14:57Это хорошо, когда кабельный интернет и можно пользоваться облаком почти как домашним ПК. У меня пока только мобильный через МТС. А потребность собрать, хоть не сервер, но объединить в локалку несколько компьютеров есть. Поставил на рабочий ноутбук с 8 Гб ОЗУ Docker, он сразу подвисать стал, пришлось снести. Для таких целей нужен другой компьютер под Линукс. Жена ведёт бухгалтерию с 1С и прочими своими приложениями - ещё компьютер. Лабу на виртуалке тоже делал, это Oracle VM на Windows 10 на отдельном компьютере (иначе каждое действие отрабатывалось по минуте-две). Есть куча плат, корпусов, HDD, БП и т.д., пробую из того, что уже есть собирать компьютеры под задачи, да ещё и интернет нужно раздать по дому.

Спасибо за статью! Хороший опыт, что-то из информации пригодится. Занёс статью себе в ссылки. И вообще, когда нужна полезная информация, в первую очередь ищу на Хабре.

Areso

16.09.2022 15:04А зачем вам хороший интернет? Главное, чтобы ssh сессия пролазила, а ей много не надо.

Ну и веб-морды рулят.

VNC/RDP с плохим интернетом, конечно, не стоит.

bankinobi

15.09.2022 19:04+3Четвертый год в кладовке стоит сервачек на китайской X99 + xeon 2680, памяти 128 гб, 6 дисков в зеркале - около 4 тб. Поверх этого запущен promox. Кроме домашних сервисов, на сервере крутится весь "девопсовский" набор. Сеть раздается микротиком ( несколько vlan) и 2 блюдцами unify ap. Ресурсов хватает за глаза.

elve

16.09.2022 20:41Один сервер все же есть у вас =). Так что вы скорее доказываете мою мысль, чем опровергаете.

bankinobi

17.09.2022 04:13Отнюдь. Вашу мысль: "Для самообучения 4 сервера может еще и мало будет." мой ответ никак не доказывает и это лютейший оверхед для процесса самообучения. Разве что для какого-нибудь инжнера-интегратора, который сервера собирает, и то натянутая версия.

romxx

15.09.2022 12:36+33"К концу четвертых суток пути поезда из Москвы во Владивосток в вагоне, где ехал сисадмин Владимир Х. уже работала сеть WiFi, домен AD, файлопомойка, WSUS и антивирусный сервер"

Areso

15.09.2022 12:48+1Как узнать, какие провайдеры независимы друг от друга — открытый вопрос. Напишите в комментариях, если есть идеи.

traceroute ?

yabovbel Автор

15.09.2022 13:44+4Здравствуйте!

Некоторые провайдеры арендуют физические волокна или лямбды в волоконно-оптических линиях других операторов. Поэтому при обрыве одного кабеля авария может произойти у нескольких провайдеров одновременно. Так как это физический уровень, то traceroute никак не поможет нам в этом.

Areso

15.09.2022 14:51Окей, на уровень физической оптики я не опускался в своих исследованиях и обычно искал совпадающие айпишники в хопах.

avelor

15.09.2022 13:14+5по части резерва через DNS есть такой нищебродский лайфхак (без промежуточных балансеров, проксей и впн-ов)

1. заводим двух провайдеров с разными ip

2. с каждого пробрасываем 53 порт на отдельные DNS-серваки

3. на каждом DNS настраиваем нашу зону с нужными запиями типа А

4. ну и делегируем наш домений на эти NS-ы

5. небольшой ttl это не отменяет, но не нужно дрюкать через API всякое - просто при недоступности первого NS резолвер пойдёт на второй

aik

15.09.2022 13:19+2Возможно, когда-нибудь я внедрю онлайн-ИБП в свой дата-центр.

Меня достал падёж интерактивных ИБП — почему-то очень быстро аккумуляторы дохнут в домашних условиях. Поставил онлайновый киловаттник. Мне пока хватает. Но он шумный, вентилятор не останавливается.Как узнать, какие провайдеры независимы друг от друга — открытый вопрос. Напишите в комментариях, если есть идеи.

Поговорить с провайдерами. В моей деревне есть РТК со своими каналами и несколько мелких провайдеров, которые покупают аплинк у билайна или мегафона. Потому у меня РТК и один из местных провайдеров.

screwer

15.09.2022 13:30Поставил онлайновый киловаттник. Мне пока хватает. Но он шумный, вентилятор не останавливается.

Поставьте дисковую полку. После нее ИБП покажется совершенно бесшумным )))

aik

15.09.2022 13:38Мне пока не надо дисковых полок, у меня сервер с несколькими винтами да роутер. Ещё всё малинку хочу повесить под pihole и ещё какие-то мелочи, которые должны быть постоянно доступны.

yabovbel Автор

15.09.2022 22:33Здравствуйте.

В моей деревне есть РТК со своими каналами и несколько мелких провайдеров, которые покупают аплинк у билайна или мегафона. Потому у меня РТК и один из местных провайдеров.

Я тоже считаю это оптимальным вариантом. Поэтому использую один аплинк от провайдера, предоставляющего сервис по оптике (PON), а другой аплинк — от провайдера, использующего медное подключение. В таком случае я минимизирую шансы того, что последняя миля выполнена на одной инфраструктуре. А вышестоящие сегменты сети у провайдеров обычно зарезервированы.

PavelBelyaev

15.09.2022 13:45Дома лучше наверно не использовать юниты, спать мешают, шумные, лучше tower собрать, 140 вентиляторы на корпусе, полупассивный БП, тихоходный процессорный, почти не будет отвлекать своим присутствием, жесткие диски только слышно как работают в полной тишине.

MakiwariB

15.09.2022 14:25Стойка удобна, если серверов и прочего сетевого оборудования много.

У Supermicro есть Tower корпуса с возможностью установки в стойку. Кроме того, существуют 4U корпуса без HotSwap корзин, такие корпуса обеспечивают достаточный поток воздуха, при достаточно низких оборотах вентиляторов (1000-1300), а высоты в 4U достаточно, чтобы установить на процессор тихую башню со 120мм вентиляторами.

Из личного опыта, в моей домашней серверной, в 4U сервере без HotSwap обороты вентиляторов не превышают 1300, в 4U с 24 HotSwap (из них заняты 15) - обороты корпусных вентиляторов держатся на уровне 2800-3400, но такие обороты по факту связаны требованиями к охлаждению дисков. Также надо учитывать, что в домашних условиях, может потребоваться обеспечить дополнительное охлаждение самых горячих компонентов, таких как SAS RAID/HBA или сетевые карты, как в случае с Tower, так и в случае с попытками соорудить тихий 4U.

При этом обслуживать серверы в стойке, на мой взгляд, гораздо удобнее, чем кучку Tower, присыпанных сверху коммутаторами.

PavelBelyaev

15.09.2022 14:44+1Моя серверная на полочке

Вы будете смеяться над моей "серверной"))

MakiwariB

15.09.2022 15:18+1Зачем смеяться? У всех свои потребности) Стойка заполненная оборудованием нужна далеко не всем.

У меня два 4U и один 2U, два коммутатора, роутер и ИБП, всё это уютно расположилось в нижней части 42U стойки, верхняя используется как стеллаж. В Tower исполнении разместить всё это было бы сложнее, а обслуживать не так удобно.

13werwolf13

16.09.2022 08:26если

1) сделать хороший кабельменеджмент

2) сделать так чтобы оборудование было закреплено а не просто лежало на полочке

то поводов для смеха не останется, да и самому смотреть будет приятнеене сочтите за наезд, так, добрый совет

AquariusStar

16.09.2022 12:47+1Может, просто вы в начале пути. В будущем может появиться и более мощный сервер. У меня тоже долгие годы обслуживал однодисковый NAS-сервер WD BookLive. Потом другие мелкие серверы появились. И только в прошлом году заменил одним сервером в башне. Остался на пару только один маленький Qnap на 4 диска, отвечающий за резервную копию. Просто пока некуда пристроить его, пусть отрабатывает каждую копейку. Потом переедет на дачу, как дострою.

meddling_mage

15.09.2022 13:49+2хочется запостить картинку про батон и троллейбус. Зачем такие сложности дома??? Ну чисто если на работе не наигрались.

Gryphon88

15.09.2022 14:09+7Зачем дома серверная:

1. Поднять свой сервер мессенджера, того же джаббера

2. Свой почтовик

3. Хранилка бэкапов

4. Медиабиблиотека: храним в одном месте, пользуемся с любого устройства

5. Сервис синхронизации

6. Локальный гит

7. Сидбокс

8. Домашняя автоматика

9. Домашний VPN, чтобы туда-сюда не передергивать VPN на устройстве

Но я согласен, что ТС несколько размахнулся и с мощностью оборудования, и с его резервированием. Фэншуйно, но часто излишне: если нет электричества, то часто нет его на последней миле у провайдера и точно нет в доме, в итоге все богатство недоступно. Примерно то же с каналом: хлопнулся линк — внутри не заметили, снаружи… ну, жизненно важными задачами обычно не нагружают, можно подождать, пока починят, или поднять резервный линк на мобильном интернете (с урезанием функционала).

PavelBelyaev

15.09.2022 14:47А что используете синхронизации и медиабиблиотеки? Я вот тоже что-то такое хочу собрать.

Gryphon88

15.09.2022 14:52Лично я синхронизацией не пользуюсь, говорят, что часто хватает обычного RSync. Для медиабиблиотеки Kodi. А ещё я никак не соберусь выкинуть часть триколоровских приемников и оставить два (почти никогда включено более 2 разных каналов), чтоб раскидывать по дому.

usego

15.09.2022 15:38Syncthing попробуйте, rsync нынче не комильфо. Ну и бекапы явно не дома надо держать.

Gryphon88

15.09.2022 18:06А почему бэкапы и всякую ерунду типа дистрибутивов не дома держать? Если сгорит дом, мне будет пофиг на бэкапы, я страхуюсь от сдохшего винта на рабочем пк.

usego

15.09.2022 18:12Просто аксиома - не держать рядом бекап того, что бекапишь. Способов потерять за раз лежащее рядом железо более, чем один. Тем более внешнее хранение нынче копейки стоит.

13werwolf13

16.09.2022 08:28советую попробовать plex или emby как замену kodi, преимуществ масса (plex сильно лучше, но он проприетарный)

а для синхронизации хороши resilio sync и syncthing (второй сильно лучше, да ещё и опенсорсный). полностью избавили меня от необходимости поддерживать свой nextcloud.

Aquahawk

15.09.2022 16:04+4Я кайфую от syncthing (синкалка) и obsidian(персональная база знаний).

bulatzaripov

15.09.2022 20:21Подтверждаю, буквально неделю назад настроил так же. Выбирал между nextcloud, owncloud, foldersync, autosync(drivesync) и т.д. и т.п. и прочими. Пока летает

nidalee

16.09.2022 07:51Синхронизация между сервером и клиентами — nextcloud, между серверами — zfs send.

Медиабибилиотека Plex.

Areso

15.09.2022 14:55Всё это отлично умещается в ... более компактный формат.

Вот у меня была проблема, что нужно было ворочать базы данных на десятки и сотни гигабайт, и под это дело были взяты дешевые 1u сервера. У одного 64 гига, у другого 192 гига.

Gryphon88

15.09.2022 15:07Если поднажать ногой, то можно и в микротик+самопальную схд упихать. А про рабочие задачи: когда учился много считать (мультиспектральные изображения), просто арендовал, когда сходные задачи появились по работе — удаленно цеплялся к серверу на работе. Сугубо имхо: если домой легально покупается любое профессиональное оборудование, то это или вы очень любите свое хобби, или вас кто-то обманул.

yabovbel Автор

15.09.2022 22:22Здравствуйте.

Соглашусь с вами, что есть большое количество сервисов, которые можно развернуть на домашних серверах.если нет электричества, то часто нет его на последней миле у провайдера и точно нет в доме, в итоге все богатство недоступно.

Так как я один из аплинков использую от провайдера, предоставляющего сервис по технологии PON, пропадание электричества в доме не влияет на работоспособность последней мили. Главное, чтобы электричество было на узле провайдера, где установлен OLT-коммутатор.

Примерно то же с каналом: хлопнулся линк — внутри не заметили, снаружи…

Для доступности сервисов снаружи можно использовать методы, описанные в статье: изменение DNS записи через API, надежный хост с VPN-туннелем до него, обратный прокси-сервер.

Vrag

16.09.2022 09:45+4У автора есть ИБП. И много проводов. Значит протянуть ешё один и воткнуть PoE инжектор проблем не возникнет (впрочем, насколько я помню, как минимум старший из его микротов в PoE out умеет одним портом). Сверлится внешняя стена и на улицу вешается например SXT Lte Kit (если мы про конюшни микротов). Который настраивается по азимут на антенну оператора с наихудшим покрытием. При таком раскладе оборудование опсоса будет на максимальном удалении и при некотором везении (а, особенно, если там живо резервированное питание) отключения электричества в р-не вам становятся не страшны.

Плюс если выбранный опсос будет отличаться от поводного провайдера (например МГТС+пчелайн или наоборот корбина+МТС) вы резервируете канал на физическом уровне. Почему операторы должны различаться? Чтобы волокно, которое поднимет экскаватор, не положило вам сразу и домашний интернет и канал до вышки сотовой связи (если он не релейный).

Но и это всё просто профдеформация в стиле "потому что мы так умеем" и "так принято делать в кровавом энтерпрайзе". Дома это всё не нужно.

Я длинным (уже в 2009 году при ремонте квартиры в 55м2 делал 28 RJ45 розеток (не путать с портами оборудования) и думал о прокладке волокна) эволюционным путём пришёл к следующей схеме: очень лёгкий по энергопотреблению сервер (с файерволом, VPN, пихолом, home assistant и ещё парой ВМ) + pon мост + 10 портовый свитч + одна точка доступа + LTE висят на БП#1 от пожаро-охранной сигнализации, которого хватает на 4-5 часов работы. Ещё 40 портов свитчей, 2 точки доступа и видеонаблюдение висят на следующем 12В БП#2 от ПОС. И сервер(а) висят на классическом ИБП.

Один из серверов мониторит заряд ИБП и при остатке в 80% душит свой гипервизор и соседа(ей) - речь максимум о получасе работы. Видеонаблюдение, 2 точки доступа и свитчи с портами, отвечающими за связь между сразу (или уже) обесточенными серверами, компами, телевизорами, медиаплеерами и проч "проводными" устройствами отрубятся часа через 1.5-2 часа. По сути это время излишне для всего, кроме видеонаблюдения. Оставшиеся 1 точка доступа, FW и обвязка проработают те самые 4-5 часов, но к этому моменту скорее всего закончатся батарейки ноутбуков. Дальше телефоны и сотовая связь, если блэкаут не глобальный. А вернее не так: я лягу спать или, если мне надо будет работать, просто за 30-60 минут сменю локацию на дом или один из офисов.

Схема не отрабатывала ни разу целиком. Сервера дважды вырубались. И даже когда я однажды вырубил автомат, на котором висит БП#1 и вспомнил про это через 5 часов - всё прекрасно работало.

13werwolf13

16.09.2022 08:29а если не секрет, на чём почтовик сделали? а то все нагугленные мной решения (в том числе и то которое в итоге использую) мне не нравятся от слова совсем.

Gryphon88

16.09.2022 13:32В итоге ни на чем: упорно лечу в спам, даже если все настроил по мануалу(

13werwolf13

16.09.2022 13:42ну это то как раз ожидаемо, поэтому почту на личном домене я в основном использую для переписок с такими же отбитыми владельцами selfhosted почтовиков.. со временем хочу перебраться на неё полностью, а если кто-то не будет получать моё письмо - пусть жалуется своему почтовому провайдеру, это не моя проблема. с этой мафией крупных почтовых серверов надо же как-то бороться.

elve

16.09.2022 20:53Просто плохие мануалы. В спам вы летите, т.к. упустили что-то в DNS (PTR,SPF,DKIM,DMARC). Настройки ПО почтовика тут не при чем.

У меня другая боль - почтовики с криво настроенными записями DNS =). Либо мы их дропаем и в т.ч. дропаем часть полезной почты с криво настроенным DNS, либо спам пролезает через фильтры, как ни обучай.

v_chaplyak

15.09.2022 14:57+2Красиво) Но как по мне, лучше уж жену завести дома, детей. Тогда и время и деньги можно будеть тратить на более интерестные занятия

sergeymakinen

15.09.2022 16:48+2Ну так одно другому не мешает (если изолировать друг от друга, конечно). Этакое Lego в большом формате, если не считать шум. :)

NAI

15.09.2022 16:19Оборудование получает «чистую электроэнергию» — ток, который стремится к правильной синусоидальной форме.

Боюсь спросить, а какой формы у вас напряжение? =)

wizard_s

15.09.2022 20:24+1Видимо, есть время и желание. Или семьи нет. В школьные годы тоже возился бы с таким круглосуточно. Но

Настолько наигрываюсь на работе, что дома всего этого уже не хочется. Пара кинетиков, nvr и коммутатор для видеокамер - вот и вся серверная.Остальное по необходимости в облаках или у хостеров поднимается под разовые задачи. Дешевле, удобнее, проще

H2oker

15.09.2022 20:44+1Доброго времени суток.

А зачем два микротика ставить для балансировки трафика? С этим отлично справится один.

yabovbel Автор

15.09.2022 22:15+2Да, с этой задачей вполне справится один роутер. Но я используя два роутера для большей отказоустойчивости. То есть на случай физического отказа одного из роутеров, необходимостью провести его обслуживание, или проблем с конфигурацией.

JayK

16.09.2022 09:27+3В домашней серверной использую 4U корпуса с низкооборотными вентиляторами, и никаких SAS дисков на 15000RPM. Самая большая проблема которая возникла у меня - фильтрация пыли, решена предфильтром на шкаф, и фильтрами от кондиционера непосредственно перед всасывающими кулерами. Также возникла проблема с удалением тепла, сделал шкафу вытяжку, экспериментирую с приточкой от кондиционера.

Как правило радиаторы старых 10гбитных сетевух и RAID контроллеров (любых) не предназначены для продувки низкооборотными кулерами. Пришлось на них лепить отдельные кулера.

Все это стоит в коридоре, рядом с платяным шкафом.

Про оптический линк я тоже так думал, пока не выключили свет и я не узнал что провайдер сэкономил на ИБП для OLT. Резервный линк это LTE с непубличным тарифом.

ИБП лучше брать APC Smart БУшные, после обслуживания они лучше любых новых, к ним есть сетевые карты которые совместимы с любым софтом, от микротика до esxi. Да, не онлайн, но для города малоактуально, да и в сельской местности они тянут, тк основные проблемы в нашей сети не форма синуса и прыжки частоты, а скачки-просадки напряжения.

Провайдеры конечно злобные сами себе буратины. Проблема решена тем что в аренду игровые сервера я сдаю через ВПН до ДЦ. Ну и не свечу этим особо. Провайдер никак оного узнать не может, просто думает что какой то буратино зачем то платит за 500Мб\Сек

Применение серверной. Работает висфера с вимоушном, 10гбит, и прочими взрослыми фичами, для личных нужд, кое какие проекты, личное облако, раздача торрентов терабайтами, несколько игровых серверов, удаленные рабочие места, жрет электричество конечно как не в себя, ок 1000W. И соответственно летом еще жрет дополнительную мощность кондиционера.

odiemius

16.09.2022 14:47+3Так как приходилось строить датацентры и дома и не дома, то добавлю и свои пять копеек.

Сервера для защиты от пыли лучше поставить повыше, полка под потолком почти идеальное место! По опыту дома могу сказать, что винты 15К (SAS, но не думаю, что SATA отличатся) в простое шумят примерно как вентилятор. Я сначала долго ловил, что-ж такое у меня так равномерно шумит (ш.ш.ш.ш.ш.), пока не отключил случайно питание дискам. Так что имейте в виду. Под нагрузкой в поиске шум, кстати, не сильно возрастал. Я собрал "тихий" сервак в mini-Tower себе для дома, чтоб там и XEN (с проброской второй видеокарты и второй звуковухи в виртуалку) с Win7 крутился, и всё остальное c центосами, включая кучку виртуалок, некоторые нарезанны openvz на контейнеры внутри и всё на зеркале на двух SAS 15K винтах, чтоб I/O не сильно торпозило и чтобы отказ диска не убил ничего.

По поводу общего шума - вентиляторы продувающие 1U, и вообще стоечные корпуса, это самолёт! У меня дома валяется стопка 1U северов, но больше про запас,выключенные. Но если хотя бы один включить то в комнате спать уже невозможно.

Странно, что автор самый первый вариант "стойки" собирал на брусочках, есть же прекрасные мини-профили типа https://anlan.ru/products/101246, которыми можно объединить оборудование. У меня первый стенд на таких профилях и был собран дома, когда я отлаживал ATC.

В качестве UPS годится почти любой выше киловата, но обязательно серверный или промышленный. У меня дома был APC 1500W, который мне изначально достался без батарей даром. Батареи (Pb) стоят довольно дорого и гарантированно мрут через пару лет. У меня Yuasa прожили 4 года до нуля ёмкости. Замен батарей это тоже занятие то еще... после того как я насобирал более года аптайма жалко было всё гасить, только чтоб заменить батарейки. Еще UPS могут производить всякие звуки. И не только их трансформатор, когда работает. Мой APC тихонько стрекотал чем-то внутри. Побороть мне не удалось, как я ни пытался, так что UPS поехал к серверам на антресоли. И да, учитывайте, что UPS греются! Даже которые не Line-Interactive. А нагрев UPS сильно сокращает срок службы батарей внутри. И не стоит стремиться достичь работы несколько часов от UPS. UPS в основном, чтобы пережить кратковременные пропадания напряжения, например, когда вы переключаете свой датацентр из одной розетки в другую :D Если питание пропало на более длительный срок то UPS должен подать сигнал и всё должно быть корректно остановлено до умирания UPS. Еще рекомендую хотя бы раз в месяц выключать UPS на пару минут из розетки чтобы проверить как он вообще работает. Но так, чтоб его не высаживать ноль. Идеально UPS поставить в отдельном помещеньице, а батареи к нему на стеллажах еще в одном отдельном.

Еще в серверной весьма важно охлаждение. Мне на антресолях пришлось в боковой стене (благо она из фанеры) прорезать окошко и вставить туда вентилятор. Иначе даже один ненагруженный сервер сильно всё греет в закрытом пространстве. В нормальном датацентре просто ставим кондишн. Но это отдельная большая тема. Как там выбирать тепловую мощность коднишина, строить всякие тёплые-холодные корридоры etc.

Вот организацией пожаротушения мне пока еще не доводилось заниматься, с удовольствием бы пощупал эту тему если возможность подвернётся.

По поводу оказания коммерческих услуг: Вас операторы не засудят, после первых жалоб или массированного трафика через Вас они просто отключат :D. Первой к Вам прийдёт налоговая, так как оплату за свои услуги как-то надо будет собирать. И даже если Вы мамой поклянётесь, что вы безплатно оказываете услуги и не берёте денег, всёравно вам доход вменят и будете должны. А для подключения к другим операторам легально, для оказания услуг, потребуется получение лицензий. Так как услуги связи это лицензируемый вид деятельности! (да-да, даже если вы вздумаете заниматься доставкой бумажных телеграмм) И если само получение лицензий (например, на передачу данных) процедура несложная, просто оплатили пошлину, подали заявку и получили, то после этого начнётся общение с ФСБ. По условиям лицензии вы обязаны в первые же 30 дней связаться с ФСБ, где вам выделят куратора по согласованию и внедрению СОРМ (проект, выбор и закупка оборудования, его монтаж, настройка-отладка, сдача в эксплуатацию и передача "ключей" от вашего оборудования к ФСБ). Вот этот СОРМ это уже затраты намного превышающие стоимость вашего оборудования всего вместе взятого. Не кратно, а на порядки превышающие!

Еще если организовывать свой ДЦ то надо подумать не только о резервировании каналов связи, но и резервировании каналов электропитания. И если вторую оптику вы еще можете заказать и вам её проложат в разумные сроки по колодцам перпендикулярно имеющейся, то провести еще одну независимую линию электропитания не получится. Я даже затрудняюсь себе представить что для этого надо, какую тонну согласований и проектов. Обычно народ просто ставит дизель-генератор в отдельной кирпичной пристроечке, с баком соляры. Но генератор тоже надо периодически, хотя бы 2-3 раза в год запускать. В идеале просто переводить питание ДЦ на него минут на 10, задно все жуки из АВР повылезут :) Но к генератору надо иметь запас запчастей, ремней, шлангов, топлива... Это все пожароопасно, занимает место, тяжелое... А некоторые штуки имеют ограниченный срок хранения (в основном резинки) и требуется их периодически покупать новые а старые куда-то утилизовать. В общем мало радости :)

Еще для личного ДЦ надо будет какую-то систему охраны и СКУД. но это просто цветочки в сравнении с описанным выше.

Поставить ДЦ на даче идея неплохая, и даже питание там можно со столба подвести, но вот каналы связи врядли Вам кто потянет в глухомань :)

И если теперь вы к этому всему посчитаете хотя бы примерную смету, во сколько это всё вам встанет... скорее всего вы решите, что быть инженером по найму куда спокойнее, чем городить личного оператора связи :D И это я еще не касался бумажной работы: всякие проекты, согласования etc....

Я всё это знаю, так как сам создал оператора связи и знаю обо всём из персонального опыта. Eсли какие-то моменты остались за рамками этого коммента то можете спрашивать.

Areso

16.09.2022 15:09+1Первой к Вам прийдёт налоговая, так как оплату за свои услуги как-то

надо будет собирать. И даже если Вы мамой поклянётесь, что вы безплатно

оказываете услуги и не берёте денег, всёравно вам доход вменят и будете

должны. ...Так как услуги связи это лицензируемый вид деятельности!

Простите, но тут вы сильно неправы:

1) обычно приходит не налоговая, а банк. Типо подозрительные платежи, или объясняйтесь или идите вон. До налоговой "дорасти" надо. А банк по умолчанию соблюдает кучу антиотмывочного законодательства.

2) лицензия нужна, если вы провайдер связи. ДЦ не являются провайдерами (в чистом виде) и у большинства такой лицензии нет, работают годами.

Vrag

16.09.2022 17:06Зачем собирать стойки на брусочках? =) На юлито почти даром есть IKEA lack. Мы из них (правда, новых из магазина) строили стойки три стола в ширину и три в высоту ступеньками, когда в одном из арендованых офисов скс по прихоти пердыдущих арендаторов сходилась в центр одной из довольно больших (не кладовка ни разу) комнат. Решили не вешать шкаф, а "сделать красиво". Там ничего сильно шумного не было: запихали патчпанели, свитчи, роутер, ИБП. Поставили один тихий сервер и принтер на нижний уровень ступеньки. Вышло довольно прикольно.

JayK

18.09.2022 05:49APC Smart штатно поддерживают горячую замену батарей, не надо ничего выключать.

Трещит внутри бесперебойника трансформатор, ничего с этим не сделаешь, не есть конечно танцы с бубном, типа найти такой же нетрещащий, виброразвязать его и тд, но это уже все шаманство.

Батареи очень желательно из него выложить и положить на соседнюю полку, подключив кабелем сечением МИНИМУМ 16мм2. У меня нормальные батареи живут по 5-6 лет, главное не превышать 25 градусов. После этого каждые пять градусов снижают срок жизни вдвое.

Вообще для для дома идеален Smart 2200 формата тауэр, у него электроника и трансы в верхнем отсеке, а батареи чилят в прохладе в нижнем. Нагрузку полкиловатта он держит больше получаса

Не надо ничего руками выключать у APC есть шедулер и режим самотеста каждый месяц допустим.

Я думал насчет аннтресолей, но остановился на напольном шкафе с пылевыми фильтрами и вытяжкой, намого удобнее. В планах сделать в него отдельную приточку еще, но это надо стену бурить.

Ну организация пожаротушения это больше косплей взрослой серверной конечно, у меня тупо стоит датчик дыма и я не совсем понимаю что именно там, в шкафу, должно загореться, у меня качественная проводка и надежные УЗо шнайдеровские.

Я покупил 500мб секунду самый дорогой тариф, и у другого оператора еще 300, и напостоянку раздаю примерно на 300 мегабит в секунду торрентов, а еще дети жена и я сам смотрят тытрубу, они там потеряются в этом трафике искать чето, особенно учитывая что половина в впны завернуто.

Дц на даче идея ОЧЕНЬ неплохая, но зачем нужен такой ДЦ если там скоость 100 максимум и это LTE. У меня на даче майнинг фермы только и дисковая полка которую выкинуть жалко, а слушать ее звук невыносимо)

echo10

17.09.2022 11:12Расскажите, что такого вы делаете на своем домашнем датацентре?

Файл-шара? Файр волл для смартфонов из нежилого помещения?

Может ли быть такое что одна своя девушка заменяет одну серверную стойку (без системы пожаротушения, но с резервированием инета)?

Aquahawk

Когда нибудь я сделаю обзор своей домашней серверной с оборудованием, но сюда хотел бы только сказать что есть такая прекрасная штука как ОСП-1 и ОСП-1 Мини. Это стеклянные порошковые огнетушители.

На фото Мини, длина 23 сантиметра, полная версия длиной полметра. Эта штука (мини) стоит около 1000 рублей и при пожаре засыпет помещение до 3 кубометров порошком. Я поставил во всех местах повышенной концентрации электроники.

holyx

Только потом порошок этот не ототрёшь, ремонт надо будет делать, если случайно сработает.

Aquahawk

Случайно он не сработает, а когда сработает считайте что объём который он защищает уже уничтожен, вопрос уничтожена ли остальная квартира.

holyx

А домашние животные, дети и просто, если случайно заденешь, разобьёшь?

Aquahawk

Не опасно для жизни. Уборки будет много, да, но не смертельно. Но вообще его стоит устанавливать в закрытых объёмах.

GavriKos

У меня в офисе случайно сработала вся система порошкового пожаротушения. Ну по крайней мере экспертиза установила что случайно.

Но - нет, технику это не уничтожило. Под выброс пошли в основном клавы и HDD. Часть моников оказалась поцарапана. В остальном - продув компрессором и промышленный клининг помещения.

Karlson_rwa

GoldGoblin

Есть не порошковые варианты. У нас в серверной висят Bontel, правда цена конская

yabovbel Автор

Добрый день!

Спасибо за совет. Я рассматривал пиростикеры Огнеборец, которые наклеиваются в электрические щиты. Но для нужного мне объема их потребовалось бы много, а соответственно и цена была не маленькой.

Про баллоны с порошком не задумывался. Возможно установлю такой в свою серверную. Правда есть и другая сторона монеты. После сработки такого баллона и попадания порошка в сервера, оборудование будет требовать восстановления. Поэтому в настоящих дата-центрах вместо порошкового пожаротушения используется газовое пожаротушение, например на основе Хладон-125.

А до тех пор у меня есть на подхвате обычный углекислый огнетушитель)

Aquahawk

Пиростикеры крутая тема но напрочь не подходит для серверной, там же охлаждение проточным воздухом

screwer

Необязательно проточным. Серверы не дышат. Внутреннего блока сплит-системы им вполне достаточно. Отсутствие притока воздуха только в плюс - не будет пыли.

Aquahawk

Согласен, но вот чего-чего а тащить сплит в домашнюю серверную мне не хочется.

lea

В случае срабатывания из уцелевшего железа удастся удалить порошок?

Aquahawk

Скорее нет чем да. Вопрос в том что при пожаре вы уже потеряли загоревшуюся технику и спасаете квартиру и остальные вещи.

still_ak

Это будет не просто

screwer

Почему не газовые ? Если обеспечить герметичность и негорючесть серверной, то заместить кислород выглядит здравой идеей. Заодно и пыли не будет.

Aquahawk

Потому что у меня герметичности серверной нет.

screwer

Я под серверную отвёл кладовку. В ходе недавнего ремонта заменил дверь на металлическую. Гореть внутри будет нечему - только железная дверь, крашеный бетон, стойка, блок кондея и огнеупорный 200кг сейф, доя хранения локальных холодных бекапов. Наружной пожар тоже не выглядит полной катафьрофой. На потолок приколочу систему пожаротушения. Но это где-нибудь в начале весны. Пока что стойка стоит у меня в кабинете, и неистово шумит кулерами)))

ElvenSailor

>>крашеный бетон

ты не поверишь, как круто горит краска на бетоне!

screwer

А в эпицентре ядерного взрыва весело горит сам бетон!

Areso

Я видел запись, как горит конструкционная сталь.

Даже без ЯО. Достаточно полить авиатопливом.

Flux

И всё-таки, it was an inside job.

HiMem-74

Нет. Я делал ремонт в хрущевке и была задача убрать краску со стен в коридоре. Пытался, в том числе, сжечь краску горелкой - бесполезно, видимо нужен напалм )))

В итоге краску победил только алмазной чашкой на болгарке + жесткая крацовка на болгарке.

Arioch

краска разная бывает. По ГОСТам в подъездах жилых домов должна быть негорючей. А по жизни весьма возможно будет любая максимлаьно дешевая.

я в подмосковье в доме 1970-х годов постройки в угол окна подъезда кинул фантик от конфеты и поджог - краска занялась

yabovbel Автор

Я тоже думал о газовом пожаротушении. Но как правильно вы заменили, для газового пожаротушения нужна герметичность. В моем случае ее обеспечить невозможно. По крайней мере сейчас. Так как в самом шкафу есть вентиляторные отверстия для охлаждения. Само помещение тоже не герметичное.

Soorin

Герметичность - ни в коем случае (будет биг бада-бум). Более того, нужна система вывода ГОТВ после срабатывания, и вентиляции.

screwer

Почему будет бадабум ?

Popadanec

Потому что при срабатывании будет резкое увеличение атмосферного давления.

Вышибет двери/окна.

yabovbel Автор

Кстати, да!

Нужно искать альтернативное решение) Система газового пожаротушения требует профессионального проектирования и реализовать ее в домашней серверной — трудно.

nidalee

yabovbel Автор

Здравствуйте. Данное устройство также использует порошок в качестве пожаротушащего вещества. А попадание порошка в серверное оборудование повлечет необходимость восстановления серверов.