Сегодня задачи технического зрения становятся с каждым днем все более актуальными. Одной из классических и, пожалуй, самых распространенных и востребованных задач этой сферы является распознавание. Основная проблема распознавания заключается в том, что эта задача даже в самых сложных вариациях легко решается человеком, но требует значительных ресурсов для решения даже простейших вариантов этой задачи машинами.

Зачем нам вообще распознавание? В условиях современного мира человек сталкивается с мощнейшим и непрерывно растущим информационным потоком. Конечно, мозг человека — очень сложная структура во всех отношениях, но обладает встроенными механизмами фильтрации поступающих сигналов, однако зачастую отфильтровывается значимая в конкретной ситуации информация. Последствия этого процесса можно наблюдать каждый день, многие из них комичны, а некоторые — трагичны. Таким образом, проблема распознавания уже десятки лет является предметом изучения и исследований на стыке множества научных дисциплин.

Если исходить из исторических предпосылок решений этой задачи одним из самых сложных процессов является обучение моделей. Уже в течение многих лет специалисты с переменным успехом занимаются разработкой и обучением моделей на предварительно заготовленных наборах данных типа MNIST, Pascal VOC, ImageNet, COCO и др. Традиционно контролируемое предварительное обучение классификации изображений использовалось для помощи в обнаружении объектов и семантическом анализе. Более того, популярное предварительное обучение без ручного контроля в последние годы дало неплохие результаты в некоторых визуальных задачах, таких как классификация изображений и кластеризация.

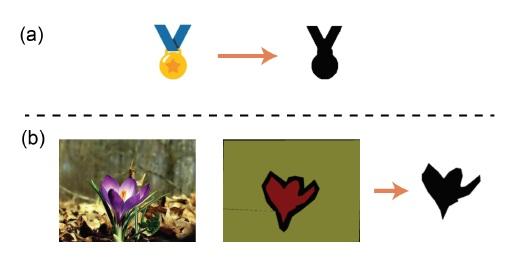

Большая часть существующих датасетов для обучения базовых моделей являются базами данных аннотированных изображений и это вполне практично, так как процесс предварительного обучения естественно начинать с реальных образов для решения повседневных задач технического зрения. Однако, как это ни странно, одним из основных ограничений текущих реализаций как раз и является их концентрация на содержании естественных изображений. Хотя помимо естественных изображений, абстрактные диаграммы, такие как тексты, символы и знаки, также несут богатую визуальную семантику и составляют значительную часть визуального мира. Яркими примерами являются «смайлы», выражающие человеческие эмоции, а также «иконки», отображающие существующие в физическом мире вещи и понятия в символические представления.

Кроме того, большинство задач, связанных с естественными изображениями, сегодня решаются с помощью мощных систем, типа глубоких сверточных нейронных сетей (к примеру, ResNet). А вот использование таких моделей для решения задач, связанных с абстрактными диаграммами, сродни стрельбе из пушки даже не по воробьям, а по комарам.

В этом топике мы познакомимся с интересным подходом к решению задачи распознавания абстрактных диаграмм с помощью головоломки Танграм.

Танграм, головоломка рассечения, состоящая из семи плоских многоугольников (танов), известна во всем мире и используется во многих сферах, включая искусство, дизайн и образование. Хотя он состоит всего из семи частей, с их помощью можно сгенерировать тысячи значимых узоров, таких как животные, здания, буквы и цифры. Решения головоломки напрямую зависят от когнитивных способностей и воображения.

Для обучения моделей был создан набор данных, состоящий более чем из 10 тысяч снимков, на которых записаны шаги по решению 388 головоломок Танграм. В статье рассматривается предварительное обучение для решения двух групп задач.

Первая группа носит эстетический характер (складывание одежды и планировка меблировки комнат). Эксперименты показали, что метод лучше всего работает в сочетании с обучением, использующим обратное подкреплением с максимальной энтропией ME-IRL и генеративно-состязательным имитационным обучением GAIL.

Во вторую группу входят несколько задач распознавания. В сеттинге N-way-K-shot (данная задача предусматривает решение задачи классификации N классов на основании K примеров на каждый класс) проведение предварительного обучения на Танграм улучшает показатели распознавания человеческого почерка, в том числе Omniglot и Multi-digit MNIST. Этот метод также повышает производительность распознавания иконок по контурам.

Три основных цели этого исследования:

перенос человеческого игрового опыта по решению Танграм для решения задач технического зрения,

доказательство успешности реализации предварительного обучения на наборе данных Танграм для решения как низкоуровневых эстетических задач, так и задач распознавания,

доказательство успешного применения предварительного обучения на наборе данных Танграм для облегчения конвергенции нескольких учебных итеративных задач и улучшения производительности распознавания в условиях низкоуровневого зрения.

Набор данных Танграм подходит для многих низкоуровневых задач, в то время как текущие исследования в основном направлены на естественные изображения с высоким разрешением, требующие больших затрат ресурсов.

Предварительное обучение

Методы предварительного обучения могут быть как контролируемыми, так и неконтролируемыми. Предварительное обучение с «учителем» в ImageNet является обычным для распознавания, локализации и сегментации объектов. Успехи неконтролируемого предварительного обучения обработки естественного языка инициировали повышенный интерес к изучению применения этого метода к компьютерному зрению (контрастное обучение, самоконтролируемое обучение и др.). Во многих задачах точная настройка обученной модели выполняется быстрее, чем обучение с нуля. Также предварительное обучение помогает в случаях недостаточности качественных размеченных данных.

Эстетика изображения

Машинная оценка эстетики изображения предполагает количественную оценку красоты изображения. На качество изображения влияют многочисленные факторы, такие как цвет, освещение, текстура и композиция изображения. Хотя субъективное суждение человеческого глаза является наиболее надежным способом оценки эстетического «качества» изображения, красоту изображения также можно оценить с помощью хорошо зарекомендовавших себя фотографических технологий. Например, анализа технических дефектов с помощью гистограмм и изучение тонового диапазона. Общий вид гистограммы дает достаточно много информации о свойствах изображения, таких как диапазон охвата тонов, контрастность, равномерность распределения уровней яркости и баланс тонов.

Недавние исследования показали, что подходы, основанные на исследовании количественных данных, могут быть более эффективными, особенно те, которые используют извлечение признаков с помощью многоколоночных сверточных нейронных сетей (CNN). Популярные базы данных для оценки качества изображений в основном собираются в виде фотографий (естественных изображений), таких как база данных Photo.Net и база данных CUHK-PhotoQuality.

Обучение в несколько итераций

Основная цель поэтапного обучения — научиться решению новых задач на нескольких вспомогательных примерах, сохраняя при этом способность к обобщению. В последнее время растет интерес к достижению цели путем изучения предварительных знаний из предыдущих задач, особенно важно обучение экстракторов признаков, которые могут эффективно разделять новые классы.

Набор данных Танграм применялся для обучения частей алгоритмов метаобучения на основе оптимизации, таких как MAML и ANIL. Кроме того, поскольку Танграм содержит только формы и контуры, эксперименты проводились с обучающими задачами из нескольких кадров, не содержащих цветов и текстур, например, Omniglot.

Итак, в экспериментах по предварительному обучению по Танграм изначально необходимо было провести сбор данных, и чтобы собрать данные решений головоломок, был разработан интерактивный инструмент маркировки с использованием игрового движка Unity. Инструмент маркировки может записывать каждый шаг перемещения, вращения или переворачивания одного многоугольника в виде снимка. Семь человек потратили несколько недель на перебор 776 решений 388 уникальных головоломок, сделав более 10 тысяч снимков.

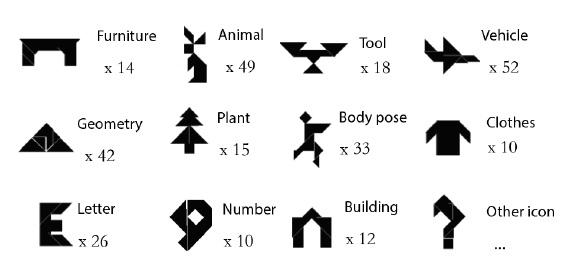

Рисунок 3 иллюстрирует обзор типов и количество решенных головоломок. Набор данных состоит из разнообразных шаблонов Танграм, включая животных, растения, буквы, числа, здания, позы людей и некоторые предметы повседневного обихода. Для их решения требуется перцептивное распознавание и элементарные навыки геометрии.

Учимся на головоломках

Обозначим сет:

как процесс решения танграм-головоломки P, где каждый Ii, i∈{1, …, np} является изображением, представляющим один шаг к решению, np — общее количество шагов. Поскольку в танграме есть только формы и контуры, Ii представляет собой бинарное изображение размером H × W.

Что можно узнать из головоломок и как использовать этапы решения? Во-первых, поэтапный процесс решения приводит к более полным, аккуратным и совершенным сочетаниям форм. Во-вторых, существует связь между паттерном и названием предмета за счет соответствия между окончательно завершенным паттерном и реальным объектом.

Поэтому формулируем две цели обучения и назначаем две функции потерь. Пусть fθ : {0, 1}H×W→[0, 1] , — функция, указывающая степень завершенности шага Ii.

По неравенству Коши-Буняковского CCL достигает минимального значения 1/(np+1), когда fθ(Ii)=i/(np+1), i = 1, 2, ..., np. Минимизация CCL приводит к правильному порядку для:

Пусть

отображает бинарное изображение в слово, вмещающее WP паттерна P, где Nword — размерность пространства вложения. Функция потерь PML (puzzle meaning loss) для последнего шага:

определяется как

Выше на рис. 4 показана реализация двух функций потерь, описанных выше. Панель (b) демонстрирует два варианта процессов решения. Первый вариант отслеживает все таны, фиксируя переход от беспорядка к упорядоченности; второй вариант прослеживает только конечное состояние перемещенных танов и представляет собой прогресс от фрагментации к завершенности.

Для обучения функций fθ и gφ используется простая сверточная нейронная сеть, имеющая всего четыре сверточных слоя 3 × 3. Размер каждого изображения подгоняется к размеру 28 × 28. Здесь применяется 50-мерный алгоритм обучения GloVe для имен паттернов с распределением весов 80% CCL и 20% PML. Часть сети, извлекающая функции, передается для решения других задач.

Эксперимент

При проведении испытаний были определены мини-визуальные задачи как задачи на зрение, требующие обучения только на бинарных изображениях с низким разрешением. Задачи поделены на две категории: эстетические и задачи распознавания. В качестве представителей первой категории выбраны складывание одежды и планировка комнат (расстановка мебели), а в качестве представителей второй категории — идентификация человеческого почерка и распознавание иконок.

Складывание одежды

Складывание одежды — классическая задача робототехники, вызвавшая бурное обсуждение в различных работах. Распространенными методами являются лес случайных решений, вероятностное планирование, а также глубокое обучение с подкреплением и разработка модифицируемой стохастической модели. В данном исследовании задача складывания одежды абстрагируется как чисто визуальная задача: контур платья/костюма/рубашки/брюк представлен бинарным изображением, а складывание одежды характеризуется манипулированием изображениями. На рис. 5 представлено изображение, похожее на абстракцию складывания платья.

Текущее состояние одежды s представлено бинарным изображением I из пространства образов S = {0, 1}H×W, а действие a приводит к складыванию изображения по некоторой оси. Данная задача рассматривается как задача итеративного обучения: поскольку нам дано лишь несколько экспертных траекторий:

где каждая траектория

представлена порядковой последовательностью состояний к решению

проблема состоит в том, как сложить произвольную одежду.

Протестировано несколько различных способов решения этой задачи, включая прямую минимизацию CCL для экспертных траекторий и использование популярных алгоритмов обучения с обратным подкреплением IRL (inverse reinforcement learning). Перечисленные ниже алгоритмы можно применять не только для складывания одежды и расстановки мебели, но и для решения широкого круга задач, связанных с робототехникой.

Оценка обучения SL (score learning): можно напрямую дать оценку состоянию Vδ : S →[0, 1], изучая экспертные траектории с помощью функции CCL (см. уравнение 1):

Обучение с обратным подкреплением с максимальной энтропией ME-IRL (max-entropy inverse reinforcement learning): предположим, что траектория τi=(s1, s2, …) выбирается из текущей методики складывания одежды πi и функции оценки для состояния s — Fψ : S →[0, 1], тогда можем вычислить градиент ψ по формуле:

где Lψ=P(πi, τ ∈ πE) — функция правдоподобия выбора экспертных траекторий при текущей методике.

Генеративно-состязательное имитационное обучение GAIL (generative adversarial imitation learning): после инициализации дискриминантной функции Dω: S →[0, 1] для различения состояний между экспертной и выборочной траекториями можем обновить с помощью градиента:

где Lω — потери соперника, а τi имеет то же значение, что и выше. Обратите внимание, что мы модифицируем GAIL, различая только состояние s вместо пары состояние-действие (s, a), так как нам не дано достаточное количество пар состояние-действие при небольшом количестве этапов.

Для упрощения мы рассматриваем достаточно агрессивную методику, определяемую значениями Vδ, Fψ и Dω, как распространенную методику πi для SL, ME-IRL и GAIL. Будем считать, что одежда изначально кладется прямо и ее можно сложить только по вертикальной и горизонтальной осям. Размер изображения I, представляющего состояние s, составляет 28 × 28, и на изображении равномерно распределены десять вертикальных и горизонтальных осей складывания.

Три разных способа, а также случаи предварительного обучения и без предварительного обучения дают нам шесть различных моделей. Модели обучаются по экспертным траекториям из 18 предметов одежды, включая платья, рубашки, футболки, брюки, шорты и юбки (по три на каждый тип). Затем модели тестируются на шести новых предметах одежды из вышеупомянутых типов и трех предметах одежды других типов.

Мы ссылаемся на Vδ, Fψ и Dω, полученные из уравнений 3, 4 и 5, как на эстетические оценки складывания. На рис. 7 показано, что Dω увеличивается по мере складывания одежды. Сравнение производительности различных моделей вычисляется ранжированием упорядоченных состояний

экспертных траекторий на основе Vδ, Fψ и Dω. Поскольку в среднем длина экспертных траекторий равна 4, рассматриваем точность только при K (P@K) с K ≤ 3.

В таблице 1 сравнивается общая разница P@K между предварительно обученной моделью и необученной моделью (обучение с нуля) для обучающих экспертных выборок.

В целом заметно, что предварительное обучение повышает точность обучения и снижает дисперсию. Отобрав лучшие модели из шести методов, тестируем их один раз на одежде, которую раньше не видели.

Таблица 2 показывает среднее значение и стандартное отклонение тестирования P@K. За исключением того, что ME-IRL без предварительного обучения несколько превосходит предварительно обученную модель, подготовка повышает общую точность теста, а высокая точность каждого значения (K = 1, 2, 3) подразумевает более высокие общие эстетические оценки.

ME-IRL и GAIL — распространенные алгоритмы, управляемые данными, в домене IRL. Как и в случае с SL, их производительность сильно зависит от количества экспертных данных, предоставленных для обучения. Таким образом, настройка предварительно обученной модели может уменьшить зависимость от данных.

P@1 |

P@2 |

P@3 |

|

Обучение с нуля |

0.54 ± 0.5 |

0.66 ± 0.32 |

0.76 ± 0.21 |

Предварительное обучение |

0.77 ± 0.41 |

0.84 ± 0.26 |

0.86 ± 0.18 |

Таблица 1: Среднее значение и стандартное отклонение обучения P@K: сравнение моделей с предварительным обучением и без него.

P@1 |

P@2 |

P@3 |

|

SL |

0.22 ± 0.46 |

0.44 ± 0.46 |

0.55 ± 0.47 |

SL (с предварительным обучением) |

0.89 ± 0.33 |

0.78 ± 0.26 |

0.81 ± 0.18 |

ME-IRL |

0.89 ± 0.33 |

0.78 ± 0.26 |

0.74 ± 0.22 |

ME-IRL (с предварительным обучением) |

0.67 ± 0.50 |

0.94 ± 0.17 |

0.96 ± 0.11 |

GAIL |

0.33 ± 0.25 |

0.61 ± 0.33 |

0.74 ± 0.22 |

GAIL (с предварительным обучением) |

0.89 ± 0.33 |

0.94 ± 0.17 |

1.00 ± 0.00 |

Таблица 2: Среднее значение и стандартное отклонение тестирования P@K.

Оценка планировок помещений

Генерация макетов комнат отличается от задачи складывания одежды тем, что последняя фокусируется на изменении формы одного объекта, а первая требует размещения нескольких объектов. Эти два предварительных тренировочных упражнения могут соответствовать двум вариантам процесса воспроизведения головоломки Танграм (см. рис. 4).

Изучение генерации макетов ранее проводилось в самых различных областях, таких как архитектурный дизайн и разработка игровых уровней. В данной статье сосредоточимся на задаче расстановки мебели в помещении и абстрагируем ее как чисто визуальную задачу, как показано на рис. 8.

Применим синтез обстановки с использованием стохастической грамматики для получения достоверной информации. Шаг за шагом изменяем расположение мебели в комнате действием а с шагом в 10 пикселей и углом 15°. Обратные шаги генерируют экспертную траекторию:

P@1 |

P@2 |

P@3 |

|

Обучение с нуля |

0.18 ± 0.23 |

0.23 ± 0.34 |

0.32 ± 0.33 |

Предварительное обучение |

0.23 ± 0.42 |

0.28 ± 0.35 |

0.39 ± 0.37 |

Таблица 3: Сравнение обучения P@K между моделями с предварительным обучением и без него.

Оригинал |

С изменениями |

|

GAIL (обучение с нуля) |

0.25 ± 0.45 |

0.23 ± 0.38 |

GAIL (с предварительным обучением) |

0.31 ± 0.41 |

0.29 ± 0.35 |

Таблица 4. Точность тестирования (P@1) ранжирования наилучшей планировки помещения.

Как и в предыдущем эксперименте, мы используем бинарное изображение I для представления текущего состояния s и применяем три функции Vδ, Fψ и Dω для формирования более эстетичных вариантов расстановки мебели комнаты. Обучение проводится только на 30 сгенерированных ожидаемых траекториях и тестируется на 10 группах траекторий организации новой планировки.

В Таблице 3 показано общее улучшение за счет предварительного обучения. Предварительная подготовка повышает точность обучения. Выбираем лучшую по результатам модель GAIL и тестируем ее для выявления наилучшего решения. Для проверки надежности работы модели вносятся небольшие флуктуации. В таблице 4 сравнивается GAIL с предварительной подготовкой к задачам тестирования и без нее. Результаты показывают, что предварительная тренировка на наборе данных Танграм улучшает общую производительность модели.

Итеративное обучение

Цель итеративного обучения состоит в том, чтобы использовать новые данные, просмотрев только несколько образцов. В этом разделе мы сосредоточимся на классификации N-way-K-shot.

Предлагаемый метод следует парадигме метаобучения: сначала обучаем экстрактор признаков как базовую модель, которая позже будет настраиваться для другой задачи с помощью метаобучения. Как и в предыдущих экспериментах, базовая модель обучается на наборе данных Танграм, а затем проводится тест по задачам Omniglot и Multi-digit MNIST, где двоичное изображение содержит достаточно информации для классификации.

В данной работе были выбраны три метода: MAML, ANIL и прототипные сети.

MAML — популярный алгоритм метаобучения для обучения за несколько шагов, обеспечивающий конкурентоспособную производительность в нескольких эталонных задачах обучения в несколько этапов.

ANIL ещё больше упрощает MAML, сокращая внутренний цикл обучения, но сохраняя процедуру обучения для части, связанной с конкретной задачей.

Прототипные сети учатся сопоставлять прототипы с метрическим пространством, а затем для классификации используются расстояния между прототипами и кодированными входными данными запроса. По сравнению с другими подходами к пошаговому обучению, они обладают более простым индуктивным смещением, более выгодным в режиме ограниченных данных, при этом позволяют достичь удовлетворительных результатов.

Чтобы протестировать базовое обучение (извлечение признаков), реализованное на наборе данных Танграм, было проведено сравнение с базовым обучением с помощью EMNIST и Fashion-MNIST. Все базовые модели имеют одинаковую сетевую структуру. Прежде чем перейти к тонкой настройке, сравнивались экстракторы признаков, полученные в результате обучения на вышеуказанных наборах данных. При этом был обучен только последний слой сети как логистическая регрессия. Как видно из таблицы 5 и таблицы 6, экстракторы признаков, предварительно обученные на наборе данных Танграм, EMNIST и Fashion-MNIST, работают намного лучше, чем экстракторы, инициализированные случайным образом. За исключением того, что базовая модель, обученная на EMNIST, лучше справляется с заданием 5-way-5-shot на Omniglot.

Omniglot |

Double-MNIST |

|

Random |

33.7% ± 2.0% |

7.3% ± 1.5% |

EMNIST |

55.0% ± 5.4% |

26.8% ± 2.2% |

Fashion-MNIST |

43.9% ± 4.1% |

30.1% ± 1.2% |

Tangram |

56.0% ± 4.7% |

36.0% ± 2.7% |

Таблица 5. Обучение 5-way-5-shot: среднее значение и стандартное отклонение точности тестирования (только логистическая регрессия).

Omniglot |

Double-MNIST |

|

Random |

8.0% ± 0.7% |

6.1% ± 0.1% |

EMNIST |

22.1% ± 1.2% |

7.5% ± 0.1% |

Fashion-MNIST |

15.6% ± 1.4% |

9.2% ± 0.5% |

Tangram |

22.0% ± 1.0% |

10.5% ± 1.0% |

Таблица 6: Обучение 20-way-5-shot: среднее значение и стандартное отклонение точности тестирования (только логистическая регрессия).

На рис. 9 сравнивается процесс настройки разных базовых моделей. Настройка этих моделей, предварительно обученных на наборе данных Танграм, показывает более высокую итоговую производительность по сравнению с обучением с нуля, а в некоторых задачах значительно ускоряет конвергенцию. Два других экстрактора, обученных с помощью EMNIST и Fashion-MNIST, показывают неплохие результаты в некоторых задачах, однако окончательные результаты не так хороши, что отражает сложность настройки базовой модели для нерелевантных задач. Эти результаты также демонстрируют важность выбора правильного фундаментального набора данных для обучения.

В таблице 7 и таблице 8 сравниваются окончательные результаты между обучением с нуля и предварительным обучением на наборе данных Танграм, где применяется ANIL в качестве алгоритма настройки.

Omniglot |

Double-MNIST |

|

Обучение с нуля |

97.1% ± 1.4% |

98.4% ± 1.3% |

Tangram |

98.1% ± 1.0% |

98.5% ± 1.0% |

Таблица 7. Тестирование точности обучения 5-way-5-shot с алгоритмом настройки ANIL.

Omniglot |

Double-MNIST |

|

Обучение с нуля |

92.4% ± 1.0% |

98.2% ± 0.3% |

Tangram |

93.5% ± 0.9% |

98.2% ± 0.2% |

Таблица 8. Тестирование точности обучения 20-way-5-shot с алгоритмом настройки ANIL.

Распознавание значков

На первый взгляд, распознавание иконок и пиктограмм является относительно простой задачей по сравнению с задачей распознавания естественных изображений, поскольку большинство их представляют собой достаточно простые формы, на восприятие которых не влияют косвенные явления (уровень освещенности, экспозиция, контрастность и др.). Однако стоит понимать, что абстрактные и, казалось бы, простые значки могут передавать самые разные смысловые понятия.

В данной статье проводится эксперимент с Icons-50, коллекцией из 50 типов иконок, с обучающими выборками от десятков до сотен для каждого типа. Проверка осуществлена на Flowers-17 и Flowers-102.

Flowers-17 |

Flowers-102 |

Icons-50 |

||||

ResNet-18 |

EfficientNet-b0 |

ResNet-18 |

EfficientNet-b0 |

ResNet-18 |

EfficientNet-b0 |

|

Обучение с нуля |

73.5% ± 3.4% |

76.1% ± 1.4% |

50.5% ± 1.3% |

51.7% ± 1.5% |

86.5% ± 0.4% |

84.5% ± 0.7% |

Tangram |

76.3% ± 3.8% |

76.0% ± 1.2% |

51.1% ± 0.8% |

50.6% ± 1.1% |

87.1% ± 1.1% |

85.0% ± 1.0% |

Таблица 9: Результаты классификации между обучением с нуля и предварительным обучением на наборе данных Танграм. Входные данные представляют собой бинарные изображения, представляющие только контуры.

Из Icons-50 были выбраны иконки с белым фоном более 40% и выделенными контурами, в результате чего получилось 2450 образцов. Flowers-17 и Flowers-102 обладают четкими контурами цветов. Flowers-17 содержит 17 типов цветов и 849 образцов, а Flowers-102 — 102 типа цветов и 8189 образцов. Для каждого набора данных 80% выборок используются для обучения, а остальные 20% — для тестирования. В качестве сетевых архитектур для классификации значков использовались ResNet-18 и EfficientNet-b0.

На вход сети подаются бинарные изображения размером 224 × 224. В таблице 9 сравнивается модель, обученная с нуля, и модель, предварительно обученная на наборе Танграм. Хотя обучение EfficientNet-b0 с нуля обеспечивает хорошую производительность, предварительно обученная модель с ResNet-18 показывает в целом более высокую точность тестирования.

В этой статье был представлен набор данных Танграм, в котором записаны пошаговые решения головоломки. Предварительное обучение на этом наборе данных может применяться к самым различным задачам. Однако наиболее впечатляющие результаты достигаются в задачах низкоуровневого зрения.

Приложения:

Набор данных Tangram.

Инструмент онлайн маркировки на Unity.

НЛО прилетело и оставило здесь промокод для читателей нашего блога:

— 15% на все тарифы VDS (кроме тарифа Прогрев) — HABRFIRSTVDS.