ОС Data ONTAP 8.3 cDOT это один из наибольших релизов NetApp. Одной из ключевых особенностей релиза является технология Advanced Drive Partitioning (ADP), в предыдущей статье я рассматривал применение этой технологии для Root-Data Partitioning, в этой же предлагаю рассмотреть внутренее устройство StoragePools. Более подробно о том, что нового в cDOT 8.3 здесь.

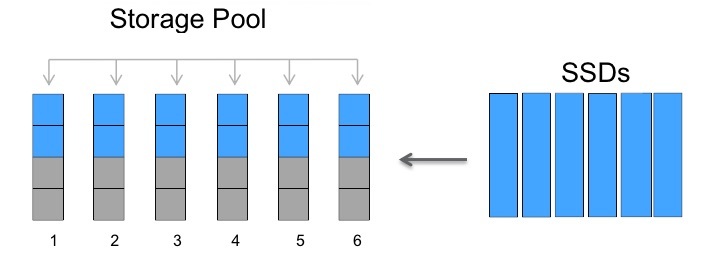

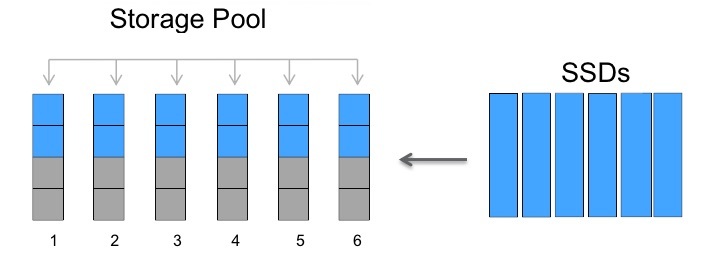

StoragePools похожа на Root-Data Partitioning, которая также использует партиционирование предоставляя новый способ распределять SSD кеш для гибридных агрегатов.

Технология StoragePool была разработана специально для гибридных агрегатов, чтобы более рационально распределять SSD кеш между ними. К примеру у вас в систему установлено всего 4 SSD, а кеш хочется сделать для 2, 3 или даже 4 агрегатов, здесь вам прийдёт на помощь ADP.

Итак, для начала нужно создать StoragePool и добавить туда набор SSD дисков.

Все диски в StoragePool'е будут разбиты на ровные 4ре части. Это нигде не настраивается, система всегда разобъет их на ровные 4ре части. Можно иметь несколько StoragePool'ов. Создавая StoragePool, по-умолчанию, партиции поровну будут поделены между двумя нодами HA системы, но это можно будет изменить.

Набор первых (P1), вторых (P2), третьих (P3) и четвертых (P4) партиций дисков StoragePool'а называется Allocation Unit соответственно (AU1, AU2, AU3, AU4).

то можно собрать RAID4 (и потерять 1 Parity диск) или собрать RAID-DP (и потерять 2 Parity диска)

Так как дисков совсем мало, в случае RAID-DP разрешается не иметь Spare диск

Для RAID-4 необходимо иметь один Spare диск

Hot-Spare диск всегда крайне рекомендован во всех конфигурациях.

При выборе между RAID4 (со Spare диском) и RAID-DP (без Spare диска), NetApp отдаёт предпочтение RAID4.

В продакшн системах с четырьмя SSD, как правило, исспользуются именно RAID4 со Spare диском (теряем два диска из четырех). Также можно на четырех дисках собрать RAID-DP со Spare диском и потерять 3 диска из 4х.

Важно отметить, что если в агрегате откажет какая-то одна (вся) RAID4 или RAID-DP группа ( будь то SSD, AU или HDD), весь агрегат перейдёт в состояние Degraded и Offline. В связи с чем NetApp всегда рекомендует исспольовать Spare диски и соответствующий вашим ожиданиям уроверь защищённости для ред групп.

Перед тем как покупать SSD диски для FlashPool вы можете оценить какое количество дисков и какой ёмкости сможет увеличить пропускнуюспособность и скорость отклика, базируясь на количестве кеш-хит попаданий которые могли бы быть в случае наличия кеша.

При выходе из строя SSD диска все рейд группы (AU) которые исспользуют его партиции будут затронуты, как результат все агрегаты которые используют эти AU. В связи с чем рекомендуется всегда иметь Spare диск, в прочем эта рекомендация была всегда.

StoragePools это ещё одна технология под капотом cDOT которая создана так, чтобы максимально просто ею пользоваться. Точно также как Root-Data Partitioning она просто есть и просто работает. В целом технология отлично справляется со своей задачей — более гибко распределять SSD кеш для гибридных агрегатов. Она косвенно позволяет экономить на SSD дисках, так раньше необходимо было покупать минимум 4x SSD для каждого гибридного агрегата, теперь можно для 4х агрегатов исспользовать один набор из 4х SSD. Понимая тонкости работы StoragePool можно более рационально распредилить кеш выделяя его порциями агрегатам: к примеру дать для начала один AU для аграгата, а потом добавлять при необходимости.

FAQ по работе ADP доступен на Fieldportal.

Сообщения по ошибкам в тексте прошу направлять в ЛС.

Замечания, дополнения и вопросы по статье напротив, прошу в комментарии.

StoragePools похожа на Root-Data Partitioning, которая также использует партиционирование предоставляя новый способ распределять SSD кеш для гибридных агрегатов.

Гибридный агрегат

Технология StoragePool была разработана специально для гибридных агрегатов, чтобы более рационально распределять SSD кеш между ними. К примеру у вас в систему установлено всего 4 SSD, а кеш хочется сделать для 2, 3 или даже 4 агрегатов, здесь вам прийдёт на помощь ADP.

Итак, для начала нужно создать StoragePool и добавить туда набор SSD дисков.

Все диски в StoragePool'е будут разбиты на ровные 4ре части. Это нигде не настраивается, система всегда разобъет их на ровные 4ре части. Можно иметь несколько StoragePool'ов. Создавая StoragePool, по-умолчанию, партиции поровну будут поделены между двумя нодами HA системы, но это можно будет изменить.

Набор первых (P1), вторых (P2), третьих (P3) и четвертых (P4) партиций дисков StoragePool'а называется Allocation Unit соответственно (AU1, AU2, AU3, AU4).

- Теперь мы можем собирать отдельные Raid Group'ы (RG) из Allocation Unit'ов (AU).

- Allocation Unit'ы создаются только из SSD.

- Рейд группа уже содержащая AU может состоять только из одного AU.

- Несколько рейд групп состоящих из AU могут сосуществовать в одном агрегате или жить в нескольких разных агрегатах, агрегаты могут жить на первой и/или второй ноде.

- AU исспользуется целиком для создания рейд группы.

- Можно задействовать любое доступное количество AU или не задействовать.

- Пока RAID группа не больше 14 Дисков, она на ходу может быть конвертирована RAID4 в RAID-DP и обратно.

- В качестве исключения из правил в агрегат состоящий из HDD дисков, могут быть добавлены SSD в качестве кеша (гибридный агрегат, его ещё называют FlashPool). Как правило NetApp не разрешает объединять в одном агрегате разногодные диски*.

- В качестве исключения из правила, для SSD рейд групп разрешается иметь отличный тип защищённости (RAID4 или RAID-DP) от того, который настроен для HDD. Как правило все рейд группы должны иметь одинаковый тип защищённости. В нашем же случае рекомендация действует таким образом: все рейд группы состоящие из HDD должны иметь одинаковый тип защищённости, а рейд группы состоящие из SSD/AU могут иметь отличный тип защищённости от HDD, но должны иметь одинаковый тип защищённости в разках SSD/AU рейд групп.

Рекомендации по RAID и Spare дискам

Если у вас всего 4-ре диска

то можно собрать RAID4 (и потерять 1 Parity диск) или собрать RAID-DP (и потерять 2 Parity диска)

Так как дисков совсем мало, в случае RAID-DP разрешается не иметь Spare диск

Для RAID-4 необходимо иметь один Spare диск

Hot-Spare диск всегда крайне рекомендован во всех конфигурациях.

При выборе между RAID4 (со Spare диском) и RAID-DP (без Spare диска), NetApp отдаёт предпочтение RAID4.

Предпочтение RAID4 на малом количестве SSD обусловлено несколькими причинами:

- SSD диски на самом деле более надёжны чем обычные диски по-этому на малых количествах SSD RAID4 более надёжен чем HDD в том же RAID

- SSD диски на много быстрее восстанавливаются из-за чего выход второго диска из строя в процессе реконструкции на много менее вероятен по срвнению с HDD

- Так как SSD диски имеют ограниченное число циклов перезаписи, Spare диск будет вообще не использоваться (и не уилизировать циклы перезаписи)

- Если число SSD превысит 7 дисков, рекомендуется исспользовать (конвертировать группу в) RAID-DP

В продакшн системах с четырьмя SSD, как правило, исспользуются именно RAID4 со Spare диском (теряем два диска из четырех). Также можно на четырех дисках собрать RAID-DP со Spare диском и потерять 3 диска из 4х.

Важно отметить, что если в агрегате откажет какая-то одна (вся) RAID4 или RAID-DP группа ( будь то SSD, AU или HDD), весь агрегат перейдёт в состояние Degraded и Offline. В связи с чем NetApp всегда рекомендует исспольовать Spare диски и соответствующий вашим ожиданиям уроверь защищённости для ред групп.

Пример конвертации RAID-DP в RAID4 для SSD кеша (AU)

storage aggregate modify -aggregate aggr_name -hybrid-enabled true

storage pool show-available-capacity

storage aggregate add aggr_name -storage-pool sp_name -allocation-units number_of_units

storage aggregate modify -aggregate aggr_name -raidtype raid4 -disktype SSD

storage aggregate show-status test

Aggregate test (online, mixed_raid_type, hybrid) (block checksums)

Plex /test/plex0 (online, normal, active, pool0)

RAID Group /test/plex0/rg0 (normal, block checksums, raid-dp)

Usable Physical

Position Disk Pool Type RPM Size Size Status

-------- --------------------------- ---- ----- ------ -------- -------- ----------

dparity 1.2.3 0 BSAS 7200 827.7GB 828.0GB (normal)

parity 1.2.4 0 BSAS 7200 827.7GB 828.0GB (normal)

data 1.2.5 0 BSAS 7200 827.7GB 828.0GB (normal)

data 1.2.6 0 BSAS 7200 827.7GB 828.0GB (normal)

data 1.2.8 0 BSAS 7200 827.7GB 828.0GB (normal)

RAID Group /test/plex0/rg1 (normal, block checksums, raid4)

Usable Physical

Position Disk Pool Type RPM Size Size Status

-------- --------------------------- ---- ----- ------ -------- -------- ----------

parity 1.3.3 0 SSD - 82.59GB 82.81GB (normal)

data 1.4.0 0 SSD - 82.59GB 82.81GB (normal)

data 1.4.1 0 SSD - 82.59GB 82.81GB (normal)

data 1.4.2 0 SSD - 82.59GB 82.81GB (normal)

Advanced Workload Analyzer (AWA)

Перед тем как покупать SSD диски для FlashPool вы можете оценить какое количество дисков и какой ёмкости сможет увеличить пропускнуюспособность и скорость отклика, базируясь на количестве кеш-хит попаданий которые могли бы быть в случае наличия кеша.

Пример вывода AWA

### FP AWA Stats ###

Host lada66a Memory 93788 MB

ONTAP Version NetApp Release Rfullsteam_awarc_2662016_1501071654: Wed

Jan 7 17:43:42 PST 2015

Basic Information

Aggregate lada66a_aggr1

Current-time Fri Jan 9 16:14:29 PST 2015

Start-time Fri Jan 9 12:30:16 PST 2015

Total runtime (sec) 13452

Interval length (sec) 600

Total intervals 24

In-core Intervals 1024

Summary of the past 20 intervals

max

------------

Read Throughput (MB/s): 134.059

Write Throughput (MB/s): 1333.279

Cacheable Read (%): 27

Cacheable Write (%): 22

Max Projected Cache Size (GiB): 216.755

Summary Cache Hit Rate vs. Cache Size

Referenced Cache Size (GiB): 216.755

Referenced Interval: ID 22 starting at Fri Jan 9 16:04:38 PST 2015

Size 20% 40% 60% 80% 100%

Read Hit (%) 1 3 6 11 21

Write Hit (%) 5 11 13 14 23

AWA Summary for top 8 volumes

Vol interval len (sec) 19200

In-core volume intervals 8

Volume #1 lada66a_vol8

Summary of the past 32 intervals

max

------------

Read Throughput (MB/s): 1.751

Write Throughput (MB/s): 18.802

Cacheable Read (%): 11

Cacheable Write (%): 16

Max Projected Cache Size (GiB): 29.963

Projected Read Hit (%): 31

Projected Write Hit (%): 16

Volume #2 lada66a_vol7

Summary of the past 32 intervals

max

------------

Read Throughput (MB/s): 1.640

Write Throughput (MB/s): 17.691

Cacheable Read (%): 14

Cacheable Write (%): 13

Max Projected Cache Size (GiB): 28.687

Projected Read Hit (%): 29

Projected Write Hit (%): 13

Недостатки

При выходе из строя SSD диска все рейд группы (AU) которые исспользуют его партиции будут затронуты, как результат все агрегаты которые используют эти AU. В связи с чем рекомендуется всегда иметь Spare диск, в прочем эта рекомендация была всегда.

Выводы

StoragePools это ещё одна технология под капотом cDOT которая создана так, чтобы максимально просто ею пользоваться. Точно также как Root-Data Partitioning она просто есть и просто работает. В целом технология отлично справляется со своей задачей — более гибко распределять SSD кеш для гибридных агрегатов. Она косвенно позволяет экономить на SSD дисках, так раньше необходимо было покупать минимум 4x SSD для каждого гибридного агрегата, теперь можно для 4х агрегатов исспользовать один набор из 4х SSD. Понимая тонкости работы StoragePool можно более рационально распредилить кеш выделяя его порциями агрегатам: к примеру дать для начала один AU для аграгата, а потом добавлять при необходимости.

FAQ по работе ADP доступен на Fieldportal.

Сообщения по ошибкам в тексте прошу направлять в ЛС.

Замечания, дополнения и вопросы по статье напротив, прошу в комментарии.

SamOwaR

А есть ли какие-то средства контроля состояния живучести SSD? Предупредит ли контроллер что кеш на последнем издыхании, и какое его будет поведение, если SSD переключится в read-only?

bbk

Я зайду издали и отвечу чуть шире, чтобы этот ответ мог пригодиться более широкой аудитории.

В системах NetApp доступна команда для просмотра состояния износа ячеек SSD

navion

А дольше 5 лет гарантию продлить нельзя?

К примеру у IBM продление можно докупать в течении 5 лет после снятия железки с продажи (добив гарантию минимум до 7-8 лет), а задорого и после этого срока через контракт.

bbk

Если абстрагироваться от технологии ADP и начать говорить об all flash массивах, то нетап предоставляет возможность продлить гарантию на 7 лет.

navion

Да, вопрос скорее общий. А на обычный/гибридный FAS или E-series можно докупить гарантию больше 5 лет и сколько это будет стоить?

bbk

Если ваша модель у NetApp ещё на поддержке, то продлевать сервис на неё можно столько раз сколько нужно, до того момента пока оно не станет End of Support (EOS).

К примеру NetApp анонсировал систему 2240 в ноябре 2011, дата когда ещё можно заказать EOA (End of Availability) у этой системы март 2015, а End of Support (EOS) март 2020. Итого эта модель может поддерживаться 9 лет: до объявления EOA прошло 4 года и она ещё будет поддерживается начиная с последней продажи 5 лет.

navion

Спасибо, а то начитался глупостей про 5 лет и подумал плохое.