Привет, Хабр! Я Максим, эксперт по анализу данных и машинному обучению в ПГК Диджитал. ПГК перевозит грузы, а мы разрабатываем сервисы с ИИ для управления этим процессом. Наши пользователи не всегда приветствуют инновации. Порой, они не доверяют рекомендациям, которые предложила ML-модель. С такой проблемой сталкиваются многие: ИИ-сервисы удобны, но вызывают сопротивление при внедрении со стороны рядовых пользователей. Расскажу, как исправить ситуацию с помощью атрибутов доверия. В подготовке материала помогал коллега, бизнес-аналитик Виктор Соловьев.

Текст состоит из четырёх частей:

Что-то не так с ИИ;

Как это исправить;

Как быть с сомневающимся заказчиком;

Заключение.

Статья будет полезна всем, кто хочет, чтобы системы с ИИ быстрее и проще внедрялись в процесс принятия решений в компаниях.

Что‑то не так с ИИ

В конце прошлого года аналитики из DataRobot опросили 5 тыс. руководителей компаний по всему миру — 53% из них отметили свое негативное или настороженное отношение к интеллектуальным решениям. В целом этот тренд специалисты наблюдают уже не первый год. Неоднозначное отношение пользователей к системам ИИ стало очевидно, когда суперкомпьютер Watson начал помогать онкологам ставить диагнозы. Врачи не воспринимали систему как полноценного помощника. Если результат работы алгоритма совпадал с мнением доктора, то в нем не было особого смысла. Если диагноз расходился, финальное решение все равно принимал врач, который ориентировался на собственный опыт.

Один из отталкивающих факторов связывают с внутренним устройством и принципами работы систем ИИ. Подавляющее большинство из них представляет собой «черные ящики», которые получают данные на входе и генерируют какой-то ответ на выходе. Как именно алгоритм пришел к своим выводам? Непонятно. Неизвестность вызывает кризис доверия, и в итоге люди предпочитают полагаться на экспертное мнение другого человека (даже если оно ошибочно).

Общественность может не знать о моделях машинного обучения, которые долго и успешно применяются в готовых программных продуктах. Зато у них на слуху кейсы, когда искусственный интеллект «слетел с катушек». Это — беспилотные такси, проезжающее перекрестки на красный сигнал светофора, или HR-системы, дискриминирующие отдельные категории соискателей.

Все это находит отражение в процессах разработки систем ИИ в корпоративной среде. Бизнес точно так же сопротивляется внедрению интеллектуальных решений. Так, еще в 2018 году в MIT заявили, что лишь 18% организаций активно внедряют системы ИИ в свои продукты и бизнес-процессы. Дело в том, что руководители не доверяют решениям систем ИИ, предпочитая ориентироваться на собственные ощущения и опыт. Определенный уровень сопротивления наблюдается и на стороне сотрудников компаний. Их беспокоит, что интеллектуальная система будет не просто помощником, но и заменит их на рабочем месте. Согласно тому же исследованию DataRobot, 52% людей верит, что модели машинного обучения приведут к серьезным сокращениям кадров. В то же время 86% специалистов считают, что способны выполнять работу лучше систем ИИ.

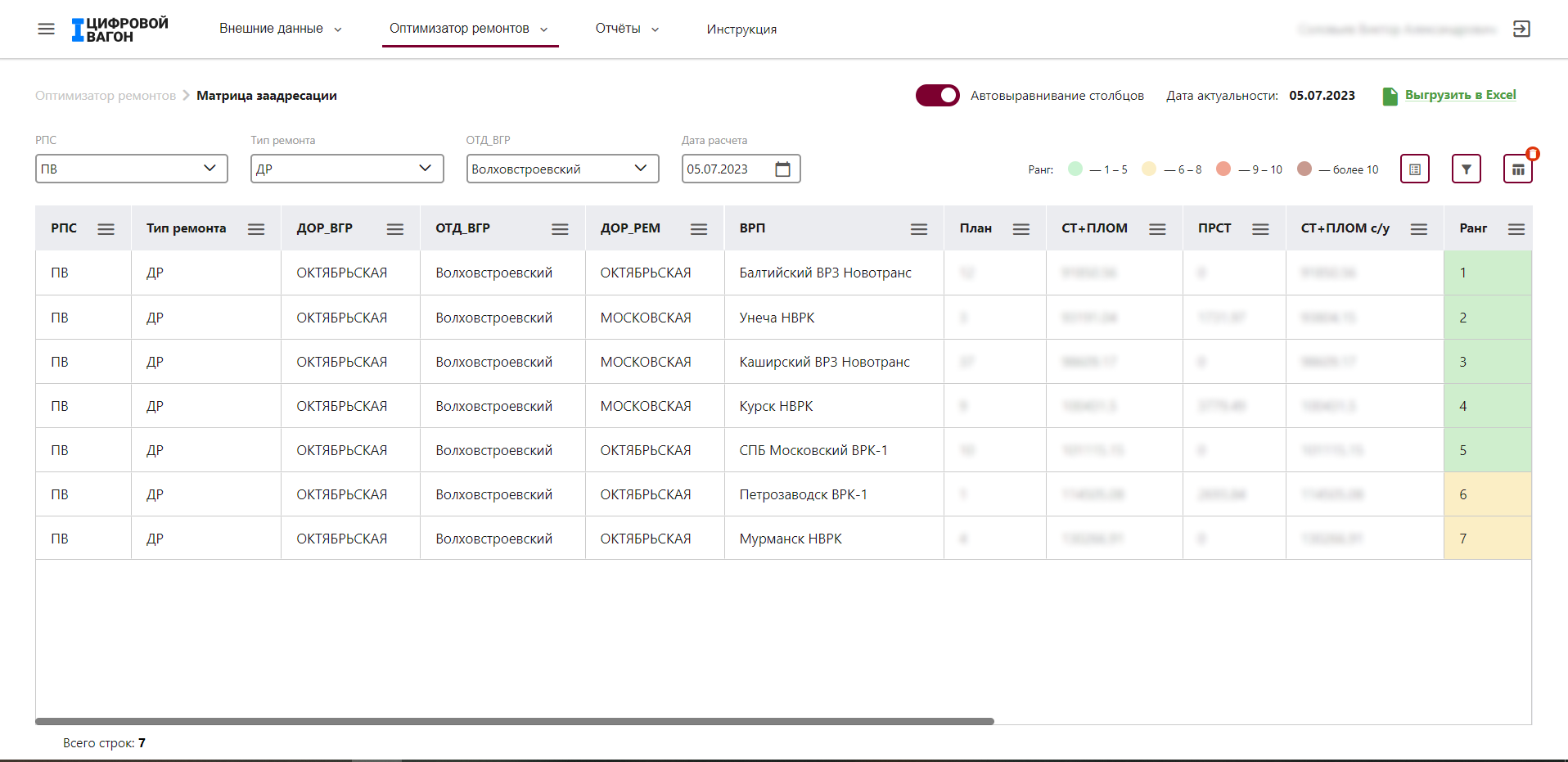

С проблемами недоверия со стороны бизнеса и пользователей сталкивается и наша команда проекта «Цифровой вагон» в Первой грузовой компании. Платформа помогает сотрудникам следить за состоянием парка и принимать решение об отправке вагонов в ремонт. Например, один из сервисов называется «Матрица заадресации» (МЗ). Его задача — помочь диспетчеру выбрать предприятие для ремонта вагона с учетом множества факторов.

Когда вагон ломается, информация об этом событии поступает диспетчеру. Раньше он анализировал большой объем информации из разных источников, чтобы выбрать оптимальное предприятие для ремонта. Сейчас этот процесс автоматизирован — его реализует система ИИ. Однако диспетчеры все равно испытывают определенный уровень недоверия к системе и часто проводят собственный анализ для перепроверки рекомендации. Наша задача сейчас — повысить доверие к ответам сервиса МЗ, чтобы специалисты не тратили лишнее время.

Как это исправить

Доверие пользователей к системам ИИ вырастет, если расширить процесс взаимодействия и уйти от привычного формата «запрос-ответ». Например, позволить корректировать настройки предоставления рекомендаций. Тогда пользователи будут благосклоннее относиться к принимаемым системой решениям. В то же время положительный эффект оказывает просветительская работа с персоналом. В Первой грузовой компании регулярно проходят вебинары и митапы для сотрудников. Команды разработчиков рассказывают о своих продуктах. Недавно коллеги из Data Science говорили про нейросети, ChatGPT и отвечали на вопросы о внутреннем устройстве систем ИИ.

Повысить доверие к интеллектуальным программным продуктам возможно, в том числе, за счет технологических решений. Например, в команде «Цифровой вагон» планируем внедрять атрибуты доверия. Это — процессные и интерфейсные решения, позволяющие выстроить доверительные отношения с пользователями, упростить внедрение сервисов с системами ИИ. Подобные практики уже внедряют компании, которые работают в сегменте B2C — маркетплейсы, сервис-провайдеры, агрегаторы и социальные сети.

Ниже представлены 4 основных атрибута доверия:

-

Предоставить возможность посмотреть, на основании чего алгоритм сделал тот или иной выбор. Сегодня развивают инициативы, направленные на разработку интерпретируемых моделей. Однако это нетривиальная задача, над которой трудятся крупнейшие исследовательские агентства вроде DARPA. Здесь можно пойти другим путем — как минимум показать пользователю набор исходных данных и статистику, а также аналогичные решения системы в других ситуациях. В этом случае пользователь увидит, что решения системы действительно имеют смысл, и сможет утвердиться в своём доверии к результату работы сервиса.

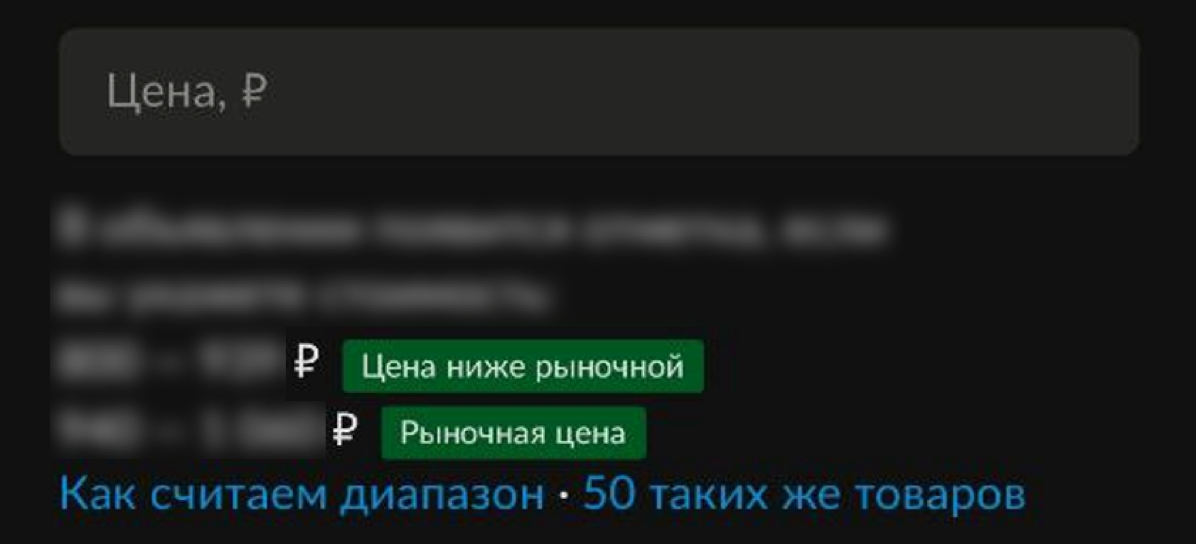

Например, разного рода онлайн-доски объявлений часто внедряют атрибуты доверия в процессы ценообразования. На маркетплейсах пользователи получают информацию о том, как желаемая стоимость соотносится с другими предложениями на площадке («цена ниже рыночной» / «рыночная цена»).

В то же время продавец может просмотреть данные для вычисления представленных ценовых диапазонов и увидеть, как появилась рекомендация (на примерах других объявлений).

-

Позволить снять с себя ответственность. Например, предложить сомневающимся пользователям указывать, что решение было получено при помощи системы ИИ, и разрешить в сложных ситуациях отправлять результат на дополнительную проверку эксперту. После верификации добавлять к решению соответствующую отметку.

Идея в том, чтобы пользователь снимал с себя часть ответственности при принятии решения. Не всегда человек может сформулировать причины своих сомнений. Чтобы не загонять его в угол один на один с рекомендацией от ML-модели, и нужно оставлять возможность обратиться за согласованием к эксперту. Так, работой наших диспетчеров управляет старший диспетчер и обладает большей экспертизой и авторитетом. Если он подтверждает правильность решения, у его подчиненных остаётся меньше поводов сомневаться в рекомендациях от системы сейчас и в дальнейшем.

Уменьшить груз ответственности при принятии решения помогает не только валидация от старших коллег. Иногда для этого достаточно дополнительной информации от системы. Например, интернет-площадки по покупке авто в качестве дополнительной услуги предлагают получить историю интересующей машины. Да, результат проверки не дает прямой рекомендации к покупке (то есть снимает ответственность не в полной мере), но значительно упрощает процесс. Вместо трудоёмких операций по сбору данных, человек получает готовый результат, предложенный сервисом.

-

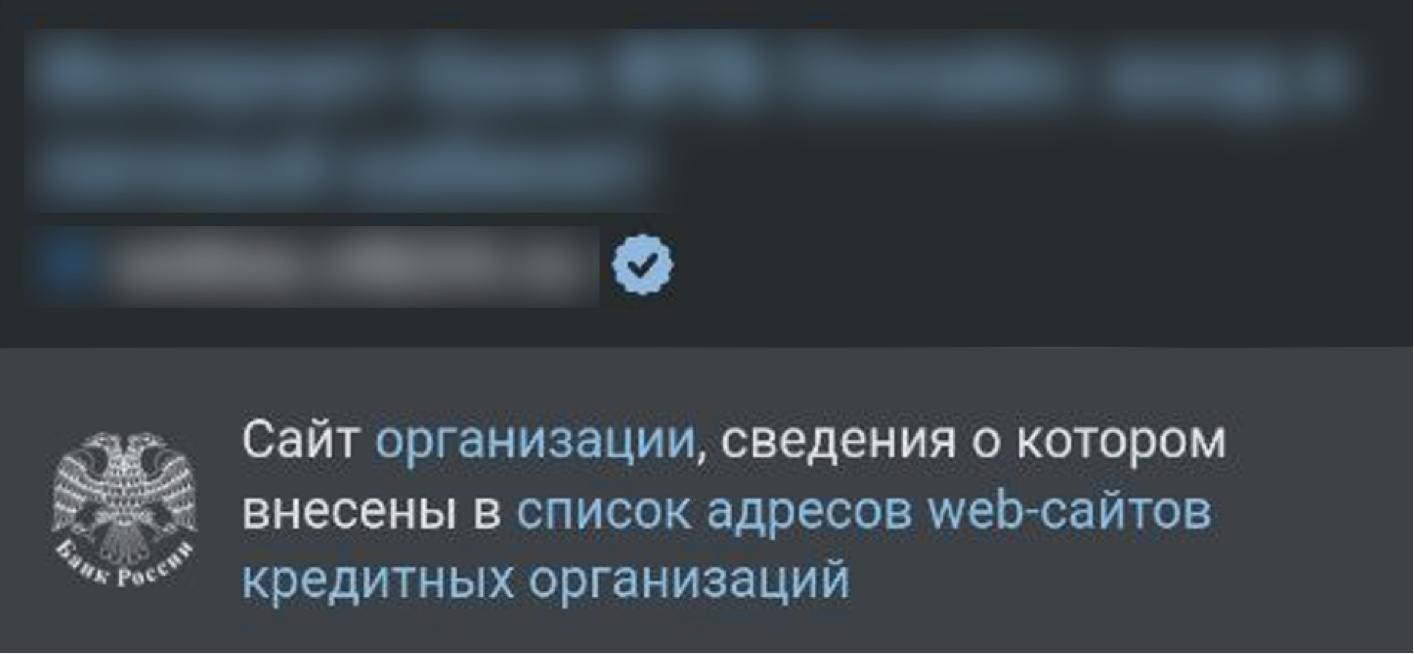

Добавить индикаторы, оценивающие качество предложенного решения. Некоторые поисковые системы ставят рядом со ссылками на сайты поясняющие значки.

Например, синяя галочка может обозначать, что ресурс находится в списке доверенных источников. Это некоторая гарантия со стороны сервиса, что данная ссылка была проверена и не несёт в себе угрозу безопасности. Такая отметка упрощает для пользователя процесс выбора результата поисковой выдачи.

-

Дать пользователям возможность оставить обратную связь. ·Иногда фидбэк от пользователей позволяет сэкономить на интеллектуальных системах сбора информации об ошибках.

Обращали внимание, как после поездки на каршеринге, такси или самокате вас спрашивают о качестве сервиса? Компания может обвесить машину гирляндой камер и датчиков, собрать ещё одну команду айтишников и разработать сервис, который будет определять чистоту и исправность транспорта по косвенным признакам. Но всё это затратно, когда можно просто получить обратную связь от пользователя. Конечно, такой подход не дает 100% точности, но если это дешевая и относительно эффективная мера, то почему бы ей не пользоваться.

Не стоит ожидать, что внедренные атрибуты доверия заработают сразу идеально. Тем не менее это рабочие практики, которых придерживаются в том числе многие крупные ИТ-компании.

Как быть с сомневающимся заказчиком

Помимо пользователей сервисов ИИ, следует уделять внимание уровню доверия со стороны бизнеса. Для достижения этой цели мы вовлекаем заказчиков в процесс активного обсуждения доработок и развития продукта. На наш взгляд, такой подход помогает выработать чувство собственничества и разделить ответственность за принятие тех или иных решений (упростить принятие сервиса в продакшн).

Важно учитывать в метриках качества продукта KPI бизнеса. В системе ценностей заказчика главное мерило «точности» модели — её прибыльность. И тут может возникнуть конфликт между тем, как работает система, и тем, какие KPI выставляют менеджерам.

Предположим, в транспортной компании установлено правило: часть премий, которые получает бизнес, зависит от качества планирования запасов запасных частей на ремонтных предприятиях. Если сервис с ИИ в рамках решения своей задачи будет ежедневно оценивать потребности в запчастях, и суммарная потребность будет отличаться от указанной бизнесом, это напрямую укажет на плохую работу менеджмента. На самом деле «некачественной работы» нет: управленцы не могут отслеживать большие объемы данных в реальном времени и корректировать результаты расчётов в моменте. Попав в ситуацию, когда решения ИИ ставят под угрозу премиальные, менеджмент вряд ли будет поощрять такое внедрение, чтобы не «подставляться».

В таком случае стоит сперва прийти к руководству, сообщить о результатах и обсудить либо возможную перестройку их KPI, либо жертвы, на которые придётся пойти сервису, чтобы добиться синхронизации технических и бизнес показателей.

Заключение

Появление ChatGPT и других генеративных моделей вскрыло слабые места передовых технологий машинного обучения. Как можно нарисовать 10 пальцев на одной кисти у человека? Почему нейросеть не понимает, что это неправильно? Если в продуктах таких гигантов, как OpenAi, есть ошибки, что же тогда у нас? Вопросы ненамеренно рождаются в головах обычных пользователей и порождают сопротивление обновлению процессов принятия решения.

Разрабатывать «черный ящик», оборачивать в интерфейс и называть продуктом уже недостаточно. Пользователи хотят понимать, могут ли они доверять рекомендациям «черного ящика», и какая часть ответственности при этом сохранится за людьми. Поэтому внедрение атрибутов доверия это не украшение крупных проектов, а обязательное условие разработки. Без них продукт с ИИ с большой вероятностью столкнётся с сильным сопротивлением или даже потерпит неудачу на этапе внедрения и проработки корректности результатов.

Разумеется, специфика восприятия атрибутов доверия зависит и от конкретной отрасли. Может требоваться адаптация под определенные запросы целевой аудитории. Чтобы грамотно оценить качество такой адаптации и общий прогресс, понадобится детально зафиксировать текущие показатели до внедрения атрибутов доверия. При качественном подходе (подстройка сервиса под интересы менеджмента, анализ полученных метрик, проработка слабых мест при запуске новой функциональности) можно рассчитывать на фундаментальное улучшение отношения бизнеса и пользователей к продукту с ИИ.

atshaman

Ну, ответ на вопрос в заголовке статьи простой:

Дикая пропитанность темы инфоцыганщиной. Как только слышишь слова "мэшин лернинг! дип мэшин лергинг! дата сайнс! биг дейта анализис! ... profit!" - одна рука инстинктивно прикрывает кошелек, вторая сама тянется к парабеллуму. Думаю, у каждого ИТ специалиста с ~10 летним бэкграундом есть 1-2 примера очень специфического взаимодействия подобного рода - стандартный для индустрии "коэффициент pi" в случае с ML\DS равен эдак 20-25.

Куча примеров "из жизни" когда ИИ выдает скажем так, странные результаты. 11 пальцев - хрен с ним, но вот специально обученный охранник, при виде начальства на проходной нажимающий кнопку - таки реальность, данная нам в ощущениях. "Распознавание лиц" работает... иногда. Охотно верю, что статистически оно чаще работает, чем не работает - но каждый раз при виде "специально обученного" все равно смеюсь.

Крайне, нет КРАЙНЕ низкое качество ИТ-составляющей решений. "Слева море legacy, справа - код дата-сатанистов, выбирайте быстро куда будете садиться" - таки отраслевой мем. Собственно я слышал "А что вы хотите?! Я МАТЕМАТИК, а не программист!" не один и не два раза. И нет, со временем лучше оно не становится.

Что с этим делать? Врать хотя бы как все остальные - раза в три, не больше. Работать руками-и-головой, а не каквсигда. И так десять лет подряд.

Идея дать людям возможность сказать "Я за это <censored> не отвечаю!" доверие не повысит, но хоть негатив снизит...

Maxim_Santalov Автор

Спасибо за комментарий.

Да, как минимум атрибуты доверия снизят негатив. А если команда разработки проанализирует обратную связь и "полечит" боль, то ещё и качество работы сервиса повысится.