В этом году мы писали про анонс HP CS200 для сред виртуализации, теперь настало время посмотреть, как эти системы работают в деле. Наши коллеги из Бельгии организовали демо-стенд из 3 систем, чтобы продемонстрировать все возможности гиперконвергентной платформы HP, и мы публикуем отчет об их работе.

Организация стенда преследовала цели на практике показать все преимущества, заявленные на сайте HP. Главное из них – скорость развертывания, а именно переход к развертыванию виртуальных машин в интерфейсе vCenter уже через 15 минут после включения питания. Здесь расписаны все шаги, которые потребуются для построения такой инфраструктуры. Забегая вперед скажу, что для начала необходимо будет определить 23 незанятых IP-адреса, так что проверяем список доступных IP адресов и вперед!

Распаковка

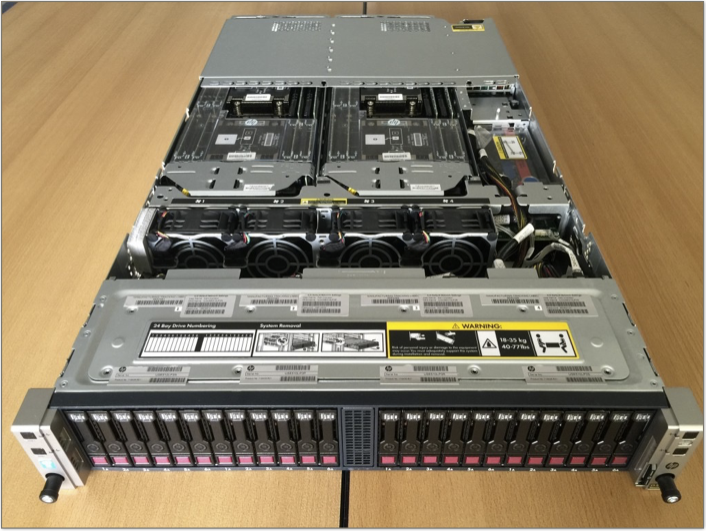

Первое замечание: коробки довольно тяжелые – тяжелее, чем HP ProLiant DL380. Это из-за того, что в составе каждой HP CS200 идут 4 независимых сервера, каждый со своими процессорами и памятью. Платформа поставляется и отдельно под именем HP ProLiant SL2500.

Сразу за салазками для установки в стойку мы находим конверт с полезной информацией для установки и Read First документацию.

Актуальное руководство по инсталляции можно найти на сайте HP. Также доступно полное руководство пользователя.

Передняя панель имеет 24 отсека для установки дисков малого форм-фактора (в зависимости от модели CS 200 это могут быть либо полностью SAS диски 10k либо гибридный вариант из SAS и SSD). Диски физически делятся между 4 серверными узлами в шасси (по 6 дисков на RAID-контроллер каждого узла).

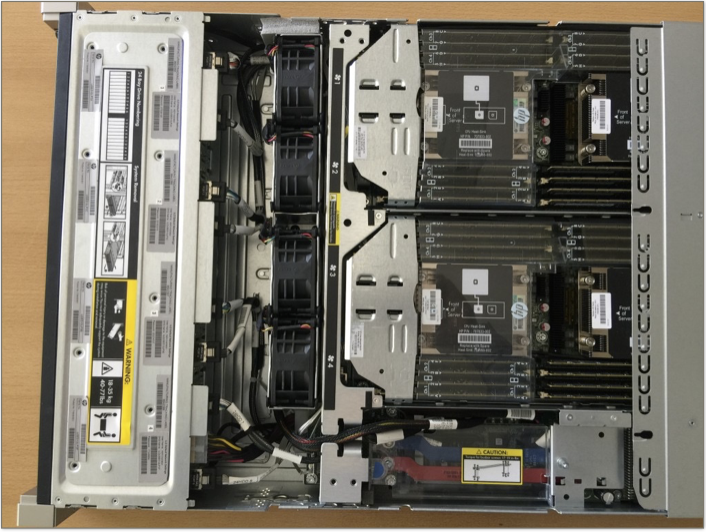

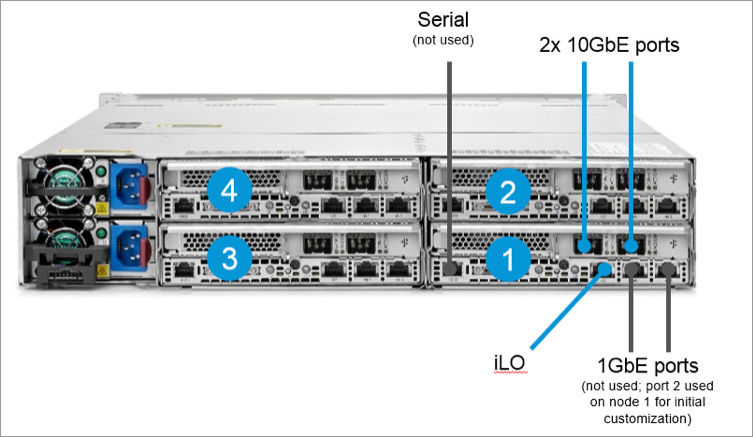

Задняя панель шасси позволяет разглядеть 4 независимых серверных узла с отдельными портами для подключения в сеть.

Каждый узел имеет 2 порта 10Gb для подключения в сеть, также на каждом узле имеются 2 отдельных порта 1Gb, которые не используются в работе и закрыты пластиковыми заглушками. Т.к. это полноценный сервер ProLiant, то каждый узел имеет отдельный порт управления iLO.

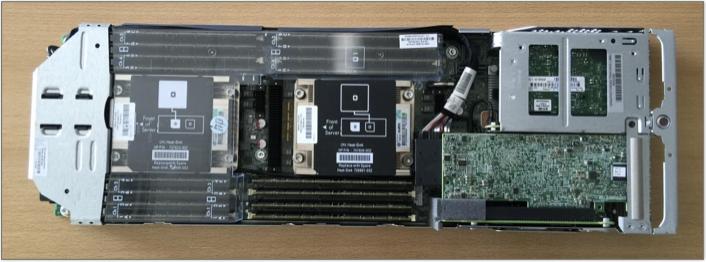

Бельгийских коллег и наших инженеров впечатлил дизайн каждого из узлов: грамотно скомпонованный и продуманный. Вот картинка отдельно стоящего узла CS200 с 16 планками памяти по 16GB, 1TB памяти на шасси. Неплохо!

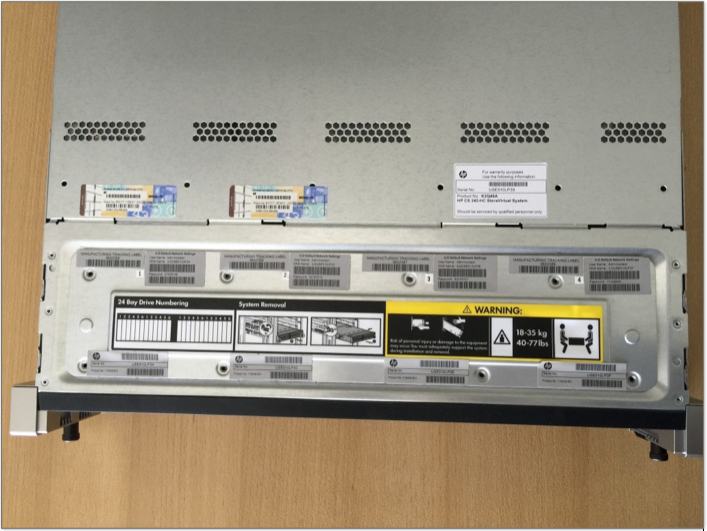

Наконец, на верхней крышке шасси можно найти всю необходимую информацию для первого запуска, такую как начальный пароль iLO каждого сервера, и system ID. Также замечаем лицензию Windows для управляющей VM (ниже будет описание).

Кстати, платформу ProLiant SL2500 можно пощупать в московском офисе компании HP на Войковской или договориться о тестировании на вашей площадке.

Запуск

После подключения 2 кабелей питания и 8 сетевых кабелей (8x 10Gb) начинаем установку системы.

На узле 1 (снизу справа шасси) нам нужно подключить один из показанных на картинке портов 1Gb к ноутбуку для первичного запуска. Больше эти порты использоваться не будут.

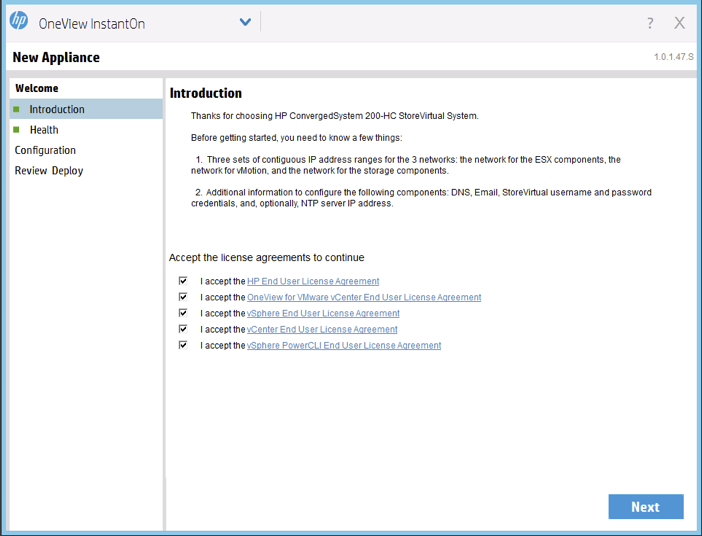

Система поставляется с предустановленным ESXi и одной управляющей VM с Windows, на которой также будет располагаться vCenter. Для первичного запуска подключаем ноутбук к первому узлу и запускаем ПО быстрого развертывания OneView Instant-On. Для этого устанавливаем ноутбуку IP адрес в диапазоне 192.168.42.x (не 100), далее подключаемся по RDP к управляющей VM по адресу 192.168.42.100. Логин/пароль находим на наклейке сверху шасси, по умолчанию это «administrator» и «hpcs200HC!».

Засекаем время!

Предполагаем, что пользователь уже ознакомился со всеми EULA’s от HP и VMware, иначе будет трудно уложиться в заявленные 15 минут!

Нажимаем «Дальше»

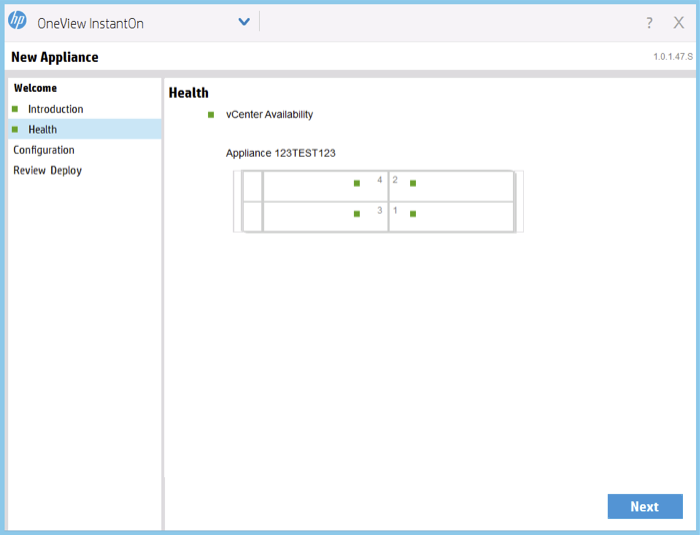

Поверх обычного образа ESXs 5.5 в CS200 устанавливается специальный агент (Discovery Agent), который будет использоваться для первичной конфигурации. Зеленые точки говорят о том, что установка проходит в штатном режиме и OneView Instant-On может без труда общаться к этими Discovery агентами. Также можно видеть, что система распознала и обнаружила vCenter, можем двигаться дальше!

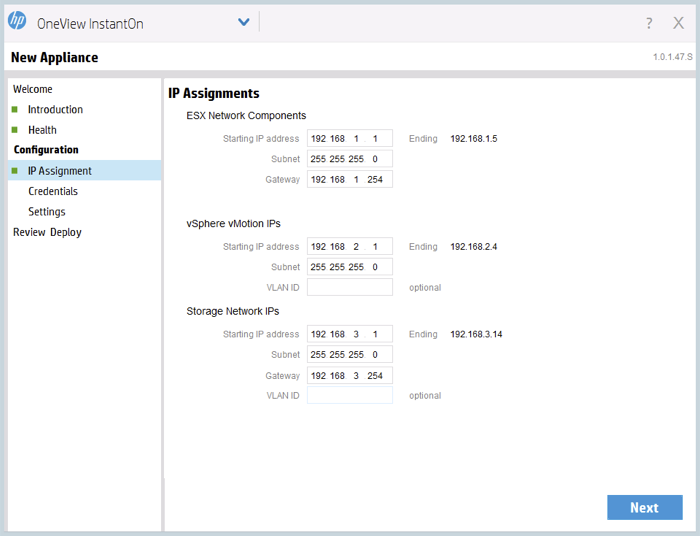

Вот тут нам пригодятся наши 23 IP адреса:

— 5 для ESXi хостов и управляющего сервера vCenter;

— 4 для vMotion kernel’s;

— 14 для сети iSCSI SAN;

Пока всё просто, дальше.

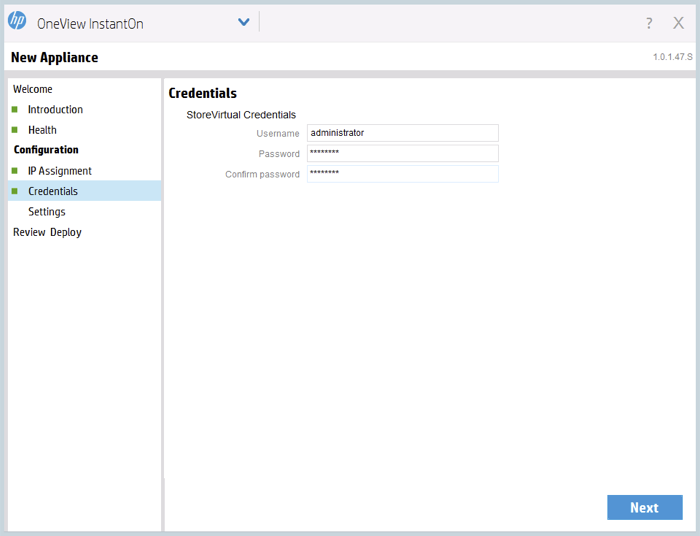

Типичный вопрос, возникающий при установке StoreVirtual iSCSI SAN для управляющей группы – настройка прав доступа.

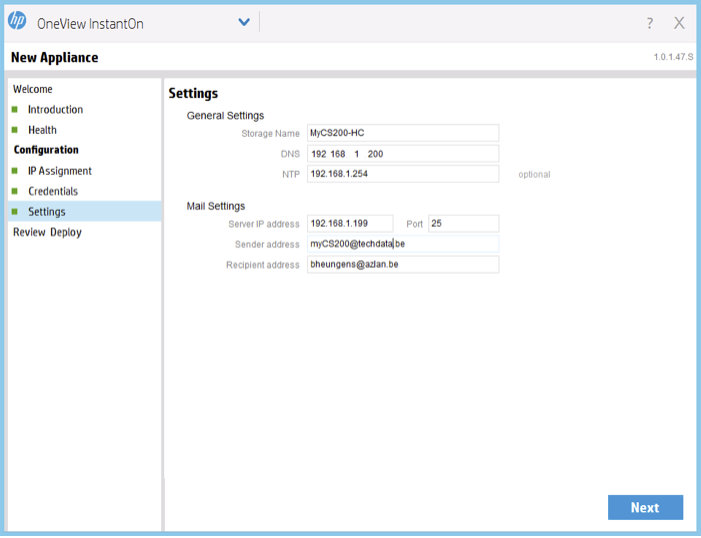

Немного дополнительных настроек: DNS, NTP, оповещения по почте.

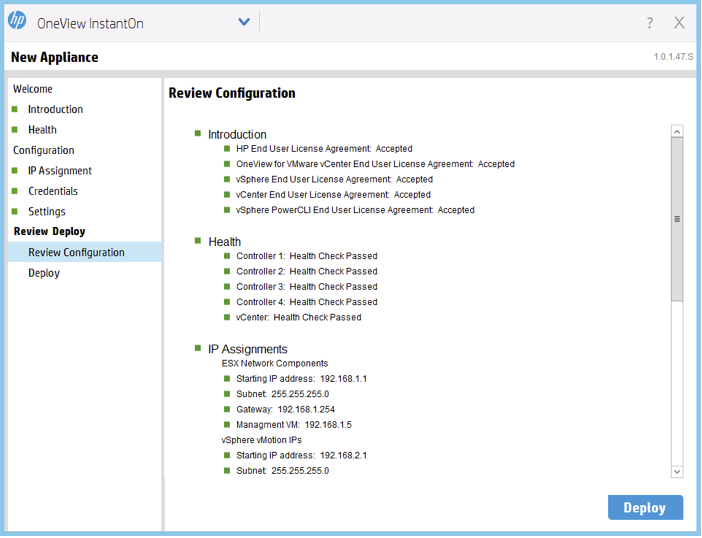

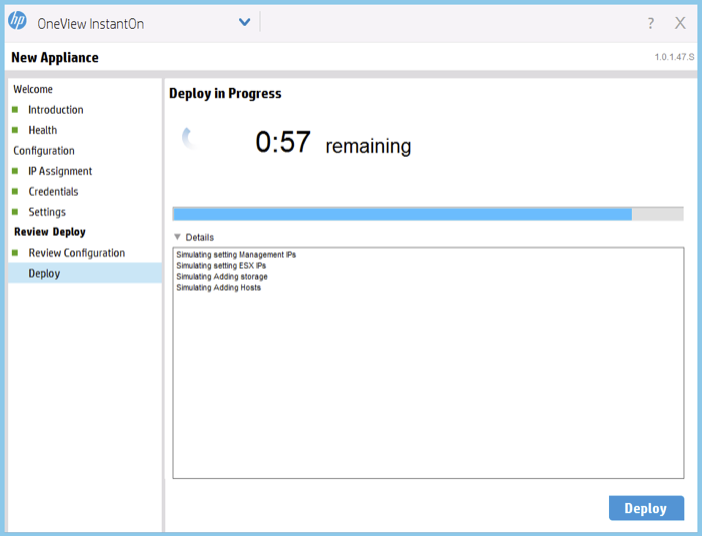

Предварительный просмотр введенной информации (все индикаторы зеленые, значит, все введено правильно) и нажимаем «Deploy». Теперь система применяет все заданные настройки на 4 ESXi узла и происходит настройка VSA SAN.

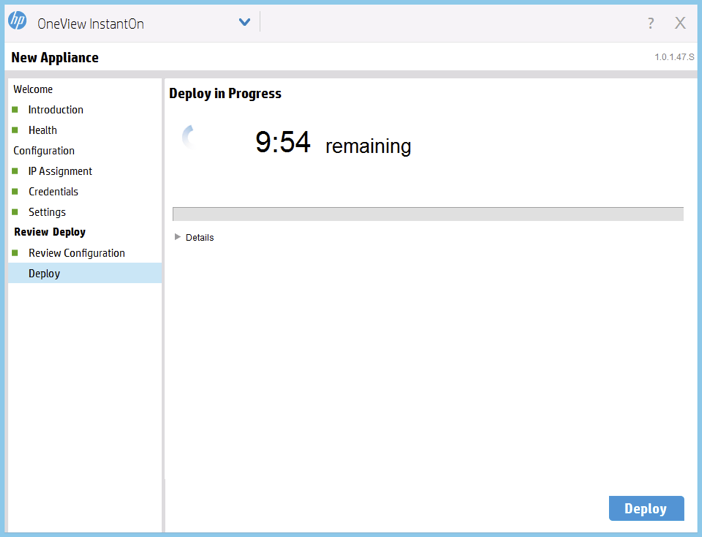

Вся детальная информация отображена в окне установки.

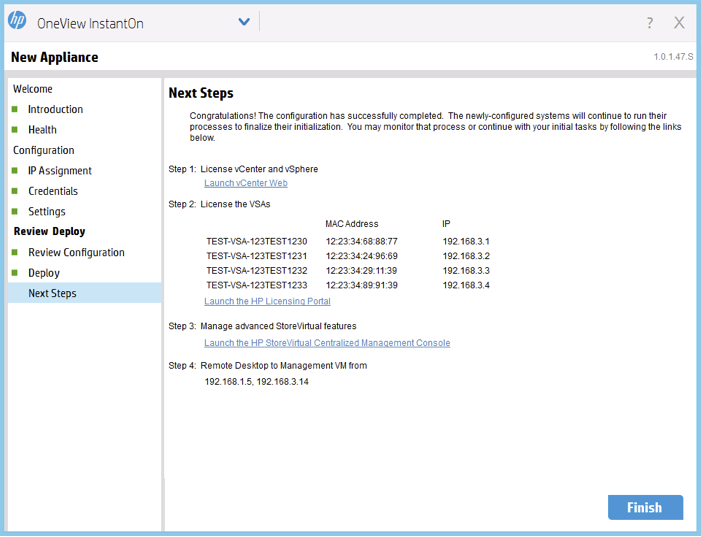

И, наконец, система полностью развернута. Дальше через web или windows клиент или можно подключиться к vCenter и начать развертывание виртуальных машин.

Последним шагом будет регистрация лицензий VSA на портале HP Licensing Portal. Уложились в 15 минут, как и обещали.

Тестирование

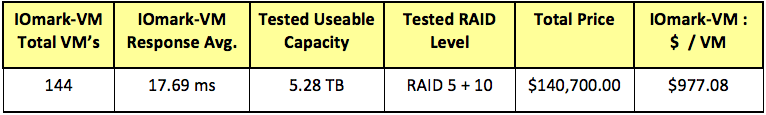

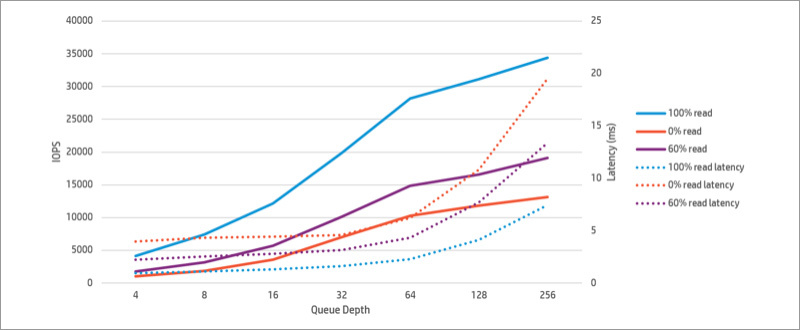

Быстрой скорости развертывания для такой системы недостаточно, нужно, чтобы система также быстро работала. Для проверки был выбран бенчмарк Iomark-VM, позволяющий определить производительность системы максимально близко к реальным условиям в среде виртуализации. Тест был проведен на системе HP ConvergedSystem 242-HC StoreVirtual в конфигурации, поддерживающей до 144 виртуальных машин на шасси. Скачать тест.

Описание рабочей нагрузки, заложенной в тест:

— нагрузка должна генерироваться целиком на тестируемой системе;

— нагрузка разделяется на сет из 8 потоков;

— 70% IO не должно превышать времени отклика 20мс;

— среднее время отклика каждого приложения не должно превышать 30мс;

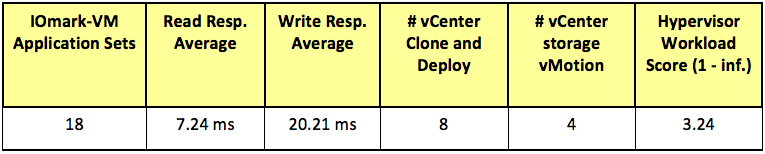

Операции гипервизора, проверяемые в тесте:

— клонирование, развертывание, загрузка, обновления SW, удаление VM;

— Миграция данных (storage migration).

Таблица конфигурации CS200:

Характеристики HP CS200, количество протестированных виртуальных машин, время отклика и полезная емкость, протестированная в тесте:

Прайс, показанный здесь – Global List Price еще до скидок. Цены для вас можно узнать у партнеров Hewlett-Packard.

Таблица теста гипервизора:

Конфигурация дисковой подсистемы доступна из ссылки на тест.

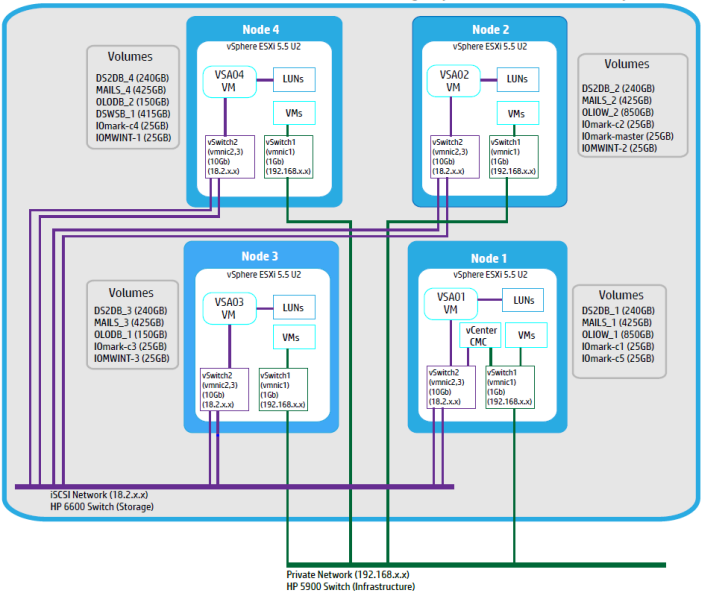

Логическая конфигурация HP ConvergedSystem 242-HC StoreVirtual:

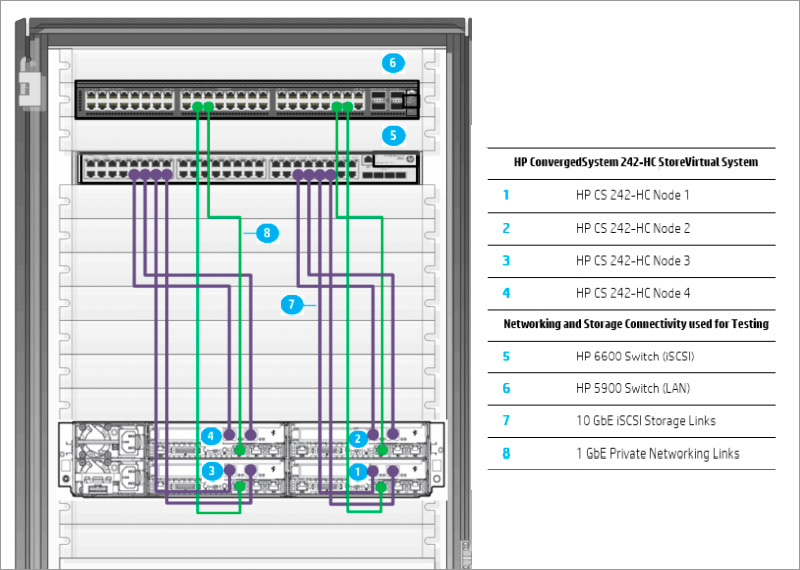

Схема стенда в стойке:

График производительности HP ConvergedSystem 242-HC StoreVirtual, полученный после тестирования:

Получилась очень компактная и очень производительная система для виртуализации, которая очень понравилась нашим европейским заказчикам как по удобству работу, так и по стоимости и производительности. Надеюсь, понравится и вам. Следите за дальнейшими анонсами!

Наши предыдущие публикации:

» HP StormRunner Load. Практическое руководство. Часть II

» HP StormRunner Load. Практическое руководство. Часть I

» Правильный бонус для вашего нового сервера

» Экономичные серверы HP для SMB и провайдеров

» HP OpenStack Helion – первое знакомство

» SDN: альтернатива или дополнение к традиционным сетям?

» Новые сетевые архитектуры: открытые или закрытые решения?

» Внедрение MSA в виртуализированном окружении предприятия

» Дисковые массивы HP MSA как основа для консолидации данных

» Мультивендорная корпоративная сеть: мифы и реальность

» Доступные модели серверов HP ProLiant (10 и 100 серия)

» Конвергенция на базе HP Networking. Часть 1

» HP ProLiant ML350 Gen9 — сервер с безумной расширяемостью

??Спасибо за внимание!

Комментарии (25)

AndreyKirov

15.05.2015 11:11А как реализована отказоустойчивость? Вот умерла одна нода. Что происходит?

Effi3 Автор

15.05.2015 12:19Добрый день, виртуальная машина поднимается на одном из оставшихся трех узлов, либо, если у нас несколько таких серверов — на другом сервере.

Вы сами задаете уровень доступности и параметры репликации.

AndreyKirov

15.05.2015 13:24А каким образом другой узел получает доступ к виртуальной машине если она хранилась на массиве, подключенном к умершему серверу?

Effi3 Автор

15.05.2015 14:31Хранилище в такой системе не локальное, а распределенное между узлами и блоками серверов (вы настраиваете уровень избыточности и отказоустойчивости), т.е. при выходе из строя узла виртуальный стор доступен другим узлам.

AndreyKirov

16.05.2015 08:27Каким образом происходит распределение? В системе стоят диски SAS. Там внутри SAS коммутатор?

Effi3 Автор

18.05.2015 18:29На бэкплейне физическое разведение отсеков дисков к своим узлам.

AndreyKirov

18.05.2015 20:41Да что же мы с вами как слепой с глухим разговариваем :)

Меня интересует как работает система и не на уровне маркетинговых фраз.

Давайте еще раз. Образ виртуальной машины лежит на физических дисках, привязанных к одному из узлов. Этот узел умирает. Диски полностью выходят из игры? Если машина при этом продолжает жить, значит данные репилицируются на диски других узлов? Если да, то как организована репликация? Синхронная/асинхронная, какие задержки, как определяется количество реплик и их местонахождение?

Объясните пожалуйста технологию.

Effi3 Автор

24.05.2015 21:10Прошу прощения за задержку с ответом, в силу высокой загруженности на работе.

Да, диски привязаны к узлу, в случае смерти узла — диски становятся недоступны.

Между узлами можно настроить синхронную репликацию на удаленную площадку (или локально на соседний сервер) с несколькими уровнями избыточности: зеркало (узел может выйти из строя, данные сохранятся на трех оставшихся узлах), зеркало +1 (2 узла могут выйти из строя, данные сохраняются на оставшихся двух), зеркало + 2 (3 узла могут выйти из строя, данные сохраняются на оставшемся узле). Уровень избыточности можно задать на каждый том свой, также как и место хранения. Увеличивая уровень избыточности нужно помнить, что будет расти нагрузка на сеть (синтетические цифры есть, на каждый уровень избыточности, но всегда нужно проверять на практике у каждого заказчика).

Требования к синхронной репликации — RTT не более 2 мс

Требований к асинхронной репликации нет.

ximik13

15.05.2015 14:581) Данные между нодами передаются/синхронизируются по iSCSI?

2) До скольки нод/серверов масштабируется решение?

3) Для работы требуется внешний 10G свитч с медными RJ45? Или там порты под SFP+ трансиверы на нодах (на картинках плохо видно)? Свитч нужен тоже от HP?

4) На 1G не заведется решение в минимальной конфигурации?

Effi3 Автор

15.05.2015 16:21Добрый день,

1. Да

2. 4 сервера по 4 узла на локальной площадке + 4 сервера по 4 узла на удаленной площадке, такая конфигурация в системе управления рассматривается как единый кластер.

3. Для гибридной системы SSD + SAS предполагается высокопроизводительное подключение 10Gb SFP+, допустимо использование коммутатора любого производителя. Есть возможность использовать 10Gb RJ45 на этом сервере пока в составе решения под VMware EVO:RAIL.

4. Есть возможность собрать решение «на коленке» отдельно сервер + отдельно VSA и гипервизор с подключением по 1Gb. Технически это будет работать, но такой способ подключения не тестировался на высокие нагрузки. Также прелести быстрого развертывания, как описывается в статье — не будет, и не будет единого номера тех поддержки. Система, описываемая в статье, обслуживается и поддерживается как единый комплекс.

ximik13

15.05.2015 16:36Спасибо. Кратко и по делу :).

Effi3 Автор

15.05.2015 17:06Обращайтесь, сервер есть в демо-центре, можете попросить через наших торговых представителей его на тестирование, заодно и протестировать на нагрузки по картам 1Gb, либо можем предложить удаленное тестирование в Европе уже собранного сервера под ваши нужды.

shapa

Отлично, полк HyperConvergent систем активно растет :)

Вопрос по поводу «очень производительно» — можно точно конфигурацию (сколько SSD на каждый нод у вас стоит?)

Откуда «ноги растут» у системы я комментировать не буду, это и так понятно, но на 4-х нодах (практически аналогичным показанной в статье железке) мы сейчас получаем в районе 120 тысяч IOPS на чтение и около 70 на запись на кластерной ФС.

Кстати, правильно ли я понимаю что VSA сделана на основе программной версии Lefthand со всеми ее ограничениями дизайна (включая применения крайне устаревшей технологии RAID5/10)?

Бесплатная версия только 1TB?

Effi3 Автор

Добрый день,

Конечно, конфигурацию комплекса можете посмотреть в тесте в статье.

70 тысяч IOPs тоже неплохие цифры, вот только нужно уточнить на какой платформе их получили, я насчитал разных серий вашего продукта аж 9, в каждой по несколько моделей, каждая под свои задачи.

На самом деле все зависит от требуемого уровня доступности виртуальной машины, не думайте, что у вас вся емкость комплекса делится пополам. Эти политики можно очень гибко настраивать.

В составе с каждым сервером идет лицезния на 1ТБ, это значит, что резервное хранилище для такого комплекса можно развернуть на любом сервере HP Proliant. Что важно для заказчика — обращения с вопросами ПО и Hardware будут адресованы одному и тому же производителю, что сэкономит кучу времени.

Если нужно скачать бесплатную версию, то можно зайти по ссылке: www.hp.com/go/tryvsa

Кстати, по этой же ссылке можно скачать бесплатную версию HP StoreVirtual VSA на любой другой объем, ограниченную сроком работы в 60 дней.

Здесь же бесплатно доступен программный продукт бэкапа HP StoreOnce, который можно разместить в виде виртуальной машины на этом же комплексе или любом другом сервере.

shapa

День добрый. Мне поэтому и стало интересно, какая конкретно конфигурация тестировалась.

Вы показали какой-то график с IOPS, но при этом совершенно не ясно на каком «железе» он снят.

«не думайте, что у вас вся емкость комплекса делится пополам. Эти политики можно очень гибко настраивать.» — это вполне мне понятно :)

Суть в том что сами по себе RAID технологии уже мертвые

Я как понимаю намек не понят был, я работаю в компании, которая нынче более 50% рынка гиперконвергентных систем держит (HP пока там нет, но наверное какую-то долю рынка получит в 2015 году).

Добро пожаловать в клуб, для несложных / небольших задач ваше решение может быть достаточно интересным. Правда про «одного вендора» немного смущает — ESXi поддержку тоже HP предоставляет? В данном случае гипервизор — критически важен.

Хотя учитывая привязку к ESXi — достаточно интересно будет объяснять клиентам почему им не поставить совершенно бесплатный N-x Community Edition (в том числе на железо HP встанет) без каких-либо ограничений по месту и прочему. С бесплатным гипервизором и системой управления оным.

Effi3 Автор

«на каком «железе»» — тестировалась ровно та система, про которую и было написано HP ConvergedSystem 242-HC StoreVirtual Storage, набор компонент у нее единый.

«я работаю в компании, которая нынче» — я бы поправил — «пока держит» :)

«Добро пожаловать в клуб» — это как посмотреть, Lefthand, на который вы указываете, известен на рынке более 16 лет, это хорошо себя зарекомендовавший и проверенный временем продукт, еще до появления продвигаемых вами систем.

По технологиям RAID — приведенная вами статья написана нашим альянсным партнером Cleversafe, который разработал продукт для объектного хранения данных. У нас есть совместная референсная архитектура, построенная на «старшей» линейке SL 4500 h20195.www2.hp.com/V2/getpdf.aspx/4AA4-9855ENW.pdf.

Надеюсь вы понимаете, что указываете на статью в которой описаны совершенно другие задачи хранения? Да, для объектного хранения мы готовы дать удаленный доступ к этим системам. Cleversafe не заявляет, что такое объектное хранилище сможет заменить блочное с высокими показателями IO и низкими задержками.

По поддержке гипервизора, готов процитировать наш мануал: «Анализ версии и исправления, а также советы, предоставляются для операционной системы сервера, программного обеспечения виртуализации, программного обеспечения хранилища/сети хранения данных и сетевого программного обеспечения.» и «Если заказчик обращается при возникновении проблемы с критически важным оборудованием или программным обеспечением, вызов будет перенаправлен специалисту по техническим решениям или заказчику перезвонят в течение 15 минут.» и «После обращения заказчика и подтверждения компанией HP запроса на обслуживание, компания HP в рамках графика предоставления услуг по ремонту оборудования или программного обеспечения выявит неисправность оборудования или программного обеспечения, дистанционно устранит ее и решит проблему заказчика.».

Не стоит наивно полагать, что какая-то информация приведена только для «красного словца», вы можете подробно почитать о преимуществах поддержки HP на нашем сайте.

«С бесплатным гипервизором» — думаю, будет интересно только совершенно новому в среде виртуализации заказчику, ибо плодить зоопарк из разных гипервизоров — в конце концов дорогое удовольствие.

shapa

«Lefthand, на который вы указываете, известен на рынке более 16 лет,» — в этом как раз и проблема. Можно конечно ботокс колоть и пластические операции делать, но фундаментально ничего не изменить.

Про «задачи хранения» — неверно, речь идет просто про большие датасторы. Причем тут объектное хранение — совершенно не ясно.

Учитывая тенденции (уже по 10TB диски есть), RAID5/6 и уж тем паче 10 — мертвые технологии в ближайшее время.

Простой вопрос — сколько у вас время ребилда при отказе диска? Двух? Нода целиком?

Про поддержку гипервизора (в данном случае ESXi) — очень интересная ситуация.

К сожалению, выглядит так что нет у HP специалистов по VMware качественных.

В компании HP работает (на весь мир) не более нескольких инженеров с VCDX статусом, на 2013 год был всего один.

Вот за 2013 год (свежее не нашел).

Если ошибаюсь в количестве VCDX в HP — поправьте.

www.virtualizetips.com/2013/09/27/vmware-vcdx-numbers

В Nutanix — несколько десятков уже. Второе место в мире после самой VMware. И да, поэтому мы реально предоставляем поддержку ESXi (так-же как HyperV /KVM).

«думаю, будет интересно только совершенно новому в среде виртуализации заказчику, ибо плодить зоопарк из разных гипервизоров — в конце концов дорогое удовольствие.»

Крайне опрометчивое заявление, учитывая что миграция с ESXi на Nutanix KVM Management Tool — чрезвычайно быстрая и простая.

В РФ уже есть крупные заказчики федерального уровня. Особенно актуально в свете импортозамещения и перехода на открытые технологии.

Кстати, какого уровня лицензия ESXi требуется для VSA? Standard хватит или нужен Enterprise / Enterprise+?

p.s. VCDX — высшая квалификация специалистов по VMware.

Effi3 Автор

«но фундаментально ничего не изменить» — так поэтому и Lefthand уже нет, есть Storevirtual, перенявший очень много полезного от Lefthand, но, в то же время, отвечающий всем современным задачам хранения данных.

«Причем тут объектное хранение» — цитирую сайт компании «Cleversafe sells an object storage system, the Dispersed Storage Network or dsNet».

«VCDX — высшая квалификация специалистов по VMware» — а что, для помощи по самым простым вопросам вашим специалистам тоже нужна самая высокая квалификация? Типичные вопросы задачика, на мой взгляд, редко требуют такого высокого статуса. Хотя, можно и микроскопом гвозди забивать :)

«учитывая что миграция с ESXi на Nutanix KVM Management Tool» — миграция это только начало, самое простое действие, оно и должно быть быстрым и простым. Далее всплывает «правда жизни» — взаимодействие с текущими гипервизорами, несколько консолей управления, кейсы в несколько компаний, стихийные патчи.

Вам, наверное, интересно будет узнать, что поддержкой HP закрывается и Service Pack for Proliant — прогнозируемый выход патчей, протестированный между всеми компонентами железа и софта, инсталляция которого закрывает и драйверы и firmware как железа, так и гипервизора.

«Особенно актуально в свете импортозамещения и перехода на открытые технологии» — очень интересное утверждение, учитывая, что ваше ПО и серверы поставляются из-за рубежа. :)

Если считать VMware проприетарной технологией, то как раз предложение HP VSA в качестве хранилища является реальной альтернативой и открытой технологией с понятными планами развития.

Мне ваши FUD'ы, приведенные здесь понятны, не хочется сходить с теплого места. :)

Если у вас есть вопросы по существу — предлагаю обсудить в кулуарах, приезжайте, в конце-концов, в Россию, пообщаемся. Издалека вещи могут выглядеть иначе. ;)

navion

Она по дизайну, а для VMware главное траблшутинг с выпуском патчей и тут поможет только вендор.

shapa

Насчет 70+ тысяч — это практически любая железка с 2-я SSD на ноду (4 ноды на 2U блок, собственно откуда и растут уши у всех новоприбывших на рынок, включая EVO:RAIL и продукт показанный в статье).

В N-X этот форм-фактор уже года 4 используется.

Если брать NX1000 с одним SSD на нод, который в GPL существенно ниже указанных вами цен, то он тоже заметно более производителен получается.

Поэтому искренне интересно, какое конкретно железо (конфигурация) указано.

И поправьте плз ссылку на «скачать тест» — она ведет в никуда:

www.iomark.org/sites/default/files/IOmark-VM_report_HP-ConvergedSystem-HC-242_id-vm-hc-150427-a.pdf

Effi3 Автор

«Если брать NX1000 с одним SSD» а что будет с IO, если этот один SSD умер? Неужто вы сами замените ему диск? Наверняка отправите к производителю OEM сервера.

Кстати, для тех заказчиков, который не собирается растить большую виртуальную инфраструктуру HP может предложить узлы только с SAS дисками, GPL такого сервера несравненно ниже систем с SSD. :)

Ссылку проверил — работает, если не открывается — готов выложить на файлообменник.

shapa

Смотрю тут:

www8.hp.com/uk/en/products/cs-solutions/product-detail.html?oid=7563555#!tab=specs

Drive description

(24) SFF SAS

Drive type

(16) 1.2 TB 6G 10K SFF Dual-port SAS Drives and

(8) 400 GB MLC SAS Solid State Drives

Итого, 8 SSD на 4 нода, по два SSD. Если не то посмотрел — поправьте ;).

В такой конфигурации на NX как раз и будет 70 тыс IOPS на запись и 120+ на чтение.

Выглядит так, что HP ConvergedSystem 200-HC StoreVirtual System где-то в 4 раза медленнее N-X на практически идентичном оборудовании.

Теперь понятно, почему HP пишет про 120 VM на блок, при том что мы обычно говорим про 100 VM на каждый нод. Как раз в 4 раза разница :)

Effi3 Автор

Тест прежде всего проверял работу комплекса в среде, близкой к реальным задачам типичного пользователя в сложных средах:

«By establishing a set of standard applications and capturing their I/O streams, it is possible to recreate application based storage workloads for these complex environments. IOmark-VM is designed utilizing these concepts, and as such is the first benchmark designed to accurately generate application workloads for storage systems, enabling direct comparison of storage system configurations and their ability to support a specific number of applications».

Тестировалась одновременная работа с виртуальными машинами, генерирующими разные паттерны нагрузки IO: базы данных, Exchange, web server, DVD store, hypervisor storage migration, clone and deploy. Это видно из ссылки в статье, стр. 15, если быть точным.

На простую запись маленькими блоками на паре SSD получить 70 тыс IOPs, это нетрудно, не спорю. :)

Что тестировалось в вашем тесте — неизвестно :).